Zusammenfassung - S-Inf

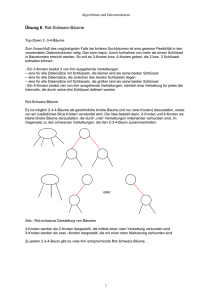

Werbung