Wahrscheinlichkeitstheorie: Grundlagen und Definitionen

Werbung

Wahrscheinlichkeitstheorie: Grundlagen und Definitionen

• Wahrscheinlichkeiten und Dichten

• Interpretation von Wahrscheinlichkeiten

• Einige Definitionen und Gesetze

PD Dr. Martin Stetter, Siemens AG

Wahrscheinlichkeitstheorie: Grundlagen, Definitionen

1

Zufallsvektoren

Multivariate Daten: Mehrere Zufallsvariablen nehmen ihre Werte in gegenseitiger

Abhängigkeit voneinander an, müssen also zusammen betrachtet werden.

Bsp: Körpergröße und Körpergewicht

•

X = ( X 1 , X 2 , ..., X d ) = ZufallsvektorWertebereich: x ∈ R d

•

p (x) = p ( x1 , ..., xd )

= zusammengesetzte („multivariate“) Wahrscheinlichkeitsdichte

p (x)dx = p ( x1 , ..., xd )dx1dx2 ...dxd

= Wahrscheinlichkeit, bei der Messung eines Vektors

X 1 ∈ [ x1 , x1 + dx1 ]

X 2 ∈ [ x2 , x2 + dx2 ]

und in derselben Messung

und in derselben Messung ....

...

X d ∈ [ xd , xd + dxd ]

zu finden

Nomenklatur: Messung = Ziehen aus der Verteilung

PD Dr. Martin Stetter, Siemens AG

p (x)

Wahrscheinlichkeitstheorie: Grundlagen, Definitionen

2

Beispiel: Multivariate Gaussverteilung

1

1

T

−1

ϕ (x | ì , Ó) =

exp

−

(

x

−

ì

)

Ó

(

x

−

ì

)

d /2

1/ 2

(2π ) (det Ó)

2

Einschub: Bilinearform:

d

xT Ax = ∑i , j =1 xi aij x j

Z.B. 2D:

a

xT Ax = ( x1 , x2 ) 11

a21

µ=

Σ=

Mittelwert-Vektor

Kovarianz-Matrix

a12 x1

= x12 a11 + 2 x1 x2 a12 + x22 a22

a22 x2

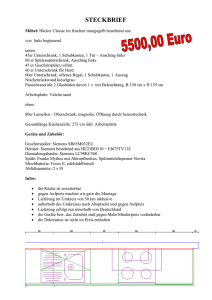

2D Gaussverteilung mit

2.0 0.6

Ó =

0.6 0.5

Links: Grauwertbild der pdf

Rechts: Stichprobe von 300 Vektoren

PD Dr. Martin Stetter, Siemens AG

Wahrscheinlichkeitstheorie: Grundlagen, Definitionen

3

Interpretation von Wahrscheinlichkeiten

Betrachte den Wert x0 einer Zufallsvariable X:

Frequentistische Philosophie:

• Der Datenpunkt ist eine Stichprobe aus einer existierenden „wahren“ Verteilung

• =>

p (x)

p (x)

kann als Grenzwert der relativen Häufigkeit interpretiert werden

• „Wahrscheinlichkeit als Prozentsatz“

• Typisches Beispiel: Wahrscheinlichkeit, 6 zu würfeln

Bayesianische Philosophie:

• Nur der Datenpunkt x0 existiert, es gibt keine zugrundeliegende Verteilung

• „Wahrscheinlichkeit als Glaube (Belief) des Eintretens eines Sachverhalts“

• Basiert allein auf Vorwissen und auf den beobachteten Daten

• Typisches Beispiel: Wahrscheinlichkeit, den nächsten Marathon zu gewinnen

PD Dr. Martin Stetter, Siemens AG

Wahrscheinlichkeitstheorie: Grundlagen, Definitionen

4

Einige Definitionen und Gesetze

Betrachte zwei Zufallsvariablen X, Y

(hier oBdA kontinuierlich ):

Bedingte Wahrscheinlichkeit

• Wahrscheinlichkeit, Y

wenn

X ∈ [ x, x + dx]

p ( y | x)dxdy

∈ [ y, y + dy ]

zu finden

bekannt ist

• Zusammengesetze Dichte:

p( y, x) = p( y | x) p( x)

X,Y abhängig unabhängig

• Marginalisierung:

p ( y ) = ∫ p ( y, x)dxdy = ∫ p ( y | x) p ( x)dxdy

• Statistische Unabhängigkeit:

⇔ p( y, x) = p( y ) p( x) ⇔ p( y | x) = p( y )

PD Dr. Martin Stetter, Siemens AG

Wahrscheinlichkeitstheorie: Grundlagen, Definitionen

5

Betrachte mehrdimensionale Daten:

X = ( X 1 , X 2 , ..., X d )

Dekomposition von zusammengesetzten Dichten:

p ( xd , xd −1 , ... , x2 , x1 ) =

= pd ( xd | xd −1 , ... , x1 ) pd −1 ( xd −1 | xd − 2 , ... , x1 ) ... p2 ( x2 | x1 ) p1 ( x1 )

Spezialfall statistische Unabhängigkeit:

p ( xd , xd −1 , ... , x2 , x1 ) = pd ( xd ) pd −1 ( xd −1 ) ... p1 ( x1 )

Spezialfall Markov-Kette 1. Ordnung:

p ( xd , xd −1 , ... , x2 , x1 ) = pd ( xd | xd −1 ) pd −1 ( xd −1 | xd − 2 ) ... p2 ( x2 | x1 ) p1 ( x1 )

p( x | y) p( y)

p( y | x) =

=

p( x)

Satz von Bayes:

Denn:

p( x | y) p( y)

∫ p( x | y′) p( y′)dy′

p ( y | x ) p ( x ) = p ( y , x ) = p ( x, y ) = p ( x | y ) p ( y )

PD Dr. Martin Stetter, Siemens AG

Wahrscheinlichkeitstheorie: Grundlagen, Definitionen

6

Überblick über statistische Datenmodellierungs-Verfahren

• Techniken der Datenmodellierung

• Dichteschätzung

• Regression

• Klassifikation

PD Dr. Martin Stetter, Siemens AG

Überblick Datenmodellierung

7

Techniken der Datenmodellierung

Ziel der statistischen Datenmodellierung:

{

D = x (1) , x ( 2 ) , ... , x ( M )

gezogen aus der unbekannten Verteilung p (x)

• Realistische Situation: Datensatz

}

• Datenvektoren x werden auch als „Datenpunkte“ oder „Muster“ bezeichnet

• Datenvektoren existieren in einem „Phasenraum“, „Zustandsraum

(z. B. abstrakter Datenrraum, Vektorraum, Hibertraum ...)

• Ziel: Extrahiere statistische Struktur aus den Daten...

und zwar durch Erstellung eines Modells der zugrundeliegenden Struktur.

• Problem: Finden eines guten Modells... => Maschinelles Lernen (später)

• Wichtige Techniken: Dichteschätzung, Funktionsapproximation

PD Dr. Martin Stetter, Siemens AG

Überblick Datenmodellierung

8

Dichteschätzung

Bemerkungen

Datenpunkt

• Schätzung der unterliegenden

zusammengesetzten Wahrscheinlichkeitsdichte

p (x) aus den Daten

• Kenntnis der Dichte bedeutet vollständige

statistische Charakterisierung!

• Charakterisierung der Struktur darin (z.B. Form

Abhängigkeiten, Trends....)

Phasenraum

PD Dr. Martin Stetter, Siemens AG

Überblick Datenmodellierung

9

Bemerkungen (Fortsetzung)

5 Punkte

• Unüberwachtes Lernverfahren (Struktur wird nur

aus den Daten extrahiert)

• Ein Dichteschätzer stellt ein „Generatives Modell“

dar (kann zur Datengenerierung benutzt werden)

• „Fluch der Dimensionen“: Im allgemeinen Fall

steigt die Anzahl der benötigten Datenpunkte

exponentiell mit der Dimension d des Problems an

• Man unterscheidet nichtparametrische und

parametrische Dichteschätzung

PD Dr. Martin Stetter, Siemens AG

Überblick Datenmodellierung

25 Punkte

d =1

d =2

Fluch der Dimensionen

10

Nichtparametrische Dichteschätzung:

Es wird kein expliziter Funktionsverlauf für die Dichte p (x) angenommen. Beispiele:

• Histogramm-Methode:

d

Teile Datenraum in Parzellen des Volumens h

ein. Berechne darin die relativen Häufigkeiten

• Kernel-Dichteschätzer:

„Glättung der Datenwolke“

M

pˆ (x) = 1 M ∑m =1 u ((x − x(m) ) h)

u (x) ≥ 0,

∫ u (x)dx = 1 Kernel

• K-nächste Nachbarn

Mittelung über K benachbarte Datenpunkte, kein

festes h.

• Bem: -- Größen h,K müssen geeignet gewählt werden (-> Regularisierung)

-- h, K, Histogrammeinträge ... können als Parameter aufgefasst werden

PD Dr. Martin Stetter, Siemens AG

Überblick Datenmodellierung

11

Parametrische Dichteschätzung:

• Die Dichte wird als Dichtefunktion formuliert: p = p ( x | w )

-- Der Verlauf der Dichtefunktion wird durch einen Parametersatz w beschrieben

-- w heißt Parametervektor, Modell, manchmal Gewichtsvektor (-> synapt: Gewichte)

• Lernen = Optimierung des Parametervektors so, daß die Daten durch p ( x | w )

am besten beschrieben werden.

• Beachte Schreibweise als bedingte

Wahrscheinlichkeit

• Vorteil: Wenige Parameter zu bestimmen

• Nachteil: Das Modell kann falsch/ungeeignet sein

• Beispiele:

-- Hauptkomponentenanalyse (PCA)

-- Independent Component Analysis (ICA)

-- Clustering

-- Bayes-Belief Netze (frequent. Interpretation)

-- Graphische Modelle

PD Dr. Martin Stetter, Siemens AG

Überblick Datenmodellierung

Beispiel: Gaußverteilung

w = (ì , Ó), p (x | w ) = ϕ (x | ì , Ó)

12

Funktionsapproximation

Oft lassen sich die Komponenten der Datenpunkte als Input und Output auffassen:

x

→ ( x1 , x2 , ..., xd , y ) = x, y x = Input (Daten), y = Output (z.B. menschl. Bewertung)

Bsp: Fertigungsparameter, Produktqualität. Man unterscheidet:

Regression

• Oft reellwertiger/vektorwertiger output

• Charakterisierung eines zugrundeliegenden funktionellen

Zusammenhangs

Klassifikation

• Binärer oder kategorialer output (Klassenmitgliedschaft)

• Approximation der Klassenmitgliedschaft, oder

• Approximation der Wahrsch. für die Klassenmitgliedschaft

Funktionsapproximation = überwachte Lernverfahren

PD Dr. Martin Stetter, Siemens AG

Überblick Datenmodellierung

13

Regression

Bemerkung

• Implizit wird ein kausaler Zusammenhang

zwischen In- und Output angenommen

(x ( m ) , y ( m ) )

Formulierung

• Erstelle Modell des zugrundeliegenden

deterministischen (kausalen) Zusammenhangs

zwischen input-output Paaren. Lerne bestes Modell

y = f (x | w ) + n

f = Regressionsfunktion, parametrisiert durch w

n beschreibt stochastisches Rauschen (Rauschvektor)

Beispiele:

-- Polynomfit, Lineares Modell... aber auch

-- Multilagen-Percepron

-- Radiale Basisfunktionen-Netzwerke

PD Dr. Martin Stetter, Siemens AG

Überblick Datenmodellierung

Beispiel:

f ( x) = 0.4 + x 2 − 0.28 x 3

n gleichverteilt in [-0.5,0.5]

w = Vorfaktoren des Polynoms

Wahres Modell: (0.4, 0, 1, -0.28)

14

Verbindung zur parametrischen Dichteschätzung:

• Schätze die zusammengesetzte Dichte p ( y , x | w )

• Ansatz (pn=Verteilung des Rauschens):

p ( y , x)

p (y , x | w ) = p (y | x, w ) p (x) = pn (y − f (x | w )) p (x)

• Wenn der Mittelwert des Rauschens

verschwindet, gilt:

yˆ (x)

p ( y , x)

fˆ ( x) = yˆ (x) = ∫ p (y | x)ydy = ∫

ydy

p ( x)

p ( y | x)

NB: Letzteres kann auch bei nichtparametrischer

Dichteschätzung verwendet werden

x

PD Dr. Martin Stetter, Siemens AG

Überblick Datenmodellierung

15

Klassifikation

Bemerkungen

• Datendimensionen werden in Input und

(kategorialer) Klassenmitgliedschaft aufgespalten

• Output heißt auch Klassenlabel

Formulierung

• Erstelle Modell für die Wahrscheinlichkeiten der

Klassenmitgliedschaft. Lerne bestes Modell

Pr( y (x) = 1) = f (x | w )

Separierende Hyperfläche

• f = Klassifikator

• Separierende Hyperfläche definiert durch Pr( y ( x) = 1) > θ ,

z.B. θ = 1 / 2

• Deterministischer Klassifikator entspricht „Regression“ einer binären Funktion

PD Dr. Martin Stetter, Siemens AG

Überblick Datenmodellierung

16