Analyse und praktischer Vergleich von neuen Access

Werbung

Analyse und praktischer Vergleich von

neuen Access-Layer-Technologien in

modernen Web-Anwendungen unter Java

Oliver Kalz

Analyse und praktischer Vergleich von

neuen Access-Layer-Technologien in

modernen Web-Anwendungen unter Java

Oliver Kalz

geb. am 15.02.1979 in Spremberg

Diplomarbeit

zur Erlangung des akademischen Grades

Diplom-Informatiker (FH)

eingereicht an der

Fachhochschule Brandenburg

– Fachbereich Informatik und Medien –

Betreuer:

Prof. Dr. S. Edlich

(Fachhochschule Brandenburg)

Prof. Dr. Th. Preuß

(Fachhochschule Brandenburg)

Brandenburg, den 08.01.2004

Danksagung

Ich danke hiermit allen, die mich während meines Studiums tatkräftig unterstützt haben. Besonderer Dank gilt meinen Eltern, ohne die dies hier nicht möglich gewesen wäre. Ebenso möchte ich mich bei Prof. Dr. Edlich bedanken, der mir mit vielen Tips und

Ideen zur Seite stand. Zu guter letzt danke ich den Korrekturlesern, die hoffentlich alle

Tippfehler entdeckt haben.

„Only two things are infinite, the universe and human stupidity, and I’m not sure about

the former.“ – Albert Einstein

Inhaltsverzeichnis

1

Einleitung

2

Grundlagen

2.1 Das Client/Server-Modell . . . .

2.2 Objektpersistenz . . . . . . . . . .

2.3 Der Java-Standard . . . . . . . . .

2.4 Die Extensible Markup Language

3

4

9

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

11

11

12

16

18

Enterprise JavaBeans

3.1 Die EJB-Architektur . . . . . . . . . . . . . .

3.2 Programmier-Restriktionen . . . . . . . . .

3.3 Bestandteile einer EJB . . . . . . . . . . . . .

3.3.1 Das Home-Interface . . . . . . . . .

3.3.2 Das Komponenten-Interface . . . . .

3.3.3 Die Bean-Klasse . . . . . . . . . . . .

3.3.4 Der Deployment-Deskriptor . . . .

3.4 Arten von EJBs . . . . . . . . . . . . . . . .

3.4.1 Session Beans . . . . . . . . . . . . .

3.4.2 Entity Beans . . . . . . . . . . . . . .

3.4.3 Message Driven Beans . . . . . . . .

3.5 Persistenzmechanismen . . . . . . . . . . .

3.5.1 Bean Managed Persistence . . . . .

3.5.2 Container Managed Persistence . .

3.6 Transaktionen . . . . . . . . . . . . . . . . .

3.6.1 Container-gesteuerte Transaktionen

3.6.2 Bean-gesteuerte Transaktionen . . .

3.6.3 Client-gesteuerte Transaktionen . .

3.7 Fazit . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

21

21

22

22

24

25

25

27

27

28

31

35

36

36

37

45

46

47

48

48

Java Data Objects

4.1 Ziele . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.2 Konzepte . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.2.1 Metadaten . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

49

50

50

50

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

6

Inhaltsverzeichnis

4.3

4.4

4.5

4.6

4.7

4.8

5

6

4.2.2 Bytecode Enhancement . . . . . . . .

4.2.3 JDO Query Language . . . . . . . . .

Der Entwicklungsprozeß mit JDO . . . . . .

Objektidentität . . . . . . . . . . . . . . . . . .

4.4.1 Datastore Identity . . . . . . . . . . .

4.4.2 Application Identity . . . . . . . . . .

4.4.3 Non-durable Identity . . . . . . . . . .

Die JDO-API . . . . . . . . . . . . . . . . . . .

4.5.1 Speichern und Löschen von Objekten

4.5.2 Objekte laden und manipulieren . . .

JDO-Implementierungen . . . . . . . . . . . .

4.6.1 Libelis LiDO . . . . . . . . . . . . . . .

4.6.2 Triactive JDO . . . . . . . . . . . . . .

4.6.3 XORM . . . . . . . . . . . . . . . . . .

JDO und XDoclet . . . . . . . . . . . . . . . .

Fazit . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

51

52

52

54

55

55

56

56

57

58

60

61

63

64

67

68

Objektrelationale Mapper

5.1 Apache ObJectRelational Bridge . . . . . . .

5.1.1 XML-Metadaten . . . . . . . . . . . .

5.1.2 Die PersistenceBroker-API . . . . . . .

5.2 Exolab Castor . . . . . . . . . . . . . . . . . .

5.2.1 Konfiguration . . . . . . . . . . . . . .

5.2.2 Mapping-Informationen . . . . . . . .

5.2.3 Abhängige und unabhängige Objekte

5.2.4 Die Castor-API . . . . . . . . . . . . .

5.3 Hibernate . . . . . . . . . . . . . . . . . . . . .

5.3.1 Mapping-Informationen . . . . . . . .

5.3.2 Die Hibernate-API . . . . . . . . . . .

5.3.3 SessionFactory und Session . . . . . .

5.4 Oracle9iAS TopLink . . . . . . . . . . . . . . .

5.4.1 Deskriptoren und Mapping . . . . . .

5.4.2 Mapping Workbench . . . . . . . . . .

5.4.3 Session und Unit of Work . . . . . . .

5.5 Weitere O/R-Mapper . . . . . . . . . . . . . .

5.6 Fazit . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

71

72

73

75

77

77

78

80

81

83

84

86

88

89

89

90

92

95

96

Objektorientierte Datenbanken

6.1 Schwächen relationaler Systeme . .

6.2 Objektrelationale Datenbanken . . .

6.2.1 SQL99 . . . . . . . . . . . . .

6.2.2 Beispiel: Intersystems Caché

6.3 Objektdatenbanken . . . . . . . . . .

6.3.1 Beispiel: db4o . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

99

100

101

102

103

107

107

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Inhaltsverzeichnis

6.4

6.5

Objektorientierte Datenbanksysteme

6.4.1 Der ODMG-Standard . . . .

6.4.2 Beispiel: Objectivity . . . . .

Fazit . . . . . . . . . . . . . . . . . . .

7

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

110

110

114

116

7

Performance

119

8

Kurzübersicht O/R-Mapping

125

9

Fazit

127

A Anhang

A.1 Servlets und Java Server Pages . . . . . . . . . . . . .

A.1.1 Servlets . . . . . . . . . . . . . . . . . . . . . . .

A.1.2 Java Server Pages . . . . . . . . . . . . . . . . .

A.2 Java Database Connectivity . . . . . . . . . . . . . . .

A.3 Transaktionen und JTA . . . . . . . . . . . . . . . . . .

A.4 Key-Generatoren . . . . . . . . . . . . . . . . . . . . .

A.5 JavaBeans . . . . . . . . . . . . . . . . . . . . . . . . .

A.6 Die Beispielanwendung . . . . . . . . . . . . . . . . .

A.7 Die JDO-DTD . . . . . . . . . . . . . . . . . . . . . . .

A.8 Primärschlüssel-Klasse für JDO Application Identity .

A.9 JDODoclet . . . . . . . . . . . . . . . . . . . . . . . . .

A.10 JDOMapper . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

129

130

130

131

135

137

139

140

142

144

145

146

148

Abbildungsverzeichnis

151

Tabellenverzeichnis

153

Literaturverzeichnis

155

1 | Einleitung

Haben vor einigen Jahren noch statische HTML-Seiten genügt, um Informationen zu

präsentieren, so hat sich das World Wide Web (WWW) in den letzten Jahren zu einem

immer wichtiger werdenden Medium entwickelt. Das Spektrum reicht dabei von der

einfachen Informationsrepräsentation mit statischen HTML-Seiten bis zu dynamisch erzeugten Webseiten mit PHP/MySQL oder ASP. Das WWW wird immer häufiger auch

als Plattform für vollständige, verteilte Anwendungen auf der Basis von Java (J2EE, Servlets, JSPs) genutzt.

Da solche komplexen Webanwendungen ihre Daten meist aus Datenbanken beziehen,

kommt dem Access Layer als unterste Schicht einer Anwendung eine große Bedeutung

zu. Der Access Layer ist dafür verantwortlich, die zu verarbeitenden und anzuzeigenden

Daten zuverlässig, vor allem aber performant zur Vefügung zu stellen.

Eine der ersten Entwicklungen zum Datenbankzugriff aus Java war die Java Database

Connectivity (JDBC), eine Sammlung von Interfaces für einen implementierungsunabhängigen Zugriff auf verschiedene Datenbanken. Da aber hier mit dem Impedance Mismatch der Unterschied zwischen objektorientierter und relationaler Welt negativ zum

Tragen kommt, wurden in letzter Zeit neue Möglichkeiten entwickelt, dieses Problem zu

umgehen.

Aufgabenstellung

Im Verlauf der Arbeit sollen alternative Persistenzmechanismen an praktischen CodeBeispielen vorgestellt und in Hinblick auf ihr Handling und ihre Performance verglichen

werden.

Zunächst soll auf einige theoretische Grundlagen eingegangen werden. Anschließend

werden dann die einzelnen Technologien vorgestellt. Schwerpunkte sind Enterprise JavaBeans, Java Data Objects, objektrelationale Mapper und objektorientierte Datenbanken. Sie haben das Ziel, den Impedance Mismatch zu verhindern oder zumindest vor

dem Entwickler zu verbergen und so die Entwicklung objektorientierter Anwendungen

zu vereinfachen. Außerdem soll eine kleine Webanwendung entstehen, in deren Access

Layer einige der vorgestellten Werkzeuge zum Einsatz kommen. Darin werden dann

auch die Unterschiede im Handling, in der Performance und der Komplexität der Implementierung deutlich.

10

Die Begleit-CD

Auf der beiliegenden CD befinden sich die im Rahmen der Arbeit entstandene Webanwendung sowie einige der verwendeten Werkzeuge in der zur Abgabe aktuellen Version. Die Webanwendung liegt im Quelltext als Eclipse-Projekt vor, außerdem wurde sie

in einem vorkonfigurierten JBoss-Applikationsserver installiert. Weitere Informationen

enthält die Datei readme.html im Hauptverzeichnis der CD.

2 | Grundlagen

In diesem Kapitel sollen einige grundlegende Erklärungen gegeben werden, die für das

Verständnis der folgenden Kapitel notwendig sind. Hierzu gehören Konzepte wie Persistenz und Objektorientierung sowie Technologien wie relationale Datenbanken, Java

und XML.

2.1

Das Client/Server-Modell

Das Client/Server-Modell beschreibt die am häufigsten verwendete Architektur für die

Entwicklung verteilter Anwendungen. Ziel solcher Anwendungen ist die gleichmäßige

Lastverteilung auf alle verfügbaren Rechner. Eine Client/Server-Architektur ermöglicht

Clients die Arbeit mit zentral verfügbaren Diensten und Daten. Ein Server stellt hierbei

einen Dienst zur Verfügung, der von anderen Rechnern genutzt werden kann. Es handelt

sich meist um einen Hintergrundprozeß, der auf Anfragen von Clients wartet. Ein Client

nutzt die von Servern bereitgestellten Dienste bei Bedarf. Zu diesem Zweck baut er eine

Kommunikationsverbindung zum Server auf. Voraussetzung für die Kommunikation ist

die Nutzung eines gemeinsamen Protokolls, welches die Regeln und Kommunikationskanäle für den Informationsaustausch beschreibt.

Die Aufteilung einer Applikation in Schichten legt fest, wie die Programmfunktionalität auf Client und Server aufzuteilen ist. Speziell bei webbasierten Anwendungen hat

diese Aufteilung einen großen Einfluß auf die Performance und die Funktionalität eines

Systems. Grundsätzlich läßt sich eine Applikation in drei Schichten aufteilen1 : Präsentationsschicht (Presentation Layer), Geschäftslogik (Business Logic Layer) und Persistenzschicht (Access Layer). Die Präsentationsschicht kann eindeutig dem Client zugeordnet

werden. Als Persistenzschicht kommt meist ein zentraler Datenbankserver zum Einsatz.

Die zentrale Datenhaltung ermöglicht es, Datenbestände effizient zu verwalten, Redundanzen zu vermeiden und die Integrität der Daten gerade im Mehrbenutzerbetrieb

sicherzustellen. Für die Verteilung der Geschäftslogik gibt es verschiedene Möglichkeiten.

In der 2-Schichten-Architektur wird die Geschäftslogik vollständig im Client implementiert. Das in der Persistenzschicht verwendete Datenbanksystem ist ausschließlich für die

1

Diese Aufteilung gilt nicht zwangsläufig nur für verteilte Anwendungen, sondern wird auch bei

Standalone-Anwendungen eingesetzt.

12

2.2 Objektpersistenz

Verarbeitung von Anfragen zuständig und sendet die Ergebnisse über ein datenbankspezifisches Protokoll an den Client. Clients in einer zweischichtigen Architektur werden

aufgrund ihrer komplexen Programmfunktionalität auch Fat Clients genannt. Sie sind

zwar vergleichsweise einfach zu entwickeln, unterliegen jedoch hohen Wartungs- und

Installationskosten, da Änderungen der Geschäftslogik bei allen Clients durchgeführt

werden müssen. Bei der Kommunikation zwischen Client und Server wird außerdem

das Netzwerk stark belastet, da zu keiner Zeit eine Vorverarbeitung von Ergebnissen

stattfindet. Vielmehr sendet der Server eine komplette Ergebnismenge an den Client. Erst

dort findet die Verarbeitung statt. Zudem ist die Skalierbarkeit einer zweischichtigen Architektur eingeschränkt. Meist bildet der Server einen Flaschenhals, eine Lastverteilung

ist nicht möglich.

In einer 3-Schichten-Architektur wird eine zusätzliche Schicht zwischen der Präsentationsund Persistenzschicht eingefügt. Diese Schicht kapselt die Geschäftslogik einer Applikation und liegt meist in Form eines Applikationsservers vor. Diese Architektur wird dann

eingesetzt, wenn die gleiche Funktionalität von verschiedenen Clients genutzt werden

soll. Die Geschäftslogik wird einmal programmiert und allen Clients über den Applikationsserver zentral zur Verfügung gestellt. Dadurch ist das System leichter zu warten und

zu erweitern: Bei einer Änderung der Funktionalität ist nur die Geschäftslogik betroffen,

die Clients bleiben davon unberührt.

Clients, die in einer dreischichtigen Architektur eingesetzt werden, fallen durch eine

geringere Komplexität und niedrigen Ressourcenverbrauch auf. Man spricht von sogenannten Thin Clients. Zudem wird die Entwicklung von derartigen Clients vereinfacht,

da die Datenspeicherung transparent erfolgt. Der Applikationsserver abstrahiert vom

Zugriff auf die Daten und kümmert sich außerdem um deren Konsistenz.

Während die Kommunikation zwischen Applikationsserver und Datenbankserver über

das datenbankspezifische Protokoll erfolgt, werden für die Kommunikation zwischen

Client und Applikationsserver sogenannte Middleware-Lösungen eingesetzt. Dort können standardisierte Protokolle wie zum Beispiel HTTP zum Einsatz kommen. Speziell

im Java-Umfeld bieten sich auch Web Services und RMI2 an.

Dreischichtige Architekturen sind somit zwar schwieriger zu realisieren, zeichnen sich

allerdings durch hohe Skalierbarkeit, einfache Wartung und gute Erweiterbarkeit aus.

2.2

Objektpersistenz

Objekte, die in einer Anwendung erzeugt und benutzt werden, sollen eine beliebige Lebensdauer haben. Der Begriff Objektpersistenz beschreibt den Mechanismus, Objekte

über die Laufzeit einer Anwendung hinaus zu erhalten. Solche Objekte werden persistente Objekte genannt und sind solange verfügbar, bis sie explizit gelöscht werden.

Neben persistenten Objekten gibt es transiente Objekte, deren Lebenszeit maximal bis

zum Ende einer Anwendung reicht.

2

RMI: Remote Method Invocation

2 | Grundlagen

13

Um die Verfügbarkeit zu gewährleisten, werden persistente Objekte meist in den Sekundärspeicher ausgelagert. So gehen diese Daten auch nicht bei einem Absturz der Anwendung verloren. Für die Auslagerung gibt es verschiedene Möglichkeiten. Objekte lassen

sich zum Beispiel im Dateisystem ablegen. Java bietet hierfür die Serialisierung an. Dabei handelt es sich um eine einfache Lösung, die nicht für große Datenmengen geeignet

ist.

Alternativ lassen sich Objekte in Datenbanksystemen speichern. Solche Systeme bieten

eine effiziente Datenhaltung und ermöglichen Anwendungen die Suche und den schnellen Zugriff auf Daten (vgl. [BG02]).

Handelt es sich um eine objektorientierte Anwendung, so würde sich auch ein objektorientiertes Datenbanksystem als Speicher für die Objekte anbieten. Allerdings haben sich

objektorientierte Systeme bisher nicht auf dem Markt durchsetzen können.

Die meisten Anwendungen speichern ihre Daten derzeit in relationalen Datenbanksystemen. Sie sind in ihrer Entwicklung ausgereift und auf dem Markt weit verbreitet.

Allerdings kommt es beim Einsatz relationaler Systeme als Datenspeicher für Anwendungen zum sogenannten Impedance Mismatch. Dieser Begriff steht für das Aufeinandertreffen zweier unterschiedlicher Programmierparadigmen: dem Programmierparadigma der Anwendung und dem relationalen Paradigma der Datenbank. So sind Programmiersprachen satzorientiert und je nach gewählter Sprache imperativ oder objektorientiert. Bei der von relationalen Datenbanken verwendeten Anfragesprache SQL3 handelt

es sich hingegen um eine mengenorientierte und deklarative Sprache. Hinzu kommt,

daß die Relationenalgebra der Datenbank durch Anwendung der Mengenlehre mathematisch erfaßbar ist. Auch die Typsysteme unterscheiden sich. So ist der Entwickler dafür verantwortlich, beide Systeme geeignet zu überbrücken und eine funktionierende

Anbindung bereitzustellen.

In den vergangenen fünf Jahren hat sich die Technik des objektrelationalen Mappings

entwickelt, um speziell objektorientierte Anwendungen unter Vermeidung des Impedance Mismatch an relationale Datenbanken anzubinden.

Das relationale Modell

Im Relationenmodell werden Daten in Tabellen gespeichert. Eine Zeile in einer Tabelle

wird Datensatz oder Tupel genannt, die Menge aller Tupel einer Tabelle heißt Relation.

Die Informationen eines Datensatzes werden in Feldern oder Attributen organisiert. Das

Relationenschema definiert alle Felder für die Relationen einer Tabelle. Diese Definition

umfaßt einen Namen sowie einen Datentyp für jedes Feld. Die Tabellen einer relationalen

Datenbank können zudem in verschiedenen Beziehungen zueinander stehen.

Für die eindeutige Identifizierung eines Datensatzes innerhalb einer Tabelle wird der

Primärschlüssel verwendet. Dieser kann aus einem oder mehreren Attributen des Datensatzes bestehen. Beziehungen werden über Fremdschlüssel hergestellt.

3

SQL: Structured Query Language

14

2.2 Objektpersistenz

Das objektorientierte Modell

Die objektorientierte Pogrammierung (OOP) ist ein modernes Programmierparadigma.

Viele der heute verwendeten Programmiersprachen sind entweder von Grund auf objektorientiert (Java, Smalltalk) oder wurden um objektorientierte Konzepte erweitert (Basic, Pascal) [GK03]. Objektorientierte Programmierung soll zu robusten, fehlertoleranten und wartungsfreundlichen Programmen führen. Im folgenden sollen die wichtigsten

Konzepte kurz vorgestellt werden.

In der objektorientierten Programmierung wird mit einem hohen Grad der Abstraktion

gearbeitet. So wird zwischen Konzeption und Umsetzung, also Klasse und Objekt unterschieden (nach [GK03]). Eine Klasse stellt einen abstrakten Datentyp dar und faßt Daten

und die Methoden, die auf diesen Daten operieren, zusammen. Die in älteren Programmiersprachen wie C und Pascal realisierte Trennung zwischen Daten und Funktionen

fällt weg. Die Daten (Attribute) sollen zudem nur über die zur Verfügung gestellten

Methoden zugänglich sein. Zu diesem Zweck muß die Signatur einer Methode nach

außen bekannt sein. Sie besteht aus einem Namen, einem Rückgabewert sowie einer Parameterliste. Dadurch kommt es zu einer vollständigen Kapselung, die die eigentliche

Implementierung einer Klasse vor der Umgebung verbirgt. Eine Klasse faßt die Eigenschaften gleichartiger Objekte zusammen und gilt somit als Bauplan für Objekte. Ein

konkretes Objekt entsteht durch Instantiierung einer Klasse. Das Objekt4 erhält eine eindeutige Identität und hat zu jeder Zeit einen bestimmten Zustand, der durch die Werte

der Attribute gegeben ist.

Das Konzept der Vererbung bringt Klassen in eine „ist-ein“-Beziehung. Das bedeutet,

daß eine Klasse von einer Oberklasse abgeleitet werden kann. Diese Unterklasse erbt alle Eigenschaften der Oberklasse und kann weitere Eigenschaften definieren. Durch Vererbung kann eine Klassenhierarchie aufgebaut werden, die von abstrakten zu immer

konkreteren Klassen führt. Oberklassen gelten in einer solchen Hierarchie als Generalisierung der Unterklassen. Umgekehrt gelten die Unterklassen als Spezialisierung der

Oberklassen. Bei der Vererbung wird zwischen Einfachvererbung und Mehrfachvererbung unterschieden. Bei der Einfachvererbung hat jede Klasse höchstens eine direkte

Oberklasse, bei der Mehrfachvererbung kann eine Klasse beliebig viele direkte Oberklassen besitzen.

Ein weiteres Konzept der Objektorientierung ist der Polymorphismus. Er beschreibt die

Möglichkeit, Methoden einer Klasse zu überschreiben oder zu überladen. Erbt eine Klasse eine Methode von der Oberklasse, so kann sie die Implementierung dieser Methode

entweder unverändert übernehmen oder eine eigene Implementierung zur Verfügung

stellen. Letzteres wird als Überschreiben bezeichnet. Hierbei ändert sich nur die Implementierung einer Methode, nicht jedoch die Signatur. Zur Laufzeit führt der Compiler

eine Typüberprüfung durch und führt in Abhängigkeit vom ermittelten Typ eines Objekts die entsprechende Methode aus (späte Bindung). Es ist auch möglich, Methoden

mit gleichen Namen, aber unterschiedlichen Parameterlisten zur Verfügung zu stellen.

Man spricht dann von überladenen Methoden.

Aus Vererbung und später Bindung folgt auch die Substituierbarkeit von Objekten. So

4

auch: Instanz

2 | Grundlagen

15

kann ein Objekt überall dort eingesetzt werden, wo eigentlich ein Objekt einer Oberklasse erwartet wird. Dies ist möglich, da ein Objekt alle Eigenschaften der Oberklasse

erbt. Der Compiler ermittelt durch die eben genannte Typüberprüfung zur Laufzeit den

richtigen Datentyp und führt eine aufgerufene Methode entsprechend aus.

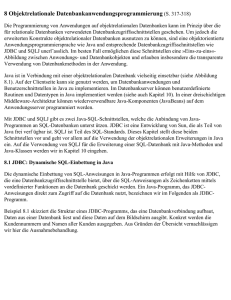

Objektrelationales Mapping

Aus der Darstellung von Daten im relationalen und objektorientierten Modell lassen

sich einige Gemeinsamkeiten erkennen (siehe [OTS02]). So definiert das Relationenschema die Struktur von Datensätzen, so wie eine Klasse die Struktur von Objekten definiert.

Die Daten eines relationalen Datensatzes werden in den Feldern des Relationenschemas

gespeichert, die Daten eines Objekts in dessen Attributen. Der Datentyp eines Feldes

ist ebenso unveränderlich (statisch) wie der Datentyp eines Objektattributs. Auch Beziehungen können sowohl in relationalen Datenbanken als auch in einem objektorientierten Datenmodell realisiert werden. Ein Datensatz referenziert andere Datensätze über

Fremdschlüssel, Objekte nutzen hierfür Referenzen.

Abbildung 2.1: Relationenmodell vs. Klasse

Beide Modelle weisen jedoch auch einige signifikante Unterschiede auf. So dienen relationale Datenbanken lediglich der Speicherung von Daten. Sie sind nicht in der Lage,

Methoden oder Vererbungshierarchien zu speichern. Auch komplexe Beziehungen können nicht ohne weiteres dargestellt werden. Beziehungen zwischen Tabellen sind immer

unidirektional. Hingegen kann im objektorientierten Modell eine Beziehung auch bidirektional, also von zwei Seiten aus navigierbar, sein.

Prinzipiell ist es also möglich, Objekte auf relationale Strukturen abzubilden. Diese Abbildung wird objektrelationales Mapping (O/R-Mapping) genannt. Dabei wird genau festgelegt, wie die Daten eines persistenten Objekts und auch seine Beziehungen zu anderen

persistenten Objekten in einer relationalen Datenbank abgebildet werden. Im Normalfall

wird eine Klasse auf eine Tabelle abgebildet, die Attribute auf Tabellenspalten. Folglich

wird ein Objekt über das Mapping mit seiner persistenten Repräsentation in der Datenbank verbunden.

16

2.3 Der Java-Standard

Werkzeuge, die diese Abbildung realisieren, werden O/R-Mapper genannt. Sie stellen eine Schicht von Java-Klassen zur Verfügung, die zwischen einer Java-Applikation und einer relationalen Datenbank zum Einsatz kommt. Die Schicht agiert als objektorientierter

Wrapper um die Datenbank und ermöglicht einer Applikation, ihre persistenten Objekte

auf ein Datenbank-Schema abzubilden.

Durch eine solche Persistenzschicht wird die Applikation vor Änderungen in der Datenbank geschützt, wodurch Änderungen am Datenbank-Schema einen geringeren Einfluß

auf die Applikation haben. Zudem bietet die Persistenzschicht eine API5 mit einer Reihe

von Methoden zum Laden, Speichern und Manipulieren von Objekten an.

2.3

Der Java-Standard

Bei Java handelt es sich nicht nur um die Programmiersprache, sondern um eine Menge von Technologien und Konzepten, die zusammen den Java-Standard ausmachen. Zu

diesem Standard gehören:

• Die Programmiersprache Java als objektorientierte Sprache mit C-ähnlicher Syntax.

Die Sprache ist an C++ angelehnt, allerdings ohne deren Komplexität, da Features

wie zum Beispiel Zeiger fehlen.

• Die Java Virtual Machine (JVM) als Interpreter für Java-Bytecode. Eine Java-Applikation ist portabel und kann auf jedem System ausgeführt werden, das über eine

JVM verfügt.

• Die Java-Plattform als Menge aller Packages und Klassen, die dem Entwickler als

APIs für seine Programme zur Verfügung stehen.

Im Jahre 1990 begann Sun Microsystems Inc. die Entwicklung von Java mit dem Ziel,

eine Software-Plattform zu schaffen, die „anywhere on the network“ und auf beliebigen

Rechnersystemen lauffähig sein sollte (vgl. [EK02]). Mittlerweile liegt Java in Version 2

vor und wurde in drei Editionen mit unterschiedlichen Zielen aufgespaltet:

• Java 2 Standard Edition (J2SE) mit allen Werkzeugen, um Java-Anwendungen

und -Applets zu entwickeln,

• Java 2 Enterprise Edition (J2EE) für netzwerkzentrische, serverseitige EnterpriseApplikationen,

• Java 2 Micro Edition (J2ME) für den Einsatz von Java auf Geräten wie Mobiltelefonen und PDAs.

Abbildung 2.2 zeigt die wichtigsten Bestandteile von J2SE und J2EE. Es wird deutlich,

daß die J2SE mit der integrierten JVM die Grundlage für die Entwicklung mit Java bildet,

die J2EE ist als Erweiterung in Form von Spezifikationen und APIs zu sehen. Während

5

API: Application Programming Interface, Programmierschnittstelle

2 | Grundlagen

17

für Anwendungen auf J2SE-Basis lediglich die JVM für die Ausführung notwendig ist,

benötigt man für Enterprise-Applikationen einen Applikationsserver.

Ausgehend von der J2SE mit der integrierten JVM bietet J2EE zusätzliche Technologien für komplexe, verteilte Enterprise-Applikationen an. Dazu gehören unter anderem

Enterprise JavaBeans, Servlets, Java Naming and Directory Interface (JNDI), Java Messaging Service (JMS), Java Transaction API (JTA) und JavaMail.

"

#

"

!

Abbildung 2.2: Komponenten von J2SE und J2EE

Java-Komponentenmodelle

Komponentenmodelle wurden von Sun entwickelt, um die Verteilung, Erweiterung und

Pflege von Software zu vereinfachen. Eine Software-Komponente soll benutzerdefinierten Code durch generische, wiederverwendbare Module ersetzen (vgl. [JS01]). Hierbei

definiert das Komponentenmodell die Struktur einer Software-Komponente. Die Plattformunabhängigkeit von Java ermöglicht, daß eine einmal entwickelte Komponente auf

verschiedenen Systemen einsetzbar ist, solange dort eine Java-Umgebung verfügbar ist.

Diese Austauschbarkeit wird außerdem durch die Konfigurierbarkeit von Komponenten gewährleistet. Das Verhalten von fertigen Komponenten wird nicht durch Eingriff in

den Code, sondern über Konfigurationsparameter angepaßt. So können selbstentwickelte Komponenten mit zugekauften Komponenten zu einer Applikation zusammengefügt

werden.

Beispiele für Komponentenmodelle sind Applets (Browser), Servlets und Java Server

Pages (Webserver) sowie Enterprise JavaBeans (EJB-Server). In Klammern angegeben ist

jeweils der zur Ausführung nötige Container. Dieser Container stellt eine Laufzeitumgebung für Komponenten zur Verfügung. Eine Komponente wird dann im sogenannten

Kontext des Containers ausgeführt.

18

2.4 Die Extensible Markup Language

Bei allen Komponentenmodellen sind eine Reihe von Interfaces definiert, die von den

Komponenten implementiert werden müssen. Diese Interfaces enthalten Callback-Methoden, die dem Container das Management des Objekt-Lebenszyklus sowie die Benachrichtigung der Komponente über Methodenaufrufe ermöglichen.

Vor- und Nachteile von Java

Die wichtigsten Vorteile von Java sind Plattformunabhängigkeit, Sicherheit und Robustheit. So bietet die Sprache Java moderne objektorientierte Sprachkonzepte und bleibt

trotz umfangreicher API einfach und kompakt, da auf Mehrfachvererbung und Operatorüberladung verzichtet wurde. Eine hohe Sicherheit wird unter anderem durch den

Verzicht auf Zeigerarithmetik und den Einsatz einer virtuellen Maschine gewährleistet.

So ist ausgeschlossen, daß eine Java-Applikation ein System zum Absturz bringen kann.

Lediglich die virtuelle Maschine, in der die Applikation läuft, kann abstürzen. JavaApplikationen liegen nicht als nativer Maschinencode vor, sondern als Bytecode. Dadurch sind Java-Applikationen portabel und können auf beliebigen javafähigen Plattformen ausgeführt werden.

Der am häufigsten genannte Nachteil ist noch immer die geringere Ausführungsgeschwindigkeit von Java-Applikationen gegenüber Programmen aus anderen Sprachen.

Da Java-Applikationen in Bytecode vorliegen und nicht in Maschinensprache, muß die

Java Virtual Machine diesen zur Laufzeit interpretieren und ausführen. In den letzten

Jahren wurden die sogenannten Just In Time Compiler eingeführt, die den Bytecode zur

Laufzeit in Maschinensprache übersetzen und so vor allem bei häufig ausgeführten Codeblöcken zu einer merklichen Erhöhung der Geschwindigkeit führen.

2.4

Die Extensible Markup Language

Bei der Extensible Markup Language - kurz XML - handelt es sich um eine textbasierte Beschreibungssprache. Es soll hier kurz auf die wichtigsten Eigenschaften von XML

eingegangen werden, da alle im Verlauf der Arbeit vorgestellten Werkzeuge mehr oder

weniger extensiv XML einsetzen, um notwendige Information zu speichern.

Die Entwicklung von XML begann im Jahre 1996, im Jahre 1998 wurde die XML-Spezifikation in der Version 1.0 vom World Wide Web Consortium (W3C) zum Standard

erhoben. Seitdem hat sich XML zur zentralen Technologie der Datenrepräsentation in

Java-Systemen entwickelt. Im Jahr 2000 folgten dann einige Detailverbesserungen und

Präzisierungen des Standards (vgl. [Se01], [Mc01]).

XML ist eine sogenannte Metasprache, mit der weitere Sprachen definiert werden können. Dazu gehören unter anderem HTML6 , WML7 und SVG8 . Die wichtigste Eigenschaft

von XML ist die Strukturierung der Daten durch eigene Tags und Attribute. Dabei definiert der Standard weder Tags noch Grammatik, sondern lediglich die allgemeine Syn6

HTML: Hypertext Markup Language

WML: Wireless Markup Language

8

SVG: Scalable Vector Graphics

7

2 | Grundlagen

19

tax. Dadurch ist XML hochflexibel und erweiterbar und der Inhalt der Daten kann unter

Beachtung der Struktur beliebig definiert werden.

Der Standard beschreibt zwei grundlegende Konzepte: Zum einen muß ein XML-Dokument wohlgeformt sein; das bedeutet, daß jeder geöffnete Tag einen dazugehörigen

schließenden Tag besitzen muß und die Schachtelungsreihenfolge nicht durchbrochen

werden darf. Ein XML-Dokument ist also genau dann wohlgeformt, wenn es eine korrekte Syntax in Bezug auf die Spezifikation hat. Zum anderen kann ein XML-Dokument

gültig sein, das heißt, es gehorcht einer Document Type Definition (DTD). Die DTD ist

Bestandteil der XML-Spezifikation und definiert die Grammatik eines XML-Dokuments,

also die Menge der erlaubten Tags und Attribute sowie mögliche Einschränkungen der

Attributwerte. Wenn ein XML-Dokument also eine DTD spezifiziert und deren Regeln

folgt, so ist es ein gültiges XML-Dokument.

Das folgende Beispiel zeigt ein einfaches, wohlgeformtes XML-Dokument, das eine externe DTD einbindet und somit auch gültig ist:

<?xml version="1.0" encoding="iso-8859-1" ?>

<!DOCTYPE locations SYSTEM "locations.dtd">

<locations>

<location>

<name>Falkensee</name>

<position latitude="52.5667" longitude="13.1" />

<zip>14612</zip>

</location>

</locations>

Jedes XML-Dokument besteht aus einem Kopf mit Steueranweisungen für Parser9 und

dem eigentlichen Inhalt. Die erste Zeile jedes XML-Dokuments enthält eine XML-Anweisung, die neben der Version als optionales Attribut das Encoding enthält, also mit

welchem Zeichensatz das Dokument verfaßt ist. Standardeinstellung ist UTF-8, werden

deutsche Umlaute verwendet, so muß ISO-8859-1 angegeben werden. Die nächste Anweisung gibt den Dokumenttyp sowie den Typ und den Pfad zur DTD an. Dabei steht

SYSTEM für eine im lokalen Dateisystem abgelegte DTD, PUBLIC für eine öffentlich zugängliche DTD, die dann über einen vollständigen URI10 angegeben wird. Zwischen

dem öffnenden und schließenden Tag des Wurzelelements stehen dann die eigentlichen

Daten.

Da es sich bei XML um kein proprietäres Dateiformat handelt, sondern um reinen Text,

ist einer der Vorteile von XML die Plattformunabhängigkeit, da solche Dateien auf jeder

Plattform gleichartig ausgewertet werden können. Als Folge ergeben sich als weitere

Vorteile die hohe Skalierbarkeit sowie die immer stärker werdende Verbreitung. Es ergeben sich allerdings auch zwei Nachteile: Zum einen fehlt ein Sicherheitskonzept, da

9

10

Programm, das XML-Dateien verarbeitet

URI: Uniform Resource Indicator

20

2.4 Die Extensible Markup Language

XML textbasiert ist. Zum anderen enthält jedes XML-Dokument aufgrund seiner Struktur einen erheblichen Overhead an nicht nutzbaren Daten.

Java & XML

Aus den vorangegangenen Abschnitten wird klar, warum Java und XML so gut zusammenarbeiten: Während Java portablen Code liefert, der auf jedem Betriebssystem mit

einer JVM läuft, steuert XML portable Daten bei (nach [Mc01]). Beide Technologien sind

standardisiert, außerdem ist Java die Sprache mit der größten Unterstützung für die Verarbeitung von XML durch eine Vielzahl von Werkzeugen und APIs.

Erst durch den Einsatz beider Technologien werden Anwendungen flexibel und können

plattformunabhängig eingesetzt werden.

3 | Enterprise JavaBeans

Bei Enterprise JavaBeans (EJBs) handelt es sich um ein verteiltes, transaktionales, serverseitiges Komponentenmodell speziell für Geschäftsanwendungen. Enterprise JavaBeans

sind die zentralen Komponenten der Java 2 Enterprise Edition und werden in einer formalen Spezifikation beschrieben. Neben den EJBs selbst beschreibt diese Spezifikation

auch detailliert die Umgebung und die zur Verfügung stehenden Dienste wie Transaktionen, Sicherheit, Persistenz und Namensdienst. Auf der Basis der Spezifikation können

Applikationsserver implementiert werden, welche den installierten EJBs die genannten

Dienste zur Verfügung stellen.

Version 1.0 der EJB-Spezifikation wurde im März 1998 veröffentlicht und im Dezember

1999 durch Version 1.1 aktualisiert. Im August 2001 wurde Version 2.0 verabschiedet,

sie bietet wesentliche Verbesserungen und Erweiterungen. Basierend auf der Version 2.0

[EJB2] soll im Rahmen dieses Kapitels ein kurzer Einblick in die Komponenten der Spezifikation gegeben werden. Allerdings soll der Fokus auf der Realisierung der Persistenz

innerhalb dieses Komponentenmodells liegen.

3.1

Die EJB-Architektur

Die EJBs als Kernkomponenten der EJB-Spezifikation stellen den Clients serverseitige

Geschäftslogik in Form von Interfaces zur Verfügung. Enterprise JavaBeans werden in einem EJB-Container installiert (deployt), der ihnen die Laufzeitumgebung zur Verfügung

stellt. Er verwaltet die installierten Instanzen, steuert ihren Lebenszyklus und bietet jeder

Komponente über Schnittstellen den Zugang zu weiteren installierten Diensten an. Zu

diesen Diensten gehören, wie eingangs erwähnt, unter anderem ein Transaktionsdienst

(via JTA), Datenbankzugriff (via JDBC) und Messaging (via JMS). Zusammen mit weiteren Containern ist der EJB-Container Bestandteil eines J2EE-konformen Applikationsservers. Der Server hat die Aufgabe, alle Container mit grundlegender Funktionalität wie

z.B. Namensdienst, Fehlermanagement, Prozeßmanagement und Lastausgleich zu versorgen. Außerdem gewährleistet er Skalierbarkeit, Verfügbarkeit und die Anbindung an

die Kommunikations-Infrastruktur (nach [BG02], [DP02]).

Für die Entwicklung und den Einsatz von EJBs definiert die Spezifikation außerdem Szenarien und Rollen, um die Entwicklung von Anwendungen für die Beteiligten zu vereinfachen [BG02]. Zu diesen Rollen gehören unter anderem der Bean-Entwickler, der die

eigentliche Entwicklung einer Komponente und ihrer Geschäftslogik übernimmt, der

22

3.2 Programmier-Restriktionen

Anwendungs-Assembler, der verfügbare Komponenten zu einer Anwendung zusammenstellt sowie der Deployer, der eine J2EE-Anwendung in einem dafür vorgesehenen

J2EE-Applikationsserver installiert.

3.2

Programmier-Restriktionen

Damit die Portabilität von EJBs gewahrt bleibt und eine EJB in jedem EJB-Container

installiert werden kann, muß der Bean-Entwickler laut Spezifikation einige Restriktionen

beachten.

• Der schreibende Zugriff auf statische Variablen ist untersagt, daher sollten alle statischen Variablen in einer EJB als final deklariert werden.

• Eine EJB darf keine Anweisungen zur Thread-Synchronisation benutzen. Ebensowenig darf eine EJB eigene Threads starten oder stoppen.

• Eine EJB darf keine AWT1 -Funktionalitäten benutzen, um Ausgaben zu realisieren

oder Eingaben von der Tastatur zu lesen.

• Die Benutzung des Packages java.io zum Lesen und Schreiben von Dateien ist

untersagt.

• Die Nutzung von Teilen des Packages java.security, um Sicherheitsrichtlinien

zu beeinflussen, ist verboten.

• Das Setzen einer Socket-Factory, die Erzeugung von Sockets und das Akzeptieren

von Verbindungen auf Sockets ist verboten.

• Die Nutzung der Reflection API, um Informationen über Klassen zu erhalten, ist

untersagt.

• Eine EJB darf die Laufzeitumgebung nicht beeinflussen. Das bedeutet, sie darf

keinen Classloader erzeugen oder benutzen, keinen Security-Manager setzen, die

JVM nicht anhalten und die Ein-/Ausgabestreams nicht verändern.

• Eine EJB darf keine nativen Bibliotheken laden.

• Eine EJB darf das Schlüsselwort this nie als Argument oder Rückgabewert eines

Methodenaufrufs nutzen.

3.3

Bestandteile einer EJB

Eine Enterprise JavaBean ist nicht nur eine einfache Java-Klasse, sondern kann sich je

nach Art aus mehreren Komponenten zusammensetzen (siehe auch Tabelle 3.2). Hierzu

gehören:

1

Abstract Windowing Toolkit

3 | Enterprise JavaBeans

23

• Home-Interface

Das Home-Interface bietet Methoden für die Verwaltung des Lebenszyklus sowie

Lokalisierungsdienste an.

• Komponenten-Interface

Das Komponenten-Interface dient als Schnittstelle zu den Geschäftsmethoden einer Bean.

• Bean-Klasse2

Die Bean-Klasse enthält die Implementierung der Geschäftslogik. Jede Methode,

die in einem der beiden zuvor genannten Interfaces deklariert ist, enthält eine korrespondierende Methode in der Bean-Klasse.

• Deployment-Deskriptor

Der Deployment-Deskriptor enthält die Konfiguration der Bean, unter anderem alle zur Bean gehörigen Interfaces sowie Informationen über das Verhalten der Bean

in Bezug auf Transaktionen und Sicherheit.

Home- bzw. Komponenten-Interface können als lokale oder Remote-Interfaces vorliegen. Vor der EJB 2.0-Spezifikation war der Zugriff auf eine Bean nur über Remote-Interfaces möglich. Erst mit Version 2.0 der EJB-Spezifikation kamen lokale Beans und damit

lokale Interfaces hinzu. Sie vermeiden den Kommunikationsaufwand, der bei Remote

Beans durch RMI-IIOP3 entsteht.

Auf lokale Beans kann nur lokal von anderen Beans oder Webkomponenten wie Servlets, JSPs oder Taglibs zugegriffen werden, nicht jedoch von entfernten Clients. Lokal

bedeutet in diesem Zusammenhang, daß der Client in der gleichen Java Virtual Machine

laufen muß, wie die lokale Bean, auf die er zugreifen möchte. Tut er dies nicht, so handelt

es sich um einen entfernten Client, der dann auch die Remote-Interfaces für den Zugriff

auf eine Bean benutzen muß.

Bei CMP-Entity Beans sind lokale Interfaces die Voraussetzung für die Realisierung von

Beziehungen.

Bei der Installation einer EJB im EJB-Container - dem sogenannten Deployment - erzeugt

der Container mit Hilfe der zur Bean gehörigen Interfaces konkrete Klassen. Aus dem

Home-Interface wird das Home-Objekt erzeugt, das als Factory für die Bean-Instanz dient.

Die meisten Container erzeugen für eine installierte EJB genau ein Home-Objekt, auf das

alle Clients zugreifen. Aus dem Komponenten-Interface wird das EJB-Objekt erzeugt,

welches als Wrapper für die Bean-Instanz dient. Hier wird der Container meist genau so

viele Objekte erzeugen, wie Clients verbunden sind (nach [BG02]).

Mit den erzeugten Home- bzw. EJB-Objekten fängt der Container alle Aufrufe an die

Bean ab und kann so vor der Weiterleitung an die eigentliche Bean-Instanz Dienste des

Systems ausführen. Ein Client greift also zu keiner Zeit direkt auf eine Bean-Instanz zu,

sondern immer über das Home- oder EJB-Objekt.

2

3

auch: Bean-Implementierung

RMI-IIOP: Remote Method Invocation over Internet Inter-Orb Protocol

24

3.3 Bestandteile einer EJB

Abbildung 3.1: Bestandteile einer EJB

3.3.1

Das Home-Interface

Das Home-Interface dient als Factory einer Bean, das heißt, mit Hilfe dieses Interfaces

können Instanzen der Bean vom Client erzeugt werden. Hierzu stellt das Interface eine

Reihe von Create-Methoden mit unterschiedlichen Signaturen bereit, die aber alle mit

dem Präfix create... beginnen müssen. Jede im Home-Interface deklarierte CreateMethode muß in der Bean-Klasse eine korrespondierende Methode haben. Der Rückgabewert einer Create-Methode ist das Komponenten-Interface der Bean, bei einer lokalen

Bean das lokale Komponenten-Interface.

Auch das Entfernen einer Bean geschieht über das Home-Interface. Hierzu steht die Methode remove() bereit, die jedoch nicht explizit deklariert werden muß, da sie vom Interface EJBHome bzw. im Falle einer lokalen Bean vom Interface EJBLocalHome geerbt

wird.

Es folgt ein Code-Beispiel für das Home-Interface einer Bean. Da dieses vom Interface

EJBHome erbt, handelt es sich um ein Remote Home-Interface, womit jede deklarierte Methode in ihrer throws-Klausel mindestens RemoteException deklarieren muß;

bei Create-Methoden kommt zusätzlich CreateException hinzu. Methoden lokaler

Beans werfen keine RemoteExceptions, da diese Beans nicht über RMI-IIOP kommunizieren.

3 | Enterprise JavaBeans

25

public interface LocationEntityHome extends EJBHome {

public LocationEntity create(Long id, String name)

throws CreateException, RemoteException;

}

Der Container stellt beim Deployment das Home-Objekt zur Verfügung, welches das

Home-Interface implementiert. Dieses Home-Objekt wird innerhalb des EJB-Servers instantiiert, an den Namensdienst gebunden und somit den Clients als Factory für die

Enterprise Bean verfügbar gemacht. Um eine Bean-Instanz zu erzeugen oder aufzufinden, sucht ein Client zunächst im Namenskontext das Home-Interface und kann danach

über das erhaltene Objekt mit der Bean arbeiten.

3.3.2

Das Komponenten-Interface

Das Komponenten-Interface enthält alle Geschäftsmethoden einer Bean, die vom Client

aufgerufen werden können.

Alle deklarierten Geschäftsmethoden müssen eine entsprechende Methode mit übereinstimmender Signatur in der Bean-Klasse haben. Außerdem dürfen als Parameter und

Rückgabewert nur primitive oder serialisierbare Datentypen verwendet werden.

Handelt es sich um eine Remote Bean, so erbt das Komponenten-Interface vom Interface

javax.ejb.EJBObject. Alle deklarierten Methoden müssen außerdem eine RemoteException in ihrer throws-Klausel deklarieren. Handelt es sich um eine lokale Bean,

so erbt das Komponenten-Interface von javax.ejb.LocalObject.

public interface LocationEntity extends EJBObject {

public Long getId();

public String getName();

public void setName(String name);

}

Die serverseitige Implementierung des Komponenten-Interfaces ist das EJB-Objekt. Dieses holt sich der Client zunächst über den Aufruf einer Create-Methode aus dem HomeInterface der Bean. Anschließend kann er auf die Geschäftsmethoden der Bean zugreifen.

Dabei soll noch einmal darauf hingewiesen werden, daß der Client nie eine Referenz auf

die Bean-Instanz erhält, sondern nur auf das EJB-Objekt. Ruft der Client eine Geschäftsmethode auf, so delegiert der Container diesen Aufruf vom EJB-Objekt zur Bean-Instanz.

3.3.3

Die Bean-Klasse

Die Bean-Klasse enthält die eigentliche Applikationsfunktionalität. Sie implementiert

abhängig von der Art der Bean eines der Interfaces SessionBean, EntityBean oder

26

3.3 Bestandteile einer EJB

Gruppe

Präfix

Create-Methoden

Finder-Methoden

Home-Methoden

Select-Methoden

ejbCreate...()

ejbFind...()

ejbHome...()

ejbSelect...()

Tabelle 3.1: Spezielle Methoden der Bean-Klasse

MessageDrivenBean (siehe Tabelle 3.2). Diese Interfaces enthalten unter anderem Callback-Methoden, die vom Container aufgerufen werden, um den Lebenszyklus einer

Bean-Instanz zu verwalten.

Neben den Callback-Methoden sind alle in den Home- bzw. Komponenten-Interfaces deklarierten Methoden in der Bean-Klasse mit ihren Implementierungen vorhanden. Keines dieser Interfaces wird jedoch direkt implementiert. Alle speziellen Methoden in der

Bean-Klasse beginnen mindestens mit dem Präfix ejb. Hierzu zählen die in Tabelle 3.1

aufgezählten Methoden sowie ejbActivate(), ejbPassivate() usw. Lediglich Geschäftsmethoden, die in den Komponenten-Interfaces deklariert wurden, sind ohne Präfix mit gleicher Signatur in der Bean-Klasse implementiert.

Das folgende Beispiel zeigt eine mögliche Bean-Klasse zu den in den beiden vorangegangenen Abschnitten definierten Interfaces (gekürzt um die Callback-Methoden des

Containers):

public class LocationEntityBean implements EntityBean {

public Long create(Long id, String name) { ... }

public Long getId() { ... }

public void setId(Long id) { ... };

public String getName() { ... };

public void setName(String name) { ... };

}

Da die Bean-Klasse das Interface javax.ejb.EntityBean implementiert, handelt es

sich um eine Entity Bean. Neben der im Home-Interface deklarierten Create-Methode

sind die Geschäftsmethoden aus dem Komponenten-Interface vorhanden. Nicht aufgeführt ist die Methode setEntityContext(), die vom implementierten Interface geerbt wird. Durch diese Methode erhält die Bean-Klasse den Kontext vom Container und

kann ihn in einem Instanzattribut speichern. Ähnliche Methoden existieren für Session

Beans und Message Driven Beans ebenfalls. Während alle Methoden in den RemoteInterfaces in ihrer Signatur mindestens RemoteException deklarieren, entfällt die Deklaration in der Bean-Klasse.

3 | Enterprise JavaBeans

3.3.4

27

Der Deployment-Deskriptor

Der Deployment-Deskriptor enthält die Konfiguration einer oder mehrerer Enterprise

JavaBeans. Diese umfaßt die Angabe aller zur Bean gehörigen Interfaces sowie der BeanKlasse, Referenzen zu anderen EJBs, Sicherheitsrollen usw. Mit den Konfigurationsangaben wird auch das Verhalten der Bean in Bezug auf Transaktionen kontrolliert.

Der Deployment-Deskriptor liegt im XML-Format vor und ist somit zwischen den unterschiedlichen benutzten Plattformen und Werkzeugen portabel.

<ejb-jar>

<enterprise-beans>

<session />

<entity>

<ejb-name>LocationEJB</ejb-name>

<home>LocationHome</home>

<remote>Location</remote>

<local-home>LocationEntityLocalHome</local-home>

<local>LocationEntityLocal</local>

<ejb-class>LocationEntityBean</ejb-class>

[...]

</entity>

<message-driven />

</enterprise-beans>

<assembly-descriptor />

</ejb-jar>

Das Wurzelelement enthält ein Element <enterprise-beans>, in dem alle Enterprise

JavaBeans mit ihren Konfigurationsdaten enthalten sind. Dabei existiert für jede Art EJB

ein eigenes Element. Mindestangaben für eine EJB sind ein eindeutiger Name für die

Komponente (<ejb-name>) und die Bean-Klasse (<ejb-class>). Abhängig davon, ob

eine EJB lokale und/oder Remote-Interfaces anbietet, werden diese in entsprechenden

Elementen angegeben: <home> für das Remote Home-Interface, <remote> für das Remote Komponenten-Interface, <local-home> für das lokale Home-Interface, <local>

für das lokale Komponenten-Interface. Der Name der zugehörigen Klasse bzw. des zugehörigen Interfaces muß in allen Fällen vollqualifiziert angegeben werden.

Unterhalb des optionalen <assembly-descriptor>-Elements können Sicherheitsrollen und Transaktionsattribute definiert werden sowie Angaben zur Zugriffskontrolle für

Methoden gemacht werden.

3.4

Arten von EJBs

Die EJB 2.0 Spezifikation definiert drei Arten von Enterprise JavaBeans: Session Beans, Entity Beans und Message Driven Beans. Eine Session Bean bietet einen Dienst in Form von

28

3.4 Arten von EJBs

Geschäftsmethoden an und liegt in einer von zwei Varianten vor: als Stateless Session Bean oder als Stateful Session Bean. Eine Stateless Session Bean ist zustandslos und kann von

mehreren Clients gleichzeitig benutzt werden. Eine Stateful Session Bean speichert einen

Zustand und wird mit genau einer Client-Sitzung assoziiert. Eine Entity Bean repräsentiert ein persistentes Objekt mit seinen Daten und Zugriffsmethoden. Die Verwaltung

der Persistenz kann von der Bean selbst übernommen werden oder dem EJB-Container

überlassen werden. Eine Message Driven Bean stellt einen Nachrichtenempfänger dar,

der auf asynchrone Nachrichten reagiert. Tabelle 3.2 gibt einen Überblick über die Arten

von Enterprise JavaBeans sowie deren Aufgabe und Bestandteile.

Session Beans und Entity Beans können vom Container bei Bedarf aus dem Hauptspeicher entfernt und in den sekundären Speicher ausgelagert werden. Dies geschieht

entweder bei Speichermangel oder nach einem bestimmten Timeout. Der Vorgang des

Auslagerns wird laut Spezifikation als Passivierung bezeichnet. Derart ausgelagerte EJBs

werden durch Aufruf einer Geschäftsmethode durch den Client wieder reaktiviert, also im Hauptspeicher wiederhergestellt. Dieser Prozeß wird als Aktivierung bezeichnet.

Um eine EJB über die Passivierung bzw. Aktivierung zu benachrichtigen, stehen die

Callback-Methoden ejbPassivate() und ejbActivate() zur Verfügung. Der Container ruft ejbPassivate() unmittelbar vor der Auslagerung auf. Eine Bean sollte in

dieser Methode alle Systemressourcen freigeben, die nicht ausgelagert werden dürfen

(z.B. Datenbank-Verbindungen). Die Methode ejbActivate() wird vom Container

aufgerufen, sobald eine Bean aktiviert wurde; in ihr können dann alle bei der Passivierung freigegebenen Ressourcen wieder angefordert werden.

3.4.1

Session Beans

Eine Session Bean repräsentiert einen serverseitigen Dienst und modelliert Abläufe oder

Vorgänge der Geschäftslogik einer Applikation. Session Beans werden daher auch als

„verlängerter Arm des Clients auf dem Server“ beschrieben [EK02].

Session Beans implementieren das Interface javax.ejb.SessionBean und werden

im Deployment-Deskriptor unterhalb des Elements <enterprise-beans> deklariert.

Für Session Beans steht das Element <session> zur Verfügung, darunter erfolgen alle Angaben gemäß Abschnitt 3.3.4 sowie zusätzlich die Angabe der Ausprägung im

<session-type>-Element, gültige Werte sind Stateful und Stateless.

<session>

[...]

<session-type>Stateless</session-type>

</session>

Stateful Session Beans

Stateful Session Beans werden verwendet, um eine Client-Sitzung zu verwalten und sitzungsbezogene Aufgaben auszuführen. Wenn ein Client eine Stateful Session Bean instantiiert, so folgt daraus eine eindeutige Zuordnung der Session Bean-Instanz zum entsprechenden Client [BG02]. Die Bean-Instanz ist für den Client dann exklusiv verfügbar

3 | Enterprise JavaBeans

29

Session Bean

Entity Bean

Zweck

Prozeß für einen Client

Ausprägung

Stateless, Stateful

gemeinsame

Nutzung

Stateful

Session

Bean einem Client

zugeordnet;

bei Stateless Session Beans keine

Zuordnung

transient, Lebenszyklus durch Client

bestimmt

Darstellung von Daten, Objekt im persistenten Speicher

Bean

Managed

Persistence,

Container

Managed

Persistence

gemeinsame Nutzung durch mehrere

Clients

Persistenz

HomeInterface

KomponentenInterface

DeploymentDeskriptor

Bean-Klasse

Bean-Klasse

implementiert

javax.ejb.

Message

Driven

Bean

Nachrichtenempfänger

-

keine direkte Zuordnung zu Clients

transient,

„stirbt“

bei Container-Terminierung

lokal, remote

persistent, Zustand

bleibt im persistenten Speicher auch

nach

ContainerTerminierung erhalten

lokal, remote

lokal, remote

lokal, remote

nein

ja

ja

ja

ja

SessionBean

ja, abstrakt bei CMP

EntityBean

ja

MessageDrivenBean

nein

Tabelle 3.2: Überblick über Enterprise JavaBeans (nach [BG02], [EK02])

30

3.4 Arten von EJBs

und speichert die Zustandsinformationen der Client-Sitzung. Der Client bestimmt den

Lebenszyklus der ihm zugeordneten Session Bean-Instanz; die Lebensdauer ist meist auf

die Dauer der Client-Sitzung begrenzt.

!" #

!" #

Abbildung 3.2: Lebenszyklus einer Stateful Session Bean (nach [BG02], [EK02])

Eine Session Bean kann eine beliebige Anzahl von Create-Methoden mit unterschiedlichen Parametern besitzen, die der Initialisierung des Zustands dienen.

Methodenaufrufe des Clients werden in den Zuständen bereit und bereit in TX entgegengenommen, eine Session Bean kann also einen Methodenaufruf innerhalb einer Transaktion ausführen.

Stateless Session Beans

Stateless Session Beans speichern keine Zustandsinformationen, daher kann ein beliebiger Client eine beliebige Instanz aus dem Pool benutzen. Der EJB-Container hält für

diesen Zweck meist eine bestimmte Anzahl von Instanzen bereit, die von mehreren Clients geteilt werden. Es kann aber nur ein Client eine Methode zu einer bestimmten Zeit

ausführen.

Der Lebenszyklus einer Stateless Session Bean ist vergleichsweise einfach. Es existieren

nur zwei Zustände: nicht existent und bereit. Da keine Zustandsverwaltung stattfindet,

werden Stateless Session Beans auch nicht passiviert: Muß Speicher freigegeben werden,

so werden einfach Instanzen aus dem Pool gelöscht. Zu einem Datenverlust kommt es

nicht.

Neben einer normalerweise parameterlosen Create-Methode besitzt eine Stateless Session Bean eine Reihe von Geschäftsmethoden, denen aufgrund des nicht vorhandenen

3 | Enterprise JavaBeans

31

Abbildung 3.3: Lebenszyklus einer Stateless Session Bean (nach [BG02], [EK02])

Zustands alle für die Ausführung nötigen Parameter übergeben werden; man kann eine Stateless Session Bean also mit einer Java-Klasse vergleichen, die statische Methoden

anbietet.

3.4.2

Entity Beans

Entity Beans werden benutzt, um persistente Objekte darzustellen; die häufigste Anwendung ist die Repräsentation von Daten einer relationalen Datenbank-Tabelle, wobei eine

einfache Entity Bean genau eine Zeile der Relation darstellt.

Entity Beans ermöglichen mehreren Clients den parallelen Zugriff auf transaktionsgesicherte Daten [DP02]. Sie sind also nicht wie eine Stateful Session Bean mit einer ClientSitzung assoziiert, sondern stehen allen Clients gleichermaßen zur Verfügung. Der Container ermöglicht den exklusiven Zugriff über den Einsatz von Transaktionen [DP02].

Eine Entity Bean definiert Methoden (u.a. Finder-, Home- und Select-Methoden), Attribute, Beziehungen und einen Primärschlüssel [DP02]. Sie implementiert außerdem das

Interface javax.ejb.EntityBean und kann beliebig viele Create-Methoden haben.

Zu jeder ejbCreate()-Methode in der Bean-Klasse muß jedoch eine korrespondierende ejbPostCreate()-Methode existieren. Der Rückgabewert der Create-Methode(n)

entspricht dem Datentyp des Primärschlüssels der Entity Bean.

Zusätzlich zu den Create-Methoden kann eine Entity Bean Finder-Methoden definieren,

die dem Auffinden von Entity Bean-Instanzen dienen. Wird eine Finder-Methode aufgerufen, so nutzt der Container eine Entity Bean-Instanz ohne Identität aus dem InstanzenPool. Für diesen Zweck hält der Container meist eine bestimmte Anzahl anonymer BeanInstanzen bereit.

Finder-Methoden werden im Home-Interface unter Verwendung des Präfixes findBy

deklariert und haben eine korrespondierende Methode in der Bean-Klasse, die mit dem

Präfix ejbFindBy beginnt. Alle Finder-Methoden müssen zudem eine Ausnahme vom

Typ FinderException deklarieren. Mindestens eine dieser Finder-Methoden muß deklariert werden: findByPrimaryKey(). Sie dient dem Auffinden genau einer Instanz

anhand des Primärschlüssels.

Während die im Home-Interface deklarierten Finder-Methoden das Komponenten-Interface (also das EJB-Objekt) als Rückgabewert haben, liefern die Implementierungen in

der Bean-Klasse den Primärschlüssel an den Container. Finder-Methoden, die mehr als

ein Ergebnis liefern, haben als Rückgabewert Collection oder Set. Die Anwendung

32

3.4 Arten von EJBs

von Set schließt Duplikate in der Ergebnismenge aus, entspricht also einem SELECT

DISTINCT.

Der Container nutzt den oder die ermittelten Schlüssel anschließend, um ein oder mehrere neue EJB-Objekte zu erzeugen. Durch den Aufruf einer Finder-Methode werden

folglich keine Bean-Instanzen erzeugt, sondern nur EJB-Objekte, die den Primärschlüssel enthalten. Die zugehörige Bean-Instanz wird erst erzeugt, wenn beispielsweise ein

Client eine Methode des EJB-Objekts aufruft (Lazy Initialization). Der Container sorgt außerdem dafür, daß pro Datenbankzeile nur eine Entity Bean-Instanz vorhanden ist.

Der eigentliche Zweck der Finder-Methoden ist somit lediglich das Ermitteln der Primärschlüssel-Daten aus der Datenbank.

Die Deklaration einer Entity Bean erfolgt im Deployment-Deskriptor unterhalb des Elements <entity>. Es erfolgen alle Angaben gemäß Abschnitt 3.3.4 sowie abhängig von

der Art der Persistenzverwaltung (siehe Abschnitt 3.5). Außerdem anzugeben ist, ob die

Bean reentrant sein soll oder nicht; gültige Werte des Elements <reentrant> sind True

und False.

Der Lebenszyklus

Der Lebenszyklus einer Entity Bean weist einige wichtige Unterschiede zum Lebenszyklus einer Session Bean auf. Abbildung 3.4 stellt alle Zustände des Lebenszyklus inklusive der Übergänge dar.

Abbildung 3.4: Lebenszyklus einer Entity Bean (nach [BG02], [EK02])

Nachdem eine Entity Bean-Instanz erzeugt wurde, handelt es sich um eine anonyme

Instanz, die der Container in einem Pool bereithält, damit Clients beispielsweise FinderMethoden aufrufen können. Wenn eine Create-Methode aufgerufen wird, erzeugt der

Container eine neue Zeile in der Datenbank und verbindet eine Bean-Instanz mit einer

3 | Enterprise JavaBeans

33

Bean-Identität. Ab diesem Zeitpunkt repräsentiert die Bean die persistenten Daten in der

Datenbank und befindet sich im Zustand bereit.

Wird die Methode remove() aufgerufen, so wird nicht wie bei Session Beans die Instanz aus dem Container entfernt, sondern zunächst die repräsentierte Zeile aus der Datenbank gelöscht. Anschließend wird die Bean-Instanz wieder als anonyme Instanz in

den Pool überführt.

Die Auslagerung von Entity Beans erfolgt ähnlich wie bei Session Beans mit Hilfe der

Methoden ejbPassivate() und ejbActivate(). Die Passivierung entspricht hierbei jedoch nicht der Auslagerung in einen Sekundärspeicher, sondern der Trennung der

Bean-Identität von einer Bean-Instanz und Rückführung der Bean-Instanz in den Pool

als anonyme Entity Bean-Instanz. Diese Instanz steht dann wieder für den Aufruf von

Finder-Methoden zur Verfügung.

Der Primärschlüssel

Jede Entity Bean besitzt ein oder mehrere Attribute, die zum Primärschlüssel gehören.

Der Primärschlüssel dient als eindeutiger Identifikator für eine Bean-Instanz. Eine Instanz kann immer über die Methode findByPrimaryKey(Object pk) aufgefunden

werden. Diese Methode wird vom Home-Objekt zur Verfügung gestellt. Außerdem stellt

der Kontext die Methode getPrimaryKey() zur Verfügung, mit welcher der Wert des

Primärschlüssels ermittelt werden kann. Somit kann jede Entity Bean immer mit ihrem

Home-Objekt und dem Primärschlüssel identifiziert werden. Man bezeichnet das HomeObjekt zusammen mit einem konkreten Wert des Primärschlüssels auch als Bean-Identität

[DP02].

Handelt es sich um einen zusammengesetzten Primärschlüssel, also einen Schlüssel, zu

dem mehrere Attribute der Entity Bean gehören, so müssen diese Attribute zusätzlich

in einer sogenannten Primärschlüsselklasse zusammengefaßt werden. Darin hat jedes Attribut den gleichen Namen und Datentyp wie in der Entity Bean. Außerdem muß diese Primärschlüsselklasse das Interface Serializable sowie die Methoden equals()

und hashCode() implementieren.

Die Primärschlüsselklasse einer Entity Bean wird mit ihrem vollqualifizierten Namen

im <prim-key-class>-Element des Deployment-Deskriptors angegeben. Für nichtzusammengesetzte Primärschlüssel gibt das Element <primkey-field> das Attribut

einer CMP-Entity Bean an, welches den Primärschlüssel enthält. Dabei müssen die Datentypen von Attribut und Primärschlüsselklasse übereinstimmen.

<entity>

<primkey-field>id</primkey-field>

<prim-key-class>java.lang.Long</prim-key-class>

[...]

</entity>

Im Normalfall obliegt der Bean-Klasse die Erzeugung eines Primärschlüssels für eine

Instanz. Die meisten EJB-Container bieten für CMP-Entity Beans einen Key-Generator

an.

34

3.4 Arten von EJBs

Das Session Facade Pattern

Entity Beans können ebenso wie Session Beans als lokale oder Remote Beans realisiert

werden. Handelt es sich allerdings um CMP-Entity Beans, die zudem auch noch in Beziehungen zueinander stehen, so müssen sie als lokale Beans vorliegen. Damit sind sie

von entfernten Clients aus nicht mehr erreichbar. Als Lösung bietet sich das sogenannte

Session Facade Pattern an, welches eine Session Bean als Vermittler zwischen Clients und

lokalen Entity Beans nutzt. Man spricht hierbei von einer sogenannten Session Fassade

(siehe Abbildung 3.5).

Beim Client kann es sich um einen lokalen oder entfernten Client handeln. Er benutzt

die Session Bean, um indirekt auf die lokalen Entity Beans zuzugreifen.

Abbildung 3.5: Prinzip einer Session Fassade

Damit eine Bean auf eine andere Bean zugreifen kann, muß zunächst im DeploymentDeskriptor die lokale Referenz deklariert werden. Dies geschieht unterhalb des Elements

<ejb-local-ref>. Es muß ein eindeutiger Name für die Referenz angegeben werden

(<ejb-ref-name>), dieser wird später beim Lookup der Bean verwendet. Außerdem

anzugeben ist die Art der referenzierten Bean (<ejb-ref-type>, im Falle einer Session

Fassade also eine Entity Bean), das Home- und Komponenten-Interface sowie der Name der EJB, die referenziert wird. Dieser Name muß mit dem übereinstimmen, der im

Element <ejb-name> der referenzierten Bean angegeben ist.

<session>

<ejb-name>StorageEJB</ejb-name>

<ejb-local-ref>

<ejb-ref-name>ejb/LocationEntity</ejb-ref-name>

<ejb-ref-type>Entity</ejb-ref-type>

<local-home>LocationLocalHome</local-home>

<local>LocationLocal</local>

<ejb-link>LocationEJB</ejb-link>

3 | Enterprise JavaBeans

35

</ejb-local-ref>

[...]

</session>

Die Session Bean hält üblicherweise Referenzen zu den Home-Objekten der verwendeten Entity Beans und kann diese auf die übliche Art und Weise benutzen.

public class StorageBean implements SessionBean {

private LocationEntityLocalHome locationHome;

public void ejbCreate() throws CreateException {

Context ctx = new InitialContext();

this.locationHome = (LocationEntityLocalHome)

ctx.lookup("java:comp/env/ejb/LocationEntity");

}

public void deleteLocation(Long id) {

this.locationHome.remove(id);

}

}

3.4.3

Message Driven Beans

Message Driven Beans (MDBs) sind transaktionale, zustandslose, serverseitige Komponenten, die JMS-Nachrichten empfangen und verarbeiten.

Eine MDB besitzt keine Home- und Komponenten-Interfaces, sondern besteht nur aus

einer Bean-Klasse und einem Deployment-Deskriptor. Damit kann ein Client auch nicht

über einen JNDI-Lookup und RMI auf eine solche Bean zugreifen, sondern nur über

das Absenden von Nachrichten per JMS. Client und MDB sind also völlig unabhängig

voneinander, da der Client den oder die Nachrichtenempfänger nicht kennt.