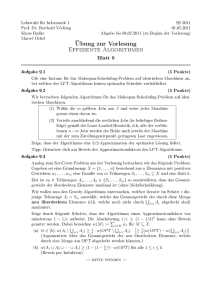

Effiziente Algorithmen

Werbung