Adaptive Music: Musik, egal ob in Filmen oder Spielen, besitzt

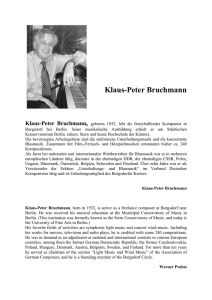

Werbung

Adaptive Music: Musik, egal ob in Filmen oder Spielen, besitzt außerordentliche Ausdruckskraft und Feinsinn. Sie ermöglicht es Inhalt auf emotionaler, nicht intellektueller Ebene, zu vermitteln. Spannung kann erzeugt oder beseitigt werden, Vorgriffe auf das nähere Geschehen durch Einsatz von „Character Themes“, also Assoziationen durch die Musik mit bestimmten Charakteren, sind beispielsweise möglich. Ziel ist es nun Musik an das aktuelle Geschehen und an den Inhalt im Spiel anzupassen. Definition: Adaptive Music beinhaltet ein System welches bedeutsam unterschiedliche Ausführungsversionen eines Stücks generiert. Lineare Musik besitzt nur eine repräsentative Form (Notenspiegel), welche nachgeahmt wird. Diese Art Interpretation eines Stücks führt von Musiker zu Musiker zu unterschiedlichen Ausführungsformen, welche jedoch alle möglichst nahe am Ideal liegen sollten. Bei Adaptive Music hingegen entstehen die Ausführungsunterschiede auf Grund der Konstruktion bzw. des Designs! Ein Music System gibt nach der Spezifikation von Ereignissen eine Art Handlungsvorschrift vor. Es wird von zuvor spezifizierten Eingabeparametern gesteuert und hängt also von umgebenden Interaktionen ab. Hierbei sind das exakte Timing und/oder die Sequenz und/oder die Anzahl und/oder die Anwesendheit und/oder die Werte der Inputparameter nicht vorbestimmt und werden erst zur Laufzeit ermittelt. Es wird davon ausgegangen, dass die aktuellen ausführungsspezifischen Ereignisse einen bedeutsamen Grad an Unbestimmtheit haben. Zu aller letzt stehen die traditionelle musikalische Stimmigkeit und die musikalische Gestaltung im Vordergrund, das generierte Stück soll so klingen, als ob es linear komponiert worden wäre. „Music Design Document“ Das „Music Design Document“ ist Teil des „Game Design Document“ und sollte von Beginn der Entwicklung eines Spiels verfasst und im weiteren Verlauf erweitert werden. Sinn und Zweck ist es die Ideen des Composers und des Game Designers zusammen zusetzten um aus kreativen Visionen zu technischen Lösungen zu gelangen. Vor dem Verfassen des „Music Design Document“ sollten folgenden Fragen geklärt werden: • Welche Teile des Spiels sollen Musik enthalten? • Welcher Musikstil ist am besten für das zu entwickelnde Spiel • Wann soll die Musik umgebend, wann intensiv sein? • Wie sollen die Übergänge der Musik klingen? • Sind “Character Themes” angemessen? Folgende Überschriften sollte ein ausgearbeitetes “Music Design Document“ enthalten: • „Music Direction“ – Stil der Musik, Produktionskosten, Abgrenzung der • • • • • Stimmungen „Themes“ - Gedanken über „World Themes”, „Character Themes”, Musik die auf einer Meta Ebene beeinflusst „Functionality and Adaptability“ – Verhalten der Musik verhalten, Grad an Anpassungsfähigkeit der eingesetzt wird „Technical Requirements“ – „Tools” und Techniken die verwendet werden oder entstehen sollen „Integration and Implementation“ – beinhaltet Kommunikation der „game engine“ mit dem „Music System“, Techniken für die Implementierung der Musik „Production Process“ –Implementierung des Spiels,Gewinnerzeugung, Qualitätssicherung Music System: Aufgabe des „Music System“ ist die Kommunikation und Zusammenarbeit mit der „Game Engine“. Anweisungen der „Game Engine“ an das „Music System“ führen zur Änderung der Musik, dadurch dass das „Music System“ nach Erhalt der Informationen durch die „Game Engine“ passende Schritte einleiten kann und eine Handlungsvorschrift vorgibt. Wichtig ist dass das „Music System“ ständig den eigenen Status übermittelt. Änderungen der Musik durch die „Game Engine“ können durch folgende Situationen ausgelöst werden: „Location based Triggers, Game-State Triggers, NPC AI Triggers, Player Character Triggers, Event Triggers”. Es besteht entweder die Möglichkeit, ein auf dem Markt erhältliches System zu verwenden (Direct Music, Miles Sound System), was jedoch ein Mühsames einarbeiten zur Folge hat, oder von Grund auf ein neues Music System, wiederum in Zusammenarbeit mit dem Composer, aufzubauen. Techniken: „Adaptive Audio Technology“ ist ein Begriff, der die Reaktion von Ton und Musik auf das „Gameplay” umfasst. Man befindet sich noch immer in einer frühen Phase der Entwicklung, welche Technik für ein Spiel verwendet wird hängt in erste Linie von dem Spiel selbst und von den Entscheidungen des Composers und des Designers ab. Vorhanden ist ein Spektrum von Musik die linear und „Pre-Rendered“ ist bis Musik die vollständig „Game-Rendered“ ist. Für die lineare Eigenschaft, werden üblicherweise „Wave-Files“ eingesetzt: Es ist möglich alle Instrumente, Tools und Techniken in ein „Wave-File“ aufzunehmen, was wiederum zu hohen Produktionswerten führt. Des Weiteren ist der Klang eines „Wave-Files“, dadurch dass es pre-rendere ist meist äußerst gut. Um eine erhöhte Anpassungsfähigkeit zu erzielen ist es möglich ein „Wave-File“ in sogenannte „Wave-Lets“ zu unterteilen. Die höchste Anpassungsfähigkeit kann mit „Midi-Files“ erzielt werden, da hierbei eine Note als manipulierbares Datenteil angesehen wird. Geschwindigkeit, Harmonie und Instrumentation sind extrem schnell änderbar. Ein Nachteil von „Midi“ ist der zwangsläufig benötigte Einsatz von plattformabhängigen „Custom Instrument Banks“ da es oft von Nöten ist langwierig nach Instrumenten, die der eigenen Vorstellung entsprechen, zu suchen. „Harmonic System“: Durch Änderung der Tonart einer „Music Cue“ in Echtzeit durch die „Game Engine“ wird Variation erzielt, Stimmungswechsel sind ebenfalls schnell und einfach möglich. Wichtig ist das die harmonischen Änderungen einer „Music Cue“ ständig verfolgt werden, damit neue „Cues“ in Einklang zur aktuell abgespielten Musik beginnen können. Mit Hilfe von „Run-Time Mixing and Effects“ ist es möglich, zur Laufzeit die Lautstärke zu verändern, Wechsel zw. Instrumenten vorzunehmen und Hall und Verzögerungen vorzunehmen. Ziel der „Musical Variation“ ist es, einen „Replay Value“ dadurch zu erreichen, dass sich die abgespielte Hintergrundsmusik wahllos verändert. Es ist beispielsweise möglich, dass das „Music System“ ein zufälliges „Wave-File“ auswählt, auf einer tieferen Ebene könnte zusätzlich wieder wahllos einer von verschiedenen „Parts“ eines Instruments zum Einsatz kommen. Übergangstechniken: Die Koordinierung und Synchronisation von verschiedenen „Music Cues“, sprich der Einsatzzeitpunkt der Musik kann entweder geschichtet („Layered“) oder sequentiell stattfinden. Einfache Techniken für Übergänge von einer „Cue “ in eine andere sind beispielsweise Stille zw. zwei „Cues“, ein „Cross-Fade“, eine direkte Verbindung oder eine extra „Cues“ zur Überlappung. Grundsätzlich muss das „Music System“ immer bereit auf Änderungen der auszuspielenden Sounds sein. Übergänge können jeder Zeit stattfinden, die Schwierigkeit besteht darin, dass immer die Gefahr für den Spieler vorhanden ist, nach schlechten Übergängen aus dem „Gameplay“ herausgerissen zu werden. Des Weiteren gibt es die „Cue-to-Cue Transission“ bei der die aktuelle „Music Cue“ bis zur eigenen nächsten Grenze spielt, dann beginnt eine neue. Diese Technik ist sehr einfach, kann jedoch abrupt wirken. Das „Layering“ zielt darauf ab, dass die Instrumentation der momentan abgespielten Musik vergrößert bzw. verkleinert wird. Hierbei liegt der Vorteil in der Kontinuität, schnelle Übergänge sind jedoch nicht umsetzbar. Eine Übergangsmatrix findet Verwendung wenn man in speziellen Spielsituation einen perfekten Übergang für nötig hält. Ziel ist es dass je zwei Elemente aus der Matrix passend ineinander übergehen können. Zur Erstellung der Matrix ist die Zusammenarbeit des Designers mit dem Composer von äußerst wichtig, da dies eine langwierige Arbeit sein kann. Real-Time Sound Synthesis: Der Grundgedanke ist es, die Entstehung und Ausbreitung von Schallwellen nachzuvollziehen, um ein realistisches Abbild der Geräuschkulisse zu erreichen. Sounds oder Töne entstehen dadurch, dass Oberflächen nach Aufprall von Schallwellen beginnen zu vibrieren. Liegt diese Vibration im Bereich von ca. 20- 20000 Hz so ist die neu entstandene Schallwellen für den Menschen wahrnehmbar. Anforderungen an eine solche sogenannte „Physically Based Sound Synthesis“ sind eine „Physics Engine“, da das „Sound System“ über die Kollisionsgeometrie informiert werden muss, und eine hohe Rechenleistung. „Physically Based Sound Synthesis“ ist davon abhängig, wie Objekte kollidieren und wo der Aufprall stattfindet ebenso wie von den Eigenschaften des Materials und der Geometrie der Objekte. Diskrete Annäherungen an die Geometrie eines Objekts und die direkte Anwendung der Bewegungslehre ermöglicht es die Modellierung der Vibrationen der Oberfläche eines Objekts nachzuvollziehen. Als Eingabe erhält man die Geometrie eines Objekts in Form eines Netzt bestehend aus Eckpunkten und verbindenden Kanten. Die Eckpunkte des Netzes werden durch Punktmassen, die Kanten durch gedämpfte Federn ersetzt (Vortragsfolie 25). Ein mathematisches Gleichungssystem, das „Feder-Masse System“ (Spring-Mass System), entsteht, welches dazu dient, die sogenannten „Vibbration Modes“ eines Objekts zu modellieren (Vortragsfolie 26). Diese „Vibration Modes“ werden durch das Beobachten der Veränderung des Abstandsvektors r (zw. den Punktmassen) in Abhängigkeit von der Zeit t, berechnet. Ein „Vibration Mode“ ist eine Sinuskurve mit einer festen Dämpfrate, mischt man nun alle „Vibration Modes“ eines Objekts zu bestimmten Anteilen, so erhält man Schallwellen bzw. die Töne, die durch die Oberflächenvibration entstanden sind. Um nicht alle Vibrationsmodi mischen zu müssen nützt die Methode der „Mode Compression“ die menschliche auditive Wahrnehmung aus (Vortragsfolie 31). Dabei werden nahe beieinander liegende Frequenzen (der verschiedenen Vibrationsmodi) zusammengefasst, um die Effizienz bei der Synthese der Sounds eines Objekts zu erhöhen. Eine weitere Methode um Rechenleistung einzusparen ist das „Quality Scaling“. Die Idee hierbei ist es die Aufmerksamkeit auf Objekte aus dem Vordergrund zu legen, indem jedes Objekt eine Skalierung der momentanen Soundqualität und Lautstärke erhält.