Erweiterung des verteilten Datenspeichersystems Cassandra um

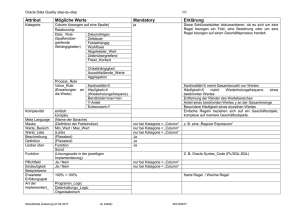

Werbung

Leibniz Universität Hannover

Fakultät für Elektrotechnik und Informatik

Institut für Praktische Informatik

Fachgebiet Datenbanken und Informationssysteme

Erweiterung des verteilten

Datenspeichersystems Cassandra um eine

Indexunterstützung

Bachelorarbeit

im Studiengang Informatik

Jan Kantert

Erstprüfer:

Prof. Dr. Udo Lipeck

Zweitprüfer:

Dr. Hans Hermann Brüggemann

Betreuer:

Prof. Dr. Udo Lipeck

Abgabedatum: 12 August 2010

2

Inhaltsverzeichnis

1 Einleitung

5

1.1

Übersicht . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5

1.2

Motivation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6

1.3

Aufgabenstellung . . . . . . . . . . . . . . . . . . . . . . . . . . .

6

1.4

Aufbau der Arbeit . . . . . . . . . . . . . . . . . . . . . . . . . .

7

2 Grundlagen

9

2.1

Cassandra . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9

2.2

Datenmodell . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11

2.3

Konfigurationsdatei . . . . . . . . . . . . . . . . . . . . . . . . . .

13

2.4

Datenverteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . .

14

2.5

CAP-Theorem . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

16

2.6

Konsistenz . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

17

2.7

Operationen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

20

2.7.1

24

Beispiele . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3 Konzept

27

3.1

Übersicht . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

27

3.2

Index-Speicherformat . . . . . . . . . . . . . . . . . . . . . . . . .

28

3.3

Korrektheit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

30

3.4

Index definieren . . . . . . . . . . . . . . . . . . . . . . . . . . . .

32

3.5

Index aktualisieren . . . . . . . . . . . . . . . . . . . . . . . . . .

33

3.6

Index abfragen . . . . . . . . . . . . . . . . . . . . . . . . . . . .

34

3.7

Index (neu-)aufbauen . . . . . . . . . . . . . . . . . . . . . . . . .

35

3.8

Index überprüfen/reparieren . . . . . . . . . . . . . . . . . . . . .

35

3

4

4 Implementierung

4.1 Externes Interface . . . . . . .

4.2 Internes Interface . . . . . . .

4.3 Beispiele . . . . . . . . . . . .

4.4 Konfigurationsinterface . . . .

4.5 Datenstrukturen zur Laufzeit

4.6 Schreiboperationen . . . . . .

4.7 Leseoperationen . . . . . . . .

4.8 Wartungsoperationen . . . . .

INHALTSVERZEICHNIS

.

.

.

.

.

.

.

.

37

38

39

41

42

44

45

47

49

.

.

.

.

.

.

.

.

51

51

53

53

54

54

55

55

55

6 Fazit

6.1 Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.2 Vergleich zu relationalen Datenbankmanagementsystemen . . . . .

6.3 Ausblick . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

57

57

58

59

Literaturverzeichnis

62

Abbildungsverzeichnis

63

Eidesstattliche Erklärung

65

A Konfigurationsdatei cassandra.yaml

67

B Thrift Interface

75

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

5 Experimente und Tests

5.1 Benchmarks . . . . . . . . . . . . . . . . . .

5.1.1 Schreiben ohne Index . . . . . . . . .

5.1.2 Schreiben mit Index . . . . . . . . .

5.1.3 Lesen auf Datensäte . . . . . . . . .

5.1.4 Lesen mit Index auf einen Datensatz

5.1.5 Lesen mit Index auf 10 Datensätze .

5.1.6 Bewertung der Ergebnisse . . . . . .

5.2 Simulation hoher Latenz . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Kapitel 1

Einleitung

1.1

Übersicht

Cassandra ist ein hoch-verfügbarer, strukturierter, versionierter Schlüssel-WertSpeicher. Er ist stark auf Geschwindigkeit optimiert und geht davon aus, dass

Ausfälle die Regel und nicht die Ausnahme sind. Die Konsistenz der Daten wird

zugunsten von Verfügbarkeit und Partitionstoleranz nicht immer garantiert. Ein

Cassandra-Datenspeicher besteht aus mehreren Knoten und alle Datensätze werden anhand ihres Schlüssels über eine Hashfunktion einem Knoten zugewiesen. Datensätze bestehen aus einer beliebigen Anzahl von Attributen, welche nicht durch

ein Schema definiert sind, und sie werden auf N Knoten repliziert. Unterstützt

werden lediglich grundlegende Operationen: Lesen eines Datensatzes, Schreiben

eines (Teil-)Datensatzes und Lesen von Bereichen von Datensätzen anhand des

Schlüssels. Alle Operationen werden vom Benutzer an einen Koordinator-Knoten

gesendet, welcher sich um die Ausführung auf den richtigen Knoten kümmert.

Dabei ist es möglich, anzugeben, auf wie viele Knoten direkt zugegriffen werden soll, um verschieden starke Konsistenzen zu erreichen. Es ist nicht möglich,

einen Datensatz über etwas anderes als den Schlüssel abzufragen. Mehrere Datensätze werden in einer ColumnFamily zusammengefasst, welche das schemalose

Äquivalent zu einer Tabelle in einem RDMS1 ist.

1

Relationales Datenbank Management System

5

6

KAPITEL 1. EINLEITUNG

1.2

Motivation

In relationalen Datenbanksystemen ist es im Unterschied zu Cassandra möglich

Anfragen nach beliebigen Spalten zu stellen. In vielen Anwendungsfällen ist es

sinnvoll, Datensätze effizient über den Wert eines Attributes abfragen zu können.

Dabei ist in den meisten Fällen vorher bekannt um welche Attribute es sind handeln

wird. Aktuell ist das nur durch einen ineffizienten Scan über alle Datensätze zu

realisieren. Zielsetzung der Arbeit ist es daher, einen effizienten und flexiblen

Mechanismus zu entwickeln und zu implementieren, der einen verteilten Index über

ein oder mehrere Attribute aufbaut und nutzt. Dem Benutzer soll es ermöglicht

werden effizient alle Datensätze zu einem Wert eines vorher definierten Attributs

zu finden.

1.3

Aufgabenstellung

Als Ziel der Arbeit sollen folgende Dinge erreicht werden:

• Es soll ein geeignetes Konfigurationsinterface geschaffen werden, in welchem

von einem Benutzer ein Index über eine ColumnFamily, also eine Gruppe von

Datensätzen, definiert werden kann. Dabei können die beteiligten Attribute

und der Name des Indexes gewählt werden.

• Es soll eine Methode entwickelt werden, um einen Index initial aufzubauen

und zu validieren. Eine Validierung soll die normale Nutzung des Indexes

nicht einschränken.

• Es soll ein Verfahren entworfen werden, welches bei jeder schreibenden

Operation auf ein Attribut in einer ColumnFamily den entsprechenden

Index aktualisiert. Dazu wird überprüft, ob die geschriebenen Attribute im

Index enthalten sind. Dann wird gegebenen Falles der Index aktualisiert.

Ein besonderes Augenmerk wird dabei auf die Architektur von Cassandra

gelegt.

• Es soll dem Benutzer ermöglicht werden, lesende Operationen mit Hilfe des

Indexes auszuführen. Dabei soll es möglich sein, einzelne Indexwerte oder

auch Bereiche von Werten abzufragen.

1.4. AUFBAU DER ARBEIT

7

• Der Index soll, wie andere Datensätze auch, per Hashfunktion über alle

Knoten verteilt und repliziert werden.

• Es sollen die gleichen Qualitätsanforderungen wie für normale Schreibzugriffe

auch für den Index gelten. Für jeden Zugriff wird angegeben, auf wie vielen

Knoten er mindestens erfolgen soll. Auf entsprechend vielen Knoten wird

auch der Index geschrieben. In jedem Fall soll der Index konsistent zu

den indexierten Datensätzen bleiben. Das gilt besonders bei Ausfällen von

Knoten oder von Verbindungen zwischen Knoten.

Die Implementierung erfolgt als Teil des Cassandra-Codes in Java. Falls möglich, soll sie in das nächste Cassandra Release einfließen.

1.4

Aufbau der Arbeit

In Kapitel 2 werden die Grundlagen von Cassandra erklärt. Dabei wird Cassandra in die Entwicklungslinien der NoSQL-Datenspeicher eingeordnet und die

generellen Begrifflichkeiten werden erläutert. Besonders eingegangen wird auf das

Datenmodell, die Datenverteilung und die Einschränkung der Konsistenz. Zuletzt

wird eine Übersicht über alle Operationen gegeben.

Danach wird in Kapitel 3 beschrieben, wie Indexe in Cassandra implementiert

werden sollen. Dabei muss auf die Eigenheiten von Cassandra Rücksicht genommen

werden. Es wird darauf eingegangen, welche Operationen ermöglicht werden sollen

und wie ein Index vom Benutzer erstellt werden kann. Weiterhin wird diskutiert,

wie ein Index beim Schreiben aktualisiert wird und wie es möglich ist die Daten

abzufragen. Zuletzt werden der initiale Aufbau und die effiziente Überprüfung

eines Indexes beschrieben.

In Kapitel 4 wird die konkrete Implementierung eines verteilten Indexes in

Cassandra beschrieben. Zunächst wird der generelle Aufbau von Cassandra kurz

erklärt. Danach werden das geplante Speicherformat und die Datenstrukturen zur

Laufzeit entworfen und es wird die Verarbeitung der Konfigurationsdatei erläutert.

Es wird beschrieben, wie schreibende Operationen modifiziert werden müssen,

um beim Schreiben einen Index zu aktualisieren. Anschließend wird eine sinnvolle

Implementierung für lesende Operationen auf den Datenspeicher vorgeschlagen

und kurz auf die Wartungsoperationen eingegangen.

8

KAPITEL 1. EINLEITUNG

Weiterhin wird die Implementierung in Kapitel 5 experimentell überprüft.

Dabei werden Geschwindigkeit und Durchsatz vor und nach der Implementierung

gemessen. Außerdem wird der Einfluss von großer Netzwerklatenz auf Durchsatz

und Geschwindigkeit von Schreiboperationen auf einen Index untersucht.

Kapitel 2

Grundlagen

In diesem Kapitel werden die für die Arbeit wichtigen Grundlagen von Cassandra erklärt und die zugrundeliegende, verteilte Architektur und Philosophie

erläutert. Dabei werden das Datenmodell, die Verteilung der Datensätze sowie

die Einschränkungen, welche sich daraus ergeben, erörtert. Danach wird eine

Übersicht über grundlegende Operationen gegeben und die besondere Behandlung

der Konsistenz von Daten erklärt.

2.1

Cassandra

Apache Cassandra ist ein verteiltes, strukturiertes Datenspeichersystem [14]. Als

Vorlage dienten Amazon Dynamo[12] und Google BigTable[11]. Dabei wurde

das Datenformat von Google BigTable übernommen und später etwas erweitert.

Während Google ein eigenes verteiltes Dateisystem verwendet, hat sich Amazon

für eine einfachere Verteilung per Distributed Hashtable entschieden. Der Fokus

bei Amazon liegt auf guten Antwortzeiten in E-Commerce-Anwendungen und

es wird ein einfaches Schlüssel-Wert-Datenmodell verwendet. BigTable dagegen

speichert zu jedem Schlüssel eine beliebige Anzahl an Attributen mit jeweils einem

Wert und eignet sich somit dazu, große Datenmengen zu verarbeiten und zu

analysieren. Cassandra kombiniert die strukturierte Datenhaltung von BigTable

mit der Verteilung von Dynamo und unterstützt wie Dynamo und BigTable nur

primitive Abfrageoperationen. Die meisten solcher NoSQL-Datenspeichersysteme1

1

NoSQL = Not Only SQL

9

10

KAPITEL 2. GRUNDLAGEN

unterstützen kein SQL2 als Anfragesprache und sind in der Regel auch nicht

relational.

Entwickelt wurde Cassandra von Facebook[13] zum Einsatz als Speicher für

mehrere Reverse Word Indexes3 [14, S. 5]. Aus diesem Grund wurden einige

Änderungen am von Google übernommenen Datenmodell durchgeführt und es

wurde ein besonderes Augenmerk auf gute Performance, hohe Verfügbarkeit und

Skalierbarkeit über viele einfache Knoten gelegt. Mittlerweile ist Cassandra ein

Apache Toplevel Projekt geworden und wird von mehreren großen Firmen genutzt

und weiterentwickelt.

Ähnliche Projekte sind Apache Hadoop[1] und Apache Hbase[2]. Wobei es sich

um einen Klon von Googles Dateisystem und Googles BigTable handelt. Sie eignen

sich besonders für die Analyse großer Datenmengen. Im Unterschied zu Cassandra

garantieren sie starke Konsistenz, dafür wird bei Ausfällen von einzelnen Knoten

zeitweise die Nichtverfügbarkeit einzelner Datensätze in Kauf genommen[2].

Ein Cassandra-Datenspeicher besteht aus einer Anzahl von Knoten, die zur

Laufzeit entfernt und hinzugefügt werden können. Alle Knoten besitzen die gleichen Rollen, es gibt keine Sonderrollen und keinen Single Point of Failure, also

keinen Knoten, dessen Ausfall zum Ausfall des gesamten Systems führt. Jeder

Knoten ist zugleich Speicher-Knoten und Koordinator-Knoten. Die Kommunikation funktioniert nach dem Peer-to-Peer-Modell. Das bedeutet, dass es keine

zentrale Koordinationsinstanz gibt, sondern, dass alle Knoten gleichberechtigt

sind und direkt miteinander kommunizieren [vgl. 12, S. 208], [vgl. 14, S. 3].

Die Philosophie von Cassandra besagt, dass Leseoperationen in linearer Zeit

zur Größe der zurückgegebenen Daten abgeschlossen werden. Bei Ausfällen von

Knoten ist es möglich, dass einige Bereiche zeitweise nicht zum Lesen verfügbar

sind. Allerdings schlagen Schreiboperationen niemals fehl, solange ein einziger

Knoten erreichbar ist und keine Konsistenzanforderungen gestellt werden[14].

2

SQL = Structured Query Language

Ein Index für Volltextsuche, bei dem für jedes Wort gespeichert wird, in welchen Dokumenten

es an welcher Stelle vorkommt.

3

2.2. DATENMODELL

2.2

11

Datenmodell

Während es in relationalen Datenbanksystemen mehrere Datenbanken gibt, verwendet Cassandra sogenannte Keyspaces4 . Ein Keyspace definiert einen eigenen

Namensraum für die enthaltenen Datentypen und muss beim Verbinden vom

Client, der eine Anfrage stellt, angegeben werden. Es kann beliebig viele Keyspaces

geben. In der Regel verwendet man einen Keyspace pro Anwendung.

Cassandra bietet zwei verschiedene Datentypen an: ColumnFamilies und

SuperColumnFamilies. Sie werden über ihren Schlüssel referenziert und sind

eindeutig in einem Keyspace definiert [5], [7].

Eine ColumnFamily kann mit einer Tabelle in einer relationalen Datenbank

ohne fixe Anzahl an Spalten verglichen werden und enthält eine beliebige Menge

von Attributen mit jeweils einem Wert. Die Attribute müssen nicht vorher definiert

und können bei Bedarf hinzugefügt werden. Dabei sind die Attributnamen innerhalb einer ColumnFamily eindeutig. Attribute können beliebige Werte enthalten,

die binär gespeichert werden.

Eine SuperColumnFamily enthält als Attribute eine beliebige Anzahl von

(Unter-)ColumnFamilies. Ein vergleichbarer Datentyp ist ein zweidimensionales

assoziatives Array. Alternativ kann man sich auch eine traditionelle Tabelle mit

einer beliebigen Anzahl an Spalten vorstellen, die jeweils ein Array enthalten [vgl.

14, S.1f].

Im Folgenden werden sowohl Werte zu ColumnFamilies als auch zu SuperColumnFamilies als Datensatz bezeichnet. In Beispiel 2.1 gibt es zwei ColumnFamilies Users und UserItems. Unter der ColumnFamily Users gibt es zwei

Datensätze mit den Schlüsseln a und b. Beide enthalten ein oder mehrere Attribute mit Werten. Außerdem gibt es eine SuperColumnFamily UserCars mit einem

Datensatz a. Dieser enthält zwei (Unter-)ColumnFamilies mit den Schlüsseln Auto

1 und Auto 2. Sie beinhalten jeweils wieder Attribute mit Werten. Zu jedem

Attributwert wird beim Schreiben automatisch ein aktueller Zeitstempel eingefügt.

Dieser wird intern zur Konfliktbehandlung verwendet und kann vom Benutzer

abgefragt werden.

Semantisch gesehen zeigt das Beispiel 2.1 eine kleine Benutzerdatenbank.

Die ColumnFamily Users enthält eine Liste von Benutzern mit verschiedenen

Attributen. In der Family UserItems wird die Anzahl an Gegenständen, welche

4

engl. Schlüsselraum

12

KAPITEL 2. GRUNDLAGEN

MyUserApp

Users

a

age: 27

19:10

b

age: 20

18:55

name: Hans

19:10

gender: m

19:20

UserItems

a

Autos: 2

17:10

Hunde: 5

12:00

UserCars

a

Auto 2

Auto 1

Farbe: rot

20:00

PS: 320

20:02

PS: 80

10:00

Abbildung 2.1: Beispiel Datenbestand gemäß Datenmodell von Cassandra

2.3. KONFIGURATIONSDATEI

13

zu einem Benutzer gehören, gespeichert. Dabei wird der gleiche Schlüssel wie in

der ColumnFamily Users verwendet. Jeder Attributname gibt einen Gegenstand

an, der Attributwert beschreibt die Anzahl der Gegenstände. Außerdem wurde

eine SuperColumnFamily UserCars definiert, welche verschiedene Attribute aller

Autos eines Benutzers angibt. Der Schlüssel ist hier ebenfalls der gleiche Schlüssel

wie beim Benutzer. Die Namen der enthaltenen ColumnFamilies geben die Namen

der Autos an. Die enthaltenen Attribute beschreiben jeweils die Eigenschaften

der Autos.

Das Datenmodell von Cassandra entspricht großteils dem Modell von Googles

BigTable [vgl. 11, S.2], auch der Begriff ColumnFamily wurde von Google geprägt.

SuperColumnFamilies sind eine Erweiterung in Cassandra, die dem ursprünglichen

Einsatzzweck von Cassandra als Volltextindex geschuldet sind. Weiterhin hält

Google BigTables eine einstellbare Anzahl von älteren Versionen eines Attributwertes vor und erlaubt es dem Benutzer diese abzufragen [11]. In Cassandra sind

ältere Versionen eines Wertes für den Benutzer nicht mehr sichtbar.

2.3

Konfigurationsdatei

keyspaces:

- name: MyUserApp

replication_factor: 5

column_families:

- name: Users

compare_with: BytesType

- name: UsersItems

compare_with: BytesType

- name: UsersCars

column_type: Super

compare_with: BytesType

compare_subcolumns_with: BytesType

Abbildung 2.2: cassandra.yaml Beispiel

Die Konfiguration von Cassandra und der ColumnFamilies erfolgt in einer

Konfigurationsdatei namens cassandra.yaml (Auszug mit ColumnFamilies siehe

14

KAPITEL 2. GRUNDLAGEN

Abbildung 2.2; Komplette Datei siehe Anhang A). Es handelt sich beim Inhalt um

strukturierte Daten im Yaml-Format[9], die beim Start von Cassandra eingelesen

werden. Nach einer Änderung einer ColumnFamily oder eines Keyspaces in der Datei muss das erneute Einlesen und die Verarbeitung durch den Benutzer ausgelöst

werden. Alternativ ist das Anlegen, Löschen oder Modifizieren einer ColumnFamily oder SuperColumnFamily auch über eine Wartungsoperationen möglich.

Dauerhaft werden die ColumnFamily-Definitionen intern im System-Keyspace

gespeichert.

Das oberste Element in der Konfigurationsdatei ist ein Keyspace keyspaces.

Für jeden Keyspace müssen der name und der replication factor definiert werden.

Der Name muss eindeutig sein. Der replication factor gibt an auf wie viele Knoten

N ein Datensatz zu einem Schlüssel k repliziert wird. Außerdem können unterhalb

des column families-Elements beliebig viele ColumnFamilies und SuperColumnFamilies definiert werden.

Das Format für eine ColumnFamily enthält Attribute für name, column type

und compare with. column type gibt an, ob es sich um eine SuperColumnFamily

oder eine normale ColumnFamily handelt. Wird der Parameter ausgelassen ist

der Standardwert ColumnFamily. Außerdem wird im Parameter compare with

eine Vergleichsfunktion angegeben. Sie definiert in welcher Reihenfolge die Datensätze anhand ihres Schlüssels über die Knoten und Festplatten verteilt werden.

SuperColumnFamilies besitzen zusätzlich noch ein weiteres Attribut für die Vergleichsfunktion der enthaltenen (Unter-)ColumnFamilies.

2.4

Datenverteilung

Die Verteilung der Daten wurde von Amazon Dynamo inspiriert und funktioniert

sehr ähnlich [12, S. 215f]. Alle Datensätze werden anhand ihres Schlüssels über

alle Knoten verteilt, um Skalierbarkeit und Lastverteilung zu erreichen. Zu diesem Zweck wird Partitionierung mit konsistentem Hashing verwendet. Aus dem

Schlüssel eines jeden Datensatzes wird mit Hilfe einer Hashfunktion ein Hashwert

berechnet. Standardmäßig verwendet Cassandra die md5-Funktion. Mit dem Parameter partitioner kann die Hashfunktion beeinflusst werden. Der Wertebereich

der Hashfunktion wird auf eine Ringstruktur abgebildet. Jedem Knoten wird

eine eindeutige Position auf dieser Ringstruktur zugewiesen (siehe Abbildung

2.4. DATENVERTEILUNG

15

2.3). Er ist dann für alle Hashwerte zwischen seiner Position und der Position

des nächsten Knotens zuständig. Außerdem wird jeder Datensatz auf N-1 weitere

Knoten repliziert, welche dann ebenfalls zuständig sind. Dazu werden jeweils die

nächsten N-1 Knoten nach dem ersten zuständigen Knoten auf der Ringstruktur

gewählt. Der Faktor N kann für jeden Keyspace bei der Konfiguration mit dem

Parameter replication factor eingestellt werden [vgl. 14, S. 2].

Knoten K

Knoten A

Knoten J

Knoten B

Hash(Key k)

Knoten I

Repliziert

Knoten C

Knoten H

Knoten D

Knoten G

Knoten E

N=3

Knoten F

Abbildung 2.3: Verteilung der Daten auf Knoten in einer Ringstruktur

In Beispiel 2.3 liegt der Hashwert des Datensatzes mit dem Schlüssel k auf der

Ringstruktur zwischen den Hashwerten von Knoten B und C. Damit ist Knoten

B der erste zuständige Knoten. Weiterhin wird der Datensatz auf N-1 auf B

folgende Knoten repliziert. In diesem Fall sind das die zwei Knoten C und D,

welche ebenfalls für den Hashwert zuständig sind.

Da alle Knoten nach dem Peer-to-Peer Modell kommunizieren, um voneinander

Daten abzufragen, ist es notwendig zu wissen, welche Knoten aktuell verfügbar

sind. Dazu wird eine Mitgliedsliste mit dem Status aller bekannten Knoten geführt.

16

KAPITEL 2. GRUNDLAGEN

Um bei vielen Knoten ohne großen Aufwand alle Knoten zu überwachen, wird

ein sogenanntes Gossip-Protokoll[15] verwendet. Dabei sendet jeder Knoten seine

Mitgliedsliste periodisch an einen zufällig ausgewählten Knoten. Beim Senden der

Knotenliste wird gleichzeitig überprüft, ob der Zielknoten verfügbar ist. Betritt

ein neuer Knoten den Cassandra-Cluster, so muss er nur einem Knoten bekannt

gemacht werden und wird dann im Laufe der Zeit allen bekannt. Somit haben

nicht alle Knoten immer die gleiche Sicht auf den Datenspeicher. Allerdings ist

dies aufgrund der Architektur von Cassandra kein Problem. Man kann zeigen,

dass in endlicher Zeit ein stabiler Zustand eintritt und die Mitgliedslisten aller

Knoten gleich sind, wenn man lang genug wartet [vgl 12, S. 212f], [vgl. 14, S. 3].

2.5

CAP-Theorem

Availability

Consistency

Partition Tolerance

Abbildung 2.4: Grafische Darstellung des CAP-Theorems

Das CAP-Theorem, welches 2000 von Eric Brewer aufgestellt wurde, besagt,

dass in einem verteilten System von den drei Eigenschaften Konsistenz (Consistency), Verfügbarkeit (Availability) und Partitionstoleranz (Partitiontolerance) nur

2.6. KONSISTENZ

17

maximal zwei gewählt werden können [vgl. 10]. Cassandra wählt Verfügbarkeit

und Partitionstoleranz [4]. Dies bietet den Vorteil, dass zu jedem Zeitpunkt ein

Lese- und Schreibzugriff auf den Speicher möglich ist. Jedoch können die Daten

beim Lesen eventuell veraltet sein. Der Verteilungsmechanismus von Cassandra

entspricht in etwa dem Mechanismus von Amazon Dynamo [vgl. 12, S. 207].

In der Abbildung 2.4 ist zu sehen, dass sich jeweils nur zwei Eigenschaften

überlappen. Allerdings erlaubt Cassandra, wie im nächsten Abschnitt zu sehen sein

wird, in einem gewissen Umfang die Partitionstoleranz zugunsten der Konsistenz

einzuschränken. Das widerspricht in begrenztem Umfang dem CAP-Theorem. Man

sollte die Aussage des Theorems also eher so verstehen, dass es nicht möglich ist

in einem verteilten System alle drei Eigenschaften in vollem Umfang gleichzeitig

zu gewährleisten [vgl. 8].

2.6

Konsistenz

Cassandra bietet also die Möglichkeit Datensätze mittels einer konsistenten Hashfunktion verteilt auf mehreren Knoten redundant zu speichern, um die Verfügbarkeit und Zuverlässigkeit der Daten zu erhöhen. Dabei werden Einschränkungen

der Konsistenz in Kauf genommen. Generell unterscheidet man zwischen drei

verschiedenen Konsistenzanforderungen:

• Strenge Konsistenz (strong consistency) - Wenn ein Schreibvorgang abgeschlossen ist, wird er von allen nachfolgenden Lesezugriffen zurückgeliefert.

Die Reihenfolge der Änderungen ist für alle Knoten immer gleich.

• Schwache Konsistenz (weak consistency) - Nach einem Schreibvorgang

existiert ein Zeitfenster, in dem Änderungen für nachfolgende Lesezugriffe

nicht zurückgeliefert werden. Die Reihenfolge der Änderungen kann von

Knoten zu Knoten variieren.

• Letztendliche Konsistenz (eventual consistency) - Es wird garantiert, dass in

endlicher Zeit alle Änderungen auf allen Knoten in der gleichen Reihenfolge

zurückgegeben werden.

Cassandra implementiert nur letztendliche Konsistenz. Dies hat zur Folge, dass

es während einer Schreiboperation für andere Leseoperationen ein Zeitfenster gibt,

18

KAPITEL 2. GRUNDLAGEN

in dem die Änderungen nicht immer sichtbar sind. Sie können auch auftauchen

und wieder verschwinden, aber in endlicher Zeit werden sie verfügbar sein [vgl.

16].

Für jeden Schlüssel k eines Datensatzes gibt es N zuständige Knoten (entspricht dem replication factor aus Abschnitt 2.3). Bei lesenden sowie schreibenden

Operationen ist es möglich, die Anzahl der Knoten anzugeben, auf die direkt

gelesen bzw. geschrieben werden soll. Dabei sei R die Anzahl an Knoten auf die

gelesen wird und W die Anzahl der Knoten auf die geschrieben. Wird nicht direkt

auf alle N Knoten geschrieben, erfolgt die Replikation der Daten asynchron im

Hintergrund [vgl. 14, S. 3], [vgl. 12, S. 210].

Bei lesenden und schreibenden Operationen ist es in Cassandra möglich, mit

dem Parameter consistency level anzugeben, von wie vielen Knoten die Daten

gelesen oder geschrieben werden. Folgende Werte sind für das consistency level

möglich (Siehe Anhang B):

• ONE - Es wird nur auf einen zuständigen Knoten geschrieben bzw. gelesen.

• QUORUM - Es wird auf (N/2)+1 zuständige Knoten geschrieben bzw.

gelesen. Da die Knotenanzahl in der Regel ungerade ist und N/2 abgerundet wird, überlappen sich die Knoten zweier QUORUM Operationen um

mindestens einen Knoten.

• ALL - Es wird auf alle N zuständigen Knoten geschrieben. Beim Lesen ist

ALL aktuell nicht implementiert.

• ANY - Es wird auf einen zuständigen Knoten geschrieben. Wenn dies

nicht möglich ist, wird die Schreiboperation an einen beliebigen anderen

Knoten geschickt. Sobald ein zuständiger Knoten erreichbar ist, wird die

Operation weitergeleitet und ausgeführt. Im Unterschied zu ONE schlägt

diese Operation nicht fehl, wenn kein zuständiger Knoten erreichbar ist.

Beim Lesen ist ANY nicht sinnvoll und nicht implementiert [vgl. 12, S. 212].

• ZERO - Es wird asynchron auf einen zuständigen Knoten geschrieben, wobei

nicht auf eine Rückmeldung gewartet wird. Ist kein zuständiger Knoten

verfügbar, schlägt die Operation fehl ohne, dass der Client davon etwas

bemerkt. Beim Lesen ist ZERO nicht implementiert..

2.6. KONSISTENZ

19

Allerdings ist nicht immer garantiert, dass nach Schreiboperationen folgende

Leseoperationen den aktuellen Wert lesen. Generell kann man sagen, dass nur

Konsistenz erreicht wird, wenn R + W > N gilt, also die Summe aus den Knoten,

auf die geschrieben wird, und die Knoten, auf die gelesen wird, größer als die

Anzahl der zuständigen Knoten ist. So wird garantiert, dass die Menge der Knoten,

auf die geschrieben wird, sich um mindestens einen Knoten mit der Menge der

Knoten überlappt, auf die gelesen wird[4].

Wird z.B. auf nur einen Knoten geschrieben, ist nicht sichergestellt, dass

nachfolgende lesende Operationen sofort den geschriebenen Wert lesen, wenn

sie nicht von allen zuständigen Knoten lesen. Da nicht jedem Knoten sofort

die Version des Datensatzes mit dem aktuellen Zeitstempel bekannt ist, müssen

mindestens N − W + 1 Knoten nach der aktuellen Version befragt werden, um

sicher mindestens einen Knoten mit dem aktuellen Datensatz zu erreichen. Für

viele Anwendungszwecke ist dies eine elementare Voraussetzung. Es gibt drei

Konstellationen, in denen gewährleistet werden kann, dass auf jeden Fall nach

einem abgeschlossenen Schreibvorgang aktuelle Daten gelesen werden:

• Schreiben auf alle N zuständigen Knoten mit consistency level =ALL. Lesen

von mindestens einem Knoten mit consistency level =ONE. Effizient bei

vielen Lese- und wenig Schreiboperation.

• Schreiben auf (N/2)+1 zuständige Knoten und Lesen von mindestens N/2

zuständigen Knoten, jeweils mit consistency level =QUORUM. Dies ist der

gängigste Arbeitsmodus in Cassandra.

• Schreiben auf einen zuständigen Knoten mit consistency level =ONE und

Lesen von allen N Knoten mit consistency level =ALL. Effektiv bei vielen

Schreib- und wenig Leseoperationen. Allerdings führt der Ausfall eines Knotens in den meisten Fällen zu Datenverlust. Aktuell ist diese Konstellation

nicht in Cassandra implementiert, da beim Lesen consistency level =ALL

nicht unterstützt wird.

In allen anderen Fällen wird nicht garantiert, dass nach einer Schreiboperation

sofort aktuelle Daten geliefert werden. Dabei tritt kein Datenverlust auf, allerdings

kann es eine kurze Zeit dauern, bis alle Änderungen auf allen Knoten ausgeführt

worden sind. Unter den oben genannten Bedingungen sind die Änderungen nach

20

KAPITEL 2. GRUNDLAGEN

Abschließen der Schreiboperation jedoch auf jeden Fall für alle Leseoperationen sichtbar und aufgrund letztendlicher Konsistenz ist auch die Reihenfolge

sichergestellt.

2.7

Operationen

Jede Operation wird vom Client an einen Koordinator-Knoten geschickt, welcher

sie an die zuständigen Knoten weiterleitet. Prinzipiell kann dies jeder Knoten im

Datenspeicher sein. Aufgrund der geringeren Latenz5 bei der Kommunikation ist

es idealerweise ein Knoten, welcher topologisch nah am Client ist. Um die Laufzeit

klein zu halten, verwendet man typischerweise einen Knoten im gleichen Rack

oder zumindest im gleichen Datenzentrum. Da sich die Latenz zwischen einem

Client und dem Koordinator-Knoten meist in einer ähnlichen Größenordnung

befindet wie die Latenz zwischen Koordinator-Knoten und einem Daten-Knoten,

wurde die Funktionalität zum Verbinden mit den zuständigen Knoten in Amazon

Dynamo in die Clients verlagert [vgl. 12, S.217f]. So spart man sich bei der

Kommunikation zwischen Client und Knoten einen Hop im Netzwerk und halbiert

die Latenz der Kommunikation. Direkte Kommunikation mit den Daten-Knoten

ohne Koordinator-Knoten ist in Cassandra nur in einem Javaclient verfügbar und

wird kaum verwendet.

Cassandra Clients verwenden das Thrift-Protokoll[3], um Operationen über

das Netzwerk auszuführen. Dabei handelt es sich um ein RPC-Protokoll6 , für

welches Bindings in fast allen gängigen Sprachen existieren. Es gibt ein externes

RPC-Interface, welches von Clients aufgerufen und vom Koordinator-Knoten

bereitgestellt wird. Zwischen Koordinator-Knoten und Daten-Knoten gibt es

ein weiteres Interface, welches nur primitive Speicheroperationen ermöglicht und

intern vom Koordinator-Knoten benutzt wird.

Bei jeder Operation kann der Client über den Parameter consistency level

angeben, auf wie viele Knoten direkt gelesen bzw. geschrieben werden soll. Damit

kann eine Entscheidung zwischen mehr Konsistenz oder mehr Geschwindigkeit

getroffen werden. Der Koordinator-Knoten sucht anhand der Hashfunktion die

für den Schlüssel zuständigen Knoten und verbindet sich mit ihnen. Alle Opera5

6

Zeit zwischen dem Absenden eine Anfrage und der Ankunft der Antwort

Remote Procedure Call; ermöglicht einen transparenten Methodenaufruf über das Netzwerk

2.7. OPERATIONEN

21

tionen sind nur innerhalb eines Datensatzes innerhalb einer ColumnFamily oder

SuperColumnFamily atomar.

Datensatz mit key k

Client

Koordinator Knoten

N=3

Knoten 1

Knoten 2

Knoten 3

Abbildung 2.5: Ablauf einer Schreiboperation

Bei schreibenden Operationen werden die Daten direkt an die verbundenen,

zuständigen Knoten gesendet und später asynchron auf die restlichen, zuständigen

Knoten repliziert.

Bei lesenden Operationen wird ein zuständiger Knoten nach den jeweils aktuellen Timestamps zu den angefragten Attributen eines Datensatzes zu einem

Schlüssel gefragt und gleichzeitig eine Digest-Anfrage7 an alle verbundenen zuständigen Knoten gestellt, um festzustellen, ob ein anderer Knoten ein Attribut mit

neuerem Timestamp besitzt. Dabei antworten alle Knoten mit dem Timestamp

ihrer aktuellen Version. Gibt es eine neuere Version als die vorhandene, wird

diese geholt und die vorherige verworfen. Danach wird die aktuellere Version vom

Koordinator-Knoten an alle anderen Knoten geschickt, die nicht das aktuellste Timestamp geliefert haben. So werden mögliche fehlende Daten beim Lesen repariert.

Aufgrund dieser relativ aufwändigen Kommunikation und eines Speicherformats,

welches Schreiben in konstanter Zeit und Lesen in logarithmischer Zeit ermöglicht,

sind Leseoperationen teurer als Schreiboperationen.

Wichtige Datenstrukturen für die Leseoperationen (Siehe Anhang B):

• ColumnPath - Gibt einen Pfad zu einem einzelnen Attribut column einer

ColumnFamily oder einer einzelnen SuperColumn einer SuperColumnFamily

7

Digest=Übersicht

22

KAPITEL 2. GRUNDLAGEN

super column innerhalb einer ColumnFamily column family an.

• ColumnParent - Gibt eine ColumnFamily column family und optional eine

SuperColumn super column an. Wird verwendet um alle oder einige Attribute innerhalb einer Column- oder SuperColumnFamily zu beschreiben.

• Column - Enthält Name name, Wert value und Timestamp clock eines

Attributes.

• SuperColumn - Beinhaltet eine SuperColumn einer SuperColumnFamily

mit dem Namen name und einer Liste von Attributen columns vom Typ

Column.

• ColumnOrSuperColumn - Repräsentiert ein Attribut Column oder eine

SuperColumn

• ConsistencyLevel - Ein ENUM8 mit den Werten aus Abschnitt 2.6.

• SliceRange - Beschreibt einen Bereich an Schlüsseln oder Attributnamen.

Mit start und finish werden die Grenzen angegeben. Zusätzlich kann die

Sortierung umgekehrt werden mit reversed oder die Anzahl an Datensätzen

begrenzt werden mit count.

• SlicePredicate - Gibt einen Bereich mit slice range an oder eine Liste von

Attributen mit slice range.

Cassandra unterstützt folgende einfache Operationen:

• set keyspace(string keyspace) - Setzt den Keyspace keyspace für alle folgenden Operationen.

• get(binary key, ColumnPath column path,

ConsistencyLevel consistency level ) - Lesen eines Datensatzes über den

Schlüssel key. Der Parameter column path gibt eine ColumnFamily und eine

SuperColumn oder ein Attributnamen an. Die Operation gibt ein Objekt

vom Typ ColumnOrSuperColumn zurück.

8

Enummeration; Aufzählungstyp mit endlichem Wertebereich

2.7. OPERATIONEN

23

• get slice(binary key, ColumnParent column parent, SlicePredicate predicate,

ConsistencyLevel consistency level ) - Lesen eines Teiles eines Datensatzes

über einen Schlüssel key. Der Parameter column parent gibt eine ColumnFamily an, in welcher alle Attribute, die mit dem Parameter predicate

spezifiziert sind, zurückgegeben werden. Die Operation gibt eine Liste von

ColumnOrSuperColumn Objekten zurück.

• get range slices(ColumnParent column parent, SlicePredicate predicate, SliceRange range, ConsistencyLevel consistency level ) - Lesen mehrerer Datensätze oder Teile davon über einen Schlüsselbereich range. Funktioniert

wie get slice. Zusätzlich ist es möglich mit dem Parameter range einen

Schlüsselbereich anzugeben. Bereichsabfragen sind nur möglich, wenn als

partitioner eine Hashfunktion gewählt wurde, welche die Reihenfolge der

Schlüssel beibehält. Die Operation gibt eine Liste von ColumnOrSuperColumn Objekten zurück.

• multiget slice(list<binary> keys, ColumnParent column parent, SlicePredicate predicate, ConsistencyLevel consistency level ) - Lesen mehrerer Datensätze oder Teile davon über einen Schlüssel key. Funktioniert ähnlich wie

get range slices mit dem Unterschied, dass statt eines Schlüsselbereiches mit

dem Parameter keys eine Liste an nicht zusammenhängenden Schlüsseln

angegeben werden kann. Die Operation gibt eine Liste von ColumnOrSuperColumn Objekten zurück.

• get count(binary key, ColumnParent column parent, ConsistencyLevel consistency level ) - Der Parameter column parent gibt eine ColumnFamily und

optional eine SuperColumnFamily an. Dabei wird die Anzahl der Attribute

in der Column- oder SuperColumnFamily gezählt, denen unter dem Schlüssel

key ein Wert zugeordnet worden ist und die nicht zuvor gelöscht wurden.

Die Operation gibt eine positive Ganzzahl zurück.

• insert(binary key, ColumnParent column parent, Column column, ConsistencyLevel consistency level ) - Schreiben eines Attributes column mit einem

Timestamp und einem Wert in die in column parent angegebene ColumnFamily oder SuperColumnFamily.

• remove(binary key, ColumnParent column path, Clock timestamp, Consisten-

24

KAPITEL 2. GRUNDLAGEN

cyLevel consistency level ) - Löschen eines Datensatzes oder eines Attributes

eines Datensatzes über seinen Schlüssel.

• batch mutate(map<string, Mutation> mutation map,

ConsistencyLevel consistency level ) - Modifizieren (Löschen oder Schreiben)

mehrerer Datensätze über einen Schlüssel auf einmal. Der Parameter mutation map enthält eine Liste von insert- und/oder remove-Operationen.

Dadurch, dass mehrere Operationen auf einmal ausgeführt werden, wird die

Gesamtzeit für die Ausführung geringer, da zwischen den Operationen nicht

auf eine Rückgabe gewartet wird.

Alle Operationen sind innerhalb eines Datensatzes atomar [14]. Schreibende

Operationen können nicht fehlschlagen, solange eine Verbindung zu einem beliebigen Knoten hergestellt werden kann und das consistency level auf ANY oder

ZERO gestellt ist (siehe Abschnitt 2.6). Alle Operationen und Datenstrukturen

sind in der Datei interface/cassandra.thrift definiert (Siehe dazu Anhang B).

2.7.1

Beispiele

Um die Funktion der Operationen zu verdeutlichen, werden nun beispielhafte

Operationen auf die Datensätze in Abbildung 2.6 ausgeführt. Als erstes wird mit

set keyspace(’MyUserApp’) der Keyspace gesetzt.

MyUserApp

Users

a

age: 27

19:10

name: Hans

19:10

gender: m

19:20

b

age: 20

18:55

c

age: 24

08:00

name: Jan

01:33

gender: m

15:00

d

name: Udo

17:10

gender: m

17:30

Abbildung 2.6: Beispiel Datensätze gemäß Datenmodell von Cassandra

2.7. OPERATIONEN

25

• insert(’b’, {column family = ’Users’}, {name = ’age’, value = ’20’, clock =

’18:55’}, ONE) - Erstellen von Datensatz b.

• get(’a’, {column family = ’Users’, column = ’age’}, QUORUM) - Anfrage

nach dem Attribut age unter dem Schlüssel a in der ColumnFamily Users.

Gibt ein Objekt vom Typ ColumnOrSuperColumn zurück:

{name = ’age’, value = ’27’, clock = ’19:10’}.

• get count(’a’, {column family = ’Users’}, QUORUM) - Zählt die Anzahl an

Attributen in Datensatz a. Gibt 3 zurück.

• get range slices({column family = ’Users’}, {start = ’a’, finish = ’h’},

{start=’a’, finish=’c’}, ONE) - Fragt nach allen Datensätzen in der ColumnFamily Users mit den Schlüsseln zwischen a und c. Dabei werden die

Attribute zwischen a und h abgefragt. Zurückgegeben wird die Liste:

a => {{name = ’age’, value = ’27’, clock = ’19:10’}, {name = ’gender’,

value = ’m’, clock = ’19:20’}},

b => {{name = ’age’, value = ’20’, clock = ’18:55’}},

c => {{name = ’age’, value = ’24’, clock = ’08:00’}, {name = ’gender’,

value = ’m’, clock = ’15:00’}}

26

KAPITEL 2. GRUNDLAGEN

Kapitel 3

Konzept

Die Zielsetzung der Arbeit ist es, Indexe auf dem verteilten Datenspeicher Cassandra zu implementieren. Dazu wird ein Konzept vorgestellt, welches besonders die

Eigenheiten von Cassandra berücksichtigt. Dabei soll ein Verzeichnis aufgebaut

werden, um effizient alle Datensätze mit bestimmten Attributwerten zu einem oder

mehreren festen Attributnamen zu finden. Danach wird ein Speicherformat definiert. Weiterhin werden Veränderungen im Ablauf von schreibenden Operationen

erklärt und Operationen beschrieben, die auf den Index lesen.

3.1

Übersicht

Der nahe liegende Ansatz zum Aufbauen eines Indexes ist, beim Schreiben von

neuen Datensätzen einen Eintrag in einem Verzeichnis einzufügen. Wird der Datensatz geändert, muss zuvor der alte Datensatz gelesen und der alte Eintrag im

Verzeichnis entfernt werden. Danach wird ein neuer Eintrag erstellt. Leider ist

dieser Ansatz nicht direkt geeignet, da weder Transaktionen noch Sperren von

Datensätzen in Cassandra existieren und nur einzelne Operationen innerhalb eines

einzelnen Datensatzes atomar sind. Es ist daher nicht möglich sicherzustellen,

dass bei zwei gleichzeitig stattfindenden Änderungen an einem Datensatz keine

Race Conditions bei der Indexaktualisierung auftreten, da nicht sicher entschieden

werden kann, welches der aktuellste Datensatz ist. Beide Operationen könnten

den gleichen älteren Datensatz lesen und beide den gleichen älteren Indexeintrag

löschen. Danach würden beide einen neuen Indexeintrag schreiben. Dies ist ohne

Sperren oder Transaktionen nicht zu verhindern. Als Folge wären zwei Indexein27

28

KAPITEL 3. KONZEPT

träge zu einem Datensatz vorhanden und der Index dauerhaft inkonsistent.

Es wäre nun möglich, Sperren in Cassandra zu implementieren. Allerdings

widerspräche es der Philosophie von Cassandra, dass Schreibzugriffe niemals

fehlschlagen und Leseoperationen eine lineare Laufzeit haben, da sie nun potentiell auf Sperren warten müssten. Transaktionen dagegen würden das Problem

potentiell beheben. Leider sind sie in einem verteilten System nur sehr teuer

zu implementieren und mit dem Konzept von letztendlicher Konsistenz nicht

vereinbar.

Wenn man nun davon ausgeht, dass weder Transaktionen noch Sperren verfüg-bar sind und Race Conditions wie oben gezeigt nicht hinnehmbar sind, wird

eine Möglichkeit benötigt, um das Aktualisieren des Indexes atomar vorzunehmen.

Aus diesem Grund ist es nicht möglich, den alten Datensatz vor der Änderung

zu lesen, den alten Index zu löschen und danach den neuen Datensatz und den

neuen Indexeintrag zu schreiben. Zusätzlich sind lesende Operationen aufgrund des

Speicherformats von Cassandra teurer als schreibende Operationen. Aus diesem

Grund könnte man nun das Entfernen des alten Indexeintrages unterlassen. Das

hat natürlich zur Folge, dass der Index viel mehr Einträge enthält als es passende

Datensätze gibt. Es wird also in Kauf genommen, dass veraltete Einträge im

Index vorhanden sind. Um dieses Problem zu beseitigen, wird später beim Lesen

vom Index die Korrektheit des Eintrages überprüft, indem das Timestamp des

Indexeintrages mit dem Timestamp des indexierten Attributs des Datensatzes

verglichen wird. Ist das Timestamp der Indexeintrages älter als das Timestamp

des gefundenen indexierten Attributs, wird der Indexeintrag entfernt. Ist das

Timestamp neuer so wird der Indexeintrag übersprungen, da der Datensatz

wahrscheinlich noch nicht geschrieben wurde. Sind die Timestamps gleich ist der

Eintrag korrekt und der Datensatz wird zurückgegeben.

3.2

Index-Speicherformat

Der Index wird intern als ColumnFamily mit der angegebenen Vergleichsfunktion

im gleichen Keyspace wie die indexierten Datensätze definiert. Der Schlüssel

eines indexierten Datensatzes wird als Attributname mit dem Timestamp des

Datensatzes und leerem Wert in der ColumnFamily des Indexschlüssels gespeichert.

Der Index ist damit wie jeder normale Datensatz verteilt über alle Knoten von

3.2. INDEX-SPEICHERFORMAT

29

Cassandra gespeichert.

MyUserApp

Users

a

age: 27

19:10

b

age: 20

18:55

c

age: 27

13:10

name: Hans

19:10

gender: m

19:20

UsersAgeIndex

20

b:

18:55

27

a:

19:10

c:

13:10

Abbildung 3.1: Speicherformat eines Indexes

In Beispiel 3.1 werden drei Benutzer in der ColumnFamily Users gespeichert.

Es gibt einen Index über das Attribut mit dem Namen age. Der Index wird in

der ColumnFamily UsersAgeIndex gespeichert. Zum Wert 27 des Attributes mit

dem Namen age gibt es zwei Attribute mit jeweils leerem Wert. Dabei entspricht

der Attributname dem Datensatz, auf den referenziert wird, im Beispiel also

die Datensätze mit den Schlüsseln a und c. Analog zeigt der Wert 20 auf den

Datensatz mit dem Schlüssel b. Dabei ist zu beachten, dass die Timestamps der

Indexeinträge und der Datensätze übereinstimmen. Bei Attributkombinationen

gäbe es theoretisch mehrere Timestamps, jedoch wird beim Schreiben sichergestellt,

dass immer auf alle Indexattribute gleichzeitig geschrieben wird. Daher haben in

diesem Fall alle Attribute das gleiche Timestamp und es muss nur das Timestamp

eines Attributs überprüft werden. Allerdings ist es dazu wichtig, dass wie in

Abschnitt 3.5 beschrieben, alle Schreiboperationen, welche nicht alle Attribute

eines zusammengesetzten Indexes enthalten, abgelehnt werden.

30

KAPITEL 3. KONZEPT

3.3

Korrektheit

Elementare Voraussetzung für eine Indeximplementierung ist, dass nach konkurrierenden Lese- und Schreiboperationen letztendlich ein konsistenter Zustand eintritt.

Dazu muss zu jedem Datensatz mit vorhandenem Indexattribut genau ein Indexeintrag vorhanden sein. Da alle Datensätze nur letztendlich konsistent sind und

Indexeinträge erst beim Lesen gelöscht werden, muss sichergestellt werden, dass

nur Indexeinträge gelöscht werden zu denen auf keinen Fall noch ein Datensatz

existieren kann. Wir zu einem Indexeintrag nicht der korrekte Datensatz gefunden,

wird er übersprugen und es gilt zu prüfen, ob der Indexeintrag gelöscht werden

kann, um die Überprüfung beim nächsten Lesezugriff nicht erneut durchführen zu

müssen. Es gibt drei verschiedene Fälle:

• Der referenzierte Datensatz wurde nicht gefunden. Dabei kann es sein, dass

bisher nur der Indexeintrag, aber der Datensatz noch nicht geschrieben

wurde. Alternativ kann auch der Datensatz gelöscht worden sein. Da beide

Fälle nicht unterschieden werden können, muss so lang gewartet werden bis

ausgeschlossen werden kann, dass der Datensatz geschrieben wurde. In der

Regel sollte hier eine Zeit von einem Tag verwendet werden.

• Der gefundene Datensatz hat ein älteres Timestamp als der Indexeintrag. Es

kann davon ausgegangen werden, dass der Datensatz noch nicht geschrieben

wurde und es muss gewartet werden.

• Der gefundene Datensatz hat ein neueres Timestamp als der Indexeintrag. In

diesem Fall kann der Indexeintrag sofort gelöscht werden, da das Timestamp

eines Datensatzes unter keinen Umständen wieder älter werden kann.

Um ein potentielles Problem zu demonstrieren, werden im Sequenzdiagramm

3.2 gleichzeitig eine Lese- und eine Schreiboperation auf die Datensätze in Abbildung 3.3 ausgeführt. Die schwarzen Datensätze stellen die Ausgangssituation

dar. Im Verlauf wird ein Indexeintrag von Client2 gelesen, bevor der Datensatz

zum Indexeintrag von Client1 geschrieben wurde. Beide Clients verwenden jeweils einen eigenen Koordinator-Knoten, welche mit Cassandra1 und Cassandra2

gekennzeichnet sind.

Client1 ändert im Datensatz a das indexierte Attribut age auf 20. Zuerst

wird vom Koordinator-Knoten Cassandra1 ein Indexeintrag erstellt, der für den

3.3. KORREKTHEIT

: Client1

31

: Client2

: Cassandra1

: Cassandra2

: Cassandra Backend

: Schreibe a mit age=20

: Schreibe Index von 20=a

: Lese age=20

: Lese Index von 20

: Lese a

: Lösche a in Index von 20

: Schreibe a

Abbildung 3.2: Race Condition beim Indexschreiben/-lesen

MyUserApp

Users

2.

a

age: 27 20

19:10 20:00

b

age: 20

18:55

c

age: 27

13:10

name: Hans

19:10

gender: m

19:20

1.

UsersAgeIndex

20

b:

18:55

a:

20:00

27

a:

19:10

c:

13:10

Abbildung 3.3: Datensätze für Race Condition Beispiel

32

KAPITEL 3. KONZEPT

Wert 20 auf den Schlüssel a des Datensatzes verweist (siehe 1. in Abbildung 3.3).

Zu diesem Zeitpunkt wurde der Wert und das Timestamp des Attributs age im

Datensatz a noch nicht geändert.

Gleichzeitig liest Client2 alles Datensätze zum Wert 20 vom Index. Cassandra

liest alle Indexeinträge und versucht den zugehörigen Datensatz zu lesen. Leider

existiert für den von Client1 geschriebenen Indexeintrag im Datensatz a zum

Attribut age ein älteres Timestamp. Es gilt an dieser Stelle zu überprüfen, ob der

Indexeintrag gelöscht werden kann. Laut der obigen Liste muss gewartet werden.

Würde man nicht warten und den Indexeintrag wie im Beispiel löschen, obwohl

Client1 den Datensatz später noch schreibt, gäbe es keinen Indexeintrag mehr

zum Datensatz a und der Index wäre nicht mehr korrekt. Aus diesem Grund ist

es unerlässlich das Löschen von Indexeinträgen abhängig vom Timestamp erst

nach längerer Zeit vorzunehmen, damit der Index unter allen Umständen korrekt

bleibt.

3.4

Index definieren

Als nächstes wird beschrieben, welche Informationen notwendig sind um ein

Index auf einer ColumnFamily zu definieren. Alle ColumnFamilies werden in

der Konfigurationsdatei cassandra.yaml definiert oder alternativ beim Start aus

dem System-Keyspace geladen. Beide sollen nun um einen Elementtyp für Indexe

erweitert werden. Das Element soll folgende Attribute enthalten:

• name - Muss ein im Keyspace eindeutiger Name für den Index sein.

• index type - Gibt den Namen der Indeximplementierung an, die verwendet

werden soll.

• compare with - Die Vergleichsfunktion gibt die Verteilung der Indexdatensätze über Knoten und Festplatten an und ist für Bereichsabfragen über

den Index wichtig. Entspricht den Vergleichsfunktionen auf ColumnFamilies.

• keys - Liste mit Attributnamen die indexiert werden sollen

Außerdem sollen beliebige Elemente als Optionen möglich sein, welche von der

konkreten Indeximplementierung ausgewertet werden. Die Indeximplementierung

in index type wird bei jedem Schreibzugriff auf die ColumnFamily sowie bei allen

3.5. INDEX AKTUALISIEREN

33

Lesezugriffen auf den Index aufgerufen. Die Vergleichsfunktion compare with gibt

die Verteilung der Indexdatensätze über Knoten und Festplatten an.

3.5

Index aktualisieren

Wenn auf einer ColumnFamily Indexe definiert sind, muss bei jedem Schreibzugriff

überprüft werden, ob die Indexe aktualisiert werden müssen. Da jeder Schreibzugriff zuerst an einen beliebigen Koordinator-Knoten geschickt wird, bietet es sich

an, die Indexaktualisierung auf diesem Knoten auszuführen. Für jeden Index muss

in der Indeximplementierung überprüft werden, ob eine Aktualisierung notwendig

ist und sie gegebenen Falles durchgeführt werden.

Knoten 7

Knoten 8

Knoten 9

Index

1.

N=3

Client

Koordinator Knoten

2.

Knoten 1

Knoten 2

Knoten 3

Data

Abbildung 3.4: Ablauf einer Schreiboperation mit Indexaktualisierung

In der konkreten Implementierungsidee dieser Arbeit (siehe Abschnitt 3.1) muss

lediglich überprüft werden, ob der Schreibzugriff auf alle der vorher definierten

Indexattribute schreibt und die entsprechenden Indexeinträge erstellen. Sollte

sich der Schreibzugriff nur auf einige Attribute eines Indexes erstrecken, wird die

Schreiboperation abgelehnt, da es notwendig wäre, alle fehlenden Attribute zu

lesen. Weil nicht sichergestellt werden kann, welches der aktuelle Datensatz ist, da

der Zugriff nicht atomar erfolgen kann, ist dies nicht lösbar (siehe Abschnitt 2.6).

Es ist daher zwingend nötig, bei Änderungen der Indexattribute immer auf alle

Attribute zu schreiben, selbst wenn sich nur ein einziges ändert. Dieses Problem

34

KAPITEL 3. KONZEPT

tritt nur bei Indexen über mehrere Attribute auf. Eigentlich widerspricht das

Ablehnen einer Schreiboperation der Philosophie von Cassandra, jedoch ist diese

Schreiboperation in diesem Fall als ungültig zu werten, da sie die Integrität eines

Indexes dauerhaft zerstören würde. Als Folge muss ein Anwendung immer alle

indexierten Attribute lesen, um sie dann wieder schreiben zu können.

Sind nun die Werte aller Attribute vorhanden, so wird daraus ein Schlüssel

für den verteilten Index generiert und es wird der Indexeintrag geschrieben

(siehe Abbildung 3.4). Erst wenn die Schreiboperation auf den Indexeintrag

abgeschlossen ist, kann der Datensatz selber geschrieben werden. Es ist also

die doppelte Latenz beim Schreiben zu erwarten. Trotzdem wird sichergestellt,

dass sowohl der Indexdatensatz als auch der indexierte Datensatz das gleiche

Timestamp erhalten und letztendliche Konsistenz erreicht wird.

3.6

Index abfragen

Im Gegensatz zu Anfragen an relationale Datenbanksysteme müssen in Cassandra

Anfragen vom Benutzer explizit gegen einen Index gestellt werden, da die vorhandenen Operationen (Siehe Abschnitt 2.7) nur Zugriffe über den Schlüssel eines

Datensatzes erlauben. Wie bei normalen Datensätzen gesehen, wird es auch bei

Indexabfragen möglich sein Abfragen auf einen Wert, mehrere Werte oder einen

Bereich von Werten durchzuführen. Dazu werden später in Kapitel 4 konkrete

neue Operationen vorgestellt.

Um Datensätze in einem Index abzufragen, wird wie beim Schreiben aus den

Werten der indexierten Attribute ein Indexschlüssel berechnet. Damit werden

alle Indexeinträge zu diesem Schlüssel gelesen. Das geschieht mit den aus Abschnitt 2.7 bekannten Operationen. Durch die gemachten Einschränkungen beim

Schreiben müssen alle Indexeinträge beim Lesen auf ihre Aktualität überprüft

werden. Dies geschieht durch eine Digest-Anfrage auf alle in einem Eintrag referenzierten Datensätze. Ist ein Datensatz zu einem Eintrag nicht zu finden oder

ist das Timestamp des referenzierten Datensatzes nicht gleich dem Timestamp

des Indexeintrages, wird der entsprechende Indexeintrag gelöscht und muss bei

der nächsten Abfrage nicht wieder überprüft werden. Einzige Ausnahme von

dieser Regel sind Indexeinträge, die noch sehr neu sind, da der Schreibvorgang

des indexierten Datensatzes noch nicht abgeschlossen sein muss. Alle gefundenen

3.7. INDEX (NEU-)AUFBAUEN

35

korrekten Datensätze werden zurückgegeben.

Eine Besonderheit stellen zusammengesetzte Indexe dar. Dabei müssen mehrere

Attributwerte auf einen Indexschlüssel abgebildet werden. Um Abfragen auf das

erste Attribut zu stellen, wird eine Bereichsanfrage gestellt, welches die hinteren

Teile des Schlüssels ignoriert. Eine Bereichsabfrage über den Index ist aufgrund der

Reihenfolge der Attributwerte im Indexschlüssel nur über die vordersten Attribute

effizient möglich. Wird eine Bereichsanfrage über ein anderes Attribut gestellt,

so müssen alle Werte der davor liegenden Attribute gelesen werden. Somit sind

effizient keine Einschränkungen des Bereichs für die davor liegenden Attribute

möglich. Bei der Konfiguration spielt also die Reihenfolge der Attribute von

zusammengesetzten Indexen eine wesentliche Rolle.

3.7

Index (neu-)aufbauen

Nach der Definition eines Indexes auf einer nicht-leeren ColumnFamily ist es

notwendig, einen Index initial aufzubauen. Auch nach Ausfällen kann es notwendig

sein, einen Index erneut zu initialisieren. Zuerst werden alle Indexeinträge zu dem

Index sequentiell gelöscht. Danach wird eine get range slice-Operation über den

gesamten indexierten Schlüsselraum ausgeführt und alle am Index beteiligten

Attribute abgefragt. Für jeden Schlüssel wird dann eine update index -Operation

ausgeführt. So werden alle Schlüssel im Index abgelegt. Währenddessen können

bereits normale Schreiboperationen ausgeführt werden. Leseoperationen werden

allerdings erst sicher korrekt beantwortet, wenn der Vorgang fertig ist.

3.8

Index überprüfen/reparieren

Eine Indexüberprüfung kann nach Ausfällen von Knoten oder während der Entwicklung sinnvoll sein, da sie günstiger ist als ein Neuaufbau des Indexes. Dazu

muss sichergestellt werden, dass Indexeinträge und indexierte Datensätze bijektiv

sind. Als Folge muss überprüft werden, dass jeder Verweis von Indexeintrag auf

einen Datensatz injektiv und surjektiv ist. Da beim Lesen alle ungültigen Indexdatensätze herausgefiltert werden und jeder Datensatz nur einen einzigen Schlüssel

haben kann, wird sichergestellt, dass die Funktion immer injektiv ist. Um zu

überprüfen, ob sie auch surjektiv ist, wird eine get range slice-Operation über

36

KAPITEL 3. KONZEPT

den gesamten indexierten Schlüsselraum ausgeführt und alle am Index beteiligten

Attribute abgefragt. Für jeden Schlüssel wird der entsprechende Indexschlüssel

berechnet und abgefragt. Ist er nicht mit dem gleichen Timestamp vorhanden,

wird ein Fehler ausgegeben und ggf. korrigiert.

So wird erreicht, dass für jeden Datensatz genau ein Indexeintrag vorhanden

ist und dass zu jedem Indexeintrag ein Datensatz vorhanden ist. Wobei beachtet

werden muss, dass jeder Indexeintrag nur zurückgegeben wird, wenn der Datensatz

existiert. So wird sichergestellt, dass kein Datensatz im Index fehlt und auch nicht

von mehreren Indexeinträgen referenziert wird.

Kapitel 4

Implementierung

thrift.CassandraServer

1.

8.

2.

service.StorageProxy

db.ICassandraIndex

3.

6.

7.

4.

5.

service.StorageService

Abbildung 4.1: Ablauf einer Schreiboperation in Cassandra mit Index

In diesem Kapitel werden zunächst alle konkreten neuen Operationen, die in

Kapitel 3 theoretisch beschrieben wurden, vorgestellt, die später zusammen mit

den bestehenden Operationen aus Abschnitt 2.7 für Clients nutzbar sein sollen.

Danach wird ein Interface vorgeschlagen, das intern für alle Indeximplementierungen genutzt werden soll. Dadurch ist es möglich, verschiedene Implementierungen

nebeneinander in der gleichen Instanz zu nutzen. Gleichzeitig wird als Teil der

Arbeit die konkrete Implementierung eines Indexes IndirectDictionary, die das

Interface implementiert, beschrieben. Als nächstes werden die Datenstrukturen

zur Laufzeit erläutert und eine Erweiterung der Konfigurationsdatei vorgenommen.

Zuletzt werden die Implementierungen der Lese-, Schreib- sowie Wartungsope37

38

KAPITEL 4. IMPLEMENTIERUNG

rationen beschrieben. Im Folgenden sind alle Namen von Paketen und Klassen

relativ zum Pfad org.apache.cassandra.

In Abbildung 4.1 sieht man die Namen der Klassen, welche bei einer Schreiboperation involviert sind. Die Pfeile stellen den Ablauf der Aufrufe dar. Zuerst

kommt die Anfrage im externen Interface in der Klasse thrift.CassandraServer an.

Dort wird sie ausgepackt und an die Klasse service.StorageProxy weitergegeben

(1). An dieser Stelle wird die update index -Funktion einer Indeximplementierung

aufgerufen, die das Interface db.ICassandraIndex implementiert (2). Um den

Indexeintrag zu schreiben verwendet die Implementierung nun wieder die Klasse

service.StorageProxy (3), welche den zu schreibenden Datensatz an die Klasse

service.StorageService weitergibt um ihn zu speichern (4). Nach dem der Index

geschrieben wurde (5), wird der eigentliche Datensatz geschrieben (6). Danach

wird die erfolgreiche Ausführung der Schreiboperation gemeldet (7,8).

4.1

Externes Interface

Damit ein Index für eine Anwendung nutzbar wird, müssen zusätzliche Methoden

zum Abfragen in das externe Interface exportiert werden. Sie orientieren sich

stark an den normalen Leseoperationen von Cassandra. Dabei werden jeweils die

Datensätze und nicht nur die Schlüssel der Datensätze zurückgegeben. Aufgrund

der mangelnden Atomizität ist dies für die meisten Anwendungszwecke vorteilhaft.

Da beim Lesen die Datensätze sowieso zur Überprüfung gelesen werden, entsteht

dadurch kaum zusätzlicher Aufwand.

Alle Anfragen von Clients werden in einer Instanz der Klasse thrift.CassandraServer verarbeitet und jeweils nach Überprüfung von Berechtigungen an eine

Instanz der Klasse service.StorageProxy weitergeleitet, wo die Logik für die Abarbeitung einer Anfrage implementiert wird (siehe Abbildung 4.1). Folgende neue

Funktionen werden implementiert (Siehe Anhang B):

• index get(String index name, Map<byte[],byte[]> key map, ColumnPath

column path, ConsistencyLevel consistency level ) - Lesen aller Datensätze zu

einem Indexeintrag. index name gibt den Namen des Indexes im Keyspace

keyspace an. Der column path kann optional die Abfrage auf ein Attribut

oder eine SuperColumn in den zurückgegebenen Datensätzen begrenzen.

4.2. INTERNES INTERFACE

39

Die key map enthält eine Liste von indexierten Attributnamen und Attributwertpaaren, auf denen der Index abgefragt wird. Das consistency level

gibt, wie in Abschnitt 2.6 beschrieben an, auf wie viele Knoten beim Lesen

zugegriffen wird.

• index get slice(Stringindex name, Map<byte[],byte[]> key map, ColumnParent column parent, SlicePredicate predicate,

ConsistencyLevel consistency level ) - Entspricht index get. Jedoch kann über

das predicate eine Liste oder ein Bereich von Attributen oder SuperColumns

unterhalb des column parent in den zurückgegebenen Datensätzen abgefragt

werden.

• index get range slices(String index name, ColumnParent column parent,

SlicePredicate predicate, KeyMap Range key map range, ConsistencyLevel

consistency level ) - Entspricht index get slice. Hier ist es aber möglich statt

einer Liste von indexierten Attributnamen und Attributwertpaaren einen

Bereich in key map range anzugeben. Vorausgesetzt wird, wie bei allen

Bereichsanfragen, dass als partitioner eine Hashfunktion gewählt wurde,

welche die Reihenfolge der Schlüssel beibehält (siehe Abschnitt 2.4).

• index multiget slice(String index name,

List<Map<byte[],byte[]>> key map list, ColumnParent column parent,

SlicePredicate predicate, ConsistencyLevel consistency level ) - Entspricht

index get slice. Weiterhin ist es in key map list möglich statt einer Liste

von indexierten Attributnamen und Attributwertpaaren mehrere Listen

anzugeben.

4.2

Internes Interface

Die Klasse service.StorageProxy leitet einige Operationen an eine Indeximplementierung weiter, welche das folgende Interface ICassandraIndex implementieren

muss. Dabei handelt es sich um folgende Funktionen, welchen den Funktionen des

externen Interface ohne index name entsprechen:

• Konstruktor(String keyspace, String name, AbstractType compare with,

List<String> column name, List<String> options) - Initialisiert das IndexObjekt und wird beim Laden der Indeximplementierung aufgerufen. Es

40

KAPITEL 4. IMPLEMENTIERUNG

müssen der Keyspace keyspace, der Name der Indeximplementierung name,

die Vergleichsfunktion compare with und die zu indexierenden Attributnamen column name übergeben werden (Genaueres siehe Parameter keys

in Abschnitt 3.4). Außerdem können Optionen mit dem Parameter option

übergeben werden.

• indexUpdate(RowMutation mutation map,

ConsistencyLevel consistency level ) - Überprüft, ob der Index beim Schreiben auf einer Liste von Attributen aktualisiert werden muss. Berechnet

Lösch- und Schreiboperationen auf Indexdatensätzen und führt diese aus.

Wird von der Klasse service.StorageProxy aufgerufen, wenn eine Schreiboperation ausgeführt wird. Übergeben werden als Parameter ein Schlüssel

key von einem Datensatz, eine Liste der Änderungen mutation map, dabei

handelt es sich um jeweils eine Schreiboperation auf ein Attribut, und das

consistency level.

• indexGet(Map<byte[],byte[]> key map, ColumnPath column path, ConsistencyLevel consistency level ) - Lesen eines einzelnen Datensatzes über den

Index.

• indexGetSlice(Map<byte[],byte[]> key map, ColumnParent column parent,

SlicePredicate predicate, ConsistencyLevel consistency level ) - Lesen eines

Teildatensatzes über den Index.

• indexGetRangeSlices(ColumnParent column parent, SlicePredicate predicate,

KeyMapRange key map range, ConsistencyLevel consistency level ) - Lesen

mehrerer Datensätze oder Teile davon über einen Indexbereich.

• indexMultiget slice(List<Map<byte[],byte[]>> key map list,

ColumnParent column parent, SlicePredicate predicate, ConsistencyLevel

consistency level ) - Lesen mehrerer Datensätze oder Teile davon über den

Index.

• indexRebuild() - Baut den Index neu auf. Siehe Abschnitt 3.7.

• indexValidate() - Überprüft die Korrektheit des Indexes. Siehe Abschnitt

3.8.

4.3. BEISPIELE

4.3

41

Beispiele

Um die Funktion der neuen Operationen aus Abschnitt 4.1 zu verdeutlichen, werden nun beispielhafte Operationen auf die Datensätze in Abbildung 4.2 ausgeführt.

Als erstes wird mit set keyspace(’MyUserApp’) der Keyspace gesetzt.

MyUserApp

Users

a

age: 27

19:10

b

age: 20

18:55

c

age: 27

13:10

name: Hans

19:10

gender: m

19:20

UsersAgeIndex

20

b:

18:55

27

a:

19:10

c:

13:10

Abbildung 4.2: Beispieldatensätze für Indexabfragen

• index get(’UserAgeIndex’, age=’27’, {column family = ’Users’, column =

’age’}, QUORUM) - Anfrage nach dem Attribut age aller Datensätze in der

ColumnFamily Users mit Attribut age = 27 über den Index UserAgeIndex.

Gibt eine Liste mit zwei Elementen zurück:

a => {{name = ’age’, value = ’27’, clock = ’19:10’}},

c => {{name = ’age’, value = ’27’, clock = ’13:10’}}.

• index get slice(’UserAgeIndex’, age=’27’, {column family = ’Users’}, start

= ’a’, finish = ’h’, ONE) - Fragt nach allen Datensätzen in der ColumnFamily Users mit age = 27 über den Index UserAgeIndex. Dabei werden

die Attribute zwischen a und h abgefragt. Zurückgegeben wird die Liste:

a => {{name = ’age’, value = ’27’, clock = ’19:10’}, {name = ’gender’,

42

KAPITEL 4. IMPLEMENTIERUNG

value = ’m’, clock = ’19:20’}},

c => {{name = ’age’, value = ’27’, clock = ’13:10’}}

4.4

Konfigurationsinterface

Beim Start von Cassandra wird die Konfigurationsdatei cassandra.yaml bei der

Instanziierung der Klasse config.DatabaseDescriptor in die Klasse config.Config

eingelesen, welche auf diverse weitere Datentypen verweist. Unter anderem wird

für jeden Keyspace eine Instanz der Klasse config.Keyspace erzeugt. Pro Instanz

werden alle ColumnFamilies in Instanzen der Klasse config.ColumnFamily eingelesen.

Config

+ cluster_name : string

+ partitioner : string

+ keyspaces : RawKeyspace

+

+

+

+

+

+

+

+

+

+

+keyspaces +

+

+

RawColumnFamily

name : string

column_type : ColumnFamilyType

compare_with : string

compare_subcolumns_with : string

comment : string

rows_cached : double

keys_cached : double

read_repair_chance : double

indexes : RawIndex

RawKeyspace

name : string

replica_placement_strategy : string

replication_factor : int

column_families : RawColumnFamily

+column_families

+indexes

+

+

+

+

+

RawIndex

name : char

index_type : string

compare_with : string

column_name : string[]

options : string[]

Abbildung 4.3: UML-Diagramm der Klassen, welche die Konfigurationsdatei

abbilden im Package config

Im Beispiel der Abbildung 4.4 sieht man zwei Indexe, die in der Konfigurationsdatei cassandra.yaml mit den Erweiterungen aus Abschnitt 3.4 definiert werden.

Beide werden auf der ColumnFamily Users definiert. Bei einem Schreibzugriff auf

das in column name angegebene Attribut age wird während der Operation der

Index mit dem in name spezifizierten Namen UsersAgeIndex aktualisiert. Dabei

wird die beispielhafte Indeximplementierungen IndirectDictionary verwendet. Um

Bereichsabfragen über den Index zu ermöglichen, sollen alle Indexeinträge mit der

Vergleichsfunktion BytesType sortiert werden, die in compare with konfiguriert

4.4. KONFIGURATIONSINTERFACE

43

keyspaces:

- name: MyUserApp

replication_factor: 5

column_families:

- name: Users

compare_with: BytesType

indexes:

- name: UsersAgeIndex

# Benutze einen indirekten Index

index_type: IndirectDictionary

# Sortiere Datensätze binär

compare_with: BytesType

# Index auf Spalte Age

column_name: age

- name: UsersGenderIndex

# Benutze einen in Memory Index

index_type: InMemoryDictionary

# Sortiere Datensätze binär

compare_with: BytesType

# Index auf Spalte Geschlecht

column_name: gender

- name: UsersItems

compare_with: BytesType

Abbildung 4.4: cassandra.yaml Index Beispiel

wird. Äquivalent funktioniert der Index UserGenderIndex. Zu jeder ColumnFamily

oder SuperColumnFamily sind beliebig viele Indexe möglich.

An dieser Stelle müssen nun auch Indexe aus der Konfigurationsdatei geladen

werden und die entsprechenden internen Objekte erzeugt werden. Dazu wird

zuerst eine neue Klasse config.Index erstellt (in Abbildung 4.3 zu sehen). Um

Informationen über Indexe auf ColumnFamilies einlesen zu können wird diese

Klasse config.ColumnFamily um eine Liste von Instanzen der Klasse config.Index

erweitert. Abbildung 4.3 zeigt das Klassendiagramm mit der neuen Klasse config.Index.

44

KAPITEL 4. IMPLEMENTIERUNG

4.5

Datenstrukturen zur Laufzeit

Während die Klassen im vorherigen Abschnitt dazu verwendet werden um die

Konfigurationsdatei einzulesen, werden jetzt Klassen erstellt die das Schema

zur Laufzeit von Cassandra abbilden. Beim Start von Cassandra werden alle

Keyspaces und ColumnFamilies von der Funktion loadSchemas() in der Klasse

config.DatabaseDescriptor aus dem System-Keyspace geladen. Das Einlesen neuer

ColumnFamilies und/oder Keyspaces aus der Konfigurationsdatei cassandra.yaml

kann vom Benutzer ausgelöst werden. Dazu wird die Methode readTablesFromYaml() in der Klasse config.DatabaseDescriptor verwendet.

KSMetaData

+ name : string

+ strategyClass : AbstractReplicationStrategy

+ replicationFactor : int

- cfMetaData : Map<String, CFMetaData>

+ deflate() : KsDef

+ inflate(ks : KsDef) : KSMetaData

CFMetaData

+ tableName : string

+ cfName : string

+ cfType : ColumnFamilyType

+ clockType : ClockType

+ comparator : AbstractType

+ subcolumnComparator : AbstractType

+ reconciler : AbstractReconciler

+ comment : string

+ rowCacheSize : double

+ keyCacheSize : double

+ readRepairChance : double

+ cfId : int

+ preloadRowCache : bool

+ column_metadata : Map<byte[], ColumnDefinition>

- idxMetaData : Map<String, idxMetaData>

+ deflate() : CfDef

+ inflate(cf : CfDef) : CFMetaData

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

IdxMetaData

keyspace : string

columnFamily : string

name : string

indexType : AbstractCassandraIndex

columnName : List<String>

compareWith : AbstractType

deflate() : IdxDef

inflate(idx : IdxDef) : IdxMetaData

+indexType

+meta

AbstractCassandraIndex

meta : IdxMetaData

index_get(key_map : Map<byte[],byte[]>, column_path : ColumnPath, consistency_level : ConsistencyLevel)

index_get_slice(key_map : List<byte[],byte[]>, column_parent : ColumnParent, predicate : SlicePredicate, consistency_level : ConsistencyLevel)

index_multiget_slice(key_map_list : List<Map<byte[],byte[]>>, column_parent : ColumnParent, predicate : SlicePredicate, consistency_level : ConsistencyLevel)

index_get_range_slice(column_parent : ColumnParent, predicate : SlicePredicate, key_map_range : KeyMapRange, consistency_level : ConsistencyLevel)

rebuildIndex()

validateIndex()

update_index(key : byte[], mutation : RowMutation, consistency_level : ConsistencyLevel)

Diagram: runtime Page 1

Abbildung 4.5: UML-Diagramm der Laufzeit Klassen des Schemas im Package

config

Während der Laufzeit von Cassandra werden alle Keyspaces in Instanzen

der Klasse config.KSMetaData gespeichert, welche unter anderem eine Liste mit

Instanzen der Klasse config.CFMetaData für jede ColumnFamily im Keyspace

enthält. Analog zu Abschnitt 4.4 wird eine neue Klasse für Indexe mit dem Namen

config.IdxMetaData erstellt. Jede ColumnFamily wird um eine Liste von Instanzen

dieser Klasse erweitert. Die Klassen und ihre Abhängigkeiten untereinander sind

in Abbildung 4.5 dargestellt.

4.6. SCHREIBOPERATIONEN

45

Da die Laufzeitstrukturen nach jeder Änderung eines Keyspaces oder einer ColumnFamily als binäre Daten im System-Keyspace gespeichert werden, enthalten sie

eine serialize- und eine deserialize-Funktion. Die neue Klasse config.IdxMetaData