online im PDF-Format - DBAI

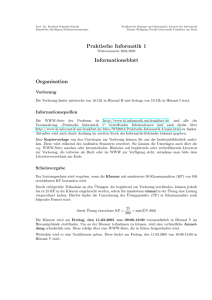

Werbung

Skriptum zur Vorlesung

DATENBANKSYSTEME

VO 181.038 (alter Studienplan)

VO 181.146 (neuer Studienplan)

WS 2002

Gerald Pfeifer

Michael Schrefl

Katrin Seyr

Markus Stumptner

0.2

Inhaltsverzeichnis

I Allgemeines

1

1

Einleitung

1.1 Das Datenbanksystem . . . . . . . . . . . . . . . . . . . . . . . .

1.1.1 Die Hardware . . . . . . . . . . . . . . . . . . . . . . . .

1.1.2 Die Software . . . . . . . . . . . . . . . . . . . . . . . .

1.1.3 Die Daten . . . . . . . . . . . . . . . . . . . . . . . . . .

1.1.4 Die Benutzer . . . . . . . . . . . . . . . . . . . . . . . .

1.2 Warum ein Datenbanksystem? . . . . . . . . . . . . . . . . . . .

1.2.1 Von Einzellösungen zu Datenbanksystemen . . . . . . . .

1.2.2 Funktionalität von Datenbanksystemen . . . . . . . . . .

1.2.2.1 Persistente Datenhaltung . . . . . . . . . . . .

1.2.2.2 Hintergrundspeicherverwaltung . . . . . . . . .

1.2.2.3 Recovery . . . . . . . . . . . . . . . . . . . . .

1.2.2.4 Concurrency Control . . . . . . . . . . . . . .

1.2.2.5 Ad-hoc-Abfragen . . . . . . . . . . . . . . . .

1.2.2.6 Datenschutz . . . . . . . . . . . . . . . . . . .

1.2.3 Komponenten eines Datenbanksystems . . . . . . . . . .

1.2.4 Vorteile des Einsatzes von Datenbanksystemen . . . . . .

1.3 Architektur eines Datenbanksystems . . . . . . . . . . . . . . . .

1.4 Die Datenmodellierung . . . . . . . . . . . . . . . . . . . . . . .

1.4.1 Begriffe . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.4.2 Datenmodelle im Datenbankentwurf . . . . . . . . . . . .

1.5 Der Datenbank-Life-Cycle“ . . . . . . . . . . . . . . . . . . . .

”

1.5.1 Die Anforderungsanalyse . . . . . . . . . . . . . . . . . .

1.5.2 Der konzeptionelle Entwurf . . . . . . . . . . . . . . . .

1.5.3 Der logische Entwurf . . . . . . . . . . . . . . . . . . . .

1.5.4 Der physische Entwurf . . . . . . . . . . . . . . . . . . .

1.5.5 Verteilter Entwurf . . . . . . . . . . . . . . . . . . . . . .

1.5.6 Datenbankimplementierung, -überwachung und -wartung .

Literaturverzeichnis

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

2

2

3

3

4

5

6

7

7

8

9

11

12

12

13

16

17

18

18

19

19

20

22

23

24

24

1

i

INHALTSVERZEICHNIS

0.ii

II Datenmodellierung

2

3

1

Konzeptionelle Datenmodelle und das ER Modell

2.1 Modellierungskonzepte konzeptioneller Datenmodelle . . . . . . .

2.2 Elementare ER-Konstrukte . . . . . . . . . . . . . . . . . . . . . .

2.2.1 Grundlegende Objekte: Entities, Beziehungen und Attribute

2.2.2 Komplexität einer Beziehung . . . . . . . . . . . . . . . . .

2.2.3 Existenz einer Entity in einer Beziehung . . . . . . . . . . .

2.2.4 Grad einer Beziehung . . . . . . . . . . . . . . . . . . . .

2.2.5 Attribute einer Beziehung . . . . . . . . . . . . . . . . . .

2.3 Erweiterte ER-Konstrukte . . . . . . . . . . . . . . . . . . . . . . .

2.3.1 Die Generalisierung . . . . . . . . . . . . . . . . . . . . .

2.3.2 ER-Constraints . . . . . . . . . . . . . . . . . . . . . . . .

2.3.2.1 Exklusionsbedingungen . . . . . . . . . . . . . .

2.4 Objektorientierte Datenmodellierung . . . . . . . . . . . . . . . . .

2.4.1 Objektorientierte Konzepte . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

2

3

3

6

7

8

9

10

10

11

12

13

13

Das Relationenmodell

3.1 Formalisierung des Relationenmodells . . . . . . . . . . .

3.2 Operationen auf Relationen . . . . . . . . . . . . . . . . .

3.2.1 Die Mengenoperationen . . . . . . . . . . . . . .

3.2.2 Die Selektion . . . . . . . . . . . . . . . . . . . .

3.2.2.1 Erweiterung der Selektion . . . . . . . .

3.2.3 Die Projektion . . . . . . . . . . . . . . . . . . .

3.2.4 Der Verbund . . . . . . . . . . . . . . . . . . . .

3.2.4.1 Der natürliche Verbund (natural join) . .

3.2.4.2 Das Kartesische Produkt . . . . . . . . .

3.2.4.3 Der Gleichverbund (equi-join) . . . . .

3.2.4.4 Der Theta-Verbund (theta-join) . . . . .

3.2.5 Die Division . . . . . . . . . . . . . . . . . . . .

3.2.6 Der Semiverbund (semijoin) . . . . . . . . . . . .

3.3 Nullwerte . . . . . . . . . . . . . . . . . . . . . . . . . .

3.3.1 Auswertung von Nullwerten . . . . . . . . . . . .

3.3.2 Äußerer Verbund (outer join) . . . . . . . . . . . .

3.4 Übersetzung des ER ins Relationenmodell . . . . . . . . .

3.5 NF2 -Relationen . . . . . . . . . . . . . . . . . . . . . . .

3.6 Weitere Sprachen für das Relationenmodell . . . . . . . .

3.6.1 Der Relationenkalkül . . . . . . . . . . . . . . . .

3.6.1.1 Der Relationenkalkül mit Tupelvariablen

3.6.1.2 QBE — Query By Example . . . . . . .

3.7 Übungsbeispiele . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

4

4

5

6

6

7

7

7

9

10

11

12

13

14

14

15

16

16

18

18

18

21

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

INHALTSVERZEICHNIS

4

5

0.iii

SQL

4.1 Interaktives SQL . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.1.1 Allgemeines . . . . . . . . . . . . . . . . . . . . . . . . .

4.1.2 Datentypen . . . . . . . . . . . . . . . . . . . . . . . . . .

4.1.3 Abfragen . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.1.3.1 Grundkonstruktion einer SQL-Abfrage . . . . . .

4.1.3.2 Mengenoperationen . . . . . . . . . . . . . . . .

4.1.3.3 Gruppierung und Aggregatfunktionen . . . . . . .

4.1.3.4 Teilabfragen . . . . . . . . . . . . . . . . . . . .

4.1.4 Nullwerte . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.1.4.1 Der Outer Join in SQL . . . . . . . . . . . . . . .

4.1.5 Datendefinition . . . . . . . . . . . . . . . . . . . . . . . .

4.1.5.1 Erzeugen von Relationenschemata . . . . . . . .

4.1.5.2 Globale Integritätsbedingungen . . . . . . . . . .

4.1.5.3 Ändern von Relationenschemata . . . . . . . . .

4.1.5.4 Entfernen von Relationenschemata . . . . . . . .

4.1.6 Datenmanipulation . . . . . . . . . . . . . . . . . . . . . .

4.1.6.1 Einfügen von Daten . . . . . . . . . . . . . . . .

4.1.6.2 Löschen von Daten . . . . . . . . . . . . . . . .

4.1.6.3 Ändern von Daten . . . . . . . . . . . . . . . . .

4.1.7 Benutzersichten . . . . . . . . . . . . . . . . . . . . . . . .

4.1.8 Zugriffskontrolle . . . . . . . . . . . . . . . . . . . . . . .

4.1.9 Transaktionsverwaltung . . . . . . . . . . . . . . . . . . .

4.1.10 Definition von Dateiorganisationsformen und Zugriffspfaden

4.1.11 Abstrakte Datentypen . . . . . . . . . . . . . . . . . . . . .

4.1.12 Rekursion in SQL-3 . . . . . . . . . . . . . . . . . . . . .

4.1.13 Trigger in SQL-3 . . . . . . . . . . . . . . . . . . . . . . .

4.2 Embedded SQL . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.2.1 Prinzip der Einbindung . . . . . . . . . . . . . . . . . . . .

4.2.2 Cursor . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3 SQL-2 versus SQL-3 Standard . . . . . . . . . . . . . . . . . . . .

4.4 Übungsaufgaben . . . . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

2

2

2

4

5

7

7

8

10

13

14

14

15

16

16

16

16

17

17

18

19

20

20

20

22

25

26

26

27

27

30

Datalog

5.1 Motivation . . . . . . . . . . . . . . . . . . . . .

5.2 Die Syntax von Datalog . . . . . . . . . . . . . .

5.2.1 Einschränkungen zur Syntax von Datalog

5.3 Semantik von Datalog . . . . . . . . . . . . . . .

5.3.1 Logische Semantik von Datalog . . . . .

5.3.2 Operationale Semantik von Datalog . . .

5.4 Erweitertes Datalog mit Negation . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

1

2

3

3

5

9

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

0.iv

5.5

6

7

8

INHALTSVERZEICHNIS

5.4.1 Graphendarstellung . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.4.2 Semanik von Datalog mit Negation . . . . . . . . . . . . . . . . . .

Übungsbeispiele . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Funktionale Abhängigkeiten

6.1 Definition von funktionalen Abhängigkeiten . . . . . . . . .

6.2 Ableitungsregeln für funktionale Abhängigkeiten . . . . . .

6.3 Äquivalenz von Systemen von funktionalen Abhängigkeiten

6.4 Inklusionsabhängigkeiten . . . . . . . . . . . . . . . . . . .

6.4.1 Definition von Inklusionsabhängigkeiten . . . . . .

6.4.2 Ableitungsregeln für Inklusionsabhängigkeiten . . .

6.5 Übungsbeispiele . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Normalformen

7.1 Erste und Zweite Normalform . . . . . . . . . . . . . . . . . . . . . . .

7.2 Die Dritte Normalform . . . . . . . . . . . . . . . . . . . . . . . . . . .

7.3 Die Boyce-Codd Normalform . . . . . . . . . . . . . . . . . . . . . . .

7.4 Zerlegungen von Relationenschemata . . . . . . . . . . . . . . . . . . .

7.4.1 Verbundtreue Zerlegung in 3NF bzw. BCNF . . . . . . . . . . . .

7.4.2 Verbund- und abhängigkeitstreue Zerlegung in 3NF bzw. BCNF .

7.4.3 Berechnung von Überdeckungen für eingebettete Abhängigkeiten

7.4.3.1 Der Algorithmus RBR (Reduction By Resolution) . . .

7.4.4 Der Synthesealgorithmus . . . . . . . . . . . . . . . . . . . . . .

7.5 Übungsbeispiele . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Physisches Datenbankdesign

8.1 Grundlegende Begriffe . . . . . . . . . . . . . . . . . . . . .

8.1.1 Clustering . . . . . . . . . . . . . . . . . . . . . . . .

8.1.1.1 Clustering-Index . . . . . . . . . . . . . . .

8.1.1.2 Geclusterte Speicherung von Datensätzen .

8.1.2 Primär- und Sekundärorganisation . . . . . . . . . . .

8.2 Speicherstrukturen für Relationen . . . . . . . . . . . . . . .

8.2.1 Kriterien zur Auswahl von Speicherstrukturen . . . . .

8.2.1.1 Ungeordnete Dateien . . . . . . . . . . . .

8.2.1.2 Indexsequentielle Dateien . . . . . . . . . .

8.2.1.3 Clustered . . . . . . . . . . . . . . . . . . .

8.2.1.4 Hashorganisation . . . . . . . . . . . . . .

8.2.1.5 B ∗ -Baum . . . . . . . . . . . . . . . . . .

8.2.2 Füllgrad . . . . . . . . . . . . . . . . . . . . . . . . .

8.2.3 Zugriffszeitverhalten . . . . . . . . . . . . . . . . . .

8.2.4 Physische Datenorganisation in kommerziellen DBMS

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

10

11

14

.

.

.

.

.

.

.

1

1

3

5

9

9

9

11

.

.

.

.

.

.

.

.

.

.

1

1

3

5

5

8

11

13

15

15

17

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

1

2

2

3

3

3

4

5

5

6

7

8

9

10

INHALTSVERZEICHNIS

8.2.4.1

8.2.4.2

8.2.4.3

0.v

INGRES . . . . . . . . . . . . . . . . . . . . . . . . . . .

ORACLE . . . . . . . . . . . . . . . . . . . . . . . . . .

MS-SQL Server . . . . . . . . . . . . . . . . . . . . . . .

III Das Datenbankmanagementsystem

9

1

Optimierung

9.1 Logische Abfragenoptimierung . . . . . . . . . . . . . . .

9.1.1 Algebraische Optimierung . . . . . . . . . . . . .

9.1.1.1 Zusammenfassen gleicher Teilausdrücke

9.1.1.2 Regeln für Join und kartesisches Produkt

9.1.1.3 Regeln für Selektion und Projektion . .

9.1.2 Ein einfacher Optimierungsalgorithmus . . . . . .

9.2 Join-Algorithmen . . . . . . . . . . . . . . . . . . . . . .

9.2.1 Nested-loop Join . . . . . . . . . . . . . . . . . .

9.2.2 Join mit Hilfe von Indexen . . . . . . . . . . . . .

9.2.3 Hash-Join . . . . . . . . . . . . . . . . . . . . . .

9.2.4 Clustering . . . . . . . . . . . . . . . . . . . . . .

9.3 Der Semijoin (Semiverbund) . . . . . . . . . . . . . . . .

9.4 Übungsbeispiele . . . . . . . . . . . . . . . . . . . . . . .

10 Concurrency Control

10.1 Begriffsklärungen . . . . . . . . . . . . . . . . . . . . .

10.1.1 Synchronisationsprobleme . . . . . . . . . . . .

10.1.2 ACID Eigenschaften von Transaktionen . . . . .

10.1.3 Ausführung mehrerer Transaktionen . . . . . . .

10.1.4 Konfliktrelation einer Ausführung . . . . . . . .

10.1.5 Serialisierbarkeit . . . . . . . . . . . . . . . . .

10.1.6 Test auf Serialisierbarkeit . . . . . . . . . . . .

10.2 Sperrprotokolle . . . . . . . . . . . . . . . . . . . . . .

10.2.1 Gültige Ausführungen . . . . . . . . . . . . . .

10.2.2 Wohlgeformte Transaktionen . . . . . . . . . . .

10.2.3 Das 2-Phasen-Sperrverfahren (2-Phase-Locking)

10.2.4 Deadlock . . . . . . . . . . . . . . . . . . . . .

10.2.5 Das Baumprotokoll . . . . . . . . . . . . . . . .

10.2.6 Das Hierarchische Sperrprotokoll . . . . . . . .

10.3 Zeitstempelverfahren (Time Stamping) . . . . . . . . . .

10.4 Transaktionen in SQL . . . . . . . . . . . . . . . . . . .

10.5 Übungsbeispiele . . . . . . . . . . . . . . . . . . . . . .

10

10

10

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

2

3

3

3

5

7

7

8

9

9

10

11

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

3

5

6

7

9

10

10

11

12

13

14

14

15

17

19

21

0.vi

INHALTSVERZEICHNIS

11 Wiederanlauf (Recovery)

11.1 Grundlagen . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11.1.1 Zielsetzung . . . . . . . . . . . . . . . . . . . . . . . . .

11.1.2 Reihenfolge von Ausführungen . . . . . . . . . . . . . .

11.1.3 Nichtwiederherstellbare Ausführung . . . . . . . . . . . .

11.1.4 ACA Ausführungen . . . . . . . . . . . . . . . . . . . .

11.1.5 Strikte Ausführung von Transaktionen . . . . . . . . . . .

11.2 Pufferverwaltung . . . . . . . . . . . . . . . . . . . . . . . . . .

11.2.1 Privater Arbeitsbereich . . . . . . . . . . . . . . . . . . .

11.2.2 Write Ahead-Protokoll . . . . . . . . . . . . . . . . . . .

11.3 Wiederanlaufverfahren mit Logprotokoll . . . . . . . . . . . . . .

11.3.1 Das Logprotokoll . . . . . . . . . . . . . . . . . . . . . .

11.3.2 Wiederanlauf nach einem Transaktionsabbruch . . . . . .

11.3.3 Wiederanlauf nach einem Systemabsturz . . . . . . . . .

11.3.4 Checkpoints . . . . . . . . . . . . . . . . . . . . . . . .

11.3.5 Wiederanlauf mit Checkpoints nach einem Systemabsturz

11.3.6 Wiederanlauf nach einem Plattenfehler . . . . . . . . . .

11.4 Schattenkopieverfahren (shadow paging) . . . . . . . . . . . . . .

11.4.1 Die Grundidee . . . . . . . . . . . . . . . . . . . . . . .

11.4.2 Die Realisierung . . . . . . . . . . . . . . . . . . . . . .

11.5 Übungsbeispiele . . . . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

1

3

3

4

4

6

8

9

9

9

11

11

12

12

14

16

16

16

19

Teil I

Allgemeines

1

Kapitel 1

Einleitung

1.1 Das Datenbanksystem

Ein Datenbanksystem (DBS) ist ein computerisiertes System, das Information speichert und

bei Bedarf zur Verfügung stellt. Unter Information verstehen wir in diesem Zusammenhang

nicht nur den reinen Wert der Daten, sondern auch deren Bedeutung für die Benutzer. Das

Datenbanksystem ist Teil eines Informationssystems. Unter diesem Oberbegriff werden alle

Systeme zusammengefasst, die einerseits Informationen über bestimmte Anwendungen bzw.

Außenweltsituationen (z.B. customer relationship management einer Firma, eine Bibliothek,

Börsenkurse usw.) speichern und (zentral) verwalten. Andererseits ermöglichen sie aber auch

das Arbeiten mit diesen Informationen nach bestimmten Gesichtspunkten bzw. mit verschiedenen Zielsetzungen, insbesondere auch von anderen Programmen aus.

Definition 1.1 [Vossen 1999] Ein Informationssystem ist ein Werkzeug zur Erfassung und

Kommunikation von Information zum Zwecke der Erfüllung der Anforderungen seiner Benutzer, der (Geschäfts-) Aktivitäten ihres Unternehmens und zur Erreichung der Unternehmensziele. Daher unterstützt ein Informationssystem die Unternehmensaktivitäten durch Bereitstellung der benötigten Information oder durch Automatisierung der mit den Aktivitäten

zusammenhängenden Vorgänge. Es umfasst sämtliche zu diesem Zweck im Unternehmen vorhandenen Ressourcen, d.h. die Daten, die Datenbanksoftware, die nötige Rechner-Hardware,

die Personen, die die Daten nutzen und verwalten, die relevante Anwendungssoftware sowie

die Programmierer, die diese entwickeln.

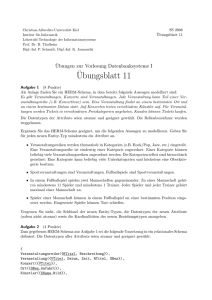

Grob gesehen interagieren vier Komponenten in einem Informationssystem: Hardware,

Software, die Daten und die Benutzer (siehe Abbildung 1.1). Die Software (das Datenbankmanagementsystem, DBMS) und die Daten (die Datenbank, DB) bilden gemeinsam das eigentliche Datenbanksystem.

1

KAPITEL 1. EINLEITUNG

1.2

Datenbankmanagementsystem

Datenbank

Daten

Daten

Applikationsprogramme

Endbenutzer

Abbildung 1.1: Vereinfachte Sicht eines Informationssystems

1.1.1 Die Hardware

Auf die Hardware werden wir im Weiteren nicht näher eingehen, da dies den Rahmen dieser Lehrveranstaltung sprengen würde. Wir wollen an dieser Stelle nur aufzählen, welche

Hardware für den Betrieb eines Datenbanksystems notwendig ist:

• Das Rechnersystem: Prozessoren, Caches, Hauptspeicher, Buffer, die zur Ausführung

der Datenbanksystemsoftware notwendig sind.

• Der Sekundärspeicher: meist Platten- und Bandsysteme, die einerseits die Daten und

andererseits Datenstrukturen zum schnellen Zugriff (Indexe) und zur Datensicherung

(Logs) lokal speichern und den dazugehörigen Input/Output Devices. Weiters sind noch

Backup-Geräte zur Sicherung der Daten notwendig.

• ein Kommunikationssystem/Rechnernetz, wenn das Datenbanksystem nicht im singleuser Betrieb laufen soll.

1.1.2 Die Software

Das Datenbankmanagementsystem (DBMS) ist jener Teil der Software, der zwischen den eigentlichen Daten und den Benutzern dieser Daten liegt und alle Anfragen der Benutzer verarbeitet. Es stellt jene Einrichtungen zur Verfügung, die notwendig sind, um neue Daten

anzulegen, Daten zu löschen, Daten abzufragen und Daten zu verändern. Das DBMS ist auch

dafür zuständig, alle hardwarespezifischen Details vor dem Benutzer zu verbergen und so

transparent zu machen. Dazu gehören z.B. die Anzahl der Platten oder generell die konkrete

Datenstruktur der gespeicherten Daten sowie die Anzahl der Prozessoren und Speichergrößen,

die zur Datenverarbeitung eingesetzt werden. Weiters realisiert ein DBMS die üblicherweise

erwartete Datenbankfunktionalität wie persistente Datenhaltung, Hintergrundspeicherverwaltung, Recovery (Wiederanlauf) und Concurrency Control (Synchronisation).

KAPITEL 1. EINLEITUNG

1.3

Heutzutage existiert eine Vielfalt von DBMSen sowohl kommerzieller als auch freier Natur, deren Einsatz von Handhelds bis hin zu Großrechnern und massiven Clustern reicht. Daher ist sowohl Multi-user Betrieb als auch Single-user Betrieb zu ermöglichen. In einem

Single-user System wird zu einem bestimmten Zeitpunkt von maximal einem Benutzer auf

die Daten zugegriffen, während in einem Multi-user System viele Benutzer gleichzeitig auf

die Daten zugreifen. Beispiele für Multi-user Systeme sind Buchungssysteme von Fluglinien

oder Anwendungen im Bankenbereich. Eine weitere Aufgabe von DBMSen im Multi-user

Betrieb ist, den Benutzern die Sicht eines single-user Betriebs auf die Daten zu geben. Probleme, die in diesem Zusammenhang entstehen, werden in Kapitel 10 behandelt.

Die Software besteht heutzutage aber nicht nur aus dem DBMS, sondern auch aus Entwicklungsumgebungen, Designhilfen, Report Writern und so weiter. Die Behandlung dieser

Werkzeuge würde jedoch den Umfang dieser Lehrveranstaltung sprengen.

1.1.3 Die Daten

Die Daten werden vom DBMS in einer Datenbank abgelegt. Eine Datenbank ist also eine Art

Behälter, der eine Menge von logisch zusammengehörigen Daten enthält. In einem DBMS

können mehrere verschiedene Datenbanken enthalten sein und eine Applikation kann auch

auf mehrere Datenbanken zugreifen. Die Beschreibung der Daten einer Datenbank mit Hilfe

eines Datenmodells wird als Datenbankschema bezeichnet. Das Datenbankschema ist von

den eigentlichen Daten zu unterscheiden, der Ausprägung der Datenbank. Die Ausprägung

umfasst die Gesamtheit der Daten, die in einer bestimmten Datenbank zu einem bestimmten Zeitpunkt vorhanden sind, und wird auch als Datenbankzustand bezeichnet. Eine kurze

Einführung in die Datenmodellierung geben wir in diesem Kapitel im Abschnitt 1.4, eine

genaue Beschreibung folgt in Kapitel 2.

Unter einer integrierten Datenhaltung verstehen wir den Umstand, dass die Datenbank als

Sammlung von unterschiedlichen Datenfiles oder Tabellen gesehen werden kann, zwischen

denen Redundanz so weit als möglich eliminiert wird. Das war einer der Gründe, warum

sich Datenbanksysteme im Laufe der Zeit immer größerer Beliebtheit erfreuten. Ein weiterer

war, dass es relativ einfach möglich ist, die Daten mehreren Benutzern für unterschiedliche

Zwecke und in unterschiedlichen Sichtweisen zur Verfügung zu stellen, wodurch die Wartung

und Aktualisierung der Daten wesentlich erleichtert wird.

1.1.4 Die Benutzer

Die Benutzer eines DBS können wir in drei Gruppen einteilen: in Datenbank- und Datenadministratoren, Applikationsprogrammierer und Endbenutzer.

Die Datenadministratoren (DA) führen die Datenmodellierung durch, die Datenbankadministratoren (DBA) sind für die Implementierung und technische Realisierung der in der

Phase der Datenmodellierung getroffenen Entscheidungen zuständig. In kleineren Projekten sind Datenbankadministrator, Datenadministrator und Anwendungsprogrammierer oft ei-

KAPITEL 1. EINLEITUNG

1.4

Produktion

Verkauf

Fakturierung

Zugriffsoperationen

Zugriffsoperationen

Zugriffsoperationen

Angestellte

Kunden

Kunden

Teile

Teile

Teile

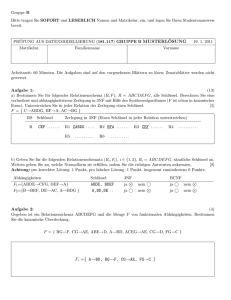

Abbildung 1.2: Die Einzellösung

ne Person. In großen Anwendungen, wie zum Beispiel im Bankenbereich oder bei Fluglinien, sind eine Gruppe von Datenbankadministratoren nur für die technische Umsetzung,

die Performance des DBS und für die Wartung des Systems im Fehlerfall (Soft- bzw. Hardware-Fehler) zuständig. Die Datenadministratoren sind für die Daten an sich zuständig. Sie

entscheiden, welche Daten in welcher Form gespeichert werden, welche Verfahren zur Datenwartung eingesetzt werden und wer in welcher Form auf die Daten zugreifen darf.

Die Applikationsprogrammierer sind für die Entwicklung der Anwendungen, die auf die

Daten im DBS zugreifen, zuständig. Diese Applikationen werden üblicherweise in den heute

gängigen objektorientierten oder prozeduralen Programmiersprachen wie Java, C++, C, oder

Pascal (Delphi) geschrieben. Vielfach wird dabei über genormte Schnittstellen wie ODBC

(Open DataBase Connectivity) oder JDBC (Java DataBase Connectivity) mit dem DBS kommuniziert, d.h., der Code kann unabhängig vom konkreten DBMS, das letztendlich verwendet

wird, geschrieben werden. Eine andere Möglichkeit ist, die entsprechenden Features der einzelnen DBMS-Anbieter und die vom DBMS zur Verfügung gestellten Schnittstellen für die

jeweiligen Programmiersprachen direkt zu verwenden.

Die Endbenutzer schließlich greifen entweder über die im letzten Punkt beschriebenen

Applikationen auf die Daten zu oder über ein Interface, das vom DBMS zur Verfügung gestellt wird. Jedes DBMS stellt eine gewisse Anzahl von eingebauten Modulen zur Verfügung,

mittels derer die Endbenutzer direkt auf die Daten zugreifen können. Eines dieser Module ist

üblicherweise eine interaktive Abfragesprache, wobei derzeit am häufigsten SQL oder eine

Abart von SQL anzutreffen sind.

1.2 Warum ein Datenbanksystem?

In diesem Abschnitt geben wir zuerst einen kurzen historischen Abriss zur Entstehung von

integrierter Datenverarbeitung und damit zur Entwicklung von Datenbanksystemen, danach

besprechen wir die Funktionalität von Datenbanksystemen und zum Schluss werden wir kurz

die Vorteile, die die Verwendung von Datenbanksystemen mit sich bringt, beschreiben.

KAPITEL 1. EINLEITUNG

1.5

Produktion

Verkauf

Fakturierung

Zugriffsoperationen

Zugriffsoperationen

Zugriffsoperationen

Personen

Datei

Teile

Datei

Abbildung 1.3: Die Integrierte Datenverarbeitung

1.2.1 Von Einzellösungen zu Datenbanksystemen

Informationssysteme sollen leicht wartbar, leicht erweiterbar und ihre Bedienung leicht erlernbar sein. Seit den ersten Implementierungen von Informationssystemen wurden diesbezüglich

große Fortschritte gemacht.

Die ersten computerunterstützten Informationssysteme wurden in Form von Einzell ösungen (siehe Abbildung 1.2), als einzelne Anwendungsprogramme mit privaten Dateien, realisiert. Diese Programme verwendeten unmittelbar das zugrundeliegende Dateisystem auf

dem jeweiligen Rechner. Gleichartige Daten wurden in Dateien (Files) gespeichert, die selbst

wieder aus einzelnen Datensätzen (Records) bestanden. Diese wiederum waren aus Einträgen

oder Feldern zusammengebaut, die somit die kleinste Dateneinheit darstellten. Diese Systeme

waren schwer wartbar, da mehrfach verwendete Daten redundant gespeichert wurden.

Diese Redundanz sowohl der gespeicherten Daten als auch des Programmcodes (da für jede Anwendung entsprechende Zugriffsfunktionen implementiert wurden) behinderte sowohl

den Betrieb als auch die Wartung solcher Systeme. Daher wurden bei der Integrierten Datenverarbeitung (siehe Abbildung 1.3) Dateien mit Hilfe von Dateisystemen in mehreren Anwendungsprogrammen verwendet und in sogenannten Data Dictionaries Verzeichnisse über

die Verwendung von Daten in Programmen zentral geführt. Programme und Dateien waren

jedoch voneinander abhängig. Änderungen in der Organisationsform einer Datei (z.B. der

Sortierreihenfolge der Datensätze) oder eine Änderung des Satzaufbaus machten eine Änderung aller Programme notwendig, die diese Datei benutzten, auch dann, wenn für diese die

Änderung inhaltlich bedeutungslos war.

Heute werden Informationssysteme meist mit Hilfe von Datenbanksystemen (siehe Abbildung 1.4) realisiert, die unabhängig von bestimmten Anwendungsprogrammen existieren und eine klare Trennungsebene zwischen Anwendungsprogrammen und Daten darstellen. Einerseits ermöglicht diese Trennung die sogenannte physische Datenunabhängigkeit,

d.h. Programme und Ad-hoc-Abfragen sind von den konkreten Speicher- oder Zugriffsmethoden unabhängig. Andererseits stellen DBMSe ein Datenmodell“, also eine Sprache zur

”

KAPITEL 1. EINLEITUNG

1.6

Produktion

Verkauf

Fakturierung

Zugriffsoperationen

Zugriffsoperationen

Zugriffsoperationen

Datenbanksystem

Personen

Datei

Teile

Datei

Abbildung 1.4: Das Datenbanksystem

Beschreibung der Datenstrukturen zur Verfügung, die es möglich macht, einzelne Programme

auf speziellen logischen Darstellungen der gespeicherten Datenbank arbeiten zu lassen, sodass bestimmte Änderungen der Datenbasis selbst vor den Anwendungsprogrammen versteckt

werden können, ein Zustand, den wir logische Datenunabh ängigkeit bezeichnen. Zusammengefasst ergeben sich folgende Vorteile:

• Redundanz ist weitgehend vermeidbar,

• ein konsistenter Datenbankzustand gemäß Integritätsbedingungen ist gesichert,

• flexibler Gebrauch der Daten wird ermöglicht.

Konventionelle Datenbanksysteme unterstützen die gemeinsame Verwendung von Daten zwischen mehreren Anwendungen. Objektorienierte Datenbanksysteme (siehe Abbildung 1.5) erweitern diese Idee der gemeinsamen Benutzung“ auf Operationen über diese

”

Daten. Das Schema einer objektorientierten Datenbank besteht aus einer Menge von Objektklassen. Eine Objektklasse beschreibt eine Datenstruktur und eine Menge von auf dieser Datenstruktur definierten Operationen. Objekte der zu beschreibenden Welt werden als Instanzen

von Objektklassen repräsentiert. Ein solches Objekt darf nur über die für seine Objektklasse

definierten Operationen modifiziert werden.

1.2.2 Funktionalität von Datenbanksystemen

In diesem Abschnitt beschreiben wir die wichtigsten Eigenschaften von Datenbanksystemen

aus Benutzersicht, als da sind: persistente Datenhaltung, Hintergrundspeicherverwaltung, Recovery (Wiederanlauf), Concurrency Control (Synchronisation), Unterstützung von Ad-hocAbfragen und Datenschutz/Zugriffskontrolle.

KAPITEL 1. EINLEITUNG

1.7

Produktion

Verkauf

Fakturierung

oo Datenbanksystem

Personen

Teile

Operationen

Operationen

Daten

Daten

Abbildung 1.5: Das Objektorientierte Datenbanksystem

1.2.2.1 Persistente Datenhaltung

Ein Datenbankmanagementsystem muss Mechanismen zur Verfügung stellen, die eine persistente Speicherung von Daten sicherstellen. Unter Persistenz verstehen wir, dass die Daten

in der Datenbank über die Ausführungszeit von Anwendungsprogrammen hinaus erhalten

bleiben, im Gegensatz zu Daten, die entweder in Programmvariablen von Anwendungsprogrammen gehalten werden oder Input- bzw. Output-Daten sind, und daher flüchtige (transiente) Daten genannt werden. Input-Daten sind jene Daten, die in das System meist interaktiv

über ein Terminal oder mittels OCR (Banküberweisungen) eingegeben werden. Input-Daten

können persistente Daten verändern oder selbst zu persistenten Daten werden, sind aber nicht

Teil der Datenbank an sich. Ähnlich verhält es sich mit Output-Daten, die meist über Drucker

oder Bildschirm ausgegeben werden. Sie leiten sich zwar oft von den persistenten Daten ab,

sind aber nicht Teil der Datenbank.

Die Daten werden üblicherweise auf einem Hintergrundspeicher (Sekundärspeicher, z.B.

Platte) persistent gehalten; Daten, die ausschließlich im Hauptspeicher (Primärspeicher) gehalten werden, sind flüchtig, d.h. sie überleben die Programmausführung nicht. Für den Benutzer eines Datenbankmanagementsystems ist nicht sichtbar, welche Daten sich während der

Benutzung der Datenbank nur im Sekundärspeicher befinden und welche vom DBMS kurzfristig zusätzlich im Primärspeicher gehalten werden.

1.2.2.2 Hintergrundspeicherverwaltung

Ein Datenbankmanagementsystem unterstützt die Verwaltung großer Datenmengen, die üblicherweise nicht zur Gänze im Primärspeicher Platz finden. Die Datenbank wird persistent

im Hintergrundspeicher (oder Sekundärspeicher) gehalten. Nachdem Programme nur auf Daten im Primärspeicher direkt zugreifen können, werden Ausschnitte der Datenbank zeitweise

auch in einem Teil des Primärspeichers, dem Datenbankpuffer, verwaltet.

1.8

KAPITEL 1. EINLEITUNG

Nachdem ein Plattenzugriff etwa um einen Faktor zehntausend länger dauert als ein Hauptspeicherzugriff, sind spezielle Techniken notwendig, um unnötige Plattenzugriffe zu vermeiden. Üblicherweise werden daher nicht einzelne Datensätze zwischen den Speichermedien

transferiert, sondern ganze Bereiche. Die Speichermedien sind in Bl öcke gegliedert, und es

werden aus Effizienzgründen jeweils alle Datensätze, die sich in einem Block befinden, übertragen.

Spezielle Puffer-Ersatz-Strategien werden verwendet, um bei Platzmangel im Datenbankpuffer zu entscheiden, welche Blöcke wieder auf die Platte ausgelagert werden sollen. Dabei

kommen verschiedene Strategien zum Einsatz, wie z.B. least recently used“ oder least fre”

”

quently used“. Wenn wir den Haupt- und Hintergrundspeicher mit unserem Schreibtisch und

der Ablage im Büro vergleichen, dann lässt sich die Pufferstrategie mit der gewählten Vorgehensweise vergleichen, nach der wir auf dem Schreibtisch durch das Wegräumen von Akten

Platz für neue Akten schaffen.

Aus Effizienzgründen ist es wichtig, wie die Datensätze den Blöcken im Sekundärspeicher zugeordnet sind. Angenommen wir verteilen jene Unterlagen, die wir für eine wichtige

Tätigkeit brauchen, auf fünf verschiedene Ordner, die überdies sehr viel andere Unterlagen

enthalten, dann müssen wir jedesmal, wenn wir diese Tätigkeit verrichten, für alle fünf Ordner am Schreibtisch Platz finden. Außerdem verbrauchen die restlichen Unterlagen, die wir

in jenem Fall gar nicht benötigen, viel Platz in den Ordnern. Sogenannte Cluster-Techniken

gruppieren Datensätze so, dass Datensätze — unter Umständen auch verschiedener Dateien

— auf die oft gemeinsam zugegriffen wird, physisch benachbart gespeichert werden.

Weiters werden verschiedene Indextechniken verwendet, um Daten auf dem Hintergrundspeicher rasch zu finden. Wie etwa Indexeinträge in Büchern auf die Buchseite verweisen,

in denen ein Stichwort erwähnt wird, so verweisen Indexeinträge in Datenbanken auf jene

Blöcke, in denen Datensätze mit bestimmten Feldwerten vorkommen. Eine genaue Behandlung dieser Thematik geben wir in Kapitel 8.

1.2.2.3 Recovery

Datenbankmanagementsysteme unterstützen Änderungen der Datenbank durch Transaktionen. Eine Transaktion ist eine Folge von Aktionen, das sind Lese- und Schreibzugriffe auf

Daten der Datenbank, die eine Datenbank von einem konsistenten Zustand in einen anderen

konsistenten Zustand überführt.

Die Recovery Einheit eines Datenbankmanagementsystems gewährleistet die Atomarität

und die Dauerhaftigkeit (Persistenz) von Transaktionen. Atomarit ät bedeutet, dass alle Aktionen einer Transaktion ausgeführt werden oder keine. Dauerhaftigkeit bedeutet, dass alle Effekte einer einmal erfolgreich abgeschlossenen Transaktion trotz etwaiger anschließend

auftretender Hard- und Softwarefehler erhalten bleiben.

Fehler, die ein Datenbankmanagementsystem abfangen muss, sind unter anderem:

1. vom Anwendungsprogramm erkannte logische Fehler (z.B. Konto nicht gedeckt“),

”

KAPITEL 1. EINLEITUNG

1.9

2. vom System erkannte Fehler (z.B. zyklisches Warten mehrerer Programme auf die Freigabe einer Ressource),

3. der Verlust des Hauptspeicherinhalts (z.B. Stromausfall) und

4. der Verlust der Daten des Plattenspeichers (z.B. Disk Crash).

Der Start, der erfolgreiche Abschluss bzw. der Abbruch einer Transaktion werden dem

Datenbankmanagementsystem durch die speziellen Befehle begin transaction, commit transaction bzw. abort transaction angezeigt.

Beispiel 1.1 Ein typisches Beispiel einer Transaktion ist die Überweisung eines Geldbetrages von einem Gehaltskonto auf ein Sparbuch. Atomarität bedeutet in diesem Fall, dass die

Überweisung zur Gänze durchgeführt wird (Abbuchung vom Gehaltskonto und Aufbuchung

auf das Sparbuch) oder gar nicht (weder Abbuchung noch Aufbuchung). Tritt während der

Überweisung nach der Abbuchung, aber noch vor der Aufbuchung ein Systemabsturz ein,

so möchten wir als Kunden davon ausgehen können, dass sich nach dem Wiederanlauf der

gesamte Geldbetrag noch auf dem Gehaltskonto befindet.

Angenommen, wir zahlen einen Millionengewinn im Lotto auf unser Konto ein. Dann

stellt die Dauerhaftigkeit von Transaktionen sicher, dass der Gewinn auch nach einem Systemneustart immer noch auf dem Konto liegt.

Für den Wiederanlauf verwenden die meisten relationalen Datenbankmanagementsysteme

ein Logprotokoll. In diesem Logprotokoll wird der Start (begin transaction), das Ende (end

transaction) und der Abbruch (abort transaction) von Transaktionen verzeichnet, sowie die

von Transaktionen durchgeführten Modifikationen (Einfügen, Löschen und Ändern von Datensätzen). Zu jeder Änderung wird der alte Datensatz (before image) und der neue Datensatz

(after image) im Logprotokoll verzeichnet. Beim Wiederanlauf werden alle nicht beendeten Transaktionen (commit transaction fehlt im Logprotokoll) unter Verwendung der BeforeImages zurückgesetzt und alle bereits erfolgreich abgeschlossenen Transaktionen (commit

transaction steht im Logprotokoll) nachgefahren. Das Logprotokoll sollte sich nicht auf dem

selben Hintergrundspeicher (z.B. der selben Platte) wie die Datenbank befinden, denn im

Falle eines Plattenfehlers wären das Logprotokoll wie auch die Datenbank verloren. Im Falle eines Systemabsturzes allein wäre die Speicherung des Logs und der Datenbank auf der

selben Platte ausreichend. Damit wir das Logprotokoll nicht in die Vergangheit zurück bis

zur erstmaligen Verwendung des Datenbanksystems aufbewahren müssen, können wir zu bestimmten Zeitpunkten auch ein Backup der Datenbank anlegen. Eine genauere Beschreibung

der unterschiedlichen Algorithmen zum Wiederanlauf geben wir in Kapitel 11.

1.2.2.4 Concurrency Control

Die Concurrency Control Einheit eines Datenbankmanagementsystems ermöglicht mehreren Benutzern, eine Datenbank gemeinsam zur selben Zeit zu benutzen, ohne ihre Konsistenz zu gefährden. Das traditionell verwendete Korrektheitskriterium für die parallele (oder

KAPITEL 1. EINLEITUNG

1.10

t

T1

T2

read(Konto,a)

read(Konto,b)

a := a + 2.000

b := b − 65

write(Konto,a)

write(Konto,b)

Abbildung 1.6: Verzahnte Ausführung von Transaktionen

verzahnte) Ausführung von Transaktionen im Mehrbenutzerbetrieb ist die Serialisierbarkeit.

Die Serialisierbarkeit besagt, dass das Ergebnis der beliebigen Parallelausführung mehrerer

Transaktionen dem Ergebnis irgendeiner Hintereinanderausführung dieser Transaktionen entspricht.

Beispiel 1.2 Angenommen, wir wollen unsere Telefonrechnung bezahlen. Wir gehen zur

Bank und füllen den Zahlschein aus, womit die Abbuchung vom Konto durchgeführt wird.

Diese Abbuchung wird nun zufällig gleichzeitig mit der Gehaltsbuchung auf das Konto durchgeführt, d.h., es gibt zwei verschiedene Transaktionen, die zur selben Zeit auf dieselben Daten zugreifen. Betrachten wir dazu die schematische Darstellung in Abbildung 1.6, die eine

mögliche verzahnte Ausführung zeigt. Angenommen, der aktuelle Kontostand beträgt 150,-.

Zunächst liest Transaktion T1 (die Gehaltsbuchung) den aktuellen Kontostand in eine Programmvariable a (150,-), danach liest Transaktion T2 (die Telefonrechnung) den aktuellen

Kontostand in eine Programmvariable b (150,-). Dann erhöht T 1 die Programmvariable a

auf 2.150,- und T2 vermindert die Programmvariable b auf 85,-. Schließlich wird von T 1 der

neue Kontostand 2.150,- und von T2 der neue Kontostand 85,- in die Datenbank geschrieben.

Nachdem beide Transaktionen abgeschlossen wurden, ist der Kontostand Euro 85,-. Jede der

beiden möglichen Hintereinanderausführungen der beiden Transaktionen (T 1 vor T2 oder T2

vor T1 ) hätte einen Kontostand von Euro 2.085,- ergeben. Das heißt, die angegebene verzahnte Ausführung ist nicht serialisierbar, und daher nicht korrekt, wie wir leicht anhand des

obigen Beispiels sehen können.

Um die Serialisierbarkeit von Transaktionen zu gewährleisten, verwenden die meisten

Datenbankmanagementsysteme ein Sperrverfahren. Dabei legt eine Transaktion auf Datenobjekte, die sie schreiben oder lesen soll, eine Sperre. Besitzt eine Transaktion auf einem

Datenobjekt eine Sperre und fordert eine andere Transaktion für dieses Datenobjekt ebenfalls

eine Sperre an, so wird diese Sperre nur dann gewährt, wenn die neu angeforderte Sperre mit

der bereits bestehenden Sperre verträglich ist. Ist sie dies nicht, so muss die die neue Sperre

anfordernde Transaktion auf die Freigabe der bestehenden Sperre warten.

KAPITEL 1. EINLEITUNG

1.11

Meist werden zwei Typen von Sperren verwendet: geteilte Lesesperren und exklusive

Schreibsperren. Lesesperren verschiedener Transaktionen für dasselbe Datenobjekt sind miteinander verträglich; eine Schreibsperre einer Transaktion ist mit keiner Sperre einer anderen

Transaktion für dasselbe Datenobjekt verträglich.

Beispiel 1.3 Bezugnehmend auf Beispiel 1.2 mit den beiden Transaktionen auf dem Gehaltskonto bedeutet das, dass die Transaktion T1 , sobald sie den Wert des Kontos lesen will, diesen

Wert exklusiv sperrt, da sie eine Schreiboperation ausführen will. Die Transaktion T 2 muss,

wenn sie den Kontostand lesen will, warten, da eine exklusive Sperre vorliegt und daher keine

andere Transaktion auf diesen Datenwert zugreifen kann. Erst wenn T 1 den Wert nach erfolgreichem Schreiben wieder freigegeben hat, kann T2 den neuen Wert lesen. Das garantiert,

dass eine zu einer seriellen Ausführung äquivalente Ausführung durchgeführt wird.

Das Sperren von Datenobjekten ist alleine jedoch nicht ausreichend, um die Serialisierbarkeit mehrerer parallel ausgeführter Transaktionen zu gewährleisten. Es muss darüber hinaus

ein Sperrprotokoll eingehalten werden. Das am meisten gebräuchliche Sperrprotokoll ist das

2-Phasen-Sperrprotokoll. Eine Transaktion erfüllt das 2-Phasen-Sperrprotokoll, wenn es nach

der ersten Freigabe einer Sperre keine neue Sperre mehr anfordert.

Weiters garantiert die Concurrency Control Komponente die Isolation von Transaktionen.

Isolation bedeutet, dass Effekte einer Transaktion erst nach ihrem erfolgreichen Abschluss für

andere Transaktionen sichtbar werden.

Die Isolation von Transaktionen wird durch das strikte 2-Phasen-Sperrprotokoll gewährleistet, wobei eine Transaktion dieses erfüllt, wenn es alle Sperren erst am Ende der Transaktion freigibt, was in der Praxis bei kommerziellen Datenbankmanagementsystemen der Fall

ist. Eine genaue Behandlung der in diesem Abschnitt vorgestellten Konzepte werden wir in

Kapitel 10 geben.

Die in den letzten beiden Abschnitten vorgestellten Eigenschaften von Transaktionen —

Atomarität, Konsistenz (Serialisierbarkeit), Isolation und Dauerhaftigkeit — werden oft als

ACID-Eigenschaften (atomicity, consistency, isolation, durability) bezeichnet.

1.2.2.5 Ad-hoc-Abfragen

Zum Zeitpunkt des Entwurfs einer Datenbank sind üblicherweise nicht alle zu erwartenden

Abfragen bekannt. Datenbankmanagementsysteme bieten die Möglichkeit, ad hoc neue Abfragen interaktiv an das Datenbanksystem zu stellen, ohne dass dafür neue Anwendungsprogramme geschrieben werden müssen. Ein gutes Datenbankmanagementsystem unterstützt

einfach formulierbare und deklarativ gestellte Abfragen. Deklarativ bedeutet, dass nur die

Bedingungen angegeben werden müssen, die die zu selektierenden Daten erfüllen. Es ist

nicht nötig, ein prozedurales Vorgehen anzugeben, wie diese Daten in der Datenbank gesucht

werden müssen. Weiters wird ein gutes Datenbankmanagementsystem die gestellte Abfrage optimieren, d.h. einen unter Berücksichtigung der Art der Abfrage und der vorhandenen

Speicher- und Indexstrukturen optimalen Zugriffsplan ermitteln. Die meisten relationalen

1.12

KAPITEL 1. EINLEITUNG

Datenbanksysteme stellen SQL (Structured Query Language) als interaktive Datenbankabfragesprache zur Verfügung. Wir werden in Kapitel 4 genauer darauf eingehen, die Optimierung

von Abfragen behandeln wir in Kapitel 9.

1.2.2.6 Datenschutz

Datenbankmanagementsysteme bieten die Möglichkeit, den Zugriff auf Ausschnitte der Datenbank für einzelne Benutzer oder Benutzergruppen zu beschränken. Dabei kann hinsichtlich

der Art des Zugriffs zwischen Lese-, Änderungs-, Einfüge- und Löschzugriffen unterschieden

werden. Wichtig in diesem Zusammenhang ist, wie granular Zugriffsrechte vergeben werden

können: z.B. für die gesamte Datenbank, für einzelne Tabellen einer relationalen Datenbank,

oder für ausgewählte Zeilen und Spalten einer Tabelle.

1.2.3 Komponenten eines Datenbanksystems

Ein Datenbanksystem besteht aus den folgenden Komponenten:

Abfragenübersetzer (query parser): übersetzt die Anweisungen einer Abfragesprache in

eine niedere Sprache (z.B. Relationale Algebra, Kapitel 3).

Abfragenoptimierer (query optimizer, strategy selector): formt das Ergebnis des Abfragenübersetzers in eine effiziente Abfrage mit gleichem Ergebnis um(Kapitel 9).

Zugangs- und Integritätsmanager: verhindert unberechtigte Zugriffe und überprüft die Einhaltung vorgegebener Integritätsbedingungen.

Puffermanager (buffer manager): führt den Datentransfer vom Sekundär- in den Primärspeicher und umgekehrt durch.

Dateimanager (file manager): verwaltet die Dateien und deren Datenstrukturen auf dem Sekundärspeicher.

Wiederanlaufeinheit (recovery unit): stellt nach Transaktions-, System- oder Hardwarefehlern einen konsistenten Zustand der Datenbank her (Kapitel 11).

Mehrbenutzerkontrolleinheit (concurrency control unit): verhindert, dass sich mehrere Benutzer oder Programme, die das Datenbanksystem gleichzeitig verwenden, gegenseitig

stören (Kapitel 10).

Das Datenbankmanagementsystem greift über die oben beschriebenen Komponenten auf

die Datenbank selbst zu, deren Daten über die folgenden Datenstrukturen verwaltet werden:

Dateien (data files): speichern die Daten selbst.

KAPITEL 1. EINLEITUNG

1.13

Benutzer

Abfragenübersetzer

Wiederanlaufmanager

Abfragenoptimierer

Benutzertransaktion

Logdatei

Mehrbenutzerkontrolle

Sperrenverzeichnis

Puffermanager

Puffer (Hauptspeicher)

Dateimanager

Statische Dateien

Indexe

Systemdaten

Platte(Hintergrundspeicher)

Benutzerdaten

Abbildung 1.7: Komponenten eines Datenbanksystems

Datenverzeichnisse (data dictionary): enthält Informationen über die Bedeutung der gespeicherten Daten und deren Aufbau (Struktur der Dateien, Zugriffsbeschränkungen,

. . . ).

Indexe (indices): werden für den effizienten Zugriff auf bestimmte Daten benötigt (Kapitel 8).

Statische Dateien (statical data): enthalten Informationen über die im Datenbanksystem gespeicherten Daten, die etwa vom Abfragenoptimierer verwendet werden können.

1.2.4 Vorteile des Einsatzes von Datenbanksystemen

Am Ende dieses Abschnittes möchten wir auf die Vorteile des Einsatzes von Datenbanksystemen in Informationssystemen eingehen, die aufgrund einer zentralisierten Verwaltung der

Daten entstehen:

• Redundanzen können reduziert bzw. verhindert werden.

In Systemen, die ihre Daten nicht in einer Datenbank organisieren, hat jede Applikation oft ihre eigenen Datenfiles. Wenn nun mehrere Applikationen dieselben Daten

KAPITEL 1. EINLEITUNG

1.14

verwenden, hat das zur Folge, dass die Daten oftmals mehrfach gespeichert werden,

wie wir in Abbildung 1.2 gesehen haben. Bei der Verwendung eines Datenbanksystems

können Datenadministratoren diesen Redundanzen begegnen und bei der Erstellung eines Datenmodells verhindern. Wir möchten jedoch an diesem Punkt sehr wohl darauf

hinweisen, dass es in in der Praxis manchmal technische oder organisatorische Gründe

gibt, nicht alle Redundanzen auszuräumen. Wichtig ist dabei jedoch, dass die Datenadministratoren sich dieser Probleme bewusst sind und etwa im DBMS Vorkehrungen

treffen, dass z.B. bei Änderung der Daten diese an allen Stellen, an denen sie redundant

gespeichert sind, aktualisiert werden.

• Inkonsistenz kann (bis zu einem gewissen Grad) verhindert werden.

Für die Entstehung von Inkonsistenzen gibt es vor allem eine Ursache, die wir bei einem

ordentlichen Design einer Datenbank verhindern sollten: redundante Daten. Wenn Kundennummer und Kundenname nicht nur an einer Stelle miteinander gespeichert sind,

sondern an mehreren, dann kann es notwendig sein, dass nach einer Namensänderung

der Name des Kunden an mehreren Stellen geändert werden muss und nicht nur bei den

Stammdaten des Kunden. Wenn das nicht geschieht, dann werden die Daten inkonsistent. Es ist auf jeden Fall möglich, Inkonsistenz zwischen den Daten auf Applikationsebene abzufangen und so sicherzustellen, dass die redundant gespeicherten Daten

an allen Stellen geändert werden. Dabei stellt sich jedoch das Problem, dass in allen

Applikationen auf diesen Umstand Rücksicht genommen werden muss. Daher stellen

die meisten kommerziellen Datenbankmanagementsysteme Trigger zur Verfügung (siehe Kapitel 4). Trigger ermöglichen es, aktiv auf Änderungen des Datenbestandes zu

reagieren und weitere Änderungen selbst durchzuführen. So ist es den Datenbankadministratoren leicht möglich, die Änderung eines Namens abzufangen und sicherzustellen,

dass diese Änderung auch an allen Stellen, an denen der Name sonst noch vorkommt,

durchgeführt wird.

• Die Daten können mehrfach verwendet werden.

Durch die Trennung von Applikationen und den eigentlichen Daten, die nun im Datenbanksystem gehalten werden, können mehrere Applikationen auf einen einzigen Datenbestand zugreifen, und auch neue Applikationen können so entwickelt werden, dass

sie auf schon bestehende Daten zugreifen. Wir können die gespeicherten Daten auch

sehr leicht erweitern, und etwa zusätzlich zur Telefonnummer und Adresse der Kunden

auch eine Email-Adresse speichern, ohne dass wir alle schon bestehenden Applikationen ändern müssen.

• Standardisierungen können sichergestellt werden.

Durch die zentrale Kontrolle der Administratoren über die Daten kann auf die Einhaltung von Standards bei der Datenorganisation Rücksicht genommen werden. Zu

KAPITEL 1. EINLEITUNG

1.15

solchen Standards gehören z.B. innerbetriebliche, industrielle, nationale oder internationale Standards. Der Vorteil einer standardisierten Datenhaltung ist, dass z.B. Datenaustausch und Datentransfer verhältnismäßig leicht realisierbar sind.

• Datensicherheit ist leicht realisierbar.

Da die Datenbankadministratoren allein für alle technischen Belange der Datenbank

zuständig sind, können sie Einfluss darauf nehmen, wie und von wem auf die Daten zugegriffen wird. Das Datenbankmanagementsystem stellt Mechanismen zur Verfügung,

mit denen unterschiedlichen Benutzern unterschiedliche Zugriffsrechte (zum Lesen,

Ändern, Löschen oder neu Anlegen) vergeben werden können. Weiters sind unterschiedliche Benutzersichten definierbar, wodurch z.B. Abteilungsleiter nur die Daten

der ihnen unterstellten Mitarbeiter einsehen können. Wir möchten aber auch darauf

hinweisen, dass die Datensicherheit erst bei der Verwendung von zentral gespeicherten

Daten zu einem richtigen Problem wird.

• Datenintegrität wird sichergestellt.

Sicherstellung der Datenintegrität bedeutet, dass die Daten bezüglich bestimmter Kriterien fehlerfrei sind. Es ist natürlich nicht möglich, absolute Korrektheit der Daten sicherzustellen, denn wir können uns bei der Dateneingabe irren und z.B. als Adresse der

Abteilung für Datenbanken und Artificial Intelligence den Karlsplatz 13 angeben, statt

Favoritenstraße 9-11. Durch eine zentrale Kontrolle der Daten und Einschränkung der

Änderungsmöglichkeiten der vielen Benutzer ist es einfacher, diese Art der Fehler zu

verhindern. Es ist aber möglich, bestimmte Zusammmenhänge im Datenbankmanagementsystem zu modellieren und somit sicherzustellen, dass diese nicht verletzt werden.

Wir könnten z.B. sagen, dass alle Assistenten der TU Wien jeweils genau einem Institut zugeordnet sind. Wenn wir nun das Institut löschen wollen, da es aufgelassen wird,

dann muss dies verhindert werden, solange noch Assistenten diesem Institut zugeordnet

sind.

Weiters ist es möglich Regeln zu definieren, anhand derer beim Ändern der Daten Integritätsbedingungen überprüft werden. So können wir z.B. verlangen, dass das Geburtsjahr der MitarbeiterInnen eines Betriebes nicht mehr als 80 Jahre vom momentanen Jahr

zurückliegt.

• Widersprüchliche Anforderungen können ausgeglichen werden.

Daten- und Datenbankadministratoren, die einen Überblick über die unterschiedlichen

Anforderungen des Unternehmens haben, haben die Möglichkeit, auf diese Anforderungen einzugehen. So kann etwa durch die Art der Datenspeicherung eine Performancesteigerung für bestimmte wichtige Applikationen zugunsten von weniger wichtigen

durchgeführt werden.

Alle hier genannten Vorteile beruhen auf der Erreichung von Datenunabhängigkeit, die

wir im nächsten Abschnitt vorstellten werden.

KAPITEL 1. EINLEITUNG

1.16

externe Ebene

ext.

Schema 1

ext.

... Schema

n

Daten-Definition

logische Datenunabhängigkeit

Daten-Manipulation

konzeptionelle Ebene

physische Datenunabhängigkeit

interne Ebene

Daten-Administration

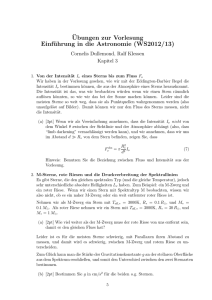

Abbildung 1.8: ANSI/SPARC Architektur eines Datenbanksystems

1.3 Architektur eines Datenbanksystems

Moderne Datenbanksysteme unterstützen die ANSI/X3/SPARC Architektur für Datenbanksysteme. Diese vom Standards Planning and Requirements Committee des American National

Standards Institute vorgeschlagene Architektur stellt drei verschiedene Sichtweisen auf ein

Datenbanksystem und die darin gespeicherten Daten vor (siehe Abbildung 1.8):

• Die Interne Ebene ist der physischen Speicherung am nächsten, entspricht ihr jedoch

nicht ganz. Wir betrachten hier nicht die Speicherstruktur auf dem Niveau von Bl öcken

oder Seiten, sondern als interne Records“ oder Datensätze. Beschrieben wird die in”

terne Ebene durch das interne Schema der Daten. Dieses Schema enthält nicht nur die

Beschreibung von Art und Aufbau der unterschiedlichen gespeicherten Datenstrukturen, sondern auch von speziellen Zugriffsmechanismen (Indexe), sowie der Anordnung

der Datensätze. Weiters wird auf der internen Ebene die Zuordnung der Datensätze auf

Sekundärspeicher-Medien verzeichnet. Diese Ebene stellt somit als Schnittstelle zur

eigentlichen Datenbank die Abbildung von logischem in physikalischen Adressraum

unter Zuhilfenahme von Betriebssystemfunktionen zur Verfügung. Wir gehen auf die

Speicherstrukturen in Datenbankmanagementsystemen in Kapitel 8 genauer ein.

• Die konzeptionelle Ebene beschreibt die logische Struktur, die logische Gesamtsicht der

Daten einer Datenbank im konzeptionellen Schema. In diesem Schema beschreiben wir

die Daten und ihre Beziehung zueinander mit den Mitteln der Datenmodellierung (siehe Abschnitt 1.4). Weiters enthält das konzeptionelle Schema Integritätsbedingungen,

Sicherheitsregeln und die Definition von Triggern.

Die Trennung zwischen der internen und der konzeptionellen Ebene führt zur physischen Datenunabhängigkeit. Diese bedeutet, dass unabhängig von der konkreten physischen Organisation der Daten die logische Organisation der Daten gleich bleibt. Wenn

wir z.B. aus Performancegründen Indexe oder Cluster einführen, hat das keine Auswirkungen auf die logische Struktur der Daten und die Anwendungsprogramme, die auf

KAPITEL 1. EINLEITUNG

1.17

der Datenbank arbeiten, müssen nicht verändert werden. Die einzige Auswirkung der

Änderung ist eine möglicherweise veränderte Laufzeit. Unterstützt ein Datenbankmanagementsystem physische Datenunabhängigkeit, können wir die Datenbank zunächst

nur nach inhaltlichen Gesichtspunkten entwerfen und implementieren. Anschließend

können wir die Speicherorganisations- und Zugriffsstrukturen der Dateien so modifizieren, dass die wichtigsten Anwendungen und Anfragen schneller ausgeführt werden,

ohne diese umschreiben zu müssen. Hat sich mit der Zeit das typische Anfragenprofil

an die Datenbank geändert, können wir wiederum eine optimale interne Organisationsform der Daten festlegen, ohne Anwendungsprogramme modifizieren zu müssen.

• Die Externe Ebene umfasst alle individuellen Sichten der einzelnen Benutzer, Benutzergruppen oder Anwendungen auf die Datenbank. Jedes externe Schema beschreibt dabei

eine dieser Sichten (Views) und enthält dabei genau jenen Ausschnitt der Datenbank

den der jeweilige Benutzer, die Benutzergruppe oder die Anwendung sehen will bzw.

darf.

Die Trennung zwischen konzeptioneller und externer Ebene wird auch als logische Datenunabhängigkeit bezeichnet. Dadurch werden Anwendungen, die auf ein externes

Schema zugreifen, von einer Änderung des logischen Aufbaus der Daten des konzeptionellen Schemas entkoppelt. Eine Restrukturierung des konzeptionellen Schemas bedingt keine Änderung der Anwendungen, die auf externe Schemata zugreifen. Eine Erweiterung des konzeptionellen Schemas einer relationalen Datenbank um neue Tabellen

oder neue Spalten von Tabellen, sowie eine Verkleinerung des konzeptionellen Schemas betreffen nur jene Anwendungen, die die hinzugefügten oder entfernten Tabellen

bzw. Spalten tatsächlich benutzen. Unterstützt ein Datenbankmanagementsystem logische Datenunabhängigkeit, können wir während des Betriebes des Datenbanksystems

neue Tabellen oder Spalten hinzufügen, ohne dass alte Anwendungen geändert werden

müssen.

Durch die ANSI SPARC-Architektur sind auch die Aufgabenprofile der Datenbankadministratoren und der Anwendungsadministratoren festgelegt, die wir schon besprochen haben. Die Datenbankadministratoren sind für die Verwaltung des logischen und des physischen

Schemas verantwortlich. Anwendungsadministratoren sind jeweils für die Verwaltung eines

oder mehrerer externer Schemata verantwortlich.

1.4 Die Datenmodellierung

In diesem Abschnitt werden die wichtigsten Begriffe zur Datenmodellierung erklärt, die danach in Kapitel 2 eingehend behandelt werden.

KAPITEL 1. EINLEITUNG

1.18

Anforderungen

Konzeptioneller Entwurf

z.B.:

Entity-Relationship-,

UML-Diagramme

Konzeptionelles Schema

konzeptionelles Datenmodell

z.B.:

Relationales Modell

(Normalisierung)

Logischer Entwurf

systemunabhängig

systemabhängig

Logisches Schema

logisches Datenmodell

z.B.:

Indexe,

Cluster

Physischer Entwurf

Physisches Schema

physisches Datenmodell

Abbildung 1.9: Der Datenbankentwurfsprozess

1.4.1 Begriffe

Ein Datenmodell besteht aus einer Menge von Modellierungskonstrukten zur Beschreibung

des Inhalts, der Struktur und der Bedeutung von Daten und einer Menge von auf diesen Modellierungskonstrukten definierten Operatoren zur Datenmanipulation. Ein Datenmodell stellt

dementsprechend eine Datendefinitionssprache (Data Definition Language, DDL) und eine

Datenmanipulationssprache (Data Manipulation Language, DML) zur Verfügung.

Datenmodellierung bezeichnet den Vorgang des Entwurfs eines Datenbankschemas für

die Verwaltung der Daten eines Informationssystems. Unter Universe of Discourse (oder

Problembereich) wird jener Weltausschnitt verstanden, der in der Datenbank repräsentiert

werden soll.

1.4.2 Datenmodelle im Datenbankentwurf

Im Datenbankentwurf werden verschiedene Datenmodelle entsprechend der ANSI/X3/SPARCArchitektur verwendet. Konzeptionelle Datenmodelle stellen problemnahe Modellierungskonzepte für die ersten Schritte des Datenbankentwurfs zur Verfügung und dienen zur Kommunikation zwischen Endbenutzern und Datenbankentwicklern. Physische Datenmodelle

stellen maschinennahe Konzepte zur Verfügung und dienen zur Beschreibung der Organisation von Daten in Dateien, sowie zur Beschreibung von Zugriffsstrukturen, die ein rasches

Einfügen, Suchen, Löschen und Ändern von Daten ermöglichen. Logische Datenmodelle dienen der Überbrückung der Kluft zwischen konzeptionellen und physischen Datenmodellen.

Sie werden oft auch als Implementierungsmodelle bezeichnet, da sie von Datenbankmanagementsystemen direkt unterstützt werden. Das logische Datenmodell steht dem Entwickler

zur Definition eines Datenbankschemas zur Verfügung und wird weitgehend automatisch vom

KAPITEL 1. EINLEITUNG

1.19

Datenbankmanagementsystem in ein physisches Datenbankschema übersetzt.

Konzeptionelle, logische und physische Datenmodelle sind in verschiedenen Phasen des

Datenbankentwurfs relevant (vgl. Abbildung 1.9).

In den letzten Jahrzehnten wurden Implementierungsmodelle immer näher an konzeptionelle Modelle herangebracht. Das Netzwerkmodell und das Hierarchische Modell wurden vor

allem in den 70er Jahren als Implementierungsmodelle verwendet und waren sehr nahe an

physische Modelle angelehnt. Das seit den 80er Jahren immer mehr eingesetzte Relationenmodell steht als logisches Modell zwischen physischen und konzeptionellen Modellen. Die

seit den 90er Jahren entwickelten objektorientierten Datenbankmanagementsysteme kommen

mit einem objektorientierten Implementierungsmodell den konzeptionellen objektorientierten

Modellen bereits weit entgegen, sind aber zur Zeit hinsichtlich der unterstützten Modellierungskonzepte meist noch eingeschränkt.

1.5 Der Datenbank-Life-Cycle“

”

Der Datenbank-Life-Cycle“ beinhaltet alle zum Design, der Erstellung und Wartung einer

”

Datenbankapplikation notwendigen Entwicklungsschritte. Der Prozess beginnt mit der Anforderungsanalyse (Requirementsanalyse), die gemeinsam mit den Kunden durchgeführt wird,

der Erstellung des konzeptionellen Schemas, des logischen Schemas und zuletzt des physischen Schemas. Nach der Fertigstellung des Designs beginnt die Implementierungsphase,

danach kommt die Wartungsphase.

In diesem Skriptum verwenden wir als roten Faden das virtuelle Unternehmen R EINE (Restaurant at the End of the InterNEt). R EINE ist ein virtuelles Unternehmen, das Leistungen im

Bereich der Gastronomie erbringt. Kunden können über das Internet Leistungen aussuchen

und bestellen, die dann geliefert werden. Im Gegensatz zu bereits existierenden Unternehmen,

die z.B. Pizzas ausliefern, soll R EINE vielfältigere Leistungen erbringen, denn auch wenn es

für den Kunden wie ein einziges Unternehmen aussieht, so besteht es eigentlich aus einer

Vielzahl von Unternehmen (Restaurants, Weinbauern, Catering Services, Transportunternehmen), die durch ihre gemeinsame Vermarktung gegenüber den Kunden eine bessere Leistung

erbringen können. Aufgrund der Komplexität dieses Anwendungsbeispieles werden wir aber

jeweils nur einen Teil der Gesamtanwendung betrachten, der sich für die Erklärung der vorgestellten Theorie eignet.

1.5.1 Die Anforderungsanalyse

In der ersten Phase des Zyklus müssen wir als Entwickler mit den Kunden (sowohl mit den

Erzeugern als auch den Benutzern der Daten) gemeinsam eine Spezifikation für die Anforderungen erstellen. An dieser Stelle müssen wir sowohl die Art der Daten und deren natürliche

Beziehungen untereinander analysieren als auch die zu verwendende Hard- und Software besprechen, da diese oft vom Kunden vorgegeben werden.

KAPITEL 1. EINLEITUNG

1.20

name

adresse

Kunde

n

knr

haube

bestellt

rnr

verkauft

1

adresse

n

Restaurant

name

typ

m

Speise

name

preis

Abbildung 1.10: Beispiel eines Entity-Relationship-Diagramms

Beispiel 1.4 In diesem Schritt müssen wir uns überlegen, welche Daten (Objekte des Problembereichs) wir für R EINE und seine Unternehmen speichern. Auf jeden Fall benötigen wir

Unternehmen, Produkte, Kunden, Bestellungen und Rechnungen sowie eventuell Mitarbeiter.

Diese Konzepte kristallisieren sich während der ersten Projektbesprechungen mit den Kunden

heraus.

1.5.2 Der konzeptionelle Entwurf

Beim konzeptionellen Entwurf wird ausgehend von den Anforderungen ein konzeptionelles

Schema entworfen, das Objekte des Problembereichs mit ihren Eigenschaften und Beziehungen zu anderen Objekten in einem konzeptionellen Datenmodell erfasst. Der konzeptionelle

Entwurf der Daten ist unabhängig davon, ob die Daten in verteilter Form (Verteilte Datenbank) oder in einer einzigen zentralen Datenbank gespeichert sind.

Das heute am weitesten und in vielen Varianten verbreitete konzeptionelle Datenmodell

ist das Entity-Relationship-Modell von Chen (1976). Es fand vor allem auf Grund seiner anschaulichen graphischen Darstellung des Datenbankschemas in Form des Entity-RelationshipDiagramms (ER-Diagramms) großen Anklang. Im ursprünglich von Chen vorgestellten Modell werden Objekte des Problembereichs auf Grund gemeinsamer Eigenschaften zu Objekttypen (Entities) zusammengefasst. Ein Objekttyp wird graphisch durch ein Rechteck repräsentiert und stellt in Form von Ovalen die allen Objekten dieses Typs gemeinsamen Merkmale

(Attribute) dar. Eine minimale Menge von Merkmalen, deren Werte ein Objekt eines Objekttyps eindeutig identifizieren, wird als Schlüssel bezeichnet. Der Primärschlüssel, das ist

ein Schlüssel, der beim Entwurf besonders ausgezeichnet wird, wird durch Unterstreichen

gekennzeichnet. Weiters werden Beziehungstypen (Relationships) zwischen Objekttypen modelliert, die angeben, dass Objekte dieser Typen zueinander in Beziehung stehen. Beziehungs-

KAPITEL 1. EINLEITUNG

1.21

name

adresse

legt

1

Kunde

n

Bestellung

knr

bnr

datum

lieferadresse

Abbildung 1.11: ER-Diagramm der Sicht der Kunden

legt

Kunde

1

n

Bestellung

n

für

verkauft

m

Restaurant

1

n

Speise

Abbildung 1.12: Integriertes ER-Diagramm (ohne Attribute)

typen werden durch Rauten dargestellt, die durch Kanten mit den betreffenden Objekttypen

verbunden sind. Eine an der Kante zwischen einem Objekttyp und dem Beziehungstyp angegebene Zahl gibt an, mit wievielen Objekten dieses Objekttyps ein bestimmtes Objekt des