10. Juni 2016

Werbung

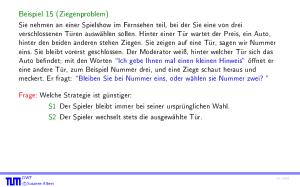

3.4 Summen von Zufallsvariablen

Satz 105

Seien X und Y unabhangige kontinuierliche Zufallsvariablen. Fur die Dichte von

Z := X + Y gilt

Z

fZ (z ) =

1

1

fX (x) fY (z x) d x :

Beweis:

Nach Denition der Verteilungsfunktion gilt

FZ (t) = Pr[Z t] = Pr[X + Y

t] =

Z

A(t)

fX;Y (x; y) d xd y

wobei A(t) = f(x; y ) 2 R2 j x + y tg.

DWT

c Susanne Albers

3.4 Summen von Zufallsvariablen

263/460

Beweis (Forts.):

Aus der Unabhangigkeit von X und Y folgt

FZ (t) =

=

Z

A(t)

Z

1

1

fX (x) fY (y) d xd y

fX (x) Z t x

1

fY (y) d y d x:

Mittels der Substitution z := x + y , d z = d y ergibt sich

Z t x

1

und somit

FZ (t) =

DWT

c Susanne Albers

fY (y) d y =

Z t Z

1

1

1

Z t

1

fY (z x) d z

fX (x)fY (z x) d x d z :

264/460

Satz 106 (Additivitat der Normalverteilung)

Die Zufallsvariablen X1 ; : : : ; Xn seien unabhangig und normalverteilt mit den

Parametern i ; i (1 i n). Es gilt: Die Zufallsvariable

Z := a1 X1 + : : : + an Xn

ist normalverteilt mit Erwartungswert = a1 1 + : : : + an n und Varianz

2 = a21 12 + : : : + a2n n2 .

Beweis:

Wir beweisen zunachst den Fall n = 2 und a1 = a2 = 1. Nach Satz 105 gilt fur

Z := X1 + X2 , dass

Z1

fZ (z ) =

=

DWT

c Susanne Albers

1

fX1 (z

1

1 2

2

Z1

1

y ) fX2 (y ) d y

exp

1

2

|

z

(

y 1 )2 (y 2 )2

+

d y:

12

22

{z

}

=:v

3.4 Summen von Zufallsvariablen

265/460

Beweis (Forts.):

Wir setzen

:= 1 + 2

2 := 12 + 22

v1 := (z )=

v22 := v v12

Damit ergibt sich unmittelbar

v22 =

woraus wir

ermitteln.

DWT

c Susanne Albers

(z y 1 )2 + (y 2 )2

12

v2 =

22

y12 2 12 + y22

1 2 (z 1 2 )2 ;

12 + 22

z22 + 1 22

3.4 Summen von Zufallsvariablen

266/460

Beweis (Forts.):

Damit folgt fur die gesuchte Dichte

fZ (z ) =

Wir substituieren noch

und erhalten

1

2 1 2 exp

v12

Z

2 1 exp

t := v2 und d t =

1

2 d y:

dy

1 2

Z 1

(

z )2

1

fZ (z ) =

2 exp

22 1 exp

Mit Lemma 92 folgt, dass fZ (z ) = '(z ; ; ) ist.

DWT

c Susanne Albers

v22

t2

2 d t:

267/460

Beweis (Forts.):

Daraus erhalten wir die Behauptung fur n = 2, denn den Fall Z := a1 X1 + a2 X2 fur

beliebige Werte a1 ; a2 2 R konnen wir leicht mit Hilfe von Satz 93 auf den soeben

bewiesenen Fall reduzieren. Durch Induktion kann die Aussage auf beliebige Werte

n 2 N verallgemeinert werden.

DWT

c Susanne Albers

268/460

3.5 Momenterzeugende Funktionen fur kontinuierliche Zufallsvariablen

Fur diskrete Zufallsvariablen X haben wir die momenterzeugende Funktion

MX (s) = E[eXs ]

eingefuhrt. Diese Denition kann man unmittelbar auf kontinuierliche Zufallsvariablen

ubertragen. Die fur MX (s) gezeigten Eigenschaften bleiben dabei erhalten.

DWT

c Susanne Albers

3.5 Momenterzeugende Funktionen fur kontinuierliche Zufallsvariablen

269/460

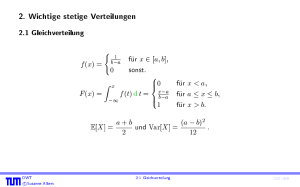

Beispiel 107

Fur eine auf [a; b] gleichverteilte Zufallsvariable U gilt

MU (t) = E[etX ] =

etx

= t(b a)

etb

eta

Z b

a

b

etx 1 dx

b a

a

= t(b a) :

DWT

c Susanne Albers

270/460

Beispiel (Forts.)

Fur eine standardnormalverteilte Zufallsvariable N

N (0; 1) gilt

Z +1

1

MN (t) = p

et e =2 d 2 1 Z

+1

e (t ) =2 d = et =2 p1

2 1

t

=

2

=e :

2

2

2

2

DWT

c Susanne Albers

3.5 Momenterzeugende Funktionen fur kontinuierliche Zufallsvariablen

271/460

Beispiel (Forts.)

Daraus ergibt sich fur Y

N (; 2) wegen Y N (0; 1)

MY (t) = E[etY ]

Y = et E[e(t) ]

= et MN (t)

= et+(t)2 =2 :

DWT

c Susanne Albers

272/460

Weiterer Beweis von Satz 106:

Beweis:

Gema dem vorhergehenden Beispiel gilt

MXi (t) = eti +(ti ) =2 :

Wegen der Unabhangigkeit der Xi folgt

2

MZ (t) = E[et(a1 X1 ++an Xn ) ] =

=

=

n

Y

i=1

n

Y

n

Y

i=1

E[e(ai t)Xi ]

MXi (ai t)

eai ti +(ai ti ) =2

2

i=1

= et+(t)2 =2 ;

mit = a1 1 + + an n und 2 = a21 12 + + a2n n2 .

DWT

c Susanne Albers

3.5 Momenterzeugende Funktionen fur kontinuierliche Zufallsvariablen

273/460

4. Zentraler Grenzwertsatz

Satz 108 (Zentraler Grenzwertsatz)

Die Zufallsvariablen X1 ; : : : ; Xn besitzen jeweils dieselbe Verteilung und seien

unabhangig. Erwartungswert und Varianz von Xi existieren fur i = 1; : : : ; n und seien

mit bzw. 2 bezeichnet ( 2 > 0).

Die Zufallsvariablen Yn seien deniert durch Yn := X1 + : : : + Xn fur n 1. Dann

folgt, dass die Zufallsvariablen

Yn n

p

n

asymptotisch standardnormalverteilt sind, also Zn N (0; 1) fur n ! 1.

Zn :=

DWT

c Susanne Albers

4 Zentraler Grenzwertsatz

274/460

Etwas formaler ausgedruckt gilt: Die Folge der zu Zn gehorenden

Verteilungsfunktionen Fn hat die Eigenschaft

lim F (x) = (x) fur alle

n!1 n

x 2 R:

Wir sagen dazu auch: Die Verteilung von Zn konvergiert gegen die

Standardnormalverteilung fur n ! 1.

DWT

c Susanne Albers

275/460

Dieser Satz ist von groer Bedeutung fur die Anwendung der Normalverteilung in der

Statistik. Der Satz besagt, dass sich die Verteilung einer Summe beliebiger

unabhangiger Zufallsvariablen (mit endlichem Erwartungswert und Varianz) der

Normalverteilung umso mehr annahert, je mehr Zufallsvariablen an der Summe

beteiligt sind.

DWT

c Susanne Albers

276/460

Beweis:

Wir betrachten Xi := (Xi )= fur i = 1; : : : ; n mit E[Xi ] = 0 und Var[Xi ] = 1.

Damit gilt (gema vorhergehendem Beispiel)

p

MZ (t) = E[etZ ] = E[et(X1 +:::+Xn )= n ]

p

p

= MX1 (t= n) : : : MXn (t= n) :

Fur beliebiges i betrachten wir die Taylorentwicklung von MXi (t) =: h(t) an der Stelle

t=0

h00 (0) 2

h(t) = h(0) + h0 (0) t +

t + O(t3):

Aus der Linearitat des Erwartungswerts folgt

2

h0 (t) = E[etXi Xi ] und h00 (t) = E[etXi (Xi )2 ]:

DWT

c Susanne Albers

4 Zentraler Grenzwertsatz

277/460

Beweis (Forts.):

Damit gilt

h0 (0) = E[Xi ] = 0 und h00 (0) = E[(Xi )2 ] = Var[X ] = 1:

Durch Einsetzen in die Taylorreihe folgt h(t) = 1 + t2 =2 + O(t3 ), und wir konnen

MZ (t) umschreiben zu

t2

t3

MZ (t) = 1 + + O 3=2

2n

n

n

! et =2 fur n ! 1:

2

Aus der Konvergenz der momenterzeugenden Funktion folgt auch die Konvergenz der

Verteilung. Damit ist Z asymptotisch normalverteilt.

DWT

c Susanne Albers

278/460

Beweis (Forts.):

Die momenterzeugende Funktion existiert leider nicht bei allen Zufallsvariablen und

unser Beweis ist deshalb unvollstandig. Man umgeht dieses Problem, indem man statt

der momenterzeugenden Funktion die so genannte charakteristische Funktion

M~ X (t) = E[eitX ] betrachtet. Fur Details verweisen wir auf die einschlagige

Literatur.

DWT

c Susanne Albers

279/460

Der Zentrale Grenzwertsatz hat die folgende intuitive Konsequenz:

Wenn eine Zufallsgroe durch lineare Kombination vieler unabhangiger,

identisch verteilter Zufallsgroen entsteht, so erhalt man naherungsweise eine

Normalverteilung.

DWT

c Susanne Albers

280/460

Ein wichtiger Spezialfall das Zentralen Grenzwertsatzes besteht darin, dass die

auftretenden Zufallsgroen Bernoulli-verteilt sind.

Korollar 109 (Grenzwertsatz von de Moivre)

X1 ; : : : ; Xn seien unabhangige Bernoulli-verteilte Zufallsvariablen mit gleicher

Erfolgswahrscheinlichkeit p. Dann gilt fur die Zufallsvariable Hn mit

Hn := X1 + : : : + Xn

fur n 1, dass die Verteilung der Zufallsvariablen

Hn :=

Hn np

np(1 p)

p

fur n ! 1 gegen die Standardnormalverteilung konvergiert.

DWT

c Susanne Albers

281/460

Beweis:

Die Behauptung folgt unmittelbar aus dem Zentralen Grenzwertsatz, da

= n1 E[Hn ] = p und 2 = n1 Var[Hn ] = p(1 p).

Bemerkung

Wenn man X1 ; : : : ; Xn als Indikatorvariablen fur das Eintreten eines Ereignisses A bei

n unabhangigen Wiederholungen eines Experimentes interpretiert, dann gibt Hn die

absolute Haugkeit von A an.

DWT

c Susanne Albers

4 Zentraler Grenzwertsatz

282/460

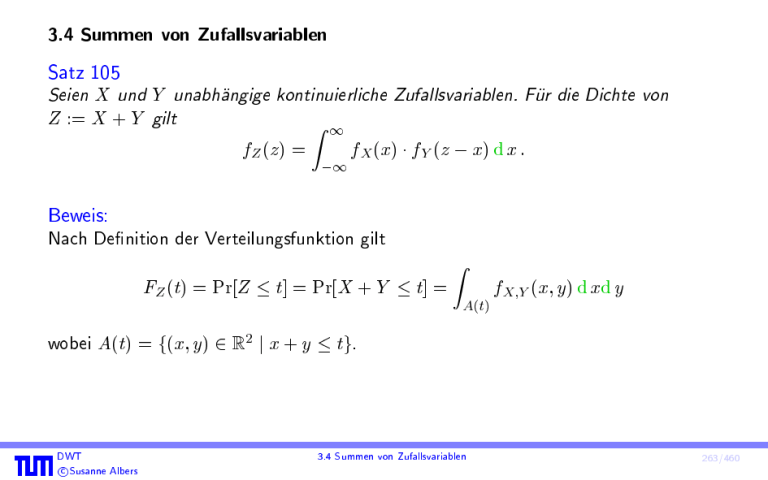

4.1 Normalverteilung als Grenzwert der Binomialverteilung

Korollar 109 ermoglicht, die Normalverteilung als Grenzwert der Binomialverteilung

aufzufassen. Die folgende Aussage ist eine Konsequenz von Korollar 109:

Korollar 110

Sei Hn Bin(n; p) eine binomialverteilte Zufallsvariable. Die Verteilung von Hn =n

konvergiert gegen N (p; p(1 p)=n) fur n ! 1.

DWT

c Susanne Albers

4.1 Normalverteilung als Grenzwert der Binomialverteilung

283/460

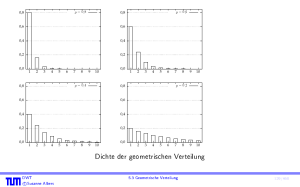

0.4

0.4

Bin(10, 0.3)

ϕ(x)

0.3

0.3

0.2

0.2

0.1

0.1

0.0

-4.0

-3.0

-2.0

-1.0

0.0

0.4

1.0

2.0

3.0

4.0

0.0

-4.0

0.3

0.2

0.2

0.1

0.1

-3.0

-2.0

-1.0

0.0

1.0

2.0

-3.0

-2.0

-1.0

0.0

0.4

Bin(50, 0.3)

ϕ(x)

0.3

0.0

-4.0

Bin(20, 0.3)

ϕ(x)

3.0

4.0

0.0

-4.0

1.0

2.0

3.0

4.0

3.0

4.0

Bin(100, 0.3)

ϕ(x)

-3.0

-2.0

-1.0

0.0

1.0

2.0

Vergleich von Binomial- und Normalverteilung

n; 0:3) bei 0:3n zentriert, mit

Bin(

DWT

c Susanne Albers

p0:3 0:7n horizontal gestaucht und vertikal gestreckt

4.1 Normalverteilung als Grenzwert der Binomialverteilung

284/460

Historisch gesehen entstand Korollar 109 vor Satz 108.

Fur den Fall p = 1=2 wurde Korollar 109 bereits von Abraham de Moivre (1667{1754)

bewiesen. De Moivre war geburtiger Franzose, musste jedoch aufgrund seines

protestantischen Glaubens nach England iehen. Dort wurde er unter anderem Mitglied

der Royal Society, erhielt jedoch niemals eine eigene Professur.

Die allgemeine Formulierung von Korollar 109 geht auf Pierre Simon Laplace

(1749{1827) zuruck. Allerdings vermutet man, dass die Losung des allgemeinen Falls

p 6= 1=2 bereits de Moivre bekannt war.

DWT

c Susanne Albers

285/460

4.2 Elementarer Beweis des Grenzwertsatzes von de Moivre fur p = 1=2

Wir betrachten die Wahrscheinlichkeit Pr[a H2n b] fur p = 1=2 und a; b 2 R mit

a b. Wenn die Verteilung von H2n , wieRin Korollar 109 angegeben, gegen N (0; 1)

konvergiert, so sollte Pr[a H2n b] ab '(t) d t fur genugend groe n gelten.

Wir schreiben f (n) 1 g (n) fur limn!1 f (n)=g (n) = 1, wollen also zeigen:

Pr[a H 2n b] 1

Z b

a

'(t) d t:

Da fur H2n Bin(2n; 1=2) gilt, dass E[H2n ] = n und Var[H2n ] = n=2 ist, erhalten wir

H2n n

;

H2n = p

n=2

DWT

c Susanne Albers

286/460

und es folgt

p

p

Pr[a H2n b] = Pr[n + a n=2 H2n n + b n=2]

X

= Pr[H2n = n + i]

i2In

p

p

fur In := fz 2 Z j a n=2 z b n=2g. Damit ist

2n

2n 1

2n b] =

n

+ i {z 2

i2In |

Pr[a H X

=:pn;i

DWT

c Susanne Albers

:

}

4.2 Elementarer Beweis des Grenzwertsatzes von de Moivre fur p = 1=2

287/460

Es gilt

2n

max pn;i pn := 2n

i

21

n

und mit der Stirling'schen Approximation fur n!

p

2n

n)! 1

= (2

(n!)2 2

;

(2n)2n e 2n p 2 2n 1 2n = p1 :

pn 1

2

n

(nn e n 2n)2

Ersetzen wir nun die pn;i durch pn , so entsteht dabei ein Fehler, den wir mit

qn;i := ppn;i

n bezeichnen.

DWT

c Susanne Albers

4.2 Elementarer Beweis des Grenzwertsatzes von de Moivre fur p = 1=2

288/460

Fur i > 0 gilt

qn;i =

=

2n 1 2n

n+i 2

2n 1 2n

2

n

Qi 1

j =0 (n j )

Qi

j =1 (n + j )

= (n + i(2)!n )!(n n! i)!n! (2n)!

i i

Y

Y

2

j 1

n j+1

=

1 n+j :

=

n+j

j =1

j =1

Wegen der Symmetrie der Binomialkoezienten gilt qn; i = qn;i , womit auch der Fall

i < 0 abgehandelt ist.

DWT

c Susanne Albers

289/460

Man macht sich leicht klar, dass 1

schlieen wir, dass

0

ln @

i

Y

j =1

p

1

1 A

1 2nj + j

1=x ln x x 1 fur x > 0 gilt. Damit

=

i

X

ln 1 2nj + j1

j =1

i

X

i

X

2

j 1

2j 1

n+j

n+i

j =1

j =1

2

3

= i(i n++1)i i = in + n(ni + i)

2

= in + O p1n ;

da i = O( n) fur i 2 In .

DWT

c Susanne Albers

4.2 Elementarer Beweis des Grenzwertsatzes von de Moivre fur p = 1=2

290/460

Ebenso erhalten wir

0

ln @

i

Y

j =1

1

1 A

1 2nj + j

=

i

X

1

j =1

i

X

1 2nj + j1

2j + 1 n j+1

j =1

i2

= n i =

Zusammen haben wir

e

i2

n i

=e

i2

n

O p1n

qn;i e

p

Wegen eO(1= n) = 1 o(1) folgt daraus qn;i

DWT

c Susanne Albers

1 e

i2

n

i

X

1!

2j 1

j =1

n i

O p1n :

i2 +O p1

n

n

i2 =n .

291/460

Damit schatzen wir nun Pr[a H2n b] weiter ab:

X

Pr[a H2n b] = pn qn;i 1

i2In

Mit :=

p1n |

X

i 2I n

e

{z

=:Sn

i2 =n :

}

p

2=n konnen wir die Summe Sn umschreiben zu

1 X e (i) :

Sn = p 2 i2In

2 1

2

R

R

2

Diese Summe entspricht einer Naherung fur ab '(t) d t = p12 ab e t =2 d t durch

Aufteilung der integrierten Flache in Balken der Breite

ur n ! 1 konvergiert die

R . F

Flache der Balken gegen das Integral, d. h. Sn 1 ab '(t) d t.

q. e. d.

DWT

c Susanne Albers

4.2 Elementarer Beweis des Grenzwertsatzes von de Moivre fur p = 1=2

292/460

4.3 Verschiedene Approximationen der Binomialverteilung

Sei Hn Bin(n; p) eine binomialverteilte Zufallsvariable mit der Verteilungsfunktion

Fn . Fur n ! 1 gilt

Fn (t) = Pr[Hn =n t=n]

!

t=n p

! p

=

p(1 p)=n

!

t np

p

:

p(1 p)n

Wir konnen Fn somit fur groe n durch approximieren. Diese Approximation ist in

der Praxis deshalb von Bedeutung, da die Auswertung der Verteilungsfunktion der

Binomialverteilung fur groe n sehr aufwandig ist, wahrend fur die Berechnung der

Normalverteilung eziente numerische Methoden vorliegen.

DWT

c Susanne Albers

4.3 Verschiedene Approximationen der Binomialverteilung

293/460

Beispiel 111

Wenn man die Wahrscheinlichkeit berechnen mochte, mit der bei 106 Wurfen mit

einem idealen Wurfel mehr als 500500-mal eine gerade Augenzahl fallt, so muss man

eigentlich folgenden Term auswerten:

T :=

10

X

106

6

i=5;00510

5

i

106

1

2

:

Dies ist numerisch kaum ezient moglich.

Die numerische Integration der Dichte ' der Normalverteilung ist hingegen relativ

einfach. Auch andere Approximationen der Verteilung , beispielsweise durch

Polynome, sind bekannt. Entsprechende Funktionen werden in zahlreichen

Softwarebibliotheken als black box\ angeboten.

"

DWT

c Susanne Albers

294/460

Beispiel

Mit der Approximation durch die Normalverteilung erhalten wir

5;005p 105 5 105

T 1 2;5 105

102

= 1 55 10

2

= 1 (1) 0;1573 :

DWT

c Susanne Albers

!

4.3 Verschiedene Approximationen der Binomialverteilung

295/460

Bei der Approximation der Binomialverteilung mit Hilfe von Korollar 109 fuhrt man oft

noch eine so genannte Stetigkeitskorrektur durch. Zur Berechnung von Pr[X x] fur

X Bin(n; p) setzt man

Pr[X x] xp+ 0;5 np

np(1 p)

statt

an.

DWT

c Susanne Albers

Pr[X x] p x np

np(1 p)

!

!

296/460

Der Korrekturterm lat sich in der Histogramm-Darstellung der Binomialverteilung

veranschaulichen. Die Binomialverteilung wird dort durch Balken angegeben, deren

Flache in etwa der Flache unterhalb der Dichte ' von N (0; 1) entspricht. Wenn man

die Flache der Balken mit X x\ durch das Integral von ' approximieren mochte, so

"

sollte man bis zum Ende des Balkens fur X = x\ integrieren und nicht nur bis zur

"

Mitte. Dafur sorgt der Korrekturterm 0;5.

DWT

c Susanne Albers

4.3 Verschiedene Approximationen der Binomialverteilung

297/460

Approximationen fur die Binomialverteilung

Approximation durch die Poisson-Verteilung: Bin(n; p) wird approximiert durch

Po(np). Diese Approximation funktioniert sehr gut fur seltene Ereignisse, d. h.

wenn np sehr klein gegenuber n ist. Als Faustregel fordert man n 30 und

p 0;05.

Approximation durch die Cherno-Schranken: Bei der Berechnung der tails der

Binomialverteilung liefern diese Ungleichungen meist sehr gute Ergebnisse. Ihre

Starke liegt darin, dass es sich bei den Schranken nicht um Approximationen,

sondern um echte Abschatzungen handelt. Dies ist vor allem dann wichtig, wenn

man nicht nur numerische Naherungen erhalten mochte, sondern allgemeine

Aussagen uber die Wahrscheinlichkeit von Ereignissen beweisen mochte.

DWT

c Susanne Albers

298/460

Approximation durch die Normalverteilung: Als Faustregel sagt man, dass die

Verteilungsfunktion Fn (t) von Bin(n; p) durch

p

Fn (t) ((t np)= p(1 p)n)

approximiert werden kann, wenn np 5 und n(1

DWT

c Susanne Albers

p) 5 gilt.

299/460

Kapitel III Induktive Statistik

1. Einfuhrung

Das Ziel der induktiven Statistik besteht darin, aus gemessenen Zufallsgroen auf die

zugrunde liegenden Gesetzmaigkeiten zu schlieen. Im Gegensatz dazu spricht man

von deskriptiver Statistik, wenn man sich damit beschaftigt, groe Datenmengen

verstandlich aufzubereiten, beispielsweise durch Berechnung des Mittelwertes oder

anderer abgeleiteter Groen.

DWT

c Susanne Albers

1 Einfuhrung

300/460

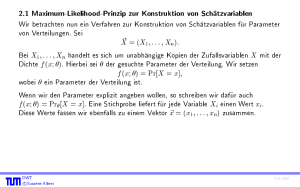

2. Schatzvariablen

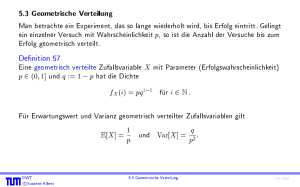

Wir betrachten die Anzahl X von Lesezugrien auf eine Festplatte bis zum ersten

Lesefehler und nehmen an, dass Pr[X = i] = (1 p)i 1 p, setzen also fur X eine

geometrische Verteilung an. Dahinter verbirgt sich die Annahme, dass bei jedem

Zugri unabhangig und mit jeweils derselben Wahrscheinlichkeit p ein Lesefehler

auftreten kann.

Unter diesen Annahmen ist die Verteilung der Zufallsvariablen X eindeutig festgelegt.

Allerdings entzieht sich der numerische Wert des Parameters p noch unserer Kenntnis.

Dieser soll daher nun empirisch geschatzt werden. Statt p konnen wir ebensogut E[X ]

bestimmen, da wir daraus nach den Eigenschaften der geometrischen Verteilung p

mittels p = E[1X ] berechnen konnen.

DWT

c Susanne Albers

2 Schatzvariablen

301/460

Dazu betrachten wir n baugleiche Platten und die zugehorigen Zufallsvariablen Xi (fur

1 i n), d. h. wir zahlen fur jede Platte die Anzahl von Zugrien bis zum ersten

Lesefehler. Die Zufallsvariablen Xi sind dann unabhangig und besitzen jeweils dieselbe

Verteilung wie X . Wir fuhren also viele Kopien eines bestimmten Zufallsexperiments

aus, um Schlusse auf die Gesetzmaigkeiten des einzelnen Experiments ziehen zu

konnen. Dies ist das Grundprinzip der induktiven Statistik. Die n Messungen heien

Stichproben, und die Variablen Xi nennt man Stichprobenvariablen.

DWT

c Susanne Albers

302/460

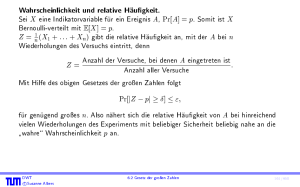

Grundprinzip statistischer Verfahren

Wir erinnern an das Gesetz der groen Zahlen (Satz 63) bzw. den Zentralen

Grenzwertsatz (Satz 108). Wenn man ein Experiment genugend oft wiederholt, so

nahert sich der Durchschnitt der Versuchsergebnisse immer mehr dem Verhalten an,

das man im Mittel\ erwarten wurde. Je mehr Experimente wir also durchfuhren, umso

"

genauere und zuverlassigere Aussagen konnen wir uber den zugrunde liegenden

Wahrscheinlichkeitsraum ableiten. Auf diesem Grundprinzip beruhen alle statistischen

Verfahren.

DWT

c Susanne Albers

303/460

Um E[X ] empirisch zu ermitteln, bietet es sich an, aus den Zufallsvariablen Xi das

arithmetische Mittel X zu bilden, das deniert ist durch

n

X

1

Xi :

X :=

n

i=1

Es gilt

E[X ] =

n

n

1X

1X

E[X ] =

E[X ] = E[X ]:

n i=1

i

n i=1

X liefert uns also im Mittel den gesuchten Wert E[X ]. Da wir X zur Bestimmung von

E[X ] verwenden, nennen wir X einen Schatzer fur den Erwartungswert E[X ]. Wegen

der obigen Eigenschaft ist X sogar ein so genannter erwartungstreuer Schatzer.

DWT

c Susanne Albers

2 Schatzvariablen

304/460

Denition 112

Gegeben sei eine Zufallsvariable X mit der Dichte f (x; ). Eine Schatzvariable oder

kurz Schatzer fur den Parameter der Dichte von X ist eine Zufallsvariable, die aus

mehreren (meist unabhangigen und identisch verteilten) Stichprobenvariablen

zusammengesetzt ist. Ein Schatzer U heit erwartungstreu, wenn gilt

E[U ] = :

Bemerkung:

Die Groe E[U

] nennt man Bias der Schatzvariablen U . Bei erwartungstreuen

Schatzvariablen ist der Bias gleich Null.

DWT

c Susanne Albers

305/460

Der Schatzer X ist also ein erwartungstreuer Schatzer fur den Erwartungswert von X .

Ein wichtiges Ma fur die Gute eines Schatzers ist die mittlere quadratische

Abweichung, kurz MSE fur mean squared error genannt. Diese berechnet sich durch

MSE := E[(U )2 ]. Wenn U erwartungstreu ist, so folgt

MSE = E[(U E[U ])2 ] = Var[U ].

Denition 113

Wenn die Schatzvariable A eine kleinere mittlere quadratische Abweichung besitzt als

die Schatzvariable B , so sagt man, dass A ezienter ist als B .

Eine Schatzvariable heit konsistent im quadratischen Mittel, wenn MSE ! 0 fur

n ! 1 gilt. Hierbei bezeichne n den Umfang der Stichprobe.

DWT

c Susanne Albers

306/460

Fur X erhalten wir wegen der Unabhangigkeit von X1 ; : : : ; Xn

"

n

1X

MSE = Var[X ] = Var

Xi

n

= n12

DWT

c Susanne Albers

n

X

i=1

#

i=1

Var[Xi ] = n1 Var[X ]:

307/460

Bei jeder Verteilung mit endlicher Varianz folgt MSE = O(1=n) und somit MSE ! 0

fur n ! 1. Der Schatzer X ist also konsistent.

Aus der Konsistenz von X im quadratischen Mittel konnen wir mit Hilfe des Satzes

von Chebyshev (siehe Satz 61) folgende Konsequenz ableiten. Sei " > 0 beliebig, aber

fest. Dann gilt

X]

!0

Pr[jX j "] = Pr[jX E[X ]j "] Var[

2

"

fur n ! 1. Fur genugend groe n liegen also die Werte von X beliebig nahe am

gesuchten Wert = E[X ]. Diese Eigenschaft nennt man auch schwache Konsistenz, da

sie aus der Konsistenz im quadratischen Mittel folgt.

DWT

c Susanne Albers

2 Schatzvariablen

308/460

Als nachstes betrachten wir eine weitere von X abgeleitete Schatzvariable:

S :=

v

u

u

t

1

n

X

n 1 i=1

(Xi X )2 :

Wir zeigen, dass S 2 ein erwartungstreuer Schatzer fur die Varianz von X ist. Sei

:= E[X ] = E[Xi ] = E[X ].

(

Xi

X )2 = (Xi

= (Xi

+ X )2

)2 + ( X )2 + 2(Xi

)2 + (

Xi

= (

=

DWT

c Susanne Albers

n

2

n

Xi

(

X )2

)2 + (

2

n

X

n j =1

X )2

2 Schatzvariablen

)(

(

Xi

2

)(Xj

X

n j 6=i

X)

(

Xi

)

)(Xj

):

309/460

Fur je zwei unabhangige Zufallsvariablen Xi , Xj mit i 6= j gilt

E[(Xi )(Xj )] = E[Xi ] E[Xj ]

= (E[Xi ] ) (E[Xj ] ) = 0 0 = 0:

Daraus folgt

n 2

E[(Xi )2] + E[( X )2]

n

= n n 2 Var[Xi ] + Var[X ]:

E[(Xi X )2 ] =

DWT

c Susanne Albers

310/460

Wegen Var[Xi ] = Var[X ] und Var[X ] = n1 Var[X ] folgt nun

E[(Xi X )2 ] =

n 1

Var[X ];

n

und somit gilt fur S 2

E[S 2 ] =

1

n

X

E[(Xi X )2 ]

n 1 i=1

= n 1 1 n n n 1 Var[X ] = Var[X ]:

S 2 ist also eine erwartungstreue Schatzvariable fur die Varianz von X .

DWT

c Susanne Albers

311/460

Die vorangegangene Rechnung erklart, warum man als Schatzer nicht

n

1X

(X

n i=1

i

!

X )2 6= S 2

verwendet, wie man vielleicht intuitiv erwarten wurde.

DWT

c Susanne Albers

2 Schatzvariablen

312/460

Denition 114

Die Zufallsvariablen

X :=

n

n

1X

1 X

Xi und S 2 :=

(Xi X )2

n

n 1

i=1

i=1

heien Stichprobenmittel bzw. Stichprobenvarianz der Stichprobe X1 ; : : : ; Xn . X und

S 2 sind erwartungstreue Schatzer fur den Erwartungswert bzw. die Varianz.

DWT

c Susanne Albers

313/460