J2EE Persistenzmanagement Architekturen

Werbung

Klassifizierung und Bewertung von

Persistenz-Management Technologien in

J2EE Architekturen

unter besonderer Betrachtung von

Skalierbarkeit und Ausfallsicherheit

Thomas Hertz

Diplomarbeit

Technische Universität München

Fakultät für Informatik

Aufgabensteller: Prof. Dr. rer. nat. Florian Matthes

Betreuer: Dipl. Inf. Thomas Büchner

15. Mai 2003

2

ERKLÄRUNG

Ich versichere, dass ich diese Diplomarbeit selbständig verfasst und nur die angegebenen

Quellen und Hilfsmittel verwendet habe.

München, Mai 2003....................................................................................................Thomas Hertz

3

„All efforts to replace N technologies by 1 new technology

usually end up with N plus 1 technologies.”

OMG EAI/Workshop 2000

4

INHALTSVERZEICHNIS

Erklärung ............................................................................................................................................ 3

Inhaltsverzeichnis.............................................................................................................................. 5

Abbildungs- und Tabellenverzeichnis ............................................................................................ 7

1

2

3

4

5

Einleitung ................................................................................................................................... 9

1.1

Motivation........................................................................................................................ 9

1.2

Einordnung und Vorgehensweise .............................................................................. 10

1.3

Gliederung ..................................................................................................................... 11

1.4

Danksagung ................................................................................................................... 12

Aufbau komplexer Client/Server Anwendungen............................................................... 13

2.1

Übersicht und Anforderungen.................................................................................... 13

2.2

Die Mehrschichten-Architektur als mögliche Lösung ............................................ 14

2.3

Ausfallsicherheit............................................................................................................ 16

2.4

Lastverteilung zur Erreichung von Ausfallsicherheit .............................................. 17

Datenbanksysteme .................................................................................................................. 21

3.1

Übersicht........................................................................................................................ 21

3.2

Die wichtigsten Zugriffsschnittstellen....................................................................... 22

3.3

Transaktionen................................................................................................................ 25

3.4

Praxisbeispiel ................................................................................................................. 28

Java 2 Enterprise Edition....................................................................................................... 29

4.1

Übersicht........................................................................................................................ 29

4.2

Enterprise JavaBeans.................................................................................................... 30

4.3

Die EJB-Persistenz-Schnittstellen.............................................................................. 33

4.4

Transaktionen in EJB-Architekturen......................................................................... 40

O/R-Mapping.......................................................................................................................... 45

5.1

Übersicht und Gliederung........................................................................................... 45

5.2

Datenhaltung................................................................................................................. 45

5.3

Datenzugriff .................................................................................................................. 52

5.4

Caching........................................................................................................................... 59

5

6

CCMP – Cached CMP ........................................................................................................... 75

7

6.1

DCache .......................................................................................................................... 76

6.2

CMP2BMP .................................................................................................................... 87

6.3

J2EEDemo.................................................................................................................... 94

6.4

Performance .................................................................................................................. 96

Bewertung und Ausblick........................................................................................................ 99

Anhang 1: Nutzung des Prototyps ............................................................................................. 103

Allgemein ............................................................................................................................... 103

DCache................................................................................................................................... 108

CMP2BMP............................................................................................................................. 112

J2EEDemo ............................................................................................................................ 114

Literaturverzeichnis....................................................................................................................... 119

6

ABBILDUNGS- UND

TABELLENVERZEICHNIS

Abbildung 1: Strukturierung dieser Arbeit ..................................................................................10

Abbildung 2: Aufbau eines komplexen Client/Server Systems................................................15

Abbildung 3: Verteiltes Relationales Datenbanksystem (RDBMS) .........................................22

Abbildung 4: EJB-Architektur.......................................................................................................31

Abbildung 5: Definition eines Enterprise JavaBeans.................................................................35

Abbildung 6: Anwendung des Serialized LOB Patterns............................................................48

Abbildung 7: Anwendung des Single Inheritance Patterns.......................................................49

Abbildung 8: Brute-Force Datenzugriff nach [Amb03]..............................................................53

Abbildung 9: Datenzugriff mittels Data Access Objects (DAO).............................................54

Abbildung 10: Trennung von logischer und physikalischer Schicht beim Datenzugriff ......55

Abbildung 11: Nutzung eines Persistenzframeworks ................................................................55

Abbildung 12: Synchronisation in verteilten Caches..................................................................62

Abbildung 13: Zugriffszeit nach Ort der Datenhaltung ............................................................66

Abbildung 14: Wege durch den Intra- und Inter-Transaction Cache......................................71

Abbildung 15: Automatisches Auffinden von Abhängigkeiten................................................72

Abbildung 16: Die einzelnen Komponenten des CCMP-Frameworks...................................76

Abbildung 17: Architekturübersicht DCache..............................................................................77

Abbildung 18: DCache-Baumstruktur für das Cachen von Entity-Beans ..............................79

Abbildung 19: Sequenzdiagramm eines Cachezugriffs ..............................................................80

Abbildung 20: Architekturübersicht des JDBCWrappers .........................................................86

Abbildung 21: Zwei Wege zur Implementierung einer eigenen EJB-Persistenzschicht.......88

Abbildung 22: Mögliche Einsprungpunkte für Cachesysteme .................................................90

Abbildung 23: Ablauf der CMP zu BMP Konvertierung..........................................................91

Abbildung 24: Architekturübersicht BMP2CMP-Framework..................................................93

Abbildung 25: Architekturübersicht J2EEDemo .......................................................................95

Abbildung 26: Performancevergleich CMP / CCMP ................................................................98

7

Tabelle 1: Verfügbarkeit von Systemen nach [GS91]................................................................. 17

Tabelle 2: Isolationslevel bei Transaktionen ............................................................................... 27

Tabelle 3: Einfaches O/R-Mapping nach [CK96]...................................................................... 46

Tabelle 4: Benötigte Metadaten zum Zugriff über ein Persistenzframework ........................ 56

Tabelle 5: Beispielhaftes Typ-Mapping von Java zu SQL......................................................... 58

Tabelle 6: Gegenüberstellung EJB und CRUD-Pattern............................................................ 88

Tabelle 7: Konfiguration des Microsoft Web Application Stress Tool................................... 97

Tabelle 8: Verzeichnisstruktur des Prototyps ........................................................................... 105

Tabelle 9: Verzeichnisstruktur DCache ..................................................................................... 109

Tabelle 10: Konfigurationsparameter des DCache-Frameworks........................................... 109

Tabelle 11: Verzeichnisstruktur des CMP2BMP-Frameworks............................................... 113

Tabelle 12: Konfigurationsparameter des CMP2BMP-Frameworks..................................... 113

Tabelle 13: Verzeichnisstruktur der J2EE-Demoapplikation................................................. 115

8

1 EINLEITUNG

1.1 Motivation

Die Nutzung von Applikationsservern im Rahmen geschäftlicher Anwendungsarchitekturen ist heutzutage nahezu zwingend. Durch sie wird eine Reihe von Technologien wie z.B.

Webserver, Transaktionsmonitor oder Messaging-System zu einem gut harmonierenden

und in sich schlüssigen Framework zusammengefügt. Neben der Bereitstellung einer

Umgebung für die Ausführung von Business-Logik realisieren sie auch die so wichtige

Verbindung zu Datenbanksystemen. Ziel der Applikationsserver ist es, die Entwicklung

eines modularen, ausfallsicheren und hochskalierbaren Systems zu ermöglichen.

Im Java-Umfeld setzt sich J2EE (Java 2 Enterprise Edition) [Sun01a] einschließlich der

Komponententechnologie EJB (Enterprise JavaBeans) [Sun01c] für Applikationsserver

immer mehr durch. EJB bietet einen Rahmen für die Entwicklung von BusinessFunktionalität und nimmt dem Entwickler immer wiederkehrende Aufgaben wie SecurityManagement, Transaktionssicherung oder Datenspeicherung ab.

Wie bereits angedeutet ist eine der Hauptaufgaben eines Applikationsservers die Anbindung aller Arten von Datenbanksystemen. Die J2EE-Spezifikation bietet auch hier einige

Hilfen für den Entwickler, ist aber leider in diesem Bereich teilweise nur sehr vage

formuliert oder adressiert wichtige Punkte gar nicht. Für die Speicherung der BusinessObjekte in einem relationalen Datenbanksystem stehen nur vergleichsweise einfache

Abbildungs- und Abfragemöglichkeiten zur Verfügung.

Die Integration bestehender Datenbanksysteme mit moderner Komponententechnik kann

somit von den heutigen Applikationsservern oft nicht ohne weitere Hilfsmittel geleistet

werden. Vor diesem Hintergrund sind Mechanismen notwendig, die eine flexible

Abbildung von Operationen und Anfragen der EJB-Objekte auf relationale Datenbanken

ermöglichen. Diese Aufgabenstellung wird üblicherweise durch Persistenz-Frameworks

erfüllt.

Die EJB-Spezifikation bietet zwei grundsätzliche Varianten für die Objekt-Persistenz an:

CMP (Container-Managed Persistence) [Sun01d, S. 125ff] und BMP (Bean-Managed

Persistence) [Sun01d, S. 243ff]. Doch muss für die Integration eines Persistenz-Frameworks

in den Applikationsserver eine detailliertere Betrachtung erfolgen, da zum einen keine

standardisierten Schnittstellen zwischen Applikationsserver und Persistenz-Framework

spezifiziert sind und zum anderen der Einsatz der so genannten Entity-Beans nicht bei

jedem Applikationsserver eine performante, ausfallsichere und hochskalierbare Architektur

gewährleistet.

Bei der Integration ist nicht nur die Frage zu lösen, wie die EJB-Technologie an das

Persistenz-Framework angebunden werden kann. Es stellt sich auch die Frage, ob und

wann ein Transaktionssystem nötig ist, wie dieses an den Applikationsserver angebunden

9

werden kann und ob das entstehende Gesamtsystem in der Praxis ausreichend viele

Transaktionen verarbeiten kann, um in großen verteilten Anwendungsarchitekturen

[Web98] einsetzbar zu sein.

1.2 Einordnung und Vorgehensweise

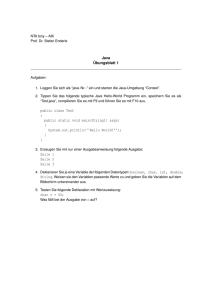

Abbildung 1 verdeutlicht die grobe Strukturierung dieser Arbeit. Der erste Teil widmet sich

den einzelnen Architektur-Schichten einer komplexen Client/Server-Architektur. Dies

beinhaltet eine Vorstellung der wichtigsten Persistenzmanagementschnittstellen der EJBArchitektur, der Auswahl von geeigneten Datenbanksystemen und Lösungen zur Erreichung von Skalierbarkeit und Ausfallsicherheit auf diesen Bereichen.

Kapitel 6

Client

Kapitel 2

Load-Balancer

Kapitel 4

CMP

CMP

BMP

Kapitel 5

CMPContainer

BMP

Generated

BMP

O/R-Mapping

JDBC-Treiber

Kapitel 3

DB

Abbildung 1: Strukturierung dieser Arbeit

Dies ist die Annäherung an den Kern dieser Arbeit, die genauere Betrachtung des

Persistenzmanagements, welches vor allem durch das sogenannte O/R-Mapping (ObjektRelationales Mapping) bestimmt wird. Es werden Architektur- und Entwurfsmuster

vorgestellt, mit deren Hilfe man den Zugriff auf relationale Daten von objektorientierten

Programmiersprachen und das intelligente Zwischenspeichern (engl. Caching) von häufig

benötigten Daten in einem verteilten System lösen kann. Es wird aufgezeigt, wie sich diese

Muster in J2EE-Systeme integrieren und damit unter der einheitlichen Programmierschnittstelle für Enterprise JavaBeans nutzbar machen lassen.

10

Nachdem dieser erste Teil der Diplomarbeit die horizontalen Architekturschichten näher

beleuchtet hat, wird im zweiten Teil der praktische Einsatz der erlangten Ergebnisse durch

den Entwurf eines Prototyps belegt. Dieser zeigt als eine Art ‚vertikaler Durchstoss’ die

beispielhafte Implementierung der vorgestellten Muster. Desweiteren werden anhand von

zwei Produktvorstellungen (Oracle Real Application Cluster und HP Traffic Director) in

den jeweiligen Kapiteln aufgezeigt, wie die Herausforderungen an komplexe skalierbare

und ausfallsichere Systeme im Bereich der Datenhaltung und der Lastverteilung in der

Praxis gelöst werden können. Den Abschluss bilden eine Bewertung der heutigen Technologien und Verfahren und ein Ausblick in die nähere Zukuft.

1.3 Gliederung

Kapitel 2, Aufbau komplexer Client/Server Anwendungen, stellt eine Einführung in

das Gebiet der Client/Server Anwendungen dar. Es werden die Anforderungen an komplexe und verteilte Mehrschichten-Systeme aufgezeigt. Auch wird die Bedeutung der

Lastverteilung für die Erfüllung der wichtigen Anforderungen Skalierbarkeit und Ausfallsicherheit anhand von praxisbezogenen Lösungen erwähnt und beschrieben. Es findet eine

Einordnung statt, in welche Bereiche diese Arbeit vordringen will und welche Gebiete

nicht oder nicht ausführlich behandelt werden.

In Kapitel 3, Datenbanksysteme, wird der Aufbau von Datenbanksystemen erklärt, es

wird der Unterschied zwischen objektorientierten und relationalen Datenbanksystemen

aufgezeigt und die Frage beantwortet, warum relationale Datenbanken immer noch die

erste Wahl bei der Verwaltung von großen Datenmengen sind. Nach einer Einführung in

die Theorie der Transaktionsverwaltung werden die wichtigsten Zugriffsschnittstellen

(SQL, JDBC, SQLJ) für die Benutzung in Java-Programmen vorgestellt. Anhand des

Produktes Oracle Real Application Cluster wird bestätigt, dass transparente, skalierbare und

ausfallsichere Datenbanksysteme auf dem Markt verfügbar sind.

Kapitel 4, Java 2 Enterprise Edition, geht nach einer grundsätzlichen Einführung der

Java 2 Enterprise Edition (J2EE) und der Komponententechnologie Enterprise JavaBeans

(EJB) auf die Persistenzschnittstellen CMP (Container Managed Persistence) und BMP

(Bean Managed Persistence) ein. Auch werden die Abfragesprache EJB QL (Enterprise

JavaBeans Query Language) und ihre Vor- und Nachteile ausführlich behandelt.

Abschließend wird aufgezeigt, welche Unterstützung J2EE im Bereich der

Transaktionsverwaltung durch CMT (Container Managed Transactions) anbietet und wie es

möglich ist, manuelle Transaktionssteuerung mittels BMT (Bean Managed Transactions) zu

betreiben.

Kapitel 5, O/R-Mapping, geht auf die Notwendigkeit ein, eine Schnittstelle zwischen der

objektorientierten Geschäftslogikschicht und der relationalen Datenbankschicht zu

benutzen. Es werden verschiedene Architektur- und Entwurfsmuster vorgestellt, die dieses

sogenannte Objekt-Relationale Mapping lösen können. Es wird im Detail über die

Notwendigkeit referiert, Daten in verteilten und skalierten Systemen oberhalb der

11

Datenbankschicht zwischenzuspeichern (zu cachen), und Lösungen hierzu aufgezeigt.

Auch die möglichen Folgen für die Transaktionssicherheit bei Verwendung von Caches

werden ausführlich erläutert.

Kapitel 6, CCMP – Cached CMP, beschreibt die genaue Architektur und den Aufbau des

im Rahmen dieser Diplomarbeit entworfenen und implementierten Prototyps mitsamt

seiner drei Komponenten

·

DCache, ein Framework für einen verteilten, transaktionssicheren Cache für

beliebige Javaobjekte,

·

CMP2BMP, ein Konverter, der aus CMP Entity-Beans BMP Entity-Beans erzeugt

und unter Nutzung der DCache-Komponente die Persistenzschicht selbst generiert,

·

J2EEDemo, eine J2EE-Beispielapplikation, an der das Zusammenspiel von DCache

und CMP2BMP demonstriert werden kann.

1

Die Beschreibungen des Prototyps werden durch UML -Klassen- und Sequenzdiagramme

weiter verdeutlicht.

Kapitel 7, Bewertung und Ausblick, fasst die im Zuge dieser Arbeit gewonnenen Erkenntnisse zusammen. Es wird aufgezeigt, welche Probleme bei der Anwendung der J2EEPlattform im Bereich Skalierbarkeit, Ausfallsicherheit und Performance zur Zeit noch

existieren und in welche Richtung die zukünftige Entwicklung geht oder gehen sollte, um

möglichst vielen der nötigen Anforderungen gerecht zu werden.

Anhang 1, Nutzung des Prototyps, dient als Handbuch für die Benutzung und Weiterentwicklung der einzelnen Prototyp-Komponenten DCache, CMP2BMP und J2EEDemo.

1.4 Danksagung

Ich danke allen, die mir bei dieser Arbeit geholfen haben: Herrn Prof. Dr. Matthes, der es

mir ermöglicht hat, über dieses interessante Thema zu schreiben, Thomas Büchner für

seine wertvollen Tipps, Martin, Andreas, Tom für das Korrekturlesen, Sabine für ihre

Fähigkeit, mich immer wieder auf andere Gedanken zu bringen, Jeanette für die seelische

Unterstützung, meinen Eltern und meiner Schwester für die Bereitstellung des sonnigen

Gartens, hybris für die Freizeit und R.E.M., deren Musik mich während der gesamten

Vorbereitungs- und Schreibarbeit begleitet hat.

1

UML ist eingetragenes Warenzeichen der Object Management Group (OMG). Für mehr Informationen

über die Unified Modelling Language siehe [OMG03].

12

2 AUFBAU KOMPLEXER CLIENT/SERVER

ANWENDUNGEN

2.1 Übersicht und Anforderungen

Ein Client/Server-System [Gei95] besteht aus zwei verschiedenen Arten von Rechnern Client-Rechnern und Server-Rechnern - die durch ein Netzwerk miteinander verbunden

sind. Die Client-Rechner sind Arbeitsstationen der einzelnen Anwender, während der

Server-Rechner die Geschäftslogik steuert und die Daten (Informationen, Dateien oder

Computerprogramme) hält, die für diese Arbeit benötigt werden.

Benutzer der Client-Rechner arbeiten mit einer Client-Software zur Abfrage der benötigten

Daten am Server. Dies ist in der Praxis bei webbasierten Anwendungen ein sogenannter

Web-Browser, der die Informationen darstellt. Die Server-Software, die auf dem ServerRechner ausgeführt wird, erhält die Datenabfragen und gibt daraufhin entsprechende

Ergebnisse an den Client-Rechner zurück. Typisch für solche Anwendungen ist, dass die

Initiative (der Aufruf des Dienstes) vom Client ausgeht, und ein Server von vielen Clients

aufgerufen werden kann und somit hohe Transaktionsraten auftreten können.

Voraussetzung für das Client/Server-Computing ist die optimale Interoperabilität zwischen

den verwendeten Systemen. Das setzt offene Architekturen voraus, die sich durch

standardkonforme Implementierungen bei den Schnittstellen und den Funktionen

abzeichnen.

Die Verteilung der Serverseite auf mehrere Rechner macht ein verteiltes, skaliertes System

aus. Dadurch wird außer der verteilten Präsentation auf mehreren Client-Rechnern auch

die Server-Software oder ein Teil von ihr dezentralisiert.

An die Entwicklung verteilter Client/Server Anwendungen werden eine Reihe von

Anforderungen gestellt:

·

Skalierbarkeit. Die Anwendung muss ohne großen Aufwand aufrüstbar sein um

auch für eine gesteigerte Last dem einzelnen Benutzer schnelle Antwortzeiten zu

bieten. Das System muss verteilbar auf mehrere physikalische Server sein, man

spricht hier von Verteilten Systemen (engl. Distributed Systems, [TS01])

·

Robustheit. Die Anwendung sollte 24 Stunden an 7 Tagen in der Woche

einsatzfähig sein, das bedeutet es soll keine oder eine möglichst geringe ungewollte

Ausfallzeit (engl. Downtime) geben. Es darf nicht zu inkonsistenten Zuständen

innerhalb der Applikation durch Fehlverhalten oder Absturz der Anwendung

kommen.

13

·

Portabilität. Die Anwendung sollte plattformunabhängig sein. Dies bedeutet, dass

sie ohne oder mit sehr wenigen Anpassungen auf verschiedenen Hardware- und

Betriebssystemplattformen eingesetzt werden kann. Die Programmiersprache Java

2

bietet beispielsweise eine hohe Portabilität. (Write Once, Run Anywhere )

·

Sicherheit. Die Sicherheit des Benutzers darf nicht beeinträchtigt werden. Es muss

Konzepte für die Vergabe von Rechten und Zugriffsbeschränkungen auf Teilbereiche der Anwendung geben. Es darf nicht möglich sein, ohne entsprechende

Autorisation an schützenswerte Informationen und Daten zu gelangen.

·

Wiederverwendbarkeit. Die Anwendung soll klare Schnittstellen aufweisen und

komponenten-basiert aufgebaut sein. Dadurch können einzelne Teile sehr einfach

in anderen Systemen wieder verwendet werden. Dies spart Entwicklungszeit und

damit Kosten.

·

Integrationsfähigkeit. Die Anwendung soll leicht auf externe Programme und

Datenquellen zugreifen können. Des Weiteren muss es möglich sein, die

Anwendung oder Teile von ihr in andere Fremdsysteme einzubetten. Hohe

Wiederverwendbarkeit fördert meist auch die Integrationsfähigkeit von Systemen.

·

Wartbarkeit. Änderungen der Anwendung müssen für Benutzer sofort verfügbar

3

gemacht werden können (z.B. Hot Deployment in J2EE-basierten Systemen).

Änderungen an der Konfiguration müssen schnell und sicher durchgeführt werden

können.

2.2 Die Mehrschichten-Architektur als mögliche Lösung

Anwendungen sind von den Anfängen des Internets bis heute durch ganz verschiedene

Entwicklungen und Techniken geprägt worden. Neben der so genannten Ein-SchichtArchitektur, z.B. einfaches statisches HTML, sind heutzutage vielfältige Lösungen mit

mehr als einer Architektur-Schicht im Internet zu finden. Zahlreiche serverseitige

Programmier- und Skriptsprachen bereichern die Anwendungsentwicklung. Der

Komplexitätsgrad der Anwendungen steigt hierbei zudem noch durch die Verwendung von

unterschiedlichen Hardware- und Softwarelösungen.

Um einigen der im letzten Kapitel vorgestellten und immer wichtiger werdenden

Anforderungen an komplexe Client/Server Anwendungen wie Skalierbarkeit, Robustheit,

Portabilität, Sicherheit und Integration genügen zu können, wechseln immer mehr Anbieter

von den typischen Ein- oder Zweischichtenarchitekturen auf Mehrschichtenarchitekturen

mit mindestens drei Ebenen.

2

3

‚Write Once, Run Anywhere’ ist ein Warenzeichen von Sun Microsystems Inc.

Feature verschiedener J2EE Server, bei dem bestimmte Verzeichnisse vom Server zur Laufzeit überwacht

und neue Applikationen automatisch erkannt und aktiviert werden.

14

Die mit diesem Wechsel verbundene stärkere Trennung von Präsentationslogik,

Geschäftslogik und Datenhaltungsschicht und die Festigung von Schnittstellen zwischen

den einzelnen Ebenen hat zu einer viel höheren Modularisierung und damit

Wiederverwendbarkeit geführt. Durch das Vorhandensein von klaren Schnittstellen können

sich Hersteller auf das Entwickeln einzelner Komponenten spezialisieren. Diese

Komponenten können leichter in andere Systeme integriert werden und in zukünftigen

Projekten mit wenigen Anpassungen erneut verwendet werden.

Dies macht deutlich, dass wichtige Anforderungen, die an die Entwicklung von verteilten

Client/Server Anwendungen gestellt werden, sich mit Hilfe von MehrschichtenArchitekturen lösen lassen.

Clients

Ausfallsicherheit /

Skalierbarkeit

Loadbalancer

Präsentation

Präsentation

Präsentation

Funktionalität

Funktionalität

Funktionalität

Ausfallsicherheit /

Skalierbarkeit

Persistenzmanagement

DB

DB

Abbildung 2: Aufbau eines komplexen Client/Server Systems

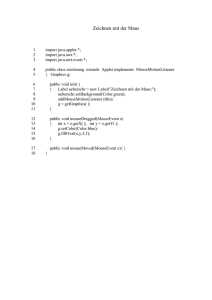

Der typische Aufbau einer solchen Mehrschichten-Architektur wird in Abbildung 2

vorgestellt. Es ist eine vorgelagerte Schicht zu sehen, die zwischen der Client- und der

Präsentationsschicht liegt. In dieser Schicht werden große Teile der wichtigen

Anforderungen Ausfallsicherheit und Skalierbarkeit durch so genannte Loadbalancer

(Lastverteilungssysteme) erfüllt. Dieser Vorgang wird unten detaillierter beschrieben.

15

2.3 Ausfallsicherheit

Die Begriffe Ausfallsicherheit oder Verfügbarkeit kann man als den Umfang bezeichnen, in

dem ein System gegen Störungen unempfindlich ist und korrekt nach seinen Vorgaben

arbeitet. Vor einer genaueren Definition fehlt noch eine Erläuterung, was unter einem

System zu verstehen ist, das ‚fehlerfrei’ oder ‚korrekt nach seinen Vorgaben’ arbeitet.

Hierbei ist nicht nur die physikalische Funktionstüchtigkeit zu verstehen, also die

Verfügbarkeit der Hardware und Netzwerkinfrastruktur, sondern auch die logische

Funktionstüchtigkeit. Ein System, welches für die Kunden zu langsam reagiert, also bei

bestehender Nutzerlast keine ausreichende Performance bietet, ist nicht verfügbar im Sinne

der Definition. Auch fallen logische Fehler im Programmablauf und undeterminiertes

Verhalten in diese Kategorie.

Zwei wichtige Begriffe im Zusammenhang mit Ausfallsicherheit sind die folgenden:

·

MTTF (mean-time-to-failure) ist die durchschnittliche Zeit, welche ein System ohne

Fehler arbeitet, nachdem es aufgesetzt oder repariert worden ist.

·

MTTR (mean-time-to-repair) ist die durchschnittliche Zeit, die benötigt wird, ein

fehlerhaftes System zu reparieren.

Mit diesem Hintergrund kann man den Begriff Ausfallsicherheit (engl. Availability) nun wie

folgt definieren:

Availabili ty =

MTTF

(MTTF + MTTR )

Die Aussage “It is paradoxical that the larger a system is, the more critical is its availability,

and the more difficult it is to make it highly-available.” [GS91] macht deutlich, wie schwierig

es ist, in komplexen Systemen eine hohe Ausfallsicherheit zu erreichen. Die derzeit

ausfallsichersten Systeme liegen nach Tabelle 1 im Bereich der High-availability

(Hochverfügbarkeit), sie weisen also eine Ausfallzeit von nur 5 Minuten pro Jahr auf.

16

System Type

Down Time

(Minutes per year)

Availability

Unmanaged

50000

90%

Managed

5000

99%

Well-managed

500

99.9%

Fault-tolerant

50

99.99%

High-availability

5

99.999%

Very-high-availability

.5

99.9999%

Ultra availability

0.05

99.99999%

Tabelle 1: Verfügbarkeit von Systemen nach [GS91]

2.4

Lastverteilung zur Erreichung von Ausfallsicherheit

A distributed system is one in which the failure of a computer you didn’t even know

existed can render your own computer unusable. (Leslie Lamport)

Lastverteilung (engl. Loadbalancing) bezeichnet die Aufgabe, Anfragen von Clients nach

einer bestimmten Strategie auf einen bestimmten zuständigen Server weiterzuleiten. Die

Aufgabe der Lastverteilung ist immer dann nötig, wenn zur Erreichung von Skalierbarkeit

und Ausfallsicherheit bestimmte Bereiche des Systems redundant ausgelegt werden. Diese

Redundanz dient dazu, ein System ohne oder mit möglichst wenigen sogenannten

einzelnen Ausfallpunkten (engl. Single Points of Failure) zu erhalten [GS96].

Da aber eine Anfrage typischerweise von nur genau einem Server bearbeitet wird, muss

darüber entschieden werden, an welchen Server die Anfrage geleitet werden soll.

In der Praxis findet man sehr häufig zwei Strategien, nach denen diese Entscheidung

getroffen wird. Eine sehr einfach zu implementierende Möglichkeit ist die Anwendung des

4

so genannte Round-Robin Verfahrens, welches hintereinander in fester Reihenfolge über

die Menge aller verfügbaren Server iteriert um danach wieder beim ersten zu beginnen.

4

Eine mögliche Herkunft des Wortes Round-Robin ist die französische Bezeichnung rond ruban (rundes Band),

mit der eine Petition bezeichnet wurde, bei der die Unterschriften im Kreis herum geschrieben wurden, um

die Reihenfolge zu verschleiern, in der sie geleistet wurden.

17

Eine weitere, aber durchaus anspruchsvollere und schwieriger zu implementierende

Strategie ist das Load-based oder lastbasierte Verfahren, bei dem ständig die Auslastung der

verfügbaren Server protokolliert wird und diejenigen Server mit hoher Auslastung weniger

Anfragen zugewiesen bekommen. Dadurch wird erreicht, dass die hoch ausgelasteten

Server entlastet werden. Durch die entstehende Dynamik stellt sich mit fortlaufender Zeit

ein Gleichgewicht in der Auslastung aller Rechner ein. Eine gute Einführung zu HTTPLoadbalancing-Strategien bietet [GT02, Kapitel 20].

Ein kritischer Punkt in einem Lastverteilungssystem ist die Erkennung von Fehlern und die

entsprechende Reaktion darauf. Dies entscheidet auch über die Ausfallsicherheit des

gesamten Systems. Der Loadbalancer ist dafür verantwortlich zu erkennen, welche unter

ihm arbeitenden Server in einem vorher zu definierenden Rahmen korrekt und mit für die

Clients erträglicher Performance arbeiten. Anfragen dürfen nicht an Server geleitet werden,

die ausgefallen sind, überlastet sind oder in sonstiger Art nicht korrekt arbeiten (z.B. durch

Liefern korrupter Ausgaben). Diese müssen aus der Verteilung ausgeschlossen und die

Clients auf andere Server geleitet werden. Nur eine gute und zuverlässige Strategie in

diesem Punkt garantiert eine weitgehende Ausfallsicherheit des Systems.

Aus diesem Punkt kann man die folgende Aussage ableiten:

Ausfallsicherheit = Skalierbarkeit + gute Fehlererkennung

Da Loadbalancer einzelne Anfragen nicht selbst beantworten müssen, sondern diese nur

5

weiterleiten , werden keine großen Anforderungen an die Rechenleistung gestellt. Der

natürlich vorhandene Bedarf an Netzwerkressourcen kann oftmals durch Maßnahmen wie

z.B. Local Triangulation [Rad01] oder Out-Of-Path-Return [Hew03a] noch weiter gesenkt

werden. Die dem Autor bekannten Systeme sind im Praxiseinsatz nicht an ihre

Leistungsgrenzen gestoßen und waren auch für große verteilte Systeme mit hoher

Transaktionszahl geeignet.

Die Technik und Ausgereiftheit dieser Systeme ist weit fortgeschritten. Dies liegt auch

größtenteils an ihrem sehr beschränkten und überschaubaren Aufgabengebiet.

Loadbalancer sind meist von anderen Komponenten in einem komplexen Systemaufbau

unabhängig. Unter dem Loadbalancer arbeitende Ebenen wie die Datenhaltungssysteme

müssen nichts von der Existenz eines Loadbalancers wissen. Die vielleicht einzige

Ausnahme ist der im Folgenden beschriebene Punkt.

Da der Loadbalancer als Zwischenschicht eingezogen wurde, haben die verarbeitenden

(Web-)Server keinen direkten Kontakt mit dem Client. Die Server sehen nun immer die IPAdresse des Loadbalancers als ihren Client und nicht mehr die des eigentlichen Clients, der

die Anfrage initiiert hat. Dadurch wird eventuell eine auf den Servern vorhandene

5

Teilweise ist es nötig, die ankommenden Anfragen auf der Applikationsschicht (Schicht 7 des OSISchichtenmodells [DZ83]) zu analysieren (z.B. um Informationen über die HTTP-Session herauszufiltern).

Die dafür nötige Rechenleistung ist aber vernachlässigbar.

18

Programmlogik, die z.B. auf die IP-Adresse des Clients reagiert, gestört. Hier bieten

fortgeschrittene Loadbalancer die Möglichkeit, die ursprüngliche Adresse in einem

zusätzlichen HTTP-Header an die verarbeitenden Server durchzureichen. Diese haben

dann die Möglichkeit, die IP-Adresse auszulesen und entsprechend darauf zu reagieren.

Die Aufgabe der Lastverteilung wird entweder durch Hardware-Loadbalancer oder

Software-Loadbalancer übernommen. Software-Loadbalancer nutzen eine vorhandene

Serverinfrastruktur und bestehen aus einer Software, welche die für die Lastverteilung

nötigen Aufgaben übernimmt, während Hardware-Loadbalancer eigene physikalische

Server sind, die dediziert Lastverteilungsaufgaben übernehmen.

Beispiel für eine softwarebasierte Loadbalancing-Lösung:

Das Modul mod_oc4j des im Oracle 9iAS integrierten Apache Webservers leitet nach dem

Round-Robin Verfahren eingehende HTTP(S) Anfragen an eine der verfügbaren

Applikationsserver-Instanzen im Cluster weiter [Ora02b].

Beispiel für eine hardwarebasierte Loadbalancing-Lösung:

Der E-Commerce Traffic-Director SA8220 von Hewlett Packard kann eingehende HTTPRequests an einen der verfügbaren Webserver weiterleiten. Es ist ein Loadbalancer in 2U

Rackgröße, der sehr einfach einzurichten und zu konfigurieren ist. Um Ausfallsicherheit

auch auf der Loadbalancer-Ebene zu gewährleisten, lässt sich ein baugleiches Gerät in

einem so genannten ‚Backup-Modus’ betreiben. Dieser gleicht über ein serielles Kabel

Konfigurationseinstellungen mit dem primären Gerät ab und überprüft ständig dessen

Betriebsbereitschaft um im Fehlerfall automatisch alle Aufgaben zu übernehmen. Weitere

Informationen zu diesem Hardware Loadbalancer findet sich unter [Hew03a].

19

20

3 DATENBANKSYSTEME

3.1 Übersicht

Ein Datenbanksystem (DBS) ist ein System zur dauerhaften Speicherung und zum

effizienten Suchen in großen Datenmengen. Moderne Datenbanksysteme bestehen aus

folgenden zwei Komponenten:

·

Die Datenbank (DB): Sammlung von Daten. Diese werden meist mittels geeigneter

Hardware wie z.B. Festplatten persistent gehalten.

·

Das Datenbank-Management-System (DBMS): Programm zum Management von

Datenbanken beliebiger Anwendungen in einem spezifizierten Format.

In der Praxis werden heutzutage meist zwei unterschiedliche Arten von Datenbanksyste6

men eingesetzt:

Die sogenannten relationalen Datenbank-Management-Systeme (RDBMS) [Kel98]

speichern die Daten und die Verknüpfung (Relationen) verschiedener Datensätze in

zweidimensionalen Tabellenstrukturen. Der Zugriff auf die Daten erfolgt über eine

Datenbankabfragesprache und erzeugt, ändert und findet einzelne Zeilen und Spalten in

dieser Tabellenstruktur.

Einen anderen Weg gehen die objektorientierten Datenbank-Management-Systeme

(OODBMS), die sich an objektorientierte Programmiersprachen anlehnen und den Zugriff

auf die Daten über Objekte kapseln. Die Daten werden nicht in einer Tabellenstruktur

gespeichert, sondern entweder in XML-Dateien, serialisierten Java-Objekten oder

proprietären Herstellerformaten. Diese Art der Datenbanksysteme ist noch sehr neu, für

den Praxiseinsatz in großen Systemen sind OODBMS oft noch nicht ausgereift genug oder

bieten keinen ausreichend performanten Zugriff.

Richard Monson-Haefel beschreibt die erste Regel für den Entwurf und die Architektur

von verteilten Systemen folgendermaßen:

Use relational database systems for persistence. They are ubiquitous, proven, standardized, maintainable, robust, and well supported by third-party tools. While ObjectDatabases are a better fit for object-based systems, they are not well supported by

third-party tools like reporting systems and data warehousing systems. In addition,

standardization in OODBS is not as mature as it is in relational database systems, so

applications tend to be less portable across database products. [Mon00]

6

Im weiteren Verlauf dieser Arbeit wird mit dem Begriff Datenbank ein komplettes Datenbanksystem im Sinne

der angegenbenen Definition referenziert, nicht ausschliesslich die Sammlung der Daten.

21

Der Autor dieser Arbeit schließt sich dieser Aussage an.

In großen Projekten ist der Einsatz bekannter erprobter relationaler Datenbanksysteme

erste Wahl. Aus diesem Grund konzentriert sich diese Arbeit vor allem auf diese Systeme.

Eine Übersicht über die derzeit bekanntesten relationalen und objekt-orientierten

Datenbanksysteme findet sich unter [Jav03].

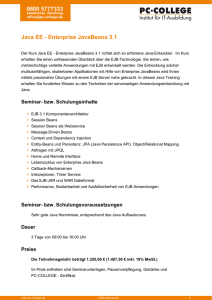

Abbildung 3 zeigt schematisch die Einbettung eines RDMBS und seiner Schnittstellen in

den Kontext einer zugreifenden Applikation. Die Sprache SQL und Javaschnittstelle JDBC

werden in den folgenden Unterkapiteln adressiert.

Applikation

JDBC-Treiber

SQL

SQL

DBMS

DBMS

DB

DB

DBS

DBS

Abbildung 3: Verteiltes Relationales Datenbanksystem (RDBMS)

3.2 Die wichtigsten Zugriffsschnittstellen

3.2.1 SQL (Structured Query Language)

SQL ist die Computersprache, mit der die meisten relationalen Datenbanken erstellt,

manipuliert und abgefragt werden. SQL ist eine sogenannte 4GL (Fourth-Generation

Language). Sie ist nichtprozedural, d. h. der Fragesteller stellt eine Frage, gibt aber keinen

Algorithmus zur Lösung vor. In einer höheren Programmiersprache (3GL) wie Pascal, C

oder Java müsste er angeben, wie die gesuchten Informationen gefunden werden können,

z. B. vom Öffnen der Datei bis zum schrittweisen Iterieren über die Datensätze. Zur

weiteren Spracheinordnung von SQL siehe auch [SM90].

22

SQL ist ein ISO- und ANSI-Standard, der mehrfach spezifiziert wurde bzw. noch wird.

Die größten Meilensteine in der Entwicklung waren:

·

SQL 86 (1986 definiert).

·

SQL 89 (1989 definiert). Zwei mögliche Ebenen des Sprachumfangs: Level 1

und Level 2.

·

SQL 92 oder SQL2 (1992 definiert). Vier mögliche Ebenen des Sprachumfangs:

Entry Level, Transitional, Intermediate Level und Full Level.

·

SQL3 (Spezifikation ist gerade in Arbeit). Informationen zu den Neuerungen in

SQL3 sind in [Sey94] zu finden.

Neben einem bestimmten SQL-Standard unterstützen Datenbanksysteme meist Teile

höherer Standards sowie eigene SQL-Erweiterungen. SQL 89 Level 2 ist auch heute noch

Basis des von vielen Datenbanksystemen unterstützen SQL, bei SQL 92 sind die meisten

Systeme nur Entry Level-Compliant (z. B. Oracle).

Trotz aller Bestrebungen, mittels SQL eine einheitliche Spezifikation für den Zugriff auf

relationale Datenbanksysteme zu schaffen, ist dies in der Praxis oft nicht erreicht worden.

Die Wahrscheinlichkeit, dass eine komplexe SQL-Anfrage auf mehreren relationalen

Datenbanksystemen ohne jegliche Anpassungen syntaktisch korrekt ist und semantisch

gleich abgearbeitet werden kann, ist sehr gering. Es zeichnet sich in naher Zukunft hier

auch keine komplette Vereinheitlichung ab, dies ist aus der Sicht des Autors aber auch

nicht unbedingt notwendig. Im Falle eines Wechsels der Datenbank ist eine Umstellung im

Bereich der SQL-Abfragen zwar oft nötig, der Aufwand hierfür aber vernachlässigbar. Das

größere Problem ist die Tatsache, dass häufig proprietäre Zusatzfunktionalität des

Datenbankherstellers eingesetzt wurde, dessen Umstellung einen meist um Faktoren

größeren Aufwand hervorruft.

3.2.2 JDBC (Java Database Connectivity)

JDBC ist eine Java Standardschnittstelle, die die Anbindung relationaler Datenbanken

erlaubt. Es bietet eine Möglichkeit, verschiedene Datenbanksysteme anzusprechen, SQLBefehle abzusetzen und die Ergebnisse auszulesen. Auch werden explizit Möglichkeiten

zum Steuern von Transaktionen (siehe Kapitel 3.3) angeboten. Zu der Mehrzahl der

relationalen Datenbanksysteme gibt es Java-Treiber, die die JDBC-Spezifikation erfüllen.

Diese wurden entweder vom Hersteller der Datenbank oder von Fremdherstellern

entwickelt.

Im Gegensatz dazu bieten die meisten OODBMS keine JDBC-Treiber. Dies widerspräche

auch der Intention der objektorientierten Systeme, da JDBC die nicht objektorientierte

Abfragesprache SQL kapselt. Um kompatibel zu JDBC-basierten Programmen zu sein,

tauchen trotzdem vereinzelt Implementierungen auf, die eine Art R/O-Mapping

23

(Relational auf Objekt-Mapping) betreiben - es werden relationale Anfragen in SQL

formuliert und anschließend in die objektorientierte Darstellung der Datenbank gewandelt.

Die Schnittstelle JDBC ist Bestandteil der Java 2 Standard Edition (J2SE). Die benötigten

Klassen und Interfaces befinden sich im java.sql-Package. Eine installierte JavaUmgebung und ein JDBC-Treiber für die gewünschte Datenbank sind also ausreichend,

um SQL-Anfragen abzusetzen.

Der folgende Programmausschnitt zeigt ein einfaches Beispiel, welches demonstriert, wie

mittels JDBC mit einem Oracle-Datenbanksystem gearbeitet werden kann:

//--register the Oracle JDBC-Driver

Class.forName( oracle.jdbc.OracleDriver.class.getName() );

//--connect to the database

Connection conn =

DriverManager.getConnection( "jdbc:oracle:thin:@SERVER:1521:SID",

"username",

"password" );

//--enable transactions

conn.setAutoCommit( false );

//--create statement object

Statement stmt = conn.createStatement();

//--execute the two SQL-statements

stmt.executeUpdate( "UPDATE Konto SET Amount=235 WHERE KTONr=71113" );

stmt.executeUpdate( "UPDATE Konto SET Amount=0 WHERE KTONr=172329" );

//--commit the transaction

conn.commit();

//--close the connection

conn.close();

3.2.3 SQLj (Embedded SQL for Java)

Eine zweite Möglichkeit, aus Java heraus auf relationale Datenbanken zuzugreifen, ist SQLj

[SQL03]. Es ist durch den Zusammenschluss führender Datenbankhersteller wie Oracle,

Sybase, SUN, IBM, Informix, Microsoft sowie Sun Microsystems entstanden und stellt

einen ANSI-Standard für Embedded SQL dar. Durch den ebenfalls standardisierten

Präprozessor SQLj Translator ist es möglich, Java-Programme mit eingebettetem,

statischem SQLj zu entwickeln.

Im Unterschied zu JDBC fügt der Programmierer in seinen Java-Sourcecode spezielle

Befehle ein, die von einem Präprozessor übersetzt werden.

System.out.println(“now performing select query..”);

#sql {SELECT * FROM bsp_tabelle};

24

SQLj bietet einige Vorteile, zu nennen sind vor allem die im Vergleich zu JDBC viel

kompaktere Schreibweise und die durch den Präprozessor gegebene Möglichkeit einer

Syntaxkontrolle noch vor der Laufzeit.

Allerdings kann gerade die Pflicht der Benutzung eines Präprozessors auch als Nachteil

angesehen werden. Es macht die Entwicklung und Einbettung in Drittapplikationen

komplexer und schwieriger. Des Weiteren ist es durch die Präkompilierung aller SQLStatements nicht möglich, zur Laufzeit dynamische Anfragen zu generieren.

Diese Arbeit wird nicht weiter auf SQLj als Schnittstelle zu relationalen Datenbanken

eingehen. SQLj hat sich in der Praxis beim Einsatz in Applikationsservern nicht

durchsetzen können.

3.3 Transaktionen

Eine Transaktion bezeichnet eine Folge von logisch zusammengehörenden

Datenbankanweisungen. Sie dient dazu, einen konsistenten Datenbankzustand in einen

anderen konsistenten Datenbankzustand zu überführen [GR93].

Bezüglich der Ausführung von Transaktionen garantiert das Datenbanksystem die

Einhaltung von vier grundlegenden Eigenschaften: Atomarität, Konsistenz, Isolation und

Dauerhaftigkeit. Man spricht hierbei von den sogenannten ACID-Eigenschaften, abgeleitet

von den Anfangsbuchstaben der englischen Begriffe Atomicity, Consistency, Isolation und

Durability [HR01]. Diese im Folgenden näher erläuterten Eigenschaften charakterisieren

zugleich das Transaktionskonzept.

1. Atomarität (Atomicity, "Alles oder Nichts")

Die Ausführung einer Transaktion soll aus Sicht des Benutzers ununterbrechbar verlaufen,

so dass sie entweder vollständig oder gar nicht ausgeführt wird. Dies bezieht sich vor allem

auf die im Rahmen der Transaktion auszuführenden Änderungen der Datenbank. Tritt

während der Ausführung einer Transaktion ein Fehler auf (Programmfehler, HardwareFehler, Absturz des Betriebssystems usw.), der die ordnungsgemäße Fortführung

verhindert, werden seitens des DBS sämtliche bereits erfolgten Änderungen der

Transaktion zurückgesetzt.

2. Konsistenz (Consistency)

Die Transaktion ist die Einheit der Datenbankkonsistenz. Dies bedeutet, dass sie die

Datenbank von einem konsistenten in einen wiederum konsistenten (nicht

notwendigerweise unterschiedlichen) Zustand überführt. Von besonderer Bedeutung ist

dabei die Einhaltung der logischen Konsistenz, so dass die Inhalte der Datenbank einem

möglichst korrekten Abbild der modellierten Wirklichkeit entsprechen. Hierzu können

beim Datenbankentwurf semantische Integritätsbedingungen (zulässige Wertebereiche,

25

Schlüsseleigenschaften usw.) definiert werden, welche vom DBS automatisch zu

überwachen sind. Das DBS garantiert somit, dass am Ende einer jeden Transaktion

sämtliche Integritätsbedingungen erfüllt sind. Änderungen, welche zu einer Verletzung der

Integritätsbedingungen führen, werden abgewiesen, d. h., sie führen zum Zurücksetzen der

Transaktion. Voraussetzung für die logische ist die physische Konsistenz der Datenbank,

also die korrekte interne Repräsentation und Speicherung der Daten im Datenbanksystem.

Zu beachten ist, dass die Konsistenz im Allgemeinen nur vor und nach Ausführung einer

Transaktion gewährleistet wird.

3. Isolation (Isolation)

Datenbanksysteme unterstützen typischerweise eine große Anzahl von Benutzern, die

gleichzeitig auf die Datenbank zugreifen können. Trotz dieses Mehrbenutzerbetriebs wird

garantiert, dass dadurch keine unerwünschten Nebenwirkungen eintreten, wie z. B. das

gegenseitige Überschreiben desselben Datenbankobjektes.

4. Dauerhaftigkeit (Durability)

Das DBS garantiert die Dauerhaftigkeit bzw. Persistenz erfolgreicher Transaktionen, deren

Operationen vollständig ausgeführt wurden. Dies bedeutet, dass Änderungen dieser

Transaktionen alle künftigen Fehler überleben, insbesondere auch Systemabstürze oder

Speicherausfälle.

Eine vollständige Implementierung der Isolation ist in der Praxis nur sehr schwierig

umzusetzen, wenn man keine beeinträchtigenden Performanceeinbussen in Kauf nehmen

will. Aus diesem Grund werden hier meist auch abgeschwächte Formen der Isolation

(Isolationslevel) angeboten, die performanter implementiert werden können.

Um zu verstehen, welche Unterscheidungen in diesem Bereich gemacht werden können,

müssen die Begriffe Dirty Read, Nonrepeatable Read und Phantom Read erklärt werden.

Dies sind Phänomene, die auftreten können, falls keine vollständige Isolation von der

Datenbank implementiert ist.

Dirty Read: Ein Dirty Read liegt vor, wenn Transaktion A einen Wert liest, der von der

noch nicht abgeschlossenen Transaktion B gesetzt wurde. Die Datenbank kann sich

während der Laufzeit von Transaktion B in einem inkonsistenten Zustand befinden. Falls

Transaktion B nicht erfolgreich ausgeführt wird, hat Transaktion A einen nicht gültigen

oder ‚schmutzigen’ (engl. dirty) Wert gelesen.

Nonrepeatable Read: Transaktion A liest einen Wert, danach ändert eine gleichzeitig

laufende Transaktion B diesen Wert und wird abgeschlossen. Falls nun Transaktion A den

Wert erneut liest und den durch Transaktion B geänderten Wert erhält, spricht man von

einem Nonrepeatable Read. Dies verstößt gegen die Isolationsbedingung.

26

Phantom Read: Ein Phantom Read geschieht, wenn eine Transaktion neue Datenbankzeilen sehen kann, die erst nach dem Beginn der eigenen Transaktion von einer anderen

Transaktion hinzugefügt wurden.

Datenbanksysteme implementieren einen Schutz vor derartigen Phänomenen meist mit

Hilfe von sogeanannten Locks (Sperren). Weitere Informationen hierzu findet man

beispielsweise unter [WV02] oder [Amb00]. Eine Einordnung des Schutzgrades wird durch

die sogenannten Isolationslevel angegeben. Je höher dieser ist, desto mehr Schutz wird

geboten. Tabelle 2 zeigt genau, welche der Phänomene in den vier bekanntesten

Isolationsleveln auftreten dürfen.

Isolationslevel

Dirty Reads

Nonrepeatable

Reads

Phantom

Reads

Read Uncommitted

Ja

Ja

Ja

Read Committed

Nein

Ja

Ja

Nonrepeatable Read

Nein

Nein

Ja

Serializable

Nein

Nein

Nein

Tabelle 2: Isolationslevel bei Transaktionen

Unter [Sim03] werden anschauliche Beispiele gegeben, mit denen nachzuvollziehen ist,

welche Isolationslevel in bekannten Datenbanksystemen unterstützt werden.

Die ACID-Bedingungen für Transaktionen müssen auch in verteilten Datenbanksystemen

garantiert werden können. Dies geschieht durch ein sogenanntes Commit-Protokoll. Das

einfachste und meistbenutzte Commit-Protokoll ist das Zwei-Phasen-Commit-Protokoll

(2PC; engl. two-phase-commit protocol) [Bir95, Kap. 13.6.1]. Beim 2PC-Protokoll wird ein

Koordinator festgelegt. Die anderen beteiligten Rechnerknoten werden als Teilnehmer

(oder Agenten) bezeichnet. Nachdem der Koordinator bestimmt wurde, verteilt dieser die

Aufträge an die anderen Teilnehmer.

Folgende Phasen werden bei Anwendung des 2PC-Protokolls durchlaufen:

1. Wahlphase

a) Der Koordinator fragt die Teilnehmer, ob sie ein Commit durchführen können.

b) Die Teilnehmer teilen dem Koordinator ihre Entscheidung mit.

2. Entscheidungsphase

a) Der Koordinator entscheidet, indem er die erhaltenen Ergebnisse auswertet.

b) Die Knoten, die mit »ja« geantwortet haben, warten auf die Entscheidung und

führen bei positivem Bescheid die Transaktion lokal aus.

27

3.4 Praxisbeispiel

Oracle bietet mit dem Oracle 9i Real Application Cluster (RAC) ein Zusatzmodul zur ihrer

Datenbank Oracle 9i Enterprise Edition, die eine Skalierung von mehreren Oracle 9iInstanzen ermöglicht. Der Autor beschreibt die Erfahrungen mit der Benutzung einer

RAC-Installation auf einem HP-UX 11i Cluster mit insgesamt 10 PA-RISC/8700

Prozessoren und 20 GB Hauptspeicher verteilt auf 4 physikalische Server. Die Rechner

waren mit einem 1GB-Ethernet verbunden, die Anbindung an das Storage-System erfolgte

per Fibrechannel.

Der einzelnen Cluster-Knoten können von einer zentralen Stelle administriert werden, der

Wartungsaufwand nach erfolgreicher Installation und Konfiguration ist nicht bedeutend

höher als bei einer einzelnen Oracle-Instanz. Alle bekannten Konzepte (z.B. Archive-Logs,

Initialisierungsfiles) funktionieren entweder exakt sehr ähnlich wie in einer EinzelInstallation.

Als größte Fragestellung vor den ersten Tests blieb die Glaubhaftigkeit der folgenden

Aussage aus dem Konzept-Handbuch von Oracle, der sehr viel Bedeutung beigemessen

wurde:

The concept of transparency implies that Real Application Clusters environments are

functionally equivalent to single-instance Oracle database configurations. In other

words, you do not need to make code changes to deploy applications on Real

Application Clusters if your applications ran efficiently on single-instance Oracle

configurations. [Ora02a, S. 34]

Diese Aussage konnte in der Praxis vollkommen nachvollzogen werden. Für einen

Datenbank Client (z.B. einen J2EE-kompatiblen Applikationsserver) verhält sich die RACInstallation wie eine einzelne Oracle Instanz. Die Logik der Lastverteilung, d.h. die

Entscheidung, welchem Cluster-Knoten ein Client zugewiesen wird, und das Failover im

Falle von Funktionsstörungen auf einem Cluster-Knoten wird vom OCI-Datenbanktreiber

übernommen und erfolgt vollkommen unsichtbar und transparent. Transaktionen werden

korrekt ausgeführt und verteilt.

Durch diese Transparenz wurde eine Modularisierung geschaffen, die es ermöglicht, die

Skalierbarkeit und Ausfallsicherheit von Datenbanksystemen völlig unabhängig von der des

restlichen Systems zu betrachten. Eine Zusammenfassung der Fähigkeiten des Oracle Real

Application Cluster findet sich im technischen Whitepaper [Ora01].

28

4 JAVA 2 ENTERPRISE EDITION

4.1 Übersicht

Mit der Java 2 Enterprise Edition (J2EE) [Sun01a] stellt Sun eine komplette Plattform für

server-side-computing zur Verfügung. J2EE versucht eine hardware- und betriebssystemunabhängige, multi-user fähige, portable, sichere Plattform für serverseitige Anwendungen

zu sein. Ein Meilenstein von J2EE sind die Enterprise JavaBeans, ein Standard für das

Erstellen von serverseitigen Komponenten in Java.

J2EE ist eine Spezifikation und kein fertiges Produkt. Es spezifiziert Regeln, die der

Entwickler beim Erstellen von serverseitigen Komponenten einhalten muss. Die Hersteller

implementieren dann die J2EE Spezifikation in ihren J2EE-kompatiblen Produkten. Aus

diesem Grund ist J2EE nicht an einen Hersteller gebunden, auch nicht an den Erfinder

Sun Microsystems. Es gibt eine Reihe kommerzieller Anbieter von Applikationsservern, die

die J2EE-Spezifikation implementieren.

J2EE kann man auch als Zusammenfügung verschiedenster sogenannter „middle-wareservices“ oder Dienste begreifen [NBW+01]. Die wichtigsten werden im Folgenden kurz

erläutert:

Enterprise JavaBeans (EJB): EJB [Mon01] [RAJ02] definiert, wie serverseitige

Komponenten aussehen und definiert einen „Vertrag“ zwischen den Komponenten und

dem Applikationsserver, der die Komponenten verwaltet. EJB ist einer der

Hauptbestandteile von J2EE und wird im Kapitel 4.2 ausführlich behandelt.

Remote Method Invocation (RMI) and RMI-IIOP: RMI stellt InterprozessKommunikation und andere Services für Kommunikation zur Verfügung. RMI-IIOP ist

eine Erweiterung von RMI und verwendet das Internet-Inter-ORB Protokoll und kann

somit für die Integration von bestehenden CORBA-Komponenten verwendet werden.

RMI bildet die Basis für die Kommunikation der einzelnen Komponenten in verteilten

J2EE-Systemen.

Java Naming and Directory Interface (JNDI): JNDI lokalisiert den physikalischen Ort

von verwendeten Komponenten und anderen Ressourcen im Netzwerk. Diese Ressourcen

wie Datenquellen oder Enterprise JavaBeans werden dem zentralen JNDI-Service bekannt

gemacht und können von Clients erfragt werden.

Java Database Connectivity (JDBC): JDBC ist die am weitesten verbreitete relationale

Datenbankschnittstelle für Javaprogramme. Sie wurde in Kapitel 3.2 bereits ausführlich

behandelt.

29

Java Transaction API (JTA) und Java Transaction Service (JTS): Die JTA und JTSSpezifikation erlaubt sichere und verlässliche Übertragung der Komponenten und deren

Daten über das Netzwerk (siehe Kapitel 4.4).

Java Messaging Service (JMS): JMS dient der asynchronen Kommunikation zwischen

Komponenten. Message-Driven-Beans, ein Typ der Enterprise JavaBeans, nutzen

beispielsweise diese Schnittstelle.

Java Servlets and JavaServer Pages (JSP): Java Servlets und JSP sind Technologien, die

zur Entwicklung dynamischer Webseiten eingesetzt werden.

JavaMail: JavaMail ist eine Schnittstelle und dient dem Versenden und Empfangen von EMails aus Javaprogrammen.

Connectors: Die Connectors Architecture verbindet J2EE mit bereits bestehenden Mainframe- und Enterprise Resource Planning (ERP) Systemen.

4.2 Enterprise JavaBeans

Enterprise JavaBeans sind einer der wichtigsten Teile der Java 2 Enterprise Edition

Plattform. Sun Microsystems definiert Enterprise JavaBeans 2.0 folgendermaßen:

The Enterprise JavaBeans (EJB) architecture is a component architecture for the

development and deployment of component-based distributed business applications.

Applications written using the Enterprise JavaBeans architecture are scalable,

transactional, and multi-user secure. These applications may be written once, and then

deployed on any server platform that supports the Enterprise JavaBeans specification.

[SUN01]

Die EJB-Architektur ist eine neue serverseitige komponentenbasierte Architektur für

verteilte unternehmenskritische Geschäftsanwendungen. Sie spezifiziert Schnittstellen,

Aufgaben und Zuständigkeiten einzelner Komponenten. Die EJB-Architektur unterstützt

durch ein breites Dienstleistungsspektrum die schnelle Realisierung von skalierbaren,

robusten und mehrbenutzerfähigen serverseitigen Anwendungssystemen.

Da die EJB-Spezifikation kein Produkt ist, muss sie von den Server- und

Applikationsserver-Herstellern umgesetzt werden.

Der Einsatz von EJB eignet sich besonders als serverseitiges Komponentenmodell für

verteilte Mehrschichten-Umgebungen. Webbasierte Anwendungen weisen häufig eine

Multitier-Architektur auf, wobei die mittlere Schicht für die Anwendungslogik

verantwortlich ist. Enterprise JavaBeans stellen ein Komponentenmodell für die

Realisierung der Anwendungslogik in dieser mittleren Schicht zur Verfügung, es ist damit

eine so genannte Middleware.

30

EJB bietet zudem Unterstützung für Basisdienste wie Transaktionsverwaltung, Sicherheits-,

Persistenz-, oder Ressourcenmanagement. Entwickler von Web-Anwendungen werden

dadurch entlastet und können sich auf die Implementierung der eigentlichen Präsentationsund Anwendungslogik konzentrieren.

4.2.1 Die Architektur

Im Folgenden werden die wesentlichen Bestandteile der EJB-Spezifikation bzw. EJBArchitektur und -Laufzeitumgebung vorgestellt und detailliert erläutert. Dadurch wird ein

Überblick über die einzelnen Bestandteile dieser Architektur gegeben und die Eignung und

Praxistauglichkeit von EJB für die Entwicklung von komplexen verteilten Client/ServerAnwendungen kann somit besser erörtert werden. Abbildung 4 gibt eine einfache

Übersicht über die EJB-Architektur.

Applikationsserver / EJB-Server

EJB-Client 1

(z.B. Webapplikation)

EJB-Container

EJB-Objekte

EJB-Client 2

(z.B. Importapplikation)

Abbildung 4: EJB-Architektur

Der EJB-Server

Zurzeit existiert eine Vielzahl von Anbietern für EJB-Server am Markt. Ein EJB-Server

kann als Teil eines Applikationsservers gesehen werden, der nicht nur die Implementierung

der EJB-Spezifikation bietet, sondern die aller geforderten J2EE Spezifikationen. In der

Praxis gibt es nur sehr wenige Hersteller, die reine EJB-Server, aber viele, die komplette

Applikationsserver vertreiben. Der Benutzer der EJB-Plattform ist somit nicht wie bei

anderen Frameworks auf einen bestimmten Serverhersteller eingeschränkt, sondern kann

31

dank der durch die Spezifikation gegebenen sehr hohen Portabilität mit wenig oder keinem

Entwicklungsaufwand den zu Grunde liegenden Server austauschen. Dies wird zwar

heutzutage in der Praxis noch nicht immer erreicht, doch sind hier große Fortschritte zu

sehen. Die Weiterentwicklung der Spezifikation wird mit großem Interesse durch die

Vielzahl der Serveranbieter und die noch größere Anzahl der Benutzer stetig

vorangetrieben.

Der EJB-Container

Der EJB-Container ist das Herzstück des EJB-Servers. Der in der EJB-Spezifikation

abgedeckte Umfang an Funktionalitäten erstreckt sich von der Verwaltung der Persistenz

von Objekten über die Bereitstellung von Diensten wie Transaktionen und SicherheitsManagement (zum Beispiel Zugriffsbeschränkungen auf EJB-Objekte), bis hin zu einer

vollständigen Lebenszyklusverwaltung der eingesetzten Objekte. Hierbei werden all diese

Funktionalitäten vom EJB-Server zur Verfügung gestellt und können vom Entwickler

durch das Ansprechen oder Implementieren von vordefinierten Schnittstellen einfach

genutzt werden. Auch bietet der EJB-Container Hilfen und Schnittstellen für die

Installation von EJB-Objekten (Deployment).

Ein Versäumnis von Sun war es, die Schnittstelle des EJB-Containers zum umgebenden

Applikationsserver nicht genügend zu konkretisieren. Dies macht den EJB-Container nicht

einfach austauschbar und ersetzbar. Ein Problem, welches auch das Design des Prototyps

zu dieser Arbeit stark beeinflusst hat.

Vor allem die Persistenzmöglichkeiten und ihre Implikationen in Hinblick auf

Skalierbarkeit und Performance werden im Fortlauf dieser Arbeit genauer betrachtet.

Die EJB-Objekte

Die zu implementierende Geschäftslogik und Funktionalität wird nach dem EJBParadigma in einzelne Objekte, die Enterprise JavaBeans, zerlegt. Ist ein solches Objekt auf

dem Server installiert, so kann man auf die durch dieses EJB zur Verfügung gestellte

Funktionalität zugreifen. In der EJB-Spezifikation wird zwischen mehreren grundsätzlich

verschiedenen Arten von Beans unterschieden.

Zum einen sind Entity-Beans vorgesehen, die vornehmlich zur Datenspeicherung benutzt

werden. Instanzen von Entity-Beans werden mit einem primären Schlüssel erzeugt. Sie

können über diesen Schlüssel wiedergefunden und somit über mehrere Sitzungen hinweg

benutzt werden. Die Eigenschaften von Entity-Beans werden üblicherweise in einer

Datenbank gespeichert, so dass sie nach einem Serverneustart immer noch vorhanden und

nutzbar sind. Zur Speicherung in einer Datenbank bietet die EJB-Spezifikation die zwei

alternativen Methoden Container Managed Persistence (CMP) und Bean Managed

Persistence (BMP) an, die später genauer erläutert werden.

32

Zum anderen können so genannte Session-Beans genutzt werden, um Instanzen von EJB’s

für nur eine Sitzung zu erzeugen und zu verwenden. Diese Art Beans wird dafür genützt,

verarbeitende Funktionalitäten zu beherbergen, welche eventuell zur Datenhaltung auf

Entity-Beans zurückgreifen. Sie selbst sollten keine Daten persistent halten.

Bei diesen Session-Beans findet eine Unterscheidung danach statt, ob die einzelnen BeanInstanzen an einen Client gekoppelt sein und ihren Status behalten sollen oder nicht. Im

ersten Fall werden sie Stateful Session Beans genannt. Ein typischer Einsatzort ist die

Implementierung einen Warenkorbes in einem e-commerce-System. Falls diese

Beibehaltung des Status nicht benötigt wird, können Stateless Session Beans verwendet

werden. Hier kann eine Instanz die Aufrufe mehrere Clients bedienen, was bedeuten

würde, dass es möglich ist, dass zwei hintereinander folgende Aufrufe desselben Clients auf

das selbe Bean andere Ergebnisse liefern könnten.

Ein weiterer zentraler Bestandteil ist eine neue Art von Beans, die Message-driven Beans.

Diese sind dadurch gekennzeichnet, dass die Methodenaufrufe nicht mehr ausschließlich

synchron durchgeführt werden, sondern der Java Messaging Service (JMS) auch asynchrone

Aufrufe gestattet. Dies ermöglicht es den Clients, Nachrichten in eine Warteschlange zu

positionieren und ohne auf die Antwort zu warten, im Programmfluss fortzufahren.

Weitere Informationen zu den verschiedenen Bean-Arten finden sich in [Mon01].

Der EJB-Client

Ein EJB-Client ist ein Programm, welches auf die EJB-Objekte zugreift und diese nutzt.

Hierbei wird zwischen einem so genannten Remote- und einem Local-Client

unterschieden. Der Remote-Client befindet sich außerhalb der Java-Virtual-Machine, in

dem die EJB-Objekte installiert sind, der Local-Client im Gegensatz dazu in dieser VirtualMachine. Diese Nähe zu den benutzten EJB-Objekten bietet starke Vorteile in Bezug auf

die Ausführungsgeschwindigkeit. Sie ergeben sich zum einen durch entfallende Zugriffe

über lokale Netzwerke, zum anderen aber auch daraus, dass bei rein lokalem Zugriff auf ein

EJB-Objekt die Verwendung des zeitlich kostspieligen RMI- oder RMI-IIOP-Protokolls

vermieden werden kann (Local interfaces).

Ein typisches Beispiel für einen EJB-Client ist eine JSP-basierte Webapplikation, die auf die

Geschäftslogik der EJB-Objekte zugreift, die im EJB-Container installiert sind.

4.3 Die EJB-Persistenz-Schnittstellen

Das Persistenzmanagement ist eine der Hauptaufgaben der Enterprise JavaBeansArchitektur. Dieses Kapitel will vor allem die Schnittstellen betrachten, die durch die

Verwendung von EJBs vorgegeben werden.

33

Über den Erfolg oder Misserfolg der EJB-Architektur entscheiden in erster Linie nicht die

aktuellen verfügbaren Implementierungen der EJB-Container, sondern die spezifizierten

Schnittstellen. Diese müssen

·

übersichtlich gestaltet und ohne großen Lernaufwand zu benutzen sein

·

den funktionalen Bedürfnissen großer Projekte genügen und

·

es erlauben, dass die darunterliegenden Implementierungen ausgetauscht werden

können.

Die EJB-Spezifikation in den ersten Versionen (1.0 und 1.1) hatte im Bereich der

Schnittstellendefinition des Persistenzmanagement große Defizite. Die für die persistenten

Objekte vorgesehenen Entity-Beans waren in der Praxis teils nicht oder nur eingeschränkt

nutzbar, so dass Entwickler dazu übergegangen sind Sessionbeans zu nutzen, um von dort

‘manuell’ auf externe Datenbanksysteme zuzugreifen. Es entstanden Hilfsmittel, die diese

Vorgehensweise vereinfacht und erleichtert haben. Dies war ein gefährlicher Schritt für den

Erfolg von Enterprise JavaBeans und mit Sicherheit nicht im Sinne des Erfinders Sun

Microsystems. Die aktuelle Version 2.0 der Spezifikation behebt jedoch einen großen Teil

der Mängel. Diese Arbeit geht auf die alte Spezifikation in der Version 1.0 und 1.1 nicht

ein, hierzu gibt [Mon01] eine gute Einführung.

Enterprise JavaBeans bietet zwei Persistenzschnittstellen an:

·

BMP (Bean Managed Persistence) und

·

CMP (Container Managed Persistence).

Bevor auf die Unterschiede dieser beiden Persistenzarten eingegangen wird, folgt ein kurzer

Blick in den Aufbau eines Entity-Beans, seiner Konfiguration und seinen Platz im EJBContainer.

34

Client

Home Interface

Remote Interface

Applikationsserver

EJB Container

Home Interface

Remote Interface

XML DeploymentDeskriptor

Bean Klasse

DB

Abbildung 5: Definition eines Enterprise JavaBeans

Abbildung 5 stellt die wichtigsten Komponenten eines Enterprise JavaBeans dar:

·

Das Remote Interface beschreibt alle Methoden des Entity-Beans, welche von

einem Client aus zugreifbar sein sollen und die ausschliesslich mit der aktuellen

Instanz arbeiten (also z.B. Product.getName() )

·

Im Home Interface werden die Methoden definiert, mit denen neue Instanzen

angelegt oder gelöscht werden können und einzelne Instanzen in der Datenbank

gesucht werden.

·

Die Bean Klasse letztendlich implementiert die Methoden des Remote und Home

Interface. Ein Client sieht die Bean Klasse nicht, der Zugriff erfolgt immer über das

Remote- oder Home Interface.

·

Der XML Deployment-Deskriptor beschreibt den Namen, die Klassen, persistente

Felder und weitere Eigenschaften des Entity-Beans.

Die Interfaces, Klassen und XML-Deskriptoren werden nach einem bestimmten Verfahren

zu einem Java Archive-File (JAR-File) gepackt und können so in einem EJB-Container

deployed werden. Die Geschäftslogik, die durch die Remote- und Home Interfaces

definiert wird, ist über den EJB-Server von einem Client aus zugänglich, wogegen die Bean

Klasse innerhalb des Containers liegt und von dort eigenständig (BMP) oder mit Hilfe des

Containers (CMP) auf die Datenbank zugreift.

35

Der Aufbau des Deskriptors wie auch die Implementierung der Bean Klasse unterscheiden

sich je nach Wahl der Persistenzschnittstellen Container Managed Persistence oder Bean

Managed Persistence. Die Vor- und Nachteile und die sich daraus ergebenden

Einsatzgebiete werden in den folgenden Unterkapiteln genauer erläutert.

4.3.1 CMP

Bei der Nutzung von Container Managed Persistence übernimmt der EJB-Container das

komplette Persistenzmanagement. Der Container weiss, wie es die Instanz eines Beans in

der Datenbank ablegen muss und kümmert sich selbständig um das Anlegen, Löschen,

Lesen und Schreiben der Daten. Die für den Container nötigen Informationen werden im

Deployment-Deskriptor für jedes Bean angegeben. Dazu zählen:

·

Klassennamen des Home- und Remote Interfaces und der Bean-Implementierung.

·

Namen der einzelnen Attribute, die persistent gemacht werden sollen.

·

Name und Typ des Primary-Key Feldes.

·

Die Definition der Finder-Methoden mittels EJB QL (EJB Query Langage).

Eine genaue Beschreibung der Attribute findet sich beispielsweise in [NBW+01].

Untenstehend sehen Sie einen Auszug aus dem Deployment-Deskriptor zum Prototyp

dieser Arbeit, in dem ein CMP Entity-Bean beschrieben wird.

<entity>

<ejb-name>Product</ejb-name>

<home>de.tum.in.j2eedemo.ProductHome</home>

<remote>de.tum.in.j2eedemo.ProductRemote</remote>

<ejb-class>de.tum.in.j2eedemo.ProductEJB</ejb-class>

<persistence-type>Container</persistence-type>

<prim-key-class>java.lang.String</prim-key-class>

<primkey-field>code</primkey-field>

...

<cmp-field><field-name>name</field-name></cmp-field>

<query>

...

<ejb-ql>

SELECT DISTINCT OBJECT(p) FROM Product p WHERE p.name LIKE '%?1%'

</ejb-ql>

</query>

...

</entity>

Durch diese Art Meta-Beschreibung [FY98] ist es dem Container möglich, die

nachfolgenden Aufgaben selbst zu implementieren:

36

1. Das Auslesen und Schreiben einzelner Attribute. Damit der Container die

Implementierung übernehmen kann, werden die Bean-Klasse und die

Zugriffsmethoden auf die einzelnen Attribute als abstrakt definiert:

public abstract class ProductEJB implements EntityBean

{

public abstract String getName();

public abstract void setName( String name );

...

}

Es ist nun möglich eine Klasse zu generieren, die von der Bean-Klasse erbt und in

der die abstrakten get- und set-Methoden implementiert sind.

2. Das Anlegen, Löschen, Lesen und Schreiben einer Bean-Instanz. Die nach

der Spezifikation angebotenen Methoden ejbCreate(), ejbRemove(),

ejbLoad() und ejbStore() bleiben leer bzw. enthalten keinen Code für die

Persistenzhaltung. Somit können diese Methoden durch den Container

überschrieben werden.

3. Die Implementierung von Suchanfragen (Findern). Die eigene Implementierung geschieht bei CMP nicht. Diese Aufgabe wird vom Container übernommen.

Die im Home Interface angegebenen Suchmethoden werden ebenfalls automatisch

durch den Container mit Hilfe der Definition der EJB QL-Query im DeploymentDeskriptor in entsprechenden Datenbankzugriffscode umgesetzt.

Der Bean-Entwickler kann sich bei Nutzung von CMP somit vollständig auf die zu

implementierende Geschäftslogik konzentrieren.

4.3.2 BMP

Bei Bean-Managed-Persistence muss der Bean-Entwickler die komplette Persistenzhaltung

selbständig implementieren.

Der EJB-Container nimmt dem Entwickler in diesem Bereich keine Arbeit ab, die BeanKlassen werden nicht wie bei CMP abstrakt definiert. In den Methoden ejbCreate(),

ejbRemove(), ejbLoad() und ejbStore() müssen die entsprechenden Zugriffe auf die

Datenbank erfolgen.

Dazu ist es ist möglich, vom Container eine JDBC Datenbank-Connection zu erhalten, die

für die Anfragen benutzt werden kann. Dies wird im nachfolgenden SourcecodeAusschnitt demonstriert:

37

public String ejbCreate( String code, String name )

{

DataSource ds =

(DataSource)new InitialContext().lookup( "jdbc:DefaultDS" );

Connection conn = ds.getConnection();

Statement stmt = conn.createStatement();

stmt.executeQuery( "INSERT INTO Product (pk, code, name ) .." );

stmt.close();

conn.close();

...

}

Bei Nutzung von BMP werden im Deployment-Deskriptor die Finder-Methoden nicht

mittels EJB QL definiert. Auch hier ist es Aufgabe des Bean-Entwicklers, die nötigen

ejbFindXY()-Methoden in der Bean-Klasse zu implementieren.

4.3.3 EJB QL

Die Definition und Implementierung von Finder-Methoden wurde in der EJB1.1

Spezifikation von Sun in keinster Weise festgelegt. Es wurde dem Applikationsserver oder

Container-Hersteller überlassen, wie in Einzelfall das Mapping von den Signaturen der

Findermethoden auf wirkliche Datenbankabfragen vom Entwickler anzugeben war. Dies

geschah bei einigen Applikationsservern durch spezielle Kommentare im Sourcecode oder

durch eigene XML-Konfigurationsdateien.

Durch die Tatsache, dass sich in diesem Bereich keinerlei Standard durchsetzen konnte,

wurde die Portabilität der ganzen EJB-Applikation auf andere Applikationsserver stark

eingeschränkt. Auch die Migration auf andere Datenbanksysteme wurde teilweise

aufwendiger, da auch hier die feinen Unterschiede in der Interpretation von SQL komplett

an den Entwickler abgegeben wurden und so die Applikationen beim Umstieg angepasst

werden mussten. Sun hat diesen Missstand erkannt und in der EJB 2.0 Spezifikation eine

einheitliche Konfigurationsmöglichkeit vorgesehen. Diese besteht aus einem zusätzlichen

Tag im standardisierten Deployment-Deskriptor, in dem mit Hilfe der SQL-ähnlichen

Abfragesprache EJB QL die Semantik der Findermethoden festgelegt wird.

Nachfolgend ein Beispiel, welches die Finder-Methode findByCode implementiert, welche

alle Objekte zurückliefert, die ein Attribut code mit dem übergebenen Wert besitzen:

<query>

<query-method>

<method-name>findByCode</method-name>

<method-params>

<method-param>java.lang.String</method-param>

</method-params>

</query-method>

<ejb-ql>

SELECT DISTINCT OBJECT(p) FROM Product p WHERE p.code = ?1

</ejb-ql>

</query>

38

Diese Spezifikation ist ein großer Schritt in die richtige Richtung. Applikationen, die EJB

QL nutzen, sind einfacher auf andere Datenbanken und Applikationsserver zu migrieren.

Leider enthielt die erste Version von EJB QL aber noch einige gravierende Mängel, doch

sieht es so aus, dass Sun hier in Zusammenarbeit mit der einsetzenden Industrie einen

Großteil dieser meist fehlenden Funktionalität aufgenommen hat.

Neu hinzugekommen seit EJB2.1 ist die in SQL sehr oft eingesetzte COUNT()-Funktion.