Inhaltsverzeichnis

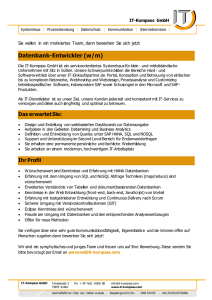

Werbung