CO2 - ETH E-Collection

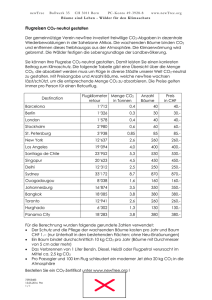

Werbung