III. Induktive Statistik

Werbung

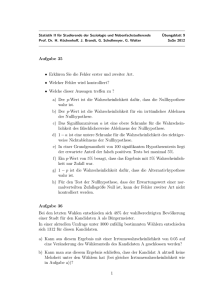

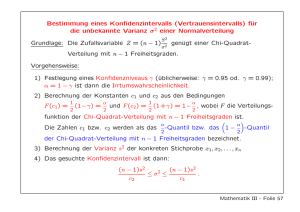

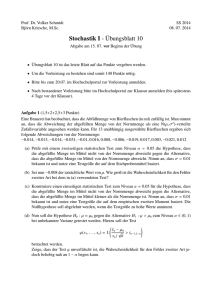

35 III. Induktive Statistik In diesem Teil der Vorlesung geht es darum, aus gewissen Eigenschaften einer Stichprobe auf entsprechende Eigenschaften der Grundgesamtheit rückzuschließen. Im Unterschied zu den im 1. Kapitel betrachteten konkreten Stichproben ( x1 , x 2 ,.., x n ) betrachten wir hier (mathematische) Stichproben (X1 , X 2 ,.., X n ) , wobei die X1 , X 2 ,.., X n unabhängige und identisch wie X verteilte Zufallsvariable sind gemäß der Verteilung, welche X in der Grundgesamtheit besitzt. 1. Allgemeines zu statistischen Testverfahren Zu den grundlegenden Aufgaben der mathematischen Statistik zählt das Testen von Hypothesen, d.h. gewisser Annahmen über Grundgesamtheiten. Hypothesen können sich z.B. auf frühere Erfahrungswerte stützen, sie können einen Sollwert darstellen oder das Ergebnis einer zu verifizierenden Theorie sein. Mit einem statistischen Test prüft man also eine vorgefasste Vermutung über eine oder auch mehrere Grundgesamtheiten anhand von Zufallsstichproben. In diesem Kapitel werden ausschließlich Tests über Parameter von Verteilungen beschrieben, deren Typ (zumeist die Normalverteilung) bekannt ist. Man spricht in diesem Zusammenhang von parametrischen oder auch verteilungsabhängigen Testverfahren. Das erste Beispiel eines statistischen Testverfahrens, mit dem wir uns in diesem Abschnitt beschäftigen, beinhaltet die Überprüfung einer Hypothese über den Mittelwert einer normalverteilten Grundgesamtheit mit bekannter Varianz σ2. Beispiel 1.1: Wir betrachten hier die Massenzüchtung von Tsetsefliegen zu medizinischen Zwecken und nehmen dazu an, dass die Produktivität einer Tsetsefliegenkolonie durch eine normalverteilte Zufallsvariable X beschrieben wird, wobei die Varianz σ 2 = 5.85 aus früheren Untersuchungen bekannt ist. Im Normalfall, d.h. bei Abwesenheit von Störursachen, kann mit einer durchschnittlichen Anzahl von µ0 = 57 Nachkommen pro Kohorte gerechnet werden. Eine konkrete Stichprobe von vier Kohorten liefert nun die Werte x1 = 52, x2 = 54, x3 = 49 und x4 = 55. Kann aufgrund dieser Stichprobe die Annahme beibehalten werden, dass sich die Produktivität noch normal verhält, d.h., dass der Erwartungswert µ von X dem „Sollwert“ µ0 entspricht? Zur Beantwortung dieser Frage formulieren wir zunächst die sogenannte Nullhypothese H0: µ = µ0. Die Negation von H0 wird als Alternative (oder Alternativhypothese) H1 bezeichnet und lautet µ ≠ µ0. Unsere Aufgabe besteht nun darin, festzustellen, ob die Nullhypothese anhand der gegebenen Stichprobe beibehalten werden kann oder aber abzulehnen (und damit die Alternativhypothese anzunehmen) ist. Diesen Entscheidungsprozeß kann man folgendermaßen führen: Man bestimmt aus den Stichprobenwerten xl, x2, ..., xn (in obigem Beispiel ist n = 4) den Mittelwert x und verwendet diesen als Schätzwert für den unbekannten Erwartungswert µ von X. Der Mittelwert x ist dann Realisierung einer Zufallsvariablen X , welche nach II, 4.2 ebenfalls normalverteilt ist und zwar mit dem Erwartungswert E ( X ) = µ X = µ und der Varianz V( X ) = σ 2X = σ 2 / n . Dies bedeutet, wiederum nach II, 4.2, dass bei Bestehen der Nullhypothese H0: µ = µ0 die aus X durch Standardisieren hervorgehende Zufallsvariable Z, also 36 (*) Z= X − µ X X − µ0 = σX σ n standardnormalverteilt ist. Man kann die Nullhypothese daher nicht bereits dann ablehnen, wenn x < µ0 oder x > µ0 ist, denn die Wahrscheinlichkeit dafür ist jeweils 1/2. Vernünftig erscheint es aber, die Nullhypothese abzulehnen, wenn x den Sollwert µ0 „wesentlich“ unteroder überschreitet, d.h., wenn der mit Hilfe von x aus (*) errechnete Wert z von Z gewisse kritische Grenzen −c bzw. +c unter- bzw. überschreitet, die so gewählt sind, dass eine Unterschreitung (und ebenso auch eine Überschreitung) nur mit einer vorgegebenen kleinen Wahrscheinlichkeit α/2 zu erwarten ist. Für den kritischen Wert c erhält man aus der Forderung P(Z < −c) = P(Z > c) = α/2 die Bestimmungsgleichung Φ(c) = 1 − α/2, d.h. c = Φ −1 (1 − α / 2) wobei die Berechnung von c durch Nachschlagen in einer Tabelle der Werte von Φ (x) oder expliziten Aufruf der Funktion Φ −1 ( x ) in einem Statistikprogramm (in Excel wäre dies z.B. STANDNORMINV(x)) geschehen kann. Obige Größe Z wird als Teststatistik oder Prüfgröße für unseren Test bezeichnet. Fällt die aus den Stichprobenwerten xl, x2, ..., xn berechnete Realisierung z von Z in den sogenannten Annahmebereich, ist also −c ≤ z ≤ c, so wird die Nullhypothese beibehalten, fällt sie hingegen in den kritischen Bereich (Ablehnungsbereich), d.h. gilt z < −c oder z > c, so wird die Nullhypothese verworfen. Dabei ist c durch die vorzugebende Wahrscheinlichkeit α (meist 5%, 1% oder 0.1%) bestimmt; aus der Tafel für die Verteilungsfunktion der Standardnormalverteilung entnehmen wir beispielsweise für α = 0.05 den Wert c = 1.96. Die Zahl α heißt Signifikanzniveau oder auch Irrtumswahrscheinlichkeit, denn sie gibt die Wahrscheinlichkeit dafür an, dass die Nullhypothese abgelehnt wird, obwohl sie richtig ist (vgl. untenstehende Abbildung). Wir kommen nun auf obiges Beispiel zurück und testen die Hypothese, dass die Produktivität den gestellten Anforderungen entspricht, und zwar auf dem Signifikanzniveau α = 0.01. Der zugehörende kritische Wert beträgt c = 2.58 (=STANDNORMINV(1-0,01/2) in Excel). Wir berechnen nun aus den Stichprobenwerten 52, 54, 49 und 55 den Mittelwert x = 52.5. Er unterschreitet den Sollwert µ0 = 57 beträchtlich, und es erhebt sich die Frage, ob man diese Abweichung noch als zufallsbedingt ansehen kann oder ob sich x und µ0 signifikant voneinander unterscheiden. Wie sich zeigt, ist eine zufallsbedingte Abweichung auf dem 1%Signifikanzniveau nicht mehr gerechtfertigt: Der Wert 37 z= 52.5 − 57 5.85 4 = −3.72 der Teststatistik Z ist deutlich kleiner als −c, d.h., die Prüfgröße fällt in den Ablehnungsbereich (siehe Abbildung), und es ist anzunehmen, dass sich die Produktivität aufgrund irgendwelcher Störursachen vom Sollwert entfernt hat. In der obigen Testsituation wird die Nullhypothese dann verworfen, wenn der Abstand x − µ 0 eine bestimmte kritische Schranke überschreitet, d.h., wenn x signifikant unter oder über dem festen Wert µ0 liegt. Man spricht daher von einem zweiseitigen Test. Abweichungen können aber auch nur in einer Richtung bedeutungsvoll oder möglich sein. Man denke z.B. an die Überprüfung einer Maximalkonzentration im Gesundheits- oder Umweltbereich. In diesem Fall lautet die Nullhypothese H0: µ ≤ µ0, die Alternative Hl: µ > µ0. Man wird also die Nullhypothese nur dann verwerfen, wenn eine signifikante Abweichung des Stichprobenmittels nach oben auftritt, eine Abweichung nach unten spielt keine Rolle. Der kritische Wert c wird dann ähnlich wie oben aus der Gleichung Φ(c) = 1 − α bestimmt, wobei Φ(x) wieder die Verteilungsfunktion der Standardnormalverteilung bezeichnet. Gilt für den Wert z der Teststatistik z > c, so wird die Hypothese H0 verworfen, in jedem anderen Fall wird sie beibehalten. Wir nennen den so modifizierten Test einen einseitigen Test auf Überschreitung. Analog ist ein einseitiger Test auf Unterschreitung möglich. Annahmebereiche und kritische Bereiche beim ein- und zweiseitigen Test sind in folgender Abbildung dargestellt. Allgemein läuft jeder Signifikanztest nach dem folgenden Schema ab: • • • Formulieren der Nullhypothese H0 und der Alternative H1 (je nach einseitiger oder zweiseitiger Fragestellung!) Bereitstellung einer geeigneten Prüfgröße (Teststatistik) Wahl des Signifikanzniveaus α und Bestimmung des kritischen Bereichs für die vorgegebene Prüfgröße 38 • • Berechnung eines Wertes z der Teststatistik aufgrund der erhobenen Zufallsstichprobe Ablehnung der Nullhypothese, falls z in den kritischen Bereich fällt (Dabei ist die Wahrscheinlichkeit, dass H0 irrtümlich verworfen wird, gleich α.) Fällt der Wert der Teststatistik in den Annahmebereich, d.h., erweist sich ein bestehender Unterschied zwischen x und µ0 als nicht signifikant, so kann diese Tatsache noch nicht als eine Bestätigung der Nullhypothese gewertet werden. Ein Wert im Annahmebereich besagt lediglich, dass die Hypothese zu den Daten der Stichprobe nicht im Widerspruch steht. Da also das Verwerfen einer Hypothese mehr Aussagekraft besitzt als deren Beibehaltung, ist es günstig, nach Möglichkeit die Nullhypothese als Gegenteil von dem zu formulieren, was man beweisen möchte, und zu versuchen, sie zu widerlegen. Ob allerdings ein bestehender Unterschied als signifikant erkannt wird oder nicht, hängt zumeist auch ganz wesentlich vom Stichprobenumfang ab. Im Zusammenhang mit diesen Überlegungen muss betont werden, dass das Signifikanzniveau prinzipiell vor der Durchführung des Testverfahrens (ja sogar vor der Datenerhebung) festgesetzt werden sollte, denn nur so bleibt die für die Irrtumswahrscheinlichkeit α gegebene Interpretation richtig. Trotzdem hat es sich in der Praxis − insbesondere beim Arbeiten mit einschlägigen Computerprogrammen − eingebürgert, oft erst nach dem Test das erreichte Signifikanzniveau P zu bestimmen und in der Form P > 0.05 (oder n.s., d.h. nicht signifikant), P ≤ 0.05, P ≤ 0.01 bzw. P ≤ 0.001 anzugeben. Dieser sogenannte P-Wert entspricht der Wahrscheinlichkeit für eine Abweichung der Testgröße vom Sollwert im beobachteten oder noch größeren Ausmaß (im Sinne der Alternativhypothese). Es bleibt dann dem Anwender überlassen, das Testergebnis gemäß dem von ihm bevorzugten oder für dieses Problem als geeignet erachteten Signifikanzniveau zu bewerten. Zum Abschluss der einführenden Bemerkungen zur Testtheorie wollen wir uns noch mit den möglichen Fehlentscheidungen befassen, die beim Testen von Hypothesen auftreten können. Wie wir gesehen haben, wird durch die Signifikanzzahl α der kritische Bereich festgelegt, also die Menge jener Werte der Teststatistik, die zu einem Verwerfen der Nullhypothese führen. Nun kann es natürlich passieren, dass die Stichprobe einen so „unwahrscheinlichen“ Wert liefert, dass die Nullhypothese abgelehnt wird, obwohl sie richtig ist. Dabei begeht man einen Irrtum; dieser wird Fehler erster Art oder α -Fehler genannt, da er mit der angenommenen Wahrscheinlichkeit α auftritt. Das Signifikanzniveau α gibt also die Wahrscheinlichkeit an, die Nullhypothese zu unrecht abzulehnen. Einen Fehler begeht man aber auch dann, wenn man die Nullhypothese nicht verwirft, obwohl sie in Wirklichkeit falsch ist. Diese Fehlentscheidung wird Fehler zweiter Art oder β -Fehler genannt, wobei β gerade die Wahrscheinlichkeit für das Auftreten dieses Fehlers bezeichnet. Mögliche Entscheidungen beim Hypothesentest: Die Nullhypothese ist richtig ist falsch wird angenommen wird verworfen richtige Entscheidung Fehler 1. Art (mit Wsch. α ) Fehler 2. Art (mit Wsch. β ) richtige Entscheidung Genau genommen hängt die Wahrscheinlichkeit, dass H0 abgelehnt wird, von den aktuellen (wenn auch unbekannten) Parametern der Verteilung der Grundgesamtheit ab, also etwa vom Mittelwert µ. Diese Wahrscheinlichkeit, die jedem Parameterwert µ − egal ob er in der Nullhypothese oder in der Alternative enthalten ist − zugeordnet werden kann, bezeichnet man als Güte(funktion) oder Trennschärfe g(µ) des Tests. Die Wahrscheinlichkeit β für einen Fehler zweiter Art lässt sich daher darstellen als β = 1 − g(µ). Im allgemeinen wird man 39 natürlich bestrebt sein, beide Fehlerwahrscheinlichkeiten α und β so gering wie möglich zu halten, wobei allerdings zu beachten ist, dass z.B. eine Verringerung von α meist eine Zunahme von β zur Folge hat und umgekehrt. Man wird also bei der Wahl des Signifikanzniveaus im Auge behalten müssen, welche Konsequenzen mit einem Fehler erster bzw. zweiter Art verbunden sind. Es gilt die folgende Faustregel: Sind die Konsequenzen schwerwiegend, wenn die Nullhypothese falsch ist, aber irrtümlich nicht verworfen wird, dann wird man die Irrtumswahrscheinlichkeit α eher groß wählen. Überwiegen dagegen die Nachteile, wenn H0 richtig ist, jedoch die Alternative irrtümlich angenommen wird, so ist eine kleine Irrtumswahrscheinlichkeit α vorzuziehen. 2. Vergleich von Mittelwerten bzw. Varianzen In diesem Abschnitt werden Testverfahren für ein und zwei Stichproben behandelt. Der Test einer Hypothese µ = µ0 über den Mittelwert µ einer normalverteilten Grundgesamtheit mit bekannter Varianz wurde bereits im letzten Abschnitt ausführlich behandelt. In der Regel wird aber die Varianz σ2 unbekannt sein und muss durch die Stichprobenvarianz s2 geschätzt werden. In diesem Fall kommt ein modifiziertes Testverfahren, der sogenannte Einstichproben-t-Test zur Anwendung. Die Rolle der Teststatistik übernimmt dabei die aus den Stichprobenvariablen X und S2 gebildete Stichprobenfunktion (**) T= X − µ0 S n. Sie besitzt unter Annahme der Hypothese µ = µ0 eine t-Verteilung mit n − 1 Freiheitsgraden, wobei n den Umfang der Stichprobe bezeichnet. Die sog. t-Verteilung spielt − ebenso wie die Normalverteilung − eine außerordentlich wichtige Rolle bei statistischen Schätz- und Prüfverfahren. Die Dichtekurve f(x) der t-Verteilung ist ähnlich wie die der Normalverteilung symmetrisch und glockenförmig. Das Aussehen von f(x) wird nur von einem Parameter FG bestimmt, der Anzahl der Freiheitsgrade heißt. Mit wachsender Zahl FG strebt f(x) gegen die Dichtefunktion Φ(x) der Standardnormalverteilung und fällt für FG ≥ 30 praktisch mit Φ(x) zusammen. Nachstehende Abbildung zeigt die Dichtekurven der t-Verteilung für verschiedene Freiheitsgrade. 40 Das Entscheidungsverfahren bei Einstichproben-t-Test, das wiederum als zweiseitiger wie als einseitiger Test durchgeführt werden kann, läuft nach dem gewohnten Schema ab: Die Nullhypothese lautet H0: µ = µ0 (bzw. µ ≥ µ0 oder µ ≤ µ0), die Alternative H1: µ ≠ µ0 (bzw. µ < µ0 oder µ > µ0). Zur Signifikanzzahl α bestimmt man nun den kritischen Wert c aus der Gleichung F(c) = 1 − α/2 (bzw. F(c) = 1 − α) für die Verteilungsfunktion F der t-Verteilung mit FG = n − 1. Dann berechnet man anhand der gegebenen Stichprobe die Werte x , s2 und schließlich den entsprechenden Wert t der Prüfgröße T gemäß (1). Fällt t in den kritischen Bereich, d.h. gilt |t| > c (bzw. t < −c oder t > c), so wird die Nullhypothese verworfen. Beispiel 2.1: Die Gewichtsverteilung von Neugeborenen werde durch eine Normalverteilung mit den Parametern µ und σ2 beschrieben. In einer Stichprobe von 47 Neugeborenen wurde ein Mittelwert von 3281 g und eine Standardabweichung von 705 g festgestellt. Kann aufgrund dieser Daten geschlossen werden, dass das mittlere Geburtsgewicht µ mehr als 3200 g beträgt? Wir wollen ein mittleres Geburtsgewicht µ über µ0 = 3200 g dann als gesichert annehmen, wenn die Hypothese µ ≤ µ0 aufgrund der Ergebnisse der betrachteten Stichprobe verworfen werden kann. Wir formulieren also die einseitige Nullhypothese H0: µ ≤ µ0 und die Alternative H1: µ > µ0. Als Signifikanzniveau wählen wir α = 0.05 und bestimmen aus F(c) = =1 − α = 0.95 für die t-Verteilung mit FG = 46 den kritischen Wert c = 1.68. (In Excel allerdings durch Berechnung von TINV( 2α; FG ) , d.h. es wird mit Signifikanzniveaus als Eingabe gerechnet und mit 2α statt α , da ein zweiseitiger Test vorliegt.) Als Realisierung der Testgröße gemäß (**) erhalten wir dann t= 3281 − 3200 47 = 0.79 . 705 Wegen t ≤ c können wir die Nullhypothese nicht ablehnen. (Diese Entscheidung würde auf einem geringeren Signifikanzniveau natürlich erst recht bestätigt werden.) Die vorliegenden Daten sprechen also nicht für ein durchschnittliches Geburtsgewicht über 3200 g, vielmehr ist auch ein Durchschnittswert in der Höhe dieser Marke oder darunter möglich. Wir haben bisher den Mittelwert einer Normalverteilung mit einer gegebenen Zahl verglichen und wollen nun die Mittelwerte zweier Grundgesamtheiten zueinander in Beziehung setzen. Von jeder der beiden Grundgesamtheiten X1 bzw. X2 liege eine Stichprobe x 11 , x 12 ,..., x 1n1 bzw. x 21 , x 22 ,..., x 2 n 2 vor. Diese Stichproben können entweder abhängig oder unabhängig sein. Abhängige (oder verbundene) Stichproben zeichnen sich dadurch aus, dass sämtliche Stichprobenwerte in Paaren vorliegen (z.B. weil sie an der selben Untersuchungseinheit, etwa an derselben Person gemessen wurden). Folglich stimmen dann auch die beiden Stichprobenumfänge n1 und n2 von vornherein überein. Verbundene Stichproben erhält man etwa dann, wenn man die Wirksamkeit zweier Behandlungsmethoden an denselben Personen hintereinander oder an paarigen Organen gleichzeitig überprüft. Zwei Stichproben heißen hingegen unabhängig, wenn ihre Beobachtungswerte nicht unmittelbar in einen paarweisen Zusammenhang gebracht werden können. Auf unabhängige Stichproben führt z.B. die Überprüfung der Wirksamkeit zweier Behandlungsmethoden an zwei verschiedenen Personengruppen. Zum Test der Hypothese µ1 = µ2 für die Mittelwerte zweier Normalverteilungen unter Benützung verbundener Stichproben (Differenzen-t-Test) geht man wie folgt vor: Man 41 bildet zunächst die Differenzen entsprechender Stichprobenwerte. Für die aus diesen Differenzen gebildete Stichprobe prüft man dann mit dem Einstichproben-t-Test wie oben ausgeführt, ob sie aus einer Verteilung mit dem Mittelwert µ = 0 stammt. Zwei normalverteilte Grundgesamtheiten bilden auch das statistische Modell für den Vergleich der Mittelwerte µ1 und µ2 zweier Normalverteilungen unter Benützung unabhängiger Stichproben (Zweistichproben-t-Test). Die zugehörenden Varianzen brauchen nicht bekannt zu sein, sie werden aber als gleich vorausgesetzt. Bezeichne n1, X1 bzw. S12 Stichprobenumfang, Mittelwert bzw. Varianz der ersten Stichprobe und n2, X 2 bzw. S22 die entsprechenden Größen der zweiten Stichprobe, so bilden wir die Zufallsvariable (***) T= X1 − X 2 (n 1 − 1)S1 + (n 2 − 1)S 2 2 2 n 1 n 2 (n 1 + n 2 − 2) . n1 + n 2 Diese besitzt im Fall µ1 = µ2 wieder eine t-Verteilung, und zwar mit n1 + n2 − 2 Freiheitsgraden. Damit ist auch der Testablauf bereits vorgezeichnet: Im Fall eines zweiseitigen Tests mit der Nullhypothese H0: µ1 = µ2 bestimmt man zur Signifikanzzahl α den kritischen Wert c aus F(c) = 1 − α/2 für die t-Verteilung mit FG = n1 + n2 − 2. Dann berechnet man für beide Stichproben Mittelwerte und Varianzen und setzt diese schließlich in der Teststatistik T gemäß (***) ein. Gilt für den so erhaltenen Wert t der Teststatistik |t| > c, so wird die Nullhypothese verworfen; ist |t| ≤ c, so wird sie beibehalten. Beim einseitigen Test ist entsprechend vorzugehen. Beispiel 2.2: Das Gewicht von Neugeborenen sei normalverteilt mit den Parametern µl und σ2 für Knaben bzw. µ2 und σ2 für Mädchen. Man teste die Hypothese µ1 = µ2 auf dem 1%Signifikanzniveau anhand einer Stichprobe von n1 = 29 männlichen sowie einer Stichprobe von n2 = 18 weiblichen Neugeborenen, wobei die empirischen Werte x 1 = 3170 g, s1 = 637 g, x 2 = 3460 g und s2 = 789 g ermittelt wurden. Wir führen diesmal einen zweiseitigen Test für die Nullhypothese H0: µ1 = µ2 mit der Alternative H1: µ1 ≠ µ2 unter Benützung von zwei unabhängigen Stichproben durch. Zur Signifikanzzahl α = 0.01 bestimmen wir zunächst aus F(c) = 1 − α/2 = 0.995 für die tVerteilung mit FG = 45 den kritischen Wert c = 2.70. (In Excel geschieht dies durch Berechnung von TINV( α; FG ) , d.h. es wird diesmal nur das einfache Signifikanzniveau eingegeben, da ein einseitiger Test vorliegt.) Obige Prüfgröße T nimmt für die gegebenen Stichproben den Wert t= 3170 − 3460 28 ⋅ 637 + 17 ⋅ 789 2 2 29 ⋅ 18 ⋅ 45 = −1.38 47 an, d.h., sie liegt deutlich im Annahmebereich. Somit kann aufgrund der vorliegenden Daten kein signifikanter Unterschied zwischen den Gewichten neugeborener Knaben bzw. Mädchen festgestellt werden. Abschließend wollen wir auch noch kurz auf den sog. F-Test eingehen, mit dessen Hilfe zwei unverbundene Stichproben mit den Umfängen n 1 bzw. n 2 und den empirischen Varianzen s12 bzw. s 22 daraufhin überprüft werden können, ob sie Grundgesamtheiten mit der gleichen Varianz entstammen, was ja eine der Voraussetzungen war, um obigen T-Test überhaupt anwenden zu können. Man spricht in diesem Zusamenhang auch von einem Test auf Varianzhomogenität. Als Testgröße TG nimmt dazu 42 TG= S12 S 22 welche unter obigen Annahmen dann Fisher-verteilt (oder kurz F-verteilt) mit (n 1 − 1, n 2 − 1) − Freiheitsgraden ist. Auch hier kann man genauso wie bei den Mittelwerten wieder ein- und zweiseitige Tests durchführen: Die Nullhypothese lautet H0: σ12 = σ 22 (bzw. σ12 ≤ σ 22 oder σ12 ≥ σ 22 ), die Alternative H1: σ12 ≠ σ 22 (bzw. σ12 > σ 22 oder σ12 < σ 22 ). Zum Signifikanzniveau α bestimmt man nun den kritischen Wert c aus der Gleichung F(c) = 1 − α/2 (bzw. F(c) = 1 − α) für die Verteilungsfunktion F der Fisher-Verteilung mit (n 1 − 1, n 2 − 1) − Freiheitsgraden. (In Excel steht dafür die Funktion FINV( ) zur Verfügung, wobei ähnlich wie bei TINV( ) Signifikanzniveaus und Freiheitsgrade eingegeben werden müssen.) Dann berechnet man anhand der beiden Stichprobenvarianzen den tatsächlichen Wert s12 / s 22 der Testgröße. Fällt sie in den jeweiligen kritischen Bereich, so wird die Nullhypothese verworfen. 3. Tests basierend auf der Chi-Quadrat-Verteilung Die bisher behandelten Tests ermöglichen einen Vergleich von Lageparametern mit vorgegebenen Werten oder auch untereinander. In diesem Abschnitt wird nun ein Verfahren beschrieben, mit dessen Hilfe eine Verteilung in ihrem Gesamtverlauf beurteilt werden kann. Der älteste und wohl auch bekannteste Test zum Vergleich von empirischen und theoretischen Verteilungen ist der von K. Pearson eingeführte χ2- Test. Die Grundlage dieses Tests bildet die sogenannte Chi-Quadrat-Verteilung (χ2-Verteilung), die − wie auch die t-Verteilung − von einem Parameter FG, der Anzahl der Freiheitsgrade, abhängig ist. So wie die Normaloder die t-Verteilung ist auch die χ2-Verteilung stetig, sie ist jedoch nur für nicht-negative Werte definiert. Der Verlauf der Dichtefunktion wird, wie die folgenden Abbildung zeigt, sehr vom Parameter FG beeinflusst; insbesondere weisen die Dichtefunktionen für kleine Anzahlen von Freiheitsgraden eine ausgeprägte Unsymmetrie auf. Wir betrachten nun eine diskrete Verteilung, bei der genau k Ausprägungen a1, a2, ..., ak mit positiver Wahrscheinlichkeit auftreten können. Aus dieser Verteilung sei eine Stichprobe vom 43 Umfang n gegeben, wobei jeweils ni Stichprobenelemente von der Ausprägung ai sind (i = 1, 2, ..., k). Die Stichprobe ist somit in k Klassen eingeteilt, die absoluten Klassenhäufigkeiten betrage n1, n2, ..., nk und es gilt n1 + n2 + ... + nk = n. Getestet wird nun eine Hypothese über die zugrundeliegende Wahrscheinlichkeitsverteilung, z.B. H0: Die Wahrscheinlichkeiten der Ausprägungen a1, a2, ..., ak sind p1, p2, ..., pk (mit p1 + p2 + ... + pk = l). Um zu einem Urteil über die Richtigkeit dieser Hypothese zu gelangen, müssen die tatsächlich beobachteten Werte n1,..., nk mit den entsprechenden unter H0 erwarteten Häufigkeiten n1* = np1, ..., nk* = npk verglichen werden. Dabei ist es − im Gegensatz zu den bisher behandelten Verfahren − völlig belanglos, ob die Stichprobenwerte qualitatives oder quantitatives Messniveau besitzen, wie das folgende Beispiel zeigt. Beispiel 3.1: Gregor Mendel erhielt in einem seiner klassischen Kreuzungsversuche an Erbsenpflanzen 315 runde gelbe, 108 runde grüne, 101 kantige gelbe und 32 kantige grüne Erbsen. Spricht dieses Ergebnis für oder gegen die Mendelsche Theorie, nach der sich diese vier Häufigkeiten wie 9:3:3:1 verhalten sollten? Die Form der Erbsen stellt offensichtlich ein qualitatives Merkmal mit vier Merkmalsausprägungen dar, die wir der Reihe nach mit 1, 2, 3 und 4 bezeichnen wollen. Die entsprechenden Wahrscheinlichkeiten lauten dann pl = 9/16, p2 = p3 = 3/16 und p4 = 1/16. Demnach sind unter den insgesamt n = 556 Erbsenpflanzen n1* = np1 = 312.75, n2* = 104.25, n3* = 104.25 und n4* = 34.75 Pflanzen in den vier Klassen zu erwarten. Der Vergleich zwischen den tatsächlich beobachteten und den erwarteten Häufigkeiten verläuft nach folgendem Schema: Zum Test der Hypothese, die gegebene Stichprobe entstamme einer durch die Wahrscheinlichkeiten pi charakterisierten Verteilung, bildet man die Testgröße k V=å i =1 (n i − n i *) 2 , ni * wobei ni die in der Stichprobe beobachteten, ni* = npi die unter der Nullhypothese erwarteten Häufigkeiten darstellen. Die Verteilung der Teststatistik V kann für große Stichproben annähernd durch eine χ2-Verteilung mit k − 1 Freiheitsgraden beschrieben werden, wobei große Werte für V signifikant sind. Die Testentscheidung wird daher nach dem folgenden üblichen Verfahren getroffen: Man wählt eine Signifikanzzahl α und bestimmt einen entsprechenden kritischen Wert c für die χ2-Verteilung mit FG = k − 1 gemäß F(c) = 1 − α. Der kritische Bereich ist dann durch V > c festgelegt; gilt also V > c, so wird die Nullhypothese verworfen, ist V ≤ c, wird sie beibehalten. In obigem Beispiel wählen wir nun α = 0.05 und bestimmen den kritischen Wert c = 7.81 aus der Gleichung F(c) = 0.95 und FG = 3. (In Excel muss jedoch, wie schon bei der t-Verteilung, α selbst und nicht 1 − α verwendet werden und man erhält kritische Werte durch Berechnung von CHIINV( α ; FG). ) Der Wert der obiger Testgröße V ergibt sich zu v= (315 − 312.75) 2 (108 − 104.25) 2 (101 − 104.25) 2 (32 − 34.75) 2 + + + = 0.47 . 312.75 104.25 104.25 34.75 Aus v ≤ c schließen wir, dass die von Mendel beobachteten Werte keineswegs im Widerspruch zu seiner Theorie stehen. (Der Statistiker R. A. Fisher vermutete − etwa 50 Jahre später − sogar, dass Mendel diese Daten manipuliert habe, um eine so gute Übereinstimmung zu erzielen.) Wie bereits erwähnt, stellt der χ2-Test lediglich ein Näherungsverfahren dar. Wie gut die Verteilung von V mit der χ2-Verteilung übereinstimmt, hängt vor allem von den erwarteten Häufigkeiten n in den schwach besetzen Klassen ab. Als Faustregel gilt ni* ≥ 5 für mindestens 44 80% aller Klassen und zugleich ni* ≥ 1 für alle Klassen. Ist diese Voraussetzung nicht erfüllt, müssen einzelne Klassen zusammengelegt und die Anzahl der Freiheitsgrade entsprechend reduziert werden. Obwohl die Fragestellung bei diesem Testverfahren eine zweiseitige Problemstellung darstellt, ist der Annahmebereich einseitig: Die Nullhypothese wird nur dann verworfen, wenn die Teststatistik V den kritischen Wert c übersteigt. Wie aus der Form der Testgröße V sofort ersehen werden kann, führen Abweichungen zwischen den beobachteten und den erwarteten Häufigkeiten in jeder Richtung stets zu einer Vergrößerung. Es sei auch noch besonders darauf hingewiesen, dass zur Berechnung der Prüfgröße die absoluten (und nicht die relativen) Häufigkeiten herangezogen werden müssen, d.h. eine Benutzung von relativen Häufigkeiten ist in diesem Zusammenhang unzulässig! Wir haben oben mit Hilfe der Chi-Quadrat-Verteilung einen sogenannten Anpassungstest durchgeführt, d.h. überprüft, wie gut sich vorgegebene Daten einer theoretisch vermuteten Verteilung anpassen. In nur leicht modifizierter Form lassen sich damit auch sog. Unabhängigkeitstests durchführen, worauf wir in Kapitel I im Zusammenhang mit Kontingenztafeln schon hingewiesen haben. Beispiel 3.2: Wir betrachten dazu nochmals Bsp. 2.1 in Kap. I mit der Vierfeldertafel. männlich weiblich Raucher n 11 =19 n 21 =10 Nichtraucher n 12 =20 n 22 =20 n .1 =29 n .2 =40 gesamt n 1. =39 n 2. =30 n = 69 Wären die Merkmale Geschlecht und Raucherstatus unabhängig, so müssten die Zahlen n11 , n12 , n 21 , n 22 folgendermassen aussehen: * n 11 = n 1. * (n .1 / n ) = 39 * (29/69) = 16.39 * n 12 = n 1. * (n .2 / n ) = 39 * (40 / 69) = 22.61 n *21 = n 2. * (n .1 / n ) = 30 * (29 / 69) = 12.61 n *22 = n 2. * (n .2 / n ) = 30 * (40 / 69) = 17.39 Ähnlich wie oben berechnen wir wieder die Testgröße * 2 * * 2 * V = (n 11 − n11 ) / n11 + (n12 − n12 ) / n12 + (n 21 − n *21 ) 2 / n *21 + (n 22 − n *22 ) 2 / n *22 =1.6472 und der zugehörige P-Wert, nämlich P(V ≥ 1.65) =CHIVERT(1.6572,1)=0.20 mit FG = (Zeilenanzahl-1)*(Spaltenanzahl-1)=1 (beachte, dass die Randsummen ja vorgegeben sind, d.h. nach Weglassen einer beliebigen Zeile und Spalte in obiger Tafel kann man diese aus den übrigen Werten immer noch rekonstruieren, womit sich obige Wert für die Anzahl der Freiheitsgrade ergibt!) zeigt überraschenderweise, dass wir die Nullhypothese, obige zwei Merkmale wären unabhängig, erst auf dem sehr hohen Signifikanzniveau von α = 0.2 ablehnen könnten. Trotzdem ist ein gewisses Maß an Abhängigkeit erkennbar, das wir nun auch quantifizieren können. 45 4. Schätzen von Parametern Wir haben im 2. Kapitel eine Reihe von Wahrscheinlichkeitsverteilungen kennengelernt und insbesondere auch gesehen, dass diese gewöhnliche von einem oder mehreren Parametern abhängen (z.B. p für die Bernoulliverteilung bzw. allgemeiner für die Binomialverteilung, λ für die Possonverteilung, µ und σ für die Gauß’sche Normalverteilung usw.). Eine weitere Standardaufgabe der Induktiven Statistik, auf die wir abschließend noch kurz eingehen wollen, ist es nun, den Wert eines gesuchten Parameters θ abzuschätzen,. Man unterscheidet dabei grundsätzlich zwischen Punktschätzungen, welche nur aus der Angabe eines Schätzwertes θ̂ für den gesuchten Parameter bestehen, und Konfidenzschätzungen (oder Intervallschätzungen), wobei ein sogenanntes Konfidenzintervall (auch Vertrauensbereich) angegeben wird, in dem der gesuchte Parameter θ mit einer vorgegeben Wahrscheinlichkeit 1 − α (mit z.B. α = 0.05 oder α = 0.01 ) liegt. 1 − α heißt dabei auch Konfidenzniveau und α die Irrtumswahrscheinlichkeit. Punktschätzungen ergeben sich dabei in der Regel als die Werte von sogenannten Schätzfunktionen (auch kurz Schätzer) θ̂(X 1 , X 2 ,.., X n ), indem man hierin aktuellen Werte x 1 , x 2 ,..., x n der Stichprobe einsetzt. Folgende Kriterien sind für die Güte dieser Schätzer von Bedeutung: • Erwartungstreue, d.h. E( θ̂ )= θ . Mit anderen Worten sollte θ̂ , auch wenn es den Wert von θ im Einzelfall nicht genau trifft, ihn doch nicht systematisch über – oder unterschätzen, d.h. wenigstens im Mittel mit ihm übereinstimmen. • Konsistenz, d.h. die Varianz V( θ̂ ) sollte mit wachsendem Stichprobenumfang gegen 0 gehen. ~ ~ Effizienz, d.h. es sollte V( θ̂ ) ≤ V( θ ) für jede andere Punktschätzung θ gelten. • • Suffizienz, d.h. es sollten wirklich alle in der Stichprobe enthaltenen Informationen im Vergleich zu allen anderen Schätzungen von θ optimal ausgenutzt worden sein. Ein wichtiges Prinzip, um Punktschätzungen mit solchen guten Eigenschaften zu erhalten ist die sog. Maximum Likelihood-Methode (auch oft kurz ML-Methode genannt). Man bestimmt dazu θ̂ als jenen Wert von θ , für den die Wahrscheinlichkeit, das die Zufallsvariable X genau die in der Stichprobe beobachteten Realisationen x 1 , x 2 ,..., x n annimmt, ein Maximum wird Beispiel 4.1: Der Mittelwert X= X1 + X 2 + .. + X n n ist wegen E( X ) = µ und V( X ) = σ 2 / n (s. II, 2.5) ein sowohl erwartungstreuer, als auch konsistenter Schätzer für den Mittelwert µ der Grundgesamtheit. Gleiches gilt für die empirische Varianz S2 = 1 n å (X k − X ) n − 1 k =1 in Bezug auf die Varianz σ 2 , wie man nach leichter Rechnung bestätigt. (Würde man hier jedoch den Faktor 1/n statt 1/(n-1) verwenden, so hätte dies eine systematische Unterschätzung von σ 2 um den Faktor (n-1)/n zur Folge!) 46 Als erwartungstreuen und konsistenten Schätzer für den Parameter p einer Bernoulliverteilung kann man die relative Häufigkeit h n (A) des Ereignisses A in den n Realisationen der Stichprobe nehmen. Dies ist im wesentlichen wieder die Aussage des Gesetzes der großen Zahlen (s. II, 2.7) Was Konfidenzschätzungen angeht, so begnügen wir uns hier mit einigen wichtigen Beispielen, aus denen das allgemeine Prinzip klar hervorgehen sollte. Insbesondere werden wir im folgenden nur zweiseitige Konfidenzintervalle betrachten, welche den zweiseitigen Tests entsprechen. (Für einseitige Konfidenzintervalle, die also nach jener Seite hin, wo Abweichungen der betrachteten Größen „irrelevant“ sind, unbeschränkt sind, hätte man nachstehende Überlegungen entsprechend zu modifizieren.) Wir beginnen dazu mit der Konfidenzschätzung für den Erwartungswert einer normalverteilten Grundgesamtheit mit bekannter Varianz. Ist die Zufallsvariable X in der Grundgesamtheit normalverteilt mit Mittel µ und Varianz σ 2 , so wissen wie bereits, dass dann X ebenfalls normalverteilt mit Mittel µ und Varianz σ 2 /n ist. Berechnet man nun genauso, wie im allerersten Beispiel zu den Testverfahren den kritischen Wert c zum Signifikanzniveau α , so heißt das, dass gilt P ( −c < X −µ (σ / n ) < c) = 1 − α wobei hier c= Φ −1 (1 − α / 2) ist, wofür wir im folgenden z 1−α / 2 schreiben. Ist x das Mittel einer konkreten Stichprobe, so gilt daher mit Wahrscheinlichkeit 1 − α die Ungleichung x − z 1−α / 2 σ n < µ < x + z1−α / 2 σ n Dieser Bereich bildet also dann das Konfidenzintervall für µ , in dem es mit Wahrscheinlichkeit 1 − α bzw. einer Irrtumswahrscheinlichkeit von α auch tatsächlich liegt. Fast die gleiche Herleitung gilt auch für die Konfidenzschätzung für den Erwartungswert einer normalverteilten Grundgesamtheit mit unbekannter Varianz. Hier nehmen wir dann als Schätzwert für die unbekannte Varianz σ 2 der Grundgesamtheit die emprische Varianz s 2 der Stichprobe, müssen aber „zum Ausgleich“ die Normalverteilung durch die t-Verteilung mit n-1 Freiheitsgraden austauschen, wo n den Stichprobenumfang bezeichnet. Das Konfidenzintervall für µ , in dem es mit Wahrscheinlichkeit 1 − α liegt, läßt sich dann beschreiben als x − t 1− α / 2 σ n < µ < x + t 1−α / 2 σ n wobei t 1− α / 2 das der Wahrscheinlichkeit 1 − α / 2 entsprechende Quartil darstellt. Als letztes wollen wir auch noch ein Konfidenzintervall für die Varianz einer normalverteilten Grundgesamtheit angeben. Wir benutzen dazu die Tatsache aus der „Theorie“, dass die Zufallsvariable (n − 1)S 2 σ2 einer χ 2 -Verteilung mit n-1 Freiheitsgraden gehorcht. Damit ergibt sich Konfidenzintervall auf dem Signifikanzniveau α nach leichter Rechnung zu 47 (n − 1)s 2 (n − 1)s 2 2 < σ < χ n2 −1;α / 2 χ n2 −1;1− α / 2 wobei hier wieder die entsprechenden Quantile der χ 2 -Verteilung mit n-1 Freiheitsgraden einzusetzen sind.