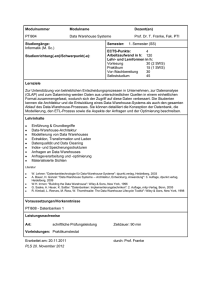

Erweiterung des Data–Warehouse des OÖ Verkehrsverbundes um

Werbung