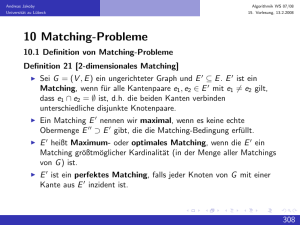

Algorithmik 1 Einleitung

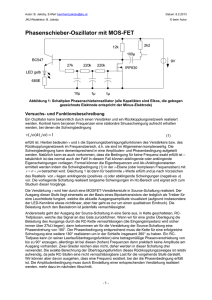

Werbung