Fehlerdiagnose in Worthypothesengraphen - Friedrich

Werbung

Friedrich-Alexander-Universität Erlangen-Nürnberg

Lehrstuhl für Künstliche Intelligenz

Fehlerdiagnose in

Worthypothesengraphen

Diplomarbeit im Fach Informatik

vorgelegt von

Martin Hacker

Matrikelnummer: 1941575

am 7. Januar 2008

Betreuer: Dr.-Ing. Bernd Ludwig

Erklärung

Ich versichere, dass ich die vorliegende Arbeit ohne fremde Hilfe und ohne Benutzung anderer als der angegebenen Quellen angefertigt habe und dass die

Arbeit in gleicher oder ähnlicher Form noch keiner anderen Prüfungsbehörde

vorgelegen hat und von dieser als Teil einer Prüfungsleistung angenommen

wurde. Alle Ausführungen, die wörtlich oder sinngemäÿ übernommen wurden, sind als solche gekennzeichnet.

Ort, Datum:

Unterschrift:

i

Inhaltsverzeichnis

1 Einführung

1

1.1

Motivation . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1

1.2

Problemstellung und Spezikation . . . . . . . . . . . . . . . .

2

1.3

Einschränkungen

4

1.4

Besondere Schwierigkeiten

. . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . . . . . . . . . .

2 Grundlagen

5

7

2.1

Wort- und Satzhypothesen . . . . . . . . . . . . . . . . . . . .

7

2.2

Merkmalstrukturen . . . . . . . . . . . . . . . . . . . . . . . .

8

2.3

Grammatikmodelle

9

. . . . . . . . . . . . . . . . . . . . . . . .

2.3.1

Variabilität der Wortstellung . . . . . . . . . . . . . . .

2.3.2

Phrasenstrukturgrammatiken

2.3.3

Dependenzgrammatiken

9

. . . . . . . . . . . . . .

10

. . . . . . . . . . . . . . . . .

13

2.4

Chart-Parsing . . . . . . . . . . . . . . . . . . . . . . . . . . .

15

2.5

Kombinationen von Dependenz und Phrasenstrukturparsern

.

17

2.6

Grundlegende Topologie deutscher Sätze

. . . . . . . . . . . .

19

3 Ein Verfahren zur Fehleranalyse in Spracherkennerhypothesen

22

3.1

3.2

Das Verfahren im Detail

. . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . . . . . . .

22

3.1.1

Architektur des Systems

22

3.1.2

Modellierung topologischer Strukturen

. . . . . . . . .

23

3.1.3

Präzedenzregeln . . . . . . . . . . . . . . . . . . . . . .

27

3.1.4

Konikte . . . . . . . . . . . . . . . . . . . . . . . . . .

30

3.1.5

Das Suchverfahren

3.1.6

Priorisierung

3.1.7

Weitere Optimierungsmaÿnahmen . . . . . . . . . . . .

40

3.1.8

Fehlerdiagnose

43

. . . . . . . . . . . . . . . . . . . .

33

. . . . . . . . . . . . . . . . . . . . . . .

38

. . . . . . . . . . . . . . . . . . . . . .

Ein Sprachmodell für das Deutsche

. . . . . . . . . . . . . . .

45

3.2.1

Satzmodi

. . . . . . . . . . . . . . . . . . . . . . . . .

45

3.2.2

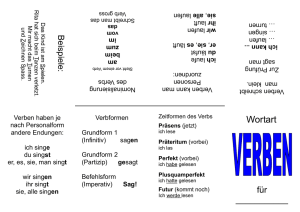

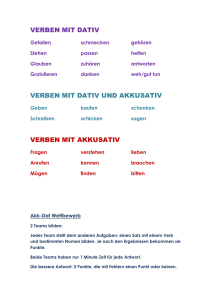

Vollverben . . . . . . . . . . . . . . . . . . . . . . . . .

45

3.2.3

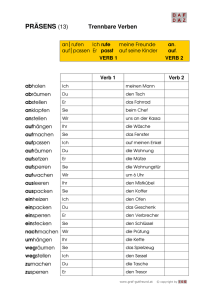

Trennbarer Verbzusatz bei trennbaren Verben

. . . . .

48

3.2.4

Kopulaverben . . . . . . . . . . . . . . . . . . . . . . .

49

3.2.5

Funktionsverbgefüge

. . . . . . . . . . . . . . . . . . .

49

3.2.6

Hilfsverben

. . . . . . . . . . . . . . . . . . . . . . . .

50

3.2.7

Modal- und Modalitätsverben

3.2.8

AcI-Verben

3.2.9

Doppel-Vollverb-Konstruktionen . . . . . . . . . . . . .

52

3.2.10 Aufbau komplexer Verbalstrukturen . . . . . . . . . . .

52

. . . . . . . . . . . . . .

51

. . . . . . . . . . . . . . . . . . . . . . . .

51

ii

3.2.11 Topologie der Verbformen

. . . . . . . . . . . . . . . .

3.2.12 Valenzalternation bei bestimmten Verbformen

53

. . . . .

54

3.2.13 Nominalphrasen . . . . . . . . . . . . . . . . . . . . . .

56

3.3

Behandlung von Koordinationen . . . . . . . . . . . . . . . . .

56

3.4

Die resultierende Sprache . . . . . . . . . . . . . . . . . . . . .

57

4 Implementierung

58

4.1

Implementierung des Suchalgorithmus . . . . . . . . . . . . . .

58

4.2

Implementierung des Sprachmodelles

. . . . . . . . . . . . . .

60

4.3

Implementierung des Topologiemodelles . . . . . . . . . . . . .

61

4.4

Implementierung des Präzedenzmodelles

. . . . . . . . . . . .

63

4.5

Implementierung des Koniktmodelles

. . . . . . . . . . . . .

63

5 Evaluation

64

5.1

Datengrundlage . . . . . . . . . . . . . . . . . . . . . . . . . .

64

5.2

Bewertung einzelner Hypothesen . . . . . . . . . . . . . . . . .

64

5.3

Nachkontrolle von Spracherkennerinterpretationen . . . . . . .

64

5.4

Lokalisierung des Fehlers . . . . . . . . . . . . . . . . . . . . .

65

6 Ausblick

66

6.1

Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . .

66

6.2

Perspektiven . . . . . . . . . . . . . . . . . . . . . . . . . . . .

67

iii

1

Einführung

1.1 Motivation

Die maschinelle Verarbeitung natürlicher Sprache gewinnt in der Praxis zunehmend an Bedeutung. Denn Fortschritte im Bereich der Künstlichen Intelligenz sind im Alltag in Kombination mit einem sprachlichen Eingabemodus

erst richtig wertvoll. Denn intelligente Systeme erfordern bei ihrer Bedienung

weit komplexere Angaben, für die einzelne Tasten auf dem Gerät oder der

Fernbedienung nicht mehr ausreichen. So könnte ein intelligenter Fernseher,

der Sendungen aus dem Fernsehprogramm nach den individuellen Wünschen

des Benutzers auswählt, auf eine Vielzahl teils vager zeitlicher und inhaltlicher Angaben reagieren, deren Formalisierung und Kodierung mittels Fernbedienung dem Benutzer kaum weniger Aufwand abverlangen würde als das

eigenhändige Stöbern in der Fernsehzeitschrift. Die Steuerung per Tastatur,

die sich bei Personalcomputern über Jahrzehnte bewährt hat, ist bei integrierten Systemen häug nicht möglich wie beim Autofahren oder für

den Benutzer nicht komfortabel wie bei der Bedienung des Fernsehers von

der Couch aus.

In der Automobilwelt oder bei Dialogsystemen zur telefonischen Auskunft

und Abwicklung sind Spracherkennungssysteme bereits heute gang und gäbe. Auch die Entwicklung intelligenter, sprachgesteuerter Haushaltsgeräte

wird von den Herstellern mit Nachdruck vorangetrieben. Die Szenarien reichen dabei vom modernen Allzweck-Haushaltsroboter, der den Bewohnern im

wahrsten Sinne des Wortes jeden Wunsch von den Lippen abliest, bis hin zu

Mobiltelefonen, die stets ein oenes Ohr für ihren Besitzer haben, um jegliche

Art der gewünschten Information per Internet zu aquirieren oder organisatorische Aufgaben zu übernehmen, indem es zum Beispiel Anweisungen an

die heimischen Haushaltsgeräte gibt.

Nun ist die natürliche Sprache aber ein schwer zu fassendes Konstrukt,

welches oft nicht den Gesetzen der Logik folgt und in Aussprache, Grammatik und Wortschatz groÿe individuelle, regionale, gesellschaftliche und situative Varietäten zeigt. Die Erkennungsrate heutiger Spracherkenner genügt

deshalb insbesondere wenn kein individuelles Training mit dem jeweiligen

Benutzer vorausgegangen ist selten den hohen Anforderungen künftiger

Anwendungen, die sich häug nicht mehr auf eine enggefasste sprachliche

Thematik beschränken. Damit intelligente Systeme in der Praxis überhaupt

Akzeptanz nden können, sind also Methoden gefragt, mit denen die Erkennungsrate gesteigert werden kann.

1

1.2 Problemstellung und Spezikation

Spracherkennungssysteme bilden Hypothesen für einzelne Wörter und Sätze

und bewerten diese in der Regel rein lokal, das heiÿt einerseits anhand eines

akustischen Abstandsmaÿes, andererseits mittels statistischer Erfahrungswerte für N-Gramm-Häugkeiten. Bedingt durch akustische Verwechslungen,

also falsche Wahl einzelner Wörter, entstehen semantisch oder syntaktisch

fehlerhafte Satzhypothesen. Vom Menschen können diese oft problemlos als

fehlerhaft eingeordnet werden, ohne die tatsächlich zugrundeliegende Äuÿerung zu kennen. Die semantischen Fehler können mit umfassendem Weltwissen, die syntaktischen durch eine globale Sicht auf die grammatikalische

Struktur des Satzes identiziert werden.

Die Idee dieser Arbeit besteht darin, im Anschluÿ an die Hypothesenbildung mit globalen maschinellen Parsing-Verfahren die grammatikalische

Korrektheit zu überprüfen. Auf diese Weise als ungrammatisch bewertete

Hypothesen können ausgeschlossen werden, was zu einer Verbesserung der

Erkennungsrate des Spracherkenners führen kann.

In einem weiteren Schritt kann der Versuch erfolgen, von den während

des Parsings aufgetretenen syntaktischen Konikten, die zur Einstufung der

Äuÿerung als ungrammatisch führten, auf die eigentliche Fehlerursache, das

verwechselte Wort beziehungsweise die verwechselten Wörter, zu schlieÿen.

Ist die Ursache einmal identiziert und somit der Fehler lokalisiert, kann über

das weitere Vorgehen entschieden werden. Dieses kann im Versuch bestehen,

das ursprüngliche Wort anhand von Alternativen im Worthypothesengraphen

oder anhand von lexikalischer und morphologischer Zusatzinformation zu erraten. Ist dies nicht aussichtsreich genug und wird keine andere Hypothese

als richtig bewertet, kann alternativ eine gezielte Nachfrage an den Benutzer

gestellt oder in schwierigen Fällen der Erkennungsversuch ganz abgebrochen werden, um den Benutzer um eine Wiederholung oder Umformulierung

zu bitten.

In den vergangenen Jahrzehnten wurde eine Menge verschiedenartiger

Parser entwickelt. Eine Neuentwicklung scheint jedoch angebracht, da sowohl die Anwendung als auch die Tatsache, dass es sich bei der Eingabe um

mündliches Deutsch handelt, spezielle Anforderungen an das System stellen:

•

Das Hauptaugenmerk liegt weniger auf bis ins Detail korrektem Parsing

grammatikalisch korrekter Sätze als vielmehr auf der Analyse fehlerhafter Äuÿerungen. Der Parser muss also in bestimmtem Maÿe fehlertole-

rant arbeiten. Lässt sich keine fehlerfreie Lösung nden, darf die Suche

nicht abgebrochen werden, sondern es muss die fehlerärmste Lösung

ermittelt werden, um Aussagen über die mutmaÿlichen Fehlerursachen

treen zu können.

2

•

Trotz gröÿeren Rechenaufwandes einer fehlertoleranten Suche soll das

Verfahren so ezient umsetzbar sein, dass ein Einsatz in einem EchtzeitDialogsystem im Bereich des Möglichen liegt.

•

Auf die speziellen, topologisch schwierigen Eigenheiten der deutschen

Sprache ist intensiv einzugehen.

•

In der gesprochenen Sprache entfällt die Interpunktion als nützliche

Hinweisquelle.

•

Das Verfahren muss oen für Umgangssprache und -grammatik sein.

•

Die akzeptierte Sprache soll möglichst weit gefasst sein, um False Negatives zu vermeiden. Denn wenn vom Spracherkenner korrekt gebildete

Hypothesen revidiert werden, besteht die Gefahr, dass sich die Erkennungsrate sogar verschlechtert.

•

Der Rechenaufwand wird in der Praxis durch den für gewöhnlich einfacheren Satzbau in der mündlichen Sprache vermindert, weil es sich

meist um sehr kurze Sätze handelt.

•

Da der primäre Gegenstandsbereich in der Sprache zur Bedienung technischer Geräte liegt, ist eine Spezialisierung auf einen kommandolastigen Sprachstil wünschenswert.

Aus obigen Postulaten wird bereits ersichtlich, dass sich die Arbeit in einem

Spannungsfeld zwischen Vollständigkeit und Ezienz sowie zwischen Fehlersensitivität und -toleranz bewegt. Tabelle 1 zeigt typische Methoden, die für

die jeweiligen Anforderungen in Frage kommen.

Fehlersensitivität

Fehlertoleranz

Vollständigkeit

Ezienz

Bottom-Up-Dependenzanalyse

PSG-Parsing

von Fachsprache

von Schriftsprache

Top-Down-Dependenzanalyse

Keyword Spotting

gesprochener Sprache

gesprochener Sprache

Tabelle 1: Geeignete Methoden für verschiedene Sprachstile, abhängig von

den Anforderungen

3

1.3 Einschränkungen

Da das Verfahren auf einzelnen Eingabeturns arbeitet, wird folgende Grundannahme getroen:

Annahme 1

Bei den Transkriptionen der Turns handelt es sich um vonein-

ander unabhängige, grammatikalisch korrekte satzförmige

1

Äuÿerungen. Es

existieren also insbesondere

•

keine syntaxrelevanten turnübergreifenden Beziehungen und Phänomene (wie zum Beispiel Ellipsen),

•

kein syntaxrelevanter Kontext.

Weiterhin wird angenommen:

Annahme 2

Die Erkennungsrate des Spracherkenners und die Satzlänge

der Eingabe sind so beschaen, dass die Wahrscheinlichkeit für

n+1

akus-

tische Verwechslungen in der Äuÿerung stets kleiner ist als die Wahrscheinlichkeit für

n

akustische Verwechslungen.

Aufgrund von Annahme 2 kann vom Parser eine Interpretation, die zum Beispiel auf einen einzigen Fehler schlieÿen lässt, einer anderen, die von mehreren

Fehlern ausgeht, vorgezogen werden.

Um die Komplexität des Verfahrens in Grenzen zu halten und den Rahmen dieser Arbeit nicht zu sprengen, werden vorerst folgende zusätzlichen

Einschränkungen getroen:

1. Auf eine semantische Analyse der Eingaben wird verzichtet, weshalb

2

eine Erkennung reiner Semantikfehler nicht möglich ist .

2. Die Eingabe enthält keine Ellipsen und Anakoluthe, keine Appositio-

3

nen

sowie keine Herausstellungsstrukturen und kein freies Topik.

3. Auf eine Auösung syntaktischer Ambiguitäten wird verzichtet, soweit

die resultierenden Alternativen hinsichtlich der Fehleranalyse gleichwertig sind. Denn es ist für die Bewertung eines Satzes ausreichend,

1 Satzförmige Äuÿerungen enthalten stets ein nites Verb, anders als satzwertige [7].

2 Zum Beispiel ist die Hypothese die sparte im orb aus drei_sat ist ausgewählt semantisch falsch, grammatikalisch jedoch nicht zu beanstanden. Die ursprüngliche Äuÿerung

lautete: die sparte talk auf drei_sat ist ausgewählt .

3 Jedoch werden für bestimmte Bezugswörter enge Appositionen zugelassen. Es han-

delt sich um Nomen, die im Subkategorisierungslexikon registriert sind und auf die üblicherweise ein Eigenname oder eine Buchstaben-Zahlen-Kombination folgt: Der Film

Der_Untergang ,

Die Sendung Monitor , Die Abkürzung ABS , im Januar 2008 .

4

zu beantworten, ob es eine zulässige syntaktische Interpretation der

fehlerfreien Passagen gibt. Es ist also zum Beispiel irrelevant, worauf

sich ein bestimmtes Satzglied bezieht, solange wenigstens eine zulässige

Interpretation möglich ist. So erlaubt der Satz

sie beehlt ihm zu folgen

zwei verschiedene Interpretationen, die in der Schriftsprache durch Interpunktion unterscheidbar sind:

Sie beehlt, ihm zu folgen

Sie beehlt ihm, zu folgen

Der Parser bricht die Suche ab, sobald eine der beiden Interpretationen

gefunden wurde. Genauso verhält es sich bei fehlerhaften Eingaben, solange der Fehler mit der Ambiguität nicht in Verbindung steht. So ist,

wenn man im Beispiel Sie durch Nie ersetzt, die Diagnose (fehlendes Subjekt) unabhängig von der Interpretation des restlichen Satzes.

Diese Einschränkung hat zur Folge, dass der entstehende Syntaxbaum

nur bedingt durch eventuelle nachgeschaltete Schritte für das Sprachverstehen genutzt werden kann. Dazu müsste der Parser durch ein Bewertungsmodell erweitert werden, welches die aus Ambiguitäten resultierenden Alternativen hinsichtlich ihrer Plausibilität bewertet.

1.4 Besondere Schwierigkeiten

Aus der Problemstellung und aus der gesprochenen Sprache als Gegenstandsbereich ergeben sich einige Probleme:

•

An einem syntaktischen Konikt sind meist zwei Elemente beteiligt,

zum Beispiel im Falle von Inkongruenz. Der eigentliche Fehler, die akustische Verwechslung, kann sich deswegen auf beiden Seiten der Koniktrelation benden. Im Beispiel

wer nden den fehler

tritt zwischen dem niten Verb nden und dem Subjekt wer eine

Inkongruenz bezüglich Numerus auf. Hinter der Hypothese können die

folgenden beiden Äuÿerungen vermutet werden:

Wer ndet den Fehler?

Wir nden den Fehler.

5

Manchmal ist nur eines der beiden Elemente, die am Konikt beteiligt

sind, bekannt:

nden ihn

Der Konikt besteht zwischen dem Verb und dem fehlenden Subjekt,

welches allerdings nicht lokalisiert werden kann.

Im manchen Fällen kann der Konikt gar an einer anderen Stelle im

Satz auftreten als der Fehler:

er wird den Kuchen essen

Versteht der Dekoder in diesem Fall besser statt essen, so tritt ein

Konikt auf, weil das Satzglied den Kuchen dem Verb wird nicht

zugeordnet werden kann. Der Fehler liegt indes weder beim Verb noch

beim Satzglied, sondern beim vermeintlichen Prädikatsadjektiv.

•

Auch die Anzahl gefundener Konikte korreliert nicht zwingend mit

der Anzahl der Fehler. Mehrere Konikte können infolge eines einzigen

Fehlers entstanden sein. Ebenso können sich die Konsequenzen mehrerer Fehler überlappen oder gegenseitig kompensieren, so dass weniger

Konikte als Fehler auftreten.

Dies ist insbesondere dann problematisch, wenn die Anzahl der Konikte beim Parsing als Bewertungsfunktion benutzt wird, da die koniktärmste Lösung nicht immer die mit den wenigsten Fehlern darstellt.

•

Aufgrund des spontanen Charakters der gesprochenen Sprache und ihrer fehlenden Möglichkeiten zur nachträglichen Korrektur ist ein gewisses Maÿ an Ungrammatizität bei den tatsächlichen Äuÿerungen zu

erwarten und somit nach Möglichkeit auch bei den Hypothesen zu tolerieren. Die Unterscheidung, ob ein syntaktischer Konikt auf eine

akustische Verwechslung zurückzuführen ist oder auf eine unsaubere

Formulierung der Äuÿerung, scheint jedoch schwer zu treen zu sein.

•

Vom Menschen als ungrammatisch empfundene Sätze können manchmal doch als grammatisch klassiziert werden, wenn es eine syntaktische (wenn auch semantisch falsche) Interpretion gibt, die so abwegig

ist, dass man sie gar nicht erahnen würde. So könnte die Hypothese solange die sendung oder die uhrzeit das nicht eindeutig festgelegt kann

die aufnahme nicht starten vom Parser ähnlich interpretiert werden

wie Solange sie das nicht eindeutig unvorbereitet kann, die Aufnahme

(bitte) nicht starten!.

6

2

Grundlagen

2.1 Wort- und Satzhypothesen

Ein Spracherkenner (Dekoder ) analysiert das Sprachsignal und bildet eine

Menge von Hypothesen für Wörter. Die Worthypothesen lassen sich als Tripel (from,

to, token)

beschreiben, wobei

from

und

to

sich auf Anfang

und Ende des betreenden Signalausschnittes auf der Zeitachse beziehen

und

token

die symbolische Repräsentation des Wortes darstellt [11]. Un-

ter den Worthypothesen benden sich auch Hypothesen für Pausen, also für

Zwischenräume zwischen nicht verbunden ausgesprochenen Wörtern. Pausen

werden üblicherweise durch das Symbol

ε

gekennzeichnet.

Eine Satzhypothese besteht aus einer Kette von Worthypothesen, deren

Entsprechungen im akustischen Signal sich auf der Zeitachse nicht überlagern

und diese vollständig abdecken.

Die Bewertung der einzelnen Worthypothesen erfolgt anhand eines akustischen Ähnlichkeitsmaÿes. Dazu werden statistische Modelle für Wörter oder

Wortuntereinheiten, üblicherweise Hidden-Markov-Modelle (HMM), verwendet. Die Wahrscheinlichkeit, dass ein HMM die akustische Beobachtung erzeugt, ist das Ähnlichkeitsmaÿ. Die Wahrscheinlichkeit, dass eine bestimmte Worthypothese zutrit, ist aber nicht unabhängig vom Rest des Satzes.

Deswegen wird statistisches Wissen über N-Gramm-Häugkeiten mit einbezogen, um unwahrscheinliche Wort- oder Wortartfolgen abzuwerten (für eine

detaillierte Darstellung siehe [12]).

Als Schnittstelle zwischen Dekoder und Parser kann eine der folgenden

Strukturen dienen [11]:

1.

m

m

beste Ketten : Aus dem Worthypothesengraphen werden diejenigen

Satzhypothesen extrahiert, für die die höchste A-posteriori-Wahr-

scheinlichkeit errechnet wurde.

2. Isolierte Worthypothesen : Die Menge aller isolierten Worthypothesen

wird übergeben, ohne auf Abhängigkeiten, also Übergangswahrscheinlichkeiten, Bezug zu nehmen.

3. Vollständige Worthypothesengraphen : Sie enthalten neben den Worthypothesen auch alle Übergangswahrscheinlichkeiten.

Das in dieser Arbeit beschriebene Satzanalyseverfahren ist auf Eingaben der

Typen 1 und 2 ausgelegt.

7

2.2 Merkmalstrukturen

Grammatikalische Merkmale werden in der Linguistik üblicherweise gebündelt in Form von Merkmalstrukturen repräsentiert (siehe [5] für eine ausführliche Darstellung). Diese bestehen aus einer Menge von Attribut-WertPaaren. Die Werte können entweder Zeichenketten sein (atomare Merkmale )

oder selbst wieder Merkmalmengen (komplexe Merkmale ), so dass hierarchische Strukturen aufgebaut werden können.

dom(M ) einer Merkmalstruktur M bezeichnet die

Menge aller direkten Attribute von M .

Der Wert eines Attributes A ∈ dom(M ) kann über den Term M (A) referenziert werden. In der vereinfachten Schreibweise M (A B) = (M (A))(B) (mit

A als Attributname eines komplexen Merkmales) können beliebig lange PfaDer Denitionsbereich

de beschrieben werden, um hierarchische Merkmalstrukturen zu durchlaufen.

Merkmalstrukturen können Koreferenzen enthalten. Eine Koreferenz bindet

den Wert eines Attributes an den Wert eines anderen. Sie wird über eine

fortlaufende Nummer identiziert, die bei der Darstellung vor die entsprechenden Attributwerte geschrieben wird.

Die Darstellung von Merkmalstrukturen kann in Form von verschachtelten

Matrizen (vgl. Abb. 1), als gerichteter azyklischer Graph oder als Gleichungssystem erfolgen. Auf das Verfahren der Unikation, das zwei kompatible

Merkmalstrukturen zusammenfasst, sei an dieser Stelle nur am Rande hingewiesen (s. dazu [5]).

Denition 1

formal

M ≤N

Eine Merkmalstruktur M subsumiert eine Merkmalstruktur N,

genau dann, wenn

M ≡N

a)

M, N

b)

M, N komplex und ∀A ∈ dom(M ) : M (A) ≤ N (A) und

∀A, B ∈ dom(M ) : M (A) = M (B) → N (A) ≡ N (B),

wobei

=

atomar und

oder

die Identität zweier Werte (das heiÿt, es existiert eine Koreferenz)

bezeichnet und

≡

4

ihre Gleichheit .

Der Begri Subsumption bezieht sich semantisch nicht auf die Merkmalstrukturen selbst, sondern auf die durch sie repräsentierten Klassen:

N

genau dann, wenn alle durch

N

subsumiert

beschriebenen Objekte auch mit

tibel sind. Mit anderen Worten: Bei

von

M

N

M

kompa-

handelt es sich um eine Spezialisierung

M.

4 Soll die Subsumptionsbeziehung erhalten bleiben, auch wenn Werte geändert werden,

sind auch die beiden Vorkommen von

≡

durch

=

zu ersetzen. Technisch würde dies be-

deuten, dass die Attributwerte Zeiger auf dieselbe Speicherstelle darstellen.

8

[VP]

[ich schreibe]

category

text

[PRON]

[personal]

[ich]

category

pos_0

pos_1

form

(3)

type

text

kasus

form

numerus

(1)

person

(2)

[NOM]

[SG]

[1 ]

[VP]

[schreibe]

category

text

modus

form

modus

numerus

(3)

person

numerus

(1)

person

(2)

[INDIKATIV]

[SG]

[1 ]

[INDIKATIV]

[SG]

[1 ]

Abbildung 1: Komplexe Merkmalstruktur mit Koreferenzen (Matrixdarst.)

2.3 Grammatikmodelle

2.3.1 Variabilität der Wortstellung

Natürliche Sprachen unterscheiden sich unter anderem in Bezug darauf, wie

variabel die Wortstellung in Sätzen ist, das heiÿt, wie viele Möglichkeiten

es gibt, ein und denselben Sachverhalt durch sich nur in der Reihenfolge

der einzelnen Wörter unterscheidende Sätze auszudrücken. Sprachen können

die grammatikalischen Funktionen der Wörter nämlich entweder syntaktisch

über die Wortstellung markieren oder morphologisch durch Flexion. Flexionsarme Sprachen wie das Englische benötigen daher eine feste Wortstellung,

während exionsreiche Sprachen wie Russisch oder Latein in der Lage sind,

breite Variationsmöglichkeiten zuzulassen. Das Deutsche bendet sich etwa

in der Mitte einer solchen Skala [2], da hier einerseits die Stellung der meisten Satzglieder sehr variabel, andererseits aber die Position des Prädikates

streng reglementiert ist. Zum Beispiel kann der Satz

This man has read the novel

im Englischen nur auf diese eine Weise formuliert werden. Das Deutsche

dagegen erlaubt die beiden Varianten

9

Dieser Mann hat den Roman gelesen

Den Roman hat dieser Mann gelesen

Aufgrund der im Deutschen ausgeprägten Flexion ist im zweiten Fall eine

Zuordnung der grammatikalischen Funktionen Subjekt und Objekt weiterhin

5

problemlos möglich , während im Englischen der transformierte Satz

The novel has read this man

jene alleine aufgrund der Positionen vertauscht. Weiterhin ist im Englischen

die Position des gesamten Prädikates streng festgelegt, während im Deutschen dessen zweiter Teil auch vorgezogen werden kann, was zu den weiteren

Varianten

Gelesen hat dieser Mann den Roman

Gelesen hat den Roman dieser Mann

Den Roman gelesen hat dieser Mann

führt. In Sprachen mit noch höherer Variabilität kann in der Regel darüber

hinaus zum Beispiel auch der erste Prädikatsteil (die Entsprechung von hat)

am Satzanfang oder -ende stehen.

2.3.2 Phrasenstrukturgrammatiken

Sprachen mit fester Wortstellung lassen sich mit denselben Mitteln verarbeiten wie formale Sprachen, was den Erfolg von PhrasenstrukturgrammatikModellen (PSG) beim Parsen englischer Sätze erklärt [2]. Jene werden in

der maschinellen Sprachverarbeitung in der Regel mit Hilfe kontextfreier

6

(Chomsky-Typ-2)-Grammatiken implementiert. PSG interpretieren die Eingabesätze (Wörter im Sinne der formalen Sprachen) als Hintereinanderreihung von Phrasen (nichtterminale Symbole), welche sich aus aneinandergereihten Konstituenten zusammensetzen, wobei die erlaubten Zusammensetzungen durch Produktionsregeln beschrieben sind. Die einzelnen Konstituenten lassen sich wiederum als Phrasen betrachten und in Konstituenten

zerlegen, bis man zu den einzelnen Wörtern (terminale Symbole) gelangt.

So entsteht ein Syntaxbaum, der den hierarchischen Aufbau des Satzes und

dessen grammatikalischer Bestandteile abbildet.

5 Bei Wortformen wie Neutrum oder Plural, wo die Flexion nicht zwischen Subjekt und

Objekt unterscheidet, führt die Flexibilität der Wortstellung zu Ambiguitäten: Bei Das

Buch hat das Kind gelesen

muss die Semantik hinzugezogen werden, um die Funktio-

nen identizieren zu können. Gibt auch die Semantik keinen Aufschluss, wird zu fester

Wortstellung übergegangen, bei der die Standardreihenfolge Subjekt-vor-Objekt vorgeschrieben ist: Romeo küsst Julia.

6 Zur Theorie formaler Sprachen siehe [6].

10

G = ({S , NP , VP , DP , N , V , DET },

{die, hunde, männer, lügen, bellen},

P, S)

P = {S →

S

→

VP

→

DP

→

NP

→

DET

→

N

→

V

→

,

VP ,

NP VP

DP

V

,

DET NP

N

,

,

die,

|

|

lügen

lügen

hunde

|

männer,

bellen,

Abbildung 2: Ein sehr einfaches Beispiel für eine PSG

Auf der untersten nichtterminalen Ebene entsprechen die Symbole den

Wortarten. Neben der Wortart werden für das Parsing aber auch Informationen über die grammatikalische Kategorisierung der Wortform benötigt,

welche zuvor mittels morphologischer Analyse ermittelt in den jeweiligen Knoten des Syntaxbaumes in Form von Merkmalstrukturen gespeichert

werden können. Die Anwendbarkeit der einzelnen Produktionsregeln unterliegt zum Teil bestimmten Kongruenzbedingungen, das heiÿt, für verschiedene Symbole auf ihrer rechten Seite müssen bestimmte Merkmale übereinstimmen. So müssen bei der Bildung von Nominalphrasen Artikel und

Adjektive mit dem Nomen in den Merkmalen Numerus, Kasus und Genus

übereinstimmen. Beim Parsing können die Kongruenz durch Unikation der

Merkmalstrukturen überprüft und die Merkmale auf die nächsthöhere Ebene

propagiert werden.

7

Parser lösen also das Wortproblem

für kontextfreie Sprachen unter Be-

rücksichtigung spezieller Kongruenzbedingungen und erstellen dabei einen

Syntaxbaum.

In vielen anderen Sprachen stoÿen PSG jedoch an ihre Grenzen. Probleme

entstehen zum einen durch variable Wortstellung, ein Phänomen, das vor al-

7 Der Begri bezieht sich auf Wörter im Sinne der formalen Sprachen, also den kompletten natürlichsprachlichen Satz.

11

lem in der maschinellen Sprachverarbeitung gewöhnlich auch als Scrambling

bezeichnet wird. Dieser Begri resultiert aus einem umstrittenen Syntaxmodell, nach dem es zu jedem semantischen Sachverhalt (mit vorgegebenen

Wörtern) genau eine fest vorgegebene Linearisierung gibt und alle anderen

Satzbauvarianten aus dieser Standardreihenfolge mittels Durcheinanderwürfeln der Satzglieder entstehen, wobei die zulässigen Modikationen durch

Transformationsregeln beschrieben werden [1]. Abgesehen von der erkenntnistheoretischen Inadäquatheit (es ist kaum vorstellbar, dass die Satzsynthese

im menschlichen Gehirn auf diese Weise abläuft) ergibt sich ein praktisches

Problem bei der Umsetzung dieses Modelles: Es mag zwar für die Satzsynthese einen akzeptablen Workaround bieten, doch für das Parsing müssten die

Transformationsregeln invers angewandt werden, denn es liegt ja nur das Ergebnis des Scramblings vor und nicht der Ausgangssatz [2]. Darüber hinaus

könnte man argumentieren, dass es keinen Sinn ergibt, eine Unterscheidung

zwischen ursprünglichen und transformierten Sätzen herbeizuführen [1].

Doch nicht nur die variable Reihenfolge der Konstituenten bereitet bei

der Verwendung von PSG Schwierigkeiten, sondern auch das Phänomen der

diskontinuierlichen Konstituenten [2]. Dabei handelt es sich um syntaktische

Einheiten, deren Bestandteile nicht aneinandergereiht sind, sondern an verschiedenen Stellen im Satz erscheinen:

8

Das Buch hat niemand diesem Mann versprochen zu lesen .

In diesem Beispiel bildet Das Buch zu lesen eine Verbalphrase. Der Versuch,

für diesen Satz einen PSG-Ableitungsbaum zu erstellen, scheitert daran, dass

sich Kanten überschneiden müssten, was bei PSG nicht möglich ist [1].

Der Grund dafür, dass die betroenen Zweige nicht neu ausgerichtet werden können, um die Überlappungen zu lösen, liegt darin, dass bei PSG die

Anordnung der Knoten des Ableitungsbaumes untrennbar mit der Oberächentopologie des Satzes verknüpft ist. Die Topologie beeinusst jedoch nicht

die grundlegende Semantik des Satzes, sondern spiegelt lediglich phonologische Aspekte [1] wie Akzentuierung und Ähnliches wider. Die Semantik

dagegen ist hauptsächlich in den grammatikalischen Beziehungen der Wörter zueinander zu nden [1]. Es liegt also nahe, Semantik und Topologie

zu trennen, indem man ein Grammatikmodell ndet, welches ausschlieÿlich

diese Beziehungen analysiert, und dieses durch ein Topologiemodell ergänzt,

welches sicherstellt, dass es sich bei der konkreten Implementation der semantischen Struktur um eine wohlgeformte Äuÿerung handelt.

8 Aus [1].

12

2.3.3 Dependenzgrammatiken

Dieser Gedanke leitet über zu einer völlig anderen Grammatikkonzeption,

deren Ansatz bereits seit Jahrhunderten bekannt ist und die von [3] (Tesnière 1959) begründet wurde: Die Dependenzgrammatik (DPG). Sie geht davon

aus, dass sich die semantische Struktur eines Satzes durch eine Menge von

Dependenzen darstellen lässt. Unter Dependenz versteht man eine Relation

zwischen zwei Wörtern, die die Abhängigkeit zwischen dem übergeordneten

Wort, dem Regens, und dem untergeordneten Wort, dem Dependens dokumentiert. Da es sich dabei um eine antisymmetrische, nichtreexive Relation

handelt, lässt sich die Menge aller Dependenzen, die in einem Satz bestehen, als gerichteter Graph darstellen. Jedes Regens ist allen seinen direkten

und indirekten Dependenten syntaktisch stets übergeordnet, deswegen ist der

Graph azyklisch. Zusammen mit folgender Annahme ergibt sich eine Baumstruktur, der Dependenzbaum :

Annahme 3

In einem Satz füllt jedes Wort genau eine grammatikalische

Funktion aus.

Als Konsequenz dieser Annahme besitzt also jedes Wort genau ein Regens,

bis auf eines, das die grammatikalische Funktion des absoluten Regens einnimmt, als solches von keinem anderen Wort regiert wird und deswegen die

Wurzel des Dependenzbaumes bildet. Dabei handelt es sich um das rang-

9

höchste Wort des Prädikates, üblicherweise das nite Verb .

Im Gegensatz zu PSG sind die Kanten nicht als Teil-Ganzes-Beziehung,

sondern als semantische Subkategorisierung zu interpretieren. Während in

PSG jede komplexe Phrase aus zwei oder mehr Konstituenten besteht, die

sich auf demselbem Niveau benden, besitzt in DPG jede Phrase ein einzelnes Wort als Repräsentanten, das alle anderen Wörter in der Phrase direkt

oder indirekt regiert. So werden zum Beispiel Nominalphrasen wie der sehr

groÿe Baum durch das Nomen ( Baum) repräsentiert, dem die zugehörigen

Adjektive ( groÿe) und Artikel ( der ) als Dependenten untergeordnet sind,

wobei das Adverb sehr wiederum dem Adjektiv als Dependens untersteht.

Dependenzgrammatiken stellen also ein weitaus mächtigeres Werkzeug

zur Modellierung natürlicher Sprachen dar als PSG. Insbesondere beim Parsen ergeben sich allerdings einige neue Schwierigkeiten:

9 Man könnte aber zum Beispiel in Hilfsverbkonstruktionen auch das Vollverb als dem

Hilfsverb übergeordnet betrachten, da es die eigentliche Grundaussage des Prädikates enthält, die durch das Hilfsverb lediglich in bestimmten grammatikalischen Kategorien (Tempus, Modus, Genus verbi) moduliert wird. Ebenso obliegt es der Denition der jeweiligen

Dependenzgrammatik, ob in Adverbialsätzen die einleitende Subjunktion dem niten Verb

über- oder untergeordnet ist.

13

1. Prinzipiell kann jedes Wort mit jedem in Beziehung stehen, im Gegensatz zu PSG, wo immer nur benachbarte Chunks in Betracht gezogen

werden. Deswegen expandiert die Suche bei DPG wesentlich mehr in

die Breite, weshalb eine deutlich höhere Komplexität des Algorithmus

zu erwarten ist als bei PSG-Parsern. Eine weitere Folge ist, dass tendenziell viel mehr Lösungen existieren als bei PSG. Dem Vorhandensein

eines adäquaten Bewertungssystemes, das die Auswahl der besten Alternative forciert, kommt daher eine groÿe Bedeutung zu.

2. Dependenzgrammatiken enthalten keine Aussagen zur Wortstellung,

lassen also von sich aus jede beliebige Reihenfolge zu. Um die daraus resultierende, viel zu weit gefasste Sprache einzugrenzen, ist die

Kombination mit einem Topologiemodell erforderlich, das unzulässige

Linearisierungen des Dependenzbaumes im Nachhinein oder besser bereits während dessen Aufbaus ausschlieÿt. Da für die Auösung von

Ambiguitäten auch die Topologie relevant ist, kann ein solches Modell

auch hierzu herangezogen werden, falls es in der Lage ist, gewichtete

Aussagen zu treen.

3. Dependenzgrammatiken lassen grundsätzlich keine Koordinationen zu,

da nur binäre Dependenzrelationen erlaubt sind:

Der Vogel fängt und frisst den Wurm.

4. Die Unterscheidung zwischen Komplementen und Supplementen (Erklärung siehe S.15) fällt nicht immer leicht, da teilweise ieÿende Übergänge vorhanden sind.

Die Anzahl und Art der Dependenten, die ein bestimmtes Wort benötigt,

hängt nur zum Teil von seiner Wortart ab. Vielmehr existieren in dieser Hinsicht insbesondere bei Verben gravierende Unterschiede von Wort zu Wort

und sogar von Lesart zu Lesart. Diese Informationen müssen dem Dependenzparser mittels eines Valenz- oder Subkategorisierungslexikons zur Verfügung

gestellt werden.

Denition 2

w

10

Die Valenz

v(r) ∈ IN einer Lesart r ∈ R(w) eines Wortes

w in der Lesart r regieren muss, damit der

gibt an, wieviele Dependenten

10 Der Begri Valenz stammt aus der Valenztheorie, nach der Verben eine bestimmte

Anzahl von Satzgliedern an sich binden, nach dem Vorbild der Atome in der Chemie.

Er bezieht sich ursprünglich ausschlieÿlich auf Verben, wird hier aber auf alle Wortarten

erweitert.

14

Satz grammatikalisch vollständig ist

Denition 3

Valenzstelle

11

. Man sagt auch,

Der zugehörige Valenzrahmen

si = (M, g), 0 ≤ i < v(r),

w

sei

v(r)-stellig.

V (r) = {si } speziziert für jede

die erforderliche Beschaenheit des

Dependens Einschränkungen bezüglich Wortart, Lemma und grammatikalischen Kategorien sowie Kongruenzbedingungen sind in der Merkmalstruktur

M

angegeben und seine grammatikalische Funktion

g.

Beispiele:

•

Das Verb geben in der üblichen, nicht übertragenen Lesart ist dreistellig, denn es benötigt neben dem Subjekt ein Objekt, das im Akkusativ

steht, und ein indirektes Objekt, das im Dativ steht: Er gibt ihr das

Buch. Keine der drei Valenzstellen kann unbesetzt bleiben.

•

Regnen ist ein nullstelliges Verb. Allerdings ist im Deutschen bei

fehlendem Subjekt stets ein Expletivum es zu ergänzen: Es regnet.

•

Das Verb erschrecken besitzt zwei Lesarten mit unterschiedlicher Valenz: In der intransitiven Variante ist es einstellig, weil nur ein Subjekt

erforderlich ist: Ich erschrecke. Dagegen fordert die transitive Lesart

zusätzlich ein Akkusativobjekt: Ich erschrecke ihn.

Neben den obligatorischen Komplementen, das heiÿt den Ergänzungen, die

durch den Valenzrahmen gefordert werden, können die meisten Wörter zusätzlich optionale Supplemente, das heiÿt freie Angaben wie zum Beispiel

Präpositionalobjekte, regieren. Diese sind häug wortartspezisch und können mehrfach besetzbar sein oder nicht.

Für die vorliegende Arbeit wurde ein Parser entwickelt, dem eine Dependenzgrammatik zugrunde liegt. Diese bietet gröÿere Chancen, den Anforderungen der gesprochenen Sprache und der Fehlertoleranz gerecht zu werden.

2.4 Chart-Parsing

Beim Parsing ist es aus Ezienzgründen erstrebenswert, bereits aufgebaute Teilanalysen wiederzuverwerten (nach [4], auch im Folgenden). Dies kann

beim PSG-Parsing dadurch erreicht werden, indem alle Teilanalysen in einer

sogenannten Chart abgelegt werden. Dabei handelt es sich um einen gerichteten Graphen. Seine Knoten entsprechen den Übergängen zwischen den einzelnen Wörtern, unterliegen also einer totalen Ordnung entsprechend deren

11 Die Valenz bezieht sich bei Verben auf deren kanonische Form Indikativ Aktiv. Liegt

das Verb in einer anderen Verbform vor, kann es zur Valenzalternation kommen (s. Abschnitt 3.2.12).

15

Position auf der Zeitachse. Die Kanten repräsentieren Teilanalysen, umspannen also einzelne Wörter oder ganze Phrasen. Hierbei muss unterschieden

werden zwischen inaktiven Kanten, welche abgeschlossenen Teilanalysen entsprechen, und aktiven Kanten, welche anzeigen, dass eine Regel nur teilweise

angewandt wurde.

Im Verlauf des Parsings werden neue Kanten erzeugt, indem bestehende

gemäÿ den Grammatikregeln verbunden werden. Entsteht eine inaktive Kante, die den gesamten Satz umspannt, so hat man eine Satzanalyse gefunden.

Um am Ende den Syntaxbaum aufbauen zu können, muss für jede Kante die

Information gespeichert werden, aus welchen Kanten sie zusammengesetzt

wurde.

12

Ein typischer Algorithmus für Bottom-Up-Chart-Parsing

lautet wie folgt:

1. Immer, wenn eine inaktive Kante entsteht, werden an ihrem Ausgangsknoten für jede Regel, bei der der Beginn der rechten Seite mit der

Kante übereinstimmt, aktive Kanten mit der Länge null eingefügt.

2. Die Chart wird initialisiert, indem in jedem Knoten für jede Wortform,

die das dort beginnende Wort ausbildet, eine inaktive Kante der Länge

eins erzeugt wird.

3. Danach durchläuft der Algorithmus iterativ von rechts nach links alle

aktiven Kanten und prüft, ob sie gemäÿ der jeweils zugewiesenen Regel

durch eine inaktive verlängert werden können. Gelingt dies, wird die

Verlängerung durchgeführt und in der Kante vermerkt, welcher Teil

der Regel bereits erfüllt ist. Ist die Regel vollständig erfüllt, wird die

Kante inaktiviert (und wie oben beschrieben entsprechende neue aktive

Kanten eingefügt).

Der beschriebene Algorithmus verfährt nach einem ähnlichen Prinzip wie

der CYK-Algorithmus

13

für kontextfreie Sprachen mit dem Unterschied,

dass die Produktionsregeln nicht in Chomsky Normalform

14

transformiert

werden müssen. Die initialen inaktiven Kanten entsprechen den terminalen

Symbolen kontextfreier Grammatiken, die später erzeugten inaktiven Kanten

den nichtterminalen. Aktive Kanten entsprechen der linken Seite von Regeln,

die (noch) nicht komplett abgearbeitet wurden.

Eine spezielle Art von Chart-Parser stellen sogenannte Chunk-Parser dar.

Sie berücksichtigen nur Regeln, die zum Aufbau von Chunks (also einfachen Nominalphrasen, Präpositionalphrasen etc.) führen und keine, die diese

12 Bottom-Up ist die verbreitetste Strategie für das Chart-Parsing, es sind aber auch

Top-Down-Strategien möglich.

13 Zum CYK-Algorithmus siehe [6] S. 64.

14 Zur Chomsky Normalform siehe [6] S. 52.

16

Chunks zu übergeordneten Phrasen (zum Beispiel komplexen Verbalphrasen)

oder ganzen Sätzen verbinden. Das Parsing wird also abgebrochen, sobald eine bestimmte Ebene im Syntaxbaum erreicht ist

15

.

Der Algorithmus lässt sich leicht modiziert auch dann anwenden, wenn

die Eingabe nicht in Form einer einzelnen Satzhypothese, sondern als Menge

von Worthypothesen vorliegt. In diesem Falle muss beim Initialisieren der

Chart (Schritt 2) berücksichtigt werden, dass die einzelnen Worthypothesen

unterschiedliche Längen besitzen können. Die initialen inaktiven Kanten können also bereits mehrere Knoten überspannen. Des weiteren muss durch den

Algorithmus oder durch die Grammatikregeln dem Fakt Rechnung getragen

werden, dass Phrasen auch Pausen enthalten können.

Denition 4

Ein

Chunk,

(li , ri , ti ), . . . , (lj , rj , tj )

der

sich

zusammensetzt,

aus

kann

Schreibweise (vgl. S. 7) als Chunkhypothese

den

in

Worthypothesen

Anlehnung

ck = (li , rj , ti . . . tj )

an

16

deren

geschrie-

ben werden. Der Chunkhypothese kann eine Merkmalstruktur zugeordnet

werden,

die

sich

gemäÿ

den

Grammatikregeln

aus

der

Unikation

der

Merkmalstrukturen der Bestandteile ergibt.

2.5 Kombinationen von Dependenz und Phrasenstrukturparsern

Das Phänomen diskontinuierlicher Konstituenten wurde auf S. 12 als eines

der Hauptargumente für die im Vergleich zum PSG-Parsing aufwändigere

Dependenzanalyse angeführt. Die meisten nichtverbalen Konstituenten in

Sätzen sind jedoch zusammenhängend und können somit von ezienteren

PSG-Parsern identiziert werden. Daher hat es sich bewährt, eine Kombination aus DPG und PSG zu verwenden. Dabei werden in einer ersten Phase

mit Hilfe eines Chunk-Parsers mögliche Konstituenten (Chunks ) vorgeschlagen, auf die in einer zweiten Phase bei der Dependenzanalyse zurückgegrien

werden kann. In [4] wird hierfür der Begri Two-Phase-Parsing verwendet.

Es gibt zwei Möglichkeiten, wie die beiden Teile ineinander greifen können:

1. Syntaxbaumtransformation: Alle Syntaxbäume nichtatomarer Chunks

werden während ihres Aufbaus oder nach Ablauf der ersten Phase durch

ein geeignetes Verfahren in Dependenzbäume übersetzt. Immer wenn

15 Beziehungsweise wird der Prozess erst auf einer Ebene unterhalb der Wurzel gestartet,

falls top down geparst werden soll.

16 Liegt eine einzelne Satzhypothese vor, können deren Wörter ebenfalls als Worthypo-

thesen geschrieben werden, wobei

to + 1

und

token

from

die Anzahl der voranstehenden Wörter,

das Wort ist.

17

from =

der Dependenzparser in der zweiten Phase eine Dependenz mit einem

Wort

w

als Dependens bildet, das in derselben Wortform als absolutes

Regens einer dieser Teilanalysen fungiert, können alle Dependenzen aus

der betreenden Teilanalyse übernommen werden, das heiÿt, die Teilanalyse kann im Dependenzbaum an den Knoten

w anmontiert werden.

Kommen mehrere Teilanalysen in Frage, so entsteht eine Verzweigung

des Suchbaumes, ähnlich wie wenn das Wort

w

Valenz 1 hätte und als

Dependens mehrere Alternativen möglich wären. Enthält eine Teilanalyse eine Dependenz, deren Dependens bereits anderweitig eingeordnet wurde, darf sie allerdings nicht verwendet werden, um Annahme 3

(S. 13) nicht zu verletzen.

2. Domänenerweiterung: Die Dependenzrelation wird dahingehend umdeniert, dass sie nicht auf der Menge der einzelnen Wörter angewandt

wird, sondern auf der Menge

17

formen enthält

C

der Chunks (die die Menge der Wort-

). Dependenzen bestehen also nicht zwischen Wör-

tern (denen dabei eine Wortform zugeordnet wird), sondern zwischen

Chunks, die aus (einer einzelnen oder mehreren) Wortformen gebildet

werden. Dafür müssen die Beschreibungen der Valenzstellen so umgeschrieben werden, dass für deren Besetzung auch bestimmte Phrasen

erlaubt sind. Die Menge der Wortarten wird also um die Menge der

komplexen Phrasentypen erweitert. So können zum Beispiel nicht nur

Nomen das Objekt zu einem Verb bilden, sondern auch Nominalphrasen.

Satz 1

Aus Annahme 3 folgt für die Domänenerweiterung:

(a) Da auch die einzelnen Wörter innerhalb der Chunks nur jeweils

eine grammatikalische Funktion ausfüllen können und parallel verlaufende Worthypothesen und Wortformen sich gegenseitig ausschlieÿen, darf jede Lösung nur Chunks enthalten, die sich gegenseitig zeitlich nicht überschneiden.

(b) Das Kriterium für eine abgeschlossene Satzanalyse, dass alle grammatikalischen Funktionen identiziert sind, ist genau dann erfüllt,

wenn die für den Dependenzbaum verwendeten Chunks die Äuÿerung auf der Zeitachse bis auf durch Hypothesen erlaubte Pausen

vollständig abdecken.

Die nichtatomaren Chunks dienen lediglich als Abkürzungen für bestimmte Suchpfade, substituieren also keineswegs ganze Zweige des Suchbaumes.

17 Der Chunk-Parser initialisiert seine Chart nämlich mit inaktiven Kanten über die

einzelnen Wortformen, siehe S. 16.

18

Führt die Verwendung eines solchen nicht zur gewünschten Lösung, müssen

demnach trotzdem Alternativpfade expandiert werden, die den Konstituenten mittels Dependenzanalyse aufbauen. Dies gilt erst recht, wenn eine vollständige Suche durchgeführt werden soll, die alle möglichen Lösungen ndet

in diesem Falle bringt die Kombination mit einem Chunk-Parser weniger

Ezienzgewinn. Bei einer unvollständigen Suche liefert das Vorhandensein

eines nichtatomaren Chunks allerdings eine wertvolle Heuristik: Da davon

ausgegangen werden kann, dass in deutschen Sätzen nichtverbale Konstituenten wesentlich häuger zusammenhängend als diskontinuierlich sind, leitet

ein nichtatomarer Chunk den Parser statistisch gesehen häuger zur gesuchten Lösung als eine atomare Alternative.

Satz 2

Werden nichtatomare Chunks gegenüber Einzelwörtern bevorzugt be-

handelt, kann deshalb die durchschnittliche Komplexität des Suchalgorithmus

deutlich verringert werden.

In dieser Arbeit wurde die Variante mit Domänenerweiterung implementiert. Deren Nachteil, dass der resultierende Dependenzbaum keine vollständige Analyse des Satzes wiedergibt einige zusammenhängende Knotenmengen sind ja durch Chunks substituiert , ist nur vorübergehender Natur,

da bei Bedarf im Nachhinein die Syntaxbäume aller verwendeten Chunks

in Dependenzbäume konvertiert und an die entsprechenden Stellen in den

Baum eingesetzt werden können. Die implementierte Dependenzgrammatik

verwendet für die nichtverbalen Konstituenten ausschlieÿlich die in Form von

Chunks bereitgestellten Teilanalysen. Dies hat zur Folge, dass der Parser in

der vorliegenden Form nur Nominal- und Präpositionalphrasen in Betracht

zieht, die vom verwendeten Chunk-Parser gefunden werden. Die Dependenzgrammatik ist allerdings erweiterbar, um zukünftig auch diese Konstituententypen mittels Dependenzanalyse aufbauen zu können.

2.6 Grundlegende Topologie deutscher Sätze

Die Topologie ist im Deutschen entscheidend durch die Stellung des Verbalkomplexes geprägt. Vorherrschend in der Linguistik ist die Theorie der

topologischen Felder. Hierbei formt im Allgemeinen das Prädikat des Satzes

eine Klammerstruktur, die den Satz in fünf Felder teilt:

Ich

habe

Sie leider nicht

verstanden

vorhin.

VORFELD

LINKE

MITTELFELD

RECHTE

NACHFELD

KLAMMER

(VF)

(LK)

KLAMMER

(MF)

19

(RK)

(NF)

Während die Reihenfolge der übrigen Satzglieder in den drei Stellungsfeldern

VF, MF und NF sehr frei ist und nur in speziellen Fällen Einschränkungen

unterliegt sonst existieren nur Präferenzen , ist die Besetzung der beiden

Klammerteile streng festgelegt und nur von der Verbstellung, das heiÿt von

der Position des niten Verbes im Satz, abhängig. Hierfür gibt drei Möglichkeiten:

•

Verb-Zweit-Stellung (VZ) : Sie ist die typische Verbstellung für Haupt-

sätze. Das nite Verb folgt nach dem ersten Satzglied und bildet alleine

die linke Klammer. Der Rest der Prädikates steht in der rechten Klammer und somit oft ganz am Ende des Satzes. Das Vorfeld muss durch ein

Satzglied besetzt sein, notfalls durch ein Expletivum: Es stimmt (, dass

es regnet)

•

18

.

Verb-Erst-Stellung (VE) : Hier bendet sich das nite Verb ebenfalls

alleine in der linken Klammer, allerdings vor dem ersten Satzglied und

somit häug wenn auch nicht zwingenderweise am Satzanfang. VE

ist typisch für Entscheidungsfragen. Der einzige topologisch relevante

Unterschied zu VZ besteht darin, dass das Vorfeld unbesetzt sein darf

•

19

.

Verb-Letzt-Stellung (VL) : Sie gilt in Sätzen (typischerweise Nebensät-

20

ze

), die entweder durch eine Subjunktion oder ein Relativpronomen

eingeleitet werden, und in abhängigen Fragesätzen. Während das einleitende Satzglied die linke Klammer bildet, steht das nite Verb am

Ende der rechten Klammer, also direkt nach dem Rest des Prädikates.

Das Vorfeld entfällt, sofern es nicht durch eine Satzkonjunktion gebildet

wird ( Und weil ...). Vertritt man die restriktive Position, dass nichtprädikative Satzglieder in den beiden Klammerteilen nicht erlaubt sind,

kann man die linke Klammer als eine Art Verschmelzung des Vorfeldes

mit der linken Klammer interpretieren.

In bestimmten Fällen ist die Verbstellung schwierig zu erkennen. Dann kann

eine gedankliche Ergänzung um weitere Satzglieder helfen. So herrscht zum

Beispiel im Fragesatz

18 Der Nebensatz übernimmt hier die Funktion des Subjekts. Als solches kann er auch

ins Vorfeld vorgezogen werden, wodurch das Expletivum entfällt: Dass es regnet, stimmt .

19 VE wird häug auch mit dem Begri Inversion umschrieben. Die zugrundeliegende

Sichtweise supponiert für Hauptsätze einen Standardsatzbauplan Subjekt-Verb-Objekt wie

im Englischen, und betrachtet VE daher als Vertauschung von Subjekt und nitem Verb.

20 Es gibt jedoch auch Fälle, in denen VL in Hauptsätzen möglich ist, z.B. in Exklama-

tivsätzen Wie lange das (heute doch wieder) dauert! oder deliberativen Fragesätzen:

Ob heute (wohl) ein guter Krimi läuft? .

20

Wer klingelt (an der Tür)?

VZ, während der gleichlautende Relativsatz

Wer (an der Tür) klingelt (, der will hinein).

VL aufweist. Verwechslungen kann es auch zwischen VE und VZ geben, wenn

einem VE-Satz Wörter im Vorfeld vorgeschaltet sind, die nicht satzgliedwertig und somit nicht vorfeldfüllend sind: Aber willst du das auch? . Dagegen

ist jedoch in Erstposition vorfeldfüllend, weshalb dem Satz Jedoch willst

du das auch VZ zuzuordnen ist

21

.

Auf der anderen Seite kann VZ leicht mit VE verwechselt werden, wenn

ein voranstehender Gliedsatz die Funktion des vorfeldfüllenden Satzgliedes

übernimmt:

(Dass Folgendes ein VZ-Satz ist,) ist schwierig zu erkennen

oder dieses in elliptischen Sätzen ganz weggelassen wird:

Er sieht das Meer. (Er) Zögert einen Moment. Und (er) beginnt dann zu

rennen.

21 Es sei denn, es handelt sich um zwei getrennte satzwertige Äuÿerungen, deren Grenze

durch ein geeignetes Satzzeichen zu markieren ist: Jedoch (frage ich dich): Willst du das

auch? 21

3

Ein Verfahren zur Fehleranalyse in Spracherkennerhypothesen

Im Folgenden wird das im Rahmen dieser Arbeit entwickelte Verfahren vorgestellt. Im ersten Teil dieses Kapitels werden die verwendeten Modelle, Algorithmen und Datenstrukturen theoretisch beschrieben, im zweiten Teil folgt

ein Auszug aus den konkreten Grammatik- und Topologieregeln, die für die

Implementierung verwendet werden.

3.1 Das Verfahren im Detail

3.1.1 Architektur des Systems

Das gesamte System besteht aus mehreren Modulen. Eine zentrale Kontrolleinheit steuert den Aufruf des Dekoders und der Parsermodule, analysiert

die Konikte und entscheidet über das weitere Vorgehen.

Zuerst lässt das Kontrollmodul die Äuÿerung von einem Dekoder analysieren und nimmt dessen Ausgabe entgegen, die in einer Liste der

n

besten

Satzhypothesen oder alternativ in einer Menge von Worthypothesen

vi

be-

steht. Im ersten Fall wird aus der besten Satzhypothese eine Worthypothesenmenge erzeugt, die keine Wortalternativen beinhaltet

einzelnen Wörter

w

22

. Dazu werden die

p im Satz durchnummevi = (p, p + 1, w) generiert.

aufsteigend nach ihrer Position

riert und für jedes von ihnen eine Worthypothese

Die Zeitangaben sind also relativ und verzerren die tatsächlichen Verhältnisse

auf der Zeitachse.

Jedes

vi

wird nun einer morphologischen Analyse unterzogen, mit deren

j

j

j

Hilfe alle jeweils möglichen Wortformen ui = (pi , pi +1, wi , si , Mi ) von vi ausj

j

ndig gemacht werden, wobei si die Wortart und Mi eine Merkmalstruktur

mit Informationen über grammatikalische Kategorien beschreibt. Die Menge

aller Wortformhypothesen wird nun an einen Chunk-Parser übergeben, der

aus ihnen mögliche Chunkhypothesen

ck = (pk , qk , tk )

bildet. Jedem

ck

ist

eine Chunkkategorie zugeordnet sowie eine Merkmalstruktur, die aus Unikation der Merkmalstrukturen der beteiligten Wortformen entsteht.

22 Die Analyse der

n

Hypothesen erfolgt sequentiell, da Wörter aus unterschiedlichen

Satzhypothesen zeitlich nicht verglichen werden können. Kann jedoch ein Verfahren dafür

gefunden werden zum Beispiel mit Hilfe der Methode der dynamischen Programmierung , könnte die Menge der Worthypothesen über alle Satzhypothesen erzeugt werden.

Diese hätte zwar quantitative Nachteile gegenüber der vollständigen Worthypothesenmenge des Dekoders. Jedoch ist anzunehmen, dass jede Hypothese in weiten Teilen die Äuÿerung korrekt wiedergibt. Somit wäre die Wahrscheinlichkeit hoch, dass eine so reduziert

rekonstruierte Worthypothesenmenge die richtige Lösung enthält, jedoch ezienter zu parsen ist als die ursprüngliche.

22

Im nächsten Schritt wird dem Dependenzparser die Menge der Chunkhypothesen übergeben. Er greift auf ein Topologiemodul und ein Dependenzmodul zurück, um sicherzustellen, dass alle Teilanalysen mit dem Topologiebeziehungsweise Dependenzmodell kompatibel sind. Diese Module stellen Regeln zur Verfügung sowie Mechanismen, die deren Einhaltung überprüfen.

Die Regeln und lexikalischen Daten werden einmalig aus Dateien eingelesen. Die Initialisierung der Module geschieht somit am besten vor der ersten

Spracheingabe. Die Daten können im Speicher behalten werden, damit sie für

nachfolgende Hypothesen oder Äuÿerungen nicht erneut eingelesen werden

müssen.

Der Parser liefert eine oder mehrere mögliche Analysen des Satzes, bewertet diese und liefert gegebenenfalls für jeden aufgetretenen Konikt Informationen über den Konikttyp und die Koniktmenge der beteiligten Wörter.

Sind die Interpretationen koniktfrei, wird die bestbewertete übernommen.

Andernfalls wird im Falle getrennter Satzhypothesen das gesamte Verfahren auf die nächste solche angewandt, bis auch die

n-te

Satzhypothese als

ungrammatisch bewertet wurde.

Wird keine fehlerfreie Lösung gefunden, kann eine Fehleranalyse

23

in Be-

tracht gezogen werden. Sie besteht darin, anhand der aufgetretenen Konikte

den mutmaÿlichen Fehler zu lokalisieren. Hierfür liefert diese Arbeit in Abschnitt 3.1.8 einige Anregungen, ein konkretes Fehlermodell konnte jedoch

im zeitlichen Rahmen dieser Arbeit nicht entwickelt werden.

Kann der Fehler lokalisiert werden, wird entschieden, ob eine gezielte

Nachfrage an den Benutzer gestellt wird oder ob sogar der Versuch erfolgen kann, den Fehler aufzulösen, indem zum Beispiel ein überschüssiges und

mutmaÿlich in der Äuÿerung nicht enthaltenes Wort gestrichen wird. Ist keine eindeutige Lokalisierung möglich, wird der Benutzer um eine Neueingabe

oder Umformulierung gebeten.

3.1.2 Modellierung topologischer Strukturen

Das im Rahmen dieser Arbeit erstellte Topologiemodell implementiert die

Theorie topologischer Felder sowie die in [1] vorgestellte Idee einer hierarchischen Untergliederung der Felder. Es ermöglicht die Modellierung komplizierter Strukturen und Matrixsätze mit verschachtelten Nebensätzen.

Übliche Topologiemodelle sind meist statisch, d. h. sie arbeiten mit vollständigen Dependenzanalysen. Sie arbeiten synthetisch, indem sie alle möglichen Linearisierungen eines Dependenzbaumes erzeugen, oder analytisch,

23 Die Implementierung des Analysemoduls ist im Rahmen dieser Arbeit jedoch nicht

vorgesehen.

23

indem sie prüfen, ob und inwiefern eine vorliegende Linearisierung bestimmten Anforderungen, in der Regel Constraints, genügt. Im Gegensatz dazu

handelt es sich bei dem in dieser Arbeit verwendeten Ansatz um ein interaktives Modell. Die topologische Struktur des Satzes wird während des Parsings

aufgebaut. Die Feldgrenzen bleiben anfangs unbestimmt oder vorläug und

werden erst nach und nach präzisiert. So kann immer, wenn eine neue Dependenz hinzugefügt werden soll, überprüft werden, ob das Dependens sich

nach den bisher gesammelten Informationen in einem der erlaubten Felder

benden kann oder nicht. Im ersten Fall werden die Feldgrenzen entsprechend

verschoben, wodurch im nächsten Schritt genauere Informationen zur Verfügung stehen. Das Modell wird durch ein Präzedenz-Modell ergänzt, das die

erlaubte und bevorzugte Reihenfolge der Konstituenten innerhalb der Felder

modelliert.

C von Chunk∈ IN und ti ∈ Σ∗ ∪ ε. Die

P = {(lj , rj , ε) ∈ C}.

Die zu analysierende Äuÿerung sei gegeben als eine Menge

hypothesen

ci = (li , ri , ti )

mit li

< ri ,

wobei li , ri

Menge aller Pausenhypothesen sei gegeben als

Denition 5

Die Relation

< auf der Menge C deniert eine Striktordnung24 :

∀ c1 = (l1 , r1 , t1 ), c2 = (l2 , r2 , t2 ) ∈ C : c1 < c2 ↔ r1 ≤ l2

c1 < c 2

gilt also genau dann, wenn

Denition 6

c1

Zwei Chunkhypothesen

zeitlich vollständig vor

c1 = (l1 , r1 , t1 )

und

c2

liegt.

c2 = (l2 , r2 , t2 )

aus

C heiÿen (miteinander) kompatibel, wenn sie sich auf der Zeitachse nicht

c1 < c2 oder c2 < c1 , also wenn r1 ≤ l2 oder

laute c1 6 k c2 .

sie inkompatibel, falls r1 > l2 und r2 > l1 . Analog

überschneiden, das heiÿt, wenn

r2 ≤ l1 .

25

Die Schreibweise

Im Umkehrschluÿ heiÿen

c1 k c2 .

Mengen A, B ⊆ C

schreibe man

Zwei

Denition 7

Eine Menge

ckung einer Menge

A 6 k B , wenn

∀(a, b) ∈ A × B : a 6 k b.

heiÿen kompatibel,

mit jedem in B kompatibel ist:

B⊆C

A ⊆ C

jedes Element in A

bildet eine vollständige einfache Abde-

genau dann, wenn beide folgenden Bedingungen

erfüllt sind:

A⊆B−P

∀ b ∈ B − P : (∃ a ∈ A

(1)

mit

a 6= b : a k b) ↔ b ∈

/A

(2)

24 Der Beweis der hinreichenden Eigenschaften Irreexivität und Transitivität ist trivial.

25 Das Symbol 6 k wurde gewählt, da es an eine negierte Parallelität erinnert. Inkompatible

Chunkhypothesen entsprechen nämlich parallel verlaufenden Kanten im Chartgraphen.

24

Eine vollständige einfache Abdeckung einer Menge

E

heiÿe minimal (maxi-

mal), wenn es keine vollständige einfache Abdeckung von

E

gibt, die eine

niedrigere (höhere) Kardinalität aufweist.

Denition 8

thesen:

Ein (topologisches) Feld ist eine Teilmenge aller Chunkhypo-

F ⊆C

Die Ausdehnung eines Feldes

F 6= ∅

ergibt sich wie folgt:

lef t(F ) =

min l

(l,r,t)∈F

right(F ) =

max r

(l,r,t)∈F

Denition 9

Ein Feld

S

(3)

(4)

heiÿe Satzfeld genau dann, wenn es genau aus den

fünf Feldern VFS , LKS , MFS , RKS und NFS besteht und diese in ebendieser

topologischen Reihenfolge angeordnet sind:

S = VFS ∪ LKS ∪ MFS ∪ RKS ∪ NFS

∀F ∈ {LKS , MFS , RKS , NFS } :

F 6= ∅ ∧ VFS 6= ∅ ↔ right(VFS ) ≤ lef t(F)

∀F ∈ {MFS , RKS , NFS } :

F 6= ∅ ∧ LKS 6= ∅ ↔ right(LKS ) ≤ lef t(F)

∀F ∈ {RKS , NFS } :

F 6= ∅ ∧ MFS 6= ∅ ↔ right(MFS ) ≤ lef t(F)

∀F ∈ {NFS } :

F 6= ∅ ∧ RKS 6= ∅ ↔ right(RKS ) ≤ lef t(F)

Denition 10

Ein Mengensystem von Feldern

bildet eine topologische Struktur

Denition 11

TC

über

Eine topologische Struktur

(5)

(6)

(7)

(8)

(9)

Fi ⊆ C, 0 ≤ i < n, n > 0

C.

TC

heiÿe wohlgeformt genau dann,

wenn alle folgenden Bedingungen erfüllt sind:

1. Umfasst ein nichtleeres Feld ein anderes topologisch, so umfasst es auch

26

alle darin enthaltenen Chunkhypothesen

:

∀F1 , F2 ∈ TC mit F1 6= ∅, F2 6= ∅ :

(lef t(F1 ) ≥ lef t(F2 ) ∧ right(F1 ) ≤ right(F2 )) ↔ F1 ⊆ F2

(10)

2. Es existieren keine teilweisen Überlappungen von Feldern:

∀F1 , F2 ∈ TC : F1 ∩ F2 6= ∅ → (F1 ⊆ F2 ∨ F1 ⊇ F2 )

26 Der Umkehrschluss (←) gilt aufgrund der Gleichungen 3 und 4 ohnehin

25

(11)

3. Es gibt ein Satzfeld

S ∈ TC ,

das alle anderen Felder in

TC

umschlieÿt:

∀G ∈ TC : G ⊆ S

4. Jedem Chunk

c∈S

ist ein Feld

Fc ∈ TC

(12)

zugeordnet, für das gilt:

∀H ∈ TC : (c ∈ H → Fc ⊆ H)

∀Satzfeld L ∈ TC : Fc ∈

/ {L, VFL , LKL , MFL , RKL , NFL })

∀d ∈ Fc mit d 6= c ∃K ∈ TC : d ∈ K ∧ K ⊂ Fc )

Fc

heiÿe das von

schreibe:

c

c

aufgespannte Feld oder kurz das Feld von

(15)

c.

Man

X ∈ TC , falls Fc diesem direkt

Fc ⊆ X ∧ (∀ Y ∈ TC : Fc ⊆ Y → X ⊆ Y ).

Eine wohlgeformte topologische Struktur

dig genau dann, wenn ihr mächtigstes Satzfeld

Abdeckung von

(14)

bendet sich in einem Feld

untergeordnet ist, das heiÿt

Denition 12

(13)

C

S

TC

heiÿe vollstän-

eine vollständige einfache

bildet.

Zu Beginn des Parsings wird eine minimale wohlgeformte topologische Struktur erstellt:

TC0 = {S, VF S , LK S , MF S , RK S , NF S }

mit S = ∅, VF S = ∅, LK S = ∅, MF S = ∅, RK S = ∅, NF S = ∅

Sei

TCi−1

(16)

die (wohlgeformte) topologische Struktur einer Teilanalyse. Die

Teilanalyse soll um eine Dependenz erweitert werden, so dass

cj ∈ C

die

g bezüglich seinem Regens r erhält.

Sr das kleinste Satzfeld27 , das r einschlieÿt, und Fr das von r aufgespannte

grammatikalische Funktion

Sei

Feld. Mit Hilfe des Topologiemodells soll entschieden werden, ob die Erweiterung topologisch zulässig ist. Dieses enthält eine Reihe von Topologieregeln

der Form:

Th (g, r, o) = (Z, p)

(17)

g die grammatikalische Funktion, in der cj zu r stehen

o ∈ {VE , VZ , VL } die in dieser Teilanalyse für Sr gewählte

Verbstellung. Die Regeln listen eine Menge Z von erlaubten Zielfeldern für

cj auf, wobei Z ⊆ {Fr , VFSr , LKSr , MFSr , RKSr , NFSr }. Bendet sich das

Feld des Regens Fr unter den Zielfeldern, gibt p ∈ {−1, 0, 1} an, ob cj darin

Dabei bezeichnet

soll, und

27 In einer topologischen Struktur können mehrere Satzfelder verschachtelt sein, wenn es

sich um einen Matrixsatz mit Nebensätzen handelt.

26

vor (p

= −1)

oder nach (p

möglich ist (p

= 0),

= 1)

seinem Regens

r

stehen muss oder ob beides

das heiÿt es gilt:

Z − Fr

Z

Zj =

Z − Fr

f alls p = −1 ∧ r < cj

f alls p = 0

f alls p = 1 ∧ cj < r

(18)

Zj,k ∈ Zj

um cj erweiterbar

i,j,k

ist, das heiÿt, ob folgende erweiterte topologische Struktur TC

wohlgeformt

ist:

Es wird nun geprüft, ob eines dieser Zielfelder

Fcj

i,j,k

TC

In

TCi,j,k

= {cj }

(19)

TCi−1

= {G ∈

| G 6⊇ Zj,k }

∪ {H ∪ cj | H ∈ TCi−1

∪ Fcj

und

H ⊇ Zj,k }

(20)

werden also das Zielfeld und um, wie in Gleichung 10 gefordert,

alle Inklusionen zu erhalten alle Felder, die es umschlieÿen, um

Zusätzlich wird das in Gleichung 13-15 geforderte von

cj

cj

erweitert.

aufgespannte neue

Feld hinzugefügt. Da Gleichung 12 unberührt bleibt, folgt für die maximal

mögliche Ausdehnung des Feldes

outmostlef t(Zj,k ) =

outmostright(Zj,k ) =

Satz 3 TCi,j,k ist

Zj,k ,

die die Wohlgeformtheit erhält:

max

right(G)

(21)

min

lef t(G)

(22)

{G∈T |right(G)≤lef t(Zj,k )}

{G∈T |right(Zj,k )≤lef t(G)}

topologisch zulässig, wenn es wohlgeformt ist und wenn zu-

sätzlich für alle darin enthaltenen Chunks die Positionierungsconstraints aus

Abschnitt 3.1.3 erfüllt sind. Dann gilt:

Ist

TCi,j,k

TCi = TCi,j,k .

zudem vollständig, ist die Analyse des vollständigen Satzes abge-

schlossen.

3.1.3 Präzedenzregeln

Die nichtprädikativen Satzglieder können fast beliebig auf die Stellungsfelder oder auf das Feld des jeweiligen Regens verteilt werden. So kann nahezu

jedes Satzglied das Vorfeld besetzen. Innerhalb eines Feldes ist ihre Reihenfolge zwar prinzipiell frei wählbar, unterliegt aber dennoch einigen Einschränkungen. Dies gilt insbesondere für das Mittelfeld, da dort üblicherweise die

gröÿten Ansammlungen von Gliedern vorzunden sind. Die Regeln lassen

sich jedoch auch auf andere Felder übertragen, zum Beispiel auf das von

27

Innitiv-Konstruktionen mit zu erzeugte Feld: Im Satz Ihm ein Buch zu

schenken, nde ich gut darf ihm nicht nach ein Buch stehen.

Manche Reihenfolgen lassen sich vollständig ausschlieÿen wie zum Beispiel Weil ihm er dankbar ist oder sind allenfalls in Lyrik vorstellbar wie

zum Beispiel Weil ein Buch ich ihm schenke. Andere sind zwar unüblich

und vermeintlich ungrammatisch, unter bestimmten Voraussetzungen (Betonung, bestimmte Verben) zumindest in gesprochener Sprache aber nicht

gänzlich unvorstellbar: Weil das Buch ICH ihm schenke.

Bei der Satzgliedreihenfolge gibt es also ieÿende Übergänge zwischen grammatisch und ungrammatisch. Bei der Beurteilung spielen viele Faktoren mit

(nach [7], S. 113-131):

•

Pronomialität: Pronomina stehen meist vor normalen Nominalphra-

sen.

•

Denitheit: Bestimmte Nominalphrasen stehen tendenziell weiter vor-

ne als unbestimmte. Ebenso sind Personalpronomina vor Demonstrativpronomina, und diese vor Indenitpronomina anzusiedeln.

•

Komplexität: Um das Verständnis des Satzes zu erleichtern, werden

28

komplexere Satzglieder möglichst weit hinten positioniert

•

.

Kasus bzw. syntaktische Funktion : Es gibt bestimmte Standardreihen-

folgen von Nominativ, Dativ und Akkusativ. Auch andere Satzglieder

wie Lokaladverbien, Temporaladverbien oder Präpositionalphrasen lassen sich hierin an bestimmten Stellen einordnen.

•

Kasussynkretismus: Ist der Kasus morphologisch nicht eindeutig mar-

kiert, kommt eine Standardreihenfolge

•

29

zur Anwendung.

Verschiedene lexikalische Faktoren: Verben können in verschiedene Klassen eingeteilt werden, die sich bezüglich der Reihenfolge ihrer Dependenten unterschiedlich verhalten.

•

Weitere morphosyntaktische, semantische und pragmatische Faktoren

können in Erwägung gezogen werden.

In der Computerlinguistik werden daher meist Gewichtungsmodelle verwendet, um die Grammatizität einer Äuÿerung zu bewerten (vgl. [7], S. 112

28 Auch der Faktor Pronomialität lieÿe sich in diesem Kontext sehen, da Pronomina nur

aus einem, andere Nominalphrasen dagegen meist aus zwei oder mehr Wörtern bestehen.

29 Die Verwendung des Begries Standardreihenfolge ist problematisch, da deren Exis-

tenz in der Linguistik umstritten ist ([7], S. 111).

28

und 133 . ). Hierzu wird eine gröÿere Menge anfechtbarer Constraints

verwendet, die sich statistisch aus Textkorpora ableiten lassen. Je mehr

dieser Regeln durch eine Äuÿerung eingehalten werden, desto besser wird

diese bewertet. Die Constraints sind sehr speziell und widersprechen sich

zum Teil, so dass in der Praxis keine Äuÿerung alle von ihnen erfüllt. Ab

einem bestimmten Schwellenwert wird die Äuÿerung akzeptiert.

Das für diese Arbeit entwickelte Modell geht von folgender vereinfachender

Annahme aus:

Annahme 4

Die Wirkung eines einzelnen Faktors auf die Stellung von Satz-

gliedern lässt sich durch binäre Präzedenzregeln vollständig beschreiben, das

heiÿt, die Frage, ob ein Satzglied

a

vor einem Satzglied

b

positioniert ist oder

nicht, ist unabhängig von der Existenz und der Position eines dritten Satzgliedes.

Die Präzedenzregeln haben die Form

M <N :w

wobei

M

und

N

Merkmalstrukturen sind und

(23)

w

eine (nicht negative) Zahl.

Die Präzedenzregel beschreibt den topologischen Zusammenhang zwischen

m und n in Satzgliedfunktion, deren Merkmalstrukturen von M

beziehungsweise N subsumiert werden und die sich im selben topologischen

Feld benden. Gilt m < n nicht, so ist die Interpretation der Äuÿerung

topologisch falsch, falls w = 0, beziehungsweise mit dem Gewicht w > 0

zu bestrafen. Die Bestrafung erfolgt durch zu w proportionale Senkung der

allen Chunks

Priorität (vgl. Abschnitt 3.1.6). Es gibt also zwei Typen von Präzedenzregeln:

a) Regeln mit

w=0

sind Positionierungsconstraints, die bei Nichteinhal-

tung absolut hemmend wirken.

b) Regeln mit

w>0

sind Präferenzregeln, die bei Nichteinhaltung relativ

hemmend wirken.

Im Gegensatz zu Positionierungsconstraints haben Präferenzregeln also keinen Einuÿ darauf, ob eine Interpretation der Äuÿerung als grammatisch

akzeptiert wird oder nicht. Sie können jedoch im Zweifelsfall die richtige

Auösung von Ambiguitäten fördern.

Aus Ezienzgründen wird nicht jedes Mal die Einhaltung aller Regeln

überprüft, wenn ein Dependenzkandidat auf seine topologische Zulässigkeit

hin überprüft wird. Stattdessen wird vor der Suche die Menge

C

analysiert

und eine Menge von Mutex-Verknüpfungen zwischen Chunks erstellt. Für

29

jedes Tupel von Chunks

M < N : w wird

und N die von n.

•

Falls

(m, n) ∈ C × C mit m > n und für jede Regel

M die Merkmalstruktur von m subsumiert

überprüft, ob

Ist beides der Fall, geschieht folgendes:

m = 0,

wird eine Mutex-Verknüpfung zwischen

m

und

n

aufge-

baut oder, falls vorhanden, eine bestehende verwendet. Sie erhält das

Gewicht

•

Falls

−1.

m > 0

und noch keine Mutex-Verknüpfung zwischen

m

vorhanden, wird eine derartige aufgebaut und mit dem Gewicht

und

w

n

ver-

sehen.

•

Falls

m > 0

und bereits eine Mutex-Verknüpfung zwischen

mit dem Gewicht

•

Falls

m > 0

−1

m

und

n

besteht, bleibt diese unverändert bestehen.

und bereits eine Mutex-Verknüpfung zwischen

mit einem positiven Gewicht besteht, wird dieses um

w

m

und

n

erhöht.

So entsteht eine Liste von absolut (−1) und relativ (>

1) hemmenden MutexVerknüpfungen. Diese gelten natürlich nur unter der Bedingung, dass m und

n im selben Feld untergebracht sind. Immer, wenn überprüft wird, ob ein

Zielfeld Z um einen Chunk c erweitert werden kann, ist das Vorgehen wie

folgt: Für alle Chunks d, die mit c mutex-verknüpft sind, wird geprüft, ob

sich d in Z bendet. Trit dies zu und ist die Verknüpfung

•

absolut hemmend, so ist die Zuweisung topologisch unzulässig.

•

relativ hemmend, werden die Gewichte der betreenden Mutex-Verknüpfungen

30

addiert. Das kumulierte Gewicht wird später

Auswahl von

c

zur Depriorisierung der

verwendet.

3.1.4 Konikte

Beim Parsing können Konikte der folgenden Typen auftreten:

•

Inkongruenz: Tritt auf, wenn die Subsumption scheitert, weil der Wert

eines oder mehrerer atomarer Merkmale nicht mit der Vorgabe übereinstimmt. Je nach Merkmal wird der Konikt höher oder niedriger

bewertet.

Beispiel: mein herz pochen.

30 Siehe Abschnitt 3.1.6.

30

Als nites Verb wurde pochen identiziert. Nun wird das Subjekt

gesucht anhand der Maske:

[NP]

category

kasus

form

numerus

person

[NOM]

[PL]

[3]

Ein Kandidat ist der Chunk mein herz mit der Merkmalstruktur:

text

[NP]

[mein

form

category

herz]

kasus

numerus

genus

person

[NOM]

[SG]

[NEUT]

[3]

In diesem Falle liefert der Subsumptionstest einen Inkongruenz-Konikt

numerus SG statt PL.

Stimmt die Chunkkategorie nicht überein, wird gar kein Konikt erzeugt, sondern der betreende Chunk gar nicht erst in Betracht gezogen: Im obigen Beispiel: auf mein herz pochen.

category

text

form

•

[PP]

[auf mein

kasrek

herz]

[AKK]

Falsche Topologie: Ein Dependens ist topologisch nicht zulässig

31

:

aufgenommen die sendung hat er nicht

aufgenommen hat die sendung er nicht

Dieser Konikt kann nicht durch Spracherkennerfehler verursacht werden und somit bei einer grammatikalisch korrekten Äuÿerung nur auftreten, wenn die Teilanalyse falsch ist. Deswegen wird auf diesen Konikttyp verzichtet und der Chunk bei der Suche nicht berücksichtigt.

•

Oene Valenzstelle: Eine Valenzstelle kann nicht besetzt werden, weil

kein topologisch zulässiger Chunk der geforderten Chunkkategorie mehr

zur Verfügung steht:

31 Vgl. Satz 3, S. 27.

31

ich möchte gerne anschauen

ich möchte gerne zu anschauen

•

Unbenutzter Chunk: Die Lösung deckt nicht die gesamte Äuÿerung ab,

sondern es bleiben Lücken übrig, in denen kein Komplement oder Supplement eines anderen Chunks gefunden wurde, und die auch nicht

durch Pausenhypothesen abgedeckt werden können:

ich möchte sie sendung anschauen

ich möchte gerne zu anschauen

Im zweiten Beispiel tritt sowohl ein Oene-Valenzstelle-Konikt auf

(kein Objekt zu anschauen` gefunden) als auch ein Unbenutzter-