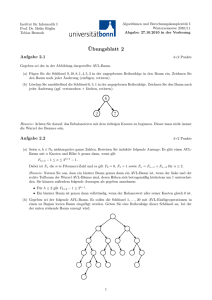

Algorithmen und Komplexität

Werbung