Computerorientierte Mathematik II

Werbung

Computerorientierte Mathematik II

mit Java

Rolf H. Möhring

Technische Universität Berlin

Institut für Mathematik

Sommersemester 2005

ii

Vorbemerkungen

Diese Vorlesung ist der zweite Teil des Zyklus Computerorientierte Mathematik und schließt sich

direkt an die Computerorientierte Mathematik I an. Dieses Skript basiert auf meiner Vorlesung vom

Sommersemester 2004. Zwei Studenten der Vorlesung, Elisabeth Günther und Olaf Maurer, haben

im Sommer 2004 eine ausgezeichnete Ausarbeitung der Vorlesung angefertigt, die von mir nur noch

leicht überarbeitet und ergänzt wurde. Das Resultat ist dieses Skript, das auch online unter

http://www.math.tu-berlin.de/coga/moehring/Coma/Skript-II-Java/

zur Verfügung steht.

Die Vorlesung umfasst folgende Punkte: Wir behandeln zunächst ein Sortierverfahren namens Bucketsort, das durch besondere Anforderungen an die Schlüsselmenge schon in linearer Zeit sortieren kann.

Dann werden Bäume, insbesondere binäre Bäume besprochen und wie diese zur Datenkompression

mit dem Huffman-Algorithmus genutzt werden können. Bäume finden als Suchbäume und insbesondere als AVL-Bäume weitere Verwendung. Wir kommen dann zu optimalen statischen Suchbäumen

und besprechen eine Alternative zum Suchen in Bäumen, das sogenannte Hashing. Den Abschluss

des Semesters bildet ein Kapitel über Schaltkreistheorie und Programmierbare Logische Arrays.

iii

iv

VORBEMERKUNGEN

Inhaltsverzeichnis

Vorbemerkungen

iii

Inhaltsverzeichnis

v

1

Bucketsort

1

1.1

Einfaches Bucketsort . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2

1.1.1

Definition . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2

1.1.2

Implementation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4

1.1.3

Aufwandsanalyse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4

Sortieren von Strings mit Bucketsort . . . . . . . . . . . . . . . . . . . . . . . . . .

5

1.2.1

Sortieren von Strings der Länge k . . . . . . . . . . . . . . . . . . . . . . .

6

1.2.2

Sortieren von Binärzahlen . . . . . . . . . . . . . . . . . . . . . . . . . . .

8

1.2.3

Sortieren von Strings variabler Länge . . . . . . . . . . . . . . . . . . . . .

9

Literaturhinweise . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

13

1.2

1.3

2

Bäume und Priority Queues

15

2.1

Bäume . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

15

2.1.1

Grundbegriffe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

15

2.1.2

Implementation von binären Bäumen . . . . . . . . . . . . . . . . . . . . .

17

2.1.3

Traversierung von Bäumen . . . . . . . . . . . . . . . . . . . . . . . . . . .

22

Priority Queues . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

25

2.2.1

Mögliche Implementationen einer Priority Queue . . . . . . . . . . . . . . .

26

Literaturhinweise . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

27

2.2

2.3

3

Huffman Codes und Datenkompression

29

v

vi

INHALTSVERZEICHNIS

3.1

Codierung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

29

3.1.1

Präfixcode . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

31

3.2

Der Huffman Algorithmus . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

33

3.3

Weitere Datenkompressionsverfahren . . . . . . . . . . . . . . . . . . . . . . . . .

41

3.3.1

Der adaptive Huffmancode . . . . . . . . . . . . . . . . . . . . . . . . . . .

41

3.3.2

Der run length code“ . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

”

Der Lempel-Ziv Code . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

41

3.4

Abschließende Bemerkungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

43

3.5

Literaturhinweise . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

44

3.3.3

4

Suchbäume

45

4.1

Basisoperationen in Suchbäumen . . . . . . . . . . . . . . . . . . . . . . . . . . . .

46

4.1.1

Suchen nach Schlüssel k . . . . . . . . . . . . . . . . . . . . . . . . . . . .

46

4.1.2

Einfügen eines Knoten . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

46

4.1.3

Löschen eines Knoten . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

46

Literaturhinweise . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

51

4.2

5

AVL-Bäume

53

5.1

Grundsätzliche Eigenschaften . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

53

5.2

Rotationen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

57

5.3

Die Basisoperationen in AVL-Bäumen . . . . . . . . . . . . . . . . . . . . . . . . .

61

5.3.1

Suchen eines Knotens v . . . . . . . . . . . . . . . . . . . . . . . . . . . .

62

5.3.2

Einfügen eines neuen Knotens v . . . . . . . . . . . . . . . . . . . . . . . .

62

5.3.3

Löschen eines Knotens v . . . . . . . . . . . . . . . . . . . . . . . . . . . .

65

Literaturhinweise . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

67

5.4

6

7

41

Optimale statische Suchbäume

69

6.1

Statische Suchbäume allgemein . . . . . . . . . . . . . . . . . . . . . . . . . . . .

69

6.2

Optimalität statischer Suchbäume . . . . . . . . . . . . . . . . . . . . . . . . . . .

70

6.3

Konstruktion eines optimalen statischen Suchbaumes . . . . . . . . . . . . . . . . .

73

6.4

Literaturhinweise . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

81

B-Bäume

83

7.1

83

Definition und Eigenschaften . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

INHALTSVERZEICHNIS

7.2

7.3

8

Basisoperationen in B-Bäumen . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

86

7.2.1

Suchen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

86

7.2.2

Einfügen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

86

7.2.3

Löschen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

88

Literaturhinweise . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

91

Hashing

93

8.1

Hash-Funktionen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

94

8.1.1

Divisionsmethode . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

95

8.1.2

Multiplikationsmethode . . . . . . . . . . . . . . . . . . . . . . . . . . . .

95

Kollisionsbehandlung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

96

8.2.1

Chaining . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

96

8.2.2

Offene Adressierung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

97

8.2

8.3

9

vii

Literaturhinweise . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 106

Schaltkreistheorie und Rechnerarchitektur

107

9.1

Schaltfunktionen und Schaltnetze . . . . . . . . . . . . . . . . . . . . . . . . . . . . 107

9.2

Vereinfachung von Schaltnetzen . . . . . . . . . . . . . . . . . . . . . . . . . . . . 115

9.3

9.4

9.5

9.2.1

Das Verfahren von Karnaugh . . . . . . . . . . . . . . . . . . . . . . . . . . 117

9.2.2

Das Verfahren von Quine und McCluskey . . . . . . . . . . . . . . . . . . . 120

9.2.3

Das Überdeckungsproblem . . . . . . . . . . . . . . . . . . . . . . . . . . . 125

Schaltungen mit Delays . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 126

9.3.1

Addierwerke . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 128

9.3.2

Das Fan-In-Problem . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 130

PLAs und das Prinzip der Mikroprogrammierung . . . . . . . . . . . . . . . . . . . 131

9.4.1

Aufbau eines PLAs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 131

9.4.2

Zur Programmierung von PLAs . . . . . . . . . . . . . . . . . . . . . . . . 133

Literaturhinweise . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 135

Literaturverzeichnis

141

Index

142

viii

INHALTSVERZEICHNIS

Kapitel 1

Bucketsort

Bucketsort ist ein Sortierverfahren, das grundsätzlich anders als alle Sortierverfahren funktioniert, die

wir bisher kennen gelernt haben. Es zeichnet sich dadurch aus, dass es nicht wie die Verfahren aus

Teil I der Vorlesung auf paarweisen Vergleichen von Schlüsseln basiert, sondern voraussetzt, dass

die Schlüsselmenge klein und bekannt ist, und dass es Objekte direkt dem richtigen Bucket“ (Fach)

”

zuordnet.

Anschaulich lässt sich dieses Verfahren mit der Verteilung der Post im Postamt auf die Häuser einer

Straße vergleichen. Der Briefträger hat eine Reihe von Fächern, die den Hausnummern entsprechen.

Er geht die Briefe der Reihe nach durch und legt jeden Brief in O(1) (also konstanter) Zeit in das Fach

mit der entsprechenden Hausnummer. Dabei können in einem Fach natürlich mehrere Briefe sein, die

aber aus Sicht der Ordnungsrelation gleich sind (da sie in das gleiche Bucket sortiert werden, haben

sie ja die gleiche Nummer) und daher nicht mehr innerhalb des Fachs sortiert werden müssen. Der

Briefträger entnimmt die Briefe den Fächern der Reihe nach und hat sie damit nach Hausnummern

sortiert.

Bei m Hausnummern und n Briefen sortiert er also in O(m + n). Da in der Regel m ≤ n gilt, wenn

Bucketsort angewendet wird, befindet sich der Algorithmus dann in der Komplexitätsordnung Θ(2n) =

Θ(n) und man erhält so also einen Sortieralgorithmus, dessen Aufwand linear von der Anzahl der zu

sortierenden Schlüssel abhängt.

Man beachte, dass die in der CoMa I ermittelte untere Komplexitätsschranke von Ω(n log n) nur

Sortieralgorithmen betrifft, die auf paarweisen Vergleichen beruhen. Bucketsort beruht jedoch nicht

auf paarweisen Vergleichen von Schlüsseln und setzt außerdem zusätzliche Informationen über die

Schlüsselmenge voraus. Daher liegt Bucketsort nicht in der Klasse der Sortieralgorithmen, die von

dieser Schranke betroffen sind.

Umgesetzt auf Datenstrukturen bedeutet dies:

Version vom 24. März 2006

1

2

KAPITEL 1. BUCKETSORT

Wirklichkeit

Fächer

Hausnummern

Stapel im Fach

Briefe am Anfang

Briefe am Ende

1.1

1.1.1

Datenstruktur

Array

Array-Indizes

Liste an jedem Array-Index

Liste

Liste

Einfaches Bucketsort

Definition

Wir geben jetzt einen Algorithmus für die oben erklärte Situation an. Gegeben seien also n Objekte a1 , a2 , . . . , an mit Schlüsselwerten s(a1 ), s(a2 ), . . . , s(an ) in einer Liste L. O.B.d.A. seien die

Schlüsselwerte Zahlen zwischen 0 und m − 1, also s(a j ) ∈ {0, 1, . . . , m − 1}, j = 1, . . . , n. Es gibt

dann also genau m paarweise verschiedene Schlüsselwerte.

Algorithmus 1.1 (Einfaches Bucketsort)

1. Initialisiere ein Array mit m leeren Queues Qi (Buckets), je eine für jeden Wert i = 0, 1, . . . , m−1

und je einer Referenz (head bzw. tail) auf den Anfang und das Ende der Queue Qi .

2. Durchlaufe L und füge das Objekt a j entsprechend seines Schlüsselwertes in die Queue Qs(a j )

ein.

3. Konkateniere die Queues Q0 , Q1 , . . . , Qm−1 über die head- und tail-Referenzen zu einer Liste L

und gebe L zurück.

Beispiel 1.1 Sei m = 5 und n = 9. Die Liste L ist gegeben durch Abbildung 1.1.

head

r - a1 - a2 - a3 - a4 - a5 - a6 - a7 - a8 - a9

2

r

1

r

0

r

2

r

2

r

4

r

0

r

4

r

1

Abbildung 1.1: Liste L der zu sortierenden Elemente

Es wird ein Array A mit je 2 Referenzen auf head und tail der Queues Qi eingerichtet. Abbildung 1.2

zeigt die Queues nach Abarbeitung der Liste L, also am Ende von Schritt 2.

Dann werden die einzelnen Listen konkateniert. Das Konkatenieren der Listen ist sehr einfach, da nur

das letzte Element (über tail) auf das erste Element (über head) der nächsten nichtleeren Liste gesetzt

werden muss, siehe Abbildung 1.3.

3

1.1. EINFACHES BUCKETSORT

A

r

A[0]

A[1]

A[2]

A[3]

A[4]

- a3 - a7

0

r

r

r

r

r

r

r

r

2

r

2

r

- a6 - a8

4

r

1

- a1 - a4 - a5

2

r

r

r

- a2 - a9

1

r

r

0

r

4

r

Abbildung 1.2: Queues nach Abarbeitung der Liste

A

r

A[0]

A[1]

A[2]

A[3]

A[4]

- a3 - a7

0

r

r

r

r

r

r

r

r

2

r

2

r

- a6 - a8

4

r

1

- a1 - a4 - a5

2

r

r

r

- a2 - a9

1

r

r

0

r

4

r

Abbildung 1.3: Queues nach Konkatenation der Einzellisten

4

KAPITEL 1. BUCKETSORT

1.1.2

Implementation

Eine Implementation in Java könnte in etwa wie folgt aussehen:

class QueuePointer {

public ListNode head;

public ListNode tail;

}

QueuePointer[] A = new QueuePointer[n];

// array with head- and tail-reference in each field

Das Einfügen des Knoten node mit Schlüsselwert i in die i-te Queue Qi geschieht dann mit einer

Anweisung der Form

A[i].tail.setNext(node);

Die Konkatenation zweier Queues erfolgt über die Anweisung

A[i].tail.setNext(A[j].head);

Dabei ist j die erste nichtleere Liste nach i.

1.1.3

Aufwandsanalyse

Satz 1.1 (Aufwand von einfachem Bucketsort) Algorithmus 1.1 sortiert die Liste korrekt in O(m +

n) Zeit.

Beweis: Am Ende von Schritt 2 enthält jede Queue Qi nur Objekte a j mit Schlüssel s(a j ) = i. Die

Konkatenation der Queues in der Reihenfolge Q0 , Q1 , . . . , Qm−1 liefert also eine korrekt sortierte Liste.

Das Einfügen von a j in die Queue Qi mit i = s(a j ) erfolgt durch Umhängen von Referenzen in O(1)

Zeit. Beim Durchlaufen der Liste L sind alle Vorgänger von a j bereits aus L entfernt und der Listenzeiger current der Liste L zeigt auf a j . Die Sequenz

A[i].tail.setNext(current);

A[i].tail = current;

current = current.getNext();

hängt a j aus L aus und in Qi ein. Das Einfügen aller Objekte a j geschieht also in O(n) Zeit.

Das Konkatenieren der Queues kann in einer Schleife mit O(1) Aufwand pro Queue geschehen. Wir

geben ein Code-Fragment an, das die Konkatenierung durchführt:

1.2. SORTIEREN VON STRINGS MIT BUCKETSORT

5

k = 0;

while ((A[k].head == NULL) && (k < m))

k++;

// k is now the first nonempty list in A, if there is one

i = k + 1;

while (i < m) { // while-loop: O(m)

// at this point k is the last list we have already concatenated

// we will now look for the next nonempty list after k

while ((A[i].head == NULL) && (i < m))

i++;

if (i==m)

break;

// if (i==m), we have iterated through all nonempty lists

// in A and are finished

// we have found a new nonempty list, concatenate it to k

A[k].tail.setNext(A[i].head);

// and prepare k for the next iteration

k = i;

i++;

} // endwhile

Weil das Konkatenieren pro Queue nur einen Aufwand in O(1) benötigt und maximal m Buckets konkateniert werden müssen, ist der Aufwand damit insgesamt O(n) + O(m) = O(m + n).

Falls m ≤ n gilt, ist der Aufwand in der Komplexitätsklasse O(n). Bucketsort schlägt dann also die

untere Komplexitätsschranke für Sortieralgorithmen, die auf paarweisen Vergleichen beruhen. Dafür

benötigt Bucketsort allerdings Informationen über die Werte der auftretenden Schlüssel, weil sonst

m nicht klein gehalten werden kann und der Aufwand von Bucketsort nur dann in O(n) liegt, wenn

m ≤ n gilt.

1.2

Sortieren von Strings mit Bucketsort

Wir wollen jetzt Bucketsort zum Sortieren von Strings gemäß der lexikographischen Ordnung nutzen.

Wir definieren zuerst, was wir unter lexikographisch kleiner“ verstehen wollen:

”

Sei S die Menge der Zeichen und ≤ eine lineare Ordnung auf S. Seien A = a1 a2 . . . a p und B =

b1 b2 . . . bq zwei Strings der Länge p bzw. q über S. Dann heißt A lexikographisch kleiner als B, in

Zeichen

A ≤lex B

6

KAPITEL 1. BUCKETSORT

falls einer der folgenden Fälle zutrifft:

1. p ≤ q und ai = bi für i = 1, . . . , p (d.h. A ist ein Anfangsstück von B).

2. Es gibt j ∈ {1, . . . , p} mit a j ≤ b j und ai = bi für i = 1, . . . , j − 1 (d.h. an der ersten Stelle j, an

der A und B verschieden sind, ist a j kleiner oder gleich b j bezüglich der linearen Ordnung auf

S).

Beispiel 1.2 Hall ≤lex Hallo, Arbeit ≥lex Album

Wir sortieren mit Bucketsort lexikographisch, indem wir für jede Komponente einfaches Bucketsort

verwenden. Zunächst betrachten wir den Spezialfall, dass alle Strings die gleiche Länge k haben. Dies

beinhaltet insbesondere das Sortieren k-stelliger Binärzahlen beziehungsweise von Strings auf der

Zeichenmenge Sb = {0, 1}.

1.2.1

Sortieren von Strings der Länge k

Die Idee besteht darin, die Strings bezüglich der Stellen mit Bucketsort zu sortieren, wobei die Stellen von hinten nach vorn durchlaufen werden. Dies gewährleistet, dass vor dem Bucketsort bezüglich

Stelle i (also nach k − i Iterationen) die Strings bereits nach den letzten Stellen i + 1, . . . , k lexikographisch sortiert sind. Diese Sortierung wird trotz der späteren Durchläufe erhalten, weil durch Bucketsort die Elemente, die an einer Stelle i gleich sind, in der gleichen Reihenfolge eingefügt werden, in der

sie schon waren (durch die vorherige Iteration beziehungsweise von Anfang an). Diese Eigenschaft

eines Sortieralgorithmus bezeichnet man als Stabilität, Bucketsort ist ein stabiler Sortieralgorithmus.

Algorithmus 1.2 (Bucketsort)

Input: Eine Liste L mit Strings A1 , A2 , . . . , An der Länge k mit Ai = ai1 , ai2 , . . . , aik und ai j ∈ S =

{0, 1, . . . , m − 1}

Output: Eine Permutation B1 , . . . , Bn von A1 , . . . , An mit Bi ≤lex B2 ≤lex · · · ≤lex Bn

Methode:

1. Richte eine Queue Q ein und füge A1 , . . . , An in Q ein. 1

2. Richte ein Array Bucket von m Buckets ein (wie beim einfachen Bucketsort)

3. for jede Stelle r := k downto 1 do

3.1 Leere alle Buckets Bucket[i]

3.2 while Q nicht leer ist do

1 Einfügen bedeutet hier immer, dass nur Referenzen auf A eingefügt werden. Das Einfügen geschieht also in O(1) und

i

nicht wie beim zeichenweisen Einfügen des Strings in O(k).

1.2. SORTIEREN VON STRINGS MIT BUCKETSORT

7

• Sei A j das erste Element in Q

• Entferne A j aus Q und füge es in Bucket[i] mit i = a jr ein

endwhile

3.3 Konkateniere die nichtleeren Buckets in die Queue Q

endfor

Beispiel 1.3 Sei S = {0, 1} und 0 < 1. Seien A1 = 010, A2 = 011, A3 = 101, A4 = 100.

Wir sortieren zunächst nach der letzten Komponente: 010 011 101 100

Dadurch erhalten wir Folgendes:

0 : 010 100

⇒ 010 100 011 101

1 : 011 101

Wir sortieren dann nach der zweitletzten Komponente: 010 100 011 101

Wir erhalten:

0 : 100 101

⇒ 100 101 010 011

1 : 010 011

Nun die letzte Iteration, also Sortierung nach der ersten Komponente: 010 100 011 101

Wir erhalten:

0 : 010 011

⇒ 010 011 100 101

1 : 100 101

Nach dem Durchlauf der for-Schleife stehen die Strings in folgender Reihenfolge in Q:

r=3

r=2

r=1

010

100

010

100

101

011

011

010

100

101

011

101

nach letzter Stelle sortiert

nach letzten 2 Stellen sortiert

nach letzten 3 Stellen sortiert

Wir sehen also: Das Sortierverfahren arbeitet (bei diesem Beispiel) korrekt. Das motiviert folgenden

Satz:

Satz 1.2 (Aufwand von Bucketsort) Algorithmus 1.2 sortiert A1 , . . . , An lexikographisch korrekt in

O((m + n) · k) Zeit.

Beweis: Wir beweisen folgende Invariante: Nach dem i-ten Durchlauf sind die Strings bezüglich der

letzten i Zeichen lexikographisch aufsteigend sortiert.

Daraus folgt dann insbesondere, dass beim Sortieren von k-stelligen Strings nach dem k-ten Durchlauf

die Strings bezüglich der letzten k Stellen (also allen Stellen) lexikographisch korrekt sortiert sind

und damit die Behauptung. Der Beweis der Invariante erfolgt durch vollständige Induktion über die

Iterationsschritte, hier bezeichnet mit r.

8

KAPITEL 1. BUCKETSORT

r = 1: (einfaches Bucketsort nach letzter Komponente):

In diesem Fall folgt die Korrektheit aus Satz 1.1, da die Strings nach Satz 1.1 lexikographisch korrekt

nach der letzten Stelle sortiert werden.

r → r + 1:

Die Behauptung sei also für r bewiesen. Betrachte nun die beiden Strings Ai und A j in der (r + 1)-ten

Iteration. Wir unterscheiden zwei Fälle:

Fall I: Ai und A j werden in der (r + 1)-ten Iteration in unterschiedliche Buckets sortiert.

Da Ai und A j in unterschiedliche Buckets sortiert werden, unterscheiden sich Ai und A j also an der

gerade betrachteten Stelle. Die lexikographische Korrektheit der Sortierung folgt dann wieder aus Satz

1.1, da wir ja wieder einfaches Bucketsort an der (r + 1)sten Stelle von hinten betrachten. Daher sind

sie lexikographisch korrekt sortiert.

Fall II: Ai und A j werden in der (r + 1)-ten Iteration in das gleiche Bucket sortiert.

Da die einzelnen Buckets durch Queues realisiert werden, werden die Strings in der Reihenfolge,

in der sie im vorigen Durchgang schon waren, hinten eingefügt und in der nächsten Iteration beziehungsweise in der Konkatenation wieder in dieser Reihenfolge ausgelesen. Da die Strings aber nach

der r-ten Iteration schon lexikographisch korrekt sortiert waren, sie sich aber an der (r + 1)-ten Stelle

von hinten nicht unterscheiden, sind sie dann nach den letzten (r + 1) Stellen lexikographisch korrekt

sortiert.

Da für jedes Zeichen in dem String genau ein Durchlauf erfolgt, erfolgen genau k Durchläufe. Da

jeder dieser Durchläufe (wie in Satz 1.1 bewiesen) in O(n + m) erfolgt, erfolgt die ganze Sortierung

daher in O (k · (n + m)).

1.2.2

Sortieren von Binärzahlen

Als spezielle Anwendung gibt es das Sortieren von n k-stelligen Binärzahlen in O(k · n). In CoMa I

wurde aber bewiesen, dass zum Sortieren von n Zahlen ein Aufwand in der Größenordnung O(n log n)

erforderlich ist. Der scheinbare Widerspruch ist aber keiner:

Mit k Stellen kann man nur 2k paarweise verschiedene Binärzahlen bilden. Für die Darstellung von n

paarweise verschiedenen k-stelligen Binärzahlen muss daher gelten:

2k ≥ n ⇔ k ≥ log n

Also gilt für dieses von n abhängige k:

n log n ≤ k · n

1.2. SORTIEREN VON STRINGS MIT BUCKETSORT

1.2.3

9

Sortieren von Strings variabler Länge

Erste Idee:

Die erste Idee für diesen Sortieralgorithmus ist es, ein Bucket hinzuzufügen, in das die Strings sortiert

werden, die im aktuellen Durchlauf an der betrachteten Stelle kein Zeichen haben. Weil diese Strings

lexikographisch kleiner sind, steht dieses Bucket vor allen anderen Buckets. Die Sortierung erfolgt

dann einfach mit Algorithmus 1.2.

Beispiel 1.4 Wir betrachten die Strings bab, abc und a und wollen sie in ihre lexikographisch korrekte

Reihenfolge sortieren. In der ersten Iteration erhalten wir

kein Zeichen : a

a:

⇒ a bab abc

b:

bab

c:

abc

Dann sortieren wir nach dem zweitletzten Zeichen:

kein Zeichen : a

a:

bab

⇒ a bab abc

b:

abc

c:

Und schließlich sortieren wir noch nach dem ersten Zeichen:

kein Zeichen :

:

a

a

abc

⇒ a abc bab

b:

bab

c:

Durch diesen Ansatz werden in jeder Iteration alle Strings betrachtet. Bezeichne `max die Länge des

längsten dieser Strings. Dann hat dieser Sortieralgorithmus den gleichen Aufwand wie der Sortieralgorithmus 1.2 zur Sortierung von Strings der festen Länge k = `max . Nach Abschnitt 1.2.1 ist also der

Gesamtaufwand dieses Algorithmus in der Klasse O (`max · (n + m)).

Es geht aber besser: Bezeichne `total die Gesamtanzahl der Zeichen. Wir können den Algorithmus so

modifizieren, dass er in O(`total + m) liegt.

Ideen für einen besseren Algorithmus

Sei wieder `max die Länge des Strings mit der größten Länge.

1. Sortiere die Strings Ai nach absteigender Länge `i .

2. Verwende `max -mal Bucketsort wie vorher, aber betrachte in Phase r nur die Strings Ai , für die

`i ≥ `max − r + 1 gilt (also die Strings, die an der aktuell betrachteten Stelle ein Zeichen haben,

weil sie genügend lang sind).

10

KAPITEL 1. BUCKETSORT

3. Um leere Buckets zu vermeiden, bestimme vorab die nötigen Buckets in jeder Phase und konkateniere am Ende einer Phase nur die nichtleeren Buckets. (Verringert den Aufwand zur Konkatenation auf O(#nichtleer) statt O(m).)

Algorithmus 1.3

Input: Strings (Tupel) A1 , . . . , An

ai j ∈ {0, . . . , m − 1}

Ai = (ai1 , ai2 , . . . , ai`i ),

(oder auch ein beliebiges anderes Alphabet)

`max = max `i

i

Output: Permutation B1 , . . . , Bn von A1 , . . . , An mit B1 ≤lex B2 ≤lex · · · ≤lex Bn

Methode:

1. Generiere ein Array von Listen NONEMPTY[] der Länge `max und für jedes `, 1 ≤ ` ≤ `max eine

Liste in NONEMPTY[`], die angibt, welche Zeichen an einer der `-ten Stellen vorkommen und

welche Buckets daher in der (`total − `)-ten Iteration benötigt werden.

Dazu:

1.1 Erschaffe für jedes ai` , 1 ≤ i ≤ n, 1 ≤ ` ≤ `i ein Paar (`, ai` ) (das bedeutet: das Zeichen ai`

kommt an `-ter Stelle in einem der Strings vor)

1.2 Sortiere die Paare lexikographisch mit Algorithmus 1.2, indem man sie als zweistellige

Strings betrachtet.

1.3 Durchlaufe die sortierte Liste der (`, ai` ) und generiere im Array NONEMPTY[], sortierte

Listen, wobei das Array NONEMPTY[`], 1 ≤ ` ≤ `max eine sortierte Liste aller ai` enthält.

Dabei lassen sich auch gleich auf einfache Weise eventuell auftretende Duplikate entfernen.

2. Bestimme Länge `i jedes Strings und generiere Listen LENGTH[`] aller Strings mit Länge ` (nur

Referenzen auf die Strings in LENGTH[`] verwalten, daher nur O(1) für Referenzen umhängen)

3. Sortiere Strings analog zu Algorithmus 1.2.3, beginnend mit `max . Aber:

• nach der r-ten Phase enthält Q nur die Strings der Länge ≥ `max − r + 1; diese sind lexikographisch korrekt sortiert bezüglich der letzten r Komponenten.

•

NONEMPTY [] wird benutzt, um die Listen in BUCKET[] neu zu generieren und außerdem

zur schnelleren Konkatenation der Einzellisten. Dies ist nötig, weil wir nur die nichtleeren

Buckets verwalten wollen.

• vor dem r + 1-ten Durchlauf wird LENGTH [`max − r] am Anfang2 der Queue Q eingefügt.

Die kurzen Strings stehen dann am Anfang und damit am lexikographisch richtigen Platz,

falls sie mit anderen im selben Bucket landen.

2 Das

ist zwar ein wenig ungewöhnlich, bereitet aber grundsätzlich keine Probleme.

11

1.2. SORTIEREN VON STRINGS MIT BUCKETSORT

Wir erinnern noch einmal: BUCKET[] ist ein Array von Queues, in das sortiert wird, und Q ist eine

Queue, die die Strings enthält, die zur Zeit betrachtet werden, also genügend lang sind.

Wir geben nun Pseudocode für Teil 3 von Algorithmus 1.3 an.

Algorithmus 1.4

1. Leere Q

2. for j:=0 to m − 1 do

2.1 leere BUCKET[j]

3. for `:=`max downto 1 do

3.1 Füge LENGTH[`] am Anfang von Q ein

3.2 while Q nicht leer do

3.2.1 Sei Ai erster String in Q

3.2.2 lösche Ai in Q und füge Ai in BUCKET[ai` ] ein

3.3 for jedes j in NONEMPTY[`] do

3.3.1 füge BUCKET[j] am Ende von Q ein

3.3.2 leere BUCKET[j]

Beispiel 1.5 Sortieren wir nun die gleichen Strings wie vorher, also a, bab und abc. Weil wir mit

Referenzen arbeiten, spielt die Stringlänge für das Einfügen keine Rolle.

Teil 1 des Algorithmus erzeugt durch einfaches Durchlaufen der Strings folgende Paare:

(1, a), (1, b), (2, a), (3, b), (1, a), (2, b), (3, c)

in der Liste. Daraus liefert Algorithmus 1.2 dann die sortierte Liste

(1, a), (1, a), (1, b), (2, a), (2, b), (3, b), (3, c)

Durch einfaches Durchlaufen dieser sortierten Liste von links nach rechts werden daraus die Listen

im Array NONEMPTY[] mit den richtigen Einträgen gefüllt:

= a, b

= a, b

NONEMPTY [3] = b, c

NONEMPTY [1]

NONEMPTY [2]

Dann werden die Längen der einzelnen Strings bestimmt:

`1 = 1, `2 = 3, `3 = 3

Mit Hilfe dieser Information erzeugt der Algorithmus dann das Array

eine Liste aller Strings der Länge ` enthält:

LENGTH [],

wobei

LENGTH [`]

12

KAPITEL 1. BUCKETSORT

= a

= 0/

LENGTH [3] = bab, abc

LENGTH [1]

LENGTH [2]

Nun führen wir den dritten Teil des Algorithmus aus, dessen Pseudocode wir angegeben haben:

Zuerst werden in Q alle Elemente von

letzten Stelle sortiert:

LENGTH [`max ]

=

LENGTH [3]

eingefügt und dann nach der

BUCKET[a]

= 0/

BUCKET[b] = bab

BUCKET[c] = abc

Durch das Array NONEMPTY[] wissen wir, dass wir das erste Bucket gar nicht betrachten müssen. Es

werden daher nur die letzten beiden Listen konkateniert und die Elemente am Ende von Q eingefügt.

Q enthält nun bab,abc. Es wird daraufhin LENGTH[2] = 0/ am Anfang von Q eingefügt.

Daraufhin wird Q nach der zweitletzten Stelle sortiert:

BUCKET[a]

= bab

= abc

BUCKET[c] = 0/

BUCKET[b]

Wieder wissen wir schon, dass das letzte Bucket leer ist und brauchen es daher nicht zu betrachten. Es

werden die ersten beiden Listen konkateniert und am Ende von Q eingefügt. Q enthält nun bab, abc.

Daraufhin wird LENGTH[1] = a am Anfang von Q eingefügt, Q enthält nun also a, bab, abc.

Daraufhin wird Q nach der ersten Stelle sortiert:

Q[a] = a, abc

Q[b] = bab

Q[c] = 0/

Dann werden die Listen konkateniert und wir erhalten als Ergebnis: a, abc, bab.

Zum Aufwand

Um die Paare zu generieren, müssen alle Strings durchlaufen werden und für jedes Zeichen in jedem

der Strings muss genau ein Paar erzeugt werden. Der Aufwand dafür ist

n

O(`1 + `2 + · · · + `n ) = O

∑ `i

!

= O(`total )

i=1

Beim Sortieren der Paare ist `max = 2. Dieser Teil erfordert einen Aufwand von

13

1.3. LITERATURHINWEISE

2. Komponente

1.Komponente

z

}|

{ z

}|

{

`max ≤`total

O 2 · `total + |{z}

m + `total + `max ⊆ O(`total + m)

|{z}

|{z}

|{z}

Elemente

Buckets

Elemente

Buckets

Um NONEMPTY[] einzurichten, müssen wir nur die sortierte Liste der Paare einmal durchlaufen, das

geht also in O(`total ). Das Berechnen der Länge (O(`total )) und Erzeugen des Arrays LENGTH[] (das

lmax Elemente besitzt) geht in O(`total + `max ) ⊆ O(`total ).

Satz 1.3 Algorithmus 1.3 sortiert die Liste korrekt in O(`total + m) Zeit.

Beweis: Die Korrektheit ist klar, folgt wie in Algorithmus 1.2. Zum Aufwand:

O(`total )

+ O(`total + m) +

O(`total )

+

Teile 1,2

Paare generieren

Paare sortieren

NONEMPTY einrichten

O(`total )

LENGTH einrichten

Teil 3:

Sei n` die Anzahl der Strings, deren Länge `i größer gleich ` ist. Sei m` die Anzahl der verschiedenen

Symbole, die an der Stelle ` auftreten. m` ist dann auch gleichzeitig die Länge von NONEMPTY[`].

Ein Durchlauf der WHILE-Schleife 3.2 hat dann als Aufwand O(n` ) (weil sich in jeder Iteration n`

Elemente in Q befinden). Ein Durchlauf der FOR-Schleife 3.3 hat einen Aufwand von O(m` ) (weil

wir genau m` Buckets verbinden müssen).

`max

Der Aufwand des Pseudocodes ist dann insgesamt: O ∑ (m` + n` ) .

`=1

`max

O

!

∑ (m` + n` )

`=1

= O

`max

`max

`=1

`=1

∑ m` + ∑ n`

!

⊆ O(`total ) + O(`total )

⊆ O(`total )

1.3

Literaturhinweise

Die Darstellung von Bucketsort folgt [HU79]. Varianten von Bucketsort (Counting Sort, Radix Sort) und eine

average vase Analyse werden in [CLRS01] behandelt.

14

KAPITEL 1. BUCKETSORT

Kapitel 2

Bäume und Priority Queues

2.1

Bäume

Bisher haben wir als dynamische Datenstrukturen Listen kennengelernt. Da der Zugriff in Listen in

der Regel nur sequentiell erfolgen kann, ergibt sich für das Einfügen bzw. Suchen in einer (sortierten)

Liste bei Länge n ein linearer Aufwand. Das heißt:

O(n) im worst case und

O(n/2) im average case.

Dies ist für viele Anwendungen, in denen ein sich dynamisch ändernder Datenbestand verwaltet werden muss, zu langsam (z.B. Verwaltung von Identifiern in einem Programm durch den Compiler,

Autorenkatalog einer Bibliothek, Konten einer Bank, usw.). Bessere Methoden bietet unter anderem

die Datenstruktur der Bäume, die in diesem Kapitel erläutert wird.

2.1.1

Grundbegriffe

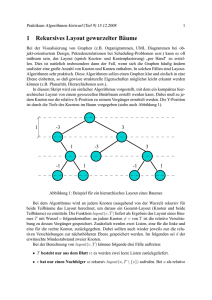

Gerichtete Bäume (kurz Bäume) kann man auf zwei Arten erklären. Eine graphentheoretische Definition 1 wurde bereits in der Coma I im Zusammenhang mit Graphen behandelt. Etwas abstrakter ist

die rekursive Definition, die in der Coma I in Zusammenhang mit der Rekursion erläutert wurde. Sie

wird hier noch einmal erklärt und in Abbildung 2.1 visualisiert:

1 Ein

gerichteter Baum ist ein Digraph T = (V, E) mit folgenden Eigenschaften:

– Es gibt genau einen Knoten r, in dem keine Kante endet (die Wurzel von T ).

– Zu jedem Knoten i 6= r gibt es genau einen Weg von der Wurzel r zu i.

Dies bedeutet, dass keine zwei Wege in den gleichen Knoten einmünden. Der Graph kann sich ausgehend von der Wurzel

also nur verzweigen. Daher kommt auch der Name Baum.

15

16

KAPITEL 2. BÄUME UND PRIORITY QUEUES

Ein Baum T

• ist entweder leer

• oder er entsteht aus endlich vielen, voneinander verschiedenen Bäumen T1 , . . . , Tn mit Wurzeln

w1 , . . . , wn , die in T als Teilbäume unter der Wurzel w von T (einem neuen Knoten) hängen.

w1

wn

A

A

T1 A

Tn A

... A

A

A

A

A

A

w r

@

@

=⇒

w1

...

A

T1 A

A

A

A

@

@ wn

A

Tn A

A

A

A

Abbildung 2.1: Baum, rekursiv aufgebaut

Beispiele für die Verwendung von Bäumen sind:

• Darstellung von Hierarchien

• Auswertung arithmetischer Ausdrücke

z.B.: ((a + b) ∗ (c + d))/e + f /g (siehe Abb. 2.6, Seite 24)

• Rekursionsbaum

Im Zusammenhang mit Bäumen ist die folgenden Terminologie üblich: Blätter, innere Knoten, Wurzel, Kinder / Söhne / Brüder, Vater / Eltern, Nachfolger, Vorgänger und Teilbäume. Ein Knoten v kann

einen Vater und Söhne haben. Die Söhne eines Vaters sind Brüder. Hat ein Knoten keinen Vater, ist

er die Wurzel des Baumes. Hat er keine Söhne, ist er ein Blatt. Wenn ein Knoten verschieden von der

Wurzel ist und mindestens einen Sohn hat, ist er ein innerer Knoten.

Eine besondere Rolle spielen die binären Bäume. Sie sind entweder leer oder bestehen aus der Wurzel

und einem linken und einem rechten binärem Baum (den Teilbäumen). Jeder Knoten hat maximal

zwei Söhne, man spricht vom linken und vom rechten Sohn. In den folgenden Abschnitten werden

wir ausschließlich binäre Bäume behandeln und deshalb das Wort Baum in der Bedeutung binärer

Baum verwenden. Bekannte Beispiele binärer Bäume sind der Stammbaum mit Vater, Mutter und

einer Person als deren Nachfolger (!) oder die Aufzeichnung eines Tennisturniers, in der jedes Spiel

durch einen Knoten mit dem Namen des Gewinners charakterisiert ist und die beiden vorausgehenden

Spiele als dessen Nachfolger aufgeführt sind.

Die rekursive Struktur von Bäumen ist von großer Bedeutung für viele Algorithmen auf Bäümen.

Auch viele charakteristische Größen von Bäumen lassen sich rekursiv beschreiben oder definieren.

17

2.1. BÄUME

Ein Beispiel dafür ist die Höhe von Bäumen. Die Höhe gibt den längsten Weg von der Wurzel bis zum

Blatt gemessen in Anzahl der Kanten an. Sie ergibt sich wie folgt:

h(T ) =

n

−1

falls T leer

max{h(T1 ), h(T2 )} + 1

sonst

(2.1)

Besteht T beispielsweise nur aus einem Knoten, ergibt sich aus Gleichung (2.1) die Höhe von T zu

h(T ) = max{−1, −1} + 1 = 0.

2.1.2

Implementation von binären Bäumen

Im Folgenden wird gezeigt, wie sich binäre Bäume als abstrakte Datenstruktur implementieren lassen.

Ein Baum besteht aus Knoten und Kanten zwischen den Knoten. Die Knoten sind hier Objekte der

inneren Klasse BinTreeNode. Für die Kanten nutzt man die Zeigereigenschaft von Referenzobjekten.

So kennt ein BinTreeNode das Objekt, das im Knoten steht, seinen linken und seinen rechten Sohn und

in manchen Implementationen auch seinen Vater. Das wird in Abbildung 2.2 deutlich. Zusätzlich sind

get und set Methoden sinnvoll sowie Methoden, die testen, ob der linke bzw. rechte Sohn vorhanden

sind.

class BinTreeNode {

Object

BinTreeNode

BinTreeNode

data;

lson;

rson;

// saved object

// left son

// right son

// sometimes also usefull

BinTreeNode

parent; // parent

...

// constructors, get methods,

// set methods ...

}

Objekt

r

Ref. auf

linken Sohn

r

A

AAU

Ref. auf

rechten Sohn

Abbildung 2.2: Struktur eines Knotens

Wie in Abb. 2.3 dargestellt, ist ein Baum eine Verzeigerung“ von Knoten. Jeder BinTreeNode zeigt

”

auf seine Söhne und, wie oben schon erwähnt, in manchen Implementationen auch auf seinen Vater.

18

KAPITEL 2. BÄUME UND PRIORITY QUEUES

Es gibt einen BinTreeNode, hier root“ genannt, dessen rechter (oder linker) Sohn immer auf die

”

eigentliche Wurzel des Baumes zeigt. Zusätzlich gibt es eine Referenz curr“ (lies: karr), die auf

”

einen beliebigen Knoten im Baum zeigt und die auf jeden Knoten umgesetzt werden kann.

root

qH

H

HH

j

Objekt

q

q

Q

Q

q

Q

+

Q

s

Q

Objekt

q

q

Objekt

q

@

@

R

@

Objekt

q

q

@

R

@

q

@

@

R

@

Objekt

q

@

curr

q

@

...

@

R

@

...

Abbildung 2.3: Baum, dargestellt als verkettete Struktur

class BinTree {

BinTreeNode dummy;

BinTreeNode curr;

// dummy node whose left son is the root

// points at the current node

...

}

Das folgende Programm 2.1 stellt ein Beispiel einer abstrakten Klasse dar, von der binäre Bäume

abgeleitet werden können. Einige Methoden werden im Folgenden genauer erklärt.

Programm 2.1 BinTree

/**

* abstract base class for all sorts of binary trees

*

* @author N.N.

*/

abstract class BinTree {

/**

* class for tree nodes

*/

protected class BinTreeNode {

19

2.1. BÄUME

public BinTreeNode() {

}

// default constructor

public BinTreeNode(Object obj) { // init constructor

}

public boolean isLeaf() {

}

// is node a leaf in tree?

public boolean isRoot() {

}

// is node root of tree?

public boolean isLeftChild() {

}

// is node left child

// of parent?

public BinTreeNode getLeftChild() {

}

// get left child

public BinTreeNode getRightChild() { // get right child

}

public BinTreeNode getParent() {

}

public String toString() {

}

}

// get parent

// conversion to string

// class BinTreeNode

/***

data

******************************************************/

/***

constructors

**********************************************/

// default constructor, initializes empty tree

public BinTree() {

}

/***

get methods

***********************************************/

public boolean isEmpty() {

}

// is tree empty?

20

KAPITEL 2. BÄUME UND PRIORITY QUEUES

// root node of tree

// -> what should be returned if tree is empty??

protected BinTreeNode _getRoot() {

}

// current number of tree nodes

public int getSize() {

}

// height of tree

public int getHeight() {

}

/***

set methods

***********************************************/

// switch debugging mode

public static void setCheck(boolean mode) {

}

/***

methods for current node

**********************************/

// reset current node to first node in inorder sequence

public void reset() {

}

// does current node stand at end of inorder sequence?

public boolean isAtEnd() {

}

// reset current node to successor in inorder sequence

public void increment() {

}

// object referenced by current node

public Object currentData() {

}

// ist current node a leaf?

public boolean isLeaf() {

}

21

2.1. BÄUME

/***

conversion methods

****************************************/

// convert tree to string

// use getClass() somewhere so that class name of "this" shows

public String toString() {

}

/***

debugging methods

*****************************************/

// check consistency of links in entire tree

protected boolean _checkLinks() {

}

}

Es gibt viele Methoden, die man an oder mit Bäumen durchführen kann. Dazu gehören beispielsweise Methoden zum Einfügen und Löschen von Knoten, zum Durchlaufen des Baumes (vgl. Abschnitt 2.1.3 usw. Wir wollen uns eine mögliche Methode zum Berechnen der Höhe eines Baumes

genauer anschauen. Diese benutzt die Gleichung 2.1 zur Berechnung der Höhe und nutzt die rekursive Struktur von Bäumen.

Programm 2.2 getHeight()

int getHeight() {

if (isEmpty()){

// empty tree

return -1;

} else {

int lheight = _getRoot().getLeftSon().getHeight();

int rheight = _getRoot().getRightSon().getHeight();

return Math.max(rheight,lheight)+1;

}

}

Implementation im Array

Bäume können auch mit Hilfe von Arrays implementiert werden. Hierbei handelt es sich zwar nicht

um eine dynamische Datenstruktur, diese Umsetzung ist allerdings für manche Programmiersprachen

(z.B. FORTRAN) erforderlich. Die Idee hierbei ist, die Indizes als Zeiger auf die Söhne zu nutzen. Das

lässt sich explizit (durch Abspeicherung) oder implizit (durch Berechnung) lösen. Bei der expliziten

Variante sehen die Knoten so aus:

class ArrayBinTreeNode {

Object data;

int

lson;

22

KAPITEL 2. BÄUME UND PRIORITY QUEUES

int

rson;

}

Der Baum wird dann, wie auch in Abbildung 2.4 veranschaulicht, als Array umgesetzt:

ArrayBinTreeNode[] tree = new ArrayBinTreeNode[n];

0

1

i

s

...

n−2 n−1

j

...

?

Objekt

i

...

j

Abbildung 2.4: Baum als Array

Dazu gehören natürlich noch die oben schon dargestellten Zugriffsfunktionen. Die Höhe wird ebenfalls auf die schon erklärte Weise rekursiv berechnet.

Bei der impliziten Variante werden die beiden Söhne nicht im Knoten gespeichert, sondern in getMethoden berechnet. Die Indizes der Söhne des Knoten i ergeben sich bei binären Bäumen immer zu

2i + 1 für den linken Sohn und 2i + 2 für den rechten Sohn.

Der Nachteil an einer Implementation mit Arrays ist leider, dass man bei nicht vollen Bäumen im

Vergleich zur üblichen Implementation mehr Speicherplatz benötigt.

2.1.3

Traversierung von Bäumen

Mit Traversierung eines Baumes bezeichnet man den Durchlauf von Knoten zu Knoten, um in jedem

Knoten etwas zu tun. In den Knoten sind Daten, ähnlich wie in einer Liste, und um mit diesen arbeiten

zu können, müssen sie nacheinander erreicht werden. Jedoch ist die Reihenfolge des Durchlaufens

eines Baumes nicht mehr eindeutig wie bei einer Liste. Standardmäßig benutzt man die folgenden

drei Traversierungen:

WLR: Der Preorder-Durchlauf. Hier wird zuerst die Wurzel betrachtet, dann der linke Teilbaum mit

derselben Regel und dann der rechte Teilbaum wieder mit der selben Regel.

LWR: Der Inorder-Durchlauf. Hier wird zuerst der linke Teilbaum, dann die Wurzel und dann der

rechte Teilbaum besucht, wobei die Teilbäume wieder mit derselben Regel durchlaufen werden.

LRW: Der Post-Durchlauf. Die Wurzel wird erst erreicht, nachdem zuerst der linke und dann der

rechte Teilbaum jeweils mit derselben Regel durchlaufen wurden.

Die Kürzel WLR, LWR und LRW zeigen vereinfacht jeweils die Reihenfolge des Durchlaufens an.

Die Vorsilben Pre-, In- und Post- beziehen sich jeweils auf die Rolle der Wurzel.

23

2.1. BÄUME

A

B

D

C

E

F

Abbildung 2.5: Beispielbaum für die Traversierung

Beispiel 2.1 Dieses Beispiel zeigt die drei Traversierungsmöglichkeiten für den Baum in Abbildung 2.5.

WLR: A, B, D, E, C, F

LWR: D, B, E, A, C, F

LRW: D, E, B, F, C, A

Ist es einfach nur wichtig, unabhängig von der Reihenfolge alle Knoten zu erreichen, spielt es keine

Rolle, welche Traversierung gewählt wird. Allerdings gibt es verschiedene Anwendungen, die jeweils

unterschiedliche Reihenfolgen benutzen. Beim Aufrufbaum oder beim Rekursionsbaum beispielsweise, die in Coma I behandelt wurden, werden die Methoden in Postorder Reihenfolge abgearbeitet. Im

folgenden Beispiel wird verdeutlicht, welchen Einfluss die verschiedenen Reihenfolgen auf arithmetische Ausdrücke haben.

Beispiel 2.2 Der arithmetische Ausdruck

((a + b) ∗ (c + d))/e + f /g

wird vom Compiler in einen Baum, wie in Abb. 2.6, umgewandelt. In diesem Baum stehen die Identifier in den Blättern. In den inneren Knoten und der Wurzel stehen Operatoren. Diese verknüpfen jeweils ihren linken Teilbaum als arithmetischen Ausdruck mit dem Ausdruck ihres rechten Teilbaums.

Durchläuft man den Baum in Inorder, ergibt sich der arithmetische Ausdruck in Infix-Notation:

((a + b) ∗ (c + d))/e + f /g

Durchläuft man den Baum aber in Postorder, erhält man den Ausdruck in Postfix-Notation beziehungsweise umgekehrter polnischer Notation (UPN):

ab + cd + ∗e/ f g/+

Dieser wird dann vom Computer, wie in Coma I behandelt, mit Hilfe eines Stacks berechnet.

Im Gegensatz zur Infix-Notation ist der Baum aus der Postfix-Notation arithmetischer Ausdrücke ohne Hilfe von Klammern (re)konstruierbar. Indem man den Ausdruck in Postfix-Notation von hinten

durchläuft, kann man den Baum über die Postorder-Reihenfolge von hinten nach vorne (wieder) aufbauen.

24

KAPITEL 2. BÄUME UND PRIORITY QUEUES

+

/

/

e

∗

+

a

f

g

+

b c

d

Abbildung 2.6: Ein arithmetischer Ausdruck als Baum dargestellt

Implementation

Um einen Baum in den verschiedenen Reihenfolgen zu durchlaufen, kann man sich in den JavaMethoden die rekursive Struktur der Bäume nützlich machen. Die Umsetzung zeigt die folgenden

Methoden, die sinnvollerweise zur Klasse BinTree gehören.

Programm 2.3 Traversierung eines Baumes

void preOrderTraversal() {

if (isEmpty()) {

return;

}

// work on root

getLeftSon().preOrderTraversal();

getRightSon().preOrderTraversal();

}

void inOrderTraversal(){

if (isEmpty()) {

return;

}

getLeftSon().inOrderTraversal();

// work on root

getRightSon().inOrderTraversal();

}

void postOrderTraversal() {

2.2. PRIORITY QUEUES

25

if (isEmpty()) {

return;

}

getLeftSon().postOrderTraversal();

getRightSon().postOrderTraversal();

// work on root

}

}

Neben den rekursiven Methoden gibt es auch die Möglichkeit den Baum iterativ zu durchlaufen. Exemplarisch wird hier nur die Inorder Traversierung angesprochen. Die Umsetzung wird in der Übung

behandelt. Zur iterativen Traversierung werden drei Methoden benötigt:

1. public void reset()

2. public void increment()

3. public boolean isAtEnd()

Die Methode reset() sucht sich den am weitesten links stehenden Knoten des Baumes und setzt den

curr-Zeiger auf diesen Knoten. Die Methode increment() setzt den curr-Zeiger auf den Nachfolger,

also auf den nächsten Knoten entsprechend der Inorder-Reihenfolge. Die Methode isAtEnd() prüft,

ob der Inorder-Durchlauf das Ende erreicht hat. Objekte mit solchen Methoden bezeichnet man als

Iterator und die Methoden werden dementsprechend Iteratormethoden genannt.

2.2

Priority Queues

Bei einer Priority Queue handelt es sich um eine Datenstruktur mit folgenden Kennzeichen:

• Sie hat einen homogenen Komponententyp, wobei jede Komponente einen Schlüssel (Wert)

besitzt.

• Die folgenden Operationen sind möglich:

1. Einfügen einer Komponente

2. Zugriff auf die Komponente mit dem kleinsten Wert

3. Entfernen der Komponente mit dem kleinsten Wert

4. Änderung des Wertes einer Komponente

Die Priority Queue wurde schon in Coma I im Zusammenhang mit Heapsort behandelt. Jedoch lag

dort die Aufmerksamkeit auf der Komponente mit dem größten Wert, nicht auf der mit dem kleinsten

Wert.

26

2.2.1

KAPITEL 2. BÄUME UND PRIORITY QUEUES

Mögliche Implementationen einer Priority Queue

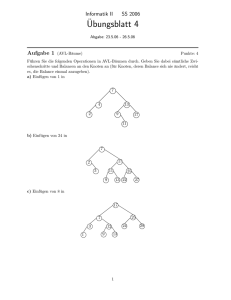

a) Als sortiertes Array

Wenn die Anzahl n der zu speichernden Elemente bekannt ist, können die Elemente in einem Array,

Abb. 2.7, gespeichert werden, wobei das kleinste Element in der ersten Komponente des Arrays steht

und die übrigen aufwärts sortiert folgen. Damit ist ein sehr schneller Zugriff auf das kleinste Element

gewährleistet, jedoch dauern die übrigen Operationen lange, wie in der folgenden Auflistung zu sehen

ist.

1. Einfügen:

O(n) (binäre Suche + Verschieben)

2. Zugriff:

O(1)

3. Entfernen:

O(n)

4. Wert ändern: O(n)

0

1

2

3

4

5

6

7

12 18 24 35 44 53 63 72

6

kleinstes

Element

Abbildung 2.7: Priority Queue als sortiertes Array

Eine bessere Variante ist die folgende:

b) Als Heap

Wie bei Heapsort wird das Array als Baum mit Heap-Eigenschaft aufgefasst. Die Heapeigenschaft ist

dann erfüllt, wenn die Wege von der Wurzel zu jedem Blatt jeweils aufsteigend sortiert sind. Zur Herstellung der Heapeigenschaft wird die Methode heapify()“ verwendet. Ihre genauere Funktionsweise

”

wurde bereits in Coma I erläutert.

0

12

1

18

35

4

HH

H

2

53

63

6

@

@

3

7

24

@

@

5

72

44

Abbildung 2.8: Priority Queue als Heap

Für die Operationen im Heap ergibt sich dann dieser Aufwand im worst case:

27

2.3. LITERATURHINWEISE

1. Einfügen:

O(log n)

2. Zugriff:

3. Entfernen:

4. Wert ändern:

O(1)

O(log n)

O(log n)

als Blatt in die letzte Arraykomponente einfügen

und nach oben wandern lassen

letzte Komp. an die 0-te Stelle tauschen und absinken lassen

aufsteigen oder absinken lassen

Also sind neben dem sehr schnellen Zugriff auf das kleinste Element auch die anderen Operationen

schneller als im sortierten Array.

Es gibt aber noch andere Implementationen, die die Operationen noch schneller, allerdings nur amortisiert, schaffen. Dazu gehören zum Beispiel die Fibonacci Heaps.

2.3

Literaturhinweise

Bäume und Priority Queues werden in jedem Buch über Datenstrukturen behandelt, vgl. etwa [CLRS01, Knu98,

OW02, SS02].

28

KAPITEL 2. BÄUME UND PRIORITY QUEUES

Kapitel 3

Huffman Codes und Datenkompression

Das Ziel der Datenkompression ist es, Daten mit weniger Speicherplatz abzuspeichern. Abhängig von

den Daten geschieht das verlustfrei oder nicht verlustfrei. Audio-, Video- und Bilddateien werden

in der Regel komprimiert, indem Informationen weggelassen werden. Das Prinzip bei MP3-Dateien

beispielsweise ist es, all die Informationen wegzulassen, die das menschliche Ohr nicht wahrnehmen kann. Somit stellt der Informationsverlust keinen Qualitätsverlust für die gespeicherte Musik

dar. Textdateien möchte man ohne Verlust von Informationen komprimieren. Um zu verstehen, wie

das funktioniert, muss man verstehen, wie Texte abgespeichert werden. Der folgende Abschnitt soll

Aufschluss darüber geben.

3.1

Codierung

Wir betrachten einen Zeichensatz C (z.B. das Alphabet, ein Java Zeichensatz, alle Wörter im Duden)

und ein Zeichen c ∈ C. Diese Zeichen werden im Computer mit Codewörtern codiert, und zwar über

dem Alphabet {0, 1}. Die Gesamtheit der Codewörter für den Zeichensatz C heißt dann Code für C.

Üblicherweise haben die Codewörter aller Zeichen eines Zeichensatzes C die selbe Länge. Ein solcher

Code heißt Blockcode. So sind auch der ASCII Code, bei dem alle Codewörter die Länge 8 haben,

und der Unicode, bei dem alle Codewörter die Länge 16 haben, Blockcodes.

Beispiel 3.1 (Blockcode der Länge 3)

Wenn C = {a, b, c, d, e, f , g, } ist, ist

a

b

c

d

e

f

g

−→

−→

−→

−→

−→

−→

−→

−→

29

000

001

010

011

100

101

110

111

30

KAPITEL 3. HUFFMAN CODES UND DATENKOMPRESSION

ein zugehöriger Blockcode der Länge 3.

Es gibt auch Codes, bei denen die Länge der Codewörter der einzelnen Zeichen eines Zeichensatzes

C unterschiedlich lang ist, die sogenannten variable length codes.

Beispiel 3.2 ( variable length code“)

”

Wir betrachten wieder C = {a, b, c, d, e, f , g, }.

a

b

c

d

e

f

g

−→

−→

−→

−→

−→

−→

−→

−→

0

1

10

11

100

101

110

111

Eine Textdatei ist nun eine Folge von Zeichen c ∈ C. Um sie abzuspeichern, muss sie verschlüsselt

werden. Die Verschlüsselung oder auch Codierung entspricht dem Ersetzen jedes Zeichens durch

sein Codewort. Damit die Datei später wieder lesbar ist, müssen die Codewörter wieder in die Zeichen des Zeichensatzes umgewandelt werden. Die Entschlüsselung bzw. Decodierung entspricht dem

umgekehrten Prozess. Das Codieren/Decodieren einer Nachricht entspricht also einer bijektiven Abbildung.

Beispiel 3.3 (Codierung/Decodierung mit Blockcode)

Angenommen, die Datei besteht aus diesen Zeichen:

fa gaga gaff fege

Wird die Datei mit der Codetabelle von Beispiel 3.1 codiert, ergibt sich diese Bitfolge:

f

a

g

a

g

a

g

a

f

f

f

e

g

e

z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{

101 000 111 110 000 110 000 111 110 000 101 101 111 101 100 110 100

Die Decodierung ist hier sehr einfach, da wir wissen, dass drei Bits immer einem Zeichen entsprechen.

Es entsteht wieder eindeutig unsere Datei:

000 |{z}

111 |{z}

101 |{z}

111 |{z}

100

101 |{z}

000 |{z}

111 |{z}

110 |{z}

000 |{z}

110 |{z}

110 |{z}

000 |{z}

101 |{z}

101 |{z}

100 |{z}

110 |{z}

|{z}

f

a

g

a

g

a

g

a

f

f

f

e

g

e

31

3.1. CODIERUNG

Beispiel 3.4 (Codierung / Decodierung mit variable length code)

Betrachten wir jetzt diese beiden Dateien:

Datei 1: abba

Datei 2: ag

Mit der Codetabelle von Beispiel 3.2 codiert, sehen sie so aus:

Datei 1:

(abba)

0110

(a g )

Datei 2: 0110

Doch mit der Decodierung wird es schwer, denn die Dateien sind nicht mehr eindeutig entschlüsselbar.

Man sagt, der Code von Beispiel 3.2 ist nicht eindeutig entzifferbar.

Ein Code heißt also eindeutig entzifferbar, wenn verschiedene Dateien, codiert mit dem selben Code, auch zu verschiedenen Codierungen führen. Der Grund dafür, dass der Code von Beispiel 3.2

nicht eindeutig entzifferbar ist, liegt in der Beschaffenheit der Codewörter. Das Problem besteht darin, dass es Codewörter gibt, die auch durch Zusammensetzen anderer Codewörter entstehen können.

So ist zum Beispiel das Codewort von g, die 110, identisch mit den hintereinander geschriebenen Codewörtern von d und a, die auch 110 ergeben. Es gibt keine Möglichkeit zu unterscheiden, ob dort ein

g oder ein d und ein a steht. Eine Lösung für dieses Problem sind präfixfreie Codes.

3.1.1

Präfixcode

Ein Code heißt Präfixcode1 , wenn kein Codewort Anfangsstück eines anderen Codewortes ist. Jeder

Blockcode ist zum Beispiel ein Präfixcode, weil kein Codewort in einem anderen enthalten sein kann.

Aber auch variable length codes können präfixfrei sein.

Lemma 3.1 Jeder Präfixcode ist eindeutig entzifferbar.

Beweis: Beim Lesen der codierten Datei ist eindeutig klar, wann ein Codewort zu Ende ist. Dann lässt

sich eindeutig sagen, welches Zeichen mit diesem Codewort codiert wurde.

Die Umkehrrichtung von Lemma 3.1 gilt aber nicht. Nicht jeder eindeutig entzifferbare Code muss

ein Präfixcode sein. Das zeigt das folgende Beispiel:

1 Der Name ist etwas verwirrend, denn eigentlich müsste der Code präfixfreier Code heißen. Aber Präfixcode hat sich in

der Literatur durchgesetzt.

32

KAPITEL 3. HUFFMAN CODES UND DATENKOMPRESSION

Beispiel 3.5 Wir betrachten diesen Code:

−→

−→

−→

a

b

c

1

100000

00

Auch wenn dieser Code nicht präfixfrei ist, kann man codierte Dateien wieder decodieren, indem man

die Nullen zählt. Steht hinter einer Eins eine gerade Anzahl von Nullen, handelt es sich um ein a mit

entsprechend vielen c’s dahinter. Steht aber hinter einer Eins eine ungerade Anzahl von Nullen, und

zwar mindestens fünf, handelt es sich um ein b mit entsprechend vielen c’s dahinter. Dafür ist es aber

unter Umständen nötig, sich erst die ganze Datei anzusehen, um zu wissen wie viele Nullen nach den

Einsen kommen. Es ist also möglich, den folgenden codierten Text zu entschlüsseln:

1 |{z}

00 |{z}

00 |{z}

1 |{z}

00 100000

|{z}

| {z }

a

c

c

a

c

b

Im weiteren Verlauf werden wir uns nur noch mit Präfixcodes befassen, da vor allem diese in der

Praxis üblich sind.

Lemma 3.2 Präfixcodes lassen sich mit binären Bäumen T identifizieren, bei denen die Zeichen c ∈ C

in den Blättern stehen und die Wege von der Wurzel bis zum Blatt die Codewörter bilden (eine Kanten

nach links entspricht der 0, eine Kante nach rechts entspricht der 1).

Beweis:

=⇒: Sei C ein Zeichensatz mit einem zugehörigen Präfixcode. Konstruiere einen Baum T , in dem

pro Codewort der Weg gegangen wird, der durch die 0 bzw. die 1 vorgegeben ist. Bei der 0 gehe

nach links, bei der 1 nach rechts. Da der Code präfixfrei ist, endet man immer in einem Blatt.

Es ergibt sich also ein Baum mit den geforderten Eigenschaften.

⇐=: Sei C ein Zeichensatz und T ein Baum mit den Zeichen c ∈ C in seinen Blättern. Betrachte

den Weg von der Wurzel zu den Zeichen c als Codewort für jedes einzelne Zeichen, wobei

der Weg nach links der 0 und der Weg nach rechts der 1 entspricht. Da die Zeichen in den

Blättern des Baumes stehen, ist klar, dass kein Weg zu einem Zeichen in einem Weg zu einem

anderen Zeichen enthalten sein kann. Daher kann kein Codewort Anfangsstück eines anderen

Codewortes sein. Also handelt es sich bei dem Code um einen Präfixcode.

Beispiel 3.6 Der Baum T in Abb. 3.1 entspricht diesem Präfixcode:

a

b

c

d

e

−→

−→

−→

−→

−→

00

01

100

11

101

33

3.2. DER HUFFMAN ALGORITHMUS

1

0

0

1

a

0

0

b

1

1

c

d

e

Abbildung 3.1: Präfixcode als Baum

Kommen wir nun zurück zur Frage der Komprimierung. Der benötigte Speicherplatz für eine Textdatei

entspricht immer der Anzahl der Bits bezüglich ihrer Codierung.

Betrachten wir noch einmal Beispiel 3.3

fa gaga gaff fege

und codieren es mit dem Code von Beispiel 3.1,

f

a

g

a

g

a

g

a

f

f

f

e

g

e

z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{

101 000 111 110 000 110 000 111 110 000 101 101 111 101 100 110 100

so benötigen wir 17 · 3 = 51 Bits. Codiert man aber das Beispiel mit dem Code von Beispiel 3.2,

f

a

g

a

g

a

g

a

f

f

f

e

g

e

z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{ z}|{

101 0 111 110 0 110 0 111 110 0 101 101 111 101 100 110 100

benötigt man 43 Bits.

Verschiedene Codierungen nehmen also unterschiedlich viel Speicherplatz in Anspruch. Bei der Komprimierung wird also (dateiabhängig) ein Code gefunden, der den Speicherplatz reduziert. Dieser Code muss natürlich ein Präfixcode sein, damit die Datei wieder einfach decodierbar ist.

3.2

Der Huffman Algorithmus

Textdateien werden standardmäßig im Blockcode codiert und gespeichert. Der Huffman Algorithmus

konstruiert einen Präfixcode variabler Länge, so dass die Anzahl der benötigten Bits kleiner wird.

Der Code wird so konstruiert, dass Zeichen, die sehr häufig auftreten, kurze Codewörter bekommen,

und weniger häufige Zeichen längere Codewörter. So wird, abhängig von der Datei, der benötigte

Speicherplatz verringert. Der Huffman Algorithmus ist sogar so gut, das der entstehende Präfixcode

optimal bezüglich des benötigten Speicherplatzes ist. Es sind Speicherplatzeinsparungen von 20% bis

90% üblich, je nach Beschaffenheit der Datei.

34

KAPITEL 3. HUFFMAN CODES UND DATENKOMPRESSION

Um den optimalen Präfixcode zu konstruieren, muss die Datei erst einmal gelesen werden, wobei die

Häufigkeiten f (c) für alle Zeichen c ∈ C ermittelt werden. Ist die Häufigkeit der Zeichen bekannt,

und wird die Datei mit dem Präfixcode T (als binärer Baum aufgefasst) codiert, so ergibt sich der

benötigte Speicherplatz der Dateiwie folgt:

B(T ) =

∑ f (c) · hT (c)

(3.1)

c∈C

Dabei gibt hT (c) die Höhe des Zeichens c im Baum T an, also die Anzahl der Kanten des Baumes

von der Wurzel bis zu dem Blatt, in der das Zeichen c steht, an. Dies entspricht nach Lemma 3.1 der

Länge des Codewortes für das Zeichen c.

Beispiel 3.7 zeigt, wie der Speicherplatz bei unterschiedlichen Codierungen variieren kann.

Zeichen c

a

b

c

d

e

f

f (c) in 1000

45

13

12

16

9

5

Code 1

000

001

010

011

100

101

Code 2

0

101

100

111

1101

1100

Code 1

0

0

a

0

1

1

0

b c

Code 2

1

0

a

0

1

d

0

e

1

1

f

0

c

0

1

1

0

1

b

d

0

1

f

e

Abbildung 3.2: Die Bäume der beiden Codes

Dann ergibt sich der benötigte Speicherplatz für Code 1 zu:

B(T1 ) = (45 + 13 + 12 + 16 + 9 + 5) · 1000 · 3 = 300000

Der benötigte Speicherplatz für Code 2 beträgt hingegen:

B(T2 ) = (45 · 1 + 13 · 3 + 12 · 3 + 16 · 3 + 9 · 4 + 5 · 4) · 1000 = 224000

35

3.2. DER HUFFMAN ALGORITHMUS

Wir wollen wir uns nun Huffman Algorithmus ansehen, der für jede Textdatei einen optimalen Präfixcode

ermittelt.

Algorithmus 3.1 (Huffman Algorithmus)

1. Fasse jedes Zeichen c ∈ C als einelementigen Baum auf und füge es in eine Priority Queue Q

ein, wobei die Häufigkeit f (c) als Schlüsselwert dient.

2. Solange Q mehr als einen Baum enthält:

• Wähle die beiden Bäume T1 und T2 mit den kleinsten Häufigkeiten (muss nicht eindeutig

sein).

• Entferne sie aus Q.

• Konstruiere einen neuen Baum aus den T1 , T2 als Teilbäume unter einer neuen Wurzel und

gebe ihm die Häufigkeit f (T1 ) + f (T2 ).

• Füge diesen Baum in Q ein.

3. Gebe (den einzig übrig gebliebenen Baum) T in Q zurück. Dieser Baum (der so genannte Huffman Baum oder Huffman Code) ist ein optimaler Präfixcode.

Bei der Codierung einer Datei gemäß T muss neben der codierten Datei natürlich der Code z.B. als

Baum mit abgespeichert werden, denn er ist zur Decodierung notwendig. Der Speicherplatz dafür ist

aber bei genügend großen Dateien im Vergleich zum eingesparten Speicherplatz so gering, dass er

vernachlässigt werden kann.

Das folgende Beispiel zeigt, wie der Huffman Algorithmus funktioniert:

Beispiel 3.8 (Konstruktion eines Huffman Baumes)

Zeichen c

f (c)

a

45

b

13

c

12

d

16

e

9

f

5

Die Zeichen werden alle als einknotige Bäume mit f (c) als Schlüssel in die Priority Queue Q eingefügt:

45

Q:

a

13

b

12

c

16

d

9

e

5

f

Die beiden Bäume mit den kleinsten Schlüsseln werden aus Q entfernt, zu einem neuen Baum zusammengefügt und wieder in Q eingefügt:

36

KAPITEL 3. HUFFMAN CODES UND DATENKOMPRESSION

45

Q:

a

13

12

b

16

14

d

c

f

e

Das wird fortgesetzt, bis nur noch ein Baum in Q ist:

45

Q:

25

14

d

b

c

45

Q:

16

a

f

e

25

30

a

b

d

c

f

e

45

Q:

55

a

b

c

d

e

f

37

3.2. DER HUFFMAN ALGORITHMUS

45

Q:

a

b

d

c

f

e

Am Ende wird der fertige Huffman Baum von Q entfernt:

45

a

b

c

d

e

f

Die Laufzeit des Huffman Algorithmus

Ist die Priority Queue als Heap implementiert (siehe Abschnitt 2.2.1 auf Seite 26) und hat man n Zeichen, so ergibt sich folgende Laufzeit für den Huffman Algorithmus:

1.

2.

alle Zeichen einfügen in Q:

n − 1 Phasen:

- die beiden Kleinsten aus Q entfernen:

- neuen Baum bauen:

- wieder einfügen in Q:

3. Baum zurück geben:

insgesamt:

O(3n)

n − 1 mal:

O(2 log n)

O(1)

O(log n)

O(1)

O(n log n)

38

KAPITEL 3. HUFFMAN CODES UND DATENKOMPRESSION

Die Optimalität des Huffman Codes

Ein Präfixcode T heißt optimal für einen Zeichensatz C und Häufigkeiten f (c), c ∈ C, wenn

B(T ) ≤ B(T 0 ),

(3.2)

für jeden anderen Präfixcode T 0 (zu C und denselben Häufigkeiten f (c)).

Lemma 3.3 Sei C eine Menge von Zeichen mit den Häufigkeiten f (c). Seien x, y die Zeichen mit den

niedrigsten Häufigkeiten. Dann gibt es einen optimalen Präfixcode T , in dem x und y die größte Höhe

und gemeinsamen Vater haben. Die beiden Codewörter für x und y haben dann dieselbe Länge und

unterscheiden sich nur im letzten Bit.

Beweis:

Die Idee des Beweises ist es, einen Baum T zu betrachten, der einen optimalen Präfixcode repräsentiert

und ihn gegebenenfalls so zu modifizieren, dass er optimal bleibt und die beiden Zeichen x und y in

den Blättern mit der größten Höhe stehen und denselben Vater haben. Ist das möglich, sind die beiden

gewünschten Eigenschaften im optimalen Präfixcode erfüllt. Abbildung 3.3 skizziert diese Vorgehensweise.

T s

s

y

-

HH

Hs

s

@

x

@s

@

s

@s

a

b

s

y

T 0s

T 00s

-

HH

Hs

s

@

a

@s

@

s

@s

x

b

s

b

HH

Hs

s

@

a

@s

@

s

@s

x

y

Abbildung 3.3: Modifizieren des Baumes T für den Beweis von Lemma 3.3

Zunächst überlegen wir uns, dass es einen optimalen Präfixcode gibt. Dies folgt daraus, dass der Wert

B(T ) immer ganzzahlig und positiv ist. In dieser Menge von Zahlen existiert ein kleinster Wert B(T ),

und der zugehörige Baum T ist ein optimaler Präfixcode.

Sei also nun T ein optimaler Präfixcode. Sei a ein Blatt in T mit größter Höhe hT (a). Dann hat a

aufgrund der Optimalität von T einen Bruder b, denn hätte a keinen Bruder, könnte man a einen

Level höher hängen“ und hätte den Wert B(T ) verbessert, was im Widerspruch zur Optimalität von

”

T stünde. Betrachte nun x und y, die beiden Zeichen mit den geringsten Häufigkeiten. Vertauscht man

a und x im Baum T , so entsteht der Baum T 0 . Für den Speicherplatz der beiden Bäume gilt dann:

B(T ) − B(T 0 ) =

∑ f (c) · hT (c) − ∑ f (c) · hT (c)

0

c∈C

=

c∈C

f (x) · hT (x) + f (a) · hT (a) − f (x) · hT 0 (x) − f (a) · hT 0 (a)

| {z }

| {z }

=hT (a)

= ( f (a) − f (x)) · (hT (a) − hT (x))

|

{z

} |

{z

}

≥0

≥ 0

=⇒

B(T ) ≥ B(T 0 )

≥0

=hT (x)

39

3.2. DER HUFFMAN ALGORITHMUS

Da T aber optimal ist, kann es keinen Präfixcode geben, der weniger Speicherplatz benötigt. Also gilt:

B(T ) = B(T 0 )

Der Präfixcode T 0 ist also auch optimal.

Entsteht T 00 , indem man in T 0 b und y vertauscht, lässt sich auf analoge Weise zeigen, dass auch T 00

optimal ist. T 0 erfüllt dann die Aussagen des Lemmas.

Lemma 3.4 (Prinzip der optimalen Substruktur) Sei C ein Zeichensatz mit den Zeichen c ∈ C und

den Häufigkeiten f (c), und seien x und y die beiden Zeichen mit den geringsten Häufigkeiten. Sei T

ein Präfixcode für C und f (c), in dem x und y einen gemeinsamen Vater z haben. Sei T 0 der Baum,

der aus T entsteht, indem x und y wegfallen, statt dessen aber z als neues Zeichen mit der Häufigkeit

f (z) = f (x) + f (y) hinzukommt. T 0 ist dann ein Präfixcode für C 0 := C \ {x, y} ∪ {z}.

Unter diesen Voraussetzungen gilt:

T ist optimal für C

⇐⇒

T 0 ist optimal für C 0

Beweis: Da wir nur die Rückrichtung benötigen, wollen wir nur zeigen:

T 0 ist optimal für C 0

=⇒

T ist optimal für C

Für T und T 0 gilt:

B(T ) − B(T 0 ) =

f (x)hT (x) + f (y)hT (y) − f (z) hT 0 (z)

| {z }

=:α

(hT (x) = hT (y) = α + 1, da x und y Söhne von z)

=

f (x)(α + 1) + f (y)(α + 1) − ( f (x) + f (y))α

= ( f (x) + f (y))(α + 1) − ( f (x) + f (y))α

= ( f (x) + f (y))(α + 1 − α)

=⇒

0

B(T ) − B(T ) =

=⇒

f (x) + f (y)

B(T ) = B(T 0 ) + f (x) + f (y)

(3.3)

Sei T 0 optimal, T aber nicht. Betrachte den optimalen Baum T ∗ für C, d.h. B(T ∗ ) < B(T ). Nach

Lemma 3.3, darf angenommen werden, dass x und y an der tiefsten Stelle im Baum T ∗ stehen und

einen gemeinsamen Vater w haben. Betrachte nun den Baum T ∗ 0 , der entsteht, wenn x und y im Baum

T ∗ wegfallen und w als neues Zeichen mit der Häufigkeit f (w) = f (x) + f (y) hinzukommt. Dann

ergibt sich nach Gleichung 3.3 für den Speicherbedarf:

B(T ∗ ) = B(T ∗ 0 ) + f (x) + f (y)

40

KAPITEL 3. HUFFMAN CODES UND DATENKOMPRESSION

Da T 0 optimal für C 0 ist und T ∗ 0 ein Präfixcode für C 0 und dieselben Häufigkeiten ist, folgt B(T 0 ) ≤

B(T ∗ 0 ). Damit gilt:

3.3

B(T ∗ ) < B(T ) = B(T 0 ) + f (x) + f (y)

≤ B(T ∗ 0 ) + f (x) + f (y)

= B(T ∗ )

Das ergibt einen Widerspruch. Also muss auch T optimal sein.

Satz 3.1 (Optimalität) Der Huffman Code T ist optimal unter allen Präfixcodes, das heißt:

B(T ) :=

∑ f (c) · hT (c) ≤ B(T 0 )

c∈C

für alle Präfixcodes T 0 .

Beweis: (Induktion nach der Anzahl der Zeichen n = |C|)

Induktionsanfang: Für n = 2 liefert der Algorithmus eine Codierung, bei denen die Codewörter nur

aus einer 0 bzw. 1 bestehen. Das entspricht dem optimalen Speicherplatz.

Induktionsschritt von n − 1 auf n: Sei n = |C|. Der Huffman Algorithmus ermittelt die Zeichen x

und y mit den kleinsten Häufigkeiten und ersetzt sie durch einen neuen Baum, mit dem Zeichen z

in der Wurzel und den beiden Söhnen x und y, wobei f (z) = f (x) + f (y) ist. Danach wird mit dem

Zeichensatz C 0 = C\{x, y} ∪ {z} weitergearbeitet. Nach Induktionsvoraussetzung liefert der Huffman

Algorithmus einen optimalen Baum T 0 für C 0 . Ersetzt man z wieder entsprechend Lemma 3.4, so

erhält man einen optimalen Präfixcode T für C. Da der Huffman Algorithmus gerade auf diese Weise

den Baum T konstruiert, ist der Huffman Code optimal unter allen Präfixcodes.

Bemerkungen zu Huffman Codes

Hier soll nochmal auf besondere Eigenschaften des Huffman Algorithmus und auf Alternativen dazu

hingewiesen werden.

Der Huffman Algorithmus entspricht einer zeichenweisen Codierung. Es wird jedem Zeichen c ∈ C

ein eigenes Codewort zugewiesen. Wie wir später noch sehen werden, gibt es auch Algorithmen, die

Codewörter für Teilstrings konstruieren. Auch beim Huffman Algorithmus wäre das möglich, indem

man Strings der Länge k als Zeichen betrachtet.

Beim Huffman Code handelt es sich um einen statischen Code. Das bedeutet, dass die ganze Nachricht vorab gelesen und analysiert wird, um die Häufigkeiten der einzelnen Zeichen zu ermitteln und

3.3. WEITERE DATENKOMPRESSIONSVERFAHREN

41

dementsprechend feste Codewörter zu konstruieren. Danach muss die Datei noch einmal gelesen werden, um sie mit den entstandenen Codewörtern zu codieren. Das Gegenteil hierzu wären die dynamischen bzw. adaptiven Codes. Bei diesen Codierungen werden die Codewörter während des Lesens des

Textfiles erstellt und im Laufe des Lesens geändert, wenn es mehr Informationen über die Nachricht

gibt. Die Datei wird während des Lesens codiert, und zwar mit sich ändernden Codewörtern. Diese

Vorgehensweise erspart ein zweimaliges Lesen. Das dynamische Codieren wird auch Komprimierung

on the fly“ genannt.

”

Die Datenkompression mittels des Huffman Algorithmus ist im Gegensatz zur Kompression von

Audio-, Video- und Graphikdateien verlustfrei. Die ursprüngliche Nachricht kann also ohne Verlust

von Informationen wieder rekonstruiert werden.

3.3

3.3.1

Weitere Datenkompressionsverfahren

Der adaptive Huffmancode

Im Gegensatz zum statischen Huffmancode, wird bei diesem Verfahren ein dynamischer Code erstellt. Im Laufe des Lesens werden zu jedem Zeitpunkt, abhängig von der schon gelesenen Nachricht, die wahrscheinlichen Häufigkeiten abgeschätzt und auf dieser Grundlage die Codewörter erstellt. Der Präfixcode wird also immer so verändert, dass er für die aktuellen Abschätzungen optimal

ist. Beim Verschlüsseln wird die Beschaffenheit der Quelldatei gelernt“. Beim Entschlüsseln muss

”