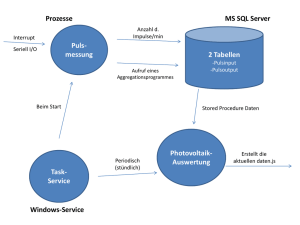

Datenbankgestützte Speicherung von Korpora

Werbung