Script Regression

Werbung

Inhaltsverzeichnis

1 Regressions- und Korrelationsrechnung

1

1.1

Regression über die Methode der kleinsten Quadrate . . . . . . . . . .

1

1.2

Lineare Regression . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2

1.2.1

Erklärte Varianz und Modellgüte der linearen Regression . . .

6

1.2.2

Lineare Regression von X aus Y . . . . . . . . . . . . . . . . .

9

1.2.3

Lineare Regression bei Abweichungswerten . . . . . . . . . . .

9

1.2.4

Der Produkt-Moment Korrelationskoeffizient rxy . . . . . . . .

11

Korrelation bei nicht metrischen Skalenniveaus . . . . . . . . . . . . .

17

1.3.1

Zusammenhang von dichotomen Merkmalen . . . . . . . . . . .

17

1.3.2

Zusammenhang von dichotomen und intervallskalierten Merkmalen 22

1.3.3

Zusammenhang bei ordinalskalierten Daten . . . . . . . . . . .

1.3

1

26

Regressions- und Korrelationsrechnung

In der Psychologie hat man es ständig mit Merkmalszusammenhängen zu tun, d.h.

man betrachtet, in welcher Weise das Auftreten eines Merkmals X mit dem Auftreten

eines Merkmals Y zusammengeht, also das Miteinanderauftreten von Merkmalen.

Allgemein formuliert hat man das Problem, daß eine vorherzusagende Variable Y aus

einer Menge von Prädiktoren X1 , . . . , XK vorhergesagt werden soll. Wir beschränken

uns im folgenden zunächst auf den einfachen Fall des Zusammenhanges zwischen

zwei Variablen, dieser kann auf den allgemeinen Fall von K Prädiktoren und einer

vorherzusagenden Variable verallgemeinert werden.

1.1

Regression über die Methode der kleinsten Quadrate

Wie betrachten zwei mindestens intervallskalierte Variablen X und Y. Gibt es einen

Zusammenhang zwischen diesen beiden Variablen, d.h. kann aus den Werten der einen

Variable eine gültige Vorhersage der Werte der anderen Variable gemacht werden,

muß die Gleichung der Form Y = ϕ (X) gelten. Wenn wir annehmen, daß X und Y

statistische Variablen sind, wird eine Gleichung dieser Form aber nicht streng gelten,

sondern wir schreiben statt dessen

Yi = ϕ (Xi ) + ei .

(1)

Die Beziehung (1) besagt, daß wir jeden Beobachtungswert Yi erklären über eine noch

unbekannte Funktion von X und einen Fehler ei , der bei der Vorhersage unvermeidlich

auftritt. Da ϕ (X) zur Vorhersage verwendet wird, schreiben wir

Ybi = ϕ (Xi )

1

(2)

für die vorhergesagten Werte und definieren den Vorhersagefehler als

ei = Yi − Ybi .

(3)

Für die anzupassende Funktion ϕ muß man ein problemangemessenen Modell wählen.

Hat man dies getan, stellt sich die Frage, nach welchem Kriterium die Modellparameter (die Konstanten der Funktion ϕ, die den Verlauf der Funktion festlegen) hergeleitet werden sollen. Das gebräuchlichste Kriterium hierfür ist das Kriterium kleinster

quadratischer Abweichungen:

N

X

e2i =

i=1

N

X

(yi − ybi )2 → min

(4)

i=1

Bezüglich der Funktion ϕ unterscheidet man 2 Fälle

1. Modelle, die durch geeignete Transformationen auf ein Polynom der Form y =

Pk

k

i=0 a0 x zurückgeführt werden könnnen;

2. Modelle, für die das nicht möglich ist.

Es läßt sich zeigen, daß für Modelle der ersten Klasse die Bestimmung der Modellparameter nach dem Kleinstquadratkriterium äquivalent ist zu der Lösung eines entsprechenden Gleichungssystems, bei dem die Anzahl der linear unabhängigen Gleichungen

gleich der Anzahl der unbekannten Parameter ist. D.h. man kann einen Algorithmus

zur Anwendung bringen, der die Lösung des Problems der Parameterbestimmung garantiert und impliziert, daß die gefundene Lösung die beste Lösung ist. Im Fall von

Modellen der zweiten Klasse ist dies nicht so: hier müssen Optimierungsstrategien zur

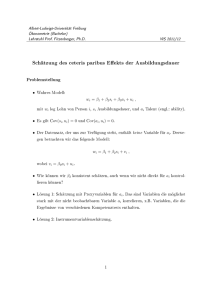

Anwendung kommen, die keine sichere Auskunft darüber geben können, ob die gefundene Lösung auch die beste ist. Abbildung 1 zeigt verschiedene Formen der Funktion

ϕ.

1.2

Lineare Regression

Wir betrachten im folgenden als Modell ein Polynom erster Ordnung

ybi = a0 + a1 x.

(5)

Einsetzen in (4) ergibt

N

X

(yi − (a0 + a1 xi ))2 = min

i=1

Wir setzen

F =

N

X

(yi − (a0 + a1 xi ))2

i=1

2

(6)

Gerade

Parabel

Y

Y

100

200

175

Yˆ = a0 + a1 X + a2 X 2

80

150

125

60

100

40

75

Yˆ = a0 + a1 X

50

20

25

5

10

15

20

25

30

5

35

10

15

Exponential modifiziert

Y

25

30

35

30

35

Hyperbel

Y

100

100

80

80

60

60

40

20

X

X

Yˆ =

1

a0 + a1 X

40

Yˆ = a ⋅ b X + c

20

20

5

10

15

20

25

30

5

35

10

15

20

25

X

X

Abbildung 1: Veranschaulichung verschiedener gebräuchlicher Funktionen zur Erklärung von Merkmalszusammenhängen (zwei Variablen X, Y ).

und bilden die partiellen Ableitungen nach den beiden gesuchten Parametern a0 und

a1 mit Hilfe der Kettenregel. Für die Ableitung nach a0 erhält man

∂F

∂a0

= 2

N

X

(yi − a0 − a1 xi ) · (−1)

i=1

N

X

= −2

yi + 2N · a0 + 2a1

i=1

N

X

xi .

i=1

Wir setzen dies gleich Null und erhalten über

0=−

N

X

yi + N · a0 + a1

N

X

i=1

xi

i=1

die erste Gleichung

N

X

yi = N · a0 + a1

i=1

N

X

i=1

3

xi .

(7)

Dies definiert in der Tat ein Minimum, denn für die zweite Ableitung erhalten wir

∂2F

= 2N,

∂a20

was größer Null ist. Für die zweite Gleichung bilden wir

N

X

∂F

=2

(yi − a0 − a1 xi ) · (−xi )

∂a1

(8)

i=1

was nach Nullsetzen

0 = −2

N

X

xi yi + 2a0

N

X

xi + 2a1

N

X

i=1

i=1

x2i

(9)

i=1

auf die zweite Gleichung

N

X

xi yi = a0

i=1

N

X

xi + a1

i=1

N

X

x2i

(10)

i=1

führt. Auch hier verifiziert man die Existenz des Minimums über

N

X

∂2F

=

2

x2i .

∂a21

i=1

Damit hat man das System

N

X

yi = a0 · N + a1

i=1

N

X

N

X

i=1

i=1

N

X

xi

(11)

i=1

xi yi = a0

xi + a1

N

X

x2i .

(12)

i=1

welches als erste und zweite Normalgleichung bekannt ist. Man sieht, daß man das

System nach den Koeffizienten a0 und a1 auflösen kann und daher die Koeffizienten

aus den empirisch ermittelbaren Summenausdrücken ermitteln kann. Stellt man die

Gleichung (11) um, erhält man für a0

a0 =

N

N

1 X

1 X

yi − a1

xi .

N

N

i=1

(13)

i=1

Um jetzt a1 in einer Gleichung ohne Bezug auf a0 zu ermitteln, macht man am

bequemsten von (9) Gebrauch und setzt dort (13) ein:

Ã

! N

N

N

N

N

X

X

X

1 X

1 X

0=−

xi yi +

yi − a1

xi

xi + a1

xi2 .

N

N

i=1

i=1

i=1

4

i=1

i=1

Das ergibt

ÃN

!2

N

N

N

X

1 X X

1 X

2

xi yi −

yi

xi = a1

xi − a1

xi

N

N

i=1

i=1

i=1

i=1

i=1

ÃN

!2

N

N

N

N

X

X

X

X

X

1

1

yi

xi = a1

x2i −

⇔

xi yi −

xi

N

N

N

X

i=1

i=1

und endlich

i=1

i=1

PN

a1 =

i=1 xi yi

1

N

−

PN

2

i=1 xi

−

PN

i=1

PN

i=1 yi

1

N

(14)

i=1 xi

´2

N

x

i

i=1

(15)

³P

für den Steigungskoeffizienten a1 . Dieser Ausdruck läßt sich auf eine bekannte Form

bringen. Wir teilen Zähler und Nenner durch N und erhalten

a1 =

1

N

PN

i=1 xi yi

1

N

−

PN

1

N

2

i=1 xi −

PN

³

PN

1

i=1 yi N

1

N

i=1 xi

PN

i=1 xi

(16)

´2

Es ist aus der Momentenschreibweise bekannt, daß

N

1 X 2

2

2

V ar (x) = x − x =

xi −

N

i=1

Ã

N

1 X

xi

N

!2

i=1

ist, also ist der Nenner von (16) gleich V ar (x). Weiter kann man die Covarianz wie

folgt definieren

Cov (x, y) =

=

N

1 X

(xi − x)(yi − y)

N

1

N

i=1

N

X

i=1

N

N

1 X 1 X

xi yi −

xi

yi

N

N

i=1

(17)

i=1

= xy − x · y.

Dann ist der Zähler von (16) also Cov (x, y) . Also folgt:

a1 =

Cov (x, y)

V ar (x)

(18)

Damit sind die beiden Parameter der Polynoms erster Ordnung, der Geraden, bestimmt. Nach (13) ist ja

a0 = y − a1 · x

(19)

und man hat die gesuchten Parameter, indem man die Mittelwerte, die Varianz von

x und die Covarianz der Variablen berechnet.

5

1.2.1

Erklärte Varianz und Modellgüte der linearen Regression

Um die Modellgüte der linearen Regression zu ermitteln, betrachte man zunächst die

Zerlegung für Abweichungswerte:

yi − y = (yi − ybi ) + (b

yi − y)

(20)

Eine Abweichung vom Mittelwert der Variable y wird also zerlegt in die Summe

aus der Abweichung vom Vorhersagewert (d.h. einen Vorhersagefehler ei = yi − ybi )

und der Distanz von Vorhersagewert und Mittelwert. Die Gültigkeit dieser Beziehung

veranschaulicht man sich anhand Abbildung 2.

^

Y

Y

^

pp

Yi

Y

^

ei = Yi - Yi

^

Yi - Y

a

0

X

Xi

X

Abbildung 2: Veranschaulichung der Zerlegung von Abweichungswerten in der linearen Regression.

Nun bilde man die Summe der Abweichungsquadrate

N

X

2

(yi − y)

=

i=1

=

N

X

i=1

N

X

((yi − ybi ) + (b

yi − y))2

(yi − ybi )2 +

i=1

N

X

i=1

(b

yi − y)2 + 2

N

X

(yi − ybi ) · (b

yi − y)

i=1

Für yb setze man nun das lineare Modell ein. Wir betrachten nur den Kreuzterm auf

der rechten Seite:

N

X

i=1

(yi − ybi ) · (b

yi − y) =

N

X

(yi − a0 − a1 xi ) · (a0 + a1 xi − y)

i=1

Um diesen Ausdruck zu vereinfachen, verwenden wir einen Trick. Wir bilden für den

Summenterm auf der rechten Seite drei Summenterme, indem wir jedes Klammerele-

6

ment der letzten Klammer einzeln in die Summe multiplizieren und erhalten

N

X

(yi − ybi )·(b

yi − y) = a0

i=1

|

N

X

(yi − a0 − a1 xi ) + a1

i=1

{z

}

N

X

|

xi (yi − a0 − a1 xi ) − y

i=1

{z

T erm1

}

|

T erm2

N

X

i=1

(yi − a0 − a1 xi )

{z

T erm3

(21)

Dieser Ausdruck läßt sich jetzt mit Hilfe der 1. und 2. Normalgleichungen bewerten.

P

PN

PN

Es gilt für Term1 N

i=1 (yi − a0 − a1 xi ) =

i=1 yi −N ·a0 −a1

i=1 xi = 0 wegen der

ersten Normalgleichung. Also ist Term 1 und Term 3 gleich 0. Weiter ist aber wegen

P

PN

PN 2

der 2. Normalgleichung N

i=1 xi yi − a0

i=1 xi − a1

i=1 xi = 0, damit ist auch Term

2 gleich Null. Es folgt

N

X

(yi − ybi ) · (b

yi − y) = 0

(22)

i=1

und damit folgt für die gesamte Zerlegung der quadratischen Abweichungen

N

X

(yi − y)2 =

i=1

N

X

(yi − ybi )2 +

i=1

N

X

(b

yi − y)2 .

(23)

i=1

Multipliziert man das mit 1/N resultiert

N

N

N

1 X

1 X

1 X

2

2

(yi − y) =

(yi − ybi ) +

(b

yi − y)2 ,

N

N

N

i=1

i=1

i=1

oder kurz

V ar (y) = V ar (e) + V ar (b

y) .

(24)

Dies ist die Varianzzerlegung der linearen Regression: die Varianz des Kriteriums

y wird zerlegt in die Summe aus Fehlervarianz und Varianz der Vorhersagewerte

(Schätzvarianz). Die Fehlervarianz ist offenbar die Variation der Meßwerte y um die

Gerade, die Schätzvarianz ist die Variation der Werte auf der Geraden um den Mittelwert y.

Kennkoeffizienten Durch die Regressionsgerade ist dem Mittelwert x offensichtlich der Mittelwert y zugeordnet:

yi = a0 + a1 x

y0 = a0 + a1 x

= y − a1 x + a1 x

=⇒ y0 = y.

Daher muß gelten ybi − y = a1 (xi − x), was man sich auch anhand des Steigungsdreiecks in Abb. 2 leicht veranschaulicht. Daraus folgt

N

N

X

1 X

2

2 1

(b

yi − y) = a1

(xi − x)2

N

N

i=1

i=1

7

}

oder

V ar (b

y ) = a21 · V ar (x) .

(25)

Teilt man Gleichung (24) durch V ar (y), erhält man

1=

V ar (e) V ar (b

y)

+

V ar (y) V ar (y)

(26)

was besagt, daß sich die Anteile der Fehlervarianz und der Schätzvarianz an der

Gesamtvarianz zu 1 addieren (komplementär sind). Für den Anteil der Schätzvarianz

an der Gesamtvarianz läßt sich ein einfach zu berechnender Koeffizient herleiten.

Ersetzt man in (26) V ar (b

y ) gemäß (25), erhält man

1=

V ar (e)

V ar (x)

+ a21

V ar (y)

V ar (y)

(27)

Also gilt mit (18)

1−

V ar (e)

V ar (y)

=

=

Cov 2 (x, y) V ar (x)

V ar2 (x) V ar (y)

Cov 2 (x, y)

V ar (x) V ar (y)

Man definiert nun

r2 = 1 −

V ar (e)

V ar (b

y)

Cov 2 (x, y)

=

=

V ar (y)

V ar (y)

V ar (x) V ar (y)

(28)

den sog. Determinationskoeffizienten r2 . Er gibt den Anteil der Schätzvarianz (durch

das Modell erklärte Varianz) an der Gesamtvarianz an. Die Definition des Determinationskoeffizienten ist eine direkte Folge der additiven Varianzzerlegung (24).

Die Fehlervarianz beschreibt die Variation der Meßwerte y um die Vorhersagewerte

yb. Es gilt

V ar (e)

r2 = 1 −

V ar (y)

¡

¢

⇔ V ar (e) = 1 − r2 · V ar (y)

und damit

se = sy

p

1 − r2 .

(29)

(30)

(31)

Dies definiert den Standardschätzfehler in der linearen Regression. Er ist definiert als

√

Anteil an der Streuung des Kriteriums, der zulasten der ”Unzuverlässigkeit” 1 − r2

geht (Ist r2 = 1, folgt se = 0). Hieraus gewinnt man noch eine weitere Beziehung. Es

ist mit (30)

V ar (e) =

¡

¢

1 − r2 · V ar (y)

8

Cov 2 (x, y)

V ar (y)

V ar (x) V ar (y)

Cov 2 (x, y) V ar (x)

= V ar (y) −

V ar (x) V ar (x)

2

V ar (y) − a1 · V ar (x) .

= V ar (y) −

1.2.2

(32)

Lineare Regression von X aus Y

Man kann natürlich auch die Variable X aus der Variablen Y vorhersagen:

x

b = a00 + a01 · y

(33)

Man optimiert dann die Abweichungen in x- Richtung nach dem Kleinstquadratkriterium. Man erhält dann als Normalgleichungen

N

X

xi =

a00

·N +

i=1

N

X

N

X

i=1

i=1

xi yi = a00

a01

yi +

N

X

yi

i=1

N

X

a01

yi2 .

i=1

und daraus

Cov (x, y)

V ar (y)

= x − a01 · y.

a01 =

(34)

a00

(35)

Die beiden Geraden schneiden sich im Punkt (x, y).

1.2.3

Lineare Regression bei Abweichungswerten

Verwendet man Abweichungswerte oder z- standardisierte Werte, lassen sich die Ausdrücke für die Koeffizienten bei der linearen Regression weiter vereinfachen. Man

definiere zunächst Abweichungswerte

ui = xi − x

v i = yi − y

und bestimme

vbi = α · ui + β.

Es gilt nun

β = v−α·u

Cov (u, v)

α =

V ar (u)

9

(36)

Da aber v = u = 0 gilt (die Summe der Abweichungen vom Mittelwert ist Null), folgt

β = 0, d.h. die Gerade geht durch Null. Durch die Verwendung von Abweichungswerten hat den ”Schwerpunkt” der Punktwolke sozusagen auf den Nullpunkt gelegt.

Weiter findet man

N

1 X

(ui − u)(vi − v)

N

Cov (u, v) =

1

N

=

1

N

=

i=1

N

X

i=1

N

X

ui · vi

(xi − x)(yi − y)

i=1

= Cov (x, y)

(37)

und entsprechend

V ar (u) =

N

1 X

(ui − u)2

N

i=1

N

X

=

1

N

=

N

1 X

(xi − x)2

N

u2i

i=1

i=1

= V ar (x)

(38)

Damit folgt

α = a1

d.h, die Steigungskoeffizienten der Regression unter Verwendung der Ausgangswerte

x und unter Verwendung von Abweichungswerten u sind gleich, der Schnittpunkt ist

aber bei Abweichungswerten immer gleich Null:

vbi = a1 · u.

(39)

Bei z- standardisierten Werten findet man

zxi

=

zyi

=

ui

xi − x

=

sx

sx

yi − y

vi

=

sy

sy

d.h. z- Werte sind über eine Konstante skalierte Abweichungswerte, daher gilt die

Regressionsgleichung

zbyi = αz · zxi

10

(40)

und man muß nur den Steigungskoeffizienten bestimmen. Für diesen gilt wieder

αz =

Cov (zx , zy )

V ar (zx )

bzw. wegen V ar (zx ) = V ar (zy ) = 1

αz = Cov (zx , zy )

(41)

Für die Covarianz von z- Werten ergibt sich dann

Cov (zx , zy ) =

N

1 X

(zxi − z x )(zyi − z yi )

N

i=1

N

X

=

1

N

=

N

1 X (xi − x)(yi − y)

N

sx · sy

zxi zyi

i=1

i=1

= rxy .

(42)

Der Koeffizient rxy heißt Produkt-Moment-Korrelationskoeffizient, er ist die vorzeichenbehaftete Wurzel aus dem Determinationskoeffizienten. Die Regressionsgleichung

bei z- Werten lautet also vereinfacht

zbyi = rxy · zxi .

(43)

Bei z- Werten muß also nur der Produkt-Moment-Korrelationskoeffizient rxy berechnet werden.

1.2.4

Der Produkt-Moment Korrelationskoeffizient rxy

Der Produkt-Moment Korrelationskoeffizient charakterisiert die lineare Beziehung

zwischen den Variablen X und Y , und ist gegenüber linearen Transformationen invariant. Die Beziehung (42) zeigt ja rxy = Cov (zx , zy ) = rzx zy . Allgemein gilt, wenn

man die Variablen X und Y gemäß X 0 = a1 X + b1 , Y 0 = a2 Y + b2 transformiert

rx0 y0

=

Cov (x0 , y 0 )

sx0 sy0

=

N

1 X (a1 xi + b1 − a1 x − b1 )(a2 yi + b2 − a2 y − b2 )

N

a1 sx · a2 sy

=

N

1 X (a1 (xi − x))(a2 (yi − y))

N

a1 sx · a2 sy

i=1

i=1

=

N

a1 a2 X (xi − x) (yi − y)

= rxy .

N a1 a2

sx · sy

i=1

11

(44)

Der Korrelationskoeffizient bleibt also derselbe, wenn man die Variablen einer linearen

Transformation unterzieht (wie es ja auch bei der z- Transformation der Fall ist). Um

den Produkt-Moment Korrelationskoeffizienten anschaulich zu deuten, ist es hilfreich,

eine Zwischenbetrachtung über Vektoren einzuschieben, die die Wertebeschränktheit

des Koeffizienten und den Zusammenhang mit der Güte der Anpassung der linearen

Gleichung an die Daten verständlich macht.

Komponente, Projektion und inneres Produkt von Vektoren

Wir denken uns einen Vektor ~v , den wir mit Hilfe des kartesischen Koordinatensystems darstellen (s. Abbildung 3). Offenbar gilt für die Komponente des Vektors ~v in

ex

=1

ur

u

=1

ur

u

r

v

= v x + v y = v x ex + v y e y

uur

ur

u

ur

u

ur

u

ur

u

ey

ur

u

ex

y2

ey

r

v

ur

u

vy

y1

ur

u

vx

= v x2 + v 2y

v x = x2 - x1

v y = y2 - y1

r

v

x2

x1

Abbildung 3: Veranschaulichung eines Vektors ~v im kartesischen Koordinatensystem.

Die Koordinaten des Vektors in x- und y- Richtung erhält man über die rechtwinkligen

Projektionen auf die entsprechenden Achsen. Die Länge des Vektors ist über den Satz

des Pythagoras gegeben (s. rechter grauer Kasten). Der Vektor ~v wird dargestellt

über die Addition der Vektoren ~vx und ~vy . Diese sind wiederum die um den Faktor

vx bzw. vy skalierten orthogonalen Einheitsvektoren ~ex bzw. ~ey (s. grauer Kasten

rechts oben). Also kann der Vektor dargestellt werden über eine Linearkombination

der orthogonalen Einheitsvektoren, wir im oberen grauen Kasten gezeigt.

X- Richtung ax = x2 − x1 in Y- Richtung ay = y2 − y1 . Dann ergibt sich die Länge

des Vektors nach dem Satz des Pythagoras:

q

k~v k = a2x + a2y .

12

(45)

Stellen wir uns vor, daß zwischen x1 und x2 ein Vektor ~vx liegt, so ist dieser offensichtlich dadurch gegeben, daß man den Fußpunkt und die Spitze von ~v rechtwinklig

auf die X- Achse projiziert. Eine analoge Betrachtung kann man zu dem Vektor ~vy

anstellen (s. Abbildung 3). Der Vektor ~v ist nun anschaulich darüber gegeben, daß

man den Fußpunkt von ~vy an die Spitze von ~vx legt (anschauliche Addition). Es ergibt

sich dann ein Vektordreieck. Man kann nun 2 Vektoren ~u und ~v betrachten. Wir legen

den Fußpunkt von ~v an den Fußpunkt von ~u und fragen nach einem neuen Vektor

~vu , der Projektion von ~v in Richtung des Vektors ~u (s. Abbildung 4). Wir erstellen

u

cos a

u

v

a

u

v

=

=

Ankathete

Hypothenuse

cos a

u

v

=

v

v

v

Abbildung 4: Projektion eines Vektors ~v auf einen Vektor ~u.

diesen Vektor zeichnerisch, indem wir von ~v auf ~u rechtwinklig projizieren. Die Länge

des Vektors ~vu können wir mit den trigonometrischen Funktionen am rechtwinkligen

Dreieck bestimmen. Man beachte, daß ~v und ~u den Winkel α einschließen. Es ist

cos (α) =

k~vu k

Ankathete

=

Hypothenuse

k~v k

(46)

und damit gilt für die Längen der Vektoren

k~vu k = cos (α) · k~v k .

(47)

Dies definiert die Länge der Projektion von ~v auf ~u als Anteil der Länge von ~v , denn die

Cosinusfunktion kann nur Werte zwischen −1 und 1 annehmen. Die Projekton ~vu ist

also immer kürzer oder gleich lang wie der Vektor ~v selbst (negative Werte resultieren

für 90 < α < 270, der Vektor ~v zeigt dann anteilig stärker in die entgegengesetzte

Richtung von ~u).

Man definiert nun das Produkt der Längen zweier Vektoren in derselben Richtung

(Produkt gleichgerichteter Längen, inneres Produkt)

h~v , ~ui = k~v k · k~uk · cos (α)

(48)

Das innere Produkt ist offenbar kommutativ (h~v , ~ui = h~u, ~v i), da es ja nur auf den

eingeschlossenen Winkel ankommt. Es ist ferner distributiv, i.e. h~v , ~u + wi

~ = h~v , ~ui +

h~v , wi

~ .

13

Wir halten zwei Sonderfälle fest:

1. Stehen zwei Vektoren senkrecht aufeinander (sog. Orthogonalität, α = 90), so

ist ihr inneres Produkt gleich Null (sie haben keine gemeinsame Länge);

2. Sind zwei Vektoren gleichgerichtet (kollinear, α = 0), so ist ihr inneres Produkt

gleich dem Produkt ihrer Längen (maximale gemeinsame Länge).

Zum inneren Produkt betrachten wir ein Beispiel.

Aus der Physik kennen wir die Beziehung Arbeit = Kraft mal Weg, d.h. Arbeit ist die

Kraft, die in Richtung des Weges geleistet wird. An einem Wagen ziehe jemand an

einer Schnur mit der Kraft F~ = 10 Newton und bewege dabei den Wagen um ~s = 20

Meter weiter. Die Schnur hat dabei einen Winkel von α = 75 zur Wegrichtung. Wieviel

Arbeit wurde geleistet?

D

W

=

E ° °

° °

F~ , ~s = °F~ ° · k~sk · cos (75)

= 10N · 20m · 0.259 = 51.76 N m

Wir betrachten nun die unanschauliche Darstellung des inneren Produktes in der

Komponentenschreibweise. Abbildung 3 veranschaulicht ebenfalls die Auffassung des

kartesischen Koordinatensystems über orthogonale Einheitsvektoren (orthogonale Vektoren der Länge 1, s. oberer rechter grauer Kasten). Offenbar gilt

h~ex , ~ex i = 1

h~ex , ~ey i = 0 = h~ey , ~ex i

h~ey , ~ey i = 1.

Nun kann man die Vektoren ~v und ~u als gewichtete Summe (Linearkombination)

der orthogonalen Einheitsvektoren ~ex , ~ey ausdrücken: Beispielsweise ist der Komponentenvektor von ~vx gegeben über die Multiplikation des Einheitsvektors ~ex mit der

Koordinatenzahl vx . Es gilt ~vx = vx · ~ex . Legt man nun den Vektor ~vy = vy · ~ey an die

Spitze von ~vx , resultiert ~v . Wir schreiben also

~v = ~vx + ~vy = vx · ~ex + vy · ~ey

~u = ~ux + ~uy = ux · ~ex + uy · ~ey

Für die Definition eines Vektors relativ zu einem rechtwinkligen Koordinatensystem

reicht es offenbar aus, das Tupel der Koordinatenzahlen anzugeben: ~v = (vx , vy ).

14

Definition 1 Unter der Koordinatendarstellung eines Vektors ~v versteht man die

Definition in Bezug auf ein rechwinkliges Koordinatensystem, wobei man ein N- stelliges Zahlentupel angibt, welches die Koordinatenzahlen des Vektors in Bezug auf die

N- Koordinatenachsen enthält ~v = (v1 , v2 , . . . , vN ) .

Für das innere Produkt gilt damit

h~v , ~ui = hvx · ~ex + vy · ~ey , ux · ~ex + uy · ~ey i

= vx ux h~ex , ~ex i + vx uy h~ex , ~ey i + vy ux h~ey , ~ex i + vy uy h~ey , ~ey i

(49)

= vx u x + vy u y .

Definition 2 Das innere Produkt zweier Vektoren ist die Summe der Produkte der

Komponenten, die gleiche Richtung haben.

Allgemein gilt für mehr als zwei Koordinatenachsen

h~v , ~ui =

N

X

vi ui

(50)

i=1

und damit folgt für die Beziehung zur Vektorlänge k~v k

h~v , ~v i =

N

X

vi2 = k~v k2

(51)

i=1

Zum Beispiel: ~v = (−1, 0, 4) , ~u = (2, 3, 1). h~v , ~ui = −1 · 2 + 0 · 3 + 4 · 1 = 2.

Die vektorielle Deutung des Produkt-Moment Korrelationskoeffizienten

Wir machen nun die die folgenden Schritte:

1. Für die Variablen X und Y berechne man Abweichungswerte ui = xi − x, vi =

yi − y.

2. Man betrachte die Ensembles der Abweichungswerte als Zufallsvektoren

~u = (u1, u2 , . . . , uN )

~v = (v1, v2 , . . . , vN ) ,

die Abweichungswerte sind ihre Koordinaten.

Wenn die Abweichungswerte die Koordinaten repräsentieren, haben wir offenbar die

beiden Variablen als Vektoren in einem Raum dargestellt, der durch die N- Meßobjekte, dies sind ja in der Psychologie meist Personen, aufgespannt wird. Deshalb spricht

15

man von einer Darstellung der Variablen im Personenraum. Die Covarianz und die

Varianzen werden hier

Cov (x, y) =

V ar (x) =

(52)

1

N

1

N

V ar (y) =

Damit ist die Korrelation

N

1 X

1

ui vi =

h~u, ~v i

N

N

i=1

N

X

i=1

N

X

u2i =

1

k~uk2

N

(53)

vi2 =

1

k~v k2

N

(54)

i=1

PN

rxy = qP

N

i=1 ui vi

PN

2

=

2

i=1 vi

i=1 ui

h~u, ~v i

k~uk k~v k

(55)

Da nach (48) die Beziehung h~v , ~ui = k~v k · k~uk · cos (α) gilt, folgt

rxy =

h~u, ~v i

= cos (~u]~v )

k~uk k~v k

(56)

Definition 3 Die Korrelation zweier Variablen entspricht dem Cosinus des Winkels

der Vektoren, die die Variablen im Personenraum repräsentieren.

Aus dieser Definition kann man folgendes schließen:

1. Der Korrelationskoeffizient liegt in dem Werteintervall −1 ≤ rxy ≤ 1.

2. Ist rxy = 0, so bedeutet dies, daß die beiden Zufallsvektoren ~u, ~v aufeinander

senkrecht stehen (zueinander orthogonal sind). Sie haben nichts an Richtung

gemeinsam. Offenbar erfassen die Variablen X und Y völlig unterschiedliche

Merkmale.

3. Ist rxy = 1, so gilt h~u, ~v i = k~uk k~v k . Dies bedeutet, daß die beiden Zufallsvektoren auf einem Strahl liegen und in dieselbe Richtung zeigen. Man erhält den

einen Vektor, indem man den anderen mit einem Skalar multipliziert (Lineare Abhängigkeit zweier Vektoren). Die Variablen X und Y erfassen dasselbe

Merkmal.

4. Ist rxy = −1, so gilt h~u, ~v i = − k~uk k~v k . Dies bedeutet, daß die beiden Zufallsvektoren auf einem Strahl liegen und in entgegegesetzte Richtung zeigen.

Man erhält den einen Vektor, indem man den anderen mit einem negativen Skalar multipliziert (Lineare Abhängigkeit zweier Vektoren). Sie erfassen dasselbe

Merkmal, eine Variable kodiert aber positive Abweichungen vom Mittelwert

in der anderen als negative und umgekehrt. Die Variablen X und Y erfassen

dasselbe Merkmal.

16

5. Gilt −1 < rxy < 0 oder 0 < rxy < 1, so haben die Vektoren ~u, ~v mehr oder weniger an Richtung gemeinsam, je nach Höhe der Korrelation. Man erhält nicht den

einen Vektor, indem man den anderen mit einem Skalar multipliziert (Lineare

Unabhängigkeit zweier Vektoren). Die Korrelation rxy gibt genau den Anteil des

Produktes gleichgerichteter Längen an dem maximal möglichen Produkt gleichgerichteter Längen an (Man veranschauliche sich dies über die entsprechenden

Flächen). Quadriert man rxy , erhält man den Anteil gleicher Richtungsvarianz

an der gesamten Varianz.

Für z- standardisierte Variablen gilt ja zy = rxy · zx . Man kann daher die Höhe

des Korrelationskoeffizienten direkt an der Steigung der Regressionsgeraden für zstandardisierte Variablen ablesen. Bei perfekter Korrelation liegen alle Punkte auf

der Geraden und die Gerade hat eine Steigung von 1 (die Winkelhalbierende), entsprechendes gilt für perfekte negative Korrelation (Steigung ist -1). Bei fehlender

Korrelation ergibt sich eine kreisförmiger Punkteschwarm und die Regressionsgerade

ist die zx Achse. Abbildung 5 veranschaulicht die beiden Darstellungsweisen über den

eingeschlossenen Winkel der Meßvektoren und über das Scattergramm.

Es sei angemerkt, daß es bei der linearen Regression um einen linearen Zusammenhang zwischen Variablen geht. Insbesondere kann aus dem Fehlen eines linearen

Zusammenhanges (rxy = 0) nicht auf das Fehlen irgendeines deterministischen Zusammenhanges zwischen den Variablen geschlossen werden. Beispielsweise ergeben

kurvilineare Zusammehänge stets Korrelationen um Null, obwohl sie deterministisch

sind, was man sich anhand des Parabelbeispiels rasch veranschaulichen kann. Die

Angemessenheit des linearen Ansatzes ist also stets zu prüfen.

1.3

Korrelation bei nicht metrischen Skalenniveaus

Zusammenhangsmaße, die der Produkt-Moment Korrelation verwandt sind, können

ebenfalls bei Variablen, die nur auf niedrigeren Skalenniveaus gemessen werden können,

bestimmt werden.

1.3.1

Zusammenhang von dichotomen Merkmalen

Psychometrische Tests bestehen häufig aus Aufgaben, die mit ”Ja” oder ”Nein” zu

beantworten sind. Kodiert man die Fragebeantwortung für alle Personen, erhält man

einen B inärvektor, einen Vektor, der nur Nullen und Einsen enthält. hnlich verhält es

sich bei Items in Intelligenztests, die entweder gelöst oder nicht gelöst werden können.

17

Scattergramm

Meßvektoren

a)

r >

0

u

Y

a

v

X

X

b)

Y

a

u

v

r <

0

X

X

c)

u

Y

r

a

=0

v

X

X

Abbildung 5: Vergleich der Darstellung von Variablenzusammenhängen durch Scattergramm (linke Graphiken) und eingeschlossenen Winkel der Meßvektoren (rechte

Graphiken). Fall a) veranschaulicht positive Korrelation der Variablen X und Y , b)

zeigt negative Korrelation, c) fehlende Korrelation.

Wir betrachten also den Fall, daß die Aufgaben binär kodiert sind:

(

1

(gelöst)

xij =

0 (nicht gelöst)

18

(57)

definiert den Wert für eine Person i auf dem Item (der Aufgabe) j. Man kann nun

Kennwerte auch für die einzelnen Aufgaben definieren. Die Itemschwierigkeit ist definiert als

pj =

1 X

xij ,

N

(58)

i

also als ein Itemmittelwert über binäre Daten (=Anteil der Personen, die die Aufgabe

lösen). Ebenso kann man die Varianz einer einzelnen Aufgabe betrachten. Mit der

Formel für die Varianz gilt

s2j =

1 X

(xij − pj )2

N

i

= pj + p2j − 2p2j

= pj − p2j

= pj (1 − pj )

= pj · qj

(59)

für die Varianz einer einzelnen Aufgabe. Diese ist maximal für pj = qj . Wir interessieren uns nun für den Zusammenhang einer Aufgabe k mit einer Aufgabe j. Das

heißt, wir wollen wissen, ob ein Kandidat, der Aufgabe k löst, wahrscheinlich auch

Aufgabe j löst oder nicht. Analog zur Produkt-Moment Korrelation müssen wir noch

betrachten, wie sich die Covarianzen von Binärdaten darstellen. Dazu betrachte man

folgende Vierfeldertafel (obere Werte absolute, untere Werte relative Häufigkeiten):

Aufgabe k

Aufgabe j

+

P

P

-

+

A

B

A + B = Z+

a

b

a + b = pj

C

D

C + D = Z−

c

d

c + d = qj

A + C = SP−

B + D = SP+

N

a + c = qk

b + d = pk

1

Abbildung 6 veranschaulicht den Gedankengang bei der Betrachtung von 4- Felder

Häufigkeitsverteilungen aus zugrundeliegenden metrischen Regressionsdaten.

Die Covarianz ist definiert als

1 X

(xj − xj ) (xk − xk ) .

N

Wir lösen für Binärdaten auf und finden

P

P

P

xj xk

xj

xk

Cov (j, k) =

− xk

− xj

+ xj xk

N

N

N

= pjk − pk pj − pj pk + pj pk

Cov (j, k) =

= pjk − pj pk

19

(60)

Xj

0

Xk £ X k Ç Xj >X0j

0

0

Xk >X k Ç Xj >X j

01

11

0

X j

10

00

0

0

Xk £ X k Ç X j £ X j

0

0

Xk >X k Ç Xj £ X j

0

X k

Xk

Abbildung 6: Veranschaulichung des Grundgedankens bei der Herleitung des PhiKoeffizienten. Es existieren zwei metrische, aber latente Fähigkeitsdimensionen Xk

und Xj . Die Aufgabe k wird gelöst, wenn die Fähigkeit einer Person größer als der

Kriteriumswert X0k ist, andernfalls nicht. Für eine bestimme Stichprobe von Personen

heißt dies, daß nur ein bestimmter Prozentsatz die Aufgabe lösen wird (diejenigen mit

einem latenten Fähigkeitswert größer als der Kriteriumswert X0k ). Die theoretische

Schwierigkeit X0k einer Aufgabe erzwingt somit ein bestimmtes Wertepaar p, q. Man

kann analoge Betrachtungen zur Aufgabe j anstellen. Dann kann man das gemeinsame

Abschneiden der Personen in beiden Aufgaben als eine Vier-Felder Tafel darstellen,

wobei ”0”Scheitern und ”1”Lösen bedeutet. Im Denkmodell der latenten Variablen

entsprechen die Feldhäufigkeiten A,B,C,D der Vierfeldertafel also der Anzahl der

Meßpunkte, die hier im Scattergramm in den entsprechenden Quadranten verzeichnet

sind.

In unserer Vierfeldertafel entspricht pjk genau dem Anteil der Probanden, die beide

Aufgaben richtig lösen, also

P

xj xk

= b.

N

√

Da die Standardabweichung einer Aufgabe j gleich pj · qj ist, ist die Aufgabeninpjk =

terkorrelation

pjk − pj pk

rjk = rphi = √

.

pj qj · pk qk

(61)

Dies ist die Produkt-Moment Korrelation, angewendet auf Binärdaten, sie heißt Phi

- Koeffizient. Der Phi-Koeffizient kann auch direkt aus den Häufigkeiten ermitteln.

20

Wir schreiben ausführlich

rphi = q

B

N

Z+

N

−

·

A+B B+D

N

N

Z−

N

·

SP+

N

·

SP−

N

und erweitern mit N 2 :

rphi =

B · N − (A + B) (B + D)

√

.

Z+ · Z− · SP+ · SP−

Da N = A+B+C+D, ist der Zähler (BA + BB + BC + BD)−(AB + AD + BB + BD),

es bleibt

BC − AD

rphi = √

Z+ · Z− · SP+ · SP−

(62)

für den Phi- Koeffizienten, was die handlichere Formel ist. Nur wenn pj = pk ist,

also gleiche Schwierigkeiten vorliegen, kann der Phi-Koeffizient den maximalen Wertebereich von −1 ≤ rphi ≤ 1 umspannen. Liegen ungleiche Schwierigkeiten vor, muss

der Phi-Koeffizient durch die maximal mögliche Phi-Korrelation geteilt werden, damit der Wert vergleichbar zum Produkt-Moment Korrelationskoeffizienten ist. Phimax

berechnet sich wie folgt

r

P himax =

ps qt

· , wobei pt ≥ ps .

qs pt

(63)

Hierin ist pt die größte Randfeldproportion und ps die korrespondierende Randfeldproportion in der anderen Variable (wenn pt die z.B. Randhäufigkeit für die ”+”

Kategorie ist, dann muß ps die Randfeldproportion für ebenfalls die ”+” Kategorie

in der anderen Variable sein). Auch (63) kann man direkt aus den Randhäufigkeiten

erhalten, da N sich ja aus den Proportionen herauskürzt. Der korrigierte Wert ist

dann

rkorr =

rphi

.

P himax

(64)

Beispiel:

Wir haben die Häufigkeiten

Aufgabe k

Daraus errechnet sich

P

Aufgabe j

-

+

+

40

20

60

P

30

10

40

70

30

100

20 · 30 − 40 · 10

rphi = √

= .089

60 · 40 · 70 · 30

21

Der maximale Wert ist

r

.4 .3

· = .53

.6 .7

Dann errechnet sich der korrigierte Phi - Wert zu

P himax =

rkorr =

.089

= .168.

.53

Die zum P himax - Wert gehörige Häufigkeitstabelle sieht so aus:

Aufgabe k

1.3.2

P

Aufgabe j

-

+

+

30

30

60

P

40

0

40

70

30

100

Zusammenhang von dichotomen und intervallskalierten Merkmalen

Wir teilen die Stichprobe ein in die Gruppe, die die Aufgabe gelöst hat (x = 1) und

diejenigen, die sie nicht lösen konnten (x = 0) und betrachten deren mittleren Gesamttestscore y 1 , y 0 . Verbinden wir diese mir einer Linie, so wird diese die Steigung

b̂yx =

∆y

∆x

= (y 1 − y 0 ) haben, eine von Null verschiedene Steigung dieser Linie besagt,

da eine Korrelation von Aufgabenbeantwortung und Gesamtscore vorliegt. Abbildung

7 zeigt dies anschaulich.

Für die Geradensteigung im Falle der Produkt-Moment Korrelation gilt ja

sy

Cov (x, y)

= ryx

2

sx

sx

sx

= byx .

sy

byx =

⇒ ryx

Wir erhalten für die Korrelation der dichotomen Variable x mit der intervallskalierten

Variable y

sx

sy

(y 1 − y 0 ) sx

sy

y1 − y0 √

pq

sy

rpbis = b̂yx

=

=

(65)

Das bedeutet, da die punktbiseriale Korrelation aus dem Mittelwertsabstand der

Gruppen bei bekannter Aufgabenschwierigkeit p und bekannter Streuung sy der Gesamtgruppe berechnet werden kann. Verwendet man den Gesamtmittelwert y, wird

die Formel

rpbis =

y1 − y

sy

22

r

p

.

q

(66)

Y1

∆Y =

Y

Y1

−Y

0

α

Y0

tan

α=

∆Y

= Y −Y

∆X

1

0

X

1

0

∆X = 1- 0 = 1

Abbildung 7: Veranschaulichung der punkt-biserialen Korrelation. Die Korrelation

einer metrischen Variable Y mit einer dichotomen Variable X wird bestimmt durch

den Mittelwerteunterschied der beiden Gruppen mit den Merkmalen X = 0 und

X = 1 in der Variablen Y .

Mit der Annahme, da sich die latente Variable, die der Dichotomisierung zugrunde

liegt, normal verteilt, kann man die punktbiseriale Korrelation in die biseriale Korrelation überführen. Wir müssen für die Geradensteigung ja ∆y/∆x betrachten, ∆x

ist jetzt nicht 1, sondern ergibt sich folgendermaßen:

x1 − x0 = (x1 − x) + (x − x0 )

Die Differenzen entsprechen bei der Normalverteilung

(x1 − x) =

(x − x0 ) =

ω0

p

ω0

,

q

ω0 ist dort der Ordinatenabschnitt der Dichotomisierung von x, so daß

x1 − x0 =

=

=

=

ω0 ω0

+

p

q

q · ω0 + p · ω0

p·q

ω0 (p + q)

p·q

ω0

pq

23

(67)

(68)

ist. Damit ist

sx

sy

(y 1 − y 0 ) · p q sx

ω0

sy

rbis = b̂yx

=

Wegen der Annahme der Standardnormalverteilung (sx = 1) gilt

rbis =

(y 1 − y 0 ) · p q

,

sy

ω0

(69)

y1 − y p

.

sy ω0

(70)

in der alternativen Darstellung

rbis =

Für beide Korrelationen gilt

√

pq

rbis

=

.

rpbis

ω0

(71)

Der punktbiseriale Korrelationskoeffizient ist also konservativer, unterschätzt den

Wert von rbis auf einem weiten Schwierigkeitsbereich um ca. 25%. Anmerkung zur Ermittlung des Ordinatenwertes ω0 : Die zu (67) analoge Beziehung mit einem arbiträren

Wert x0 lautet ausführlich geschrieben im Falle der Normalverteilung

∂

∂x

F (x)|x0

,

1 − F (x0 )

x0 − x =

wobei F (x) die Verteilungsfunktion (theoretische kumulative relative Häufigkeitsfunktion)

ist und x0 der Wert auf der X- Achse, ab dem dichotomisiert wird. Da sich die theoretische relative Häufigkeitsfunktion ω (x) über

ω (x) =

∂

F (x)

∂x

(72)

ω (x0 )

.

1 − F (x0 )

(73)

auf die Verteilungsfunktion bezieht, ist

x0 − x =

Denn für einen Anteil p und sein Komplement q gilt ja

p = 1 − F (x0 )

(74)

q = F (x0 )

(75)

und man kann x0 über die inverse Operation

x0 = F −1 (q)

24

(76)

bestimmen. Diesen setzt man in ω (x) ein und erhält ω (x0 ) = ω0 , den gesuchten

Ordinatenabschnitt.

Aufgabenbeispiel:

13 Personen bearbeiten eine Vorform eines psychometrischen Einstellungstests, der

den Grad an autoritären Lebenseinstellungen feststellen soll. Der Test besteht aus

22 Fragen. Es soll verglichen werden, wie die Bearbeitung einer bestimmten Aufgabe

X mit dem Gesamtscore des Tests Y (Summenwert aller Aufgaben) korreliert. Ein

hoher Summenscore (viele Fragen in Richtung der Merkmalsrichtung beantwortet)

bedeutet hohen Grad an autoritären Lebenseinstellungen. Aus den Daten (s. Tabelle)

errechnet sich der punkt-biseriale Koeffizient zu

15.57 − 12.83 √

· .462 · .538

3.098

= .884 · .499 = .441.

rpbis =

X=0

X=1

1

13

18

2

12

12

3

9

15

4

10

15

5

17

12

6

16

18

Y1 =

15.57

Y0 =

12.83

sY

=

p

=

q

=

P

3.098

x/N = .538

1 − p = .462

19

7

Es besteht damit eine mäßig hohe sog. Item-total Korrelation, d.h. wenn man weiß,

ob eine Person die bestimmte Aufgabe gelöst hat, weiß man noch nicht so genau,

ob die Person zu der Gruppe der ”besseren” oder ”schlechteren” zählt. Man kann

aber annehmen, daß das Item X latent normalverteilt ist. Man prüfe nun, ob sich

durch Anwendung der biserialen Korrelation die Item- total Korrelation aufwerten

läßt. Der Ordinatenabschnitt ω0 ermittelt man mit Tabellenwerken folgendermaßen.

Da q = .462, schauen wir in der Tabelle der Verteilungsfunktion der Standardnormalverteilung (z.B. Bortz 1999 S. 768) denjenigen z- Wert nach, dem eine Fläche von

0.462 entspricht. Das ist mit kleinem Rundungsfehler etwa z0 = −0.1. Für diesen

Wert bestimmen wir mit einer Tabelle der Ordinaten der Standardnormalverteilung

(im Bortz ist das dieselbe) einen Ordinatenwert von ω0 = 0.397. Wir können jetzt in

(69) einsetzen und erhalten

15.57 − 12.83 .462 · .538

·

3.098

0.397

= .884 · .626 = .553.

rbis =

25

Das ist eine erhebliche Aufwertung, die Item- total Korrelation erweist sich nun als

ordentlich.

1.3.3

Zusammenhang bei ordinalskalierten Daten

Wir stellen uns vor, uns liegen von denselben Personen zwei Meßreihen vor, die aber

nur Rangskalendignität haben. Beispielsweise könnten wir einen die Punktwerte in

zwei Fragebögen (Anzahl der mit ”ja” beantworteten Items) so auffassen, wenn keine

weitere Skalierung gemacht wurde. Spearman hat den Produkt-Moment Korrelationskoeffizient auf Rangdaten angewendet und daraus eine sehr einfache Rechenformel

abgeleitet. Sie lautet

P

2

6· N

i=1 di

rs = 1 −

.

N (N 2 − 1)

(77)

Hierin ist di die Rangdifferenz der Person i in beiden Meßreihen. Ein Beispiel möge die

Anwendung von (77) verdeutlichen (Beispiel nach Siegel 1956). 12 Studenten haben

zwei Fragbögen bearbeitet, einen zur Erfassung autoritärer Einstellungen (X ) und

einen zum sozialen Statusstreben (Y ). Die Punktwerte in jedem Fragebogen werden

in eine Rangreihe (Rx , Ry ) gebracht und die Differenzen d in den Rangreihen werden

berechnet. Man hat die Tabelle

Es ergibt sich

PN

2

i=1 di

Student

X

Rx

Y

Ry

d

d2

A

82

2

42

3

1

1

B

98

6

46

4

2

4

C

87

5

39

2

3

9

D

40

1

37

1

0

0

E

116

10

65

8

2

4

F

113

9

88

11

2

4

G

111

8

86

10

2

4

H

83

3

56

6

3

9

I

85

4

62

7

3

9

J

126

12

92

12

0

0

K

106

7

54

5

2

4

L

117

11

81

9

2

4

= 52 und damit

rs = 1 −

6 · 52

= .82,

12 · 143

also eine recht hohe Korrelation der beiden Merkmale autoritärer Einstellung und

soziales Statusstreben. Liegen sog. Rangbindungen vor (mehrere Messungen werden

auf denselben Rangplatz abgebildet), sollte einfach die Produkt- Moment Korrelation

26

direkt auf die Rangdaten angewendet werden, da die einfache Rechenformel (77)

nicht mehr so genau ist. Bei Rangbindungen vergibt man nicht Rangplätze mehrfach,

sondern das arithmetische Mittel der Rangplätze, die die Daten in der natürlichen

Folge erhalten hätten. Eine kleine Beispieltabelle zeigt dies:

X

16

13

13

10

9

Rx

5

3.5

3.5

2

1

27