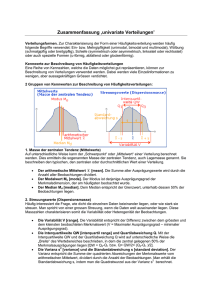

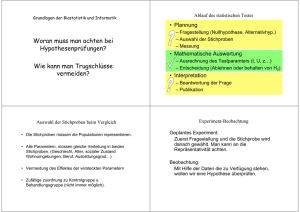

Kapitel 8 : Verteilungsfreie Tests In Kapitel 7 haben wir Stichproben

Werbung

– 133 –

Kapitel 8 : Verteilungsfreie Tests

In Kapitel 7 haben wir Stichproben = ( , , … , ) aus einer

Normalverteilung N(µ, σ2) studiert und Tests für den unbekannten

Parameter µ = E(Xk) konstruiert.

Oft ist jedoch wenig über die Verteilungsfunktion F(x) der Xk bekannt.

Insbesondere ist die Normalverteilungsannahme durch nichts

gerechtfertigt. In diesem Fall kann man weder den t-Test noch den

Gaußtest anwenden. Zur Vereinfachung nehmen wir an, daß die

unbekannte Verteilungsfunktion F(x) stetig ist, d.h. für unsere

Beobachtungen = (

, , … , ) gilt xj ≠ xk für j ≠ k.

Wir wollen zwei Tests zu dieser Situation vorstellen:

Beim ersten Test will man herausfinden, ob die Stichprobe „im Mittel“

größer (kleiner) als ein vorgegebener Wert m0 ist. Als Mittel der

Verteilung F(x) betrachtet man hier den Median mF , d.h. einen Wert

mit F(mF) = ½.

Beim zweiten Test vergleicht man zwei Stichproben = ( , , … , )

und = ( , , … , ) hinsichtlich FX(x) und FY(x).

Bei beiden Tests spielt der Typ von F(x) keine Rolle. Man spricht

deshalb von verteilungsfreien (oder auch nichtparametrischen) Tests.

§1 Der Mediantest (Vorzeichentest) (Ein – Stichproben – Test)

Es soll geprüft werden, ob die Stichprobe = ( , , … , ) im Mittel

größer (oder kleiner) als ein bestimmter Wert m0 ist. mF sei der Median

der (unbekannten) Verteilungsfunktion F(x) der Xk. Wir schätzen mF

durch den Median der Daten = (

, , … , ).

– 134 –

Rechtsseitiger Test :

H : m F = m0

gegen

K : mF > m 0

Linksseitiger Test :

H : mF = m 0

gegen

K : mF < m0

Als Teststatistik TM(x) bietet sich die Anzahl der Beobachtungen xk an,

die größer als m0 sind (d.h. die Anzahl der Differenzen xk – m0 mit

positivem Vorzeichen).

TM(x) = #{ j = 1, 2, . . ., n | xj > m0 } = Anzahl der j mit xj > m0.

Unter H : mF = m0

gilt

PF(Xj > m0) = ½.

⇒ Unter H : TM(x) =d B(n, ½).

1.1

Beim rechtsseitigen Test wird H : mF = m0

K : mF > m0

zugunsten von

für große Werte von TM(x) verworfen.

Für das Signifikanzniveau α ergibt sich der kritische Bereich :

Cα = { x | TM(x) ≥ Kα }, wobei Kα die kleinste natürliche Zahl ist,

∑ (, ½)() = ∑ 2– ≤ α.

sodaß

p – Wert :

p(x) = 2– ∑ () .

Für große n kann man Kα und p(x) mit Hilfe der Normalverteilung

approximieren :

B(n, ½) ≈ N(, ) ⇒ Kα ≈

Cα ≈ { x | TM(x) ≥

1.2

+

√

"

#–

};

+

p(x) ≈ 1 – Φ √

"

#–

%&–

√

.

Analog ergeben sich für den linksseitigen Test

H : m F = m0

gegen

K : mF < m 0 :

()

Cα = { x | TM(x) ≤ n – Kα } und p(x) = 2– ∑(

.

Für die Normalapproximation gilt :

Cα ≈ { x | TM(x) ≤

–

√

"

#–

};

p(x) ≈ 1 – Φ – ()

√

.

⇒

– 135 –

Beispiel 1.3 : Mit den klassischen Autoreifen einer Firma beträgt der

Bremsweg im Mittel (Median) m0 = 100 Meter. Für einen neuen Reifen

soll getestet werden, ob er besser als der klassische Reifen ist.

Es wurde deshalb folgender linksseitige Mediantest auf dem

Signifikanzniveau α = 0,05 durchgeführt :

H : mF = 100

gegen

K : mF < 100 .

Es wurden n = 8 Bremsversuche mit dem neuen Reifen gemacht.

∑)* ) 2–) =

∑). ) 2–) =

+*

+*

,%)*& + %).& + %))&/ =

,%).& + %))&/ =

)0

+*

)0)0

+*

≈ 0,145 > 0,05

und

≈ 0,0352 < 0,05 .

Also ist K0,05 = 7.

H wird verworfen, wenn TM(x) ≤ 8 – 7 = 1.

Als Daten ergaben sich:

j

1

2

3

4

5

6

7

8

xj

98,3

98,1

100,7

98,5

98,2

98,6

99,6

100,2

⇒ TM(x) = 2,

H kann also auf dem Niveau α = 0,05 nicht verworfen werden.

p(x) =

+*

∑( ) ≈ 0,145.

H kann also auf keinem vernünftigen Niveau verworfen werden.

§2 Der Wilcoxon – Test

(Zwei – Stichproben – Test)

2.1 Situation : Es soll getestet werden, ob von zwei unbekannten

Verteilungsfunktionen F2(x) besser ist als F1(x), im Sinne von

F2(x) ≤ F1(x) für alle x ∈ ℝ (da dann die Quantile von F2(x) größer

sind als diejenigen von F1(x)).

– 136 –

Es soll das wichtigste Testverfahren vorgestellt werden, das auf

sogenannten Rangsummen basiert.

Getestet wird :

2.2

H : F2(x) = F1(x)

gegen

K : F2(x) ≤ F1(x) , F2 ≠ F1 .

Wiederum seien F1(x) und F2(x) stetige Funktionen.

Man betrachte die unabhängigen Stichproben

= ( , , … , ) und = ( , , … , )

mit

Xj =d F1 und Yk =d F2.

Definition 2.3 : Als Rang der Beobachtung yj bezeichnet man die Anzahl

der Beobachtungen von , , … , und 2 , 2 , … , 2 , die kleiner oder

gleich yj sind, also

Rang(yj) = #{ i | xi ≤ yj } + #{ k | yk ≤ yj } und

Rang(xj) = #{ i | xi ≤ xj } + #{ k | yk ≤ xj } .

Rang(yj) = 1 bedeutet also, daß yj die kleinste Beobachtung ist, u.s.w.

Beispiel 2.4 : n = 3, m = 4, x = (8; 4,2; 3,5), y = (1; 19; – 4; 4,6)

Rang

1

2

3

4

5

6

7

Wert

–4

1

3,5

4,2

4,6

8

19

Herkunft

y3

y1

x3

x2

x1

y4

y2

Z.B. Rang(x2) = 4, Rang(y1) = 2.

Unter der Alternative K sind die Werte von Y tendenziell größer als die

von X. Das bedeutet, daß die Ränge der Beobachtungen von Y groß

sind. Als Maßzahl definieren wir die Summe der Ränge der y – Beobachtungen:

W(x, y) : = ∑

345(2 ).

W(x, y) wird oft auch Wilcoxon – Statistik genannt.

In Beispiel 2.4 ist W(x, y) = 1+ 2 + 6 + 7 = 16.

– 137 –

Bemerkung 2.5 : Die Verteilung der Wilcoxon – Statistik W(X, y) (bei

zufälliger Beobachtung X und fester Beobachtung y ) hängt unter H

nicht von der konkreten Verteilungsfunktion F1(x) ab. Daher kann man

mit ihrer Hilfe einen Test konstruieren, der immer das gewünschte

Niveau einhält, egal welches die zugrunde liegende Verteilung ist

(verteilungsfreier Test).

Die Verteilung von W(X, Y) unter H heißt Wilcoxon – Verteilung mit

den Parametern n und m , kurz Wiln,m .

Für kleine Werte von n und m sind die Quantile cn,m;β von Wiln,m

tabelliert. Meist findet man jedoch nicht cn,m;β selbst, sondern

un,m;β = cn,m;β –

(0)

,

die Quantile der sogenannten U – Statistik.

Für große n und m gibt es eine Normalverteilungsapproximation :

Satz 2.6 : (i) EH(W(X, Y)) = ½ n⋅m +

(0)

∙(00)

VarH(W(X, Y)) =

und

.

(ii) Unter H gilt für große n und m :

8 (, ) : =

7

9%:,;& –

⇒ cn,m; 1 – α ≈

Definition 2.7 :

<(=<=#)

∙<(=<=#)

>

#

(00)

d

≈ N(0, 1) .

+>

∙(00)

∙ ? – @ .

Der Wilcoxon – Test

H : F2(x) = F1(x)

gegen

K : F2(x) ≤ F1(x) , F2 ≠ F1

• verwirft H auf dem Niveau α , wenn

W(x, y) ≥ cn,m; 1 – α =

(0)

+ un,m; 1 – α .

– 138 –

• hat den p – Wert

8 (

, 2) , für große n, m .

p(x, y) = 1 – Wiln,m(W(x, y)) ≈ 1 – Φ 7

Beispiel 2.8 : Ein Bauer möchte herausfinden, ob ein neuer Dünger,

der gerade auf den Markt kommt, einen besseren Ertrag liefert, als sein

bisher benutzter.

Hierzu plant er eine Stichprobe von n = 8 Beobachtungen

= ( , , … , ) ) (Verteilung F1) mit seinem bisherigen Dünger und

eine Stichprobe von n = 10 Beobachtungen = ( , , … , ( )

(Verteilung F2) mit dem neuen Dünger.

Mit dem Wilcoxon – Test soll zum Niveau α = 0,05

H : F2(x) = F1(x)

gegen

K : F2(x) ≤ F1(x)

getestet werden.

Aus der Tabelle erhält man den Wert u8,10; 0,95 = 59 und berechnet

(((0)

C8,10; 0,95 = 59 +

= 59 + 55 = 114.

Zum Vergleich der Wert, den die Normalapproximation liefert :

z0,95 = 1,64485 ;

)∙(()0(0)

c8,10; 0,95 ≈ 1,64485 ⋅ >

+

(()0(0)

= 18,51 + 95 = 113,51.

Jetzt werden die Daten erhoben :

j

1

2

3

4

5

6

7

8

xj

105,7

95,3

85,4

102,6

98,1

97,1

104

102,4

und

j

yj

1

2

96,2 99,1

3

4

116

112

5

6

7

114,9 108,9 107

8

82

9

10

99,4 105,3

– 139 –

Zur Berechnung der Rangsumme der yj sortieren wir die Daten der

Größe nach und unterstreichen die Zahlen, die Werte von einem yj

waren :

Rang

1

2

3

4

5

6

7

8

9

Wert

82

85,4

95,3

96,2

97,1

98,1

99,1

99,4

102,4

Rang

10

11

12

13

14

15

16

17

18

107

108,9

112

114,9

116

Wert 102,6

104

105,3 105,7

Als Rangsumme der 2 , 2 , … , 2( erhalten wir :

W(x, y) = 1 + 4 + 7 + 8 + 12 + 14 + 15 + 16 + 17 + 18 =

= 112 < 114 = c8,10; 0,95 .

Also kann H : F2 = F1 nicht verworfen werden.

Mit Hilfe der Normalapproximation können wir einen Näherungswert für

den p – Wert der Beobachtungen angeben :

8 (

, 2) = 1 – Φ p(x, y) ≈ 1 – Φ 7

% –A+&

,+B*

≈ 1 – Φ(1,51 ) =

= 1 – 0,9332 = 0,0668 .

Dies deutet an, daß K : F2(x) ≤ F1(x) , F2 ≠ F1 nicht ganz abwegig

ist, aber mehr Daten erhoben werden müßten, um ein klareres Ergebnis

zu erhalten.