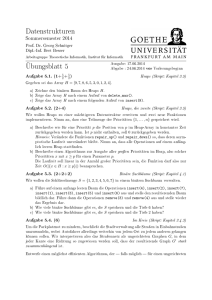

(1/4) :*: c` (1/4) - Technische Fakultät

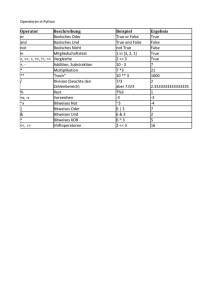

Werbung

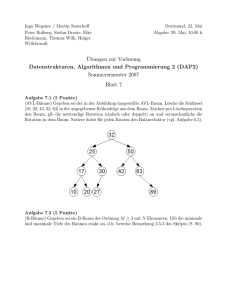

Algorithmen und Datenstrukturen I

phrase1

phrase2

phrase3

phrase4

strophe

endlos

bruderJakob

=

=

=

=

=

=

=

c’ (1/4)

(1/4) :*:

:*: f’

d’ (1/4)

(1/4) :*:

:*: g’

e’ (1/2)

(1/4) :*: c’ (1/4)

e’

g’

(1/8)

:*: a’

(1/8)

:*: g’ (1/8) :*: f’ (1/8)

:*:

e’

(1/4)

:*:

c’

(1/4)

c’

(1/4)

:*::*:

(transponiere

(-12)

(g’phrase3

(1/4))):*:

:*:wdh

c’’phr

(1

wdh

phrase1

wdh

phrase2

:*:

wdh

ad_infinitum

strophe

Tempo

andante

(Instr

VoiceAahs

(einsatz

(0/1)

endlos

:+:

(einsatz

(2/1)

(transponiere

12

endlos))

:+:

(einsatz

(4/1)

endlos)

:+:

(einsatz (6/1) endlos )))

Robert Giegerich · Ralf Hinze · Universität Bielefeld

Universität Bielefeld

Technische Fakultät

WS 2004/2005

Inhaltsverzeichnis

1. Einleitung

1.1. Rechnen und rechnen lassen . . . . . . . . . . . . . . . . . . . . . . . . . .

1.2. Die Aufgabengebiete der Informatik . . . . . . . . . . . . . . . . . . . . .

1.3. Einordnung der Informatik in die Familie der Wissenschaften . . . . . . .

2. Modellierung

2.1. Eine Formelsprache für Musik . . . . . . . . .

2.2. Typen als Hilfsmittel der Modellierung . . . .

2.3. Die Rolle der Abstraktion in der Modellierung

2.4. Modellierung in der molekularen Genetik . .

2.5. Anforderungen an Programmiersprachen . . .

1

1

3

5

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

7

7

11

13

14

23

3. Eine einfache Programmiersprache

3.1. Datentypen . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.1.1. Datentypdefinitionen . . . . . . . . . . . . . . . . . . .

3.1.2. Typsynonyme . . . . . . . . . . . . . . . . . . . . . . .

3.1.3. Typdeklarationen, Typprüfung und Typinferenz . . . .

3.1.4. Typklassen und Typkontexte . . . . . . . . . . . . . . .

3.2. Wertdefinitionen . . . . . . . . . . . . . . . . . . . . . . . . .

3.2.1. Muster- und Funktionsbindungen . . . . . . . . . . . .

3.2.2. Bewachte Gleichungen . . . . . . . . . . . . . . . . . .

3.2.3. Gleichungen mit lokalen Definitionen . . . . . . . . .

3.2.4. Das Rechnen mit Gleichungen . . . . . . . . . . . . . .

3.2.5. Vollständige und disjunkte Muster . . . . . . . . . . .

3.3. Ausdrücke . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.3.1. Variablen, Funktionsanwendungen und Konstruktoren

3.3.2. Fallunterscheidungen . . . . . . . . . . . . . . . . . . .

3.3.3. Funktionsausdrücke . . . . . . . . . . . . . . . . . . .

3.3.4. Lokale Definitionen . . . . . . . . . . . . . . . . . . . .

3.4. Anwendung: Binärbäume . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

25

25

25

30

30

32

34

34

36

37

40

41

43

43

44

46

48

49

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

ii

Inhaltsverzeichnis

3.5. Vertiefung: Rechnen in Haskell . . . . . . . . . .

3.5.1. Eine Kernsprache/Syntaktischer Zucker . .

3.5.2. Auswertung von Fallunterscheidungen . .

3.5.3. Auswertung von Funktionsanwendungen

3.5.4. Auswertung von lokalen Definitionen . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

53

53

53

54

56

4. Programmiermethodik

4.1. Spezifikation . . . . . . . . . . . . . . . . . . . .

4.2. Strukturelle Rekursion . . . . . . . . . . . . . . .

4.2.1. Strukturelle Rekursion auf Listen . . . . .

4.2.2. Strukturelle Rekursion auf Bäumen . . . .

4.2.3. Das allgemeine Rekursionsschema . . . .

4.2.4. Verstärkung der Rekursion . . . . . . . . .

4.3. Strukturelle Induktion . . . . . . . . . . . . . . .

4.3.1. Strukturelle Induktion auf Listen . . . . .

4.3.2. Strukturelle Induktion auf Bäumen . . . .

4.3.3. Das allgemeine Induktionsschema . . . .

4.3.4. Verstärkung der Induktion . . . . . . . . .

4.3.5. Referential transparency . . . . . . . . . .

4.4. Anwendung: Sortieren durch Fusionieren . . . .

4.4.1. Phase 2: Sortieren eines Binärbaums . . .

4.4.2. Phase 1: Konstruktion von Braun-Bäumen

4.5. Wohlfundierte Rekursion . . . . . . . . . . . . . .

4.5.1. Das Schema der wohlfundierten Rekursion

4.6. Vertiefung: Wohlfundierte Induktion . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

59

59

62

62

66

67

67

69

69

72

73

74

76

76

76

78

80

80

82

5. Effizienz und Komplexität

5.1. Grundlagen der Effizienzanalyse . . . . . . . . . . . . . . . . . . . . .

5.1.1. Maßeinheiten für Zeit und Raum beim Rechnen . . . . . . . .

5.1.2. Detaillierte Analyse von insertionSort . . . . . . . . . . .

5.1.3. Asymptotische Zeit- und Platzeffizienz . . . . . . . . . . . . .

5.2. Effizienz strukturell rekursiver Funktionen . . . . . . . . . . . . . . .

5.3. Effizienz wohlfundiert rekursiver Funktionen . . . . . . . . . . . . . .

5.4. Problemkomplexität . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.5. Anwendung: Optimierung von Programmen am Beispiel mergeSort

5.5.1. Varianten der Teile-Phase . . . . . . . . . . . . . . . . . . . .

5.5.2. Berücksichtigung von Läufen . . . . . . . . . . . . . . . . . .

5.6. Datenstrukturen mit konstantem Zugriff: Felder . . . . . . . . . . . .

5.7. Anwendung: Ein lineares Sortierverfahren . . . . . . . . . . . . . . .

5.8. Vertiefung: Rolle der Auswertungsreihenfolge . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

85

85

85

86

89

92

97

98

101

102

106

107

112

115

Inhaltsverzeichnis

6. Abstraktion

6.1. Listenbeschreibungen . . . . . . . . . . . . .

6.2. Funktionen höherer Ordnung . . . . . . . . .

6.2.1. Funktionen als Parameter . . . . . . .

6.2.2. Rekursionsschemata . . . . . . . . . .

6.2.3. foldr und Kolleginnen . . . . . . . .

6.2.4. map und Kolleginnen . . . . . . . . . .

6.3. Typklassen . . . . . . . . . . . . . . . . . . . .

6.3.1. Typpolymorphismus und Typklassen .

6.3.2. class- und instance-Deklarationen

6.3.3. Die Typklassen Eq und Ord . . . . . .

6.3.4. Die Typklassen Show und Read . . . .

6.3.5. Die Typklasse Num . . . . . . . . . . .

6.4. Anwendung: Sequenzen . . . . . . . . . . . .

6.4.1. Klassendefinition . . . . . . . . . . . .

6.4.2. Einfache Instanzen . . . . . . . . . . .

6.4.3. Generische Instanzen . . . . . . . . . .

6.4.4. Schlangen . . . . . . . . . . . . . . . .

6.4.5. Konkatenierbare Listen . . . . . . . . .

iii

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

A. Lösungen aller Übungsaufgaben

B. Mathematische Grundlagen

oder: Wieviel Mathematik ist nötig?

B.1. Mengen und Funktionen . . . . . . . . . . . .

B.1.1. Der Begriff der Menge . . . . . . . . .

B.1.2. Der Begriff der Funktion . . . . . . . .

B.2. Relationen und Halbordnungen . . . . . . . .

B.3. Formale Logik . . . . . . . . . . . . . . . . . .

B.3.1. Aussagenlogik . . . . . . . . . . . . . .

B.3.2. Prädikatenlogik . . . . . . . . . . . . .

B.3.3. Natürliche und vollständige Induktion

117

117

121

121

125

128

133

137

137

140

141

143

145

148

148

150

152

152

154

155

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

167

167

167

169

169

170

170

171

172

iv

Inhaltsverzeichnis

1. Einleitung

1.1. Rechnen und rechnen lassen

Man kann vorzüglich Rechnen lernen, ohne sich jemals zu fragen, was denn das Rechnen

vom sonstigen Gebrauch des Verstandes unterscheidet. Wir stellen diese Frage jetzt und

betrachten dazu das Rechnen so wie es uns im Leben zuerst begegnet — als Umgang mit

den Zahlen. Wir werden also die Natur des Rechnens an der Arithmetik studieren, und

dabei am Ende feststellen, daß die Zahlen bei weitem nicht das Einzige sind, womit wir

rechnen können.

Zweifellos ist Rechnen ein besonderer Gebrauch des Verstandes. Eine gewisse Ahnung

vom Unterschied zwischen Denken im allgemeinen und Rechnen im besonderen hat jeder,

der einmal mit seinem Mathematiklehrer darüber diskutiert hat, ob der Fehler in seiner

Schularbeit „bloß“ als Rechenfehler, oder aber als „logischer“ Fehler einzuordnen sei.

Richtig Rechnen heißt Anwendung der Rechenregeln für Addition, Multiplikation etc.

Dies allein garantiert das richtige Ergebnis — und neben ihrer Beachtung und Anwendung

ist als einzige weitere Verstandesleistung die Konzentration auf diese eintönige Tätigkeit

gefragt. Kein Wunder, daß nur wenige Menschen zum Zeitvertreib siebenstellige Zahlen

multiplizieren!1

Damit soll nicht etwa das Rechnen diffamiert werden — es entspricht so gerade der

Natur dessen, worum es dabei geht, nämlich den Zahlen. Diese sind Größen, abstrakte

Quantitäten ohne sonstige Eigenschaft. Bringe ich sie in Verbindung, ergeben sich neue,

andere Größen, aber keine andere Qualität. Der Unterschied von 15 und 42 ist 27, und

daraus folgt — nichts. Die mathematische Differenz zweier Größen ist, so könnte man

sagen, der unwesentliche Unterschied.

Nur zum Vergleich: Stelle ich meinen Beitrag zum Sportverein und meine Einkommenssteuer einander gegenüber, so ergibt sich auch ein Unterschied im Betrag. Daneben aber

auch einer in der Natur der Empfänger, dem Grad der Freiwilligkeit, meine Einflußmöglichkeiten auf die Verwendung dieser Gelder und vieles andere mehr. Dies sind wesentliche

Unterschiede, aus ihnen folgt allerhand. Unter anderem erklären sie auch die Differenz

der Beträge, und rechnen sie nicht bloß aus.

Für das Rechnen jedoch spielt es keine Rolle, wovon eine Zahl die Größe angibt. Jede

sonstige Beschaffenheit der betrachteten Objekte ist für das Rechnen mit ihrer Größe oh1 Denkaufgabe:

Was folgt daraus, wenn einer gut rechnen kann?

Grit Garbo ist Mathematikerin der alten Schule. Für sie gibt es

eigentlich keine Wissenschaft der Informatik — soweit Informatik wissenschaftlich ist, gehört sie zur Mathematik, alles andere ist Ingeniertechnik oder Programmierhandwerk. Fragen der

Programmiersprachen oder des Software Engineering sieht sie

als bloße Äußerlichkeiten an. Sie kann es nicht ganz verschmerzen, daß die Mathematik von ihrer Tochter Informatik heute in

vielerlei Hinsicht überflügelt wird.

2

Harry Hacker ist ein alter Programmierfuchs, nach dem Motto: Eine Woche Programmieren und Testen kann einen ganzen

Nachmittag Nachdenken ersetzen. Er ist einfallsreich und ein

gewitzter Beobachter; allerdings liegt er dabei oft haarscharf

neben der Wahrheit. Zu Programmiersprachen hat er eine dezidiert subjektive Haltung: Er findet die Sprache am besten, die

ihm am besten vertraut ist.

1. Einleitung

ne Belang. Deshalb kann das Rechnen in starre Regeln gegossen werden und nimmt darin

seinen überraschungsfreien Verlauf. Die kreative gedankliche Leistung liegt woanders: Sie

manifestiert sich in der Art und Weise, wie man die abstrakten Objekte der Zahlen konkret aufschreibt. Wir sind daran gewöhnt, das arabische Stellenwertsystem zu verwenden.

Dieses hat sich im Laufe der Geschichte durchgesetzt, da sich darauf relativ einfach Rechenregeln definieren und auch anwenden lassen. Das römische Zahlensystem mit seinen

komplizierten Einheiten und der Vor- und Nachstellung blieb auf der Strecke: Den Zahlen

XV und XLII sieht man den Unterschied XXVII nicht an. Insbesondere das Fehlen eines

Symbols für die Null macht systematisches Rechnen unmöglich — gerade wegen der Null

war das Rechnen mit den arabischen Zahlen im Mittelalter von der Kirche verboten.

Einstweiliges Fazit: Das Rechnen ist seiner Natur nach eine äußerliche, gedankenlose, in

diesem Sinne mechanische Denktätigkeit. Kaum hatte die Menschheit Rechnen gelernt,

schon tauchte die naheliegende Idee auf, das Rechnen auf eine Maschine zu übertragen.

Die Geschichte dieser Idee — von einfachen Additionsmaschinen bis hin zu den ersten

programmgesteuerten Rechenautomaten — ist an vielen Stellen beschrieben worden und

soll hier nicht angeführt werden. An ihrem Endpunkt steht der Computer, der bei entsprechender Programmierung beliebig komplexe arithmetische Aufgaben lösen kann —

schneller als wir, zuverlässiger als wir und (für uns) bequemer.

Wenn dieses Gerät existiert, stellt sich plötzlich eine ganz neue Frage: Jetzt, wo wir

rechnen lassen können, wird es interessant, Aufgaben in Rechenaufgaben zu verwandeln,

die es von Natur aus nicht sind (und die wir mit unserem Verstand auch nie so behandeln

würden). Es gilt, zu einer Problemstellung die richtigen Abstraktionen zu finden, sie durch

Formeln und Rechengesetze, genannt Datenstrukturen und Algorithmen, so weitgehend

zu erfassen, daß wir dem Ergebnis der Rechnung eine Lösung des Problems entnehmen

können. Wir bilden also abstrakte Modelle der konkreten Wirklichkeit, die diese im Falle

der Arithmetik perfekt, in den sonstigen Fällen meist nur annähernd wiedergeben. Die

Wirklichkeitstreue dieser Modelle macht den Reiz und die Schwierigkeit dieser Aufgabe,

und die Verantwortung des Informatikers bei der Software-Entwicklung aus.

Die eigentümliche Leistung der Informatik ist es also, Dinge in Rechenaufgaben zu verwandeln, die es von Natur aus nicht sind. Die Fragestellung „Was können wir rechnen

lassen?“, ist neu in der Welt der Wissenschaften — deshalb hat sich die Informatik nach

der Konstruktion der ersten Rechner schnell aus dem Schoße der Mathematik heraus zu

einer eigenständigen Disziplin entwickelt. Die Erfolge dieser Bemühung sind faszinierend,

und nicht selten, wenn auch nicht ganz richtig, liest man darüber in der Zeitung: „Computer werden immer schlauer“.

1.2. Die Aufgabengebiete der Informatik

3

1.2. Die Aufgabengebiete der Informatik

Informatik ist die Wissenschaft vom maschinellen Rechnen. Daraus ergeben sich verschiedene Fragestellungen, in die sich die Informatik aufgliedert.

Zunächst muß sie sich um die Rechenmaschine selbst kümmern. In der Technischen Informatik geht es um Rechnerarchitektur und Rechnerentwurf, wozu auch die Entwicklung

von Speichermedien, Übertragungskanälen, Sensoren usw. gehören. Der Fortschritt dieser

Disziplin besteht in immer schnelleren und kleineren Rechnern bei fallenden Preisen. In

ihren elementaren Operationen dagegen sind die Rechner heute noch so primitiv wie zur

Zeit ihrer Erfindung. Diese für den Laien überraschende Tatsache erfährt ihre Erklärung in

der theoretischen Abteilung der Informatik.

Mit der Verfügbarkeit der Computer erfolgt eine Erweiterung des Begriffs „Rechnen“.

Das Rechnen mit den guten alten Zahlen ist jetzt nur noch ein hausbackener Sonderfall. Jetzt werden allgemeinere Rechenverfahren entwickelt, genannt Algorithmen, die

aus Eingabe-Daten die Ausgabe-Daten bestimmen. Aber — was genau läßt sich rechnen,

und was nicht? Mit welcher Maschine? Die Theoretische Informatik hat diese Frage beantwortet und gezeigt, daß es nicht berechenbare Probleme2 gibt, d.h. Aufgaben, zu deren

Lösung es keinen Algorithmus gibt. Zugleich hat sie gezeigt, daß alle Rechner prinzipiell

gleichmächtig sind, sofern sie über einige wenige primitive Operationen verfügen. Dagegen erweisen sich die berechenbaren Aufgaben als unterschiedlich aufwendig, so daß die

Untersuchung des Rechenaufwands, Komplexitätstheorie, heute ein wichtiges Teilgebiet

der Theoretischen Informatik darstellt.

Zwischen den prinzipiellen Möglichkeiten des Rechnens und dem Rechner mit seinen

primitiven Operationen klafft eine riesige Lücke. Die Aufgabe der Praktischen Informatik

ist es, den Rechner für Menschen effektiv nutzbar zu machen. Die „semantische Lücke“

wird Schicht um Schicht geschlossen durch Programmiersprachen auf immer höherer Abstraktionsstufe. Heute können wir Algorithmen auf der Abstraktionsstufe der Aufgabenstellung entwickeln und programmieren, ohne die ausführende Maschine überhaupt zu

kennen. Dies ist nicht nur bequem, sondern auch wesentliche Voraussetzung für die Übertragbarkeit von Programmen zwischen verschiedenen Rechnern. Ähnliches gilt für die Benutzung der Rechner (Betriebssysteme, Benutzeroberflächen), für die Organisation großer

Datenmengen (Datenbanken) und sogar für die Kommunikation der Rechner untereinander (Rechnernetze, Verteilte Systeme). Das World Wide Web (WWW) ist das jüngste und

bekannteste Beispiel für das Überbrücken der semantischen Lücke: Es verbindet einfach2 Man

kann solche Aufgaben auch als Ja/Nein-Fragestellungen formulieren und nennt sie dann „formal unentscheidbare“ Probleme. Läßt man darin das entscheidende Wörtchen „formal“ weg, eröffnen sich tiefsinnige,

aber falsche Betrachtungen über Grenzen der Erkenntnis.

Lisa Lista ist die ideale Studentin, den Wunschvorstellungen eines überarbeitetenn Hochschullehrers entsprungen. Sie ist unvoreingenommen und aufgeweckt, greift neue Gedanken auf

und denkt sie in viele Richtungen weiter. Kein Schulunterricht

in Informatik hat sie verdorben. Lisa Lista ist 12 Jahre alt.

4

Peter Paneau ist Professor der Theoretischen Informatik. Er

sieht die Informatik im wesentlichen als eine formale Disziplin.

Am vorliegenden Text stört ihn die saloppe Redeweise und die

Tatsache, daß viele tiefgründige theoretische Probleme grob vereinfacht oder einfach umgangen werden. An solchen Stellen erhebt er mahnend der Zeigefinger . . .

1. Einleitung

ste Benutzbarkeit mit globalem Zugriff auf Informationen und andere Ressourcen in aller

Welt. Heute bedarf es nur eines gekrümmten Zeigefingers, um tausend Computer in aller

Welt für uns arbeiten zu lassen.

In der Angewandten Informatik kommt endlich der Zweck der ganzen Veranstaltung

zum Zuge. Sie wendet die schnellen Rechner, die effizienten Algorithmen, die höheren

Programmiersprachen und ihre Übersetzer, die Datenbanken, die Rechnernetze usw. an,

um Aufgaben jeglicher Art sukzessive immer vollkommener zu lösen. Je weiter die Informatik in die verschiedensten Anwendungsgebiete vordringt, desto spezifischer werden

die dort untersuchten Fragen. Vielleicht werden wir bald erleben, daß sich interdisziplinäre Anwendungen als eigenständige Disziplinen von der „Kerninformatik“ abspalten.

Wirtschaftsinformatik und Bioinformatik sind mögliche Protagonisten einer solchen Entwicklung. Während es früher Jahrhunderte gedauert hat, bis aus den Erfolgen der Physik

zunächst die anderen Natur-, dann die Ingenieurwissenschaften entstanden, so laufen

heute solche Entwicklungen in wenigen Jahrzehnten ab.

Wenn die Rechner heute immer mehr Aufgaben übernehmen, für die der Mensch den

Verstand benutzt, so ist insbesondere für Laien daran längst nicht mehr erkennbar, auf

welche Weise dies erreicht wird. Es entsteht der Schein, daß das analoge Resultat auch

in analoger Weise zustande käme. Diesen Schein nennt man künstliche Intelligenz, und

seiner Förderung hat sich das gleichnamige Arbeitsfeld der Informatik gewidmet. Es lohnt

sich, die Metapher von der Intelligenz des Rechners kurz genauer zu betrachten, weil

sie — unter Laien wie unter Informatikern — manche Verwirrung stiftet. Es ist nichts

weiter dabei, wenn man sagt, daß ein Rechner (oder genauer eine bestimmte Software)

sich intelligent verhält, wenn er (oder sie) eine Quadratwurzel zieht, eine WWW-Seite

präsentiert oder einen Airbus auf die Piste setzt. Schließlich wurden viele Jahre Arbeit

investiert, um solche Aufgaben rechnergerecht aufzubereiten, damit der Rechner diese

schneller und zuverlässiger erledigen kann als wir selbst. Nimmt man allerdings die Metapher allzu wörtlich, kommt man zu der Vorstellung, der Rechner würde dadurch selbst

so etwas wie eine eigene Verständigkeit erwerben. Daraus entsteht gelegentlich sogar die

widersprüchliche Zielsetzung, den Rechner so zu programmieren, daß er sich nicht mehr

wie ein programmierter Rechner verhält. Der Sache nach gehört die „Künstliche Intelligenz“ der Angewandten Informatik an, geht es ihr doch um die erweiterte Anwendbarkeit des Rechners auf immer komplexere Probleme. Andererseits haben diese konkreten

Anwendungen für sie nur exemplarischen Charakter, als Schritte zu dem abstrakten Ziel,

„wirklich“ intelligente künstliche Systeme zu schaffen. So leidet diese Arbeitsrichtung unter dem Dilemma, daß ihr Beitrag zum allgemeinen Fortschritt der Informatik vom Lärm

der immer wieder metaphorisch geweckten und dann enttäuschten Erwartungen übertönt

wird.

Unbeschadet solch metaphorischer Fragen geht der Vormarsch der Informatik in allen

Lebensbereichen voran — der „rechenbare“ Ausschnitt der Wirklichkeit wird ständig er-

1.3. Einordnung der Informatik in die Familie der Wissenschaften

5

weitert: Aus Textverarbeitung wird DeskTop Publishing, aus Computerspielen wird Virtual

Reality, und aus gewöhnlichen Bomben werden „intelligent warheads“. Wie gesagt: die

Rechner werden immer schlauer. Und wir?

1.3. Einordnung der Informatik in die Familie der

Wissenschaften

Wir haben gesehen, daß die Grundlagen der Informatik aus der Mathematik stammen,

während der materielle Ausgangspunkt ihrer Entwicklung die Konstruktion der ersten Rechenmaschinen war. Mutter die Mathematik, Vater der Computer — wissenschaftsmoralisch gesehen ist die Informatik ein Bastard, aus einer Liebschaft des reinen Geistes mit

einem technischen Gerät entstanden.

Die Naturwissenschaft untersucht Phänomene, die ihr ohne eigenes Zutun gegeben

sind. Die Gesetze der Natur müssen entdeckt und erklärt werden. Die Ingenieurwissenschaften wenden dieses Wissen an und konstruieren damit neue Gegenstände, die selbst

wieder auf ihre Eigenschaften untersucht werden müssen. Daraus ergeben sich neue Verbesserungen, neue Eigenschaften, und so weiter.

Im Vergleich dieser beiden Abteilungen der Wissenschaft steht die Informatik eher den

Ingenieurwissenschaften nahe: Auch sie konstruiert Systeme, die — abgesehen von denen der Technischen Informatik — allerdings immateriell sind. Wie die Ingenieurwissenschaften untersucht sie die Eigenschaften ihrer eigenen Konstruktionen, um sie weiter zu

verbessern. Wie bei den Ingenieurwissenschaften spielen bei der Informatik die Aspekte

der Zuverlässigkeit und Lebensdauer ihrer Produkte eine wesentliche Rolle.

Eine interessante Parallele besteht auch zwischen Informatik und Rechtswissenschaft.

Die Informatik konstruiert abstrakte Modelle der Wirklichkeit, die dieser möglichst nahe

kommen sollen. Das Recht schafft eine Vielzahl von Abstraktionen konkreter Individuen.

Rechtlich gesehen sind wir Mieter, Studenten, Erziehungsberechtigte, Verkehrsteilnehmer,

etc. Als solche verhalten wir uns entsprechend der gesetzlichen Regeln. Der Programmierer bildet reale Vorgänge in formalen Modellen nach, der Jurist muß konkrete Vorgänge

unter die relevanten Kategorien des Rechts subsumieren. Die Analogie endet allerdings,

wenn eine Diskrepanz zwischen Modell und Wirklichkeit auftritt: Bei einem Programmfehler behält die Wirklichkeit recht, bei einem Rechtsbruch das Recht.

Eine wissenschaftshistorische Betrachtung der Informatik und ihre Gegenüberstellung

mit der hier gegebenen deduktiven Darstellung ist interessant und sollte zu einem späteren Zeitpunkt, etwa zum Abschluß des Informatik-Grundstudiums, nachgeholt werden.

Interessante Kapitel dieser Geschichte sind das Hilbert’sche Programm, die Entwicklung

der Idee von Programmen als Daten, die oben diskutierte Idee der „Künstlichen Intelligenz“, der Prozeß der Loslösung der Informatik von der Mathematik, die Geschichte der

6

1. Einleitung

Programmiersprachen, die Revolution der Anwendungssphäre durch das Erscheinen der

Mikroprozessoren, und vieles andere mehr.

2. Modellierung

Wir haben im ersten Kapitel gelernt: Programmieren heißt, abstrakte Modelle realer Objekte zu bilden, so daß die Rechenregeln im Modell die relevanten Eigenschaften in der

Wirklichkeit adäquat nachbilden.

Wir werden den Vorgang der Modellierung nun anhand von zwei Beispielen kennen

lernen.

2.1. Eine Formelsprache für Musik

Wir haben gelernt, daß die Welt der Zahlen wegen ihres formalen Charakters die natürliche Heimat des Rechnens ist. Es gibt ein zweites Gebiet, in dem ein gewisser Formalismus

in der Natur der Sache liegt: die Musik.

Das Spielen eines Musikstückes mag vieles sein – ein künstlerischer Akt, ein kulturelles

oder emotionales Ereignis. Im Kern jedoch steht das Musikstück – es bringt die Musikvorstellung des Komponisten in eine objektive Form und ist nichts anderes als ein Programm

zur Ausführung durch einen Musiker (oder heute über eine Midi-Schnittstelle auch durch

einen elektronischen Synthesizer). Wer immer als erster ein Musikstück niedergeschrieben

hat, hat damit den Schritt vom Spielen zum Spielen lassen begründet.

Diese kulturhistorische Leistung ist viel älter als die Idee einer Rechenmaschine. In der

traditionellen Notenschrift ist der formale Anteil der Musik manifestiert. Die Modellierung

ist hier also bereits erfolgt, allerdings ausschließlich im Hinblick auf die Wiedergabe durch

einen menschlichen Interpreten, und nicht bis hin zur Entwicklung von dem Rechnen

vergleichbaren Regeln. Zwar sind viele Gesetze z.B. der Harmonielehre bekannt, man kann

sie aber in der Notenschrift nicht ausdrücken. So kann man zwar jeden Dur-Dreiklang

konkret hinschreiben – aber die allgemeine Aussage, daß ein Dur-Dreiklang immer aus

einem großen und einem kleinen Terz besteht, muß auf andere Art erfolgen. In diesem

Abschnitt setzen wir die Notenschrift (natürlich nur einen kleinen Ausschnitt davon) in

eine Formelsprache samt den zugehörigen Rechenregeln um.

Musikstücke sind aus Noten zusammengesetzt, die gleichzeitig oder nacheinander gespielt werden. Jede Note hat einen Ton und eine Dauer. Dem Stück als Ganzem liegt ein

bestimmter Takt zugrunde, und die Dauer einzelner Töne wird in Takt-Bruchteilen gemessen. Die Tonskala besteht aus 12 Halbtönen, die sich in jeder Oktave wiederholen.

8

2. Modellierung

Wir legen das tiefe C als untersten Ton zugrunde und numerieren die Halbtöne von 0

ab aufwärts. Angaben zum Spieltempo (in Taktschlägen pro Minute) und zur Wahl des

Instruments werden global für ganze Musikstücke gemacht.

Formeln, die Musik bedeuten, können wir uns z.B. so vorstellen:

Note

0 (1/4)

-Note 24 (1/1)

-Pause

(1/16)

-Note 24 (1/4) :*: Note 26 (1/4)

-Note 24 (1/4) :+: Note 28 (1/4)

-Tempo

40 m

-Tempo

100 m

-Instr Oboe m

-Instr VoiceAahs m

--

Viertelnote tiefes C

ganze Note

c’

Sechzehntelpause

:*: Note 28 (1/4)

Anfang der C-Dur Tonleiter

:+: Note 31 (1/4)

C-Dur Akkord

Musik m als Adagio

Musik m als Presto

Musik m von Oboe gespielt

Musik m gesummt

Wir konstruieren nun die Formelwelt, deren Bürger die obigen Beispiele sind. Wir gehen

davon aus, daß es Formeln für ganze Zahlen, Brüche und ein bißchen Arithmetik bereits

gibt in der Formelwelt und führen neue Typen von Formeln ein: Ton, Dauer, Instrument

und Musik.

infixr 7 :*:

infixr 6 :+:

type GanzeZahl

type Bruch

type Ton

type Dauer

data Instrument

data Musik

=

=

=

=

=

Int

-- Ganze Zahlen und Brueche setzen wir

Rational

-- als gegeben voraus.

GanzeZahl

Bruch

Oboe | HonkyTonkPiano |

Cello | VoiceAahs

deriving Show

= Note Ton Dauer |

Pause Dauer |

Musik :*: Musik |

Musik :+: Musik |

Instr Instrument Musik |

Tempo GanzeZahl Musik

deriving Show

Die neuen Formeltypen Ton und Dauer sind nur Synonyme für ganze Zahlen und Brüche entsprechend der besonderen Bedeutung, in der wir sie gebrauchen. Sie tragen keine neuen Formeln bei. Anders bei Instrument und Musik. Die Symbole Note, Pause,

:*:, :+:, Instr, Tempo sind die Konstruktoren für neuartige Formeln, die Musikstücke darstellen. In der Formel m1 :*: m2 dürfen (und müssen!) m1 und m2 beliebige

Formeln für Musikstücke sein, insbesondere selbst wieder zusammengesetzt.

2.1. Eine Formelsprache für Musik

9

In Anlehnung an die Punkt-vor-Strich Regel der Algebra geben wir der Verknüpfung

von Noten zu einer zeitlichen Abfolge (:*:) Vorrang vor der zeitlich parallelen Verknüpfung mehrerer Stimmen (:+:). Damit ist die Formel m1 :+: m2 :*: m3 zu lesen als

m1 :+: (m2 :*: m3).

Umfangreiche Musikstücke können nun als wahre Formelgebirge geschrieben werden.

Zuvor erleichtern wir uns das Leben in der Formelwelt, indem wir einige Abkürzungen

einführen. Etwa für die Pausen:

gP

hP

vP

aP

sP

=

=

=

=

=

Pause

Pause

Pause

Pause

Pause

(1/1)

(1/2)

(1/4)

(1/8)

(1/16)

Diese Definitionen sind zugleich Rechenregeln. Sie bedeuten einerseits, daß man die

neuen Symbole gP, hP, vP, aP, sP überall in Musikstücken einsetzen kann – es erweitert sich damit die Formelwelt. Zugleich kann man jedes Symbol jederzeit durch die

rechte Seite der Definition ersetzen – so daß die Musikstücke in der Formelwelt nicht

mehr geworden sind.

Hier sind klangvolle Namen für einige Tempi:

adagio = 70; andante = 90; allegro = 140; presto = 180

Die üblichen Bezeichnungen für die 12 Halbtöne führen wir so ein:

ce

de

eh

ef

ge

ah

ha

=

=

=

=

=

=

=

0;

2;

4;

5;

7;

9;

11;

cis

dis

eis

fis

gis

ais

his

=

=

=

=

=

=

=

1;

3;

5;

6;

8;

10;

12

des

es

fes

ges

as

be

=

=

=

=

=

=

1

3

4

6

8

10

Diese Töne sind in der untersten Oktave angesiedelt, und wir brauchen sie hier kaum.

Dagegen brauchen wir eine bequeme Notation für Noten (beliebiger Dauer) aus der CDur Tonleiter in der dritten Oktave:

c’

e’

g’

h’

u

u

u

u

=

=

=

=

Note

Note

Note

Note

(ce+24)

(eh+24)

(ge+24)

(ha+24)

u;

u;

u;

u;

d’

f’

a’

c’’

u

u

u

u

=

=

=

=

Note

Note

Note

Note

(de+24)

(ef+24)

(ah+24)

(ce+36)

u

u

u

u

Als Beispiele hier der C-Dur Akkord in neuer Schreibweise, sowie eine (rhythmisch beschwingte) C-Dur Tonleiter:

10

2. Modellierung

cDurTonika = c’ (1/1) :+: e’ (1/1) :+: g’ (1/1)

cDurSkala = Tempo allegro(

c’ (3/8) :*: d’ (1/8) :*: e’ (3/8) :*: f’ (4/8)

:*: g’ (1/8) :*: a’ (1/4) :*: h’ (1/8) :*: c’’ (1/2))

Allgemein gesagt, besteht ein Dur-Dreiklang aus einen Grundton t sowie der großen

Terz und der Quinte über t.

Dieses Gesetz als Formel:

durDreiklang t = Note t (1/1) :+: Note (t+4) (1/1) :+: Note (t+7) (1/1)

Wie wär’s mit einer allgemeinen Regel zur Umkehrung eines Dreiklangs (der unterste

Ton muß eine Oktave nach oben)?

umk ((Note t d) :+: n2 :+: n3) = n2 :+: n3 :+: (Note (t+12) d)

Als komplexe Operation auf ganzen Musikstücken betrachten wir das Transponieren.

Es bedeutet, daß Töne um ein gewisses Intervall verschoben werden, während alles andere gleich bleibt. Wie muß die Rechenregel lauten, um Musikstück m um Intervall i zu

transponieren? Wir geben eine Regel für jede mögliche Form von m an:

transponiere

transponiere

transponiere

transponiere

transponiere

transponiere

i

i

i

i

i

i

(Pause d)

(Note t d)

(m1 :*: m2)

(m1 :+: m2)

(Instr y m)

(Tempo n m)

=

=

=

=

=

=

Pause d

Note (t+i) d

(transponiere i m1) :*:

(transponiere i m1) :+:

Instr y (transponiere i

Tempo n (transponiere n

(transponiere i m2)

(transponiere i m2)

m)

m)

gDurTonika = transponiere 7 cDurTonika

Da das Transponieren Intervalle nicht ändert, führt es einen Dur-Dreiklang wieder in

einen Dur-Dreiklang über. Es gilt folgendes Gesetz für beliebigen Grundton g und beliebiges Intervall i:

transponiere i (durDreiklang t) = durDreiklang(t+i)

Zur Überprüfung rechnen wir beide Seiten mittels der Definition von transponiere

und durDreiklang aus und erhalten beide Male

Note (t+i) (1/1)

:+: Note (t+4+i) (1/1) :+: Note (t+7+i) (1/1)

2.2. Typen als Hilfsmittel der Modellierung

11

Hier haben wir eine Methode zur Validierung von Modellen kennengelernt: Wenn man

beweisen kann, daß ein Gesetz der realen Welt auch in der Formelwelt gilt, so gibt das

Modell die Wirklichkeit zumindest in dieser Hinsicht treu wieder.

Bevor wir ein komplettes Lied zusammenstellen, hier zwei Regeln zur Wiederholung:

wdh m = m :*: m

ad_infinitum m = m :*: ad_infinitum m

Einen um Dauer d verzögerten Einsatz erhält man durch Vorschalten einer Pause.

einsatz

d m = (Pause d) :*: m

Unser letztes Beispiel beschreibt den Kanon „Bruder Jakob“, wobei wir die 2. Stimme

eine Oktave über den anderen notieren.

phrase1 = c’ (1/4) :*: d’ (1/4) :*: e’ (1/4) :*: c’ (1/4)

phrase2 = e’ (1/4) :*: f’ (1/4) :*: g’ (1/2)

phrase3 = g’ (1/8) :*: a’ (1/8) :*: g’ (1/8) :*: f’ (1/8)

:*: e’ (1/4) :*: c’ (1/4)

phrase4 = c’ (1/4) :*: (transponiere (-12) (g’ (1/4))) :*: c’’ (1/2)

strophe = wdh phrase1 :*: wdh phrase2 :*: wdh phrase3 :*: wdh phrase4

endlos = ad_infinitum strophe

bruderJakob = Tempo andante (Instr VoiceAahs

(einsatz (0/1) endlos

:+:

(einsatz (2/1) (transponiere 12 endlos)) :+:

(einsatz (4/1) endlos)

:+:

(einsatz (6/1) endlos )))

Natürlich gehört zu einer praktischen Formelsprache für Musik noch vieles, was wir hier

nicht betrachtet haben – Text, Artikulation, Kontrapunkt, eine Möglichkeit zur Übersetzung der Formeln in die traditionelle Notation und in eine Folge von Midi-Befehlen, um

damit einen Synthesizer zu steuern.

2.2. Typen als Hilfsmittel der Modellierung

In der realen Welt verhindert (meistens) die Physik, daß unpassende Operationen mit

untauglichen Objekten ausgeführt werden. Man kann eben einen Golfball nicht unter einer Fliege verstecken oder einen Rosenbusch mit einer Steuererklärung paaren. Macht

12

2. Modellierung

es Sinn, einer streikenden (?) Waschmaschine gut zuzureden? Das Problem in einer Formelwelt ist, daß man zunächst alles hinschreiben kann, weil die Formeln sich nicht selbst

dagegen sträuben.

Aus diesem Grund gibt man jedem Objekt des Modells einen Typ, der eine Abstraktion

der natürlichen Eigenschaften des realen Objekts ist.

In der Formelsprache für Musik haben wir die Typen Ton (synonym für ganzeZahl) und

Dauer (synonym für positive rationale Zahl) vorausgesetzt und die Typen Musik und

Instrument neu eingeführt. Die Typendeklaration legt nicht nur fest, daß Musik auf

sechs verschiedene Weisen zusammengesetzt werden kann, und zwar durch die (Formel-)

Konstruktoren Note bis Tempo. Sie sagt auch, welche Formeln zusammengefügt werden

dürfen. Note muß stets einen Ton mit einer Dauer verknüpfen. Mit :*: kann man zwei

Musikstücke verknüpfen, nicht aber ein Musikstück mit einem Ton. Folgende Formeln

sind fehlerhaft:

Note 3/4 ce

Pause Cello

Tempo Oboe 100

Pause (1/2 :*: 1/4)

Instr (Cello :+: Oboe) cDurTonika

c’ :+: e’ :+: g’

Möglicherweise hat sich der Autor dieser Formeln etwas Sinnvolles gedacht – aber es

muß in unserer Formelsprache anders ausgedrückt werden. Auch die durch Definitionen

eingeführten Namen erhalten einen Typ. Er ergibt sich aus der rechten Seite der definierenden

Gleichung. Wir schreiben a, b, c :: t für die Aussage „Die Namen (oder Formeln)

a, b, c haben Typ t“ und stellen fest:

ce, cis, des, de, dis, es, eh, eis, fes, ef, fis :: Ton

ges, ge, gis, as, ah, ais, be, ha, his

:: Ton

gP, hP, vP, aP, sP

:: Musik

cDurTonika

:: Musik

adagio, andante, allegro, presto

:: GanzeZahl

Die Namen c’, d’ etc. bezeichnen Funktionen, die eine Dauer als Argument und

Musik als Ergebnis haben. umk, wdh und ad_infinitum wandeln Musikstücke um.

c’, d’, e’, f’, g’, a’, h’, c’’ :: Dauer -> Musik

umk, wdh, ad_infinitum

:: Musik -> Musik

transponiere schließlich hat zwei Argumente, was wir – etwas gewöhnugsbedürftig

– mit zwei Funktionspfeilen ausdrücken.

transponiere :: GanzeZahl -> Musik -> Musik

2.3. Die Rolle der Abstraktion in der Modellierung

13

Hinter dieser Notation steht die Sichtweise, daß man einer zweistelligen Funktion wie

transponiere manchmal nur ein Argument geben möchte: Unter

(transponiere 7) stellen wir uns eine abgeleitete Funktion vor, die Musikstücke um

eine Quinte nach oben transponiert. Natürlich hat (transponiere 7) dann den „restlichen“ Typ Musik -> Musik.

2.3. Die Rolle der Abstraktion in der Modellierung

Unsere Formelsprache für Musik erlaubt es, in direkter Analogie zur Notenschrift Musikstücke als Formeln hinzuschreiben. Darüberhinaus können wir aber auch abstrakte Zusammenhänge zwischen Musikstücken darstellen, wie etwa den Aufbau eines Dur-Dreiklangs

oder das Transponieren. Worauf beruht dies Möglichkeit?

Sie beginnt damit, daß wir beliebige Formeln mit einem Namen versehen können, wie

etwa bei gP, hP oder phrase1 bis phrase4. Diese Namen sind kürzer und (hoffentlich)

lesbarer als die Formeln, für die sie stehen, aber noch nicht abstrakter. Die Abstraktion

kommt mit dem Übergang zu Funktionen ins Spiel. Vergleichen wir die beiden folgenden

Definitionen eines Zweiklangs:

tritonus_f_1 = Note ef (1/1) :+: Note ha (1/1)

tritonus t d = Note t d

:+: Note (t+6) d

tritonus_f_1 beschreibt einen Zweiklang von konkreter Tonlage und Dauer.

tritonus dagegen abstrahiert von Tonlage und Dauer, und hält nur fest, was für den als

Tritonus bekannten Zweiklang wesentlich ist — ein Intervall von 6 Halbtonschritten.

Dieser Unterschied macht sich auch an den Typen bemerkbar. Wir finden:

tritonus_f_1 :: Musik

tritonus

:: Ton -> Dauer -> Musik

Hier verrät uns bereits der Typ, daß in der Formel tritonus erst Ton und Dauer konkretisiert werden müssen, ehe spielbare Musik entsteht. Bei den Noten der eingestrichenen

C-Dur-Skala (c’, d’, ...) haben wir von der Dauer abtrahiert, sonst hätten wir Definitionen für 40 oder noch mehr Namen einführen müssen. Andererseits haben wir hier

natürlich nicht vom Ton abstrahiert, wir wollten ja Namen für bestimmte Töne einführen. Und außerdem gibt es diese Abstraktion bereits: Eine Note von beliebigem Ton und

Dauer wird gerade von dem Konstruktor Note repräsentiert, dem wir daher auch den Typ

Ton -> Dauer -> Musik zuordnen.

Typen halten die Objekte der Formelwelt auseinander, Funktionen stiften Zusammenhänge. Wollten wir ohne Abstraktion das Prinzip der Umkehrung eines Dreiklangs beschreiben, kämen wir über konkrete Beispiele nicht hinaus. Die Funktion umk leistet das

14

2. Modellierung

Gewünschte mühelos. Und schließlich hält uns nichts davon ab (Übungsaufgabe!), im Kanon bruderJakob von der eigentlichen Melodie zu abstrahieren und ein allgemeines

Konstruktionsprinzip für einen vierstimmigen Kanon anzugeben.

Hier haben wir die Methode der funktionalen Abstraktion kennengelernt. Technisch

gesehen besteht sie lediglich darin, in einer Formel einige Positionen als variabel zu betrachten. So wird aus der Formel eine Funktion, die mit einem Namen versehen und in

vielfältiger Weise eingesetzt werden kann, und die zugleich selbst ein abstraktes Prinzip

repräsentiert. Wir werden später noch andere Formen der Abstraktion kennenlernen, aber

die funktionale Abstraktion ist sicher die grundlegendste von allen.

2.4. Modellierung in der molekularen Genetik

Die Basen Adenin, Cytosin, Guanin und Thymin bilden zusammen mit Phosphor und Ribose die Nukleotide, die Bausteine der Erbsubstanz.

data Nucleotide = A | C | G | T

deriving (Eq, Show)

Die 20 Aminosäuren sind die Bausteine aller Proteine:

data AminoAcid

=

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Ala

-- Alanin

Arg

-- Arginin

Asn

-- Asparagin

Asp

-- Aspartat

Cys

-- Cystein

Gln

-- Glutamin

Glu

-- Glutamat

Gly

-- Glycin

His

-- Histidin

Ile

-- Isoleucin

Leu

-- Leucin

Lys

-- Lysin

Met

-- Methionin

Phe

-- Phenylalanin

Pro

-- Prolin

Ser

-- Serin

Thr

-- Threonin

Trp

-- Tryptophan

Tyr

-- Tyrosin

Val

-- Valin

Stp

-- keine Aminosaeure; siehe unten

deriving (Eq, Show)

2.4. Modellierung in der molekularen Genetik

15

Lange Ketten von Nukleotiden bilden die Nukleinsäure, lange Ketten von Aminosäuren bilden Proteine. Chemisch werden diese Ketten auf unterschiedliche Weise gebildet:

Bei den Nukleotiden verknüpfen die Phosphor-Atome die Ribose-Ringe, zwischen den

Aminosäuren werden Peptidbindungen aufgebaut. Da wir aber die Chemie der Moleküle nicht modellieren wollen, wollen wir auch nicht unterscheiden, auf welche Weise die

Ketten konstruiert werden. Als Formel für Kettenmoleküle schreiben wir

A:C:C:A:G:A:T:T:A:T:A:T: ..., oder

Met:Ala:Ala:His:Lys:Lys:Leu: ...

Im Unterschied zur Molekularbiologie kennt also unsere Formelwelt einen Konstruktor

(:), der Ketten jeglicher Art aufbaut:

data [a] = []

| a:[a]

-- leere Kette

-- (:) verlaengert Kette von a’s um ein a.

Den Datentyp [a] nennt man einen polymorphen Listentyp. Hier ist a ein Typparameter. Dies bedeutet, das Elemente beliebigen, aber gleichen Typs mittels der Konstruktoren

(:) und [] zu Listen zusammengefügt werden können. Für Listen führen wir eine spezielle Notation ein: Statt a:b:c:[] schreiben wir auch [a,b,c].

Damit können wir nun sagen, welcher Datentyp in der Formelwelt den realen Nukleinsäuren und Proteinen entsprechen soll:

type DNA

= [Nucleotide]

type Protein = [AminoAcid]

type Codon

= (Nucleotide, Nucleotide, Nucleotide)

Im Ruhezustand (als Informationsspeicher) ist die DNA allerdings ein Doppelmolekül:

Zwei DNA-Stränge bilden die berühmte, von Watson und Crick entdeckte Doppelhelix.

Sie beruht darauf, daß bestimmte Basen zueinander komplementär sind - sie können Wasserstoffbrückenbindungen aufbauen, wenn sie einander gegenüber stehen.

wc_complement

wc_complement

wc_complement

wc_complement

A

T

C

G

=

=

=

=

T

A

G

C

Wir können die dopplesträngige DNA auf zwei verschiedene Weisen darstellen, als Paar

von Listen oder als Liste von Paaren.

type DNA_DoubleStrand = (DNA,DNA) -- als Paar zweier Einzelstraenge

type DNA_DoubleStrand’ = [(Nucleotide,Nucleotide)]

-- als Kette von Watson-Crick-Paaren

dnaDS_Exmpl1 = ([A,C,C,G,A,T],[T,G,G,C,T,A])

dnaDS_Exmpl2 = [(A,T),(C,G),(C,G),(G,C),(A,T),(T,A)]

16

2. Modellierung

Dabei ist die erste Version deutlich vorzuziehen. Sie deutet an, was in der Zelle auch

stattfindet: Das Aufspalten oder Zusammenfügen des Doppelstrangs aus zwei Einzelsträngen. Die zweite Version dagegen suggeriert, daß existierende Watson-Crick Basenpaare zu

einer Doppelkette verknüpft werden. Einzelne solche Paare sind jedoch wegen der sehr

schwachen Wasserstoffbindung nicht stabil und kommen daher in der Zelle nicht vor.

Wir entscheiden uns also für den Datentyp DNA_DoubleStrand. So naheliegend seine

Definition auch erscheint, sie ist nicht ohne Gefahren: Formeln vom Typ

DNA_DoubleStrand sollen beliebige doppelsträngige DNA-Moleküle darstellen. Das können sie auch. Aber darüber hinaus können wir formal korrekte Formeln des Typs

DNA_DoubleStrand hinschreiben, denen keine Doppelhelix entspricht.

incorrectDoubleStrand = ([A,C,C,G,A,T],[T,G,G,C,A,T,C])

incorrectDoubleStrand ist in zweifacher Weise falsch: Erstens sind die jeweiligen

Basen an mehreren Stellen nicht komplementär, und zweitens haben die beiden Einzelstränge gar noch unterschiedliche Länge. Wir stoßen hier auf eine grundlegende Schwierigkeit bei jeder Modellierung: Es gibt Objekte in der Modellwelt, die nichts bedeuten,

d.h. denen keine Objekte der Wirklichkeit entsprechen. Solche Formeln, die wohlgebaut,

aber ohne Bedeutung sind, nennt man syntaktisch korrekt, aber semantisch falsch. Alles

geht gut, solange beim Rechnen mit den Formeln auch keine solchen Objekte erzeugt

werden. Wenn doch, sind die Folgen meist unabsehbar. Im besten Fall bleibt die Rechnung irgendwann stecken, weil eine Funktion berechnet werden soll, die für solche Fälle

keine Regel vorsieht. Manchmal passen die Rechenregeln auch auf die nicht vorgesehenen Formeln, und dann kann es im schlimmsten Fall geschehen, daß die Rechnung ein

Ergebnis liefert, dem man nicht ansieht, daß es falsch ist.

Wir werden sehen, daß selbst die Natur im Falle der DNA-Replikation dieses Problem erkannt und einen Weg zu seiner Lösung gefundenhat. Zunächst betrachten wir

den „Normalfall“ der Replikation. Weil das Komplement jeder Base eindeutig definiert

ist, kann man zu jedem DNA-Einzelstrang den komplementären Doppelstrang berechnen.

In der Tat geschieht dies bei der Zellteilung. Der Doppelstrang wird aufgespalten, und

die DNA-Polymerase synthetisiert zu jedem der beiden Stränge den jeweils komplementären Strang. Die DNA-Polymerase können wir auf zwei verschiedene Weisen darstellen:

Enerseits ist sie ein Enzym, also selbst ein Protein:

dnaPolymerase_Sequenz = Met:Ala:Pro:Val:His:Gly:Asp:Asp:Ser ...

Dies hilft uns allerdings nicht dabei, die Wirkungsweise dieses Enzyms auszudrücken.

Noch viele Jahrzehnte werden vergehen, ehe die Wissenschaft die Funktion eines Proteins

aus der Kette seiner Aminosäuren ableiten kann. Was liegt also näher, als die Funktion der

Polymerase durch eine Funktion zu modellieren:

2.4. Modellierung in der molekularen Genetik

17

dnaPolymerase :: DNA -> DNA_DoubleStrand

dnaPolymerase x = (x, complSingleStrand x) where

complSingleStrand []

= []

complSingleStrand (a:x) = wc_complement a:complSingleStrand x

Will man prüfen (lassen), ob ein Dopplestrang tatsächlich korrekt aufgebaut ist, kann

man dies nun einfach tun.

data Bool = True | False

-- die abstrakten Urteile Wahr und Falsch

wellFormedDoubleStrand :: DNA_DoubleStrand -> Bool

wellFormedDoubleStrand (x,y) = (x,y) == dnaPolymerase x

(Zur Unterscheidung von der definierenden Gleichung schreiben wir den Vergleich zweier Formeln als ==. Dabei werden beide Formeln zunächst ausgerechnet und dann verglichen.)

Blickt man etwas tiefer ins Lehrbuch der Genetik, so findet man, daß auch die Natur

nicht ohne Fehler rechnet: Mit einer (sehr geringen) Fehlerrate wird in den neu polymerisierten Strang ein falsches (nicht komplementäres) Nukleotid eingebaut. Dadurch wird die

Erbinformation verfälscht. Daher gibt es ein weiteres Enzym, eine Exonuclease, die fehlerhafte Stellen erkennt und korrigiert. Sie muß dabei ein subtiles Problem lösen: Gegeben

ein Doppelstrang mit einem nicht komplementären Basenpaar darin – welcher Strang ist

das Original, und welcher muß korrigiert werden? Die Natur behilft sich dadurch, daß der

Originalstrang beim Kopieren geringfügig modifiziert wird – durch Anhängen von Methylgruppen an seine Nukleotide.

Diese Technik können wir nicht einsetzen, da wir die Chemie der Nukleotide nicht modellieren. Wir behelfen uns auf eine nicht weniger subtile Art: Im Unterschied zur Wirklichkeit (Doppelhelix) kann man im Modell (DNA_DoubleStrand) einen „linken“ und

„rechten“ Strang unterscheiden. Übereinstimmend mit der Modellierung der Polymerase

legen wir fest, daß stets der „linke“ Strang als Original gilt, der „rechte“ als die Kopie.

Auch die Exonuclease modellieren wir durch ihre Funktion:

exonuclease

exonuclease

exonuclease

exonuclease

exonuclease

:: DNA_DoubleStrand -> DNA_DoubleStrand

([],[])

= ([],[])

([],x)

= ([],[])

-- Kopie wird abgeschnitten

(x,[])

= dnaPolymerase x -- Kopie wird verlaengert

(a:x,b:y) = if b == ac then (a:x’,b:y’)

else (a:x’,ac:y’)

where ac

= wc_complement a

(x’,y’) = exonuclease (x,y)

Damit erhalten wir z.B. die erwünschte Korrektur des fehlerhaften Doppelstrangs:

18

2. Modellierung

exonuclease incorrectDoubleStrand ==> ([A,C,C,G,A,T],[T,G,G,C,T,A])

Unsere Definition der Exonuclease ist der Natur abgelauscht. Vom Standpunkt des Rechenergebnisses aus betrachtet (man nennt diesen Standpunkt extensional) können wir

das Gleiche auch einfacher haben: Verläßt man sich darauf, daß unsere DNA-Polymerase

im Modell keine Fehler macht, kann man einfach den kopierten Strang gleich neu polymerisieren.

dnaCorr :: DNA_DoubleStrand -> DNA_DoubleStrand

dnaCorr (x,y) = dnaPolymerase x

Es ist nicht ganz überflüssig, die gleiche Funktion auf verschiedene Weisen zu beschreiben. Daraus ergibt sich die Möglichkeit, das Modell an sich selbst zu validieren. Es muß

ja nun die folgende Aussage gelten:

Für alle d::DNA_DoubleStrand gilt dnaCorr d == exonuclease d.

Außerdem muß die dnaPolymerase eine Idempotenzeigenschaft aufweisen:

Für alle x::DNA gilt: x == z where

(x,y) == dnaPolymerase x

(y,z) == dnaPolymerase y

Wir formulieren solche Eigenschaften, die wir aus der Wirklichkeit kennen, in der Sprache der Modellwelt. Können wir sie dort als gültig nachweisen, so wissen wir erstens,

daß unser Modell im Hinblick auf genau diese Eigenschaften der Realität entspricht. Aber

noch mehr: Sofern wir diese Eigenschaften beim Formulieren des Modells nicht explizit

bedacht haben, fördert ihr Nachweis auch unser generelles Vertrauen in die Tauglichkeit

des Modells. Wir werden später Techniken kennenlernen, wie man solche Eigenschaften

nachweist.

Fast ohne Ausnahme benutzen alle Lebewesen den gleichen genetischen Code. Bestimmte Dreiergruppen (genannt Codons) von Nukleotiden codieren für bestimmte Aminosäuren. Da es 43 = 64 Codons, aber nur 20 Aminosäuren gibt, werden viele Aminosäuren durch mehrere Codons codiert. Einige Codons codieren für keine Aminosäure; man

bezeichnet sie als Stop-Codons, da ihr Auftreten das Ende eines Gens markiert.

Der genetische Code ist also eine Funktion, die Codons auf Aminosäuren abbildet. (Wir

abstrahieren hier davon, daß die DNA zunächst in RNA transkribiert wird, wobei die Base

Thymin überall durch Uracil ersetzt wird.)

genCode

genCode

genCode

genCode

:: Codon -> AminoAcid

(A,A,A)

= Lys;

(A,A,C)

= Asn;

(A,C,_)

= Thr

genCode (A,A,G)

genCode (A,A,T)

= Lys

= Asn

2.4. Modellierung in der molekularen Genetik

genCode

genCode

genCode

genCode

genCode

genCode

genCode

genCode

genCode

genCode

genCode

genCode

genCode

genCode

genCode

genCode

genCode

genCode

genCode

genCode

genCode

genCode

genCode

(A,G,A)

(A,G,C)

(A,T,A)

(A,T,T)

(A,T,G)

(C,A,A)

(C,A,C)

(C,G,_)

(C,C,_)

(C,T,_)

(G,A,A)

(G,A,C)

(G,C,_)

(G,G,_)

(G,T,_)

(T,A,A)

(T,G,A)

(T,A,C)

(T,C,_)

(T,G,G)

(T,G,C)

(T,T,A)

(T,T,C)

=

=

=

=

=

=

=

=

=

=

=

=

=

=

=

=

=

=

=

=

=

=

=

Arg;

Ser;

Ile;

Ile

Met

Glu;

His;

Arg

Pro

Leu

Glu;

Asp;

Ala

Gly

Val

Stp;

Stp

Tyr;

Ser

Trp

Cys;

Leu;

Phe;

19

genCode (A,G,G)

genCode (A,G,T)

genCode (A,T,C)

= Arg

= Ser

= Ile

genCode (C,A,G)

genCode (C,A,T)

= Glu

= His

genCode (G,A,G)

genCode (G,A,T)

= Glu

= Asp

genCode (T,A,G)

= Stp

genCode (T,A,T)

= Tyr

genCode (T,G,T)

genCode (T,T,G)

genCode (T,T,T)

= Cys

= Leu

= Phe

Ein Gen beginnt stets mit dem „Startcodon“ (A,T,G) , setzt sich dann mit weiteren

Codons fort und endet mit dem ersten Auftreten eines Stopcodons. Die Translation, d.h.

die Übersetzung des Gens in das codierte Protein erfolgt am Ribosom. Dies ist ein sehr

komplexes Molekül, ein Verbund aus Proteinen und Nukleinsäuren. Wir modellieren es

durch seine Funktion:

ribosome :: DNA -> Protein

ribosome (A:T:G:x) = Met:translate (triplets x) where

triplets :: [a] -> [(a,a,a)]

triplets []

= []

triplets (a:b:c:x) = (a,b,c):triplets x

translate :: [Codon] -> Protein

translate []

= []

translate (t:ts) = if aa == Stp then []

else aa:translate ts where

aa

= genCode t

Auch hier haben wir wieder einige Modellierungsentscheidungen getroffen, die man

sich klarmachen muß. Dies betrifft die Behandlung inkorrekt aufgebauter Gene, die auch

20

2. Modellierung

in der Natur gelegentlich vorkommen. Fehlt das Startcodon, wird kein Protein produziert.

Ist das Gen unvollständig, d.h. bricht es ohne Stopcodon ab, so ist ein unvollständiges

Proteinprodukt entstanden, das entsorgt werden muß. Im Modell ist dies so ausgedrückt:

• Fehlt das Startcodon, gibt es keine passende Rechenregel für ribosome, und die

Rechnung beginnt gar nicht erst.

• Ist das letzte Triplett unvollständig, bleibt die Rechnung in einer Formel der Art

triplets [a] oder triplets[a,b] stecken, für die wir keine Rechenregel vorgesehen haben. Ein Fehlen des Stopcodons wird verziehen. Wer dies nicht will,

streicht die erste Regel für translate, so daß ohne Stopcodon die Rechnung am Ende

in translate [] steckenbleibt.

Eine frühere Entscheidung hat sich hier gelohnt: Da wir den Listentyp polymorph eingeführt haben, können wir hier auch ganz nebenbei Listen von Codons, d.h. den Typ

[Codon] verwenden.

Bisher haben wir Vorgänge modelliert, die in der Natur selbst vorkommen. Zum Abschluß nehmen wir den Standpunkt des Naturforschers ein. Heute liefern die großen

Sequenzierprojekte dank weitgehender Automatisierung eine Fülle von DNA-Sequenzen

immer mehr Organismen. Von einigen ist sogar bereits das komplette Genom bekannt,

etwa vom Koli-Bakterium (ca. 3 Millionen Basenpaare) oder der Bäckerhefe (ca. 14 Millionen Basenpaare). Den Forscher interessiert nun unter anderem, welche Gene eine neue

DNA-Sequenz möglicherweise enthält. Sequenzabschnitte, die den Aufbau eines Gens haben, nennt man ORFs (open reading frames). Ob es sich bei ihnen tatsächlich um Gene

handelt, hängt davon ab, ob sie jemals vom Ribosom als solche behandelt werden. Dies

kann man der Sequenz heute nicht ansehen. Wohl aber ist es interessant, in einer neuen

DNA-Sequenz nach allen ORFs zu suchen und ihre Übersetzung in hypothetische Proteine vorzunehmen. Wir wollen also für unsere Kollegin aus der Molekularbiologie eine

Funktion definieren, die genau dieses tut.

Damit ist unsere Aufgabe so bestimmt: Wir gehen von einem DNA-Doppelstrang aus,

der zu untersuchen ist. Als Ergebnis möchten wir alle ORFs in übersetzter Form sehen, die

in dem Doppelstrang auftreten.

Wir wollen diese Aufgabe durch eine Funktion analyseORFs lösen. Schon beim Versuch, den Typ dieser Funktion anzugeben, wird klar, daß die Aufgabe zwar halbwegs ausreichend, aber keineswegs vollständig beschrieben ist.

Was genau bedeutet „alle ORFs“? Weder in der DNA, noch in unserem Modell liegt

eine feste Einteilung der Nukleotidsequenz in Codons vor. Das Auftreten einer Dreiergruppe A,T,G definiert implizit die Lage der folgenden Codons. Ein einzelnes Nukleotid

kann so drei verschiedenen Leserastern angehören, in denen es jeweils als 1., 2. oder 3.

Element eines Codons interpretiert wird. Damit kann ein DNA-Abschnitt überlappende

2.4. Modellierung in der molekularen Genetik

21

ORFs enthalten. Das gleiche gilt für den Gegenstrang, der dabei in umgekehrter Richtung

abzulesen ist.

„Alle ORFs“ zu finden ist also etwas komplizierter als es zunächst erscheint. Das führt

zu der Frage, wie eigentlich das Ergebnis aussehen soll. Einfach eine Liste aller ORFs,

die vorkommen? Oder will man zu jedem ORF auch wissen, in welchem Leseraster auf

welchem Strang er liegt? Möchte man gar zusätzliche Informationen erhalten, wie etwa

Länge eines ORF und seine Lage relativ zum Anfang der DNA-Sequenz? Schließlich –

wir wissen ja was unsere Kollegin letzlich interessiert – könnte man die hypothetischen

Proteine noch mit einer Proteindatenbank abgleichen, um zu sehen, ob ein solches (oder

ein ähnliches) Protein an anderer Stelle bereits nachgewiesen wurde ...

Es ist immer ein gutes Entwurfsprinzip

• möglicherweise interessante Information, die während der Rechnung anfällt, auch

im Ergebnis sichtbar zu machen. Dies gilt hier für die Verteilung der ORFs auf die

Leseraster.

• die Funktionalität eines Entwurfs nicht zu überfrachten. Was gut und logisch einleuchtend durch zwei getrennte Funktionen realisiert werden kann, wird auch getrennt. Dadurch entstehen kleine Bausteine von überschaubarer Komplexität, die

möglicherweise auch in anderem Kontext wiederverwendbar sind.

Wir entscheiden, daß das Ergebnis eine Liste von 6 Listen übersetzter ORFs sein soll,

getrennt nach Leseraster. Wir halten diesen Beschluß durch die entsprechende Typdeklaration fest.

analyzeORFs :: DNA_DoubleStrand -> [[Protein]]

Da ein Startcodon an beliebiger Stelle stehen kann, bilden wir zunächst 6 verschiedene

Leseraster, die dann alle nach ORFs durchsucht werden.

frames3 :: DNA -> [[Codon]]

frames3 x = if length x < 3 then [[],[],[]]

else [triplets x, triplets (tail x),

triplets (tail(tail x))] where

triplets :: [a] -> [(a,a,a)]

triplets []

= []

triplets [_]

= []

triplets [_,_]

= []

triplets (a:b:c:x) = (a,b,c):triplets x

findStartPositions :: [Codon] -> [[Codon]]

findStartPositions []

= []

findStartPositions (c:x) = if c == (A,T,G) then (c:x):findStartPositions x

else findStartPositions x

22

2. Modellierung

analyzeORFs (strain,antistrain)

= map (map translate) orfs where

sixframes = frames3 strain ++ frames3 (reverse antistrain)

orfs

= map findStartPositions sixframes

Der polymorphe Listendatentyp wird hier in verschiedener Weise benutzt; das Ergebnis

z.B. ist eine Liste von Listen von Listen von Aminosäuren. Wir unterstellen Funktionen

(++) und reverse, die Listen aller Art verketten bzw. umkehren. Die Umkehrung des

Gegenstrangs ist notwendig, weil dieser am Ribosom in gegenläufiger Richtung gelesen

wird. Die Funktion map schließlich wendet eine Funktion f auf alle Elemente einer Liste

an, so daß z.B. gilt map f [x,y,z] = [f x, f y, f z].

Einige Beispiele:

dna_seq3 = dnaPolymerase [A,A,T,G,T,C,C,A,T,G,A,A,T,G,C]

dna_seq4 = dnaPolymerase [A,T,G,A,T,G,A,A,T,G,C,C,G,G,C,A,T,T,C,A,T,C,A,T]

analyzeORFs dna_seq3 ==>

[[],

[[Met, Ser, Met, Asn], [Met, Asn]],

[[Met]],

[[Met, Asp, Ile]],

[],

[]]

analyzeORFs dna_seq4 ==>

[[[Met, Met, Asn, Ala, Gly, Ile, His, His],

[Met, Asn, Ala, Gly, Ile, His, His]],

[[Met, Pro, Ala, Phe, Ile]],

[],

[[Met, Met, Asn, Ala, Gly, Ile, His, His],

[Met, Asn, Ala, Gly, Ile, His, His]],

[[Met, Pro, Ala, Phe, Ile]],

[]]

Daß bei dna_seq4 auf Strang und Gegenstrang die gleichen hypothetischen Proteine

gefunden werden, liegt am besonderen Aufbau dieser Beispielsequenz: Strang und reverser Gegenstrang (in umgekehrter Leserichtung) sind gleich.

2.5. Anforderungen an Programmiersprachen

23

2.5. Anforderungen an Programmiersprachen

Aus der Sprache der Mathematik haben wir den Umgang mit Formeln übernommen. Dabei zeigt sich gleich ein wichtiger Unterschied: Die „Sprache“ der Mathematik ist im wesentlichen fertig – die meisten Anwender kommen ein Leben lang mit den einmal erlernten Formeln und Begriffen – sagen wir einmal aus Arithmetik, Algebra und Analysis – aus.

Erweiterungen dieser Sprache, die Einführung neuer Begriffe und Notationen bleibt einer

kleinen Gemeinde von Forschern vorbehalten, die in dieser Hinsicht keinen Regeln unterliegen. In der Informatik ist das Gegenteil der Fall. Modellierung bedeutet Schaffung

neuer Formelwelten. Jeder Programmierer führt neue Objekte (Typen) und Beziehungen

zwischen ihnen (Funktionen) ein. Wenn ein Formalismus ständig erweitert wird und trotzdem allgemein verständlich und sogar durch den Computer ausführbar sein soll, dann muß

es einen festen Rahmen dafür geben, was man wie hinschreiben darf. Dies begründet die

besondere Rolle der Programmiersprachen in der Informatik. Ihre Syntax legt fest, wie

etwas aufgeschrieben wird. Ihre Semantik bestimmt, wie mit diesen Formeln zu rechnen

ist, sei es durch uns selbst, sei es durch den Computer. Eine präzise definierte Syntax und

Semantik ist die Mindestanforderung an eine Programmiersprache.

Anhand der vorangehenden Abschnitte können wir einige Beobachtungen dazu machen, was eine Programmiersprache darüber hinaus leisten muss.

• Ein strenges, aber flexibles Typkonzept hält die Formelwelt in Ordnung. Streng bedeutet, daß jeder Formel ein Typ zugeordnet wird und sich daher fast alle Programmierfehler bereits als Typfehler bemerkbar machen. Flexibel heißt andererseits, daß

uns das Typkonzept nicht zwingen darf, die gleiche Operation mehrfach zu programmieren, nur weil sich die Typen unwesentlich unterscheiden.

• Ein hierarchisch organisierter Namensraum erlaubt die Kontrolle über die Sichtbarkeit von Namen. Definitionen können ihrerseits lokale Bezeichnungen einführen, die

nach außen hin nicht sichtbar sind. Die Funktion triplets haben wir zweimal und

leicht unterschiedlich definiert, jeweils als lokale Definition innerhalb der Definitionen von ribosome und frames3. Ohne lokal beschränkte Sichtbarkeit könnte

man sich bei größeren Programmen vor Namenskonflikten nicht retten – man denke

allein an die vielfache Verwendung der Variablen „x“ . . . .

• Methoden zum Nachweis von Programmeigenschaften erlauben uns, die Übereinstimmung des Modells mit wesentlichen Aspekten der modellierten Wirklichkeit zu

verifizieren. Auch die Korrektheit einzelner Funktionen sollte man einfach nachweisen können, indem man algebraische Eigenschaften wie im Fall der exonuclease

benutzt.

24

2. Modellierung

• Ein hohes Abstraktionsniveau der Programmiersprache gewährleistet eine überschaubare Beziehung zwischen Modell und Wirklichkeit. Wir wollen Rechenregeln formulieren, die für uns nachvollziehbar sind. Schließlich müssen zuerst wir selbst unsere

Programme verstehen. Vom Computer nehmen wir einfach an, daß er damit klarkommt. (Dafür zu sorgen ist natürlich die Aufgabe des Übersetzers für die jeweilige

Programmiersprache.) Sprachen auf geringem Abstraktionsniveau verlangen doppelten Aufwand, weil die formale Beschreibung der Modellwelt und die Programmierung auseinanderfallen.

Wir haben Haskell als Programmiersprache gewählt, weil es derzeit die obigen Kriterien

am besten erfüllt. Wir werden im Laufe der Vorlesung noch weitere Anforderungen an

Programmiersprachen kennenlernen, und nicht alle sehen Haskell als Sieger.

3. Eine einfache Programmiersprache

Ziele des Kapitels: Im Kapitel Modellierung haben wir uns darauf konzentriert, wie man

Objekte und Zusammenhänge der Realität durch Formeln und ihr Verhalten rechnerisch

nachbildet. Wir haben uns darauf verlassen, daß jeder mit Formeln rechnen kann, auch

wenn diese etwas anders aussehen als aus der Mathematik gewohnt. In diesem Kapitel nehmen wir die umgekehrte Perspektive ein und betrachten näher, wie die Formeln

aussehen, mit denen wir rechnen (lassen) wollen. Mit anderen Worten: wir legen eine

Programmiersprache fest. Diese Sprache wollen wir möglichst einfach halten, da sie uns

nur als Vehikel dient, um über weitere Grundkonzepte der Informatik reden zu können.

Wir werden also nur einen Auschnitt aus der Sprache Haskell einführen.

Gliederung des Kapitels: Ein Haskell-Programm besteht aus einer Folge von Definitionen

und Deklarationen: Definiert werden Werte, meistens Funktionen, und neue Datentypen;

deklariert werden die Typen von Werten. Für Rechnungen spielen Deklarationen keine

Rolle; sie sind nur der „Ordnung halber“ da. Aber wie sagt man so schön: „Ordnung ist

das halbe Leben.“.

3.1. Datentypen

3.1.1. Datentypdefinitionen

Neue Typen und die dazugehörigen Werte werden mittels einer Datentypdefinition definiert. Sie führen Daten-Konstruktoren (kurz Konstruktoren) ein, die unsere Formelwelt

bereichern. Beispiele aus Abschnitt 2.1 sind Musik und Instrument, die wir hier noch

einmal wiederholen:

data Instrument =

|

|

|

Oboe

HonkyTonkPiano

Cello

VoiceAahs

data Musik

Note Ton Dauer

Pause Dauer

Musik :*: Musik

Musik :+: Musik

=

|

|

|

Grit Garbo: Mit anderen Worten: ganz schön ungewohnt.

26

3. Eine einfache Programmiersprache

| Instr Instrument Musik

| Tempo GanzeZahl Musik

Der Typ Instrument führt nur nullstellige Konstruktoren ein. Solche Typen nennt man

Aufzählungstypen. Der Typ Musik hat einen einstelligen Konstruktor (Pause) und fünf

zweistellige Konstruktoren (Note, (:*:), (:+:), Instr, Tempo). Diese Konstruktoren

nehmen wiederum Argumente eines bestimmten Typs, hier etwa Ton und Dauer für Note

und Instrument und Musik bei Instr.

Die Typen der Konstruktor-Argumente können auch Typparameter sein, wie wir das

schon beim Listentyp gesehen haben. Alle Typparameter werden als Argumente des Typnamens auf der linken Seite der Definition angegeben. Die Datentypdefinition selbst wird

mit dem Schlüsselwort1 data eingeleitet. Die allgemeine Form einer Datentypdefinition

hat somit die Gestalt

data T a1 . . . am

=

C1 t11 . . . t1n1

|

...

|

Cr tr1 . . . trnr

mit m > 0, r > 1 und ni > 0. Im Falle m > 0 bezeichnet man den neuen Typ T auch

als Typkonstruktor, weil er in Analogie zu den Daten-Konstruktoren Typen als Argumente

nimmt und daraus Typausdrücke bildet. Allerdings treten diese nur in Typangaben auf und

sind keine Formeln, mit denen gerechnet wird.

Programmierhinweis: Die Namen von Typen bzw. Typkonstruktoren und Konstruktoren müssen

großgeschrieben werden (genauer: der erste Buchstabe groß, alle folgenden beliebig). Die Namen

von Werten bzw. Funktionen, Parametern und Typparametern müssen hingegen klein geschrieben

werden (genauer: der erste Buchstabe klein, alle folgenden beliebig). Jeder Name darf nur einmal

verwendet werden. Ausnahme: Für einen Typ und einen Konstruktor bzw. für eine Variable und

einen Typparameter darf der gleiche Name benutzt werden, da sich Werte und Typen „nicht in die

Quere kommen“.

Wir sehen uns nun einige Datentypen von allgemeiner Nützlichkeit an. Wir geben jeweils die Typdefinition an, erläutern die Semantik des Typs, und gehen gegebenenfalls auf

spezielle Notationen ein.

Wahrheitswerte