Grundbegriffe aus der Vorlesung Lineare Algebra

Werbung

Grundbegriffe aus der Vorlesung Lineare Algebra

16. September 2015

1

Inhaltsverzeichnis

1 Vektorräume

3

2 Lineare Abbildungen

4

3 Der Dualraum

5

4 Bilinearformen

6

5 Determinanten

7

6 Euklidische und unitäre Vektorräume

6.1 Euklidische Vektorräume . . . . . . .

6.2 Unitäre Vektorräume . . . . . . . . .

6.3 Selbst-adjungierte Abbildungen . . .

6.4 Normale Abbildungen . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

9

9

10

11

12

7 Polynome

12

8 Eigenwerte, Eigenvektoren, Diagonalisierbarkeit

14

9 Trigonalisierbarkeit

16

10 Jordan-Normalform

10.1 Polynome von Endomorphismen . . . . . . . . . . . . . . . . . . . . . . . . .

16

17

11 Quotientenräume

19

12 Vektorraum der r-Formen

19

13 Orientierungen von Vektorräumen

21

2

1

Vektorräume

Ein Vektorraum über einem Körper K (auch: K-Vektorraum) ist eine abelsche Gruppe

(V, +) zusammen mit einer Abbildung · : K × V → V, (λ, v) 7→ λ · v (der skalaren

Multiplikation), für die folgende Eigenschaften erfüllt sind:

1. ∀ λ ∈ K, u, v ∈ V :

λ · (u + v) = λ · u + λ · v

2. ∀ λ, µ ∈ K, u ∈ V :

(λ + µ) · v = λ · v + µ · v,

(λ µ) · v = λ(µ · v),

1·v =v

Sei V ein K-Vektorraum. Eine Teilmenge W ⊂ V heißt Untervektorraum von V (kurz:

Unterraum), falls

1. 0V ∈ W,

2. ∀v, w ∈ W :

v + w ∈ W,

3. ∀v ∈ W, λ ∈ K :

λ·v ∈W

Sei V ein K-Vektorraum und v1 , . . . , vm ∈ V . Ein Vektor w ∈ V der Form

w = λ1 v1 + . . . + λm vm ,

λ1 , . . . λm ∈ K

heißt Linearkombination der Vektoren v1 , . . . vm .

Sei V ein K-Vektorraum und sei U ⊂ V eine beliebige Teilmenge. Dann ist die lineare

Hülle von U in V ( auch: der von U aufgespannte Raum ) definiert als

spanK (U ) := {v ∈ V | v ist Linearkombination von Vektoren aus U}

Seien v1 , . . . , vm ∈ V , dann ist die lineare Hülle des m-Tupels (v1 , . . . , vm ) definiert als

spanK (v1 , . . . , vm ) := {λ1 v1 + . . . + λm vm | λ1 , . . . , λm ∈ K}

Sei V ein K-Vektorraum. Vektoren v1 , . . . vm ∈ V heißen linear unabhängig falls:

λ1 v1 + . . . + λm vm = 0 mit λ1 , . . . , λm ∈ K

⇒

λ1 = . . . = λm = 0 .

D.h. eine Linearkombination der Vektoren v1 , . . . , vm ist nur der Nullvektor, falls alle Koeffizienten Null sind.

Sei V ein K-Vektorraum und M ⊂ V .

1. M heißt Erzeugendensystem von V falls:

spanK (M ) = V

2. M heißt Basis von V , falls M ein linear unabhängiges Erzeugendensystem ist.

3

Die kanonische Basis (auch: Standardbasis) des Vektorraumes V = K n ist definiert als

B = (e1 , . . . , en ) mit ei = (0, . . . , 0, 1, 0, . . . , 0)T , wobei die Eins an der i-ten Stelle steht.

Ein K-Vektorraum V heißt endlich erzeugt, falls es ein endliches Erzeugendensystem von

V gibt, d.h. es existiert eine Menge M = {v1 , . . . , vm } mit V = spanK (M ).

Ein K-Vektorraum V heißt n-dimensional, dimK V = n, falls er eine Basis mit n Vektoren

besitzt. Anderenfalls nennt man V unendlich-dimensional, dimK V = ∞.

Sei V ein K-Vektorraum mit Unterräumen W1 , . . . , Wr ⊂ V . Die Summe der Unterräume

W1 , . . . , Wr ist definiert als

W1 + . . . + Wr := {v = w1 + . . . + wr ∈ V | wi ∈ Wi , i = 1, ..., r} .

Ein K-Vektorraum V heißt direkte Summe seiner Unterräume W1 , W2 ⊂ V falls

V = W1 + W2

und

W1 ∩ W2 = {0} .

In diesem Fall schreibt man: V = W1 ⊕ W2 .

Sei V ein K-Vektorraum mit einem Unterraum W ⊂ V . Ein Komplement von W in V ,

auch direkter Summand von V zu W , ist ein Unterraum W 0 ⊂ V mit

V = W ⊕ W0 .

2

Lineare Abbildungen

Eine Abbildung F : V → W zwischen zwei K-Vektorräumen V und W heißt K-lineare

Abbildung, falls für alle u, v ∈ V und λ ∈ K gilt:

F (u + v) = F (u) + F (v)

und

F (λu) = λ F (u) .

Eine bijektive lineare Abbildung heißt Isomorphismus. In diesem Fall heißen die Vektorräume V und W zueinander isomorph, man schreibt: V ∼

= W . Eine lineare Abbildung

F : V → V heißt Endomorphismus von V und ein Isomorphismus F : V → V heißt

Automorphismus von V .

4

Hom K (V ; W ) := {F : V → W | K−linear}

Raum der K-linearen Abbildungen (dies ist ein Vektorraum).

End K (V ) := Hom K (V, V ),

Raum der Endomorphismen von V (dies ist ein Ring, sogar eine K-Algebra).

AutK (V ) := GL (V ) = {F : V → V | F Isomorphismus} , speziell: GL n (K) = GL (K n ):

Raum der K-linearen Isomorphismen (allgemeine lineare Gruppe von V ).

Sei K ein Körper. Eine K-Algebra ist ein Ring R mit Eins, der gleichzeitig ein K-Vektorraum

ist, so dass zusätzlich für alle f, g ∈ R und λ ∈ K gilt:

λ · (g · f ) = (λ · g) · f = g · (λ · f ) .

Sei F : V → W eine K-lineare Abbildung. Man definiert:

1. Kern von F :

Ker F = {v ∈ V | F (v) = 0}

2. Bild von F :

Im F = {F (v) | v ∈ V }

3. Rang von F :

Rang (F ) = dim Im (F )

Eine Projektion ist eine lineare Abbildung P : V → V mit P 2 = P . Jede Projektion

definiert eine direkte Summenzerlegung: V = Ker P ⊕ Im P . Die Projektion P ist dann die

Projektion auf den Unterraum Im P . Umgekehrt definiert jede direkte Summenzerlegung

V = U ⊕ W Projektionen auf die Unterräume U bzw. W .

Sei F : V → W eine K-lineare Abbildung zwischen zwei K-Vektorräumen V, W mit Basen

A = (v1 , . . . , vn ) von V und B = (w1 , . . . , wm ) von W . Die darstellende Matrix von F ,

bzgl. der BasenPA und B ist die Matrix MBA (F ) = (aij ) ∈ M (m × n, K), die definiert ist

durch F (vj ) = m

i=1 aij wi , j = 1, . . . , n.

Sei V ein K-Vektorraum mit einer Basis A = (v1 , . . . , vn ). Dann ist der kanonische Basisisomorphismus ΦA : V → K n definiert durch ΦA (vi ) = ei , i = 1, . . . , n, d.h. ΦA (v) =

(x1 , . . . , xn ) falls v = x1 v1 + . . . + xn vn .

3

Der Dualraum

Sei V ein K-Vektorraum. Der Dualraum V ∗ von V ist definiert als

V ∗ := Hom K (V, K) = {λ : V → K | K − linear} .

5

Vektoren im Dualraum V ∗ nennt man Linearformen oder auch lineare Funktionale.

Sei V ein K-Vektorraum mit einer Basis A = (v1 , . . . , vn ). Dann ist die zu A duale Basis

eine Basis A∗ = (v1∗ , . . . , vn∗ ) von V ∗ , definiert durch vi∗ (vj ) := δij , für 1 ≤ i, j ≤ n.

Fakten: Zu jeder Basis existiert eine eindeutig bestimmte duale Basis. Jede Linearform

λ ∈ V ∗ schreibt sich als λ = λ1 v1∗ + . . . + λn vn∗ , wobei sich die Koeffizienten λi ergeben als

λi = λ(vi ), i = 1, . . . , n. Es gilt: dim V = dim V ∗ . Für euklidische Vektorräume gibt es

einen kanonischen Isomorphismus Φ : V → V ∗ , v 7→ λv mit λv (w) := hw, vi. Man nennt

V ∗ ∗ := (V ∗ )∗ den Bidualraum von V . Es gibt eine kanonische Identifizierung j : V → V ∗ ∗

mit j(v)(λ) := λ(v).

Sei F : V → W eine K-lineare Abbildung. Die zu F duale Abbildung F ∗ : W ∗ → V ∗ ist

für λ ∈ W ∗ und v ∈V definiert als: F ∗ (λ)(v) = λ(F v), d.h. F ∗ (λ) = λ ◦ F .

Fakten: Die Zuordnung F 7→ F ∗ ist K-linear. Es gilt: (F ◦ G)∗ = G∗ ◦ F ∗ und Id∗V = IdV ∗ .

Weiter ist F genau dann ein Isomorphismus, wenn F ∗ es ist und: (F ∗ )−1 = (F −1 )∗ . Sei

F : V → W linear, sei A eine Basis in V und B eine Basis in W , dann gilt

∗

MAB∗ (F ∗ ) = (MBA (F ))T .

Sei U ⊂ V ein Unterraum. Dann ist der Annullator von U ein Unterraum U 0 ⊂ V ∗ definiert

durch:

U 0 = {λ ∈ V ∗ | λ(u) = 0 ∀ u ∈ U } .

Fakten: Es gilt: dim U 0 = dim V − dim U und Im F ∗ = (Ker F )0 bzw. Ker F ∗ = (Im F )0 .

Daraus folgt insbesondere Rang (F ∗ ) = Rang (F ).

4

Bilinearformen

Sei V ein K-Vektorraum. Eine Bilinearform auf V ist eine Abbildung

b : V × V −→ K,

(v, w) 7→ b(v, w) ,

so dass für alle v, v 0 , w, w0 ∈ V und λ ∈ K gilt

b(v + v 0 , w) =

b(v, w) + b(v 0 , w),

b(λv, w) = λ b(v, w)

b(v, w + w0 ) =

b(v, w) + b(v, w0 ),

b(v, λw) = λ b(v, w)

6

Eine Bilinearform b : V × V → K heißt symmetrisch, falls für alle v, w ∈ V gilt

b(v, w) = b(w, v) .

Eine Bilinearform heißt schiefsymmetrisch oder alternierend, falls entsprechend

b(v, w) = − b(w, v) .

Eine Bilinearform heißt positiv definit, falls für alle v ∈ V mit v 6= 0 gilt:

b(v, v) > 0 .

Eine Bilinearform b : V × V → K heißt nicht ausgeartet oder regulär, falls sie durch die

Abbildung v 7→ b(·, v) einen Isomorphismus V → V ∗ definiert. Äquivalent dazu ist, dass kein

v0 ∈ V, v0 6= 0 existiert mit b(v, v0 ) = 0, für alle v ∈ V .

Die zu einer Bilinearform b : V × V → K gehörende quadratische Form qb ist definiert

durch

qb : V → K,

qb (v) := b(v, v) .

Sei K ein Körper mit char(K) 6= 2 d.h. 2 6= 0 in K. Dann ist eine Bilinearform b über die

Polarisierungsformel vollständig durch die zugehörige quadratische Form qb bestimmt:

b(v, w) =

5

1

(qb (v + w) − qb (v) − qb (w)) .

2

Determinanten

Die symmetrische Gruppe Sn ist die Gruppe der bijektiven Abbildungen der Menge

{1, . . . , n}. Die Gruppenelemente der symmetrischen Gruppe nennt man Permutationen.

Permutationen, die genau zwei Elemente vertauschen und die restlichen Elemente festlassen

heißen Transpositionen.

Zu einer Permutation σ ∈ Sn ist die Permutationsmatrix Pσ ∈ Mn (R) definiert durch

(Pσ )ij = δσ(i),j , wobei R irgendein Ring mit Eins ist.

Das Signum einer Permutation σ ∈ Sn ist definiert als sign (σ) := det(Pσ ). Es gilt:

sign σ = (−1)a(σ) ,

wobei a(σ) die Anzahl der Fehlstände ist, d.h. die Anzahl der Paare (i, j) mit i < j und

σ(i) > σ(j). Permutation mit Signum +1 heißen gerade, die mit Signum -1 heißen ungerade.

7

Das Signum einer Permutation σ ∈ Sn lässt sich auch berechnen durch:

Y σ(i) − σ(j)

= det(eσ(1) , . . . , eσ(n) ) .

sign σ =

i

−

j

i<j

Fakten: Jede Permutation lässt sich als Produkt von Transpositionen schreiben. Die Abbildung σ 7→ sign (σ) ist ein Gruppenhomomorphismus. Die Menge An der geraden Permutationen ist eine Untergruppe in Sn , mit: |An | = 12 |Sn | = 21 n!.

Die Leibniz-Formel gibt folgende Vorschrift zur Berechnung der Determinante einer Matrix

A = (aij ) ∈ Mn (K):

X

det A =

sign σ aσ(1)1 · . . . · aσ(n)n .

σ∈Sn

Der Laplace-Entwicklungssatz gibt folgende Vorschrift zur Berechnung der Determinante

einer Matrix A = (aij ) ∈ Mn (K):

det A =

n

X

(−1)i+j aij det Aij ,

i=1

wobei Aij ∈ Mn−1 (K) die Matrix ist, die man aus A durch das Streichen der iten Zeile und

jten Spalte erhält, wobei j ∈ {1, . . . , n} beliebig.

Bemerkung: Die Determinante wird definiert durch die Formel aus dem Laplace-Entwicklungssatz für j = 1, d.h. mit der Entwicklung nach der ersten Spalte. Diese Definition und auch die Leibniz-Formel sowie der Laplace-Entwicklungssatz gelten dann auch für

Matrizen, die Einträge in einem Ring R mit Eins haben.

Fakten: Sei A ∈ M (n × l, R), l ≤ n, R ein kommutativer Ring mit Eins. Es bezeichne

Ai1 ,...,il ∈ Ml (R) die Matrix, die aus den Zeilen zi1 , . . . , zil von A besteht. Die Formel von

Cauchy-Binet besagt:

X

det(AT · B) =

det(Ai1 ,...,il ) · det(Bi1 ,...,il ) ,

i1 <...<il

dabei sind A, B ∈ M (n × l, R). Spezialfall: det(A · B) = det A · det B, für A, B ∈ Mn (R).

Man nennt

X

G(A) := det(AT · A) =

det(Ai1 ,...,il )2 ≥ 0

i1 <...<il

die Gramsche Determinante von A. Es gilt Rang (A) ≥ l genau dann, wenn det(AT · A) > 0.

Seien v1 , . . . , vl ∈ Rn und A die Matrix A = (v1 , . . . , vl ) ∈ M (n × l, R). Dann definiert man

das l-dimensionale Volumen desp

durch die Vektoren v1 , . . . , vl aufgespannten Parallelepipeds

(Spat) durch Vol (v1 , . . . , vl ) := G(A) und insbesondere Vol (v1 , . . . , vn ) = | det A|.

Weiter gilt det A = det AT .

8

6

6.1

Euklidische und unitäre Vektorräume

Euklidische Vektorräume

Ein euklidischer Raum ist ein reeller Vektorraum V mit einer symmetrischen, positiv

definiten Bilinearform b : V × V → R. Eine solche Bilinearform b nennt man euklidisches

Skalarprodukt. Man schreibt auch b(·, ·) = h·, ·i.

Das kanonische Skalarprodukt (auch Standardskalarprodukt) auf Rn ist ein euklidisches Skalarprodukt auf Rn definiert durch:

hv, wi := v T · w = v1 w1 + . . . + vn wn .

für Vektoren v = (v1 , . . . , vn )T und w = (w1 , . . . , wn ) aus Rn ..

Jedes euklidische Skalarprodukt b definiert eine (euklidische) Norm durch

p

b(v, v)

kvk =

und einen Abstand, oder Metrik durch d(v, w) = kv − wk .

Sei (V, h·, ·i) ein euklidischer Vektorraum. Zwei Vektoren v, w ∈ V heißen zueinander orthogonal, falls hv, wi = 0. Ein Orthonormalsystem in V ist eine Menge von Vektoren

v1 , v2 , . . . mit hvj , vk i = δjk , d.h. die Vektoren haben die Länge 1 und sind paarweise orthogonal. Eine Orthonormalbasis ist eine Basis von V , die zusätzlich ein Orthonormalsystem

ist.

Fakten: Die kanonische Basis von Rn ist eine Orthonormalbasis bzgl. des kanonischen Skalarproduktes von Rn . Jeder euklidische Vektorraum besitzt eine Orthonormalbasis, die aus

einer beliebigen Basis durch das Gram-Schmidt-Verfahren konstruiert wird.

Sei M ⊂ V eine beliebige Teilmenge. Dann ist das orthogonale Komplement von M

definiert durch:

M ⊥ := {v ∈ V | hv, wi = 0 ∀ w ∈ M }

Sei U ⊂ V ein Unterraum. Dann gilt V = U ⊕ U ⊥ und die orthogonale Projektion auf U

ist definiert durch

pU : V → U,

pU (v) = u

falls v = u + w mit u ∈ U und w ∈ U ⊥ .

Eine orthogonale Abbildung zwischen zwei euklidischen Vektorräumen (V, h·, ·iV ) und

(W, h·, ·iW ) ist eine lineare Abbildung F : V → W mit

hF v, F wiW = hv, wiV .

9

für alle Vektoren v, w ∈ V . Die orthogonale Gruppe, oder Gruppe der orthogonalen

Matrizen ist definiert als

O(n) := {A ∈ Mn (R) | A · AT = En } ,

wobei En die Einheitsmatrix bezeichnet. Dies ist die Gruppe der orthogonalen Abbildungen

FA : Rn → Rn , die gegeben sind durch Matrizenmultiplikation mit A, wobei auf Rn das

kanonische Skalarprodukt fixiert ist.

Fakten: Die orthogonalen Matrizen in O(n) sind genau die Matrizen, deren Spalten (bzw.

Zeilen) eine Orthonormalbasis von Rn bilden (bzgl. des kanonischen Skalarproduktes) .

Orthogonale Endomorphismen euklidischer Vektorräume sind im Allgemeinen nicht diagonalisierbar. Man hat aber immer eine Normalform orthogonaler Endomorphismen: es

existiert eine Orthonormalbasis B, so dass die darstellende Matrix MB (F ) von folgender

Form ist:

MB (F ) = diag (λ1 , . . . , λr , M1 , . . . , Ms )

dabei ist λi = ±1, i = 1, . . . , r und Mi , i = 1, . . . , s sind 2 × 2-Drehmatrizen.

6.2

Unitäre Vektorräume

Sei V ein komplexer Vektorraum, d.h. K = C. Eine hermitesche Form auf V ist eine

Abbildung h : V × V → C mit folgenden Eigenschaften

h(u + v, w) = h(u, w) + h(v, w),

h(λ v, w) = λ h(v, w),

h(v, w) = h(w, v)

für alle u, v, w ∈ V und λ ∈ C. Eine hermitesche Form ist also linear im ersten und anti-linear

im zweiten Argument, dh. im zweiten Argument gilt

h(u, v + w) = h(u, v) + h(u, w),

h(u, λv) = λ̄ h(u, v) .

für alle u, v, w ∈ W und λ ∈ C.

Ein unitärer Vektorraum ist ein komplexer Vektorraum V zusammen mit einer positiv

definiten hermiteschen Form h. Diese nennt man dann unitäres Skalarprodukt auf V . Positiv

definit heißt hier wieder h(v, v) > 0 für alle Vektoren v ∈ V, v 6= 0. Diese Definition ist

sinnvoll, da h(v, v) ∈ R für hermitesche Formen h.

Das kanonische Skalarprodukt auf Cn ist ein unitäres Skalarprodukt auf Cn definiert durch

hv, wi := v̄ T · w = v1 w̄1 + . . . + vn w̄n .

Orthogonalität von Vektoren, Orthonormalbasen, orthogonale Projektionen, orthogonale Komplemente und das Gram-Schmidt-Verfahren sind analog zu euklidischen Vektorräumen definiert.

10

Eine lineare Abbildung F : V → W zwischen zwei unitären Vektorräumen V und W heißt

unitär, falls für alle Vektoren v, w ∈ V gilt:

hF v, F wiW = hv, wiV .

Eine Matrix A ∈ Mn (C) heißt unitär, falls die durch Matrizenmultiplikation gegebenen

Abbildung FA : Cn → Cn bezüglich des kanonischen Skalarproduktes unitär ist. Äquivalent

dazu ist die Bedingung A · ĀT = E. Die unitäre Gruppe U(n) ist die Menge der unitären

Matrizen, d.h.

U(n) := { A ∈ Mn (C) | A · ĀT = E } .

Unitäre Matrizen sind genau die Matrizen, deren Zeilen (bzw. Spalten) eine Orthonormalbasis bilden (bzgl. des kanonischen Skalarproduktes auf Cn ). Die spezielle unitäre Gruppe

SU(n) ist eine Untergruppe von U(n) definiert durch SU(n) := {A ∈ U(n) | det A = 1}.

Fakten: Unitäre Endomorphismen (Matrizen) sind diagonalisierbar. Eigenwerte unitärer

Endomorphismen (Matrizen) sind komplexe Zahlen der Länge eins, d.h. komplexe Zahlen

der Form ei t mit t ∈ R. Es gilt O(n) ⊂ U(n) ⊂ GL n (C) und GL n (R) ⊂ GL n (C).

6.3

Selbst-adjungierte Abbildungen

Zu jeder linearen Abbildung F : V → W zwischen zwei euklidischen bzw. unitären Vektorräumen existiert eine eindeutig bestimmte lineare Abbildung F ad : W → V , die zu F adjungierte Abbildung, die charakterisiert ist durch die Gleichung

hF v, wi = hv, F ad wi ,

für alle v ∈ V und w ∈ W . Seien (v1 , . . . , vn ) bzw. (w1 , . . . , wm ) Orthonormalbasen von V

bzw. W , dann ist F ad definiert durch

F

ad

wi =

n

X

hF vk , wi i vk

für

i = 1, . . . , m .

k=1

Mit Hilfe der kanonischen Identifizierungen Φ : V → V ∗ bzw.. Ψ : W → W ∗ , gegeben durch:

Φ(v0 ) = (v 7→ hv, v0 i) und Ψ(w0 ) = (w 7→ hw, w0 i), kann F ad auch geschrieben werden als

F ad = Φ−1 ◦ F ∗ ◦ Ψ .

Ein Endomorphismus F ∈ End V eines euklidischen bzw. unitären Vektorraumes (V, h·, ·i)

heißt selbst-adjungiert, falls für alle v, w ∈ V gilt:

hF v, wi = hv, F wi .

11

Äquvivalent dazu ist, daß die darstellende Matrix A = MB (F ) von F bezüglich einer Orthonormalbasis B von V eine symmetrische Matrix, d.h. A = AT , bzw. eine hermitesche

Matrix, d.h. A = ĀT , ist. Selbst-adjungierte Abbildungen sind Endomorphismen, die mit

ihrer adjungierten Abbildung F ad übereinstimmen.

Fakten: Selbst-adjungierte Abbildungen, und entsprechend symmetrische bzw. hermitesche

Matrizen, sind diagonalisierbar. Die Eigenwerte hermitescher Matrizen sind reell. Es gilt:

Im F ad = (Ker F )⊥ ,

6.4

Ker F ad = (Im F )⊥ ,

V = Ker F ⊕ Im F ad = Ker F ad ⊕ Im F .

Normale Abbildungen

Ein Endomorphismus F ∈ End V eines unitären Vektorraumes (V, h·, ·i) heißt normal, falls

F ◦ F ad = F ad ◦ F . Entsprechend heißt eine Matrix A ∈ Mn (C) normal, falls A · ĀT = ĀT · A.

Fakten: Beispiele normaler Endomorphismen sind: unitäre, selbst-adjungierte und schiefhermitesche (F ad = −F ) Abbildungen. Normale Endomorphismen sind diagonalisierbar.

Jeder diagonalisierbare Endomorphismus von V mit einer Orthonormalbasis von Eigenvektoren ist normal. Sei F normal, dann gilt:

Ker F ad = Ker F,

7

Im F ad = Im F,

V = Ker F ⊕ Im F .

Polynome

Sei K ein Körper. Ein Polynom über K ist eine Folge a = (a0 , a1 , a2 , . . .) mit ai ∈ K,

so dass es ein N ≥ 0 gibt, mit ai = 0 für alle i ≥ N . Seien zwei Polynome gegeben:

a

(an ) und b = (bn ), dann definiert man a + b = (an + bn ) und a · b = (cn ) mit cn =

P=

n

j=1 aj · bn−j . Weiter definiert man eine skalare Multiplikation: λ · a := (λ an ). Damit wird

die Menge K[x] aller Polynome zu einem K-Vektorraum und einem kommutativen Ring mit

Eins (der Polynomring). Definiert man x := (0, 1, 0, . . .), dann ist ein Polynom ein Ausdruck

der Gestalt:

P = an xn + an−1 xn−1 + . . . + a1 x + a0 .

Die Zahlen a0 , . . . , an heißen Koeffizienten des Polynoms. Sind alle Koeffizienten gleich Null,

so spricht man vom Nullpolynom, P = 0. Ist P nicht das Nullpolynom, so definiert man den

Grad von P durch

deg(P ) := max { i | ai 6= 0 } .

Ein Polynom vom Grad n mit an = 1 heißt normiert. Die Potenzen 1, x, x2 , . . . bilden eine

Basis des Vektorraumes K[x].

12

Jedes Polynom P ∈ K[x] definiert eine Abbildung P̃ : K → K (polynomiale Abbildung)

durch: P̃ (λ) = an λn + an−1 λn−1 + . . . + a0 . Die Zuordnung P 7→ P̃ definiert den Auswertungshomomorphismus K[x] → Abb (K, K). Für Körper K mit unendlich vielen Elementen

ist dieser injektiv, d.h. man kann dann P und P̃ identifizieren.

Eine Zahl λ ∈ K heißt Nullstelle von P ∈ K[x], falls P̃ (λ) = 0. Man schreibt dann auch

einfach P̃ (λ) = 0.

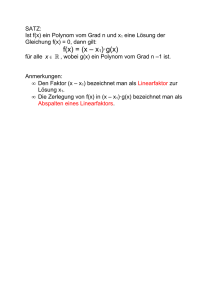

Unter dem Abspalten von Linearfaktoren versteht man folgende Aussage. Sei P ∈ K[x]

und sei λ ∈ K eine Nullstelle von P . Dann existiert ein eindeutig bestimmtes Polynom

Q ∈ K[x] mit deg(Q) = deg(P ) − 1 und P = (x − λ) Q, man sagt von P wurde der

Linearfaktor (x − λ) abgespalten. Sei P ∈ K[x], P 6= 0. Für λ ∈ K heißt

µ(P, λ) := max { r ∈ N | P = (x − λ)r Q, Q ∈ K[x] }

die Vielfachheit der Nullstelle λ von P . Man sagt ein Polynom P ∈ K[x] zerfällt in Linearfaktoren, falls es sich in folgender Form schreiben läßt:

P = a (x − λ1 )r1 · . . . · (x − λk )rk

mit a ∈ K. Man spricht dann von einer Linearfaktorzerlegung von P .

Analog zu den ganzen Zahlen hat man auch für Polynome eine Division mit Rest: die Polynomdivision. Zu je zwei Polynomen p, q ∈ K[x] mit p, q 6= 0 und deg q ≤ deg p existieren

eindeutig bestimmte Polynome h, r ∈ K[x] mit p = h · q + r und deg(r) < deg(q) .

Der Polynomring K[x] ist wie der Ring der ganzen Zahlen Z ein sogenanntener euklidischer

Ring, d.h. es existiert ein euklidischer Algorithmus. Darunter versteht man folgendes

Verfahren: Seien P1 , P2 ∈ K[x] mit P1 , P2 6= 0 und deg P1 ≤ deg P2 . Man betrachtet eine

Folge von Polynomdivisionen mit Rest:

P1 = Q1 · P2 + P3

..

..

.

.

Pk = Qk · Pk+1 + Pk+2

..

..

.

.

Pn−1 = Qn−1 · Pn

mit

deg P3 < deg P2

mit

deg Pk+2 < deg Pk+1

mit

deg Pn < deg Pn−1

Dann gilt:

1. Pn ist der größte gemeinsame Teiler von P1 und P2 , d.h. Pn |P1 , Pn |P2 und falls

P |P1 , P |P2 dann folgt P |Pn .

2. Pn = P · P1 + Q · P2 für gewisse Polynome P, Q ∈ K[x]

13

Der Fundamentalsatz der Algebra besagt, daß jedes nicht-konstante Polynom über C

mindestens eine Nullstelle besitzt. Damit besitzt jedes komplexe Polynom eine Linearfaktorzerlegung.

Der Wurzelsatz von Vieta besagt: Sei P = xn + an−1 xn−1 + . . . + a1 x + a0 ein

Polynom, dass vollständig in Linearfaktoren zerfällt, mit Nullstellen λ1 , . . . , λn (die nicht

paarweise verschieden sein müssen), d.h. P = a(x − λ1 ) . . . (x − λn ). Dann berechnen sich

die Koeffizienten ak als

ak = (−1)n−k sn−k (λ1 , . . . , λn ) .

Dabei sind sk die elementarsymmetrischen Funktionen, definiert durch

X

sr (λ1 , . . . , λn ) :=

λi1 · . . . · λir .

i1 <...<ir

Insbesondere gilt: a0 = P (0) = (−1)n λ1 · . . . · λn und an−1 = −λ1 − . . . − λn .

Sei P ∈ C[x] ein Polynom mit reellen Koeffizienten. Man sagt P ist ein reelles Polynom:

P ∈ R[x] ⊂ C[x]. Dann ist mit jedem λ ∈ C auch die konjugiert komplexe Zahl λ̄ eine

Nullstelle. Die Nullstellen λ und λ̄ haben die gleiche Vielfachheit. Insbesondere hat jedes

reelles Polynom ungeraden Grades eine reelle Nullstelle.

8

Eigenwerte, Eigenvektoren, Diagonalisierbarkeit

Sei V ein K-Vektorraum und sei F ∈ End V . Ein λ ∈ K heißt Eigenwert von F , falls es

einen Vektor v ∈ V mit v 6= 0 gibt, für den F v = λv gilt. In diesem Fall nennt man v einen

Eigenvektor von F zum Eigenwert λ.

Sei F ∈ End V und λ ∈ K . Dann ist der Eigenraum von F zum Eigenwert λ definiert als

Eλ (F ) := {v ∈ V | F v = λv} ,

d.h. Eλ (F ) ist die Menge der Eigenvektoren von F zum Eigenwert λ, zusammen mit dem

Nullvektor.

Ein F ∈ End V heißt diagonalisierbar, wenn es eine Basis aus Eigenvektoren gibt. Das ist

genau dann der Fall, wenn es eine Basis B von V gibt, für die die darstellende Matrix MB (F )

eine Diagonalmatrix ist.

Eine Matrix A ∈ Mn (K) heißt diagonalisierbar, falls die durch A definierte Abbildung

FA : K n → K n , x 7→ A · x diagonalisierbar ist, oder falls ein S ∈ GL n (K) existiert, so dass

S · A · S−1 eine Diagonalmatrix ist.

14

Zwei Endomorphismen F, G ∈ End V heißen simultan diagonalisierbar, falls eine Basis

von V existiert, die aus Vektoren besteht, die gleichzeitig Eigenvektoren von F und G sind.

Fakten: Zwei diagonalisierbare Endomorphismen F, G sind genau dann simultan diagonalisierbar, wenn sie kommutieren, d.h. wenn F ◦ G = G ◦ F gilt. Es folgt, dass dann die

Eigenräume von G invariant unter F sind und umgekehrt. Die gleichzeitig diagonalsierende

Basis erhält man, indem man z.B. die Einschränkungen von F auf die Eigenräume von G

diagonalisiert.

Sei F ∈ End V . Dann ist das charakteristische Polynom von F definiert durch:

PF := det(F − x IdV ) ∈ K[x] .

Sei A die darstellende Matrix von F bzgl. irgendeiner Basis von V , dann gilt

PF = det(A − x E) ∈ K[x],

wobei E die Einheitsmatrix bezeichnet. Dieser Ausdruck definiert auch das charakteristische

Polynom PA für eine beliebige Matrix A ∈ Mn (K).

Fakten: Die Nullstellen des charakteristischen Polynoms sind genau die Eigenwerte von F

bzw. A. Ähnliche Matrizen haben das gleiche charakteristische Polynom. Schreibt man das

charakteristische Polynom als PF = an xn + an−1 xn−1 + . . . + a0 . Dann gilt:

an = (−1)n ,

an−1 = (−1)n−1 Tr (A),

a0 = PF (0) = det F .

Sei F ∈ End V mit charakteristische Polynom PF . Die algebraische Vielfachheit des

Eigenwertes λ von F ist definiert als die Vielfachheit der Nullstelle λ von PF . Man schreibt

µalg (F, λ) = µ(PF , λ) .

Zerfällt das charakteristische Polynom PF in Linearfaktoren, d.h. hat man

PF = ± (x − λ1 )r1 · . . . · (x − λk )rk ,

wobei die λi , mit i = 1, . . . , k die paarweise verschiedenen Nullstellen von PF seien, dann ist

µalg (F, λi ) = ri .

Die geometrische Vielfachheit des Eigenwertes λ ist definiert als Dimension des Eigenraumes zum Eigenwert λ. Man schreibt

µgeom (F, λ) = dim Eλ (F ) .

Fakten: Eigenvektoren zu verschiedenen Eigenwerten sind linear unabhänging. Sei λ ein

Eigenwert von F ∈ End V dann gilt: 1 ≤ µgeom (F, λ) ≤ µalg (F, λ) ≤ dim V . Ein Endomorphismus ist genau dann diagonalisierbar, wenn PF in Linearfaktoren zerfällt und für

alle Eigenwerte geometrische und algebraische Vielfachheiten übereinstimmen. Weiter ist

F ∈ End V genau dann diagonalisierbar, wenn V direkte Summe der Eigenräume von F ist.

15

9

Trigonalisierbarkeit

Sei V ein K-Vektorraum und F ∈ End V . Ein Unterraum W ⊂ V heißt F-invariant, falls:

F (W ) ⊂ W ,

d.h. F (w) ∈ W

für alle w ∈ W .

Der Nullvektorraum {0} und der ganze Vektorraum V sind triviale invariante Unterräume,

d.h. sie sind für jedes F ∈ End V invariant.

Sei F ∈ End V und sei dim V = n, dann definiert man:

(i) Eine Fahne in V ist ein Tupel (Vr )r=0,...,n von Unterräumen in V mit

{0} := V0 ⊂ V1 ⊂ . . . ⊂ Vn := V

mit dim Vr = r für r = 0, . . . , n.

(ii) Eine Fahne heißt F-invariant, falls für jedes r der Unterraum Vr F -invariant ist.

Ein Endomorphismus F ∈ End V heißt trigonalisierbar, falls eine F -invariante Fahne in

V existiert. Äquivalent dazu ist: Es existiert eine Basis B von V , für die die darstellende

Matrix MB (F ) eine obere Dreiecksmatrix ist.

Eine Matrix A = (aij ) ∈ Mn (K) heißt obere Dreiecksmatrix, falls aij = 0 für i > j.

Eine Matrix A ∈ Mn (K) heißt trigonalisierbar, falls die durch Matrizenmultiplikation gegebene Abbildung FA : K n → K n , x 7→ Ax trigonalisierbar ist, oder falls ein S ∈ GL (n, K)

existiert, so daß SAS −1 eine obere Dreiecksmatrix ist.

Fakten: Endomorphismen oder Matrizen sind genau dann trigonalisierbar, wenn ihr charakteristisches Polynom in Linearfaktoren zerfällt.

10

Jordan-Normalform

Eine Normalform einer gewissen Menge von Endomorphismen ist die einfachst mögliche

Matrixform, auf die die darstellenden Matrizen dieser Endomorphismen durch Wahl einer

geeigneten Basis gebracht werden können, insbesondere wenn die Endomorphismen nicht

diagonalisierbar sind. Damit sind z.B. die Diagonalmatrizen Normalform von unitären und

selbstadjungierten Endomorphismen, während die Normalform der orthogonalen Endomorphismen aus den Matrizen bestehen, die auf der Diagonalen entweder ±1 oder 2 × 2- Drehmatrizen zu stehen haben und die sonst Null sind.

16

Sei A eine beliebige Matrixdarstellung eines Endomorphismus F ∈ End V und sei  eine

Normalform von F . Dann existiert eine invertierbare Matrix S mit S −1 A S = Â. Die Spalten

von S sind dabei genau die Basisvektoren von V bzgl. der die Matrix von F in Normalform

ist. Ist F diagonalisierbar dann sind die Spalten von S genau die Eigenvektoren von F .

10.1

Polynome von Endomorphismen

Der Einsetzungshomomorphismus ΦF : K[x] → End V , ordnet jedem Polyonom P einen

Endomorphismus ΦF (P ) := P (F ). Insbesondere wird dem Polynom P = xk der Endomorphismus P (F ) = F k = F ◦ . . . ◦ F zugeordnet, dabei geht das Polynom P = x0 = 1 auf die

Identität IdV .

Fakten: Der Einsetzungshomomorphismus ist ein Ringhomomorphismus. Für zwei Polynome P1 , P2 gilt: (P1 · P2 )(F ) = P1 (F ) ◦ P2 (F ). Das Bild Im ΦF = {P (F ) | P ∈ K[x]} ist

ein kommutativer Unterring. Weiter gilt: Ker ΦF = {P | P (F ) = 0} ist ein Ideal. Sei R ein

kommutativer Ring. Eine Teilmenge I ⊂ R heißt Ideal, falls I eine Untergruppe bzgl. der

Addition ist und für alle a ∈ I und b ∈ R gilt a · b ∈ I. Der Polynomring K[x] ist ein

Hauptidealring, d.h. jedes Ideal I ⊂ K[x] ist von der Form I = Q · K[x] = {Q · P | P ∈ K[x]}.

Sei F ∈ End V , dann ist das Minimalpolynom MF ∈ K[x] das eindeutig bestimmte normierte Polynom mit Ker ΦF = MF · K[x]. Das Minimalpolynom von F ist als das normiertes

Polynom von minimalem Grad, dass die Gleichung MF (F ) = 0 erfüllt.

Fakten: Ist P ein Polynom mit P (F ) = 0, dann gilt MF |P . Ist F diagonalisierbar und gilt

PF = ±(x − λ1 )r1 · . . . · (x − λk )rk , mit paarweise verschiedenen Eigenwerten λi , dann folgt

MF = (x − λ1 ) · . . . · (x − λk ).

Der Satz von Cayley-Hamilton besagt: PF (F ) = 0, wobei PF das charakteristische Polynom von F ist. Daraus folgt insbesondere, dass das Minimalpolynom ein Teiler des charakteristischen Polynoms ist. Zerfällt PF in Linearfaktoren, so auch MF und es treten die

gleichen Faktoren auf.

Der Zerlegungssatz besagt: seien P, Q, R Polynome mit P = Q · R und seien Q, R teilerfremd, dann ist Ker P (F ) = Ker Q(F ) ⊕ Ker R(F ). Die Summanden sind F -invariant

und die Projektionen auf die Summanden können als Polynom in F geschrieben werden.

Insbesondere erhält man eine direkte Summenzerlegung von V für Polynome P in Ker ΦF .

Sei V ein K-Vektorraum mit n = dim V . Ein Endomorphismus F ∈ End V heißt nilpotent,

falls eine Zahl k ∈ N existiert mit F k = 0. Äquivalent dazu ist, dass das charakteristische

Polynom die Form PF = ±xn hat bzw. dass eine Basis von V existiert, für die die darstellende

Matrix von F eine obere Dreiecksmatrix ist, bei der Nullen auf der Diagonalen stehen.

17

Insbesondere ist also Null der einzige Eigenwert eines nilpotenten Endomorphismus. Nilpotente Endomorphismen F mit F 6= 0 sind nicht diagonalisierbar (analog für Matrizen).

Sei F ein Endomorphismus von V für den das charakteristische Polynom PF in Linearfaktoren zerfällt, mit paarweise verschiedenen Eigenwerten λ1 , . . . , λk . Dann ist der verallgemeinerte Eigenraum V (λj ) von F zum Eigenwert λj definiert durch

V (λj ) := Ker (F − λj )rj ,

dabei ist rj die algebraische Vielfachheit des Eigenwertes λj und gleichzeitig auch die Dimension von V (λj ). In der Definition kann man rj auch durch sj ersetzen, wobei sj der Exponent

des Faktors (x − λj ) im Minimalpolynoms von F ist.

Fakten: Der Vektorraum V zerfällt in die direkte, F -invariante Summe der verallgemeinerten

Eigenräume (Hauptraumzerlegung):

V = V (λ1 ) ⊕ . . . ⊕ V (λk )

Man hat folgende Kette von Inklusionen von Unterräumen:

Eλj (F ) = Ker (F −λj Id) ⊂ Ker (F −λj Id)2 ⊂ . . . ⊂ Ker (F −λj Id)sj = . . . = Ker (F −λj Id)rj .

Dabei ist sj der erste Exponent ab dem Gleichheit in der Kette auftritt. Der Endomorphismus

F schreibt sich als F = D + N , mit D diagonalisierbar, N nilpotent und D ◦ N = N ◦ D.

Auf dem verallgemeinerten Eigenraum V (λ) hat man D = λ Id und N = F − λ Id.

Ein Jordan-Block ist eine Matrix Jr (λ) ∈ Mr (K), mit Einträgen λ auf der Diagonalen,

Einsen auf der ersten (oberen) Nebendiagonalen und Nullen sonst.

Eine Jordan-Normalform eines Endomorphismus F ist eine darstellende Matrix von F ,

die Jordan-Blöcke entlang der Diagonalen hat und deren sonstigen Einträge Null sind.

Fakten: Ist K algebraisch abgeschlossen, dh. zerfällt jedes Polynom über K in Linearfaktoren, z.B. K = C, dann besitzt jeder Endomorphismus eines K-Vektorraumes eine JordanNormalform.

Sei F ∈ End V ein Endomorphismus mit paarweise verschiedenen Eigenwerten λ1 , . . . , λk .

Die algebraische Vielfachheit des Eigenwertes λj sei rj , die geometrische sei dj und sj sei der

Exponent von x − λj im Minimalpolynom. Dann läßt sich die Jordan-Normalform J von F

aus folgenden Eigenschaften ableiten:

1. Die Matrix J besteht aus k quadratischen Blöcken Aj ∈ Mrj (K) mit j = 1, . . . , k, in

denen jeweils λj auf der Diagonalen steht.

2. Jede Matrix Aj besteht aus dj Jordan-Blöcken Ji (λj ), mit i = 1, . . . , dj .

18

3. Dabei gibt es dim ker(F − λj )r − dim ker(F − λj )r−1 Blöcke mit mindestens r Zeilen.

4. Der größte Jordan-Block in Aj hat sj Zeilen

11

Quotientenräume

Sei V ein K-Vektorraum und U ⊂ V ein Unterraum, dann ist auf V eine Äquivalenzrelation

definiert durch: v ∼ w ↔ v − w ∈ U . Die Menge der Äquivalenzrelationen V /∼ = V /U

bezeichnet man als den Quotientenraum (V nach U ).

Der Quotientenraum besitzt genau eine Vektorraumstruktur, bzgl. der die kanonische Projektion π : V → V /U , v 7→ [v] eine lineare Abbildung wird, d.h. man definiert Addition und

skalare Multiplikation von Äquivalenzklassen durch [v] + [w] := [v + w] und λ [v] := [λ v].

Der Nullvektor in V /U ist der Unterraum U selbst: 0V /U = [0V ] = U . Punkte in V /U , also

Teilmengen der Form v + U = {v + u|u ∈ U }, nennt man affine Unterräume von V .

Fakten: Die wichtigsten Eigenschaften der Quotientenräume sind:

1. Die kanonische Projektion π : V → V /U ist surjektiv und Ker π = U .

2. Für endlich-dimensionale Vektorräume V gilt: dim V /U = dim V − dim U

3. Sei F : V → W eine lineare Abbildung mit U ⊂ Ker F . Dann gibt es eine eindeutig

bestimmte Abbildung F̃ : V /U → W mit F = F̃ ◦ π. Weiter gilt: Ker F̃ = (Ker F )/U .

Insbesondere gilt ganz allgemein: Im F ∼

= V /Ker F .

4. Sei U 0 irgendein Komplement des Unterraumes U , d.h. es gelte V = U ⊕ U 0 , dann

definiert die kanonische Projektion einen Isomorphismus: π 0 := π|U 0 : U 0 → V /U .

12

Vektorraum der r-Formen

Sei V ein K-Vektorraum eine Abbildung D : V × . . .r−mal . . . × V → K heißt multi-linear,

falls sie in jedem Eintrag linear ist, d.h. falls die Abbildung V → K

vi 7→ D(v1 , . . . , vi , . . . , vr )

für feste Vektoren vk , k 6= i linear ist. Eine multi-lineare Abbildung heißt alternierend falls,

D(v1 , . . . , vr ) = 0 sobald ein Paar (i, j) mit i 6= j und vi = vj existiert. Ist V ein Vektorraum

der Charakteristik ungleich zwei, d.h. gilt 1 + 1 6= 0, dann sind alternierende Abbildungen

genau die, die beim Vertauschen zweier Einträge das Vorzeichen wechseln, d.h. wo gilt

D(v1 , . . . , vi , . . . , vj , . . . , vr ) = − D(v1 , . . . , vj , . . . , vi , . . . , vr ) .

19

Beispiel: Die Determinante einer n×n-Matrix ist eine multi-lineare, alternierende Abbildung

det : M (n × n, K) ∼

= K n × . . .n−mal . . . × K n → K ,

die auf der Einheitsmatrix den Wert Eins annimmt. Es kann gezeigt worden, dass durch diese

drei Bedingungen die Determinante eindeutig festgelegt ist. Die Determinante interpretiert

man hier als multi-lineare Abbildung auf den Spalten der gegebenen Matrix.

Sei V ein r-dimensionaler komplexer oder reeller Vektorraum. Eine (alternierende) r-Form

auf V ist eine multilineare und alternierende Abbildung

ω : V × . . . r mal . . . × V

→ K

Der Raum der r-Formen wird mit Λr V ∗ bezeichnet. Dabei ist Λ0 V ∗ = K, Λ1 V ∗ = V ∗ und

Λ2 V ∗ ist der Raum der schiefsymmetrischen Bilinearformen und Λk V ∗ = {0} für k > dim V .

Sei ω ∈ Λr V ∗ und η ∈ Λs V ∗ . Dann ist das Dachprodukt ω ∧ η eine (r+s)-Form definiert

durch:

1 X

sign (σ) ω(vσ(1) , . . . , vσ(r) ) η(vσ(r+1) , . . . , vσ(r+s) ) .

ω ∧ η(v1 , . . . , vr+s ) :=

r!s! σ∈S

r+s

Als äußere Algebra bezeichnet man den Raum aller Formen (mit dem Dachprodukt).

Insbesondere gilt für λ, µ ∈ V ∗ , dass (λ ∧ µ)(v, w) = λ(v)µ(w) − λ(w)µ(v) und allgemeiner

gilt für λ1 , . . . , λr ∈ V ∗ und v1 , . . . , vr ∈ V die Formel (λ1 ∧. . .∧λr )(v1 , . . . , vr ) = det(λi (vj )) .

Eigenschaften: Es gelten folgende grundlegende Rechenregeln für das Dachprodukt:

1.

α ∧ (β + γ) = α ∧ β + α ∧ γ

2.

α ∧ β = (−1)r·s β ∧ α

und

α ∧ (β ∧ γ) = (α ∧ β) ∧ γ

für α ∈ Λr V ∗ , β ∈ Λs V ∗

Daraus folgt α ∧ α = 0 falls α ∈ Λ2r+1 V ∗ und λσ(1) ∧ . . . ∧ λσ(r) = sign (σ)λ1 ∧ . . . ∧ λr . Sei

(v1 , . . . , vn ) eine Basis von V mit dualer Basis (v1∗ , . . . , vn∗ ) dann sind die r-Formen vi∗1 ∧. . .∧vi∗r

für 1 ≤ i1 < . . . < ir ≤ n eine Basis im Raum der r-Formen Λr V ∗ . Insbesondere gilt:

dim Λr V ∗ = nr .

Sei F : V → W eine lineare Abbildung, dann ist das Zurückziehen von k-Formen bzw. die

pull-back-Abbildung F ∗ = Λk (F ) : Λk W ∗ → Λk V ∗ definiert durch

(F ∗ ω)(v1 , . . . , vk ) := ω(F v1 , . . . , F vk )

für ω ∈ Λk W ∗ und v1 , . . . , vk ∈ V .

Eigenschaften: Es gelten folgende Rechenregeln für das Zurückziehen von Formen:

20

1.

F ∗ ist K-linear

2.

(F ◦ G)∗ = G∗ ◦ F ∗

3.

F ∗ (α ∧ β) = (F ∗ α) ∧ (F ∗ β)

4.

F ∗ (ω) = det(F ) ω

13

für ω ∈ Λdim V V ∗

Orientierungen von Vektorräumen

Sei V ein reeller Vektorraum. Dann nennt man zwei Basen gleichorientiert, falls der Basiswechselisomorphismus eine positive Determinante hat. Seien A = {v1 , . . . , vn } und B =

{w1 , . . . , wn } zwei Basen von V . Dann ist der Basiswechselisomorphismus F definiert durch

F vi = wi für i = 1, . . . , n.

Die Eigenschaft gleichorientiert zu sein definiert eine Äquivalenzrelation auf der Menge der

Basen von V . Man hat genau zwei Äquivalenzklassen. Eine Orientierung auf V ist eine

Äquivalenzklassen gleichorientierter Basen von V . Die Basen der fixierten Orientierung nennt

man positiv orientiert die anderen entsprechend negativ orientiert.

Der Raum Rn hat eine kanonische Orientierung. Das ist die Äquivalenzklassen in der die

kanonische Basis liegt.

Die Orientierung auf einem n-dimensionalen Vektorraum V kann festgelegt werden durch die

Wahl einer Volumenform, d.h. einer von Null verschiedenen n-Form, also

ω ∈ Λn V ∗ \ {0} .

Die Menge der Basen von Rn kann identifiziert werden mit der Menge der invertierbaren

Matrizen GL n (R). Entsprechend hat man folgende disjunkte Zerlegung:

GL n (R) = GL + ∪ GL − ,

mit GL + = {A ∈ Mn (R)| det A > 0} und GL − = {A ∈ Mn (R)| det A < 0} . Dabei entspricht

GL + der Menge der positiv orientierten Basen der kanonischen Orientierung von Rn .

Zwei Basen A, B von Rn heißen stetig ineinander deformierbar, falls die entsprechenden

Matrizen A, B ∈ GL n (R) verbindbar sind, d.h. falls in GL n (R) ein stetiger Weg von A nach

B existiert. Das ist äquivalent dazu, dass die Basen gleichorientiert sind.

21