Vorlesung 1

Werbung

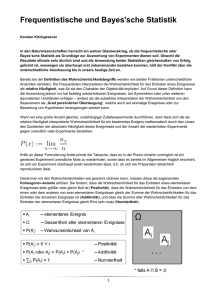

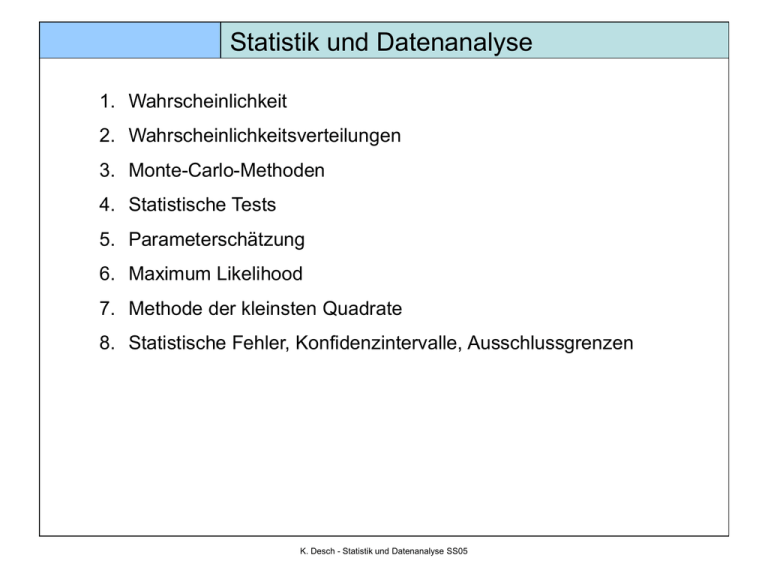

Statistik und Datenanalyse 1. Wahrscheinlichkeit 2. Wahrscheinlichkeitsverteilungen 3. Monte-Carlo-Methoden 4. Statistische Tests 5. Parameterschätzung 6. Maximum Likelihood 7. Methode der kleinsten Quadrate 8. Statistische Fehler, Konfidenzintervalle, Ausschlussgrenzen K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Kolmogorov-Axiome Mathematische Definition von Wahrscheinlichkeit (damit ist aber noch keine Bedeutung/Interpretation von W. impliziert) Menge S von “Ereignissen” (Stichprobenraum) Jeder Untermenge A von S wird eine reelle Zahl P(A) zugewiesen P(A) = Wahrscheinlichkeit von A so dass gilt 1. für jede Untermenge A von S ist P(A) 0 2. P(S) = 1 3. für disjunkte Untermengen A und B (d.h. für AB=Ø) ist P(AB) = P(A) + P(B) K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Folgerungen aus den Kolmogorov-Axiomen P(Ø) = 0 0 P(A) 1 AB P(A) P(B) P(AB) = P(A) + P(B) – P(AB) für das A, das Komplement von A gilt P(A) = 1 – P(A) P(AA) = 1 A und B heißen statistisch unabhängig (oder unkorreliert) genau dann wenn P(AB) = P(A)P(B) Das bedeutet, dass die Zugehörigkeit eines Ereignisses zu A nichts aussagt darüber, ob es auch zu B gehört oder nicht Wichtiges Konzept! K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Statistische Unabhängikeit - Beispiele Beispiel 1 (unkorreliert): S = alle Studierenden der Uni Freiburg A = alle männlichen Studierenden der Uni Freiburg B = alle Studierenden die zwischen 1.1. und 30.4. Geburtstag haben A und B sind (vermutlich) unkorreliert, also P(AB) = P(A)P(B) Beispiel 2 (korreliert): S = alle Menschen A = alle Kinder unter 12 Jahren B = alle Menschen unter 150 cm A und B sind (stark) positiv korreliert, d.h. P(AB) > P(A)*P(B) K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Statistische Unabhängikeit - Beispiele Beispiel 3: Rutherfordstreuung K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Statistische Unabhängikeit - Beispiele Beispiel 4: Rb K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Bedingte Wahrscheinlichkeit Wahrscheinlichkeit für A wenn B gegeben ist: P(A|B):= P(A B) P(B) Wahrscheinlichkeit für B wenn A gegeben ist: P(B|A):= P(B A) P(A) Daraus folgt das Bayes-Theorem: P(A|B) P(B) = P(B|A) P(A) Wenn man S in disjunkte Untermengen Ai aufteilt gilt: P(B)=P(B|Ai )P(Ai ) i und mit Bayes-Theorem folgt: P(A|B)= P(B | A) P(A) P(B|Ai )P(Ai ) i K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Beispiel zum Bayes Theorem Ein Bluttest diagnostiziert 100% aller Erkrankten P(positiv|erkrankt) = 100% und nur 1% aller gesunden falsch positiv P(positiv|gesund) = 1% Der Anteil der Erkrankten in der Bevölkerung ist 0.2% P(erkrankt) = 0.2% Damit versagt der Test aber in 80 % aller Fälle: P(erkrankt|positiv) = P(positiv|erkrankt)P(erkrankt)/P(gesund) = 100%*0.2%/99.8% = 20% d.h. 80% aller Diagnosen sind falsch positiv. K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit als Häufigkeit Verbreitetste Interpretation von Wahrscheinlichkeit: relative Häufigkeit eines Ergebnisses einer Messung (Ereignis) im Grenzwert unendlich vieler Wiederholungen dieser Messung Dies ist die Interpretation von Wahrscheinlichkeit - in der Quantenmechanik - in der statistischen Mechanik Die Elemente des Stichprobenraums sind alle möglichen Ergebnisse einer Messung Anzahl der Ergebisse A in n Messungen n n P(A) = lim K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit als Häufigkeit Probleme mit der Häufigkeitsdefinition Grenzwert kann i.d.R. nicht gebildet werden Abschätzung des Grenzwertes aus n Messungen K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Subjektive Wahrscheinlichkeit (Bayes-Statistik) K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Wahrscheinlichkeitsdichte Einfachster Fall: Messung kann nur diskrete Werte xi annehmen (z.B. Zählexperiment) f 1 Wahrscheinlichkeit xi zu erhalten: P(xi) =: fi i i Häufig ist ein Messergebnis aber eine kontinuierliche Größe x Wahrscheinlichkeit genau x zu erhalten ist Null Besser: Wahrscheinlichkeit eine Messung im Intervall [x+dx] zu erhalten P([x+dx]) =: f(x) dx f(x) = Wahrscheinlichkeitsdichte mit S f(x)dx 1 f(x) 0 (probability density function, p.d.f.) f(x) ist keine Wahrscheinlichkeit, erst Integration über endlichen Bereich ergibt eine Wahrscheinlichkeit x Kumulative Verteilungsfunktion: F(x) : f(x)dx gibt die Wahrscheinlichkeit an, dass ein Messergebnis kleiner als x ist. K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Wahrscheinlichkeitsdichte Wahrscheinlichkeit, dass eine Messung im Intervall [a,b] liegt ist F(b)-F(a) Für diskrete Zufallsvariable ist F(x) : x xi x Beispiel einer Wahrscheinlichkeitsdichtefunktion: i zugehörige kumulative Verteilungsfunktion: K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Charakterisierung von Wahrscheinlichkeitsdichten Quantil: x : F(x ) x f(x) dx Median: x 0.5 (50%-Wert) Wahrscheinlichster Wert (most probable value): Maximum vom f(x) Mittelwert (mean value): x x f(x)dx diskrete Verteilung: x xiP(xi ) i K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Bestimmung von Wahrscheinlichkeitsdichten Histogramm: Häufigkeitsverteilung von Ereignissen Normiert auf Flächeninhalt = 1: Bin-Inhalt/Bin-Breite ~ f(x) (Im Limes Bin-Breite ->0) K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Momente Erwartungswert einer Funktion a(x): E[a] a(x)f(x)dx Für a(x) = x erhält man den Mittelwert E[x] x f(x)dx Die Erwartungswerte von Potenzen von x heißen Momente einer p.d.f. Algebraische Momente: E[xn ] n' n x f(x)dx Zentrale Momente: E[(x ) ] n n n (x ) f(x)dx K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Varianz Ein gutes Maß für die Breite einer Verteilung ist die 2 2 Varianz: V[x] x E[(x ) ] 2 (x ) f(x)dx Die Varianz ist das zweite zentrale Moment von f(x), also die mittlere quadratische Abweichung vom Mittelwert. Standardabweichung: x V[x] (gleiche Einheit wie x, ) Für diskrete p.d.f.’s: 2 2 2 2 2 Für die Varianz gilt: V[x] E[(x ) ] E[x ] 2E[x] E[x ] (folgt aus Linearität der Erwartungswerte, wird später nützlich bei der Berechnung von Schätzwerten für die Varianz) K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Höhere Momente Schiefe (Skewness): E[(x )3 ] / 3 Mass für die Asymmetrie der Verteilung um den Mittelwert Kurtosis: E[(x )4 ] / 4 3 Ausläufer der Verteilung Breitere Ausläufer als bei Gaussverteilung: > 0 Kürzere Ausläufer als bei Gaussverteilung: < 0 K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Mehrere Zufallsvariablen mit gemeinsamer p.d.f. Beispiel: Experiment liefert mehrere Messgrößen Gemeinsame Wahrscheinlichkeitsdichte (hier nur für 2 Variablen): f(x,y) dx dy = Wahrscheinlichkeit, daß x[x,x+dx] und y[y,y+dy] Normierung: S f(x,y) dxdy 1 Individuelle Wahrscheinlichkeitsdichte (“Randverteilung”) für x und y: fx (x) f(x,y) dy fy (y) f(x,y) dx gibt Wahrscheinlichkeitsdichte für x (bzw. y) unabhängig von y (bzw. x) x und y heißen statistisch unabhängig wenn f(x,y) fx (x) fy (y) d.h. x(y) hat immer die gleiche Wahrscheinlichkeitsverteilung, egal wie y(x) eingeschränkt wird K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Mehrere Zufallsvariablen mit gemeinsamer p.d.f. Bedingte Wahrscheinlichkeitsdichten: f(x,y) h(y | x) fx (x) g(x | y) f(x,y) fy (y) h(y|x)dxdy ist die Wahrscheinlichkeit, dass ein Ereignis im Intervall [y,y+dy] zu messen, wenn das Ereignis im Intervall [x,x+dx] liegt. K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Mehrere Zufallsvariablen mit gemeinsamer p.d.f. Beispiel: Messung der Länge eines Stabes und der Temparatur x = Abweichung von 800mm y = Temparatur in 0C a) 2-dimensionales Histogramm (“scatter-plot”) b) Randverteilung von y (“y-Projektion”) c) Randverteilung von x (“x-Projektion”) d) 2 bedingte Verteilungen von x (s. Bänder in a)) Breite in d) kleiner als in a) x und y sind “korreliert” K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Mehrere Zufallsvariablen mit gemeinsamer p.d.f. E[a(x)] a(x)f(x)dx ...dx n Erwartungswert (analog zum 1-dim. Fall) 1 Varianz (analog zum 1-dim. Fall) V[a(x)] a2 (a(x) a )f(x)dx ...dx n 1 wichtig bei mehreren Variablen: Maß für die Korrelation der Variablen: Kovarianz für 2 Variable x,y mit gemeinsamer Wahrscheinlichkeitsdichte f(x,y): cov[x,y] Vxy : E[(x x )(y y )] E[xy] xy ... xy f(x,y)dxdy x y wenn x, y stat. unabhängig (f(x,y) = fx(x)fy(y)) dann ist cov[x,y] = 0 K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Mehrere Zufallsvariablen mit gemeinsamer p.d.f. Positive Korrelation: positive (negative) Abweichung von x von x erhöht Wahrscheinlichkeit, dass y positiv (negativ) von seinem Mittelwert y abweicht Entspr. für negative Korrelation. Für die Summe zweier Zufallszahlen x+y gilt V[x+y] = V[x] + V[y] + 2 cov[x,y] cov[xi ,x j ] Vxix j heißt Kovarianzmatrix (symmetrische Matrix) Diagonalelemente: cov[xi ,xi ] V[xi ] 2x i Für unkorrelierte Variablen ist die Kovarianzmatrix diagonal Für alle Elemente der Kovarianzmatrix gilt cov[xi ,x j ] xi x j Normierte Größe: xi x j : cov[x i , x j ] xi x j heißt Korrelationskoeffizient K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Mehrere Zufallsvariablen mit gemeinsamer p.d.f. Beispiele für Korrelationskoeffizienten (Einheiten spielen keine Rolle!) K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Mehrere Zufallsvariablen mit gemeinsamer p.d.f. Noch ein Beispiel: K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Mehrere Zufallsvariablen mit gemeinsamer p.d.f. Noch ein Beispiel: K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Charakteristische Funktion Nützliche Größe zur Bestimmung von Momenten: x (k) : E[exp(ikx)] exp(ikx)f(x)dx Charakteristische Funktion bis auf Faktor die Fouriertransformierte von f. Durch Rücktransformation erhält man die Wahrscheinlichkeitsdichte f: 1 f(x) exp(ikx)x (k)dk 2 Für diskrete Zufallsvariablen: x (k) exp(ikxi )P(xi ) i Rücktransformation: i exp(ikb) exp(ika) F(b) F(a) x (k)dk 2 k K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Charakteristische Funktion Konkrete Beispiele später… Wichtiger Satz: Die charakteristische Funktion einer Summe von Zufallszahlen ist dem Produkt der charakteristischen Funktionen der einzelnen Zufallszahlen Sei z xi ,dann : z (k) 1(k)...n (k) Also: z (k) ... exp ik xi f1(x1 )...fn (xn )dx1...dxn i i Beweis: exp(ikx1 )f1(x1 )dx1 1(k) exp(ikx n )fn (xn )dxn n (k) ' m Die algebraischen Momente m E[x ] können aus der char. Fkt. leicht berechnet werden: dm dm m m m ' (k) exp(ikx)f(x)dx i x f(x)dx i m x m m k 0 k 0 dk dk K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Variablentransformation K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Variablentransformation K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Faltung K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Faltung K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Fehlerfortpflanzung K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Fehlerfortpflanzung K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Fehlerfortpflanzung K. Desch - Statistik und Datenanalyse SS05 Wahrscheinlichkeit Zusammenfassung K. Desch - Statistik und Datenanalyse SS05