Archäologie und Informationssysteme

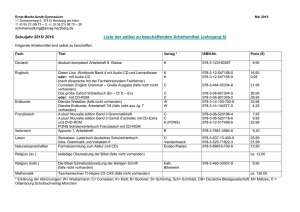

Werbung