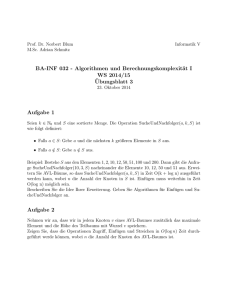

Algorithmen für Peer-to-Peer-Netzwerke

Werbung