Wissenschaftliche Visualisierung – Ausgewählte Forschungsprojekte

Werbung

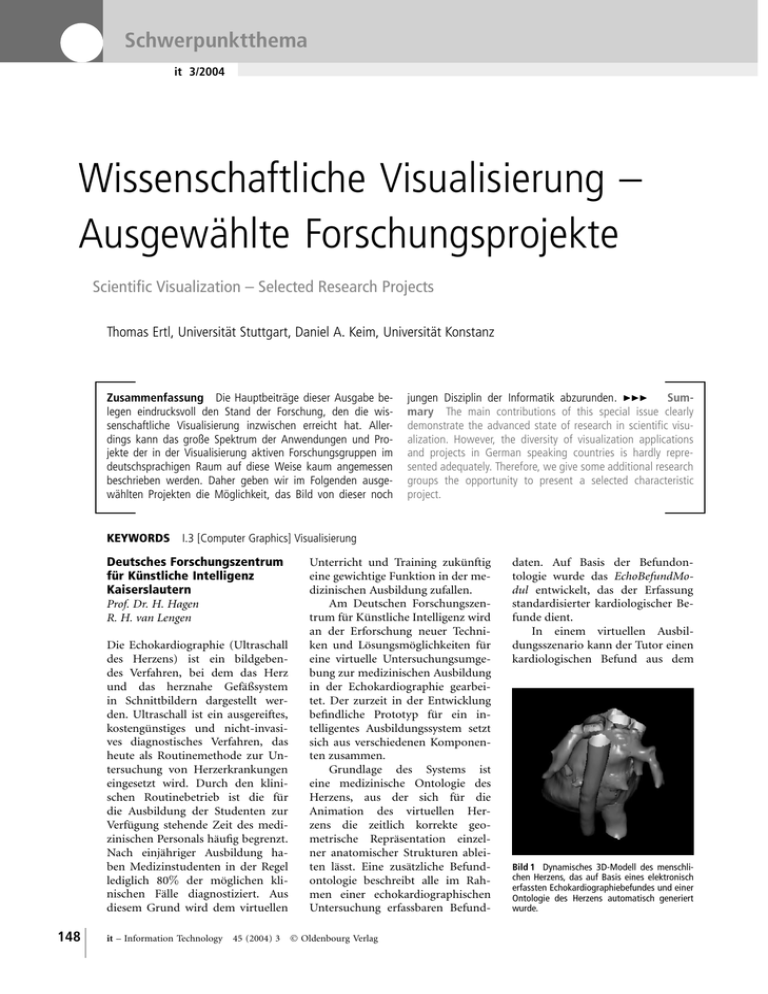

Schwerpunktthema it 3/2004 Wissenschaftliche Visualisierung – Ausgewählte Forschungsprojekte Scientific Visualization – Selected Research Projects Thomas Ertl, Universität Stuttgart, Daniel A. Keim, Universität Konstanz Zusammenfassung Die Hauptbeiträge dieser Ausgabe belegen eindrucksvoll den Stand der Forschung, den die wissenschaftliche Visualisierung inzwischen erreicht hat. Allerdings kann das große Spektrum der Anwendungen und Projekte der in der Visualisierung aktiven Forschungsgruppen im deutschsprachigen Raum auf diese Weise kaum angemessen beschrieben werden. Daher geben wir im Folgenden ausgewählten Projekten die Möglichkeit, das Bild von dieser noch jungen Disziplin der Informatik abzurunden. Summary The main contributions of this special issue clearly demonstrate the advanced state of research in scientific visualization. However, the diversity of visualization applications and projects in German speaking countries is hardly represented adequately. Therefore, we give some additional research groups the opportunity to present a selected characteristic project. KEYWORDS I.3 [Computer Graphics] Visualisierung Deutsches Forschungszentrum für Künstliche Intelligenz Kaiserslautern Prof. Dr. H. Hagen R. H. van Lengen Die Echokardiographie (Ultraschall des Herzens) ist ein bildgebendes Verfahren, bei dem das Herz und das herznahe Gefäßsystem in Schnittbildern dargestellt werden. Ultraschall ist ein ausgereiftes, kostengünstiges und nicht-invasives diagnostisches Verfahren, das heute als Routinemethode zur Untersuchung von Herzerkrankungen eingesetzt wird. Durch den klinischen Routinebetrieb ist die für die Ausbildung der Studenten zur Verfügung stehende Zeit des medizinischen Personals häufig begrenzt. Nach einjähriger Ausbildung haben Medizinstudenten in der Regel lediglich 80% der möglichen klinischen Fälle diagnostiziert. Aus diesem Grund wird dem virtuellen 148 it – Information Technology 45 (2004) 3 Unterricht und Training zukünftig eine gewichtige Funktion in der medizinischen Ausbildung zufallen. Am Deutschen Forschungszentrum für Künstliche Intelligenz wird an der Erforschung neuer Techniken und Lösungsmöglichkeiten für eine virtuelle Untersuchungsumgebung zur medizinischen Ausbildung in der Echokardiographie gearbeitet. Der zurzeit in der Entwicklung befindliche Prototyp für ein intelligentes Ausbildungssystem setzt sich aus verschiedenen Komponenten zusammen. Grundlage des Systems ist eine medizinische Ontologie des Herzens, aus der sich für die Animation des virtuellen Herzens die zeitlich korrekte geometrische Repräsentation einzelner anatomischer Strukturen ableiten lässt. Eine zusätzliche Befundontologie beschreibt alle im Rahmen einer echokardiographischen Untersuchung erfassbaren Befund Oldenbourg Verlag daten. Auf Basis der Befundontologie wurde das EchoBefundModul entwickelt, das der Erfassung standardisierter kardiologischer Befunde dient. In einem virtuellen Ausbildungsszenario kann der Tutor einen kardiologischen Befund aus dem Bild 1 Dynamisches 3D-Modell des menschlichen Herzens, das auf Basis eines elektronisch erfassten Echokardiographiebefundes und einer Ontologie des Herzens automatisch generiert wurde. Wissenschaftliche Visualisierung – Ausgewählte Forschungsprojekte wählten Befund. Eine weiterentwickelte Version würde beide Befunde automatisch abgleichen und zusammen mit den Positionsdaten der Ultraschallsonde Rückschlüsse auf das Ausbildungsniveau des Studenten gewinnen. Literatur Bild 2 Herzmodell teilweise transparent dargestellt mit Hilfe einer so genannten ClippingEbene. EchoBefundModul auswählen. Mit Hilfe der Ontologie des Herzens wird automatisch ein dynamisches 3D-Modell inklusive der aus dem Befund abgeleiteten pathologischen Strukturen erzeugt. Das Modell wird dem auszubildenden Studenten anschließend in einer virtuellen Umgebung präsentiert. Der Student kann das virtuelle Herz in seiner räumlichen Darstellung diagnostizieren und seinerseits einen Befundbericht in das EchoBefundModul eingeben. In der einfachen Variante des Systems vergleicht der Tutor den eingegebenen Befund mit dem ursprünglich von ihm ausge- [1] M. Bertram, S. Köhn, T. Bähr, B. Klein, R.H. van Lengen: Visualization the Shadows of Information. WM2003 (02.04.–04.04.2003), Luzern, Schweiz. [2] G. Reis, M. Bertram, R.H. van Lengen, H. Hagen: Adaptive Volume Construction from Ultrasound Images of a Human Heart. Symp. on Visualization (VisSym), Joint Eurographics – IEEE TCVG 19 (21.05.2004), Konstanz. Universität Konstanz Prof. Dr. Daniel A. Keim In vielen Data Mining Szenarios wird es zunehmend wichtiger, Beziehungen und Muster zu explorieren, die durch große geographiebezogene Datenmengen beschrieben werden. Interessante Beispiele sind Kreditkartentransaktionen, bei denen sowohl die Adresse des Verkäufers als auch des Kunden gesichert werden, oder Telefongespräche, bei denen die Adressen und die Koordinaten (Standorte) des Anrufers und des Angerufenen protokolliert werden. Auch in der Demographie und anderen amtlichen Veröffentlichungen werden neben den statistischen Werten auch Adressen und geographische Verzeichnisse verwendet. Diese geographischen Datenbanken werden durch eine Menge von Tupeln, bestehend aus einem Längengrad und einem Breitengrad, sowie einer Menge von statistischen Werten beschrieben. Jedes Tupel repräsentiert eine geographische Position, welcher ein oder mehrere statistische Werte, entsprechend den Messergebnissen bzw. der statistischen Erhebungen für einen geographischen Standort, zugeordnet werden. Eine sehr einfache und weit verbreitete Visualisierungstechnik sind DotMaps, bei denen einfach Punkte an den einzelnen Standorten gezeichnet werden. Ein großes Problem dieser Technik ist das Überschreiben von bereits gesetzten Punkten, da geographische Daten sehr unregelmäßig in der realen Welt verteilt sind. Dieses Problem führt dazu, dass lokale Muster durch unerwünschtes Überschreiben von bereits gesetzten Pixeln in Bild 3 Vergleich einer traditionellen Karte und einer PixelMap: Beide Karten zeigen das durchschnittliche Haushaltseinkommen in den USA. In der PixelMap Visualisierung kann man sehr leicht die sechs am dichtesten besiedelten Gebiete der USA und deren Einkommenscluster erkennen. 149 Schwerpunktthema Bild 4 Visualisierung von Clustern des durchschnittlichen Haushaltseinkommens des Bundesstaates New York durch PixelMap: Man beachte Cluster mit sehr hohen Einkommen an der Ostseite des Central Parks in Manhattan und Cluster mit sehr niedrigen Einkommen am westlichen Rand von Brooklyn. dichten Regionen (z. B. Ballungszentren) miteinander vermischt werden, während dünn besiedelte Regionen im Gegensatz dazu virtuell leer sind. Diese Situation führt zu neuen Herausforderungen in Hinblick auf die Skalierbarkeit neuer Visualisierungstechniken. In Kooperation mit dem AT&T Shannon Research Laboratory haben wir einen neuen Ansatz, PixelMap genannt, zur visuellen Analyse von großen geographischen Datenbanken entwickelt. Unser PixelMapAnsatz kombiniert dabei ClusteringTechniken mit einer neuen pixelbasierenden Visualisierungstechnik. Die Kombination der beiden unterschiedlichen Techniken ermöglicht einerseits eine effiziente Verzerrung der Karte basierend auf einer Approximation der zweidimensionalen Dichtefunktion auf den beiden geographischen Dimensionen, sodass die dreidimensionalen Punktwolken besser auf die Karte abgebildet werden können, und andererseits eine effiziente Neupositionierung der Datenpunkte. Literatur [1] D.A. Keim, C. Panse, M. Sips: Visual Data Mining of Large Spatial Data Sets, In Databases in Networked 150 Information Systems, Third Int’l Workshop, DNIS’03, Aizu, Japan, Sep. 22–24, LNCS. 2822, 2003. [2] D.A. Keim, S.C. North, C. Panse, M. Sips: PixelMaps: A New Visual Data Mining Approach for Analyzing Large Spatial Data Sets, In: ICDM 2003, The Third IEEE Int’l Conf. on Data Mining, Melbourne, Florida, USA,2003. TU München Prof. Dr. Rüdiger Westermann Die visuelle Simulation und interaktive Visualisierung realer Phänomene ist traditionelles Thema der Computergraphik mit Anwendungen in der wissenschaftlichen Visualisierung, in der virtuellen Realität, in virtuellen Trainings- und Lernsystemen und in Computerspielen. Ausgehend von mathematischen Beschreibungen physikalischer Modelle durch Differentialgleichungen und Differentialgleichungssysteme kommen vor allem numerische Simulationsverfahren zum Einsatz. Im interaktiven Bereich steht die Optimierung der Rechengeschwindigkeit im Vordergrund, was in der Vergangenheit eine starke Einschränkung des zu erzielenden Grades an Realismus oder einen hohen Bedarf an Ressour- cen zur Folge hatte. Die rasante Entwicklung der PC-Graphikhardware hat neue Möglichkeiten zur interaktiven oder gar echtzeitfähigen visuellen Simulation eröffnet, die Gegenstand aktueller Forschung in der Computergraphik sind. Am Lehrstuhl für Computergraphik und Visualisierung der Technischen Universität München wird eine Numerik-Bibliothek für die Simulationsrechnung und Visualisierung entwickelt, die sich von existierenden Bibliotheken darin unterscheidet, dass numerische Lösungs- Bild 5 Direkte numerische Lösung der Navier-Stokes Gleichungen für inkompressible Medien und gleichzeitige Visualisierung der Simulationsergebnisse auf einer ATI 9800 PCGraphikkarte. Die Simulations- und Darstel× 512 Gitter bei 25 lungsrate liegt für ein 512× Bildern pro Sekunde. Wissenschaftliche Visualisierung – Ausgewählte Forschungsprojekte Bild 6 Interaktive Simulation und Visualisierung eines 3D-Windtunnel-Experiments auf einer ATI 9800 PC-Graphikkarte. Basierend auf einem Verfahren zweiter Ordnung können bis zu 40 Millionen Partikel pro Sekunde entlang der Stromlinien in einem stationären Vektorfeld integriert werden. verfahren auf programmierbare PCGraphikhardware abgebildet werden. Dadurch kann das vorhandene Potential an Speicherbandbreite, Parallelverarbeitung und HardwareUnterstützung für spezielle numerische Operationen genutzt werden. Darüber hinausgehend wird der Transfer der Simulationsergebnisse auf das graphische Subsystem zum Zweck der Darstellung vollständig vermieden. Die Kombination mit speziellen Darstellungstechniken für hoch aufgelöste Skalar- und Vektorfelder (z. B. Particle-Engines oder Volume Rendering Methoden) ermöglicht die direkte Simulation und gleichzeitige Darstellung komplexer physikalischer Phänomene in Echtzeit. mobilindustrie untersucht. In der Fahrzeugentwicklung spielt die Simulation z. B. des Crash-Verhaltens oder der Außenaerodynamik schon in einer frühen Phase eine große Rolle. Die zu Grunde liegenden Finite-Element-Modelle sind heute so detailliert, dass traditionelle Pre- und Postprocessing-Techniken zur Aufbereitung der Modelle und zur Analyse der Berechnungsergebnisse oft kein interaktives Arbeiten mehr erlauben. In mehreren Projekten wurden daher in enger Kooperation mit Fahrzeugherstellern hochspezialisierte Visualisierungswerkzeuge entwickelt, die mit optimierten Algorithmen und unter Ausnutzung moderner Graphikhardware komplexe Manipulationen und aussagekräftige Darstellungen in Echtzeit ermöglichen. Einige dieser Tools wurden erfolgreich kommerzialisiert und werden heute weltweit im produktiven Entwicklungsprozess eingesetzt (siehe Bild 7). Beispielhaft sei das BMBF-Verbundprojekt AUTOOPT erwähnt, bei dem in Stuttgart die Integration von unabhängig vernetzten Karosseriebauteilen zu ei- Literatur [1] J. Krüger, R. Westermann: Linear Algebra Operators for GPU Implementation of Numerical Algorithms. SIGGRAPH 2003 Conf. Proc., pp. 908– 917, 2003. [2] J. Krüger, R. Westermann: Acceleration Techniques for GPU based Volume Rendering. IEEE Visualization Conf. Proc., pp. 287–293, 2003. Bild 7 Verschiedene Methoden der Strömungsvisualisierung, die interaktiv zur Optimierung der Außenaerodynamik eines PKW eingesetzt werden (PowerVIZ der science + computing ag). Universität Stuttgart Prof. Dr. Thomas Ertl Am Institut für Visualisierung und Interaktive Systeme der Universität Stuttgart werden neben grundlegenden Aspekten interaktiver Visualisierungsverfahren auch deren Einsatzmöglichkeiten in der Auto- Bild 8 Assembly von unabhängig vernetzten Bauteilen zu einem Finite-Element-Modell des Gesamtfahrzeugs für die Crash-Simulation. nem Gesamtfahrzeugmodell bearbeitet wird. Bei diesem Assembly fallen folgende algorithmisch anspruchsvolle Teilaufgaben an: Korrektur von Netzfehlern wie Perforationen, Auffinden potentieller Flansche zum Verschweißen, Visualisierung von Verbindungstechnik wie Klebeschichten, interaktives Modifizieren der Bauteile bei Aufrechterhalten der Finite-Element-Qualität (siehe Bild 8). Weitere Informationen zu diesem und anderen Projekten finden sich auf www.vis.unistuttgart.de. Literatur [1] N. Frisch, D. Rose, O. Sommer, T. Ertl: Visualization and Pre-processing of Independent Finite Element Meshes for Car Crash Simulations. The Visual Computer , 18(4):236-249, 2002. [2] D. Rose, T. Ertl: Interactive Visualization of Large Finite Element Models. In Workshop on Vision, Modelling, and Visualization VMV ’03, pp. 585–592. infix, 2003. Universität Tübingen Prof. Dr. Wolfgang Straßer Der Lehrstuhl für graphisch-interaktive Systeme (GRIS) der Universität Tübingen betreibt Forschung in allen Bereichen der Computergraphik. Ein wichtiger Schwerpunkt der letzten Jahre stellte die Behandlung von großen Datenmengen dar. Als Beispiel soll hier eine neu entwickelte Technik zu Darstellung großer animierter dreidimensionaler Szenen vorgestellt werden. Motivation für diese Arbeit waren bekannte Filme wie „Der König der Löwen“ oder „Der Herr der Ringe“, in denen Massenszenen mit Hilfe von Computergraphik realisiert werden. Ersterer Film zeigt zum Beispiel eine Animation einer riesigen Büffelherde, die durch ein Tal donnert, während im Herrn der Ringe gewaltige Schlachtszenarien mit hunderttausenden Fantasiewesen realistisch dargestellt werden. Unser Ziel war es, ähnliche Szenen auch in Echtzeitanwendungen, wie etwa Computerspielen, darstel- 151 Schwerpunktthema len zu können. Mit bisher bekannten Verfahren war dies nicht möglich, da die Komplexität der Szenen zu hoch ist (viele tausend Objekte, die wiederum aus vielen tausend Darstellungsprimitiven bestehen). Um die Komplexität zu reduzieren, wird ein Stichprobenverfahren angewandt: Es werden Oberflächenpunkte aus der Menge der Objekte ausgewählt, die die dargestellten Objekte gleichmäßig im Bildraum abdecken. Aus den Stichprobenpunkten wird dann ein Bild rekonstruiert. Der Vorteil dieses Ansatzes liegt darin, dass die Anzahl der nötigen Stichprobenpunkte nur von der Bildauflösung, nicht aber von dem Detaillierungsgrad der Objekte abhängt: Hierarchische Hilfsdatenstrukturen erlauben es, die notwendigen Stichproben mit einem Zeitaufwand zu nehmen, der unabhängig von der Szenenkomplexität ist. Damit lassen sich so auch extrem komplexe Szenen mit gleich bleibendem Aufwand bearbeiten. Im Vergleich zu früheren Verfahren zur Komplexitätsreduktion hat das Stichprobenverfahren (engl.: Point Sample Rendering) den großen Vorteil, dass es sich sehr leicht auf animierte Szenen anwenden lässt. Bild 9 und 10 zeigen zwei Beispielszenen hoher Komplexität, die mit dem neuen Verfahren in Echtzeit dargestellt werden konnten. Aufgrund der Effizienz wie auch der konzeptionellen Einfachheit des Ansatzes hoffen wir, dass entsprechende Techniken auch bald in der Praxis Anwendung finden werden. Weitere Informationen finden sich auch auf unserer Webseite: http://www.gris.uni-tuebingen.de. Literatur [1] M. Wand, M. Fischer, I. Peter, F. Meyer auf der Heide, W. Straßer: The Randomized z-Buffer Algorithm: Interactive Rendering of Highly Complex Scenes. In: SIGGRAPH 2001 Conf. Proc. [2] M. Wand, W. Straßer: Multi-Resolution Rendering of Complex Animated Scenes. In: EUROGRAPHICS 2002 Conf. Proc.. TU Wien und Forschungszentrum VRVis Prof. Dr. Eduard Gröller Dr. Helwig Hauser Bild 9 Ein Stadion mit Fußballfans. Die Animation der jubelnden Fans wird in Echtzeit dargestellt. Die Szene besteht aus 105 Millionen Dreiecken. Bild 10 Eine Horde Pferde läuft durch eine Hügellandschaft. Das Verhalten der 2000 Pferde wird in Echtzeit simuliert und dargestellt. Die Pferde bestehen zusammen aus 45 Millionen Dreiecken. 152 Seit einigen Jahren werden am Institut für Computergraphik und Algorithmen der TU Wien ( http://www.cg.tuwien.ac.at/home ) sowie am VRVis Zentrum für Virtual Reality und Visualisierung (http://www.VRVis.at/) weltweit anerkannte Forschungsarbeiten auf dem Gebiet der medizinischen Visualisierung abgewickelt. Im Rahmen wissenschaftlicher Projekte werden Methoden der 3D-Computergraphik sowie insbesondere auch der 3D-Volumensdarstellungen für den täglichen klinischen Einsatz in der Radiologie (wie auch in anderen medizinischen Fächern) erforscht und entwickelt. Neue Werkzeuge für die medizinische Visualisierung ermöglichen qualitative und quantitative Fortschritte in der Computer- unterstützten Diagnose (bessere sowie schnellere Analysen bestimmter pathologischer Sachverhalte) wie auch eine verbesserte Operationsbeziehungsweise Therapieplanung. Ein aktuelles Beispiel ist die auf Computer-Tomographie-Angiographie basierende Visualisierung von Blutgefäßen. Traditionelle Verfahren weisen erhebliche Schwierigkeiten bei der Sichtbarkeit von wichtigen Einzelheiten auf, etwa dem Flusskanal sowie dem Verkalkungsgrad. Eine Möglichkeit zur Darstellung von Gefäßstrukturen für Diagnosezwecke besteht in der Erzeugung von Längsschnitten durch die Blutgefäße. Diese Darstellungsart wird als curved planar reformation (CPR) bezeichnet. Der Flusskanal, die Gefäßwand und das umgebende Gewebe werden mittels einer nicht-linearen, sich am Blutgefäß orientierenden Transformation eben (im 2D) dargestellt. Aktuell werden in Wien CPR-Verbesserungen erforscht wie z. B. die verdeckungsfreie Darstellung eines gesamten Gefäßbaums (MultipfadCPR, siehe Bild 11). Ein anderer Ansatz erlaubt die Ableitung eines geometrischen Modells für Gefäße wobei mittels deformierbarer Modelle interne und externe Randbedingungen berücksichtigt werden. Andere ausgewählte Beispiele für aktuelle Wiener Forschungsergebnisse im Bereich der medizinischen Visualisierung sind verbesserte 3D-Volumendarstellungen (z. B. two-level volume rendering, verschiedene, auch nicht- Bild 11 Koronale Multi-Pfad-Darstellung der peripheren Gefäße (links), saggitale verdeckungsfreie Darstellung der peripheren Gefäße (rechts). Wissenschaftliche Visualisierung – Ausgewählte Forschungsprojekte Bild 12 Two-Level Volume Rendering unter Einbindung verschiedener Darstellungsarten (Konturendarstellung, tone shading, maximumintensity projection, schattierte Oberflächendarstellung, etc.) für die Visualisierung eines menschlichen Kopfes (Computertomographiedaten). photorealistische, d. h., illustrative Darstellungstechniken integrierend, Bild 12), optimierte Techniken zur Segmentierung von Volumendaten (z. B. die vom Arzt geführte, fast-automatische Bestimmung des Herzmuskels) und Fortschritte in der virtuellen Endoskopie (z. B. die besonders schnelle und dabei doch hoch-qualitative Oberflächendarstellung von inneren Organen mit gleichzeitiger Unterstützung von force-feedback Interaktion für die Navigation). Weiterführende Informationen und weitere Beispiele sind unter den oben angegebenen Internetseiten zu finden. Literatur [1] A. Kanitsar, R. Wegenkittl, D. Fleischmann, E. Gröller: Advanced Curved Planar Reformation: Flattening of Vascular Structures; Proc. of IEEE Visualization 2003 , pp. 43–50. [2] M. Hadwiger, C. Berger, H. Hauser: High-Quality Two-Level Volume Rendering of Segmented Data Sets on Consumer Graphics Hardware; Proc. of IEEE Visualization 2003, pp. 301–308. Innotec. Beide Firmen spielen eine führende Rolle bei der CFD-Simulation von Wasserturbinen. Aufgrund der großen Erfahrung mit CFD konnte in den letzten zehn Jahren eine große Anzahl von Francis Laufräder ohne Modellversuch entwickelt und direkt ab Bildschirm gefertigt werden. Eines der derzeit aktivsten Forschungsgebiete ist der Einsatz der CFD für die Peltonturbinen, die man bislang nur mithilfe des Experiments und empirischer Erfahrung optimieren kann. Neben Neubauprojekten spielt vor allem die Modernisierung bestehender Anlagen eine wichtige Rolle. Die jeweils unterschiedlichen lokalen Gegebenheiten bedingen individuell angepasste Designs, was zu einem großen Bedarf an Simulationen führt, umso mehr als jeweils mehrere Betriebspunkte und oft auch mehrere Designvarianten durchgerechnet werden. Bei der Strömungsvisualisierung geht es vor allem darum, in qualitativer Weise den Einfluss dieser beiden Parameter Betriebspunkt und Designvariante auf spezifische Strömungsmerkmale zu erfassen. Die Verarbeitung ganzer Serien von Datensätzen macht dabei eine automatische Erkennung von Merkmalen unabdingbar. Für Wasserkraftmaschinen relevante Strömungsmerkmale sind vor allem Wirbel, Kavitation und Rückströmung. ETH Zürich Dr. Ronald Peikert Das Computer Graphics Laboratory der ETH Zürich hat sich innerhalb seiner Visualisierungsaktivitäten vor allem auf dreidimensionale Strömungsdaten spezialisiert. Seit 1994 besteht eine Kooperation mit den Industriepartnern VA Tech Hydro (ehemals Escher Wyss) und Sulzer Bild 14 Simulation der Strömung in einer Peltonturbine: Der Wasserstrahl trifft den Becher und wird durch diesen nach außen abgelenkt wobei die Impulsübertragung auf das Laufrad stattfindet. Das rechte Bild zeigt den Druckverlauf auf dem Becher. Die automatische Erkennung und Verfolgung von Wirbeln hat sich im letzten Jahrzehnt zu einem Schwerpunkt der Strömungsvisualisierung entwickelt. Verwendete Methoden basieren auf geometrischen, topologischen oder physikalischen Wirbelmodellen. Geometrische Verfahren benutzen lokale Kriterien wie Krümmung oder Windung von Stromlinien. Topologische Verfahren analysieren kritische Punkte und deren Separatrizen, basieren also auf globalen Kriterien. Keiner der zwei Ansätze eignet sich aber für Wirbel der ganzen Größenskala. Die Betrachtung der Strömungsmerkmale im Scale-Space ist deshalb sinnvoll und gibt zusätzliche Information. Bei Geschwindigkeitsfeldern mit ausgeprägter Zeitabhängigkeit muss aber auch den physikalischen Grundlagen, etwa dem VorticityTransport, vermehrt Rechnung getragen werden, was Gegenstand der aktuellen Forschung ist. Literatur Bild 13 Teillastwirbel in einer Pumpturbine: Der rotierende Wirbelzopf verursacht Druckschwankungen in der ganzen Maschine. [1] D. Bauer, R. Peikert, M. Sato, M. Sick: A Case Study in Selective Visualization of Unsteady 3D Flow. Proc. of IEEE Visualization ’02, IEEE Computer Society Press, pp.525-529. [2] D. Bauer, R. Peikert: Vortex Tracking in Scale-Space. Joint EUROGRAPHICS - IEEE TCVG Symp. on Visualization (2002), VisSym’02, Barcelona, May 27–29, pp. 233–240, 2002. 153