Vorlesung Vorlesung

Werbung

Vorlesung

Grundlagen betrieblicher

y

Informationssysteme

Prof. Dr. Hans Czap

Lehrstuhl für Wirtschaftsinformatik I

Email: Hans

Hans.Czap@uni

Czap@uni-trier

trier.de

de

Lehrstuhl für

Wirtschaftsinformatik I

- II - 1 -

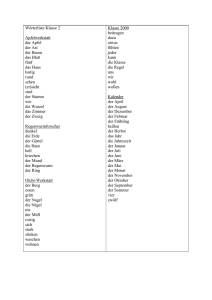

Inhalt

Kap. 1 Ziele der Datenbanktheorie

Kap. 2 Datenmodellierung und Datenbankentwurf

K

Kap.

3D

Datenbankarchitektur

t b k hit kt

Kap. 4 Die Datenbanksprache SQL

Kap 5 Konzepte für Objektorientierte Datenbanken

Kap.

Kap. 6 Objektrelationale Datenbanken

Kap.

p 7 Datenbankentwurf: Funktionale Abhängigkeiten

gg

und

Normalisierung

Kap. 8 Datenintegrität

• Sperrprotokolle

• Recovery

Kap 9 Data-Warehouse-Konzept

Kap.

Data Warehouse Konzept

Kap. 10 Data Mining und Knowledge Discovery

Lehrstuhl für

Wirtschaftsinformatik I

- II - 2 -

Data-Mining und Knowledge Discovery

•

Aufgaben des Data Mining

– Identifizierung von Beziehungsmustern (Regelmäßigkeiten oder auch

Auffälligkeiten) der Daten einer Datensammlung (Abweichungsentdeckung)

– Aufzeigen der logischen bzw. funktionalen Beziehungszusammenhänge: Ziel

ist es, neue Zusammenhänge bzw. Zusammenhangsmuster (Pattern-Analyse) zu

entdecken. Konkret ist dabei an Assoziationen bzw. der Analyse von

S

Sequenzen

zu denken (Abhängigkeitsentdeckung,

(

Regression))

– Klassifikation und Clusterbildung von Daten mit dem Ziel Risiko-Faktoren zu

entdecken bzw. Erfolgsgruppen (z.B. für Marketing-Aktivitäten) zu identifizieren

bzw. zu selektieren. Typisches Anwendungsbeispiel: Klassifikation von

Konsumenten, die um einen Kredit nachsuchen, in Risikogruppen.

• Klassifikation = Einteilung in vorgegebene Klassen

• Clusterbildung = Einteilung aufgrund von Merkmalsausprägungen nach Ähnlichkeit

bzw. Unähnlichkeit. Anzahl Klassen ist nicht vorgegeben.

•

Knowledge

g Discovery

y in Datenbanken ((KDD))

KDD wird zum Teil als Oberbegriff des Data-Mining gesehen, zum Teil als

äquivalent. Es wird also in der Literatur nicht scharf zwischen KDD und DataMining

gg

getrennt. Soweit KDD als Oberbegriff

g g

gesehen wird,, wird das

Data_Mining als Hilfsmittel bzw. Methode für KDD betrachtet.

Lehrstuhl für

Wirtschaftsinformatik I

- II - 3 -

Abhängigkeitsentdeckung

•

Warenkorbanalyse (Beispiel)

WK#

Kunden#

Datum

Artikel#

Bezeichnung

E-Preis

Menge

134

201

02 12 97

02.12.97

432

Füller

35

2

134

201

02.12.97

120

Tinte

2

1

134

201

02.12.97

009

Heft

5

3

134

201

02.12.97

890

Seife

1

6

107

83

13.11.97

432

Füller

35

1

107

83

13 11 97

13.11.97

120

Ti t

Tinte

2

1

107

83

13.11.97

009

Heft

5

1

110

135

13.11.97

432

Füller

35

1

110

135

13.11.97

009

Heft

5

1

103

201

26.08.97

432

Füller

35

2

103

201

26.08.97

120

Tinte

2

2

103

201

26.08.97

890

Seife

1

4

Lehrstuhl für

Wirtschaftsinformatik I

- II - 4 -

Warenkorbanalyse

• Vermutete Assoziation

Wenn ein Füller gekauft wird, dann wird auch Tinte gekauft: Füller Î Tinte

Hier: Betrachtungseinheit (BE) = Warenkorb, Items der Regel = Füller, Tinte

• Definitionen

# BE, die alle Items der Regel enthalten

Support (einer Regel) =

# aller in der Tabelle vorkommenden BE

# BE, die alle Items der Regel enthalten

Confidence(einer Regel) =

# BE, die die Items des Voraussetzungsteils enthalten

Folglich gilt für obige Regel:

Lehrstuhl für

Wirtschaftsinformatik I

Support = ¾ , Confidence = ¾ .

- II - 5 -

Algorithmische Bestimmung von Regeln

•

•

•

Zur algorithmischen Bestimmung von Regeln sucht man zunächst nach

Mengen von Items mit einem Support > s0, s0 vorgegebener Schwellenwert.

Anschließend bildet man geeignete Teilmengen der Items LS und RS

( LS = left side, RS = right side) und bestimmt die Confidence der Regel

LS Î RS.

Es werden nur die Regeln akzeptiert, die eine Confidence > c0,

c0 vorgegebener Minimalwert, haben.

Lehrstuhl für

Wirtschaftsinformatik I

- II - 6 -

Algorithmus

•

•

•

•

•

•

•

MI = Menge häufiger Item-Mengen

Item-Mengen, Zu Beginn gilt MI = ∅.

∅

Teste für jedes Item I (genauer für jede ein-elementige Item-Menge I1), ob I häufig

ist, d.h. in mehr als s0 BE (Warenkörben) vorkommt.

Falls ja,

ja MI := MI + {I},

{I} d.h.

d h nimm I in MI auf.

auf

k sei Indikator für die größten in MI vorkommenden Item-Mengen. Zunächst gilt k:=1.

Für jede Item-Menge Ik in MI mit k Elementen:

Bilde sukzessive alle (k+1)-elementigen Obermengen Ik+1 ⊃ Ik und prüfe auf

Häufigkeit

Falls Ik+1 häufig

g ist, nimm Ik+1 in MI auf: MI := MI + {{Ik+1}}

Erhöhe k, k:=k+1.

Wenn dieser Algorithmus mit den Werten s0 = 0,7

0 7 und c0 = 0,8

0 8 auf obiges Beispiel angewendet

wird, erhält man folgende Mengen:

k=1, MI = {{Füller},{Tinte},{Heft}}

kk=2,

2, MI = {{Füller, Tinte },{Füller, Heft}}

Die dreielementige Menge {Füller, Tinte, Heft} wird getestet und als nicht häufig verworfen.

Die potentiellen Regeln lauten damit: Füller Î Tinte, Tinte Î Füller, Füller Î Heft und Heft Î

, zu überprüfen.

p

Füller. Sie sind auf Confidence > 0,8

Damit verbleiben die Regeln Tinte Î Füller und Heft Î Füller.

Lehrstuhl für

Wirtschaftsinformatik I

- II - 7 -