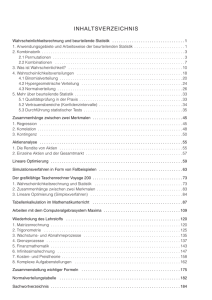

Vorlesung: Statistik II für Wirtschaftswissenschaft - StaBLab

Werbung

Vorlesung: Statistik II für

Wirtschaftswissenschaft

Prof. Dr. Helmut Küchenho↵

Institut für Statistik, LMU München

Sommersemester 2017

Einführung

1

Wahrscheinlichkeit: Definition und Interpretation

2

Elementare Wahrscheinlichkeitsrechnung

3

Zufallsgrößen

4

Spezielle Zufallsgrößen

stetige Verteilungen

5

Mehrdimensionale Zufallsvariablen

6

Genzwertsätze

t-Verteilung

Definition t-Verteilung

Seien X und Y1 , . . . Yn unabhängige Zufallsvariablen mit X ⇠

N(0, 1) und Yi ⇠ N(0, 1). Dann ist der Quotient

qP

n

X

2

i=1 Yi /n

⇠ tn

t-verteilt mit n Freiheitsgraden.

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

173 / 210

t-Verteilung

0.4

0.3

0.2

0.1

−6

Statistik 2

t30

0.0

0.0

0.1

0.2

0.3

0.4

t1

0.5

0.5

Beispiele der Dichtefunktion

−4

−2

Sommersemester 2017

0

2

4

6

−6

−4

−2

0

Helmut Küchenho↵ (Institut für Statistik, LMU)

2

4

6

174 / 210

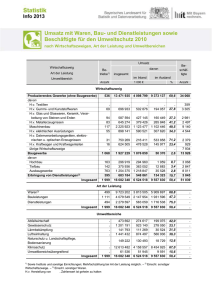

Anwendungen bei Finanzdaten

Häufig wird die Normalverteilung fr die Verteilung von Renditen

genutzt

Problematisch, da die Wahrscheinlichkeit von extremen Ausreißern

(Crash) unterschätzt wird

Abhilfe: Verwende Verteilungen mit heavy tails z.B. die t-Verteilung

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

175 / 210

Vergleich t-Verteilung und Normalverteilung

0.4

0.3

y

Verteilung

Normalverteilung

0.2

t−Verteilung

0.1

0.0

−4

−2

0

2

4

x

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

176 / 210

Einführung

1

Wahrscheinlichkeit: Definition und Interpretation

2

Elementare Wahrscheinlichkeitsrechnung

3

Zufallsgrößen

4

Spezielle Zufallsgrößen

5

Mehrdimensionale Zufallsvariablen

6

Genzwertsätze

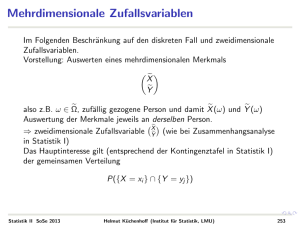

Mehrdimensionale Zufallsvariablen

Analog zu den Maßzahlen und Überlegungen aus der deskriptiven

Statistik:

✓ ◆

X

Y

also z.B. ! 2 ⌦, zufällig gezogene Person und damit X (!) und Y (!)

Auswertung der Merkmale jeweils an derselben Person.

) zweidimensionale Zufallsvariable YX (wie bei Zusammenhangsanalyse

in Statistik I)

Das Hauptinteresse gilt (entsprechend der Kontingenztafel in Statistik I)

der gemeinsamen Verteilung

P({X = xi } \ {Y = yj })

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

177 / 210

Zweidimensionale Verteilungen

Betrachtet werden zwei eindimensionale diskrete Zufallselemente X und

Y (zu demselben Zufallsexperiment). Die Wahrscheinlichkeit

P(X = xi , Y = yj ) := P({X = xi } \ {Y = yj })

in Abhängigkeit von xi und yj heißt gemeinsame Verteilung der

mehrdimensionalen Zufallsvariable YX bzw. der Variablen X und Y .

Randwahrscheinlichkeiten:

pi•

=

P(X = xi ) =

m

X

P(X = xi , Y = yj )

j=1

p•j

Statistik 2

=

Sommersemester 2017

P(Y = yj ) =

k

X

P(X = xi , Y = yj )

i=1

Helmut Küchenho↵ (Institut für Statistik, LMU)

178 / 210

Bedingte Verteilungen

P(X = xi |Y = yj )

=

P(Y = yj |X = xi )

=

P(X = xi , Y = yj )

P(Y = yj )

P(X = xi , Y = yj )

P(X = xi )

Stetiger Fall: Zufallsvariable mit zweidimensionaler Dichtefunktion

f (x, y ):

!

Z

Z

b

P(a X b, c Y d) =

Statistik 2

Sommersemester 2017

d

f (x, y )dy

a

dx

c

Helmut Küchenho↵ (Institut für Statistik, LMU)

179 / 210

Kovarianz

Seien X und Y zwei Zufallsvariablen. Dann heißt

X ,Y

:= Cov(X , Y ) = E ((X

E(X ))(Y

E(Y )))

Kovarianz von X und Y .

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

180 / 210

Rechenregeln

Cov(X , X ) = Var(X )

Cov(X , Y ) = E(XY )

E(X ) · E(Y )

Cov(X , Y ) = Cov(Y , X )

Mit X̃ = aX X + bX und Ỹ = aY Y + bY ist

Cov(X̃ , Ỹ ) = aX · aY · Cov(X , Y )

Var(X + Y ) = Var(X ) + Var(Y ) + 2 · Cov(X , Y )

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

181 / 210

Korrelation

Definition

Zwei Zufallsvariablen X und Y mit Cov(X , Y ) = 0 heißen unkorreliert.

Stochastisch unabhängige Zufallsvariablen sind unkorreliert. Die

Umkehrung gilt jedoch im allgemeinen nicht.

Vergleiche Statistik I: Kovarianz misst nur lineare Zusammenhänge.

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

182 / 210

Korrelationskoeffizient

Definition

Gegeben seien zwei Zufallsvariablen X und Y . Dann heißt

⇢(X , Y ) = p

Cov(X , Y )

p

Var(Y )

Var(X )

Korrelationskoeffizient von X und Y .

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

183 / 210

Eigenschaften des Korrelationskoeffizienten

Mit X̃ = aX X + bX und Ỹ = aY Y + bY ist

|⇢(X̃ , Ỹ )| = |⇢(X , Y )|.

1 ⇢(X , Y ) 1.

|⇢(X , Y )| = 1 () Y = aX + b

Sind Var(X ) > 0 und Var(Y ) > 0, so gilt ⇢(X , Y ) = 0 genau dann,

wenn Cov(X , Y ) = 0.

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

184 / 210

Einführung

1

Wahrscheinlichkeit: Definition und Interpretation

2

Elementare Wahrscheinlichkeitsrechnung

3

Zufallsgrößen

4

Spezielle Zufallsgrößen

5

Mehrdimensionale Zufallsvariablen

6

Genzwertsätze

Grenzwertsätze: Einführung

Big Data: Bobachtung von großen Datensätzen

Was ist das Besondere daran?

Vereinfacht sich etwas und wenn ja was?

Kann man Wahrscheinlichkeitsgesetzmäßigkeiten“ durch

”

Betrachten vielfacher Wiederholungen erkennen?

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

185 / 210

Das i.i.d.-Modell

Betrachtet werden diskrete oder stetige Zufallsvariablen X1 , . . . , Xn , die

i.i.d. (independently, identically distributed) sind, d.h. die

1) unabhängig sind und

2) die gleiche Verteilung besitzen.

Ferner sollen der Erwartungswert µ und die Varianz 2 existieren. Die

Verteilungsfunktion werde mit F bezeichnet.

Dies bildet insbesondere die Situation ab in der X1 , . . . , Xn eine

Stichprobe eines Merkmals X̃ bei einer einfachen Zufallsauswahl sind.

Beispiel:

X̃ Einkommen, n Personen zufällig ausgewählt

Statistik 2

X1

X2

..

.

Einkommen der

Einkommen der

ersten

zweiten

..

.

zufällig ausgewählten Person

zufällig ausgewählten Person

Xn

Einkommen der

n-ten

zufällig ausgewählten Person

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

186 / 210

Stichprobenvariable

Jede Funktion von X1 , . . . , Xn ist wieder eine Zufallsvariable, z.B. das

arithmetische Mittel oder die Stichprobenvarianz

n

1X

Xi

n

i=1

S̃ 2 =

n

1X

(Xi

n

X̄ )2

i=1

Wahrscheinlichkeitsaussagen möglich =) Wahrscheinlichkeitsrechnung

anwenden

Gerade bei diesen Zufallsgrößen ist die Abhängigkeit von n oft

wichtig, man schreibt dann X̄n , S̃n2

Sind X1 , . . . , Xn jeweils {0, 1}-Variablen, so ist X̄n gerade die

empirische relative Häufigkeit von Einsen in der Stichprobe vom

Umfang n. Notation: Hn

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

187 / 210

Erwartungswert und Varianz von X̄n

X1 , X2 , . . . , Xn seien unabhängig und identisch verteilt.

X1 , X2 , . . . , Xn

Ist E(Xi ) = µ und Var (Xi ) =

2

i.i.d.

, so gilt:

E(X1 + X2 + . . . + Xn )

=

nµ

Var (X1 + X2 + . . . + Xn )

✓

◆

1

E

(X1 + X2 + . . . + Xn )

n

✓

◆

1

Var

(X1 + X2 + . . . + Xn )

n

=

n

=

µ

2

2

=

n

Diese Eigenschaften bilden die Grundlage für die folgenden Sätze.

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

188 / 210

Das schwache Gesetz der großen Zahlen

Betrachte für wachsenden Stichprobenumfang n:

X1 , . . . , Xn i.i.d.

Xi 2 {0, 1} binäre Variablen mit ⇡ = P(Xi = 1)

Beispiele: Pro/Contra, Kopf/Zahl, A tritt ein/A tritt nicht ein

Hn = die relative Häufigkeit der Einsen in den ersten n Versuchen.

relative

6

Häufigkeit

wahrer Wert

-

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

189 / 210

0

0

1000

1500

0.3

-

1000

1500

1500

1:i

3000

2000

3500

2500

3000

1:i

0.6

s[1:i]

0.5

0.4

0.3

0.6

s[1:i]

0.4

0.3

0

3500

1:i

500

1000

1500

1500

0.5

s[1:i]

0.5

0.6

s[1:i]

s[1:i]

0.3

0.4

2500

1500

0500

1000

0.7

0.7

0.6

0.7

0.7

s[1:i]

0.5

2000

1000

1:i

10001500

1:i

500

1:i

0.4

0.3

1500

500

0

5001000

1:i

0

1:i

0.6

0.7

0.6

1000

0

1500

1500

0.7

0.7

0.5

0.6

s[1:i]

s[1:i]

s[1:i]

0.4

0.5

0 500

0.3

500

1000

1500

1000

1:i

1000

1:i

0

1500

1:i

1000

500

1:i

0.3

0.4

1500

1000

500

500

0.6

0.7

0.7

0.4

0.5

s[1:i]

0.6

0.60.7

s[1:i]

0.50.6

0.3

1000

500

1:i

0500

0.6

0.5

s[1:i]

s[1:i]

0.4

0.3

500

1500

0

0

1000

1500

1500

2000 0

4000

2000

6000

4000

1:i

0

500

1:i

1000

1500

8000

6000

10000

8000

10000

1:i

2000

2500

3000

3500

1:i

0.7

1:i

0

0.3

1500

0.5

0.4

0.6

0.5

s[1:i]

0.4

0.3

1000

1:i

500

1000

0

1500

0.7

0.7

0.7

0.6

0.7

0.3

0.4

0.3

500

0500

0.40.5

0.30.4

0 500

0

1:i

0.5

0.6

s[1:i]

s[1:i]

0

1500

1:i

0.4

0.5

0.7

0.6

0.5

s[1:i]

0.4

0.3

0

1500

1000

1:i

-

0.3

1500

1000

1500

1000

500

1:i

0.3

500

1000

1:i

0

0.5

0.6

1000

1:i

0500

00

s[1:i]

s[1:i]

0.4

0.3

0.3

0.4

500

0.3

0

500

0.7

0.7

0.7

0.6

0.7

0.5

0.6

0.4

0.5

0.7

0.6

s[1:i]

0.5

s[1:i]

s[1:i]

0.4

0

0.3

00

0

0.4

0.5

0

eiben:

Simulationen

variable!

allsvariable!

FigurFigur

beschreiben:

beschreiben:

Helmut Küchenho↵ (Institut für Statistik, LMU)

.7

Sommersemester 2017

.7

6.7

.7

Statistik 2

190 / 210

Beobachtungen

1

Am Anfang sehr unterschiedlicher, unregelmäßiger Verlauf der

Pfade.

2

Mit wachsendem n pendeln sich die Pfade immer stärker um ⇡

herum ein, d.h. mit wachsendem Stichprobenumfang konvergiert die

relative Häufigkeiten eines Ereignisses gegen seine

Wahrscheinlichkeit.

3

Formalisierung von 2.: Legt man sehr kleine Korridore/Intervalle um

⇡, so ist bei sehr großem n der Wert von Hn fast sicher in diesem

Korridor.

Das Ereignis Die relative Häufigkeit Hn liegt im Intervall der Breite

”

2✏ um ⇡ lässt sich schreiben als:

”

⇡

"

"

Statistik 2

Sommersemester 2017

Hn

Hn

⇡

|Hn

⇡|

⇡+"

"

"

Helmut Küchenho↵ (Institut für Statistik, LMU)

191 / 210

Theorem von Bernoulli

Seien X1 , . . . , Xn , i.i.d. mit Xi 2 {0, 1} und P(Xi = 1) = ⇡. Dann gilt für

Hn =

n

1X

Xi

n

i=1

(relative Häufigkeit der Einsen“) und beliebig kleines ✏ > 0

”

lim P(|Hn

n!1

⇡| ✏) = 1

Anschauliche Interpretation: Die relative Häufigkeit eines Ereignisses

nähert sich praktisch sicher mit wachsender Versuchszahl an die

Wahrscheinlichkeit des Ereignisses an.

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

192 / 210

Zwei wichtige Konsequenzen

1) Häufigkeitsinterpretation von Wahrscheinlichkeiten:

P(A), die Wahrscheinlichkeit eines Ereignisses A, kann man sich

vorstellen als Grenzwert der relativen Häufigkeit des Eintretens von A

in einer unendlichen Versuchsreihe identischer Wiederholungen eines

Zufallsexperiments.

2) Induktion: Man kann dieses Ergebnis nutzen, um Information über

eine unbekannte Wahrscheinlichkeit (⇡ =

ˆ Anteil in einer

Grundgesamtheit) zu erhalten.

Sei z.B. ⇡ der (unbekannte) Anteil der SPD Wähler, so ist die relative

Häufigkeit in der Stichprobe eine gute Schätzung für ⇡“. Je größer

”

die Stichprobe ist, umso größer ist die Wahrscheinlichkeit, dass die

relative Häufigkeit sehr nahe beim wahren Anteil ⇡ ist.

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

193 / 210

Gesetz der großen Zahl (allgemein)

Das Ergebnis lässt sich verallgemeinern auf Mittelwerte beliebiger

Zufallsvariablen:

Gegeben seien X1 , . . . , Xn i.i.d. Zufallsvariablen mit (existierendem)

Erwartungswert µ und (existierender) Varianz 2 . Dann gilt für

n

1X

X̄n :=

Xi

n

i=1

und beliebiges ✏ > 0:

µ| ✏) = 1

lim P(|X̄n

n!1

Schreibweise:

P

X̄n ! µ

( Stochastische Konvergenz“, Xn konvergiert in Wahrscheinlichkeit

”

”

gegen µ“.)

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

194 / 210

Konsequenz

Interpretation des Erwartungswerts: µ kann in der Tat

interpretiert werden als Durchschnittswert in einer unendlichen

Folge von Wiederholungen des Zufallsexperiments.

Spiele. Wenn ein Spiel mit negativem Erwartungswert häufig

gespielt wird, verliert man mit sehr hoher Wahrscheinlichkeit (Grund

für Rentabilität von Spielbanken und Wettbüros)

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

195 / 210

Die Verteilungsfunktion

Jetzt betrachten wir die empirische Verteilungsfunktion: In jedem Punkt

x ist Fn (x) vor der Stichprobe eine Zufallsvariable, also ist Fn eine

zufällige Funktion

Wie vergleicht man die zufällige Funktion Fn (x) mit der Funktion F (x)?

Der Abstand hängt ja von dem Punkt x ab, in dem gemessen wird!

Idee: Maximaler Abstand

max |FnX1 ,...,Xn (x)

x 2R

F (x)|

Existiert nicht immer; formal muss man das sogenannte Supremum

betrachten.

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

196 / 210

Hauptsatz der Statistik

Seien X1 , . . . , Xn i.i.d. mit Verteilungsfunktion F und sei Fn (x) die

empirische Verteilungsfunktion der ersten n Beobachtungen. Mit

Dn := sup |Fn (x)

F (x)|,

x

gilt für jedes c > 0

lim P(Dn > c) = 0.

n!1

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

197 / 210

Interpretation

Erträglichkeitsschranke“ c vorgegeben. Wsk, dass maximaler

”

Abstand größer c ist geht für hinreichend großes n gegen 0 =)

überall kleiner Abstand. Man kann {Dn > c} interpretieren als Die

”

Stichprobe führt den Betrachter hinter das Licht.“. Dann ist also die

Wahrscheinlichkeit mit hinreichend großem n praktisch null.

Anschaulich: Praktisch sicher spiegelt die empirische

Verteilungsfunktion einer unendlichen Stichprobe die wahre

Verteilungsfunktion wider.

Falls die Stichprobe groß genug ist, so wird letztendlich immer

representativ für die Grundgesamtheit, d.h. man kann

Verteilungsgesetzmäßigkeiten durch Beobachtungen erlernen

(grundlegend für die Statistik) ! Hauptsatz “.

”

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

198 / 210

4

Statistik 2

−4

−2

0

sort(x)

2

Sommersemester 2017

4

−4

−4−2

sort(x)

−20

02

24

sort(x)

4

−3

Helmut Küchenho↵ (Institut für Statistik, LMU)

0.2

0.4

0.6

0.8

1.0

4 2

function(x) pnorm(x, 0, 1) (x)

1.0

2 0

0.8

0 −2

0.6

sort(x)

0.4

1.0

−2−4

0.2

0.8

−4

0.0

0.6

function(x) pnorm(x, 0, 1) (x)

0.4

1.0

4

0.0

0.2

0.8

42

0.6

1.0

20

sort(x)

(1:lx)/lx

0.8

−2

0

sort(x)

0.4

(1:lx)/lx

0.6

(1:lx)/lx

0.4

−4

−2

0.0

0.2

0.2

−4

0.0

0.0

0.0

0.0

0.0

0.0

0.0

0.2

0.2

0.2

0.2

0.2

0.6

0.6

0.6

(1:lx)/lx

0.4

(1:lx)/lx

0.6

(1:lx)/lx

0.4

0.4

(1:lx)/lx

0.4

(1:lx)/lx

0.6

(1:lx)/lx

0.4

0.8

0.8

0.8

0.8

0.8

1.0

1.0

1.0

1.0

1.0

Beispiele

sort(x)

4 −4

−2

sort(x)

−2

−3 −1

0

−2 0

x

2

−1 1

0

4

Normal CDF

Normal CDF

x

2

1 3

2

3

199 / 210

Der zentrale Grenzwertsatz I

Gibt es für große Stichprobenumfänge Regelmäßigkeiten im

Verteilungstyp?

Gibt es eine Standardverteilung, mit der man oft bei großen

empirischen Untersuchungen rechnen kann?

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

200 / 210

Der zentrale Grenzwertsatz II

Seien X1 , . . . , Xn i.i.d. mit E(Xi ) = µ und Var(Xi ) =

n ✓

1 X Xi

p

Zn =

n i=1

µ

◆

2

> 0 sowie

.

Dann gilt: Zn ist asymptotisch standardnormalverteilt, in Zeichen:

a

Zn ⇠ N(0; 1), d.h. es gilt für jedes z

lim P(Zn z) =

n!1

(z).

Für die Eingangsfragen gilt also:

Ja, wenn man die Variablen geeignet mittelt und standardisiert, dann

kann man bei großem n näherungsweise mit der Normalverteilung

rechnen. Dabei ist für festes n die Approximation umso besser, je

symmetrischer“ die ursprüngliche Verteilung ist.

”

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

201 / 210

Standardisieren

Die Funktion kommt durch Standardisieren und durch geeignetes mitteln

zustande.

p

Dabei ist es wichtig, durch n (und nicht durch n) zu teilen.

P

P

Xi

! verliert sich; Var( Xi ) ! 1

P

P

1

xi

! Var n1

Xi ! 0

n

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

202 / 210

Beispiele

Histogram of res

Histogram of res

1

0

2

3

1

2

0.4

Density

0.2

Density

0.1

0

2

2

4

−4

4

−2

res

Sommersemester 2017

4

0.4

0.4

0.3

Density

0.2

0.1

0.1

0.0

−4

−2

−2

0

res

0

2

2

4

Histogram of res

Histogram of res

0.0

−4

0

res

0.3

0.4

0.2

Density

0.1

0.0

2

res

Statistik 2

Density

0.3

0.4

0.3

0.2

Density

0.1

0

0

−2

Histogram of res

Histogram of res

0.0

−2

−2

−4

res

Histogram of res

−4

0.3

0.4

0.3

0.1

0.0

−4

3

res

0.4

−1

0.3

0

42

4

0.2

−2

res

Density

−1

0.1

−3

0.0

−2

0.0

0.2

0.3

−4

0.2

−3

Density

Density

0.1

0.0

0.1

0.0

0.0

−4

Histogram of res

0.2

0.3

0.2

0.2

Density

0.1

Density

0.3

0.4

Histogram of res

Histogram of res

−4

res

Helmut Küchenho↵ (Institut für Statistik, LMU)

−2 −4

0 −2

res

2

0

4

2

6

4

6

res

203 / 210

Anwendung des zentralen Grenzwertsatz auf X̄ I

Gemäß dem Gesetz der großen Zahlen weiß man: X̄n ! µ

Für die Praxis ist es aber zudem wichtig, die konkreten Abweichungen bei

großem aber endlichem n zu quantifizieren, etwa zur Beantwortung

folgender Fragen:

Gegeben eine Fehlermarge " und Stichprobenumfang n: Wie groß ist

die Wahrscheinlichkeit, dass X̄ höchstens um " von µ abweicht?

Gegeben eine Fehlermarge " und eine

Sicherheitswahrscheinlichkeit“ : Wie groß muss man n mindestens

”

wählen, damit mit mindestens Wahrscheinlichkeit das

Stichprobenmittel höchstens um " von µ abweicht

(Stichprobenplanung)?

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

204 / 210

Anwendung des zentralen Grenzwertsatz auf X̄ II

Aus dem zentralen Grenzwertsatz folgt:

n ✓

1 X Xi

p

n i=1

oder auch

2

µ

◆

=

Pn

=

nX̄n nµ

X̄n µ a

p

p ⇠ N(0, 1)

=

n·

/ n

i=1

p

Xi

n·

✓

a

X̄n ⇠ N µ,

2

n

nµ

◆

.

wird mit wachsendem n immer kleiner

n

* Schwankung im richtigen Wert (µ)

* Ausschläge werden kleiner

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

205 / 210

Warten auf den Bus

Bestimme Wartezeit, Durchschnittliche Wartezeit in 1 Woche, 1 Monat,

1 Jahr

150

count

count

150

100

100

50

50

0

0

0.0

2.5

5.0

7.5

10.0

0.0

2.5

einmal

5.0

7.5

10.0

7.5

10.0

eine Woche

150

200

count

count

100

100

50

0

0

0.0

2.5

5.0

einen Monat

Statistik 2

Sommersemester 2017

7.5

10.0

0.0

2.5

5.0

ein Jahr

Helmut Küchenho↵ (Institut für Statistik, LMU)

206 / 210

1 Jahr

count

200

100

0

4.50

4.75

5.00

5.25

5.50

ein Jahr

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

207 / 210

Approximation der Binomialverteilung I

Sei X ⇠ B(n, ⇡). Kann man die Verteilung von X approximieren?

Hier hat man zunächst nur ein X . Der zentrale Grenzwertsatz gilt aber

für eine Summe vieler Glieder.

Idee: Schreibe X als Summe von binären Zufallsvariablen.

X ist die Anzahl der Tre↵er in einer i.i.d. Folge Y1 , . . . , Yn von

Einzelversuchen, wobei

(

1 Tre↵er

Yi =

0 kein Tre↵er

Derselbe Trick wurde bei der Berechnung von Erwartungswerten

angewendet.

Die Yi sind i.i.d. Zufallsvariablen mit Yi ⇠ Bin(1, ⇡) und es gilt

X =

n

X

i=1

Statistik 2

Sommersemester 2017

Yi ,

E(Yi ) = ⇡,

Var(Yi ) = ⇡ · (1

Helmut Küchenho↵ (Institut für Statistik, LMU)

⇡).

208 / 210

Approximation der Binomialverteilung II

Damit lässt sich der zentrale Grenzwertsatz anwenden:

!

P

n

1 X

Yi ⇡

1

Yi n · ⇡

p

p

= p p

n i=1

n

⇡(1 ⇡)

⇡(1 ⇡)

P

Yi n · ⇡ a

= p

⇠ N(0, 1)

n · ⇡(1 ⇡)

und damit

X E(X ) a

p

⇠ N(0, 1)

Var(X )

so dass

P(X x) ⇡

falls n groß genug.

Statistik 2

Sommersemester 2017

x

n·⇡

p

n · ⇡(1

⇡)

!

Helmut Küchenho↵ (Institut für Statistik, LMU)

209 / 210

Faustregeln

Es gibt verschiedene Faustregeln, ab wann diese Approximation gut ist,

z.B.

n·⇡

5 und n · (1

n · ⇡(1

⇡)

5

⇡)

9

Wichtig: Ob die Approximation hinreichend genau ist, hängt

insbesondere vom substanzwissenschaftlichen Kontext ab.

Statistik 2

Sommersemester 2017

Helmut Küchenho↵ (Institut für Statistik, LMU)

210 / 210