4 Sprachanalyse

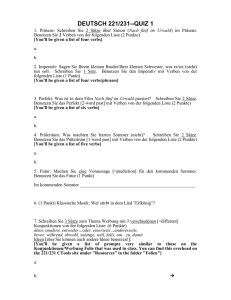

Werbung

4 Sprachanalyse

9. Vorlesung: Syntaktisches Parsen

Semantische Interpretation

hier nur am Beispiel kontextfreier Grammatiken

Problem:

Gegeben ein Satz als Folge von Wörtern.

Finde den zugehörigen Syntaxbaum.

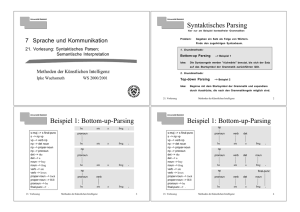

1. Grundmethode:

Bottom-up Parsing

Idee:

--> Beispiel 1

Die Syntaxregeln werden "rückwärts" benutzt, bis sich der Satz

auf das Startsymbol der Grammatik zurückführen läßt.

2. Grundmethode:

Top-down Parsing

Idee:

--> Beispiel 2

Beginne mit dem Startsymbol der Grammatik und expandiere

durch Ausdrücke, die nach den Grammatikregeln möglich sind.

!

"

he

s-maj –> s final-punc

s –> np vp

vp –> verb np

np –> det noun

np –> proper-noun

np –> pronoun

det –> the

det –> a

noun –> boy

noun –> frog

verb –> ate

verb –> loves

proper-noun –> Jack

proper-noun –> Bill

pronoun –> he

final-punc –> .

he

frog

.

ate

a

frog

.

ate

a

frog

.

a

frog

.

np

pronoun

he

np

pronoun

verb

he

a

pronoun

ate

ate

!

#

np

s-maj –> s final-punc

s –> np vp

vp –> verb np

np –> det noun

np –> proper-noun

np –> pronoun

det –> the

det –> a

noun –> boy

noun –> frog

verb –> ate

verb –> loves

proper-noun –> Jack

proper-noun –> Bill

pronoun –> he

final-punc –> .

pronoun

verb

det

ate

a

frog

verb

det

noun

ate

a

frog

he

.

np

pronoun

he

np

final-punc

pronoun

verb

det

noun

ate

a

frog

he

.

!

.

$

s

final-punc

np

pronoun

he

noun

a

frog

ate

he

det

noun

a

frog

a

frog

s

noun

final-punc

np

.

vp

pronoun

.

s-maj

np

verb

he

det

ate

np

verb

he

.

np

verb

final-punc

vp

pronoun

vp

pronoun

det

ate

np

np

np

verb

final-punc

det

noun

a

frog

ate

!

.

%

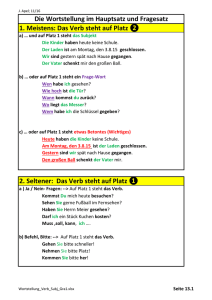

• Die Ersetzungsregeln sind zu interpretieren als

"<linke Seite> kann ersetzt werden durch <rechte Seite>".

• Wenn mehrere Regeln anwendbar sind, kann ein begonnener

Syntaxbaum u.U. nicht konsistent weitergebaut werden.

np

noun –> can

modal –> can

That can made him sick.

That can make him sick.

np

Einziger Weg:

• Solange durchprobieren, bis eine Kombination von Regelanwendungen gefunden wird, die einen vollständigen Syntaxbaum liefert.

• Bei mehreren voneinander unabhängigen Ambiguitäten:

exponentiell viele Möglichkeiten!

!

&

hier nur am Beispiel kontextfreier Grammatiken

Problem:

Gegeben ein Satz als Folge von Wörtern.

Finde den zugehörigen Syntaxbaum.

1. Grundmethode:

Bottom-up Parsing

Idee:

--> Beispiel 1

Die Syntaxregeln werden "rückwärts" benutzt, bis sich der Satz

auf das Startsymbol der Grammatik zurückführen läßt.

2. Grundmethode:

Top-down Parsing

Idee:

--> Beispiel 2

Beginne mit dem Startsymbol der Grammatik und expandiere

durch Ausdrücke, die nach den Grammatikregeln möglich sind.

!

'

s-maj –> s final-punc

s –> np vp

vp –> verb np

np –> det noun

np –> proper-noun

np –> pronoun

det –> the

det –> a

noun –> boy

noun –> frog

verb –> ate

verb –> loves

proper-noun –> Jack

proper-noun –> Bill

pronoun –> he

final-punc –> .

Beginne mit dem Startsymbol der Grammatik und expandiere

durch Ausdrücke, die nach den Grammatikregeln möglich sind,

bis der Satz dasteht.

s-maj

s

final-punc

np

vp

pronoun

verb

he

ate

!

np

det

noun

a

frog

.

(

(s-maj (s (np (pronoun he))

(vp (verb ate)

(np (det a) (noun frog))))

(final-punc . ))

s-maj

s

final-punc

np

vp

pronoun

verb

he

ate

np

det

noun

a

frog

.

!

• Für bestimmte Sätze ist "top-down" besser als "bottom-up", für

andere schlechter – keine Methode ist grundsätzlich überlegen.

Did

you hit Bill?

Hilfsverb

• Striktes top-down parsing beginnt mit s –> np vp und würde (hier

ohne Ergebnis) erst alle Möglichkeiten suchen, np zu expandieren.

• In vielen Fällen werden top-down Parser vorgezogen (einfacher zu

realisieren).

• Sehr bekannte top-down Parser sind die sogenannten ATN-Parser.

(Augmented Transition Networks)

!

)

*

Bisher:

Natürlichsprachlicher Satz

Jetzt:

Syntaxbaum

->

->

Syntaxbaum

interne Repräsentation

semantische Interpretation

> vereinfachte Betrachtung

> Hauptzweck: Motivation

Zwei Teilaufgaben:

• Disambiguierung von Wortsinn und Referenz

• Konvertierung disambiguierter Syntaxrepräsentation in

logische Form (in der gewählten internen Repräsentationssprache)

!

)

)

Verstehen der syntaktischen Struktur natürlicher Sprache ist

ein Schritt in Richtung zur internen Repräsentation

+

Tiefenstruktur (deep structure): – alte Theorie –

+

verschiedene Anteile sprachlicher Konstruktionen sind aufgelöst

(mit Hilfe von Transformationsregeln), z.B.

passive Konstruktionen

Bezüge von Reflexivpronomen (Ich wusch mich.)

Wichtig: Die ursprüngliche Bedeutung des Satzes ändert sich nicht.

,

,

,

,

Tiefenstruktur ist nicht = interne Repräsentation:

+

enthält noch Wörter der natürlichen Sprache, während die interne

Repräsentation Ausdrücke einer Repräsentationssprache enthält.

,

!

)

"

gegeben durch definite Nominalphrasen (definite noun phrases)

-

.

/

0

1

2

Beschreibung der Szene durch Fakten

(in assertional notation)

3

@

>

A

B

5

5

@

-

.

/

0

1

2

7

.

.

/

A

B

7

2

3

5

>

8

.

6

.

/

0

1

2

.

7

C

6

3

-

.

/

0

1

C

5

9

4

@

0

/

.

/

-

.

/

0

1

2

3

7

C

?

<

6

:

;

=

>

<

?

<

@

/

B

:

>

.

7

2

A

B

-

-

.

.

/

0

1

2

1

2

3

-

.

/

0

1

2

4

C

?

<

@

-

2

5

:

5

7

D

;

/

0

1

2

4

-

.

/

0

1

C

5

3

6

@

0

/

.

/

-

.

/

0

1

2

4

-

.

7

C

D

<

"the red block"

@

/

B

7

D

:

A

B

-

-

.

@

0

/

0

1

2

/

.

/

-

.

F

G

H

I

G

A

B

5

5

.

K

>

H

@

J

2

L

7

H

B

.

/

0

3

1

-

2

O

P

Q

O

F

M

R

S

F

J

R

T

I

P

3

.

7

0

U

-

.

/

W

V

X

Y

F

W

V

N

V

G

P

Q

G

H

S

Y

Y

5

6

-

.

7

2

3

C

/

0

1

2

;

=

>

-

.

7

2

3

C

?

<

E

7

.

.

/

9

C

/

7

5

:

<

2

-

-

.

?

/

0

1

2

E

;

Y

!

)

#

Aufbau der Repräsentation für "the red block" erfordert:

C

0

N

6

1

C

5

• Zuordnung von Bedeutungen zu den einzelnen Wörtern

(zu finden in einem Konzept-Lexikon):

kompositionellen Semantik.

@

Q

6

Prinzip der

A

N

5

-

>

M

6

@

K

5

;

D

:

4

C

6

@

B

0

E

5

<

• muß Bezug auf "Weltmodell" (hier: die faktische

Szenenbeschreibung) auslösen wie folgt:

/

;

:

• Erwartung: bezieht sich auf einen definiten Referenten

.

?

<

@

>

2

5

:

/

.

/

-

.

/

0

1

2

3

7

C

?

<

<

(Theorie über Verstehen der

@

/

B

7

D

2

5

:

:

-

-

.

/

0

1

2

3

-

.

/

0

1

2

4

C

?

<

;

Bedeutung von Sprache)

@

-

>

@

A

B

0

.

/

0

1

2

4

-

.

/

0

1

C

5

/

.

/

-

.

/

0

1

2

4

-

.

7

C

D

<

@

/

B

7

D

2

5

:

:

-

-

.

/

0

1

2

4

-

?

5

<

.

7

2

3

C

6

;

1. Syntaktische Analyse

@

>

A

B

.

/

0

1

2

E

6

;

/

.

/

-

.

/

0

1

2

E

=

7

<

@

>

D

.

.

/

9

7

2

5

:

-->

(inst ?x block)

the

-->

retrieve-val

• Kombination der einzelnen Wortbedeutungen, um Bedeutung der

Wortgruppen zu erhalten:

C

des Ganzen aus der

:

block

?

;

/

B

(color ?x red)

<

2. Ableitung der Bedeutung

0

-->

C

5

:

@

red

-

-

?

.

/

0

1

2

E

-

5

<

.

7

2

3

C

6

;

-->

red block

Bedeutung der Teile.

(and(inst ?x block)(color ?x red)

the red block -->

Es gibt andere Formen der

(retrieve-val '?x

'(and (inst ?x block)

(color ?x red)))

semantischen Interpretation.

• Anbindung dieser Prozesse an den syntaktischen Parser

!

)

$

q

r

s

t

u

v

w

s

x

y

x

z

s

u

{

u

|

u

{

}

(anderer Ansatz)

• Die interne Repräsentation wird

Einbezug der semantischen Interpretation bereits bei

zur gleichen Zeit aufgebaut wie

der Syntaxanalyse, um den Parser zu führen (unsinnige

die syntaktischen Beziehungen.

Analysen der Satzkonstituentenstruktur auszuschalten).

• Dazu werden in die (z.B. ATN-)

Grammatik Regeln einbezogen,

die parallel zur Syntaxanalyse

Ich las einen Artikel über den Vietnamkrieg in der Zeitung.

Fakten in einer Datenbasis

assertieren: interne Repräsentation.

Ich las einen Artikel über den Vietnamkrieg in der Zeitung.

Beispiel: Einführung von Referenten

für Nominalphrasen

[Hier nicht weiter betrachtet.]

Z

[

\

]

^

q

_

r

`

s

a

t

b

u

c

v

w

d

s

x

e

y

x

z

s

u

{

u

|

u

{

`

f

g

]

h

`

c

h

`

^

i

j

c

a

f

_

k

l

g

`

c

m

c

f

`

_

_

k

d

`

c

n

o

p

o

~

}

Phonologie

Syntax

Input

Blackboard

Weltwissen

Z

Semantik

[

\

]

^

_

`

a

b

c

d

e

`

f

g

]

h

`

c

h

`

^

i

j

c

a

f

_

k

l

g

`

c

m

c

f

`

_

_

k

d

`

c

n

q

r

s

t

u

v

w

s

x

y

x

z

s

u

{

u

|

u

{

}

Probleme bei der Verarbeitung von sprachlichen Eingaben:

Strukturelle Analyse der natürlichen Sprache

Syntaxproblem

Erfassen der Bedeutung unter Bezug auf ein Weltmodell

Semantikproblem

Ableitung einer Antwort (in symbolischer Repräsentation)

Inferenzproblem

Generierung einer Antwort in natürlicher Sprache

Generierungsproblem

Z

[

\

]

^

q

_

r

`

s

a

t

b

u

c

v

w

d

s

x

e

y

x

z

s

u

{

u

|

u

{

`

f

g

]

h

`

c

h

`

^

i

j

c

a

f

_

k

l

g

`

c

m

c

f

`

_

_

k

d

`

c

n

o

}

nach dem alten Code „ETAOIN SHRDLU“, mit dem Linotype-Setzer

Satzfehler in Zeitungsspalten markierten ...

ein Programm soll (englisch gestellte) Fragen über eine

simulierte Blockwelt verstehen

auf solche Fragen (auf englisch) eine Antwort geben

(auf englisch gegebene) Instruktionen verstehen, um die

Klötzchen zu verschieben

jede Instruktion in eine Reihenfolge von Operationen, die

das Programm ausführen kann, zerlegen

„verstehen“, was getan wurde und warum

ausgeführte Handlungen und Gründe dafür beschreiben

Z

[

\

]

^

_

`

a

b

c

d

e

`

f

g

]

h

`

c

h

`

^

i

j

c

a

f

_

k

l

g

`

c

m

c

f

`

_

_

k

d

`

c

n

o

q

r

s

t

u

v

w

s

x

y

x

z

s

u

{

u

|

u

{

}

Terry Winograd

Z

[

\

]

^

q

_

s

a

t

b

u

c

v

w

d

s

x

e

y

x

z

s

u

{

u

|

u

{

`

f

g

]

h

`

c

h

`

^

i

j

c

a

f

_

k

l

g

`

c

m

c

f

`

_

_

k

d

`

c

n

o

}

Z

Charniak & McDermott, Kapitel 4, Seite 194-199 ff

über SHRDLU z.B. bei Hofstadter: „Gödel, Escher, Bach“

Stuttgart: Klett-Cotta, 1985 (S. 624-631)

Z

r

`

[

\

]

^

_

`

a

b

c

d

e

`

f

g

]

h

`

c

h

`

^

i

j

c

a

f

_

k

l

g

`

c

m

c

f

`

_

_

k

d

`

c

n

q

r

s

t

u

v

w

s

x

y

x

z

s

u

{

u

|

u

{

}

Videointermezzo

10. Vorlesung: KI – zu schwer für Computer?

q

r

s

t

u

v

w

s

x

y

x

z

s

u

{

u

|

u

aus der

Videosammlung

(zum Vorlesungstermin

16.11.99)

o

[

\

]

^

_

`

a

b

c

d

{

}

Eine Maschine verändert die Welt

53:00 min

Teil 4: Künstliche Intelligenz - zu schwer

für Computer? (1991)

NDR, 1991

Start kurz nach Filmanfang!

0001 KI-Historie (MIT: Minsky, McCarthy, INTEGRAL,

0126 Was ist Denken? Menschliche vs. künstliche Intelligenz

0257 Prof. Hubert Dreyfus

0312 Probleme der Klötzchen-Welt

0393 Univ. Edinburgh: Freddy (Erkennen von Gegenständen)

0444 Univ. Stanford: Sehen und Fortbewegung

0480 Turing-Test

0523 ELIZA

0634 Doug Lenat: Probleme des Sprachverstehens

0679 Erste MÜ-Anwendung Englisch-Russisch

(Illusion und Wirklichkeit - Problem Weltwissen und Kontext)

0827 Ernüchterung in der KI

0861 SHRDLU

0912 Edward Feigenbaum: Expertensysteme (u.a. DENDRAL)

1006 Hubert Dreyfus: Vorteile und Grenzen von XPS (Beispiele)

1039 Doug Lenat: dto.

1059 Vergleich mit einem "Idiot savoir"? (etwas makaber)

1120 Vorlage eher: Kinder (bereits diffuses Wissen)

1193 Frames (Child´s Birthday Party)

1211 Allgemeines Hintergrundwissen

1322 CYC

1402 Kritik an CYC (Dreyfus): Wissen ist an (sinnliche) Erfahrungen gebunden

1494 Neuronale Netze

1543 Perceptron

1610 netzgesteuertes Fahrzeug

1663 Dreyfus: Grenzen und Probleme von Neuronalen Netzen

1705 NETTALK (Aussprechen geschriebener Sprache)

(...)

Fortsetzung...

1785 Schlußpassage: Zusammenfassung, bisherige KI-Leistungen und Fazit

1852 Epilog - Noch mal: CYC

2021 Ende

e

`

f

g

]

h

`

c

h

`

^

i

j

c

a

f

_

k

l

g

`

c

m

c

f

`

_

_

k

d

`

c

n