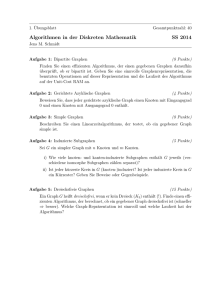

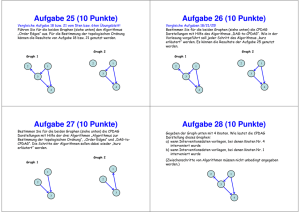

Algorithmen und Datenstrukturen

Werbung