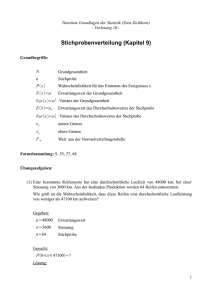

Statistik und Wahrscheinlichkeitstheorie

Werbung