4.4. Rang und Inversion einer Matrix

Werbung

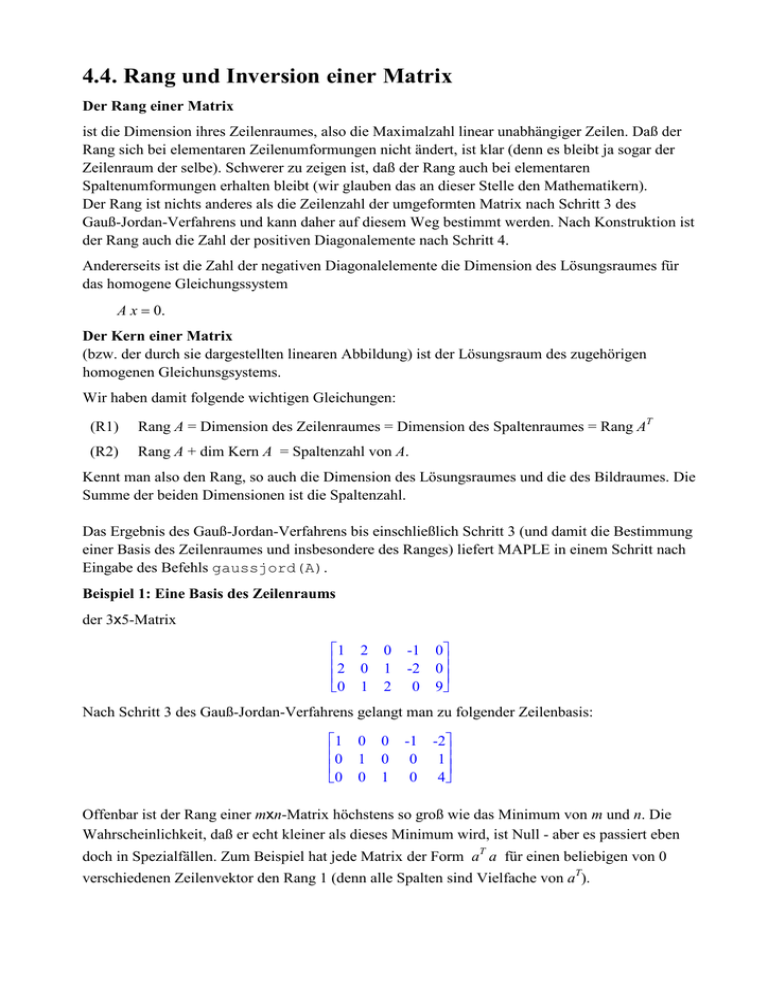

4.4. Rang und Inversion einer Matrix Der Rang einer Matrix ist die Dimension ihres Zeilenraumes, also die Maximalzahl linear unabhängiger Zeilen. Daß der Rang sich bei elementaren Zeilenumformungen nicht ändert, ist klar (denn es bleibt ja sogar der Zeilenraum der selbe). Schwerer zu zeigen ist, daß der Rang auch bei elementaren Spaltenumformungen erhalten bleibt (wir glauben das an dieser Stelle den Mathematikern). Der Rang ist nichts anderes als die Zeilenzahl der umgeformten Matrix nach Schritt 3 des Gauß-Jordan-Verfahrens und kann daher auf diesem Weg bestimmt werden. Nach Konstruktion ist der Rang auch die Zahl der positiven Diagonalemente nach Schritt 4. Andererseits ist die Zahl der negativen Diagonalelemente die Dimension des Lösungsraumes für das homogene Gleichungssystem A x = 0. Der Kern einer Matrix (bzw. der durch sie dargestellten linearen Abbildung) ist der Lösungsraum des zugehörigen homogenen Gleichunsgsystems. Wir haben damit folgende wichtigen Gleichungen: (R1) Rang A = Dimension des Zeilenraumes = Dimension des Spaltenraumes = Rang AT (R2) Rang A + dim Kern A = Spaltenzahl von A. Kennt man also den Rang, so auch die Dimension des Lösungsraumes und die des Bildraumes. Die Summe der beiden Dimensionen ist die Spaltenzahl. Das Ergebnis des Gauß-Jordan-Verfahrens bis einschließlich Schritt 3 (und damit die Bestimmung einer Basis des Zeilenraumes und insbesondere des Ranges) liefert MAPLE in einem Schritt nach Eingabe des Befehls gaussjord(A). Beispiel 1: Eine Basis des Zeilenraums der 3x5-Matrix 1 2 0 2 0 1 0 1 2 -1 -2 0 0 0 9 Nach Schritt 3 des Gauß-Jordan-Verfahrens gelangt man zu folgender Zeilenbasis: 1 0 0 0 1 0 0 0 1 -1 -2 0 1 0 4 Offenbar ist der Rang einer mxn-Matrix höchstens so groß wie das Minimum von m und n. Die Wahrscheinlichkeit, daß er echt kleiner als dieses Minimum wird, ist Null - aber es passiert eben doch in Spezialfällen. Zum Beispiel hat jede Matrix der Form aT a für einen beliebigen von 0 verschiedenen Zeilenvektor den Rang 1 (denn alle Spalten sind Vielfache von aT). Die Rang-Ungleichung Rang( AB ) ≤ min( Rang( A ), Rang( B ) ) gilt für beliebige Matrizen A und B, deren Produkt definiert ist. Der Test zufälliger Matrizen zeigt, dass die Rang-Ungleichung fast immer eine Gleichung ist! Beispiel 2: Rang von Produktmatrizen -85 A= -35 -11519 AB = 4838 79 -37 , B = 49 50 57 -55 97 -8675 -6042 , BA = -6370 1201 -2780 56 63 -59 1087 3416 -8858 -123 1337 -5059 Rang( A ) = 2, Rang( B ) = 2, Rang( AB ) = 2, Rang( BA ) = 2 Wenn für zwei Matrizen A und B sowohl das Produkt AB als auch BA definiert ist (wann ist das der Fall?), so braucht der Rang von AB dennoch nicht mit dem Rang von BA übereinzustimmen. Beispiel 3: Produkte mit verschiedenen Rängen 1 A = 1 0 0 0 1 0 0, 0 0 B = 1 1 0 0 1 0 1 1 0 AB = 0 1 0 0 0 0 0 0 , BA = 1 2 1 0 1 1 0 0 0 Rang( A ) = 2, Rang( B ) = 2, Rang( AB ) = 1, Rang( BA ) = 2 Ohne die Lösungen zu berechnen, testet man mit Hilfe des Ranges die Lösbarkeit eines linearen Gleichungssystems Das Gleichungssystem A x = b ist genau dann lösbar, wenn der Rang der geränderten Matrix (A,b) mit dem Rang von A übereinstimmt. Denn das bedeutet gerade, daß der Spaltenraum von A die gleiche Dimension wie der Spaltenraum von (A,b) hat, also mit diesem bereits zusammenfällt - und das passiert dann und nur dann, wenn b eine Linearkombination der Spalten von A , also in der Form A x = b darstellbar ist. Beispiel 4: Ein unlösbares Gleichungssystem 45 A = -93 43 -8 77 92, b = 66, Rang( A ) = 2, Rang( A, b ) = 3 -62 54 Ein Gleichungssystem mit einer 3x2-Matrix A ist nur sehr selten lösbar, weil A höchstens Rang 2 haben kann, die geränderte Matrix aber fast immer den Rang 3 hat! Invertierbare Matrizen Eine quadratische Matrix A heißt invertierbar, falls es eine Matrix B mit A B = B A = E gibt. Im nächsten Satz stellen wir eine ganze Reihe von Kriterien für die Invertierbarkeit einer Matrix zusammen. Invertierbarkeitskriterien Die folgenden Aussagen über eine Matrix A aus K (n x n) sind äquivalent: (a1) A ist invertierbar. (a2) Es gibt eine Matrix B mit A B = E. (a3) Es gibt eine Matrix C mit C A = E. (b1) Die durch A dargestellte lineare Abbildung ist bijektiv. (b2) Die durch A dargestellte lineare Abbildung ist surjektiv. (b3) Die durch A dargestellte lineare Abbildung ist injektiv. (c1) A x = b hat für jedes b aus Kn genau eine Lösung. (c2) A x = b hat für jedes b aus Kn mindestens eine Lösung. (c3) A x = b hat für jedes b aus Kn höchstens eine Lösung. (d1) Die Spalten von A bilden eine Basis des Kn. (d2) Die Spalten von A bilden ein Erzeugendensystem des Kn. (d3) Die Spalten von A sind linear unabhängig. (e1) A x = 0 hat nur die Lösung x = 0. (e2) A läßt sich durch elementare Zeilenumformungen in die Einheitsmatrix umformen. (e3) Rang A = n. In jeder dieser Aussagen kann man A durch AT ersetzen. Beweisschema: Die nachfolgenden Implikationen sind sämtlich ohne Mühe nachzuprüfen. (a2) ---> (b2) ---> (c2) ---> (d2) ---> (e2) / / / / / (a1) ---> (b1) ---> (c1) ---> (d1) ---> (e1) \ \ \ \ \ (a3) ---> (b3) ---> (c3) ---> (d3) ---> (e3) Auch von (e2) bzw. (e3) zurück nach (a2) kommt man relativ leicht. Etwas trickreich ist der Schritt von (a2) nach (a1). Daß eine linksinverse Matrix mit einer rechtsinversen übereinstimmen muß, sieht man so: A B = E = C A ==> B = E B = C A B = C E = C . Aufgrund des obigen Satzes gibt es zu einer invertierbaren Matrix A genau eine Matrix , deren Multiplikation mit A (von links oder rechts) die Einheitsmatrix ergibt. Man nennt diese Matrix die Inverse von A und bezeichnet sie mit ( −1 ) A . Sind A und B invertierbare nxn-Matrizen, so auch AB, und es gilt ( −1 ) (A B) =B ( −1 ) ( −1 ) A . Denn aufgrund des Assoziativgesetzes haben wir ( −1 ) ABB A ( −1 ) =AEA ( −1 ) =AA ( −1 ) = E. Beispiel 5: Diagonalmatrizen Jede Diagonalmatrix mit von Null verschiedenen Diagonalelementen ist invertierbar, und die Inverse ist wieder eine Diagonalmatrix: Ist A von der Form a1 0 0 und gilt aj bj = 1, so hat B = A ( −1 ) 0 a2 0 0 0 a3 0 b2 0 0 0 b3 die Gestalt b1 0 0 Orthogonale Matrizen sind dadurch charakterisiert, daß ihre Spalten (oder Zeilen) eine Orthonormalbasis bilden. Jede orthogonale Matrix A ist wegen AT A = E = A AT invertierbar, und die Inverse ist die Transponierte. Die orthogonalen 3x3-Matrizen bzw. die durch sie dargestellten linearen Abbildungen werden vollständig durch den Hauptsatz am Ende von Kapitel 3.3 charakterisiert: Drehmatrizen und Spiegelmatrizen Eine orthogonale 3x3-Matrix A beschreibt genau dann eine Drehung oder Spiegelung, wenn es einen Einheitsvektor u gibt mit A u = u. Ist A dabei symmetrisch, so handelt es sich um eine Spiegelung, und u liegt in der Spiegelebene. Ansonsten handelt es sich um eine Drehung, und u erzeugt die Drehachse. Alle anderen orthogonalen Matrizen beschreiben Drehspiegelungen, sind also Produkte von Drehund Spiegelmatrizen. Spur und Drehwinkel Die Spur einer quadratischen Matrix ist die Summe ihrer Diagonalelemente: n Spur( A ) = ∑a j, j . j=1 Bei einer Drehmatrix A berechnet sich der Cosinus des Drehwinkels φ nach der Formel Spur( A ) = 1 + 2 cos( φ ). Denn wie wir früher gesehen haben, gilt mit s = sin( φ ) und c = cos( φ ): c + (1 − c) u 2 1 A = ( 1 − c ) u1 u2 + u3 s ( 1 − c ) u u − u s 1 3 2 ( 1 − c ) u1 u3 + u2 s ( 1 − c ) u2 u3 − u1 s 2 c + ( 1 − c ) u3 ( 1 − c ) u1 u2 − u3 s c + ( 1 − c ) u2 2 ( 1 − c ) u2 u3 + u1 s 2 2 2 also Spur( A ) = 3 c + ( 1 − c ) ( u1 + u2 + u3 ) = 1 + 2 c. Beispiel 6: Achse und Drehwinkel einer Drehmatrix Die folgende Matrix ist orthogonal: A := 2 1 3 -2 3 2 3 1 3 2 3 3 -2 3 -1 3 2 3 Probe: 1 A A = 0 0 T 0 1 0 0 0 1 Die Transponierte ist also die Inverse: AT = Für den Einheitsvektor u = ( −1, 1, 1 )T/ 3 2 -2 3 1 3 2 3 -2 3 -1 3 3 1 3 2 3 2 3 ergibt sich A u = u. (Wenn man diesen "Eigenvektor" nicht errät, kann man ihn durch Lösen des Gleichungssystems A u = u finden; davon später mehr). Da A nicht symmetrisch ist, muß es eine Drehmatrix sein. In der Tat beschreibt A eine Drehung um die Achse R u und einen Winkel von 600 bzw. π/3. Denn die Spurformel liefert 1 cos( φ ) = . 2 Spiegelmatrizen sind stets zu sich selbst invers. Das ist klar aufgrund der geometrischen Bedeutung von Spiegelungen (zweimal spiegeln ergibt die Ausgangsfigur). Folglich gilt für jede Spiegelmatrix S: S=S ( −1 ) = ST. Beispiel 7: Vom Drehen zum Spiegeln In der Drehmatrix aus Beispiel 6 vertauscht man zweite und dritte Spalte und bekommt eine Spiegelung: S := 2 -2 3 -2 3 -1 3 1 3 2 3 3 1 3 2 3 2 3 Berechnung der Inversen Die Inverse einer Matrix A kann man mit Hilfe des Gauß-Jordan-Algorithmus bestimmen (aber in der Praxis geht das nur für kleine Matrizen): Man wendet elementare Zeilenumformungen simultan auf A und E an. Am Ende hat man A in E umgeformt, und dann ist aus E die Inverse zu A geworden. Das liegt daran, daß jede elementare Zeilenumformung durch Multiplikation mit einer invertierbaren Matrix von links bewirkt wird. Das Produkt all dieser Matrizen sei B. Dann ist B A = E, also ( −1 ) B=A . Es passiert relativ selten, dass die Inverse einer ganzzahligen Matrix wieder ganzzahlig ist. Beispiel 9: Eine ganzzahlige Matrix mit ganzzahliger Inverser 1 3 0 2 1 2 1 1 0, 0 1 0 0 1 0 0 0 1 Subtraktion der dreifachen ersten Zeile von der zweiten Zeile: 1 0 0 1 1 -3, -3 1 0 2 -5 2 0 1 0 0 0 1 0 1 0 0 3 1 0 1 0 -1 3 1 Addition der dreifachen dritten Zeile zur zweiten Zeile: 1 0 0 1 1 0, -3 1 0 2 1 2 Subtraktion der dritten Zeile von der ersten Zeile: 1 0 0 0 1 0, -3 1 0 0 1 2 Subtraktion der zweifachen zweiten Zeile von der dritten Zeile: 1 0 0 0 1 0 0 1 0, -3 1 6 0 1 -2 -1 3 -5 Die rechts unten stehende Matrix ist also die Inverse von A. Invertiert man sie nochmals, kommt natürlich die ursprüngliche Matrix A heraus. Probe: 1 -3 6 0 1 -2 -1 1 3 3 -5 0 2 1 2 1 1 0 = 0 1 0 0 1 0 0 0 1 Transponieren und Invertieren Die Transponierte einer invertierbaren Matrix A ist wieder invertierbar, und die Inverse von AT ist ( −1 ) die Transponierte von A . Potenzen von Matrizen Man kann nun beliebige ganzzahlige Potenzen einer invertierbaren Matrix definieren. Für positive Exponenten k und jede quadratische Matrix A ist Ak natürlich das k-fache Produkt von A mit sich selbst, und für negative Exponenten setzt man ( −k ) ( −1 ) k ( −1 ) A := ( A ) = ( Ak ) , sofern A invertiebar ist. Es gelten dann die üblichen Potenzregeln, wie z.B. A (k + l) l = Ak Al und (k l) ( Ak ) = A . Beispiel 10: Potenzen einer Drehmatrix cos( φ ) −sin( φ ) A= sin( φ ) cos( φ ) beschreibt die ebene Drehung um den Winkel φ, also cos( k φ ) −sin( k φ ) Ak = sin( k φ ) cos( k φ ) die Drehung um den k-fachen Winkel. Speziell ist beispielsweise cos( φ )2 − sin( φ )2 cos( 2 φ ) −sin( 2 φ ) = A A = A2 = sin( 2 φ ) cos( 2 φ ) 2 cos( φ ) sin( φ ) −2 cos( φ ) sin( φ ) , cos( φ )2 − sin( φ )2 woraus man sofort die Additonstheoreme für den doppelten Winkel ablesen kann. Beispiel 11: Potenzen einer Bandmatrix bei der in der Hauptdiagonalen und in der ersten Diagonalen darüber Einsen stehen. 1 0 B = 0 0 0 1 1 0 0 0 0 1 1 0 0 0 0 1 1 0 0 1 0 0 2 0, B = 0 0 1 1 0 2 1 0 0 0 1 2 1 0 0 0 1 2 1 0 0 1 0 0 3 1, B = 0 0 2 1 0 1 4 6 4 1 1 5 0 1 4 6 4 0 1 5 4 B = 0 0 1 4 6 , B = 0 0 0 0 0 1 4 0 0 0 0 0 0 1 0 0 In den Zeilen wie in den Spalten dieser Matrizen stehen die Binomialkoeffizienten n! B( n, k ) = . k! ( n − k )! 10 5 1 0 0 10 10 5 1 0 3 1 0 0 0 3 3 1 0 0 1 3 3 1 0 0 1 3 3 1 5 10 10 5 1 Sie ergeben sich bei der Entwicklung des Polynoms n (1 + x) = n ∑ B( n, k ) x . k k=0 Pascalsches Dreieck Jede Zahl in diesem Dreieck außer den Einsen ist die Summe der zwei darüber stehenden Zahlen. 1 1 1 1 2 1 1 3 3 1 1 4 6 4 1 1 5 10 10 5 1