Die Fakten, Mythen und Wahrheiten hinter Big

Werbung

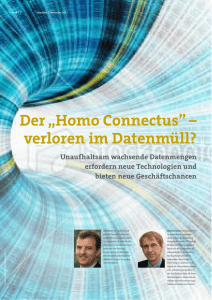

Die Fakten, Mythen und Wahrheiten hinter Big Data Ein Überblick aus Expertensicht Management Summary Alles ist mit allem verknüpft, alles hängt voneinander ab. Angesichts der riesigen Datenmengen wird es immer schwerer, den Überblick zu behalten. Und die digitale Flut steigt weiter. Mit der richtigen Technologie jedoch können Organisationen diese überbordende Datenfülle – auch Big Data genannt – in große Chancen verwandeln. Aber was ist Big Data eigentlich? Und wie steht es mit allem anderen, was irgendwie mit Big Data zu tun hat? Was verbirgt sich hinter In-Memory-Technologie, SAP HANA® oder Hadoop? Vor allem aber: Welchen Einfluss hat Big Data heute und künftig auf Unternehmen und deren Geschäft? Ziel dieses White Papers ist es, die aktuelle Entwicklung zu beleuchten. Neben den persönlichen Perspektiven unserer Fachleute spiegelt es Trends wider, liefert Fakten und wichtige Definitionen, entschleiert weitverbreitete Mythen und räumt mit Fehlinformationen auf. Über die Autoren Klaus-Christoph Müller Klaus­- Christoph Müller ist Director Global Business Solutions bei itelligence in Berlin. Der Schwerpunkt seiner Arbeit liegt auf der Entwicklung von Branchenlösungen. Er verfügt über langjährige Erfahrung im Business Development, in der Strategieberatung, in der Lösungsentwicklung und im Presales. Seine Karriere begann Klaus­-Christoph Müller in der Automobilindustrie, wo er bei Volkswagen und DaimlerChrysler Financial Services (jetzt Daimler AG) verschiedene Fach-­und Managementpositionen innehatte. Der Autor verfügt über Wissen und Erfahrung aus zahlreichen erfolgreichen Projekten mit innovativen Prozesslösungen. Kontakt: [email protected] Christian Schmidt Christian Schmidt ist Global Director Business Analytics für itelligence in München. Seine Arbeit konzentriert sich auf Technologien zur Geschäftsanalyse, einschließlich SAP® BusinessObjects™, SAP NetWeaver® Business Warehouse und In-Memory-Technologie von SAP (SAP HANA) . Er sammelte ausgiebige Industrieerfahrung in verschiedenen Positionen als Experte und im Management bei der Deloitte GmbH, bei der Infineon Technologies AG und der Mead Corporation (jetzt MeadWestvaco). Zurzeit arbeitet Christian Schmidt mit Kunden zusammen und implementiert SAP HANA. Er ist außerdem ein angesehener Referent, der bei wichtigen Branchenveranstaltungen in ganz Europa spricht. Kontakt: [email protected] 2 Inhaltsverzeichnis Seite Management Summary 2 Über die Autoren 2 Die aktuellen Herausforderungen 4 Geschäftliche Herausforderungen 4 IT-Herausforderungen 4 Was ist Big Data? 5 Mythos 1: „Big Data ist etwas Neues“ 7 Praxisbeispiele für Big Data 8 Mythos 2: „Big Data ist eine Einzeltechnologie“ 9 Was ist In-Memory-Technologie? Mythos 3: „In-Memory ist nur ein Hype von SAP“ Was ist Hadoop? 9 11 12 Mythos 4: „Hadoop ist eine Alternative zu In-Memory-Technologie“ 13 Wie Big Data die Business-IT der Zukunft beeinflusst 14 Predictive Analytics – weil die Zeit dafür reif ist! 16 Mythos 5: „In-Memory-Computing ist das Ende von Data Warehousing“ 18 Empfehlungen für Big-Data-Strategien 19 Predictive Analytics wird zum großen Vorteil 19 SAP HANA hat sich als Plattform bewährt 20 Der Business Case weist den Weg 21 3 Die aktuellen Herausforderungen Geschäftliche Herausforderungen Zwei Jahrzehnte im Zeichen einer enormen Internationalisierung gingen für Unternehmen fast aller Branchen mit einem bislang ungeahnten Ausmaß an Veränderungen einher. Das stellt große Konzerne und mittelständische Unternehmen gleichermaßen vor vielfältige Herausforderungen – eröffnet ihnen aber zugleich auch große Chancen: Sie können nun Märkte erschließen, von denen sie zuvor kaum zu träumen wagten. Andererseits verlangen der intensivierte Wettbewerb und die höhere Marktdynamik nach: ■■ kürzeren Reaktionszeiten, ■■ beschleunigten Innovationszyklen, ■■ besonders flexiblen und anpassungsfähigen Geschäftsprozessen. »Veränderung ist der Prozess, mit dem Im gleichen Ausmaß wie der globale Wettbewerb und die Zukunft unser Leben durchdringt. « ein sich wandelndes Konsumverhalten das Tempo Alvin Toffler vorgeben, verbreiten und vervielfältigen sich relevante Daten explosionsartig: Das Internet, soziale Medien und Mobilgeräte sprengen alle räumlichen und zeitlichen Grenzen. Daten im Allgemeinen sowie die geschäftsrelevanten Daten im Besonderen wachsen exponentiell. Das Pro-Kopf-Volumen an technologischer Speicher­k apazität hat sich seit den 1980er Jahren alle 40 Monate nahezu verdoppelt. 2012 wurden beispielsweise 2,5 Exabyte an neuen Daten erstellt – und das an jedem einzelnen Tag des Jahres. IT-Herausforderungen Die neue geschäftliche Realität unserer Welt ist für die IT-Systeme und -Abteilungen in den Unternehmen eine besondere Herausforderung. Wo es früher relativ stabile Geschäftsumgebungen gab, herrscht heute ein Klima ständiger Veränderung. Übernahmen und Zusammenschlüsse, Umstrukturierungen, Ausgründungen oder neue Produkte verlangen nach neuen Prozessen und manchmal auch Systemen. Damit die IT mit dieser variablen Geschäftsumgebung Schritt halten kann, muss sie viel schneller und deutlich flexibler ­ werden. Ein möglicher Weg zu mehr Agilität führt über die Abkehr von klassischen Was­ser­fallmodellen. Gleichzeitig haben der sogenannte Consumerism, also die veränderte Erwartungshaltung an die Bedienerfreundlichkeit, und das veränderte Nutzungsverhalten im Zuge der rasanten Entwicklung bei Smartphones enorm an Bedeutung gewonnen. Big Data ist neben mobilen Technologien, sozialen Medien und der Cloud nur einer von vier großen, ineinander greifenden Trends, denen sich IT-Abteilungen aktuell gegenüber sehen (siehe Abbildung 1). 4 Abbildung 1: Wie Innovationen die Business-IT beeinflussen Sozial weltweite Vernetzung, „Consumerism“ Cloud Business IT Mobil immer und überall zugänglich skalierbar, wartungsarm, kosteneffektiv Big Data rasch steigender Umfang, komplex, sehr veränderlich Vor dem Hintergrund dieser großen technologischen Fortschrittstreiber scheinen knappe Budgets so etwas wie die letzte Konstante in einer sich ständig wandelnden Welt zu sein. Aber es gibt auch gute Neuigkeiten: Datenspeicherung ist inzwischen billiger denn je! Außerdem wird die Datenverarbeitung über RAM-Module und CPU immer schneller und kostengünstiger (siehe Abbildung 2). Dieser erstaunliche Preisverfall geht einher mit neuen In-Memory-Technologien wie SAP HANA und neuen Analyseanwendungen wie Hadoop. Sie ermöglichen schnelle und kostengünstige Big-Data-Analysen, und das sowohl konventionell vergangenheitsorientiert als auch zunehmend zukunftsgerichtet (Predictive Analysis). Was dabei aber noch wichtiger ist, die IT kann nun ihre bislang vielleicht größte Schwachstelle überwinden – die schwierige Integration zwischen der transaktionalen (oder operativen) Datenver­ar­beitung und der Datenanalyse. Was ist Big Data? Wie so oft bei heißen Themen: Jeder spricht darüber, aber allzu häufig bleiben viele grundlegende Definitionen und Fakten im Dunkeln. Stattdessen entsteht umso mehr Raum für die Bildung von Mythen. 5 Worum also handelt es sich genau bei Big Data? Grundsätzlich gilt: „Big Data ist ein Allerweltswort für jede Sammlung von Datensätzen, die so groß und komplex ist, dass es schwierig wird, sie mit den bisher verfügbaren Datenmanagement-Tools oder herkömmlichen Datenverarbeitungsanwendungen zu verarbeiten.“ Nach einer etwas differenzi­ erteren Definition von Gartner lässt sich Big Data im Englischen durch die „3 Vs“ kenn­ zeichnen: Volume (Menge), Velocity (Geschwindigkeit) und Variety (Vielfalt). Volume (Menge): ■■ Immer größere Mengen an Daten werden beispielsweise durch Maschinen produ Die „3 Vs“ charakterisieren Big Data ziert – in Petabytes pro Tag: Eine einziges Flugzeugtriebwerk erzeugt alle 30 Minuten rund 10 TB an Tracking-Daten … und täglich finden etwa 25.000 Flüge statt! ■■ Strukturierte Daten erfordern eine hohe Bandbreite und Speicher mit großen Kapazitäten. Velocity (Geschwindigkeit): ■■ Datenströme in sozialen Medien erzeugen beispielsweise einen ständigen Zustrom an Meinungen und Beziehungen, die für das Kundenbeziehungsmanagement wertvoll sind. ■■ Selbst bei nur 140 Zeichen pro Tweet erzeugt die hohe Geschwindigkeit (und Frequenz) von Twitter-Daten eine Menge von über 8 TB täglich. Variety (Vielfalt): ■■ Für neue Dienste, neue Sensoren oder neuartige Marktkampagnen werden auch neue Datenarten benötigt, um die entstehende Information zu erfassen. ■■ Die größten Herausforderungen liegen darin, die sprichwörtliche Nadel im Heuhaufen zu finden, die relevante Information innerhalb einer großen Datenmenge herauszu­ filtern – und die relevanten Daten dann für weitere Analysen aufzubereiten. Abbildung 2: Kosteneffizientere Speicherung und beschleunigte Verarbeitung von Daten Datenmenge 4 TB z. B. 1 Milliarde Textdateien mit je 4 KB Jahr Speicherkosten Verarbeitungszeit 2003 600.000 US $ 33 Std. 20 Min.* 2008 100.000 US $ 2014 20.000 US $ 17 Min.** Mehr Speicher und Geschwindigkeit bei erheblich geringeren Kosten! * Abruf und Hochladen aus HD-Speicher ** Lesen aus RAM 6 »Big Data beschreibt große Mengen an komplexen Warum ist die Datenmenge in den letzten und variablen Hochgeschwindigkeitsdaten, für Jahren so drastisch gestiegen? Ein Grund deren Informationsanalyse fortschrittliche Tech­ niken und Technologien erforderlich sind. « ist in den sinkenden Preisen für Infra­ struktur, beispielsweise für GPS-Sender, Netz­­werk­verbindungen und Speichermedien zu finden. Entscheidend sind jedoch die neu­en Möglichkeiten der persönlichen und geschäftlichen Kommunikation, welche z. B. Internet, Mobilgeräte und soziale Netzwerke bieten. Zugleich schafft die explodie­ rende Anzahl an Kommunikationspunkten und Verflechtungen immer mehr Ein- und Ausgangs­punkte für Daten – eine klassische Henne-Ei-Situation! Und wie wirkt sich das auf die Geschäftsmodelle von Unternehmen aus? Vielleicht nicht gleich – aber eventuell schon bald. Einige Fälle und Zahlen veranschaulichen es beispielhaft. Aus den sozialen Medien: Facebook hat über 1,31 Milliarden Nutzer. Sie teilen sich alle 20 Minuten rund eine Million Links und tauschen etwa drei Millionen Nachrichten aus. Facebook sammelt dabei geschätzt etwa 500 TB an Daten täglich. „Wenn man aus Big Data keinen Nutzen zieht, hat man nicht Big Data, sondern einfach nur Massen an Daten“, sagt Jay Parikh, Vice President Infra­­struc­ture bei Facebook: „Uns interessiert alles.“ Zum Vergleich: Die gesamte US-Library of Congress umfasst lediglich 20 TB an Daten. Aus der klassischen Industrie: Das „Internet der Dinge“ (in Deutschland häufig auch Industrie 4.0 genannt) hebt die automatisierte Maschine-zu-Maschine-Kommunikation auf die nächste Ebene. Ein bekan­nter Anwendungsfall ist das „vernetzte Auto“: Viele Fahrzeuge sind bereits mit einem Internet­z ugang und einem drahtlosen lokalen Netzwerk (WLAN) ausgerüstet. Autos warnen sich so gegenseitig oder helfen Dienstleistern und Erstausrüstern dabei, Prob­leme zu entdecken, ehe sie entstehen. Die neuesten Daten von ABI Research zum „Internet of Everything“ (IoE) gehen heute bereits von über 10 Milliarden drahtlos verbundenen Geräten im Markt aus. 2020 sollen es schon über 30 Milliarden sein. Big Data ist nicht neu! Mythos 1: „Big Data ist etwas Neues“ Big Data ist nicht wirklich neu. Unternehmen beschäftigen sich schon seit Langem mit großen Datenmengen und führen anspruchsvolle Analysen durch. Denken Sie nur an die Kaufempfehlungen bei Ebay oder Amazon. Der geschäftliche Wert von Big Data in diesem Zusammenhang bedarf keines weiteren Nachweises. 7 Praxisbeispiele für Big Data 1. Medizinforschung Big Data bietet hier völlig neue Möglichkeiten, Erkenntnisse zu gewinnen. Früher haben Forscher Hypothesen über Beziehungen oder Einflussfaktoren in umfangreichen statistischen Verfahren nachweisen müssen. Das war sehr zeit- und kosten-intensiv. Häufig musste deshalb die Anzahl an Variablen auf einige ausgewählte Parameter beschränkt werden. Und bei einer Falsifizierung der Hypothese war alles umsonst: Man musste wieder komplett von vorne beginnen. Mit Big Data können die Forscher nun den umgekehrten Ansatz wählen: von den Daten hin zur Hypothese. So können z. B. auf der Grundlage zahlloser verfügbarer Datensätze aus medizinischen Aufzeichnungen gezielt nach neuen Beziehungen gesucht werden. 2. Politische Meinungsforschung Vor der US-Präsidentenwahl 2012 sammelte die Fachhochschule Ludwigshafen am Rhein über 50 Millionen Feeds und Posts von Twitter und Facebook als Showcase für die In-Memory-Datenbank SAP HANA. Etwa 1,5 Millionen Posts täglich (über 18 pro Sekunde) wurden in Bezug auf sinnvolle Meinungen hinsichtlich der Kandidaten ausgewertet. Die auf dieser Analyse unstrukturierter Daten basierenden Vorhersagen zum Wahlausgang übertrafen die Erwartungen und lagen überraschend nah an den tatsächlichen Ergebnissen. 3. Einzelhandel 2011 eröffnete der Einzelhandelsriese Tesco einen virtuellen Supermarkt in der U-Bahn der südkoreanischen Hauptstadt Seoul. Berufspendler können dort einfach per Smartphone einkaufen. Während Wartezeiten können Kunden über QR-Codes auf digitalen Werbeanzeigen bestellen und sich die Waren an die Haustür liefern lassen. Die Online-Umsätze stiegen in der Folge um 130 Prozent. Darüber hinaus optimierte Tesco zusätzlich die internen Prozesse mit Big Data: Mehr als 70 Millionen Datenpunkte von Kühlschränken werden in ein spezielles Data Warehouse eingespeist und analysiert. Auf diese Weise lässt sich beispielsweise die Geräteleistung überwachen und erkennen, ob regelmäßige oder präventive Wartungen zur Senkung Hohe Wertigkeit der Energiekosten notwendig sind. von Big-DataTechnologie 4. Lotterie Tipp24 AG, eine Online-Plattform für unterschiedliche europäische Lotterien, ver­ wendet die (kürzlich von SAP erworbene) Software KXEN, um Milliarden von Transaktionen und Hunderte von Kundenattributen zu analysieren. Tipp24 kann vorausschauende Modelle für eine optimierte Kundenansprache nach Zielgruppen und personalisierte Nachrichten für die Verkaufsförderung entwickeln. Zusätzliche prädiktive Modelle lassen sich so um 90 Prozent schneller erstellen. 8 Mythos 2: „Big Data ist eine Einzeltechnologie“ Alle Beispiele belegen den hohen Wert von Big-Data-Technologie – vom Wissensmanagement über Geschäftsanalytik und das betriebliche Berichtwesen bis hin zu Simulationen und zur Forschung. Was sie gemeinsam haben, sind besonders intelligente, ganz unterschiedliche Lösungsansätze, die sich auf strukturierte und unstrukturierte Daten aus heterogenen Quellen stützen. Was sie nicht aufweisen, ist eine einzige, zentrale Big-Data-Technologie – schlicht deshalb, weil es sie nicht gibt. Big Data steht für den kombinierten Einsatz von unter­ schiedlichsten (alten und neuen) Methoden und Technologien. Sie alle zielen darauf ab, neue Erkenntnisse zu gewinnen und gleichzeitig riesige Datenmengen effektiv und ohne Speicherprobleme zu verwalten. Um es ganz deutlich zu machen: Big Data erfordert vor allem außergewöhnliche Ansätze, die zum einen die Verarbeitung unterschiedlichster Massendaten aller Art ermöglichen und zum anderen Endanwender in kürzester Zeit zu neuen Erkenntnissen und Maßnahmen führen. Nach diesen grundlegenden Definitionen von Big Data, hat sich der Nebel um weit verbreitete Mythen vielleicht schon etwas gelichtet. Damit können nun zwei zentrale Technologien in den Fokus rücken: In-Memory-Technologie und Hadoop. Was ist In-Memory-Technologie? Das herkömmliche Modell der relationalen Datenbank mit zeilenorientiertem Zugriff wurde in datenintensiven Anwendungen wie Business Intelligence früh von Verfahren mit spaltenorientiertem Zugriff abgelöst. Der Zugriff auf den Datenspeicher, die sogenannte Input/Output-(I/O-)Rate, blieb jedoch weiterhin der entscheidende Engpass: Moderne Prozessoren können hochkomplizierte Algorithmen zwar blitzschnell ausführen, herkömm­ liche (relationale) Datenbanken damit jedoch nicht Schritt halten. Erheblich leistungsfähigere Prozessoren und der große Preisverfall bei den Rechenkapazitäten ermöglichen heute die direkte Datenhaltung im Hauptspeicher (In-Memory). Dadurch lässt sich der zeitaufwendige Speicherzugriff vollständig vermeiden – so rückt die In-Memory-Technologie auf die Agenda vieler CIOs. 9 Abbildung 3: Herkömmliche Architektur im Vergleich mit SAP HANA Herkömmlich Mit SAP-HANA-Software Partitionierung Speicher Keine aggregierten Tabellen In-Memory Nur Delta-Eingabe Cache Kompression Flash & StandardFestplattentechnologie Speichern in Reihen und Spalten » In-Memory-Computing leitet einen gravie- SAP HANA, ein von SAP entwickeltes und vermark- renden Wandel ein, weil es die Total Cost tetes, spaltenorientiertes, relationales In-Memory- of Ownership drastisch reduziert. « Datenbank-Managementsystem, ist vielleicht das bekannteste Beispiel für eine dedizierte In-MemoryTechnologie. Zu ihren Fähigkeiten gehören die Part­- itionierung für Datenbank-Computing (komplexe Abläufe finden direkt auf Datenbankebene statt) sowie der Verzicht auf Aggregatsbildung (flexible Datenmodelle ohne Redundanzen). Weitere Merkmale sind die Echtzeitreplikation und schnelle Ladevorgänge für Daten; die Delta-Eingabe sowie eine Datenkompression von bis zu 80 Prozent. Vor allem aber führt die spalten- und zeilenorientierte In-Memory-Speicherung zu höheren Reak­tionsfähigkeit und einer außerordentlichen Beschleunigung (siehe Abbildung 3). Das ist nicht nur bei geschäftlichen Analysen oder bestimmten Big-Data-Szenarien von großem Nutzen, sondern alle Transaktionen können viel schneller verarbeitet werden. Somit lassen sich unmittelbare Erkenntnisse aus Daten gewinnen, die bisher aufgrund der Leistungsgrenzen relationaler Datenbanken und des „I/O-Engpasses“ ungenutzt bleiben mussten. Diese Beschleunigung ermöglicht Echtzeitanalysen und generell eine höhere Wertschöpfung in Geschäftsprozessen und kann sogar zu grundlegenden Veränderungen in Geschäftsmodellen führen. 10 Auf einen Blick: Die Vorteile der In-Memory-Technologie ■■ Geringere Betriebskosten für Anwendungen (durch Auslagerung von Datenbanken und Legacy-Anwendungen) ■■ Leistungsfähigere transaktionale Anwendungen ■■ Mehr horizontale Skalierbarkeit (Scale-up/Scale-down) ■■ Schnellere Reaktionszeiten bei Analyseanwendungen ■■ Geringe Latenzzeit der Anwendungsprotokolle (<1 Mikrosekunde) ■■ Drastisch schnellere Ausführung von Batch-Prozessen ■■ Business Intelligence als Selfservice inklusive freier Daten-Explorationen ■■ Korrelationen/Muster in Millionen von Abläufen lassen sich „in null Komma nichts“ erkennen ■■ Unterstützung von Big Data (Big Data ist speicherintensiv) ■■ Hybrid Transactional Analytical Processing (HTAP) – Transaktions- und Analyse anwendungen lassen sich mit der gleichen physischen Datenbank betreiben Mythos 3: „In-Memory ist nur ein Hype von SAP“ Man sollte sich nicht von selbsternannten Experten in die Irre führen lassen: In-Memory ist weder „nur ein Hype von SAP“ noch „eine neue und unerprobte Technologie“: Über 50 Softwareanbieter liefern heute bereits In-Memory-Technologie. Für bestimmte An­­wen­ dungs­a rten, insbesondere für analytische Zwecke, steht In-Memory-Computing sogar schon seit den späten 1990er Jahren bereit. Text- und Semantikanalysen gibt es ebenfalls seit vielen Jahren. Bei SAP beispielsweise kam diese Technologie erstmals bei SAP Advanced Planning and Optimization und in der Suchmaschine TREX zum Einsatz. »Bis 2025 werden die meisten IT-Organisationen Vergleichsweise neu ist jedoch, dass sich dem Weg von SAP folgen und ihre gesamte Infra- der Einsatz von In-Memory-Technologie struktur auf In-Memory-Datenbanken betreiben. « nicht mehr auf zweckbestimmte oder einzelne, spezialisierte Anwendungen beschränkt. Seit 2013 kann SAP HANA vorhandene relationale Datenbanken vollständig ersetzen und lässt sich als zentrale Platt­form für die komplette SAP Business Suite nutzen – auch für SAP BW/BI/BO und als unabhängige Plattform für neue Anwen­dungen. Da SAP nun die gesamte SAP Business Suite auf SAP-HANA-Datenbanken anbietet, lassen sich die Vorteile der In-MemoryTechnologie auch für transaktionale Abläufe erschließen. Gartner prognostiziert, dass die meisten IT-Organisationen bis 2025 dem Weg von SAP folgen und ihre gesamte Infrastruktur auf In-Memory-Datenbanken und Flash-Speicher umstellen werden. Die Tage von Tape und HDD sind also gezählt. 11 Was ist Hadoop? Eines vorab: Das von der Apache Foundation entwickelte Hadoop ist keine Datenbank! Es ist vielmehr ein auf Java basierendes Software-Framework für skalierbare, dezentrale Softwareanwendungen, welches eine einfache Handhabung und Analyse großer Daten­mengen unterstützt. Wie bereits zuvor erwähnt, sind die „3 Vs“ – Volume (Menge), Velocity (Geschwindigkeit) und Variety (Vielfalt) von Big Data die wichtigsten Herausforderungen für plattenbasierte, relationale Datenbanken. Und genau hier setzt Hadoop an. ■■ Volume: Hadoop bewältigt Datenmengen durch die Aufteilung von Daten und deren Verarbeitung auf mehrere „Datenknotenpunkte“. Falls Datenmenge oder Verarbeitungspensum an einem einzelnen Datenknotenpunkt steigen, lassen sich die Daten von einem Knotenpunkt auf weitere verteilen. ■■ Velocity: Hadoop sorgt für Datengeschwindigkeit, indem es die Trägheit vermeidet (oder zumindest verzögert), die mit der Eingabe von Daten in ein herkömmliches relationales Datenbankmanagementsystem einhergehen. ■■ Variety: Hadoop bewältigt unterschiedliche Daten, indem es sie als Linux-Betriebs­- system-Dateien abspeichert – ohne sie vorab zu überprüfen oder zu verarbeiten. So lässt sich absolut jede Art von Daten speichern, ohne vorher die Datenstruktur zu kennen oder zu definieren. »Mit Hadoop lassen sich größere, granulare Datenmengen kostengünstiger speichern. Auch der Zugriff ist einfacher möglich. Man kann Hadoop läuft auf Hunderten oder Tausenden von kostengünstigen Commodity-Servern, sogenannten DataNodes (Datenknotenpunkte). Jeder speichert nur einen Teil der Daten. Durch mehr in die Tiefe gehen und Geschäftsdaten auf die Aufteilung eines Verarbeitungsschritts in unterschiedlichsten Wegen eingeben. « Tausende parallel laufende, kleinere Schritte auf einzelnen Maschinen kann Hadoop problem­los Petabytes oder mehr verarbeiten. Es werden einfach weitere DataNode-Server hin­­zu­­gefügt. Hadoop folgt dem Map-Reduce-Programmiermodell von Google, und kann so Analyseund Verarbeitungstätigkeiten parallel ausführen (siehe Abbildung 4). Ein weiteres zentrales Merkmal der Hadoop-Softwarearchitektur ist es, dass Datenspeicherung und Datenver­arbeitung getrennt voneinander erfolgen. Viele Grundprinzipien von Hadoop sind schon lange bekannt. Sie erinnern stark an Methoden wie Stored Procedures und Batchläufe. Einen zentralen Unterschied stellen aber die erheblich einfacheren Benutzerdialoge dar. Die Antworten erscheinen, ähnlich wie bei Google oder anderen Suchmaschinenanbietern, quasi schon während der Ein­g­abe. Beeindruckend – insbesondere, wenn man die riesige Zahl der zugrunde liegenden Datensätze kennt. 12 Obwohl sich Hadoop und ähnliche Ansätze noch im Frühstadium befinden, sind sie jetzt schon eine Überlegung wert. Relationale Datenbanken sind nicht in der Lage, den aufgezeigten Anforderungen von Big Data gerecht zu werden. Und auch In-MemoryTechnologie allein kann unter Umständen nicht alle Anforderungen bedienen. Das führt zur nächsten Frage: Wie verhält sich Hadoop eigentlich zu In-Memory-Technologie? Abbildung 4: Cluster von Commodity-Servern und das Map-Reduce-Programmiermodell bei Hadoop Hadoop Namensknotenpunkt Job Manager Datenknotenpunkte Job 1 Job 2 Job n Ergebnis Ergebnis Ergebnis Job 1 Job 2 Job n Mappingphase Reduktionsphase Endergebnis Mythos 4: „Hadoop ist eine Alternative zu In-Memory-Technologie“ Angesichts der genannten Fakten ist klar, dass Hadoop keine Alternative oder Konkurrenz für In-Memory-Computing darstellt. Im Gegenteil: In-Memory ist vielmehr die technische Grundlage und eine ideale Plattform für Hadoop. Hadoop und In-Memory-Technologie ermöglichen in Echtzeit eine einfache Integration von großen Datenvolumen aus unterschiedlichen Quellen. Big Data lässt sich so ohne Beeinträchtigung durch vorhandene Business-Analytics- und Data-Warehouse-Strukturen analysieren. Das ist auch einer der Gründe für die Kooperation von SAP mit dem Hadoop-Framework. Daraus resultierte bereits ein dediziertes Toolset für eine einfache Integration in SAPBW-Systeme. Weitere Kooperationsvereinbarungen gibt es mit Hadoop-Anbietern wie Cloudera, Hitachi Data Systems, Hortonworks, HP und IBM – alle auf Basis der In-Memory-Datenbank SAP HANA. 13 Wie Big Data die Business IT der Zukunft beeinflusst Tendenziell werden geschäftliche Entscheidungen immer noch auf der Grundlage historischer Daten getroffen, und das obwohl schon seit vielen Jahren von „Echtzeit­ systemen“ gesprochen wird. So stand beispielsweise SAP R/3® für die dritte Genera­tion des Realtime-(also Echtzeit-)Systems. Bei genauerer Betrachtung galt diese Vor­aussetzung bislang aber nur für den transaktionalen Bereich von Geschäftssystemen. Aus Leistungsgründen wurde der analytische Teil entkoppelt: sowohl technisch – schließlich Mehr Leistung gab es unterschiedliche Systeme – als auch logisch, weil die Analyse immer auf Basis durch Big Data aggregierter historischer Daten durchgeführt wurde. Mehr Leistungsfähigkeit durch Big-Data-Technologien wie In-Memory und Hadoop ermöglichen Analysen in Echtzeit, die aber auch umgehend wieder für den operativen Betrieb zur Verfügung gestellt werden können. In anderen Worten: Unternehmen können nun zum einen viel schneller reagieren und zum anderen auch zunehmend proaktiv handeln. Der Fokus rückt immer mehr darauf, was als nächstes passieren wird und welche strategischen Handlungsoptionen bestehen, anstatt wie bisher nur auf historische Daten zu reagieren. Bislang konnten viele Firmen aus ihren wertvollen Daten einfach noch keinen Nutzen ziehen, selbst wenn sie eigentlich verfügbar waren. Der Grund dafür? Seit dem Beginn des ERP-Zeitalters hatten Unternehmen prinzipiell nur zwei Optionen für Reporting und Business Intelligence. Alternative 1: Sie konnten unternehmensinterne Auswertungen „stricken“ oder zusätzliche Programme entwickeln. Das führte in der Regel zu komplizierten und starren Lösungen, die es dem Business User nicht ermöglichten, selbst Berichtstrukturen und Anfragen zu verändern. Demzufolge veralteten vorabdefinierte Berichte und deren Ergebnisse schnell. Aber selbst wenn dies nicht der Fall war, ließ die mangelnde Performanz keine weitreichenderen Schlussfolgerungen oder gar schnelle Entscheidungen auf Grundlage fundierter Informationen zu. Viele Unternehmen entschieden sich daher für Alternative 2: ein Data Warehouse. Diese wurden im Laufe der Zeit aufgrund ihrer größeren Flexibilität immer beliebter. Allerdings hatte diese Flexibilität ihren Preis: Es musste ein zusätzliches System aufgebaut werden und für das Erstellen von Auswertungen waren Experten und spezielle Extraktoren erforderlich. Diese „Datenlager“ sind daher Spezialwerkzeuge für geschulte Mitarbeiter bestimmter Geschäftsbereiche. Aber selbst wenn geeignete Berichte verfügbar sind, bleiben Performance und Reaktionszeit ebenso ein Problem wie mobile Zugriffsmöglichkeiten für die Sales- und Servicemitarbeiter im Außendienst. Die mangelnde Leistungsfähigkeit lag hauptsächlich an der Trennung zwischen Online Transaction Processing (OLTP) und Online Analytical Processing (OLAP), die wiederum durch den hohen Preis für Datenspeicher bedingt war. 14 Abbildung 5: Die Entwicklung der Analysefähigkeiten in Unternehmen Geschäftliche Herausforderung Historisch Echtzeit Mit Verzögerung Echtzeit nur für Transaktionsszenarien Beschreibend Diagnostisch Direkte Integration von betrieblichem Reporting in den Ablauf Kürzere/proaktive Reaktionszeiten Simulationen Sehen, was als Nächstes passiert Gegensteuern möglich, z. B. gegen Abwanderung Vorausschauende Maßnahmen Selfservice-Analysen Strukturierte Daten aus Geschäftsanwendung Überwiegend strukturierte Daten aus Geschäftsanwendungen Unstrukturierte Daten teilweise möglich Viele Datenquellen Strukturierte Daten Unstrukturierte Daten Speicherung und Indexierung Sofort-Abfragen Viele verschiedene Datenquellen Beschränkung durch RAM Schichtenarchitektur Trennung OLTP/OLAP ETL/Data Warehouse In-Memory Gemischte Szenarien möglich Jetzt bereit für EnterpriseComputing Hadoop/Map Reduce/ kein SQL/R Frühe Entwicklungsstadien Daten Technologie Prädiktiv Mit der In-Memory-Technologie wird die Trennung von Transaktionen und Analyse aufgehoben. Es sind keine zusätzlichen Beschleunigungsprozesse mehr nötig. Das operative Reporting kann also dahin zurückkehren, wo es hingehört: In das zentrale, operative bzw. transaktionale System! Diese Konvergenz von OLTP- und OLAPAufgaben wird als Hybrid Transactional Analytical Processing (HTAP) bezeichnet. Der Ausdruck beschreibt die technische Fähigkeit, Anwendungen und Analysen in einer einzigen Umgebung durchzuführen – und das mit deutlichen Vorteilen in der Performance und Verarbeitungsgeschwindigkeit durch die SAP-HANA-Datenplattform, der ersten „echten“ Echtzeit-Datenbankplattform. Im Zusammenhang mit „Echtzeit“ sind Datenqualität, Steuerung und Kontrolle des Quellsystems wichtiger denn je. Ansonsten wird SAP HANA zwar schnelle, jedoch unzureichende oder falsche Informationen liefern. Durch HTAP entfallen nämlich bislang vorhandene, zusätzliche Ebenen. Die Datenqualität muss also schon direkt an der Quelle „stimmen“. Folglich muss sich die Qualitätssicherung von einem nachgelagerten, latenzgesteuerten Bereinigungsprozess in einen parallelen Echtzeitprozess am Ausgangs­punkt wandeln. Ähnlich dem Paradigma des umfassenden Qualitäts­ managements im Lean Manufacturing gilt nun: Es muss von Anfang an Qualität produziert werden, um (teure) Prüfungen und nachträgliche Korrekturen zu vermeiden. 15 Abbildung 6: In-Memory-Technologie wie SAP HANA vereinigt und beschleunigt Transaktionen und Analyse Data Marts Betriebliche Daten ETL aus verschiedenen Quellen Data Warehouse Report Einordnung Ansammlung OLAP-System im Batch-Modus OLTP-System in Echtzeit SAP In-Memory im Vergleich zu Abwickeln Analysieren Beschleunigen Transaktionen + Analyse direkt im Arbeitsspeicher (In-Memory) Aber Vorsicht: Die Plattform allein schafft noch kein Echtzeitunternehmen. Nur wenn es mit Hilfe von mobilen Lösungen und modernsten Benutzeroberflächen gleichzeitig gelingt, die Datenmenge und damit die Komplexität für den Anwender zu reduzieren wird Big Data überschaubar. Nur das liefern, was erforderlich ist! Das Grundprinzip: Nur das liefern, was erforderlich ist – zum richtigen Ort, zur richtigen Person, zur richtigen Zeit! (Eine Leseempfehlung hierzu ist das Whitepaper „Changes in Order”: Die neue Aufgabe des CIO, insbesondere das Kapitel „Warum nur der Anwendernutzen zählt“.) Predictive Analytics – weil die Zeit dafür reif ist! Prädiktive Analysen sind – wie jede Art der Prognose – von Natur aus unsicher. Das ändert sich auch durch Big Data nicht, allerdings lassen sich viele Wissenslücken schließen und die geschäftliche „Terra Incognita“ erheblich reduzieren. Das Aufstellen von Hypothesen ist der Anfangspunkt. Im Folgenden helfen dann Tools für Predictive Analytics alle Zweifel, Einschätzungen und Möglichkeiten zu verifizieren und entspre­ chende Nachweise zu liefern. Der Ansatz setzt dabei auf bewährte statistische Verfahren wie lineare und nicht lineare Verteilungsmodelle, Regressionstests, Zeitreihenanalyse oder Klassifizierung und Cluster­ bildung. Für die meisten Anwendungsfälle stehen dabei umfangreiche Open-Source-CodeBibliotheken zur Verfügung. 16 »Big Data schließt Wissenslücken und Für statistische Berechnungen und grafische Visualisierungen reduziert die geschäftliche „Terra kommen in den meisten Softwareanwendungen sogenannte Incognita“ erheblich. « R-Libraries zum Einsatz, so beispielsweise auch in SAP Predictive Analysis. Open Source R bildet ein solides Fundament für prädiktive Analysen auf Basis großer Datensätze. Es gibt über 3.500 AddOns, mit deren Hilfe sich individuelle Funktionalitäten erstellen lassen. Die entsprechenden Algorithmen und Funktionalitäten sind ebenfalls nicht neu. Statis­tische Verfahren und Tools stehen schon lange auf den Lehrplänen von Wirtschaftshochschulen und Universitäten. Dennoch haben sich Vorhersagemodelle bislang nicht richtig durchsetzen können. Hauptsächlich lag es am Mangel relevanter Daten oder am schwi­e ­ rigen Zugriff auf die Daten und/oder an Performance-Beschränkungen der Systeme. Daher haben bislang nur Firmen mit einem sehr dringenden geschäftlichen Interesse eigene prädiktive Anwendungen entwickelt. Big-Data-Technologie bietet nun endlich beste Voraussetzungen, um die größten Hindernisse in der Datenaggregation aus dem Weg zu räumen – mangelnde Performance und resultierende Latenz. Weitere wichtige Faktoren sind: ■■ maximale Benutzerfreundlichkeit für Geschäftsanwender, ■■ sicherer, interaktiver Echtzeitzugriff auf Daten aus unterschiedlichen Quellen, ■■ fähige und kompetente Mitarbeiter, die die richtigen Fragen stellen und die richtigen Hypothesen aufstellen – und so von der agnostischen (nicht-wahrnehmenden) Analyse zur vorhersagenden Analyse gelangen. Abbildung 7: Geschäftlicher Wert von Predictive Analysis Wahrnehmen und reagieren Vorhersagen und handeln Wettbewerbsvorteil Optimierung Rohdaten Ad-hocBerichte + Analyse StandardBereinigte Berichte Daten Was ist passiert? Allgemein vorhersagende Analysen Warum ist es passiert? Vorhersagemodelle Was wird passieren? Welches ist der günstigste Fall? Analytische Reife 17 Eine hochinteressante Lösung ist in diesem Zusammenhang SAP InfiniteInsight®: Es handelt sich dabei um eine mächtige Lösung für vorhersagende Analysen, die sich ohne Expertenwissen sehr einfach einsetzen lässt – und das nicht nur von Statistikern. Die Software liefert Optionen zur automatisierten Modellierung und ermöglicht einen vollen Zugriff auf die Datenberge, die sich in den Data Warehouses und CRM-Systemen von Unternehmen auftürmen. Es bedarf keiner manuellen Vorbereitung, wie etwa einer Datenvorauswahl. So lassen sich zwei Fliegen mit einer Klappe schlagen: Ein effektiver Datenzugang für den Durchschnittsanwender und ein Schutz vor dem Ausschluss wertvoller Informationen durch eine falsche Datenvorauswahl sind gewährleistet. Auf diese Weise können Kunden beispielsweise immer die richtigen Vorschläge unterbreitet werden – binnen Sekunden und immer dann, wenn sie benötigt werden. Mythos 5: „In-Memory-Computing ist das Ende von Data Warehousing“ Wenn also ein separater Speicher für geschäftliche Analyse operationaler Daten überflüssig ist, welche Aufgaben bleiben da künftig noch für Data Warehousing? Der Einsatz von In-Memory-Technologie wie SAP HANA verringert die Notwendigkeit von sogenannten ETL-Szenarien, also die Extraktion, Umwandlung und das Laden von Betriebsdaten, in und aus Data Warehouses ganz erheblich. Data Marts sind ebenfalls nicht mehr erforderlich. Außerdem gibt es keine Aggregate mehr. Die Daten sind entweder direkt zugänglich (in jedem Detail!) oder werden einfach auf der Stelle repliziert (im sog. Sidecar Scenario). Folglich macht In-Memory-Computing das Data Warehousing überflüssig. Richtig? Nein, absolut nicht. Data Warehouses haben weiter ihre Daseinsberechtigung, die Anwendungsfälle und Implementierungen werden sich jedoch tiefgreifend ändern. Data Warehouses werden künftig hauptsächlich für agnostische und taktische Business Intelligence (BI) verwendet, etwa zum Vergleich unterschiedlicher Geschäftsszenarien und deren Eintrittswahrscheinlichkeiten, beispielsweise bei Unternehmensübernahmen oder zur Beurteilung von Geschäftsstrategien. Auch in Hinblick auf die Implementierung selbst werden sich Veränderungen ergeben. Man muss künftig nicht mehr alles in einer einzigen Datenbank speichern und es dann „denormalisieren“. Trotz der Vorteile der In-Memory-Technologie macht es keinen Sinn, alle Arten von Daten dauerhaft in einer einzigen Datenbank zu speichern – womöglich Petabytes an unstrukturierten Daten, Social-Media-Daten, Internetprotokollen und anderen Streaming-Daten, die eventuell für Entscheidungen wichtig sein könnten. Statt­dessen können sich Unternehmen für Business-Process-Orchestration-Modelle entscheiden, die es Anwendern ermöglichen, diese Fragen direkt zu beantworten; beispielsweise kann SAP HANA in Verbindung mit Hadoop die jeweils geeignete Quelle für relevante Daten festlegen. 18 Empfehlungen für Big-Data-Strategien Es sind nun also prinzipiell alle Voraussetzungen da, um das operative Reporting dahin zurückzuholen, wo es hingehört. Der vergleichsweise unzweckmäßige Einsatz von Business Intelligence für operatives Reporting muss nicht mehr sein. Gleiches gilt für die Nutzung von Echtzeitanalytik für agnostische und strategische Szenarien. Aber welche strategischen Rückschlüsse lassen sich daraus ziehen? Predictive Analytics wird zum großen Vorteil „Seherische“ Fähigkeiten erfüllen ein offenkundiges Bedürfnis vieler Firmen. Eine präzi­sere Vorhersage des Bedarfs ermöglicht es beispielsweise, hohe Abschreibungskosten für unverkäufliche Überbestände zu vermeiden. Bislang war das aufgrund fehlender Daten­grundlagen oder von Performance-Problemen unumgänglich. In-Memory-Technologie bereitet diesem andauernden Missstand ein Ende. Es ist daher mit einer enorm steigenden Nachfrage nach prädiktiven Analysen zu rechnen – selbst von kleinen und mittleren Unternehmen. Die Erfolgschancen von In-Memory hängen jedoch stark von der Fähigkeit eines Unter­­ nehmens ab, auch seine Mitarbeiter entsprechend fachlich weiterzuentwickeln. Das Er­fassen von Daten und die Bereitstellung von relevanten Informationen ist nur die Grundvoraussetzung für präzise Vorhersagen. Darüber hinaus sind entsprechendes Fachwissen und eine gewisse Erfahrung (!) erforderlich, um auch die richtigen Schlussfolgerungen ziehen zu können. Es besteht ein großer Bedarf an „tiefgehenden analytischen Talenten“ qualifizierter Analysten und Manager, um Big-Data-Analysen gut genug verstehen und die richtigen Entscheidungen zu treffen. Je nach individuellem Handlungsdruck und Business Cases sind die meisten Firmen gut beraten, sich zunächst die grundlegenden Echtzeitfähigkeiten ins Haus zu holen, ehe sie auf dieser Basis den Sprung in die Zukunft wagen. Letztlich lohnt sich die Investition in eine Echtzeitplattform aber auf jeden Fall, wie die Vorteile im Überblick zeigen: ■■ Mehr Effizienz: Eine minimierte Anzahl an Systemen und Datenbanken – in Verbindung mit konsolidierten Prozessen auf einer einzigen Plattform – reduzieren die Komplexität und die Kosten ganz erheblich (die vollständige SAP Business Suite kann beispielsweise komplett auf einer einzigen SAP-HANA-Instanz laufen). ■■ Schnelles, nachvollziehbares Reporting: Bislang schleppend laufende Prozesse wie die Materialbedarfsplanung, Wirtschaftlichkeitsanalysen und andere komplizierte Berichte werden zu „Schnellabfragen“. ■■ Fortschrittlichste Echtzeit-Analytik: Vorhersagen, Simulationen, „Was-wäre- wenn“-Szenarien und Drill-downs ohne Latenzzeit werden ganz einfach. ■■ Kontinuierliche Prozessverbesserung: Eine fokussierte Entscheidungsfindung sorgt für mehr Profitabilität und Kundenzufriedenheit. 19 Unter diesen Vorzeichen prognostizieren wir für die nächsten zwei bis drei Jahre einen starken Trend zur In-Memory-Technologie. SAP HANA hat sich als Plattform bewährt Wir empfehlen, neue Implementierungsprojekte nach Möglichkeit gleich auf Basis von SAP HANA anzugehen. Alle künftigen Systemerweiterungen und neuen Produkte des Weltmarktführers für Geschäftslösungen werden auf SAP HANA beruhen. Die bewährten SAP-Funktionalitäten sind bereits für SAP HANA vorbereitet und für viele Rechenzentren ist die SAP-HANA-Plattform schon jetzt Routine. Aber natürlich gibt es nicht nur „die eine richtige“ Strategie. Für viele Entscheidungsträger kommt es sicher darauf an, bisherige Investitionen soweit wie möglich zu schützen, unabhängig vom gewählten Migrationspfad und Geschäftsszenario. Eine sichere Mi­g ration in die neue Technologie lässt sich in jedem Fall gewährleisten, ganz gleich ob unter Beibehaltung bestehender Systemkonfigurationen oder mithilfe maßgeschneiderter Migrations-Tools. Damit stellt sich die Frage nach dem optimalen Zeitpunkt: Hat die Konkurrenz schon Big-Data-Initiativen, besteht ohne Echtzeitinformationen die Gefahr, im Wettbewerb den Anschluss zu verlieren. Falls nicht, haben Unternehmen jetzt noch die Chance, sich mit Big-Data-Initiativen einen Vorsprung zu verschaffen. Allgemeine Vorhersagen für einzelne Branchen sind schwierig. Diejenigen, die unter hohem Margendruck stehen, wie etwa der Handel oder Einzelhandel, könnten den größten Wettbewerbsvorteil erlangen. Zu den sogenannten Early Adopters von Big-DataTechnologien zählen aber vor allem Telekommunikationsanbieter (z. B. für Vorhersagen zur Kundenfluktuation) und Finanzdienstleister (zur Aufdeckung von Betrug und Manipulation). Die Auswertung bisheriger Anwendungsfälle für Echtzeit- und Predictive-Szenarien haben gezeigt, dass es eher sinnvoll ist, Cluster nach Funktionsbereichen oder Prozessen zu bilden anstatt sich branchenspezifisch zu orientieren. Schwerpunkte unserer Kunden und Ansprechpartner sind bislang folgende Funktionsbereiche: ■■ Financial-Performance-Analyse, Risikoanalyse, Sicherheit, Betrugserkennung und Compliance. ■■ Vertrieb und Marketing – Tracking des Kundenverhaltens, Optimierung der Vertriebskanäle, Kundenwertanalyse, soziale Medien, Analyse der Kundenstimmung. ■■ Operatives Reporting für Logistik und Beschaffung, Root-Cause-Analysen, strategische Szenarien. 20 Diese Beispiele dienen jedoch nur zur allgemeinen Orientierung. Entscheidend sind die spezifische Situation und die Anforderungen eines Unternehmens. Diese bestimmen, ob es sinnvoll ist, sich a) zunächst darauf zu konzentrieren, das betriebliche Reporting in das Kernsystem zurückzuholen, oder b) neue Einblicke zu gewinnen, indem struktu­ rierte und unstrukturierte Informationen in einem Big-Data-Business-Intelligence-Projekt gebündelt werden. Ein Unternehmen sollte mehr Wert auf die richtigen Informationen für die richtige Person zur richtigen Zeit legen, um betriebliche Abläufe zu be­schleu­nigen. Für ein anderes macht es vielleicht mehr Sinn, über gezielte Big-Data-Analysen neue Geschäftsfelder zu ermitteln. Der Business Case weist den Weg Wie so oft verweist der individuelle Business Case auf die idealen Ausgangspunkte und zeigt den Weg zu nachhaltigem Geschäftswert durch Big Data. Statt altbekannte Fakten zur Berechnung des Business Case zu wiederholen, sollen wenige Hinweise zusätzliche Orientierung geben. 1.Die Verfügbarkeit vorhandener Informationen prüfen Wo befinden sich Informationen im Unternehmen und worin könnte deren möglicher geschäftlicher Nutzen liegen? Lassen sich irgendwo schnell Vorteile erreichen? Manchmal reicht es schon, den Zugriff auf hilfreiche Informationen zu vereinfachen, getreu dem Motto „Oh, wenn ich das vorher gewusst hätte …“. Big Data muss nicht immer gleich „ganz groß“ gedacht werden. Studien zeigen, dass die meisten Unter­ nehmen, die Big Data nutzen, oft schon lange über entsprechende Informationen verfügten, es ihnen jedoch bislang an den richtigen Fragen und der richtigen Unterstützung zu deren Beantwortung fehlte. Das globale Logistikunternehmen DHL beispielsweise verfolgt seine Sendungen schon immer minutiös, konnte diese Informationen aber erst nach einer Überarbeitung der Analytics-Systeme auch sinnvoll nutzen. 2.Das passende Betriebsmodell zum Business Case wählen Eine vollständige Implementierung im Unternehmen oder ein „Sidecar“-Modell mit zusätzlichem Cloud-Service? Was ist die bessere Option? Die individuell richtige Antwort hängt maßgeblich davon ab, wie viel Aufwand und welche Kosten damit einhergehen. 3.Die Gesamtinvestitionskosten im Auge behalten Die Gesamtbetriebskosten unterscheiden sich erheblich von den Gesamtanschaffungs­ kosten. Beide sind wichtig, aber leicht entsteht ein irreführender Eindruck. Zu ­beachten ist vor allem der Unterschied zwischen den Disk- und den RAM-Preisen. Auf den ersten Blick ist RAM weitaus teurer als Disk, aber wenn man die Leistung pro Sekunde berücksichtigt, ist RAM weitaus wirtschaftlicher. 21 Außerdem wichtig: die laufenden Betriebskosten, denn eine geringere Anzahl an Systemen verursacht auch weniger Kosten und Aufwand für Strom, Kühlung, Grundfläche, Wartung … 4.Und zuletzt: Nicht nur auf die Kosten achten, sondern auch die Vorteile im Blick behalten Obwohl es einige sehr eindrucksvolle Beispiele für Big-Data-Analysen gibt, ist der Business Case oft noch nicht nachgewiesen. Das sollte jedoch niemanden davon abhalten, über die Zukunft und Wettbewerbsvorteile für sein Unternehmen nachzudenken. Allgemeiner Wert, Langlebigkeit Abbildung 8: Nicht für alle Informationen ist ein Big-Data-Ansatz notwendig Interaktionen mit Kunden Finanzielle Konsolidierungsdaten Prozessdaten Managementinformationen Stammdaten Informationen zur Aufzeichnung Informationen zur Differenzierung Social-MediaDaten Stammdaten Informationen für Innovation Flüssigkeit, Veränderlichkeit, Anzahl an Systemen Allgemein sind zur Aufzeichnung bestimmte Informationen weniger volatil und lassen sich deshalb in einem einzigen System speichern (oder besser: konsolidieren). Es kann sehr hilfreich sein, sich die für Big Data maßgeblichen „drei Vs“ in Erinnerung zu rufen: Volume (Menge), Velocity (Geschwindigkeit) und Variety (Vielfalt). Aber selbst wenn diese Kriterien erfüllt sind, fehlt noch ein konkreter Nachweis ihres Werts. 22 Als Faustregel zur Datenklassifizierung gilt: Daten- Strukturiert/Bereits erfasst » Worauf warten Sie noch? Strukturiert/Noch nicht erfasst » Zeitnah auf die Agenda setzen. Unstrukturiert/Noch nicht verfügbar » Abwarten, im Auge behalten und loslegen, wenn sich die Chance bietet. klassifizierung Mindestens zwei dieser Szenarien lassen sich bereits gut mit In-Memory-Technologie abbilden. SAP als Technologieführer hält mit SAP HANA alles bereit: Geschäftsprozesse lassen sich optimieren, indem relationale Datenbanken entweder komplett ersetzt werden oder neben konventionellen Datenbanken zum Einsatz kommen, um bestimmte Funk­­tionalitäten zu beschleunigen. Egal wie Sie sich entscheiden, es steht eine um­fassen­de Auswahl an zusätzlichen Tools und Hilfsmitteln für den sicheren und schnellen Zugriff auf In-Memory-Technologie bereit. Seien Sie also vorbereitet und idealerweise von Anfang an dabei: 2014 bedeutet den Durchbruch für In-Memory-Technologie. Die Zukunft besser vorhersagen zu können, bleibt kein Wunschdenken mehr. Die Fähigkeit entwickelt sich vielmehr künftig zur Schlüsselkompetenz für viele IT-Fachleute. Diese können ihren Unternehmen damit einen großen geschäftlichen Mehrwert eröffnen und viel bewegen. Lesen Sie mehr … … über zukunftsorientierte Strategien und Softwarelösungen in unserer White-PaperReihe. Wenn Sie mehr über Big Data wissen möchten, wenden Sie sich bitte an die Autoren oder besuchen Sie uns im Internet unter: www.itelligencegroup.com 23 Quellen Hilbert, Martin; López, Priscila (2011). “The World‘s Technological Capacity to Store, Communicate, and Compute Information“. Science 332 (6025): 60–65 http://en.wikipedia.org/wiki/Exabyte “IBM What is big data? – Bringing big data to the enterprise“. http://www-01.ibm.com/software/ data/bigdata/what-is-big-data.html. Retrieved 2014-05-06 http://en.wikipedia.org/wiki/Big_data TechAmerica Foundation, Demystifying big data: A Practical Guide to Transforming the Business of Government. www.techamerica.org/Docs/fileManager.cfm?f=techamerica-bigdatareport-final.pdf http://www.statisticbrain.com/facebook-statistics Retrieved 2014-05-12 http://gigaom.com/2012/08/22/facebook-is-collecting-your-data-500-terabytes-a-day http://en.wikipedia.org/wiki/Internet_of_Things https://www.abiresearch.com/press/more-than-30-billion-devices-will-wirelessly-conne Retrieved 2014-05-12 http://en.wikipedia.org/wiki/SAP_HANA https://www.gartner.com/doc/2657815/hybrid-transactionanalytical-processing-foster-opportunities http://www.sap.com/bin/sapcom/en_us/downloadasset.2013-08-aug-23-23.Architecture%20Matters-Thought%20Leadership%20Whitepaper%20on%20Enterprise%20Data%20Warehousing%20 by%20Claudia%20Imhoff-pdf.html www.mckinsey.com/features/big_data http://www.forbes.com/sites/gilpress/2013/12/12/16-1-billion-big-data-market-2014-predictions-from-idc-and-iia/ Über itelligence itelligence ist einer der international führenden IT-Komplettdienstleister für SAP®-Lösungen und mit mehr als 3.800 hoch qualifizierten Mitarbeitern in 22 Ländern vertreten. Wir haben unsere SAP-Expertise in den letzten 25 Jahren stetig weiterentwickelt. Heute unterstützen wir mehr als 5.000 Kunden weltweit mit maßgeschneiderten, integrierten Geschäftslösungen. Das Service-Portfolio umfasst SAP-Strategie-Beratung, SAP-Lizenzvertrieb, Implementierung und Prozessberatung, Outsourcing sowie Application-Management-Services. Unsere Experten leisten Pionierarbeit in der Entwicklung neuer Lösungen für unterschiedliche Branchen. Außerdem erarbeiten wir gemeinsam mit SAP weg­weisende Einsatzszenarien und Lösungen in den Bereichen Business Analytics, In-MemoryComputing und SAP HANA®, Cloud-Computing und Mobile. Im Jahr 2013 erzielte itelligence einen Gesamtumsatz von 457,1 Millionen Euro. www.itelligencegroup.com 24 Austria Belgium Canada China Czech Republic Denmark France Germany Hungary India Malaysia Netherlands This white paper outlines our general product direction and must not be relied on in making a purchase decision, as it is not subject to your license agreement or any other agreement with itelligence. itelligence has no obligation to pursue any course of business outlined in this white paper or to develop or release any functionality Norway mentioned herein. This white paper and itelligence‘s strategy for possible future devel- Poland opments are subject to change and may be changed by itelligence at any time for any Russia Slovak Republic reason without notice. This document disclaims any and all expressed or implied warranties, including but not limited to, the implied warranties of merchantability, fitness for a particular purpose, or non-infringement. itelligence assumes no responsibility Spain for errors or omissions in this document, except if such damages were intentionally Switzerland caused by itelligence or its gross negligence. Turkey Ukraine United Kingdom Imprint/Contact United States of America itelligence AG Königsbreede 1 D-33605 Bielefeld www.itelligencegroup.com 2014