Stochastische Signale

Werbung

Statistische Signaltheorie Formelsammlung

SS 2006

Grundlagen

Kombinatorik

Wahrscheinlichkeitsräume

Permutation

Anordnungsmöglichkeiten von n Elementen: Pn = n!

• Ergebnisraum Ω als Menge möglicher Ergebnisse ωi eines Zufallsgeschehens:

Ω = {ω1 , ω2 , . . .}

Anordnungsmöglichkeiten von n Elementen wobei k1 , k2 , . . . Elemente gleich sind: Pn(k) =

• Ereignis A eines Zufallsgeschehens als Teilmenge des Ergebnisraums A ⊂ Ω

• Ereignis-Algebra F als Menge von Ereignissen (Teilmengen) des Ergebnisraums

F ⊆ P (Ω)

Auswahl von k Elementen aus einer n-Menge mit Beachtung der Reihenfolge

n!

n

=

ohne Wiederholung/Zurücklegen: Vn(k) = k!

k

(n − k)!

Ai ∩ A j ∈ F

Ai \ Aj ∈ F

⇒

n!

k1 !k2 ! . . .

Variation

Achtung: F = P (Ω) (Potenzmenge) nur für abzählbare Ω

Minimalanforderungen an eine Ereignis-Algebra:

Ω∈F

C

C

A∈F ⇒ A

∈ F mit A = Ω \ A

A1 , A2 , . . . ∈ F ⇒

Ai ∈ F

c

Veit

Kleeberger

mit Wiederholung/Zurücklegen: Vn(k) = nk

i≥1

Eine Ereignisalgebra welche die Minimalanforderungen erfüllt ist eine σ-Algebra F . Das Paar (Ω, F ) heißt dann

Ereignisraum bzw. messbarer Raum.

Wenn F auf der Grundlage einer Menge G erzeugt wird, so wird diese Erzeugendensystem von F genannt.

wenn F = P ( Ω ) → |F| = 2

N Elemente

Mächtigkeit von F : |F| = Anzahl der Teilmengen (Ai ) von F

N

Definition des Wahrscheinlichkeitsmaßes

0 ≤ P (A) ≤ 1 für jedes Ereignis A

P (Ω) = 1

A ∩ B = ∅ ⇒ P (A ∪ B) = P (A) + P (B)

P(

Ai ) ≤

i≥1

Auswahl von k Elementen aus einer n-Menge ohne Beachtung der Reihenfolge

n

n!

ohne Wiederholung/Zurücklegen: Cn(k) =

=

(n − k)!k!

k

n+k−1

mit Wiederholung/Zurücklegen: Cn(k) =

k

Summenformeln

Ai ∩ Aj = ∅, i = j ⇒ P (

P (Ai )

Kombination

∞

Ai ) =

i=1

i≥1

∞

n

P (Ai )

k=1

k=0

n−1

axk = a

k=0

Rechenregeln

n−1

P (AC ) = 1 − P (A)

P (A ∪ B) = P (A) + P (B) − P (A ∩ B)

i=0

Bedingte Wahrscheinlichkeit und unabhängige Ereignisse

P (B|A) =

P (A ∩ B)

P (A)

Gesetz von

der totalen Wahrscheinlichkeit

P (A) =

P (Bi )P (A|Bi )

i∈I

f (k, l)

1

=

2

y=0

n

a

1−x

min(m,n)

f (k, k)

=

∞

xk

k=0

k=0

(−1)n+1

m<a

oder n<b

|x| < 1

k!

= ex

n n

=1

j=1

f (k,l)=0

für k=l

k=a l=b

1

1

=

n!

e

n

k=0

k

xn y n−k = (x + y)n

f (n − k) =

n

f (k)

k=0

0

k=max(a,b)

Faltung

Satz von Bayes

P (Bj )P (A|Bj )

P (Bj |A) = P (Bi )P (A|Bi )

x[n] ∗ h[n] =

P (B)P (A|B)

P (B|A) =

P (A)

∞

l=−∞

i∈I

Für unabhängige Ereignisse gilt

P (A ∩ B) = P (A) · P (B)

P (B|A) = P (B),

P (A|B) = P (A)

∞

1y

1 − xn

1−x

1

i = (n − 1)n

2

n m

P (A ∩ B)

P (B)

axk =

i=1

A ⊂ B ⇒ P (A) < P (B)

P (A|B) =

∞

2k−1 = 2n − 1

x(t) ∗ h(t) =

x[l]h[n − l] =

∞

h[l]x[n − l]

l=−∞

+∞

+∞

x(τ )h(t − τ )dτ =

h(τ )x(t − τ )dτ

−∞

−∞

2

SS 2006

Statistische Signaltheorie Formelsammlung

Zufallsvariablen

Transformation von ZV

Definition

P (X ∈ A) =

Dichtefunktion fx (x)

x

Verteilungsfunktion F

Erwartungswert E[X] oder μ

Streuung (Varianz) V ar[X] oder σ 2

Standardabweichung

P (X ∈ A) =

fx (x)dx

x∈A

A

Berechnung von fY (y) mit y = g(x)

fx (x)

F (x) =

fx (t)dt

F (x) = P (X ≤ x) =

fx (t)

t≤x

−∞

μ = xfx (x)dx

μ=

x · fx (x)

Ω

x∈Ω

2

2

2

2

σ = E[(X − μ) ] = (x − μ) fx (x)dx

σ =

(x − μ)2 fx (x)

x∈Ω

Ω

σ = V ar[X]

monoton nicht fallend

rechtsstetig

Fx (−∞) = 0

2. Für jeden Bereich den Wertebereich für x und für g(x) bestimmen.

3. y = g(x) nach x auflösen (⇒ x = g −1 (x)) für jeden Bereich (bei mehreren Lösungen gültiges x für jeweiligen

Bereich nehmen, s.o.)

4. Berechnung der Ableitung g (x) für jeden Bereich

P (a ≤ x ≤ b) = Fx (b) − Fx (a) =

• g (x) = 0

Fx (+∞) = 1

b

a

fx (x)dx

P (x ≤ a) = Fx (a)

fx (x)dx

fY (y) = fX (x)

a

Erwartungswerte

E[X + Y ] = E[X] + E[Y ]

E[g(X)] =

xw2

fX (x)dx

P (y = yi ) =

xw1

• g (x) = 0

∞

E[aX + b] = aE[X] + b

⇒ g(x) = Waagrechte im Bereich [xw1 , xw2 ] mit yi als y-Position der Waagrechten

fY (y) = P (y = yi ) · δ(y − yi )

fx (x)dx

−∞

a

P (x > a) = 1 − F (a) =

1. g(x) in Bereiche einteilen, wo sich die Definition ändert bzw. wo g(x) ein Extremum besitzt.

5. Aufstellen der Teilfunktionen für fY (y)

Verteilungsfunktionen

g(x)fX (x) bzw.

diskrete ZV

g(x)fX (x)dx

Ω

1 |g (x)| x=g−1 (y)

6. Für alle Teilbereiche wo der gültige g(x) Bereich gleich ist: Summe bilden.

x∈Ω

stetige ZV

7. Mithilfe der gefundenen g(x)-Bereiche, die (stückweise definierte) Funktion fY (y) aufstellen.

Spezialfälle

Monoton steigende Funktion g(x)

Streuungen

V ar[X] = E[X 2 ] − (E[X])2

V ar[X + Y ] = V ar[X] + V ar[Y ] + 2Cov[X, Y ]

V ar[aX] = a2 V ar[X]

n

n

n n

V ar

ai Xi =

a2i V ar(Xi ) + 2

ai aj Cov(Xi , Xj ) V ar[X − Y ] = V ar[X] + V ar[Y ] − 2Cov[X, Y ]

i=1

c

Veit

Kleeberger

i=1

V ar[X]

P (|X − μ| ≥ a) ≤

a2

Monoton fallende Funktion g(x)

FY (y) = 1 − FX (g −1 (y))

i=1 j=i+1

Tschebyschev-Ungleichung

E[X 2 ]

P (|X| ≥ a) ≤

a2

FY (y) = FX (g −1 (y))

1

P (|X − μ| ≥ kσ) ≤ 2

k

Lineare Transformation Wenn g(x) = y = ax + b ⇒ fY (y) =

1

f ( y−b )

|a| x a

FY (y) = FX ( y−b

)

a

Momente

k-tes Moment: mk = E[X k ]

k-tes zentrales Moment: zk = E[(X − E[X])k ]

Quantil, Fraktil

Ein α-Quantil ist der Zahlenwert xα , der die Unlgleichung P (X < xα ) ≤ α erfüllt

Das (schwache) Gesetz der großen Zahlen

X n = (X1 + · · · + Xn )/n

lim P X n − μ < ε = 1

∀ > 0

n→∞

3

4

Statistische Signaltheorie Formelsammlung

SS 2006

Zweidimensionale Zufallsvariable

Bedingte Verteilungen f (x|y) bzw. f (y|x)

Fxy (x, y) = P (X ≤ x, Y ≤ y) =

Verteilungsfunktion Fxy

Erwartungswerte E[g(X, Y )]

E[g(X, Y )] =

∞ ∞

−∞ −∞

∞

Randverteilungen

(Marginalisierung)

fX (x) =

fY (y) =

−∞

∞

x y

fuv (u, v)dudv

−∞ −∞

Für unabhängige Zufallsvariable X und Y gilt

fxy (x, y) = fX (x)fY (y)

E[XY ] = E[X]E[Y ]

∞

fX+Y (x) =

fX (t)fY (x − t)dt = fX (x) ∗ fY (y)

fuv (u, v)

u≤x v≤y

g(x, y)fxy (x, y)dxdy

x

fxy (x, y)dy

f (y|x) =

g(x, y)fxy (x, y)

y

fX (x) =

fxy (x, y)

fxy (x, y)dx

fY (y) =

fxy (x, y)

x

f (x, y)

fX (x)

fY (y)f (x|y)dy

fY (y) =

−∞

fX (x)f (y|x)dy

fX (x) =

fY (y)f (x|y) fY (y) =

y

−∞

fX (x)f (y|x)

x

Für unabhängige Zufallsvariable X und Y gilt

f (y|x) = fY (y)

Fxy (x, y) = FX (x)FY (y)

f (x, y)

fY (y)

∞

fX (x) =

f (x|y) = fX (x)

f (x, y) = fX (x)fY (y)

Bayes-Regel

V ar[X + Y ] = V ar[X] + V ar[Y ]

f (x|y) = ∞

fX (x)f (y|x)

fX (x)f (y|x)

f (x|y) = fX (x)f (y|x)

fX (x)f (y|x)dx

X

−∞

−∞

Bedingte Erwartungswerte

Kovarianz Cov[X, Y ]

Cov[X, Y ] = E[(X − μ1 )(Y − μ2 )]

∞

μ1 = E[X], μ2 = E[Y ]

E[X|Y ] =

Cov[X + Y, Z] = Cov[X, Z] + Cov[Y, Z]

Cov[X, Y ] = 0 ⇒ X und Y unkorreliert

E[X|Y ] =

E[Y |x]fX (x)dx

E[Y ] =

−∞

Cov[aX + b, cY + d] = acCov[X, Y ]

unkorreliert ⇒ unabhängig

∞

E[X|y]fY (y)dy

E[X] =

yf (y|x)dy

−∞

∞

X und Y unabhängig ⇒ Cov[X, Y ] = 0

Cov[aX, Y ] = aCov[X, Y ]

∞

E[Y |X] =

xf (x|y)dx

−∞

Cov[X, Y ] = E[XY ] − E[X]E[Y ] = Cov[Y, X]

Cov[X, c] = 0

f (x|y) =

∞

y

−∞

Cov[X, X] = V ar[X],

c

Veit

Kleeberger

−∞

E[Y |X] =

xf (x|y)

x

Kovarianzmatrix V ar[z]

z T = [y, x]T

2

Cov[Y, X]

σy

V ar[z] =

2

Cov[X, Y ] σx

E[X] =

E[X|y]fY (y)

E[Y ] =

y

E[Y ] = E[E[Y |X]]

V ar[X] = E[V ar[X|Y ]] + V ar[E[X|Y ]]

Cov[X, Y ]

ρ= V ar[X]V ar[Y ]

−1≤ρ≤1

ρ = 1 ⇒ korreliert

ρ = 0 ⇒ unkorreliert

E[Y |x]fX (x)

x

E[X] = E[E[X|Y ]]

Korrelationskoeffizient ρ

yf (y|x)

y

V ar[Y ] = E[V ar[Y |X]] + V ar[E[Y |X]]

Lineare Regression

ρ = −1 ⇒ antipodisch

X steht in linearer Regression mit Y, wenn E[X|y] eine lineare Funktion von y ist. In diesem Fall gilt:

x̂ = E[X|y] = μx + ρ

σx

(y − μy )

σy

(Regressionsgerade)

Steht Y in linearer Regression mit X, dann gilt

V ar[X + Y ] = V ar[X] + V ar[Y ] + 2ρ

5

V ar[X]V ar[Y ]

ŷ = E[Y |x] = μy + ρ

σy

(x − μx )

σx

(Regressionsgerade)

6

Statistische Signaltheorie Formelsammlung

SS 2006

Wahrscheinlichkeitsverteilungen

Stetige Verteilungsfunktionen

Diskrete Verteilungsfunktionen

Gleichverteilung U (a, b)

Binomialverteilung B(n, p)

n x

p (1 − p)n−x ,

f (x) = P (X = x) =

x

x = 0, 1, . . . , n

F (x) = P (X ≤ x) =

x n

i=0

σ 2 = np(1 − p)

μ = np

μ=

Geometrische Verteilung G(p)

f (x) = P (X = x) = (1 − p)x p,

x = 0, 1, 2, . . .

μ=

F (x) = P (X ≤ x) =

(1 − p)i p

σ2 =

f (x) = λe−λx

Φ(jω) =

σ2 =

⎩

0

x<a

− a) a ≤ x ≤ b

1

x>a

1

(x

b−a

(b − a)2

12

Exponentialverteilung E(λ)

x

p

1 − (1 − p)s

1−p

p

F (x) = P (X ≤ x) =

ejbω − ejaω

jω(b − a)

a+b

2

i=0

ϕ(s) =

a≤x≤b

⎧

⎨

pi (1 − p)n−i

Φ(jω) =

Φ(jω) = (1 − p + pejω )n

ϕ(s) = (1 − p + ps)n

i

1

f (x) =

b−a

c

Veit

Kleeberger

μ=

1−p

p2

x≥0

F (x) = P (X ≤ x) = 1 − e−λx

x≥0

λ

λ − jω

1

λ

σ2 =

1

λ2

Normalverteilung N (μ, σ)

Poisson-Verteilung P (λ)

f (x) = √

entsteht aus Binomialverteilung wenn p · n = λ = const. und n → ∞

P (X = x) = e−λ λx /x! x = 0, 1, 2, . . .

F (x) = P (X ≤ x) =

x

i=0

ϕ(s) = eλ(s−1)

μ=λ

Φ(jω) = e

σ2 = λ

λ(ejω −1)

e−λ λi /i!

(x−μ)2

1

e− 2σ2

2πσ

x

F (x) = P (X ≤ x) =

f (t)dt

−∞

jμω− 21 σ 2 ω 2

Φ(jω) = e

μ=μ

σ2 = σ2

N (0, 1) heißt auch Standard-Normalverteilung

Rayleigh-Verteilung R(σ)

x − x22

e 2σ

σ2

μ = σ π/2

f (x) =

7

x≥0

σ 2 = 2σ 2 (1 −

π

)

4

8

Statistische Signaltheorie Formelsammlung

Zweidimensionale (bivariate) Normalverteilung

Die zweidimensionale Zufallsvariable (X, Y ) ist N (μx , μy , σx , σy , ρ)-verteilt, wenn sie eine Dichtefunktion folgender Gestalt besitzt:

2 2

2 1

y − μy

x − μx

x − μx

1

y − μy

f (x, y) =

+

− 2ρ

exp

2(1 − ρ2 )

σx

σy

σx

σy

2πσx σy 1 − ρ2

1

1

z = [x, y]T ∧ μ = [μx , μy ]T

= exp − (z − μ)V ar[z]−1 (z − μ)T

2

2π det(V ar[z])

Die bedingte Verteilung von Y bei gegebenem X = x ist die N (μ, σ)-Verteilung mit

σy

μ = μy + ρ (x − μx ) und σ 2 = σy2 (1 − ρ2 )

σx

Verteilungsverknüpfungen

Additionstheoreme

X1

X2

X1 + X2

B(n1 , p)

B(n2 , p)

B(n1 + n2 , p)

P (λ1 )

P (λ2 )

P (λ1 + λ2 )

N (μ1 , σ1 ) N (μ2 , σ2 ) N (μ1 + μ2 ,

Verteilung von Y

E(λ)

−

N (0, σ)

N (0, σ)

λX1

E(1)

X12 + X22 R(σ)

U (a, b)

−

− λ1 ln(X1 )

Wahrscheinlichkeitserzeugende Funktion (nur für ganzzahlige Zufallsvariable)

1 dx

ϕ

(s)

PX (X = x) =

x

x! dsx

s=0

du(t)

dt

Integration

t

d

d

t aU (f ) + bU (f )

1

2

t 1 U(f )

d

t e−j2πt0 f U (f )

d

t U (f − f )

0

t j2πf U (f )

d

|k|

t 1 dU (f )

u(τ )dτ d

t U (f )( 1

j2π

1

+ 12 δ(t)) d

u(t)(− j2πt

df

j2πf

−∞

t

f

U (φ)dφ

Vertauschung

U ∗ (t) d

Gleichanteil

Dirac-Impuls

u(t) = 1

u(t) = δ(t)

u(t) = δ(t − t0 )

u(t) = σ(t)

1 |t| < T /2

u(t) =

0

sonst

−| ad t| + d |t| < a

u(t) =

0

sonst

Gauß-Impuls

e-Impuls

Sinusfunktion

Cosinusfunktion

cos x =

ejx + e−jx

2

u (f )

d

d

d

t U (f ) =

t U (f ) =

d

t U (f ) = T · si(πT f )

d

t a · d · si2 (aπf )

2αβsi(2πβt) d

e−αt

t>0

e−α|t|

u(t) = sin(2πf0 t)

u(t) = cos(2πf0 t)

sin x =

ejx − e−jx

2j

t U (f ) = δ(f )

t U (f ) = 1

d

2

d

u(t) = exp(− (απt

2)

GT )

si-Impuls

+ 12 δ(f ))

−∞

t ∗

V ar[X] = ϕ (1) + ϕ (1) − (ϕ (1))2

E[X 3 ] = ϕ (1) + 3ϕ (1) + ϕ (1)

k

−tu(t) d

E(λ)

Integraltransformationen von Verteilungen

E[X] = ϕ (1)

au1 (t) + bu2 (t)

u(kt)

u(t − t0 )

ej2πf0 t u(t)

Differentiation

Dreieck-Impuls

Verteilung von X1 Verteilung von X2 Y

E[X 2 ] = ϕ (1) + ϕ (1)

Linearität

Ähnlichkeit

Verschiebung

Rechteck-Impuls

σ12 + σ22 )

c

Veit

Kleeberger

Fourier-Transformationspaare

Sprung-Impuls

Beziehungen zwischen den Verteilungen

ϕ(s) = E[sX ]

SS 2006

d

d

d

d

e−j2πf t0

1

δ(f ) +

2

1

j2πf

t U (f ) = α T exp(−πα2 T 2 f 2 )

G

G

t U (f ) =

α |f | < β

0 sonst

1

t U (f ) =

j2πf +α

2α

t

4π 2 f 2 +α2

t U (f ) = 1 (δ(f − f ) − δ(f + f ))

0

0

2j

t U (f ) = 1 (δ(f − f ) + δ(f + f ))

2

0

0

ejx = cos x + j sin x

X1 und X2 unabhängig: ϕX1 +X2 (s) = ϕX1 (s)ϕX2 (s)

Charakteristische Funktion

Φ(ω) = E[ejωX ]

1 dk

E[X n ] = k k Φ(ω)

j dω

E[X] = −jΦ (0)

V ar[X] = −Φ (0) + (Φ (0))2

ω=0

X1 und X2 unabhängig: ΦX1 +X2 (ω) = ΦX1 (ω)ΦX2 (ω)

9

10

Statistische Signaltheorie Formelsammlung

Stochastische Signale

y[n, ω] = A(x[n, ω])

y[n + k] = A(x[n + k]) ∀k

X[n, ω] = X(ωn )

Erwartunswertfunktion

μ[n] = E[x[n]]

Varianzfunktion

Autokorrelationsfunktion

Autokovarianzfunktion

σ 2 [n] = V ar[x[n]]

=

rx [k, l] = E[x[k]x[l]]

=

Kreuzkorrelationsfunktion rx,y [k, l] = E[x[k]y[l]]

cx,y [k, l] = Cov[x[k], y[l]]

cx [k, l] = cx [l, k]

+∞

=

cx [k, l] = Cov[x[k], x[l]]

Kreuzkovarianzfunktion

=

=

=

−∞

+∞

ξfx (ξ; n)dξ

ξηfx (ξ, η; k, l)dξdη

−∞ −∞

+∞

+∞

(ξ − μξ )(η − μη )fx (ξ, η; k, l)dξdη

−∞ −∞

+∞

+∞

ξηfxy (ξ, η; k, l)dξdη

−∞ −∞

+∞

+∞

(ξ − μξ )(η − μη )fxy (ξ, η; k, l)dξdη

rxy [m, n] = E[x[m] · y[n]] = An (rx [m, n]) = h[n] ∗ rx [m, n]

∞

|h[i]| < ∞)

Spezielle Zufallsfolgen

Gaußsche Zufallsfolge s[n] = x(ωn ) + x(ωn+1 )

mit x(ωi ) = N (0, σ)

rx [k, l] = σ 2 · δ[k − l]

μx [i] = 0 ∀i

rs [k, l] = σ 2 δ[k − l − 1] + 2σ 2 δ[k − l] + σ 2 δ[k − l + 1]

μs [n] = E[s[n]] = 0

cx [k, k] = V ar[x[k]] =

An heißt A bzgl. x[n] (A(x[n]))

ry [m, n] = Am (rxy [m, n]) = Am (An (rx [m, n])) = h[m] ∗ h[n] ∗ rx [m, n]

σx2 [k]

Stationarität

n

mit x : Ω → {−δ, +δ}

x(ωi )

P (x[i] = −δ) = P (x[i] = +δ) = 0, 5

i=0

fx (ξ0 , . . . , ξn−1 ; k, k + 1, . . . , k + n − 1) = fx (ξ0 , . . . , ξn−1 ; 0, . . . , n − 1)

∀n, k

P (s[n] = r · δ) =

Schwach Stationär (WSS, wide sense stationary)

V ar[x[n]] = V ar[x[0]] ∀n

rx [k, l] = rx [k − l] ∀k, l

n+1

r+n+1

2

2−(n+1)

Moving Avarage Folge s[n] =

n→∞

1) sicher konvergent:

X[n, ω] → X(ω)

2) fast sicher konvergent:

P ( lim X[n, ω] = X(ω)) = 1

3) konvergent im quadratischen Mittel:

lim E{|x[n] − x|2 } = 0

4) konvergent in Wahrscheinlichkeit:

5) konvergent in Verteilung:

aus 3) folgt stets 4) (nicht umgekehrt).

E[s[n]] = μ

m≥n

cx [m, n] =

V ar[s[n]] = (n + 1)δ 2

E[s[n]] = 0

1

k+1

Konvergenz

11

(falls A zustandsstabil, d.h.

i=−∞

ξ 2 fx (ξ; n)dξ

−∞

+∞

+∞

−∞ −∞

A(α1 x1 [n] + α2 x2 [n]) = α1 A(x1 [n]) + α2 A(x2 [n])

E[Y [n]] = A(E[x[n]]) = h[n] ∗ E[x[n]]

Random Walk s[n] =

E[x[n]] = E[x[0]] ∀n

c

Veit

Kleeberger

LTI-Systeme

Zufallsfolgen (diskret)

rx [k, l] = rx [l, k]

SS 2006

n

x[i]

k>0

E[x[n]] = μ V ar[x[n]] = σ 2

i=n−k

((n−m)+k+1)σ 2

(k+1)2

0

für m − k ≤ n

für m − k > n

n→∞

n→∞

lim P (|x[n] − x|2 < ) = 0

n→∞

lim Fn (x) = F (x)

n→∞

1) → 5) : stark → schwach (im Prinzip)

12

Statistische Signaltheorie Formelsammlung

SS 2006

Zufallsprozesse (kontinuierlich)

Erwartunswertfunktion

LTI-Systeme

μ(t) = E[x(t)]

Varianzfunktion

Autokorrelationsfunktion

Autokovarianzfunktion

=

σ 2 (t) = V ar[x(t)]

=

rx (t1 , t2 ) = E[x(t1 )x(t2 )]

=

cx (t1 , t2 ) = Cov[x(t1 ), x(t2 )]

=

Kreuzkorrelationsfunktion rx,y (t1 , t2 ) = E[x(t1 )y(t2 )]

cx,y (t1 , t2 ) = Cov[x(t1 ), y(t2 )]

Kreuzkovarianzfunktion

=

=

+∞

−∞

+∞

y(t) = A(x(t)) = h(t) ∗ x(t)

ξfx (ξ; t)dξ

μy (t) = E[y(t)] = A(μx (t)) = h(t) ∗ μx (t)

ξ 2 fx (ξ; t)dξ

−∞

+∞

+∞

−∞ −∞

+∞

+∞

rxy (t1 , t2 ) = At2 (rx (t1 , t2 )) = h(t2 ) ∗ rx (t1 , t2 )

ξηfx (ξ, η; t1 , t2 )dξdη

(ξ − μξ )(η − μη )fx (ξ, η; t1 , t2 )dξdη

−∞ −∞

+∞

+∞

−∞ −∞

+∞

+∞

−∞ −∞

ξηfxy (ξ, η; t1 , t2 )dξdη

(ξ − μξ )(η − μη )fxy (ξ, η; t1 , t2 )dξdη

Cov[X, Y ] = E[XY ] − E[X]E[Y ] = E[(X − μx )(Y − μy )]

unkorreliert ⇒ rxy (t1 , t2 ) = μx (t1 )μy (t2 )

ry (t1 , t2 ) = h(t1 ) ∗ rxy (t1 , t2 ) = h( t1 ) ∗ h( t2 ) ∗ rx (t1 , t2 )

Falls x(t) WSS:

Sy (f ) = H(f ) · Sxy (f ) = |H(f )|2 Sx (f )

Spezielle Zufallsprozesse

Poisson-Prozess

∞

u(t − Tn )

x(t) =

orthogonal ⇒ rxy (t1 , t2 ) = 0

unabhängig ⇒ z.B. Fxy (ξ1 , ξ2 , η1 , η2 ; t1 , t2 ) = Fx (ξ1 , ξ2 ; t1 , t2 )Fy (η1 , η2 ; t1 , t2 )

t≥0

n=1

P (x(t) = i) = e−λt

Stationarität

{X(t1 ), . . . , X(tn )} und {X(t1 + h), . . . , X(tn + h)} besitzen für alle t1 , . . . , tn und h > 0 dieselbe Verteilungsfunktion.

(λt)i

,

i!

P ((x(t2 ) − x(t1 )) = n) =

V ar[x(t)] = V ar[x(0)] ∀t

rx (t1 , t2 ) = rx (t1 − t2 ) ∀t1 , t2

P ({|x(t + τ ) − x(t)| ≥ α}) ≤

SX (f ) = SX (−f )

2

(rx (0) − rx (τ ))

α2

rx (0) =

SX (f ) ≥ 0

mit τ = t2 − t1

rx (0) = rx (t, t) = E{x(t)x(t)}

Spektrale Leistungsdichte SX (f ) = F{rx } =

i

P (x(t) = k)

k=0

(λ(t2 − t1 ))n −λ(t2 −t1 )

e

n!

t1 < t2

rx (t1 , t2 ) = λ min(t1 , t2 ) + λ2 t1 t2

E[X(t)] = V ar[X(t)] = λt

y0 ∈ {−1, +1} (Anfangszustand)

y(t) = (−1)x(t) y0

Autokorrelationsfunktion rx (t1 , t2 ) = rx (t2 − t1 ) = E{X(t1 )X(t1 + τ )} = rx (τ )

|rx (t)| ≤ rx (0)

P (x(t) ≤ i) =

Zufalls-Telegraphen-Prozess

Autokovarianzfunktion cx (t1 , t2 ) = cx (t2 − t1 )

rx (−t) = rx (t)

u(t) : Einheitssprung

Tn : Zeitpunkt des Auftretens des n-ten Ereignisses

i = 0, 1, 2, . . .

Schwach Stationär (WSS, wide sense stationary)

E[x(t)] = E[x(0)] ∀t

c

Veit

Kleeberger

α>0

+∞

E[y(t)] = E[y0 ]e−2λt

rx (τ )e−j2πf τ dτ

ry (t, t + τ ) = e−2λτ

Wiener-Prozess

x(t) = √

−∞

x(t) : Poisson-Prozess

1

−ξ 2

exp(

)

2αt

2παt

E[x(t)] = 0

cx (t1 , t2 ) = α min{t1 , t2 }

SX (f )∗ = SX (f )

+∞

SX (f )df = Leistung im Zeitbereich

−∞

x(t) = αu(t) ⇒

rx (t) = α2 ru (t) SX (ω) = α2 SU (ω)

rxy (t) = αruy (t) SXY (ω) = αSU Y (ω)

ryx (t) = αryu (t) SY X (ω) = αSY U (ω)

13

x(t) = u(t) + v(t) ⇒

rx (t) = ru (t) + rv (t) + ruv (t) + rvu (t)

SX (ω) = SU (ω) + SV (ω) + SU V (ω) + SV U (ω)

rxy (t) = ruy (t) + rvy (t)

SXY (ω) = SU Y (ω) + SV Y (ω)

14

Statistische Signaltheorie Formelsammlung

Markov Prozesse

fx (ξn |ξn−1 , ξn−2 , . . . ; tn , tn−1 , tn−2 , . . .) = fx (ξn |ξn−1 ; tn , tn−1 )

(1-Schritt-Gedächtnis)

Markov-Ketten := Markov-Prozess mit diskretem Zufallsprozess mit diskreten Zufallsvariablen.

Darstellung über Übergangsmatrix A

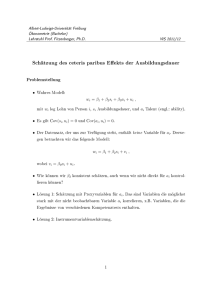

Beispiel:

a23

a12

a11

x=0

x=2

x=1

a21

a22

a33

a32

⎤

⎤ ⎡

⎤

P [xn−1 = 0]

P [xn = 0]

a11 a21 a31

P [xn = 1] ⎦ = ⎣ a12 a22 a32 ⎦ · P [xn−1 = 1] ⎦

P [xn = 2]

P [xn−1 = 2]

a13 a23 a33

n

Pn = A

P n−1 = A

(AP n−2 ) = A

P0

:

: :

:

n

n −1

Pn = A

P 0 = ::

QΛ

Q P0

:

: ::

aij = P (xn = j − 1|xn−1 = i − 1) < 1

15