Probability Inequalities

Werbung

Technische Universität Wien

Seminararbeit

Finanz-und Verischerungsmathematik

Probability Inequalities

Miloš Jovanović

betreut von

Dr Stefan Gerhold

Wien, 2. Juni 2017

]

Contents

1 Vorwort

2

2 Moment-Ungleichungen im Zusammenhang mit einer oder

2.1 Höldertype Ungleichungen . . . . . . . . . . . . . . . . . . . .

2.2 Jensensche Ungleichung . . . . . . . . . . . . . . . . . . . . .

2.3 Kimball Ungleichung . . . . . . . . . . . . . . . . . . . . . . .

2.4 Freedman Ungleichung . . . . . . . . . . . . . . . . . . . . . .

2.5 Exponential Moment der oben abgeschnittenen Variablen . .

zwei Variablen

. . . . . . . . . .

. . . . . . . . . .

. . . . . . . . . .

. . . . . . . . . .

. . . . . . . . . .

3 Schätzung von Momenten der Summen von Zufallsvariablen

3.1 Elementare Ungleichungen . . . . . . . . . . . . . . . . . . . . .

3.2 Minkowski Ungleichung . . . . . . . . . . . . . . . . . . . . . .

3.3 Khintchine Ungleichung . . . . . . . . . . . . . . . . . . . . . .

3.4 Marcinkiewicz-Zygmund Ungleichung . . . . . . . . . . . . . . .

3.5 Doob Ungleichungen . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3

3

4

5

6

7

8

. 8

. 9

. 10

. 10

. 12

4 Ungleichungen im Zusammenhang mit assoziativen Variablen

4.1 Kovarianz von PQD Variablen . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.2 Wahrscheinlichkeit von Quadrant auf PA (NA) Folgen . . . . . . . . . . . . . . .

4.3 Maximal Partialsumme von PA Folge . . . . . . . . . . . . . . . . . . . . . . . . .

14

14

14

15

5 Ungleichungen über Stochastiche Prozesse

17

5.1 Schätzung von Wahrscheinlichkeit des Supremum von Brownscher Bewegung . . 17

5.2 Schätzung von Wahrscheinlichkeit des Supremum von Poisson Prozess . . . . . . 19

6 Literaturverzeichnis

20

1

1

Vorwort

Das Thema der hier vorliegenden Seminararbeit ist Probability Inequalities.Hier werden vorgestelt

und erklärt wichtige Konzepte und Ungleichungen aus der Buch Probability Inequalities von

Zhengan Lin und Zhidong Bai.Ich habe hier nur die Kapiteln 8-12 untersucht.

Ungleichungen in Wahrscheinlichkeit sind nicht wichtig nur für Wahrscheinlichkeitstheorie,sondern

auch breite Anwendung in Finanz-und Versicherungsmathematik,als auch für andere Gebiete

der Mathematik,wie Statistik und Analysis haben.

2

2

Moment-Ungleichungen im Zusammenhang mit einer oder

zwei Variablen

In diesem Kapitel werden wir mit einigen wichtigen Moment-Ungleichungen ,wie Hölder,CauchySchwarz und Jensen Ungleichung,beschäftigen. Folgende Moment-Ungleichungen sind mit der

unbedingte Erwartungwert gegeben,aber sie sind auch richtig,wenn wir unbedingte mit der

bedingte Erwartungswert tauschen.

2.1

Höldertype Ungleichungen

In der mathematichen Analysis gehört die Höldersche Ungleichung zusammen mit der Minkowski

Ungleichung und der Jensenschen Ungleichung zu den fundamentalen Ungleichungen für Lp

Räume

Satz (Höldersche Ungleichung). Für p>1 und q>1 mit 1/q + 1/p = 1 gilt:

1

1

E|XY | ≤ (E|X|p ) p (E|Y |q ) q

Beweis: Wir können annehmen,dass 0 < E|X|p , E|Y |q < ∞. Ansonsten wäre die Ungleichung

trivial.

Wir wissen schon,dass − log(x) eine konvexe Fuktion auf (0, ∞) ist,da für a,b>0 gilt

− log(

ap bq

1

1

+ ) ≤ − log ap − log bq = − log ab

p

q

p

q

oder äquivalent :

ab ≤

ap bq

+

p

q

, 0 ≤ a, b ≤ ∞

dann folgt :

E(|X|/E(|X|p )1/p )E(|Y |/E(|Y |q )1/q )

≤ p1 E(|X|/E(|X|p )1/p )p + 1q E(|Y |/E(|Y |q )1/q )q

= p1 + 1q = 1.

Spezialfall:

Für p=q=2 erhalten wir Cauchy-Schwarz Ungleichung:

E|XY | ≤ (EX 2 )1/2 (EY 2 )1/2

Wir können auch eine Verallgemeinerung von Höldersche Ungleichung erhalten

Satz (Verallgemeinerte Höldersche Ungleichung).

Für 0 < p < 1 und q = −p/(1 − p) gilt:

E|XY | ≥ (E|X|p )1/p (E|Y |q )1/q

Beweis: Für X 0 = |XY |p , Y 0 = |Y |−p . Dann gilt mit der Höldersche Unglechung :

E|X|p = EX 0 Y 0 ≤ (EX 01/p )p (EY 01/(1−p) )1−p = (E|XY |)p (E|Y |q )1−p .

so wir haben

E(|XY |)p ≥ E|X|p (E|Y |q )−(1−p)

Wenn wir p-te Würzel ziehen erhalten wir die gewünschte Ungleichung.

3

2.2

Jensensche Ungleichung

Jensensche Ungleichung ist eine elementare Ungleichung für konvexe und konkave Funktionen.

Sie ist wegen ihrer Allgemeinheit Grundlage vieler bedeutender Ungleichungen, vor allem in der

Analysis und Informationstheorie.

Da wir schon Ungleichungen in Wahrscheinlichkeitstheorie betrachten,werden wir in folgendem annehmen,dass (Ω, F, P) ein Wahrscheinlichkeitsraum und X eine integrierbare,reelle Zufallsvariable ist.

Satz (Jensen Ungleichung). Sei g eine konvexe Funktion auf R.Angenommen,dass Erwartungswerte

von X und g(X) existieren.Dann gilt :

g(EX) ≤ Eg(X)

Gleichung gilt für strikt konvexe g ⇐⇒ X = EX f.s.

Beweis: Wir wissen,dass für konvexe Funktion g und für alle x,y gilt:

g(x) ≥ g(y) + (x − y)g 0 (y)

Sei x=X und y=EX,wir erhalten

g(X) ≥ g(EX) + (X − EX)g 0 (EX)

Die Erwartung ergibt die gewünschte Ungleicheit.

Falls g strickt konvex ist,g’ ist steng monoton wachsend.Offensichtlich ist,wenn X=EX f.s =⇒

Eg(X)=g(EX)

Andererseits,wenn Eg(X)=g(EX),erhalten wir mit der obigen Ungleichung:

E(EX − X)g 0 (X) = 0 =⇒ E(EX − X)(g 0 (X) − g 0 (E(X)) = 0.

Was aber folgt,dass X=EX f.s.

Bemerkung: Eine Funktion f ist strikt konvex,wenn f 00 > 0. (dh. dass f 0 streng monoton

wachsend ist.)

Ich möchte jetzt zwei Folgen desr Jenschen Ungleichung vorhanden:

Monotonie der Lr -norm

Für alle 0 < r ≤ s,

(Folge der Jensensche Ungleichung)

(E|X|r )1/r ≤ (E|X|s )1/s .

Besonders,für alle p> 0

E|X| ≤ (E|X|p )1/p .

Beweis: Nehmen wir an,dass g(x) = |x|s/r und tausche X mit |X|r in der Jensensche Ungleichung.Dann haben wir:

s

(E|X|r )s/r ≤ E|X| r r = E|X|s .

Wenn wir die s-te Würzel ziehen erhalten wir die gewünschte Ungleichung.Für die zweite Ungleichung machen wir dieselbe mit g(x) = |x|p .

Satz (aritmetisch-geometrische Ungleichung). Sei X eine nicht negative reelle Zufallsvariable,dann

EX ≥ exp{E(log x)}

Diese Ungleichung folgt direkt aus der Jensen Ungleichung,wenn fur x > 0, g(x) = − log x

(− log x ist eine konvexe Funktion.) setzen und für x ≤ 0 , g(x) = ∞ setzen.

4

{ a1 , ..., an } sei eine Menge von positiven Zahlen.Interpretiert man diese Menge als

n

X

1

−1

Merkmalraum einer Stochastiche Grosse X mit P(X=ai )= , so ist E(X) = n

ai das

n

i=1

arithmetische Mittel (AM) der ai .Da − ln x eine konvexe Funktion ist,folgt nach der Jensensche

Ungleichung :

!

!1/n

n

n

n

Y

1X

1X

ai ≤ E(− ln X) = −

ln ai = − ln

ai

− ln

n

n

Beispiel

i=1

i=1

i=1

Der Ausdruck in eckigen Klammern ist das geometrische Mittel (GM) der ai ;also gilt GM ≤

AM .Ersetzt man ai durch 1/ai ,schreibt sich die letztere Ungleichung wie folgt:

n

n

Y

1

ai

1X 1

≥

n

ai

i=1

!1/n

i=1

Oder äquivalent :

1

n

1

Pn

1

i=1 ai

≤

n

Y

!1/n

ai

i=1

Der Ausdruck auf der linken Seite ist das harmonische Mittel (HM) der ai ;ingesamt gilt also die

Ungleichungskette:

HM ≤ GM ≤ AM.

Gleicheit besteht nur dann,wenn alle ai identisch sind.Allgemeiner gilt,dass das (gewichtete)

Potenzmittel der Ordnung r:

n

X

mr =

!1/r

wi ari

, wi ≥ 0,

i=1

n

X

wi = 1

i=1

eine monoton wachsende Funktion von r ist.Dabei entspricht wi = 1/n und r = 1 dem AM, r =

−1 dem HM und r → 0 dem GM. (Letzteres zeigt man mittels der Regeln von De L’Hospital.)

2.3

Kimball Ungleichung

Seien u(x) und v(x) beide nicht wachsende oder beide nicht fallende Funktionen.Dann ist:

Eu(X)Ev(X) ≤ E(u(X)v(X))

Beweis: Wir verwenden die Hoeffding Lemma

Z Z

Cov(u(X), v(X)) =

{P (u(X) < s, v(X) < t) − P (u(X) < s)P (v(X) < t)}dsdt

(1)

Da u(x) und v(x) beide nicht wachsend oder beide nicht fallend,wir haben

P (u(X) < s, v(X) < t) = min{P (u(X) < s), P (v(X) < t)} ≥ P (u(X) < s)P (v(X) < t).

Zusammen mit (1) erhalten wir die gewünschte Ungleichung,da die Cov(u(X), v(X)) ≥ 0,was

ist äquivalent zu E(u(X)v(X)) ≥ Eu(X)Ev(X).

5

2.4

Freedman Ungleichung

Sei X eine Zufallsvariable mit |X| ≤ 1, EX = 0 und σ 2 = V ar(X), λ > 0,dann gilt :

exp{(e−λ − 1 + λ)σ 2 } ≤ E exp(λX) ≤ exp{(eλ − 1 − λ)σ 2 }

Beweis: Zuerst wollen wir die 2.(rechte) Ungleichung zeigen mit Hilfe von TaylorreicheEntwicklung:

∞

∞

k=3

k=3

X λk

X λk

1

1

EX k ≤ 1 + λ2 σ 2 +

σ2

E exp(λX) = 1 + λ2 σ 2 +

2

k!

2

k!

∞

X

λk 2

σ ) = exp(σ 2 (eλ − 1 − λ))

≤ exp(

k!

k=2

Jetzt wollen wir die erste Ungleichung zeigen.Wir setzen.dass :

g(λ) = E exp(λX) − exp{(e−λ − 1 + λ)σ 2 }

Es ist einfach zu prüfen,dass :

g 0 (λ) = EXeλX − σ 2 (1 − e−λ ) exp{(e−λ − 1 + λ)σ 2 }

g 00 (λ) = EX 2 eλX − σ 2 e−λ − σ 4 (1 − e−λ )2 exp{(e−λ − 1 + λ)σ 2 }

Es ist zu bemerken,dass g(0) = g 0 (0) = g 00 (0).Um zu zeigen,dass g(λ) ≥ 0, für alle λ > 0,wir

sollen nur,zeigen dass g 00 (λ) ≥ 0, für alle λ > 0.

Bemerken wir,dass X ≥ 1 und EX 2 eλX − σ 2 e−λ = EX 2 eλX − e−λ , ∀ λ > 0,wir sollen noch

nur zeigen dass:

σ 2 e−λ − σ 2 e−λ − σ 4 (1 − e−λ )2 exp{(e−λ − 1 + λ)σ 2 } ≥ 0.

Das ist äquivalent zu:

h(λ) ≡ exp −σ

2

−λ

e

2 −λ

2

eλ

−1+λ − 1−σ 1−e

(2)

Wir erhalten einfach,dass:

h0 (λ) = σ 2 e−λ − 1 exp −σ 2 e−λ − 1 + λ + σ 2 eλ − e−λ

≥ σ 2 (1 − e−λ ) 1 − exp(−σ 2 (e−λ − 1 + λ))

wobei die letzte Schritt folgt,da e−λ − 1 + λ > 0,fr̈ alle λ > 0. (2) folgt von oben und h(0) = 0.

Dann ist die erste Ungleichung komplett.

6

2.5

Exponential Moment der oben abgeschnittenen Variablen

Satz. Sei X eine Zufallsvariable mit EX = 0 Sei a > 0 und 0 ≤ α ≤ 1.Dann für alle t ≥ 0 wir

haben:

2

t2+α eta E|X|2+α

t

2

EX +

E exp(tXI(X ≤ a)) ≤ exp

2

(α + 1)(α + 2)

Beweis: Für u ≤ u0 wir haben

1

e − 1 − u − u2 =

2

u

Z

uZ s

0

0

=

Z

(e − 1)dwds ≤ w

0

|u|2+α eu0

(α + 1)(α + 2)

Dann ist:

E exp(tXI(X ≤ a))

= 1 + tEXI(X ≤ a) +

t2

2

2 EX I(X

≤ a) +

t2+α eta E|X|2+α

(α + 1)(α + 2) t2+α eta E|X|2+α

2

≤ exp t2 EX 2 +

(α + 1)(α + 2)

≤1+

t2

2

2 EX

t2+α eta E|X|2+α

(α + 1)(α + 2)

+

7

uZ s

0

|w| e dwds

α u0

3

Schätzung von Momenten der Summen von Zufallsvariablen

Eigenschaften von Partialsummenfolge von Zufallsvariablen spielen eine größe Rolle in Wahrscheinlichkeitstheorie.Daher ist die Schätzung von Momenten der Summen von Zufallsvariablen sehr

wichtig in der Forschung von Abschätzung Methoden.In diesem Kapitel werden wir einige

wichtigste Ungleichungen,wie Minkowski,Bahr-Esseen,Khintchine,Marcinkiewics-Zygmund-Berkholder

und Doob Ungleichungen, vorstellen.

3.1

Elementare Ungleichungen

Sei X1 , · · · , Xn Zufallsvariablen und Sn =

n

X

Xi

i=1

cr -Ungleichung

E|Sn |r ≤ cr

n

X

|Xi |r

i=1

,wobei cr = 1 für 0 < r ≤ 1 oder nr−1 für r > 1.

Beweis: 1. Fall: r > 1 : Sei ξ Zufallsvariable,die in Wahrscheinlichkeit die Werte a1 , · · · , an

hat,dann

n

n

1X

1X

r

E|ξ| =

|ai |,

E|ξ| =

|ai |r

n

n

i=1

i=1

Mit der Jensen’sche Ungleichung können wir einfach merken,dass

!r

n

n

1X

1 X

|a

|

≤

|ai |r .

i

nr

n

i=1

i=1

2. Fall: 0 < r ≤ 1.Das ist nur notwendig,wenn nicht alle a1 , · · · , an gleich 0 sind.Dann ist

|a |

|ak |r

Pn k

≤ Pn

( i=1 |ai |)r

i=1 |ai |

k = 1, · · · , n

Durch Hinzufügen aller Ungleichungen oben,können wir die gewünschte Ungleichung erhalten.

Spezialfall Sei 1 ≤ r ≤ 2.Falls X1 , · · · , Xn unabhängige und symmetrische Zufallsvariblen

sind(dh.dass X gleiche Verteilung wie −X hat.),dann:

r

E|Sn | ≤

n

X

E|Xi |r

i=1

Beweis: Für n = 1 ist die Ungleichung trivial.Wir machen den Beweis mit der Induktion.Angenommen dass m fix ist und 1 ≤ m < n.Sei fm (t) stetige Funktion von Xm+1 (im Allgemein fm (t) = E[exp(itXm+1 )|Sm ]).Da Xi symmetrisch für i = 1, · · · , n =⇒ fm (t) ∈ R.Dann

haben wir,dass

Z

1 − cos(tSm )fm (t)

r

E[|Sm+1 | |Sm ] = K(r)

dt f.s

|t|r+1

Γ(r + 1)

rπ

sin( ).Aber

π

2

1 − cos(tSm )fm (t)

= (1 − cos(tSm )) + (1 − fm (t)) − (1 − cos(tSm ))(1 − fm (t))

,wobei K(r) =

8

≤ (1 − cos(tSm )) + (1 − fm (t))

Dann ist

Z

r

E(|Sm+1 | |Sm ) ≤ K(r)

1 − cos(tSm )

dt + K(r)

|t|r+1

Z

1 − fm (t)

dt

|t|r+1

= |Sm |r + E(|Xm+1 |r |Sm ).

Wenn wir noch Erwartungwerte reingeben,erhalten wir :

E|Sm+1 |r ≤ E|Sm |r + E(|Xm+1 |r )

. Dann ist die Ungleichung mit dem Induktion gezeigt.

3.2

Minkowski Ungleichung

Minkowski Ungleichung wird in unterschierdlichen Versionen formuliert,meißt für den Folgenraum `p sowie die Lebesque Räume Lp und Lp .Ich werde die Minkowski Ungleichung in Wahrscheinlichkeitstheorie vorstellen.

Satz (Minkowski Ungleichung).

r 1/r

X

n

X

n

E

X

≤

(E|Xj |r )1/r

j

j=1 j=1

E

n

X

r 1/r

|Xj |

>

j=1

n

X

(E|Xj |r )1/r

f ur r ≥ 1;

f ur 0 < r < 1.

j=1

.

Beweis: Es ist klar,dass wir nun der Fall n = 2 betrachten müssen.Sei r > 1.Mit der Hölder

Ungleichung gilt :

E|X1 + X2 |r = E(|X1 + X2 ||X1 + X2 |r−1 ) ≤ E(|X1 ||X1 + X2 |r−1 ) + E(|X2 ||X1 + X2 |r−1 )

≤ ((E|X1 |r )1/r + (E|X2 |r )1/r )(E|X1 + X2 |r )(r−1)/r .

Dividieren beide Seite durch (E|X1 + X2 |r )(r−1)/r erhalten wir:

E|X1 + X2 |r

≤ (E|X1 |r )1/r + (E|X2 |r )1/r ,

(E|X1 + X2 |r )(r−1)/r

was genau die erste Ungleichung ist.Ähnlich können wir die zweite Ungleichung mit der Hilfe

von Verallgemeinerte Höldersche Ungleichung beweisen,die für den Fall 0 < r < 1 gilt.

Satz.

E

n

X

r

|Xj | ≥

j=1

E

n

X

j=1

n

X

E|Xj |r , f ur r ≥ 1;

j=1

r

|Xj | <

n

X

E|Xj |r , f ur 0 < r < 1.

j=1

9

.P

Beweis: Wir sollen bemerken,dass für r ≥ 1, |Xj | ( nk=1 |Xk |r )r−1 ≤ 1 , ∀j = 1, · · · , n.

Dann haben wir:

Pn

Pn

r

j=1 |Xj |

j=1 |Xj |

P

≥

= 1,

P

n

r

( nk=1 |Xk |r )1/r

k=1 |Xk |

was aber führt zur erste Ungleichung.Die zweite Ungleichung können wir klar anschauen,da die

Unglechung oben die umgekehrte Richtung,wenn 0 < r < 1, hat.

Das Fall 1 ≤ r ≤ 2

Satz (Bahr-Essen Ungleicung). Sei 1 ≤ r ≤ 2 und seien X1 , · · · , Xn die unabhängige Zuvallsvariable.Dann gilt :

r !

n

n

X

X

−1

E Xi ≤ (2 − n )

E(|Xk |r ).

i=1

k=1

Das Fall r ≥ 2 :

Sei r ≥ 2 und X1 , · · · , Xn die Martingaldifferenzenfolge.Dann ist:

r

E|Sn | ≤ Cr n

r/2−1

n

X

E|Xj |r ,

j=1

wobei Cr = (8(r − 1) max(1, 2r−3 )).

3.3

Khintchine Ungleichung

Die Khintchin-Ungleichung,benannt nach Aleksandr Jakovlevich Khintchine,ist eine Ungleichung

aus dem mathematischen Teilgebiet der Funktionalanalysis.Hier werden wir nur die Ungleichung

für die Wahrscheinlichkeitstheorie vorstellen.

Satz. Seien X1 , · · · , Xn iid. Zufallsvariablen mit P (X1 = 1) = P (X1 = −1) = 21 und seien

b1 , · · · , bn beliebige reelle Zahlen.Dann ∀r > 0∃ Konsanten 0 < Cr ≤ Cr0 ,sodass:

r

r/2

r/2

n

n

n

X

X

X

Cr

b2j ≤ E bj Xj ≤ Cr0

b2j .

j=1

j=1

j=1

3.4

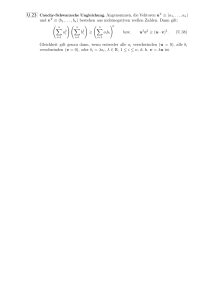

Marcinkiewicz-Zygmund Ungleichung

Satz. Sei r ≥ 1, X1 , X2 , · · · unabhängige Zufallsvariable mit E(Xn ) = 0 für n = 1, 2, · · · .Dann

existieren positive Konstanten ar ≤ br sodass

r/2

r/2

k

k

X

X

ar E

Xj2 ≤ E(|Sn |r ) ≤ br E

Xj2 ,

j=1

j=1

r/2

r/2

∞

∞

X

X

ar E

Xj2 ≤ sup E(|Sn |r ) ≤ br E

Xj2 .

j=1

n≥1

j=1

10

Beweis: Nach der cr -Ungleichung und Monotonie der Summe von Momenten haben wir

1/2

k

X 2

E(|Sn |r ) < ∞ ⇐⇒ E(|Xj |r ) < ∞ j = 1, · · · , n ⇐⇒ E

Xj

< ∞.

j=1

Daher kann man davon ausgehen, dass diese wahr ist.Sei {Xn0 , n ≥ 1} eine i.i.d. mit {Xn , n ≥ 1

und Xn∗ = Xn − Xn0 .Außerdem sei {Vn , n ≥ 1 eine i.i.d Folge von Zufallsvariablen mit P (V1 =

1) = P (V1 = −1) = 21 ,die unabhängig von {Xn , Xn0 , n ≥ 1} ist.Da

n

k

X

X

∗

E

Vj Xj |V1 , · · · , Vn , X1 , · · · Xn =

Vj Xj ,

j=1

j=1

folgt für jede natürliche Zahl n ≥ 1 ,dass

zur ersten Ungleichung führt

nP

k

j=1 Vj Xj ,

o

∗ zwei-Term Martingal ist,was

V

X

j

j

j=1

Pk

r

r r

r

X

X

X

X

X

k

k

k

k

k

∗

r−1

0

r E

Vj Xj ≤ E Vj Xj ≤ 2 E Vj Xj + =2 E

Vj Xj Vj Xj . (3)

j=1

j=1

j=1

j=1

j=1

r

X

k

Verwenden wir die Khintchine Ungleichung auf E = 2r E Vj Xj |X1 , X2 , · · · ,wir erhal

j=1

ten

r

r/2

r/2

n

n

n

X

X

X

Cr E

Xj2 ≤ E Vj Xj ≤ Cr0 E

Xj2 ,

j=1

j=1

j=1

,was im Zusammenhang mit (3) folgt zu

Cr E

n

X

j=1

r/2

Xj2

r

r/2

n

n

X

X

≤ E Vj Xj∗ ≤ 2r Cr0 E

Xj2 .

j=1

j=1

(4)

Mit der Symmetrie von Xj∗ erhalten wir

r

r

r

X

X

X

n

n

n

r

∗

∗

E Vj Xj = E Xj ≤ 2 E Xj .

j=1

j=1

j=1 Andererseits erhalten wir mit der Monotonie von der Summe von Momenten,dass :

r

r

r

X

X

X

n

n

n

∗

∗

Xj .

Xj ≥ E Vj Xj = E E

j=1 j=1

j=1

Wenn man diese 2 Ungleichungen in (4) einsetzt, ergibt sich die erste gewünschte Ungleichung,

die die zweite sofort impliziert.

11

3.5

Doob Ungleichungen

Satz. Sei {Yn , An , n ≥ 1} ein nichtnegative Submartingal.Dann :

e

(1 + E(Yn log + Yn )),

E max Yj ≤

1≤j≤n

e−1

e

E sup Yn ≤

(1 + sup E(Yn log + Yn )),

e

−

1

n≥1

n≥1

und für p > 1 ,

p

p

≤

E

EYnp ,

p−1

p

p

p

E sup Yj ≤

sup EYnp .

p − 1 n≥1

n≥1

max Y p

1≤j≤n j

Beweis: Wir sollen nur erste und dritte Ungleichung zeigen.Die zweite Ungleichung folgt aus

der erste und die vierte aus der dritte.

Sei Yn∗ = max .Für eine Zufallsvariable X ≥ 0 mit E(X p ) < ∞ und für Verteilungsfunktion

1≤j≤n

F (x),beim Verwendung des partielle Integration erhalten wir

Z ∞

p

E(X ) = p

tp−1 (1 − F (t))dt, p > 0.

(5)

0

Und somit unter verwendung der Doob Ungleichung (siehe [Lin,Bai] 6.5.a) erhalten wir

Z ∞

∗

∗

+

EYn − 1 ≤ E(Yn − 1) =

P (Yn∗ − 1 ≥ x)dx

0

Z

∞

≤

0

1

x+1

Z Yn∗ −1

= EYn

0

Z

{Yn∗ ≥x+1}

Yn dP dx

1

dx = EYn logYn∗ .

x+1

Wir brauchen folgende Elementare Ungleichung.Für konstante a ≥ 0 und b > 0, a log b ≤

a log+ a + be−1 .Sei g(b) = log+ a + be−1 .Dann g 00 (b) = a/b2 > 0 und g 0 (ae) = e−1 − a/(ae) =

0.Dann ist g(ae) = a log+ a − a log a ≥ 0 Minimum von g(b).Die Ungleichung ist gezeigt.Mit der

Anwendenung von dieser Ungleichung,erhalten wir

EYn∗ − 1 ≤ EYn log+ Yn + e−1 EYn∗ ,

von welche wir sofort die erste Ungleichung erhalten.

Wenn p > 1,mit der Verwendung von (5),[Lin,Bai] 6.5.a, und die Höldersche Ungleichung,erhalten

wir:

Z ∞

EYn∗ = p

xp−1 P (Yn∗ ≥ x)dx

Z ∞ 0 Z

≤p

xp−2

Yn dP dx

0

{Yn∗ ≥x}

12

Z

Yn∗

xp−2 dx

= pEYn

0

p

=

EYn (Yn∗ )p−1

p−1

p

≤

(EYnp )1/p (EYn∗p )(p−1)/p ,

p−1

was aber folgt zum dritte Ungleichung.

13

4

Ungleichungen im Zusammenhang mit assoziativen Variablen

In diesem Kapitel werden wir andere Klasse von abhängige Variablen vorstellen.

Zwei Zufallsvariablen X und Y sind positive Quadrant abhängig (PQD) (engl. positive quadrant

dependent),wenn P (X > x, Y > y) ≥ P (X > x)P (Y > y), ∀x, y.

Sie sind negative Quadrant abhängig (NQD),wenn P (X > x, Y > y) ≤ P (X > x)P (Y > y).

Die Menge von n Zufallsvariblen X1 , · · · , Xn nennt man positive assoziativ (PA),wenn für eine

Koordinatenweise nichtfallende Funktionen f und g auf Rn , Cov(f (X1 , · · · , Xn ), g(X1 , · · · , Xn )) ≥

0 immer,wenn Kovarianz existiert.

Die Menge nennt man negativ assoziativ,wenn für zwei disjunkte Menge A, B ⊂ {1, · · · , n}

und für nichtfallende Funktionen f auf RA und g auf RB , Cov(f (Xk , k ∈ A), g(Xj , j ∈ B)) ≤ 0.

Eine unendliche Familie von Zufallsvariablen nennt man

X linear positive

X Quadrant abhängig

(LPQD),wenn für disjunkte Menge A, B und positive a0j s

ak Xk und

aj Xj sind PQD.Analog

k∈A

j∈B

für linear negative Quadrant abhängige Familie (LNQD).

Die unendliche Familie von Zufallsvariablen nennt man positive (bzw. negative) assoziativ,wenn

jede endliche Teilmenge PA (bzw. NA) ist.

Bemerkung 5.1: Klarerweise für ein Paar von Zufallsvariablen PQD (bzw. NQD) ist äquivalent

zu PA (bzw. NA).Für eine Familie von Zufallsvariblen,aus PA (bzw. NA) folgt LQPD (bzw.

NQPD).

PQD kann in vielen Situationen eine sehr realistische Annahme sein. Denken von zB. Lebenserwartung von Männern und Frauen in verschiedenen Ländern.Man würde erwarten, dass die

höhere Lebenserwartung für Männer in einem Land mit einer höheren Lebenserwartung für

Frauen geht.Anwendung von PQD hat eine besondere Bedeutung in Finanz- und Versicherungsgebiet.

4.1

Kovarianz von PQD Variablen

Satz. Wenn X und Y PQD (bzw. NQD) Zufallsvariablen sind,dann gilt

E(XY ) ≥ E(X)E(Y )

(bzw. E(XY ) ≤ E(X)E(Y )).

wenn die Erwartungswerte existieren.Die Gleichung gilt dann und genau dann,wenn X und Y

unabhängig sind.

Beweis:

Wir werden nur PQD Fall betrachten.F bezeichnet gemeinsame und FX , FY die Randverteilungen von X und Y .Dann haben wir,dass

Z Z

E(XY ) − E(X)E(Y ) =

(F (x, y) − FX (x)FY (y)dxdy,

,was aber gleich folgt zum unsere gewünschte Ungleichung.

Jezt nehmen wir an,dass die Gleicheit gilt.Dann ist F (x, y) = FX (x)FY (y) f.ü.Da die Verteilungsfunktionen rechtsstetig sind,dann ist offensichtlich,dass wenn 2 Verteilungsfunktionen gleich f.ü.

bzgl. Lesbequemaß sind,sie müssen überall gleich sein.Dann sind X und Y unabhängig.

4.2

Wahrscheinlichkeit von Quadrant auf PA (NA) Folgen

Satz. Seien X1 , · · · , Xn PA (bzw. NA) Zufallsvariablen, Yj = fj (X1 , · · · , Xn ) und sei fj eine

nicht fallende Funktion für j = 1, · · · k.Dann gilt für x1 , · · · , xk

14

P

k

\

k

Y

(Yj ≤ xj ) ≥

P (Yj ≤ xj )

j=1

bzw.

P

j=1

k

\

k

Y

(Yj ≤ xj ) ≤

P (Yj ≤ xj ) ,

j=1

P

k

\

j=1

k

Y

(Yj > xj ) ≥

P (Yj > xj )

j=1

bzw.

P

j=1

k

\

k

Y

(Yj > xj ) ≤

P (Yj > xj ) .

j=1

j=1

Beweis: Wir betrachten nur das PA Fall.Nach der Definiton sind Y1 , · · · , Yk PA (da Xi PA

sind).Sei Aj = {Yj > xj }.Dann ist Ij := I(Aj ) nicht fallend in Yj und I1 , · · · , Ik sind PA.Wir

untersuchen wachsende Funktionen f (t1 , · · · tk ) = t1 und g(t1 , · · · tk ) = t1 , · · · tk .f (I1 , · · · , Ik )

und g(I1 , · · · , Ik ) sind PA und nach dem vorigen Satz (+Bemerkung 5.1 ) ist

E(I1 , · · · , Ik ) ≥ E(I1 )E(I2 , · · · , Ik ).

Wenn wir dieser wieder verwenden erhalten wir

E(I1 , · · · , Ik ) ≥ E(I1 ) · · · E(Ik ).

Somit ist die zweite Undgleichung bewiesen.

Als für die erste Teil des Beweises,untersuchen wir 1 − Ij statt Ij .Sei f 0 (t1 , · · · tk ) := 1 − f (1 −

t1 , · · · , 1 − tk ) und g 0 (t1 , · · · tk ) := 1 − g(1 − t1 , · · · , 1 − tk ).Die beide Funktionen sind wachsend.Dann ist

Cov(f (1 − I1 , · · · , 1 − Ik ), g(1 − I1 , · · · , 1 − Ik )) = Cov(f 0 (I1 , · · · , In ), g 0 (I1 , · · · , In )) ≥ 0.

Das impliziert die erste Ungleichung.

4.3

Maximal Partialsumme von PA Folge

Satz. Seien X1 , · · · , Xn PA Zufallsvariablen mit Mittelwert gleich 0 und endliche Varianz.Seien

k

X

Sk =

und Mn = max Sk .Dann gilt:

j=1

1≤k≤n

E(Mn2 ) ≤ V ar(Sn )

Beweis: Definiere Kn := min{0, X2 + · · · + Xn , X3 + · · · + Xn , Xn },

Ln := max{X2 , X2 + X3 , · · · , X2 + · · · Xn }, Jn := {0, Ln } und bemerken wir dass Kn = X2 +

· · · Xn − Jn eine nicht fallende Funktion von Xj0 s ist,sodass Cov(X1 , Kn ) ≥ 0.Dann

E(Mn2 ) = E(X1 + Jn )2 = V ar(X1 ) + 2Cov(X1 , Jn ) + E(Jn2 )

= V ar(X1 ) + 2Cov(X1 , X2 + · · · + Xn ) − 2Cov(X1 , Kn ) + E(Jn2 )

15

≤ V ar(X1 ) + 2Cov(X1 +, X2 + · · · Xn ) + E(L2n ).

(6)

Machen wir weiter mit Induktion fúr n.Dann folgt,dass E(L2n ) ≤ V ar(X2 + · · · + Xn ).Zussamen

mit (6) ist der Beweis fertig.

Satz. Sei s2n = E(Sn2 ).Wir haben dann für jede x ≥ 2

P { max |Sj | ≥ xsn } ≤ 2P {|Sn | ≥ (x −

1≤j≤n

√

2)sn }

Beweis: Sei Sn∗ = max(0, S1 , · · · Sn ) und 0 ≤ x1 < x2 ,

∗

∗

P {Sn∗ ≥ x2 } ≤ P {Sn ≥ x1 } + P {Sn−1

≥ x2 , Sn−1

− Sn > x2 − x1 }

∗

∗

≤ P {Sn ≥ x1 } + P {Sn−1 ≥ x2 }P {Sn−1 − Sn > x2 − x1 }

∗

∗

≤ P {Sn ≥ x1 } + P {Sn−1

≥ x2 }E((Sn−1

− Sn )2 /(x2 − x1 )2 ).

∗

∗

Wir haben hier die Tatsache,dass Sn−1

und Sn − Sn−1

PA sind (da be beide nicht fallende

0

Funktionen von Xj s sind) ,verwendet.Jeztz von dem vorigen Satz,ersetzen wir Xj beim Yj =

−Xn−j+1 .Das ergibt

∗

E((Sn−1

− Sn )2 ) = E(max(Y1 , Y1 + Y2 , · · · , Y1 + · · · + Yn )2 ) ≤ E(Sn2 ).

√

Dann wir haben für (x2 − x1 )2 ≥ 2

P {Sn∗ ≥ x2 } ≤ (1 − s2n /(x2 − x1 )2 )−1 P {Sn ≥ x1 }.

(7)

Beim addieren √

(7) zu analog Ungleichung,wo jede Xj ist durch −Xj ersetzt und wählen x2 =

xsn , x1 = (x − 2)sn ,erhalten wir gewünschte Ungleichung. 16

5

Ungleichungen über Stochastiche Prozesse

In disem Kapitel werden wir einige wichtige Ungleichungen über die Stochastische Prozesse

vorstellen.Zuerst errinern wir uns an der Definitionen von Brownsche Bewegung (Wiener Prozess)

und Poisson Prozess.

Ein Stochastischer Prozess {W (t), t ≥ 0},definiert auf dem Wahrscheinlichkeitsraum (Ω, F, P ),heißt

Brownsche Bewegung (oder Wiener Prozess) wenn:

(i) ∀ ω ∈ Ω ⇒ W (0, ω) ≡ 0 und ∀ 0 ≤ s ≤ t ⇒ W (t) − W (s) ∈ N (0, t − s)

(ii) W hat f.s. stetige Pfade

(iii) für 0 ≤ t1 ≤ t2 ≤ · · · ≤ t2n−1 ≤ t2n ,die Inkremente W (t2 ) − W (t1 ), · · · , W (t2n−1 ) − W (t2n )

sind unabhängig.

Ein Stochastischer Prozess {N (t), t ≥ 0} heißt Poisson Prozess,wenn:

∀ k ≥ 1 und ∀ 0 ≤ t1 ≤ t2 ≤ · · · ≤ tk , N (t1 ), N (t2 ) − N (t1 ), · · · , N (tk ) − N (tk−1 ) unabhängige

Poisson Zufallsvariablen mit Mittelwert t1 , t2 − t1 , · · · , tk − tk−1 sind.

5.1

Schätzung von Wahrscheinlichkeit des Supremum von Brownscher Bewegung

Satz. ∀ x ≥ 0 gilt:

sup W (s) ≥ x

P

= 2P {W (t) ≥ x},

0≤s≤t

P

inf W (s) ≤ −x

0≤s≤t

P

sup |W (s)| ≥ x

= 2P {W (t) ≤ −x},

≤ 2P {|W (t)| ≥ x} = 4P {W (1) ≥ xt−1/2 }.

0≤s≤t

Beweis: Wir sollen nur die erste Gleichung zeigen,da die zweite Gleichung folgt aus der Symmetrie der Brownsche Bewegung und dritte Ungleichung folgt aus der Kombination der erste

zwei Gleichungen.Also wenn x = 0 ,die 2 Gleichungen und die Ungleichung gelten trivial.So

nehmen wir in unser Beweis an,dass x > 0.

Zuerst beweisen wir das Reflektionsprinzip der Brownscher Bewegung.Sei W (s), 0 ≤ s ≤ t ≤ ∞

eine Brownsche Bewegung, x ∈ R und S sei dei Stopzeit,dann ist W 0 (s) auch eine Brownsche

Bewegung auf [0, t],wobei:

W 0 (s) = W (s),wenn 0 ≤ s ≤ S ∧ t und W 0 (s) = 2W (S) − W (s),wenn S ∧ t < s ≤ t.

Mit starke Markov Eigenschaft von der Brownscher Bewegung folgt,dass W (s), s > S ∧ t ist

unabhängig von W (k), k ≤ S ∧ t.Mit der Symmetrie der Brownscher Bewegung

{W (S + s) − W (S), s ≥ 0} hat die gleiche Verteilung wie {W (S) − W (S + s), s ≥ 0}. Dann

sind W und W 0 gleich verteilt.Jetzt wollen wir zum Beweis von die erste Gleichung zuruckkommen.Offensichtlich haben wir:

P sup W (s) ≥ x = P sup W (s) ≥ x; W (t) ≥ x + P sup W (s) ≥ x; W (t) < x

0≤s≤t

0≤s≤t

0≤s≤t

Da aus {W (t) ≥ x} folgt { sup W (s) ≥ x},wir haben :

0≤s≤t

P sup W (s) ≥ x; W (t) ≥ x = P (W (t) ≥ x)

0≤s≤t

Mit dem Reflektionsprinzip haben wir dann

17

(8)

P

0

0

sup W (s) ≥ x; W (t) < x = P sup W (s) ≥ x; W (t) > x = P (W (t) > x)

0≤s≤t

(9)

0≤s≤t

Aus (8) und (9) gilt die erste Gleichung und damit ist unser Beweis fertig

Satz. Für alle x > 0 gilt:

Z x

2

2

e−u /2 du,

sup W (t) ≤ x = √

2π 0

0≤t≤1

4

1 −9π2 /8x2

2

2

≤ P sup |W (t)| < x ≤ e−π /8x .

− e

3

π

0≤t≤1

P

4

π

2

2

e−π /8x

Beweis: Die erste Gleichung folgt aus der erste Gleichung des voriges Satzes.Um die Ungleichung zu zeigen,sollen wir zuerst zeigen,dass

P

Z (2k+1)x

∞

1 X

2

sup |W (t)| < x = √

e−t /2 dt

(−1)k

2π k=−∞

0≤t≤1

(2k−1)x

Definiere τ0 := inf{t ≤ 1; |W (t)| > x} und τ1 := inf{t ≤ 1; |W (t)| < −x}.Mit dem Induktion

definiere ζk := inf{t ∈ (τk , 1]; W (t > x)} und τk+1 := inf{t ∈ (ζk , 1]; W (t) < −x},wobei

wir verwenden die Konvention inf{t ∈ ∅} = 2.Wir müssen bemerken,dass die beide τ und

ζ Stopzeiten sind. Sei K die Anzahl von der Überschreitungen (jeweils von der oberen und

unteren Schranke) (engl. crossings) von die Brownsche Bewegung {W (t), t ∈ [0, 1]} über das

Intervall [−x, x].Dann :

P sup |W (t)| < x

0≤t≤1

= P {W (1) ∈ [−x, x]} − P sup |W (t)| ≥ x; W (1) ∈ [−x, x]

0≤t≤1

= P {W (1) ∈ [−x, x]} − 2P sup |W (t)| ≥ x; W (τ0 ) = x, W (1) ∈ [−x, x]

0≤t≤1

= P {W (1) ∈ [−x, x]} − 2

= P {W (1) ∈ [−x, x]} − 2

∞

X

P {W (τ0 ) = x, K = k, W (1) ∈ [−x, x]}

k=0

∞

X

(−1)k P {W (τ0 ) = x, K ≥ k, W (1) ∈ [−x, x]}.

k=0

Mit dem Reflektionsprinzip (wobei Reflektion über x bei ζk+2/2 , · · · , ζ1 und Reflektion über −x

bei τk/2 , · · · , τ1 . ) wir haben :

P {W (τ0 ) = x, K ≥ k, W (1) ∈ [−x, x]} = P (W (1) ∈ [(2k + 1)x, (2k+)x]).

Dann ist die behauptete Identität bewiesen durch

P (W (1) ∈ [(2k + 1)x, (2k+)x]) = P (W (1) ∈ [−(2k + 1)x, −(2k+)x]).

Dann definieren wir h,sodass h(t) = 1,wenn 0 < t < x;und h(t) = −1,wenn x < t < 2x ;

h(t) = h(−t); h(t) = h(t + x). Mit der Fourier Entwicklung wir haben:

18

∞

4 X (−1)k

2k + 1

h(t) =

cos

πt .

π

2k + 1

2x

k=0

Bei was beweisen ist,wir haben

Z (2k+1)x

∞

1 X

2

k

√

P sup |W (t)| < x =

e−t /2 dt

(−1)

2π k=−∞

0≤t≤1

(2k−1)x

Z ∞

Z ∞

∞

1

4 X (−1)k 1

(2k + 1)π

2

2

√

=√

h(t)e−t /2 =

e−t /2 cos

t dt

π

2k + 1 2π −∞

2x

2π −∞

k=0

∞

X

(−1)k

(2k + 1)2 π 2

.

= π4

exp −

2k + 1

8x2

k=0

wobei wir haben verwenden die Tatsache,dass

Z ∞

1

2

2

√

e−t /2 cos(αt)dt = e−α /2

2π −∞

Wähle nur der Term k = 0,dann haben wir die RHS Ungleichung,und beim 3 Term k = −1, 0, 1

wir haben LHS Ungleichung. Bemerkung: Die Serienentwicklung von P sup |W (t)| < x in der obigen Beweis ist selbst

0≤t≤1

eine wichtige Folgerung.

5.2

Schätzung von Wahrscheinlichkeit des Supremum von Poisson Prozess

Sei ψ(t) = 2h(t + 1)/t2 mit h(t) = t(log t − 1) + 1,für t > 0.

Satz. Es gilt

2 2 sup0≤t≤b (N (t) − t)±

x

±x

√

≥ x ≤ exp

ψ √

2

b

b

√

für alle x > 0 in ” + ” Fall und für 0 ≤ x ≤ b in ” − ” Fall.

P

Beweis: ∀ r > 0 , {exp(±r(N (t) − t)), 0 ≤ t ≤ b} sind beide Submartingale.Dann mit dem

stetigen Parameter von die Doob Ungleichung (siehe [LIN,BAI] 6.5.a)gilt:

(

)

P

sup (N (t) − t)± ≥ x

(

0≤t≤b

= inf P

r>0

)

sup exp(±r(N (t) − t)) ≥ exp(rx)

0≤t≤b

≤ inf exp(−rx)E exp(±r(N (b) − b))

r>0

±r

≤ inf exp{−rx + b(e

r>0

2

− 1) ∓ rb} = exp −(x /2b)ψ

±x

b

Hier ist das Minimum durch Differenzierung der Exponent und lösen erreicht.Jeztz ersetzen wir

√

x durch x x und bekommen die gewünschte Ungleichung. 19

6

Literaturverzeichnis

[1] Zhengyan Lin und Zhidong Bai. Probability Inequalitites. Springer Berlin Heidelberg, 2010.

[2] Vladimir V. Petrov. Limit Theorems of Probability Theory:Sequences of Independent Random Variables. Oxford Science Publications, 1995.

[3] Lehmann E L. Some concepts of dependence. The Annals of Mathematical Statistics,1966.

[4] Norbert Kusolitsch. Maß- und Wahrscheinlichkeitstheorie: Eine Einführung . SpringerVerlag, 2014.

[5] Irene Gijbels, Marek Omelka und Dominik Sznajder. Positive quadrant dependence tests

for copulas. The Canadian Journal of Statistics,2010.

20