DHBW Mannheim - DHBW Stuttgart

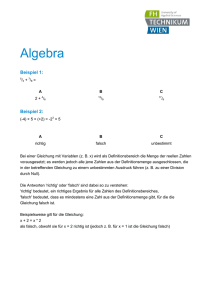

Werbung