1 Elementare Wahrscheinlichkeitstheorie

Werbung

1

Elementare Wahrscheinlichkeitstheorie

1.1

Zufallsexperiment

Definition 1.1. Ein Zufallsexperiment ist ein ”Vorgang”, der im Prinzip

beliebig oft unter identischen Randbedingungen wiederholt werden kann.

Damit ist natürlich jedes naturwissenschaftliche Experiment auch ein Zufallsexperiment (was ja auch stimmt: Bei jeder Messung werden Fehler gemacht!).

Interessant sind für uns insbesondere solche Experimente, deren Ergebnisse aufgrund der Komplexität der Randbedingungen nicht mit Sicherheit vorhergesagt

werden können. Das klassische Beispiel ist der Münzwurf oder der Würfelwurf.

Definition 1.2. Die Menge der möglichen Ergebnisse eines Zufallsexperimentes

heißt der Ereignisraum Ω.

Beispiel 1.3.

1. Im Fall des Würfels ist Ω = {1, 2, 3, 4, 5, 6}.

2. Beim Lotto “6 aus 49” ist Ω = {A ⊂ {1, . . . , 49} : |A| = 6}.

3. Beim Münzwurf gilt Ω = {Kopf, Zahl}.

4. Wir können auch eine Reißzwecke werfen und die möglichen Ausgänge

sind dann “bleibt auf dem Kopf liegen (Stachel zeigt nach oben)” oder

“fällt auf die Seite”. Hier ist von vornherein nicht klar, wie “wahrscheinlich” welcher Ausgang des Zufallsexperimentes ist: Man muß einfach oft

genug eine Reißzwecke (oder einmal ganz viele) werfen und die “relativen

Häufigkeiten” auszählen.

5. Wenn wir mit zwei Würfeln werfen und als Ausgang des Experimentes die

Summe der Augenzahlen nehmen, dann haben wir ein Zufallsexperiment

mit Ω = {2, 3, . . . , 12}.

Definition 1.4. Teilmengen des Ereignisraums Ω heißen Ereignisse. Sprechweise: Ist A ⊆ Ω und liegt das Ergebnis eines Zufallsexperimentes in A, so sagt

man auch, das Ereignis A ist eingetreten.

Spezielle Ereignisse A bekommen spezielle Namen:

1. |A| = 1: Elementarereignis.

2. A = Ω: Sicheres Ereignis

3. A = { }: Unmögliches Ereignis.

4. Sind A und B zwei Ereignisse mit A ∩ B = { }, dann heißen die Ereignisse

disjunkt oder unvereinbar.

5. Das Ereignis Ω \ A heißt das Gegenereignis von A. Bezeichnung auch

A.

1

Beispiel 1.5. Angenommen, wir würfeln mit zwei Würfeln gleichzeitig. Dann

ist

Ω = {A ⊆ {1, 2, 3, 4, 5, 6} : 1 ≤ |A| ≤ 2}.

6·5

6

6

und |Ω| = 2 + 1 = 2 + 6 = 15 + 6 = 21, wobei die einelementigen Mengen

gerade die Situation beschreiben, dass beide Würfel dieselbe Zahl zeigen. Wenn

wir aber zweimal nacheinander würfeln, wäre ein angemessener Ereignisraum,

um dieses Zufallsexperiment zu beschreiben,

Ω = {1, 2, 3, 4, 5, 6} × {1, 2, 3, 4, 5, 6}.

eine Menge mit 36 Elementen. Ein mögliches Ereignis wäre in beiden Fällen das

Werfen eines Paschs. Im ersten Fall wären das die einelementigen Teilmengen,

im zweiten Fall {(1, 1), (2, 2), (3, 3), (4, 4), (5, 5), (6, 6)}.

Da Ereignisse Teilmengen von Ω sind, kann man sie mengentheoretisch verknüpfen

(Vereinigung, Schnitt, Komplement). Das Komplement haben wir schon betrachtet (Gegenereignis). Die Vereinigung A ∪ B beschreibt anschaulich das

Ereignis “A oder B”, und A ∩ B das Ereignis “A und B”.

1.2

Wahrscheinlichkeitsraum

Beachten Sie, dass wir bislang noch gar nicht von Wahrscheinlichkeiten gesprochen

haben. Das kommt erst jetzt: Dazu nehmen wir an, dass |Ω| < ∞, also endlich

ist, oder aber zumindest abzählbar unendlich, d.f. |Ω| = |N|. Im ersten Fall

können wir die Ereignisse einfach als Ω = {ω1 , . . . , ωn } schreiben, im letzteren

Fall wenigstens noch abzählen, also Ω = {ωi : i ∈ N}.

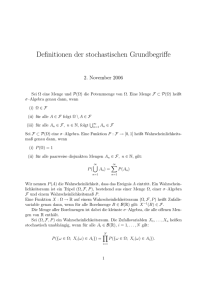

Definition 1.6. Sei Ω eine endliche oder abzählbar unendliche Menge. und P :

2Ω → R eine Abbildung. Das Paar (Ω, P ) heißt Wahrscheinlichkeitsraum,

wenn gilt:

(K1) P (A) ≥ 0 für alle A ⊂ Ω.

(K2) P (Ω) = 1.

(K3) Sind Ai , i = 1, . . . paarweise disjunkte Ereignisse, so gilt

P (A1 ∪ A2 ∪ . . .) = P (A1 ) + P (A2 ) + . . . .

Die Abbildung P heißt Wahrscheinlichkeitsmaß. Der Wert P (A) heißt die

Wahrscheinlichkeit für das Ereignis A.

Mit diesem Axiomensystem umgeht man das Problem, was eigentlich eine Wahrscheinlichkeit ist: Wahrscheinlichkeit ist einfach etwas, was (K1), (K2) und (K3)

erfüllt. Wir sprechen im Fall der Definition 1.6 von einem diskreten Wahrscheinlichkeitsraum (weil |Ω| höchstens abzaählbar unendlich ist). Im Fall überabzählbarer

2

Ereignisräume kann man nicht mehr sinnvoll jedem Ereignis (also jeder Teilmenge von Ω) eine W.K. zuordnen. Wir wollen dieses Problem hier nicht vertiefen; man sollte sich allerdings merken, dass es für überabzählbare Mengen Ω

kein P gibt, das (K1), (K2), (K3) erfüllt und jeder Teilmenge von Ω einen Wert

aus R zuordnet. In der Praxis genügt es aber, wenn wir allen mengen A, die

wir durch abzählbare Vereinigung und Schnitte und Komplementbildung aus

abgeschlossenen Intervallen erhalten so eine W.K. P (A) zurodnen können, dass

(K1), (K2) und (K3) gilt.

Wir werden aber zunächst nur diskrete Wahrscheinlichkeitsräume behandeln;

dort treten die gerade angesprochenen Probleme nicht aus, und wir können

jeder Teilmenge des Ereignisraumes eine W.K. zuordnen, insbesondere auch den

einelementigen Teilmengen. Es ist klar, dass den Wahrscheinlichkeiten dieser

Elementarereignisse eine besondere Bedeutung zukommt. Kennt man nämlich

P ({ω}) (meistens ab jetzt P (ω) bezeichnet für alle ω ∈ Ω, dann kennt man

bereits das ganze Wahrscheinlichkeitsmaß (im abzählbaren Fall, also in dem

Fall, den wir diskret genannt haben).

1.3

Laplace-Experiment

Das einfachste Wahrscheinlichkeitsmaß ist das folgende: Ω ist eine endliche

1

. Man sieht rasch, dass in dem Fall gilt:

Menge, und P (ω) = |Ω|

P (A) =

|A|

.

|Ω|

lax gesprochen: Anzahl günstiger Ausgänge geteilt durch die Anzahl möglicher

Ausgänge eines Zufallsexperimentes.

Um dieses Wahrscheinlichkeitsmaß mit einem Zufallsexperiment in Verbindung

zu bringen, müssen wir nun doch von einer naiven Vorstellung von Wahrscheinlichkeit ausgehen: W.K. gibt an, wie oft ein Ereignis ungefähr eintritt, wenn

wir das Zufallsexperiment nur oft genug wiederholen. Oder aber, etwas materialistisch: Der Kehrwert der W.K. für das Eintreten eines Ereignisses ist der

Geldbetrag (z.B. in e), den ein intelligenter Wetter beim Einsatz eines Euros

auf das Ereignis mindestens als Ausschüttung (inkl. Einsatz) erwartet. Wenn

ich also 1e auf “gerade Zahl” beim Würfel setze, erwarte ich beim Eintreten

dieses Ereignisses mindestens 2e, sonst würde ich (als halbwegs intelligenter

Mensch) nicht wetten.

Unter einem Laplace-Experiment verstehen wir nun ein Zufallsexperiment,

bei dem das Ereignis A mit W.K. |A|

|Ω| eintritt.

Beispiel 1.7. Die Wahrscheinlichkeit, beim Würfeln mit einem Würfel eine

bestimmte Zahl zu würfeln, ist 1/6, es liegt also ein Laplace-Experiment vor

und so gilt z.B., dass die Wahrscheinlichkeit, eine gerade Zahl zu würfeln, 1/2

ist.

3

Beispiel 1.8. Mit welcher Wahrscheinlichkeit erhält man beim Würfeln mit

zwei nicht unterscheidbaren Würfeln einen Pasch? Unser Ereignisraum hat hier

die Mächtigkeit 21, und es gibt 6 Möglichkeiten für einen Pasch. Allerdings

6

6

, sondern 36

. Ähnlich ist die W.K., dass

ist die Wahrscheinlichkeit nicht 21

2

1

sondern 36

. Es gibt also

ein Würfel eine 1, ein anderer eine 2 zeigt, nicht 21

1

15 Elementarereignisse, die jeweils mit Wahrscheinlichkeit 18 eintreten, und

1

6 Elementarereignisse, die jeweils mit W.K. 36

eintreten (die Paschs), in der

Summe gibt das 1.

1.4

Beispiel eines unendlichen Ereignisraumes

Hier sei Ω = {0, 1, . . .} Dabei sei λ > 0 und das Eintreten eines Elementarereignisses {i} sei

λi

P (i) = e−λ

i!

und somit

X

P (A) =

P (i).

i∈A

Offenbar gilt (K1) und (K3). Nicht ganz klar ist (K2): Benutze den bekannten

Grenzwert

∞

X

λi

= eλ ,

i!

i=0

also

P (Ω) =

∞

X

λi

i=0

i!

e−λ = 1.

Wir werden diesem Wahrscheinlichkeitsmaß noch unter dem Stichwort “PoissonVerteilung” begegnen.

1.5

Elementare Eigenschaften eines Wahrscheinlichkeitsmaßes

Satz 1.9. Sei (Ω, P ) ein Wahrscheinlichkeitsraum (d.h. bei uns zunächst einmal, dass Ω höchstens abzählbar unendlich ist). Dann gilt:

1. P (Ω \ A) = 1 − P (A).

2. P ({ }) = 0.

3. P (A ∪ B) = P (A) + P (B) − P (A ∩ B).

4. Wenn A ⊆ B, dann gilt P (A) ≤ P (B).

Es ist wichtig zu bemerken, dass diese Eigenschaften aus den Axiomen in Definition 1.6 folgen, also beweisbar sind. Sie sind nicht Bestandteil des Axiomensystems.

4

1.6

Geburtstagsparadoxon: Anwendung in der Kryptographie

Angenommen, jedes Dokument wird mit einem sogenannten Hashwert, der

eine Zahl h mit 1 ≤ h ≤ N ist, “unterschrieben”. Diese Zahl berechnet sich

aus dem Dokument (ist also so etwas wie eine Prüfziffer). Wie groß ist die

W.K., dass bei n unterzeichneten Dokumenten alle verwendeten Hashwerte verschieden sind? Warum ist das wichtig. Hashwerte werden zur digitalen Signatur

benutzt, d.h. eine Person (nennen wir sie Alice) unterzeichnet ein Dokument

so, dass sie erst den Hashwert berechnet und dann den Hashwert digital unterschreibt. Der Empfänger, sagen wir Bob, kann überprüfen, ob die Signatur

korrekt ist (dazu sagen wir hier nichts), und wenn ja, überprüft er, ob der

Hashwert zum Dokument passt (denn sonst hätte unterwegs ja jemand das

Dokument austauschen können!). Nun könnte aber ein “bad guy”, sagen wir

Eve, in betrügerischer Absicht ganz viele harmlose Varianten des Dokumentes

erzeugen, das Alice unterschreiben soll. Gleichzeitig erzeugt Eve viele Varianten eines gefälschten Dokumentes, zusammen mit den Hashwerten. Wenn sie

ein Paar (S, T ) mit identischen Hashwerten gefunden hat, wobei S das richtige

und T das gefälschte Dokument ist, legt sie S und den Hashwert von S Alice zur

Unterschrift vor, und dann tauscht sie beim Senden an Bob den Text S durch

T aus. Weil der Hashwert von T mit dem von S übereinstimmt, erkennt Bob

die betrügerische Absicht von Eve nicht.

Wie groß ist also die W.K. für eine Kollision, wenn man N Hashwerte hat (das

ist jetzt nicht ganz das beschriebene Szenario: Bei dem oben beschriebenen

Szenario hätten wir zwei Gruppen (die echten und die gefälschten Nachrichten)

und fragen nach Kollisionen zwischen der EINEN und der ANDEREN Menge;

hier geht es jetzt um Kollisionen innerhalb einer Menge).

Es werden n Dokumente zufällig gewählt, und dann ist es vernünftig anzunehmen,

dass auch die Hashwerte zufällig ausgewählt werden. Wir können uns das als ein

Urnenexperiment vorstellen, wobei in der Urne N verschiedene Kugeln liegen

(die Hashwerte) und es werden, mit Zurücklegen, n gezogen. Dann ist die Anzahl “günstiger” Ausgänge ohne Kollision

N (N − 1)(N − 2) · · · (N − n + 1) =

N!

.

(N − n)!

Die Anzahl aller möglichen Ziehungen ist N n . Das liefert die gesuchte W.K.

P

=

N!

N −n+1

N N −1

=

·

···

(N − n)!N n

N

N

N

=

0

1−

N

1

2

n−1

1−

1−

··· 1 −

.

N

N

N

Ist n/N klein, benutzen wir ex ≈ 1 − x und erhalten

P ≈ e[−1−2−...−(n−1)]/N = e−

5

n(n−1)

2N

.

Wann ist dieser Wert 1/2? Er ist 1/2 wenn

−

n(n − 1)

1

= ln( ) = − ln(2),

2N

2

also

n2 − n = 2N ln(2)

gilt, d.h.

r

p

1

1

+ 2N ln(2) ≈ 2 ln(2)N

n= +

2

4

für große N . Für N = 365 erhalten wir n ≈ 23, also in einer Gruppe von 23

Menschen gibt es mit W.K. etwa 21 zwei, die am selben Tag Geburtstag feiern

(daher der Name Geburtstagsparadoxon).

1.7

Bedingte Wahrscheinlichkeiten

Definition 1.10. Zwei Ereignisse A und B heißen unabhängig, wenn

P (A ∩ B) = P (A) · P (B)

gilt.

Beachten Sie den Unterschied zu unvereinbaren Ereignissen A und B (da gilt

P (A ∩ B) = 0.

Anschaulich soll bedingte Wahrscheinlichkeit folgendes bedeuten: Wir wollen

P (B) bestimmen, wenn wir schon wissen, dass A eingetreten ist.

Definition 1.11. Es seien A und B Ereignisse eines Ereignisraums Ω, auf

dem ein Wahrscheinlichkeitsmaß P definiert ist. Ferner sei P (B) 6= 0. Dann

definieren wir

P (A ∩ B)

P (A|B) :=

.

P (B)

Gesprochen: P von A gegeben B. Wir nennen P (A|B) die bedingte Wahrscheinlichkeit.

Bemerkung 1.12. Es gilt

P (A ∩ B)

= P (B) · P (A|B)

= P (A) · P (B|A).

Satz 1.13 (Satz von Bayes).

P (A|B) =

P (A)

P (B|A)

P (B)

sofern P (A), P (B) 6= 0.

6

Wenn zwei Ereignisse A und B unabhängig voneinander sind, gilt

P (A|B)

=

P (A)

P (B|A)

=

P (B).

Manchmal nennt man P (A) die “a-priori” Wahrscheinlichkeit und P (A|B) die

“a-posteriori”-Wahrscheinlichkeit. Das Problem, bedingte Wahrscheinlichkeiten

vernünftig zu interpretieren, ist folgendes: Von Wahrscheinlichkeiten reden wir,

wenn ein Zufallsexperiment durchgeführt wird, und die W.K. sagt dann etwas

aus über das Ergebnis eines Experimentes, das in der Zukunft liegt, also erst ausgeführt wird. Wenn uns jemand nach Durchführung des Zufallsexperimentes ein

wenig Informationen gibt (also sagt, das Ereignis B sei eingetreten), haben wir

ja gar kein Zufallsexperiment mehr! Man muss vielmehr vor der Durchführung

des Experimentes vereinbaren, ob die Information B weitergegeben wird. Wir

schauen uns also all die Ausgänge eines Zufallsexperimentes an, die eintreten,

wenn auch B eingetreten ist und auch wirklich nur dann! Wir erhalten so einen

neuen Wahrscheinlichkeitsraum:

Satz 1.14. Sei (Ω, P ) ein Wahrscheinlichkeitsraum und sei B ein Ereignis mit

P (B) 6= 0. Dann definiert P (A|B) für A ⊆ Ω ein Wahrscheinlichkeitsmaß auf

Ω. Dieses neue Maß wird auch PB (A) bezeichnet.

Beispiel 1.15. Angenommen wir würfeln mit einem Würfel und B sei das

Ereignis “es wird eine gerade Zahl gewürfelt”. Dann ist

P ({1}|A)

=

0

P ({2}|A)

=

1/3

P ({3}|A)

=

0

P ({4}|A)

=

1/3

P ({5}|A)

=

0

P ({6}|A)

=

1/3.

Satz 1.16 (Satz von der totalen Wahrscheinlichkeit). (Ω, P ) sei ein Wahrscheinlichkeitsraum,

Ai ⊆ Ω mit 1 ≤ i ≤ m paarweise disjunkte Ereignisse mit

Sm

Ω = i=1 Ai . Ferner sei B ⊆ Ω sowie P (B), P (Ai ) 6= 0 für i = 1, . . . , m.

Dann gilt

m

m

X

X

P (B) =

P (Ai ) · P (B|Ai ) =

P (Ai ∩ B)

i=1

i=1

sowie (Satz von Bayes)

P (Ak |B) =

P (Ak )P (B|Ak )

P (A)

· P (B|Ak ) = Pm

.

P (B)

i=1 P (Ai ) · P (B|Ai )

Beispiel 1.17. Nehmen wir an, wir leben in einem Land, in dem jede Familie

genau zwei Kinder hat, jeweils 1/4 der Familien haben zwei Jungen und zwei

7

Mädchen, und bei jeweils 1/4 der Familien ist die Verteilung mj und jm, wobei

im ersten Fall das Mädchen das erstgeborene Kind ist, im zweiten Fall der Junge.

Es gilt hier also

Ω = {mm, jj, mj, jm}

und wir haben, wenn eine Familie zufällig ausgewählt wird, ein Laplace-Experiment.

Nun nehmen wir an, dass in dem Land einem Besucher stets (falls möglich)

zuerst die Tochter vorgestellt wird. Wenn man also eine Familie besucht und es

wird eine Tochter vorgestellt, erhält man Teilinformationen, nämlich man weiß,

dass das Ereignis

B = {mj, jm, mm}

eingetreten ist. Das liefert

PB (mm)

=

1/3

PB (mj)

=

1/3

PB (jm)

=

1/3

PB (jj)

=

0.

Das bedeutet, mit Wahrscheinlichkeit 2/3 handelt es sich bei der Familie um

eine mit einem Mädchen und einem Jungen.

Nun ändern sich die Traditionen in dem Land, und einem Besucher wird stets

der/die Erstgeborene vorgestellt. Angenommen, dann wird uns eine Tochter

vorgestellt. Das Ereignis C wäre dann

C = {mm, mj}

und wir erhalten

PC (mm)

=

1/2

PC (mj)

=

1/2

PC (jm)

=

0

PC (jj)

=

0.

Damit ist nun die Wahrscheinlichkeit für eine Familie mit einem Mädchen und

einem Jungen genau 1/2.

Nun ändern sich die Traditionen noch mehr und die Eltern schnappen sich

irgendein Kind, das sie dem Besucher als erstes vorstellen. Angenommen, das

ist ein Mädchen. Wie groß ist jetzt die W.K., daß das zweite Kind ein Junge ist?

Oft wird hier so argumentiert wie im ersten Fall. Andererseits hat man intuitiv

das Gefühl, die W.K. für das Geschlecht des zweiten Kindes sollte unabhängig

sein vom Geschlecht eines zufällig beobachteten Kindes. Wie können wir hier

vorgehen? Gehen wir zu einem gößeren Ereignisraum über:

Ωe := Ω × Ωv ,

8

wobei Ωv = {j, m} das Geschlecht des Kindes ist, das vorgestellt wird. Wir

erhalten

P (mm, m)

=

1/4

P (mm, j)

=

0

P (mj, m)

=

1/8

P (mj, j)

=

1/8

P (jm, m)

P (jm, j)

=

=

1/8

1/8

P (jj, m)

=

0

P (jj, j)

=

1/4.

Die Wahrscheinlichkeit, dass uns ein Mädchen vorgestellt wird (Ereignis D)

ist 1/2. Wenn A das Ereignis bezeichnet “Ein Kind ist ein Junge”, so ist die

Wahrscheinlichkeit P (A ∩ D) = 1/4, somit P (A|D) = 1/2.

Dieses Beispiel soll zeige, das es schon wichtig ist zu wissen wie wir an die Teilinformation kommen. Das Zufallsexperiment, das zu einer bedingten Wahrscheinlichkeit PB gehört, ist eines, bei dem wir genau die Ereignisse aus B voraussetzen und keine Teilmenge von B, wie im letzten Fall, wo uns zufällig ein

Kind vorgestellt wird. In dem Fall können wir zwar sicher sein, in der Menge

{mm, mj, jm} zu liegen, aber wenn uns ein Junge vorgestellt wird, können wir

nicht sicher sein, außerhalb von B zu liegen! Beachten Sie dabei: P (A|B) ist in

der Regel etwas anderes als P (A|B 0 ) wenn B 0 ⊂ B!

Wir können uns den Unterschied zwischen dem ersten und zweiten Szenario

auch wie folgt klarmachen: Angenommen wir besuchen 1000 Familien. Dann

werden uns im ersten Fall etwa 750 mal Mädchen vorgestellt, das sind genau

die Situationen, in denen das Ereignis {mm, mj, jm} eingetreten ist. Von diesen

(etwa) 750 Fällen sind etwa 2/3 Fälle, in denen das zweite Kind ein Junge ist.

Also kann man sagen, die Wahrscheinlichkeit für einen Jungen in der Familie

ist 2/3, wenn uns ein Mädchen vorgestellt wurde.

Im dritten Szenario, wo uns zufällig ein Kind vorgestellt wird, sehen wir etwa 500

mal ein Mädchen: In der Situation mm mit Sicherheit, in den (etwa) 250 Fällen

mj etwa in der Hälfte der Fälle, und in den Fällen jm ebenfalls etwa in der Hälfte

der Fälle. Von diesen 500 Familien hat etwa die Hälfte ein zweites Mädchen und

die andere Hälfte einen Jungen als zweites Kind. Bedingte Wahrscheinlichkeiten

können wir hier nicht anwenden, weil durch die Information “ein Mädchen wird

uns vorgestellt” nicht klar wird, welches Ereignis in {mm, jm, mj, jj} eingetreten ist. Das können wir erst in dem erweiterten Modell sagen, in dem wir

die Ereignisse noch gesplittet haben, je nachdem, welches Kind uns vorgestellt

wurde.

Eine weitere Bemerkung: Stellen Sie sich vor, im ersten Szenario (Mädchen wird

vorgestellt, falls möglich) hätten Sie die Zusatzinformation, daß die Mädchen

9

bevorzugt vorgestellt werden, nicht. Sie würden dann fälschlicherweise wohl

nach einer gewissen Zeit vermute, in dem Land wären 3/4 der Kinder Mädchen.

Beispiel 1.18. In einer Urne liegen je zwei rote, schwarze und blaue Kugeln.

Es wird vereinbart, dass eine Person I nacheinander ohne Zurücklegen Kugeln

aus der Urne zieht und einer anderen Person mitteilt, wann erstmals eine blaue

Kugel gezogen wird. Diese Person II sieht aber nicht, welche Kugeln gezogen

wurden. Angenommen die dritte Kugel ist blau (erstmals!). Mit welcher W.K.

wurden dann in den ersten beiden Ziehungen die beiden roten Kugeln gezogen?

Ohne die Zusatzinformation ist die W.K., in den ersten beiden Ziehungen die

beiden roten Kugeln zu ziehen,

1

1 1

· =

.

3 5

15

In der Vorlesung zeigen wir, dass die W.K., dass die ersten beiden Kugeln rot

sind, 1/6 ist unter der Annahme, dass die 3. Kugel blau ist.

p=

Beispiel 1.19. In einer Bevölkerungsgruppe seien 0.1% der Bevölkerung mit

einem Virus infiziert, der Rest ist nicht infiziert. Ein Test habe eine zuverlässigkeit

von 99%, d.h. er liefert in 1% der Fälle ein falsches Ergebnis. Mit welcher W.K.

ist ein positiv auf das Virus getesteter Mensch in Wirklichkeit gesund (nicht

infiziert). Wir können das mit dem Satz von der totalen W.K. machen: Jemand

kann gesund oder krank (infiziert) sein (G, K) und jemand kann positiv (auf

Virus) p oder negativ (gesund) n getestet werden. P (·) bezeichne die W.K. für

diese Ereignisse. Dann gilt

P (G|p) =

P (G) · P (p|G)

0.999 · 0.01

=

≈ 0.9098 . . .

P (G) · P (p|G) + P (K) · P (p|K)

0.999 · 0.01 + 0.001 · 0.99

Also: Die meisten positiv getesteten Menschen sind gesund!

1.8

Stoppstrategie

Sie suchen den besten Partner/in fürs Leben! Oder aber Sie sind Personalchef

und suchen unter einer Menge von n Bewerbern den Besten. Nun können Sie

sich nicht alle Bewerber/innen anschauen, genauso wenig wie Sie alle möglichen

Partner/innen ausprobieren können. Sie können aber alle Kandidaten, die sie

sich genauer anschauen, miteinander vergleichen und sagen, wer besser ist. Es

gibt aber a priori kein Maß was eigentlich ein guter Bewerber ist (oder was ein

guter Lebenspartner ist). Eine mögliche Strategie wäre: Sie schauen sich j Bewerber/innen an, dann haben Sie also Marktanalyse gemacht. Danach nehmen

Sie den nächsten Bewerber, der besser ist als der Beste in der Referenzmenge

der ersten j. Die Frage ist: Wie sollte man j wählen (sicherlich in Abhängigkeit

von n), um die W.K. Pj , den besten Bewerber zu finden, zu maximieren?

Dazu betrachten wir folgende Ereignisse:

Ak

:

Bewerber k wird angenommen

Bk

:

Bewerber k ist der beste aller Bewerber.

10

Wir erhalten folgende W.K.:

P (Bk )

=

P (Ak |Bk )

=

P (Ak |Bk )

=

1

n

0 für k ≤ j

j

für k > j.

k−1

Kurz zur letzten Gleichung: Wenn der k-te Bewerber angenommen wird und

dieser auch der beste ist, muss der beste Bewerber unter den ersten k − 1 unter

den ersten j gewesen sein, denn sonst hätte man ja schon vor dem k-ten Bewerber gestoppt und wäre gar nicht in die Verlegenheit gekommen, sich den k-ten

anzuschauen. Wir erhalten

Pj =

n

X

k=1

P (Ak ∩ Bk ) =

n

X

k=1

P (Bk )P (Ak |Bk ),

also

Pj

=

=

Benutze nun

n−1

X

k=j

j

j

1 j

+

+ ... +

n j

j+1

n−1

1

j 1

+ ... +

.

n j

n−1

1

≈

k

Z

j

n

1

dx = ln

x

n

j

um

Pj ≈ −x ln(x)

mit x = j/n zu erhalten. Diese Funktion nimmt ihr Maximum für x = 1/e an,

und auch die W.K. Pj ist dann 1/e.

1.9

Mehrstufige Experimente

Sehr häufig werden Zufallsexperimente als mehrstufige Experimente durchgeführt,

sagen wir m Experimente. Die möglichen Ausgänge der i-ten Stufe seien in dem

Ereignisraum Ωi zusammengefasst. Ein Ereignis ist also ein m-Tupel

(ω1 , . . . , ωm ) ∈ Ω1 × . . . × Ωm .

Wir müssen die Wahrscheinlichkeiten der Elementarereignisse bestimmen. Das

ist dann ganz einfach, wenn die Experimente, die zu den Ereignisräumen Ω1 , . . . , Ωm

gehören, unabhängig voneinander sind. In dem Fall gilt

P (ω1 , . . . , ωm ) =

m

Y

i=1

11

Pi (ωi ),

wobei Pi (ωi ) die W.K. angibt, dass in der i-ten Stufe das Ereignis ωi eintritt.

Sehr oft ist es aber so, dass die W.K. in der zweiten Stufe davon abhängt, was

in der ersten Stufe passiert ist:

Beispiel 1.20. In einer Urne liegen eine rote und drei schwarze Kugeln. Nun

wird in der ersten Stufe des Experimentes eine Kugel gezogen, die Farbe notiert

und die Kugel sowie eine weitere Kugel derselben Farbe zurückgelegt. Wir

haben Ω1 = {R, S} = Ω2 . Gesucht ist P (R, R), P (R, S), P (S, R), P (S, S). Es

ist P1 (R) = 1/4 und P1 (S) = 43 . Man nennt das oft auch die Startverteilung

des mehrstufigen Experimentes. Offenbar gilt

P (R, R)

=

1 2

2

· =

4 5

20

P (R, S)

=

1 3

3

· =

4 5

20

P (S, R)

=

3 1

3

· =

4 5

20

P (S, S)

=

3 4

12

· =

.

4 5

20

Die Wahrscheinlichkeiten beim Übergang von Stufe j − 1 zu Stufe j hängen also

davon ab, was “vorher” passiert ist. Wir nennen

Pj (ωj |ω1 , . . . , ωj−1 )

die Übergangswahrscheinlichkeit, das ist die W.K. für das Eintreten von ωj

unter der Voraussetzung, dass in den vorhergehenden Stufen des mehrstufigen

Experimentes die Ereignisse ω1 , . . . , ωj−1 eingetreten sind. Offenbar gilt

P (ω1 , . . . , ωm ) = P (ω1 ) · P (ω2 |ω1 ) · P (ω3 |ω1 , ω2 ) · · · P (ωm |ω1 , . . . , ωm−1 ).

Man macht sich so etwas oft an einem Baumdiagramm klar.

Beispiel 1.21. Wir würfeln mit einem Würfel. Danach nehmen wir eine Münze

und werfen diese so oft, wie beim vorhergehenden Würfelwurf Augen angezeigt

wurden. Angenommen, jemand teilt uns mit, dass bei all diesen Münzwürfen

als Ergebnis Kopf herauskam. Mit welcher Wahrscheinlichkeit war dann das

Ergebnis der Würfelwurfs eine 1, 2, 3, 4, 5 oder 6. Es stellt sich heraus, dass

diese W.K. 32/63, 16/63, 8/63, 4/63, 2/63 und 1/63 sind.

Beispiel 1.22 (Das Ziegenproblem). In einer Fernsehshow wird hinter einer von

drei verschlossenen Türen ein Fahrrad, hinter den anderen beiden eine Ziege versteckt. Dann darf die Kandidatin eine der Türen öffnen: Ist dahinter das Rad,

darf sie es behalten, andernfalls darf sie nix behalten, nicht mal die Ziege! Nun

deutet die Kandidatin erst einmal auf eine Tür. Der Moderator sagt daraufhin,

12

hinter einer der anderen beiden Türen sei ja eh eine Ziege, und das weiß doch

jeder, deshalb könne er doch auch gefahrlos eine Tür, hinter der eine Ziege steht,

öffnen (wir gehen davon aus, dass der Moderator weiß hinter welcher Tür das

Fahrrad steht). Der Moderator gibt der Kandidatin nun die Möglichkeit, sich

neu zu entscheiden, welche Tür sie öffnen will. Frage: Lohnt es sich für die

Kandidatin, sich neu zu entscheiden? Die Antwort ist ja, wie wir in der Vorlesung zeigen. Die W.K., das Fahrrad zu gewinnen, steigt durch einen Wechsel

der Entscheidung auf 2/3!

2

Zufallsvariablen

Wir gehen hier zunächst davon aus, dass der Ereignisraum Ω eines Zufallsexperimentes höchstens abzählbar unendlich ist.

2.1

Grundlagen

Definition 2.1. Sei Ω der Ereignisraum eines Zufallsexperimentes. Eine Abbildung

X:Ω→R

heißt Zufallsvariable. Das Bild von X nennen wir die möglichen Realisierungen der Zufallsvariablen. Ist auf Ω eine W.K. definiert, ist also (Ω, P ) ein

Wahrscheinlichkeitsraum, dann können wir mit Hilfe einer Zufallsvariable eine

Abbildung F : R → [0, 1] wie folgt definieren:

F (x) := P ({ω ∈ Ω : X(ω) ≤ x}).

Wir nennen F die zugehörige Verteilungsfunktion. Die Verteilungsfunktion

ordnet also gewissen Ereignissen eine Wahrscheinlichkeit zu. Statt P ({ω ∈ Ω :

X(ω) ≤ x}) schreibt man meistens einfacher P (X(ω) ≤ x) oder P (X ≤ x).

Da im Falle endlicher Ereignisräume Ω auch nur endlich viele Realisierungen

existieren, können wir eine Abbildung Bild(X) → [0, 1] definieren durch

x 7→ P (X(ω) = x)

und wir schreiben px := P (X(ω) = x). Wenn die Realisierungen x1 , x2 , . . . mit

i indiziert werden, schreibt man auch pi statt pxi . Die Zufallsvariable heißt

diskret, wenn es nur abzählbar viele Realisierungen gibt.

Bemerkung 2.2.

1. Achtung: Die px sind nicht die Wahrscheinlichkeiten

für Elementarereignisse, weil viele Elementarereignisse durch X auf dasselbe Bild abgebildet werden können.

2. Wir schreiben

X=x

:= {ω : X(ω) = x}

X < x := {ω : X(ω) < x}

x<X≤y

:= {ω : x < X(ω) ≤ y}.

13

Proposition 2.3. Sei X eine Zufallsvariable auf einem diskreten Wahrscheinlichkeitsraum. Dann gilt

P (x < X ≤ y) = F (y) − F (x).

Ferner ist

X

F (x) =

P (ω) =

ω∈Ω : X(ω)≤x

X

py .

y≤x

Beispiel 2.4. In der Vorlesung werden wir die Verteilungsfunktion und die px

der Zufallsvariable “Augensumme beim Würfeln mit zwei Würfeln” diskutieren.

Satz 2.5. Für eine Verteilungsfunktion F gilt:

(1.) F ist monoton wachsend.

(2.) Für jedes x∗ ∈ R existieren die Grenzwerte limx%x∗ F (x) sowie limx&x∗ F (x)

und es gilt

lim∗ F (x) = F (x∗ ),

x&x

d.h. F ist rechtsseitig stetig.

(3.) limx&x∗ F (x) − limx%x∗ F (x) = P (X = x∗ ).

(4.)

(5.)

lim F (x) = 0.

x→−∞

lim F (x) = 1.

x→+∞

Bemerkung 2.6. Der Punkt (3.) zeigt, dass wir die px unmittelbar aus der

Verteilungsfunktion ablesen können und umgekehrt.

Definition 2.7. Ist X eine Zufallsvariable mit zugehöriger Verteilungsfunktion

F , so sagen wir, die Z.V. ist F -verteilt, geschrieben X ∼ F .

Bemerkung 2.8. Beachten Sie, dass die Verteilungsfunktion eine Eigenschaft

der Zufallsvariablen ist, nicht eines Wahrscheinlichkeitsraumes.

Wir werden später sehen, dass man jeder Zufallsvariablen gewisse Zahlen zuordnen kann, die wichtige Eigenschaften der Z.V. beschreiben. Ein erstes Beispiel

sind die Quantile:

Definition 2.9. Sei X eine Zufallsvariable und p ∈ (0, 1). Ferner sei F die

zugehörige Verteilungsfunktion. Eine Zahl Qp mit

lim F (x) ≤ p ≤ F (Qp )

x%Qp

heißt p-Quantil der Zufallsvariablen. Im Fall p = 1/2 spricht man vom Median.

Actung: Die Zahlen Qp sind nicht eindeutig bestimmt. Wenn F eine Umkehrfunktion hat, gilt Qp = F −1 (p).

14

2.2

Binomialverteilung, Hypergeometrische Verteilung, Poissonverteilung

Die einfachste Verteilung ist die Gleichverteilung, bei der P (X = xi ) = 1/N

gilt, wenn N die Anzahl möglicher Realisierungen x1 , . . . , xN von X bezeichnet. Die zugehörige Verteilungsfunktion ist eine Treppenfunktion. Klassisches

Beispiel: Münzwurf oder würfeln.

Definition 2.10. Ein Bernoulli-Experiment ist ein Zufallsexperiment, bei

dem es nur zwei mögliche Ausgänge A und B gibt. Das Ereignis A trete mit

W.K. p und das Ereignis B dann mit W.K. 1 − p = q ein. Damit wird {A, B}

zu einem Wahrscheinlichkeitsraum. Wir haben kein Laplace-Experiment, es sei

denn, p = q = 1/2.

Wenn wir ein Bernoulliexperiment n mal wiederholen, ist der Ereignisraum Ω =

{A, B}n . Die Elementarereignisse heißen Bernoulliketten. Eine Kette mit k

Ereignissen A und n − k Ereignissen B tritt mit W.K. pk q n−k ein. So wird auf

Ω ein Wahrscheinlichkeitsmaß definiert. Wir definieren nun eine Zufallsvariable

X auf diesem Wahrscheinlichkeitsraum wie folgt: Einer Bernoullikette mit k

Einträgen A und n − k Einträgen B wird die Zahl k (manchmal auch “Anzahl

Erfolge” genannt) zugeordnet. Offenbar gilt

n k

P (X = k) =

p (1 − p)n−k .

k

Dies liefert eine Wahrscheinlichkeitsverteilung, die sogenannte Binomialverteilung

B(n, p). Sie ist komplett durch Angabe von n und p bestimmt. Wir nennen eine

Zufallsvariable binomialverteilt mit Parametern n und p, wenn ihre Wahrscheinlichkeitsverteilung B(n, p) ist. Die folgenden Bilder zeigen die Wahrscheinlichkeitsverteilungen für einige Werte von p und n:

B(21, 0.5) :

15

B(20, 0.2) :

B(100, 0.8) :

16

Kommen wir nun zur hypergeometrischen Verteilung H(n, M, N ): Wir

haben hier eine Urne mit N Kugeln, M davon seien rot. Wir ziehen ohne

Zurücklegen n Kugeln. Diesem Zufallsexperiment können wir ein Wahrscheinlichkeitsmaß zuordnen sowie eine Z.V. X definieren, nämlich die Anzahl k roter

Kugeln. Es gilt

P (X = k) =

M

k

N −M

n−k

N

n

.

Eine Zufallsvariable mit dieser Wahrscheinlichkeitsverteilung heißt hypergeometrisch

verteilt.

Abschließend betrachten wir die Poisson-Verteilung. Der Ereignisraum ist

hier {0, 1, . . .} die Menge der nicht-negativen ganzen Zahlen. Die Poissonverteilung modelliert recht gut die Anzahl seltener Ereignisse, die in einem

fest gewählten Zeitraum auftreten (Tore pro Fußballspiel). Wir nennen eine

Zufallsvariable X Poisson-verteilt P (λ) mit Parameter λ, wenn

P (X = k) =

λk −λ

e .

k!

Hier ist ein Bild für λ = 2.5, was etwa der Anzahl geschossener Tore in einem

Bundesligaspiel entspricht:

In der Vorlesung zeigen wir auch einige “Animationen” dieser drei wichtigen

Verteilungen.

Interessant ist, dass die Poissonverteilung als Grenzverteilung der Binomialverteilung

interpretiert werden kann: Gilt X ∼ B(n, p) mit großem n und kleinem p, so

17

können wir die Approximation

P (X = k) ≈

λk −λ

e .

k!

nutzen. Faustregel: n ≥ 50 und p ≤ 0.1.

2.3

Lagemaße

Jeder Zufallsvariablen kann man gewisse Zahlen zuordnen kann, die wichtige

Eigenschaften der Z.V. beschreiben. Ein Beispiel haben wir bereits gesehen,

die Quantile (Definition 2.9). In diesem Abschnitt folgen Erwartungswert und

Varianz.

Definition 2.11. Sei X eine Zufallsvariable mit Realisierungen x1 , x2 , . . .. Der

Erwartungswert E(X) von X ist definiert als

E(X) :=

∞

X

i=1

xi · P (X = xi )

sofern diese Summe existiert (was im Fall endlicher Wahrscheinlichkeitsräume

immer der Fall ist).

18

P

Bemerkung 2.12. Es gilt E(X) = ω∈Ω X(ω)P (ω). Beachten Sie, dass auch

hier der Erwartungswert mit einer Zufallsvariablen zusammenhängt und keine

Größe des Zufallsexperimentes ist: Bei einem Zufallsexperiment kommen ja

keine Zahlen heraus. Zahlen, mit denen man dann rechnen kann, entstehen erst

durch das Anwenden von Zufallsvariablen!

Beispiel 2.13. Wenn wir mit zwei Würfeln werfen und als Zufallsvariable jedem Ausgang den Betrag der Differenz der Augenzahlen zuordnen, so ist der

Erwartungswert 35/18, siehe Vorlesung.

Definition 2.14. Sei X eine Zufallsvariable mit Realisierungen x1 , x2 , . . . und

Erwartungswert µ. Wir definieren die Varianz

V (X) := E((X − µ)2 )

sofern dieser Erwartungswert existiert.

Bemerkung 2.15. Es gilt

V (X) =

∞

X

i=1

(xi − µ)2 · P (X = xi )

sowie

V (X) = E(X 2 ) − µ2 .

Ferner wird die Wurzel aus der Varianz auch Standardabweichung σ genannt.

Entsprechend schreibt man für die Varianz manchmal σ 2 .

Man kann die Abweichung einer Z.V. vom Mittelwert mit Hilfe der Varianz

abschätzen:

Satz 2.16 (Tschebyscheff’sche Ungleichung).

P (|X − E(X)| ≥ ) ≤

1

V (X).

2

Diese Abschätzung gilt für beliebige Zufallsvariablen.

Wir haben drei wichtige Wahrscheinlichkeitsverteilungen kennengelernt: Binomial, Poisson, hypergeometrisch. In der folgenden Tabelle fassen wir Erwartungswert und Varianz dieser Verteilungen zusammen:

B(n, p)

H(n, M, N )

P (λ)

E(X)

V (X)

np

np(1 − p)

M N −n

nM

nM

N

N (1 − N ) N −1

λ

λ

19

Bemerkung 2.17. Wenn X eine Zufallsvariable ist, dann ist auch g(X) für

eine Funktion g : R → R eine Zufallsvariable. Man kann aber nicht unmittelbar

Erwartungswert, Varianz und Wahrscheinlichkeitsverteilung aus g ablesen. Es

gilt

∞

X

E(g(X)) =

g(xi )P (X = xi ).

i=0

Satz 2.18. Sei X eine Zufallsvariable mit Erwartungswert E(X) = µ und

Varianz V (X)σ 2 . Dann gilt

E(aX + b)

=

V (aX + b)

=

a · E(X) + b

a2 · V (X).

X −µ

eine Zufallsvariable mit Erwartungswert 0 und Varianz

σ

1 (sofern σ =

6 0).

Insbesondere ist

2.4

Gemeinsame Verteilungen und Lagemaße von Zufallsvariablen

Satz 2.19. Seien X und Y Zufallsvariablen auf einem Wahrscheinlichkeitsraum

(Ω, P ) mit Erwartungswerten E(X) und E(Y ). Dann gilt

E(aX + Y ) = aE(X) + E(Y ).

Ein entsprechender Satz für die Varianz gilt zunächst einmal nicht.

Definition 2.20. Zwei Zufallsvariablen X und Y heißen unabhängig, wenn

für alle rellen Zahlen x, y gilt:

P (X = x und Y = y) = P (X = x) · P (Y = y).

Mit anderen Worten: Die beiden Ereignisse

{ω : X(ω) = x}

{ω : Y (ω) = y}

sind unabhängig. Allgemein nennen wir Z.V. X1 , . . . , Xn auf (Ω, P ) unabhängig,

wenn für alle x1 , . . . , xn ∈ R gilt

P (Xi = xi für i = 1, . . . , n) =

n

Y

P (X = xi ).

i=1

Bemerkung 2.21. Beachten Sie, dass X und Y auf dem selben Wahrscheinlichkeitsraum definiert sind!

20

Bemerkung 2.22. Unabhängigkeit von mehr als zwei Zufallsvariablen ist eine

stärkere Bedingung als paarweise Unabhängigkeit!

Für unabhängige Zufallsvariablen gilt:

Satz 2.23. Seien X und Y unabhängige Zufallsvariablen auf einem W.R. (Ω, P ).

Dann gilt

E(X · Y ) = E(X) · E(Y )

sofern beide Erwartungswerte existieren, ebenso für das Produkt mehrerer unabhängiger Zufallsvariablen

Im Fall unabhängiger Z.V. kann man auch etwas über die Summe der Varianz

sagen:

Satz 2.24. Seien X und Y unabhängige Zufallsvariablen auf einem W.R. (Ω, P ).

Dann gilt

V (X + Y ) = V (X) + V (Y )

sofern V (X), V (Y ) existieren.

Bemerkung 2.25. Beide Sätze gelten auch für mehr als zwei unabhängige

Zufallsvariablen.

Definition 2.26. Die Kovarianz zweier Zufallsvariablen X, Y ist definiert als

C(X, Y ) = E(X · Y ) − E(X) · E(Y )

sofern die entsprechenden Erwartungswerte existieren.

Die Bedeutung der Kovarianz wird im folgenden Satz deutlich:

Satz 2.27. Seien X und Y zwei Zufallsvariablen auf dem W.R. (Ω, P ). Dann

gilt

V (X + Y ) = V (X) + V (Y ) + 2C(X, Y ).

Eigenschaften der Kovarianz:

Proposition 2.28. X, Y, X1 , . . . , Y1 , . . . seien Z.V. auf W.R. (Ω, P ). Dann gilt

(1.) C(X, X) = V (X),

C(X, Y ) = C(Y, X).

(2.) C(X, Y ) = E (X − E(X)) · (Y − E(Y )) .

(3.) C(X + a, Y + b) = C(X, Y ).

(4.) Wenn X und Y unabhängig sind, dann gilt C(X, Y ) = 0.

Pn

P

(5.) V (X1 + . . . + Xn ) = i=1 V (Xi ) + 2 · 1≤i<j≤n C(Xi , Xj ) .

P

P

P

(6.) C( i ai Xi , j bj Yj ) = i,j ai bj C(Xi , Yj ).

21

(7.) C(X, Y )2 ≤ V (X) · V (Y ).

Bemerkung 2.29. Die letzte Eigenschaft zeigt, dass wir die Kovarianz normieren

können. Wir nennen den Quotienten

C(X, Y )

−1 ≤ p

≤1

V (X) · V (Y )

die Korrelation zwischen X und Y . Liegt die Korrelation nahe bei ±1, so

besteht zwischen X und Y eine “große” Abhängigkeit. Unabhängige Z.V. sind

unkorreliert (d.h. Korrelation = 0), aber nicht umgekehrt: Man kann sich

beispielsweise überlegen, dass Summe und Differenz beim zweimaligen Würfeln

unkorrelierte Z.V. sind, die aber nicht unabhängig sind.

Beispiel 2.30. Wir würfeln zweimal nacheinander und betrachten die beiden

Z.V. X und Y , wobei X die kleinere Augenzahl ist und Y die Summe der

beiden Würfe. Die folgende kleine Tabelle zeigt die Ereignisse, die W.K. für die

Ereignisse sowie die Werte der Z.V.:

Ereignis

P

X

Y

1, 1

2, 2

3, 3

4, 4

5, 5

6, 6

1, 2

1, 3

1, 4

1, 5

1, 6

2, 3

2, 4

2, 5

2, 6

3, 4

3, 5

3, 6

4, 5

4, 6

5, 6

1/36

1/36

1/36

1/36

1/36

1/36

1/18

1/18

1/18

1/18

1/18

1/18

1/18

1/18

1/18

1/18

1/18

1/18

1/18

1/18

1/18

1

2

3

4

5

6

1

1

1

1

1

2

2

2

2

3

3

3

4

4

5

2

4

6

8

10

12

3

4

5

6

7

5

6

7

8

7

8

9

9

10

11

22

X ·Y

2

8

18

32

50

72

3

4

5

6

7

10

12

14

16

21

24

27

36

40

55

Man rechnet nach:

91

≈ 2.53

36

E(Y ) = 7

2555

≈ 1.97

V (X) =

1296

35

V (Y ) =

≈ 5.83

6

35

C(X, Y ) =

≈ 2.92.

12

p

Normierung der Kovarianz (d.h. Division durch V (X) · V (Y )) ergibt einen

Korrelationskoeffizienten von 0.86, die Zufallsvariablen sind also vergleichsweise

stark korreliert.

E(X)

2.5

=

Produkträume

Was passiert, wenn wir Z.V. Xi haben, die auf verschiedenen Wahrscheinlichkeitsräumen (Ωi , Pi ) definiert sind. Dazu definieren wir den Produktraum

Ω = Ω1 × . . . × Ωn und definieren auf Ω das Produktmaß

P (ω1 , . . . , ωm ) =

m

Y

Pi (ωi ).

i=1

Zumindest im abzählbar unendlichen Fall ist das kein Problem und wir können

so jeder Teilmenge von Ω eine Wahrscheinlichkeit zuordnen. Die Xi kann man

als unabhängige Zufallsvariablen auf diesem Produktraum auffassen und wir

können damit arbeiten so wie oben für den Fall dass die verschiedenen Z.V.

auf einem W.R. definiert sind. Klassishcer Fall: Zufallsexperiment wird nmal wiederholt. Dann bezeichnet (Ωi , Pi ) den Wahrscheinlichkeitsraum, der zur

i-ten Durchführung des Zufallsexperimentes gehört.

Es gilt das für die Statistik wichtige schwache Gesetz der großen Zahlen:

Satz 2.31. Es seien X1 , . . . , Xn unabhängige Zufallsvariablen auf einem Wahrscheinlichkeitsraum (Ω, P ), die alle dieselbe Verteilungsfunktion haben (i.i.d.: independently identical distribution) mit Erwartungswert µ und Varianz σ 2 . Dann ist

auch X̃n = n1 (X1 + . . . + Xn ) eine Zufallsvariable auf Ω mit

lim P (|X̃n − µ| < ) = 1

n→∞

für jedes > 0.

Bemerkung 2.32. Der klassische Fall ist der, dass ein Zufallsexperiment mit

Z.V. X mehrfach (n mal) durchgeführt wird. Formal haben wir dann aber n

unabhängige Z.V. X1 , . . . , Xn , die jeweils den Ausgang des i-ten Experimentes

beschreiben. Formal sind das dann unabhängige Z.V. auf dem Produktraum.

Ferner kann man die Voraussetzungen etwas abschwächen.

23

2.6

Der kontinuierliche Fall

Im Fall eines Wahrscheinlichkeitsraumes mit einer überabzählbaren Ereignismenge Ω kann man, wie bereits erwähnt, nicht mehr sinnvoll jedem Ereignis

eine Wahrscheinlichkeit zuordnen. Deshalb muss man bei der Definition einer

Zufallsvariablen X : Ω → R darauf achten, dass zumindest den Ereignissen

{ω : X(ω) ≤ x}.

Wahrscheinlichkeiten zugeordnet werden können. Wir wollen diese Annahme

ab jetzt stillschweigend machen. Dann können wir wie im diskreten Fall eine

Verteilungsfunktion F : R → R definieren:

F (x) := P (X ≤ x).

Die Definitionen 2.9 und 2.7 übertragen sich, ebenso wie Satz 2.5 und Proposition 2.3.

Es sei noch bemerkt: Wenn der Wahrscheinlichkeitsraum Ω unendlich viele Elemente, die Zufallsvariable X aber nur endlich viele Realisierungen hat, sprechen

wir immer noch von einer diskreten Zufallsvariable.

Wir können im kontinuierlichen Fall in der Regel den einelementigen Ereignissen

keine positive Wahrscheinlichkeit zuordnen, ebenso kann man den Ereignissen

{ω : X(ω) = x} nicht immer eine positive W.K. zuordnen. Das Analogon zu

den Wahrscheinlichkeiten px ist hier die Dichtefunktion:

Definition 2.33. Wenn es für eine Verteilungsfunktion F eine Funktion f :

R → R gibt mit

Z x

F (x) =

f (t)dt,

−∞

so heißt f die zu F gehörende Dichtefunktion. Wir nennen X dann eine

stetige Zufallsvariable mit Verteilungsfunktion F und Dichte f .

Proposition 2.34. Sei X eine stetige Zufallsvariable mit Dichte f und Verteilungsfunktion F . Dann gilt F 0 (x) = f (x) und

P (a ≤ X ≤ b) =

Z

b

f (t)dt.

a

Insbesondere gilt P (X = x) = 0.

Auch die Begriffe Varianz und Erwartungswert lassen sich auf kontinuierliche

Zufallsvariable übertragen:

Definition 2.35. Sei X eine stetige Z.V. mit Verteilungsfunktion F und Dichte

f . Dann heißt

Z

∞

E(X) :=

−∞

24

x · f (x) dx

der Erwartungswert von X, sofern dieses Integral existiert. Entsprechend wird

die Varianz V (X) definiert:

Z ∞

(x − E(X))2 · f (x) dx.

V (X) =

−∞

Die Sätze über Erwartungswerte und Varianz in Kapitel 2.3 übertragen sich auf

den stetigen Fall, insbesondere gilt auch Satz 2.16.

Wir können die Varianz auch wie folgt berechnen:

Z ∞

x2 · f (x) dx − [E(X)]2 .

V (X) =

−∞

Definition 2.36 (Normalverteilung). Die vermutlich bekannteste und wichtigste Verteilungsfunktion ist die Normalverteilung mit Dichte

f (x) =

1 x−µ 2

1

√ e− 2 ( σ ) .

σ 2π

Wir nennen eine Z.V. normalverteilt wenn es µ und σ > 0 so gibt, dass die

Verteilungsfunktion der Z.V. diese Dichte hat, geschrieben X ∼ N (µ, σ 2 ). Gilt

µ = 0 und σ = 1 nennen wir die Zufallsvariable standardnormalverteilt. Die

zugehörige Verteilungsfunktion wird oft mit Φ bezeichnet.

Bemerkung 2.37. Die Funktion Φ ist als (im wesentlichen) das Integral der

2

Funktion e−x nicht durch “einfache” Funktionen darstellbar.

Beispiel 2.38. Zunächst ist hier ein Bild dreier Normalverteilungen, nämlich

einmal der Verteilung N (0, 1) (schwarz), dann N (0, 2) (blau) sowie N (0, 21 ) (rot):

0.8

0.6

0.4

0.2

0

−6

−4

−2

0

25

2

4

6

Hier sind die zugehörigen Verteilungsfunktionen:

1

0.75

0.5

0.25

−3

−2

−1

1

2

3

Beispiel 2.39. Erwartungswert einer N (µ, σ 2 ) verteilten Z.V. ist µ, die Varianz

ist σ 2 . In dem Fall ist die Zufallsvariable (X − µ)/σ standardnormalverteilt.

Die Verteilungsfunktion einer N (µ, σ 2 ) verteilten Z.V. ist

x−µ

Φ

σ

und die Dichtefunktion

wobei

1

f (x) = ϕ

σ

x−µ

σ

,

1 2

1

ϕ(x) = √ e− 2 x

2π

die Dichte der Standardnormalverteilung mit µ = 0 und σ = 1 ist.

Proposition 2.40. Sei X ∼ N (µ, σ 2 ). Dann gilt

P (a ≤ X ≤ b) = Φ(

2.7

b−µ

a−µ

) − Φ(

).

σ

σ

Weitere Eigenschaften der Normalverteilung

Satz 2.41. Es seien X1 und X2 zwei unabhängig normalverteilte Zufallsvariablen mit Erwartungswerten µ1 und µ2 sowie Varianzen σ12 und σ22 . Dann ist

auch X1 + X2 normalverteilt mit Erwartungswert µ1 + µ2 und Varianz σ12 + σ22 .

26

Man nennt diese Eigenschaft auch die Faltungseigenschaft der Normalverteilung:

Haben ganz allgemein zwei unabhängige Z.V. die Dichten f und g, so hat X1 +

X2 die Dichte

Z

∞

−∞

f (t)g(x − t) dt

und das hier auftretende Integral heißt die Faltung von f und g.

Beim schwachen Gesetz der großen Zahlen (Satz 2.31) haben wir gesehen, dass

man Erwartungswert und Varianz des arithmetischen Mittels von unabhängigen

und identisch verteilten Zufallsvariablen berechnen kann. Im Fall normalverteilter Z.V. kennt man sogar die Verteilung. Der Beweis ist im Gegensatz zu den

meisten bisher formulierten Sätze nicht trivial:

Satz 2.42 (Zentraler Grenzwertsatz). Es seien X1 , . . . , Xn unabhängige und

identisch verteilte Zufallsvariablen mit Erwartungswert µ und Varianz σ 2 auf

einem Wahrscheinlichkeitsraum (Ω, P ). Dann gilt für die Folge der Zufallsvariablen X̃n = n1 (X1 + . . . + Xn ):

!

X̃n − µ

√ ≤ z = Φ(z).

lim P

n→∞

σ/ n

Mit anderen Worten: Das arithmetische Mittel ist asymptotisch N (µ, σ 2 /n)verteilt.

Sei FB(n,p) die Verteilungsfunktion einer B(n, p) verteilten Zufallsvariable X.

Dann gilt

!

x + 21 − np

FB(n,p) (x) ≈ Φ p

np(1 − p)

falls np und n(1−p) beide groß sind (Faustregel: np(1−p) ≥ 9). Man nennt die

Addition von +1/2 die Stetigkeitskorrektur. Das wird deutlich, wenn man sich

ein Beispiel anschaut, z.B. die Verteilung von B(300, 0.2) und die entsprechende

Normalverteilung ohne und mit Stetigkeitskorrektur. Im ersten Bild ohne, im

zweiten Bild mit Stetigkeitskorrektur:

27

Man nennt diese Approximation der Binomialverteilung durch die Normalverteilung

auch den zentralen Grenzwertsatz von deMoivre-Laplace. Beachten Sie, dass bei

der Berechnung der W.K. P (k ≤ Sn ≤ l) die “Stetigkeitskorrektur” an der unteren Schranke mit einem anderen Vorzeichen erfolgt:

28

Proposition 2.43. Sei X ∼ B(n, p) mit np(1 − p) ≥ 9. Dann gilt

!

!

l + 21 − np

k − 21 − np

P (k ≤ X ≤ l) ≈ Φ p

−Φ p

.

np(1 − p)

np(1 − p)

Da die Poissonverteilung als Grenzverteilung der Binomialverteilung auftritt ist

es auch nicht überraschend, dass die Poissonverteilung FP (λ) zum Parameter λ

durch die Normalverteilung approximiert werden kann:

x + 1/2 − λ

√

.

FP (λ) (x) ≈ Φ

λ

2.8

Gleichverteilung und Exponentialverteilung

Eine Zufallsvariable X mit Realisierungen auf einem Intervall [a, b] heißt gleichverteilt, falls für die Wahrscheinlichkeiten gilt

P (X ∈ [c, d]) =

d−c

b−a

für a ≤ c ≤ d ≤ b. Die Dichtefunktion f (x) ist dann

1

x ∈ (a, b)

b−a

f (x) =

.

0

sonst

Man kann dann daraus leicht Erwartungswert und Varianz einer auf [a, b] gleichverteilten Zufallsvariablen X bestimmen:

b+a

E(X) =

2

(b − a)2

V (X) =

.

12

Definition 2.44. Eine Zufallsvariable X heißt exponentialverteilt zum Parameter λ (geschrieben X ∼ Exp(λ)), wenn die Dichte f (x) = λ · e−λx für x > 0

und 0 sonst ist.

Satz 2.45. Die Verteilungsfunktion F (x) einer Exponentialverteilung ist F (x) =

1−e−λx für x ≥ 0 und 0 für x < 0. Der Erwartungswert ist 1/λ und die Varianz

1/λ2 .

Bemerkung 2.46. Die Exponentialverteilung ist gedächtnislos im folgenden

Sinne:

P (X ≥ t + h|X ≥ t) = P (X ≥ h)

für alle t, h > 0.

Hier sind die Bilder der Dichten von zwei Exponentialverteilungen, einmal zum

Parameter λ = 1 (rot) und einmal zum Parameter λ = 1/2 (blau).

29

1

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

1

2.9

2

3

4

5

6

7

8

9

10

Gammaverteilung

Zunächst verallgemeinern wir den Begriff der Fakultät:

Z ∞

Γ(z) :=

xz−1 e−x dx, z > 0.

0

Es gilt Γ(k) = (k − 1)! für k ∈ {1, 2, 3, . . .}.

Definition 2.47. Eine Zufallsvariable X heißt gammaverteilt (∼ Γ(α, λ)) mit

Parametern α > 0 und λ > 0, wenn ihre Dichte

f (x) =

λα α−1 −λx

x

e

Γ(α)

für x > 0

ist (und 0 für x ≤ 0).

Der Parameter λ ist nur ein “Formparameter”, denn wenn X ∼ Γ(α, 1), dann

gilt λ1 X ∼ Γ(α, λ). Der Parameter α hingegen hat wesentlichen Einfluß auf die

Dichtefunktion. Im Fall α = 1 erhalten wir die Exponentialverteilung.

Satz 2.48. Sei X ∼ Γ(α, λ), dann

E(X)

=

α

λ

V (X)

=

α

.

λ2

Das folgende Bild zeigt die Dichte der Gammaverteilung jeweils für λ = 1 und

α = 0.5 (rot), α = 1 (blau) und α = 2 (grün):

30

3.0

2.5

2.0

1.5

1.0

0.5

0

0

1

2

3

4

31

5

6

7

8

9