Finanzmathematik 1

Werbung

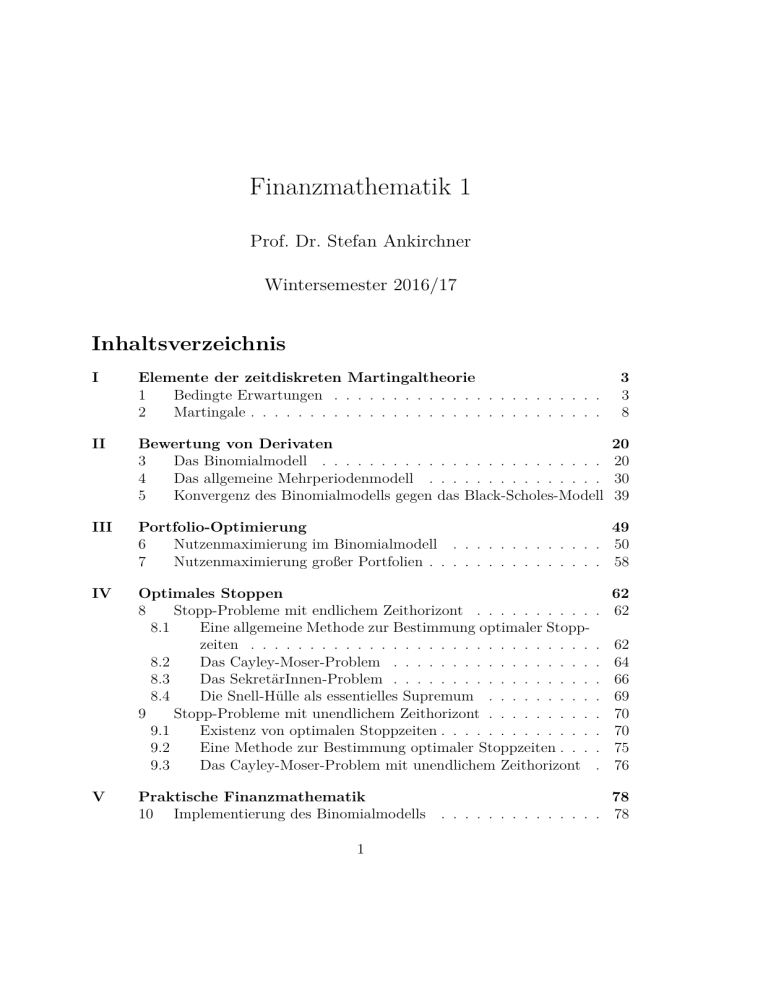

Finanzmathematik 1

Prof. Dr. Stefan Ankirchner

Wintersemester 2016/17

Inhaltsverzeichnis

I

Elemente der zeitdiskreten Martingaltheorie

1

Bedingte Erwartungen . . . . . . . . . . . . . . . . . . . . . . .

2

Martingale . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3

3

8

II

Bewertung von Derivaten

3

Das Binomialmodell . . . . . . . . . . . . . . . . . . . . . . . .

4

Das allgemeine Mehrperiodenmodell . . . . . . . . . . . . . . .

5

Konvergenz des Binomialmodells gegen das Black-Scholes-Modell

20

20

30

39

III

Portfolio-Optimierung

49

6

Nutzenmaximierung im Binomialmodell . . . . . . . . . . . . . 50

7

Nutzenmaximierung großer Portfolien . . . . . . . . . . . . . . . 58

IV

Optimales Stoppen

8

Stopp-Probleme mit endlichem Zeithorizont . . . . . . . . . .

8.1

Eine allgemeine Methode zur Bestimmung optimaler Stoppzeiten . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8.2

Das Cayley-Moser-Problem . . . . . . . . . . . . . . . . .

8.3

Das SekretärInnen-Problem . . . . . . . . . . . . . . . . .

8.4

Die Snell-Hülle als essentielles Supremum . . . . . . . . .

9

Stopp-Probleme mit unendlichem Zeithorizont . . . . . . . . .

9.1

Existenz von optimalen Stoppzeiten . . . . . . . . . . . . .

9.2

Eine Methode zur Bestimmung optimaler Stoppzeiten . . .

9.3

Das Cayley-Moser-Problem mit unendlichem Zeithorizont

V

62

. 62

.

.

.

.

.

.

.

.

62

64

66

69

70

70

75

76

Praktische Finanzmathematik

78

10 Implementierung des Binomialmodells . . . . . . . . . . . . . . 78

1

INHALTSVERZEICHNIS

10.1

Bewertungsalgorithmen, die die Binomialverteilung verwenden . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

10.2 Baumalgorithmen . . . . . . . . . . . . . . . . . . . . . . .

10.3 Bewertung amerikanischer Optionen . . . . . . . . . . . .

11 Monte-Carlo-Verfahren . . . . . . . . . . . . . . . . . . . . . .

12 Der LSMC-Algorithmus . . . . . . . . . . . . . . . . . . . . .

13 Portfolio-Optimierung . . . . . . . . . . . . . . . . . . . . . .

13.1 Lösungsmethode: Simulation . . . . . . . . . . . . . . . .

13.2 Lösungsmethode: Verteilung . . . . . . . . . . . . . . . . .

2

.

.

.

.

.

.

.

.

78

80

81

84

90

93

93

94

I

Elemente der zeitdiskreten Martingaltheorie

Literaturempfehlung: Durrett Probability: Theory and Examples

1

Bedingte Erwartungen

Ziel des Kapitels: Wiederholung wichtiger Eigenschaften von bedingten Erwartungen.

Sei (Ω, F, P ) ein Wahrscheinlichkeitsraum.

Definition

Sei R̄ = R ∪ {−∞, +∞}. Für p ∈ [1, ∞] definieren wir die Räume Lp (Ω, F, P )

(kurz Lp ) durch

(

R

X : Ω → R̄|X ist F-mb, Ω |X|p dP < ∞

p

L (Ω, F, P ) := X : Ω → R̄|X ist F-mb, ess supω∈Ω |X(ω)| < ∞

p ∈ [1, ∞),

p = ∞.

Sei X eine integrierbare ZV (d.h X ∈ L1 (Ω, F, P )). Weiterhin sei G eine Sub-σAlgebra von F. Eine Zufallsvariable Y heißt bedingte Erwartung von X bezüglich G, falls gilt:

(1) Y ist G-messbar,

(2) für alle A ∈ G gilt:

R

A

XdP =

R

A

Y dP .

Wir zeigen die Existenz einer bedingten Erwartung mit Hilfe des Satzes von RadonNikodym. Dazu:

Erinnerung (Absolutstetigkeit von Wahrscheinlichkeitsmaßen)

Sei Q ein weiteres Wahrscheinlichkeitsmaß auf (Ω, F). Dann ist Q absolutstetig

bezüglich P (man schreibt Q P ) falls für alle A ∈ F gilt:

P (A) = 0 ⇒ Q(A) = 0

Weiterhin: P und Q heißen äquivalent (man schreibt P ∼ Q), falls

P Q und Q P.

3

1

Bedingte Erwartungen

Satz 1.1 (Radon-Nikodym)

Falls Q P , dann existiert eine Zufallsvariable X ∈ L1 (Ω, F, P ) mit X ≥ 0,

sodass für alle A ∈ F gilt:

Z

Q(A) = XdP.

A

X heißt dann Dichte von Q bezüglich P auf F. Man schreibt häufig

dQ

dP

für X.

Beweis. Stochastik oder Maßtheorie-Vorlesung.

Satz 1.2

Sei X ∈ L1 (Ω, F, P ) und G ⊂ F eine Sub-σ-Algebra. Dann existiert eine bedingte Erwartung Y von X bezüglich G. Y ist bis auf Nullmengen eindeutig

bestimmt, d.h. es gilt:

Y, Y 0 bed. Erw. von X ⇒ Y = Y 0

a

f.s.a

P ({ω : Y (ω) 6= Y 0 (ω)}) = 0

Beweis. Wir zeigen zunächst, dass eine bedingte Erwartung integrierbar ist (d.h.

in L1 (Ω, F, P ) liegt). Dazu sei A = {Y ≥ 0}. Dann gilt

Z

Z

Z

Z

E|Y | = Y dP − Y dP = XdP − XdP

A

Ac

Z

≤

|X|dP +

A

A

Ac

Z

|X|dP = E|X| < ∞.

Ac

Nun zur Eindeutigkeit: Seien Y, Y 0 zwei bedingte Erwartungen von X. Dann gilt für

A(n) := {Y − Y 0 ≥ n1 }, n ≥ 1, nach der Chebyshev-Ungleichung und Eigenschaft

(2)

Z

1

P (A(n)) ≤

(Y − Y 0 )dP = 0.

n

A(n)

Damit folgt P (A(n)) = 0. Mit der σ-Stetigkeit von P folgt

P (Y − Y 0 > 0) = lim P (A(n)) = 0.

n→∞

Analog zeigt man P (Y − Y 0 < 0) = 0. Damit folgt P (Y = Y 0 ) = 1, d.h. Y = Y 0

f.s.

4

1

Bedingte Erwartungen

Existenz: Sei zunächst X ≥ 0 mit E(X) ∈ (0, ∞) (im Fall E(X) = 0, ist 0 eine

bedingte Erwartung von X). Wir definieren ein neues Wahrscheinlichkeitsmaß Q

auf G wie folgt:

Z

1

Q(A) :=

XdP, A ∈ G.

E(X)

A

Es gilt Q P auf G. Nach Satz 1.1 existiert eine Zufallsvariable Ye ∈ L1 (Ω, G, P )

mit Ye ≥ 0 und

Z

Q(A) = Ye dP, A ∈ G.

A

Somit ist Y := E(X)Ye eine bedingte Erwartung von X.

Sei nun X eine beliebige Zufallsvariable in L1 (Ω, F, P ) und X = X + −X − . X + und

X − haben jeweils eine bedingte Erwartung Y + bzw. Y − . Definiere Y := Y + − Y − .

Dann gilt für alle A ∈ G

Z

Z

Z

Z

Z

+

−

+

XdP = X dP − X dP = Y dP − Y − dP

A

A

Z

=

A

A

Y dP.

A

Also ist Y eine bedingte Erwartung von X.

Notation: Man bezeichnet die bedingte Erwartung von X ∈ L1 (Ω, F, P ) bezüglich G mit E(X | G).

Eigenschaften von bedingten Erwartungen

Im Folgenden seinen X, Y integrierbare Zufallsvariablen und G eine Sub-σ-Algebra

von F. Es gilt:

• Linearität: für a, b ∈ R gilt

E(aX + bY | G) = aE(X | G) + bE(Y | G),

f.s.

• Monotonie:

X ≤ Y,

f.s. ⇒ E(X | G) ≤ E(Y | G),

f.s.

• E[X|G] ∈ L1 (Ω, G, P )

5

1

Bedingte Erwartungen

• Falls X G-messbar ist, dann gilt E[X|G] = X.

• Falls X unabhängig von G ist, dann gilt E[X|G] = E[X].

Lemma 1.3 (Jensen-Ungleichung)

Sei ϕ : R → R konvex und E|ϕ(X)| < ∞. Dann gilt

f.s.

ϕ(E(X | G)) ≤ E(ϕ(X) | G),

Beweis. Sei S = {(a, b) ∈ Q2 : ax + b ≤ ϕ(x), ∀x ∈ R}. Man kann zeigen:

ϕ(x) = sup{ax + b : (a, b) ∈ S}. Sei nun (a, b) ∈ S. Dann gilt

E[ϕ(X) | G] ≥ E[aX + b | G] = aE(X | G) + b,

f.s.

Damit folgt

E[ϕ(X) | G] ≥ sup {aE(X | G) + b} = ϕ(E(X | G)),

f.s.

(a,b)∈S

Beispiel

Sei ϕ(x) = x2 , E(X 2 ) < ∞. Dann ist (E(X | G))2 ≤ E(X 2 | G), f.s.

Lemma 1.4

Sei H eine Sub-σ-Algebra von G (also H ⊂ G ⊂ F). Dann gilt

(a) E[E(X | G) | H] = E(X | H).

( Turmeigenschaft“)

”

(b) E[E(X | H) | G] = E(X | H).

Beweis. (a) Sei A ∈ H. Dann gilt

Z

Z

Z

E(X | G)dP = XdP = E(X | H)dP.

A

A

A

(b) gilt, da E(X | H) bereits messbar bezüglich G ist.

Lemma 1.5

Sei Y G-messbar und E|XY | < ∞. Dann gilt

E(XY | G) = Y E(X | G),

6

f.s.

1

Bedingte Erwartungen

Beweis. Wir zeigen die Aussage durch maßtheoretische Induktion:

1) Sei Y = 1B , B ∈ G. Dann gilt für A ∈ G

Z

Z

Z

Z

XY dP =

XdP =

E(X | G)dP = Y E(X | G)dP.

A

A∩B

A∩B

A

Also E(XY | G) = Y E(X | G).

2) Sei Y eine einfache Zufallsvariable, d.h. eine Zufallsvariable der Form

Y =

n

X

ai ∈ R, Bi ∈ G.

ai 1Bi ,

i=1

Die Behauptung folgt aus 1) und der Linearität der bedingten Erwartung.

3) Sei nun Y beliebig. Durch Zerlegung in Positiv- und Negativteil können wir

annehmen: X, Y ≥ 0. Wähle einfache Zufallsvariablen Yn mit

und

0 ≤ Y1 ≤ Y2 ≤ . . .

sup Yn = Y.

n

Monotone Konvergenz impliziert, für alle A ∈ G,

Z

Z

Z

Z

2)

XY dP = lim

XYn dP = lim

Yn E(X | G)dP = Y E(X | G)dP.

n→∞

A

n→∞

A

A

A

Lemma 1.6

Sei E(X 2 ) < ∞. Dann minimiert E(X | G) den quadratischen Abstand zu X

unter allen Y ∈ L2 (Ω, G, P ), d.h.

E[(X − E(X | G))2 ] = min{E[(X − Y )2 ] : Y ∈ L2 (Ω, G, P )}.

Beweisskizze. Sei Z ∈ L2 (Ω, G, P ). Dann ist E|XZ| < ∞ und mit Lemma 1.5

folgt: E(ZX | G) = ZE(X | G). Damit folgt

E[Z(X − E(X | G))] = E[ZX] − E[E(ZX | G)] = 0.

Sei Y ∈ L2 (Ω, G, P ) und setze Z := Y − E(X | G). Dann

E[(X − Y )2 ] = E[(X − E(X | G) − Z)2 ] = E[(X − E(X | G))2 ] + E(Z 2 ).

Der Abstand wird minimal, falls Z = 0, d.h. falls Y = E(X | G).

7

2

2

Martingale

Martingale

Sei (Ω, F, P ) ein Wahrscheinlichkeitsraum.

Definition

Sei (Fn )n∈N0 eine Folge von σ-Algebren mit Fn ⊂ F . (Fn ) heißt Filtration, falls

F0 ⊂ F1 ⊂ F2 ⊂ . . . ⊂ Fn ⊂ . . . .

In diesem Fall heißt (Ω, F, (Fn )n∈N0 , P ) filtrierter Wahrscheinlichkeitsraum.

Definition

Eine Familie von Zufallsvariablen (Xn )n∈N0 auf (Ω, F, P ) heißt stochastischer

Prozess. Sei (Fn )n∈N0 eine Filtration. Ein stochastischer Prozess (Xn )n∈N0 heißt

adaptiert an (Fn )n∈N0 , falls für alle n ∈ N0 gilt: Xn ist Fn -messbar. Ein stochastischer Prozess (Xn )n≥1 heißt previsibel bezüglich (Fn )n∈N0 , falls für alle n ≥ 1

gilt: Xn ist Fn−1 -messbar.

Bemerkung

Sei (Xn )n≥0 ein stochastischer Prozess. Setze Gn := σ(X0 , . . . , Xn ) (= kleinste σAlgebra bezüglich derer X0 , . . . , Xn messbar sind). Dann ist (Xn ) adaptiert an

(Gn ).

Definition

Sei (Xn )n≥0 ein stochastischer Prozess und (Fn )n≥0 eine Filtration. (Xn ) heißt

Martingal bezüglich (Fn ), falls gilt:

(1) (Xn ) ist adaptiert an (Fn ),

(2) E|Xn | < ∞, für alle n ≥ 0,

(3) E[Xn+1 | Fn ] = Xn , für alle n ≥ 0.

(Xn ) heißt Supermartingal, falls (1), (2) und

(3’) E[Xn+1 | Fn ] ≤ Xn für alle n ≥ 0 gilt.

(Xn ) heißt Submartingal, falls (1), (2) und

(3”) E[Xn+1 | Fn ] ≥ Xn für alle n ≥ 0 gilt.

Bemerkung (Merksatz)

There is nothing super about a supermartingale.

Lemma 2.1

Sei (Xn ) ein Martingal. Dann gilt für alle n > m, dass E(Xn | Fm ) = Xm .

Beweis. Sei n = m + k. Wir beweisen die Aussage durch Induktion nach k.

8

2

Martingale

k = 1: Aussage folgt aus der Definition von Martingalen.

k → k + 1:

E(Xm+k+1 | Fm )

Turmeig.

=

=

I.V.

=

E(E(Xm+k+1 | Fm+k ) | Fm )

E(Xm+k | Fm )

Xm .

Bemerkung

Sei (Xn ) ein Super- bzw. Submartingal. Dann gilt für n > m:

E(Xn | Fm ) ≤ Xm

bzw.

E(Xn | Fm ) ≥ Xm .

Beispiel (Irrfahrten)

Sei (Zn ) iid (unabhängig und identisch verteilt) mitP

P (Zn = 1) = p und P (Zn =

−1) = 1 − p, wobei p ∈ [0, 1]. Sei X0 = 0 und Xn = ni=1 Zi , n ≥ 1. Weiterhin sei

Fn = σ(X0 , . . . , Xn ), n ≥ 0. Falls p = 12 , dann heißt (Xn ) einfache symmetrische

Irrfahrt.

Es gilt:

(1) p ≥

1

2

⇒ (Xn ) ist Submartingal,

(2) p ≤

1

2

⇒ (Xn ) ist Supermartingal.

Insbesondere: p =

1

2

⇒ (Xn ) ist Martingal.

Begründung:

1. Nach Definition von (Fn ) ist (Xn ) adaptiert.

2. |Xn | ≤ n. Also ist Xn integrierbar.

3. Beachte: E(Zn ) = p − (1 − p) = 2p − 1. Somit

E(Xn+1 | Fn ) = E(Xn + Zn+1 | Fn )

= E(Xn | Fn ) + E(Zn+1 | Fn ) = Xn + E(Zn+1 )

= Xn + 2p − 1.

Hiermit folgt die Behauptung.

Lemma 2.2

Sei (Xn ) ein Martingal und ϕ : R → R eine konvexe Funktion mit E|ϕ(Xn )| < ∞

für alle n ≥ 0. Dann ist ϕ(Xn ) ein Submartingal.

9

2

Martingale

Beweis. Eigenschaften (1) und (2): X Eigenschaft (3”): Mit Lemma 1.3 folgt

E(ϕ(Xn+1 ) | Fn ) ≥ ϕ(E(Xn+1 | Fn )) = ϕ(Xn ).

Korollar 2.3

Sei p ≥ 1 und (Xn ) ein Martingal mit E|Xn |p < ∞ für alle n ≥ 0. Dann ist |Xn |p

ein Submartingal.

Definition

Sei (Xn )n≥0 ein adaptierter und (Hn )n≥1 ein previsibler stochastischer Prozess mit

Werten in R. Dann heißt

InX (H)

:=

n

X

Hk (Xk − Xk−1 ),

n ≥ 0,

k=1

stochastisches Integral von (Hn ) bezüglich (Xn ). Hier: I0X (H) := 0.

Bemerkung (Mögliche Interpretation)

(Xn ) = Preisprozess eines Wertpapieres

(Hn ) = Anlagestrategie; Hn ist die Stückzahl des Wertpapieres im Portfolio zwischen den Zeitpunkten n − 1 und n.

InX (H) = Gewinn bis zur Zeit n (negativer Gewinn bedeutet Verlust)

Satz 2.4

Sei (Xn )n≥0 ein Martingal bezüglich (Fn ). Weiterhin sei (Hn )n≥1 previsibel mit

Hn beschränkt für alle n ≥ 1. Dann ist auch (InX (H)) ein Martingal.

Beweis. 1. InX (H) ist adaptiert: folgt aus der Konstruktion.

2. Wir zeigen durch Induktion nach n: E|InX (H)| < ∞.

n = 0: I0X (H) = 0. X

n → n + 1: Sei InX (H) integrierbar. Beachte:

X

In+1

(H) = InX (H) + Hn+1 (Xn+1 − Xn ).

Also

X

E|In+1

(H)| ≤ E|InX (H)| +E|Hn+1 (Xn+1 − Xn )|.

| {z }

<∞, nach I.V.

10

2

Martingale

Sei C ∈ R+ mit |Hn+1 | ≤ C, f.s. Dann

E|Hn+1 (Xn+1 − Xn )| = E(|Hn+1 ||Xn+1 − Xn |) ≤ C · E|Xn+1 − Xn |

≤ C · (E|Xn+1 | + E|Xn |) < ∞.

X

Also ist In+1

(H) integrierbar.

3. Sei n ≥ 0. Dann gilt

X

E((In+1

(H) | Fn ) = InX (H) + E[Hn+1 (Xn+1 − Xn ) | Fn ]

= InX (H) + Hn+1 E[Xn+1 − Xn | Fn ]

|

{z

}

(Lemma 1.5)

=0

=

InX (H).

Bemerkung

Interpretation: Falls (Xn ) ein Martingal ist, so ist zu jedem Zeitpunkt der erwartete

Gewinn einer Anlagestrategie gleich 0. Denn

E(InX (H)) = E(I0X (H)) = 0.

Satz 2.5

Sei (Xn )n≥0 ein Sub- bzw. Supermartingal und (Hn )n≥1 previsibel mit Hn ≥ 0

und Hn beschränkt. Dann ist auch InX (H) ein Sub- bzw. Supermartingal.

Beweis. Ähnlich zum Beweis von Satz 2.4.

Mit stochastischen Integralen lässt sich auch die Martingaleigenschaft verifizieren.

Satz 2.6

Sei (Xn )n≥0 ein adaptierter Prozess mit X0 = 0 für den gelte:

(Hn )n≥1 beschränkt und previsibel =⇒ InX (H) ∈ L1 und E(InX (H)) = 0.

Dann ist X ein Martingal.

Beweis. Adaptiertheit: X

Integrierbarkeit: Für alle n ≥ 1 gilt Xn = Xn − X0 = InX (1) ∈ L1 .

3. Martingaleigenschaft: Wähle A ∈ Fn und setze Hn+1 = 1A und Hk = 0 für

X

X

k 6= n. Dann ist In+1

(H) = 1A (Xn+1 − Xn ). Aus E(In+1

(H)) = 0 folgt

E[1A Xn+1 ] = E[1A Xn ].

Somit gilt also E[Xn+1 |Fn ] = Xn .

11

2

Martingale

In späteren Kapiteln benötigt: mehrdimensionale Versionen von Satz 2.4 und 2.6.

Hierzu sei d ∈ N. Für alle 1 ≤ j ≤ d sei (Xnj )n≥0 adaptiert und (Hnj )n≥1 previsibel.

Wir schreiben

Xn = (Xn1 , . . . , Xnd ) und Hn = (Hn1 , . . . , Hnd ). Des Weiteren bezeichne

Pd

x · y = j=1 xj yj das Skalarprodukt von x, y ∈ Rd . Das stochastische Integral von

(Hn ) bez. (Xn ) ist definiert als

InX (H)

=

n

X

k=1

Hk · Xk =

n X

d

X

j

Hkj (Xk+1

− Xkj ).

(1)

k=1 j=1

Wir bezeichnen (Xn ) als (d-dimensionales) Martingal, falls jede Komponente (Xnj )

ein Martingal ist.

Satz 2.7

Ist (Xn )n≥0 ein d-dim Martingal und (Hn )n≥1 previsibel mit Hn beschränkt für

alle n ≥ 1, dann ist (InX (H)) ein Martingal.

Beweis. Ähnlich zum Beweis von Satz 2.4.

Satz 2.8

Sei (Xn )n≥0 ein Rd -wertiger adaptierter Prozess mit X0 = 0 für den gelte:

(Hn ) = (Hn1 , . . . , Hnd ) beschr. und prev. =⇒ InX (H) ∈ L1 und E(InX (H)) = 0.

Dann ist X ein Martingal.

Beweis. Ähnlich zum Beweis von Satz 2.6.

Definition

Sei (Fn )n≥0 eine Filtration. Eine Zufallsvariable τ : Ω → N0 ∪ {+∞} heißt Stoppzeit bezüglich (Fn ), falls {τ = n} ∈ Fn für alle n ∈ N ∪ {∞}.

Beispiel

Sei (Xn )n≥0 ein stochatischer Prozess und Fn := σ(X0 , . . . , Xn ), n ≥ 0.

a) τ := min{n ≥ 0 : Xn ≥ 5} ist Stoppzeit bezüglich (Fn ). Hier: min ∅ = ∞.

Begründung:

{τ = n} = {Xn ≥ 5} ∩ {Xn−1 < 5} ∩ . . . ∩ {X0 < 5} ∈ Fn .

b) τ := max{0 ≤ n ≤ 10 : Xn = max0≤k≤10 Xk }

12

2

Martingale

2

1

6

10

Im Allgemeinen hängt {τ = n} von allen Zufallsvariablen X0 , . . . , X10 ab. Zum

Beispiel

(

∈ F10

{τ = 0} = {X0 > X1 } ∩ {X0 > X2 } ∩ . . . ∩ {X0 > X10 }

,

∈

/ F0

außer in trivialen Fällen. Deshalb ist τ im Allgemeinen keine Stoppzeit.

Lemma 2.9

Sei τ : Ω → N0 ∪ {∞} eine Abbildung. Dann:

τ ist Stoppzeit

⇔

{τ ≤ n} ∈ Fn für alle n ∈ N.

S

Beweis. ⇒“ {τ ≤ n} = nk=0 {τ = k} ∈ Fn .

”

⇐“ Für n ≥ 1 gilt: {τ = n} = {τ ≤ n} ∩ {τ ≤ n − 1}c ∈ Fn .

”

Für n = 0: {τ = 0} = {τ ≤ 0} ∈ F0 .

Lemma 2.10

Seien σ und τ zwei Stoppzeiten. Dann sind auch σ ∧ τ und σ ∨ τ Stoppzeiten.a

a

x ∧ y := min{x, y} und x ∨ y := max{x, y}.

Beweis. a) {σ ∧ τ ≤ n} = {σ ≤ n} ∪ {τ ≤ n} ∈ Fn .

b) {σ ∨ τ ≤ n} = {σ ≤ n} ∩ {τ ≤ n} ∈ Fn .

Mit Lemma 2.9 folgt, dass σ ∧ τ und σ ∨ τ Stoppzeiten sind.

Notation: Sei (Xn )n≥0 ein stochastischer Prozess und τ eine Stoppzeit. Wir bezeichnen mit (Xnτ )n≥0 den gestoppten Prozess

Xnτ (ω) := Xn∧τ (ω) (ω),

n ≥ 0.

13

2

Martingale

Bemerkung

Für alle n ≥ 0 ist Xnτ eine Zufallsvariable, denn:

{Xnτ

≤ a} = {ω : Xn∧τ (ω) (ω) ≤ a} =

n

[

({τ ∧ n = k} ∩ {Xk ≤ a}) ∈ F ,

a ∈ R.

k=0

Satz 2.11

Sei τ eine Stoppzeit und (Xn )n≥0 ein Martingal bezüglich (Fn ). Dann ist auch

(Xnτ )n≥0 ein Martingal bezüglich (Fn ).

Beweis. Setze Hn := 1{τ ≥n} , n ≥ 1. Da {τ ≥ n} = {τ ≤ n − 1}c ∈ Fn−1 , ist (Hn )

previsibel. Nach Satz 2.4 ist (InX (H)) ein Martingal. Beachte:

InX (H)

=

n

X

1{τ ≥k} (Xk − Xk−1 ) = Xτ ∧n − X0 .

k=1

Damit folgt Xnτ = Xτ ∧n = InX (H) + X0 ist Martingal.

Satz 2.12

Sei τ eine Stoppzeit und (Xn ) ein Sub- bzw. Supermartingal. Dann ist auch

(Xnτ )n≥0 ein Sub- bzw. Supermartingal.

Beweis. Ähnlich zum Beweis von Satz 2.11, aber unter Verwendung von Satz 2.5,

statt Satz 2.4. Beachte dazu: Hn ≥ 0, also kann man Satz 2.5 anwenden.

Satz 2.13 (Optional stopping theorem)

Sei (Xn ) ein Martingal, k ∈ N und τ eine Stoppzeit mit P (τ ≤ k) = 1. Dann

gilt

E(X0 ) = E(Xτ ) = E(Xk ).

Beweis. 1. Gleichung: nach Satz 2.11 ist X τ ein Martingal. Also

E(X0 ) = E(X0τ ) = E(Xkτ ) = E(Xτ ).

2. Gleichung: folgt aus E(Xk ) = E(X0 ).

Beispiel (Verdopplungsstrategie)

P

Sei (Yi )i≥1 iid mit P (Yi = 1) = P (Yi = −1) = 12 . Sei X0 = 0 und Xn = ni=1 Yi ,

n ≥ 1. Sei F0 = {∅, Ω} und Fn = σ(Y1 , . . . , Yn ), n ≥ 1. Dann ist (Xn )n≥0 ein

14

2

Martingale

Martingal bezüglich (Fn ) (siehe Beispiel oben). Betrachte folgende Anlagestrategie

(Hn ):

H1 = 1

H2 = 2 · 1{Y1 =−1}

..

.

Hn = 2n−1 · 1{Y1 =−1,...,Yn−1 =−1}

..

.

Wie groß ist InX (H), der Gewinn zur Zeit n?

Satz 2.14

Für die Verdopplungsstrategie (Hn ), n ≥ 1 gilt:

P (InX (H) = 1) = 1 −

1

.

2n

P (InX (H) = 1 − 2n ) =

1

.

2n

Beweis. Wir zeigen durch Induktion nach n: für alle n ≥ 1 gilt

(

1 − 2n falls Y1 = . . . = Yn = −1

InX (H) =

.

1

sonst

n = 1:

I1X (H)

(

−1 falls Y1 = −1

= H1 (X1 − X0 ) = Y1 =

.

+1 sonst

n → n + 1: Die Behauptung gelte für n. Dann

X

In+1

(H) = InX (H) + Hn+1 (Xn+1 − Xn )

= InX (H) + 2n · 1{Y1 =...=Yn =−1} Yn+1

(

1 − 2n − 2n = 1 − 2n+1 falls Y1 = . . . = Yn = Yn+1 = −1

=

.

1

sonst

Beachte nun: {InX (H) = 1 − 2n } =

gilt

P (InX (H)

Tn

k=1 {Yk

n

=1−2 )=

n

Y

k=1

= −1}. Da die Yi unabhängig sind,

P (Yk = −1) =

1

.

2n

15

2

Martingale

Daraus folgt die Behauptung.

Korollar 2.15

Für die Verdopplungsstrategie gilt:

lim P (InX (H) = 1) = 1.

n→∞

Bemerkung

1) (InX (H)) ist ein Martingal (wg. Satz 2.4). Also gilt E(InX (H)) = I0X (H) = 0, für

alle n ≥ 0. D.h.: Zu jedem Zeitpunkt ist der erwartete Gewinn 0, obwohl InX (H)

f.s. gegen 1 konvergiert (fast sichere Konvergenz, aber nicht in Erwartung (d.h.

nicht L1 -Konvergenz)). Eine Umsetzung der Strategie erfordert unbeschränktes Kapital, ist also praktisch nicht möglich. In vielen finanzmathematischen

Modellen werden Verdopplungsstrategien ausgeschlossen.

2) (InX (H)) ist ein Beispiel für ein Martingal, das f.s. gegen einen Grenzwert konvergiert. Jetzt: allgemeines Kriterium für Martingalkonvergenz.

Beobachtung: Ein stochastischer Prozess (Xn ) konvergiert genau dann wenn jedes Intervall [a, b] nur endlich oft durchquert wird.

b

a

Zunächst Abschätzung der Anzahl an Durchquerungen. Dazu setze N (0) = −1

und definiere rekursiv für k ≥ 1

N (2k − 1) = min{m > N (2k − 2) : Xm ≤ a},

N (2k) = min{m > N (2k − 1) : Xm ≥ b}.

16

2

Martingale

b

a

0 N (1)

N (2)

N (3)

Man kann durch Induktion zeigen: Für alle j ≥ 1 gilt:

N (j) ist Stoppzeit bezüglich Fn = σ(X0 , . . . , Xn ).

Betrachte folgende buy-low-sell-high-Strategie (Hn )n≥1 :

(

1 falls N (2k − 1) < n ≤ N (2k)

Hn =

.

0 sonst

(Hn ) ist previsibel, denn:

{Hn = 1} = {ω ∈ Ω : ∃k ≥ 1 : N (2k − 1) < n ≤ N (2k)}

[

=

({N (2k − 1) ≤ n − 1} ∩ {N (2k) ≤ n − 1}c )

|

{z

} |

{z

}

k≥1

∈Fn−1

∈Fn−1

∈ Fn−1

Sei Un := sup{k ≥ 1 : N (2k) ≤ n} die Anzahl der Durchquerungen bis zur Zeit n.

Lemma 2.16 (Doob’s upcrossing lemma)

Ist (Xn ) ein Submartingal bezüglich (Fn ), dann gilt

(b − a)EUn ≤ E(Xn − a)+ − E(X0 − a)+ .

Beweis. Setze Yn := a + (Xn − a)+ . (Yn ) ist ein Submartingal, denn

1. (Yn ) ist adaptiert.

2. E|Yn | ≤ |a| + E|Xn | < ∞ für alle n ≥ 0.

17

2

Martingale

3.

E[Yn+1 | Fn ] = E[a + (Xn+1 − a)+ | Fn ] = a + E[(Xn+1 − a)+ | Fn ]

≥ a + (E(Xn+1 | Fn ) − a)+

≥ a + (Xn − a)+

= Yn

b

a

0 N (1)

N (2)

N (3)

Es gilt: (b − a)Un ≤ InY (H). Mit Km := 1 − Hm gilt

InY (H) + InY (K) = InY (1) = Yn − Y0 .

Mit Satz 2.5 folgt: InY (K) ist ein Submartingal, also E(InY (K)) ≥ E(I0Y (K)) = 0.

Damit folgt

E(Yn − Y0 ) = E(InY (H)) + E(InY (K)) ≥ E(InY (H)) ≥ (b − a)EUn .

Damit folgt die Behauptung.

Satz 2.17 (Martingalkonvergenzsatz)

Sei (Xn )n≥0 ein Submartingal mit supn→∞ E(Xn+ ) < ∞. Dann konvergiert (Xn )

f.s. gegen eine Zufallsvariable X mit E|X| < ∞.

Beweis. Beachte: (Xn − a)+ ≤ Xn+ + |a|. Lemma 2.16 impliziert somit

|a| + E(Xn+ )

EUn ≤

.

b−a

Mit dem Satz der monotonen Konvergenz folgt

lim EUn = EU,

18

2

Martingale

wobei U := limn→∞ Un (= Anzahl aller Durchquerungen). Mit den Annahmen

folgt also EU < ∞. Insbesondere ist U < ∞, f.s. und somit

P (lim inf Xn ≤ a < b ≤ lim sup Xn ) = 0.

n→∞

n→∞

Da a und b beliebig sind, gilt auch

[

P

{lim inf Xn ≤ a < b ≤ lim sup Xn } = 0.

a,b∈Q

a<b

Also lim infn Xn = lim supn Xn , f.s. Daher konvergiert Xn f.s. gegen eine Zufallsvariable X.

Zur Integrierbarkeit von X: Mit Fatous Lemma folgt

EX + = E lim inf Xn+ ≤ lim inf EXn+ ≤ sup EXn+ < ∞.

n

n

n

Für den Negativ-Teil gilt:

EXn− = −EXn + EXn+

−Xn Supermartingal

≤

−EX0 + sup EXn+ < ∞.

n

Also mit Fatou:

EX − = E lim inf Xn− ≤ lim inf EXn− ≤ −EX0 + sup EXn+ < ∞.

n

n

n

Daraus folgt E|X| = EX + + EX − < ∞.

19

II

Bewertung von Derivaten

Ein Finanzderivat (kurz Derivat) ist ein Vertrag dessen wirtschaftlicher Wert

vom Verlauf einer marktbezogenen Referenzgröße abhängt.

Beispiele:

• Forward contract (kurz: forward) ist eine Vereinbarung zwischen 2 Vertragsparteien ein Gut (Wertpapier, Rohstoff, landwirtschaftliches Produkt,

…) an einem festgelegten Datum T (in der Zukunft) zu einem heute vereinbarten Preis K zu kaufen bzw. zu verkaufen. Ein Geld- bzw. Gütertausch

erfolgt erst zur Zeit T :

Käufer:

Verkäufer:

bekommt das Gut, zahlt K.

bekommt K, liefert das Gut.

• Call-Option (kurz: call) ist das Recht, aber nicht die Pflicht, ein Wertpapier zu einem festgelegten Preis K (dem sogenannten strike) an einem

zukünftigen Zeitpunkt T (der sogenannten Fälligkeit, oder Maturität) zu

kaufen.

• Put-Option (kurz: put) ist das Recht, aber nicht die Pflicht, ein Wertpapier zu einem festgelegten Preis K an einem zukünftigen Zeitpunkt T zu

verkaufen.

Frage: Wie kann man sinnvolle Preise für Derivate bestimmen?

Ausblick: Wir werden das sogenannte No-Arbitrage-Prinzip zur Bewertung von

Derivaten kennenlernen. Es erlaubt eine einfache, marktkonsistente Bewertung.

Zunächst untersuchen wir diese Methode im Rahmen des Binomialmodells.

3

Das Binomialmodell

Modell eingeführt in: Cox, Ross, Rubenstein. Option Pricing: A Simplified

Approach, 1979.

Wir betrachten einen Finanzmarkt mit 2 Wertpapieren. Handelszeiten: 0, 1, . . . , N .

Annahmen: Das erste Wertpapier ist eine Anleihe mit fester Verzinsung r ≥ 0

pro Zeitschritt. Der Wert zur Zeit n sei

Bn = (1 + r)n .

Das zweite Papier ist eine Aktie (oder ein anderes riskantes Papier) mit Preis Sn

zur Zeit n. Zwischen den Zeiten n und n + 1 ändert sich der Preis um einen Faktor

20

3

u oder d:

Sn+1

(

uSn ,

=

dSn ,

Das Binomialmodell

mit Wahrscheinlichkeit p,

mit Wahrscheinlichkeit 1 − p.

Im Folgenden nehmen wir an:

0 < d < 1 + r < u.

(3.1)

Der Preisprozess kann mit einem Binomialbaum veranschaulicht werden:

u2 S0

uS0

S0

udS0

dS0

d2 S0

Beachte: Der Binomialbaum ist rekombinierend: # Knoten zur Zeit N : N + 1.

Wir modellieren den Preis (Sn ) als stochastischen Prozess. Sei dazu (Ω, F, P ) ein

Wahrscheinlichkeitsraum und Y1 , . . . , YN eine Familie von unabhängigen Zufallsvariablen mit

P (Yn = u) = p und P (Yn = d) = 1 − p,

wobei p ∈ (0, 1). Sei S0 ∈ (0, ∞). Wir definieren

Sn (ω) := S0 ·

n

Y

Yi (ω)

i=1

und Fn := σ(S0 , . . . , Sn ), n ∈ {0, . . . , N }.

Beachte: F0 = {∅, Ω} und Fn = σ(Y1 , . . . , Yn ), für n ∈ {1, . . . , N }.

Satz 3.1

1+r−d

1

⇒

Sn ist Submartingal

u−d

(1 + r)n

1+r−d

1

p≤

⇒

Sn ist Supermartingal

u−d

(1 + r)n

p≥

Insbesondere: p =

1+r−d

u−d

1

⇒ (1+r)

n Sn ist Martingal.

21

3

Das Binomialmodell

Beweis. Setze Xn :=

1

S .

(1+r)n n

Dann

1. Sn ist Fn -messbar, also auch Xn .

u n

2. Es gilt 0 ≤ Xn ≤ S0 1+r

< ∞. Also ist Xn integrierbar für alle n ≤ N .

3. Für n < N − 1 gilt:

1

E(Xn+1 | Fn ) = E( 1+r

Xn Yn+1 | Fn )

1

=

Xn E(Yn+1 | Fn )

1+r

1

=

Xn E(Yn+1 ).

1+r

Falls p ≥

1+r−d

,

u−d

dann ist

E(Yn+1 )

pu + (1 − p)d

=

≥ 1,

1+r

1+r

und somit E(Xn+1 | Fn ) ≥ Xn . Falls p ≤

1+r−d

,

u−d

folgt E(Xn+1 | Fn ) ≤ Xn .

Definition

Ein R2 -wertiger stochastischer Prozess (Gn , Hn )n∈{1,...,N } heißt Portfolioprozess

(oder Strategie), falls die Prozesse (Gn ) und (Hn ) previsibel bezüglich (Fn ) sind.

Interpretation:

Gn = Stückzahl von Papier 1 im Portfolio zwischen den Zeitpunkten n − 1 und n.

Hn = Stückzahl von Papier 2 im Portfolio zwischen den Zeitpunkten n − 1 und n.

Beachte: negative Werte für G und H sind erlaubt.

Definition

Ein Portfolioprozess (G, H) heißt selbstfinanzierend, falls für alle n ∈ {1, . . . , N −

1} gilt:

Gn Bn + Hn Sn = Gn+1 Bn + Hn+1 Sn

( Umschichtung des Portfolios ohne Wertänderung“).

”

Definition

Der Wertprozess (Vn ) einer Strategie (G, H) ist definiert durch

V0 = G1 B0 + H1 S0 ,

Vn = Gn Bn + Hn Sn ,

V0 heißt Startwert.

22

n ∈ {1, . . . , N }.

3

Das Binomialmodell

Nun zu Derivaten:

Betrachte zum Beispiel eine Call-Option auf die Aktie mit strike K und Fälligkeit

N . Der Wert des calls zur Zeit N ist

(3.2)

C(N, K) := (SN − K)+ .

Wir identifizieren die Call-Option mit der ZV C(N, K), d.h. mit ihrem Payoff/Wert zur Zeit N .

Die entsprechende Put-Option identifizieren wir mit der Zufallsvariable

P (N, K) := (K − SN )+ .

Wir zeigen jetzt: C(N, K) und P (N, K) können im Binomialmodell repliziert werden.

Definition

Eine Zufallsvariable X heißt replizierbar, falls es ein selbstfinanzierendes Portfolio (G, H) gibt mit

GN BN + HN SN = X.

(3.3)

Wir betrachten zunächst den 1-Perioden-Fall. Wie lässt sich C(1, K) replizieren?

Beachte, dass

(

(uS0 − K)+ , falls Y1 = u

C(1, K) = (S1 − K)+ =

.

(dS0 − K)+ , falls Y1 = d

Für den Wert des Portfolios gilt

(

G1 (1 + r) + H1 uS0 ,

V1 = G1 B1 + H1 S1 =

G1 (1 + r) + H1 dS0 ,

falls Y1 = u

falls Y1 = d

.

Es gilt also V1 = C(1, K) genau dann, wenn

(1)

(2)

(uS0 − K)+ = G1 (1 + r) + H1 uS0

(dS0 − K)+ = G1 (1 + r) + H1 dS0 .

Lösung des Gleichungssystems:

H1 =

Cu − Cd

,

uS0 − dS0

G1 =

uCd − dCu

,

(1 + r)(u − d)

23

3

Das Binomialmodell

wobei Cu = (uS0 − K)+ und Cd = (dS0 − K)+ . Für den Wert des Portfolios zur

Zeit 0 gilt:

uCd − dCu

Cu − Cd

V0 = G1 B0 + H1 S0 =

+ S0

(1 + r)(u − d)

uS0 − dS0

1

1+r−d

u − (1 + r)

=

Cu +

Cd

1+r

u−d

u−d

Wir definieren p∗ :=

1+r−d

.

u−d

(3.4)

Wegen (3.1) ist p∗ ∈ (0, 1). Aus (3.4) folgt

V0 =

1

(p∗ Cu + (1 − p∗ )Cd ).

1+r

Interpretation: V0 ist der diskontierte Erwartungswert des Payoffs unter Verwendung des neuen Wahrscheinlichkeitsgewichts p∗ . Mehr dazu später.

Preis

Wert des replizierenden Portfolios

Cu

uS0

S0

V0 =

p∗ Cu +(1−p∗ )Cd

1+r

dS0

Cd

Betrachte nun den 2-Perioden-Fall:

Cuu = (u2 S0 − K)+

u2 S0

c1 (uS0 )

uS0

1

1

S0

udS0

Cud = (udS0 − K)+

c0 (S0 )

2

2

dS0

c1 (dS0 )

Cdd = (d2 S0 − K)+

d2 S0

Annahme: Wir befinden uns im Knoten 1. Nur 1 Periode verbleibt. Aus den obigen

Überlegungen folgt: es gibt ein Portfolio zwischen Zeit 1 und 2, das Cuu bzw. Cdd

repliziert. Der Wert dieses Portfolios zur Zeit 1 ist

c1 (uS0 ) =

24

1

(p∗ Cuu + (1 − p∗ )Cud ).

1+r

3

Das Binomialmodell

Analog: Im Knoten 2 existiert ein replizierendes Portfolio mit Anfangswert

c1 (dS0 ) =

1

(p∗ Cud + (1 − p∗ )Cdd ).

1+r

Wir replizieren nun zwischen 0 und 1 die Zufallsvariable

(

c1 (uS0 ), falls Y1 = u

c1 (S1 ) =

.

c1 (dS0 ), falls Y1 = d

Es muss gelten

(1)

(2)

G1 (1 + r) + H1 uS0 = c1 (uS0 )

G1 (1 + r) + H1 dS0 = c1 (dS0 ).

Lösung des Gleichungssystems:

H1 =

c1 (uS0 ) − c1 (dS0 )

uS0 − dS0

und G1 =

uc1 (dS0 ) − dc1 (uS0 )

.

(1 + r)(u − d)

Für den Wert des replizierenden Portfolios zur Zeit 0 gilt

c0 (S0 ) =

1

(p∗ c1 (uS0 )) + (1 − p∗ )c1 (dS0 )).

1+r

Die Argumentation lässt sich auf beliebig viele Schritte ausdehnen. Im Allgemeinen

Fall gilt:

Satz 3.2

Die Call-Option C(N, K) ist replizierbar durch folgende selbstfinanzierende Strategie:

Hn =

cn (uSn−1 ) − cn (dSn−1 )

,

uSn−1 − dSn−1

Gn =

ucn (dSn−1 ) − dcn (uSn−1 )

,

(1 + r)n (u − d)

(3.5)

wobei die Funktionen cn rekursiv definiert sind:

cN (x) = (x − K)+

1

cn (x) =

(p∗ cn+1 (ux) + (1 − p∗ )cn+1 (dx))

1+r

(3.6)

für n < N . cn (Sn ) gibt dabei den Wert des replizierenden Portfolios zur Zeit n

an.

25

3

Das Binomialmodell

Beweis. Zunächst zeigen wir durch Induktion nach N : C(N, K) replizierbar, cn (Sn )

Wertprozess des repl. Portfolios

N = 1: siehe oben X

N − 1 → N : Betrachte das Binomialmodell auf dem Zeitintervall von 1 bis N .

Q

+

Nach Induktionsvoraussetzung ist (uS0 N

Porti=2 Yi − K) replizierbar mit einemQ

folio, das den Startwert (zur Zeit 1) c1 (uS0 ) hat. Analoge Aussage git für (dS0 N

i=2 Yi −

+

K) . Wir zeigen jetzt: Die Zufallsvariable

(

c1 (uS0 ), Y1 = u

X = c1 (S1 ) =

c1 (dS0 ), Y1 = d

kann zwischen 0 und 1 repliziert werden.

Das führt zu folgendem Gleichungssystem:

(1)

(2)

c1 (uS0 ) = G1 (1 + r) + H1 uS0

c2 (dS0 ) = G1 (1 + r) + H1 dS0

Dieses hat die eindeutige Lösung

H1 =

Es gilt

c1 (uS0 ) − c1 (dS0 )

,

uS0 − dS0

G1 =

uc1 (dS0 ) − dc1 (uS0 )

.

(1 + r)(u − d)

G1 B1 + H1 S1 = c1 (S1 ) (Replikation von X)

und

1

Def.

(p∗ c1 (uS0 ) + (1 − p∗ )c1 (dS0 )) = c0 (S0 ).

1+r

Formel (3.5) folgt durch Lösen der entsprechenden Gleichungssysteme.

G1 B0 + H1 S0 =

26

3

Das Binomialmodell

Bemerkung

1) Satz 3.2 kann auf Optionen mit Payoff f (SN ) verallgemeinert werden (Bsp:

f (x) = (K − x)+ für eine Put-Option). Man muss dazu die Endbedingung in

(3.6) ersetzen durch cN (x) = f (x).

2) Satz 3.2 kann sogar auf pfadabhängige Optionen verallgemeinert werden. Dann

muss cn als Funktion mit n Argumenten S1 , . . . , Sn gewählt werden.

Definition

Sei X eine im Binomialmodell replizierbare Zufallsvariable. Der CRR-Preis (Cox-Ross-Rubenstein)

von X ist der Wert des replizierenden Portfolios zur Zeit 0.

Frage: Warum ist der CRR-Preis ein vernünftiger Preis für X?

Begündung: Sei dazu

V0 = Wert des replizierenden Portfolios zur Zeit 0,

M = Marktpreis des Derivats X zur Zeit 0.

1. Fall: M > V0 .

Dann verkaufe das Derivat am Markt zum Preis M und kaufe das replizierende Portfolio zum Preis V0 . Dies lässt sich ohne Startkapital realisieren,

da δ := M − V0 > 0. Zur Zeit N gilt: Portfoliowert = Derivatwert. Der

Überschuss δ bleibt. Also lässt sich ohne Risiko ein Gewinn erzielen, d.h.

es gibt eine Arbitragemöglichkeit. Falls also M > V0 , würden viele das

Derivat verkaufen. ⇒ Preis fällt bis M = V0 .

2. Fall: M < V0 . Kaufe das Derivat und verkaufe das replizierende Portfolio. Wieder lässt sich ohne Risiko Gewinn erzielen.

3. Fall: M = V0 . In diesem Fall gibt es keine Arbitragemöglichkeit.

Fazit: Der CRR-Preis ist der einzige arbitragefreie Preis von X.

Satz 3.3

Für den CRR-Preis einer Call-Option C(N, K) gilt

N X

1

N

CRR_call(S0 , K, N, u, d, r) =

(p∗ )k (1−p∗ )N −k (S0 uk dN −k −K)+

N

(1 + r) k=0 k

(3.7)

Beweis. Sei cn die Funktionenfolge aus Satz 3.2. Nach Satz 3.2 gilt: CRR_call =

27

3

Das Binomialmodell

c0 (S0 ). Es genügt zu zeigen, dass für alle n ∈ {0, . . . , N } gilt:

n X

1

n

c0 (S0 ) =

(p∗ )k (1 − p∗ )n−k cn (uk dn−k S0 ).

n

(1 + r) k=0 k

Beweis durch Induktion nach n:

n = 0: RS = c0 (S0 )

n − 1 → n: Es gelte

n−1 X

1

n−1

c0 (S0 ) =

(p∗ )k (1 − p∗ )n−1−k cn−1 (uk dn−1−k S0 ).

(1 + r)n−1 k=0

k

Nach Definition gilt

cn−1 (uk dn−1−k S0 ) =

1

p∗ cn (uk+1 dn−1−k S0 ) + (1 − p∗ )cn (uk dn−k S0 ) .

1+r

Also

n−1 X

1

n−1

c0 (S0 ) =

(p∗ )k+1 (1 − p∗ )n−1−k cn (uk+1 dn−1−k S0 )

(1 + r)n k=0

k

n−1

∗ k

∗ n−k

k n−k

+

(p ) (1 − p ) cn (u d S0 )

k

n X

1

n−1

n−1

=

+

(p∗ )k (1 − p∗ )n−k cn (uk dn−k S0 ).

(1 + r)n k=0

k−1

k

|

{z

}

=

n

k

Formel (3.7) erinnert an die Binomialverteilung. Sei P ∗ ein neues Wahrscheinlichkeitsmaß, sodass Y1 , . . . , YN unabhängig bezüglich P ∗ sind und P ∗ (Yi = u) = p∗

und P ∗ (Yi = d) = 1 − p∗ . Dann folgt aus (3.7):

Korollar 3.4

Es gilt

CRR_call(S0 , K, N, u, d, r) =

1

E∗ [(SN − K)+ ],

(1 + r)N

wobei E∗ der Erwartungswertoperator unter P ∗ ist.

28

(3.8)

3

Beweis. Setze

(

1,

Xi =

0,

Yi = u

Yi = d

und Z :=

N

X

Das Binomialmodell

Xi .

i=1

Unter P ist Z binomialverteilt mit den Parametern N und p∗ , d.h.

N

P (Z = k) =

(p∗ )k (1 − p∗ )N −k , ∀k ∈ {0, . . . , N }.

k

∗

Da SN = S0 uZ dN −Z , folgt die Behauptung aus (3.7).

Wichtige Beobachtung: Der arbitragefreie Preis (= CRR-Preis) der Call-Option

ist der diskontierte Erwartungswert des Payoffs (SN −K)+ unter dem neuen Wahrscheinlichkeitsmaß P ∗ . Der Preis hängt nicht vom Ausgangsmaß P ab.

Wir untersuchen P ∗ näher: Wegen (3.1) ist p∗ ∈ (0, 1). Somit sind P ∗ und P

äquivalent auf FN (nur ∅ ist Nullmenge in FN ). Weiterhin folgt aus Prop. 3.1,

Sn

∗

dass (1+r)

ist (ersetze dazu p mit p∗ ).

n ein Martingal unter P

Definition

Ein Wahrscheinlichkeitsmaß Q heißt äquivalentes Martingalmaß auf FN , falls

Sn

Q ∼ P auf FN und (1+r)

n , n ∈ {0, . . . , N }, ein Martingal unter Q ist.

Satz 3.5

P ∗ ist das einzige äquivalente Martingalmaß auf FN .

Beweis. Sei Q ein äquivalentes Martingalmaß. Dann gilt einerseits

Sn+1

Q

E

| Fn = Sn , n ∈ {0, . . . , N − 1}.

1+r

Andererseits gilt

Q

E

Sn+1

| Fn

1+r

=

Sn Q

E (Yn+1 | Fn ).

1+r

Somit erhalten wir

1 + r = EQ (Yn+1 | Fn ) = EQ (u1{Yn+1 =u} + d1{Yn+1 =d} | Fn )

= uQ(Yn+1 = u | Fn ) + dQ(Yn+1 = d | Fn )

= uQ(Yn+1 = u | Fn ) + d(1 − Q(Yn+1 = u | Fn )),

wobei Q(Yn+1 = x | Fn ) := EQ (1{Yn+1 =x} | Fn ), x ∈ {u, d}. Folglich gilt

Q(Yn+1 = u | Fn ) =

1+r−d

= p∗ .

u−d

29

4

Das allgemeine Mehrperiodenmodell

Insbesondere gilt Q(Yn+1 = u) = p∗ . Wir zeigen jetzt, dass die Y1 , . . . , YN unabhängig unter Q sind. Es genügt zu zeigen, dass Yn+1 unabhängig von Fn ist, für

alle n < N . Sei dazu A ∈ Fn . Dann gilt

Q({Yn+1 = u} ∩ A) = EQ (1{Yn+1 =u} 1A )

= EQ (EQ (1{Yn+1 =u} 1A | Fn ))

= EQ (1A EQ (1{Yn+1 =u} | Fn ))

= p∗ · Q(A)

= Q(Yn+1 = n) · Q(A).

Die analoge Aussage gilt für {Yn+1 = d}. Also sind Y1 , . . . , YN unabhängig unter

Q.

Sei nun A = {Y1 = x1 , . . . , YN = xN } ein Elementarereignis in FN , wobei xi ∈

{u, d}. Dann gilt, mit k = |{i : xi = u}|,

Q(A) = (p∗ )k (1 − p∗ )N −k = P ∗ (A).

Damit folgt schließlich die Behauptung Q = P ∗ auf FN .

Wichtige Beobachtung: Der arbitragefreie Preis (= CRR-Preis) einer Option

ist der diskontierte Erwartungswert des Payoffs unter dem äquivalentem Martingalmaß. Im Binomialmodell ist das äquivalente Martingalmaß eindeutig.

Frage: Welche Erkenntnisse sind spezifisch für das Binomialmodell, welche gelten

allgemein? Hierzu:

4

Das allgemeine Mehrperiodenmodell

Literatur: Harrison, Pliska. Martingales and stochastic integrals in the theory

of continuous trading, 1981.

Wir betrachten einen Finanzmarkt mit einem risikolosen und d ∈ N riskanten

Wertpapieren. Hierbei seien

0, 1, . . . , N

Sk0 = (1 + r)k

Ski

die Handelszeiten,

der Wert des risikolosen Papiers zur Zeit k (r ≥ 0) und

der Wert des i-ten riskanten Papiers zur Zeit k (i ∈ {1, . . . , d}) ist.

Annahme: (Ω, F, (Fk ), P ) ist ein filtrierter Wahrscheinlichkeitsraum, und für jedes

i ∈ {1, . . . , d} ist (Ski )k∈{0,...,N } ein (Fk )-adaptierter, nichtnegativer stochastischer

Prozess. Der Einfachheit halber gelte F0 = {∅, Ω}.

30

4

Das allgemeine Mehrperiodenmodell

Notation: S k := (Sk0 , Sk ) := (Sk0 , Sk1 , . . . , Skd ).

Definition

Ein Rd+1 -wertiger Prozess

H k := (Hk0 , Hk ) := (Hk0 , Hk1 , . . . , Hkd ),

k ∈ {1, . . . , N },

heißt Portfolioprozess (kurz: Strategie), falls für alle 0 ≤ i ≤ d der Prozess

(Hki )k∈{1,...,N } previsibel bezüglich (Fk ) ist.

Definition

Eine Strategie H heißt selbstfinanzierend, falls für alle k ∈ {0, . . . , N − 1} gilt:

H k+1 · S k = H k · S k ,

wobei · hier das Skalarprodukt H k · S k =

Pd

i=0

Hki Ski bezeichnet.

Definition

Der Wertprozess Vk = Vk (H) ist definiert durch

V0 (H) = H 1 · S 0 ,

Vk (H) = H k · S k ,

k ∈ {1, . . . , N }.

V0 heißt Startwert.

Lemma 4.1

Eine selbstfinanzierende Strategie H = (H 0 , H) mit Wertprozess (Vk )k∈{0,...,N }

ist eindeutig durch H und V0 bestimmt.

Beweis. Wir zeigen durch Induktion nach k: Hk0 ist Funktion von H und V0 .

k = 1: Es gilt V0 = H 1 · S 0 = H10 + H1 · S0 . Damit folgt H10 = V0 − H1 · S0 .

k − 1 → k: H k−1 sei eindeutig durch H und V0 bestimmt. Dann ist auch Vk−1 =

H k−1 · S k−1 eindeutig durch H und V0 bestimmt. Da H selbstfinanzierend

ist, gilt

0

Vk−1 = H k−1 · S k−1 = H k · S k−1 = Hk0 Sk−1

+ Hk · Sk−1 ,

also

Hk0 =

1

(Vk−1 − Hk · Sk−1 ).

(1 + r)k−1

31

4

Das allgemeine Mehrperiodenmodell

Definition

Eine selbstfinanzierende Strategie H heißt Arbitragemöglichkeit(strategie), falls

für den zugehörigen Wertprozess (Vk )k∈{0,...,N } gilt:

(i) V0 ≤ 0

(ii) VN ≥ 0, f.s.

(iii) P (VN > 0) > 0.

Wir zeigen zunächst: Der Markt ist arbitragefrei genau dann, wenn es in keiner

der einzelnen Handelsperioden eine Arbitragemöglichkeit gibt. Hierzu bezeichne

L0 (F) die Menge aller F-messbaren, reellwertigen Zufallsvariablen.

Lemma 4.2

Folgende Aussagen sind äquivalent:

(a) Es gibt eine Arbitragemöglichkeit.

(b) Es gibt ein k ∈ {1, . . . , N } und ein η ∈ (L0 (Fk−1 ))d mit η·Sk ≥ (1+r)η·Sk−1 ,

f.s. und

P (η · Sk > (1 + r)η · Sk−1 ) > 0.

(c) Es gibt ein k ∈ {1, . . . , N } und ein η ∈ (L∞ (Fk−1 ))d mit η·Sk ≥ (1+r)η·Sk−1 ,

f.s. und

P (η · Sk > (1 + r)η · Sk−1 ) > 0.

(d) Es gibt eine Arbitragemöglichkeit H = (H 0 , H) mit H beschränkt und

V0 (H) = 0.

Beweis. (a) ⇒ (b): Sei H eine Arbitragemöglichkeit. Dann V0 ≤ 0, VN ≥ 0, f.s.

und P (VN > 0) > 0. Sei t := min{k : Vk ≥ 0 f.s. und P (Vk > 0) > 0}.

Beachte: t ∈ {1, . . . , N }, und Vt−1 ≤ 0 f.s. oder P (Vt−1 < 0) > 0.

1. Fall: Vt−1 ≤ 0, f.s. Dann ist H t · S t−1 = H t−1 · S t−1 = Vt−1 ≤ 0. Also

H t · S t = Vt ≥ 0 ≥ (1 + r)H t · S t−1

und

P (H t · S t > (1 + r)H t · S t−1 ) > 0.

0

Die Balken kann man weglassen, da St0 = (1 + r)St−1

. Also gilt die

Behauptung mit η = Ht .

2. Fall: P (Vt−1 < 0) > 0. Setze η := (η 0 , η) := H t · 1{Vt−1 <0} . Dann gilt

η · S t−1 = Vt−1 1{Vt−1 <0} ≤ 0

32

4

Das allgemeine Mehrperiodenmodell

und P (η · S t−1 < 0) > 0. Wegen η · S t = Vt · 1{Vt−1 <0} ≥ 0, f.s., folgt

also

η · S t ≥ (1 + r) · η · S t−1

und P (η · S t > (1 + r)η · S t−1 ) > 0. Wieder kann man die Balken

weglassen.

(b) ⇒ (c): Seien k und η wie in (b). Definiere

η n := η1{|η|≤n} ,

n ≥ 1.

Dann gilt η n · Sk ≥ (1 + r)η n · Sk−1 . Mit der σ-Stetigkeit von P :

lim P (η n · Sk > (1 + r)η n · Sk−1 ) = P

n

!

[

{η n · Sk > (1 + r)η n · Sk−1 }

n≥1

= P (η · Sk > (1 + r)η · Sk−1 )

> 0.

Somit gilt die Aussage für hinreichend großes n.

(c) ⇒ (d): Seien k und η wie in (c). Setze Hk := η und Hn := 0 für n 6= k. Nach

Lemma 4.1 ist durch H und V0 = 0 eindeutig eine selbstfinanzierende Strategie H = (H 0 , H) bestimmt. Diese Strategie ist eine Arbitragemöglichkeit.

(d) ⇒ (a): klar.

Definition

Ein Wahrscheinlichkeitsmaß Q auf (Ω, F) heißt Martingalmaß, falls für alle i ∈

{1, . . . , d} der diskontierte Prozess

(Xki )k∈{0,...,N }

:=

Ski

Sk0

k∈{0,...,N }

ein Q-Martingal bezüglich (Fk ) ist.

Ein Martingalmaß Q heißt äquivalentes Martingalmaß, falls Q ∼ P . Wir bezeichnen die Menge alle äquivalenten Martingalmaße mit P.

Im Folgenden schreiben wir Xk = (Xk1 , . . . , Xkd ), k ∈ {0, . . . , N }.

33

4

Das allgemeine Mehrperiodenmodell

Lemma 4.3

Sei H = (H 0 , H) eine selbstfinanzierende Strategie und

Dn := Dn (H) :=

Vn (H)

Sn0

(diskontierter Wertprozess).

Dann gilt

Dn = V0 + InX (H),

n ∈ {0, . . . , N },

wobei (I X (H)) das stochastische Integral von (Hn ) bez. (Xn ) ist.

Beweis.

Dn = (Dn − Dn−1 ) + . . . + (D1 − D0 ) + D0

H n · S n H n−1 · S n−1

H 1 · S1 H 1 · S0

=

−

+ ... +

−

+ D0

0

Sn0

Sn−1

S10

S00

S n S n−1

S1 S0

= Hn ·

− 0

+ . . . + H1 ·

−

+ V0

Sn0

Sn−1

S10 S00

n

X

= V0 +

Hk · (Xk − Xk−1 )

= V0 +

k=1

InX (H).

Satz 4.4

Sei Q ein Wahrscheinlichkeitsmaß. Dann sind folgende Aussagen äquivalent:

(a) Q ist Martingalmaß.

(b) Ist H = (H 0 , H) selbstfinanzierend mit beschränktem H, so ist

(Dn (H))n∈{0,...,N } ein Q-Martingal.

(c) Ist H = (H 0 , H) selbstfinanzierend mit beschränktem H und V0 (H) = 0, so

ist DN (H) Q-integrierbar und EQ (DN (H)) = 0.

Beweis. (a) ⇒ (b): Nach Lemma 4.3 ist Dn (H) = V0 + InX (H), n ∈ {0, . . . , N }.

Somit folgt die Behauptung aus Satz 2.7.

(b) ⇒ (c): Erinnerung: F0 = {∅, Ω}. Also gilt

EQ (DN ) = EQ (Dn | F0 ) = D0 = V0 = 0.

(c) ⇒ (a): folgt aus Satz 2.8.

34

4

Das allgemeine Mehrperiodenmodell

Satz 4.5 (fundamental theorem of asset pricing)

Das Marktmodell ist genau dann arbitragefrei, wenn P 6= ∅. In diesem Fall

∗

existiert P ∗ ∈ P mit beschränkter Dichte dP

.

dP

Bemerkung

Das Theorem wurde in dieser Version bewiesen in: Dalang, Morton, Willinger. Equivalent martingale measures and no arbitrage in stochastic securities

market models, 1989. Wir beweisen ⇒“ nur in dem Spezialfall |Ω| < ∞ (siehe

”

Harrison, Pliska 1981).

Beweis. ⇐“ Sei H = (H 0 , H) selbstfinanzierend mit H beschränkt. Es gelte

”

V0 (H) = 0 und VN (H) ≥ 0, P -f.s. Wegen Lemma 4.2 (d) genügt es zu zeigen,

dass P (VN (H) > 0) = 0. Sei P ∗ ∈ P. Da P ∗ ∼ P , gilt auch VN (H) ≥ 0, P ∗ -f.s.

Mit Satz 4.4 (c) folgt

E∗ (VN (H)) = (1 + r)N E∗ (DN (H)) = 0.

Damit folgt VN (H) = 0, P ∗ -f.s. und somit P -f.s.

⇒“ Beweisskizze für den Fall |Ω| = K < ∞. Sei Ω = {ω1 , . . . , ωK } und p =

”

(p1 , . . . , pK ) = (P ({ω1 }), . . . , P ({ωK })). Wir können annehmen: pi > 0 für alle

i ∈ {1, . . . , K} (falls nicht, verkleinere Ω). Sei X die Menge aller reellen Zufallsvariablen auf (Ω, 2Ω ). Die Abbildung

ψ : X → RK ,

X 7→ (X(ω1 ), . . . , X(ωK ))

ist eine Bijektion. Setze

X + = {X ∈ X : E(X) ≥ 1 und X ≥ 0}.

Beachte: Das Bild von X + unter ψ ist die konvexe Menge

C := {x ∈ RK

+ : x · p ≥ 1}.

Sei

X 0 := {X ∈ X : ∃ eine s.f. Strategie H mit V0 (H) = 0 und VN (H) = X}.

Dann ist A := ψ(X 0 ) ein linearer Teilraum von RK . Da es keine Arbitragemöglichkeit gibt, folgt X 0 ∩ X + = ∅. Das heißt A ∩ C = ∅. Mit einem Trennungssatz

im RK (vgl. Aufgabe 3, Übungsblatt 5) folgt: es exisitert y ∈ RK mit

(i)

(ii)

y · x = 0,

y · x > 0,

für alle x ∈ A

für alle x ∈ C

35

4

Das allgemeine Mehrperiodenmodell

Skizze:

C

y

x1

x2

A

Beachte: yi > 0 für alle i ∈ {1, . . . , k}. Begründung hierfür: Sei ei der i-te Einheitsvektor. Dann ist

1

1

ei · p = 1, also ei ∈ C.

pi

pi

1

1

Damit folgt 0 < y · pi ei = pi yi , also yi > 0.

Definiere Q wie folgt:

yi

Q({ωi }) := Pn

j=1

yi

.

Sei nun X ∈ X 0 . Dann gilt

ψ(X) ∈ A und E (X) =

Q

K

X

yi X(ωi ) = y · ψ(X) = 0.

i=1

Mit Satz 4.4 ((c) ⇒ (a)) folgt, dass Q ein Martingalmaß ist. Da yi > 0 und pi > 0

für alle i ∈ {1, . . . , K}, sind Q und P äquivalent.

Nun zur Bewertung von Derivaten. Wir identifizieren ein Derivat mit einer FN messbaren Zufallsvariable X, die den Payoff zur Zeit N beschreibt.

Definition

Ein (Fn )-adaptierter Prozess (Skd+1 )k∈{0,...,N } heißt arbitragefreier Preisprod+1

zess (APP) für ein Derivat X, falls SN

= X, f.s. und das erweiterte Modell

(S 0 , S 1 , . . . , S d+1 ) arbitragefrei ist.

Im Folgenden nehmen wir an, dass der nicht-erweiterte Markt (S 0 , . . . , S d ) arbitragefrei ist. D.h. P 6= ∅, wobei im Folgenden P die Menge der äquivalenten

Martingalmaße im nicht-erweiterten Modell sei.

Zunächst zeigen wir: Ist X replizierbar, so existiert genau ein arbitragefreier Preisprozess.

36

4

Das allgemeine Mehrperiodenmodell

Definition

Ein Derivat heißt replizierbar, falls ein H selbstfinanzierend existiert mit VN (H) =

X.

Wir betrachten nur Derivate in

R := {VN (H) : H = (H 0 , H) selbstfinanzierend mit H beschränkt}.

Satz 4.6

Sei X ∈ R mit X = VN (H). Dann ist Vk := Vk (H), k ∈ {0, . . . , N }, der einzige

arbitragefreie Preisprozess für X.

Beweis. 1. Wir zeigen zuerst, dass (Vk ) ein arbitragefreier Preisprozess ist. Sei

dazu P ∗ ∈ P. Nach Satz 4.4 ist SVk0 ein P ∗ -Martingal. Also ist P ∗ auch ein äquik

valentes Martingalmaß für den erweiterten Markt (S 0 , . . . , S d , V ). Mit Theorem

4.5 folgt, dass das erweiterte Modell arbitragefrei ist.

2. Eindeutigkeit: Sei (Skd+1 ) ein arbitragefreier Preisprozess für X. Wir zeigen:

Skd+1 = Vk , f.s. Annahme: P (Skd+1 > Vk ) > 0 für ein k < N . Definiere für alle

n ≥ k + 1:

G0n

:=

Hn0 + S10 (Skd+1 − Vk ) · 1{S d+1 >Vk }

k

k

Gn

:= Hn · 1{S d+1 >Vk }

k

Gd+1

:=

−1

d+1

n

{S

>Vk }

k

Interpretation von (G , G, G ): Zur Zeit k verkaufe das Derivat und kaufe

”

das replizierende Portfolio, falls Skd+1 > Vk .“Beachte: (G0 , G, Gd+1 ) ist selbstfinanzierend zwischen k und k + 1:

0

d+1

d+1

G0k+1 Sk0 + Gk+1 · Sk + Gd+1

= (H k+1 · S k + Skd+1 − Vk − Skd+1 ) · 1{S d+1 >Vk }

k+1 Sk

k

= 0.

Die Selbstfinanzierungseigenschaft nach k +1 ist klar. Vor k seien die Positionen

= 0. Weiterhin gilt für den Wert von (G0 , G, Gd+1 ) zur Zeit N :

0

G0N SN

+ GN · SN +

d+1

Gd+1

N SN

0

SN

d+1

= VN (H) + 0 (Sk − Vk ) − X · 1{S d+1 >Vk }

k

Sk

d+1

N −k

= (1 + r)

(Sk − Vk ) · 1{S d+1 >Vk }

≥ 0,

f.s.

k

37

4

Das allgemeine Mehrperiodenmodell

d+1

0

und P (G0N SN

+ GN · SN + Gd+1

> 0) > 0. D.h. (G0 , G, Gd+1 ) ist eine

N SN

Arbitragemöglichkeit im erweiterten Modell (S 0 , . . . , S d+1 ). Also Skd+1 ≤ Vk ,

f.s.

Analog kann man zeigen: Skd+1 ≥ Vk , f.s. Somit gilt: Skd+1 = Vk , f.s.

Nun zu allgemeinen Derivaten, insbesondere zu nicht-replizierbaren Derivaten.

Notation: Sei X eine FN -messbare Zufallsvariable. Dann

π(X) := {y ∈ R | es ex. ein APP (Skd+1 )k∈{0,...,N } für X mit S0d+1 = y}.

Beachte: da F0 = {∅, Ω}, ist S0d+1 immer konstant.

Satz 4.7

Sei X FN -messbar. Dann ist π(X) 6= ∅ und

X

∗

π(X) = {E

: es ex. P ∗ ∈ P mit E∗ |X| < ∞}.

0

SN

(4.1)

Beweis. 1. Wir zeigen zunächst (4.1) ⊂“: Sei y ∈ π(X). Dann existiert ein ar”

d+1

bitragefreier Preisprozess (Skd+1 ) mit S0d+1 = y und SN

= X. Mit Theorem

4.5 folgt die Existenz eines äquivalenten Martingalmaßes P ∗ für das erweiterte

S d+1

Modell (S 0 , . . . , S d+1 ). Insbesondere gilt P ∗ ∈ P. Da Sk 0 Martingal bezüglich

k

∗

∗

∗

P ist, ist X integrierbar bezüglich P und E SX0 = S0d+1 = y. Also y ∈ RS.

N

“⊃“: Sei P ∗ ∈ P mit E∗ |X| < ∞. Setze Skd+1 := (1 + r)−(N −k) E∗ (X | Fk ). Dann

ist

Skd+1

= (1 + r)−N E∗ (X | Fk )

Sk0

ein P ∗ -Martingal. Also ist P ∗ ein äquivalentes Martingalmaß für das erweiterte

0

d+1

0

d+1

Modell

(S ,. . . , S ). Mit Theorem 4.5 folgt (S , . . . , S ) ist arbitragefrei.

⇒ E∗

Skd+1

Sk0

= y ∈ π(X).

2. Wir zeigen jetzt π(X) 6= ∅.

1

Dazu sei Pe das Wahrscheinlichkeitsmaß mit Dichte ddPP = a 1+|X|

, wobei a =

−1

1

E 1+|X|

. Beachte Pe ∼ P . Nach Theorem 4.5 existiert ein P ∗ ∈ P mit

e

38

5

dP ∗

dPe

Konvergenz des Binomialmodells gegen das Black-Scholes-Modell

beschränkt. Nun gilt

∗

Pe

E (|X|) = E

∗

dP ∗

dP

|X|

|X| = aE

< ∞.

dPe

dPe 1 + |X|

Also ist die RS von 4.1 nichtleer und folglich π(X) 6= ∅.

Wichtige Beobachtung: Allgemein gilt: Jeder arbitragefreie Preis einer Option

ist diskontierter Erwartungswert des Payoffs unter einem ÄMM.

5

Konvergenz des Binomialmodells gegen das Black-ScholesModell

Erinnerung: Man schreibt N (µ, σ 2 ) für die Normalverteilung mit Mittelwert µ ∈

R und Standardabweichung σ ∈ R≥0 .

Seien X∞ , X1 , X2 , . . . Zufallsvariablen und F∞ , F1 , F2 , . . . die zugehörigen Verteilungsfunktionen (d.h. Fi (y) = P (Xi ≤ y), y ∈ R).

Die Folge (Xn )n≥1 konvergert in Verteilung gegen X∞ , falls für jede Stetigkeitsstelle

y von F∞ gilt:

lim Fn (y) = F∞ (y).

n→∞

In diesem Fall schreibt man Xn −→ X∞ .

d

Zentraler Grenzwertsatz: Sind X1 , X2 , . . . iid mit E(Xi ) = µ ∈ R und Var(Xi ) =

σ 2 ∈ (0, ∞), dann gilt

Pn

d

i=1 (Xi − µ)

√

−→ G,

σ n

wobei G N (0, 1)-verteilt ist.

Bemerkung

Die Verteilungsfunktion von G ist gegeben durch

1

Φ(x) = √

2π

Zx

y2

e− 2 dy.

−∞

Beachte, dass Φ überall stetig ist. Also gilt für alle x ∈ R

lim Fn (x) = Φ(x),

n→∞

39

5

Konvergenz des Binomialmodells gegen das Black-Scholes-Modell

wobei Fn die Verteilungsfunktion von

mäßig gegen Φ konvergiert. (Übung!)

Pn

(Xi −µ)

i=1 √

σ n

. Man kann zeigen, dass Fn gleich-

Betrachte nun die einfache symmetrische Irrfahrt: sei (Xk )k≥1 iid mit

1

P (Xk = 1) = P (Xk = −1) =

2

und Mn :=

n

X

Xk ,

n ∈ N.

k=1

Aus Kapitel 2 wissen wir bereits: (Mn ) ist ein Martingal bezüglich (Fn ), wobei

Fn = σ(X1 , . . . , Xn ). Für N ∈ N definieren wir die skalierte Irrfahrt

(N )

Wt

1

:= √ MbN tc ,

N

t ∈ R≥0 ,

wobei bxc := max{k ∈ Z | k ≤ x} die Gaußklammer von x ist.

Wogegen konvergiert Wt

(N )

, falls N → ∞?

Lemma √

5.1

(N ) d

Wt → tG, wobei G N (0, 1)-verteilt ist.

Beweis. Zunächst beachte, dass

(N )

Wt

1

= √ MbN tc =

N

Sei GN die Verteilungsfunktion von Wt

p

P tc

bN tc bN

X

√

pk=1 k .

N

bN tc

(N )

und FN die Verteilungsfunktion von

PbN tc

k=1 Xk

p

.

bN tc

Da E(Xk ) = 0 und Var(Xk ) = 1, folgt aus dem zentralen Grenzwertsatz

und der Bemerkung oben:

lim sup |FN (x) − Φ(x)| = 0.

N →∞ x∈R

Weitergin gilt

p

bN tc √

lim √

= t.

N →∞

N

40

5

Konvergenz des Binomialmodells gegen das Black-Scholes-Modell

Also gilt, für x ∈ R,

!

p

P tc

bN tc bN

X

k

√

pk=1

GN (x) = P

≤x

N

bN tc

!

√

PbN tc

X

N

k

pk=1

=P

≤p

x

bN tc

bN tc

√

N

= FN ( p

x)

bN tc

1

N →∞

−→ Φ( √ x)

t

1

= P (G ≤ √ x)

t

√

= P ( tG ≤ x).

√

Beachte: tG ist N (0, t)-verteilt. Wir haben gezeigt: Für festes t ∈ R≥0 konvergiert

(N )

(N )

Wt gegen eine N (0, t)-verteilte Zufallsvariable. Man kann weiter zeigen: Wt

konvergiert simultan für alle t ∈ R≥0 und zwar gegen die Brownsche Bewegung.

Definition

Eine Familie (Wt )t∈R≥0 von Zufallsvariablen auf einem Wahrscheinlichkeitsraum

(Ω, F, P ) heißt Brownsche Bewegung, falls gilt:

(1) W0 = 0,

(2) ∀ω ∈ Ω ist die Abbildung t 7→ Wt (ω) stetig,

(3) für alle 0 = t0 < t1 < . . . < tn sind die Zuwächse

Wtn − Wtn−1 , . . . , Wt1 − Wt0

unabhängig,

(4) für alle 0 ≤ s ≤ t gilt: Die Verteilung von Wt − Ws ist N (0, t − s).

Wir formulieren jetzt einen funktionalen zentralen Grenzwertsatz. Dazu definieren

wir folgenden stetigen Prozess.

(

√1 MbN tc ,

N t ∈ Z≥0

(N )

N

Vt :=

linear,

N t ∈ (bN tc, bN tc + 1)

41

5

Konvergenz des Binomialmodells gegen das Black-Scholes-Modell

Satz 5.2

Sei T ∈ R≥0 und ψ : C[0, T ] → R beschränkta und stetig bezüglich der k · k∞ Norm (d.h. für f, fn ∈ C[0, T ] mit limn→∞ kfn − f k∞ = 0 folgt limn→∞ ψ(fn ) =

ψ(f )). Dann gilt

lim Eψ((Vt

(N )

N →∞

)t∈[0,T ] ) = Eψ((Wt )t∈[0,T ] ),

wobei (Wt ) eine Brownsche Bewegung ist.

a

Zum Beispiel ψ(f ) = f (T ) oder ψ(f ) = max{f (t) : t ∈ [0, T ]}.

Beweis. Siehe fortgeschrittene Stochastik-Vorlesungen.

Jetzt: Konvergenz des skalierten Binomialmodells. Wir betrachten zunächst einen

Spezialfall:

Annahme (A):

σ

σ

r = 0, u = uN = 1 + √ , d = dN = 1 − √ , σ ∈ (0, ∞).

N

N

N sei hinreichend groß, sodass d > 0. Dann gilt:

σ

√

1+r−d

1

p =

= N

σ = .

√

u−d

2 N

2

∗

Unter dem äquivalenten Martingalmaß ist die Anzahl der us bis zur Zeit k binomialverteilt mit den Parametern k und p∗ = 12 (vgl. Beweis zu Korrolar 3.4). Setze

Ui := 12 (Xi + 1) und beachte

(

1, Xi = 1

Ui =

.

0, Xi = −1

Somit ist Zk :=

Es gilt

Pk

i=1

Zk =

Ui ebenfalls binomialverteilt mit den Parametern k und 12 .

k

X

1

i=1

42

2

(Xi + 1) =

1

2

k+

k

X

i=1

!

Xi

1

= (k + Mk ).

2

5

Konvergenz des Binomialmodells gegen das Black-Scholes-Modell

Also können wir den Preisprozess S auch so modellieren:

1

1

Sk = S0 uZk dk−Zk = S0 u 2 (k+Mk ) d 2 (k−Mk ) .

Skalierter Preisprozess

(N )

St

1

1

:= SbN tc = S0 u 2 (bN tc+MbN tc ) d 2 (bN tc−MbN tc ) .

Beachte: u und d hängen von N ab.

Satz 5.3

Es gelte Annahme (A). Dann gilt für alle t ≥ 0

(N )

St

d

−→ S0 eσWt −

σ2

t

2

,

wobei (Wt ) eine Brownsche Bewegung ist.

Für den Beweis benötigen wir:

Lemma 5.4 (Slutsky)

Seien a, b ∈ R, X eine Zufallsvariable und (Xn ), (An ) und (Bn ) Folgen von

d

Zufallsvariablen mit Xn → X, An → a in Wahrscheinlichkeit und Bn → b in

Wahrscheinlichkeit. Dann gilt:

d

An + Bn Xn −→ a + bX.

Beweis. Stochastik 2-Vorlesung.

Beweis von Satz 5.3. Es genügt zu zeigen, dass

log(St

(N )

d

) −→ log(S0 ) + σWt −

σ2

t.

2

Beachte dazu:

log(St

(N )

1

1

) = log(S0 ) + (bN tc + MbN tc ) log(u) + (bN tc − MbN tc ) log(d). (5.1)

2

2

Die Taylor-Entwicklung von log(1 + x) in 0 ergibt:

1

log(1 + x) = x − x2 + R(x),

2

43

5

Konvergenz des Binomialmodells gegen das Black-Scholes-Modell

wobei R(x) ∈ O(x3 ). Also gilt

log(u) = log 1 +

log(d) = log 1 −

Dabei ist R

(N )

log(St )

± √σN

σ

σ

1 σ2

σ

√

=√ −

+R √

2N

N

N

N

2

σ

σ

1σ

σ

√

= −√ −

+ R −√

.

2N

N

N

N

∈ O(N − 2 ). Aus (5.1) folgt, dass

3

1

σ

1 σ2

σ

= log(S0 ) + (bN tc + MbN tc ) √ −

+R √

2

2N

N

N

2

1

σ

1σ

σ

+ (bN tc − MbN tc ) − √ −

+ R −√

2

2N

N

N

3

1 σ2

σ

−2

− 32

= log(S0 ) + bN tc −

+ O(N ) + MbN tc √ + O(N )

2N

N

e

= AN + XN + YN ,

wobei

1 σ2

− 32

e

AN = log(S0 ) + bN tc −

+ O(N ) ,

2N

MbN tc

XN = σ √

N

und

MbN tc

YN = √ O(N −1 ).

N

d

d

Mit Lemma 5.1 gilt XN → σWt . Lemma 5.4 impliziert YN → 0. Da der Limes

konstant ist, gilt auch YN → 0 in Wahrscheinlichkeit. Somit gilt

eN + YN −→ log(S0 ) − 1 σ 2 t in Wahrscheinlichkeit.

AN := A

2

Wieder mit Lemma 5.4 folgt nun

log(St

(N )

1

d

) = AN + XN −→ log(S0 ) − σ 2 t + σWt .

2

Annahme (B):

rN =

44

r

√σ

− √σ

, u = uN = e N , d = dN = e N , σ ∈ (0, ∞), r ∈ [0, ∞), N s.d. uN > 1+rN .

N

5

Konvergenz des Binomialmodells gegen das Black-Scholes-Modell

Beachte: Unter (B) hängt

p∗N

=

1+

r

n

− √σ

−e

√σ

N

N

− √σ

N

e

−e

von N ab. Betrachte deshalb einen Array von Zufallsvariablen: Für alle N sei

(XN,k )k≥1 iid. mit

Setze MN,k

und P (XN,k = −1) = 1 − p∗N .

P (XN,k = 1) = p∗N

P

:= ki=1 XN,i .

Preis im Binomialmodell mit N Schritten:

1

1

Sk = S0 u 2 (k+MN,k ) d 2 (k−MN,k )

1 √σ

N

= S0 e 2

= S0 e

√σ

N

(k+MN,k ) − 12

e

MN,k

√σ

N

(k−MN,k )

.

Skalierter Preisprozess:

(N )

St

:= SbN tc = S0 e

√σ

N

MN,bN tc

t≥0

,

(5.2)

Satz 5.5

Es gelte Annahme (B). Dann gilt für alle t ≥ 0

(N )

St

d

−→ S0 eσWt +(r−

σ2

)t

2

.

Beweisskizze. Es genügt zu zeigen

log(St

(N )

d

) −→ log(S0 ) + σWt + (r −

Betrachte dazu die momenterzeugende Funktion von

ϕN (ϑ) := Ee

ϑ √1 MN,bN tc

N

σ2

)t.

2

√1 MN,bN tc

N

ϑ ≥ 0.

,

Es gilt

PbN tc

ϑ √1

ϕN (ϑ) = Ee

=

k=1

N

bN tc Y

ϑ √1

e

N

XN,k

−ϑ √1

p∗N + e

N

(1 − p∗N )

k=1

= e

√ϑ

N

− √ϑ

p∗N + e

N

bN tc

(1 − p∗N )

.

45

5

Konvergenz des Binomialmodells gegen das Black-Scholes-Modell

Man kann zeigen:

2

t ϑ2 + rϑ

− ϑσ

σ

2

lim ϕN (ϑ) = e

N →∞

.

Dabei ist die rechte Seite die momenterzeugende Funktionvon N σr − σ2 t, t .

2

D.h. die Limes-Verteilung von √σN MN,bN tc ist N

r − σ2 t, σ 2 t . Damit folgt

schließlich

σ

σ2

d

(N )

log St = log S0 + √ MN,bN tc −→ log S0 + σWt + r −

t.

2

N

Das Black-Scholes-Modell

Im Black-Scholes-Modell wird der Preis des riskanten Papiers modelliert als

2

σWt + r− σ2 t

St = S0 e

,

t ∈ R≥0 .

Dabei ist (Wt ) Brownsche Bewegung unter dem (man kann zeigen: es gibt nur

eins) äquivalenten Martingalmaß P ∗ .

Bemerkung:

t = Zeit in Jahren,

σ = Volatilität,

r = kontinuierlicher Zins.

Der Wert St0 des risikolosen Papiers ist gegeben durch

St0 = ert ,

t ∈ R≥0 .

Kontinuierliche Verzinsung bedeutet: Zinsen erwirtschaften sofort selbst Zinsen

(Zinseszins). Anders formuliert: Die Verzinsungsperioden sind infinitesimal klein.

Sei N die Anzahl der Verzinsungsperioden bis t > 0. Dann

N

rt

lim 1 +

= ert .

(5.3)

N →∞

N

Definition

Der Black-Scholes-Preis einer Call-Option mit stike K und Fälligkeit T > 0 ist

definiert durch

BS_call(S0 , K, T, σ, r) := e−rT E∗ ((ST − K)+ ).

46

5

Konvergenz des Binomialmodells gegen das Black-Scholes-Modell

Satz 5.6 ( BS-Formel“)

”

Es gilt

BS_call(S0 , K, T, σ, r) = S0 Φ(d1 ) − e−rT KΦ(d2 ),

wobei

log

d1 =

S0

K

+ r+

√

σ T

σ2

2

T

(5.4)

√

und d2 = d1 − σ T .

√

d

Beweis. Sei G N (0, 1)-verteilt unter P ∗ . Dann gilt σ T G = σWT und somit

e−rT E∗ [(ST − K)+ ] = e−rT E∗ [(S0 eσWT +

r− σ2 T

√

σ

− K)+ ]

= e−rT E∗ [(S0 eσ T G+ r− 2 T − K)+ ]

Z

√

y2

σ

1

−rT

=e

(S0 eσ T y+ r− 2 T − K)+ √ e− 2 dy.

2π

Die rechte Seite lässt sich vereinfachen zu S0 Φ(d1 ) − e−rT KΦ(d2 ).

Satz 5.7

q

q

T

T

σ N

−σ N

rT

Sei rN = N , uN = e

, dN = e

. Dann gilt

lim CRR_call(S0 , K, N, uN , dN , rN ) = BS_call(S0 , K, T, σ, r).

N →∞

Beweisskizze. Es ist

CRR_call(S0 , K, N, uN , dN , rN ) = (1 + rN )−N E(S1

(N )

− K)+ ,

wobei S (N ) wie in (5.2) definiert ist. Aus (5.3) folgt (1 + rN )−N → e−rT . Mit Satz

5.5 folgt

(N )

S1

d

−→ S0 e

√

f1 + r− σ2 T

σ TW

2

,

f Brownsche Bewegung unter P . Damit kann man zeigen

wobei W

lim CRR_call = e

N →∞

−rT

E[(S0 e

fT + r− σ2 T

σW

2

− K)+ ].

Praktische Notiz:

47

5

Konvergenz des Binomialmodells gegen das Black-Scholes-Modell

1) Die Black-Scholes-Formel (5.4) kann verwendet werden, um σ zu bestimmen:

Wähle σ = σimp so, dass

BS_call(S0 , K, T, σimp , r) = Marktpreis des Calls.

σimp heißt implizite Volatilität.

2) Das BS-Modell mit σimp kann dann zur Bewertung von exotischen Optionen

verwendet werden.

48

III

Portfolio-Optimierung

Bei der Steuerung von Portfolien hat man häufig die Wahl zwischen riskanten und

weniger ristkanten Wertpapieren/Anlageformen. Üblicherweise gilt: je riskanter

das Papier/die Anlage, desto größer die Rendite.

Frage: Was ist die optimale Zusammensetzung des Portfolios?

Es gibt viele Modelle und Ansätze, um diese Frage zu beantworten. Wir untersuchen Ansätze, die Nutzenfunktionen verwenden.

Annahme: Ein ökonomischer Agent (= Wirtschaftssubjekt) will die Wertentwicklung eines Portfolios bis zu einem Zeitpunkt T < ∞ optimieren. Wir identifizieren

den Portfoliowert zur Zeit T mit einer Zufallsvariable X. Die Menge aller implementierbaren X sei X . Alle X ∈ X seien auf demselben Wahrscheinlichkeitsraum

(Ω, F, P ) definiert.

Definition

U : R → R ∪ {−∞} heißt Nutzenfunktion, falls U konkav und nicht-fallend ist.

Beispiele

(i) Logarithmische Nutzenfunktion

(

log(x), x > 0

U (x) =

−∞,

x≤0

(ii) Potenznutzenfunktion

(

U (x) =

x1−η

,

1−η

x≥0

−∞, x < 0

wobei η > 0, η 6= 1 (Risikoaversionsparameter).

(iii) Exponentielle Nutzenfunktion

U (x) = −e−λx ,

wobei λ > 0.

Jede Nutzenfunktion U definiert eine Präferenzrelation auf X wie folgt:

XY

:⇔

EU (X) ≤ EU (Y ).

Hier nehmen wir an, dass EU (X) und EU (Y ) definiert sind.

49

6

Nutzenmaximierung im Binomialmodell

Beispiel

Sei X eine Zufallsvariable mit P (X = 500) = P (X = 1500) = 12 und Y = 1000

konstant. Dann gilt E log Y > E log X (siehe Jensen-Ungleichung). Also bevorzugt

ein Agent mit logarithmischen Nutzenpräferenzen die Auszahlung Y gegenüber X.

6

Nutzenmaximierung im Binomialmodell

Wir machen dieselben Annahmen wie in Kapitel 3. Insbesondere gelte

Sn = S0

n

Y

Yi ,

n ∈ {0, . . . , N },

i=1

wobei Y1 , . . . , YN iid unter P mit

P (Yi = u) = p

und P (Yi = d) = 1 − p.

Ziel: Bestimme den selbstfinanzierenden Portfolioprozess (G, H) mit Startwert

V0 = v, sodass der erwartete Nutzen EU (VN ) maximal wird.

Wir formulieren zunächst das Ziel geeignet um. Fixiere dazu v ∈ (0, ∞). Sei (G, H)

ein selbstfinanzierender Portfolioprozess, sodass für den zugehörigen Wertprozess

(Vn ) gilt:

V0 = v

Vn > 0, f.s. für alle n ∈ {0, . . . , N }.

Setze πn+1 :=

Hn+1 Sn

Vn

(Prozentsatz des Portfoliowertes im riskanten Papier).

Da (G, H) selbstfinanzierend ist, gilt Gn+1 =

Also gilt

1

(Vn

Bn

− Hn+1 Sn ) für alle n < N .

Vn+1 = Gn+1 Bn+1 + Hn+1 Sn+1

Bn+1

Sn+1

=

(Vn − Hn+1 Sn ) + πn+1 Vn

Bn

Sn

= (1 + r)Vn − (1 + r)πn+1 Vn + πn+1 Vn Yn+1

= [(1 + r) + πn+1 (Yn+1 − (1 + r))]Vn .

Der Portfolioprozess (G, H) ist eindeutig bestimmt durch V0 = v und die Strategie

(πn )n∈{1,...,N } (vgl. Lemma 4.1). Für den zugehörigen Wertprozess (Vn ) = (Vnπ (v))

gilt

V0 = v,

Vn+1 = Vn [1 + r + πn+1 (Yn+1 − (1 + r))].

50

6

Nutzenmaximierung im Binomialmodell

Nutzenmaximierungsproblem:

Bestimme π so, dass EU (VNπ (v)) maximal wird.

1. Lösungsmethode: Dynamische Programmierung

Für alle n ≤ N und v ∈ (0, ∞) setze

Vkn,π (v) := v

k

Y

(1 + r + πj (Yj − (1 + r))),

k ∈ {n, . . . , N }.

j=n+1

Wir bezeichnen mit

An (v) := {π : π ist previsibel und f.alle k ∈ {n, . . . , N } gilt Vkn,π (v) > 0}

die Menge aller zulässigen Strategien ab n. Die Funktion

Wn (v) := sup{EU (VNn,π (v)) : π ∈ An (v)}

heißt Wertfunktion zur Zeit n. π ∈ An (v) heißt optimal für Wn (v), falls

EU (VNn,π (v)) = Wn (v).

Man kann die Menge der zulässigen Strategien reduzieren: sei Ãn (v) die Menge

aller Prozesse (πk )k∈{n+1,...,N } , für die gilt:

(i) πn+1 ist konstant,

(ii) πk ist σ(Yn+1 , . . . , Yk−1 )-messbar, für k ∈ {n + 2, . . . , N },

(iii) Vkn,π (v) > 0, für alle k ∈ {n + 1, . . . , N }.

Man kann zeigen:

Wn (v) = sup{EU (VNn,π (v)) : π ∈ Ãn (v)}.

Satz 6.1 (Bellman-Prinzip)

Für alle n < N und v ∈ (0, ∞) gilt:

Wn (v) = sup E(Wn+1 (v[1 + r + c(Yn+1 − (1 + r))])).

(6.1)

c∈R

51

6

Nutzenmaximierung im Binomialmodell

Beweis. ≤: Sei π = (πn+1 , . . . , πN ) ∈ Ãn (v). Dann b := πn+1 ∈ R. Setze vu :=

vu (b) := v[1+r +b(u−(1+r))] und vd := vd (b) := v[1+r +b(d−(1+r))]. Definiere

π̂ := (πn+2 , . . . , πN ). Man kann zeigen: es gibt α ∈ Ãn+1 (vu ) und β ∈ Ãn+1 (vd )

mit

(

α, falls Yn+1 = u

π̂ =

β, falls Yn+1 = d.

Also

EU (VNn,π (v)) = E[1{Yn+1 =u} U (VNn+1,α (vu )) + 1{Yn+1 =d} U (VNn+1,β (vd ))].

(2)

Beachte

E[1{Yn+1 =u} U (VNn+1,α (vu ))] = E E[1{Yn+1 =u} U (VNn+1,α (vu ))|σ(Yn+1 )]

= E 1{Yn+1 =u} E[U (VNn+1,α (vu ))] .

Der 2. Term auf der RS von (2) kann analog umgeformt werden. Also

EU (VNn,π (v)) = E[1{Yn+1 =u} E[U (VNn+1,α (vu ))] + 1{Yn+1 =d} E[U (VNn+1,β (vd ))]]

≤ E 1{Yn+1 =u} Wn+1 (vu ) + 1{Yn+1 =d} Wn+1 (vd )

= E [Wn+1 (v[1 + r + b(Yn+1 − (1 + r))])]

≤ sup E [Wn+1 (v[1 + r + c(Yn+1 − (1 + r))])] .

c∈R

≥: Annahme: die rechte Seite von (6.1) ist größer als die Linke. Dann existiert

ε > 0 und c ∈ R mit

Wn (v) < −ε + E[Wn+1 (v[1 + r + c(Yn+1 − (1 + r))])].

Wähle α ∈ Ãn+1 (vu (c)) und β ∈ Ãn+1 (vd (c)) so, dass E[U (VNn+1,α (vu (c))] >

− 2ε + Wn+1 (vu (c)) und E[U (VNn+1,β (vd (c))] > − 2ε + Wn+1 (vd (c)). Definiere π =

(πk )k∈{n+1,...,N } wie folgt:

πn+1

(

αk , Yn+1 = u

= c und für k > n + 1 sei πk =

βk , Yn+1 = d.

Dann ist π ∈ Ãn (v) und

VNn,π (v) = VNn+1,α (vu (c))1{Yn+1 =u} + VNn+1,β (vd (c))1{Yn+1 =d} .

52

6

Nutzenmaximierung im Binomialmodell

Weiterhin

E[U (VNn,π (v))] = E[E[U (VNn+1,α (vu (c)))1{Yn+1 =u} + U (VNn+1,β (vd (c)))1{Yn+1 =d} |σ(Yn+1 )]]

h

i

= E E[U (VNn+1,α (vu (c)))]1{Yn+1 =u} + E[U (VNn+1,β (vd (c)))]1{Yn+1 =d}

ε

≥ − + E[Wn+1 (vy (c))|y=Yn+1 ]

2

ε

= − + E[Wn+1 (v[1 + r + c(Yn+1 − (1 + r))])]

2

ε

ε

> − + ε + Wn (v) = + Wn (v).

2

2

Dies ist ein Widerspruch zur Definition von Wn (v).

Wegen des Bellman-Prinzips lässt sich Wn rekursiv bestimmen. Es gilt WN (v) =

U (v). Mit (6.1) kann man nun WN −1 bestimmen, danach WN −2 , usw.

Satz 6.2

Sei U = log. Dann gilt für alle v ∈ (0, ∞) und n ≤ N

Wn (v) = log(v) + cn ,

wobei

(6.2)

p

1−p

cn := (N − n) (1 + r) + p log ∗ + (1 − p) log

.

p

1 − p∗

Die Strategie

πk = π

b :=

(1 + r)(p − p∗ )

,

p∗ (1 − p∗ )(u − d)

k ∈ {1, . . . , N },

(6.3)

ist in An (v) und optimal für Wn (v).

Beweis. 1. Wir zeigen zunächst, dass π

b ∈ An (v) für alle n ∈ {1, . . . , N } gilt.

Beachte dazu, dass

1+r+π

b(Yj − (1 + r))

nur zwei Werte annehmen kann:

53

6

Nutzenmaximierung im Binomialmodell

a)

(1 + r)(p − p∗ )

(u − (1 + r))

p∗ (1 − p∗ )(u − d)

(1 + r)(p − p∗ )

=1+r+

p∗

p

= (1 + r) ∗ > 0.

p

1+r+π

b(u − (1 + r)) = 1 + r +

b)

(1 + r)(p − p∗ )

(d − (1 + r))

p∗ (1 − p∗ )(u − d)

(1 + r)(p − p∗ )

=1+r−

1 − p∗

1−p

= (1 + r)

> 0.

1 − p∗

1+r+π

b(d − (1 + r)) = 1 + r +

Damit folgt für alle v ∈ (0, ∞), n ∈ {0, . . . , N } und k ∈ {n, . . . , N }

Vkn,bπ (v) > 0.

Also ist π

b zulässig ab jedem n.

2. Wir zeigen jetzt (6.2) und die Optimalität von (6.3) durch Rückwärtsinduktion.

n = N : WN (v) = log(v) X

n + 1 → n: Es gelte Wn+1 (v) + log(v) + cn+1 für alle v ∈ (0, ∞). Mit (6.1) und

der Induktionsvoraussetzung folgt

Wn (v) = sup EWn+1 (v[1 + r + π(Yn+1 − (1 + r))])

π∈R

= cn+1 + sup E log(v[1 + r + π(Yn+1 − (1 + r))]).

π∈R

Beachte

f (π) :=E log(v[1 + r + π(Yn+1 − (1 + r))])

(3)

= log v + p log(1 + r + π(u − (1 + r))) + (1 − p) log(1 + r + π(d − (1 + r)))

und

df

u − (1 + r)

d − (1 + r)

(π) = p

+ (1 − p)

.

dπ

1 + r + π(u − (1 + r))

1 + r + π(d − (1 + r))

54

6

Die BEO

df

(π)

dπ

Nutzenmaximierung im Binomialmodell

= 0 impliziert

p(u−(1+r))(1+r+π(d−(1+r)))+(1−p)(d−(1+r))(1+r+π(u−(1+r)) = 0,

und damit