1 7. Vorlesung Statistik II Letzte Änderung: 9. Oktober 2001, 30

Werbung

1

7. Vorlesung Statistik II

Letzte Änderung: 9. Oktober 2001, 30 Seiten

Kapitel 17 Parametrische Tests

17.1 Einige Überlegungen zur Begründung der Testtheorie

Nach den beiden vorhergehenden Kapiteln über die Punkt- und Intervallschätzung ist

jetzt die wichtige Frage der Beurteilung solcher Schätzwerte zu beantworten.

Dazu wird eine Theorie bereitgestellt, mit der der Grad der Unsicherheit solcher Aussagen,

etwa über Parameterwerte, deutlich gemacht werden kann.

Die Methodenvielfalt zeigt zum einem die Bedeutsamkeit der Fragestellung, zum anderen

jedoch auch, daß wie in anderen schwierigen Problemen auch in der Statistik eine Frage

mehr als eine Antwort finden kann.

Die Faktenausgangslage ist unverändert die alte: Es gibt eine Zufallsstichprobe der Länge

n, d.h. n Zufallsvariable (X1, X2, ..., Xn) , für die eine Realisierung (x1, x2, ..., xn) bekannt

ist. Mit Hilfe einer Stichprobenfunktion, einer Schätzfunktion

θ = g(X1, X2, ..., Xn)

bzw. bei vorliegender Stichprobenrealisierung (x 1, x2, ..., xn)

θ = g(x1, x2, ..., xn),

geht es darum, den Schätzwert θ für den unbekannten wahren Parameter θ aus den

Realisierungen zu bestimmen und nach noch vorzustellenden Kriterien zu beurteilen. Dies

Grundanliegen ist sehr ähnlich der Theorie des Konfidenzbereichs. Doch die formale

Ausgestaltung der Tests unterscheidet sich von der des Konfidenzbereichs. Als erstes soll

eine Definition des Tests allgemein vorgestellt werden, dann die in der Definition

unerklärten begrifflichen Bestandteile motiviert und schließlich im Rest des Kapitels über

eine Folge von Beispielen das Schema des Tests verdeutlicht werden.

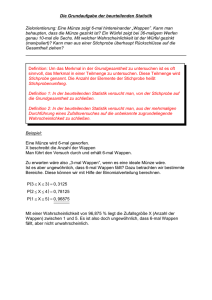

17.1.1 Definition (Der statistische Test)

Unter den Voraussetzungen des Kapitels 13 (Vorgabe einer identisch verteilten

Zufallsstichprobe der Länge n aus einer festgelegten Grundgesamtheit) heißt ein

Verfahren, das aufgrund der Stichprobe eine Entscheidung über Annahme oder

Ablehnung einer Hypothese erlaubt, ein statistischer Test, bzw. Test.

2

Bemerkung (Abraham Walds statistisches Entscheidungsschema)

Die Daten der Stichprobe werden durch drei Mengen von Objekten beschrieben:

(a) eine Menge von Zuständen der Natur, denen sich der Statistiker gegenüber

sieht (z.B. zwei Zuständen; mehr als zweien, aber endlich vielen Zuständen;

einem Kontinuum von Zuständen),

(b) eine Menge möglicher Entscheidungen, die der Statistiker treffen kann (z.B. ist

Nichtstun eine erste Entscheidungsmöglichkeit; wir gehen im folgenden fast

stets von zwei Entscheidungsmöglichkeiten aus; zu dieser Regel siehe den Film

Jacubovsky und der Oberst: im Leben gibt es zumindest immer zwei Möglichkeiten; u.U. gibt es beliebig viele diskrete oder möglicherweise stetige Entscheidungsmöglichkeiten)

(c) eine Menge von Konsequenzen aus dem Zusammenwirken von Zuständen

und Entscheidungen.

Sei dies an einem Problem von 2 Zuständen und drei Entscheidungen sowie 6 möglichen

Folgen illustriert (Vergl. Luce, Raiffa, S. 276):

Für ein Rührei sind bereits 5 gute Eier in die Pfanne gehauen. Um das Rührei auf die

richtige Größe zu bringen, ist noch ein sechstes in die Pfanne zu tun. Zur Voruntersuchung

des Eis Nr. 6 kann man es vorher in eine Untertasse hauen; dies ändert nicht die Logik,

erhöht aber die Menge der Zustände und Entscheidungen. Die Situation kann durch die

folgende (3,2)-Entscheidungsmatrix beschrieben werden. Daß dies eine Vereinfachung ist

wie alle Modelle der Wissenschaft, ist auch klar.

Zustände der Natur

Entscheidungen

Ei ist gut

Ei ist faul

6-Ei Rührei

5 Eier

verdorben

Probe in

Untertasse

6-Ei Rührei

Untertasse

spülen

5-Ei Rührei

Untertasse

spülen

Ei 6 gleich

fortwerfen

5-Ei Rührei

Verlust Ei 6

5-Ei Rührei

keine Probe

in Untertasse

3

Die Menge der Folgen steht offensichtlich in den Feldern der Matrix, während die

Entscheidungen durch die Zeilen und die Menge der Zustände durch die Spalten der

Matrix dargestellt werden.

Genau in einer solchen Lage ist der Statistiker. Die Natur (die Zustandsmenge) wird durch

die Menge der Parameterwerte dargestellt, im einfachsten Fall durch zwei Werte: Der

Parameter θ hat zwei mögliche Werte, nämlich θ1 und θ2 (oder oft auch in der historisch

üblichen Bezeichnung θ0 und θ1). Welcher von beiden der “wahre” ist und ob dies aus der

Stichprobe überprüfbar ist, ist unbekannt und gerade durch den Statistiker zu beurteilen.

Damit hat der Statistiker zumindest zwei Entscheidungen zu treffen, und der Einfachheit

halber seien im folgenden nur zwei Entscheidungen erörtert: entweder legt er sich auf den

einen oder den anderen der Parameter fest. M.a.W. der Statistiker muß sich klarwerden,

was in seinen Augen zutrifft. Bevor noch erläutert wird, daß dabei die Rolle von θ1 und θ2

nicht symmetrisch ist, soll dieser Rahmen des Tests als erstes im Schema von Wald

beschrieben werden:

Zustände der Natur

(die Menge der Parameterwerte)

Entscheidungen

des Statistikers

Hypothese H0

wird angenommen

Hypothese H0

wird abgelehnt

Nullhypothese

Hypothese H0

θ 0 trifft zu

Alternativhypothese

Hypothese H1

θ 1 trifft zu

richtig

falsch

Fehler 2. Art

falsch

Fehler 1. Art

richtig

17.1.3 Bemerkung (Fehler 1. Art, Fehler 2. Art):

Offensichtlich können in einer solchen Entscheidungssituation zwei Fehlentscheidungen

getroffen werden: Man verwirft die Nullhypothese, obwohl die Alternative falsch ist

(Fehler 1. Art); dies ist äquivalent zu der Formulierung, man verwirft die Nullhypothese,

obwohl sie richtig ist. Die zweite Fehlentscheidung ist, man verwirft die Nullhypothese

nicht, obwohl die Alternativhypothese richtig ist (Fehler 2. Art).

Die zu prüfenden Parameterwerte werden als Alternativen einander gegenübergestellt;

und zwar als sogenannte Nullhypothese derjenige Parameterwert, der auf seine weitere

Gültigkeit hin getestet werden soll gegenüber einem (etwa aufgrund neuer Überlegungen,

Fertigungstechniken o.ä.) neuen Parameterwert, der in der Alternativhypothese formuliert wird.

Durch Vorgabe der Fehlerwahrscheinlichkeit 1. Art wird dann gewissermaßen die Risikobereitschaft ausgedrückt, vom alten Zustand abzurücken, obwohl es besser wäre, diesen

alten Zustand beizubehalten.

4

Im folgenden wird die Nullhypothese mit H0 und die Alternativhypothese mit H1

bezeichnet, im allgemeinen in folgender Gegenüberstellung:

H0: θ = θ1 gegen H1: θ = θ2

Es sind jedoch auch andere Bezeichnungsweisen üblich, z.B.

H1: θ = θ1 gegen H2: θ = θ2 oder

H0: θ = θ0 gegen Ha : θ = θa .

Zustände der Natur

(die Menge der Parameterwerte)

Entscheidungen

des Statistikers

Hypothese H0

θ 0 trifft zu

Hypothese H1

θ 1 trifft zu

nach Entscheidungsfunktion Annahme

von Hypothese H0

1-α

P[Fehler 2.Art] = β

nach Entscheidungsfunktion Ablehnung

von Hypothese H0

P[Fehler 1.Art] = α

1-β

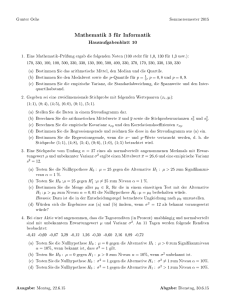

17.1.4 Bemerkung (Irrtumswahrscheinlichkeit und Güte):

Die Wahrscheinlichkeit α, d.h. die Wahrscheinlichkeit einen Fehler 1. Art zu machen, wird

auch oft einfach als Irrtumswahrscheinlichkeit bezeichnet und die Wahrscheinlichkeit 1-β,

die Wahrscheinlichkeit keinen Fehler 2. Art zu machen, als Güte des Tests (power of the

test).

Dieses allgemeine Schema eines Test sei nun durch eine Folge von Beispielen und durchgerechneter Aufgaben verdeutlicht. Die Beispiele differieren nach wenigen, aber wichtigen

Voraussetzungen nämlich danach,

wieviel über die betrachteten Zufallsvariablen bekannt ist

z.B. Mittelwert und Varianz,

z.B. nur die Varianz,

z.B. weder Mittelwert noch Varianz,

z.B. nur die Verteilung;

wie die für den unbekannten zu betrachtenden Parameter zu beschaffende

Information aussehen soll

z.B. ein fester Wert

z.B. eine Schranke für den Wert nach oben oder unten,

z.B. eine Schranke für den Wert nach oben und unten;

welche und wieviele Beobachtungen (Stichprobe(n)) zur Verfügung stehen.

z.B. eine (ein seltener, aber nicht ganz abwegiger Sonderfall),

z.B. mehrere, aber endlich viele (der Regelfall),

z.B. beliebig viele (ein Fall, der u.U. den Zentralen Grenzwertsatz zur

Anwendung bringt.)

Unabhängigkeit der Stichprobe wird für unsere Überlegungen stets vorausgesetzt.

5

17.2 Einstichprobentests für Erwartungswerte

17.2.1 Beispiel (Normal-Stichprobe mit bekannter Varianz)

Wie im Beispiel 16.1.6 der Konfidenzbereichsbestimmung für Erwartungswerte sei die zu

untersuchende Zufallsstichprobe aus einer Normalverteilung mit bekannter Varianz σ2

entnommen, d.h. alle (X 1, X2, ..., Xn) mit den Realisierungen (x1, x2, ..., xn) seien identisch

normalverteilt

Xi ~N (µ,σ2) (i = 1, 2, 3, ..., n)

und zugleich sei σ2 bekannt.

Damit gilt wie dort für die Stichprobenfunktion µ = X

σ2

σ2

E(µ)= µ, var(µ) =

und µ ist normalverteilt: µ ~ N (µ, ).

n

n

Für das Hypothesenpaar

H0: µ = µ0

µ0≠µ 1 (o.B.d.A. µ0<µ1)

H1: µ = µ1

und die Stichprobenfunktion X sowie eine Schranke k, einen kritischen Wert k (oft

µ0<k<µ1) sei die folgende Entscheidungsregel verwandt:

(i) Annahmebereich (Akzeptanz-Region):

Falls X ≤ k, dann wird H0 akzeptiert

(ii) Ablehnungsbereich (Rejektions-Region):

Falls X > k, dann wird H0 verworfen.

Nach Vorgabe dieser Entscheidungsregel kann über die übliche Standardisierung auf die

Standard-Normalverteilung für die Stichprobenfunktion X bei Vorgabe der Fehlerwahrscheinlichkeit 1. Art α der kritische Wert k bestimmt werden:

Sei für H0 definiert:

z0:=

µ - E(µ)

var(µ)

=

(µ - µ0)

σ

n

.

Dann gilt

z0 ~ N (0,1),

und aus der Bedingung (Fehler 1. Art; Entscheidung im Ablehungsbereich):

P(z0 > k*) = α ⇔ P(z0 ≤ k*) = 1 - α ⇔ Φ(k*) = 1 - α,

kann der standardisierte kritische Wert k* aus der Standardnormalverteilungstabelle

entnommen und anschließend wieder auf den gesuchten kritischen Wert k für die nichtnormalisierte Größe umgerechnet werden:

(k-µ 0)

σ

n = k* ⇔ k= µ 0 + k*

.

σ

n

Die Entscheidung erfolgt jetzt nach der oben angeführten Entscheidungsregel: Verwerfe

H0, wenn für die Realisierung x von X gilt: x > k. Die folgende Abbildung zeigt die

Entscheidungsbereiche. Ist x links von k (die Testgröße (Teststatistik) ist kleiner als der

kritische Wert) gilt die Hypothese H0 als akzeptabel, während für den Fall, daß x rechts

von k ist ( x ist größer als k) die Hypothese H0 abzulehnen ist. Man beachte genau die

Sprechweise: im Annahmebereich heißt es nicht: “die Hypothese H 0 gilt”, sondern nur,

6

“man kann sie nicht verwerfen”. Im Ablehnungsbereich hingegen ist die Aussage viel

stärker: “die Hypothese H0 wird verworfen”. Aber das heißt nicht notwendig, daß sie

wirklich falsch ist!

17.2.2 Bemerkung (Klassifikation des Tests):

Der erörterte Test heißt einfach, weil beide Hypothesen nur durch jeweils genau einen

Parameterwert repräsentiert werden. Empirisch ist es u.U. schwierig, die richtigen

Hypothesen herauszufinden. In der Praxis treten sie oft durch streitige Behauptung zu

Tage: der Verkäufer eines Produkts behauptet einen Wert und der Käufer einen anderen,

z.B. die mittlere Lebendauer eines Reifens.

17.2.3 Beispiel

1. Der Ablehnungsfall

Zur Verdeutlichung sei wieder die kleine Stichprobe aus Beispiel 16.1.7 von vier Beobachtungen betrachtet: (1, 2, 3, 1). Die Varianz der zugrundeliegenden normalverteilten

Zufallsvariablen X sei bekannt: σ2 = 1.

Zur Irrtumswahrscheinlichkeit 1. Art α = 0.1 soll

H0: µ = µ0: = 1 gegen

H1: µ = µ1: = 2

getestet werden. Mit µ = X , E(µ ) = µ, var( µ ) =

X - µ0

σ2

n

k-1

2 )= 1- α

σ

1

erhält man: k = 1.641, und wegen x = 1.75 > 1.641 = k muß H0 verworfen werden.

Der Fehler 2. Art β tritt dann mit folgender Wahrscheinlichkeit auf:

X - µ1

1.641-2

P(

n ≤

2)= Φ(-0.718)= 0.2396.

σ

1

P(

n ≤

7

N (1,

σ

2

)

n

N (2,

µ 0=1

σ

2

)

n

µ 1=2

k=1.641

2. Der Annahmefall

Wählt man unter sonst gleichen Umständen die Irrtumswahrscheinlichkeit

1. Art α = 0.05, dann erhält man aus

X - µ0

k-1

P(

n ≤

2) = 1-α

σ

1

den kritischen Wert k = 1.8225, und wegen x = 1.75 < 1.8225 = k kann H0 nicht verworfen

werden.

Hier tritt der Fehler 2. Art β mit folgender Wahrscheinlichkeit auf:

X - µ1

1.8225-2

P(

n ≤

2)= Φ(-0.357)= 0.3604.

σ

1

N (1,

σ

2

n

)

N (2,

µ 0=1

µ 1=2

k=1.8225

σ

2

n

)

8

17.2.4 Bemerkung (Zusammenhang der Fehlerwahrscheinlichkeiten)

Offensichtlich - man siehe die Abbildung auf der Vorseite - wächst die Fehlerwahrscheinlichkeit 2. Art, wenn die Fehlerwahrscheinlichkeit 1. Art verringert wird und umgekehrt.

Beide Fehler zugleich zu minimieren ist keine sinnvolle Fragestellung, d.h. die Verkleinerung des einen Fehlers wird durch eine Vergrößerung des anderen erkauft.

17.2.5 Bemerkung (Zusammenhang von Fehlern und Stichprobenlänge)

Die einzige Möglichkeit, bei gegebener Fehlerwahrscheinlichkeit 1. Art α die Fehlerwahrscheinlichkeit 2. Art β zu beeinflussen (zu verkleinern), besteht darin, bei der Erhebung

der Stichprobe einen größeren Aufwand zu treiben, d.h. den Stichprobenumfang zu

erhöhen.

17.2.6 Beispiel (Fortsetzung)

Hätte man etwa als Stichprobenrealisation die Beobachtungen (1,2,3,1,1,2,3,1) erhalten,

dann wäre x = 1.75 wie bisher, aber der kritische Wert k zur Fehlerwahrscheinlichkeit

1. Art α = 0.05 wäre nun k= 1.5816. Folglich müßte jetzt die Nullhypothese verworfen

werden und man erhielte als Fehlerwahrscheinlichkeit 2. Art β

X - µ1

1.5816-2

P(

n ≤

8 ) = Φ(-1.1834) = 0.1183

1

σ

17.2.7 Bemerkung (gemischte, zusammengesetzte Hypothesen):

Einfache Hypothesen, wie in Beispiel 17.1.7, sind nicht der Regelanwendungsfall, sondern

die folgenden sog. gemischten oder zusammengesetzten Hypothesen. Statt zweier

spezifischer Werte für µ0 und µ1 werden ganze Bereiche für die Parameter miteinander

verglichen. D.h. etwa, daß einer Behauptung, ein Parameter übersteige eine bestimmte

Grenze, die Behauptung gegenübergestellt wird, diese Grenze werde durch den Parameter unterschritten. Im Bereich des Umweltschutzes etwa geht es bei der Frage nach den

Immissionsmengen bestimmter Schadstoffe nicht so sehr um die exakten Werte als vielmehr darum, ob gewisse Grenzwerte überschritten werden oder die immittierte Menge

sich noch in einem Bereich bewegt, der bezüglich weiterreichender Folgen unbedenklich

ist.

Unter den Vorausetzungen des Beispiels 17.1.7 sei das Hypothesenpaar

H0: µ ≤ µ0 gegen H1: µ > µ1

zu testen. (Auch hier sei µ0 ≤ µ1).

Dabei verfährt man so, als ob bezüglich der Nullhypothese der im Sinne dieser Nullhypothese ungünstigste aller Fälle wahr wäre, d.h. man geht davon aus, daß µ=µ0 ist und

führt den Test entsprechend den oben entwickelten Regeln durch.

9

2

N ( µ0 , σ )

Annahmebereich

Ablehnungsbereich

α

µ0

kritischer Wert

Bei der Bestimmung der Fehlerwahrscheinlichkeit 2. Art β verfährt man entsprechend:

Man geht vom ungünstigsten Fall aus, d.h. unter allen unter der Alternativhypothese

zulässigen Parameterwerten wählt man denjenigen, der die Fehlerwahrscheinlichkeit 2.

Art maximiert. Bei der obigen Formulierung der Alternativhypothese, in der die Menge

der zulässigen Parameterwerte offen ist, muß dann das folgende Supremum gebildet

werden:

sup {P(X < k)}.

µ>µ1

Dieses Supremum erhält man, indem man den ungünstigsten Parameterwert, µ1, wählt.

Für das umgekehrte Hypothesenpaar

H0: µ ≥ µ0

H1: µ < µ1

folgt ein entsprechendes Rezept für die Bestimmung von kritischem Wert und Annahmeund Ablehnungsbereich (s.u. die Übersicht im Anhang).

10

2

N (µ 0 , σ )

Ablehnungsbereich

α

Annahmebereich

kritischer Wert

µ0

Eine besonders interessante Variante des Tests ist die Untersuchung des folgenden

symmetrischen Parameterintervalls:

17.2.8 Beispiel (Zweiseitiger Mittelwert-Test bei bekannter Varianz)

Für das Hypothesenpaar

H0: µ = µ0 gegen

H1: µ ≠ µ0,

die Stichprobenfunktion X sowie die symmetrische Entscheidungsregel

(i) Annahmebereich (Akzeptanz-Region):

Falls |X–µ0|≤ k, dann wird H0 akzeptiert

(ii) Ablehnungsbereich (Rejektions-Region): Falls |X–µ0|> k, dann wird H0

verworfen,

stimmt der Mittelwerttest mit einem symmetrischen Konfidenzbereich für µ0 überein,

sofern der Fehler 2. Art außerachtgelassen wird, wie es hier geschieht. Für den Fehler

1. Art gilt die Definition des Vertrauensintervalls (s.o. Definition 16.1.1)

P[zu ≤ z ≤ zo ] = 1 - α, 0< α <1

mit dem einzigen Unterschied, daß in der Definition von z statt eines unbekannten µ (so in

der Theorie des Konfidenzintervalls) die Größe µ0 der Nullhypothese einzusetzen ist:

(µ - µ 0) n

µ - E(µ)

z=

=

.

σ

var(µ)

Sofern z in das durch die Tafelwerte begrenzte Intervall fällt, ist die Hypothese zu akzeptieren. Diese Sicht der Dinge erklärt, weshalb das α des Signifikanzniveaus in der Theorie

der Konfidenzbereiche auch als Irrtumswahrscheinlichkeit bezeichnet wurde (s.o. Beispiel

16.1.6).

11

Mit Ausnutzen der Symmetrie folgt das kritische Intervall, der Annahmebereich:

P[-T ≤ z ≤ T] = 1 - α, 0< α <1, der zugehörige Tafelwert T aus der Normal(0,1)-Tabelle.

Dieser Annahmebereich stimmt mit dem Konfidenzintervall aus Beispiel 16.1.6 überein.

17.2.9 Beispiel

Mit der Stichprobenrealisation (1,2,3,1) wie in Beispiel 17.1.7 sollen zur Fehlerwahrscheinlichkeit 1. Art α = 0.05 die Hypothesen

H0: µ = 1.5 gegen

H1: µ ≠ 1.5

getestet werden. Die zugrundeliegende Zufallsvariable sei wieder normalverteilt mit bekannter Varianz σ2 = 1.

Zu bestimmen sind jetzt die beiden (symmetrisch zu µ0=1.5 gelegenen) Werte (d.h. c)

µ0 - c und µ0 + c

derart, daß gilt:

P(µ0 - c ≤ X ≤ µ0 + c) = 1-α.

Hieraus erhält man:

c

α

c

Φ(n) = ⇔ n = -1.96 ⇔ c =.0.98.

σ

σ

2

Die Nullhypothese kann also nicht verworfen werden, da

µ0 - c = 1.5-0.98 = 0.52 < 1.75 = x < 2.48 = 1.5+0.98 = µ0 + c.

2

N (µ 0 , σ )

Annahmebereich

Ablehnungsbereich

α/2

Ablehnungsbereich

α/2

µ

kritischer Wert 1

0

kritischer Wert 2

12

17.2.10 Bemerkung (Zweiseitiger Mittelwert-Test bei unbekannter Varianz)

In gleicher Weise, wie das entsprechende Vertrauensintervall für den Fall unbekannter

Varianz zur t-Verteilung der Stichprobenfunktion führte, sonst jedoch die Überlegungen

unverändert ließ (s.o. Beispiel 16.1.10), so folgt für den symmetrischen Normal-MittelwertTest bei unbekannter Varianz σ2 das kritische Intervall, der Annahmebereich

P[T u ≤ z ≤ T o ] = 1 - α,0< α <1, bzw.

P[-T ≤ z ≤ T] = 1 - α, 0< α <1, T u, T o, T zugehörige Tafelwerte der t-Tabelle

17.2.11 Beispiel

Mit der Stichprobenrealisation (1, 2, 3, 1) wie zuvor soll zur Fehlerwahrscheinlichkeit 1. Art

α = 0.05 die Hypothese

H0: µ = 1.5 gegen

H1: µ ≠ 1.5

getestet werden. Die zugrundeliegende Zufallsvariable sei normalverteilt mit unbekannter

Varianz; deshalb benutzen wir hier die korrigierte Stichprobenstreuung

s* = 0.9574.

Zu bestimmen sind jetzt die beiden (symmetrisch zu 0 gelegenen) Werte T u und T o, bzw. T

derart, daß gilt:

P[T u ≤ z ≤ T o ] = P[-T ≤ z ≤ T] = 1 - α.

Aus der t-Verteilungstabelle mit n-1 = 3 Freiheitsgraden erhält man

T u = -T =-3.18 und entsprechend der Symmetrie der t-Verteilung T o = T = 3.18

Die Nullhypothese kann also nicht verworfen werden, da

-T = -3.18 < 0.52 < 3.18 = T .

Dabei wird der Wert der Stichprobenfunktion wie folgt berechnet (s.o. Kapitel 16):

(x - µ0) n 1.75 - 1.5

=

⋅ 4 = 0.52

s*

0.9574

17.2.11 Bemerkung

Beim zweiseitigen Test über den Erwartungswert µ der Normalverteilung wird bei

unbekannter Varianz ebenso die Teststatistik

X - µ0

X - µ0

n-1 =

n

S

S*

verwendet. Diese Teststatistik ist mit n-1 Freiheitsgraden t-verteilt.

Bei einseitigen Tests kommt dieselbe Statistik zur Anwendung. Deshalb kann das

Verfahren aus Beispiel 17.2.3 entsprechend übertragen werden.

13

17.3 Ein Zweistichprobentest zum Vergleich zweier Mittelwerte bei bekannter Varianz

Die Daten bestehen aus zwei unabhängigen Teilstichproben, eine der Länge n 1 und die

andere der Länge n 2. Beides seien Zufallsstichproben aus Normalverteilungen mit jeweils

bekannter Varianz σ 2i (i = 1, 2), d.h.

(X11, X12, ..., X1n1 ) mit der Realisierung (x11, x12, ..., x1n1 ),

2

X1i ~ N (µ1,σ 1) (i = 1, 2, ...,n1) und

(X21, X22, ..., X2n2 ) mit der Realisierung (x21, x22, ..., x2n2 ),

2

X2i ~ N (µ2, σ 2) (i = 1, 2, ..., n2).

Für die beiden Stichprobenfunktionen gilt:

σ 2i

σ 2i

µi =X i , E(µi)= µ i, var(µ i) =

, µ ~N (µi,

), i=1,2.

ni i

ni

Außerdem gilt wegen der Unabhängigkeit (s.o. Bemerkung 13.1.3)

σ2 σ2

E(X1 - X2) = E(µ 1 - µ 2) = µ1 - µ2, var(X 1 - X2) = var(µ1 - µ2)= n 1 + n 2

1

2

und für eine Stichprobenfunktion Y:= X1 - X2 gilt damit:

Y ~ N(µ1 - µ 2,

σ21

σ22

+ ).

n1 n 2

Für die Mittelwertdifferenz δ:= µ1 - µ2 können daher folgende Hypothesenpaare einem

üblichen Mittelwert-Test unterzogen werden:

Unterfall 1 (einfacher Test auf Gleichheit):

H0: δ = δ0 = 0

H1: δ = δ1 (δ1 ≠ δ0),

Unterfall 2 (einfacher Test auf eine von Null verschiedene Differenz):

H0: δ = δ0 ≠ 0

H1: δ = δ1 (δ1 ≠ δ0),

Unterfall 3 (ein gemischter beidseitiger Test):

H0: δ = δ0

H1: δ ≠ δ0,

Unterfall 4 (ein gemischter einseitiger Test):

H0: δ ≥ δ0 (oder δ ≤ δ0)

H1: δ < δ0 (oder δ > δ0).

14

17.3.1 Beispiel

Die Niederschlagsmenge im Monat Juli (in mm) betrug in Hamburg bzw. München

Hamburg

München

1975

120

137

1976

34

136

1977

72

152

1978

74

161

1979

84

67

1980

169

166

1981

72

181

1982

31

107

1983

5

35

1984

47

(Quelle: Statistische Jahrbücher 1976-1985)

104

Die Niederschlagsmenge im Monat Juli in Hamburg bzw. München sei normalverteilt mit

den Mittelwerten µ0 bzw. µ1 und gemeinsamer Varianz σ2 = 2000. Damit läßt sich anhand

der obigen Stichprobe

H0: µ0 ≥ µ1 gegen H1: µ0 < µ1

mit der Fehlerwahrscheinlichkeit 1. Art von 0.10 ein Test gemäß Unterfall 4 formulieren:

H0: δ ≥ 0 gegen H1: δ < 0, wobei δ = µ0 - µ1 gesetzt wurde.

Aus den Daten errechnet man x = 70.8 undy = 124.6.

X - Y - (µ0 - µ 1)

Die Stichprobenfunktion Z:=

σ 21 σ22

n1 + n 2

ist standardnormalverteilt, und man errechnet die Realisierung z = -2.69. Aus der

Standard-Normalverteilungstabelle erhält man -1.282 und folglich muß H0 verworfen

werden; d.h. es kann als statistisch gesichert angesehen werden, daß es im Juli in München

mehr regnet als in Hamburg! (Vorsicht: Trotzdem kann es in Hamburg häufiger regnen!)

Anmerkung zur Schreibweise

Wenn nach Durchführen eines Tests eine Hypothese angenommen werden kann, wird

diese Entscheidung (im Englischen decision) häufig in Kurzschreibweise wie folgt angegeben: d = H0

Entsprechend ist die Kurzschreibweise für die Ablehnung der Hypothese: d ≠ H0.

15

17.3.2 Bemerkung

(Vergleich zweier Normal-Mittelwerte bei

unbekannter, aber gleicher Varianz)

So wie der Übergang vom Beispiel 17.2.8 zu Beispiel 17.2.10 im Test die Ersetzung der

Normalverteilung durch die t-Verteilung brachte, so kann auch hier eine zweite Testserie

für den Vergleich der Mittelwerte gemacht werden, wenn beide Varianzen unbekannt

sind. Die Ergebnisse übertragen sich unmittelbar.

Der Fall, daß die eine Varianz bekannt und die andere unbekannt ist, wird nicht erörtert.

17.3.3 Beispiel

Sei nun die gleiche Problemstellung wie bei Beispiel 17.3.1 gegeben aber die Varianzen

seien unbekannt (wenn auch noch immer gleich). Dann ist die Zufallsvariable

X - Y - (µ0 - µ1)

T:=

n1 + n2 - 2

1

1

*2

+

(n1 - 1)s*2

1 + (n2 -1)s 2

n 1 n2

für n1≥2 und n2≥2 t-verteilt mit n1+n2-2 Freiheitsgraden (s.o. 17.3)

Folglich wird H0 abgelehnt, wenn die entsprechende Realisierung von T im offenen

Intervall (- ∞ , tα;n1+n2-2) liegt.

Für α = 0.1 findet man in der Tabelle (n1 + n2 - 2 = 10+10-2 = 18): t = -1.33.

Die Stichprobenfunktion T hat die Realisierung -2.57. Folglich muß die Nullhypothese

wieder verworfen werden.

Eine Variante dieser beiden Aufgaben (17.3.1 und 17.3.3) ist die Situation, in der für den

Zwei Stichproben-Mittelwert-t-Test nicht die Urdaten vorliegen, sondern bereits

Zusammenfassungen:

16

17.3.4. Aufgabe (Zwei Stichproben-Mittelwert-t-Test bei unbekannter identischer

Varianz)

Die Höhe X bzw. Y eines Baumes der Sorte A bzw. B (eines bestimmten Alters) ist

normalverteilt; X und Y sind unabhängig und haben gleiche Varianzen. Unabhängige

Stichproben aus X bzw. Y ergaben folgende Resultate:

6

6

12

12

Σ X i = 90, Σ X 2i = 1500, Σ Yj = 120, Σ Yj2 = 1275

i=1

i=1

i=1

i=1

Testen Sie mit einer Fehlerwahrscheinlichkeit 1. Art α=0.01 folgende Hypothesen über die

Erwartungswerte:

a) H0: E(X)= E(Y) gegen H1: E(X)≠E(Y)

b) H 0: E(X)≤ E(Y) gegen H 1: E(X)>E(Y)

Lösung

Sind die Verteilungen X ~ N(µx, σ2), Y ~ N(µy , σ2), dann ist die interessierende Größe die

Mittelwertdifferenz µ:= µx - µy . Damit wird die Aufgabe reformuliert zu

H0: µ=0, und für die Teilaufgaben gelten die Alternativhypothesen:

(a) H1:µ≠0 und (b) H1:µ>0. Die Teststatistik T ist t-verteilt:

T=

X–Y

·

nXS2X+n YS 2Y

S 2X = 250-225=25,

n X+n Y–2

1

1

n X + nY

~ tnX+ nY-2 =t6+12-2 =t16

nX S 2X =150, nX =6,Y =10, S 2Y = 106.25-100=6.25, nY S 2Y =75, nY =12

1

1 1 1

1

15–10

4

40

nXS 2X+n YS 2Y = 225, nX + nY -2= 16,

+

= + = ,T=(

)·

=

= 2.67

n X n Y 6 12 4

15

0.5 15

Mit diesen Vorbereitungen folgen die Antworten zu a und b:

a) Der Test auf Gleichheit der Mittelwerte von X und Y

d≠H0 ⇔ |T| > k (= links und rechts zum Nullhypothesenwert symmetrischer

kritischer Wert)

α = 0.01 ⇒ 0.01= 2 . t16(-k) ⇒ t16(k)= 0.995 ⇒ k= 2.92 (der kritische Wert rechts);

X =15,

T = 2.67≤ 2.92 (= der in der Stichprobe realisiert Wert ist innerhalb des Annahmebereiches) ⇒ d=H0 (die Nullhypothese der Gleichheit ist akzeptabel)

b) Der Test des kleineren Erwartungswertes von X

d≠H0 ⇔ T > k (= kritischer Wert oberhalb des Nullhypothesenwertes)

α = 0.01 ⇒ 0.01 = 1 - tα, 16(-k) ⇔ t1 - α,16 (k) = 0.99 ⇒ k = 2.58, T= 2.67 > 2.58 ⇒ d≠H0

Beachten Sie, daß aus den Stichproben nur die beiden Momente X , Y bzw. S2 benutzt

werden.

17

17.3.5. Aufgabe (Zwei Stichproben-Mittelwert-t-Test bei unbekannter identischer

Varianz)

Der Erfolg einer einwöchigen Abmagerungsdiät, die komplette Mahlzeiten garantiert und

verspricht, daß kein Hungergefühl aufkommt, soll getestet werden. Aus Bequemlichkeitsgründen (man weiß nicht Besseres) nimmt man an, die Beobachtungen seien

normalverteilt und die Varianzen der beiden Stichproben seien gleich. Bei 15 Testpersonen

wurden die Gewichte vor und nach der Diät erhoben. Dabei ergaben sich folgende

Gewichtsdaten in kg:

Testperson

1

2

3

4

5

6

7

8

9

10 11 12 13 14 15

vorher Xv

64

81

79

69

70

80

69

68

75

75

76

83

69

85

77

nachher Xn

62

76

80

68

70

74

71

72

75

73

77

78

66

82

79

Testen Sie zum Niveau 0.05, ob eine signifikante Gewichtsverringerung eintritt.

Lösung (Der Test der Gewichtsdifferenz X = Xv - Xn)

Die Zufallsvariable ist X: Gewichtsveränderung (“vorher - nachher”) durch die Diät.

Zu testen ist H0: E(X) = 0 gegenüber H1: E(X) > 0

i

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

xi

2

5

-1

1

0

6

-2

-4

0

2

-1

5

3

3

-2

Die Teststatistik T ist t-verteilt: T=

Xv – Xn – 0

nvS 2v+n nS 2n

·

n v+n n–2

1 1

nv + n n

~ tnv+ nn - 2 = t15+15-2 = t28

17

= 1.13, s2 = 8.552 ⇒ s = 2.924

15

d≠H0 ⇔ T > k (= kritischer Wert oberhalb des Nullhypothesenwertes)

α = 0.05 ⇒ t α,28 (k) = 0.05 ⇒ k = + 1.645, d.h. der Ablehungsbereich ist (+ 1.645, ∞).

x =

T=

Xv – Xn – 0

nv+nn– 2

=

x–0

s

n =

1.133

2.924

15 = 1.501

1 1

+

nv nn

Da T = 1.501 < 1.645, kann H0 kann mit dieser Stichprobe nicht abgelehnt werden.

nvS 2v+n nS 2n

·

18

17.4 Die Theorie des p-Wertes (Einige Illustrationen des ein- und beidseitigen Tests)

Wenn ohnehin auf die Auswertung des Fehlers 2. Art verzichtet wird, dann bietet sich

folgende Theorie an, die sich unter dem Namen “p-Wert” eingebürgert hat.

Die Bedeutung des p-Werts wird hier für das Hypothesenpaar

H0: µ = µ0 gegenüber H1: µ ≠ µ0 bzw. H 1: µ = µ1 und µ0<µ1

vorgeführt.

Die benutzten Statistiken sind das übliche arithmetische Mittel: µ = X sowie die mittleren

quadratischen Abweichungen

S2

1

=

n

n

Σ (xi i=1

X)2

2

= σ bzw.

S* 2

1

=

n–1

n

Σ (xi -X) 2 = σ 2 .

i=1

Mit der Null-Hypothese für den Mittelwert H0: µ = µ0 gegenüber einer noch anzugebenden

Alternativ-Hypothese H 1 gilt für die Verteilung der Teststatistik je nach Kenntnis der Varianz,

daß sie entweder normalverteilt oder t-verteilt mit n-1 Freiheitsgraden ist, d.h. entweder

(µ - µ 0) n

µ - E(µ)

z0:=

=

, z0 ~ N (0,1),

σ

var(µ)

oder

µ - µ0

X - µ0

X - µ0

µ - µ0

µ - E(µ)

z0:=

=

n =

n =

n–1 =

n–1 , z0 ~ tn-1.

S*

S

σ

σ

var(µ)

Aus der Stichprobe folgt ein z0, das eingesetzt in die jeweilige Tabelle (entweder Normalverteilung oder t-Verteilung) einen numerischen Wert p1 bzw. p2 liefert, den sog. p-Wert

für die Null-Hypothese:

q1 = P[z≤z0] = Φ(z0) bzw. q 2 = P[z≤z0]= F(z0)

und

1 - q1 = p1 = P[z>z0] = 1 - Φ(z0) bzw.1 - q 2 = p2 = P[z>z0] = 1 -F(z0)

Der Vergleich mit dem zugehörigen einseitigen Test zeigt, daß der p-Wert die Rolle

ähnlich einer Irrtumwahrscheinlichkeit spielt, die hier jedoch nicht vorgegeben ist, was

ohnehin recht willkürlich und oft nur historisch bedingt ist, sondern folgt aus den

Beobachtungen. Die Grundidee ist dabei stets die gleiche, die die folgende Definition

beschreibt:

Definition (p-Wert)

Der p-Wert ist die Wahrscheinlichkeit, einen Schätzwert zu erhalten, der noch weiter vom

wahren Wert der Hypothese entfernt ist (falls die Hypothese wahr wäre) als der, der

tatsächlich durch die Beobachtungen (die spezielle Stichprobe, die spezielle Schätzung)

geliefert wird.

19

D.h. der p-Wert mißt, wie glaubwürdig die Ablehnung der Hypothese ist; m.a.W. ein

großer p-Wert (Nähe zum Nullhypothesenwert) läßt die Hypothese gelten. Damit wird

aber nicht bewiesen, daß die Hypothese zutreffend ist. Ein kleiner p-Wert spricht gegen

die Hypothese. Damit ist die Interpretation etwa, wie folgende Tabelle festhält:

p-Wert nach Tafel

Größenordnung

empirische Evidenz gegen die Null-Hypothese

> 0.12 (12%)

kaum, gegen die Null-Hypothese ist kaum etwas zu sagen

≈ 0.10 (10%)

schwach, die Null-Hypothese mag zutreffen

≈ 0.05 (5%)

fraglich, die Null-Hypothese ist sicher nicht selbstverständlich

≈ 0.01 (1%)

stark, empirischer Wert weit ab, die Null-Hypothese muß strittig sein

< 0.001 (1%o)

sehr stark, empirischer Wert zu weit ab, Null-Hypothese nicht tragbar

Numerisches Beispiel:

Sei eine Stichprobe X = {1, 2, 3, 2} zum Testen des Hypothesenpaares

H0: µ = 1.5 gegen H 1: µ ≠ 1.5

beobachtet.

X - µ0

2 -1.5

Die zugehörige t n-1-Testgröße ist z0 =

n =

4 ≈ 1.2247. Die t-Tafel liefert

S*

2/3

einen p-Wert von etwa 0.16 bzw., da es ein zweiseitiger Test ist, 0.32

(durch Interpolation der Tafelwerte

für t3

p= 0.20 in 0.978

für t3

p= 0.15 in 1.250).

M.a.W. die Hypothese ist so gut wie unangreifbar.

Für das Hypothesenpaar

H0: µ = 0.5 gegen H 1: µ = 2.5

X - µ0

2 -0.5

liefert die gleiche Stichprobe mit z0 =

n =

4 ≈ 3.674

S*

2/3

(durch Interpolation der Tafelwerte

für t3

p= 0.025 in 3.176

für t3

p= 0.010 in 4.538)

einen p-Wert von etwa 0.02. M.a.W. die Hypothese ist wenig überzeugend, da sie so weit

vom Nullhypothesenwert entfernt ist. Derartig große Abweichungen sind kaum

begründet.

20

Offensichtlich ist eine solche Interpretation schillernd.

Entsprechende p-Wert-Überlegungen können für die übrigen Tests gemacht werden.

Dazu wird die folgende bildliche Darstellung, die auf Wild und Seber (p.380) zurückgeht,

geboten:

Alternativ

Hypothese

Evidenz gegen

die 0-Hypothese

H0: µ = µ0 für

H1: µ > µ 0

µ >> µ 0

Dichte für den

Schätzwert

t-Dichte bzw. Normaldichte

einseitig

p-Wert

H1: µ < µ 0

µ << µ 0

.

einseitig

H1: µ ≠ µ0

µ0 zu weit ab

von µ0

in beiden

Richtungen

Die Schraffur bezeichnet den p-Wert.

p-Wert

21

17.5 Stichprobentests für die Varianz

Nach der Einführung von Tests über Erwartungswerte wird im folgenden noch ein Test

über Varianzen vorgestellt.

17.5.1 Der Test für die Varianz der Normal-Stichprobe

Entsprechend der Konstruktion eines Konfidenzintervalls für σ2 wird für einen zugehörigen Test, d.h. für ein Hypothesenpaar

Unterfall 1 (ein einfacher Test):

H0: σ 2 = σ20

σ21 ≠ σ20 (σ 21 > σ20 oder σ 21 < σ20)

2

2

H1: σ = σ 1

Unterfall 2 (ein beidseitiger Test):

H0: σ2 = σ 20

H1: σ2 ≠ σ 20

Unterfall 3 (ein einseitiger Test):

H0: σ2 = σ 20

H1: σ2 ≥ σ 20

Unterfall 4 (ein einseitiger Test):

H0: σ2 = σ 20

H1: σ2 ≤ σ 20

als Stichprobenfunktion auf die beiden Schätzer für σ2 zurückgegriffen:

n (x - µ)2

n (x - µ) 2

σ2 = Σ i n

und σ 2 = Σ i

n-1 .

i=1

i=1

Die Stichprobenfunktion (in vier äquivalenten Schreibweisen, wie in der Theorie des

Konfidenzintervalls erläutert) für σ2 ist:

n

Σ (xi - X)2

z:=

i=1

σ2

=

n⋅S2

σ2

=

n⋅σ 2

σ2

=

(n -1)⋅σ2

σ2

undz ~ χ2n-1.

Damit kann in Abhängigkeit von der Irrtumswahrscheinlichkeit 1. Art der entsprechende

Verwerfungsbereich für die jeweilige Nullhypothese bestimmt werden.

Für den 2. Unterfall (dieser wird behandelt, da er besonders einfach in Analogie zum

Konfidenzbereich behandelbar ist, vergl. oben Beispiel 16.1.14, bei dem in gleicher Weise

von der Parallelität der formalen Entwicklung Gebrauch gemacht ist) folgt nach Entnahme

der zugehörigen Tafelwerte aus der χ 2-Verteilung-Tabelle ein beidseitiges Intervall:

P[T u ≤ z ≤ T o ] = 1 - α, 0< α <1 bzw. mit

Tu⋅ σ 20

n⋅S 2

n⋅σ 2

Tu ≤

⇔ Tu ≤

⇔

≤σ 2

2

2

n

σ

σ

0

0

der durch folgende Ungleichungen beschriebene Annahmebereich:

Tο σ20

n⋅S 2

n⋅σ 2

2

≤ Tο ⇔

≤ Tο ⇔ σ ≤

n

σ2

σ2

0

0

22

(1)

P[û( σ 20 )

2

≤σ ≤

ô( σ 20 )]

= 1 - α, 0< α <1,

Tu⋅σ 20

2

û( σ 0 ):=

,

n

To⋅σ20

2

o( σ 0 ):=

n

D.h. der Fehler 2. Art wird der Einfachheit halber im Test vernachlässigt. Für die alternative Schreibweise mit σ 2 folgt der Annahmebereich:

Tu⋅σ 20

To⋅σ20

2

2

2

2

2

(2)

P[u(σ 0) ≤ σ ≤ o(σ 0)] = 1 - α, 0< α <1, u( σ 0 ):=

, o( σ 0 ):=

.

n-1

n-1

1

α1

0.5

Annahmebereich

α2

1 - α = 1 - (α1 + α2)

0

Ablehnungsbereich 1

5

10

15

Ablehnungsbereich 2

Zur Frage des kürzesten Intervalls sei auf die Ausführungen im Kapitel 16 hingewiesen.

Für die Unterfälle 1, 3 und 4 folgen entsprechend die einseitigen Annahmebereiche, in

denen die Tafelwerte T jeweils einen α-Bereich überdecken, während im beidseitigen

Intervall die Wahrscheinlichkeitssumme oberhalb von T o und unterhalb von T u den

Bereich α ausmachen.

Unterfall 1:

2

(1)'

P[σ 2 ≤ ô( σ 20)] = 1 - α, 0< α <1, ô(σ 20) =

T o σ0

n

2

(2)'

P[ σ 2 ≤ õ( σ 20)] = 1 - α, 0< α <1, õ(σ 20) =

T o σ0

n-1

23

Unterfall 3:

2

(1)"

P[ σ ≤ ô( σ 20)] = 1 - α, 0< α <1, ô(σ 20 ) =

(2)"

P[ σ 2 ≤ õ( σ 20)] = 1 - α, 0< α <1, õ(σ 20 ) =

To σ20

n

To σ20

n-1

1

0.5

1-α

Annahmebereich

0

5

α

10

15

Ablehnungsbereich

24

Unterfall 4:

(1)’’’

P[û(σ 20)

(2)’’’

P[u(σ 20 )

2

≤ σ ] = 1 - α, 0< α <1,

2

≤ σ ] = 1 - α, 0< α

û(σ 20)

=

<1, u(σ 20 )

To ⋅σ 20

n

=

To ⋅σ 20

n-1

1

0.5 α

1-α

Annahmebereich

0

Ablehnungsbereich

5

10

15

17.5.2 Varianz-Test

Zur Illustration sei das kleine obige Beispiel der Beobachtungen (1, 2, 3, 1) fortgesetzt.

Es soll getestet werden

H0: σ2 = 4 gegen H 1: σ2 ≠ 4 .

Mit σ 2 = 11/16 und mit n-1 = 4-1 = 3 Freiheitsgraden folgen für α = 0.05 und "symmetrischer" Zuordnung der "Schwänze" der Verteilung

û(σ 20) = 0.22 und û(σ 20) = 9.35 und damit P[0.22 ≤ σ 2 ≤ 9.35] = 0.95.

Deshalb kann H0 nicht verworfen werden.

17.6 Bemerkung (Tests auf Grundlage des Zentralen Grenzwertsatzes)

Mit Zutreffen der Voraussetzungen des Zentralen Grenzwertsatzes können wie in der

Theorie der Konfidenzintervalle auch hier Tests entsprechend den Beispielen 16.1.15 und

16.1.16 für Zufallsstichproben aus beliebig verteilten Zufallsvariablen konstruiert werden.

Die Überlegungen des Kapitels 16 übertragen sich entsprechend.

25

17.7 Tests für mehr als einen Parameter

Besteht die Aufgabe darin, daß zugleich mehr als ein Parameter getestet werden soll (z.B.

Mittelwert und Varianz der Normalverteilung), so kann man die oben entwickelten Tests

nicht nacheinander durchführen. Auch hier gilt, was bereits für die Konfidenzintervalle

gesagt worden ist (siehe oben Kapitel 16, Abschnitt 7).

17.8 Aufgaben

Aufgabe 17.8.1 (Ein Test für die Poisson- und die Exponentialverteilung)

a) Eine poissonverteilte Zufallsstichprobe der Länge n=5 habe die Realisierung

(3, 1, 0, 2, 0).

Bestimmen Sie mit der Irrtumswahrscheinlichkeit α einen Test für das

Hypothesenpaar H0: µ = 2 gegen H 1: µ = 1.

Bestimmen Sie den zugehörigen Fehler 2. Art.

(Hinweis: Benutzen Sie eine Tabelle der Poissonverteilung für ein bestimmtes α,

dann verallgemeinern Sie Ihre Vorgehensweise für ein beliebiges α.

b) Diskutieren Sie die Anwendbarkeit des Zentralen Grenzwertsatzes für die

Aufgabe (Eine Antwort: Ja oder Nein ist ohne Begründung und ohne

Beschreibung der Vorgehensweise nicht hinreichend!)

c) Wie bekannt, sind die Wartezeiten zwischen Poissonereignissen, also auch die

Zeiten zwischen dem jeweiligen Auftreten der Realisierungen aus Aufgabe a),

exponentialverteilt. Damit läßt sich die Aufgabe fortsetzen. Aber auch ohne

eine solche Fortsetzung läßt sich von vorneherein annehmen, eine zu

untersuchende Stichprobe sei exponentialverteilt. Für diese Stichprobe sei

(u.U. mit Hilfe einer geeigneten Approximation) ein Test für den Vergleich

der Hypothesen λ 0= 0.5 und λ 1 = 1.0 entwickelt.

Nehmen Sie an, Sie kennen das Stichprobenmittel X .

Lösung

a) X = 6/5 = 1.2; der Ablehnungsbereich ist links offen, d.h. X ≤ k, m.a.W. X muß "groß"

genug für eine Annahme sein (kK der kritische Wert, links von dem abgelehnt werden

muß). Die direkte Auswertung von

P[Ablehnung] = P[X ≤ k] =

k

Σ (pj|P(µ), µ = 2) = α

j=0

liefert (nach Vorgabe von α) den Wert k; dies gelingt hier nur approximativ:

k

0

1

2

3

4

5

6

α

0.1353

0.4060

0.6767

0.8571

0.9473

0.9834

0.9955

Für z.B. α = 0.05 ist k = 0. Einsetzen von k gibt dann den Fehler 2. Art β:

∞

Σ

P[X > k] =

(pj|P(µ), µ = 1)

j=k+1

k

0

1

2

3

4

β

0.6321

0.2642

0.0803

0.0190

0.0037

Damit ist der zugehörige Fehler 2. Art 0.6321. Mit X = 1.2 kann die Hypothese akzeptiert

werden.

26

Eine alternative Lösung zu a) berücksichtigt die Ganzzahligkeit der Poisson-Variablen, die

5

mit X verlorengeht: Falls X~ P(λ), dann Y = Σ X i, Y~ P(5λ), d.h. mit der Null-Hypothese

i=1

kann die P(10)-Verteilungstafel benutzt werden:

k

0

1

2

3

4

5

6

α

0.0000

0.0005

0.0028

0.0103

0.0293

0.0671

0.1301

Für α = 0.05 ist (wie oben) dann k = 4, und Einsetzen von k in die Alternativhypothese gibt

dann den Fehler 2. Art β:

∞

P[Y > k] =

Σ

(pj|P(µ), µ = 5)

j=k+1

k

0

1

2

3

4

5

β

0.9933

0.9596

0.8753

0.7350

0.5595

0.3840

Damit ist der zugehörige Fehler 2. Art 0.5595. Mit Y = 6 kann die Hypothese akzeptiert

werden. Im Vergleich zur Lösung mit X ist der Fehler 2. Art numerisch kleiner. In b) fällt

die Antwort aber anders aus.

b) Die Anwendung des Zentralen Grenzwertsatzes heißt, daß der Test mit der Normal(k- µ) ⋅ n

verteilungsapproximation P(X ≤ k) ≈ Φ(

) durchgeführt wird. Dafür ist eine

µ

hinreichend große Anzahl von Beobachtungen nötig. Falls das zutrifft, erhält man die

Entscheidungsregel: d ≠ H0 ⇔ X ≤ kritischer Wert k ⇒ Entscheidung für H1.

(k- µ0) ⋅ n

(k- µ0) ⋅ n

(k- 2) ⋅ n

) = α, z.B. α = 0.05 folgen

= - 1.645 =

µ0

µ0

2

Mit Einsetzen von n läßt sich dieses nach k auflösen,

T µ0

k = µ0 +

, T der Tafelwert; z.B. für n=49 folgt dann k = - 1.645. 2 / 7 + 2 ≈ 1.668.

n

Mit X = 1.2 kann die Hypothese nur abgelehnt werden.

Für Φ(

Für den zugehörigen Fehler 2. Art. folgt dann

(K - µ1) ⋅ n

β ≈ 1 - Φ(

) = 1 - Φ((1.668 - 1). 7) =1 - Φ(4.676) ≈ 0.

µ1

Die Frage, ob X auch Poisson-verteilt ist, ist unbeachtlich, da nur die Momente

σ2 µ

E(X )= µ und var(X ) =

= benutzt werden.

n n

NB.: Die Poisson-Verteilung ist die Verteilung, in der Mittelwert und Varianz übereinstimmen: E(X) = µ = var(X).

27

Aufgabe 17.8.2 (Ein Test für die Binomialverteilung)

Unser Wetter wird von vielen Faktoren wie z.B. Temperatur, Luftbewegungen, Luftdruck, Sonneneinstrahlung, Staubanteile in der Luft beeinflußt. Brauchbare länger-fristige

Modelle sind (leider) noch nicht bekannt. Die längerfristige Wettervorhersage scheint

(daher) ein Zufallsexperiment zu sein. Die Meteorologen behaupten, daß der Einsatz von

Beobachtungssatelliten ihre Vorhersagen gegenüber der früheren Trefferquote von 0.65

verbessert habe, so daß nunmehr mit einer Wahrscheinlichkeit von 0.75 eine Prognose

korrekt sei.

a) Es sei p die Wahrscheinlichkeit für eine richtige Vorhersage. Eine Stichprobe der

Länge 20 ergab 15 richtige Vorhersagen. Testen Sie damit

H0: p = 0.65 gegen H 1: p = 0.75 mit α = 0.05. Wie groß ist der Fehler 2. Art?

b) Angenommen, bei einer Stichprobe der Länge 40 seien 30 richtige Vorhersagen

beobachtet worden. Bestimmen Sie nun den Fehler 2. Art näherungsweise mit

Hilfe des zentralen Grenzwertsatzes.

c) Was ändert sich am Test, wenn die einfachen Hypothesen durch die folgenden

zusammengesetzten Hypothesen ersetzt werden?

*

*

H 0: p ≤ 0.65

gegen H 1: p ≥ 0.75

d) Warum darf man in Teil a) den zentralen Grenzwertsatz nicht anwenden?

Lösung

a) Unter H0, d.h. für die Hypothesen H0: p = 0.65 gegen H 1: p = 0.75, ist

20

∑ Xi ~ B(20, 0.65), d.h. jeweils X ~ B(1, p) mit p0 = 0.65 und p1 = 0.75.

i=1

n

Der Test dafür lautet: d ≠ H0 ⇔ ∑ Xi >k, wobei k die kritische Grenze ist.

i=1

α = 0.05 ≈ PH0(H0 wird abgelehnt) =PH0(

20

Σ

X i >k) ⇔ k = 16 (laut Tabelle). Die Werte für

n=1

n

Pp=0.65( ∑ X i > k) werden entsprechend dem Komplement [Y~B(20,0.65)~B(20,0.35)] aus der

i=1

Verteilungstabelle für p = 0.35 abgelesen, und zwar gemäß

p = 0.65

0

1

2

3

…

18

19

20

p = 0.35

20

19

18

17

…

2

1

0

k

15(~ 4)

16(~ 3)

17(~ 2)

18(~ 1)

19(~ 0)

α

0.1182

0.0444

0.0121

0.0021

0.0 02

Als Test erhalten wir damit die Entscheidungsregel:

n

20

i=1

i=1

d ≠ H0 ⇔ ∑ Xi >16 . Da für die vorliegenden Beobachtungen Y= ∑ Xi = 15 ist, gilt H0.

Der Fehler 2. Art wird entsprechend bestimmt:

28

p = 0.75

0

1

2

3

…

18

19

20

p = 0.25

20

19

18

17

…

2

1

0

K

15(~ 4)

16(~ 3)

17(~ 2)

18(~ 1)

19(~ 0)

α

0.4148

0.2253

0.0913

0.0243

0.032

PH (Σ X i ≤ K ) = 1 -0.2252= 0.7748 gemäß Tabelle, und damit ist der Fehler der 2. Art, also

1

i

die Entscheidung für H0, falls H1 richtig ist, das Komplement:

20

PH (H0 wird angenommen) = P5( ∑ X> 16)

1

i=1

|p=0.75 = 0.2252

Die genaue Berechnung macht von der speziellen Tabellierung Gebrauch:

20

n

1 - P( ∑ Xi >k)

i=1

k

Σ

p=0.75 = P( Σ X i ≤ k)| H 1 = 0.7748

|

i=1

n–k–1

(pj|B(n,p))=

j=0

Σ

j=0

16

(p j|B(n, 1–p)) =

Σ

j=0

3

(pj|B(20, 0.75)) =

Σ (pj|B(20, 0.25)) =0.2252

j=0

b) Eine Anwendung des zentralen Grenzwertsatzes und der Normal-Approximation

X - p0

PH0

n ≤ z0 = 0.95 ⇒ z0 = 1.645

p 0 (1 - p0)

X - p0

0.65 . 0.35

⇒

n ≤ 1.645 ⇔ X ≤ 1.645 .

+ 0.65 = 0.7741

p 0 (1 - p 0)

40

Da n= 40 und Σ Xi = 30 folgt X = 0.75 ≤ 0.7741 und damit d = H0.

i

Der Fehler 2. Art folgt: PH ( ∑ X i< k ) = PH X<0.7741

1

1

X -p 1

0.7741- 0.75

PH

n<

40 = Φ(0.352) =0.6368

1 p1 (1- p1)

0.75 . 0.25

c) Die Fehlergrößen 1. und 2. Art sind nun folgendermaßen definiert:

α H * = max {Pp(d ≠ H0): p unter H0}, Fehler 1. Art,

β H * = max {Pp(d ≠ H0): p unter H1}, Fehler 2. Art.

Allerdings kann man zeigen α H * = α H bzw. β H* = β H . An der Entscheidungsregel

ändert sich nichts.

d) Eine Anwendung des ZGWS entfällt, weil der Stichprobenumfang zu klein ist.

Anmerkung: Die Aufgabe läßt sich leicht ändern: Man wähle in b) andere Werte, z.B. statt

40 und 30 z.B. 60 und 45.

29

Aufgabe 17.8.3 (Ein Einstichproben-Mittelwerttest und ein Varianztest

bei unbekannter Varianz)

In industriellen Großanlagen eines bestimmten Typs werden im sicherheitsrelevanten

Bereich Haltebolzen benötigt, die einem hohen Verschleiß ausgesetzt sind. Da die

Überprüfung dieser Bolzen sehr aufwendig ist, werden vorsorglich mehr eingebaut als

eigentlich erforderlich wären. Um die Anzahl der einzubauenden Bolzen abschätzen zu

können, interessiert man sich für deren mittlere Lebensdauer unter realistischen

Belastungen. Eine entsprechende Stichprobe ergab folgende Lebensdauern (in vollendeten

Monaten): 38 41 37 36 42 40 35 40 43 38

Die Lebensdauer dieser Bolzen kann als normalverteilt mit Erwartungswert µ und Varianz

σ2 angenommen werden.

a) Testen Sie die zur Fehlerwahrscheinlichkeit 1. Art α = 0.1 die Hypothese

H0: µ ≥ 40 gegen H1: µ < 40

b) Testen Sie zur Fehlerwahrscheinlichkeit 1. Art α = 0.05 die Hypothese

H0: σ2 ≤ 6 gegen H1: σ2 > 6.

Lösung

a) n= 10, x = 39, s2 = 6.2, s*2 = 6.8

x - µ0

Entscheidungsregel: d ≠ H0 ⇔

n < tα;n-1 (ein einseitiger Test, links offen)

s*

x - µ0

39 - 40

n =

10 = - 1.2048, t0.1;9 = -1.383 ∴ d = H0

s*

2.6247

b) Entscheidungsregel: d ≠ H0 ⇔

⇔

s *2(n-1)

σ 20

=

s *2(n-1)

σ 20

2

> χ1–

α; n – 1 (ein einseitiger Test, rechts offen)

2

6.8 . 9

≈ 10.2 < 16.9 = χ 0.95; 9 ∴ d = H0.

6

30

Aufgabe 17.8.4 (Ein Zweistichproben-Mittelwerttest bei unbekannter Varianz)

Die voneinander unabhängigen Benzinverbräuche X und Y zweier Wagen sollen an-hand

unabhängiger Stichproben der Länge nX = nY = 10 verglichen werden. Dabei wer-den die

Verbräuche jeweils als normalverteilt mit unbekanntem Erwartungswert µX bzw. µY und

unbekannten, aber gleichen Varianzen σX2 = σ2 = σY2 betrachtet.

Die Stichprobenergebnisse lauten:

Σ x i 68 Σ (x – x)2 6

i

i

Σ yi

i

i

70

Σ (yi – y)2

4

i

Zum Signifikanzniveau α = 0.05 soll folgende Hypothese getestet werden:

H0: "µX ist mindestens so groß wie µY" gegen die Alternative H1: "nicht H0"

Lösung :

Die Hypothese ist formal: H 0: "µX ≥ µY" gegen die Alternative H1: "µX < µY".

Da σ2 unbekannt ist, folgt ein t-Test für den Mittelwert (Test auf Gleichheit, s.o.) .

Aus den Daten ergeben sich mit n = nX = nY = 10, x = 6.8, y = 7.0,

σ 2X = 6/9 = 2/3 ≈ 0.67, σ X =

0.67 ≈ 0.82; σ 2Y = 4/9 ≈ 0.44, σ Y = 2/3 ≈ 0.67

M.a.W. die anzuwendende Statistik ist die Größe z:= X - Y . Sie wird standardisiert und für

z soll gelten: H0: z ≥ 0 gegenüber H1: z < 0.

Die Testregel ist dann: H0 ist zu verwerfen, wenn die Testgröße T,

X - Y - (µX - µ Y)

T=

nX + nY - 2 , die für n ≥ 2 und n ≥ 2

X

Y

1 + 1 (n - 1)s * 2 +(n - 1)s* 2

X

X

Y

Y

n X nY

t-verteilt mit nX + nY - 2 = 18 Freiheitsgraden ist,

im folgenden kritischen offenen Intervall liegt:

(-∞, tα;nX+nY-2), d.h. unterhalb tα;nX+nY-2 = t0.05;18 = -1.73

Die entsprechende Realisierung von T ist:

6.8 - 7.0

T=

18 = - 0.6; damit kann H0 nicht abgelehnt werden.

2

4

0.2 9 ⋅ + 9 ⋅

3

9