Handouts09 - Fakultät Statistik (TU Dortmund)

Werbung

Bedingte Wahrscheinlichkeiten und

stochastische Unabhängigkeit

Stochastische Unabhängigkeit von Ereignissen

Beispiel: das Ziegenproblem

Gewinnspiel:

Hinter einer von drei Türen ist ein Preis, hinter den anderen beiden eine Ziege

1. Kandidat muss sich für eine Tür entscheiden

2. Moderator deckt zufällig eine der anderen Türen mit einer Ziege auf

3. Kandidat kann bei seiner Entscheidung bleiben oder die Tür wechseln

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

1

Bedingte Wahrscheinlichkeiten und

stochastische Unabhängigkeit

Stochastische Unabhängigkeit von Ereignissen

Beispiel: das Ziegenproblem

A: Kandidat gewinnt

B: Kandidat entscheidet sich um

Frage: P(A|B) = P(A|BC)?

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

2

Bedingte Wahrscheinlichkeiten und

stochastische Unabhängigkeit

Stochastische Unabhängigkeit von Ereignissen

Beispiel: das Ziegenproblem

A: Kandidat gewinnt

B: Kandidat entscheidet sich um

1,2,3

1

Kandidat wählt:

1/3

Preis ist in Tür:

Moderator deckt auf:

1-P(B)

Kandidat wählt

endgültig:

1

1

1/3

1/3

2

1/2

1/2

2

3

P(B)

1

1-P(B)

1

1

3

P(B)

3

1-P(B)

1

1

3

2

P(B)

2

1-P(B)

1

P(B)

3

2

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

3

Bedingte Wahrscheinlichkeiten und

stochastische Unabhängigkeit

Stochastische Unabhängigkeit von Ereignissen

Beispiel: das Ziegenproblem

A: Kandidat gewinnt

B: Kandidat entscheidet sich um

1,2,3

Kandidat gewinnt

1

Kandidat wählt:

1/3

Preis ist in Tür:

Moderator deckt auf:

1-P(B)

Kandidat wählt

endgültig:

1

1

1/3

1/3

2

1/2

1/2

2

3

P(B)

1

1-P(B)

1

1

3

P(B)

3

1-P(B)

1

1

3

2

P(B)

2

1-P(B)

1

P(B)

3

2

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

4

Bedingte Wahrscheinlichkeiten und

stochastische Unabhängigkeit

Stochastische Unabhängigkeit von Ereignissen

Beispiel: das Ziegenproblem

A: Kandidat gewinnt

B: Kandidat entscheidet sich um

1,2,3

Kandidat gewinnt

1

Kandidat wählt:

1/3

Preis ist in Tür:

Moderator deckt auf:

1-P(B)

Kandidat wählt

endgültig:

1

1

1/3

1/3

2

1/2

1/2

2

3

P(B)

1 1

1-P(B)

1

3

P(B)

1-P(B)

1

+

3

1

3

1

P( A ) = 3 ⋅ 2 ⋅ [1 − P(B)]

1

2

P(B)

2

1-P(B)

1

P(B)

3

2

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

+

1 1

⋅ ⋅ [1 − P(B)]

3 2

1

1

⋅ 1 ⋅ P(B) + ⋅ 1 ⋅ P(B)

3

3

2

2

= ⋅ [1 − P(B)] + ⋅ P(B)

6

3

=

1 P( B )

+

3

3

5

Bedingte Wahrscheinlichkeiten und

stochastische Unabhängigkeit

Stochastische Unabhängigkeit von Ereignissen

Beispiel: das Ziegenproblem

A: Kandidat gewinnt

B: Kandidat entscheidet sich um

1,2,3

P(A) =

1

Kandidat wählt:

1/3

Preis ist in Tür:

1

Kandidat wählt

endgültig:

1

1/3

1

1/2

1/2

2

3

1

3

1

1

3

1

1

Kandidat bleibt

bei 1. Wahl und

gewinnt

1/3

2

2

1

1

1 P( B )

+

3

3

P(B) = 0

⇒ P( A| BC ) =

1 0 1

+ =

3 3 3

1

1

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

6

Bedingte Wahrscheinlichkeiten und

stochastische Unabhängigkeit

Stochastische Unabhängigkeit von Ereignissen

Beispiel: das Ziegenproblem

A: Kandidat gewinnt

B: Kandidat entscheidet sich um

1,2,3

P(A) =

1

Kandidat wählt:

1/3

Preis ist in Tür:

1

Kandidat wählt

endgültig:

1/3

1/2

2

3

3

3

3

P(B) = 1

1

1

1

Kandidat

entscheidet sich um

und gewinnt

1/3

2

1/2

1

1

2

1

2

1 P( B )

+

3

3

1

⇒ P( A| B ) =

1 1 2

+ =

3 3 3

3

2

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

>

1

= P( A| BC )

3

7

Bedingte Wahrscheinlichkeiten und

stochastische Unabhängigkeit

Stochastische Unabhängigkeit von Zufallsvariablen

Seien X und Y Zufallsvariablen mit Verteilungsfunktionen FX, FY und F(X,Y). Dann

heißen X und Y stochastisch unabhängig, falls

F(X,Y) (x, y) = FX (x) ⋅ F Y (y) für alle x, y ∈ ℜ.

Die Zufallsvariablen X1,…,Xn heißen stochastisch unabhängig, falls

n

F

(X1 ,...,X n )

(x 1 ,..., x n ) = ∏ FXi (x i ) für alle x 1 ,..., x n ∈ ℜ.

i=1

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

8

Bedingte Wahrscheinlichkeiten und

stochastische Unabhängigkeit

Stochastische Unabhängigkeit von Zufallsvariablen

Seien X und Y Zufallsvariablen mit Verteilungsfunktionen FX, FY und F(X,Y). Dann

heißen X und Y stochastisch unabhängig, falls

F(X,Y) (x, y) = FX (x) ⋅ F Y (y) für alle x, y ∈ ℜ.

⇒ F(X,Y) (x, y) = P(A ∩ B) = P(A) ⋅ P(B) = FX (x) ⋅ F Y (y)

mit A = {ω ∈ Ω | X(ω ) ≤ x} , B = {ω ∈ Ω | Y(ω ) ≤ y}

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

9

Bedingte Wahrscheinlichkeiten und

stochastische Unabhängigkeit

Stochastische Unabhängigkeit von Zufallsvariablen

Seien X und Y Zufallsvariablen mit Verteilungsfunktionen FX, FY und F(X,Y). Dann

heißen X und Y stochastisch unabhängig, falls

F(X,Y) (x, y) = FX (x) ⋅ F Y (y) für alle x, y ∈ ℜ.

F(X,Y) diskret

⇒ p(x, y) = P(A ∩ B) = F(X,Y) (x i , y j ) − F(X,Y) (x i−1 , y j ) − F(X,Y) (x i , y j−1 ) + F(X,Y) (x i−1 , y j−1 )

= FX (x i )FY (y j ) − FX (x i−1 )FY (y j ) − FX (x i )FY (y j−1 ) + FX (x i−1 )FY (y j−1 )

[

][

]

= FX (x i ) − FX (x i−1 ) ⋅ FY (y i ) − FY (y i−1 ) = p(x) ⋅ p(y)

mit A = {ω ∈ Ω | X(ω ) = x i } , B = {ω ∈ Ω | Y(ω ) = y j }

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

10

Bedingte Wahrscheinlichkeiten und

stochastische Unabhängigkeit

Stochastische Unabhängigkeit von Zufallsvariablen

Seien X und Y Zufallsvariablen mit Verteilungsfunktionen FX, FY und F(X,Y). Dann

heißen X und Y stochastisch unabhängig, falls

F(X,Y) (x, y) = FX (x) ⋅ F Y (y) für alle x, y ∈ ℜ.

F(X,Y) stetig

⇒ f

(X,Y)

∂F(X,Y) (x, y) ∂[F X (x) ⋅ F Y (y)] ∂FX (x) ⋅ ∂F Y (y) X

(x, y) =

=

=

= f (x) ⋅ f Y (y)

∂x∂y

∂x∂y

∂x∂y

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

11

Bedingte Wahrscheinlichkeiten und

stochastische Unabhängigkeit

Stochastische Unabhängigkeit von Zufallsvariablen

Beispiel: Multinomialverteilung

(X,Y) ~ Mult(2, 0.5, 0.5)

⇒ p XY (0,2) =

2

2 1

1

⋅ 0.52 =

⋅ =

0!⋅2!

1⋅2 4

4

p XY (1,1) =

2

2 1

1

⋅ 0.52 =

⋅ =

1!⋅1!

1 ⋅1 4

2

p XY (2,0) =

2

2 1

1

⋅ 0.52 =

⋅ =

2!⋅0!

2 ⋅1 4

4

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

12

Bedingte Wahrscheinlichkeiten und

stochastische Unabhängigkeit

Stochastische Unabhängigkeit von Zufallsvariablen

Beispiel: Multinomialverteilung

(X,Y) ~ Mult(2, 0.5, 0.5)

p XY (0,2) =

1

4

p X (0) = p Y (0) =

1

4

p X (0) ⋅ p Y (2) =

1 1 1

1

⋅ =

≠ = p XY (0,2)

4 4 16 4

p XY (1,1) =

1

2

p X (1) = p Y (1) =

1

2

1 1 1 1

p X (1) ⋅ p Y (1) = ⋅ = ≠ = p XY (1,1)

2 2 4 2

p XY (2,0) =

1

4

p X (2) = p Y (2) =

1

4

p X (2) ⋅ p Y (0) =

1 1 1

1

⋅ =

≠ = p XY (2,0)

4 4 16 4

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

13

Bedingte Wahrscheinlichkeiten und

stochastische Unabhängigkeit

Stochastische Unabhängigkeit von Zufallsvariablen

Beispiel: Multinomialverteilung

(X,Y) ~ Mult(2, 0.5, 0.5)

p XY (0,2) =

1

4

p X (0) = p Y (0) =

1

4

p X (0) ⋅ p Y (2) =

1 1 1

1

⋅ =

≠ = p XY (0,2)

4 4 16 4

p XY (1,1) =

1

2

p X (1) = p Y (1) =

1

2

1 1 1 1

p X (1) ⋅ p Y (1) = ⋅ = ≠ = p XY (1,1)

2 2 4 2

p XY (2,0) =

1

4

p X (2) = p Y (2) =

1

4

p X (2) ⋅ p Y (0) =

1 1 1

1

⋅ =

≠ = p XY (2,0)

4 4 16 4

⇒ X und Y sind stochastisch abhängig

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

14

Erwartungswert und Varianz

Zuletzt: Abbildung von Ereignissen auf reelle Zahlen durch Zufallsvariablen und

mathematische Formulierung ihrer Wahrscheinlichkeiten durch Verteilungsfunktionen

X : Ω→ℜ

ω a X(ω )

FX ∈ F

FX : ℜ → [0,1]

x a FX (x )

Jetzt: Charakterisierung der Verteilungen durch einzelne Parameter

θ: F →ℜ

FX a θ(FX )

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

15

Erwartungswert und Varianz

Erinnerung

Betrachtung der Population Ω={e1,…,eN} mit quantitativem

Datensatz y={y1,…,yN} , y∈{x‘1,…,x‘J}=:TX

⇒ Falls P ein Wahrscheinlichkeitsmaß ist mit P({ei})=1/N, i=1,…,N, so sind die

Werte FX(x) der theoretischen Verteilungsfunktion der

Zufallsvariable X mit X({e})=y(e) für alle x ∈TX identisch mit denen der empirischen

Verteilungsfunktion FN(x) von y.

Entsprechend sind relative Häufigkeitsverteilung fj von y und Zähldichte p(x‘j) von X

für alle j=1,…,J numerisch identisch.

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

16

Erwartungswert und Varianz

Erinnerung

Ω={e1,…,eN}

X({e})=y(e)

⇒

y={y1,…,yN}

TX={x‘1,…,x‘J}

FN (x)= FX(x), x∈ℜ

P({ei})=1/N , i=1,…,N

fj=p(x‘j) , j=1,…,J

J

1 N

Für das arithmetische Mittel von y gilt: y = ∑ y i = ∑ fj ⋅ x' j

N i=1

j=1

J

J

1 N

Der Wert E(X) : = y = ∑ y i = ∑ fj ⋅ x' j = ∑ p(x' j ) ⋅ x' j

N i=1

j=1

j=1

charakterisiert unter den obigen Voraussetzungen also die Lage der Verteilung FX.

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

17

Erwartungswert und Varianz

Diskrete Wahrscheinlichkeitsverteilungen

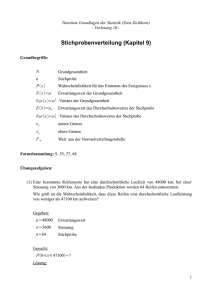

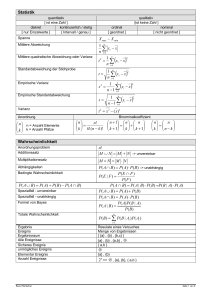

Der Erwartungswert einer diskret verteilten Zufallsvariable X mit Zähldichte p(x) und

Träger TX={x1,x2,…} ist definiert durch

E(X) =

J

∑ p(x ) ⋅ x

j

j

, J ∈ ℵ ∪ {∞}.

j=1

Die Varianz von X ist definiert durch

(

)

J

var(X) = E [X − E(X)] = ∑ p(x j ) ⋅ [x j − E(X)]2 , J ∈ ℵ ∪ {∞}.

2

j=1

Die Standardabweichung von X ist definiert durch

var(X) .

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

18

Erwartungswert und Varianz

Diskrete Wahrscheinlichkeitsverteilungen

Ist h : ℜ → ℜ eine Funktion, so gilt für den Erwartungswert der transformierten

Zufallsvar iable h(X) :

E[h(X)] =

J

∑ h(x ) ⋅ p(x ) ,

j

j

J ∈ ℵ ∪ {∞}.

j=1

Für h : x a x ergibt sich für E[h(X)] damit der Erwartungswert von X und

für h : x a [x − E(X)]2 die Varianz von X.

Der Wert, der sich für h : x a x k ergibt, wird k - tes Moment von X genannt :

mk (X) = E(X ) =

k

J

∑x

k

j

⋅ p(x j ) , J ∈ ℵ ∪ {∞}.

j=1

Das k - te Moment der um den Erwartungswert zentrierten Zufallsvariable

X − E(X) heißt k - tes zentrales Moment :

(

) ∑ [x

μ k (X) = E [X − E(X)] =

k

J

j

− E(X)]k ⋅ p(x j ) , J ∈ ℵ ∪ {∞}.

j=1

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

19

Erwartungswert und Varianz

Stetige Wahrscheinlichkeitsverteilungen

Approximation stetiger Dichtefunktion von X durch Zähldichte diskretisierter Zufallsvariable

X ⋅ d /d + (X ⋅ d + 1)/d

X (d) :=

2

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

20

Erwartungswert und Varianz

Stetige Wahrscheinlichkeitsverteilungen

Approximation stetiger Dichtefunktion von X durch Zähldichte diskretisierter Zufallsvariable

X ⋅ d /d + (X ⋅ d + 1)/d

X (d) :=

2

p(i+ 0.5)/d = P(X (d) = (i + 0.5)/d ) =

(i+1)/d

∫ f(t)dt

, i∈ Z

i/d

1

= f(X (d) ) ⋅

+

d

(i+1)/d

∫ [f(t) − f(X

(d)

)]dt

i/d

1442443

d > d0;i ⇒ ... ≤ ([i + 1]/d) − i/d) ⋅ [f([i + 1]/d) − f(i/d)]

i/d

(i+1)/d

=

[f([i + 1]/d) − f(i/d)]

→∞

d

→ 0

d

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

21

Erwartungswert und Varianz

Stetige Wahrscheinlichkeitsverteilungen

Approximation stetiger Dichtefunktion von X durch Zähldichte diskretisierter Zufallsvariable

X ⋅ d /d + (X ⋅ d + 1)/d

X (d) :=

2

f(X (d) ) (i+1)/d

p(i+ 0.5)/d =

+ ∫ [f(t) − f(X (d) )]dt ,

d

i/d

i∈ Z

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

22

Erwartungswert und Varianz

Stetige Wahrscheinlichkeitsverteilungen

Approximation stetiger Dichtefunktion von X durch Zähldichte diskretisierter Zufallsvariable

X ⋅ d /d + (X ⋅ d + 1)/d

X (d) :=

2

f(X (d) ) (i+1)/d

p(i+ 0.5)/d =

+ ∫ [f(t) − f(X (d) )]dt ,

d

i/d

i∈ Z

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

23

Erwartungswert und Varianz

Stetige Wahrscheinlichkeitsverteilungen

Approximation stetiger Dichtefunktion von X durch Zähldichte diskretisierter Zufallsvariable

X ⋅ d /d + (X ⋅ d + 1)/d

X (d) :=

2

f(X (d) ) (i+1)/d

p(i+ 0.5)/d =

+ ∫ [f(t) − f(X (d) )]dt ,

d

i/d

i∈ Z

E(X(d) ) = ∑ [(i + 0.5)/d] ⋅ p(i+ 0.5)/d

i∈Z

(i + 0.5) f((i + 0.5)/d)

(i + 0.5)

=∑

⋅

+∑

⋅

d

d

d

i∈Z

i∈Z

d→∞ , s: =(i+ 0.5)/d

(i+1)/d

∫ [f(t) − f((i + 0.5)/d)]dt

i/d

∞

→ ∫ s ⋅ f(s)ds =: E(X)

−∞

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

24

Erwartungswert und Varianz

Stetige Wahrscheinlichkeitsverteilungen

Der Erwartungswert einer stetig verteilten Zufallsvariable X mit Dichtefunktion f ist

definiert durch

∞

∫ t ⋅ f(t)dt .

E(X) =

−∞

Die Varianz von X ist definiert durch

var(X) = E([X - E(X)] ) =

2

∞

2

[t

−

E(X)]

⋅ f(t)dt .

∫

−∞

Die Standardabweichung von X ist definiert durch

var(X) .

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

25

Erwartungswert und Varianz

Eigenschaften von Erwartungswerten

Falls die folgenden Erwartungswerte von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(1) E(X + Y) = E(X) + E(Y)

n

n

(3) E ∑ aiX i + b = ∑ aiE(Xi ) + b , a1 ,..., an , b ∈ ℜ

i=1

i=1

(2) E(aX + b) = aE(X) + b , a, b ∈ ℜ

(4) X und Y st.u. ⇒ E(XY) = E(X) ⋅ E(Y)

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

26

Erwartungswert und Varianz

Eigenschaften von Erwartungswerten

Falls die folgenden Erwartungswerte von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(1) E(X + Y) = E(X) + E(Y)

n

n

(3) E ∑ aiX i + b = ∑ aiE(Xi ) + b , a1 ,..., an , b ∈ ℜ

i=1

i=1

(2) E(aX + b) = aE(X) + b , a, b ∈ ℜ

(4) X und Y st.u. ⇒ E(XY) = E(X) ⋅ E(Y)

Beweis : E(X + Y) =

∑ [x + y] ⋅ P(X + Y = x + y) = ∑ [X(ω ) + Y(ω )] ⋅ P({ω })

(x + y)∈TX + Y

ω∈Ω

= ∑ X(ω ) ⋅ P({ω }) + ∑ Y(ω ) ⋅ P({ω }) = ∑ x ⋅ P(X = x) + ∑ y ⋅ P(Y = y) = E(X) + E(Y)

ω∈Ω

ω∈Ω

x∈TX

y∈TY

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

27

Erwartungswert und Varianz

Eigenschaften von Erwartungswerten

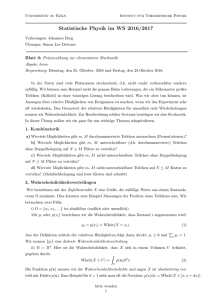

E(X+Y) = E(X)+E(Y) gilt auch, wenn X und Y nicht stochastisch unabhängig sind!

Beispiel Lotterie

Unter n Losen sei ein Los mit Gewinn xg, der Rest Nieten. Ein Spieler kauft k Lose.

Dann ist es für den erwarteten Gewinn unerheblich, ob mit oder ohne Zurücklegen gezogen wird.

Ohne Zurücklegen

k=1

Mit Zurücklegen

Gewinnverteilung

Gewinnverteilung

Erwarteter Gewinn

Erwarteter Gewinn

xg

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

xg

28

Erwartungswert und Varianz

Eigenschaften von Erwartungswerten

E(X+Y) = E(X)+E(Y) gilt auch, wenn X und Y nicht stochastisch unabhängig sind!

Beispiel Lotterie

Unter n Losen sei ein Los mit Gewinn xg, der Rest Nieten. Ein Spieler kauft k Lose.

Dann ist es für den erwarteten Gewinn unerheblich, ob mit oder ohne Zurücklegen gezogen wird.

Ohne Zurücklegen

k=2

Mit Zurücklegen

Gewinnverteilung

Gewinnverteilung

Erwarteter Gewinn

Erwarteter Gewinn

xg

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

xg

29

Erwartungswert und Varianz

Eigenschaften von Erwartungswerten

E(X+Y) = E(X)+E(Y) gilt auch, wenn X und Y nicht stochastisch unabhängig sind!

Beispiel Lotterie

Unter n Losen sei ein Los mit Gewinn xg, der Rest Nieten. Ein Spieler kauft k Lose.

Dann ist es für den erwarteten Gewinn unerheblich, ob mit oder ohne Zurücklegen gezogen wird.

Ohne Zurücklegen

k=3

Mit Zurücklegen

Gewinnverteilung

Gewinnverteilung

Erwarteter Gewinn

Erwarteter Gewinn

xg

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

xg

30

Erwartungswert und Varianz

Eigenschaften von Erwartungswerten

E(X+Y) = E(X)+E(Y) gilt auch, wenn X und Y nicht stochastisch unabhängig sind!

Beispiel Lotterie

Unter n Losen sei ein Los mit Gewinn xg, der Rest Nieten. Ein Spieler kauft k Lose.

Dann ist es für den erwarteten Gewinn unerheblich, ob mit oder ohne Zurücklegen gezogen wird.

Ohne Zurücklegen

k=4

Mit Zurücklegen

Gewinnverteilung

Gewinnverteilung

Erwarteter Gewinn

Erwarteter Gewinn

xg

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

xg

31

Erwartungswert und Varianz

Eigenschaften von Erwartungswerten

E(X+Y) = E(X)+E(Y) gilt auch, wenn X und Y nicht stochastisch unabhängig sind!

Beispiel Lotterie

Unter n Losen sei ein Los mit Gewinn xg, der Rest Nieten. Ein Spieler kauft k Lose.

Dann ist es für den erwarteten Gewinn unerheblich, ob mit oder ohne Zurücklegen gezogen wird.

Ohne Zurücklegen

k=n

Mit Zurücklegen

Gewinnverteilung

Gewinnverteilung

Erwarteter Gewinn

Erwarteter Gewinn

xg

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

xg

32

Erwartungswert und Varianz

Eigenschaften von Erwartungswerten

Falls die folgenden Erwartungswerte von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(1) E(X + Y) = E(X) + E(Y)

n

n

(3) E ∑ aiX i + b = ∑ aiE(Xi ) + b , a1 ,..., an , b ∈ ℜ

i=1

i=1

(2) E(aX + b) = aE(X) + b , a, b ∈ ℜ

(4) X und Y st.u. ⇒ E(XY) = E(X) ⋅ E(Y)

Beweis : E(aX + b) =

∞

∞

∞

−∞

−∞

−∞

∫ (at + b) ⋅ f(t)dt = ∫ at ⋅ f(t)dt + ∫ b ⋅ f(t)dt

∞

∞

−∞

−∞

= a ⋅ ∫ t ⋅ f(t)dt + b ⋅ ∫ f(t)dt = a ⋅ E(X) + b ⋅ 1 = aE(X) + b

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

33

Erwartungswert und Varianz

Eigenschaften von Erwartungswerten

E(aX + b) = aE(X) + b , a, b ∈ ℜ

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

E(X)

34

Erwartungswert und Varianz

Eigenschaften von Erwartungswerten

E(aX + b) = aE(X) + b , a, b ∈ ℜ

E(aX) = aE(X)

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

35

Erwartungswert und Varianz

Eigenschaften von Erwartungswerten

E(aX + b) = aE(X) + b , a, b ∈ ℜ

E(aX+b) = aE(X)+b

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

36

Erwartungswert und Varianz

Eigenschaften von Erwartungswerten

Falls die folgenden Erwartungswerte von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(1) E(X + Y) = E(X) + E(Y)

n

n

(3) E ∑ aiX i + b = ∑ aiE(Xi ) + b , a1 ,..., an , b ∈ ℜ

i=1

i=1

(2) E(aX + b) = aE(X) + b , a, b ∈ ℜ

(4) X und Y st.u. ⇒ E(XY) = E(X) ⋅ E(Y)

n

n

Beweis : E ∑ aiX i + b = E ∑ aiX i + b =

(1)

i=1

(2) i=1

n

∑ E(a X ) + b

i i

i=1

=

(2)

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

n

∑ a E(X ) + b

i

i

i=1

37

Erwartungswert und Varianz

Eigenschaften von Erwartungswerten

Falls die folgenden Erwartungswerte von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(1) E(X + Y) = E(X) + E(Y)

n

n

(3) E ∑ aiX i + b = ∑ aiE(Xi ) + b , a1 ,..., an , b ∈ ℜ

i=1

i=1

(2) E(aX + b) = aE(X) + b , a, b ∈ ℜ

(4) X und Y st.u. ⇒ E(XY) = E(X) ⋅ E(Y)

Beweis : X und Y st.u. ⇒ fXY (x, y) = fX (x) ⋅ fY (y)

⇒ E(XY) =

∞ ∞

∫ ∫u⋅ v ⋅ f

XY

− ∞− ∞

(u, v) du dv =

∞

∞ ∞

∫ ∫ u ⋅ v ⋅ f (u) ⋅ f (v) du dv

X

− ∞− ∞

Y

∞

= ∫ u ⋅ fX (u)du ∫ v ⋅ fY (v) ⋅ dv = E(X) ⋅ E(Y)

−∞

−∞

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

38

Erwartungswert und Varianz

Eigenschaften von Varianzen

Falls die folgenden Varianzen von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(A) var(X) ≥ 0

(D) X und Y st.u. ⇒ var(X + Y) = var(X) + var(Y)

(B) var(X) = 0 ⇔ X ~ εa , a ∈ ℜ

(E) X 1 ,..., X n st.u. , a1 ,..., an ∈ ℜ

n

n 2

⇒ var ∑ aiX i + b = ∑ ai var(X i )

i=1

i=1

(C) var(aX + b) = a2 var(X)

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

39

Erwartungswert und Varianz

Eigenschaften von Varianzen

Falls die folgenden Varianzen von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(A) var(X) ≥ 0

(D) X und Y st.u. ⇒ var(X + Y) = var(X) + var(Y)

(B) var(X) = 0 ⇔ X ~ εa , a ∈ ℜ

(E) X 1 ,..., X n st.u. , a1 ,..., an ∈ ℜ

n

n 2

⇒ var ∑ aiX i + b = ∑ ai var(X i )

i=1

i=1

(C) var(aX + b) = a2 var(X)

a2 − a2

Beweis " ⇐": X ~ εa ⇒ var(X) = ∫ t ⋅ 1 ⋅ dt =

=0

2

a

a

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

40

Erwartungswert und Varianz

Eigenschaften von Varianzen

Falls die folgenden Varianzen von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(A) var(X) ≥ 0

(D) X und Y st.u. ⇒ var(X + Y) = var(X) + var(Y)

(B) var(X) = 0 ⇔ X ~ εa , a ∈ ℜ

(E) X 1 ,..., X n st.u. , a1 ,..., an ∈ ℜ

n

n 2

⇒ var ∑ aiX i + b = ∑ ai var(X i )

i=1

i=1

(C) var(aX + b) = a2 var(X)

Beweis " ⇒": var(X) = 0 ⇔

∞

2

[t

−

E(X)]

⋅ f(t)dt = 0

∫

−∞

⇒ für alle t ∈ ℜ : [t − E(X)]2 = 0 oder f(t) = 0

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

41

Erwartungswert und Varianz

Eigenschaften von Varianzen

Falls die folgenden Varianzen von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(A) var(X) ≥ 0

(D) X und Y st.u. ⇒ var(X + Y) = var(X) + var(Y)

(B) var(X) = 0 ⇔ X ~ εa , a ∈ ℜ

(E) X 1 ,..., X n st.u. , a1 ,..., an ∈ ℜ

n

n 2

⇒ var ∑ aiX i + b = ∑ ai var(X i )

i=1

i=1

(C) var(aX + b) = a2 var(X)

Beweis " ⇒": var(X) = 0 ⇒ für alle t ∈ ℜ : [t − E(X)]2 = 0 oder f(t) = 0

[t − E(X)]2 = 0 ⇔ t = E(X) ⇒ für alle t ≠ E(X) muss gelten : f(t) = 0 ∞ ⇒ f[E(X)] = 1

∫ f(t)dt=1

−∞

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

42

Erwartungswert und Varianz

Eigenschaften von Varianzen

Falls die folgenden Varianzen von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(A) var(X) ≥ 0

(D) X und Y st.u. ⇒ var(X + Y) = var(X) + var(Y)

(B) var(X) = 0 ⇔ X ~ εa , a ∈ ℜ

(E) X 1 ,..., X n st.u. , a1 ,..., an ∈ ℜ

n

n 2

⇒ var ∑ aiX i + b = ∑ ai var(X i )

i=1

i=1

(C) var(aX + b) = a2 var(X)

Beweis " ⇒": var(X) = 0 ⇒ f[E(X)] = 1 ⇒ X ~ εE(X)

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

43

Erwartungswert und Varianz

Eigenschaften von Varianzen

Falls die folgenden Varianzen von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(A) var(X) ≥ 0

(D) X und Y st.u. ⇒ var(X + Y) = var(X) + var(Y)

(B) var(X) = 0 ⇔ X ~ εa , a ∈ ℜ

(E) X 1 ,..., X n st.u. , a1 ,..., an ∈ ℜ

n

n 2

⇒ var ∑ aiX i + b = ∑ ai var(X i )

i=1

i=1

(C) var(aX + b) = a2 var(X)

(

Beweis : var(aX + b) = E [aX + b − E(aX + b)]2

(

)

(

)

)

=

E(aX +b)=aE(X)+b

(

(

E [aX + b − aE(X) − b]2

)

)

= E [a ⋅ (X − E[X])]2 = E a2 ⋅ [X − E(X)]2 = a2 ⋅ E [X − E(X)]2 = a2 var(X)

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

44

Erwartungswert und Varianz

Eigenschaften von Varianzen

Falls die folgenden Varianzen von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(A) var(X) ≥ 0

(D) X und Y st.u. ⇒ var(X + Y) = var(X) + var(Y)

(B) var(X) = 0 ⇔ X ~ εa , a ∈ ℜ

(E) X 1 ,..., X n st.u. , a1 ,..., an ∈ ℜ

n

n 2

⇒ var ∑ aiX i + b = ∑ ai var(X i )

i=1

i=1

(C) var(aX + b) = a2 var(X)

Beweis : X und Y st.u. ⇒ E(XY) = E(X)E(Y)

(

) (

)

(

Var(X + Y) = E [X + Y − E(X + Y)]2 = E [X + Y − E(X) − E(Y)]2 = E [(X − E(X) + (Y − E(Y)]2

(

)

)

= E [X − E(X)]2 + [Y − E(Y)]2 + 2[X − E(X)] ⋅ [Y − E(Y)] = Var(X) + Var(Y) + 2R

R = E([X − E(X)] ⋅ [Y − E(Y)])

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

45

Erwartungswert und Varianz

Eigenschaften von Varianzen

Falls die folgenden Varianzen von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(A) var(X) ≥ 0

(D) X und Y st.u. ⇒ var(X + Y) = var(X) + var(Y)

(B) var(X) = 0 ⇔ X ~ εa , a ∈ ℜ

(E) X 1 ,..., X n st.u. , a1 ,..., an ∈ ℜ

n

n 2

⇒ var ∑ aiX i + b = ∑ ai var(X i )

i=1

i=1

(C) var(aX + b) = a2 var(X)

Beweis : X und Y st.u. ⇒ E(XY) = E(X)E(Y)

Var(X + Y) = Var(X) + Var(Y) + 2R

R = E([X − E(X)] ⋅ [Y − E(Y)]) = E(XY − E(X)Y − XE(Y) + E(X)E(Y))

= E(XY) − E(X)E(Y) − E(X)E(Y) + E(X)E(Y)

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

=

E(XY)=E(X)E(Y)

0

46

Erwartungswert und Varianz

Eigenschaften von Varianzen

Falls die folgenden Varianzen von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(A) var(X) ≥ 0

(D) X und Y st.u. ⇒ var(X + Y) = var(X) + var(Y)

(B) var(X) = 0 ⇔ X ~ εa , a ∈ ℜ

(E) X 1 ,..., X n st.u. , a1 ,..., an ∈ ℜ

n

n 2

⇒ var ∑ aiX i + b = ∑ ai var(X i )

i=1

i=1

(C) var(aX + b) = a2 var(X)

Beweis : X und Y st.u. ⇒ E(XY) = E(X)E(Y)

Var(X + Y) = Var(X) + Var(Y) + 2R = Var(X) + Var(Y)

R =0

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

47

Erwartungswert und Varianz

Eigenschaften von Varianzen

Falls die folgenden Varianzen von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(F) Verschiebungssatz von Steiner : a ∈ ℜ ⇒ var(X) = E[(X − a)2 ] − [E(X) − a]2 ,

insb. a = 0 ⇒ var(X) = E(X 2 ) − E(X)2

(G) Tschebyscheff - Ungleichung P(| X − E(X)|> ε) ≤

var(X)

, ε ∈ (0, ∞)

ε2

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

48

Erwartungswert und Varianz

Eigenschaften von Varianzen

Falls die folgenden Varianzen von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(F) Verschiebungssatz von Steiner : a ∈ ℜ ⇒ var(X) = E[(X − a)2 ] − [E(X) − a]2 ,

insb. a = 0 ⇒ var(X) = E(X 2 ) − E(X)2

(G) Tschebyscheff - Ungleichung P(| X − E(X)|> ε) ≤

var(X)

, ε ∈ (0, ∞)

ε2

Beweis

var(X) = E [X − E(X)]2 = E [(X − a) + (a − E[X])]2 = E (X − a)2 + 2(a − E[X])(X − a) + (a − E[X])2

(

) (

) [

]

= E[(X − a)2 ] + 2(a − E[X])(E[X] − a) + (a − E[X])2 = E[(X − a)2 ] − 2(a − E[X])2 + (a − E[X])2

= E[(X − a)2 ] − (a − E[X])2

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

49

Erwartungswert und Varianz

Eigenschaften von Varianzen

Falls die folgenden Varianzen von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(F) Verschiebungssatz von Steiner : a ∈ ℜ ⇒ var(X) = E[(X − a)2 ] − [E(X) − a]2 ,

insb. a = 0 ⇒ var(X) = E(X 2 ) − E(X)2

(G) Tschebyscheff - Ungleichung P(| X − E(X)|> ε) ≤

Beweis : var(X) =

∞

2

[t

−

E(X)]

fX (t)dt

∫

−∞

≥2

[t −E(X)] fX (t)≥0

var(X)

, ε ∈ (0, ∞)

ε2

2

[t

−

E(X)]

fX (t)dt

∫

t:[t −E(X)]2 > ε2

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

50

Erwartungswert und Varianz

Eigenschaften von Varianzen

Falls die folgenden Varianzen von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(F) Verschiebungssatz von Steiner : a ∈ ℜ ⇒ var(X) = E[(X − a)2 ] − [E(X) − a]2 ,

insb. a = 0 ⇒ var(X) = E(X 2 ) − E(X)2

(G) Tschebyscheff - Ungleichung P(| X − E(X)|> ε) ≤

∞

Beweis : var(X) ≥ ∫∫[t[t−−E(X)]

E(X)]22fXfX(t)dt

(t)dt ≥

− ∞2 > ε2

t:[t −E(X)]

∞

var(X)

, ε ∈ (0, ∞)

ε2

E(X)+ ε

2 2

XX

E(X)− ε

2

≥2 ∫ ε2 fX (t)dt

[t

−

=

E(X)]

ε

f

f

(t)dt

(t)dt

=

ε

P[E(X) − ε ≤ X ≤ E(X) + ε]

∫

∫

[X −E(X)] fX (t)

≥0

t:[t −E(X)]2 >ε2 ε2

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

51

Erwartungswert und Varianz

Eigenschaften von Varianzen

Falls die folgenden Varianzen von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(F) Verschiebungssatz von Steiner : a ∈ ℜ ⇒ var(X) = E[(X − a)2 ] − [E(X) − a]2 ,

insb. a = 0 ⇒ var(X) = E(X 2 ) − E(X)2

(G) Tschebyscheff - Ungleichung P(| X − E(X)|> ε) ≤

Beweis : var(X) ≥

∞

2

2

2

ε

f

(t)dt

=

ε

⋅

[t

−

E(X)]

f

(t)dt

X

X

∫ ∫

t−

:[t∞−E(X)]2 > ε2

var(X)

, ε ∈ (0, ∞)

ε2

∞

2 2

εfX (t)dt

⋅ P[(t > E(X) + ε) ∪ (t < E(X) − ε)]

≥2∫ fX (t)dt∫ [t − =

E(X)]

2

2

[X −E(X)] fX2(t)≥20

t:[t −E(X)] >ε

[t −E(X)] >ε

ε2 ⇔

t >E(X)+ ε

∪ t <E(X)− ε

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

52

Erwartungswert und Varianz

Eigenschaften von Varianzen

Falls die folgenden Varianzen von stetig oder diskret verteilten Zufallsvariablen

existieren, so gelten folgende Eigenschaften:

(F) Verschiebungssatz von Steiner : a ∈ ℜ ⇒ var(X) = E[(X − a)2 ] − [E(X) − a]2 ,

insb. a = 0 ⇒ var(X) = E(X 2 ) − E(X)2

(G) Tschebyscheff - Ungleichung P(| X − E(X)|> ε) ≤

∞

2

var(X)

, ε ∈ (0, ∞)

ε2

∞

2

2

> E(X)

+ ε) ∪ (t <≥2 E(X) − ∫ε)]

ε2 ⋅ P[|

X − E(X)|> ε]

Beweis : var(X) ≥ ε∫ [t⋅ P[(t

− E(X)]

fX (t)dt

[t −=E(X)]

fX (t)dt

−∞

[X −E(X)] fX (t)≥ 0

ε2

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

53

Erwartungswert und Varianz

Eigenschaften von Varianzen

Anwendung der Tschebyscheff-Ungleichung: Abschätzung verteilungsunabhängiger

Unsicherheitsbereiche

P(| X − E(X)|> ε) ≤

(

var(X)

, ε ∈ (0, ∞)

2

ε

)

Setze ε := r var(X) ⇒ P | X − E(X)|> r var(X) ≤

1

r2

(

)

⇔ P E(X) − r var(X) ≤ X ≤ E(X) + r var(X) ≥ 1 −

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

1

r2

54

Erwartungswert und Varianz

Eigenschaften von Varianzen

Anwendung der Tschebyscheff-Ungleichung: Abschätzung verteilungsunabhängiger

1

Unsicherheitsbereiche

P E(X) − r var(X) ≤ X ≤ E(X) + r var(X) ≥ 1 − 2

r

(

)

Die Wahrscheinlichkeit, dass eine Realisation von X in einem symmetrischen Intervall

der Breite von r Standardabweichungen fällt, beträgt also unabhängig von der

Verteilung von X mindestens 1-1/r2.

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

55

Erwartungswert und Varianz

Eigenschaften von Varianzen

Anwendung der Tschebyscheff-Ungleichung: Abschätzung verteilungsunabhängiger

Unsicherheitsbereiche

1

(

)

P E(X) − r var(X) ≤ X ≤ E(X) + r var(X) ≥ 1 −

r2

Die Wahrscheinlichkeit, dass eine Realisation von X in einem symmetrischen Intervall der Breite

von r Standardabweichungen fällt, beträgt also unabhängig von der Verteilung von X mindestens

1-1/r2.

r=1

P[|X-E(X)|≤

≤E(X)+r∙var(X)0.5] ≈ 0.6827

P[|X-E(X)|≤

≤E(X)+r∙var(X)0.5] ≈ 0.8647

1-1/r2 = 0

N(5,1)

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

1-1/r2 = 0

Exp(0.5)

56

Erwartungswert und Varianz

Eigenschaften von Varianzen

Anwendung der Tschebyscheff-Ungleichung: Abschätzung verteilungsunabhängiger

Unsicherheitsbereiche

1

(

)

P E(X) − r var(X) ≤ X ≤ E(X) + r var(X) ≥ 1 −

r2

Die Wahrscheinlichkeit, dass eine Realisation von X in einem symmetrischen Intervall der Breite

von r Standardabweichungen fällt, beträgt also unabhängig von der Verteilung von X mindestens

1-1/r2.

P[|X-E(X)|≤

≤E(X)+r∙var(X)0.5] ≈ 0.7287

r = 1.1

P[|X-E(X)|≤

≤E(X)+r∙var(X)0.5] ≈ 0.8775

1-1/r2 ≈ 0.1736

N(5,1)

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

1-1/r2 ≈ 0.1736

Exp(0.5)

57

Erwartungswert und Varianz

Eigenschaften von Varianzen

Anwendung der Tschebyscheff-Ungleichung: Abschätzung verteilungsunabhängiger

Unsicherheitsbereiche

1

(

)

P E(X) − r var(X) ≤ X ≤ E(X) + r var(X) ≥ 1 −

r2

Die Wahrscheinlichkeit, dass eine Realisation von X in einem symmetrischen Intervall der Breite

von r Standardabweichungen fällt, beträgt also unabhängig von der Verteilung von X mindestens

1-1/r2.

P[|X-E(X)|≤

≤E(X)+r∙var(X)0.5] ≈ 0.8664

r = 1.5

P[|X-E(X)|≤

≤E(X)+r∙var(X)0.5] ≈ 0.9179

1-1/r2 ≈ 0.5556

N(5,1)

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

1-1/r2 ≈ 0.5556

Exp(0.5)

58

Erwartungswert und Varianz

Eigenschaften von Varianzen

Anwendung der Tschebyscheff-Ungleichung: Abschätzung verteilungsunabhängiger

Unsicherheitsbereiche

1

(

)

P E(X) − r var(X) ≤ X ≤ E(X) + r var(X) ≥ 1 −

r2

Die Wahrscheinlichkeit, dass eine Realisation von X in einem symmetrischen Intervall der Breite

von r Standardabweichungen fällt, beträgt also unabhängig von der Verteilung von X mindestens

1-1/r2.

P[|X-E(X)|≤

≤E(X)+r∙var(X)0.5] ≈ 0.9545

r=2

P[|X-E(X)|≤

≤E(X)+r∙var(X)0.5] ≈ 0.9502

1-1/r2 = 0.75

N(5,1)

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

1-1/r2 = 0.75

Exp(0.5)

59

Erwartungswert und Varianz

Eigenschaften von Varianzen

Anwendung der Tschebyscheff-Ungleichung: Abschätzung verteilungsunabhängiger

Unsicherheitsbereiche

1

(

)

P E(X) − r var(X) ≤ X ≤ E(X) + r var(X) ≥ 1 −

r2

Die Wahrscheinlichkeit, dass eine Realisation von X in einem symmetrischen Intervall der Breite

von r Standardabweichungen fällt, beträgt also unabhängig von der Verteilung von X mindestens

1-1/r2.

P[|X-E(X)|≤

≤E(X)+r∙var(X)0.5] ≈ 0.9999

r=4

P[|X-E(X)|≤

≤E(X)+r∙var(X)0.5] ≈ 0.9933

1-1/r2 = 0.9375

N(5,1)

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

1-1/r2 = 0.9375

Exp(0.5)

60

Erwartungswert und Varianz

Eigenschaften von Varianzen

Anwendung der Tschebyscheff-Ungleichung: Abschätzung verteilungsunabhängiger

Unsicherheitsbereiche

1

(

)

P E(X) − r var(X) ≤ X ≤ E(X) + r var(X) ≥ 1 −

r2

Die Wahrscheinlichkeit, dass eine Realisation von X in einem symmetrischen Intervall der Breite

von r Standardabweichungen fällt, beträgt also unabhängig von der Verteilung von X mindestens

1-1/r2.

1 − 1/r 2

P[|X-E(X)|<E(X)+r∙var(X)0.5]

N( μ , σ 2 )

W( 1.4,2.6)

R( a, b)

Ber( 0.2)

Bin(20, 0.2)

Poi(10)

r

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

61

Erwartungswert und Varianz

Beispiel: Roulette

12P (1-12)

Manque

(1,...,18)

0

Impair

(2∙i-1, i=1,…,18)

Rouge

(Rote Zahlen)

12M (13-24)

12D (13-24)

3

6

9

12

15

18

21

24

27

30

33

36

Col.36

(3∙i,i=1,…,12)

2

5

8

11

14

17

20

23

26

29

32

35

Col.35

(3∙i-1,i=1,…,12)

1

4

7

10

13

16

19

22

25

28

31

34

Col.34

(3∙i-2,i=1,…,12)

12D (13-24)

Passe

(19,…,36)

Pair

(2∙i, i=1,…,18)

Noir

(Schwarze Zahlen)

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

12M (13-24)

12P (1-12)

62

Erwartungswert und Varianz

12P (1-12)

Beispiel: Roulette

Manque

(1,...,18)

0

Impair

(2∙i-1, i=1,…,18)

Rouge

(Rote Zahlen)

12M (13-24)

12D (13-24)

3

6

9

12

15

18

21

24

27

30

33

36

Col.36

(3∙i,i=1,…,12)

2

5

8

11

14

17

20

23

26

29

32

35

Col.35

(3∙i-1,i=1,…,12)

1

4

7

10

13

16

19

22

25

28

31

34

Col.34

(3∙i-2,i=1,…,12)

12D (13-24)

Passe

(19,…,36)

Pair

(2∙i, i=1,…,18)

Noir

(Schwarze Zahlen)

12M (13-24)

12P (1-12)

Für jedes Setzereignis A={a1,…,ak}, das k Zahlen enthält und auf das der Betrag eA gesetzt wird,

wird im Fall, dass die Kugel bei einer der in A enthaltenen Zahlen anhält, der Betrag BA= eA∙(36/k)

ausgezahlt.

Der Grundraum des zugrundeliegenden Zufallsexperiment ist gegeben durch Ω={0,1,…,36}, da

jede Zahl die gleiche Wahrscheinlichkeit hat, gilt P({i}) = 1/37, für i = 0,…,36.

Damit berechnet sich die Erfolgswahrscheinlichkeit von Ereignis A = {a1,…,ak}, zu P(A) = k/37

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

63

Erwartungswert und Varianz

12P (1-12)

Beispiel: Roulette

Manque

(1,...,18)

A = {a1 ,..., ak }

P(A) =

k

37

0

Impair

(2∙i-1, i=1,…,18)

Rouge

(Rote Zahlen)

12M (13-24)

12D (13-24)

3

6

9

12

15

18

21

24

27

30

33

36

Col.36

(3∙i,i=1,…,12)

2

5

8

11

14

17

20

23

26

29

32

35

Col.35

(3∙i-1,i=1,…,12)

1

4

7

10

13

16

19

22

25

28

31

34

Col.34

(3∙i-2,i=1,…,12)

12D (13-24)

Passe

(19,…,36)

Pair

(2∙i, i=1,…,18)

Noir

(Schwarze Zahlen)

12M (13-24)

12P (1-12)

Damit ist die Zähldichte der Zufallsvariable BA mit BA(ω) = eA∙(36/k)∙I(ω∈A) gegeben durch

pBA(x)=(1-k/37) ∙ I(x=0) + (k/37) ∙ I(x=eA ∙(36/k))

und die Zähldichte der Zufallsvariable Gewinn GA=BA-eA =eA ∙(36/k-1) durch

pGA(x)=(1-k/37) ∙ I(x=-eA) + (k/37) ∙ I(x=eA∙(36/k-1))

Der Träger der Gewinnverteilung ist also gegeben durch TGA={-eA, eA∙(36/k-1)}

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

64

Erwartungswert und Varianz

12P (1-12)

Beispiel: Roulette

Manque

(1,...,18)

A = {a1 ,..., ak }

P(A) =

k

37

0

36

GA = e A ⋅ − 1

k

pGA (x) =

(1 − k/37) ⋅ I(x = −e A )

+ (k/37) ⋅ I(x = eA ⋅ (36/k − 1))

Impair

(2∙i-1, i=1,…,18)

Rouge

(Rote Zahlen)

12M (13-24)

12D (13-24)

3

6

9

12

15

18

21

24

27

30

33

36

Col.36

(3∙i,i=1,…,12)

2

5

8

11

14

17

20

23

26

29

32

35

Col.35

(3∙i-1,i=1,…,12)

1

4

7

10

13

16

19

22

25

28

31

34

Col.34

(3∙i-2,i=1,…,12)

12D (13-24)

Passe

(19,…,36)

Pair

(2∙i, i=1,…,18)

Noir

(Schwarze Zahlen)

12M (13-24)

12P (1-12)

Somit gilt für den erwarteten Gewinn E(GA1):

E(GA ) =

∑ x ⋅p

x∈TGA

GA

(x) = (1 − k/37) ⋅ (−e A ) + (k/37) ⋅ e A ⋅ (36/k − 1)

k

36

k

e

= 1 + eA ⋅ + eA ⋅ − eA ⋅

=− A

37

37

37

37

Nach häufig wiederholtem Setzen konvergiert der Gesamtverlust also gegen ein

Siebenunddreißigstel des Gesamteinsatzes.

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

65

Erwartungswert und Varianz

12P (1-12)

Beispiel: Roulette

36

GA = e A ⋅ − 1

k

pGA (x) =

(1 − k/37) ⋅ I(x = −e A )

+ (k/37) ⋅ I(x = e A ⋅ (36/k − 1))

Manque

(1,...,18)

0

Impair

(2∙i-1, i=1,…,18)

Rouge

(Rote Zahlen)

12M (13-24)

12D (13-24)

3

6

9

100

12

15

18

21

24

27

30

33

36

Col.36

(3∙i,i=1,…,12)

2

5

8

11

14

17

20

23

26

29

32

35

Col.35

(3∙i-1,i=1,…,12)

1

4

7

10

13

16

19

22

25

28

31

34

Col.34

(3∙i-2,i=1,…,12)

50

E(GA ) = − (e A /37)

12D (13-24)

Passe

(19,…,36)

Pair

(2∙i, i=1,…,18)

Noir

(Schwarze Zahlen)

12M (13-24)

12P (1-12)

Somit gilt für den erwarteten Gewinn E(GA1) von Spieler 1, der einen Betrag von 50 auf die vier

Zahlen 25,26,28 und 29 setzt: E(GA1 ) = − (50/37) ≈ −1.351.

Der erwartete Gewinn des Spielers 2, der den Betrag 100 auf die Zahl 9 gesetzt

hat, lautet: E(GA2 ) = − (100/37) ≈ −2.703.

Das Verhältnis der erwarteten Verluste von zwei Spielern hängt also nur vom Verhältnis ihrer

Einsätze und nicht vom Ereignis, auf das sie setzen ab.

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

66

Erwartungswert und Varianz

12P (1-12)

Beispiel: Roulette

36

GA = e A ⋅ − 1

k

pGA (x) =

(1 − k/37) ⋅ I(x = −e A )

+ (k/37) ⋅ I(x = e A ⋅ (36/k − 1))

Manque

(1,...,18)

0

Impair

(2∙i-1, i=1,…,18)

Rouge

(Rote Zahlen)

12M (13-24)

12D (13-24)

3

6

9

12

15

18

21

24

27

30

33

36

Col.36

(3∙i,i=1,…,12)

2

5

8

11

14

17

20

23

26

29

32

35

Col.35

(3∙i-1,i=1,…,12)

1

4

7

10

13

16

19

22

25

28

31

34

Col.34

(3∙i-2,i=1,…,12)

E(GA ) = − (e A /37)

12D (13-24)

Passe

(19,…,36)

Pair

(2∙i, i=1,…,18)

Noir

(Schwarze Zahlen)

12M (13-24)

12P (1-12)

Die Varianz var(GA) des Gewinns wird wie folgt ermittelt:

Setze X =

GA + e A

⇔ GA = e A (36/k) ⋅ X − e A ⇒ p X (x) = (1 − k/37) ⋅ I(x = 0) + (k/37) ⋅ I(x = 1)

e A (36/k)

⇒ E(X) = 0 ⋅ (1 - k/37) + 1 ⋅ (k/37) = k/37 und E(X2 ) = 0 ⋅ (1 - k/37) + 1 ⋅ (k/37) = k/37

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

67

Erwartungswert und Varianz

12P (1-12)

Beispiel: Roulette

36

GA = e A ⋅ − 1

k

pGA (x) =

(1 − k/37) ⋅ I(x = −e A )

+ (k/37) ⋅ I(x = e A ⋅ (36/k − 1))

Manque

(1,...,18)

0

Impair

(2∙i-1, i=1,…,18)

Rouge

(Rote Zahlen)

12M (13-24)

12D (13-24)

3

6

9

12

15

18

21

24

27

30

33

36

Col.36

(3∙i,i=1,…,12)

2

5

8

11

14

17

20

23

26

29

32

35

Col.35

(3∙i-1,i=1,…,12)

1

4

7

10

13

16

19

22

25

28

31

34

Col.34

(3∙i-2,i=1,…,12)

E(GA ) = − (e A /37)

12D (13-24)

Passe

(19,…,36)

Pair

(2∙i, i=1,…,18)

Noir

(Schwarze Zahlen)

12M (13-24)

12P (1-12)

Die Varianz var(GA) des Gewinns wird wie folgt ermittelt:

Setze X =

GA + e A

⇔ GA = e A (36/k) ⋅ X − e A ⇒ p X (x) = (1 − k/37) ⋅ I(x = 0) + (k/37) ⋅ I(x = 1)

e A (36/k)

2

⇒ E(X) = k/37 ,

E(X ) = k/37

2

k k

k k

⇒ var(X) = E(X ) − E(X) =

− = 1 − ⋅

37 37

37 37

2

2

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

68

Erwartungswert und Varianz

12P (1-12)

Beispiel: Roulette

36

GA = e A ⋅ − 1

k

pGA (x) =

(1 − k/37) ⋅ I(x = −e A )

+ (k/37) ⋅ I(x = e A ⋅ (36/k − 1))

Manque

(1,...,18)

0

Impair

(2∙i-1, i=1,…,18)

Rouge

(Rote Zahlen)

12M (13-24)

12D (13-24)

3

6

9

12

15

18

21

24

27

30

33

36

Col.36

(3∙i,i=1,…,12)

2

5

8

11

14

17

20

23

26

29

32

35

Col.35

(3∙i-1,i=1,…,12)

1

4

7

10

13

16

19

22

25

28

31

34

Col.34

(3∙i-2,i=1,…,12)

E(GA ) = − (e A /37)

12D (13-24)

Passe

(19,…,36)

Pair

(2∙i, i=1,…,18)

Noir

(Schwarze Zahlen)

12M (13-24)

12P (1-12)

Die Varianz var(GA) des Gewinns wird wie folgt ermittelt:

Setze X =

GA + e A

⇔ GA = e A (36/k) ⋅ X − e A ⇒ p X (x) = (1 − k/37) ⋅ I(x = 0) + (k/37) ⋅ I(x = 1)

e A (36/k)

⇒ E(X) = k/37 ,

E(X2 ) = k/37

k k

⇒ var(X) = 1 − ⋅

37 37

2

k k

36

⇒ var(GA ) = [e A ⋅ (36/k)] ⋅ var(X) = e A ⋅ ⋅ 1 − ⋅

k 37 37

2

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

2

69

Erwartungswert und Varianz

12P (1-12)

Beispiel: Roulette

36

GA = e A ⋅ − 1

k

pGA (x) =

(1 − k/37) ⋅ I(x = −e A )

+ (k/37) ⋅ I(x = e A ⋅ (36/k − 1))

Manque

(1,...,18)

0

Impair

(2∙i-1, i=1,…,18)

Rouge

(Rote Zahlen)

12M (13-24)

12D (13-24)

3

6

9

12

15

18

21

24

27

30

33

36

Col.36

(3∙i,i=1,…,12)

2

5

8

11

14

17

20

23

26

29

32

35

Col.35

(3∙i-1,i=1,…,12)

1

4

7

10

13

16

19

22

25

28

31

34

Col.34

(3∙i-2,i=1,…,12)

E(GA ) = − (e A /37)

2

k k

36

var(GA ) = e A ⋅ ⋅ 1 − ⋅

k 37 37

2

12D (13-24)

Passe

(19,…,36)

Pair

(2∙i, i=1,…,18)

Noir

(Schwarze Zahlen)

12M (13-24)

12P (1-12)

Im Gegensatz zum Erwartungswert hängt die Gewinnvarianz also offensichtlich sowohl vom

Einsatz als auch von der Gewinnchance ab.

eA=1

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

k

70

Erwartungswert und Varianz

12P (1-12)

Beispiel: Roulette

36

GA = e A ⋅ − 1

k

pGA (x) =

(1 − k/37) ⋅ I(x = −e A )

+ (k/37) ⋅ I(x = e A ⋅ (36/k − 1))

Manque

(1,...,18)

0

Impair

(2∙i-1, i=1,…,18)

Rouge

(Rote Zahlen)

12M (13-24)

12D (13-24)

3

6

9

100

12

15

18

21

24

27

30

33

36

Col.36

(3∙i,i=1,…,12)

2

5

8

11

14

17

20

23

26

29

32

35

Col.35

(3∙i-1,i=1,…,12)

1

4

7

10

13

16

19

22

25

28

31

34

Col.34

(3∙i-2,i=1,…,12)

50

E(GA ) = − (e A /37)

2

12D (13-24)

k k

36

var(GA ) = e A ⋅ ⋅ 1 − ⋅

k 37 37

2

Passe

(19,…,36)

Pair

(2∙i, i=1,…,18)

Noir

(Schwarze Zahlen)

12M (13-24)

12P (1-12)

Somit gilt für die Gewinnvarianz var(GA1) von Spieler 1, der einen Betrag von 50 auf die vier

Zahlen 25,26,28 und 29 setzt: Var(GA1 ) = 502 ⋅ 92 ⋅ (33/37) ⋅ (4/37) ≈ 139.732.

Die Gewinnvarianz des Spielers 2, der den Betrag 100 auf die Zahl 9 gesetzt

hat, lautet:

Var(GA2 ) = 1002 ⋅ 362 ⋅ (36/37) ⋅ (1/37) ≈ 291.892.

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

71

Erwartungswert und Varianz

12P (1-12)

Beispiel: Roulette

36

GA = e A ⋅ − 1

k

pGA (x) =

(1 − k/37) ⋅ I(x = −e A )

+ (k/37) ⋅ I(x = e A ⋅ (36/k − 1))

Manque

(1,...,18)

0

Impair

(2∙i-1, i=1,…,18)

Rouge

(Rote Zahlen)

12M (13-24)

12D (13-24)

3

6

9

100

12

15

18

21

24

27

30

33

36

Col.36

(3∙i,i=1,…,12)

2

5

8

11

14

17

20

23

26

29

32

35

Col.35

(3∙i-1,i=1,…,12)

1

4

7

10

13

16

19

22

25

28

31

34

Col.34

(3∙i-2,i=1,…,12)

50

E(GA ) = − (e A /37)

2

k k

36

var(GA ) = e A ⋅ ⋅ 1 − ⋅

k 37 37

2

12D (13-24)

Passe

(19,…,36)

Pair

(2∙i, i=1,…,18)

Noir

(Schwarze Zahlen)

12M (13-24)

12P (1-12)

Stammen beide Chips vom selben Spieler, so ist sein erwarteter Gewinn gegeben durch:

E(GA ) = E(GA1 ) + E(GA2 ) ≈ −1.351 − 2.703 = −4.054.

Da GA1 und GA2 nicht stochastisch unabhängig sind, kann die Formel var(X+Y)=var(X)+var(Y) nicht

angewendet werden!

Nils Raabe: Wahrscheinlichkeitsrechnung und

mathematische Statistik für Informatiker

72