Modellierung und Analyse technischer Systeme

Werbung

Modellierung und Analyse technischer Systeme

Prof. Dr. W. Vogler

Sommersemester 2017

1

INHALTSVERZEICHNIS

i

Inhaltsverzeichnis

1 Einleitung, formale Sprachen

1.1 Wörter . . . . . . . . . . . .

1.2 Sprachen . . . . . . . . . . .

1.3 Graphen . . . . . . . . . . .

und Wörter

. . . . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . . . . . . . . . . . . . . . . . .

2 Endliche Automaten

2.1 Endliche Automaten . . . . . . . . . . . . . . . . . . . . . . . . . .

2.2 Pumping–Lemma . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.3 Deterministische Automaten . . . . . . . . . . . . . . . . . . . . . .

2.4 Abschlusseigenschaften, Entscheidbarkeitsprobleme und Simulation

2.5 Induktive Definition von Termen . . . . . . . . . . . . . . . . . . .

2.6 Rationale Ausdrücke und der Satz von Kleene . . . . . . . . . . . .

2.7 Lexikalische Analyse — (F)LEX . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

4

5

6

6

9

11

14

18

20

23

3 Mealy-Automaten

26

4 Aussagenlogik

4.1 Syntax . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.2 Semantik,Wahrheitstafeln . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

33

33

36

5 Beweismethoden für Aussagenlogik

5.1 Der Hilbert-Kalkül . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.2 Sequenzenkalkül . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.3 Resolution . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

43

43

50

52

6 Temporale Logik

6.1 LTL . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.2 CTL . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.3 CTL-Model-Checking . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

54

54

63

68

7 Ein Blick auf UML-State-Machines

72

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

1 EINLEITUNG, FORMALE SPRACHEN UND WÖRTER

1

1

Einleitung, formale Sprachen und Wörter

Diese Vorlesung befaßt sich mit formaler (mathematischer) Grundlagen-Informatik (Stichworte: korrekte Software, Verifikation), speziell mit Automaten und Logik. Endliche Automaten

beschreiben präzise Zeichenketten, die einfache Bausteine in Programmiersprachen sein können (der Lexer bereitet die Compilation vor) oder z.B. Abläufe von Systemen. Sie spielen

(in leicht abgewandelter Form) auch eine wichtige Rolle im Software- und Systementwurf

(Zustandsmaschinen in UML – s. Kapitel 7, Transitionssysteme).

Wort:

Sequenz von Zeichen aus einem gegebenen Zeichenvorrat (z.B. C-Programm)

formale Sprache: Menge von Wörtern (z.B. der syntaktisch korrekten C-Programme)

Ein Alphabet (Zeichenvorrat) Σ ist eine endliche Menge; ihre Elemente heißen Buchstaben

(Zeichen).

a,b,c,0,1

a,b,c

1

2

Abbildung 1:

Beispiel 1.1. Der endliche Automat in Abb. 1 erkennt/akzeptiert genau die (formale Sprache

der) Bezeichner über Σ = {0, 1, a, b, c}: notiere die Buchstaben auf einem Weg vom Startzustand zum Endzustand, z.B. a00b, b, aber nicht 1ab.

a-

a+

b+

0

b-

x-

a

b+

ab

a+

b

x+

xa

xab

x-

baxb

Abbildung 2:

Beispiel 1.2. Bei einem Und-Gatter seien die Eingangssignale a und b sowie das Ausgangssignal x auf 0. Gehen die Eingangssignale mit a+ und b+ auf 1, muss auch x mit x+ auf 1

gehen; geht dann ein Eingangssignal mit a− oder b− auf 0, muss auch x mit x− auf 0 gehen

etc.

Der endliche Automat in Abb. 2 erkennt/akzeptiert genau die Abläufe, die in einen stabilen

Zustand führen, bei dem also keine fällige Änderung des Ausgangssignals fehlt, z.B. a+ b+

x+ b− x−, a+ a− b+ a+ x+ und a+ a− b+, aber nicht a+ x+, a+ b+ a− und a+ b+ x+

b−.

1.1

Wörter

Wir legen zunächst einige Grundlagen:

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

1 EINLEITUNG, FORMALE SPRACHEN UND WÖRTER

2

Definition 1.3. Ein Alphabet (Zeichenvorrat) Σ ist eine endliche Menge; ihre Elemente heißen

Buchstaben (Zeichen); oft ist zusätzlich eine totale Ordnung auf Σ gegeben.

Eine Folge von Buchstaben w = a1 · · · an mit ai ∈ Σ heißt Wort oder Zeichenkette über Σ.

|w| := n ist die Länge des Wortes. Für n = 0 heißt w das leere Wort und wird mit λ (oft auch

ε) bezeichnet.

Σn bezeichnet die Menge der Wörter mit Länge n. Wörter der Länge 1 sind einfach Buchstaben; also Σ1 = Σ und Σ0 =

Σ+ =

[

Σn

Menge der nichtleeren Wörter

n≥1

Σ∗ =

[

Σn = Σ+ ∪˙ {λ}

Menge aller Wörter

n≥0

Eine formale Sprache über Σ ist eine Teilmenge L ⊆ Σ∗ .

Beispiele 1.4.

• {abba, babba} und {aa, ab, ba, bb} sind Sprachen über {a, b}.

• Die leere Sprache ∅ und die Sprache {λ}, die nur das leere Wort enthält, sind Sprachen

über jedem Alphabet.

• immer λ ∈ Σ∗ , speziell: ∅∗ 6= ∅

Definition 1.5. Die Konkatenation der Wörter v = a1 · · · an ∈ Σn und w = b1 · · · bm ∈ Σm

ist v · w = a1 · · · an b1 · · · bm ∈ Σn+m ; wir schreiben oft vw (in Java: +).

Ein Präfix ist ein Anfangsstück eines Wortes (inkl. λ!), d.h. v ist Präfix von u, wenn es ein

Wort w mit u = vw gibt.

Die Konkatenation ist assoziativ (also (uv)w = u(vw) ) und λ ist das neutrale Element,

d.h. es gilt λw = w = wλ für alle w ∈ Σ∗ .

Wir definieren noch eine parametrische Länge.

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

1 EINLEITUNG, FORMALE SPRACHEN UND WÖRTER

3

Definition 1.6. Ist A ⊆ Σ, so ist |w|A die Anzahl der Zeichen von w, die in A liegen; speziell

ist also |w| = |w|Σ . Formaler definieren wir |w|A durch Induktion über die Wortlänge:

|λ|A

=

|av|A

=

0

(

1 + |v|A

|v|A

Beispiele 1.7.

wenn a ∈ A

sonst

• Wörter mit gleich vielen a und b: |w|a = |w|b

• Wörter gerader Länge: |w| mod 2 = 0

• Kommunikation eines Pufferspeichers: Hier soll e für eine Eingabe in den Puffer, a

bzw. b für eine Ausgabe auf Kanal A bzw. B stehen. w ∈ {a, b, e}∗ ist ein korrektes

Pufferverhalten, z.B. eaeeaeb (nicht aber eaeabe), wenn für jedes Präfix v von w gilt

|v|{a,b} ≤ |v|e .

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

1 EINLEITUNG, FORMALE SPRACHEN UND WÖRTER

1.2

4

Sprachen

Strukturen wie Σ∗ mit einer assoziativen Operation · und einem neutralen Element 1 gibt es

häufiger, sie heißen Monoide. In Monoiden kann man natürlichzahlige Potenzen definieren: xn

ist das Produkt von n x’en; formal:

x0 = 1;

xn+1 = x · xn

Speziell für Σ∗ ist also wn die Konkatenation von n w’s und w0 = λ. Weiter ist z.B.

(ab)3 = ababab, ab3 = abbb und a3 b3 = aaabbb – Potenzieren geht als „Rechenart höherer

Stufe“ also vor.

Es gelten in allen Monoiden die üblichen Rechenregeln für Potenzen:

x1 = x;

xn+m = xn · xm ;

(xn )m = xnm

Weiter verhält sich die Länge wie ein Logarithmus:

|λ| = 0;

|vw| = |v| + |w| ;

|wn | = n · |w|

Auch die Sprachen bilden ein Monoid.

Definition 1.8. Für ein Alphabet Σ ist P(Σ∗ ) die Potenzmenge von Σ∗ , d.h. die Menge

aller Sprachen über Σ. Die Konkatenation · wird auf P(Σ∗ ) erweitert: für K, L ⊆ Σ∗ ist

K · L = {k · l | k ∈ K, l ∈ L}.

Beispiele 1.9.

{a, ab}2 =

• In {a, b, c}∗ : {ab, ac} · {c, cb} =

• In {0, 1, . . . , 9}∗ : {1, . . . , 9} · {0, 5} ist die Menge aller zweistelligen, durch 5 teilbaren

Dezimalzahlen.

Jetzt ist auch P(Σ∗ ) ein Monoid wegen · und {λ}. Ferner ist ∅ ein Nullelement, d.h. für

alle Sprachen L gilt L · ∅ = ∅ = ∅ · L.

Die n-te Potenz von Σ ∈ P(Σ∗ ) besteht aus allen Produkten von n Elementen von Σ, also

allen Wörtern der Länge n – genau wie wir Σn oben bereits definiert haben.

Wenn wir die Elemente von Σ als Aktionen eines Systems oder eines Programms auffassen,

sind die Wörter Aktionsfolgen, d.h. Abläufe des Systems (vgl. Beispiel Kommunikation eines

Pufferspeichers). Die möglichen Abläufe des Systems (die von den Eingangsdaten oder z.B.

vom Benutzer beeinflußt werden können und daher nicht von vornherein eindeutig festliegen)

bilden eine Sprache L. Ln ist dann die n-fache Iteration des Programms (for-Schleife); u.a.

für beliebige (endliche) Iteration (terminierende while-Schleife) führen wir ein:

[

L+ =

Ln

n≥1

∗

L =

[

˙

Ln = L+ ∪{λ}

n≥0

Für L = Σ entsprechen L+ und L∗ unseren obigen Festlegungen.

Beispiel 1.10. {0, 1, . . . , 9}∗ · {0, 5} sind alle durch 5 teilbaren Dezimalzahlen (evtl. mit

führenden Nullen).

ohne führende Nullen:

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

1 EINLEITUNG, FORMALE SPRACHEN UND WÖRTER

1.3

5

Graphen

Da endliche Automaten offenbar (Kanten-beschriftete) (gerichtete) Graphen sind, definieren

wir:

Definition 1.11. Ein Graph G = (V, E) besteht aus einer (in der Regel endlichen) Menge

V von Ecken (vertex, vertices, Knoten) und einer Menge E ⊆ V × V von Kanten (edges,

Pfeilen); statt (v, w) ∈ E schreibt man bei Graphen meist vw ∈ E. Ein Weg (von x0 nach

xn ) (der Länge n) ist eine Folge x0 x1 . . . xn , n ≥ 0, mit (xi , xi+1 ) ∈ E für alle i < n. (Analog

gibt es auch unendliche Wege.)

Ein Graph G ist ein Baum mit Wurzel u0 , wenn es für jedes v ∈ V genau einen Weg von

u0 nach v gibt. Gelegentlich betrachten wir auch unendliche Bäume.

Ist G ein Baum und v ∈ V , so heißen die w ∈ V mit vw ∈ E die Kinder von v; gibt es

einen Weg von v nach w, so ist w ein Nachkomme von v.

✷

Ein Weg ist ein Kreis, wenn x0 = xn .

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

2

6

Endliche Automaten

Literatur zu diesem Kapitel:

Hopcroft, Motwani, Ullman: Introduction to Automata Theory, Languages and Computation.

dtsch.: Einführung in die Automatentheorie, Formale Sprachen und Komplexitätstheorie

Schöning: Theoretische Informatik kurz gefaßt. 5. Auflage

2.1

Endliche Automaten

Ein endlicher Automat (finite automaton oder finite state machine) erkennt bzw. akzeptiert

Wörter über einem Alphabet Σ; eine andere Sichtweise ist, dass er Wörter generiert. Wir

verwenden meist die folgenden Bezeichnungen:

• a, b, c ∈ Σ, α ∈ Σ ∪ {λ}

• u, v, w ∈ Σ∗

Der endliche Automat liest bei einem Zustandsübergang ein Zeichen aus Σ oder macht

einen spontanen Übergang ohne Lesen eines Zeichens. Er akzeptiert ein Wort, wenn er am

Wortende in einen besonders ausgezeichneten Zustand gelangt.

Definition 2.1. Ein (nichtdeterministischer) endlicher Automat (EA) über Σ ist ein Tupel

A = (Q, Σ, δ, q0 , F ), wobei:

• Q — endliche Menge von Zuständen

• q0 ∈ Q — Startzustand

• F ⊆ Q — Menge der (akzeptierenden oder) Endzustände

• δ ⊆ Q × (Σ ∪ {λ}) × Q — Übergangsrelation

Graphische Darstellung:

Zustand q ∈ Q

bzw.

Startzustand q0

(p, α, q) ∈ δ

q

p

Endzustand q ∈ F

bzw.

α

q

bzw.

b

λ

a

λ

Beispiel 2.2.

c

a

b

d

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

7

Ein endlicher Automat ist also ein Kanten-beschrifteter gerichteter Graph mit ausgezeichneten Ecken; die Kanten / Pfeile werden als Tripel angegeben mit der Beschriftung in der Mitte.

Es kann zwischen zwei Ecken mehrere („parallele“) Kanten mit verschiedenen Beschriftungen

geben – meist malt man nur eine Kante und trennt die Beschriftungen durch ein Komma.

Die Sprache L(A) ist die Menge der Beschriftungen von Wegen von q0 zu einem Endzustand.

Auf so einem Weg dürfen weitere Endzustände liegen; z.B. abda ∈ L(A).

Definition 2.3. Zum endlichen Automaten A sei δ∗ ⊆ Q × Σ∗ × Q die kleinste 3-stellige

Relation mit

i) ∀p ∈ Q: (p, λ, p) ∈ δ∗

ii) ∀p, q, q ′ ∈ Q, v ∈ Σ∗ , α ∈ Σ ∪ {λ} : (p, v, q ′ ) ∈ δ∗ , (q ′ , α, q) ∈ δ =⇒ (p, vα, q) ∈ δ∗

Also: (p, v, q) ∈ δ∗ =

b A kann v von p nach q lesen.

Die akzeptierte (erkannte) Sprache eines endlichen Automaten A ist:

L(A) = {w ∈ Σ∗ | ∃q ∈ F mit (q0 , w, q) ∈ δ∗ }

= {w1 · · · wn ∈ Σ∗ | n ≥ 0; ∃p0 = q0 , p1 , . . . , pn : pn ∈ F und

∀i = 1, . . . , n : wi ∈ Σ ∪ {λ} und (pi−1 , wi , pi ) ∈ δ

(bzw. (p0 , w1 , p1 ), . . . , (pn−1 , wn , pn ) ∈ δ)}

Solche Sprachen heißen regulär.

Endliche Automaten A1 , A2 heißen äquivalent, wenn L(A1 ) = L(A2 ).

✷

Ist speziell q0 ∈ F , so kann man oben n = 0 wählen und erhält λ ∈ L(A). Im obigen Beispiel

gibt es . . . mit ab beschriftete Wege von q0 aus, von denen nur einer in F endet. Nach 2.3

akzeptiert der Automat ab, d.h. er „rät“ richtig – im Gegensatz zu real existierenden Maschinen, die im Zweifel alles falsch machen; angelischer vs. dämonischer Nichtdeterminismus. Die

Umsetzung in ein reales Programm zur Spracherkennung ist also nicht offensichtlich.

a

a

b

b

b

Abbildung 3:

Beispiel 2.4. Für A aus Abb. 3:

Der dritte Zustand (als Startzustand) charakterisiert die Wörter

Der zweite Zustand charakterisiert die Wörter

L(A) = .

Oder: Zweiter Zustand weiß: bisher

Dritter Zustand weiß: bisher

Beispiel 2.5. EA für {w ∈ {a, b}∗ | |w|b ist gerade}.

Als ersten Schritt zu einem „realistischeren“ Automatentyp zeigen wir, daß Automaten ohne

spontane Übergänge nicht weniger können.

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

8

Definition 2.6. Eine endlicher Automat heißt buchstabierend, wenn δ ⊆ Q × Σ × Q.

Satz 2.7. Zu jedem endlichen Automaten A existiert effektiv ein äquivalenter buchstabierender endlicher Automat A′ .

Hier bedeutet „effektiv“, dass ein Verfahren angegeben wird, das A′ (hier: aus A) konstruiert.

Beweis. Wir müssen lediglich die λ–Kanten eliminieren:

Wir setzen R(p) = {q ∈ Q | (p, λ, q) ∈ δ∗ }. Dann sei

• Q′ = Q,

• q0′ = q0 ,

• δ′ = {(p, a, q) ∈ Q × Σ × Q | ∃q ′ ∈ R(p) : (q ′ , a, q) ∈ δ}

und

• F ′ = {p ∈ Q | R(p) ∩ F 6= ∅}.

λ

λ

a

a

a

a

λ

λ

✷

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

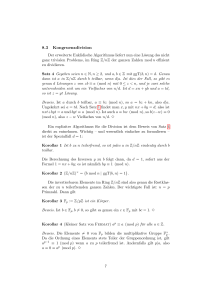

2.2

9

Pumping–Lemma für reguläre Sprachen oder: Das uvw–Theorem

Um zu zeigen, daß eine Sprache regulär ist, muß man lediglich einen entsprechenden EA

angeben. Wie aber zeigt man, daß eine Sprache nicht regulär ist?

Hier ein wichtiges Hilfsmittel.

Satz 2.8. Sei L regulär. Dann existiert ein n ∈ N, so daß es für alle z ∈ L mit |z| ≥ n eine

Zerlegung z = uvw gibt, für die gilt:

|uv| ≤ n, |v| ≥ 1 und ∀i ≥ 0 : uv i w ∈ L

Beweis. Sei A ein buchstabierender endlicher Automat mit L = L(A); vgl. Satz 2.7. Wähle

n = |Q|. Sei z = a1 · · · am ∈ L; m ≥ n, ai ∈ Σ. Dann in A: (q0 , a1 , q1 ), (q1 , a2 , q2 ), . . . ,

(qm−1 , am , qm ) ∈ δ und qm ∈ F . Nach Wahl von n tritt ein Zustand in der Folge q0 , . . . , qm –

ja sogar in q0 , . . . , qn mehrfach auf, d.h. ∃0 ≤ j < k ≤ n mit qj = qk .

Wir setzen u = a1 · · · aj , v = aj+1 . . . ak , w = ak+1 . . . am . Dann gilt |uv| = k ≤ n; |v| = k −

j ≥ 1. Wir können von q0 aus u lesen und qj erreichen, dann beliebig oft v und qj = qk erreichen

(auch 0–mal!), schließlich w und einen Endzustand erreichen; also gilt: ∀i ≥ 0 : uv i w ∈ L. ✷

Der Satz gibt nur eine Folgerung, aber keine Charakterisierung für reguläre Sprachen an.

Aus der Folgerung kann man schließen, daß reguläre Sprachen in einem gewisse Sinn ein

lineares Wachstum haben, also nicht immer größer werdende Lücken; vgl. 2.10. Aber eigentlich

ist die Folgerung für sich genommen nicht besonders interessant.

Anwendung: Zeigen, daß L die Folgerung verletzt und daher nicht regulär sein kann.

Beispiel 2.9. Das klassische Beispiel: L = {am bm | m ≥ 0} ist nicht regulär.

Beweis. Annahme: L ist regulär. Dann gibt es ein n wie in 2.8. (Wir kennen n nicht, eventuell

ist n sehr groß, abhängig von n dürfen wir jetzt aber ein beliebiges z ∈ L wählen.)

Sei z = an bn ; dann gibt es uvw wie in 2.8. (Wir kennen uvw nicht, wir müssen in jedem

Fall zum Widerspruch kommen.)

Da |uv| ≤ n gilt uv = aj , j ≤ n, ferner ist v = ak , k ≥ 1. Für i = 0 ergibt 2.8: aj−k an−j bn =

an−k bn ∈ L mit n − k 6= n. Widerspruch!

(Wir haben gezeigt, dass ∀n ∃z ∀z = uvw gilt: ¬ |uv| ≤ n ∨ ¬ |v| ≥ 1 ∨ ¬∀i ≥ 0 : uv i w ∈ L

bzw. |uv| ≤ n ∧ |v| ≥ 1 =⇒ ¬∀i ≥ 0 : uv i w ∈ L. — Um zu zeigen, dass ∀n∃k : n < k, gibt

man einfach k = n + 1 an; analog haben wir z = an bn angegeben.)

✷

Schlussfolgerung:

• Endliche Automaten können „nicht zählen“.

• Obiges L gehört zur Klasse der kontextfreien Sprachen; also ist nicht jede kontextfreie

Sprache regulär.

o

n 2

Beispiel 2.10. L = am | m ≥ 0 ist nicht regulär. (Hat immer größere Lücken.)

Beweis. Annahme: L ist regulär. Dann gibt es ein n wie in 2.8. (Wir dürfen wieder ein beliebiges, langes z ∈ L wählen.)

2

Sei z = an ; dann gibt es uvw wie in 2.8. (Wir kennen uvw nicht, wir müssen in jedem Fall

zum Widerspruch kommen.)

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

10

Also ist uv 2 w ∈ L und wegen 1 ≤ |v| ≤ |uv| ≤ n gilt n2 = |uvw| < uv 2 w ≤ n2 + n <

n2 + 2n + 1 = (n + 1)2 Also ist uv 2 w keine Quadratzahl – Widerspruch!

✷

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

2.3

11

Deterministische Automaten

Realistische Maschinen/Programme raten nicht einfach richtig; wir geben jetzt eine realistische

Automatenvariante, die man direkt in ein Programm übertragen kann.

Definition 2.11. Ein buchstabierender endlicher Automat heißt deterministisch (ein DEA),

wenn δ eine partielle Funktion Q × Σ 99K Q ist, d.h. wenn ∀q ∈ Q, a ∈ Σ höchstens ein

Folgezustand q ′ ∈ Q mit (q, a, q ′ ) ∈ δ existiert. Ein DEA heißt vollständig, wenn δ eine (total

definierte!) Funktion ist.

Beispiel 2.12. Der endliche Automat in Abbildung 3 ist deterministisch, aber nicht vollständig.

Kann ein DEA A „v von p nach q lesen“, so ist q eindeutig. Also ist δ∗ eine partielle Funktion

Q × Σ∗ 99K Q.

Ein deterministischer endlicher Automat läßt sich leicht in ein Programm zur Worterkennung umwandeln; dies benötigt die Q × Σ-Tabelle δ, den jeweils aktuellen Zustand (zunächst

q0 ), das gerade gelesene Zeichen und F , also konstanten Platzbedarf; jedes Zeichen wird in

konstanter Zeit verarbeitet , das Wort also in linearer Zeit gelesen (gemessen an der Wortlänge).

Satz 2.13 (Hauptsatz über endliche Automaten). Zu jeder regulären Sprache L gibt es effektiv

einen vollständigen (und daher deterministischen) endlichen Automaten A mit L(A) = L.

Beweis. Potenzautomatenkonstruktion von Myhill :

Nach 2.7 sei A′ ein buchstabierender endlicher Automat mit L(A′ ) = L.

Idee: A merkt sich in jedem seiner Zustände alle Zustände von A′ , in die A′ beim Lesen

einer gegebenen Eingabe geraten kann.

Also: Q := P(Q′ ), q0 = {q0′ } ,

δ(P, a) = {q ∈ Q′ | ∃p ∈ P mit (p, a, q) ∈ δ′ }

Idee: Nach dem „bisher gelesenen v“ kann A′ in jedem p ∈ P sein; ist (p, a, q) ∈ δ′ , kann

A′ nach va in q sein.

Offenbar ist A deterministisch und sogar vollständig.

F = {P ⊆ Q′ | P ∩ F ′ 6= ∅}.

Idee: Ist A im „Superzustand“ P ∈ F , könnte A′ in p ∈ P ∩ F ′ sein und akzeptieren.

Um zu zeigen, daß L(A) = L(A′ ), zeigen wir durch Induktion über |w|:

(∗) (q0 , w, P ) ∈ δ∗ ⇐⇒ P = q ∈ Q′ | (q0′ , w, q) ∈ δ′∗

Variante 1:

Induktionsanfang: |w| = 0, d.h. w = λ :

(q0 , λ, P ) ∈ δ∗ ⇐⇒ P = q0 = {q0′ } = {q ∈ Q′ | (q0′ , λ, q) ∈ δ′∗ }

rend!)

(A und A′ sind buchstabie-

Induktionsschritt: Sei w ∈ Σ∗ und a ∈ Σ, wobei w nach Ind.ann. (∗) erfüllt:

(q0 , wa, P ) ∈ δ∗

Def.δ∗

⇐⇒

(q0 , w, P ′ ) ∈ δ∗ ∧ (P ′ , a, P ) ∈ δ (A buchst.)

⇐⇒

IAnn

P ′ = {p ∈ Q′ | (q0′ , w, p) ∈ δ′∗ } ∧ (P ′ , a, P ) ∈ δ

Def.δ

P ′ = . . . ∧ P = {q ∈ Q′ | ∃p ∈ P ′ : (p, a, q) ∈ δ′ }

P = {q ∈ Q′ | ∃p ∈ Q′ : (q0′ , w, p) ∈ δ′∗ ∧ (p, a, q) ∈ δ′ }

⇐⇒

⇐⇒

Def.δ′∗

⇐⇒

Prof. Dr. W. Vogler

P = {q ∈ Q′ | (q0′ , wa, q) ∈ δ′∗ } (A′ buchst.)

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

12

(∗) δ∗ (q0 , w) = q ∈ Q′ | (q0′ , w, q) ∈ δ′∗

Variante 2:

Induktionsanfang: |w| = 0, d.h. w = λ : δ∗ (q0 , λ) = q0 = {q0′ } = {q ∈ Q′ | (q0′ , λ, q) ∈ δ′∗ }

(A und A′ sind buchstabierend!)

Induktionsschritt: Sei w ∈ Σ∗ und a ∈ Σ, wobei w nach Ind.ann. (∗) erfüllt:

δ∗ (q0 , wa)

(∗)

Def.δ∗

δ(δ∗ (q0 , w), a) = δ({p ∈ Q′ | (q0′ , w, p) ∈ δ′∗ } , a)

Def.δ

{q ∈ Q′ | ∃p ∈ Q′ : (q0′ , w, p) ∈ δ′∗ ∧ (p, a, q) ∈ δ′ }

=

=

Def.δ′∗

{q ∈ Q′ | (q0′ , wa, q) ∈ δ′∗ }

=

Nun gilt für alle w ∈

Varianten ✷

Σ∗ :

(∗)

w ∈ L(A) ⇐⇒ δ∗ (q0 , w) ∈ F ⇐⇒

q ∈ Q′ | (q0′ , w, q) ∈ δ′∗ ∩ F ′ 6= ∅

Def. F

(q0′ , w, q)

′

⇐⇒ ∃q ∈ F mit

∈ δ′∗ ⇐⇒ w ∈ L(A′ )

✷

a

b

a

1

λ

A'

c

7

6

2

a

3

4

a

Beispiel 2.14.

8

b

c

5

a

a

1

b

X

2

buchstabierend

a

a

3

c

7

6

a

4

8

b

c

5

Da A exponentiell viele Zustände im Vergleich zu A′ haben kann, wollen wir im letzten,

entscheidenden Schritt immer nur den erreichbaren Teil von A erzeugen; dabei kann hier

Zustand 3 keine Rolle spielen.

a

a

1

b,c

a,b,c

{}

a

4,6

c

2

b

a,b

7,8

a

c

b,c

A

2,5

b,c

Fangzustand

Der Fangzustand hat nur einlaufende Kanten, und insbesondere eine Schlinge für jedes

Zeichen.

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

13

Wie macht man einen deterministischen Automaten vollständig?

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

2.4

14

Abschlusseigenschaften, Entscheidbarkeitsprobleme und Simulation

Eine Abschlusseigenschaft ist z.B.: Die natürlichen Zahlen sind abgeschlossen unter Addition.

(Gegenbsp.: unter Differenz) In unserem Kontext geht es darum, ob die Menge der regulären

Sprachen unter gewissen Operationen abgeschlossen ist. Solche Abschlußeigenschaften können

nützlich sein um zu begründen, warum eine Sprache regulär ist (s. Beispiel 2.17), oder auch

warum sie nicht regulär ist: Ist L1 regulär, L1 ∪ L2 aber nicht, so kann nach dem folgenden

Satz auch L2 nicht regulär sein.

Auch werden sich Abschlußeigenschaften im nächsten Abschnitt als sehr nützlich erweisen.

Satz 2.15. Seien E ⊆ Σ∗ endlich und L1 , L2 ⊆ Σ∗ regulär. Dann sind (effektiv) regulär:

i) E

ii) L1 ∪ L2

iii) L1 · L2

iv) L∗1

Beweis. Nach Definition 2.3 existieren A1 , A2 zu L1 , L2 .

i) E = {w1 , . . . , wn } ist regulär wegen

ii) Vereinige A1 , A2 disjunkt; füge neuen Startzustand q0 und λ-Kanten zu q01 und q02

hinzu.

iii) Vereinige A1 , A2 disjunkt; setze

iv) Nach derselben Idee könnten wir

Dann fehlt aber evtl.

Aber:

Also:

✷

Wegen ii)–iv) sagt man: Die regulären Sprachen sind effektiv abgeschlossen unter (endlicher)

Vereinigung, Konkatenation und Sternbildung.

Satz 2.16.

i) Die regulären Sprachen sind effektiv unter Komplementbildung abgeschlossen, d.h. ist L ⊆ Σ∗ regulär, so auch L := Σ∗ − L.

ii) Die regulären Sprachen sind effektiv unter (endlichem) Durchschnitt abgeschlossen.

Beweis.

i) Sei nach Satz 2.13 A ein vollständiger endlicher Automat mit L(A) = L. Transformiere A in A′ mit F ′ = Q − F , man vertauscht also End- und Nicht-Endzustände.

Da δ∗ eine Funktion ist, gilt

w ∈ L ⇐⇒ δ∗ (q0 , w) ∈ F ⇐⇒ δ′∗ (q0′ , w) ∈

/ F ′ ⇐⇒ w ∈

/ L(A′ ).

ii) Folgt aus i) mit 2.15 ii) und L1 ∩ L2 = L1 ∪ L2 = Σ∗ − ((Σ∗ − L1 ) ∪ (Σ∗ − L2 )).

✷

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

15

Beispiel 2.17. i) Es läßt sich leicht ein EA (nicht so leicht aber ein DEA) finden zu L =

{w ∈ {a, b}∗ | w enthält das zusammenhängende Teilwort aaba}. Daher ist auch L regulär;

wie ein EA zu L aussieht, ist aber nicht so offensichtlich.

ii) L = {w ∈ {a, b}∗ | |w|a = |w|b } ist nicht regulär; sonst wäre auch L ∩ {a}∗ {b}∗ = {an bn |

n ≥ 0} regulär.

Satz 2.18. Es ist entscheidbar, ob für

i) einen gegebenen endlichen Automaten A L(A) leer bzw. = Σ∗ ist;

ii) zwei gegebene endliche Automaten A1 , A2 mit demselben Alphabet Σ gilt: L(A1 ) ⊆

L(A2 ), bzw. A1 und A2 sind äquivalent.

Beweis.

i) Leerheit: Mit einem effizienten Graphenalgorithmus (Tiefen- oder Breitensuche, vgl. Informatik III) ermittelt man, ob es einen Weg vom Start- zu einem Endzustand

gibt.

= Σ∗ : Wir berechnen den „Komplementautomaten“ wie im Beweis von Satz 2.16 i) –

das ist aufwendig!! – und prüfen ihn auf Leerheit der Sprache.

ii) Sind A1 , A2 gegeben, so können wir nach obigen Ergebnissen einen endlichen Automaten

A3 konstruieren, mit L(A3 ) = L(A1 ) ∩ (Σ∗ − L(A2 )). Es ist L(A3 ) = ∅ genau dann,

wenn L(A1 ) ⊆ L(A2 ); mit i) ist dies entscheidbar und damit auch L(A1 ) = L(A2 )

entscheidbar.

✷

Wir wollen noch eine Methode behandeln, mit der man die Frage angehen kann, ob L(A1 ) ⊆

L(A2 ). Diese Methode ist vor allem auch für Transitionssysteme geeignet; ein Transitionssystem entspricht weitgehend einem endlichen Automaten, es kann aber auch unendlich sein;

dann sind die Verfahren aus obigem Beweis natürlich nicht anwendbar. Außerdem hat es nur

Endzustände. (Deswegen muß man einfach kein F angeben.)

Sind Transitionssysteme systematisch gegeben, kann man evtl. auch im unendlichen Fall

eine Simulation (s.u.) finden und damit die Sprachinklusion nachweisen. Sprachinklusion läßt

sich so interpretieren, daß System A1 nur Verhalten zeigt, das auch bei A2 erlaubt ist, so daß

wir A1 als Implementierung der Spezifikation A2 ansehen können, s.u.

Definition 2.19. Eine Simulation für endliche Automaten A1 und A2 mit demselben Alphabet Σ ist eine Relation S ⊆ Q1 × Q2 mit folgenden Eigenschaften:

i) (q01 , q02 ) ∈ S

ii) Ist (q1 , q2 ) ∈ S und (q1 , α, p1 ) ∈ δ1 (also α ∈ Σ∪{λ}), so gibt es p2 ∈ Q2 mit (q2 , α, p2 ) ∈

δ2∗ (!) und (p1 , p2 ) ∈ S.

iii) Ist (q1 , q2 ) ∈ S und q1 ∈ F1 , so auch q2 ∈ F2 . (kann bei Transitionssystemen wegfallen)

Satz 2.20. Ist S eine Simulation für endliche Automaten A1 und A2 , so gilt L(A1 ) ⊆ L(A2 ).

Beweis. Ist w ∈ L(A1 ), so gibt es (q01 , α1 , q11 ), (q11 , α2 , q21 ), . . . , (q(m−1) 1 , αm , qm1 ) ∈ δ1 mit

αi ∈ Σ ∪ {λ}, w = α1 · · · αm und qm1 ∈ F1 . Nach Definition 2.19 i) ist (q01 , q02 ) ∈ S; also gibt

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

16

es mit wiederholter Anwendung von ii) (q02 , α1 , q12 ), (q12 , α2 , q22 ), . . . , (q(m−1) 2 , αm , qm2 ) ∈ δ2∗

– also (q02 , w, qm2 ) ∈ δ2∗ – mit (qm1 , qm2 ) ∈ S; nach iii) ist also auch qm2 ein Endzustand, und

damit w ∈ L(A2 ).

✷

1

A1

a

2

a

23

c

5

b

4

1

A'1

a

3

b

4

1

A2

λ

2

c

λ

b

3

4

c

5

c

b

5

1

A'2

4

5

Abbildung 4:

Abbildung 4 zeigt zwei sprachäquivalente Automaten A1 und A2 ; eine Simulation für diese

ist S = {(1, 1), (2, 23), (3, 23), (4, 4), (5, 5)}. Für A2 und A1 gibt es aber keine Simulation,

denn 23 hat eine b- und eine c-Kante, für einen simulierenden Zustand müßte das auch gelten

– aber einen solchen Zustand hat A1 nicht. Ähnlich können sich A′1 und A′2 aber gegenseitig

simulieren.

Die Methode ist also korrekt, aber nicht vollständig. Das wesentliche Problem dabei ist der

Nichtdeterminismus. Weiter beschränken wir A1 in Satz 2.21 auf den Fall, daß von jedem

Zustand ein Weg zu einem Endzustand führt; das ist keine wesentliche Einschränkung, da

andere Zustände für die Sprache von A1 irrelevant sind.

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

17

Satz 2.21. Seien A1 und A2 endliche Automaten mit demselben Alphabet Σ; in A1 gebe es

von jedem Zustand einen Weg zu einem Endzustand, und A2 sei deterministisch. Ist L(A1 ) ⊆

L(A2 ), so gibt es eine Simulation S für A1 und A2 .

Beweis. Wir setzen S = {(q1 , q2 ) | ∃w ∈ Σ∗ : (q01 , w, q1 ) ∈ δ1∗ ∧ (q02 , w, q2 ) ∈ δ2∗ }. Beachte,

daß q2 durch w eindeutig bestimmt ist, da A2 deterministisch ist.

Für den Fall w = λ ergibt sich (q01 , q02 ) ∈ S.

Ist (q1 , q2 ) ∈ S und q1 ∈ F1 , so ist w ∈ L(A1 ), also auch w ∈ L(A2 ), und wegen der

Eindeutigkeit von q2 muß q2 ∈ F2 sein.

Sei nun (q1 , q2 ) ∈ S wegen w und (q1 , α, p1 ) ∈ δ1 ; nach Voraussetzung gibt es v mit

(p1 , v, p) ∈ δ1∗ und p ∈ F1 , d.h. wαv ∈ L(A1 ). Da nun auch wαv ∈ L(A2 ), gibt es einen

wαv-beschrifteten Weg von q02 zu einem Endzustand, der wegen der Eindeutigkeit über q2

und ein p2 führen muß mit (q2 , α, p2 ) ∈ δ2∗ . (Entweder ist α ∈ Σ und (q2 , α, p2 ) ∈ δ2 oder

α = λ und q2 = p2 .) Jetzt ist (q01 , wα, p1 ) ∈ δ1∗ ∧ (q02 , wα, p2 ) ∈ δ2∗ , also (p1 , p2 ) ∈ S.

✷

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

2.5

18

Induktive Definition von Termen

Der nächste Abschnitt verbindet die endlichen Automaten mit einer Term-Darstellung von

formalen Sprachen. Dazu befassen wir uns zunächst etwas formaler mit sehr einfachen Termen

– auch als Vorbereitung auf die Logik in Kapitel 4 – und geben eine induktive AufbauDefinition:

Definition 2.22. Die Menge SimT der (besonders) einfachen Terme ist die (bzgl. ⊆) kleinste

Menge mit

i) a, b, c, d ∈ SimT

ii) Sind v, w ∈ SimT , so auch (v + w) ∈ SimT .

iii) Sind v, w ∈ SimT , so auch (v − w) ∈ SimT .

Z.B. sind a, (b − c), ((b + c) − (c + a)) ∈ SimT . „kleinste Menge“ bedeutet, dass Wörter

nur dann in SimT sind, wenn dies aufgrund der Regeln i)-iii) zwingend ist. Nur nach diesen

Regeln aufgebaute Objekte sind einfachen Terme (e.T.), man kann also für jeden e.T. eine

Herleitung angeben. Z.B. sind Herleitungen von (b + c) und (c + a), jeweils der Länge 3:

• b wg. i), c wg. i) und (b + c) wg. ii).

• .

Systematisch bekommen wir dann folgende Herleitung von ((b + c) − (c + a)) (es geht aber

auch kürzer):

b wg. i), c wg. i), (b + c) wg. ii), .

Wir erkennen an diesem Beispiel: Jede Herleitung für einen e.T. außer a, b, c und d enthält

Herleitungen für die beiden unmittelbaren Teilterme.

Definition 2.22 entspricht einer Induktion über die Herleitungslänge: Hier gewinnt man mit

i) alle e.T. der Herleitungslänge 1 – es könnte aber mehrere Regeln zu dieser Länge geben; mit

ii) und iii) gewinnt man einen e.T. der Herleitungslänge n aus zwei e.T. der Herleitungslänge

< n – es gibt hier also mehrere solcher Regeln.

Zusammenfassend: Sind alle Objekte mit einer Herleitungslänge m < n bereits hergeleitet,

kann man aus ihnen jedes Objekt der Herleitungslänge n mit jeweils einer Regelanwendung

gewinnen.

Man kann nun Beweise oder weitere Definitionen für e.T.s mittels Induktion über die Herleitungslänge angeben, wobei es für jede Regel einen Fall gibt. Beschreibt die ursprüngliche

Definition den Aufbau von Objekten durch Zusammensetzen wie in unserem Beispiel, spricht

man dann von einem induktiven Beweis oder einer induktiven Definition über den Aufbau

(hier: eines e.T.) oder von struktureller Induktion (hier: über einen e.T.). Z.B.:

Beispiel 2.23. Jeder e.T. hat mindestens so viele ( wie +.

Beweis. mit struktureller Induktion:

i) a, b, c, d: Beide Anzahlen sind 0.

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

19

ii) (v +w): Anzahl von ( in (v +w) ist die Summe der Anzahlen von ( in v und w plus 1; dies

ist nach Ind. (v, w haben kürzere Herleitungen) mindestens die Summe der Anzahlen

von + in v und w plus 1, was gerade die Anzahl von + in (v + w) ist.

iii) (v − w): Anzahl von ( in (v − w) ist die Summe der Anzahlen von ( in v und w plus 1;

dies ist nach Ind. größer als die Summe der Anzahlen von + in v und w, was gerade die

Anzahl von + in (v − w) ist.

✷

Das Vorgehen im Beweis entspricht dem folgenden Induktionsprinzip der Noetherschen Induktion (well-founded induction), vgl. Diskrete Strukturen für Informatiker, wenn man speziell

unter A(n) versteht, dass alle e.T. der Herleitungslänge n mindestens so viele ( wie + haben.

Proposition 2.24. Sei A(n) eine Aussage über die natürliche Zahl n. Angenommen, es gilt

für alle n ∈ N das folgende: Wenn A(m) für alle m mit m < n gilt, so gilt auch A(n). Dann

gilt A(n) für alle n ∈ N.

Statt < auf N gilt dies Prinzip für alle Noetherschen Halbordnungen ❁ auf beliebigen

Mengen, d.h. wenn es keine unendlichen absteigenden Ketten bzgl. ❁ gibt.

Wir haben hier eine stärkere Ind.vor., was den Beweis der Ind.beh. erleichtern kann, und

keine Verankerung. Warum dürfen wir so verfahren?

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

2.6

20

Rationale Ausdrücke und der Satz von Kleene

Definition 2.25. Die Menge der rationalen Ausdrücke über Σ, Rat(Σ∗ ), ist induktiv definiert

durch:

i) ∅, λ, a für a ∈ Σ sind rationale Ausdrücke und bezeichnen ∅, {λ}, {a}.

ii) Bezeichnen r, s ∈ Rat(Σ∗ ) die Mengen R und S, so sind (r + s), (rs) und r ∗ rationale

Ausdrücke und bezeichnen R ∪ S, RS und R∗ .

L ⊆ Σ∗ heißt rational, wenn L durch einen rationalen Ausdruck r bezeichnet wird. Wir

schreiben L = L(r) (falls diese Unterscheidung notwendig ist); z.B. {ab, ac} = L(a(b + c)).

r + ist Abkürzung für r · r ∗ , also L(r + ) = L(r)+ .

Bemerkung:

∗

bindet stärker als · bindet stärker als + =⇒ Klammern sparen.

Satz 2.26 (Satz von Kleene). Eine Sprache L ist genau dann rational, wenn sie regulär ist.

(Daher spricht man auch oft von regulären Ausdrücken.)

Beweis(„=⇒“). Strukturelle Induktion gemäß der Aufbau-Definition der rationalen Ausdrücke

(Definition 2.25).

i) Für r = ∅, r = λ, r = a ist L(r) regulär nach 2.15.

ii) Seien r, s ∈ Rat(Σ∗ ); Annahme: L(r) und L(s) sind regulär.

a) L(r+s) = L(r)∪L(s) ist regulär nach 2.15 ii) und Annahme, dass L(r) und L(s) regulär

sind.

b) L(rs) = L(r)L(s) nach 2.15 iii) und Annahme regulär.

c) L(r ∗ ) = L(r)∗ nach 2.15 iv) und Annahme regulär.

✷

Beweis(„⇐=“). Sei A ein endlicher Automat mit L(A) = L; o.E. Q = {1, . . . , n}. Wir definieren:

Lkij = {u ∈ Σ∗ | ∃ einen mit u beschrifteten Weg in A, der bei i beginnt, bei j endet und

im Inneren nur Zustände ≤ k benutzt}

S

Sei q0 = 1. Dann ist L(A) = j∈F Ln1j ; daher genügt es zu zeigen, daß Lnij rational ist.

(Dann kann man die Summe der passenden rationalen Ausdrücke bilden.) Um eine Induktion

zu ermöglichen, zeigen wir mehr: Lkij ist rational für k = 0, . . . , n.

k = 0: L0ij = {u ∈ Σ∗ | (i, u, j) ∈ δ} (bzw. . . . ∪ {λ}, falls i = j) ist endlich, also rational.

∗

k−1

k−1

k−1

k−1

∪ Lij

ist rational nach Induktionsannahme mit

Lkj

Lkk

1 ≤ k ≤ n: Lkij = Lik

einem rationalen Ausdruck der Form

✷

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

21

Meistens unterscheidet man nicht zwischen r und L(r), spricht also z.B. von der Sprache

(aa)∗ a + a(bb)∗ . In diesem Abschnitt wollen wir die Unterscheidung aber beibehalten.

Mit der Sichtweise, daß Elemente a von Σ Aktionen sind (die ein System ausführen soll),

sind rationale Ausdrücke abstrakte Programme (von kontextfreien Grammatiken erzeugt).

a =

b

statement

=

b „führe a aus“

+ =

b if–then–else =

b Auswahl (von if-Bedingung abstrahiert)

=⇒ Prozeß–Algebra

· =

b

;

=

b Hintereinanderausführung

∗ =

b

while–do

=

b beliebige Wiederholung

Jeder rationale Ausdruck bezeichnet eine Menge von möglichen Aktionsfolgen (= Sprache);

dies ist eine denotationelle Semantik. Jeder rationale Ausdruck kann in einen endlichen Automaten übersetzt werden (vgl. 2.26 bzw. 2.15), eine Maschine, die die gewünschten Aktionsfolgen ausführt; dies ist eine operationale Semantik. (übliche Programmiersprache: denotationell

∼ Ein–/Ausgabefunktion; operational ∼ Maschinenmodell – beschreibt die Programmabarbeitung)

Rationale Ausdrücke entsprechen sequentiellen Programmen; für parallele (bzw. nebenläufige) Programme wurden als Erweiterung der rationale Ausdrücke Prozeßalgebren eingeführt.

In diesem Sinn kann man das Programm r = (abac)∗ als Implementierung der Spezifikation

s = (a(b + c))∗ auffassen, da alle (endlichen) Abläufe von r (d.h. Wörter aus L(r)) auch von

s erlaubt werden (Wörter in L(s) sind). Damit wird von Automaten auf rationale Ausdrücke

übertragen, was schon oben gesagt wurde: Sprachinklusion lässt sich so interpretieren, dass

System A1 nur Verhalten zeigt, das auch bei A2 erlaubt ist, so dass wir A1 als Implementierung

der Spezifikation A2 ansehen können.

Definition 2.27. Für rationale Ausdrücke r und s ist r eine Implementierung der Spezifikation

s, in Zeichen: r ⊑ s, wenn L(r) ⊆ L(s). Man nennt r auch eine Verfeinerung (verfeinerte

Spezifikation).

Während ⊆ eine Halbordnung ist, ist ⊑ nur eine Präordnung, also nicht . . . . . . . Z.B. gilt

für r = ab + ac und s = a(b + c), dass r ⊑ s und s ⊑ r; r und s sind aber nicht identisch.

Bemerkung: Wenn man eine Implementierungsrelation als „wird simuliert von“ definiert

(und dazu rationale Ausdrücke mit den zugehörigen Automaten gleichsetzt), so ist r Implementierung von s (vgl. A1 und A2 in Abb. 4), nicht aber umgekehrt. Simulation stellt also

strengere Anforderungen an Implementierungen: s entscheidet später zwischen b und c als r,

das ist bei Simulation nicht zulässig.

Für Implementierungsrelationen wie ⊑ ist es wichtig, dass sie ein kompositionales Vorgehen

beim Systementwurf unterstützen: Hat man eine Spezifikation s + t und weiß, dass r ⊑ s, so

erwartet man, dass man die Komponente s durch r ersetzen darf und damit eine Verfeinerung

erhält. Es soll also aus r ⊑ s folgen, dass r + t ⊑ s + t.

Damit sind ⊑ und + verträglich wie man es von ≤ und + bei reellen Zahlen kennt. Formal

gesagt, soll die Präordnung ⊑ eine Präkongruenz sein.

Definition 2.28. Eine Präordnung ⊑ ist eine Präkongruenz für eine zweistellig Operation ◦

bzw. eine einstellige Operation f , wenn für alle r, s und t aus r ⊑ s folgt, dass r ◦ t ⊑ s ◦ t

und t ◦ r ⊑ t ◦ s bzw. f (r) ⊑ f (s).

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

22

Satz 2.29. Auf den rationalen Ausdrücken ist ⊑ eine Präkongruenz für die relevanten Operationen, d.h. für alle rationalen Ausdrücke r, s und t folgt aus r ⊑ s:

i) r + t ⊑ s + t und t + r ⊑ t + s

ii) rt ⊑ st und tr ⊑ ts

iii) r ∗ ⊑ s∗

Beweis. Wir beschränken uns auf den schwierigsten Fall iii). Sei also r ⊑ s.

Dann gilt für jedes n: L(r)n = {w1 . . . wn | wi ∈ L(r), i = 1, . . . , n}, welches nach Voraussetzung enthalten ist in {w1 . . . wn | wi ∈ L(s), i = 1, . . . , n} = L(s)n .

S

S

Damit erhalten wir L(r ∗ ) = L(r)∗ = n≥0 L(r)n ⊆ n≥0 L(s)n = L(s)∗ = L(s∗ ).

✷

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

2.7

23

Lexikalische Analyse — (F)LEX

Erste Phase der Compilation; der sogenannte Lexer zerlegt das C–/. . .–Programm in lexikalische Einheiten (Symbole, tokens) wie:

• Bezeichner

• Zahlen

• reservierte Wörter (for, if, then,. . . )

• Kommentare

Diese Mengen von Symbolen sind jeweils regulär, der Lexer ist also im wesentlichen ein (möglichst kleiner) vollständiger Automat — bzw. eine Kombination von Automaten (je Symbolart

einer) bzw. ein Automat mit getypten Endzuständen. Dabei versucht der Lexer ein Symbol

zu erkennen und führt dann ggf. eine vorgeschriebene Aktion aus; danach wiederholt er dies

Vorgehen, bis die Eingabe abgearbeitet ist.

Erzeugen von Lexern unter UNIX: (F)LEX.

(F)LEX erzeugt aus einer Lex-Spezifikation

ein C–Programm lex.yy.c, dessen Funktion yylex eine lexikalische Analyse durchführt.

Lex–Spezifikation: %{evtl. selbstgeschriebener Anfang des C–Programms, z.B.

#include <stdio.h>

%}

%%

(Regel–Sektion): (Muster Aktion)∗

%%

selbstgeschriebenes Ende, z.B.:

main()

{yylex();

}

Muster (pattern) sind reguläre Ausdrücke (müssen am Zeilenanfang stehen), Aktionen sind

C–Statements (dürfen nicht am Zeilenanfang stehen); z.B.:

[\t␣]+

[a-zA-Z][a-zA-Z0-9]*

[^\t␣\n]+

.|\n

/* Leerzeichen ignorieren*/;

{printf ("%s ist Bezeichner\n", yytext);}

{printf ("%s ist kein Bezeichner\n",yytext);}

{ECHO;/*ausgeben*/}

Der Lexer liest ein möglichst langes Anfangsstück w der Eingabe, das auf ein Muster paßt

nach yytext, führt die zugehörige Aktion aus und wiederholt dies bis zum Ende der Eingabe;

paßt w auf mehrere Muster, so wird das erste gewählt. Für a2+␣ passt Muster 2 auf a2 und

3 auf a2+, also wird 3 gewählt; für a2␣ passen Muster 2 und 3 auf a2, also wird 2 gewählt.

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

[ ]

[\t␣]+

[a-z]*

[^az]

\n

|

.

24

schließt Zeichen ein; [\t␣] ist also {TAB, BLANK}

eine Folge von Leerzeichen (6= λ); die zugehörige Aktion ist „;“, also leer.

ist {a, b, c, . . . , z}∗

Menge aller Zeichen ∈

/ {a, z}

newline, Zeilenvorschub

Auswahl z.B. steht ([a-d]*(bc|bd)+)|a* für (a + b + c + d)∗ (bc + bd)+ + a∗

paßt auf jedes Zeichen außer \n

Nach obiger Regel wird das vierte Muster nur gewählt, wenn die ersten drei nicht passen.

Man vermeide Muster (wie ein alleinstehendes [a-z]*), die auf λ passen; sie können zur

Nichtterminierung führen, da λ wiederholt ohne Fortschritt erkannt werden kann.

Bemerkung:

• r? stehr für r + λ.

• Steuerzeichen wie z.B. + steht in [ ] für Zeichen +; sonst schreibt man \+ für das

Zeichen + (durch \ geschützt).

Beschränken wir die Eingabe auf Folgen von Wörtern über {a, b, . . . , z} (getrennt durch

␣), so prüft z.B. der Lexer gemäß folgender Lex-Spezifikation, welche Wörter zu (ab)∗ a passen:

%{#include

%}

%%

[\t␣]+

(ab)*a

[a-z]+

.|\n

%%

main()

{yylex();

}

<stdio.h>

/* Leerzeichen ignorieren*/;

{printf ("%s ist o.k.\n", yytext);}

{printf ("%s ist nicht o.k.\n", yytext);}

{ECHO;/*ausgeben*/}

Verwendung: Lex–Spezifikation in Datei myspec.l

> flex myspec.l

> cc lex.yy.c -o mylexer -ll

> mylexer Text ^D

(Evtl. muß die Option -ll durch -lfl oder mylexer durch ./mylexer ersetzt werden. Evtl.

erst return, dann Text mit return abschließen; ggf. wiederholen; Programmende mit ^D.)

Ist der Text z.B. abba ababa abac, so liefert mylexer:

abba

ist nicht ok

ababa

ist ok

abac

ist nicht ok

Um den Text aus einer Datei eingabe zu lesen, lautet der Aufruf mylexer < eingabe.

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

2 ENDLICHE AUTOMATEN

25

Anstatt nur „ok/nicht ok“ oder Symboltypen auszugeben, wird der Lexer in der Praxis z.B.

Bezeichner mit Typinformation in eine Tabelle eintragen.

Genaueres zur Syntax und Kooperation mit Compilern: J.R. Levine et al.: Lex & yacc,

O’Reilly, 1995.

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

3 MEALY-AUTOMATEN

3

26

Mealy-Automaten

Endliche Automaten lesen und untersuchen Zeichenfolgen. Eine andere Sichtweise ist, dass

sie Zeichenfolgen erzeugen, wobei die Zeichen als Aktionen oder Signale verstanden werden

können; in Endzuständen kann der Automat terminieren, muss aber nicht unbedingt. Werden

die Zeichen als Aktionen gesehen, lässt man die Endzustände oft weg und spricht von Transitionssystemen, die auch unendlich sein dürfen; ein solches System kommt zum Stillstand, wenn

es einen Zustand ohne ausgehende Kanten erreicht, den man oft als Verklemmung versteht.

Mealy-Automaten kombinieren beide Sichtweisen: Deterministisch lesen sie Eingabezeichen

und beantworten sie jeweils mit einem Ausgabezeichen. Welche Eingaben kommen, wird von

der Umgebung bestimmt; der Automat kümmert sich daher nicht um Akzeptieren oder Terminierung und hat keine Endzustände.

Mealy-Automaten eignen sich u.a. zur Modellierung von Schaltkreisen; da Schaltkreise im

Allgemeinen mehrere Eingaben und Ausgaben haben, ist hier ein Eingabezeichen ein Tupel,

das für jedes Eingabesignal einen Wert festlegt (1 oder 0, + oder −); Ausgabezeichen werden

ggf. analog behandelt; vgl. auch Kap. 7.

Der folgende Mealy-Automat führt eine serielle (auch: sequentielle) Addition durch. Die

Eingabe besteht aus zwei Binärzahlen, wobei jeweils die beiden Ziffern einer Stelligkeit von

rechts nach links eingegeben werden und die Ziffer derselben Stelligkeit ausgegeben wird. Der

Automat muss sich im Zustand merken, ob ein Übertrag aufgelaufen ist.

00 / 1

00 / 0

01 / 1

10 / 1

0

1

11 / 0

01 / 0

10 / 0

11 / 1

Abbildung 5:

Definition 3.1. Ein Mealy-Automat (MlA) über dem Eingabealphabet Σ und dem Ausgabealphabet ∆ ist ein Tupel A = (Q, Σ, ∆, δ, γ, q0 ), wobei:

• Q—

• q0 ∈ Q —

• δ — Übergangsfunktion δ

• γ — Ausgabefunktion γ

Wie bei endlichen Automaten erweitern wir δ zu δ∗ : Q × Σ∗ → Q und wie folgt analog γ

zu γ ∗ : Q × Σ∗ → ∆∗ :

• γ ∗ (q, λ) =

• γ ∗ (q, wa) =

für a ∈ Σ, w ∈ Σ∗

Die Leistung von A ist dann γA : Σ∗ → ∆∗ mit γA (w) = γ ∗ (q0 , w).

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

3 MEALY-AUTOMATEN

27

Mit dieser Definition ist die Leistung des obigen MlA tatsächlich Serienaddition im folgenden Sinn: Ein w ∈ ({0, 1}2 )∗ entspricht dem Paar (k1 , k2 ) ∈ N2 , wenn ki binär rückwärts „in

i-ter Zeile steht“, z.B. (7, 10) entspricht 10 11 10 01 00 ; beginnen beide Binärdarstellungen

mit mindestens einer 0 beginnen, so entspricht γA (w) k1 + k2 .

r

s

x

y

Abbildung 6:

Als nächstes wollen wir den Schaltkreis in Abbildung 6 als MlA modellieren. Dieser Schaltkreis hat Eingänge r und s, den Ausgang x (bzw. x′ s.u.) und ein internes Signal y; neben den

üblichen Gattern (hier „oder“ und (dicker) Negationspunkt, die jeweils zusammen ein NOR

ergeben) hat dieser Schaltkreis zwei Verzögerungsglieder bzw. Register.

Ohne diese kann man den Schaltkreis als asynchronen Schaltkreis mit folgendem Verhalten

verstehen. Der Schaltkreis befindet sich in einem stabilen Zustand, z.B. rsxy = 1001; wenn

dann die Eingabe auf 01 gesetzt wird, liefert das linke NOR immer noch 0, aber y ändert

sich auf 0; erst jetzt ändert sich x auf 1, und der Zustand ist wieder stabil. Um Probleme zu

vermeiden, muss hierbei die Umgebung die Eingaben auf 01 halten, bis Stabilisierung eintritt

– der Schaltkreis muss im sog. Fundamentalmodus betrieben werden. (Dann realisiert er ein

RS-Flip-Flop, s.u.) Solche mehrstufigen Übergänge sind konzeptionell offenbar schwierig.

Einfacher sind getaktete Schaltkreise, die in der Praxis vorherrschend sind. Hier puffern

die Verzögerungsglieder die Werte von x und y, wobei wir gepufferte und Ausgabe-Signale als

lokale Signale bezeichnen.

Die Verzögerungsglieder liefern an ihren Ausgängen die alten Werte, auch wenn sich im

aktuellen Takt neue Werte für x und y ergeben – die wir mit x′ und y ′ bezeichnen wollen. Da

nach „Durchschneiden“ der Verzögerungsglieder ein kombinatorischer Schaltkreis (also ohne

Kreise) entsteht – das müssen und wollen wir fordern –, kann man gemäß „Pfeilrichtung“ (d.h.

von den Eingaben und den gepufferten Signalen aus) die neuen Werte für alle Drähte in einem

Durchgang bestimmen. Dieser Sichtweise wollen wir hier folgen.

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

3 MEALY-AUTOMATEN

xy \

rs

00

01

10

01

10

00

10

28

11

00

00

Der Zustand des Schaltkreises entspricht den Werten der gepufferten Signale x und y. Ist

dieser Zustand 01 wie oben und die nächste Eingabe ist wieder 01, so ist x′ y ′ = 00. Ist die

darauffolgende Eingabe wieder 01, geht der Schaltkreis nach 10, bei 11 aber bleibt er in 00.

Insgesamt bekommen wir obige Übergangstabelle, wenn wir als Startzustand 00 wählen und

die Eingabe 00 verbieten; daraus ergibt sich dann der MlA in Abbildung 7.

Abbildung 7:

Jetzt wollen wir an mehreren Beispielen den Entwurf eines Schaltkreises mit Mealy-Automaten untersuchen. Das erste Beispiel ist ein T-Flip-Flop; es hat Zustände 0 und 1, mit denen

es ein Bit (zunächst 0) speichert. Bei Eingabe a = 0 bleibt das Flip-Flop in seinem Zustand,

bei Eingabe 1 wechselt es seinen Zustand. Die Ausgabe ist gleich dem neuen Zustand; offenbar

entspricht der Zustand hier einem lokalen Signal q, mit q ′ als Ausgabesignal. Abbildung 8 zeigt

den MlA, aus dem wir wieder eine Tabelle gewinnen.

Zum Entwurf eines Schaltkreises empfiehlt es sich, die Tupel, die den möglichen Zuständen

und Eingaben entsprechen, wie auf der linken Seite einer Wahrheitstafel aufzulisten; dazu

muss man die Zustände binär codieren. Die Codierung ist hier schon gegeben; i.A. kann man

sie geschickt und weniger geschickt wählen. Auf der rechten Seite stehen die gestrichenen

Zustandssignale und die Ausgaben.

1/0

0/0

1

0

0/1

1/1

qa

00

01

10

11

q′

Abbildung 8:

Wir erkennen, dass es sich hier einfach um ein . . . handelt. Zur Realisierung mit StandardGattern (hier: AND, OR, NOT) kann man im Zweifel auf die disjunktive Normalform (s.

Kap. 4) zurückgreifen und erhält die Gleichung q ′ = . . . .

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

3 MEALY-AUTOMATEN

29

Es gibt also ein OR-Gatter mit Ausgabe q ′ ; diese Ausgabe führen wir über ein Verzögerungsglied zurück zu den Gattern, die q als Eingabe haben, und in diesem Fall auch als

Ausgabesignal nach draußen. Dies ergibt folgende Schaltung:

Abbildung 9:

Im Allgemeinen hat die Tabelle links die Eingaben und die Zustandssignale (die gepuffert

werden), rechts die Ausgaben und die (gestrichenen) Zustandssignale – die evtl. mit Ausgaben

zusammenfallen können.

Analog wollen wir nun einen Schaltkreis entwickeln, der mittels Eingabesignal a eine 0-1Folge erhält und sein Ausgabesignal x genau dann auf 1 setzt, wenn in der 0-1-Folge (inkl.

aktuelle Eingabe) der Block von 1en seit der letzten 0 (oder ab Anfang) eine durch 4 teilbare Länge (evtl. 0) hat. Es ergibt sich also bei der Eingabe 1011011111 die Ausgabe

0100100010.

pqa

000

001

010

011

100

101

110

111

p′ q ′ x

Abbildung 10:

Zunächst entwerfen wir einen Mealy-Automaten für das gewünschte Verhalten; dann codieren wir die Zustände geeignet – hier ohne eine ausgefeilte Methode. Zum Entwurf des

Schaltkreis stellen wir wieder eine Tabelle auf; vgl. Abbildung 10.

Aus der Tabelle lesen wir geeignete Gleichungen ab:

• p′ =

• q′ =

• x=

Dies führt auf die Schaltung in Abbildung 11.

Abbildung 11:

Das nächste Beispiel ist ein RS-Flip-Flop; Zustand und Ausgabe wie beim T-Flip-Flop.

Diesmal gibt es zwei Eingabesignale r und s: bei 00 bleibt das RS-Flip-Flop in seinem Zustand,

bei 01 wird der Zustand auf 1 (set), bei 10 auf 0 (reset) gesetzt; Eingabe 11 ist verboten.

Diesmal ist die Wahrheitstafel unvollständig; die freien Felder können wir nach Bedarf

füllen. Z.B. können wir ausnutzen, dass q ′ offenbar fast s ist. Dies führt auf q ′ =

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

3 MEALY-AUTOMATEN

30

Abbildung 12:

Eine andere Gleichung ist q ′ =

Sind die beiden Booleschen Ausdrücke äquivalent?

qrs

000

001

010

011

100

101

110

111

q′

Abbildung 13:

Natürlich sind auch MlAen durch ihr endliches Gedächtnis beschränkt; dies wird z.B. durch

folgendes konkretes Ergebnis demonstriert.

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

3 MEALY-AUTOMATEN

31

Satz 3.2. Es gibt keinen MlA zur seriellen Multiplikation, der also wie der Serienaddierer zwei

Binärzahlen als Eingabe bekommt und jeweils die entsprechende Stelle des Produkts ausgibt.

Beweis. Angenommen, A sei so ein MlA und habe weniger als n Zustände. Ein „Lauf“ bei der

Eingabe von (2n , 2n ) hätte also die Form

00/0

11/0

00/0

00/0

00/0

00/1

q0 −→ . . . −→ q1 −→ q2 −→ . . . −→ qn −→

(Nach der Ausgabe von n + 1 0en erreicht A q1 und nach 2n 0en qn .)

Offenbar gibt es 1 ≤ i < j ≤ n mit qi = qj . Da alle MlAen deterministisch sind, ist der

Ablauf nach qj bis qn derselbe wie nach qi , d.h. es gibt i ≤ k < n mit qk = qn . Dies führt zum

Widerspruch, da qk anders auf 00 reagiert als qn .

✷

Tatsächlich hängt die Ausgabe unserer bisherigen Beispiel-MlAen meist nur vom beim jeweiligen Übergang erreichten Zustand ab. Ein andersartiges Beispiel bekommt man, wenn

man bei dem obigen 1er-Block-Automaten verlangt, dass die Länge des 1er-Blocks zudem

positiv sein muss. Übung: Wie ändert sich die Schaltkreiskonstruktion und der Schaltkreis?

(Behalten Sie die Automatenzustände und ihre Codierung bei!)

Hier ein weiteres Beispiel: Abbildung 14 skizziert einen Spielautomaten. Bei A oder B kann

man wiederholt eine Kugel einwerfen; die Kugel wird durch die passierten „Türen“ bei x1 , x2

und x3 abgelenkt, die nach dem Ablenken in die jeweils andere Schrägstellung springen.

Üb.: Konstruiere einen Mealy-Automaten, der Folgen über {A, B} annimmt und jeweils

ausgibt, ob die letzte Kugel bei C oder D austritt.

A

x

B

x

2

1

x

C

3

D

Abbildung 14:

Auf die Frage, welche Funktionen f sich als Leistung eines MlA beschreiben lassen, werden

wir jetzt eine Antwort geben. Offenbar muss gelten, dass die Ausgabe genauso lang ist wie

die Eingabe, und dass f (v) ein Präfix von f (vw) ist.

• Die Funktion f : Σ∗ → ∆∗ heißt längentreu, falls |f (w)| = |w| für alle w ∈ Σ∗ .

• Die Funktion f heißt sequentiell, falls für alle v, w ∈ Σ∗ das Wort f (v) ein Präfix von

f (vw) ist, d.h. dass ein u ∈ ∆∗ existiert mit f (v)u = f (vw). Da dies u eindeutig

ist, können wir fv (w) = u definieren und erhalten damit eine Familie von Funktionen

f v : Σ ∗ → ∆∗ .

Ist nun jede längentreue und sequentielle Funktion Leistung eines MlA? Man betrachte die

Funktion f , die beschreibt, dass eine Eingabe aus {a, b} mit 1 beantwortet wird, wenn die

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

3 MEALY-AUTOMATEN

32

bisherige Folge von Eingaben die Form an bn hat, und mit 0 sonst. (Übung: Geben Sie eine

formale Def. von f ! )

Diese Funktion ist längentreu und sequentiell, aber offenbar müsste ein entsprechender MlA

die anfänglichen a zählen können. Anders ausgedrückt: Erreicht man mit an Zustand q, muss

q fan realisieren; alle fan sind verschieden (fan (bm ) endet auf 1 gdw. n = m). Das kann nicht

gehen.

• Das Gewicht von f ist die Anzahl der verschiedenen Funktionen fv .

Satz 3.3. Eine Funktion f : Σ∗ → ∆∗ ist genau dann die Leistung eines MlA, wenn sie

längentreu und sequentiell mit endlichem Gewicht ist.

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

4 AUSSAGENLOGIK

4

33

Aussagenlogik

Logik: formale Behandlung des exakten Denkens und Folgerns;

Grundlage aller vernünftigen Argumentation in Wissenschaft, Politik und

„am Stammtisch“

z.B. auch bei Themen wie Dunkle Materie, die es ja evtl. nicht gibt

beantwortet die Frage „Was ist ein mathematischer Beweis?“ (Hilbert 1920er)

in der Informatik:

• Korrektheitsbeweise (Verifikation) von Programmen, Schaltkreisen etc.; diese benötigen

Rechnerunterstützung; dazu: formale Angabe von Aussagen, speziell von

• Spezifikationen (Logik ist ausdrucksstark bzw. soll es sein)

• automatisches Beweisen

• logische Programmierung (PROLOG) (Beweis als Programmablauf)

• semantic web: Webseite um Inhaltsbeschreibung/-katalogisierung ergänzen – „Logik pur“

Literatur zum Thema Logik

M. Huth, M. Ryan: Logic in Computer Science. Modelling and reasoning about systems.

Cambridge University Press

M. Kreuzer, S. Kühling: Logik für Informatiker. Pearson Studium 2006

U. Schöning: Logik für Informatiker. BI-Wissenschaftsverlag, Reihe Informatik Bd. 56

Logische Formeln (wie auch Programme) sind Zeichenketten bzw. syntaktische Objekte,

z.B. P (x). Durch Interpretation der Symbole (z.B. P =

b „ist prim“) geben wir der Formel eine

Bedeutung (Semantik).

Hier behandeln wir keine Prädikatenlogik, sondern zunächst nur Aussagenlogik.

4.1

Syntax

Gegeben sei eine endliche oder abzählbar unendliche Zeichenmengen P von atomaren PFormeln p, q, r etc. – kurz Atomen.

Die Menge der (P-)Formeln (Aussagen) ist die kleinste Menge For P (For ) mit:

(A1) P ⊆ For

(A2) Ist A ∈ For , so auch (¬A) ∈ For

(A3) Sind A, B ∈ For , so auch (A ∧ B), (A ∨ B), (A → B), (A ↔ B) ∈ For

„kleinste Menge“ heißt: For enthält nichts, was nicht aufgrund dieser Regeln in For sein

muß; vgl. auch rationale Ausdrücke.

Wir führen die Formeln true und false ein als Abkürzungen für p0 ∨ ¬p0 und ¬true für ein

festes p0 ∈ P. Zur verkürzenden Schreibweise lassen wir meist – aber erst ab dem nächsten

Abschnitt!! – Klammern weg:

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

4 AUSSAGENLOGIK

34

• Außenklammern

• Klammern bei aufeinanderfolgenden Negationen: ¬¬A

• Linksklammerung bei A ∨ B ∨ C, A ∧ B ∧ C

• Bindungsstärke: ¬ ≫ ∧ ≫ ∨ ≫ → ≫ ↔

Wegen oben „kleinste Menge“ sind nur nach den drei Regeln aufgebaute Objekte Terme.

Der Aufbau nach den Regeln wird durch eine Herleitung beschrieben, d.h. jede Formel hat

eine Herleitung; z.B.:

(1)

(2)

(3)

(4)

q (d.h. q ∈ For )

(¬q)

p

((¬q) ∧ p)

A1 (Begründung)

A2 (1)

A1

A3 (2),(3)

Herleitung: bottom-up (erst Teile herleiten)

Regeln wie A1, A2 und A3 kann man in folgender Form schreiben:

B1 , . . . , Bn

B

Prämissen

Konklusion

Idee: Wenn B1 , . . . , Bn Formeln (oder gültige Aussagen (s.u.) etc.) sind, so auch B.

Speziell für n=0:

Axiom

B

Damit sind A1 und A3:

(A1’)

(A3’)

p

A, B

(A ∧ B)

p ∈ P (Nebenbedingung)

etc.

Eine Herleitung von B0 für solche Regeln ist eine Folge w1 , . . . , wm von Zeichenketten mit

wm ≡ B0 (syntaktisch gleich, d.h. gleiche Zeichenketten), so daß für jedes i = 1, . . . , m eine

n

mit wi ≡ B existiert, für die B1 , . . . , Bn unter den w1 , . . . , wi−1 auftreten. Wir

Regel B1 ,...,B

B

numerieren die wi explizit und geben jeweils die angewandte Regel an zusammen mit den

Zeilennummern der Bi .

Auch jedes w1 , . . . , wi ist eine Herleitung.

Beispiel 4.1. siehe oben; w1 ≡ q, w2 ≡ (¬q), w3 ≡ p, w4 ≡ ((¬q) ∧ p).

(¬q), p

, und (¬q) und p sind w2 und w3 .

Z.B. für w4 besagt Regel (A3) ((¬q)∧p)

✷

Man kann nun Definitionen/Beweise für herleitbare Objekte durch Induktion (über die

Herleitungslänge m) durchführen. Ausführlich:

Objekt B hat mindestens eine Herleitung; sei also eine solche Herleitung der Länge m

gegeben. Nach Induktion liegt Definition/Beweis für alle Objekte mit kürzerer Herleitung

schon vor (Noethersche Ind.!).

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

4 AUSSAGENLOGIK

35

n

Die zuletzt angewandte Regel zur Herleitung von B sei B1 ,...,B

– hier muß man jeweils

B

eine Fallunterscheidung nach den gerade behandelten Regeln machen. Die Bi erscheinen in

der gegebenen Herleitung vor B; sie haben also kürzere Herleitungen, so daß nach Ind. Definition/Beweis für sie schon vorliegt. Gib basierend darauf Definition/Beweis für B.

Bei einem solchen im Prinzip immer wieder gleichen Vorgehen hat man für jede Regel einen

Fall. Man gibt nur die Liste dieser Fälle und schreibt jeweils kurz:

n

: Definition/Beweis für B basierend auf Definition/Beweis für die Bi

Regel B1 ,...,B

B

Bei Formeln sind die Bi Teilterme von B; man spricht von Induktion über den Formelaufbau

bzw. struktureller Induktion. Vgl. rationale Ausdrücke.

Beispiele 4.2. Die Negationszahl #N B von B ist definiert durch:

(A1) #N p = 0

(A2) #N (¬B) =

(A3) #N (A ∧ B) = etc.

Die Fallunterscheidung nach der Form von A wird deutlicher, wenn man „A ≡ p ∈ P“ statt

(A1) und „A ≡ (¬B)“ statt (A2) schreibt – etc.

Achtung: Definition ist eindeutig, weil Zerlegung in Teilformeln (also die letzte Regel) eindeutig ist. Im Allgemeinen kann es sein, dass man ein Objekt auf verschiedene Weise herleiten

kann, dass die letzte Regel einer Herleitung also nicht eindeutig ist. Dies entspricht einer Definition, bei der man eine Variante für x ≥ 1 und eine zweite für x ≤ 1 hat; was muss man

dann beachten?

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

4 AUSSAGENLOGIK

4.2

36

Semantik,Wahrheitstafeln

Um eine Formel zu einem Wahrheitswert auswerten zu können, müssen wir nur wissen, welche

Atome wahr und welche falsch sind. Dazu ist eine Interpretation I zu P eine Funktion, die

jedem p ∈ P einen Wahrheitswert zuordnet, also I : P → {T, F }. Im Kontext der Aussagenlogik redet man oft auch von einer Belegung. Die Auswertung von Formeln folgt nun der

induktiven Definition mit (A1), (A2) und (A3) s.o.

Wir definieren I |= B, d.h. B gilt bei bzw. unter I bzw. I erfüllt B bzw. I ist ein Modell

von B durch:

(:⇔ heißt per Definition äquivalent)

(vgl. A1) I |= p :⇔ I(p)

Bemerkung: ⇔ ist unsere Sprache, mit der wir über Formeln sprechen (Metasprache); ↔

gehört zur Sprache der Formeln (Objektsprache). Analog: Im Deutschen über Englisch

reden.

(vgl. A2) I |= ¬A :⇔ nicht I |= A ⇔: I 6|= A

(vgl. A3) I |= A ∧ B

I |= A ∨ B

I |= A → B

I |= A ↔ B

:⇔

:⇔

:⇔

:⇔

I |= A und I |= B

I |= A oder I |= B

I 6|= A oder I |= B

(I 6|= A und I 6|= B) oder (I |= A und I |= B)

Zudem definieren wir für M ⊆ For : I |= M :⇔ für alle A ∈ M gilt I |= A

Beispiel 4.3. Es sei I(p) = F und I(q) = T . Dann gilt:

I |= p ∨ p ∧ q → p ⇔

nicht I |= p ∨ p ∧ q oder I |= p

⇔ es gilt nicht, dass I |= p oder I |= p ∧ q, oder es gilt I(p)

⇔ es gilt nicht, dass I(p) oder sowohl I(p) als auch I(q)

⇔ es gilt nicht, dass sowohl falsch als auch wahr

Also gilt die Formel unter I.

(letzteres ist falsch)

Definition von ¬A, A ∧ B, etc. tabellarisch mit einer Wahrheitstafel; dabei steht A, A ∧ B

etc. für I |= A, I |= A ∧ B etc.

A

T

T

F

F

B

T

F

T

F

¬A

F

F

T

T

A∧B

T

F

F

F

A∨B

T

T

T

F

A xor B

F

T

T

F

A→B

T

F

T

T

A↔B

T

F

F

T

∨ ist das inklusive, xor das exklusive Oder.

Beispiele 4.4. 1. p: Augsburg liegt in Thailand.

q: Augsburg liegt in Asien.

r: Augsburg liegt in Afrika.

p → r gilt mit der Realität als Interpretation — p → q natürlich auch. Wir benutzen →

extensional, d.h. nur die Wahrheitswerte sind interessant.

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

4 AUSSAGENLOGIK

37

Intentional ist p → r („Wenn Augsburg in Thailand läge, dann läge es in Afrika.“) wohl

falsch.

p=

b Satz, der wahr oder falsch ist. Also nicht:

• Hau ab !

• Nachts ist es kälter als draußen.

• Der gegenwärtige König von Frankreich hat eine Glatze.

• Diser Saz enthält drei Fehler. (falsch, da nur 2 Schreibfehler; wahr, da ein Sinnfehler

dazukommt)

Der letzte Satz zeigt, daß Sätze, die sich auf sich selbst beziehen, problematisch sind; weitere

Beispiele:

• Dieser Satz ist falsch.

• Ein Kreter sagt: „Alle Kreter lügen.“

2.

a) Max sagt: „Paul lügt.“

b) Paul sagt: „Max lügt.“

Sei p „Paul lügt“und m „Max lügt“. Dann besagen a) und b) (¬m ↔ p) und (¬p ↔ m).

3. I |= ∅ gilt immer

Proposition 4.5. (Hier wie auch sonst bedeutet das folgende: „Für alle Interpretationen I

und Formeln A, B gilt. . . “)

I |= A ⇔ I 6|= ¬A ⇔ I |= ¬¬A

Beweis. I 6|= ¬A bzw. I |= ¬¬A

⇔ nicht I |= ¬A (Definition 6|= und ¬)

⇔ nicht nicht I |= A (Definition ¬)

⇔ I |= A

(Metalogik)

✷

Nur üblicher math. Beweis – wir streben größere Präzision an; dazu müssen wir unser

formales Vorgehen mit „gesundem (math.) Menschenverstand“ absichern.

Definition 4.6. (Folgerbarkeit und Äquivalenz)

Seien A, B ∈ For und M ⊆ For ; A folgt aus M (in Zeichen: M |= A), wenn für alle Interpretationen I gilt: I |= M ⇒ I |= A.

Konvention: Wir schreiben auch A1 , . . . , An |= A für {A1 , . . . , An } |= A.

A und B sind logisch äquivalent, A =||= B, wenn A |= B und B |= A. Entsprechend:

M =||= M ′ , wenn M |= A für alle A ∈ M ′ und umgekehrt.

Satz 4.7.

i) Für alle n ≥ 1 gilt: I |= {A1 , . . . , An } ⇔ I |= A1 ∧ · · · ∧ An

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

4 AUSSAGENLOGIK

38

ii) M |= A → B ⇔ M ∪ {A} |= B

Beweis. i) per Induktion über n

ii) ”⇒“ Gelte I |= M ∪ {A} (– z.z. ist I |= B). Dann gilt I |= M und damit nach Voraussetzung I |= A → B. Also gilt I 6|= A oder I |= B. Außerdem gilt I |= A wegen I |= M ∪ {A};

zusammen I |= B.

”⇐“ Gelte I |= M (– z.z. ist I |= A → B). Entweder I |= A ist falsch (fertig!) oder I |= M ∪{A}

und nach Voraussetzung I |= B; fertig nach der Definition von →.

✷

Definition 4.8. A ∈ For ist (allgemein)gültig (eine Tautologie), in Zeichen: |= A, wenn für

alle Interpretationen I gilt I |= A. Analog definieren wir |= M für M ⊆ For .

A bzw. M ⊆ For sind erfüllbar, wenn es ein I gibt mit I |= A bzw. I |= M , andernfalls

unerfüllbar.

|= A bzw. M |= A sind die Wahrheiten, die uns interessieren.

Proposition 4.9. Sei A ∈ F or.

i) A gültig ⇒ A erfüllbar, d.h.

A unerfüllbar ⇒ A nicht gültig.

ii) A gültig ( |= A ) ⇔ ∅ |= A

Beweis. ii)

∅ |= A ⇔

⇔

⇔ A gültig.

✷

Satz 4.10. Sei A ∈ For und M ⊆ For . Dann gilt M |= A genau dann, wenn M ∪ {¬A}

unerfüllbar ist; speziell ist A gültig genau dann, wenn ¬A unerfüllbar ist.

Beweis. für alle I : I |= M ⇒ I |= A

genau dann wenn

für alle I : I |= M ⇒ I 6|= ¬A (Proposition 4.5)

genau dann wenn

M ∪ {¬A} ist unerfüllbar.

✷

Algorithmische Idee: Versuche, erfüllendes I für ¬A zu konstruieren; gelingt dies, ist A nicht

gültig (und wir haben I als Beleg dafür), sonst ist es gültig (wenn die Versuche geeignet sind).

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

4 AUSSAGENLOGIK

39

Wir können alle Interpretationen (bzw. ihren relevanten Teil) mittels Wahrheitstafel durchprobieren; genau dann, wenn alle Einträge einer Formel T sind, ist die Formel gültig. Gültigkeit ist also entscheidbar.

Eine Formel ist erfüllbar genau dann, wenn mindestens ein Eintrag in der Wahrheitstafel

T ist. Also ist Erfüllbarkeit entscheidbar.

Beispiel 4.11.

A ≡ p → (q → p)

B ≡ (¬p → ¬q) → (q → p) (Kontraposition)

C ≡ (¬p → ¬q) → (p → q)

p

T

T

F

F

q

T

F

T

F

q→p

T

T

F

T

A

T

T

T

T

¬p → ¬q

T

T

F

T

B

T

T

T

T

p→q

T

F

T

T

C

T

F

T

T

A und B sind gültig, C nicht – aber erfüllbar.

Bei vielen Atomen (n) ist dies Verfahren sehr aufwendig (2n Zeilen); also (Hilbert-)Kalkül

– s. Abschnitt 5.1 – oder evtl. ”gezielte Suche”/geeignete Fallunterscheidung.

Beispiel 4.12. Beim Antrag auf das Vordiplom stehen ein weißes, ein rotes und ein blaues

Formular zur Wahl. Die Prüfungsordnung enthält folgende Vorschriften:

a) w → ¬b (In Worten: Wer ein weißes Formular einreicht, darf kein blaues einreichen.)

b) w ∨ r

c) r → b ∧ w

Angenommen r = T , dann

Also r = F , damit c) X

wegen

wegen

Ergibt die einzige erfüllende Interpretation. Alternativ: Wahrheitstafel mit 8 Zeilen.

Die logische Äquivalenz ”=||=” heißt einfach „haben dieselben Modelle”; auch das können

wir mit Wahrheitstafeln durchprobieren.

Beispiel 4.13.

p → (q → r) =||= (p ∧ q) → r

p q r

q → r links p ∧ q rechts

.

.

.

T T F

F

F

T

F

T

T

F

T

T F T

.

.

.

.

.

.

F T F

F

T

F

T

.

.

.

Da die Spalten zu links und rechts gleich sind, folgt die Äquivalenz.

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

4 AUSSAGENLOGIK

40

A ≡ p → (q → p) aus Beispiel 4.11 ist nur einzelne Formel; ”natürlich” gilt auch ¬p →

(q ∧ r → ¬p). Allgemein:

Satz 4.14. Sei B ∈ For gültig mit Atomen p0 , p1 , ..., pn und seien A0 , ..., An ∈ For . B ′

entstehe aus B, indem man jedes pi durch Ai ersetzt. Dann ist B ′ gültig.

Beispiel 4.11 (Fortsetzung): Nach Satz 4.14 gilt für alle A, B ∈ For : A → (B → A)

Analog zu 4.14 folgt aus B1 =||= B2 auch B1′ =||= B2′ . Nach Beispiel 4.13 ist also für

alle A, B, C ∈ For : A → (B → C) =||= A ∧ B → C; die zweite Formel ist wohl besser zu

verstehen.

Proposition 4.15.

i) A → (B → C) =||= A ∧ B → C

ii) A ∧ B =||= ¬(A → ¬B)

iii) A ∨ B =||= ¬A → B

iv) A ↔ B =||= (A → B) ∧ (B → A)

Beweis. Teil i, s.o. Rest analog.

✷

Wir können jede Formel (auch als Teilformel einer größeren Formel – ohne Beweis; vgl.

Satz 4.14) durch eine logisch äquivalente ersetzen; also gilt z.B.

A ∨ B ∧ ¬C =||= ¬A → B ∧ ¬C

=||= ¬A → ¬(B → ¬¬C) (Teilformel ersetzt)

=||= ¬A → ¬(B → C)

Mit 4.15 können wir uns also bei Bedarf auf ¬ und → beschränken und ∧, ∨, ↔ als Abkürzungen (A ∧ B für ¬(A → ¬B) etc.) auffassen, die wir bei Bedarf zur besseren Lesbarkeit benützen. Damit haben wir weniger Formeln und weniger Fallunterscheidungen, z.B. im

Hilbert-Kalkül in Abschnitt 5.1.

Bemerkung: Zum Vergleich der verschiedenen Äquivalenzsymbole:

• ↔ steht in Formeln

• =||= steht zwischen Formeln; Meta-Sprache

• ⇔ steht zwischen (meta-sprachlichen) Aussagen, die wahr oder falsch sind; A ∨ B ⇔

¬A → B ist syntaktisch falsch, denn A ∨ B ist nicht wahr oder falsch – I |= A ∨ B

schon.

Hier eine Liste mit bekannten aussagenlogischen Äquivalenzen mit Namen (d.h. die folgenden Aussagen gelten sogar für alle prädikatenlogischen Formeln A, B und C):

Kommutativität, Assoziativität ∨ und ∧ sind kommutativ und assoziativ, d.h.

A ∨ B =||= B ∨ A und (A ∨ B) ∨ C =||= A ∨ (B ∨ C) etc.

Idempotenz

Prof. Dr. W. Vogler

A ∨ A =||= A und A ∧ A =||= A

Universität Augsburg

Mod. und Analyse techn. Systeme

4 AUSSAGENLOGIK

Distributivität

41

A∨(B ∧C) =||= (A∨B)∧(A∨C) und A∧(B ∨C) =||= (A∧B)∨(A∧C)

De Morgansche Gesetze

Doppelte Negation

Absorption

¬(A ∨ B) =||= ¬A ∧ ¬B und ¬(A ∧ B) =||= ¬A ∨ ¬B

(vgl. 4.5)

¬¬A =||= A

A ∨ (A ∧ B) =||= A und A ∧ (A ∨ B) =||= A

Neutrale Elemente

A ∨ false =||= A und A ∧ true =||= A

Inverse Elemente A ∨ ¬A =||= true (tertium non datur) und A ∧ ¬A =||= false

(Achtung: die Verknüpfung mit ∨ ergibt das neutrale Element von ∧ und vice versa!)

Null-Elemente A ∨ true =||= true und A ∧ false =||= false

(Sehen wir ∨ als Addition, das neutrale Element false also als 0 und ∧ als Multiplikation, so

entspricht die letzte Äquivalenz gerade der Aussage x · 0 = 0.)

Wenn wir aus diesen Gesetzen weitere ermitteln, verwenden wir meist unter der Hand

Kommutativität und Assoziativität sowie die Symmetrie von =||=.

Beispiele 4.16. Als Anwendung wollen wir zeigen, wie man im Gegenzug zu unseren obigen

Überlegungen → aus Formeln entfernen kann:

A → B =||= ¬¬A → B (Doppelte Negation) =||= ¬A ∨ B (vgl. 4.15 iii)). (Hier haben wir

zweimal die Symmetrie von =||= verwendet.)

Damit und mit 4.15 iv): A ↔ B =||= (¬A ∨ B) ∧ (¬B ∨ A)

Ferner ist false nach Definition ¬true; also ist ¬false äquivalent zu ¬¬true und zu true

(Doppelte Negation).

Ähnlich gilt: false → A =||= ¬false ∨ A (s.o.) =||= true ∨ A (gerade gesehen) =||= true

(Null-Element; genaugenommen auch Kommutativität).

Die Aussage false → A =||= true heißt ex falso quodlibet.

Prof. Dr. W. Vogler

Universität Augsburg

Mod. und Analyse techn. Systeme

4 AUSSAGENLOGIK

42

Exkurs:

Literale : p, ¬p mit p ∈ P

Klausel : l1 ∨ · · · ∨ ln mit Literalen li .

Eine Formel ist in bzw. eine konjunktive(r) Normalform (konj. NF, KNF), wenn sie eine

Konjunktion von Klauseln ist; z.B. (p1 ∨ ¬p2 ∨ p3 ) ∧ (¬p1 ∨ p3 ) ∧ (p2 ∨ ¬p3 ). (Erfüllbarkeit ist

schwer zu entscheiden, s.u.)

Analog: disjunktive Normalform (DNF): Disjunktion von Konjunktionen von Literalen

(Verwendet zur Beschreibung von Schaltkreisen; es gibt Verfahren zu ihrer Minimierung.)

Erfüllbarkeit leicht:

(*) Zu jeder Formel gibt es eine logisch äquivalente disjunktive Normalform.

Wir lesen ihre Konjunktionen aus den Zeilen der Wahrheitstafel mit T , den T -Zeilen, ab:

Beispiel 4.17. p ∨ q → ¬q =||= ??

p

T

T

F

F

q

T