Weitere Eigenschaften und Anwendungen diskreter Zufallsvariablen

Werbung

Weitere Eigenschaften und Anwendungen diskreter

Zufallsvariablen

Binomialverteilung

Bsp. 2.7 (Kommunikationskanal) Schicken

Binärzahlen durch einen Kommunikationskanal.

p: Wkt. einer fehlerhaften Übertragung

n: Anzahl der übertragenen Zeichen

Wkt. für genau i Fehler:

N i

P (i) =

p (1 − p)n−i =: b(i; n, p)

i

Bsp. 2.8 (Qualitätskontrolle) Stichprobe von 10 Computerchips aus einer sehr großen Lieferung (Los). Wenn

keine defekt, so wird die Lieferung angenommen, sonst

nicht.

p: Wkt., ein zufällig ausgewählter Chip ist defekt.

Wkt. für genau i defekte Stücke = b(i; 10, p).

P (Los angenommen) = (1 − p)10

130

W.Kössler, Humboldt-Universität zu Berlin

Bsp. 2.9 (k aus n Systeme) Jede Komponente habe die

Intaktwkt. p.

Wkt., daß genau i Komponenten ausfallen:

n n−i

P (X = i) =

p (1 − p)i

i

Wkt., daß höchstens k Komponenten ausfallen:

P (X ≤ k) =

=

k X

n

i=0

n

X

i=n−k

pn−i(1 − p)i

i

n i

p (1 − p)n−i

i

Geometrische Verteilung

Bem. 2 Sei Y ∼ Geo(p), d.h.

P (Y > s) = 1 −

P (Y > t) = 1 −

s

X

i=1

t

X

(1 − p)i−1 · p = (1 − p)s

(1 − p)i−1 · p = (1 − p)t

i=1

131

W.Kössler, Humboldt-Universität zu Berlin

P (Y > s) · P (Y > t) = (1 − p)s+t

s+t

X

= 1−

(1 − p)i−1 · p

i=1

= P (Y > s + t).

also:

P (Y > s + t, Y > t)

P (Y > s + t|Y > t) =

P (Y > t)

P (Y > s + t)

=

P (Y > t)

= P (Y > s)

Bez. 5 Wir sagen, Verteilungen mit

P (Y > s + t|Y > t) = P (Y > s)

besitzen die sogenannte Markov-Eigenschaft oder sie

sind gedächtnislos.

132

W.Kössler, Humboldt-Universität zu Berlin

Satz 2.3 Sei X diskrete Zufallsvariable mit Werten in

{1, 2, 3, . . .} und X habe die Markov-Eigenschaft. Dann

ist X ∼ Geo(p) für ein p, p ∈ (0, 1)

Beweis: : Sei

1 2 3 . . .

X :

p1 p2 p3 . . .

Aus der Markov-Eigenschaft folgt:

P (X > s) · P (X > t) = P (X > s + t) ∀s, t

s

t

s+t

X

X

X

(1 −

pi)(1 −

pi ) = 1 −

pi

i=1

i=1

i=1

Setzen p := p1. Einsetzen von

s = 1, t = 1 liefert (1−p)2 = (1−p−p2); p2 = p(1−p).

s = 1, t = 2 liefert (1−p)(1−p−p2) = (1−p−p2 −p3);

(1 − p − p2)(1 − p − 1) = −p3; also p3 = p(1 − p)2 usw.

2

133

W.Kössler, Humboldt-Universität zu Berlin

Bsp. 2.10 (Qualitätskontrolle) Wkt., daß das i-te Item

das erste defekte ist.

Bsp. 2.11 (Time-sharing computer system) mit festen

Zeitscheiben.

Programm wird in der Zeitscheibe vollständig abgearbeitet mit Wkt. p

Wenn nicht, neuer Versuch in der neuen Zeitscheibe

X: # benötigten Zeitscheiben

X ∼ Geo(p).

Bsp. 2.12 (Repeat-Schleife) A: aussagenlogischer Ausdruck, A = true mit Wkt. p.

repeat S until A.

# der Durchläufe von S: ∼ Geo(p).

134

W.Kössler, Humboldt-Universität zu Berlin

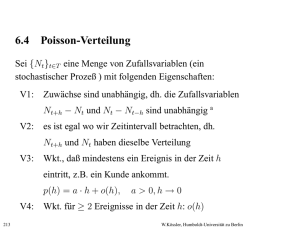

Poisson-Verteilung

Sei {Nt}t∈T eine Menge von Zufallsvariablen (ein stochastischer Prozeß ) mit folgenden Eigenschaften:

V1: Zuwächse sind unabhängig, dh. die Zufallsvariablen

Nt+h − Nt und Nt − Nt−h sind unabhängig 1

V2: es ist egal wo wir Zeitintervall betrachten, dh.

Nt+h und Nt haben dieselbe Verteilung

V3: Wkt., daß mindestens ein Ereignis in der Zeit h

eintritt, z.B. ein Kunde ankommt.

p(h) = a · h + o(h),

a > 0, h → 0

V4: Wkt. für ≥ 2 Ereignisse in der Zeit h: o(h)

Anmerkung: Zwei Zufallsvariablen X und Y heißen unabhängig, falls

∀A, B ∈ B;

135

P (X ∈ A, Y ∈ B) = P (X ∈ A)·P (X ∈ B)

W.Kössler, Humboldt-Universität zu Berlin

Frage: Wkt. daß bis zum Zeitpunkt t k Ereignisse eintreten? (eingetroffene Kunden, zerfallene Teilchen)

Pk (t) := P (Nt = k),

p(h) =

∞

X

Pk (t) = 0

für k < 0

≥ 1Ereignis tritt ein

Pk (h)

k=1

Offenbar:

1=

∞

X

Pk (t)

k=0

V 3 ⇒ P0(h) = 1 − p(h) = 1 − ah + o(h)

∞

X

V4 ⇒

Pk (h) = o(h),

(h → 0)

k=2

136

W.Kössler, Humboldt-Universität zu Berlin

1. Schritt: Bestimmen P0(t).

P0(t + h) = P (Nt = 0, Nt+h − Nt = 0)

= P0(t)P (Nt+h − Nt = 0)

= P0(t)P (Nh − N0 = 0)

= P0(t)P0(h)

wegen

wegen V1

wegen V2

N0 = 0

= P0(t)(1 − p(h))

= P0(t)(1 − ah + o(h))

wegen V4

Nacheinander folgt:

o(h)

P0(t + h) − P0(t)

= P0(t)(−a +

)

h

h

P00 (t) = −aP0(t)

P0(t) = ce−at

Wegen P0(0) = 1 folgt: c = 1 und

P0(t) = e−at

137

W.Kössler, Humboldt-Universität zu Berlin

2. Schritt: Bestimmen Pk (t).

Zerlegen das Ereignis {Nt+h = k} in disjunkte Teilereignisse.

{Nt+h = k} = {Nt = 0, Nt+h − Nt = k} ∪

= {Nt = 1, Nt+h − Nt = k − 1} ∪

= {Nt = 2, Nt+h − Nt = k − 2} ∪ . . . ∪

= {Nt = k, Nt+h − Nt = 0}

Pk (t + h) =

=

=

k

X

P (Nt = k − j, Nt+h − Nt = j)

j=0

Pk−j (t) P (Nt+h − Nt = j)

{z

}

|

j=0

k

X

k

X

wegen V1

=P (Nh −N0=j)

Pk−j (t)Pj (h) wegen V2

j=0

= Pk (t)P0(h) + Pk−1(t)P1(h) +

k

X

Pk−j (t)Pj (h)

j=2

138

W.Kössler, Humboldt-Universität zu Berlin

P1(h) =

∞

X

Pj (h) −

j=1

∞

X

Pj (h)

j=2

= p(h) + o(h)

= ah + o(h)

∞

X

Pk−j (t)Pj (h) ≤

j=2

∞

X

Pj (h) = o(h) wegen V2

j=2

Nacheinander folgt:

Pk (t + h) − Pk (t) = (P0(h) − 1)Pk (t) + Pk−1(t)P1(h) + o(h)

= −ahPk (t) + ahPk−1(t) + o(h)

o(h)

Pk (t + h) − Pk (t)

= −aPk (t) + aPk−1(t) +

h

h

Pk0 (t) = −aPk (t) + aPk−1(t), Pk (0) = 0

139

W.Kössler, Humboldt-Universität zu Berlin

Qk (t) := Pk (t)eat

⇒

Q0k (t) = Pk0 (t)eat + Pk (t)aeat

Q0k (t) = eat(−aPk (t) + aPk−1(t) +aPk (t))

{z

}

|

Pk0 (t)

= aQk−1(t)

Q01(t) = aQ0(t) = ae−ateat = a ⇒ Q1(t) = at

2 2

a

t

2

0

Q2(t) = aQ1(t) = a t ⇒ Q2(t) =

2

Durch vollständige Induktion:

a k tk

Qk (t) =

k!

ak tk −at

Pk (t) =

e

k!

Poisson-Verteilung mit Parameter λ = at.

140

W.Kössler, Humboldt-Universität zu Berlin

Programme:

Descr_Binomial_neu.sas

Descr_Poisson.sas

Descr_Geometr.sas

Descr_Hypergeom.sas

Bem: In den Wahrscheinlichkeiten können Parameter

auftreten, die in der Regel unbekannt sind.

Die Parameter sind anhand der Beobachtungen

(der Daten) zu bestimmen/zu schätzen!

−→ Aufgabe der Statistik

141

W.Kössler, Humboldt-Universität zu Berlin