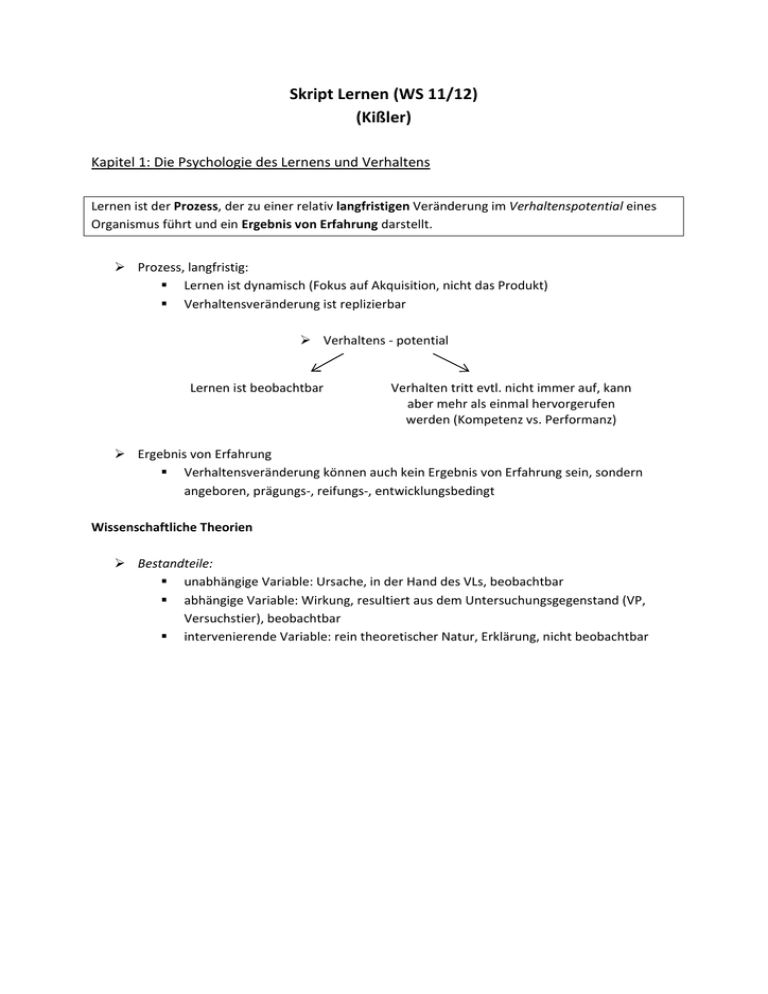

Skript Lernen (WS 11/12) (Kißler)

Werbung