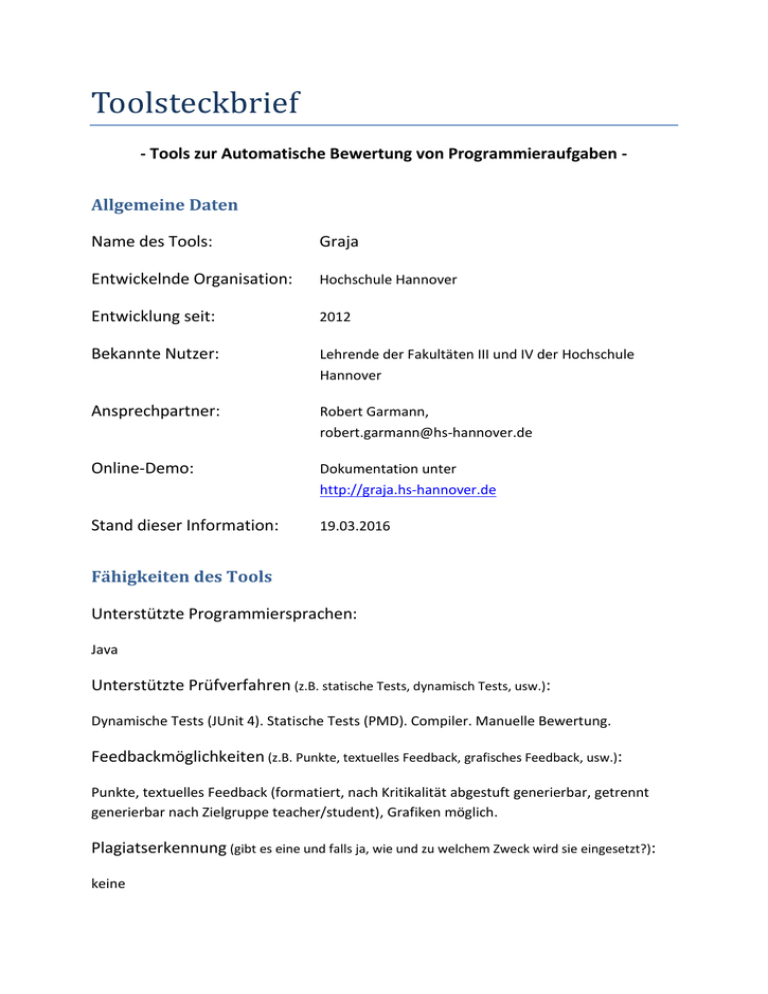

Graja - Hochschule Hannover

Werbung

Toolsteckbrief - Tools zur Automatische Bewertung von Programmieraufgaben Allgemeine Daten Name des Tools: Graja Entwickelnde Organisation: Hochschule Hannover Entwicklung seit: 2012 Bekannte Nutzer: Lehrende der Fakultäten III und IV der Hochschule Hannover Ansprechpartner: Robert Garmann, [email protected] Online-Demo: Dokumentation unter http://graja.hs-hannover.de Stand dieser Information: 19.03.2016 Fähigkeiten des Tools Unterstützte Programmiersprachen: Java Unterstützte Prüfverfahren (z.B. statische Tests, dynamisch Tests, usw.): Dynamische Tests (JUnit 4). Statische Tests (PMD). Compiler. Manuelle Bewertung. Feedbackmöglichkeiten (z.B. Punkte, textuelles Feedback, grafisches Feedback, usw.): Punkte, textuelles Feedback (formatiert, nach Kritikalität abgestuft generierbar, getrennt generierbar nach Zielgruppe teacher/student), Grafiken möglich. Plagiatserkennung (gibt es eine und falls ja, wie und zu welchem Zweck wird sie eingesetzt?): keine Benutzerverwaltung (gibt es eine und falls ja, welche Möglichkeiten bietet sie?): keine Integration des Tools Anbindung an LMS für Studierende (z.B. Integration in Moodle, Ilias, o.ä.): Reines Grader-Backend als eigenständiges Java-Programm, das per Kommandozeile gestartet werden kann (Dateien an der Schnittstelle) oder durch Verwendung einer GrajaAPI (Java-Objekte an der Schnittstelle). Zur LMS-Anbindung ist seitens des LMS die Generierung der Eingabedateien sowie die Verarbeitung der Ausgabedatei zu realisieren. Graja ist eine reine Dienstkomponente ohne eigene Datenhaltung von Aufgaben und Lösungen. Existierende LMS-Anbindungen: ppkm (intern an der HS Hannover entwickeltes, rudimentäres LMS, nicht veröffentlicht), Grappa/moodle Anbindung an LMS für Lehrende (z.B. Integration in Moodle, Ilias, o.ä.): Dto. Nutzung von Standards (z.B. für die Integration in LMS oder das Aufgabenformat): ProFormA-Aufgabenformat. Einbindung als BackendPlugin in die Middleware Grappa. Wissenschaftliche Auswertung Publikationen zur Technik des Tools: Robert Garmann: Graja – Grader for java programs. http://graja.hs-hannover.de. 2016. Robert Garmann: E-Assessment mit Graja – ein Vergleich zu Anforderungen an Softwaretestwerkzeuge. Workshop "Automatische Bewertung von Programmieraufgaben", 6.11.2015, Wolfenbüttel. Robert Garmann: Sicherheitsimplikationen beim Einsatz von Test Doubles zur automatisierten Bewertung studentischer Java-Programme mit Graja und mockito. Workshop "Automatische Bewertung von Programmieraufgaben", 28.10.2013, Hannover. Publikationen zur Nutzung des Tools: Peter Werner, Robert Garmann, Felix Heine, Carsten Kleiner, Paul Reiser, Immanuel De Vere Peratoner, Sören Grzanna, Peter Wübbelt, Oliver J. Bott: Grading mit Grappa – Ein Werkstattbericht. Workshop "Automatische Bewertung von Programmieraufgaben", 6.11.2015, Wolfenbüttel. Sebastian Becker, Andreas Stöcker, Daniel Bräckelmann, Robert Garmann, Felix Heine, Carsten Kleiner, Peter Werner und Oliver Bott: Prototypische Integration automatisierter Programmbewertung in das LMS Moodle. Workshop "Automatische Bewertung von Programmieraufgaben", 28.10.2013, Hannover. Andreas Stöcker, Sebastian Becker, Robert Garmann, Felix Heine, Carsten Kleiner, Oliver J. Bott: Evaluation automatisierter Programmbewertung bei der Vermittlung der Sprachen Java und SQL mit den Gradern „aSQLg“ und „Graja“ aus studentischer Perspektive. DeLFI, 8.-11.09.2013, Bremen. Sonstiges Graja kann die ZIP-Datei-Einreichung eines einzelnen Studierenden zu mehreren Übungsaufgaben in einem Durchgang bewerten (entpacken, einzelne Teilaufgaben bewerten, Ergebnisse aggregieren). Graja besitzt verschiedene Möglichkeiten zur Beschränkung des Resourcenverbrauchs / zugriffs des zur Ausführung gebrachten Fremdcodes. Vielen Dank für das Ausfüllen des Steckbriefs!