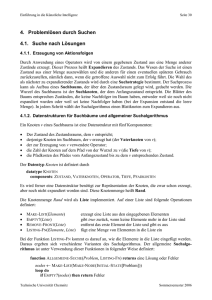

Einführung in die Künstliche Intelligenz

Werbung