Neurokognition - Technische Universität Chemnitz

Werbung

Neurokognition

Vorlesung an der Technischen Universität Chemnitz

Wintersemester 2006/07

Prof. Dr. Werner Dilger

Neurokognition

Seite 2

Inhalt

1.

Einleitung.................................................................................................................................................................... 4

1.1. Computermodelle und Neurokognition .............................................................................................................. 4

1.2.

Motivation für die Verwendung von Computermodellen in der Neurokognition ............................................... 4

1.3.

Einige wichtige kognitive Phänomene und ihre biologischen Grundlagen ......................................................... 7

2.

Neuronen .................................................................................................................................................................. 11

2.1.

Überblick .......................................................................................................................................................... 11

2.2.

Detektoren als Modelle von Neuronen ............................................................................................................. 11

2.3.

Die Biologie des Neurons ................................................................................................................................. 13

2.4.

Die Elektrophysiologie des Neurons ................................................................................................................. 18

2.5.

Modellierung und Implementation der neuronalen Aktivierungsfunktion ........................................................ 25

2.6.

Hypothesen testende Analyse eines neuronalen Detektors ............................................................................... 32

2.7.

Selbstregulierung: Erschlaffung und Hysterese ................................................................................................ 37

3.

Netze von Neuronen ................................................................................................................................................ 39

3.1.

Überblick .......................................................................................................................................................... 39

3.2.

Allgemeine Struktur kortikaler Netze ............................................................................................................... 39

3.3.

Unidirektionale exzitatorische Interaktionen: Transformationen ...................................................................... 43

3.4.

Bidirektionale exzitatorische Interaktionen ...................................................................................................... 47

3.5.

Inhibitorische Interaktionen .............................................................................................................................. 49

3.6.

Constraint Satisfaction ...................................................................................................................................... 55

4.

Hebbsches Modelllernen.......................................................................................................................................... 59

4.1.

Überblick .......................................................................................................................................................... 59

4.2.

Biologische Lernmechanismen ......................................................................................................................... 59

4.3.

Berechnungstheoretische Ziele des Lernens ..................................................................................................... 61

4.4.

Hauptkomponentenanalyse ............................................................................................................................... 64

4.5.

Bedingte Hauptkomponentenanalyse ................................................................................................................ 66

4.6.

Renormierung und Kontrastverstärkung ........................................................................................................... 71

4.7.

Selbst organisierendes Modelllernen ................................................................................................................ 74

5.

Fehler getriebenes Aufgabenlernen ......................................................................................................................... 75

5.1.

Überblick .......................................................................................................................................................... 75

5.2.

Die Verwendung des Fehlers für das Lernen: Die Deltaregel........................................................................... 75

5.3.

Fehlerfunktionen, Gewichtsbeschränkung und Aktivierungsphasen ................................................................ 77

5.4.

Die verallgemeinerte Deltaregel: Backpropagation .......................................................................................... 80

5.5.

Der verallgemeinerte Rückkreislauf-Algorithmus ............................................................................................ 83

5.6.

GeneRec aus biologischer Sicht ........................................................................................................................ 86

6.

Kombination von Modell- und Aufgabenlernen und andere Lernmechanismen ..................................................... 91

6.1.

Kombination von Hebbschem Lernen und Fehler getriebenem Lernen ........................................................... 91

6.2.

Verallgemeinerung in bidirektionalen Netzen .................................................................................................. 94

6.3.

Erlernen der Re-Repräsentationen in tiefen Netzen .......................................................................................... 95

6.4.

Erlernen von Folgen und zeitlich verzögertes Lernen ...................................................................................... 96

6.5.

Kontextrepräsentationen und sequentielles Lernen........................................................................................... 97

6.6.

Reinforcement Learning für zeitlich verzögerte Ergebnisse ........................................................................... 100

7.

Die großräumige funktionale Organisation der Gehirnareale ................................................................................ 109

7.1.

Überblick ........................................................................................................................................................ 109

7.2.

Allgemeine Berechnungs- und funktionale Prinzipien ................................................................................... 109

7.3.

Allgemeine Funktionen der kortikalen Lappen und subkortikaler Areale ...................................................... 114

7.4.

Dreigeteilte funktionale Organisation ............................................................................................................. 118

7.5.

Ein Ansatz zu einer kognitiven Architektur des Gehirns ................................................................................ 120

7.6.

Allgemeine Probleme ..................................................................................................................................... 123

8.

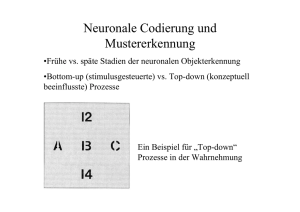

Wahrnehmung und Aufmerksamkeit ...................................................................................................................... 129

8.1.

Die Biologie des visuellen Systems ......................................................................................................... 129

8.2.

Ein Modell der primären visuellen Repräsentationen ..................................................................................... 133

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

8.3.

8.4.

Seite 3

Objekterkennung und der visuelle Form-Pfad ................................................................................................ 136

Ein Modell der räumlichen Aufmerksamkeit .................................................................................................. 142

Literatur

Gazzaniga, M.S., Ivry, R.B., Mangun, G.R.: Cognitive Neuroscience. The Biology of the Mind. 2.

W.W. Norton & Company, New York, 2002.

Posner, M.I., Raichle, M.E.: Bilder des Geistes. Hirnforscher auf den Spuren des Denkens.

Spektrum Akademischer Verlag, Heidelberg, 1996.

O’Reilly, R.C., Munakata, Y.: Computational Explorations in Cognitive Neuroscience.

Understanding the Mind by Simulating the Brain. MIT Press, Cambridge, MA, 2000.

M. Spitzer: Geist im Netz. Modelle für Lernen, Denken und Handeln. Spektrum Akademischer

Verlag, Heidelberg, 2000.

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

1.

1.1.

Seite 4

Einleitung

Computermodelle und Neurokognition

Die Vorlesung, unterstützt durch die Experimente mit den Programmen von O’Reilly und Munakata, soll eine Einführung in verschiedene Gebiete der Neurokognition geben, darunter die folgenden:

Visuelle Kodierung: Ein neuronales Netz sieht natürlich Bilder und entwickelt mit Hilfe von

Lernmechanismen Arten der Kodierung die visuellen Szenen in ähnlicher Weise wie das Gehirn,

um der visuellen Welt Bedeutung zu geben.

Räumliche Aufmerksamkeit: An den Interaktionen zwischen verschiedenen Strömen der visuellen

Eingabe kann man beobachten, wie das Modell seine Aufmerksamkeit auf verschiedene Orte im

Raum fokussiert um z.B. eine visuelle Szene zu erfassen. Das Modell kann dann dazu benutzt

werden, die Aufmerksamkeitsleistung gesunder und hirngeschädigter Personen zu simulieren.

Episodisches Gedächtnis: Stattet man ein Neuronales Netz mit einem Modell des Hippocampus

aus, dann kann es neue Gedächtnisinhalte aus alltäglichen Erfahrungen und Ereignissen erzeugen

und somit menschliche Erinnerungsleistung simulieren.

Arbeitsgedächtnis: Spezielle biologische Mechanismen können das Arbeitsgedächtnis eines

Netzes verbessern. Man kann simulieren, wie eine geschickte Steuerung des Arbeitsgedächtnisses

durch Erfahrung gelernt werden kann.

Lesen: Ein Netz kann lernen, beinahe 3000 englische Wörter zu lesen und auszusprechen. Das Netz

kann sogar neue Buchstabenfolgen (nicht unbedingt Wörter), die es vorher nicht gesehen, aussprechen. Damit wird gezeigt, dass es die Regeln der englischen Aussprache gelernt hat und nicht nur

die Beispiele auswendig kann. Indem man das Modell beschädigt, kann man dann verschiedene

Formen von Legasthenie simulieren.

Semantische Repräsentation: Ein Netz kann ein ganzes Buch lesen und daraus ein überraschend

gutes Verständnis der darin benutzten Wörter gewinnen, indem es prüft, welche Wörter oft gemeinsam oder in ähnlichen Kontexten vorkommen.

Aufgabenorientiertes Verhalten: Man kann ein Modell des „Ausführungsteils“ des Gehirns, dem

präfrontalen Kortex, entwickeln und beobachten, wie es die Aufmerksamkeit auf die aktuelle

Aufgabe fokussiert und davon abhält, von anderen Dingen abgelenkt zu werden.

Überlegte, explizite Wahrnehmung: Viele Vorgänge im Gehirn laufen relativ automatisch ab,

man kann aber auch in absichtlicher, expliziter Form denken und handeln. An einem Netzmodell

kann man beide Formen der Kognition im Kontext einer einfachen Kategorisierungsaufgabe untersuchen. Das Modell zeigt somit die biologische Basis für Bewusstsein.

1.2.

Motivation für die Verwendung von Computermodellen in der

Neurokognition

1.2.1. Physikalischer Reduktionismus

Es hat in der Vergangenheit viele Versuche gegeben, die menschliche Kognition mit unterschiedlichen Sprachen und Metaphern zu erklären. Zum Beispiel wurde versucht, Kognition als auf

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 5

einfachen logischen Operationen beruhend aufzufassen oder als in der Art eines sequentiellen

Standardcomputers operierend. Das hat zwar manche Einsicht vermittelt, aber der bessere Weg ist,

das Gehirn selbst und seine Funktionsweise zu betrachten um die menschliche Kognition zu

erklären. So betrachtet ist das Wesen der Neurokognition nicht nur Reduktionismus, sondern auch

die Forderung, dass die Komponenten, auf die reduziert wird, Komponenten des Gehirns als Träger

der Kognition sind.

Viele frühere und zum Teil noch heute benutzte Theorien über menschliche Kognition beruhen auf

Konstrukten wie „Aufmerksamkeit“ und „Arbeitsspeicher“; diese haben aber ihre Grundlage in der

Analyse von Verhalten oder Denken, nicht in den physikalischen Entitäten, die gemessen werden

können. Neurokognition unterscheidet sich von der gängigen Kognitionswissenschaft dadurch, dass

sie kognitive Phänomene auf der Basis und in der Begrifflichkeit der zugrunde liegenden neurobiologischen Komponenten zu erklären versucht; diese können im Prinzip unabhängig gemessen

und lokalisiert werden. Andere Theorien der Kognition können teilweise dazu passen, andere nicht.

1.2.2. Rekonstruktionismus

Bloßer Reduktionismus führt dazu, dass man zwar die Teile eines Systems identifizieren und

lokalisieren und ihre Funktionsweise verstehen kann, aber man versteht damit noch nicht, wie die

Teile zusammenwirken und wie daraus die Gesamtleistung des Systems entsteht. Zur Reduktion

eines Systems um die Teile zu verstehen gehört auch die anschließende Rekonstruktion. Das

Verständnis der Funktionsweise der Neuronen erklärt noch nicht, wie aus den Interaktionen der

Neuronen im Gehirn Bewusstsein entsteht.

Im Rekonstruktionsprozess bekommt der Ansatz der Computermodellierung in der Neurokognition

entscheidende Bedeutung, denn es ist sehr schwierig, mit verbalen Beschreibungen die menschlichen Kognition aus der Aktion einer großen Zahl interagierender Komponenten zu rekonstruieren.

Stattdessen kann man aber das Verhalten der Komponenten implementieren und testen, ob sie in der

Lage sind, die gewünschten Phänomene zu reproduzieren. Solche Simulationen sind wesentlich um

zu verstehen, wie die Neuronen Kognition erzeugen. Das ist insbesondere der Fall, wenn es emergente Phänomene gibt, die erst aus den Interaktionen entstehen und an den einzelnen Komponenten

nicht zu beobachten sind, d.h. wenn das Ganze größer ist als die Summe seiner Teile. Die

Bedeutung des Rekonstruktionismus wird oft in der Wissenschaft übersehen, er konnte aber erst mit

der Entstehung leistungsfähiger Computer angegangen werden.

1.2.3. Analyseebenen

Der Prozess der Reduktion und der anschließenden Rekonstruktion erscheint sinnvoll, löst aber

nicht alle Probleme. Der Grund dafür liegt in der extremen Komplexität und dem Mangel an Wissen

sowohl über das Gehirn als auch über die Kognition, die es erzeugt. Aus diesem Grund wurde in der

Forschung vorgeschlagen, Analyseebenen zur Bewältigung der Komplexität einzuführen. Zur

Erklärung der menschlichen Kognition erscheinen manche Analyseebenen einleuchtender als

andere, z.B. erscheint es sinnlos, die Kognition auf der Ebene der Atome und einfachen Moleküle

oder auch auf der Ebene der Proteine und DNA erklären zu wollen, statt dessen sollten Mechanismen höherer Ebenen benutzt werden. Welches aber die richtige Ebene ist, lässt sich schwer

entscheiden und hängt vom aktuellen Wissensstand ab. Deshalb ist die hier gewählte Analyseebene

nur diejenige, die derzeit als beste erscheint. Die Idee der Analyseebenen wurde von David Marr in

der Kognitionswissenschaft eingeführt; er sprach von einer Berechnungs-, einer algorithmischen

und einer Implementationsebene und betonte damit die Analogie zum Computer.

Ein anderer Ansatz der wissenschaftlichen Analyse ist die Optimalität oder rationale Analyse, die in

vielen „Wissenschaften der Komplexität“ wie Biologie, Psychologie oder Ökonomie benutzt wird

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 6

(Anderson). Auch sie betont die Berechnungsebene und nimmt an, es sei möglich, die optimale

Berechnung oder die optimale von einem Menschen oder einem Tier in einem bestimmten Kontext

ausgeführte Funktion zu identifizieren, und dass das Gehirn, egal was es tut, irgendwie diese

optimale Berechnung durchführe und deshalb ignoriert werden könne. Zum Beispiel behauptet

Anderson, dass das Erinnerungsvermögen optimal an die Häufigkeit und die Abstände für das

Abrufen von Gedächtnisinhalten angepasst sei. So gesehen spielt es keine Rolle, wie das

Erinnerungsvermögen tatsächlich funktioniert, denn die treibende Kraft dahinter ist letztlich das

Optimalitätskriterium für das Abrufen von Inhalten bei Anfragen, und dieses folgt allgemeinen

Gesetzmäßigkeiten.

Das Problem des Optimalitätsansatzes ist allerdings, dass die Definition der Optimalität oft von

verschiedenen Annahmen abhängt, unter anderem solchen über die Natur der zugrunde liegenden

Implementierung, die keine unabhängige Grundlage haben. Optimalität kann also kaum mit rein

„objektiven“ Begriffen definiert werden, deshalb hängt es oft von den einzelnen Umständen ab, was

optimal ist.

Beide Ansätze, die Analyseebenen und das Optimalitätskriterium, suggerieren, dass die Implementationsebene weitgehend irrelevant ist. In Standardcomputern und –sprachen trifft dies auch zu,

denn sie sind effektiv äquivalent auf der Implementationsebene, deshalb beeinflussen Implementationsdetails die algorithmische und die Berechnungsebene nicht und Algorithmen können vollständig automatisch durch Compilation in Implementierungen umgesetzt werden. Beim Gehirn kann

aber die neuronale Implementierung nicht automatisch von irgendeiner höheren Beschreibungsebene abgeleitet werden, deshalb kann es nicht so einfach auf einer höheren Ebene beschrieben

werden. Die beiden erwähnten Ansätze haben eine allgemeine Form der Implementierung

vorausgesetzt, ohne sich darum zu kümmern, wie sie aussehen könnte. Durch die Entwicklung

paralleler Computer ist aber ein neues Berechnungsparadigma entstanden mit einer ganz neuen

Klasse von Algorithmen und neuen Denkweisen um die Vorteile der parallelen Berechnung zu

nutzen. Das Gehirn lässt sich am ehesten mit einem massiv parallelen Computer vergleichen mit

Milliarden von Rechenelementen, deshalb sind von Standardcomputern abgeleitete Vorstellungen

hier nicht adäquat.

Umgekehrt haben verschiedene Forscher betont, die Implementationsebene sei die primäre und

kognitive Modelle müssten dadurch aufgebaut werden, dass man sehr detaillierte Nachbildungen

von Neuronen macht um so zu garantieren, dass die entstehenden Modelle alle wichtigen

biologischen Mechanismen enthalten. Aber ohne ein vorab vorhandenes klares Verständnis davon,

welche Eigenschaften funktional bedeutsam sind und welche nicht, entsteht bei diesem Ansatz das

Problem, dass man komplizierte und schwer verständliche Modelle bekommt, die wenig Einsicht in

die wesentlichen Eigenschaften der Kognition geben. Außerdem schaffen es diese Modelle niemals,

alle biologischen Mechanismen im letzten Detail abzubilden, deshalb kann man nie ganz sicher

sein, dass nicht doch etwas Wichtiges fehlt.

Um den Problemen zu entgehen, die mit der Bevorzugung einer Ebene über eine andere verbunden

sind, wird hier ein konsequent interaktiver, gleichgewichtiger Ansatz befolgt. Bei ihm werden

Verbindungen zwischen Daten über alle relevanten Ebenen hinweg gebildet und ein vernünftiger

Kompromiss zwischen dem Wunsch nach einem einfachen Modell und dem Wunsch, so viel wie

möglich von den bekannten biologischen Mechanismen zu integrieren, eingegangen. Es wird also

sowohl ein bottom-up- als auch ein top-down- als auch ein interaktiver Ansatz gemacht, bei dem

gleichzeitig Constraints auf der biologischen und der kognitiven Ebene berücksichtigt werden.

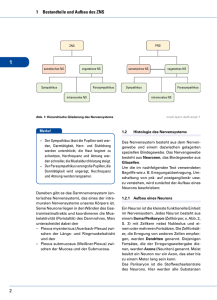

Im Folgenden wird die in Abbildung 1.1 dargestellte Hierarchie von Analyseebenen verwendet. Sie

besteht im Kern aus zwei Ebenen, die nach dem Prinzip des physikalischen Reduktionismus und

des Rekonstruktionismus miteinander verbunden sind. Die untere Ebene bilden die neurobiologiTechnische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 7

schen Mechanismen, die obere Ebene die kognitiven Phänomene. Letztere werden auf Operationen

der neurobiologischen Mechanismen reduziert und mittels Simulationen wird gezeigt, wie diese

Mechanismen emergente kognitive Phänomene erzeugen. Die Simulationen stützen sich auf

vereinfachte, abstrakte Wiedergaben der neurobiologischen Mechanismen. Die Zwischenebene der

allgemeinen Prinzipien ist eine Art Hilfsebene, die die Verbindung zwischen den beiden anderen

unterstützt. Weder das Gehirn noch die Kognition können vollständig durch die allgemeinen

Prinzipien beschrieben werden, diese dienen aber dazu, die Verbindungen zwischen bestimmten

Aspekten der Biologie und Aspekten der Kognition deutlich zu machen.

1.2.4. Skalierung

Die Skalierung bezieht sich auf die Art und Weise, wie ein herunterskaliertes Modell des Gehirns

konstruiert werden kann. Natürlich ist die Notwendigkeit der Skalierung zumindest teilweise durch

die Beschränktheit der verfügbaren Computerhardware bedingt, die sich in der Zukunft abschwächen wird. Andererseits sind aber herunterskalierte Modelle auch leichter zu verstehen und deshalb

für die Forschung in der Neurokognition ein guter Ausgangspunkt. Das Skalierungsproblem wird

auf folgende Weise zu lösen versucht:

Das beabsichtigte kognitive Verhalten, das von den Modellen erwartet (und erreicht) wird, wird

in ähnlicher Weise herunterskaliert im Vergleich zu der Komplexität der tatsächlichen menschlichen Kognition.

Es wird gezeigt, dass ein simuliertes Neuron das Verhalten vieler realer Neuronen approximieren kann, so dass also Modelle mehrerer Gehirnbereiche gebaut werden können, wobei die

Neuronen in diesen Bereichen von wesentlich weniger Einheiten simuliert werden.

Es wird angenommen, dass die Informationsverarbeitung im Gehirn fraktale Eigenschaften hat,

wobei dieselben grundlegenden Eigenschaften in unterschiedlichen physikalischen Maßstäben

gelten. Diese grundlegenden Eigenschaften sind die der einzelnen Neuronen, die auch auf

höheren Ebenen durchscheinen und somit auch für das Verständnis des Verhaltens des Gehirns

im großen Maßstab relevant sind.

1.3.

Einige wichtige kognitive Phänomene und ihre biologischen

Grundlagen

1.3.1. Parallelismus

Menschen können viele Dinge parallel zueinander tun, z.B. beim Gehen etwas essen, beim

Autofahren reden, verschiedene Laute gleichzeitig hören usw. Jeder dieser einzelnen Prozesse ist

aber seinerseits ein Produkt einer großen Zahl von Prozessen, die gleichzeitig ablaufen. Das

menschliche Gehirn besteht aus 10 bis 20 Milliarden Neuronen, und jedes trägt einen kleinen Teil

zum gesamten Bewusstsein bei, deshalb muss Kognition aus der parallelen Aktivität aller dieser

Neuronen entstehen. Dieses Phänomen, dass die Ausführung jeder kognitiven Funktion über eine

große Zahl individueller Prozesselemente parallel verteilt ist, nennt man parallele verteilte

Verarbeitung (parallel distributed processing, PDP). Der Parallelismus kommt auf verschiedenen

Ebenen vor, von Gehirnarealen über kleine Gruppen von Neuronen bis zu den Neuronen selbst.

Die parallele Verarbeitung kann es zu einer Herausforderung machen, die Kognition zu verstehen,

d.h. um herauszufinden, wie alle diese Teilprozesse sich miteinander koordinieren um so etwas

Sinnvolles zustande zu bringen. Wäre Kognition ein Bündel diskreter sequentieller Schritte, dann

wäre die Aufgabe einfacher, man müsste nur die Schritte und ihre Folge identifizieren.

Parallelismus hat dagegen eine Ähnlichkeit mit dem Mehrkörperproblem in der Physik: Die

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 8

paarweise Interaktion zweier Dinge kann einfach sein, so bald aber mehrere Dinge vorhanden sind,

die gleichzeitig aktiv sind und sich gegenseitig beeinflussen, wird es schwierig herauszufinden, was

vor sich geht. Hier wird konsequent auf PDP gesetzt, die mächtige mathematische und intuitive

Werkzeuge zum Verständnis der Interaktion zwischen einer großen Zahl von Prozesseinheiten

bereitstellt.

1.3.2. Abgestuftheit

Im Gegensatz zur diskreten Booleschen Logik und den binären Speicherinhalten von Standardcomputern arbeitet das Gehirn von Natur aus abgestuft und analog. Neuronen integrieren Informationen

von einer großen Zahl verschiedener Eingabequellen und produzieren im Wesentlichen eine stetige,

reelle Zahl, die in etwa die relative Stärke der Eingaben repräsentiert. Sie senden dann ein weiteres

abgestuftes Signal (die Feuerrate oder Aktivierung) an andere Neuronen als Funktion dieser

relativen Stärke. Diese abgestuften Signale können so etwas wie das Ausmaß oder den Grad, zu

dem eine Sache wahr ist, übermitteln.

Aktivierung

Abgestuftheit ist von entscheidender Bedeutung für Wahrnehmungs- und motorische Phänomene,

die auf stetigen Werten wie Position, Winkel, Kraft oder Farbe beruhen. Das Gehirn behandelt diese

Werte so, dass verschiedene Neuronen unterschiedliche „prototypische“ Werte entlang eines Kontinuums repräsentieren und mit abgestuften Signalen reagieren, die wiedergeben, wie nahe das gerade

wahrgenommene Exemplar dem bevorzugten Wert ist, vgl. Abbildung 1.2. Diese Art der Repräsentation, die auch grobe Kodierung oder Basisfunktions-Repräsentation genannt wird, deutet genau

einen bestimmten Ort in einem Kontinuum an, indem sie eine gewichtete Schätzung auf der Basis

der abgestuften Signale abgibt, die zu jedem Basiswert gehört.

Stetige Dimension

Abbildung 1.2

Abgestuftheit hat noch einen anderen wichtigen Aspekt, der damit zusammenhängt, dass jedes

Neuron Eingaben von vielen Tausenden anderer Neuronen erhält. Auf Grund dieser Tatsache ist ein

einzelnes Neuron nicht entscheidend für das Funktionieren anderer, vielmehr trägt es nur als

Bestandteil eines abgestuften Gesamtsignals etwas bei, das die Zahl der zum Signal beitragenden

Neuronen sowie die Stärke ihres Beitrags widerspiegelt. Aus diesem Sachverhalt entsteht das

Phänomen der allmählichen Abschwächung, bei der sich eine Funktion mit zunehmendem Ausmaß

der Schädigung im Nervengewebe allmählich abschwächt. Der Ausfall von Neuronen vermindert

die Stärke des Signals, zerstört aber die Funktion nicht vollständig.

Ein dritter Aspekt der Abgestuftheit hängt mit der Art der Informationsverarbeitung im Gehirn

zusammen. Sie tritt in Erscheinung, wenn man versucht sich an etwas zu erinnern, es einem aber

trotz Nachdenken nicht einfällt. Es ist das Phänomen des „Auf der Zunge Liegens“. Das Gehirn

lässt dabei ein Bündel relativ schwach ausgeprägter Ideen kreisen um zu sehen, welche sich verstärken, indem sie in Resonanz geraten miteinander oder mit anderen Inhalten, und welche sich

abschwächen und verschwinden. Ähnlich funktioniert die Intuition: eine Menge relativ schwacher

Faktoren addieren sich und unterstützen eine Idee gegen eine andere, aber es gibt keinen klaren,

eindeutigen Grund dafür.

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 9

Ein Äquivalent zu diesem Phänomen auf der Berechnungsebene ist das Bootstrapping und multiple

Constraint Satisfaction. Durch Bootstrapping kann ein System selbstständig einen Zustand erreichen indem es aus einer schwachen, unvollständigen Information ein gültiges Ergebnis erzeugt.

Durch multiple Constraint Satisfaction können parallele, abgestufte Systeme gute Lösungen für

Probleme finden, die eine Anzahl von Constraints involvieren. Die Idee dieser Methode ist, dass

jedes Constraint so viel zur Lösung beiträgt, wie es in etwa seiner Stärke oder Wichtigkeit

entspricht. Die resultierende Lösung stellt eine Art Kompromiss dar, der die Konvergenz derjenigen

Constraints verstärkt, die ungefähr in dieselbe Richtung zeigen, und die Zahl der nicht erfüllten

Constraints vermindert.

1.3.3. Interaktivität

Das Gehirn unterscheidet sich von einem seriellen Standardcomputer noch in der Hinsicht, dass die

Verarbeitung zu einem Zeitpunkt nicht nur in einer Richtung verläuft. Sie ist also nicht nur parallel,

sondern auch noch vor- und rückwärts zugleich. Dieses Phänomen nennt man Interaktivität,

Rekurrenz oder bidirektionale Verknüpfung. Man kann sich das Gehirn als aus hierarchisch angeordneten Verarbeitungsgebieten zusammengesetzt denken. Eingaben, z.B. visuelle Reize, werden in

dieser Hierarchie stufenweise verarbeitet, beginnend auf sehr einfacher Stufe (z.B. Orientierung von

Linien) und fortschreitend auf immer höheren Stufen, auf denen komplexere Merkmale herausgearbeitet werden (z.B. Kombinationen von Linien, Objekte, Szenen usw.). In diesem System

erfolgt die Verarbeitung gleichzeitig bottom-up und top-down, d.h. der Informationsfluss verläuft in

beide Richtungen. Zusammen mit dem Parallelismus und der Abgestuftheit liefert die Interaktivität

gute Erklärungen für Phänomene, die ansonsten nicht verständlich wären.

1.3.4. Wettbewerb

Der Wettbewerb zwischen den Neuronen im Gehirn hat zur Folge, dass bestimmte Repräsentationen ausgewählt und stärker aktiv werden, während andere abgeschwächt oder unterdrückt werden.

In Analogie zum Prozess der Evolution ist das Prinzip des „survival of the fittest“ eine wichtige

Kraft bei der Ausformung des Lernens und der Verarbeitung. Durch dieses Prinzip werden

Neuronen darin verstärkt, sich besser an besondere Situationen, Aufgaben Umgebungen usw.

anzupassen. Besonders in den für die Kognition zentralen Gehirnbereichen gibt es ausgedehnte

Schaltkreise inhibitorischer Interneuronen, die den Mechanismus des Wettbewerbs bewirken.

1.3.5. Lernen

Die menschliche Intelligenz wird sowohl durch die genetische Veranlagung bedingt als auch durch

das individuelle Lernen beeinflusst. Ein wichtiges Ziel der Neurokognition ist zu erklären, wie

beide Faktoren zusammenwirken um die menschliche Kognition zu erzeugen. Mit Hilfe von

Simulationen können die komplexen und feinen Abhängigkeiten untersucht werden, die zwischen

bestimmten Eigenschaften des Gehirns und dem Lernprozess bestehen.

Zusätzlich zum evolutionären Lernen geschieht das Lernen ständig in der menschlichen Kognition.

Könnte man einen relativ einfachen Lernprozess identifizieren, der auf der Basis einer geeignet

instanziierten Architektur die Milliarden von Neuronen im menschlichen Gehirn so organisiert, dass

die ganze Vielfalt der kognitiven Funktionen entsteht, dann wäre dies der „heilige Gral“ der Neurokognition. Deshalb wird die Untersuchung der Eigenschaften eines solchen Lernmechanismus, der

biologischen und kognitiven Umgebung, in der er arbeitet, und den Ergebnissen, die er erzeugt, das

Hauptgewicht haben. Damit soll aber nicht di Bedeutung der genetischen Grundlage der Kognition

vermindert werden, vielmehr können die genetischen Parameter erst im Kontext eines solchen

Lernmechanismus vollständig verstanden werden.

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 10

Das Problem des Lernens kann als Problem der Veränderung betrachtet werden. Durch das Lernen

wird die Art und Weise verändert, wie Informationen im System verarbeitet werden. Deshalb ist es

leichter zu lernen, wenn das System auf die Veränderungen in abgestufter, proportionaler Form

reagiert, statt seine Verhaltensweise radikal umzustellen. Die abgestuften Veränderungen ermöglichen es dem System verschiedene neue Ideen (d.h. Arten der Verarbeitung von Dingen) auszuprobieren und eine Art abgestufter, proportionaler Andeutung dafür zu bekommen, wie die

Veränderungen die Verarbeitung beeinflussen. Indem es sehr viele kleine Änderungen untersucht,

kann das System diejenigen auswerten und verstärken, die die Performanz verbessern, und die

anderen verwerfen.

Es gibt auch andere Lernprozesse, die von Natur aus diskreter sind als diese abgestuften, nur mit

kleinen Änderungen verlaufenden. Einer davon ist das Lernen durch Versuch und Irrtum. Dabei

führt man auf der Basis einer Hypothese einen Versuch aus und aktualisiert die Hypothese abhängig

vom Ergebnis des Versuchs. Obwohl diese Art des Lernens diskreteren Charakter hat, kann es am

besten mit denselben Arten abgestufter neuronaler Mechanismen implementiert werden, wie sie bei

den anderen Arten des Lernens verwendet werden. Ebenfalls ein Lernprozess mit diskreterem

Charakter ist das Auswendiglernen einzelner diskreter Fakten oder Ereignisse. Das Gehirn hat einen

spezialisierten Bereich, der für diese Art des Lernens besonders geeignet ist, den Hippocampus.

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

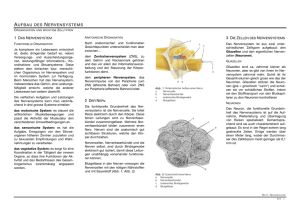

2.

2.1.

Seite 11

Neuronen

Überblick

Das Neuron stellt die grundlegenden informationsverarbeitenden Mechanismen bereit, die die

Grundlage der menschlichen Kognition sind. Biologische Neuronen sind winzige aber sehr komplexe elektrochemische Systeme. Will man simulierte Neuronen in Modellen der kognitiven Phänomene benutzen, dann muss man das Neuron stark vereinfachen und dabei seine grundlegenden

funktionalen Eigenschaften beibehalten. Aus der Perspektive des Berechnungsparadigmas kann

man sich die wesentliche Funktion eines Neurons als die eines Detektors vorstellen. Es integriert

Informationen aus verschiedenen Quellen (Eingaben) zu einer einzigen reellen Zahl, die ausdrückt,

wie gut die Informationen zu dem passen, auf dessen Entdeckung das Neuron spezialisiert ist, und

sendet Ausgabe, die das Ergebnis der Auswertung wiedergibt. Man nennt dieses Modell das

integriere-und-feure-Modell der neuronalen Funktion. Die Ausgabe wird als Eingabe für andere

Neuronen benutzt, wodurch ein kaskadenartiger Prozess durch das Netz der verknüpften Neuronen

zustande kommt.

In diesem Kapitel wird ein Überblick über die Beschreibung von Neuronen auf der Berechnungsebene und die biologischen Mechanismen, die ihnen zugrunde liegen, gegeben. Als Muster wird das

pyramidale Neuron im Kortex verwendet. Die Summe dieser biologischen Mechanismen wird als

Aktivierungsfunktion und die resultierende Ausgabe des Neurons als Aktivierungswert bezeichnet.

Für die Modellierung wird eine Punktneurons-Aktivierungsfunktion verwendet, die dieselbe Dynamik der Informationsverarbeitung verwendet wie reale biologische Neuronen, aber die räumliche

Ausdehnung des Neurons auf einen Punkt schrumpft. Dadurch wird die Implementierung erheblich

vereinfacht. Die beschriebenen Simulationen illustrieren die elementaren Eigenschaften der Aktivierungsfunktion und wie sie aus den zugrunde liegenden biologischen Eigenschaften der Neuronen

entsteht. Es wird gezeigt, wie die Aktivierungsfunktion in den Begriffen einer mathematischen

Analyse auf der Grundlage des Bayesschen Hypothesentestens beschrieben werden kann.

2.2.

Detektoren als Modelle von Neuronen

In einem Standardcomputer sind sie Speicherung und die Verarbeitung auf verschiedene Module

verteilte Prozesse. Die Verarbeitung erfolgt zentralisiert in der CPU. Die Information muss aus dem

Speicher geholt, der CPU übergeben und das Ergebnis in den Speicher gebracht werden. Im Gehirn

dagegen erfolgt die Informationsverarbeitung nach dem PDP-Paradigma. Der Speicher (das

Gedächtnis) ist ebenso wie die Verarbeitung über das ganze Gehirn verteilt. Das Modell eines

Neurons muss deshalb erklären können, wie ein Neuron Speicher- und Verarbeitungsfunktionen

verteilt bereitstellt, aber in Verbindung mit den anderen Neuronen etwas Nützliches produziert.

Die Arbeitsweise eines Neurons wird durch die Vorstellung eines Detektors erklärt. Vereinfachend

kann man sich ein Neuron als etwas vorstellen, das die Existenz einer Menge von Bedingungen

entdeckt und darauf mit einem Signal reagiert, das mitteilt, bis zu welchem Grad die Bedingungen

zugetroffen haben.

Die Reaktion eines Neurons ist oft kontextsensitiv, d.h. sie hängt von anderen Dingen ab, die man

sonst nicht bemerkt hätte. Zum Beispiel kann es passieren, dass ein Streifendetektor in den unteren

Stufen des visuellen Systems bei einer bestimmten Szene nicht reagiert, obwohl er es nach der Lage

der Streifen müsste. Er wird dann von anderen Aspekten der Szene, also dem Kontext, übersteuert.

Es kann auch vorkommen, dass der Detektor zum einen Zeitpunkt, an dem die Szene gesehen wird,

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 12

reagiert, und am nächsten nicht, wegen dynamischer Änderungen im Netz, die den Fokus der

Aufmerksamkeit bestimmen.

Die Fähigkeit, etwas zu entdecken, passt am besten zur Verarbeitung von Sensorinformationen,

trotzdem kann sie aber auch zur Beschreibung der Arbeitsweise anderer Neuronen benutzt werden.

Ein Neuron des motorischen Systems kann z.B. entdecken, wann eine bestimmte motorische

Reaktion ausgeführt werden sollte und seine Ausgabe führt dann zur Ausführung der Reaktion.

Auch interne Aktionen, z.B. die Fokussierung der Aufmerksamkeit oder das Suchen nach einem

Wort um einen Sachverhalt zu beschreiben, können als Entdecken der Bedingungen zur Ausführung

der gewünschten Aktionen beschrieben werden. Ein Vorteil des Detektormodells ist, dass es auf

einfache Weise die ganze Komplexität und Feinheit in einem elementaren Rahmen unterbringen

kann, der trotzdem zunächst in sehr einfachen und intuitiven Begriffen verstanden werden kann

durch die Analogie mit einfachen Geräten wie dem Rauchdetektor.

Das Detektormodell eines Neurons betont mehrere wichtige Eigenschaften. Es betont, dass Neuronen bestimmten Zwecken gewidmete, spezialisierte Prozessoren sind und keine universellen

Speicherzellen wie in einem Computer, die mit beliebigen Inhalten gefüllt werden können. Durch

die Art, wie jedes Neuron mit anderen Neuronen im Netz verbunden ist, wird es der Entdeckung

einer bestimmten Menge von Dingen gewidmet. Diese Widmung befähigt das Neuron, gleichzeitig

Speicher- und Verarbeitungsfunktionen auszuführen. Durch den Speicher kann es die Bedingungen

in Erinnerung rufen, die es auf seine Eingaben anwendet um zu entdecken, was es entdecken kann,

und seine Verarbeitung ist die Art und Weise wie es diese Bedingungen auswertet und die

Ergebnisse anderen Neuronen mitteilt.

Unter der Repräsentation eines Neurons versteht man meistens das, was es entdeckt. Zum Beispiel

ein Neuron, das einen Streifen mit einer bestimmten Orientierung und an einer bestimmten Position

entdeckt, repräsentiert genau diesen Streifen. Weil die Neuronen gewidmet und spezialisiert sind,

kann man sich diese Repräsentation als eine permanente Eigenschaft jedes Neurons vorstellen.

Trotzdem muss aber das Neuron aktiv werden um die Aktivierung anderer Neuronen zu beeinflussen, deshalb ist es zweckmäßig, zwischen einer Bedeutung von Repräsentation, die eine relativ

permanente Spezialisierung eines Beurons bezeichnet (latente oder gewichtsbasierte Repräsentation), und der aktiven Repräsentation, die von den gerade aktiven Neuronen erzeugt wird, zu unterscheiden.

2.2.1. Erklärung der Bestandteile des Neurons mittels des Detektormodells

Eine der am meisten genutzten Vereinfachungen des Neurons ist das integriere-und-feure-Modell.

Abbildung 2.1 stellt dar, dass das Detektormodell sich sehr gut in das integriere-und-feure-Modell

des Neurons abbilden lässt.

Ein Detektor benötigt zunächst Eingaben, die ihm die für seine Aufgabe notwendige Information

liefern. Ein Neuron erhält seine Eingaben über die Synapsen an den Dendriten. Diese sind Verzweigungen, die sich über größere Entfernungen vom Zellkörper weg erstrecken. Im menschlichen

Gehirn sind verhältnismäßig wenige Neuronen direkt mit der Sensoreingabe verbunden, alle anderen erhalten ihre Eingaben aus vorangegangenen Stufen der Verarbeitung. Die Verkettung mehrerer

Ebenen von Detektoren kann zu leistungsfähigeren und effizienten Entdeckungsfähigkeiten führen

als die direkte Verarbeitung der Sensoreingabe. Allerdings ist es dadurch auch schwieriger herauszufinden, auf welcher Art von Eingabe ein Neuron seine Entscheidung über einen entdeckten Inhalt

durchführt, wenn es so indirekt mit den Sensoreingaben verbunden ist.

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 13

Ausgabe

Axon

Zellkörper,

Membranpotenzial

Integration

Dendriten

Eingaben

Synapsen

Detektor

Neuron

Abbildung 2.1

Anschließend verarbeitet der Detektor seine Eingaben. Im Detektormodell des Neurons wird der

relative Beitrag der verschiedenen Eingaben zur gesamten Entdeckungsentscheidung mittels der

Gewichte gesteuert, die im Neuron der relativen Effizienz entspricht, mit der eine Synapse dem

Neuron eine Eingabe übermittelt. Beim Neuron heißt dieser Effekt synaptische Wirksamkeit oder

synaptische Stärke. Die Gewichte sind entscheidend um zu bestimmen, was ein Neuron entdeckt.

Neuronen können Aktivitätsmuster über ihren Eingaben entdecken, wobei diejenigen Eingabemuster, die am besten dem Gewichtsmuster entsprechen, die stärkste Entdeckungsreaktion erzeugen.

Die Eingaben werden nicht als einzelne Muster analysiert, sondern als Teil des gesamten Eingabemusters. Dies geschieht dadurch, dass die einzelnen Eingaben zu einem Gesamtwert integriert

werden, der ein aggregiertes Maß dafür ist, wie gut das Eingabemuster zu dem erwarteten, d.h. zu

dem, worauf das Neuron spezialisiert ist, passt. Die Integration der Eingaben wird durch die

elektrischen Eigenschaften der Dendriten realisiert, aus denen ein Membranpotenzial am Zellkörper

entsteht, das das Ergebnis der Integration wiedergibt. Das Neuron kann also als ein kleines

elektrisches System betrachtet werden.

Nach der Integration der Eingaben muss ein Detektor die Ergebnisse seiner Verarbeitung in Form

einer Ausgabe mitteilen. Viele Detektoren haben zusätzlich einen Schwellenwert oder ein Kriterium, das noch vor der Ausgabe angewendet wird um zu entscheiden, ob eine Ausgabe erzeugt wird

oder nicht.

Das Neuron hat auch einen Schwellenmechanismus, wodurch es inaktiv bleibt, so lange es nicht

etwas mit ausreichender Stärke und Zuverlässigkeit entdeckt, was es wert ist, den anderen Neuronen mitzuteilen. Ein Neuron benötigt Stoffwechselressourcen um mit anderen Neuronen zu kommunizieren, deshalb ist es sinnvoll, den Kommunikationsprozess für wichtige Ereignisse zu reservieren. Wenn die integrierte Eingabe den Schwellenwert überschreitet, dann sagt man, das Neuron

feuert. Der Schwellenwert wird am Beginn einer langen, vom Zellkörper ausgehenden verzweigten

Faser angewendet, dem Axon. Das Axon bildet Synapsen an den Dendriten anderer Neuronen und

liefert ihnen Eingaben.

2.3.

Die Biologie des Neurons

Abbildung 2.2 zeigt ein Neuron, und zwar ein pyramidales Neuron aus dem Kortex. Trotz dieser

differenzierten Struktur handelt es sich um eine einzige Zelle. Die Zelle hat einen Körper mit einem

Kern, ist mit Flüssigkeit und zellulären Organellen gefüllt und von einer Membran umgeben wie

andere Körperzellen. Das Neuron ist aber einzigartig in der Hinsicht, dass es fadenartige

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 14

Auswüchse besitzt, die Dendriten und das Axon. Die meisten Eingaben in das Neuron kommen

über die Dendriten, die Ausgabe erfolgt über das Axon.

Abbildung 2.2

Damit die Neuronen miteinander kommunizieren können, obwohl sie in Membrane eingeschlossen

sind, gibt es in der Membran kleine Öffnungen, die so genannten Kanäle. Die elementaren Mechanismen der Informationsverarbeitung (Integration der Eingaben, Schwellenwerttest und Erzeugung

von Ausgaben) beruhen auf der Bewegung von Ionen durch die Kanäle in die Zelle hinein und aus

ihr heraus und innerhalb der Zelle selbst. Die Ionen bewegen sich nach den grundlegenden

Prinzipien der Elektrizität und der Diffusion. Mit diesen Prinzipien und den mit ihnen verbundenen

Gleichungen kann man eine mathematische Beschreibung dafür entwickeln, wie ein Neuron auf

Eingaben von anderen Neuronen reagiert.

Ein zentraler Bestandteil des elektrischen Modells des Neurons ist die Ladungsdifferenz zwischen

dem Neuron und seiner Umgebung. Diese Differenz heißt Membranpotenzial, denn die Membran

trennt das Innere von der Außenseite des Neurons, weshalb an der Membran die Differenz der

Ladung anliegt. Der Ionenfluss in und aus der Zelle verändert das Membranpotenzial. Diese Veränderungen werden zu anderen Teilen des Neurons propagiert und integrieren sich mit anderen dort

befindlichen Potenzialen. Diese Propagierung und Integration kann damit erklärt werden, dass man

die Dendriten als Kabel betrachtet und ihre Kabeleigenschaften untersucht.

Wenn also die Ionen durch Kanäle in die Dendriten hineinfließen, propagieren sie in den Zellkörper

und werden dort integriert. An der Stelle, wo der Zellkörper in das Axon übergeht, bestimmt das

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 15

Membranpotenzial, ob das Neuron feuert. Die Schwelleneigenschaft des Feuerprozesses wird durch

eine Menge spezieller Kanäle realisiert, die zu dem Membranpotenzial führen. Die Kanäle öffnen

sich nur, wenn das Membranpotenzial ausreichend erhöht ist. Diese Kanäle werden spannungsgesperrt (voltage gated) genannt. Es gibt mehrere Typen solcher Kanäle.

Außer den elektrischen Prozessen werden auch chemische Prozesse benötigt, um die Informationsverarbeitung im Gehirn zu ermöglichen. Viele Typen von Neuronen benutzen bestimmte chemische

Stoffe statt eines elektrischen Signals, um ihre Ausgaben anderen Neuronen zu übermitteln. Andere

Neuronen benutzen aber direkt elektrische Signale. Die kortikalen Neuronen benutzen die chemische Übertragung. Diese chemischen Stoffe, genannt Neurotransmitter, werden an den Synapsen

abgegeben. Die Abgabe wird durch einen elektrischen Impuls ausgelöst, der durch das Axon

kommt, das so genannte Aktionspotenzial, und nachdem sie abgegeben sind, diffundieren die Stoffe

zu den Dendriten und binden dort chemisch an Rezeptoren, wodurch die Kanäle geöffnet werden.

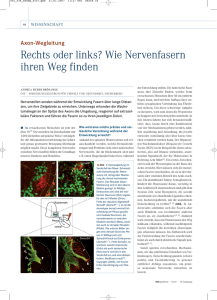

2.3.1. Das Axon

Die Aktion des Feuerns durch ein Neuron wird verschiedentlich Spiking genannt oder einen Spike

feuern oder ein Aktionspotenzial auslösen. Der Spike wird am Beginn des Axons initiiert, einer

Stelle, die Axonhügel heißt, vgl. Abbildung 2.3. Hier sind zwei Arten von spannungsgesperrten

Kanälen stark konzentriert,die nur aktiv werden, wenn das Membranpotenzial einen bestimmten

Schwellenwert erreicht. Das Spiking des Neurons wird also durch den Wert des Membranpotenzials

am Axonhügel bestimmt.

Wenn sich eine Art von spannungsgesperrten Kanälen öffnet, steigert sich die Erregung des

Neurons. Das veranlasst die andere Art von Kanälen sich zu öffnen und diese Kanäle hemmen das

Neuron. Das Ergebnis ist ein Spike von Erregung gefolgt von einer Hemmung. Wenn das Membranpotenzial durch die inhibitorischen Kanäle wieder vermindert worden ist tendiertes dazu, dass

Ruhepotenzial geringfügig zu unterschreiten. Dies verursacht eine Hemmungsperiode nach einem

Spike, in der das Neuron so lange keinen weiteren Spike feuern kann, bis das Membranpotenzial

wieder bis zum Schwellenwert angestiegen ist. Die Hemmungsperiode kann auch durch die anhaltende Inaktivität der spannungsgesperrten Kanäle verursacht werden. Die Hemmungsperiode

bewirkt eine feste maximale Feuerrate des Neurons.

Propagierung

des Aktionspotenzials

Ranvier-Knoten

Myelin

Axonhügel

Abbildung 2.3

Der Spike wird das Axon entlang geschickt mittels eines aktiven und eines passiven Mechanismus.

Der aktive Mechanismus baut eine Kettenreaktion auf, an der dieselbe Art von spannungsgesperrten

Kanälen entlang des Axons beteiligt ist. Der Spike, der am Anfang des Axons ausgelöst wird,

steigert das Membranpotenzial ein kleines Stück abwärts entlang des Axons und löst dort wieder

einen Spiking-Prozess aus usw., wie bei einem Dominoeffekt. Dieser aktive Mechanismus benötigt

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 16

aber relativ viel Energie und ist außerdem langsam, weil er das Öffnen und Schließen von Kanälen

erforderlich macht. Deshalb haben die meisten Neuronen Abschnitte am Axon, in denen der Spike

mittels des passiven Mechanismus propagiert wird. Dieser ist im Wesentlichen derselbe wie der in

den Dendriten verwendete, er ist ein rein elektrischer Prozess und ist wesentlich schneller als der

aktive.

Der passive Prozess hat wie alle elektrischen Leitungen den Nachteil, dass er sich abschwächt über

die Entfernung hinweg. Deshalb hat das Neuron gewissermaßen Relais-Stationen am Axon, an

denen der aktive Spiking-Mechanismus das Signal wieder auffrischt. Diese Relais-Stationen heißen

Ranvier-Knoten. Um die passive Leitung effektiver zu machen, ist das Axon zwischen den RanvierKnoten mit einer isolierenden Scheide umgeben, die Myelin heißt. Mittels dieser Kombination von

Propagierungsmechanismen kann das Neuron effizient Signale über relativ lange Entfernungen

(mehrere cm) in relativ kurzer Zeit schicken (im Millisekundenbereich).

2.3.2. Die Synapse

Die Synapse ist die Verbindung zwischen dem Axon des Senderneurons und einem Dendrit des

Empfängerneurons. Die Abbildungen 2.4 und 2.5 zeigen eine Mikroskopaufnahme und ein Schemabild einer Synapse. Der Endpunkt des Axons, der zur Synapse gehört, heißt Axonende oder Axonknopf. Das Gegenstück dazu ist bei manchen Synapsen ein synaptischer Dorn an dem Dendrit, bei

anderen ist es direkt die Membran des Dendrits.

Abbildung 2.4

Abbildung 2.5

Wenn der elektrische Impuls den Axonknopf erreicht, aktiviert er Calciumionen (Ca++), indem er

spannungsgesperrte Kanäle öffnet, so dass die Ca++-Ionen in das Axonende einströmen können,

zusätzlich können noch interne Speicher von Ca++-Ionen geöffnet werden. Die Calciumionen veranlassen die Neurotransmitter enthaltenden Vesikel, sich an die Membran des Axonknopfs zu binden.

Dadurch scheiden sie den Neurotransmitter in den synaptischen Spalt aus. Der Neurotransmitter

diffundiert durch den Spalt und bindet sich an die postsynaptischen Rezeptoren. Diese reagieren

darauf in unterschiedlicher Weise. Die ionotropen Rezeptoren öffnen Kanäle, die Ionenflüsse

ermöglichen, die metabotropen Rezeptoren stoßen verschiedene chemische Prozesse innerhalb des

postsynaptischen Neurons an. Es gibt verschiedene Arten von Neurotransmitterstoffen, die von

verschiedenen Typen von Senderneuronen ausgeschieden werden, und diese binden an verschiedene Rezeptoren und lösen damit unterschiedliche Reaktionen im Empfängerneuron aus.

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 17

Um ein kontinuierliches Ausscheiden von Neurotransmitter über mehrere Spikes hinweg zu ermöglichen, wird das Vesikelmaterial, das an die Membran gebunden wird, später recycelt um neue

Vesikel zu produzieren, und neuer Neurotransmitter und andere wichtige Moleküle werden über

Mikroröhren in die Vesikel eingebracht. Auch der in den Spalt ausgesonderte Neurotransmitter

muss zur Wiederverwendung zurück gebracht werden (reuptake). Verbleibt der Neurotransmitter im

Spalt (durch Unterdrückung des Reuptake-Mechanismus), dann aktiviert er die Rezeptoren dauernd,

was Probleme verursachen kann. Viele Drogen beeinflussen diesen Ablauf, unter anderem blockieren sie die Rezeptoraktivierung, das Reuptake und die postsynaptischen chemischen Prozesse, die

von den Rezeptoren angestoßen werden. Sie eignen sich deshalb zur Untersuchung des gesamten

Ablaufs.

Die Synapse hat einige dynamische Eigenschaften, die ihr Verhalten nach einer vorangegangenen

Aktivität beeinflussen. Eine davon ist die Unterstützung gepaarter Pulse. Dabei ist der zweite Spike,

wenn er dicht genug auf den ersten folgt, stärker als der erste. Dieser Effekt kann durch im Axonende verbleibende Calciumionen oder durch weiter bestehende Bindungen von Vesikeln an die

Membran als Folge des vorangegangenen Ausscheidungsvorgangs zustande kommen. Ebenso ist es

wahrscheinlich, dass anhaltende hohe Feuerraten die synaptischen Ressourcen erschöpfen, z.B.

Neurotransmitter und Ca++, was eine erhöhte Zahl von Ausscheidungsfehlern zur Folge hat, bei

denen während eines Spikes kein Neurotransmitter ausgeschieden wird. Dies kann zu einer

sättigenden Nichtlinearität der neuronalen Ausgabefunktion führen.

Einige wichtige Merkmale der Biologie der Synapse sind die folgenden: Die verschiedenen Komponenten der Synapse können auf mehrere Arten die Stärke der Informationsübertragung vom Sender

zum Empfänger beeinflussen. Im Berechnungsmodell wird diese Stärke durch das Gewicht

zwischen den Einheiten repräsentiert. Die Modifikation eines oder mehrerer dieser Faktoren können

Lernen erzeugen. Die wichtigsten präsynaptischen Komponenten der Synapsenstärke sind die Zahl

der Vesikel, die sich bei jedem Aktionspotenzial entleeren, die Menge an Neurotransmitter in jedem

Vesikel und die Wirksamkeit des Reuptake-Mechanismus. Die wichtigsten postsynaptischen

Faktoren sind die Gesamtzahl der Rezeptoren, die Anordnung und Nähe der Rezeptoren zu den

präsynaptischen Ausscheidungsstellen und die Wirksamkeit der einzelnen Kanäle bezüglich des

Ionenflusses. Es kann auch sein, dass die Form des dendritischen Dorns einen Einfluss auf die

Übertragung des elektrischen Signals von der Synapse zu dem Dendriten hat. Derzeit ist es noch

Gegenstand der Forschung, welche dieser Faktoren beim Lernen modifiziert werden, vermutlich

tragen aber mehrere Faktoren zum Lernen bei.

2.3.3. Der Dendrit

Biologische betrachtet sind die wichtigsten Teile eines Dendriten die Rezeptoren. Es gibt viele

unterschiedliche Typen von Rezeptoren, im Kortex sind zwei davon die wichtigsten, besser gesagt:

zwei Neurotransmitter/Rezeptor-Kombinationen. Die eine Kombination bindet den Neurotransmitter Glutamat an die Rezeptoren AMPA, NMDA und mGlu. Der von AMPA aktivierte Kanal stellt

die primäre exzitatorische Eingabe her, denn sie ermöglicht Natriumionen (Na+) in den Dendrit einzuströmen. Diese Ionen erhöhen das postsynaptische Membranpotenzial so dass das Neuron eventuell feuern kann. Wenn die exzitatorischen Kanäle geöffnet sind heißt das entstehende Membranpotenzial „exzitatorisches postsynaptisches Potenzial“ (EPSP). Der von NMDA aktivierte Kanal ist

ebenfalls exzitatorisch, ist aber wahrscheinlich wichtiger wegen seiner Wirkung auf das Lernen,

denn er ermöglicht den Calciumionen einzuströmen, die chemische Prozesse auslösen können, die

zum Lernen führen. Der mGlu-Rezeptor (metabotropisches Glutamat) löst im postsynaptischen

Neuron verschiedene chemische Prozesse aus, die ebenfalls Auswirkung auf das Lernen haben

können.

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 18

Die andere wichtige Neurotransmitter/Rezeptor-Kombination benutzt den Neurotransmitter GABA,

der an verschiedene GABA-Rezeptoren binden kann. Diese öffnen Kanäle, durch die Chloridionen

(C1) einströmen können, die inhibitorische Wirkung im postsynaptischen Neuron haben, denn sie

Vermindern die Wahrscheinlichkeit, dass das Neuron feuert. Diese inhibitorischen Eingaben

werden „inhibitorische postsynaptische Potenziale“ (IPSP) genannt. Es gibt zwei verschiedene

Typen von GABA-Rezeptoren, GABA-A und GABA-B, die sich in ihrer zeitlichen Dynamik

unterscheiden. Die GABA-B-Kanäle bleiben länger offen, deshalb diese Rezeptoren eine stärkere

inhibitorische Wirkung.

Ein bestimmter Typ von Neuronen scheidet nur einen Typ von Neurotransmitter aus, und dieser

aktiviert nur bestimmte Typen von Rezeptoren. Das bedeutet, dass ein kortikales Neuron nur

exzitatorische oder inhibitorische Signale aussendet, aber nicht beides. Das betrifft aber nur die

Ausgabe des Neurons, es kann sowohl exzitatorische als auch inhibitorische Signale empfangen. Es

ist in der Tat eine der wichtigsten Funktionen eines Neurons und eines Netzes von Neuronen, ein

Gleichgewicht zwischen exzitatorischen und inhibitorischen Eingaben herzustellen.

2.4.

Die Elektrophysiologie des Neurons

2.4.1. Elementare Elektrizität

Elektrizität kommt durch die Ladung und Bewegung elementarer Teilchen zustande. Die elementarsten Ladungsträger sind die Elektronen und die Protonen, die gleich an Masse aber entgegengesetzt geladen sind. Normalerweise besitzen Atome gleiche Anzahlen von Elektronen und Protonen,

manche allerdings haben ein oder zwei Ladungsträger der einen Sorte weniger, diese heißen Ionen.

Je nachdem, welche Ladungsträger fehlen, sind die Ionen positiv oder negativ geladen. Für die

neuronalen Prozesse sind die Natrium- (Na+), Chlor- (Cl), Kalium- (K+) und Calcium- (Ca++)

Ionen von besonderer Bedeutung.

Die Anziehung entgegengesetzt geladener Ionen und die gegenseitige Abstoßung gleich geladener

Ionen verursacht Strom, d.h. fließende Ladung. Sind die Ionen beweglich wie in einer Flüssigkeit,

dann kann derselbe Typ von Strom durch abfließende positive Ladungen oder durch einfließende

negative Ladungen hervorgerufen werden, nämlich negativer Strom, im umgekehrten Fall, bei

abfließender negativer Ladung oder einfließender positiver Ladung entsteht positiver Strom.

Die Ungleichheit der Ladungsverteilung in einem bestimmten Bereich ruft dort ein elektrisches

Potenzial hervor. Es spiegelt die Menge entgegen gesetzter Ladung wider, die potenziell angezogen

werden kann. Werden Ladungen angezogen, dann nimmt das Potenzial gleichzeitig ab, d.h. das

Potenzial eines bestimmten Bereichs verändert sich in Abhängigkeit vom Strom, der in diesen

Bereich fließt. Dieser Zusammenhang spielt für die Funktionsweise der Neuronen eine wichtige

Rolle.

Die Ionen müssen bei ihrer Bewegung normalerweise einen Widerstand überwinden, der durch

andere Flüssigkeitsteilchen oder durch eine Membran mit Poren, durch die die Ionen durchtreten

können, verursacht sein kann. Je größer der Widerstand ist, desto größer muss das Potenzial sein,

um die Ionen zu bewegen. Das ist das Ohmsche Gesetz

I

V

R

Die Inverse des Widerstands wird als Leitfähigkeit bezeichnet und geschrieben als G. Es ist also

G R1 . Mit G kann man das Ohmsche Gesetz in der folgenden Form schreiben:

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 19

I = VG

Die Art, wie Neuronen Information integrieren, wird auf der Basis des Ohmschen Gesetzes

beschrieben. Das Öffnen und Schließen der Membrankanäle bestimmt die Leitfähigkeit G für jeden

Typ von Ion als Funktion der Eingabe, die das Neuron erhält. Das Potenzial V ist gerade das

Membranpotenzial. Das Potenzial kann aktuell mit Hilfe des Ohmschen Gesetzes berechnet werden,

indem der Strom I bestimmt wird. Durch iterative Anwendung des Ohmschen Gesetzes können die

Potenzialänderungen im Zeitverlauf berechnet werden. Jedes Ion reagiert auf ein vorliegendes

Membranpotenzial in spezifischer Weise, mit bestimmt durch die Diffusion, und trägt so auf je

eigene Weise zum Gesamtstrom bei.

2.4.2. Diffusion

Ähnlich wie beim Strom ist auch für die Diffusion die Ursache eine unausgeglichene Verteilung

von Teilchen. Die Diffusion veranlasst Teilchen irgendeines Typs sich gleichmäßig im Raum zu

verteilen. Sobald also eine starke Konzentration einer bestimmten Teilchenart an einem Ort

vorliegt, bewirkt die Diffusion die Ausbreitung und gleichmäßige Verteilung der Teilchen im

ganzen Raum. Die Ursache der Diffusion ist der Sachverhalt, dass Atome in einer Flüssigkeit oder

in einem Gas sich ständig hin und her bewegen und dies hat einen Mischprozess zur Folge, der

dafür sorgt, dass alles gleichmäßig verteilt ist. Diffusion ist also keine direkte Kraft wie das

elektrische Potenzial, sondern eher ein indirekter Effekt der sich bewegenden Materie.

Eine wichtige Eigenschaft der Diffusion ist, dass sie für eine gleichmäßige Verteilung individuell

für jede einzelne Teilchenart sorgt. Deshalb kann eine starke Konzentration einer Teilchenart nicht

durch eine starke Konzentration einer anderen Teilchenart kompensiert werden, selbst wenn die

Ladung der beiden Arten gleich ist (z.B. Na+ und K+). Bei der Elektrizität dagegen spielt die

Teilchenart keine Rolle, es kommt nur auf die Größe der Ladung an.

Da die Diffusion ähnliche Wirkung hat wie die Elektrizität und wie eine Kraft wirkt, auch wenn sie

eigentlich keine ist, wird sie trotzdem durch eine Kraftgleichung beschrieben. Sie beschreibt, was

mit Ionen als Folge eines Konzentrationsunterschieds geschieht (bei der Elektrizität als Folge eines

Ladungsunterschieds). In einem Behälter sei eine Flüssigkeit durch eine Trennwand in zwei

Bereiche unterteilt. Die Trennwand kann entfernt werden. Nun gibt man in einen der beiden

Bereiche eine größere Menge eines bestimmten Typs von Ionen. Dadurch entsteht eine Konzentrationsdifferenz oder ein Gradient zwischen den beiden Bereichen und dieser bewirkt eine Art

Konzentrationspotenzial, das die Ionen dazu veranlasst, in den anderen Bereich zu fließen. Wird die

Trennwand entfernt, dann entsteht ein Diffusionsstrom der abfließenden Ionen, wie bei der Elektrizität, und das Konzentrationspotenzial nimmt ab. Der Diffusionskoeffizient entspricht hierbei der

Leitfähigkeit bei der Elektrizität und es gilt eine Entsprechung zum Ohmschen Gesetz

I = DC

Diese Gleichung heißt das erste Ficksche Gesetz. I ist der Diffusionsstrom, D der Diffusionskoeffizient und C das Konzentrationspotenzial.

2.4.3. Elektrisches Potenzial versus Diffusion: Das Gleichgewichtspotenzial

Um den Strom zu berechnen, den eine bestimmte Art von Ionen erzeugt, muss man die Wirkung der

elektrischen und der Diffusionskräfte auf die Ionen in geeigneter Weise addieren. Zu diesem Zweck

muss man den Gleichgewichtspunkt bestimmen, an dem sich die beiden Kräfte gegenseitig in ihrer

Wirkung neutralisieren, so dass die Konzentration der Ionen genau so bleibt, wie sie ist. An diesem

Punkt ist der durch diese Ionenart verursachte Strom null. Würde es nur elektrische Kräfte geben,

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 20

dann wäre der Gleichgewichtspunkt dort, wo das elektrische Potenzial null ist. Wegen der Konzentrationsdifferenz der Ionen zwischen der Innenseite und der Außenseite eines Neurons ist der

Gleichgewichtspunkt aber nicht dort.

Die absoluten Werte der Stromstärke, die hier vorkommen, sind relativ klein, deshalb kann man den

Ansatz machen, dass die relativen Konzentrationen eines Ions innerhalb und außerhalb der Zelle,

die typischerweise stark voneinander abweichen, relativ konstant bleiben. Außerdem verfügt das

Neuron über einen speziellen Mechanismus um eine ziemlich feste Menge relativer Konzentrationen aufrecht zu erhalten. Der Gleichgewichtspunkt kann also durch die Größe des elektrischen

Potenzials ausgedrückt werden, das zum Ausgleich für die ziemlich konstante Diffusionskraft

erforderlich ist. Dieses Potenzial wird als Gleichgewichtspotenzial oder Umkehrungspotenzial (weil

der Strom auf beiden Seiten des Nullpunkts das Vorzeichen wechselt) oder Treibpotenzial (weil der

Ionenfluss das Membranpotenzial zu diesem Wert treibt) bezeichnet.

Das Gleichgewichtspotenzial E kann als Korrekturfaktor im Ohmschen Gesetz verwendet werden,

indem man es von dem elektrischen Potenzial V subtrahiert, wodurch das Nettopotenzial V – E

entsteht. Das resultierende Gesetz wird Diffusions-korrigierte Version des Ohmschen Gesetzes

genannnt. Es kann für jede Ionenart einzeln verwendet werden und liefert den durch die jeweilige

Art erzeugten Anteil am Gesamtstrom. Die Diffusions-korrigierte Version ist

I = G(V – E)

2.4.4. Die neuronale Umgebung und die Ionen

Um die Funktionsweise eines Neurons auf der Basis der elektrischen und Diffusionsprozesse zu

verstehen, muss man die interne und externe Umgebung des Neurons betrachten, insbesondere unter

dem Aspekt der Konzentrationen verschiedener Ionen. Die Neuronen befinden sich im Gehirn in

einer flüssigen Umgebung, die eine ähnliche Zusammensetzung wie Meerwasser hat. Man nennt

diese Umgebung den extrazellulären Raum. Wie im Meerwasser ist darin eine gewisse Menge an

Kochsalz gelöst, wodurch eine beträchtliche Konzentration an Na+- und Cl-Ionen gegeben ist. Die

anderen Ionen, die noch von Bedeutung sind, sind K+ und Ca++.

Wenn die Ionen ungehindert durch offene Membrankanäle fließen könnten, dann wäre die

Konzentration der verschiedenen Ionen im Innern der Zelle gleich groß wie außerhalb. Dies wird

aber durch zwei Mechanismen verhindert, so dass ein Ungleichgewicht der Konzentrationen an der

Membran entsteht. Der erste Mechanismus ist eine so genannte Natrium-Kalium-Pumpe, die aktiv

für ein Ungleichgewicht der Konzentrationen von Natrium und Kalium sorgt. Sie pumpt Na+-Ionen

aus der Zelle hinaus und eine kleinere Menge von K+-Ionen in die Zelle hinein. Der zweite Mechanismus ist die selektive Durchlässigkeit der Kanäle, aufgrund derer ein Kanal nur einer Art oder

einigen wenigen Arten von Ionen das Passieren erlaubt. Viele der Kanäle sind außerdem normalerweise geschlossen, wenn sie nicht speziell aktiviert werden, z.B. durch einen Neurotransmitter. Die

Natrium-Kalium-Pumpe erzeugt also ein Ungleichgewicht der Ionenkonzentrationen und die selektiven Kanäle erhalten dieses Ungleichgewicht und ändern es dynamisch.

Die Natrium-Kalium-Pumpe verbraucht Energie, sie lädt gewissermaßen die Batterie auf, die das

Neuron antreibt. Die Herstellung von Ungleichgewichten bei zwei Ionenarten hat andere Ungleichgewichte zur Folge. Eine unmittelbare Konsequenz der verhältnismäßig geringen internen Konzentration an Na+-Ionen ist das negative Ruhepotenzial des Neurons. Dieses ist das Potenzial, das

besteht, wenn keine Eingaben in das Neuron gemacht werden. Es beträgt typischerweise -70

Millivolt (-70mV).

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 21

Im Folgenden werden für die vier wichtigsten Ionen die internen und externen Konzentrationen

angegeben, die elektrischen und Diffusionskräfte bestimmt und die Kanäle untersucht, durch die sie

in das Neuron hinein oder aus ihm hinaus fließen können. In Abbildung 2.6 ist die Beschreibung

grafisch für drei Arten der Ionen dargestellt.

Inhibitorische

synaptische

Eingabe

Cl

Exzitatorische

synaptische

Eingabe

Na+

-70

Leck

Cl

+

Vm

+55 Vm

K+

+

Na/KPumpe

Na

K

-70

Vm

-70 mV

Vm

0 mV

Abbildung 2.6

Na+

Da die Konzentration an Natrium wegen der Natrium-Kalium-Pumpe außerhalb des Neurons größer

ist als innerhalb, drückt die Diffusionskraft die Ionen in das Neuron hinein. Um diese Kraft durch

eine elektrische Kraft auszugleichen würde das Neuron eine positive Ladung im Innern benötigen.

Deshalb ist das Gleichgewichtspotenzial von Na+ positiv mit einem Wert von ungefähr +55 mV. Es

gibt zwei Haupttypen von Kanälen, durch die Na+ fließen kann. Der wichtigste ist in diesem

Zusammenhang der exzitatorische synaptische Eingabekanal, der normalerweise geschlossen ist,

aber durch das Binden des Neurotransmitters Glutamat geöffnet wird. Es gibt außerdem einen

spannungsgesperrten Na+-Kanal, dessen Öffnen und Schließen vom Membranpotenzial abhängt.

Allgemein spielt Na+ eine wesentliche Rolle für die Aktivierung des Neurons, denn die Diffusionskräfte drücken es tendenziell in das Neuron hinein, was zu einer Erhöhung des Membranpotenzials

führt. Die Aktivierung wird deshalb auch Depolarisation genannt, denn sie vermindert die Polarisation des Membranpotenzials, d.h. bringt sie an den Wert null heran.

Cl

Durch das von der Natrium-Kalium-Pumpe hergestellte negative Ruhepotenzial werden die ClIonen aus dem Neuron hinausgedrückt, was zu einem Ungleichgewicht der Konzentration mit mehr

Chlorionen außerhalb als innerhalb des Neurons führt. Deshalb drückt die Diffusionskraft die

Chlorionen in das Neuron hinein. Die Diffusionskraft wird aber genau durch das negative Ruhepotenzial ausbalanciert; insgesamt ergibt sich ein Gleichgewichtspotenzial von -70 mV. Der

Hauptkanal für die Chlorionen ist der inhibitorische synaptische Eingabekanal, der durch den

Neurotransmitter GABA geöffnet wird. Da das Gleichgewichtspotenzial für Cl dasselbe ist wie das

Ruhepotenzial, hat die Inhibition bei diesen Neuronen so lange nur einen geringen Effekt, bis das

Neuron erregt wird und sein Membranpotenzial ansteigt. Dieses Phänomen wird oft als verschobene

Inhibition bezeichnet.

K+

Die Konzentration von Kalium hängt direkt und indirekt mit der Natrium-Kalium-Pumpe zusammen. Die direkte Wirkung ist, dass eine gewisse Menge Kalium in die Zelle gepumpt wird. Da die

Pumpe ein negatives Ruhepotenzial herstellt, wird sekundär das positiv geladene Kaliumion noch

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 22

zusätzlich in die Zelle hineingedrückt. Deshalb gibt es in der Zelle eine wesentlich größere Kaliumkonzentration als außerhalb. Deshalb drückt die Diffusionskraft die Ionen wieder aus der Zelle

hinaus. Die Diffusionskraft wird größtenteils durch das Ruhepotenzial ausbalanciert, aber weil das

Ion aktiv in die Zelle hineingepumpt wird, ist seine innere Konzentration sogar höher als von dem

Ruhepotenzial allein zu erwarten wäre, deshalb ist sein Gleichgewichtspotenzial etwa -90 mV. Es

gibt viele verschiedene K+-Kanäle, der wichtigste in diesem Kontext ist der Leck-Kanal, der immer

offen ist und kleine Mengen von Kalium austreten lässt. Dieser Kanal lässt aber auch kleine

Mengen von Na+ einströmen, deshalb ist das Gleichgewichtspotenzial für die Leitfähigkeit dieses

Kanals nicht genau dasselbe wie für das K+-Ion, es ist vielmehr dasselbe wie das Ruhepotenzial,

nämlich -70 mV. Es gibt auch einen spannungsgesperrten K+-Kanal, der der Wirkung der Erregung,

die durch das Aktionspotenzial entsteht, entgegenwirkt, indem er eine größere Menge an Kalium

ausströmen lässt, wenn das Neuron stark erregt wird. Ein dritter Typ von K +-Kanal öffnet abhängig

von der Menge des im Neuron vorhandenen Calciums, das ausgedehnte Perioden von Aktivität

anzeigt. Dieser Kanal erzeugt also eine Anpassung oder einen ermüdungsartigen Effekt, indem es

überaktive Neuronen hemmt. Insgesamt kann man sagen, dass K+ weitgehend eine regulative

Funktion im Neuron hat.

Ca++

Calcium ist im Innern des Neurons nur in geringen Konzentrationen vorhanden. Das liegt teils an

einer anderen Pumpe, die Calcium aus der Zelle hinauspumpt, und teils an intrazellulären Mechanismen, die Calcium absorbieren oder puffern. Die Diffusionskraft für Ca++ ist also nach innen

gerichtet, deshalb ist ein positives elektrisches Potenzial im Innern erforderlich, das das Calcium

hinausdrückt. Die Größe dieses Potenzials ist etwa +100 mV wegen der hohen Konzentrationsunterschiede. Wegen der doppelten Ladung des Ca++-Ions wirkt ein elektrisches Potenzial auf das Ion

doppelt so stark wie auf ein Ion mit einfacher Ladung. Der wichtigste Kanal, der Ca ++ leitet, ist der

NMDA-Kanal, der durch Glutamat von exzitatorischen Neuronen aktiviert wird. Dieser Kanal ist

von entscheidender Bedeutung für Lernprozesse. Auch der Anpassungseffekt und sein Gegenstück,

der Sensitivierungseffekt, hängen von der Anwesenheit von Ca++-Ionen im Neuron als einem Maß

für neuronale Aktivität ab. Die Ionen gelangen in das Neuron durch spannungsgesperrte Kanäle,

deshalb weist ihre Anwesenheit auf erst kurz zurück liegende neuronale Aktivität hin und sie sind in

so kleinen Mengen vorhanden, dass ihre Konzentration einen guten Hinweis auf die durchschnittliche Größe der neuronalen Aktivität in der letzten Zeitperiode gibt. Dadurch sind sie auch für das

Auslösen anderer Prozesse im Neuron nützlich.

2.4.5. Integration

Die verschiedenen Effekte für die einzelnen Ionen und Kanäle werden nun zusammengefasst in eine

Gleichung, die die neuronale Integration der Information wiedergibt. Diese Gleichung beschreibt

die Aktualisierung des Membranpotenzials Vm. Zu diesem Zweck müssen mittels des Ohmschen

Gesetzes der Strom für jeden Ionenkanal berechnet und dann alle diese Werte zusammenaddiert

werden. Für jeden Typ von Ionenkanal (der Index c bezeichnet den Kanal) werden drei Angaben

benötigt:

1. Das Gleichgewichtspotenzial Ec,

2. der Bruchteil der Kanäle gc(t) von der Gesamtzahl der Kanäle für das betreffende Ion, die zur

Zeit offen sind,

3. die maximale Leitfähigkeit g c , die sich ergeben würde, wenn alle Kanäle offen wären. Das

Produkt von gc(t) und g c ergibt die gesamte Leitfähigkeit.

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 23

Der Strom für einen Kanal ist durch das Diffusions-korrigierte Ohmsche Gesetz gegeben. Es ist das

Produkt aus der Gesamtleitfähigkeit g c t g c und dem Nettopotenzial Vm t Ec :

I c g c t g c Vm t Ec

(2.1)

Die drei grundlegenden Kanäle, die den größten Beitrag zur Aktivität des Neurons leisten, sind:

a) Der exzitatorische synaptische Eingabekanal, der durch Glutamat aktiviert wird und Na+-Ionen

befördert (bezeichnet durch Index e),

b) der inhibitorische synaptische Eingabekanal, der durch GABA aktiviert wird und Cl-Ionen

befördert (bezeichnet durch Index i),

c) der Leck-Kanal, der immer offen ist und K+-Ionen befördert (bezeichnet durch Index l).

Der gesamte oder auch Nettostrom für diese drei Kanäle ist

I net g e t g e Vm t Ee gi t gi Vm t Ei gl t g l Vm t El

(2.2)

Der Nettostrom beeinflusst das Membranpotenzial, weil die Bewegung der Ladungen die Ladungsdifferenz vermindert, was das Potenzial verursacht. Die Aktualisierung des Membranpotenzials

wird durch die folgende Gleichung beschrieben:

Vm t 1 Vm t dt vm I net

Vm t dt vm g e t g e Vm t Ee g i t g i Vm t Ei g l t g l Vm t El

(2.3)

Die Zeitkonstante dtvm (0 < dtvm < 1) verlangsamt die potenzielle Veränderung, wodurch die

Verlangsamung der Änderung im Neuron wiedergegeben wird. Sie ist hauptsächlich auf die

Kapazität der Zellmembran zurück zu führen.

Um das Verhalten eines Neurons zu verstehen ist es zweckmäßig, sich das Ansteigen des Membranpotenzials als Folge eines positiven Stroms, d.h. als Erregung, vorzustellen. Gleichung (2.3) zeigt

aber, dass nach den Gesetzen der Elektrizität das Ansteigen des Membranpotenzials eine Folge

negativen Stroms ist. Um die intuitive Vorstellung damit in Einklang zu bringen, wird das

Vorzeichen des Stroms im Modell umgekehrt, also Inet = Inet, und der Strom zum vorherigen

Membranpotenzial addiert statt von ihm subtrahiert. Das ergibt die Gleichung

Vm t 1 Vm t dt vm I net

Vm t dt vm g e t g e Ee Vm t g i t g i Ei Vm t g l t g l El Vm t

(2.4)

Die Gleichungen (2.3) und (2.4) sind mathematisch äquivalent, aber (2.4) wird der intuitiven Vorstellung der Relation zwischen Potenzial und Strom besser gerecht. Zur Vereinfachung der Notation

wird im Folgenden statt Inet nur Inet geschrieben.

Um eine punktweise Beschreibung der Ausbreitung des Membranpotenzials zu vermeiden, wird der

Vorgang der Ausbreitung approximiert. Die Approximation beruht auf dem Sachverhalt, dass die

elektrischen Signale bei ihrer Fortpflanzung von den Dendriten zum Zellkörper gemittelt werden.

Deshalb kann man den durchschnittlichen Bruchteil der offenen Kanäle der verschiedenen Typen

entlang des ganzen Dendrits als eine sehr grobe aber effiziente Approximation der gesamten

Leitfähigkeit eines bestimmten Typs von Kanal benutzen und diese Zahl in Gleichung (2.4)

verwenden, die das Verhalten des ganzen Neurons zusammengefasst beschreibt.

Technische Universität Chemnitz

Wintersemester 2006/07

Neurokognition

Seite 24