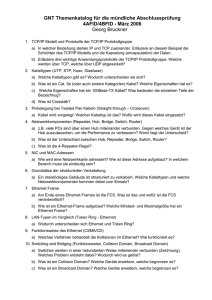

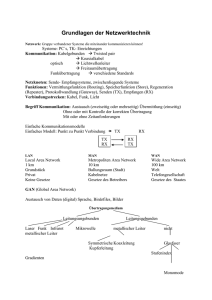

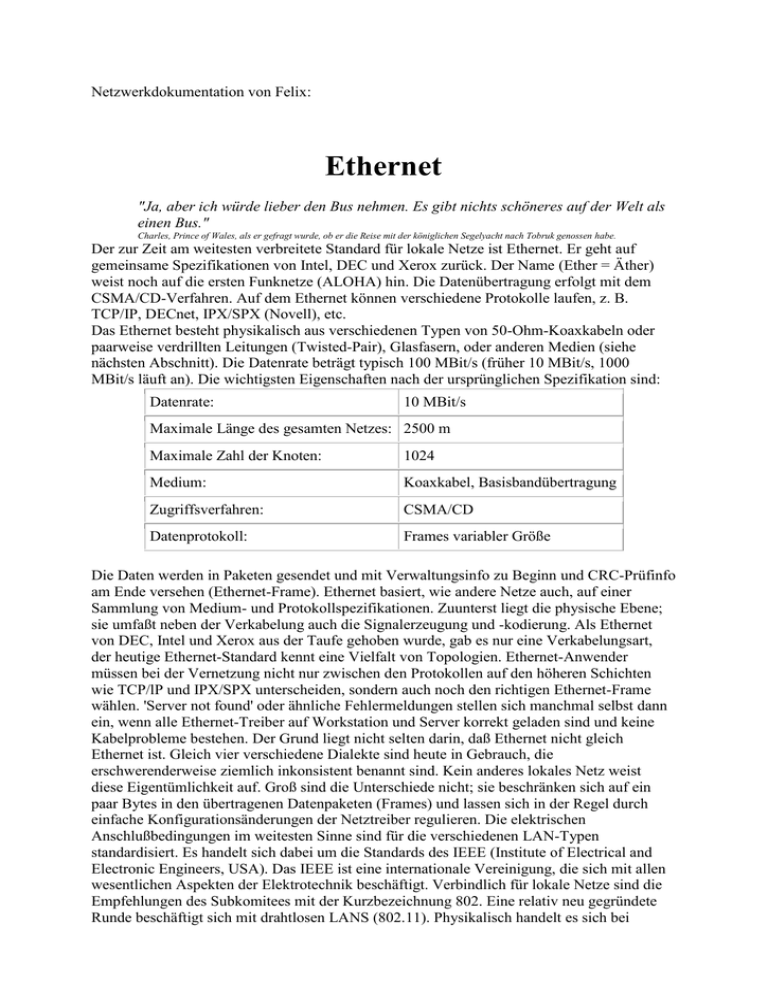

Netzwerkdokumentation von Felix:

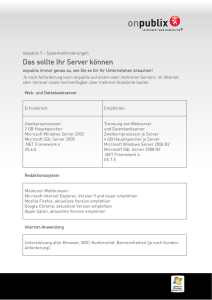

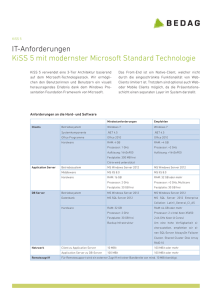

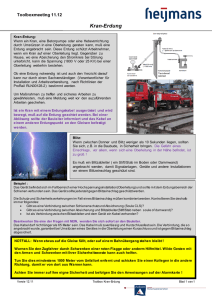

Werbung