P P P 8>>>: Y Y Y Y Y Q P X

Werbung

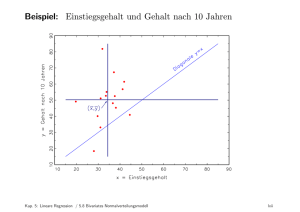

Logistische Regression M. Gruber 20.11.2015 Beispiel 1 (Kreditanalyse) [AMMIL12], Example 3.4. Kreditanalyse f uhrt je nach Art der Fragestellung zu verschiedenen Grundaufgaben des Maschinenlernens. Fragestellung Lernmethode Lernalgorithmus Vergabe Ja/Nein? Perzeptron PLA, Pocket Kredith ohe? Lineare Regression Pseudoinverse Ausfallwahrscheinlichkeit? Logistische Regression Gradientenabstieg P P P Fehlerfunktion T 1 N 1nN [sgn w xn 6= yn ] T 2 1 N 1nN jw xn ynTj y w x 1 n n) N 1nN ln(1 + e Bei der logistischen Regression wird die bedingte Wahrscheinlichkeit P(y j x), y = 1, gelernt, die fur die Entstehung der Lernmenge D = f[x1 ; y1 ]; : : : ; [xN ; yN ]g verantwortlich ist. Der Ansatz fur die Hypothese w ist 8 >< ewT x wT x P(y j x) = 1 + e wT x >:1 e fur y = 1; fur y = 1: 1 + ewT x es Die verwendete Funktion (s) = hat zwei schone Eigenschaften. Erstens bildet sei die reellen 1 + es Zahlen auf das Intervall [0; 1] ab. Ihre Werte konnen als Wahrscheinlichkeiten interpretiert werden. Zweitens ist 1 (s) = ( s). Das erlaubt eine einfachere Darstellung von P(y j x), namlich P(y j x) = (ywT x) = eyw x fur y = 1: 1 + eywT x T Welche Hypothese w ist die beste? Diejenige, die die Lermenge am wahrscheinlichsten erscheinen lasst (Likelihood-Argument). Gesucht ist also die Hypothese w, die das Likelihood-Ma Y 1nN maximiert. Es ist Y 1nN P(yn j xn ) = (yn wT xn ) = Y Y 1nN (yn wT xn ) Y eyn w xn 1 yn wT xn = yn wT xn : 1 + e 1 + e 1nN 1nN T Q P 1 T Statt 1nN ln(1 + e yn w xn ) maximieren oder den KreuzT xn kann man 1nN y w n 1+e entropiefehler T 1 X ln(1 + e yn w xn ) N 1nN minimieren. 1 WS 2015/16 Statistical Learning Vorlesung 7 Zur Minimierung des Kreuzentropiefehlers kann man auf die Gradientenabstiegsmethode zuruckT greifen. Sei en (w) = ln(1 + e yn w xn ). Der Gradientenabstieg iteriert den Schritt wneu walt 1 N X 1nN ren (walt ) bis zur Erreichung eines (lokalen) Minimums. Dabei ist ein geeigneter Lernkoezient. Es ist ren (w) = (+yn wT xn )yn xn . Der Aufwand fur den Gradientenabstieg ist hoch, denn bei jedem Schritt muss die gesamte Lernmenge zur Berechnung von wneu herangezogen werden. Gunstiger ist der stochastische Gradientenabstieg. Bei diesem wird f ur jeden Schritt ein n 2 f1; : : : ; N g zufallig bestimmt und wneu walt ren (walt ) ausgefuhrt. In unserem Fall bedeutet dies wneu T xn )yn xn : walt + (yn walt Fur den stochastischen Gradientenabstieg sprechen drei Argumente. Erstens ist der Erwartungswert seiner Einzelschritte der Einzelschritt aus dem klassischen Gradientenabstieg. Zweitens bleibt der stochastische Gradientenabstieg nicht so leicht in einem lokalen Minimum stecken wie der klassische. Und drittens ist der Aufwand geringer. Fur den Lernkoezient ist 0:1 oft die passende Wahl (Erfahrungswert). Literatur [AMMIL12] Yaser S. Abu-Mostafa, Malik Magdon-Ismail, and Hsuan-Tien Lin. Data. AMLbook.com, rst edition, 2012. Learning From 2