Document

Werbung

Nagl, Einführung in die Statistik

Seite 196

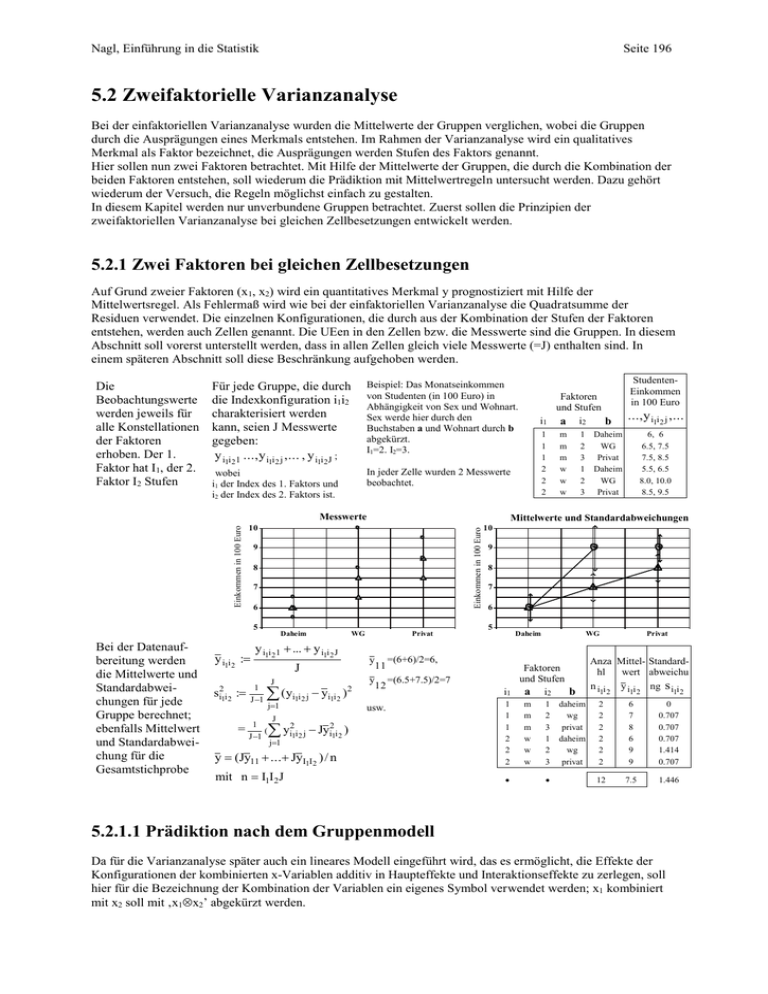

5.2 Zweifaktorielle Varianzanalyse

Bei der einfaktoriellen Varianzanalyse wurden die Mittelwerte der Gruppen verglichen, wobei die Gruppen

durch die Ausprägungen eines Merkmals entstehen. Im Rahmen der Varianzanalyse wird ein qualitatives

Merkmal als Faktor bezeichnet, die Ausprägungen werden Stufen des Faktors genannt.

Hier sollen nun zwei Faktoren betrachtet. Mit Hilfe der Mittelwerte der Gruppen, die durch die Kombination der

beiden Faktoren entstehen, soll wiederum die Prädiktion mit Mittelwertregeln untersucht werden. Dazu gehört

wiederum der Versuch, die Regeln möglichst einfach zu gestalten.

In diesem Kapitel werden nur unverbundene Gruppen betrachtet. Zuerst sollen die Prinzipien der

zweifaktoriellen Varianzanalyse bei gleichen Zellbesetzungen entwickelt werden.

5.2.1 Zwei Faktoren bei gleichen Zellbesetzungen

Auf Grund zweier Faktoren (x1, x2) wird ein quantitatives Merkmal y prognostiziert mit Hilfe der

Mittelwertsregel. Als Fehlermaß wird wie bei der einfaktoriellen Varianzanalyse die Quadratsumme der

Residuen verwendet. Die einzelnen Konfigurationen, die durch aus der Kombination der Stufen der Faktoren

entstehen, werden auch Zellen genannt. Die UEen in den Zellen bzw. die Messwerte sind die Gruppen. In diesem

Abschnitt soll vorerst unterstellt werden, dass in allen Zellen gleich viele Messwerte (=J) enthalten sind. In

einem späteren Abschnitt soll diese Beschränkung aufgehoben werden.

Die

Beobachtungswerte

werden jeweils für

alle Konstellationen

der Faktoren

erhoben. Der 1.

Faktor hat I1, der 2.

Faktor I2 Stufen

Für jede Gruppe, die durch

die Indexkonfiguration i1i2

charakterisiert werden

kann, seien J Messwerte

gegeben:

y i1i 2 1 ..., y i1i 2 j ,... , y i1i 2J ;

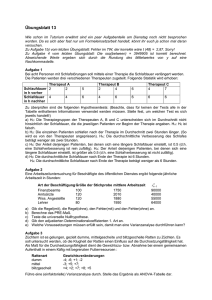

Beispiel: Das Monatseinkommen

von Studenten (in 100 Euro) in

Abhängigkeit von Sex und Wohnart.

Sex werde hier durch den

Buchstaben a und Wohnart durch b

abgekürzt.

I1=2. I2=3.

wobei

i1 der Index des 1. Faktors und

i2 der Index des 2. Faktors ist.

In jeder Zelle wurden 2 Messwerte

beobachtet.

9

8

7

6

5

Bei der Datenaufbereitung werden

die Mittelwerte und

Standardabweichungen für jede

Gruppe berechnet;

ebenfalls Mittelwert

und Standardabweichung für die

Gesamtstichprobe

y i1i 2 :

si21i 2 :

Daheim

WG

y i1i 2 1 ... y i1i 2 J

J

1

J 1

J

( yi1i 2 j yi1i 2 )2

j1

1

2

3

1

2

3

Daheim

WG

Privat

Daheim

WG

Privat

6, 6

6.5, 7.5

7.5, 8.5

5.5, 6.5

8.0, 10.0

8.5, 9.5

Privat

y

y

11

12

9

8

7

6

5

Daheim

=(6+6)/2=6,

=(6.5+7.5)/2=7

i1

y (Jy11 ... JyI1I2 ) / n

mit n I1I2J

1

(

J 1

m

m

m

w

w

w

..., y i1i 2 j ,...

10

1

1

1

2

2

2

=

1

1

1

2

2

2

StudentenEinkommen

in 100 Euro

Mittelwerte und Standardabweichungen

10

Einkommen in 100 Euro

Einkommen in 100 Euro

Messwerte

i1

Faktoren

und Stufen

a i2

b

usw.

J

yi21i2 j Jyi21i 2 )

j1

WG

Faktoren

und Stufen

a i2

b

m

m

m

w

w

w

1

2

3

1

2

3

daheim

wg

privat

daheim

wg

privat

Privat

Anza Mittel- Standardhl

wert abweichu

n i i y i i ng s i i

12

12

2

2

2

2

2

2

6

7

8

6

9

9

0

0.707

0.707

0.707

1.414

0.707

12

12

7.5

1.446

5.2.1.1 Prädiktion nach dem Gruppenmodell

Da für die Varianzanalyse später auch ein lineares Modell eingeführt wird, das es ermöglicht, die Effekte der

Konfigurationen der kombinierten x-Variablen additiv in Haupteffekte und Interaktionseffekte zu zerlegen, soll

hier für die Bezeichnung der Kombination der Variablen ein eigenes Symbol verwendet werden; x1 kombiniert

mit x2 soll mit ‚x1x2’ abgekürzt werden.

Nagl, Einführung in die Statistik

Seite 197

5.2.1.1.1 Multiple Prädiktion mit Hilfe der beiden kombinierten Faktoren

Prädiktionsregel:

GruppenMittelwerteregel

R(x1x2): ŷ i1i 2 j : y i1i 2 ist der Die Gruppenprädiktionsregel R (ab) ordnet als Prädiktionswert jeder

Fehlermaß:

Summe der

quadrierten

Residuen

i1i2j. (x1x2)-Residuum:

ri1i 2 j : y i1i 2 j y i1i 2 für jede

j. UE innerhalb jeder Gruppe

(Zelle)

F(x1x2):=ssqe(x1x2)=

I1

Andere

Berechnungsvarianten:

einzelnen UE den Mittelwert jener Gruppe zu, der sie angehört. Die

Gruppen werden durch die Stufenkombinationen gebildet.

Einkommen in 100 Euro

Direkte Berechnung

Prädiktionswert für jede UE.

ssqe(cells)=

I2

J

ri21i 2 j =

I1

I2

8

7

6

Daheim

i1 1 i 2 1 j1

I1

=

WG

i1 a i2

I2

(J 1)s i21i 2

b

1 m 1 daheim

1 m 2

wg

1 m 3 privat

2 w 1 daheim

2 w 2

wg

2 w 3 privat

=

i1 1i 2 1

Anzahl

J

2

2

2

2

2

2

(J-1)* (1)

s i1i 2 s i21i 2 y i21i 2

36

0

0

49

0.707 0.5

64

0.707 0.5

36

0.707 0.5

91

1.414 2

91

0.707 0.5

F(ab) =

OHNE-Prädiktionsregel ist die

Gesamtmittelwer

tregel .

OHNE-Fehlermaß:

Summe der

quadrierten

Abweichungen

vom

Gesamtmittelwer

t (total ssqe)

Direkte Berechnung

I1

I1

J

y i21i 2 j - J

I2

y i21i 2

i1 1 i 2 1

i1 1 i 2 1 j1

R(-):

ŷ i1i 2 j : y für alle UEen in

allen Gruppen

i1i2j. (-)-Residuum:

ri1i 2 j : y i1i 2 j y für jede j.

UE innerhalb aller Gruppen

F(-):=ssqe(total)=

I1

I2

J

ri21i 2 j =

i1 1 i 2 1 j1

Andere

Berechnungsvariante:

Summe der quadr.

Werte minus n mal

quadr. Gesamtmittel

(n=I1*I2*J)

I2

I1

I2

J

( y i1i 2 j y) 2 =

i1 1 i 2 1 j1

I1

=

I2

J

y i21i 2 j I1 I 2 Jy 2

i1 1 i 2 1 j1

4

347

Die Summe der

quadrierten Residuen

wird hier nach der Formel

für die Summe der mit (J1) gewichteten

quadrierten

Standardabweichungen

(=Varianzen) der

einzelnen Gruppen

berechnet: F(ab) = 4.

In der Spalte (1) wurde die Summe der quadrierten Mittelwerte

berechnet=347.

Die Summe der quadrierten Messwerte= 62+62+6.52+...+9.52= 698.

Nach der letzten Formel gilt:

F(ab) = Summe der quadrierten Werte – J*Summe der quadrierten Mittelwerte=

698 – 2*347 = 4

R (-): Jeder UE wird der Gesamtmittelwert zugesprochen y 7.5

Die Prädiktionswerte sind in der Graphik unten eingetragen (konstant

für alle UEen)

Einkommen in 100 Euro

Summe der quadr.

Werte minus

gewichtete quadr.

Gruppenmittel.

Privat

J

( y i1i 2 j y i1i 2 ) 2

Summe der

gewichteten

Gruppenvarianzen

9

5

i1 1 i 2 1 j1

Die quadrierten

Residuen sind

die einzelnen

Quadrate, die als

Flächen für jede

UE sichtbar sind.

10

11

10

9

8

7

6

5

Daheim

WG

Privat

Da oben bereits die Summe der quadrierten Messwerte berechnet wurde

(=698), ist die letzte Berechnungsvariante am einfachsten:

F(-) = Summe der quadrierten Messwerte – n * quadr. Gesamtmittel =

= 698 – 12 * (7.5)2 = 698 – 675 = 23

Bis daher gleicht die Vorgehensweise für die aus x1 und x2 kombinierte Variable x1x2 genau der

Vorgehensweise der einfaktoriellen Varianzanalyse, wenn x1x2 als ein Faktor angesehen wird. Das

entsprechende PRE-Mass wird als Determinationskoeffizient 1. Art bezeichnet, hier in multipler

Verallgemeinerung, Fehlerreduktionsanteil durch Berücksichtigung der beiden x-Merkmale in kombinierter

Form x1x2.

Anteilige multiple 2

x1 x 2 =Multipler Det.-Koef- Fehler F (ab) = ssqe(cells)= 4.

Fehlerreduktion

Fehler F (-):= ssqe(total)= 23.

fizient 1. Art=

durch

Die gesamte Fehlerreduktion beträgt FR(ab) = F (ab)- F (-)=19.

Berücksichtigung

Das multiple PRE-Mass heißt multipler Determinationskoeffizient der

von x1x2.

Nagl, Einführung in die Statistik

=

ssqe(-) - ssqe(cells)

=

ssqe(-)

Andere Berechnung:

Quadratsumme

‚zwischen‘ den

Gruppen durch

Quadratsumme ‚Total’

Seite 198

I1

J

1. Art bzw.

=19/ 23

I2

y i21i 2 ny 2

i1 1 i 2 1

2x1 x 2 =

2

a

b = (ssqe(-) - ssqe(cells)) / ssqe(-) =

ssqe()

Der Zähler stellt die

Fehlerreduktion durch die

kombinierte Variable x1x2:

FR(x1x2)= ssqe(x1x2)

(23- 4)/ 23

0.8261

Der Det.-Koeffizient 1. Art kann auch anders berechnet werden:

ssqe(between)= J*Summe der quadrierten Mittel – n *quadriertes Gesamtmittel

=2*347 – 12*7.52= 19

Multipler Det.-Koeffizient 1. Art= ssqe(between)/ssqe(total) =

19/ 23 0.8261

D.h. die Berücksichtigung der Mittelwertunterschiede in y, die durch

ab bedingt sind, führt zu einer Prädiktionsfehlerreduktion von

82.61%.

5.2.1.1.2 Prädiktion mit Hilfe der einzelnen Faktoren

Nun soll jeder einzelne Faktor untersucht werden. Vielleicht ist einer der beiden Faktoren zur Prädiktion des yMerkmals mit Hilfe der Mittelwertregel ausreichend. Zur Beantwortung dieser Frage werden wiederum die

Prädiktionsfehler für die einzelnen Faktoren berechnet.

Die Mittelwerte der

einzelnen Faktoren lassen

sich als Randmittelwerte in

einer Tabelle darstellen, die

in den Zellen die Mittelwerte

der Gruppen enthält.

Der Gesamtmittelwert kann

rechts unten dargestellt

werden.

Darstellung der Zellenmittelwerte und der

Randmittelwerte für die beiden Faktoren; mit

Gesamtmittelwert rechts unten.

x2

i2

i1

x1 1

x11

...

I1 x 1I1

...

I2

x21

1

...

x 2I 2

y11

...

y1I2

...

...

...

y I11

...

yI1I 2

yI1

y1

...

y I 2

y

b

y1

i2

i1

a

1

2

1

2

daheim wg

m

w

3

privat

6

6

7

9

8

9

7

8

6

8

8.5

7.5

Prädiktion mit Hilfe von Faktor x1

R(x1): ŷ i1i 2 j : y i1

Die a-Gruppenprädiktionsregel R (a) ordnet als Prädiktionswert jeder

einzelnen UE den Mittelwert jener a-Gruppe zu, der sie angehört.

i1i2j. (x1)-Residuum:

ri1i 2 j : y i1i 2 j y i1 für die j.

UE innerhalb aller Gruppen

F(x1):=ssqe(x1)=

Direkte Berechnung

I1

I2

J

ri21i 2 j =

Einkommen in 100 Euro

Prädiktionsregel:

x1-GruppenMittelwerteregel

Fehlermaß:

Summe der

quadrierten

Residuen

11

10

i1 1 i 2 1 j1

Andere

Berechnungsvarianten:

I1

I2

9

8

7

6

5

J

( y i1i 2 j y i1 ) 2

Daheim

i1 1 i 2 1 j1

(1)

2

Summe der quadr.

Werte minus quadr.

x1-Gruppenmittel.

I1

=

I2

I1

i1

a

yi

1

i1 1

1

2

m

w

49

64

J

y i21i 2 j - I 2 J y i21

i1 1 i 2 1 j1

113

WG

Privat

In der Spalte (1) wurde die Summe der

quadrierten a-Gruppenmittelwerte

berechnet=113.

Die Summe der quadrierten Messwerte=

62+62+6.52+...+9.52= 698.

Nach der letzten Formel gilt: F(a) = Summe der

quadrierten Werte – J*I2*Summe der quadrierten

Mittelwerte= 698 – 2*3*113 = 20

Prädiktion mit Hilfe von Faktor x2

Prädiktionsregel:

x2-GruppenMittelwerteregel

R(x2): ŷ i1i 2 j : y i 2

Die b-Gruppenprädiktionsregel R (b) ordnet als Prädiktionswert jeder

einzelnen UE den Mittelwert jener b-Gruppe zu, der sie angehört: 6, 8,

8.5

Nagl, Einführung in die Statistik

i1i2j. (x2)-Residuum:

ri1i 2 j : y i1i 2 j y i 2 für die j.

Einkommen in 100 Euro

Fehlermaß:

Summe der

quadrierten

Residuen

Seite 199

UE innerhalb der Gruppen

F(x2):=ssqe(x2)=

I1

Direkte Berechnung

I2

J

ri21i 2 j =

I1

I2

Summe der quadr.

Werte minus Summe

der quadrierten x2Gruppenmittel.

I1

=

I2

9

8

7

5

J

( y i i j y i ) 2

i1 1 i 2 1 j1

10

6

i1 1 i 2 1 j1

Andere

Berechnungsvarianten:

11

12

Daheim

WG

2

In der Spalte (1) wurde die Summe

der quadrierten b-Mittelwerte

berechnet=172.25.

2

I2

J

y i21i 2 j - I1 J y 2i 2

i1 1 i 2 1 j1

i 2 1

i2

b

(1) y i

2

1

2

3

daheim

wg

privat

36

64

72.25

Privat

Nach der letzten Formel gilt: F(b) =

Summe der quadrierten Werte –

J*I1*Summe der quadrierten

Mittelwerte= 698 – 2*2*172.25 = 698

– 689= 9

172.25

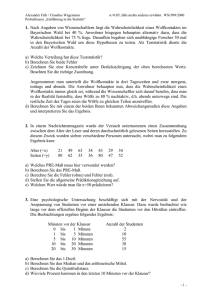

5.2.1.1.3 Übersicht über die Gruppenmodelle

Der Vergleich von Sequenzen der vier Gruppenmodelle (keine x-Variable, x1, x2 und die Kombination von x1

mit x2) erlaubt wiederum, das multiple PRE-Mass (Multipler Determinationskoeffizient 1. Art) additiv in eine

Summe von semipartiellen PRE-Maße zu zerlegen (die multiplikative Zerlegung gilt ebenfalls).

Studenten-Einkommens-Beispiel: für alle Faktoren-Modelle wurden die Fehler berechnet. Dargestellt wird jeweils das Fehlermaß der

Modelle (ssqe). Darauf aufbauend sind ebenfalls die Fehlerreduktionen eingetragen.

-

-

ssqe(-)

23

FR(a)

a

b

a

ssqe(a)

ssqe(b)

20

FR(b . a)

14

3

FR(b)

FR(a . b)

b

9

5

16

FR(ab)

ab

ssqe(ab)

19

ab

4

Auch die im Rahmen der Teilgruppenbetrachtung mögliche Darstellung des partiellen PRE-Maßes als

gewichteten Mittelwert der Teilgruppen-PRE-Maße kann ebenfalls angewandt werden.

5.2.1.2 Prädiktion mit Hilfe eines linearen Modells

Das lineare Modell erweitert das Gruppenmodell um die Möglichkeit, die Mittelwerte des kombinierten

Gruppenmodells als additive Effekte beider Faktoren und einem nichtadditiven Resteffekt darzustellen. Der

nichtadditive Resteffekt wird als eigenständiger Effekt betrachtet und als Interaktionseffekt bezeichnet. Bei der

Entwicklung der folgenden Effektgrößen werden implizit symmetrische Restriktionen eingeführt.

In den folgenden Beispiel werden wegen einfacherer Schreibweise griechische Buchstaben zur Bezeichnung der Mittelwerte und der Effekte

verwendet (eigentlich sollte noch ein Dach drauf).

Als Ausgangslage seien Mittelwerte des

Gesucht ist eine additive

Ausgangslage seien Mittelwerte

Einkommensbeispiels gewählt:

Darstellung der

Mittelwerte aus

Summanden, die den

tatsächlichen Mittelwerten in

der Population möglichst

nahe kommt (Nur Effekte der

Stufen der Faktoren sollen

addiert werden, nicht

Kombinationselemente!)

b

b

a

1

2

3

1

11

12

13

1

2

21

22

23

2

1

2

3

a

1

2

1

2

3

6

6

7

9

8

9

7

8

6

8

8.5

7.5

Nagl, Einführung in die Statistik

Seite 200

Eine mögliche Wahl für die

Konstante ist die Wahl des

Gesamtmittelwerts; zur

Konstanten können von

beiden Rändern her ’s (vom

Zeilenrand) und ’s (vom

Spaltenrand) addiert werden.

So entsteht die rein additive

Darstellung

(Rekonstruktion) der

Mittelwerte.

Als 1 kann ( 1-) , als 2 kann ( 2-)

gewählt werden; als 1 kann (1 -) gewählt

werden usw.

Auf Grund der additiven

Rekonstruktion von den

Rändern her müssen die

Linien, die diese

rekonstruierten Mittelwerte

im Streudiagramm

verbinden, parallele Linien

sein

Da zu jedem + j einerseits

konstant für jede Ausprägung von a

eine bestimmte Größe (i) addiert

wird, entstehen parallele Linien für

jede a-Ausprägung.

Daher im Beispiel: 1=7 – 7.5= -0.5.

2=8 – 7.5= 0.5. 1 = 6 – 7.5 = -1.5 usw.

b

b

1

2

3

a 1

+ 1+ 1

+ 1+ 2

+ 1+ 3

1

2

+ 2+ 1

+ 2+ 2

+ 2+ 3

2

1

2

3

a

1

2

1

2

3

5.5

6.5

7.5

8.5

8

9

-0.5

0.5

-1.5

0.5

1

7.5

-0.5+ 0.5=0 und -1.5 + 0.5 + 1 =0

Es gelten hier die symmetrischen Restriktionen:

1+ 2=0 und 1+ 2+ 3 =0

10

9

8

7

6

5

Daheim

WG

Privat

Die Effekte, die pro Stufe eines Faktors definiert wird, heißen Haupteffekte. Die ’s und ’s werden auch als

Effektgrößen bezeichnet. Sie sind als Parameter der Population gedacht, die in einer Stichprobe zu schätzen sind.

Interaktionseffekte

Da die Summe der Haupteffekte (plus Konstante) meist die Zellmittelwerte nicht vollständig rekonstruieren

können, werden zusätzlich sogenannte Interaktionseffekte definiert.

Die Interaktionseffekte

sind die Differenz der

Zellmittelwerte zum rein

additiven Modell(Summe

von Haupteffekten und

Konstante)

b

1

a

2

b

3

Summe

1

11- ( + 12- ( + 13 - ( +

1+ 1)

1+ 2)

1+ 3)

0

2

21- ( + 12 - ( + 13 - ( +

2+ 1)

2+ 2)

2+ 3)

0

Summe

0

0

1

a

3

8-8

9-9

b

1

0

=

Zeilenrandsummen und Spaltenrandsummen sind

hier gleich null.

2

1 6 -5.5 7-7.5

2 8 -6.5 9-8.5

2

a 1 0.5 -0.5

2 -0.5 0.5

3

0

0

Bezeichnung der Interakb

tionseffekte: Damit nicht

Beachte ABER: i1i 2 stellt nicht ein

Summe

1

2

3

zusätzliche neue Symbole

Produkt aus und dar, sondern ist

0

a 1

11

12

13

eingeführt werden müssen

nur ein kombiniertes Symbol!

2

0

21

22

23

werden sie meist durch die

Kombination der

Summe

0

0

0

Haupteffektbuchstaben

bezeichnet

Die ()’s werden auch als Effektgrößen bezeichnet. Wie die Haupteffektgrößen sind auch sie als Parameter der

Population gedacht, die in der Stichprobe zu schätzen sind.

5.2.1.2.1 Modellgleichung des linearen Modells

Das lineare Modell zur Darstellung der Zellmittelwerte kann nun als Summe von Effekten geschrieben werden:

i1i 2 i1 i 2 i1i 2

Dabei ist zu beachten, dass verschiedene

Restriktionen notwendig sind. Symmetrische

HaupteffektRestriktionen

=0 (Summe der -Effekte ist 0)

=0 (Summe der -Effekte ist 0)

Nagl, Einführung in die Statistik

Seite 201

Restriktionen besagen, dass Summen bestimmter

Effektgrößen 0 sind. Zur Charakterisierung der

Restriktionen kann die Punktnotation verwendet

werden.

i1 0 für alle i1

InteraktionseffektRestriktionen

i 2 0 für alle i 2

5.2.1.2.2 Schätzung der Effektparameter des linearen Modells

In den Stichproben müssen die einzelnen Effekte geschätzt werden, und zwar nach der Methode der kleinsten

Quadrate (KQ). Die hier berichteten Schätzer gelten für gleiche und proportionale Zellbesetzung, bei ungleicher

Zellbesetzung sind die Schätzer zu modifizieren.

Unter Geltung der

beschriebenen

symmetrischen Restriktionen

sind die KQ-Schätzer (engl.

LS-Schätzer) recht einfach

zu ermitteln.

Ohne die Dachnotation: 1=7 – 7.5= -0.5.

2=8 – 7.5= 0.5.

1 = 6 – 7.5 = -1.5 usw.

KQ Schätzer der Effekte bei

symmetrischen Restriktionen:

Konstante:

ˆ y

ˆ i y i y

Haupteffekte:

1

b

1

ˆ i 2 y i 2 y

a

Daher gilt (summieren obiger Effekte):

ˆ i ˆ i y i y i y

ˆ

1

2

1

1

2

1

2

3

5.5

6.5

7.5

8.5

8

9

-0.5

0.5

-1.5

0.5

1

7.5

2

Interaktionseffekte:

-0.5+ 0.5=0 und -1.5 + 0.5 + 1 =0

i1i 2 y i1i 2 y i1 y i 2 y

ˆ ˆ i i ) nur ein Dach. Leider habe ich innerhalb von Word kein solches Dach

Bemerkung: Eigentlich sollte auf das kombinierte Symbol (

12

über 2 Buchstaben gefunden.

5.2.1.2.3 Prädiktion mit Hilfe des Modells rein additiver Haupteffekte

In der Modellgleichung wird unterstellt, dass alle Interaktionseffekte 0 sind. Daher werden die Zellmittelwerte

ˆ ˆ y y y

durch die Schätzung ˆ

ermittelt.

i1

Fehlermaß:

Summe der

quadrierten

Residuen

i1

i 2

i1i2j. (x1,x2)-Residuum:

ri1i 2 j : y i1i 2 j y i1 y i 2 y

für alle UEen

F(x1,x2):=ssqe(x1,x2)=

I2

J

ri21i 2 j =

10

9

8

7

6

I2

5

J

(y i1i 2 j y i1 y i 2 y )

Summe der quadr.

Werte

minus quadr. x1Gruppenmittel

minus quadr. x2Gruppenmittel

plus quadr.

Gesamtmittel

11

i1 1 i 2 1 j1

I1

Andere

Berechnungsvariante:

Die a-Gruppenprädiktionsregel R (a) ordnet als Prädiktionswert

jeder einzelnen UE den Mittelwert jener a-Gruppe zu, der sie

angehört.

R(x1,x2): ŷ i1i 2 j : y i1 y i 2 y

I1

Direkte Berechnung

i2

Einkommen in 100 Euro

Prädiktionsregel:

Additive Haupteffekte als

Mittelwerteregel

i1 1 i 2 1 j1

I1

=

I2

J

y i21i 2 j

WG

Privat

2

2

i1

a

(1) y i1

1

2

m

w

49

64

i2

b

(2) y i 2

1

2

3

daheim

wg

privat

36

64

72.25

113

i1 1 i 2 1 j1

- I2J

Daheim

2

172.25

Die Summe der quadrierten Werte= 6 +6 +6.5 +...+9.52= 698.

In der Spalte (1) wurde die Summe der quadrierten aMittelwerte berechnet=113, in Spalte 2 die für b = 172.25.

2

I1

I2

i1 1

i 2 1

y i21 - I1 J y 2i 2

2

+ I1 I 2 Jy

2

2

Nach der letzten Formel gilt: F(a,b) = 698 – 2*3*113 –

2*2*172.25 + 2*2*3*7.52 = 698 – 678 – 689 + 675 = 6

Alle übrigen linearen Modelle wurden bereits bei der Bearbeitung des Gruppenmodells geschätzt, die Regeln

entsprechen exakt denen des Gruppenmodells. Daher sind auch die Prädiktionsfehler identisch. Gewonnen

Nagl, Einführung in die Statistik

Seite 202

wurde aber durch die Bearbeitung des Problems mit Hilfe eines linearen Modells die rein additive Regel und

damit ein Fehlerterm, der den kombinierten Fehler aufgliedert.

5.2.1.3 Übersicht über die verschiedenen Modelle

Studenten-Einkommens-Beispiel: für alle Faktoren-Modelle wurden die Fehler berechnet. Dargestellt wird jeweils das Fehlermaß der

Modelle (ssqe). Darauf aufbauend sind ebenfalls die Fehlerreduktionen eingetragen; Hier zusätzlich mit rein additivem Modell

-

-

ssqe(-) 1

23 1

a

b

I1

ssqe(a)

a

I2

ssqe(b)

FR(b . a)

14

3

FR(b)

FR(a)

b

9 3

20 2

FR(a . b)

3

14

a, b

a, b

I1+I2-1

ssqe(a,b)

Rein additives Modell

FR. durch Interaktion

6 4

2

FR(ab. (a,b) )

19

FR(ab)

ab

ab

ssqe(ab) I1I2

4

z

6

Anzahl linear unabhängiger Parameter

Übersicht über die linear unabhängigen Parameter der Modelle

Prädiktionsmodell

-

Prädiktionsf

ehler

F(-)

Linear unabhängige Parameter

im Gruppenmodell

im linearen Modell

x1

F (x1)

1 , 2 , , I1

, 1 , , I1 1

I1

x2

Additives

Modell: x1, x2

F (x2)

1 , 2 , , I2

, 1 , , I2 1

I2

, 1 , , I1 1 , 1 , , I2 1

I1+I2-1

x1x2

F(x1x2)

F (x1, x2)

11 , , I1I2

Anzahl

1

, 1 , , I1 1 , 1 , , I2 1 ,

i1i 2 (i1 1, , I1 1; i 2 1, , I 2 1)

I1I2

Zusammenfassung der Fehlerreduktionen, Bezeichnungen und Formeln

Die Fehlerreduktionen können als Differenzen zwischen den Fehlern im Rahmen des obigen Schemas gebildet

werden. Die Formeln für die Fehlerreduktionen sind die jeweiligen Differenzen der Formeln der

Prädiktionsfehler.

Variationsquelle

Sum of

Squares

Formeln

Freiheitsgrade =

df

I1

Faktor, x1

FR(x1)

ssq(x1)

I 2 J y i21 - I1 I 2 Jy

Faktor, x2

FR(x2)

ssq(x2)

I1 J y 2i 2 - I1 I 2 Jy 2

2

I1 - 1

i1 1

I2

I2 - 1

i 2 1

Interaktion,

x1x2

I1

FR(x1x2)

ssq(x1x2)

J

I2

I1

I2

i1 1

i 2 1

y i21i 2 - I 2 J y i21 - I1 J y 2i 2

i1 1 i 2 1

+ I1I 2 Jy 2

(I1-1)(I2-1)

Nagl, Einführung in die Statistik

Seite 203

Error,

within cells

F(x1x2) ssqe(x1x2)

Total

F(-)

I1

I2

I1

(J 1)s i21i 2 =

i1 1i 2 1

I2

y i21i 2 j - J

I2

J

y

i1 1 i 2 1 j1

2

i1i 2 j

I2

y i21i 2

n - I1I2

i1 1 i 2 1

i1 1 i 2 1 j1

I1

ssqe(total)

I1

J

I1 I 2 Jy 2

n-1

Die Freiheitsgrade der Fehlerreduktionen können als Differenzen der Anzahl der linear unabhängigen Parameter

der entsprechenden Modelle errechnet werden. Die Freiheitsgrade des Prädiktionsfehlers eines Modells selbst

sind jeweils die Differenz zwischen n und der Anzahl der linear unabhängigen Parameter des entsprechenden

Modells.

Das kombinierte Modell (bisher als x1x2 bezeichnet) kann auch als das Modell bezeichnet werden, das sowohl

die Haupteffekte additiv verknüpft als auch die Interaktionseffekte selbst additiv hinzufügt, und daher wie folgt

abgekürzt werden: x1, x2, x1x2; daher z.B. statt F(x1x2) auch F(x1, x2, x1x2) bzw. statt ssqe(x1x2) auch ssqe(x1,

x2, x1x2).

5.2.1.3.1 Genese der Stichproben

Der Begriff des Modells umfasst nicht nur die Modellgleichungen, sondern auch die Konzeption dafür, wie die

beobachtbaren Werte entstehen. Neben der Systematik (repräsentiert durch i1i 2 ) ist dabei zu beachten, dass

jede Teilstichprobe aus einer Population verschiedener Werte gezogen wird.

Das Ergebnis Y wird als

Summe aus einem

systematischen Teil ( i1i 2 )

und einem Zufallsteil (e)

dargestellt. e wird manchmal

als ‚Störgröße‘ oder ‚Fehler‘

bezeichnet.

Yi1i 2 j i1i 2 e i1i 2 j ,

Verteilung der Störgröße:

wobei e i1i 2 j von Ziehung zu Ziehung

unabhängig ist und jeweils aus der

gleichen ‚Störgrößen‘-Verteilung mit

der Standardabweichung (auch mit e

bezeichnet) und µe=0 stammt.

-2e -e

0

e 2e e

Es wird daher unterstellt, dass für alle Stichproben die gleiche Varianz gilt (Homoskedastizitätsannahme). Die

Konzeption für die Entstehung der Beobachtungen betrifft das Gruppenmodell ebenso wie das lineare Modell.

Im linearen Modell wird nur zusätzlich die spezielle additive Zerlegung von i1i 2 in Haupteffekt-Parameter

möglich.

Pfaddiagrammdarstellung: Das

allgemeine Niveau, die - und -Effekte samt der Störgröße können als

einfache Pfeile dargestellt werden.

Die Interaktionseffekte () werden Daheim

durch Kombinationspfeile

WG

dargestellt (die Kombinationspfeile Privat

sollen das ‚synergetische

Zusammenwirken’ der

Faktorenstufen symbolisieren).

weiblich

0.5

-0.5

0.5

-1.5

0.5

1

Eink.

7.5

e

Die geschätzten Haupteffekte für beide Faktoren

werden durch die Zahlen bei den einfachen Pfeilen

dargestellt.

Die geschätzten Interaktionseffekte sind bei den

Kombinationspfeilen eingetragen.

Wegen der asymmetrischen Restriktionen genügt

für den Faktor Sex die Darstellung einer Stufe

(weiblich); die männlich-Effekte sind nur jeweils

das Negative der weiblich-Effekte.

5.2.1.3.2 Hypothesen und Tests

Haupteffekt-Hypothesen

Für beide Haupteffekte können Nullhypothesen formuliert werden. Die Hypothesen können als Aussagen zu den

Mittelwerten oder den Effektparametern formuliert werden.

Anzahl der

Formen der Hypothese

Hypothesen

Beispiel: Der Einkommensmittelwert eines

Null-Hypothese zum

H0(x1): 1 2 I1

Studenten ist gleich dem

Faktor x1: die

I1-1

Einkommensmittelwert einer Studentin.

bzw.

Mittelwerte der x1Die Einkommenseffekte von Sex sind 0

0

1

I1 1

Gruppen sind gleich

Nagl, Einführung in die Statistik

Null-Hypothese zum

Faktor x2: die

Mittelwerte der x2Gruppen sind gleich

Seite 204

H0(x2): 1 2 I2

bzw.

1 I2 1 0

Beispiel: Die Einkommensmittelwerte

unterscheiden sich nicht nach Wohnform.

I2-1

Die Einkommenseffekte von Wohnform

sind 0

Interaktionseffekt-Hypothese

Auch diese Hypothese kann als Aussage zu den Mittelwerten genau so wie als Aussage zu den Effektparametern

formuliert werden.

Anzahl der

Formen der Hypothese

Hypothesen

Beispiel: Alle Interaktioneffektsparameter

Null-Hypothese zur

H0(x1x2): alle Effektparameter

sind null. Auf Grund der Restriktionen

Interaktion zwischen

sind 0:

sind allerdings nur zwei

den beiden Faktoren x1

Interaktioneffektsparameter zu betrachten;

i1i 2 (i1 1, , I1 1;

(I1-1) (I2-1) es genügt zu fordern: = =0. Auf

11

12

und x2. D.h. das rein

Grund der Restriktionen sind dann alle

i 2 1, , I 2 1) . bzw.

additive Modell der

Effektparameter 0.

Haupteffekte ist richtig

Hier werden in der Hypothese alle

Differenzen zur 1. Stufe betrachtet (dies

könnten auch andere Differenzen sein).

Die

Mittelwertunterschiede H0(x1x2):

zwischen den x111 21 1I2 2I2 und

Gruppen sind gleich in

......

allen x2-Stufen

11 I11 1I2 I1I2

Beispiel: Die Einkommensunterschied

zwischen Studenten und Studentinnen ist

in allen Wohnformen gleich groß

Auch hier werden in der Hypothese alle

Beispiel: Die Einkommensunterschied

zwischen daheim versus in WG zu

wohnen ist gleich groß für Studenten wie

für Studentinnen.

Zudem gilt: Die Einkommensunterschied

zwischen daheim versus privat zu wohnen

ist gleich groß für Studenten wie für

Studentinnen.

Differenzen zur 1. Stufe betrachtet.

Die

Mittelwertunterschiede H0(x1x2):

11 12 I11 I1 2 und

zwischen den x2Gruppen sind gleich in

......

allen x1-Stufen

11 1I2 I11 I1I2

Teststatistiken für die Überprüfung der Hypothesen

Für die verschieden Hypothesen müssen Stichprobenmaßzahlen konstruiert werden, mit deren Hilfe die

Hypothesen beurteilt werden können. Unter Geltung der Nullhypothesen sollten diese Stichprobenmaßzahlen

tendenziell klein werden, unter Geltung der Alternativhypothese eher groß. Diese Eigenschaft erfüllen die

Fehlerreduktions-Quadratsummen, deren Formeln hier wiederholt werden (allerdings etwas umgeformt):

Variationsquelle

Sum of

Squares

Formeln

I1

Faktor, x1

I 2 J ( y i y ) 2

ssq(x1)

i1 1

1

Nullhypo- Konsequenz für die Sum of Squares

these

bei Geltung der Nullhypothese

Laut Nullhypothese würde ssq(x1) in der

H0(x1)

Pop. null werden. Abweichungen von Null

sind aber in der Stichproben zu erwarten

I2

Faktor, x2

I1 J ( y i y ) 2

ssq(x2)

i 2 1

I1

Interaktion

ssq(x1x2)

, x1x2

J

2

H0(x2)

Laut Nullhypothese würde ssq(x2) in der

Pop. null werden. In der Stichprobe sind

Abweichungen von Null zu erwarten

H0(x1x2)

Laut Nullhypothese würde ssq(x1x2) in der

Pop. null werden. In der Stichprobe sind

Abweichungen von Null zu erwarten

I2

( y i1i 2 (y i1 y i 2 y )) 2

i1 1 i 2 1

Diese Quadratsummen werden zudem relativiert auf die Variabilität innerhalb der Zellen einerseits, andererseits

werden auch die Freiheitsgrade berücksichtigt. Die resultierende Teststatistiken sind F-Statistiken (z.B. für

Faktor x1):

ssq ( x 1 ) / dfz

F(dfz, dfn )

, wobei dfz=(I1-1) und dfn=(n-I1I2) ist.

ssqe ( within ) / dfn

Nagl, Einführung in die Statistik

Seite 205

dfz wird als Zählerfreiheitsgrad, dfn als Nennerfreiheitsgrad bezeichnet. Der Zähler ssq(x 1)/dfz wird auch

msq(x1), der Nenner ssq(within)/dfn wird auch msq(within) genannt. Dabei steht msq für ‚mean sum of

squares‘ (Mittlere Quadratsumme). Dieser Typ von Statistik wurde bereits bei der einfaktoriellen Varianzanalyse

eingeführt. Dabei sei hier noch mal wiederholt:

Testverteilung der Teststatistik F(dfz,dfn) unter Geltung von H 0. Unter der Voraussetzung, dass die y-Werte

in jeder Gruppe normalverteilt sind und die Varianzen in allen Gruppen gleich (Homoskedastizität) sind, hat die

Teststatistik F(dfz,dfn) eine bekannte Verteilung, und zwar die sogenannte F-Verteilung. Die Form der

Verteilung für F(dfz,dfn) hängt von den beiden Freiheitsgraden df1 und df2 ab.

Durchführung der Tests

Als Schema für die Berechnung wird meist eine ANOVA-Tabelle erstellt:

Variationsquelle

Faktor, x1

Faktor, x2

Faktor, x1x2

Error, within

Sum of Squares

ssq(x1)

ssq(x2)

ssq(x1x2)

ssqe(within)

Total

ssqe(total)

df.

Mean sum of squares

df1= I1-1

msq(x1)= ssq(x1)/ df1

df2= I2-1

msq(x2)= ssq(x2)/ df2

df12=( I1-1)(I2-1)

msq(x1x2)= ssq(x1x2)/ df12

dfe= n- I1I2

msqe(within) =ssqe(within) / dfe

n-1

msq(total)

2

=ssqe(total) / (n-1)= s n 1

Beispiel: Einkommen von Studentinnen und Studenten in unterschiedlichen Wohnformen.

ANOVA-Tabelle

Variationsquelle

Sum of Squares

df.

Mean sum of squares

Faktor, Sex (=a)

ssq(a)=3

1

3

Faktor, Wohnform(=b)

ssq(b)=14

2

7

Faktor, Sex Wohnform

ssq(ab)=2

2

1

Error, within

ssqe(within)=4

6

4 / 6 = 2/3=0.666

Total

ssqe(total) = 23

11

F-Ratio

F(df1,dfe) = msq(x1) / msqe(within)

F(df2,dfe) = msq(x2) / msqe(within)

F(df12,dfe) = msq(x1x2) / msqe(within)

F-Ratio

F(1, 6) = 3 / (2/3) = 4.5

F(2, 6) = 7 / (2/3) = 21/2 = 10.5

F(2, 6) = 1 / (2/3) = 3/2 = 1.5

2

23 / 11= s n 1

Kritischer Bereich und Entscheidung. Es ist noch zu untersuchen, ob der F-Wert im kritischen Bereich liegt.

Der kritische Bereich ist jener Wertebereich der F-Verteilung, der einerseits größer als (bzw. gleich) der

sogenannte kritische Wert ist, und für den andererseits gilt: P(F kritischer F-Wert) = . Wenn der in der

Stichprobe errechnete F-Wert im kritischen Bereich liegt, wird H0 abgelehnt.

Für das vorliegende Beispiel werden zwei verschiedene kritische Bereiche benötigt:

KB F0.95 (1,6) =5.99 und KB F0.95 (2,6) =5.14 (siehe F-Verteilung

F-Verteilung

df1=1

df2=6

0.4

0.4

F-Verteilung

df1=2

df2=6

0.3

0.3

0.2

Kritischer

Bereich

0.2

Kritischer

Bereich

0.1

0.1

0

Entscheidung

im Tabellenanhang F).

0

1

2

3

4

5

6

7

8

9 F

7 Kritis

8

9 F

Kritis

Kritischer

Kritischer

cher Bereich

cher Bereich

5.99

5.14

Berei

Berei

ch

ch

Über

die

Nullhypothese,

dass

keine

Interaktion

zwischen

Sex

und

Wohnart bezüglich

des

Kritis

H0 wird abgelehnt,

Kritis

Studenteneinkommens

vorliegt, wird mit Hilfe des Testwerts F(2,

6) (= 3/2 ) entschieden.

cher

cher

Kritischer

Kritischer

falls der Testwert

2 Zählerund 6 Nennerfreiheitsgraden ist der kritischeKritis

Bereich

jener, der größer

KritisBei

Berei oder

Berei

Bereich

Bereich

im kritischen

ist. Daher liegt der Testwert nicht im kritischen

Bereich; die Nullhypothese

wird

cher gleich 5.14 ch

ch

cher

Bereich liegt. Bereidaher nicht verworfen.

Berei

ist, wird mit Hilfe des

ch Über die Nullhypothese, dass kein Sex-Haupteffekt vorhanden

ch

Testwerts F(1, 6) (= 4.5 ) entschieden. Bei 1 Zählerfreiheitsgrad und 6

Nennerfreiheitsgraden ist der kritische Bereich jener, der größer oder gleich 5.99 ist. Daher

liegt der Testwert nicht im kritischen Bereich; die Nullhypothese wird daher nicht

verworfen.

Über die Nullhypothese, dass kein Wohnform-Haupteffekt vorhanden ist, wird mit Hilfe

des Testwerts F(2, 6) (= 10.5 ) entschieden. Der Testwert liegt im kritischen Bereich; die

Nullhypothese wird somit verworfen.

1

2

3

4

5

6

5.2.2 Zwei Faktoren bei ungleichen Zellbesetzungen

Nagl, Einführung in die Statistik

Seite 206

Die Varianzanalyse wurde ursprünglich für geplante Experimente entwickelt. Dabei war es kein Problem,

gleiche Zellbesetzungen in den Zellen vorzusehen. In dieser Situation sind die Faktoren selbst unabhängig im

Häufigkeitssinn (das trifft auch für Designs zu, bei denen die Häufigkeiten proportional zu den Randhäufigkeiten

sind). In varianzanalytischer Terminologie werden Versuche, bei denen gleiche oder proportionale

Zellbesetzungen gegeben sind, als balanzierte Designs bezeichnet. Bei nichtbalanzierten Designs korrelieren im

allgemeinen die Faktoren, da die Häufigkeiten nicht proportional zu den Randhäufigkeiten sind.

Bei der Erweiterung auf beliebige Zellbesetzungen (nichtbalanzierte Designs) werden die für gleiche

Zellbesetzungen definierten Konzepte (Haupteffekte, Interaktionseffekte und Fehlermaße) übernommen. Ebenso

entspricht die Vorgehensweise für Tests von Hypothesen der balanzierten Situation.

Bei der Erweiterung sind allerdings zwei Aspekte zu beachten, die die Interpretation der Effekte bei ungleichen

Zellen komplizieren:

Bei den Modellen, die verschiedene Faktoren berücksichtigen, sind die geschätzten Effekte je nach

Modell unterschiedlich groß.

Die Fehlerreduktion durch einen bestimmten Faktor ohne Konstanthaltung ist nicht gleich groß wie die

Fehlerreduktion dieses Faktors bei Konstanthaltung eines andern Faktors.

Beispiel: Beim Einkommensbeispiel werden

zwei daheim wohnende Studenten

hinzugefügt mit den Einkommenswerten 6.

Dadurch ändern sich die Zellmittelwerte

nicht

Studenteni1 a i2

b

Einkommen

Die beiden Probleme sind

darauf zurückzuführen, dass

bei ungleichen

Zellbesetzungen die

Gruppenmittelwerte für die

Stufen der Faktoren nicht

gleich dem ungewichteten

Mittelwert über die

Zellmittelwerte sind (diese

Gleichheit gilt bei

balanzierten Designs).

1

1

1

2

2

2

m

m

m

w

w

w

1

2

3

1

2

3

Daheim

WG

Privat

Daheim

WG

Privat

Der Gesamtmittelwert (=7.2857) ist nun nicht mehr

dem ungewichteten Mittel der Zellenmittelwerte.

I. a. sind auch die Randmittelwerte (Mittelwerte der

Gruppen) wegen unterschiedlicher Häufigkeiten nicht

mehr gleich dem ungewichteten Mittelwert über die

Zellmittelwerte.

b

i2

6, 6, 6, 6

6.5, 7.5

7.5, 8.5

5.5, 6.5

8.0, 10.0

8.5, 9.5

i1

1

2

6

6

7

9

8

9

Randmi

ttel

6.75

8

6

8

8.5

7.2857

daheim wg

a

1 m

2 w

Randmittel

3

privat

Prädiktionsfehler und Schätzung der Effekte für die verschiedenen Modelle

Wie im balanzierten Fall können auch hier die Effekte geschätzt werden unter Berücksichtigung mehr oder

weniger Faktoren. Die Effekte werden nach den Kleinst-Quadrateprinzip geschätzt: KQ Schätzer der Effekte bei

symmetrischen Restriktionen:

Modell

Konstante

Sexeffekte Wohneffekte Interaktionseffekte Prädiktionsfehler

ˆ 11 , ˆ 12

̂

̂ 1 , ̂ 2

̂ , ̂ , ̂

1

OHNE

7.285714

Sex(=a)

7.375

Wohnform(=b)

Additiv: Sex und

Wohnform

Sex, Wohnform und

Interaktion

7.5

2

3

26.85

0.625, -0.625

21.5

-1.5, 0.5, 1

9

6.3

7.55

0.45, -0.45

-1.4, 0.45, 0.95

7.5

0.5, -0.5

-1.5, 0.5, 1

0.5, -0.5

4

Während hier bei den unterschiedlichen Modellen jeweils unterschiedliche Schätzwerte für die Effekte eines

Faktors durch die KQ-Schätzung resultieren, sind beim balanzierten Fall die Effekte für den untersuchten Faktor

jeweils gleich (ebenfalls die Konstante) in allen Modellen.

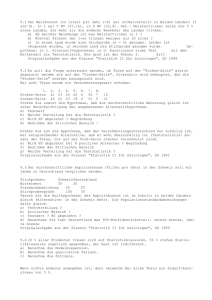

Die Fehlerreduktion durch einen Faktor ist unterschiedlich je nach Konstanthaltung der anderen Faktoren.

Studenten-Einkommens-Beispiel: Prädiktionsfehlerberechnung für nicht balanziertes Daten. Hier ist wiederum die Fehlerreduktion durch

einen Faktor unterschiedlich je nach Konstanthaltung (z.B. FR(b) =17.85 ungleich FR(b . a)=15.2).

-

-

ssqe(-)

26.85

FR(a)

a

b

a

ssqe(a)

ssqe(b)

21.5

FR(b . a)

Rein additives Modell

FR. durch Interaktion

17.85

5.35

FR(b)

FR(a . b)

b

9

2.7

15.2

a, b

a, b

ssqe(a,b)

6.3

2.3

FR(ab. (a,b) )

22.85

FR(a, b, ab)

a, b, ab

ssqe(ab)

a, b, ab

4

Nagl, Einführung in die Statistik

Seite 207

Im allgemeinen sollte der Faktor durch jene Fehlerreduktion beurteilt werden, bei der die maximale

Konstanthaltung vorliegt.

5.3 Kovarianzanalyse

Der Prädikand ist hier wie bei der Varianzanalyse quantitativ, mindestens intervallskaliert. Als Kovarianzanalyse

bezeichnet SCHEFFÈ(1959) jede Regressionsanalyse, die sowohl quantitative Merkmale als Prädiktoren als auch

qualitative Prädiktoren enthält. In diesem Kapitel soll nur eine Kovariate und ein Faktor betrachtet werden

Etwas eingeschränkter wird unter Kovarianzanalyse ein Verfahren verstanden, das erlaubt Gruppenunterschiede

(qualitativen Faktor) zu untersuchen, obwohl bekannt ist, dass die Gruppen in etwa einem (oder mehreren)

quantitativen Merkmal (Kovariate genannt) unterschiedlich sind, das seinerseits für den Prädikanden relevant ist.

Dabei soll nun mit Hilfe der ‚Konstanthaltung der Kovariaten’ die Vergleichbarkeit hergestellt werden. Diese

Form der Analyse sei als Kovarianzanalyse im engeren Sinne bezeichnet, die allgemeinere von SCHEFFÈ(1959)

eingeführte Bezeichnung als Kovarianzanalyse im weiteren Sinn.

5.3.1 Kovarianzanalyse im engeren Sinn

Allerdings sei bekannt, dass sich die Gruppen

in einer (für y vermutlich relevanten)

quantitativen x-Variablen unterscheiden.

Dieser Unterschied in der x-Variablen sollte

den Gruppenvergleich nicht beeinträchtigen.

Beispiel: Der Gewichtsunterschied zwischen Männern und Frauen (Sex als

qualitativer Faktor)soll festgestellt werden. Nun sind aber Männer meist auch

größer (Körpergröße als quantitatives x-Merkmal). Soll der Größenunterschied

berücksichtigt werden, könnten eventuell nur die Personen im schmalen

Überlappungsbereich untersucht werden, in dem sowohl Frauen als auch Männer

zu finden sind.

Gewicht in kg

Wie in der Varianzanalyse soll der

Unterschied bezüglich y zwischen Gruppen

festgestellt werden.

95

Überlappun

gsbereich

85

75

Eine Möglichkeit bestünde darin, nur UEen

im Überlappungsbereich des quantitativen xMerkmals für den Gruppenvergleich

heranzuziehen; dann müsste aber die

Stichprobe eventuell stark verkleinert

werden. Zudem ist es sehr schwierig, einen

angemessenen Überlappungsbereich zu

definieren

65

55

45

35

150

160

170

180

190

Größe in cm

Gewicht in kg

Es wird unterstellt, dass die beiden Regressionsgeraden (innerhalb beider

Die Kovarianzanalyse wählt einen anderen

Gruppen) die gleiche Steigung haben.

Weg:

Es wird unterstellt, dass zwischen x und

95

y ein linearer Zusammenhang besteht;

und zwar soll die Steigung in beiden

85

Gruppen gleich sein (Parallelität).

75

Dann kann der Unterschied zwischen

Gruppenun

den Gruppen an jeder beliebigen Stelle

terschied

65

des quantitativen Merkmals als

Höhenunterschied zwischen den

55

Geraden abgelesen werden.

Auf diese Art kann der Unterschied zwischen

45

den Gruppen unter Berücksichtigung des

35

Einflusses des x-Merkmals (d.h. unter

150

160

170

180

190

Größe in cm

Konstanthaltung von x) festgestellt werden.

Nagl, Einführung in die Statistik

Seite 208

Die Steigung der Geraden wird mit 0.77 geschätzt.

Lineare

Die Konstante ist irrelevant. Frauen sind im

Modellgleichung:

Schnitt 3.83 leichter als die Mitte, Männer um 3.83

y = k + i + x + e; schwerer (Gesamtunterschied = 2*3.83 = 7.66). Der

wobei die i die für Unterschied ist aber gerade nicht mehr signifikant

(Prob>|t| = 0.055; das ist größer als =0.05)

I Gruppen so

Schätz Std

gewählt werden

Term

wert Error t Ratio Prob>|t|

können, daß sie sich

-69.36 35.04 -1.98 0.053

k

Für jeden Schätzwert wird der Standardfehler zu 1 summieren

-3.83 1.95 -1.97 0.055

weibl.

der t-Wert und p-Wert berechnet (der p-Wert

3.83 1.95 1.97 0.055

männl.

erlaubt durch Vergleich mit die Signifikanz

Größe(cm) 0.77 0.20 3.83

0.000

zu beurteilen)

Die Analyse des Gruppenunterschieds setzt die Parallelität der Geraden innerhalb der beiden Gruppen voraus.

Diese Parallelität kann ebenfalls untersucht und die Parallelitätshypothese getestet werden.

Als Modell wird eine additive Verknüpfung

der Gruppeneffekte und der Regressiongerade

mit Steigung (inklusive der obligaten Konstanten k) verwendet. Mit Hilfe eines

Regressions-Computerprogramms können die

Parameter leicht geschätzt werden.

5.3.2 Kovarianzanalyse im weiteren Sinn

5.3.2.1 Überprüfung der Parallelität von Regressionsgeraden

Gewicht in kg

Für die Gruppen des qualitativen Merkmals Beispiel: Für die beiden Sexgruppen (Männer und Frauen) kann jeweils eine

wird jeweils eine eigene Regressionsgerade Regressionsgerade bestimmt werden

berechnet.

Die Parameter des Abschnitts auf der y-AchMänner

95

se (bei x=0) seien für die i Gruppen

y= -90.28 + 0.90 x

85

1, 2, ... , I.

Die Parameter der Steigung seien für die i

75

Frauen

Gruppen

1, 2, ... , I.

y= -22.58 + 0.46 x

65

Untersucht werden soll, ob die

Steigungsparameter in den verschiedenen

Gruppen gleich sind.

55

45

35

150

Falls die Steigungen verschieden sind, sind

die Niveauunterschiede zwischen den

Gruppen je nach x-Position unterschiedlich

160

170

180

GrößenMittelwert

=176.9

190

Größe in cm

Zur Überprüfung der Parallelität wird eine Regressions- bzw. Kovarianzanalyse

durchgeführt, bei der zusätzlich zum Faktor und der Größenvariablen die

Interaktion zwischen Größenvariablen und dem qualitativen Faktor eingeführt

Mit Hilfe einer sogenannten

Reparametrisierung kann die Fragestellung

durch eine Regressionsanalyse berechnet

werden, in der zusätzlich zum Faktor und

dem quantitativen x noch die Interaktion

zwischen Faktor und x eingeführt wird. Die

qualitativen Variablen werden in der Form

von Dummy-Variablen in die

Regressionsanalyse eingeführt.

Schätz Std

t

Prob>|t|

wert Error Ratio

Term

k

weiblich (bei 176.9)

Bei symmetrischer Restriktion wird dann

eine ‚durchschnittliche’ Steigung berechnet:

-56.37 37.31 -1.51

-5.04 2.29 -2.20

0.137

0.032

männlich (bei 176.9)

5.04

2.29 -2.20

0.032

Größe(cm)

0.68

0.22 3.15

0.003

Interaktion weibl.* (Größe(cm) -176.9) -0.22

0.22 -1.01

0.316

Interaktion männl.*(Größe(cm) -176.9) 0.22

0.22 1.01

0.316

wird.

Die geschätzte durchschnittliche Steigung ist 0.68 (=(0.46+0.90)/2).

Der Unterschied zur durchschnittlichen Steigung ist bei Frauen gleich –0.22. Das

heißt, die Steigung ist bei den Frauen um 0.22 kleiner; bei den Männern muss

wegen der symmetrischen Restriktion (=Summe gleich 0) die Steigung um 0.22

größer sein.

Für die Prüfung der Parallelitätshypothese reicht bei einem Faktor mit nur 2

Stufen der t-Test, da nur eine Abweichung zu prüfen ist. Die Hypothese kann bei

=0.05 nicht verworfen werden, da der p-Wert (Prob>|t| = 0.316) größer als ist;

bzw. der t-Wert (=-1.01) nicht im kritischen Bereich der Student-t-Verteilung

liegt.

Der Effekt von Sex (weiblich) mit –5.04 wird für die Stelle des Mittelwerts der xWerte berechnet.

Die Konstante k gibt den Abschnitt der durchschnittlichen Steigung auf der yAchse an (bei x=0).

= (1+2+... + I)/I

Zusätzlich wird für jede Gruppe die

Abweichung von der durchschnittlichen

Steigung berechnet. Für die Abweichungen

kann die Nullhypothese (alle Abweichungen

sind =0, d.h. Parallelität) mit Hilfe eines

Tests (F-Test) geprüft werden.

Einzelabweichungshypothesen können mit

dem t-Test geprüft werden.

Übersicht über die Fehler-Quadratsummen der verschiedenen Modelle. Gewichtsprädiktion: a = Sex, x = Körpergröße (n=53). Dargestellt

wird jeweils das Fehlermaß der Modelle (ssqe). Darauf aufbauend sind ebenfalls die Fehlerreduktionen eingetragen.

-

-

ssqe(-) 1

FR(a)

a

I

6869 1

2805

FR(x)

x

2

a

3483

x

Nagl, Einführung in die Statistik

Seite 209

5.3.2.2 Überprüfung der Gleichheit von Korrelationskoeffizienten

Für große Stichproben (n pro Gruppe mindestens 15) kann auch die Hypothese überprüft werden, dass die

Korrelationskoeffizienten in allen Gruppen gleich sind.

5.3.2.2.1 Korrelationstest für zwei unverbundene Stichproben

Sind die

Korrelationskoeffizienten

in zwei Gruppen gleich?

Wie bereits in Abschnitt

4.3.2 sollen auch hier die

FISHER'schen z-transformierten der

Korrelationskoeffizienten

betrachtet werden

Als Teststatistik für die

Nullhypothese, dass die

Korrelationen in beiden

Gruppen gleich ist

Kritischer Bereich und

Entscheidung.

Die beiden Korrelationskoeffizienten in der

Stichprobe werden mit r1 und r2 abgekürzt

(in der Population entsprechend griechische

Buchstaben). Die entsprechenden

Zufallsvariablen seinen mit R1 und R2

abgekürzt.

Die Korrelationswerte werden mit Hilfe der

Formel

z( r ) 12 ln 1 r (-1< r <1)

1 r

in z-Werte transformiert.

Die Teststatistik tw

z(r1 ) z(r2 )

1

n1 3

ist

Beispiel: Die Korrelation zwischen

Körpergröße und Gewicht in den beiden

Gruppen nach Sex:

1. weiblich r1=0.332 n1=18

2. männlich r2=0.5313 n2=35

FISHER'sche z-Transformierte der

Korrelationskoeffizienten:

Gruppe 1: z(r1)=z(0.332)=

0.5 ln( (1+.332)/ (1-0.332))=

= 0.345

Gruppe 2: z(r2)=z(0.5313) = 0.592

tw

z(0.332) z(0.5313)

1

n 2 3

approximativ standardnormalverteilt

Der zweiseitige Kritische Bereich bei der

Standardnormalverteilung für =0.05 ist der

Wertebereich, der kleiner gleich -1.96 bzw.

größer gleich 1.96 ist.

Der linksseitige KB für =0.05 ist der

Wertebereich, der kleiner gleich -1.645.

Der rechtsseitige KB für =0.05 ist der

Wertebereich, der größer gleich 1.645.

1

183

=

1

353

0.247

0.313

=

-0.789.

Die Alternativhypothese sei: Die

Korrelationskoeffizienten in den beiden

Gruppen sind verschieden.

Daher ist die Nullhypothese bei einem groß

negativem wie bei großem positivem

Testwert abzulehnen. Daher ist der KB

zweiseitig zu wählen.

Der Testwert tw= -0.789 liegt nicht im

zweiseitigen KB. Daher wird die

Nullhypothese akzeptiert.

5.3.2.2.2 Korrelationstest für mehrere unverbundene Stichproben

Die Nullhypothese

behauptet die Gleichheit

der Korrelationskoeffizienten in allen Gruppen

Wie bereits in Abschnitt

4.3.2 sollen auch hier die

FISHER'schen z-transformierten der

Korrelationskoeffizienten

betrachtet werden

Nullhypothese für I Gruppen:

Ho: 1 = 2 = ... = I.

Für alle Gruppen werden die

Korrelationskoeffizienten FISHER'sche zTransformiert:

z( r ) 12 ln 1 r (-1< r <1)

1 r

Beispiel: Korrelation zwischen geplanter und

tatsächlicher Arbeitszeit ist in den drei

Schichten {Unter-, Mittel- und Oberschicht}

gleich: Ho: (US) = (MS) = (OS) .

Angaben und FISHER'sche z-Transformierte

der Korrelationskoeffizienten:

ni

ri

z(ri)

1.

i

US

50

0.4

0.42

2.

MS

30

0.5

0.55

3.

OS

20

0.55

0.62

Nagl, Einführung in die Statistik

Als Teststatistik für die

Nullhypothese wird eine

Größe konstruiert, in der

den Unterschied zwischen

den z-Transformierten

berechnet wird.

Seite 210

Teststatistik:

I

tw = (n i 3)( z(ri ) z ) 2 ,

i 1

mit z

I

(n i 3)z(ri )

i 1

I

(n i 3)

i 1

(1)

ni-3

(2)

z(ri)

(3)

(1)*(2)

1

47

0.42

19.911

-0.074

0.255

2

27

0.55

14.831

0.052

0.073

3

17

0.62

10.512

0.1211

91

45.255

z=

Verteilung der

Teststatistik

Kritischer Bereich und

Entscheidung.

Tw ist unter Geltung der Nullhypothese 2

verteilt mit (I-1) Freiheitsgrade 2(I-1)

Kritischer Bereich auf Grund der Tabelle

bestimmen, Entscheidung wie üblich.

(4)

(5)

z(ri)- z (1)*(4)2

i

0.4973

0.249

0.577

=tw

Die Anzahl der Freiheitsgrade= I-1 =2

Bei 2 Freiheitsgraden ist der KB 5.99. Der

Testwert 0.577 liegt nicht drin.

Nullhypothese daher nicht ablehnen

Übungsaufgaben (5.2)

1.

Betriebe wurden untersucht, damit die Auswirkung von Supervision auf die Zufriedenheit der Beschäftigten

geprüft werden kann. Zudem soll auch der Bereich der Betriebe berücksichtigt werden. Es wurden pro Zelle

je zwei Betriebe erhoben; jeweils stand der Zufriedenheitswert des Betriebes zur Verfügung. Die

Zusammenfassung der Daten:

a.

b.

c.

d.

Supervision

a

Bereich

b

Anzahl

ja

ja

ja

ja

nein

nein

nein

nein

Exekutive

Medizin

Sozial

Wirtschaft

Exekutive

Medizin

Sozial

Wirtschaft

2

2

2

2

2

2

2

2

Zufriedenheits- Standardabwei

Mittelwert

chung

13

14

20

25

18

14

8

5

1.41421

1.41421

1.41421

2.82843

1.41421

1.41421

1.41421

1.41421

Berechnen Sie den multiplen Determinationskoeffizienten 1. Art.

Erstellen Sie ein Streudiagramm mit den Mittelwerteinträgen.

Berechnen Sie auch F(a) und F(b).

Stellen Sie die Mittelwerte in einer Matrix dar (Zeilen für die Stufen von a, Spalten für die Stufen

von b).

e. Schätzen Sie die Effektparameter (alpha’s und beta’s) unter symmetrischer Restriktion.

f. Berechnen Sie die Prädiktionswerte unter Geltung eines rein additiven Modells.

g. Berechnen Sie den Prädiktionsfehler bei der Prädiktion mit dem rein additiven Modell.

h. Zeichnen Sie den ‚Modell-Diamanten’ mit den entsprechenden Einträgen.

i. Berechnen Sie die Anzahl der Lin. unabhängigen Parameter, tragen Sie die Werte im ModellDiamanten ein.

j. Berechnen Sie die diversen Fehlerreduktionen (bitte im Diamanten eintragen!)

k. Berechnen Sie die Freiheitsgrade der Fehlerreduktionen (im Diamanten eintragen)

l. Erstellen Sie die Liste der Hypothesen in Form einer ANOVA-Tabelle, die im Rahmen der VA

getestet werden.

m. Berechnen Sie für die Zeilen die Msq-Werte, die F-Werte.

n. Welche Hypothesen werden verworfen, warum?