2. Für jede Fehlerreduktion der Art FR(z. x)= F(x)

Werbung

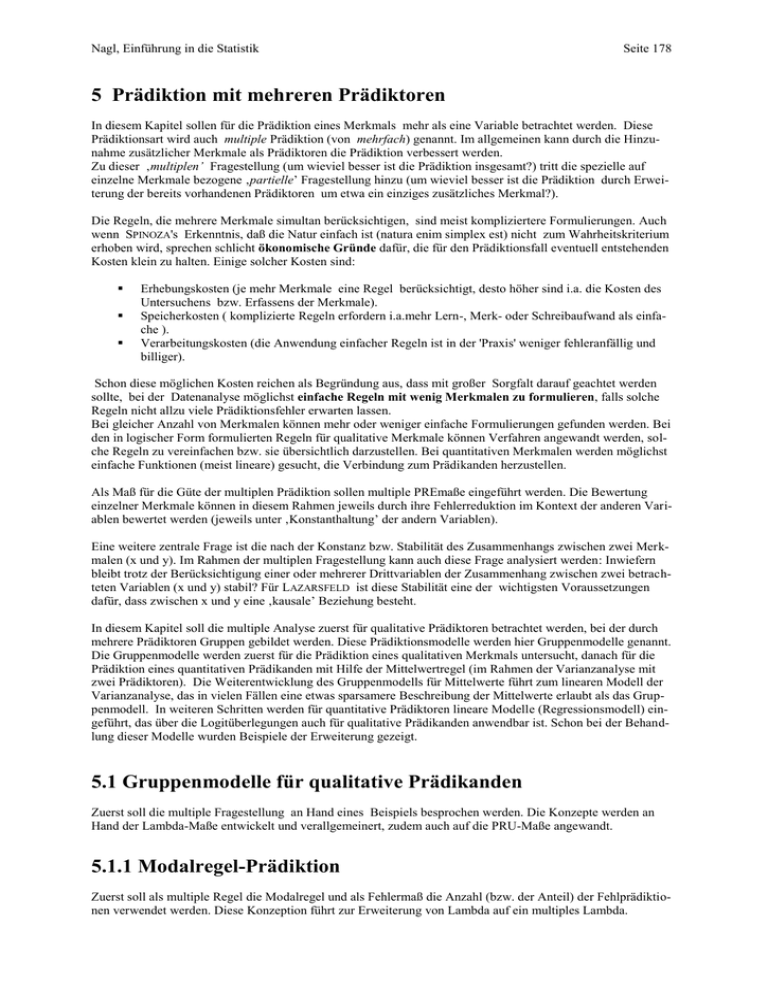

Nagl, Einführung in die Statistik Seite 178 5 Prädiktion mit mehreren Prädiktoren In diesem Kapitel sollen für die Prädiktion eines Merkmals mehr als eine Variable betrachtet werden. Diese Prädiktionsart wird auch multiple Prädiktion (von mehrfach) genannt. Im allgemeinen kann durch die Hinzunahme zusätzlicher Merkmale als Prädiktoren die Prädiktion verbessert werden. Zu dieser ‚multiplen’ Fragestellung (um wieviel besser ist die Prädiktion insgesamt?) tritt die spezielle auf einzelne Merkmale bezogene ‚partielle’ Fragestellung hinzu (um wieviel besser ist die Prädiktion durch Erweiterung der bereits vorhandenen Prädiktoren um etwa ein einziges zusätzliches Merkmal?). Die Regeln, die mehrere Merkmale simultan berücksichtigen, sind meist kompliziertere Formulierungen. Auch wenn SPINOZA's Erkenntnis, daß die Natur einfach ist (natura enim simplex est) nicht zum Wahrheitskriterium erhoben wird, sprechen schlicht ökonomische Gründe dafür, die für den Prädiktionsfall eventuell entstehenden Kosten klein zu halten. Einige solcher Kosten sind: Erhebungskosten (je mehr Merkmale eine Regel berücksichtigt, desto höher sind i.a. die Kosten des Untersuchens bzw. Erfassens der Merkmale). Speicherkosten ( komplizierte Regeln erfordern i.a.mehr Lern-, Merk- oder Schreibaufwand als einfache ). Verarbeitungskosten (die Anwendung einfacher Regeln ist in der 'Praxis' weniger fehleranfällig und billiger). Schon diese möglichen Kosten reichen als Begründung aus, dass mit großer Sorgfalt darauf geachtet werden sollte, bei der Datenanalyse möglichst einfache Regeln mit wenig Merkmalen zu formulieren, falls solche Regeln nicht allzu viele Prädiktionsfehler erwarten lassen. Bei gleicher Anzahl von Merkmalen können mehr oder weniger einfache Formulierungen gefunden werden. Bei den in logischer Form formulierten Regeln für qualitative Merkmale können Verfahren angewandt werden, solche Regeln zu vereinfachen bzw. sie übersichtlich darzustellen. Bei quantitativen Merkmalen werden möglichst einfache Funktionen (meist lineare) gesucht, die Verbindung zum Prädikanden herzustellen. Als Maß für die Güte der multiplen Prädiktion sollen multiple PREmaße eingeführt werden. Die Bewertung einzelner Merkmale können in diesem Rahmen jeweils durch ihre Fehlerreduktion im Kontext der anderen Variablen bewertet werden (jeweils unter ‚Konstanthaltung’ der andern Variablen). Eine weitere zentrale Frage ist die nach der Konstanz bzw. Stabilität des Zusammenhangs zwischen zwei Merkmalen (x und y). Im Rahmen der multiplen Fragestellung kann auch diese Frage analysiert werden: Inwiefern bleibt trotz der Berücksichtigung einer oder mehrerer Drittvariablen der Zusammenhang zwischen zwei betrachteten Variablen (x und y) stabil? Für LAZARSFELD ist diese Stabilität eine der wichtigsten Voraussetzungen dafür, dass zwischen x und y eine ‚kausale’ Beziehung besteht. In diesem Kapitel soll die multiple Analyse zuerst für qualitative Prädiktoren betrachtet werden, bei der durch mehrere Prädiktoren Gruppen gebildet werden. Diese Prädiktionsmodelle werden hier Gruppenmodelle genannt. Die Gruppenmodelle werden zuerst für die Prädiktion eines qualitativen Merkmals untersucht, danach für die Prädiktion eines quantitativen Prädikanden mit Hilfe der Mittelwertregel (im Rahmen der Varianzanalyse mit zwei Prädiktoren). Die Weiterentwicklung des Gruppenmodells für Mittelwerte führt zum linearen Modell der Varianzanalyse, das in vielen Fällen eine etwas sparsamere Beschreibung der Mittelwerte erlaubt als das Gruppenmodell. In weiteren Schritten werden für quantitative Prädiktoren lineare Modelle (Regressionsmodell) eingeführt, das über die Logitüberlegungen auch für qualitative Prädikanden anwendbar ist. Schon bei der Behandlung dieser Modelle wurden Beispiele der Erweiterung gezeigt. 5.1 Gruppenmodelle für qualitative Prädikanden Zuerst soll die multiple Fragestellung an Hand eines Beispiels besprochen werden. Die Konzepte werden an Hand der Lambda-Maße entwickelt und verallgemeinert, zudem auch auf die PRU-Maße angewandt. 5.1.1 Modalregel-Prädiktion Zuerst soll als multiple Regel die Modalregel und als Fehlermaß die Anzahl (bzw. der Anteil) der Fehlprädiktionen verwendet werden. Diese Konzeption führt zur Erweiterung von Lambda auf ein multiples Lambda. Nagl, Einführung in die Statistik Der Prädikand sei ein qualitatives Merkmal. Als m Prädiktoren dienen im Gruppenmodell mehrere qualitative Merkmale x1, x2, ... , xm. Erstellen der (m+1)-dimensionalen Häufigkeitstabelle: Da die x-Merkmale qualitativ sind, können die diversen Kombinationen der Ausprägungen der Merkmale vorerst wie die Ausprägungen einer einzigen KombinationsVariablen (=x) interpretiert werden. Seite 179 Beispiel: Multiple Prädiktion des Merkmals ‚Angst vor neuen Aufgaben’ auf Grund der ersten 50 UEen der Studentenuntersuchung. Die Prädiktoren sind drei dichotomisierte Merkmale, die mit mit den drei Buchstaben m (=x1) a (=x2) und s (=x3) abgekürzt werden. Das Ergebnis kann in Form einer vierdimensionalen Häufigkeits-Kreuztabelle dargestellt werden: Ausbildung der Mutter (m) höher als VS(h) Arbeiten zu Hause (a) viel (v) wenig(w) volksschule (v) viel(v) wenig(w) Mit dieser Interpretation können die Häufigkeiten in der gleichen Art wie bei einer Kreuztabelle mit nur einem x- und yMerkmal dargestellt werden. Modal-Prädiktionsregeln Für jede Kombinationsausprägung kann auch eine Modal-Prädiktionsregel gefunden werden (in der gleichen Art wie bei einer Kreuztabelle mit nur einem x und y-Merkmal). Die Regel R(x1,x2,...,xm) unter Berücksichtigung der verschiedenen x-Merkmale kann wiederum kurz in Tabellenform dargestellt werden bzw. ausführlicher in aussagenlogischer Form (die Merkmalsausprägungen werden pro Zeile mit ‚’ verknüpft). Für jede der und-verknüpften Bedingung kann eine Konditionalaussage formuliert werden. Bei zwei Ausprägungen des Prädikanden genügt es, nur die Bedingungen für eine der beiden Ausprägungen zu charakterisieren. Die Bedingung für eine bestimmte Ausprägung kann auch in Form eines Mengendiagramms (VENN-Diagramm) dargestellt werden. Die und-Verknüpfung() entspricht dem Mengenschnitt (), die oder-Verknüpfung () entspricht der Mengen-Vereinigung(). Berufliche Sicherheit ist wichtig (s) ja (j) nein(n) ja (j) nein(n) ja (j) nein(n) ja (j) nein(n) y: Angst vor neuen Aufgaben ja nein 0 1 2 8 2 0 3 9 2 0 4 2 3 1 5 8 21 1 10 2 12 2 6 4 13 29 50 In den Zellen der Kreuztabelle steht die Anzahl der UEen, für die alle entsprechenden Zeilen-Ausprägungen als auch die Spaltenausprägung zutrifft. Die Modalregeln werden pro Zeile (Kombinationsausprägung der x-Merkmale) für die Prädiktion von y erstellt (siehe oben). Darstellung der Regeln in Tabellenform und als Konditionalaussagen: R(mas) m a s h h h h v v v v v v w w v v w w j n j n j n j n y n n j n j j j n F(mas): Fehleranzahl 0 2 0 3 0 2 1 5 13 R(mas) (m=h) (a=v) (s=j) (m=h) (a=v) (s=n) (m=h) (a=w) (s=j) (m=h) (a=w) (s=n) (m=v) (a=v) (s=j) (m=v) (a=v) (s=n) (m=v) (a=w) (s=j) (m=v) (a=w) (s=n) (y=n) (y=n) (y=j) (y=n) (y=j) (y=j) (y=j) (y=n) Prädiktion von y=j, wenn (m=h) (a=w) (s=j) oder (m=v) (a=v) (s=j) oder (m=v) (a=v) (s=n) oder (m=v) (a=w) (s=j); sonst Prädiktion von y=n VENN-Diagramm für die Bedingung, für die y=j prädiziert wird: s=j a=w Jedes Teilsegment ist hier der Schnitt jeweils dreier Bedingungen. m=v Vereinfachen der Regel: Der logische Ausdruck kann meist zudem vereinfacht werden (unter Verwendung der Gesetze der boolschen Algebra). Eine große Hilfe dabei ist das Mengendiagramm Auf Grund des obigen VENN-Diagramms kann leicht nachgeprüft werden, dass die folgende Beschreibung der Bedingung äquivalent zur ursprünglichen komplizierteren Beschreibung ist: (a=w) (s=j) oder (a=v) (m=v); in Worten(mit Prädiktion): Wer wenig arbeitet und Sicherheit wünscht oder wer viel arbeitet und eine Mutter mit Volksschulausbildung hat, hat Angst vor neuen Aufgaben 5.1.1.1 Multiples Lambda Die Prädiktion wird wiederum über die Fehlerreduktion bewertet: Die Anzahl der Fehlprädiktionen für ein Prädiktionsscenario ist gleich der AnAls Fehler MIT x1,x2,... und xm, abgekürzt durch F(x1,x2,...,xm), wird die Anzahl in den zahl der UEen in den nicht prädizierten Zellen. Der Wert wurde bereits in der Tabelle oben (im vorigen Abschnitt) berechnet: nicht prädizierten Zellen(=Fehlerzellen) F(m,a,s)=13 bzw. kurz F(mas)=13 verwendet werden. Nagl, Einführung in die Statistik Regel und Fehler OHNE x-Werte: Die Regel OHNE die x-Werte wird wiederum auf Grund der y-Randverteilung gefunden (der Modalwert der Randverteilung). Der Fehler selbst ist die Anzahl der UEen außerhalb der Modalzelle der Randverteilung, abgekürzt: F(-) bzw. F(OHNE) Multiple Fehlerreduktion durch mehrere xMerkmale FR(x1,x2,...,xm) = F(-) - F(x1,x2,...,xm) Das multiple Lambda ist das ‚multiple’ PRE-Maß, das die Gesamtfehlerreduktion durch mehrere Merkmale anteilig auf den OHNE-Fehler bezieht: λ y|x1,x 2 ,,x m = F( )F( x1 , x 2 ,, x m ) F( ) FR ( x1 , x 2 ,, x m ) = F( ) = 1 Seite 180 Die OHNE-x Modalregel auf Grund der Randverteilung von y lautet: ‚Niemand hat Angst vor neuen Aufgaben’. Für jeden Einzelfall wird daher (y=n) prädiziert. Dadurch entsteht bei den UEen eine Fehlprädiktion, die nicht dem prädizierten Wert entspricht (y=j). y: Angst vor neuen Aufgaben ja nein 21 29 50 F(-) = 21. Die multiple Fehlerreduktion durch die Einführung der Regel, die alle drei Merkmale berücksichtigt, ist: FR(mas) = F(-) - F(mas) = 21-13 = 8 Das multiple Lambda berechnet die anteilige Fehlerreduktion, die simultan durch alle drei Prädiktoren erreicht werden kann: y|mas= 8/21 = (21- 13)/21 = 1 – 13/21 0.381. Der Prädiktionsfehler kann durch die Modalregel, die alle drei Merkmale als Prädiktoren berücksichtigt, um 38.1% reduziert werden. F( x1 , x 2 ,, x m ) F( ) 5.1.1.2 Fehlerreduktion durch einzelne Prädiktoren Für jedes Merkmal kann untersucht werden, wie groß sein Fehlerreduktionsbeitrag im Kontext der anderen Merkmale ist. Eventuell ist es gar nicht erforderlich, viele Merkmale simultan für die Prädiktion zu berücksichtigen, da vielleicht der Prädiktionsfehler bei weniger Merkmalen etwa gleich groß oder nur unerheblich kleiner. Deshalb sollen auch die Regeln mit den entsprechenden Fehleranteilen für weniger Prädiktoren untersucht werden. Erzeugen von kleiner-dimensionalen Häu- Eliminieren des Merkmals Sicherheit figkeitstabellen: Eliminieren von Prädiktoren erbringt folgende Häufigkeitstabelle: in der (m+1)-dimensionalen Häufigkeitstabely le. j n m a Die Spaltentexte der entsprechenden Merk11 h v 2 9 male werden gestrichen. Manche Zeilen ha14 w 5 9 ben danach gleiche Texte; die Häufigkeiten 8 v v 6 2 dieser Zeilen sind zu addieren und als eine 17 w 8 9 einzige Zeile in die neu zu bildende kleiner21 29 50 dimensionale Häufigkeitstabelle eingetragen. Auch für die kleinerdimensionalen Häufigkeitstabellen können Modalprädiktionsregeln erstellt und die entsprechenden Fehlermaße berechnet werden. Bei m Merkmalen können insgesamt (unter Berücksichtigung der Konstellation ohne Merkmal (-) und der Konstellation aller Merkmaln) 2m verschiedene Merkmalskombinationen gebildet werden. Für jede der Merkmalskombinationen kann wiederum eine Häufigkeitstabelle erzeugt, entsprechende Prädiktionsregeln erstellt und der Prädiktions-Fehler berechnet werden. Eliminieren des Merkmals Sicherheit und Arbeitsaufwand erbringt folgende Häufigkeitstabelle: y m h v Die Modalzellen sind oben markiert. Der Fehler, der m und a berücksicht, wird mit F(ma) abgekürzt: F(ma)=2+5+2+8=17 j 7 14 n 18 11 25 25 21 29 50 Der Fehler für die Regel, die nur m berücksichtigt ist F(m)=7+11=18 F(-)= 21 m a s F(m)=18 F(a)=21 F(s)=16 ma F(ma)=17 ms F(ms)=16 as F(as)=16 mas F(mas)=13 Die Fehler bei Berücksichtigung der jeweils angegebenen Merkmale wurden auf Grund der entsprechenden Häufigkeitsverteilungen berechnet. Bei 3 Merkmalen gibt es 2*2*2=8 verschiedene Merkmalskombinationen. Nagl, Einführung in die Statistik Seite 181 5.1.1.2 Sequentiell inkrementelle Teilfehlerreduktion Die sequentiell inkrementelle Fehlerreduktion dient als Fehlerübersicht bei sequentiellem Hinzufügen von zusätzlichen Merkmalen. Dadurch wird der Fehlerreduktionsbeitrag des einzelnen Merkmals innerhalb einer solchen Sequenz berechnet, wonach die prädiktive Relevanz des Merkmals bewertet werden kann. Eine solche Sequenz beginnt beim Fehler ohne ein Merkmal (-) und endet dann, wenn alle m Merkmale berücksichtigt sind. Sequentiell inkrementelle Sequentielle Fehler Teil-Fehlerreduktion durch ein Merkmal Fehler Fehlerreduktion: F(-) F(-) = 21 F(x1) FR(x1) = F(-) - F(x1) F(m)=18 FR(m) = 21-18 =3 F(x1,x2) FR(x2 . x1)= F(x1) - F(x1,x2) F(ma)=17 FR(a. m) =18-17 =1 .............. ............ F(mas)=13 FR(s. ma) = 17-13 = 4 FR(xm. x1,x2,..,xm-1)= F(x1,x2,...,xm-1)- F(x1,x2,..,xm) F(x1,x2,...,xm-1,xm) Bemerkung: Bei der inkrementellen Fehlerreduktion eines Merkmals wird jeweils untersucht, um wie viel der Fehler reduziert werden kann durch das Hinzufügen des Merkmals zur Menge der schon vorhandenen Merkmale. Daher wird diese Fehlerreduktion jeweils als Unterschied zwischen dem Fehler, der das Merkmal enthält, und dem Fehler, der besagtes Merkmal nicht enthält, berechnet. In der Bezeichnung wird hinter die Merkmalsbezeichnung ein Punkt gesetzt und danach die Liste der bereits vorhandenen Variablen eingefügt. Die Summe der Fehlerreduktionen einer Sequenz ist gleich der multiplen Reduktion Die multiple Fehlerreduktion ist die Differenz des Fehlers, der bei Berücksichtigung aller Merkmale bei der Prädiktion anfällt, zum Fehler, der kein Merkmal berücksichtigt. Da die Teilfehlerreduktionen innerhalb einer Sequenz jeweils die sukzessiven Differenzen der Fehler sind, muss die Summe dieser sukzessiven Differenzen gleich der Multiplen Differenzen sein. Denn z.B. für m=3: Beispiel: Multiple Fehlerreduktion: FR(x1) + FR(x2 . x1)+FR(x3 . x1 x2) = FR(mas) = 8 FR(x1,x2,...,xm) = F(-) - F(x1,x2,...,xm) = F(-) - F(x1) + (F(x1) - F(x1,x2)) + = FR(m) +FR(a. m) +FR(s. ma) Summe der Teil-Fehlerreduktionen einer (F(x1,x2) - F(x1,x2,x3)) = 3 + 1 + 4 Sequenz: FR(x1) + FR(x2 . x1)+ FR(x3 . x1 x2)+ = F(-) - F(x1,x2,x3). wzzw = 8 Da die mittleren Summanden jeweils ... + FR(xm. x1,x2,..,xm-1) wegfallen. Dieses Argument kann auf beliebiges m übertragen werden. Vielfalt von Sequenzen In manchen Anwendungen ist die Reihenfolge aus inhaltlichen Gründen vorgezeichnet; generell gibt es aber viele mögliche Reihenfolgen (m!) solch inkrementeller Fehlerreduktionen (im vorliegenden Beispiel sind das jeweils alle OHNE(-) nach Wege von FR(m) ‚mas’ im nachfolgenden Diagramm auf den eingetragenen Linien). - - F(-) 21 FR(a) FR(s) 3 0 5 a m a s m a s F(m) F(a) F(s) 18 21 16 FR(a. m) FR(m. a) FR(s . m) FR(m. s) FR(s. a) FR(a. s) 1 a 4 2 0 5 0 a ma ms as ma ms as F(ma) F(ms) F(as) 17 16 16 FR(s. ma) FR(a . ms) mas F(mas) FR(m. as) 4 3 s a mas m 3 13 Der Fehlerreduktionsbeitrag des einzelnen Merkmals ist i. a. sequenzabhängig Der Fehlerreduktionsbeitrag eines bestimmten Beispiel: Das Merkmal a bringt 0 als Fehlerreduktion FR(a), andererseits 1 Merkmals kann in verschiedenen Sequenzen nach Einführung von m (FR(a . m)) und 3 (=FR(a . ms)) nach Einführung von m und s. unterschiedlich groß sein Nagl, Einführung in die Statistik Seite 182 Diese Sequenzabhängigkeit der prädiktiven Relevanz eines Merkmals hat große Konsequenzen in der Datenanalyse. Folgende beiden idealtypischen Situationen sind möglich: Auch wenn ein einzelnes Merkmal allein keinen Beitrag zur Erklärung des Prädikanden leisten kann, kann es dies eventuell in Kombination mit anderen sehr wohl (z.B. a im Beispiel). Ein einzelnes Merkmal allein leistet einen großen Beitrag zur Erklärung des Prädikanden, in Kombination mit anderen ist die prädiktive Relevanz des Merkmals klein. Diese Thematik kann auch als Scheinunabhängigkeit bzw. Scheinabhängigkeit abgehandelt werden. Die prädiktive Relevanz eines Merkmals ist sequenzunabhängig, falls die Prädiktoren wechselseitig unabhängig (im Anteilssinn) sind. 5.1.1.3 Semipartielle und partielle Reduktion des Fehlers Der Fehlerreduktionsbeitrag des einzelnen Merkmals innerhalb einer Sequenz wurde oben definiert. Die Reduktion soll nun auch anteilig (prozentual) dargestellt werden. Als Basis der Prozentuierung kommen allerdings mehrere Fehlerwerte in Frage, im wesentlichen aber zwei Fehlerwerte: 1. Globale Basis der Anteilsbildung: Für alle Fehlerreduktionen der Fehlerwert ohne Merkmal (F(-)). Diese Art der Anteilsbildung wird manchmal die semipartielle genannt. 2. Für jede Fehlerreduktion der Art FR(z. x)= F(x)-F(x,z) wird als Anteilsbasis F(x) gewählt. Diese Art der Anteilsbildung wird auch partielle genannt. Bei dieser Gelegenheit werden Koeffizienten nur im Sinne der anteiligen Fehlerreduktion gebildet. Das partielle Lambda kann später noch in einem anderen Sinn interpretiert werden. Damit die Koeffizienten in jedem Kontext interpretiert werden können, wird bei der Bezeichnung auch der Prädikand beigefügt, jeweils unterschiedlich beim semipartiellen und beim partiellen. Dadurch können die Koeffizienten schon formal ohne weiteren Zusatz unterschieden werden. Semipartielles Lambda Basis der Anteilsbildung ist der Fehler ohne jedes Merkmal. Globalanteilige Reduktion des Fehlers durch ein Merkmal ‚unter Konstanthaltung’ anderer Merkmale y(z. x1x 2 ...x k ) = FR (z. x1x 2 ...x k ) F(-) F( x1x 2 ...x k )-F( zx1x 2 ...x k ) = F(-) Sprich: Semipartielles Lambda zwischen y und z unter Konstanthaltung von x1,x2,...,xm. Beachte die Bezeichnung mit dem Klammerausdruck: y( z. x 1 x 2 ...x k ) . Beispiel: FR (s. ma) F(ma)-F(mas) = = 17 - 13 =0.1905 21 F(-) F(-) Unter Konstanthaltung von m und a kann die Prädiktion von y durch s um 19.05% global verbessert werden FR (a. m) F( m)-F( ma) = = 18 - 17 =0.0467 y(a. m) = F(-) 21 F(-) Unter Konstanthaltung von m kann die Prädiktion von y durch a um 4.67% global verbessert werden FR ( m . ) F( )-F( m) = 21 - 18 =0.1429 y(m) = F(-) = 21 F(-) y(s. ma ) = Dieser letzte semipartielle Koeffizient ist zugleich der einfache Koeffizient für die Prädiktion von y auf Grund von m Partielles Lambda Basis der Anteilsbildung ist der Fehler an der Stelle, an der das Merkmal hinzugefügt wird. Anteilige Reduktion des Fehlers durch ein Merkmal ‚unter Konstanthaltung’ anderer Merkmale yz. x1x 2 ...x k = FR (z. x1x 2 ...x k ) F( x1x 2 ...x k ) Beispiel: FR (s. ma) F(ma)-F(mas) = = 17 - 13 =0.2353 17 F( ma) F(ma) Unter Konstanthaltung von m und a kann die Prädiktion von y durch s um 23.53% verbessert werden FR (a. m) F( m)-F( ma) Sprich: Partielles Lambda zwischen y und = = 18 - 17 =0.0556 ya. m = F( m) 18 F( m) z unter Konstanthaltung von Unter Konstanthaltung von m kann die Prädiktion von y durch a x1,x2,...,xm. um 5.56% verbessert werden FR ( m . ) F( )-F( m) Beachte die Bezeichnung ohne Klammer: = 21 - 18 =0.1429 ym = F(-) = 21 F(-) yz. x 1 x 2 ...x k . Dieser letzte partielle Koeffizient ist zugleich der einfache Koeffizient für die Prädiktion von y auf Grund von m F( x1x 2 ...x k )-F( zx1x 2 ...x k ) = F( x1x 2 ...x k ) ys. ma = Beachte: Partielle Lambdas sind größer (eventuell gleich) als semipartielle, weil die partiellen Koeffizienten durch einen kleineren Fehler dividiert werden als die semipartiellen! Nagl, Einführung in die Statistik Seite 183 5.1.1.4 Additive bzw. multiplikative Zerlegung des multiplen Lambda Das multiple Lambda kann selbst additiv durch semipartielle Lambdas eine Sequenz dargestellt werden, andererseits multiplikativ durch partielle Lambdas einer Sequenz. Additive Zerlegung Die additive Zerlegung ist leicht nachvollziehbar, da schon bereits besprochen wurde, dass die Summe der Fehlerreduktionen einer Sequenz ist gleich der multiplen Reduktion ist. Die einzelnen Fehlerreduktionen einer Sequenz sind jeweils nach Division durch den Faktor F(-) nach Definition die semipartiellen Lambdas. Andererseits ist das multiple Lambda definiert als multiple Reduktion durch den gleichen Faktor (F(-)): Multiples Lambda= λ y|x1,x 2 ,,x m = y( x1 ) + y( x 2 . x1 ) λ y|mas = y(m) + y(a. m) + y(s. ma ) 0.381 = 0.1429 + 0.0467 + 0.1905. Beispiel: + y(x3. x1x 2 ) 0. 4 0. 3 0. 2 λ y|mas 0. 1 + ... + y(x m . x1x 2 ...x m1) 0 Multiplikative Zerlegung Die multiplikative Zerlegung des multiplen Lambda in partielle Lambdas als Faktoren ist für die Fehlerkomponenten eher nachvollziehbar. Daher soll zuerst der multiple Fehleranteil in Faktoren zerlegt werden: Beispiel: Multipler Fehleranteil= F( x1 , x 2 ,, x m ) F( ) = F( x1 ) F( ) . F( x1 , x 2 ) F( x1 ) . F( x1 , x 2 , x 3 ) F( x1 , x 2 ) F( x , x ,, x ) . ... . F( x 1,x 2,, x m ) 1 2 m 1 Die Produkte auf der rechten Seite sind so aufgebaut, dass sukzessiv gekürzt werden kann; als Ergebnis des Kürzens ist gleich der linken Seite. Fehlerverhältnis: 1-Lambda: F(m)/F(-) *F(ma)/F(m) 18/21 *17/18 =1-ym =1-ya. m =1-0.1429 =1-0.0556 *F(mas)/F(ma) *13/17 =1-ys. ma =1-0.2353 =1-y|.mas =1-0.381 = = F(mas)/F(-) 13/21 =1 - 8/21 Der trotz der 1.Variablen verbleibende Fehleranteil wird multipliziert jeweils mit dem Fehlerverhältnis der weiteren Variablen als Faktor(= 1- partielle Lambda) Ergebnis: Der trotz aller 3 Variablen verbleibende Fehleranteilsverhältnis Da die entsprechenden Fehleranteilsverhältnisse jeweils 1- multiplem Lambda bzw. 1- partiellem Lambda entsprechen, folgt: 1- Multiples Lambda = 1 - λ y|x1,x 2 ,,x m = (1- y( x1 ) )*(1- y( x 2 . x1 ) )*(1- y( x3. x1x 2 ) )* ... *(1- y( x m . x1x 2 ...x m1 ) ) Bemerkung ‚Energiesparmaßnahmen’: Diese multiplikative Zerlegung ist wohl manchem geläufig aus dem Zusammenhang mit Überlegungen zu Heizkosteneinsparungen: Wie viel Prozent kann durch eine Sequenz von Maßnahmen insgesamt gespart werden (Die anteilsmäßige Ersparnis einer einzelnen Maßnahme entspricht dem partiellen Koeffizienten; die Gesamtersparnis dem multiplen Koeffizienten). Bei der Sequenz von Maßnahmen müssen jeweils (1-Ersparnisanteil ) der Einzelmaßnahmen multipliziert werden, damit der nach der Serie von Maßnahmen verbleibenden Anteil des ursprünglichen Energieverbrauchs errechnet wird (was 1- dem multiplen Koeffizienten entspricht). Weiterhin ist dabei auch verständlich, dass manche Maßnahme (entspricht einem Merkmal) in Kombination mit anderen mehr oder weniger bringen kann (entspricht: die Relevanz eines Merkmals als Prädiktor kann nicht isoliert von den andern Merkmalen betrachtet werden, die auch Prädiktoren sind). Daher spielt auch hier die Sequenz eine Rolle. Leider sind in vielen Prospekten diese Interdependenzen nicht berücksichtigt. Beispiel: Laut Prospekt wird durch folgende Maßnahmen in dieser Reihenfolge wird jeweils der Energiebedarf um x % gesenkt: Einbau von Doppelfenstern (um 20 Prozent); Isolationen bei den Fenstern( um 10 Prozent); Einbau einer Wärmepumpe( um 30 Prozent); Einbau von Solarzellen ( um 50 Prozent). Wieviel Prozent kann dadurch insgesamt an Energie gespart werden? Gesucht ist die multiple Ersparnis. Gegeben sind die partiellen Einsparungen, da wohl jedes Mal die Einsparung bezüglich des gerade erreichten Zustandes gemeint ist. Gestartet wird mit einem Zustand von 100% Kosten (als Anteil = 1): (a) Kostenanteil vor Maßnahme 1 0.80 0.72 0.504 Maßnahme Einbau von Doppelfenstern Isolationen bei den Fenstern Einbau einer Wärmepumpe Einbau von Solarzellen (b) Ersparnis 0.20 0.10 0.30 0.50 (c)=1 - (b) Faktor 0.80 0.90 0.70 0.50 (a)*(c) Kostenanteil nach Maßnahme 0.80 0.72 0.504 0.252 Der verbleibende Kostenanteil ist 0.252. Daher wurde insgesamt 1-0.252 = 0.748 gespart (vom ursprünglichen Stand aus gesehen). Nagl, Einführung in die Statistik Seite 184 5.1.1.5 Teilgruppen-Lambdas und partielles Lambda Die partiellen Lambdas können auch als gewichtete Mittelwerte der Teilgruppenlambdas berechnet werden. So wird beim partiellen Lambda (etwa zwischen y und x unter Konstanthaltung von z) die Begrifflichkeit des ‚Konstanthaltens’ oder auch das in ‚partiell’ enthaltene Wort ‚Teil’ besser verständlich. Die Konstanthaltung bezieht sich auf das z-Merkmal, dessen prädiktive Bedeutung insofern neutralisiert wird, als der Zusammenhang zwischen y und x für jede Teilgruppe berechnet wird. Einerseits ist zwar der Vergleich der verschiedenen Teilgruppenlambdas interessant, um zu überprüfen, welchen ‚Einfluß’ die z-Variable auf den Zusammenhang zwischen x und y hat. Im partiellen Lambda wird andererseits durch eine einzige Maßzahl der gewichtete Durchschnitt dieser Teilgruppenlambdas beschrieben. Eine einzige Maßzahl ist besonders dann aussagekräftig, wenn die Teilgruppenlambdas ungefähr gleich groß sind. 5.1.1.5.1 Übersicht über die Berechnung der Fehler bei drei Variablen Hier wird die Kreuztabelle der Häufigkeiten mit den Bezeichnungen für die Merkmale am Beispiel zweier xVariablen x1 und x2 dargestellt. Die Bezeichnungen sind so gewählt, dass eine Verallgemeinerung auf m x-Merkmale einfach möglich ist. In der Kreuztabelle werden auch die Summenhäufigkeiten dargestellt; dabei wird die bekannte Punktnotation für die Indizes verwendet, über welche summiert wird. y 1 2 J i1 i2 y1 y2 . yJ x1 x2 1 x11 1 x 21 n111 n112 . n 11J n11 x 22 1 x11 2 .. … . ... x 2I2 n11 1 x11 I2 1 x11 n121 n 12J n122 . ... ... . ... … n 1I21 n 1I 2 2 . n 1I2J n1I2 n12 . n1J n1 Beispiel: Das y-Merkmal sei wiederum ‚Angst vor neuen Aufgaben’. Die beiden x-Merkmale sind m und s. In der Kreuztabelle sind zusätzlich die Maxima der Häufigkeiten markiert, bei denen jeweils y-Modalwert liegt. Teilgruppen y 1 1. n22 2. m i2 s j n 1 1 1 h h h 1 2 j n 2 5 1 17 7 18 3 22 25 2 2 v v 1 2 5 9 1 10 6 19 2 v 14 11 25 21 29 50 n211 n212 . n21J n21 2 x 21 x 22 n221 n222 . n22J n22 . ... ... ... . ... … x12 I2 x 2I 2 n 2I21 n 2I 2 2 . n 2I2J n 2I 2 2 x12 n21 n22 n2J n2 … .. … n I111 ... ... 1 … x 2i 2 ... I1 … x 1I1 n I112 . n I11J n I11 1 h 1 j n111 n112 n11 1 h 2 n n121 n122 n12 I1 x 1I1 2 x 2i 2 n I1 21 n I1 22 . n I1 2J n I1 2 1 h . ... 2 x12 1 2 x12 . … 2 .. … . ... ... ... I1 x 1I1 I2 x 2I 2 n I1I21 n I1I 2 2 . n I1I2J n I1I2 I1 x 1I1 n I11 n I1 2 . n I1J n I1 n 1 n 2 . n J n … Bezeichnungen: Fehler pro Bedingung (vollständige x-Konfiguration): F( x 1 x 1i1 , x 2 x 2i 2 )= n i1i 2 - max (n i1i 2 j ) j Fehler für x-Randsummen: x1 –Randsumme: F( x 1 x 1i1 ) = n i1 - max (n i1 j ) j x2 –Randsumme F( x 2 x 2i 2 ) = n i 2 - max (n i 2 j ) j Total-Randsumme: F(-) = n - max (n j ) j 2 i1 j n Darstellung der Tabelle mit Häufigkeitssymbolen; pro Zeile wurden auch die Fehlerbezeichnungen eingefügt: in y i1 m i2 s 1 2 j n n11 n12 n1 2 v 1 j n211 n212 n21 2 v 2 n n221 n222 n22 2 v n21 n22 n2 n1 n2 n Fehlerbezeichnungen Zahlen F(m=h, s=j)= n11- n111 F(m=h, s=j)= n12- n122 F(m=h)= n1- n12 =1 =5 =7 F(m=v, s=j)= n21- n211 =1 F(m=v, s=n)= n22- n222 =9 F(m=v)= n2- n21 =11 F(-)= n- n2 =21 Die Prädiktionsfehler wurden oben pro Bedingung (jeweils eine Zeile in der vorliegenden Darstellung) eingetragen. Die Fehlerbezeichnungen enthalten jeweils zwei Argumente zur Charakterisierung der Bedingung, wenn beide Variablen berücksichtigt werden z.B. F(m=h, s=j). Falls die Bedingung nur ein Argument enthält z.B. F(m=h), bezieht sich die Bedingung nur auf eine Variable, was auch bedeutet, dass der Fehler für Häufigkeitsrandsummen berechnet wird. Für den Randsummenfehler muß keine Bedingung angegeben werden (F(-)). Dieser Fehler ist zugleich der Fehler OHNE irgendein Merkmal. Nagl, Einführung in die Statistik Seite 185 Auf Grund der Fehler pro Bedingung können die merkmalsspezifischen Fehler berechnet werden: F(x1, x2)= i111 i22 1 F(x 1 x 1i1 , x 2 x 2i2 ) I F(x1)= i11 F( x 1 x 1i1 ) 1 I2 F(x2)= i 1 F( x 2 x 2i 2 ) 2 I I Der Fehler mit m und s = F(m, s)= F(m=h, s=j)+ F(m=h, s=j)+ F(m=v, s=j) + F(m=v, s=n)= 1 + 5 + 1 + 9 = 16. Der Fehler mit m = F(m)= F(m=h)+ F(m=v) = 7+ 11=18. Auch F(s) (der Fehler mit s) kann auf gleiche Art berechnet werden; dafür ist zusätzlich die Tabelle erforderlich, bei der Variable m eliminiert wird. Der Fehler OHNE jede x-Variable ist F(-) =21. 5.1.1.5.2 Lambda in Gesamtgruppe, Lambdas der Teilgruppen und partielles Lambda Lambda für den Zusammenhang zwischen x2 und y werde für die Gesamtgruppe (ohne Aufgliederung in Teilgruppen) berechnet. Zu untersuchen: Bleibt der Zusammenhang erhalten in den Teilgruppen? Wird er größer / kleiner? Gesamt 21 wobei F( x 1 x 1i1 , x 2 ) 29 50 Fehler F(a) = F(-) = Lambda 16 21 ys= 5/21 = 0.238 ys für die Prädiktion von y auf Grund von s beträgt: 0.238. Für die Darstellung der Formeln für die Lambdas der Teilgruppen kann wieder die Bedingungsschreibweise der Fehler verwendet werden. Lambda für den Zusammenhang zwischen x2 und y in der i1. Teilgruppe (durch eine Ausprägung von x1 gebildet): F( x 1 x 1i1 , x 2 ) , yx2 (x1 x1i1 ) = 1 F( x 1 x 1i1 ) I2 F( x 1 i 2 1 y j n 9 7 2 14 27 41 s j n x 1i1 , x 2 x 2i 2 ) dem Fehler MIT x2 und F(x 1 x 1i1 ) dem Fehler OHNE x2 in der i1. Teilgruppe entspricht. Fehler der Teilgruppen Teilgrup pen 1. m h s j n 2. m v s j n Lambdas der Teilgruppen y j n 2 1 3 ys(m=h) = 5 17 22 F(m=h, s) =6 1 - 6/7 = 7 18 25 F(m=h) =7 1/7= 0.143 j n 5 1 6 ys(m=v) = 9 10 19 F(m=v, s) =10 1 - 10/11= 14 11 25 F(m=v) =11 1/11=0.091 Die Lamdas der Teilgruppen sind annähernd gleich groß aber kleiner als das Lambda für die Gesamtgruppe. Oben wurden bereits berechnet: F(m, s) = 16. F(m) = 18. Das partielle Lambda zwischen y und x2 unter Konstanthaltung der Variablen x1 wurde bereits im vorigen Abschnitt F( x 1 , x 2 ) F( x 1 ) F( x 1 , x 2 ) definiert als: yx2 . x1 1 = F( x 1 ) F( x 1 ) Daher ist das partielle Lambda zwischen y und s unter Konstanthaltung von m = ys. m = 1 – (16/18) = (18 - 16)/18 = 2/18 = 0.1111. 5.1.1.5.3 Partielles Lambda als gewichteter Mittelwert der Teilgruppen-Lambdas Die partiellen Lamdas sind nicht einfach ein Mittelwert über die verschiedenen Teilgruppen-Lambdas, sondern ein gewichteter Mittelwert. Die Gewichte sind die OHNE-Fehler der Teilgruppen. Das partielle Lambda zwischen y und x2 unter Konstanthaltung von x1, dargestellt als gewichtete Summe der Teilgruppen-Lambdas: yx2 . x1 = yx2 (x 1 x 11 ) F( x1 x11 ) F( x1 ) + yx2 (x 1 x 12 ) F( x1 x12 ) F( x1 ) + ... + yx2 (x 1 x 1I1 ) F( x1 x1I1 ) F( x1 ) Schema für die Berechnung des partiellen Lambda auf Grund der Teilgruppenlambdas: MIT s Fehler OHNE Fehler TeilLambdas der (1)*(2) in Teilgrup- in Teilgrupgrup Teilgruppen (2) / F(m) pen pen (1) pen m 1. h F(m=h, s) =6 F(m=h) =7 ys(m=h) = 1/7 1/18 2. , wobei: F(x 1 x 1i1 ) der Fehler OHNE x2 in der i1. Teil- v F(m=v, s) =10 F(m=v) =11 ys(m=v) =1/11 1/18 F(m) = 18 2/18 = ys.m Die Summe der Gewichte ist gleich 1. Daher kann sowohl von I gruppe ist; F(x1)= i11 F( x 1 x 1i1 ) ; einem gewichteten Mittelwert als auch von einer gewichteten Summe gesprochen werden. 1 Lambda für die i1. Teilgruppe yx2 ( x 1 x 1i1 ) Nagl, Einführung in die Statistik Seite 186 Denn: Jedes Teilgruppen-Lambda yx2 ( x 1 x 1i1 ) ist gleich 1 F(x1 x1i1 , x 2 ) / F(x1 x1i1 ) . Multiplizieren des Teilgrup- penlambdas mit dem Gewicht liefert pro Summand (F(x 1 x 1i ) F(x 1 x 1i , x 2 )) / F(x 1 ) . 1 1 Die Summe über alle x1-Teilgruppen lautet: = F(x1) und zusätzlich auch 1 F( x1 ) i111 F(x 1 x 1i1 ) F(1x1 ) i111 F(x 1 x 1i1 , x 2 ) . I I i111 F(x 1 x 1i1 , x 2 ) F(x 1 , x 2 ) I aber gleich der Definition für das partielle Lambda yx2 . x1 . 1 folgt, dass die Summe gleich i111 F(x 1 x 1i1 ) I Da F( x1 , x 2 ) ist. Dieser Ausdruck ist F( x1 ) Wzzw Die Mittelung über Teilgruppen-Lambdas ist nicht beschränkt auf Teilgruppen, die durch die Ausprägungen eines einzigen Merkmals gebildet werden, die Teilgruppen können auch durch die Kombination der Ausprägungen mehrerer Merkmale entstehen. Insofern ist die Idee der gewichteten Mittelung von Teilgruppen-Lambdas zum partiellen Lambda generalisierbar auf partielle Lambdas, bei denen mehr als ein Merkmal konstant gehalten wird. 5.1.2 Erweiterung auf PRU und tau Die Konzepte der multiplen Analyse konnten an Hand von Lambda wurde dadurch erleichtert, dass beim Lambda ein sehr einfaches Fehlermaß (Fehleranzahl bzw. Fehleranteil) verwendet werden kann. Hier soll gezeigt werden, wie die Konzepte auch auf andere PRE-Maße erweitert werden können. Die Berechnung der entsprechenden Fehlermaße ist etwas komplizierter. Dabei sollen die Fehlermaße im Einklang mit den Definitionen bei den zweidimensionalen Kreuztabellen hier ebenfalls auf der Basis der bedingten und der Randanteile berechnet werden. Für das PRU-Maß wird die Entropie in nits (also mit natürlichem Logarithmus) angegeben. 5.1.2.1 Berechnung der Fehlermaße Schreibweise: Generell können zwar m x-Variable betrachtet werden, der Übersicht halber wird das Schema für die bedingten Anteile und die diversen Randanteile hier nur für 2 Merkmale x1 und x2 dargestellt. Anteile y 1 2 y2 p . 11 J p11 p . p 12 J p22 i1 x1 i2 x2 1 x11 1 x 21 y1 p p 111 1 x11 2 x 22 .. … . ... I2 x 2I2 p 1 x 21 p p 1 2 x11 x12 2 x12 2 x 22 . … . ... p 2 x12 I2 x 2I 2 … … .. … I1 x 1I1 1 x 2i 2 p x 1I1 2 x 2i 2 p .. … . ... I1 x 1I1 I2 x 2I 2 I1 Beispiel 12 1 ... 1I 2 1 211 22 1 ... 2I21 11 2 p p … I11 1 I1 2 1 I1I 2 1 21 2 222 ... 2I2 2 . . p p p yJ p ... . p 21 J p21 . p 22 J p22 . ... . p 2I2J ... … p 2I 2 ... I11 2 . p I11 J p I11 I1 2 2 . p I1 2 J p I1 2 ... . I1I 2 2 . p I1I 2 J ... n 1 1 2 2 2 5 5 9 1 17 1 10 3 22 6 19 1 h 1 j n111 n112 n11 1 h 2 n n121 n122 n12 21 29 50 … p I1I2 h h v v 1 2 1 2 y j n j n y 1 2 1 2 n j i1 m i2 s h h v v j i1 m i2 s Anteile 1 1 2 2 2 i1 m i2 s y 2 … p1I2 1 1 . p1I 2J ... ... p 1I 2 2 p p 12 2 ... J Häufigkeiten Häufigkeiten j n j n 1 2 j n 2/3 1/3 3/50 5/22 17/22 22/50 5/6 1/6 6/50 9/19 10/19 19/50 21/50 29/50 50/50 2 v 1 j n211 n212 n21 2 v 2 n n221 n222 n22 n1 n2 n Auf Grund der Häufigkeiten werden einerseits die Randanteile gebildet werden. Die Summe der Randanteile aller x-Konfigurationen ist gleich 1. Pro x-Konfiguration (Zeile) werden die bedingten Anteile gebildet, die pro Zeile als Summe 1 haben. x-Randanteile: p i1i 2 n i1i 2 / n für alle i1 , i 2 y-Zeilenanteile für jede x-Konfiguration (Zeile) heißen auch bedingte Anteile für y-Ausprägungen (Bedingung ist die x-Konfiguration): p n i1i 2 j / n i1i 2 für alle i1 , i, 2 , j i1i 2 j BEACHTE: Summe in solchem Rundeck ist =1 p 1 p 2 . p J 1 Diese Darstellung ist auf m x-Merkmale erweiterbar, indem die i-Indices nicht nur aus zwei, sondern aus m Elementen bestehen. Nagl, Einführung in die Statistik Seite 187 Auf der Basis der bedingten y-Anteile und der x-Randanteile können die PRE-Maße wie im schon früher behandelten Fall berechnet werden, wenn nur eine x-Variable vorliegt; an die Stelle der Ausprägungen der einen xVariablen treten die x-Konfigurationen als ‚Ausprägungen’ der m x-Variablen. Als abkürzendes Symbol für die ausführlicher Beschreibung des Fehlers F(x 1 x 1i1 , x 2 x 2i 2 ) in einer Konfiguration wird F(x 1i1 , x 2i 2 ) verwendet. Entropie(x1 ,x2): Entropie in nits bei Berücksichtigung zweier Merkmale x1 und x2 Beispiel: Für die vier Konfigurationen (gebildet durch die Ausprägungen von I1 I 2 ist die nach s) wird die mittlere Entropie für die bedingten Anteile berechnet; mit F ( x , x ) F (x ,x )= , 1 2 dem Randan 1i1 2i 2 mdemundx-Randanteil multipliziert (1)*(2) (=Spalte 3) ist der Wert der Fehler i 1 i 1 1 2 teil der xder Konfiguration F(x 1i , x 2i ) . 1 2 KonfiguratioAnteile (1) (2) (3) y nen gewichwobei F(x 1i1 , x 2i 2 ) 1 2 J tete Summe h = p i1i 2 h i1i 2 ( y) und p i i j ln(p i i j ) i1i 2 (1) der mittleren *(2) 12 12 n p i1i 2 i1 m i2 s j (y) j1 Entropie jeder J 1 h 1 j 2/3 1/3 3/50 -2/3*ln(2/3) -1/3*ln(1/3) 0.637 0.0382 h i1i 2 ( y) p ln( p ) bedingten yi1i 2 j i1i 2 j -5/22*ln(5/22) j 1 1 h 2 n 5/22 17/22 22/50 0.536 0.2358 Verteilung . 17/22*ln(17/22) (=mittlere Entropie in der i1 i2. 2 v 1 j 5/6 1/6 6/50 -5/6*ln(5/6) - 1/6*ln(1/6) 0.451 0.0541 -9/19*ln(9/19) Konfiguration, die durch die 2 v 2 n 9/19 10/19 19/50 0.692 0.2629 10/19*ln(10/19) Ausprägungen von x1 und x2 F(m s)= 0.591 gebildet wird) Qualitative Varianz als Fehlermaß bei Berücksichtigung zweier Merkmale x1 und x2 Beispiel: Für die vier Konfigurationen (gebildet durch die Ausprägungen von I1 I 2 ist die nach dem Randan- F (x1 ,x2)= F( x 1i1 , x 2i 2 ) , m und s) wird die qualitative Varianz für die bedingten Anteile berechnet; mit dem x-Randanteil multipliziert (1)*(2) (=Spalte 3) ist der Wert der i1 1 i 2 1 teil der xFehler der Konfiguration F(x 1i , x 2i ) . Diese Fehler werden summiert. 1 2 KonfiguratioAnteile (1) (2) (3) y nen gewichwobei F(x 1i1 , x 2i 2 ) = J 1 2 tete Summe v (1) p i1i 2 v i1i 2 ( y) und p i1i2 j (1 p i1i2 j ) i1i 2 *(2) der qualitatin p i1i 2 i1 m i 2 s j (y) j1 J ven Varianv i1i 2 ( y) p (1 p ) 1 h 1 j 2/3 1/3 3/50 2/3*(1-2/3) +1/3*(1-1/3) 0.444 0.027 zen jeder ii j i1i 2 j 5/22* (1-5/22) j1 1 2 1 h 2 n 5/22 17/22 22/50 0.351 0.155 bedingten y+17/22* (1-17/22) (=qualitative Varianz in der Verteilung . 2 v 1 j 5/6 1/6 6/50 5/6* (1-5/6) + 1/6* (1-1/6) 0.278 0.033 i1 i2. Konfiguration, die durch 9/19* (1-9/19) + 2 v 2 n 9/19 10/19 19/50 0.499 0.189 10/19* (1-10/19) die Ausprägungen von x1 und F(m s)= 0.404 x2 gebildet wird) Auch der Fehler für Lambda kann als Anteil im Rahmen des vorliegenden Schemas berechnet werden. Fehleranteil für Modalregeln als Fehlermaß für Lambda bei Berücksichtigung zweier Merkmale x1 und x2. Beispiel: Für die vier Konfigurationen (gebildet durch die Ausprägungen von I1 I 2 ist die nach dem Randan- F (x1 ,x2)= F( x 1i1 , x 2i 2 ) , m und s) wird der Modalregelfehler für die bedingten Anteile berechnet; mit dem x-Randanteil multipliziert (1)*(2) (=Spalte 3) ist der Wert der Fehler i1 1 i 2 1 teil der xder Konfiguration F(x 1i , x 2i ) . 1 2 Konfigurationen gewichwobei F(x 1i1 , x 2i 2 ) = Anteile (1) (2) (3) y tete Summe 1 2 1 max p i i j d i1i 2 p i1i 2 d i1i 2 ( y) und (1) 12 des Modalrej *(2) n pi i i1 m i2 s j (y) 1 2 gelfehlers d i1i 2 ( y) 1 max p i1i 2 j 1 h 1 j 2/3 1/3 3/50 1 - 2/3 1/3 1/50 j jeder beding1 h 2 n 5/22 17/22 22/50 1 - 17/22 5/22 5/50 ten y(=der Modalregelfehler in der 2 v 1 j 5/6 1/6 6/50 1 - 5/6 1/6 1/50 Verteilung i1 i2. Konfiguration, die durch 2 v 2 n 9/19 10/19 19/50 1 - 10/19 9/19 9/50 die Ausprägungen von x1 und F(m s)= 16/ 50 x2 gebildet wird) Nagl, Einführung in die Statistik Seite 188 5.1.2.2 Multiple und partielle Konzepte gelten für alle PRE-Maße Bei der Einführung der Konzepte für die multiple Analyse an Hand von Lambda wurden bei der Definition der sequentiell inkrementellen Fehlerreduktion, der multiplen und partiellen Lambdas keine speziellen Eigenschaften verwendet, die auf Lambda beschränkt sind. Die Konzepte beruhen ausschließlich auf den Überlegungen der anteiligen Fehlerreduktion (proportional Reduction of Error), daher diese Definitionen auf alle PRE-Maße ausgedehnt werden. Bei PRU, tau und anderen PRE-Maßen sind nur entsprechend andere Fehlermaße involviert. Für die verschiedenen Teiltabellen ist jeweils das Fehlermaß für die Prädiktion von y zu berechnen. Die verschiedenen multiplen, partiellen und semipartiellen PRE-Maße werden auf Grund der entsprechenden Fehlerreduktionen definiert. Für das mas-Beispiel, für das oben bereits behandelt wurde: Entropie in nits als Fehler und Fehlerreduktion bei PRU-Maßen FR(m) - - F(-) 0.68 0.041 FR(s) FR(a) 0 0.059 a m a s m a s F(m) F(a) F(s) 0.64 0.68 0.622 FR(a. m) FR(m. a) FR(s . m) FR(m. s) 0.027 FR(a. s) FR(s. a) a 0.048 0.068 0.063 0.031 0.004 a ma ms as ma ms as F(ma) F(ms) F(as) 0.612 0.59 0.617 FR(s. ma) FR(a . ms) FR(m. as) 0.082 FR(mas) mas 0.061 s a mas m 0.088 0.151 0.53 F(mas) Wegen Rundungsproblemen leichte Inkonsistenzen! Das multiple PRE-Maß stellt die anteilige Fehlerreduktion durch alle m x-Variablen dar PRE y|x1,x2,...,xm= (F(-) - F(x1,x2,...,xm))/F(-) Das semipartielle PRE-Maß zwischen y und xs unter Konstanthaltung von x1,x2,...,xk stellt die anteilige Fehlerreduktion durch Hinzunahme das Merkmals xs zu x1,x2,...,xk dar: PRE y (xs . x1,x2,...,xk) = (F(x1,x2,...,xk)- F(x1,x2,...,xk,xs))/ F(-) Das partielle PRE-Maß zwischen y und xs unter Konstanthaltung von x1,x2,...,xk stellt die anteilige Fehlerreduktion durch Hinzunahme das Merkmals xs zu x1,x2,...,xk dar: PRE yxs . x1,x2,...,xk = (F(x1,x2,...,xk)- F(x1,x2,...,xk,xs)) / F(x1,x2,...,xk) Beispiel: für PRU PRU y|mas = (0.68 - 0.53) / 0.68 = 0.151/ 0.68 = 0.22 Die Unsicherheit (gemessen in Entropie) kann durch die Kenntnis von mas insgesamt um 22% reduziert werden z.B. PRU y (m . as) = (0.617 - 0.53) / 0.68 = 0.088/ 0.68 = 0.13 Die Unsicherheit (gemessen in Entropie) kann durch die Kenntnis von m (zusätzlich zu as) um 13% (bezogen auf die Anfangsunsicherheit) her reduziert werden z.B. PRU ym . as = (0.617 - 0.53) / 0.617 = 0.088/ 0.617 = 0.143 Die Unsicherheit (gemessen in Entropie) kann durch die Kenntnis von m (zusätzlich zu as) um 13% (bezogen auf die Unsicherheit bei as) her reduziert werden Für alle PRE-Maße gilt auch die additive Zerlegung des multiplen PRE-Maßes in semipartielle und die multiplikative in partielle PRE-Maße; für den Beweis dieser Sachverhalte beim Lambda wurden ebenfalls wieder nur PRE-Eigenschaften verwendet. Für alle Gruppenmodelle gilt zudem, dass das partielle PRE-Maß als gewichteter Mittelwert der Teilgruppen-PRE-Maße dargestellt werden kann. PRE yx2 . x1 = PRE yx2 (x 1 x 11 ) PRE yx2 (x1 x12 ) PRE yx2 (x 1 x 1I1 ) F( x1 x11 ) F( x1 ) F( x1 x12 ) F( x1 ) MIT s Fehler OHNE Fehler TeilLambdas der (1)*(2) in Teilgrup- in Teilgrupgrup Teilgruppen (2) / F(m) pen pen (1) pen m 1. h F(m=h, s) =6 F(m=h) =7 ys(m=h) = 1/7 1/18 + ... + F( x1 x1I1 ) F( x1 ) Schema für die Berechnung des partiellen Lambda auf Grund der Teilgruppenlambdas: + , 2. wobei: F(x 1 x 1i1 ) der Fehler OHNE x2 in der i1. Teilgruppe ist; F(x1)= i11 F( x 1 x 1i1 ) . I 1 Das PRE-Maß für die i1. Teilgruppe PRE yx2 ( x 1 x 1i1 ) v F(m=v, s) =10 F(m=v) =11 ys(m=v) =1/11 1/18 F(m) = 18 2/18 = ys.m Die Summe der Gewichte ist gleich 1. Daher kann sowohl von einem gewichteten Mittelwert als auch von einer gewichteten Summe gesprochen werden. Nagl, Einführung in die Statistik Seite 189 5.1.3 Schätzung und Hypothesen-Tests 5.1.3.1 Population und Stichproben Die Population kann durch die Anteile (x-Randanteile und bedingte y-Anteile) beschrieben werden. Sie werden wie üblich als die Populationsparameter bezeichnet. Die gemeinsamen Anteile in der Population für m xMerkmale und ein y-Merkmal heißen i1i 2 ...i m j . Auf dieser Bezeichnung aufbauend können bedingte Anteile und Randanteile gebildet werden. Im Beispiel Für 2 x-Merkmale x1 und x2 dargestellt: Pop.-Anteile 1 i1 x1 i2 x2 1 x11 1 1 x11 .. … 1 … x11 i1i 2 j sind die y 2 y2 . x 21 y1 11 J 11 2 x 22 . 12 J 22 . ... I2 x 2I2 … .. … I1 x 1I1 1 x 2i 2 I1 x 1I1 2 x 2i 2 .. … . ... I1 x 1I1 I2 x 2I 2 111 12 1 ... 1I 2 1 11 2 1I 2 2 … . I11 1 I1 2 1 I1I 2 1 1 ... 1I 2 . I11 J I11 I1 2 2 . I1 2 J I1 2 ... . I1I 2 2 . I1I 2 J 2 . ... J durch die Summation über die J y-Ausprägungen aus den gemeinsamen Anteilen. ... y 1 i1 m i2 s Die Randsummen ( i1i 2 ) entstehen … I11 2 ... . 1I 2J ... ... 12 2 ... . yJ Pop.Anteile gemeinsamen Anteile für die zwei x-Merkmale und für y J 2 j 1 h 1 j 1 h 2 n 2 v 1 j 2 v 2 n 111 12 1 211 22 1 1 n 11 2 11 12 2 22 21 2 21 222 22 2 1 y-Zeilenanteile für jede x-Konfiguration bedingten Anteile für y-Ausprägungen (Bedingung ist die xKonfiguration): i1i 2 j / i1i 2 für alle i1 , i, 2 , j … I1I2 1 i1i 2 j Ziehen der Stichproben. Grundsätzlich können mindestens zwei Arten des Ziehens von Stichproben unterschieden werden: 1. Eine einzige Zufallsstichprobe (Einfache Zufallsstichprobe). 2. Für jede x-Konfiguration kann eine Zufallsstichprobe gezogen werden (geschichtete Zufallsstichprobe). Dabei wird von vornherein geplant, wie groß die einzelnen Stichproben sein sollen. Die erste Arten wird auch als 1. Stichprobenschema, die zweite Art als 2. Stichprobenschema bezeichnet. 5.1.3.2 Schätzen der Anteile und Maximale Ln-Likelihood Die Anteile können mit Hilfe der ML-Methode geschätzt werden. Die vollen gemeinsamen Anteile i1i 2 ...i m j können und müssen verständlicherweise nur dann geschätzt werden, wenn eine einzige Zufallsstichprobe vorliegt. Die bedingten Anteile für y-Ausprägungen (= ) können sowohl bei geschichteter Zufallsstichprobe i1i 2 j als auch bei einer einfachen Zufallsstichprobe ML-geschätzt werden als: ˆ i i 1 2 ... i m j zugleich die bisher mit p i i 1 2 ... i m j n i1i 2 ... i m j / n i1i 2 ... i m . Sie sind abgekürzten Abedingten Anteile der Stichprobe. Die x-Randanteile sind bei einfachen Zufallsstichproben als ML-Schätzer darstellbar: ˆ i1i 2 ...i m n i1i 2 ...i m / n , bei geschichteten Stichproben sind die Randanteile bekannt. p i1i 2 ...i m n i1i 2 ...i m / n . Für die ML-geschätzten Anteile können die Standardfehler berechnet werden, die je nach Stichprobenschema leicht unterschiedlich sind. Bezeichnung und Berechnung der maximalen Ln-Likelihood bei Berücksichtigung der Variablen x1 ,x2, …,xm. Das Supremum des natürlichen Logarithmus der Likelihood an der Stelle der ML-geschätzten bedingten y-Anteile unter Berücksichtigung aller Variablen x1 ,x2, …,xm beträgt: Nagl, Einführung in die Statistik Seite 190 ln L( x 1 , x 2 , , x m ) I1 I2 i 2 1 i 2 1 Im J n i1i2 ...im j ln(ˆ i1i2 ...im j ) i 2 1 j1 Bei Berücksichtigung der beiden Merkmale x1 ,x2: ln L(x1 ,x2) Beispiel: Für die vier Konfigurationen (gebildet durch die Ausprägungen von ist die nach ln L(x1 ,x2)= m und s) wird der Logarithmus der Likelihood für die ML-Schätzer der I1 I 2 J dem Randanbedingten Anteile berechnet teil der x n i1i2 j ln(ˆ i1i2 j ) , Anteile y i 2 1 i 2 1 j1 Konfiguratio1 2 J nen gewich- dabei sind ̂ die MLn i1i 2 j ln( ˆ i i j ) i1i 2 j tete Summe n i1i 21 n i1i2 2 12 j n i1 m i2 s j 1 der mittleren Schätzer der bedingten Popula1 h 1 j 2/3 1/3 2 1 2*ln(2/3) + 1*ln(1/3) = -1.9 Entropie jeder tionsanteile, die mit den be1 h 2 n 5/22 17/22 5 17 5*ln(5/22) + 17*ln(17/22) = -11.8 bedingten y- dingten Stichprobenanteilen 2 v 1 j 5/6 1/6 5 1 5*ln(5/6) + 1*ln(1/6) = -2.7 p i i j identisch sind Verteilung . 1 2 2 v 2 n 9/19 10/19 9 10 9*ln(9/19) + 10*ln(10/19) = -13.1 ln L(m ,s)=-29.5 Kein x-Merkmal wird berücksichtigt: ln L(-) J Für den yln L(-) = n j ln( ˆ j ) Randanteil j1 (OHNE Aufgliederung) Die ML-Schätzer ˆ j der wird die Likebedingten Populationsanteile, lihood besind mit den bedingten Stichrechnet probenanteilen p j identisch. Beispiel: Für die y-Randtabelle wird der Logarithmus der Likelihood für die ML-Schätzer der bedingten Anteile berechnet Anteile y 1 2 i1 i2 j n 21/50 29/50 J n j ln(ˆ j ) n 1 n 2 21 29 j1 21*ln(21/50) + 29*ln(29/50) = -34 (Die Summationspunkte könnten auch entfallen, falls nur die Randtabelle betrachtet wird) ln L(-)=-34 Für die folgende Übersicht werden jeweils die Logarithmen der Likelihoods an der Stelle des ML-Schätzers berechnet für Modelle, die mehr oder weniger x-Merkmale als Prädiktoren berücksichtigen. In der Übersicht werden die Werte –2*ln L eingetragen: mas-Beispiel: für alle Teiltabellen wurden die Likelihoods berechnet. Dargestellt wird jeweils -2lnL - - -2lnL(-) 68 a m a s m a s -2lnL(m) -2lnL(a) -2lnL(s) 64 68 62.2 ma ms as ma ms as -2lnL(ma) -2lnL(ms) -2lnL(as) 61.2 59 61.7 a a s mas a mas m 53 -2lnL(mas) Mit lnL(-) wird die Likelihood für die y-Randverteilung bezeichnet, bei der nach keiner x-Variablen aufgegliedert wird. Ein Vergleich mit der Formel für die Entropie in nits zeigt, dass gilt: -ln L(x1 ,x2, …,xm) = n * Entropie(x1 ,x2, …,xm) Nagl, Einführung in die Statistik Seite 191 5.1.3.3 Testen von Hypothesen Im Rahmen der multiplen Analyse sind viele Hypothesen möglich; grundsätzlich sollen zwei Typen von Hypothesen unterschieden werden. Die Hypothesen können mit Hilfe des verallgemeinerten Likelihood-Ratio-Test geprüft werden, da die Schätzer ML-Schätzer sind. 5.1.3.3.1 Globale multiple Nullhypothese Die globale multiple Nullhypothese behauptet, dass die bedingten Anteile für jedes j der y-Ausprägung in allen x-Konfigurationen gleich sind. Diese Hypothese kann in einer Form etwas leichter formuliert werden, in der behauptet wird, dass alle Werte gleich einem bestimmten Wert sind, also dass die bedingten y-Anteile aller xKonfigurationen gleich einem bestimmten Wert sind: H0: i i ... i j a j für alle i 1i 2 ...i m und j 1,..., J - 1 . m 12 Diese Formulierung beinhaltet für jedes j (I1*I2*...*Im)- 1 Einzelhypothesen (da aj nur eine Formulierungshilfsgröße ist). Wenn alle Anteile gleich sind, müssen die y-Randanteile genau diese Größen sein. Daher kann obige Hypothese auch so formuliert werden: H0: i i ... i j ... j für alle i 1i 2 ...i m und j 1,..., J - 1 12 m Das Modell einmal unter Geltung dieser eingeschränkten H0-Hypothese (0-Raum) und einmal ohne diese Restriktion geschätzt werden (im uneingeschränkten -Raum). Für beide Varianten müssen die Likelihoods mit den entsprechenden ML-Schätzern berechnet werden. Der Vergleich dieser beiden Likelihoods liefert die Teststatistik. Maximaler Likelihoodfunktionswert unter Geltung der Nullhypothese Unter Geltung der Hypothese sind die gruppenspezifischen Schätzer für i i ...i j gleich dem Schät12 m zer für den y-Randanteil: ˆ i i ...i j ˆ ... j für alle i1i 2 ...i m 12 m sup ln L( i i 1 2 ... i m j 0 und j ; n i1i 2 ... i m j )=: lnL(-) Die Dim(0) gibt an, wie viele lin. unabhängige Parameter vorhanden sind: J-1 Beispiel : Der Ausgangspunkt der Überlegungen sei das Beispiel mit drei x-Variablen: mas. Daher müssen so drei Indizes berücksichtigt werden; unter Geltung der Nullhypothese sind die ML-Schätzer für die bedingten Pop-Anteile in allen x-Konfigurationen gleich: ˆ i i i j ˆ j für alle i1i 2 i 3 und j 12 3 Die Berechnung der Likelihood lnL(-) entspricht genau der Situation der hier vorgelegten Hypothese: sup lnL( i i i j ; n i1i 2i3 j ) = lnL(-) = -34. 1 2 3 0 Dim(0) = 2 – 1 = 1 Maximaler Likelihoodfunktionswert im NICHTrestringierten Raum Ohne Restriktion (-Raum) sind die gruppenspezifischen ML-Schätzer für i i ...i j gleich den be12 m dingten Stichprobenanteilen unter Berücksichtigung aller m Prädiktoren: ˆ i i ...i j p i i ...i j für alle i1i 2 ...i m und j. 12 m 12 Daher gilt: sup ln L( i i m 1 2 ... i m j ; n i1i 2 ... i m j )=: lnL(x1,x2, ...,xm) Beispiel (Fortsetzung): Unter Berücksichtigung der 3 x-Variablen: mas sind die ML-Schätzer für die bedingten Pop-Anteile in den Konfigurationen gleich den Stichprobenanteilen: ˆ i i i j p i i i j für alle i1i 2 i 3 und j. 12 3 12 3 Die Berechnung der Likelihood lnL(mas) entspricht genau dieser unrestringierten Situation: sup lnL( i i i j ; n i1i 2i3 j ) = lnL(mas) = -53. 1 2 3 Die Dimension von ist durch 8 Konfigurationen (=2*2*2) bestimmt. Für jede Konfiguration wird ein bedingter Anteil geschätzt (Der zweite Die Dim() gibt an, wie viele lin. unabhängige Parameter durch Anteil ergibt sich, weil die Summe der Anteile dieses Modell geschätzt wird: I1*I2*...*Im*(J-1). jeweils 1 ist). Daher Dim() = 2*2*2*1 = 8 Approximativ 2 verteilter Testwert Freiheitsgrade Entscheidung Nach dem generalisierten LR-Test-Prinzip ist die Differenz -2( lnL(-) - lnL(x1,x2, ...,xm) ) = -2lnL(-) - (-2lnL(x1,x2, ...,xm)) ( :=LR2 (x1,x2, ...,xm) ) approximativ 2 verteilt. Anzahl der Freiheitsgrade= Dim()-Dim(0) = Anzahl der durch die Nullhypothese gesetzten Parameter =( I1*I2*...*Im – 1)*(J-1). H0 ablehnen, wenn Testwert im KB (kritischen Bereich) liegt. LR2 (mas):= -2( lnL(-) - lnL(mas) ) = -2lnL(-) - (-2lnL(mas) = 68 53 = 15 Df = (8-1)(2-1) = 7 KB: LR2 (mas) 14.07 (= kritischer chi**2Wert aus Tabelle bei df=7 und =0.05). H0 wird abgelehnt Nagl, Einführung in die Statistik Seite 192 Der eben vorgestellte LR2 (x1,x2, ...,xm)-Test entspricht dem LR2-Test für eine zweidimensionale Kreuztabelle, bei der als globales x-Merkmal die Kombination der Ausprägungen der einzelnen x-Merkmale betrachtet wird. Die formulierte globale multiple Nullhypothese bedeutet zugleich, dass das y-Merkmal von den x-Merkmalen unabhängig ist. Die Teststatistik LR2 (x1,x2, ...,xm) kann im Rahmen der Modelle, die unterschiedlich viele Merkmale berücksichtigen, sehr gut deutlich gemacht werden; sie charakterisiert den Unterschied zwischen dem vollständigen Modell mit allen Merkmalen als Prädiktoren und dem OHNE-Modell. mas-Beispiel: Die Differenzen zwischen den -2lnL –Werten der verschiedenen Modelle sind LR2 verteilte Werte - - -2lnL(-) LR2 (m) LR2 (a) 68 1 4 LR2 (s) m a s -2lnL(m) -2lnL(a) -2lnL(s) LR2 (a . s) LR2 (m . s) LR2 (s . a) LR2 (a . m) LR2 (m . a) LR2 (s . m) ma ms as -2lnL(ma) -2lnL(ms) -2lnL(as) 0 m a 64 2 68 2 2.8 5 6.8 s 62.2 2 ma ms 61.2 4 59 4 as 61.7 4 6 LR2 (m . as) mas 9 8.2 LR2 (mas) 0.5 6.3 3.2 LR2 (a . ms) LR2 (s . ma) 6.2 a 15 mas 53 8 -2lnL(mas) z = Dim(Raum des Modells) =Anzahl lin. unabh. Parameter 5.1.3.3.2 Partielle Nullhypothesen Neben der globalen multiplen Nullhypothese gibt es jene auf bestimmte einzelne Variablen bezogenen Hypothese, die behaupten, dass die Aufgliederung durch eine bestimmte zusätzliche Variable (z) insofern nicht nötig sei, als die y-Anteile in der Population nur von den anderen bereits berücksichtigten Variablen abhängt. Durch diese Art der Hypothesen wird untersucht, inwiefern noch zusätzliche Variablen berechtigterweise zur Erklärung der y-Anteile eingeführt werden können. Hier können nur einige Beispiele von Formulierungen solcher Hypothesen dargestellt werden. Die Hypothesenforderung wird auch als bedingteUnabhängigkeitsforderung (bzw. lokale Unabhängigkeitsforderung) bezeichnet. Damit klar ist, dass mit dieser Unabhängigkeit die stochastische Unabhängigkeit gemeint ist, wird auch speziell von lokal stochastischer Unabhängigkeit gesprochen. H0 (x1 . x2x3...xm) x1 ist irrelevant unter Berücksichtigung aller andern Merkmale; Anders formuliert: x1 und y sind bedingt unabhängig; dh. Für jede durch die restlichen Variablen gebildeten Konfigurationen ist x1 und y unabhängig; Beispiel: Angenommen, man beschränkr sich auf zwei Merkmale. Das 1. Merkmal sei m, das 2. Merkmal sei s. Dann ist die Form der bedingten Anteile y i i j . in 12 j n m s y Pop s Die Tabelle mit den h j 0.67 0.33 j n = j 0.78 0.22 Stichprobenanteilen n 0.23 0.77 lautet: v j 0.83 0.17 = n 0.34 0.66 n 0.47 0.53 Die Hypothese, daß m irrelevant ist für die y-Anteile, lautet: Anders formuliert: Die bedingten y-Anteile in der Population sind gleich für die verschiedenen Ausprägungen von x1 (unter Konstanthaltung der andern Merkmale) : i i ...i j i ...i für alle i1i 2 ...i m und alle j 12 m 2 für alle möglichen Indizes, dh.: 12 2j y m s j n h j 111 11 2 n 121 12 2 j 211 21 2 n 221 22 2 mj v LR2 kann wiederum nach den LR-Prinzipien konstruiert werden i i j = i in Pop = = y s j n j 1 1 1 2 n 2 1 2 2 LR2 (m . s) = -2lnL(s) - (-2lnL(ms)) = 62.2 – 59 = 3.2 bei 4-2 (= 2) Freiheitsgraden Nagl, Einführung in die Statistik Andere Darstellungsformen der Nullhypothese der bedingten Unabhängigkeit. Seite 193 Die Hypothese der bedingten (gegeben s) Unabhängigkeit zwischen m und y besagt, daß die y-Anteile der Teiltabelle sy gleich sind in beiden nach m gebildeten Teilgruppen (links); oder auch (rechts): für die Teilgruppen nach s gilt: Die y-Anteile sind in beiden m Ausprägungen gleich. y m h v s j n j n j 0.67 0.23 0.83 0.47 n 0.33 0.77 0.17 = 0.53 in Pop = y s j m h v n h v j 0.67 0.83 0.83 0.47 n 0.33 0.17 0.17 = 0.53 in Pop = = Grundsätzlich könnten auch mehrere Variablen in einem Schritt in die Hypothese einbezogen werden, z.B. die erste und zweite Variable: H0 (x1 x2. x3...xm) x1 und x2 sind irrelevant unter Berücksichtigung der andern Merkmale y ist von x1 und x2 sind bedingt unabhängig; dh. y ist unabhängig von x1 und x2 für alle Konfigurationen, die durch die restlichen Variablen gebildet werden Die bedingten y-Anteile in der Population sind gleich für die verschiedenen Ausprägungen von x1 (unter Konstanthaltung der andern Merkmale) : i i i ...i j i ...i für alle i1i 2 ...i m und alle j 123 m 3 mj 5.1.4 Modellauswahl mit nichtmonotonen Informationskriterien Alle bisher in diesem Kapitel besprochenen Fehlermaße haben folgende Monotonitätseigenschaft: innerhalb einer Sequenz von Variablen wird der Fehler kleiner (bzw. gleich) bleiben durch das Berücksichtigen zusätzlicher Variablen. Das trifft entsprechend auch für die Likelihood zu: das Berücksichtigen einer zusätzlichen Variablen führt zu einer Erhöhung der Likelihood (an der Maximumsstelle). Der Grund für diese Monotonitätseigenschaft liegt darin, dass die gesuchten Regeln genau nur für die vorliegenden Daten optimiert werden. Je mehr Details in diesen Regeln berücksichtigt werden, desto weniger Fehler werden bei einer Prädiktionsaufgabe gemacht; allerdings nur so lange, als die Regeln nur auf die vorliegende Stichprobe angewandt werden. Würden die Regeln auf andere Stichproben angewandt, könnte sich herausstellen, dass die Regeln zu spezielle Datenkonstellationen einer Stichprobe in das Regelwerk mit aufgenommen wurde. Diese Erkenntnis stammt u.a. von H. AKAIKE (1975). Er hat daher versucht, die Regeln im Hinblick auf andere unabhängig gezogene Stichproben zu optimieren. Diese Optimierung bestand für ihn darin, für eine in der vorliegenden Stichprobe gefundene Regel ein Maß zu definieren, das den Fehler bei der Regelanwendung im Schnitt über andere unabhängige Stichproben minimiert (und daher nicht einfach den Fehler bei Regelanwendung in der vorliegenden Stichprobe). Die Grundidee dieses Kriteriums ist daher der Transfer der Regeln auf andere Stichproben. H. AKAIKE (1975) nannte sein Kriterium ‚An Information Criterion’ (=AIC). Es ist anwendbar auf alle ML-Schätzverfahren. Es soll hier im Hinblick auf die verschiedenen Gruppenmodelle formuliert werden, die unterschiedlich viele Variablen berücksichtigen. Ursprünglich hat H. AKAIKE (1973) sein Kriterium aus Prinzipien der Informationstheorie abgeleitet. H. AKAIKE’s AIC(x1,x2,x3,... ,xm) = Informationskri-2 lnL(x1,x2,x3,... ,xm) terium AIC für + 2 (Anzahl lin. unabh. Parameter), m Prädiktoren wobei lnL(x1,x2,x3,... ,xm) die oben eingeführte Likelihood an der Maximumsstelle für das Modell ist, das die Variablen x1,x2,x3,... ,xm berücksichtigt Beispiel : Wenn alle drei Variablen mas berücksichtigt werden, lautet die Formel: AIC(mas) = -2 lnL(mas) + 2 (Anzahl lin. unabh. Parameter für mas). Bereits oben wurde -2 lnL(mas) berechnet: 53. Die Anzahl lin. unabh. Parameter für mas wurde ebenfalls schon oben festgestellt: 8. Daher: AIC(mas) = 53 + 2*8 = 69 Als bestes Modell wird jenes ausgewählt, das den kleinsten AIC-Wert hat. Nagl, Einführung in die Statistik Seite 194 Im Anschluss an die Entwicklung des AIC wurden Verbesserungen vorgeschlagen, von denen vor allem das von G. SCHWARZ(1978) entwickelte SBC (=SCHWARZ-BAYES’sche Kriterium ) Beachtung verdient. Bei diesem Kriterium wird auch die Stichprobengröße berücksichtigt. Es ist nicht nur erwartungstreu wie das AIC, sondern auch zusätzlich konsistent. Das AIC führt in großen Stichproben tendenziell zur Entscheidung für zu komplizierte Regeln, daher sollte SBC bevorzugt werden. G. SCHWARZ’s SBC(x1,x2,x3,... ,xm) = Informationskri-2 lnL(x1,x2,x3,... ,xm) terium SBC für + ln(n) (Anzahl lin. unabh. Parameter), m Prädiktoren wobei lnL(x1,x2,x3,... ,xm) die oben eingeführte Likelihood an der Maximumsstelle für das Modell ist, das die Variablen x1,x2,x3,... ,xm berücksichtigt, und n die Stichprobengröße Beispiel : Wenn alle drei Variablen mas berücksichtigt werden, lautet die Formel: SBC(mas) = -2 lnL(mas) + ln (Anzahl lin. unabh. Parameter für mas). Daher: SBC(mas) = 53 + ln(50)*8 = 84.3 mas-Beispiel: SBC für alle Teilmodelle: Jeweils -2lnL + ln(n)Dim(Raum des Modells) - - SBC(-) 71.9 m a s m a s SBC(m) SBC(a) SBC(s) 71.8 75.9 70 ma ms as ma ms as SBC(ma) SBC(ms) SBC(as) 76.8 74.7 77.4 mas mas SBC(mas) 84.3 Als bestes Modell wird jenes ausgewählt, das den kleinsten SBC-Wert hat (Im vorliegenden Beispiel ist dies das Modell, das nur s berücksichtigt). Vor allem in Situationen, in denen keine klar formulierten Hypothesen vorhanden sind, ist die Modellauswahl mit Hilfe der Informationskriterien zu empfehlen. Beide Informationskriterien (SBC und AIC) sind wiederum als Fehlermaße interpretierbar; sie sind aber nicht monoton (ein zusätzliches Merkmal kann zu einer Erhöhung des Fehlers führen). PRE-Maß-Normierung der Informationskriterien Die Informationskriterien sind nicht normiert. Da normierte Maße leichter interpretierbar sind, ist auch bei den Informationskriterien eine Normierung erstrebenswert. Die Informationskriterien selbst entsprechen Fehlermaßen, für die eine PRE-Normierung möglich ist. Sie können durch das Anfangsfehlermaß (z.B. SBC(-)) dividiert werden. Zusätzlich können auch die Reduktionen als Maß verwendet werden. Manche Reduktionen können nun aber negativ werden, da bei Hinzunahme eines weiteren Prädiktors der Informationskriterienwert auch steigen kann. 5.1.5 Logistisches Modell für mehrere Prädiktoren Die Analyse qualitativer y-Variablen kann mit Hilfe des logistischen Modells sowohl auf qualitative wie auch für quantitative x-Variablen erweitert werden. Nagl, Einführung in die Statistik Seite 195 Übungsaufgaben (5.1) 1. Ein berühmter Datensatz (Präsidentenwahlen in den USA 1940; Veränderung der Meinung zu Willkie (gegen vs. für) und Parteipräferenz (Demokraten vs. Reps) zu 2 Zeitpunkten. Diesen Datensatz hat LAZARSFELD wiederholt analysiert. Parteipräferenz 1. Zeitp. a Dem (d) Meinung zu Willkie 1. Zeitp. b gegen (g) für(f) Rep (r) gegen (g) für(f) a. b. c. d. e. 2. y: Meinung zu Willkie 2. Zeitp. Gegen(g) Für(f) 68 1 11 0 1 23 2 3 2 1 12 1 0 11 1 129 Erstellen Sie die Modalregeln zur Prädiktion von y, die alle drei Prädiktoren berücksichtigen Versuchen Sie die Modalregel-Bedingung für die Präferenz des Nordens zu vereinfachen (etwa mit Hilfe des Venn-Diagramm) Berechnen Sie das Multiple Lambda Berechnen Sie für die Sequenz der Variablen a, b, c die semipartiellen Koeffizienten Berechnen Sie für die Sequenz der Variablen a, b, c die partiellen Koeffizienten. Laut Prospekt wird durch folgende Maßnahmen in dieser Reihenfolge wird jeweils der Energiebedarf um x % gesenkt: Einbau von Doppelfenstern (um 20 Prozent); Isolationen bei den Fenstern( um 10 Prozent); Einbau einer Wärmepumpe( um 30 Prozent); Einbau von Solarzellen ( um 50 Prozent). a. b. 3. Parteipräferenz 2. Zeitp. c Dem (d) Rep (r) Dem (d) Rep (r) Dem (d) Rep (r) Dem (d) Rep (r) Wieviel Prozent kann dadurch insgesamt an Energie gespart werden? Wie groß sind die semipartiellen Sparanteile der einzelnen Maßnahmen? Es seien für 4 Gruppen (Einteilung in Gruppen auf Grund der Variablen z) sowohl die PRE-Maße zur Prädiktion von y auf Grund der Variablen x als auch die Fehler OHNE x gegeben: Gruppen (nach z) 1. z=1 2. z=2 3. z=3 4. z=4 PREyx .70 .40 .10 0 Fehler OHNE 0.2 0.2 0.3 0.7 Wie groß ist das partielle PRE-Maß PREyx . z? 4. Für die Willkie-Daten: a. Berechnen Sie für alle möglichen Teiltabellen Entropie-Maße und stellen Sie die Entropie-Maße übersichtlich in einem ‚Modell’-Diamanten dar (Entropie in nits). b. Berechnen Sie nur das multiple PRU c. Stellen Sie die additive Zerlegung des multiplen PRU im Rahmen der additiven Zerlegung dar d. Berechnen Sie nun alle –2lnL werte für die verschiedenen Teiltabellen und tragen Sie –2lnL Werte wiederum in einen ‚Modell-Diamanten’ ein. e. Prüfen Sie die Hypothese, dass alle bedingten Anteile gleich sind. f. Prüfen Sie die Hypothese, dass nach Berücksichtigung von a und b, c keinen ‚Einfluß’ auf y hat. g. Prüfen Sie die Hypothese, dass nach Berücksichtigung von a, b und c keinen ‚Einfluß’ auf y hat. h. Prüfen Sie die Hypothese, dass a und y bedingt unabhängig sind (Bedingung sei c und b). 5. Wählen Sie für die Willkie-Daten mit Hilfe von SBC das beste Modell aus. a. Berechnen Sie SBC für alle Modelle. b. Wählen Sie das Modell aus, das den kleinsten SBC-Wert hat.